以AI验证AI:务实的进化还是危险的豪赌?

前言

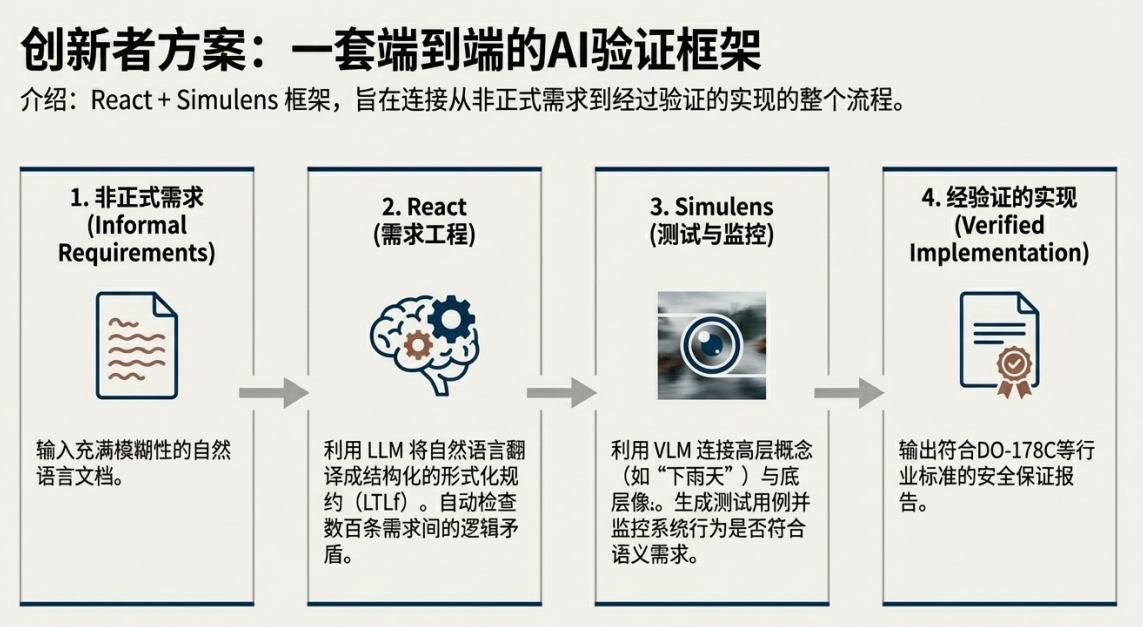

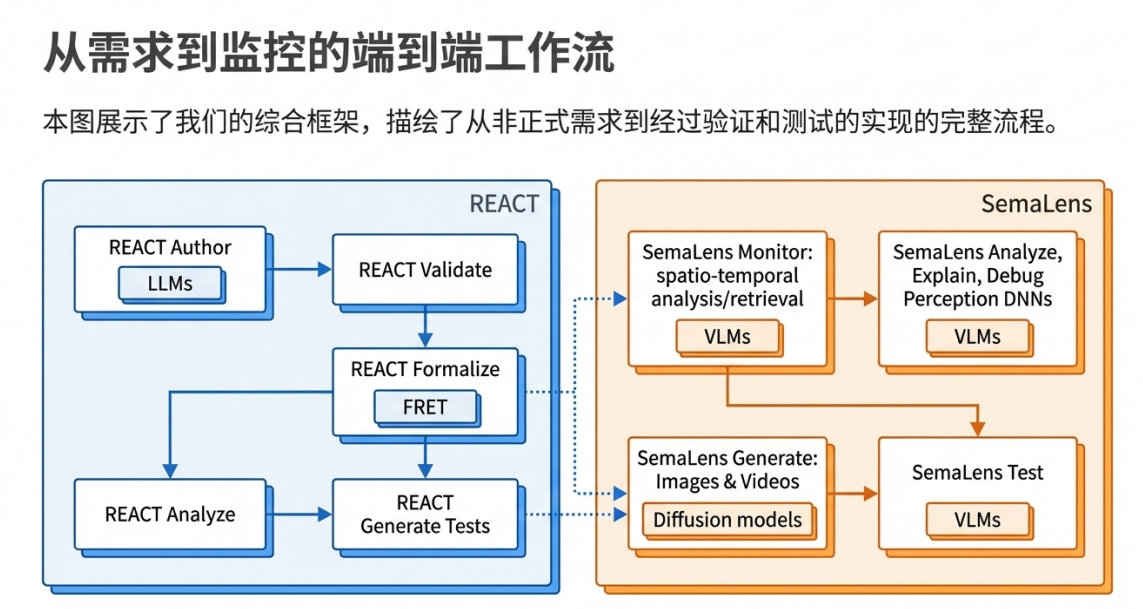

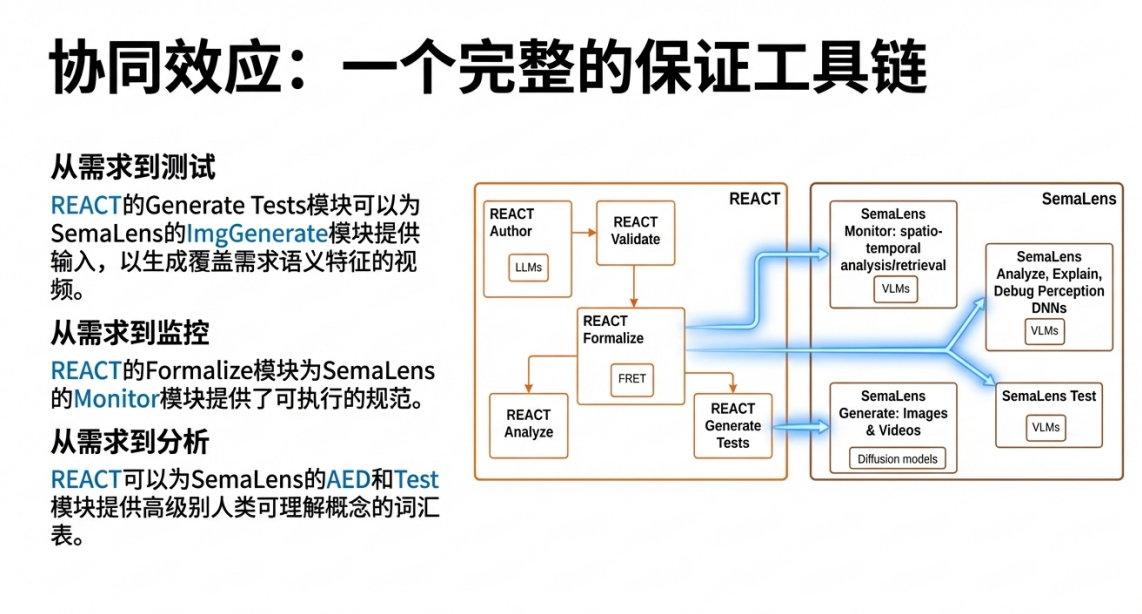

《Fighting AI with AI: Leveraging Foundation Models for Assuring AI-Enabled Safety-Critical Systems》探讨了在航空航天和自动驾驶等安全关键系统中,使用深度神经网络(DNNs)进行软件保证所面临的挑战,并提出了一个名为“以AI治AI”的解决方案框架。该框架由两个互补组件构成:REACT(利用大型语言模型/LLMs)专注于弥合非正式需求与形式化规约之间的语义鸿沟,以实现早期验证和测试用例生成;而SemaLens(利用视觉语言模型/VLMs)则充当“分析透镜”,用于测试、调试和监控DNN感知系统的行为,使其能被人类可理解的概念进行解释。讨论这一方法的前景与风险,肯定了其在解决传统需求工程痛点和语义匹配方面的进步,同时也警示了这种“用一个黑箱验证另一个黑箱”的策略对系统信任链的潜在脆弱性,尤其是在涉及复杂性、不确定性和行业认证的背景下。

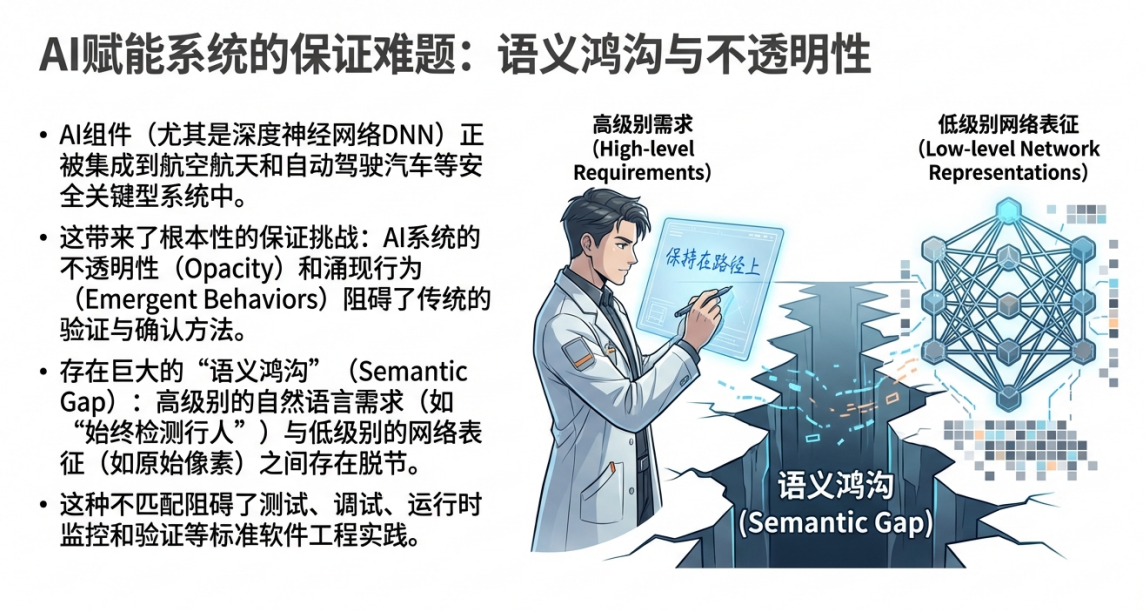

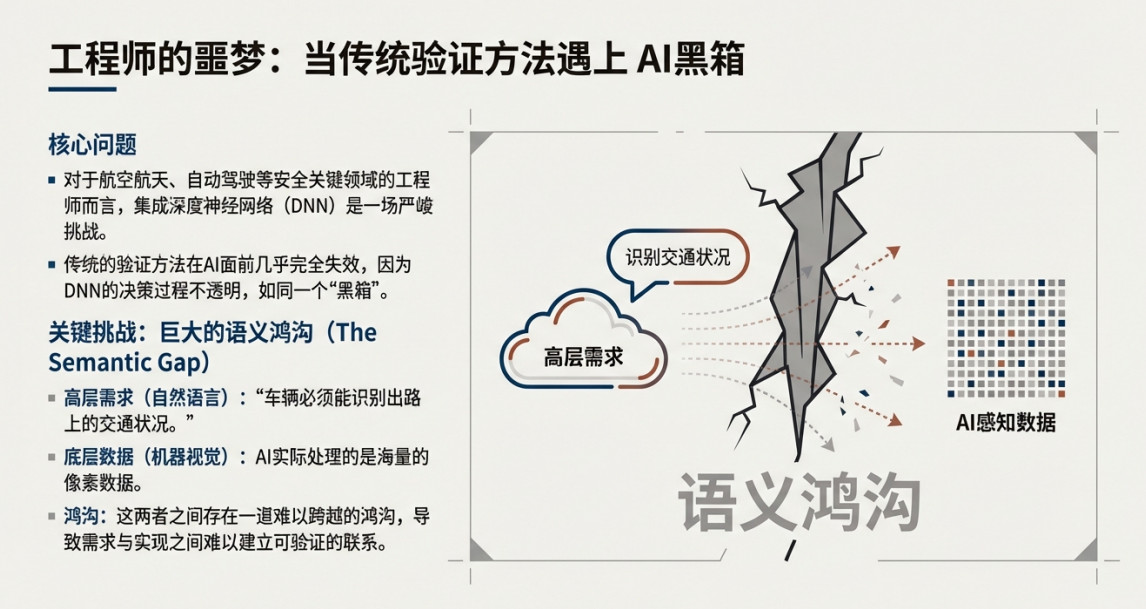

正如在“论点交锋”播客中一位工程师所言,将深度神经网络(DNNs)集成到航空航天等安全关键系统中,“这绝对是一场噩梦”。传统的验证方法在AI面前几乎完全失效,其核心挑战主要有两点:

1. 不透明性(黑箱问题):我们无法完全理解AI做出某个决策的具体内部逻辑。

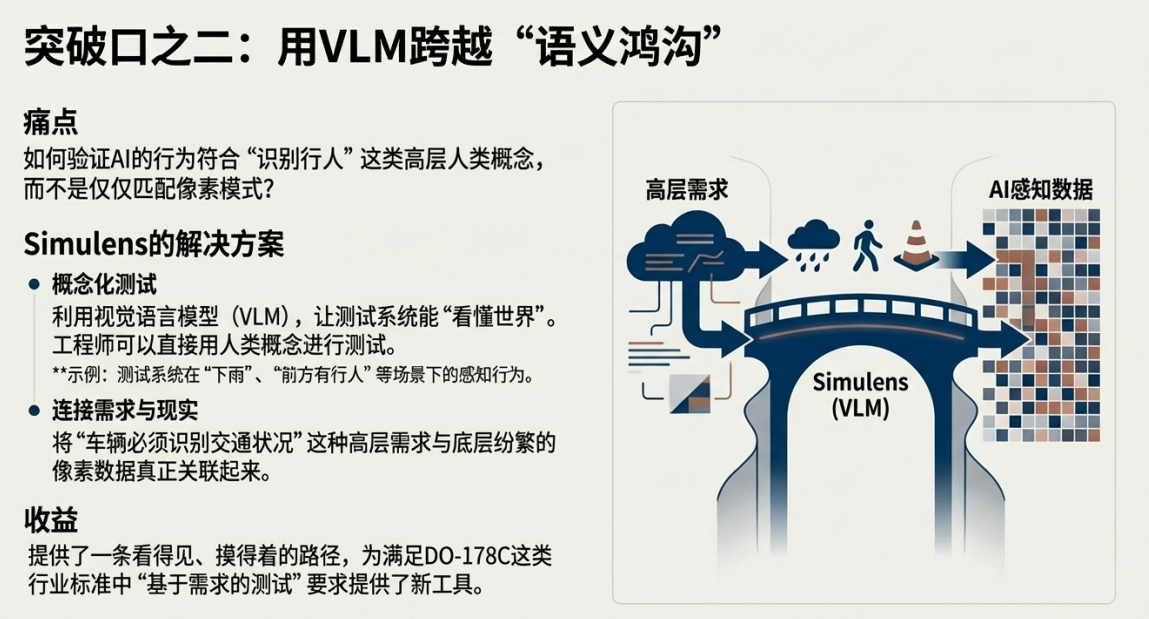

2. 语义鸿沟:工程师用自然语言提出的高层需求(例如,“车辆必须能识别行人”)与AI实际处理的底层像素数据之间存在巨大的脱节,难以建立可靠的验证关联。

为了应对这些挑战,一个大胆的思路应运而生:以AI验证AI。即利用能力更强的大型语言模型(LLM)和视觉语言模型(VLM)等基础模型,来反向验证、测试和监控系统中的AI组件。

这便引出了我们领域的核心问题:“以AI验证AI”,究竟是引领我们走出困境的务实的进化,还是一场将不可预测性层层叠加、置生命于险境的危险的豪赌?本文将通过正反双方的观点交锋,帮助您深入理解这场辩论的核心。

核心框架简介:理解我们正在辩论什么

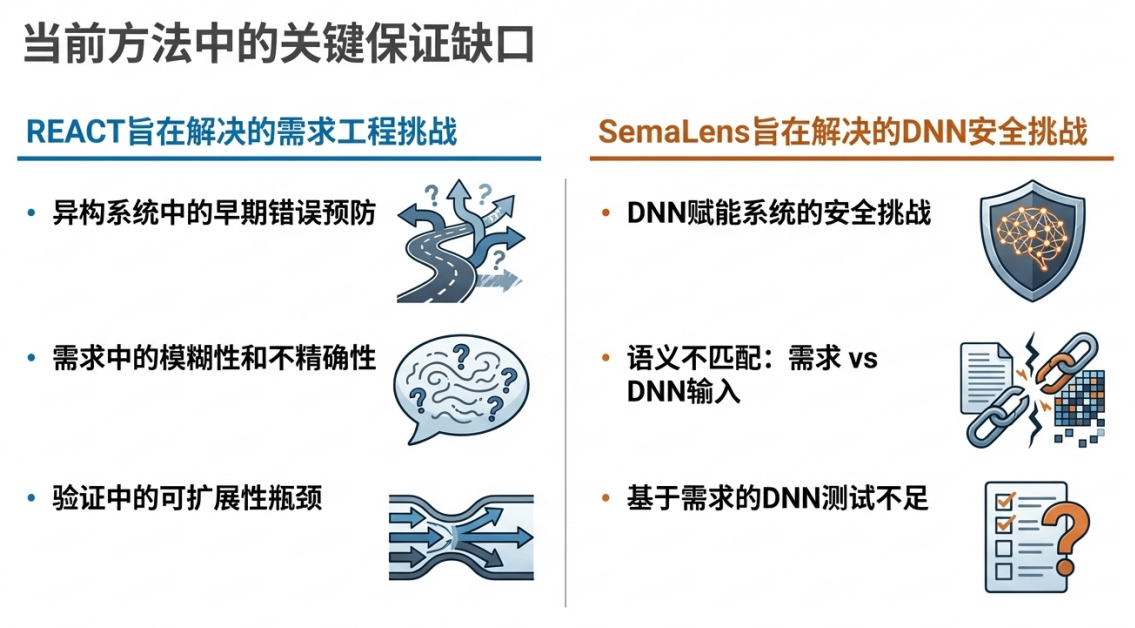

在进入辩论之前,我们首先需要了解作为讨论基础的集成框架,它由REACT和SemaLens两个互补的组件构成。

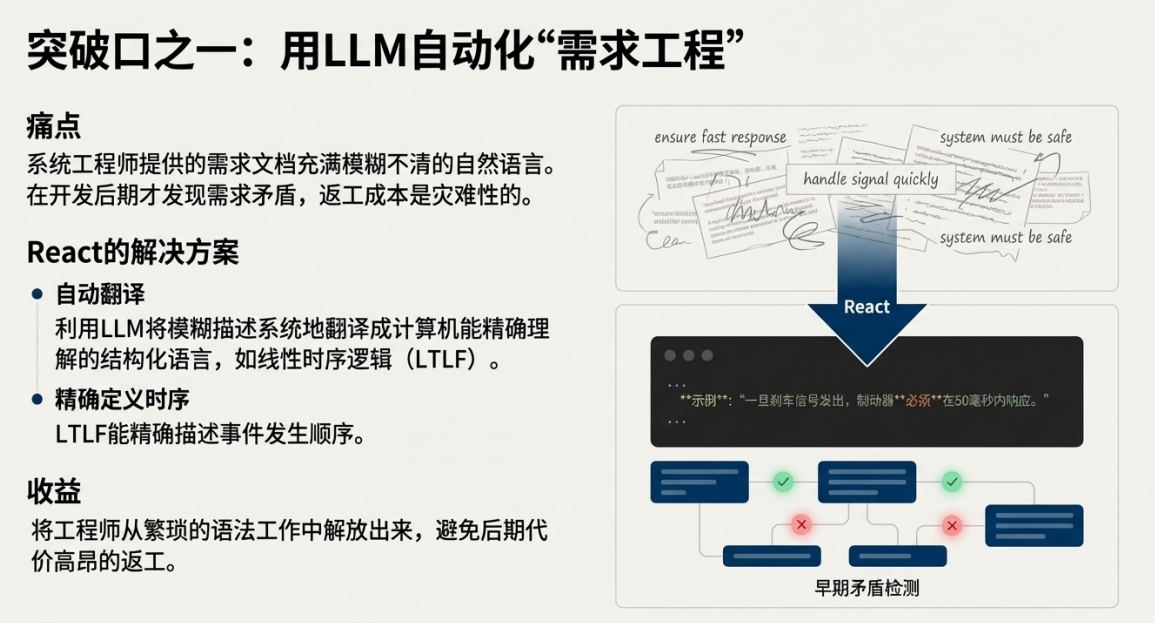

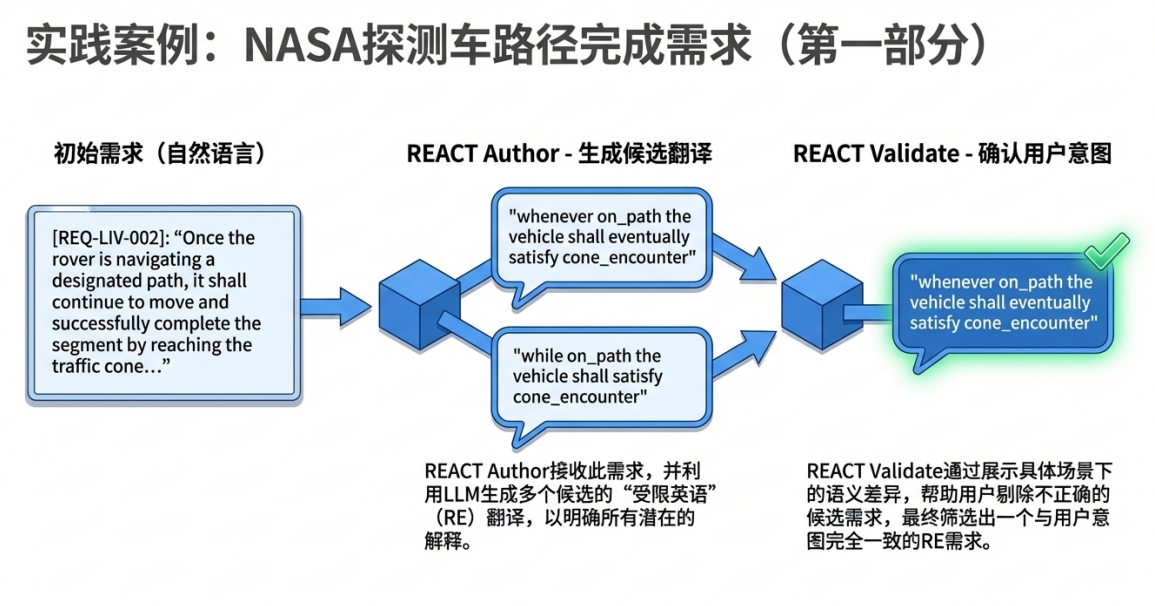

REACT:从模糊到精确的需求工程助手

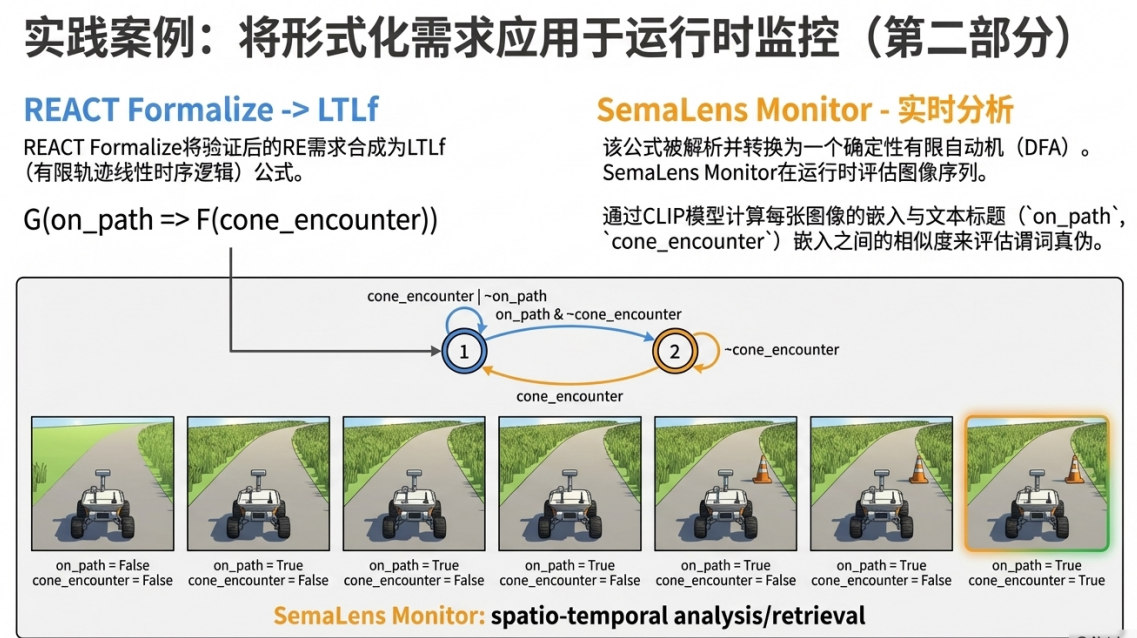

• 目标: 利用大型语言模型(LLM),将工程师用自然语言编写的、可能充满模糊性的需求,系统地转化为精确、可验证的形式化规约(Formal Specifications),例如线性时序逻辑(LTLf)。

• 价值: 旨在实现早期错误检测。通过在设计阶段就对形式化的需求进行一致性分析,可以发现需求间的潜在矛盾,避免在开发后期才发现问题而导致灾难性的返工成本。

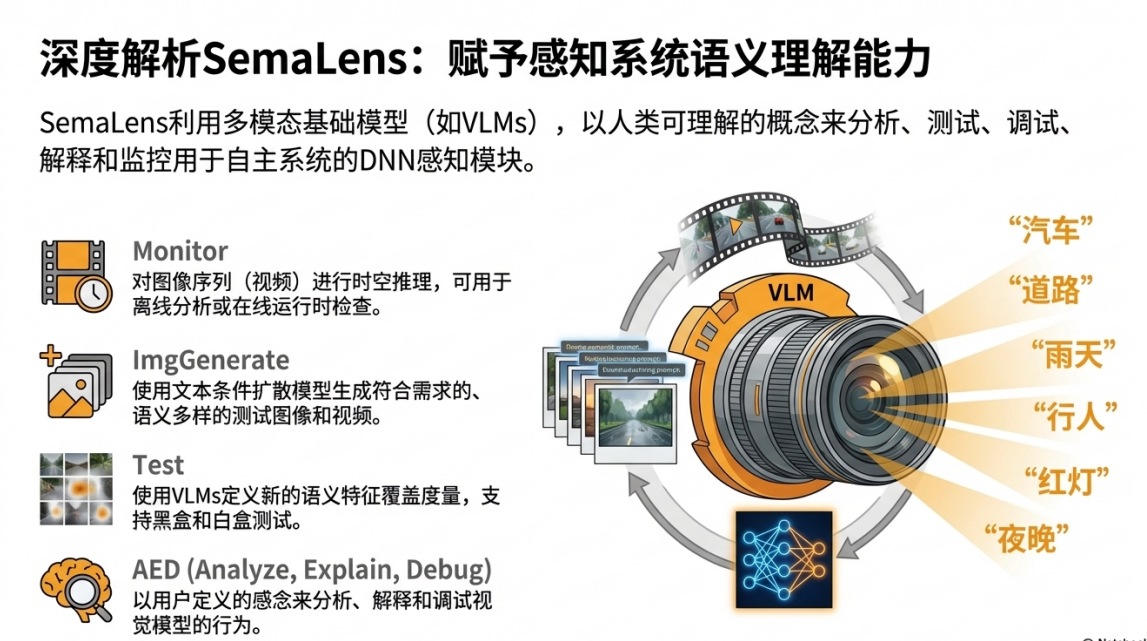

SemaLens:跨越语义鸿沟的“智能镜头”

• 目标: 利用视觉语言模型(VLM),让测试和监控系统能够以人类可理解的概念(如“天气状况”、“行人”、“交通锥”)去分析和评估感知系统的行为。

• 价值: 旨在弥合高层需求与底层像素数据之间的语义鸿沟,从而实现从需求到实现的端到端验证,确保AI“看懂”了世界并做出了正确反应。

尽管这个框架蓝图看起来很理想,但其核心理念“以AI验证AI”却引发了深刻的争议。

第一轮交锋:核心前提的对决

正方观点:这是必要且务实的进化

作为支持这一方向的工程师,我认为这是我们唯一可行的前进方向。

• 传统方法已力不从心:我们不能“用旧地图找新大陆”。传统的软件验证方法在面对DNNs的复杂性和不确定性时已经捉襟见肘,我们迫切需要新的工具和思路。

• 严谨性与效率的结合:这个框架并非凭空创造,而是将形式化方法的严谨性与AI的效率和规模化能力巧妙结合。它精准地瞄准了需求模糊和语义鸿沟这两大业界最核心的痛点。

• 提供了一条可行的路径:它构建了一个从非正式需求到经过验证的实现的端到端解决方案。这为满足DO-178C等严苛的行业标准,提供了一条“看得见、摸得着的路径”。

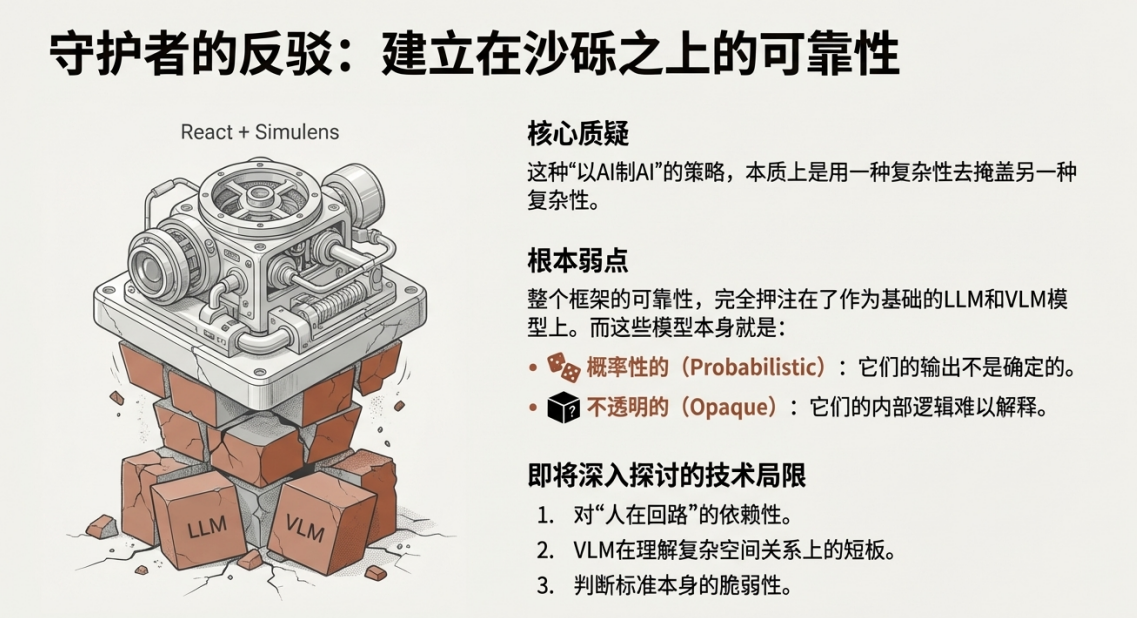

反方观点:这是用一个黑箱验证另一个黑箱

我对此持严重保留态度,这本质上是用一种我们同样无法完全理解的工具去验证另一个。

• 脆弱的信任链:该策略的本质是“用一种复杂性去掩盖另一种复杂性”。整个系统的信任链完全建立在同样不透明、本质上是概率性的基础模型(LLM和VLM)极其脆弱。

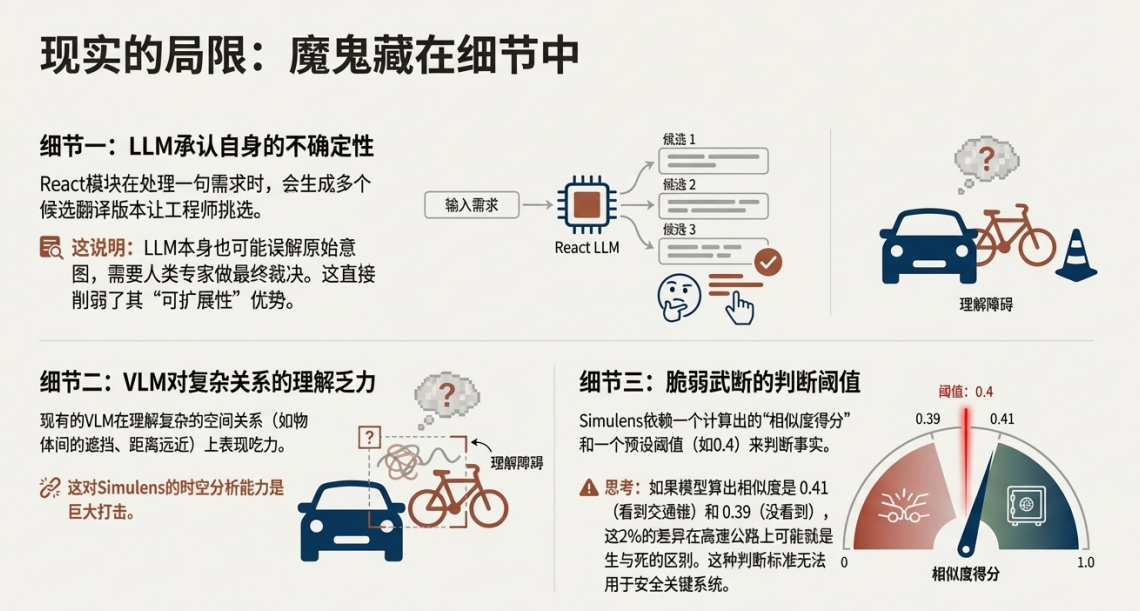

• 承认自身不可靠:REACT Author模块在翻译一句自然语言需求时,会生成多个候选项让工程师挑选。这个设计本身就等于承认了LLM可能会误解原始意图,从而需要“人在回路”进行最终裁决。这恰恰引入了新的、由验证工具本身带来的风险。

• 风险的叠加:这不仅没有解决原有的黑箱问题,反而引入了新的、更隐蔽的复杂性。对于“人命关天”的安全关键系统来说,这种做法太过冒险。

这种在核心前提上的根本分歧,迫使我们审视更深层次的问题。如果我们暂时接受正方的观点,那么这种人机协同在实践中究竟表现如何?这便将辩论从宏观理念,带入了微观的现实考量之中。

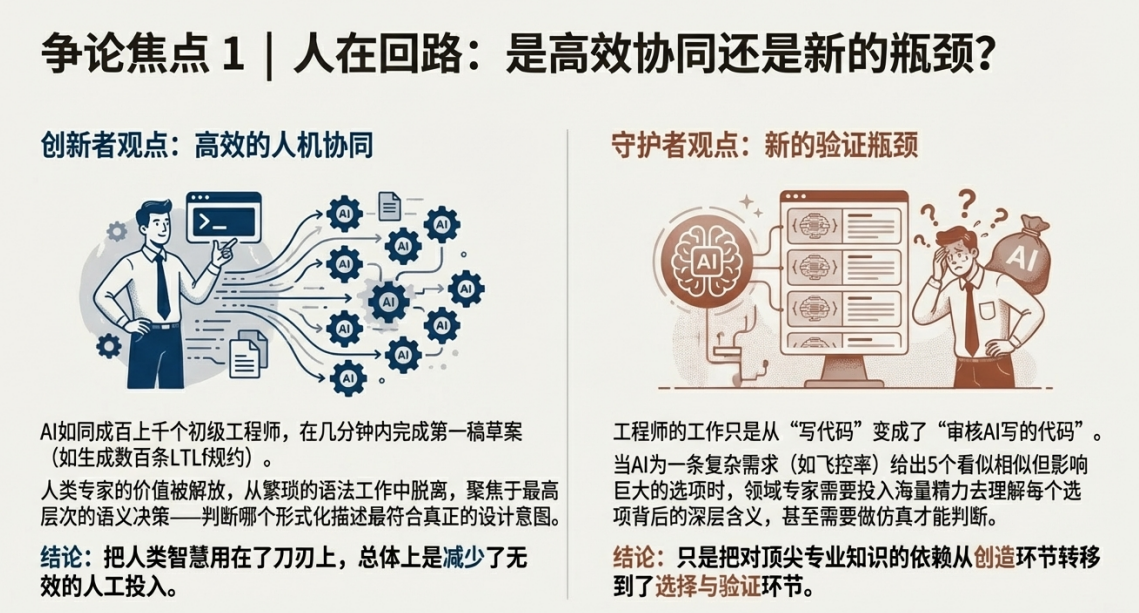

第二轮交锋:实践中的效率与陷阱

正方观点:这是高效的人机协同,将专家智慧用在刀刃上

反方对“人在回路”的质疑,恰恰说明了这个框架设计的巧妙之处。

• 重新定义“人在回路”:我们必须承认,让工程师从零开始手写几百条LTLf规约是一项极其耗时且容易出错的工作。现在,AI像“成百上千个初级工程师”一样,在几分钟内就完成了繁琐的初稿工作。

• 提升专家价值:这使得人类专家得以从“繁琐的语法工作中解放出来”,转而聚焦于最高层次的语义决策——判断哪个形式化描述最符合真正的系统设计意图。例如,当AI将模糊的“系统应具备鲁棒性”需求细化为多个具体场景(如“在10%丢包率下保持功能”、“在传感器延迟50毫秒内正常运行”)时,它实际上是在帮助设计者明确之前未定义的细节。

• 减少无效投入:这是一种高效的人机协同模式,它把人类最宝贵的领域知识用在了刀刃上,总体上减少了无效的人工投入。

反方观点:这制造了新的瓶颈,且判断标准十分脆弱

正方所谓的“高效协同”可能只是一个美好的幻想。

• 创造新的巨大瓶颈:对于一个复杂的系统,当AI生成五个“看似相似,但对系统行为影响巨大”的选项时,领域专家需要投入海量的精力去理解每个选项背后的深层含义,甚至需要仿真才能判断。这个审核过程本身就可能成为一个新的巨大瓶颈,甚至比从头写更费劲。

• 判断标准极其脆弱:SemaLens最脆弱的一环,是它依赖一个预设的**相似度得分阈值(如0.4)**来做判断(这一阈值在源论文的示例中被明确提及,说明这并非一个假设性问题)。让我们设想一个场景:

这场争论的核心,最终还是回到了AI的“黑箱”问题。我们是否真的能通过一个AI去理解另一个AI呢?这引出了关于“可解释性”的终极辩论。

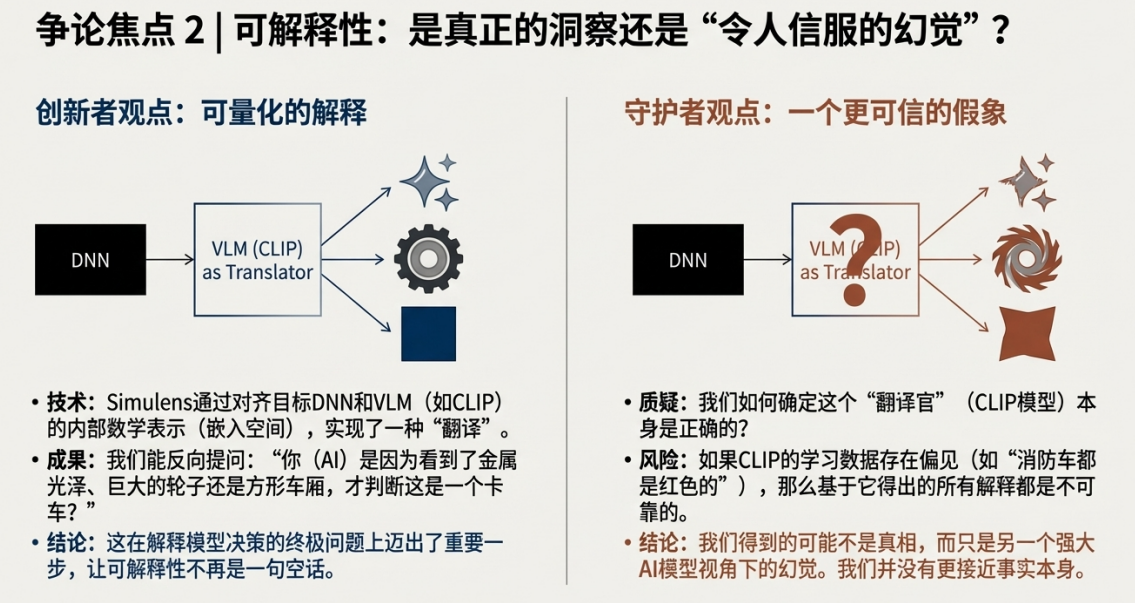

第三轮交锋:可解释性的突破与幻觉

正方观点:AI“看到”了什么,我们终于可以一探究竟

我认为SemaLens在可解释性上取得了真正的突破。

• 技术核心:其AED(分析、解释与调试)模块做了一件非常酷的事情。它将我们目标DNN的内部数学表示(即嵌入空间)与像CLIP这样强大的视觉语言模型的嵌入空间进行了对齐。

• 突破性价值:通过这种“对齐”,我们终于可以提出一些以前无法回答的问题。例如,当系统将一个物体识别为“卡车”时,我们可以反向提问:它是基于“金属光泽”、“巨大的轮子”还是“方形车厢”这些人类可以理解的概念做出这个判断的?

• 量化可解释性:这让可解释性不再是一句空话,而有了可以量化的依据。这是在“模型为何如此决策”这个终极问题上迈出的重要一步。

反方观点:我们得到的可能不是真相,只是一个更令人信服的假象

这个想法听起来很巧妙,但这也恰恰是让我最担忧的地方。

• 问题的转移而非解决:我们如何确定作为“翻译官”的VLM(如CLIP)本身是正确无误的?这只是将“解释一个黑箱的问题”巧妙地转换成了“理解两个黑箱之间映射关系”的另一个、可能更复杂的问题。

• 解释的不可靠性:如果作为“镜头”的CLIP模型本身就存在偏见——比如因为其训练数据里大部分消防车都是红色的,导致它将“红色”和“消防车”这两个概念强行关联——那么基于它得出的所有解释和所谓的语义覆盖率都将是不可靠的。

• 危险的幻觉:这种方法可能带来的后果是极其危险的。

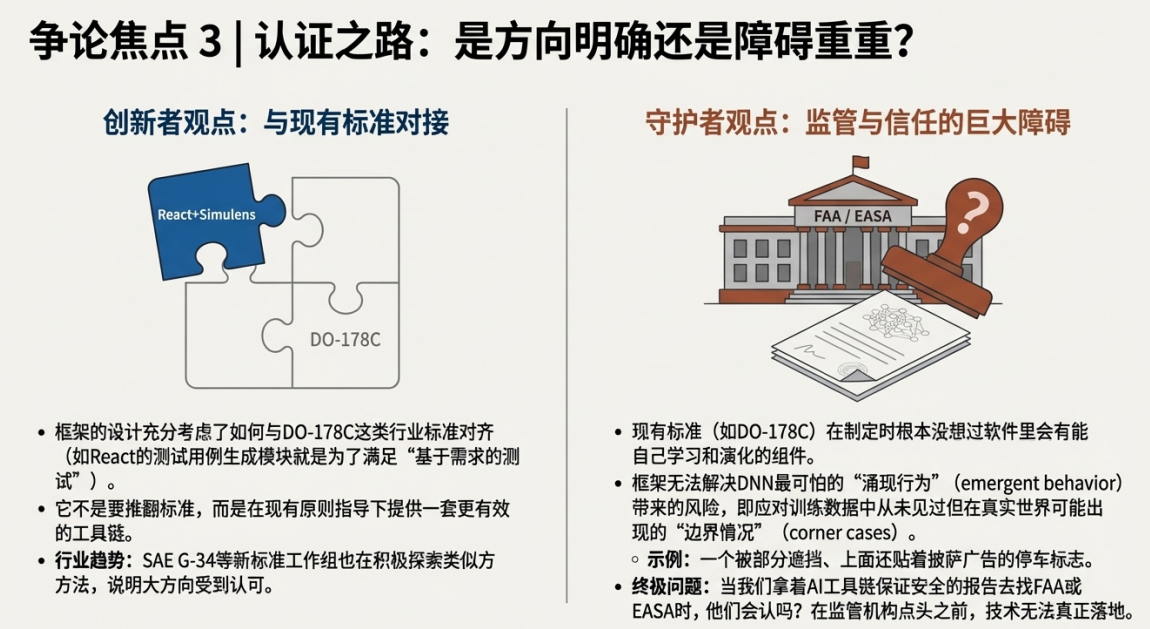

这场辩论从技术理念深入到实施细节,最终必然要面对现实世界的终极考验:监管与认证。

深刻的权衡与未来的挑战

观点汇总:一场势均力敌的辩论

辩论维度 | 正方观点(务实的进化) | 反方观点(危险的豪赌) |

核心理念 | 将形式化方法的严谨性与AI的效率相结合,是应对当前挑战的唯一可行路径。 | 用一个不透明的黑箱验证另一个,信任链极其脆弱,是在叠加风险。 |

关于效率 | 高效的人机协同模式,将人类专家从繁琐工作中解放,聚焦于高层语义决策。 | 审核AI生成的复杂选项可能成为新的瓶颈,并不一定能减少工作量。 |

关于可解释性 | 通过对齐嵌入空间,首次实现了对AI决策依据的量化分析,是重大突破。 | 解释的可靠性依赖于“翻译”AI的可靠性,可能得到的是更令人信服的假象而非真相。 |

关于现实可行性 | 框架设计对齐DO-178C等行业标准,代表了业界公认的发展方向(如SAE G-34)。 | 现有标准(如DO-178C)根本没为“会演化的组件”设计;无法解决未知的“涌现行为”(如一个贴着披萨广告的被遮挡停车标志);最终能否被FAA或EASA等认证机构接受是巨大的未知数。 |

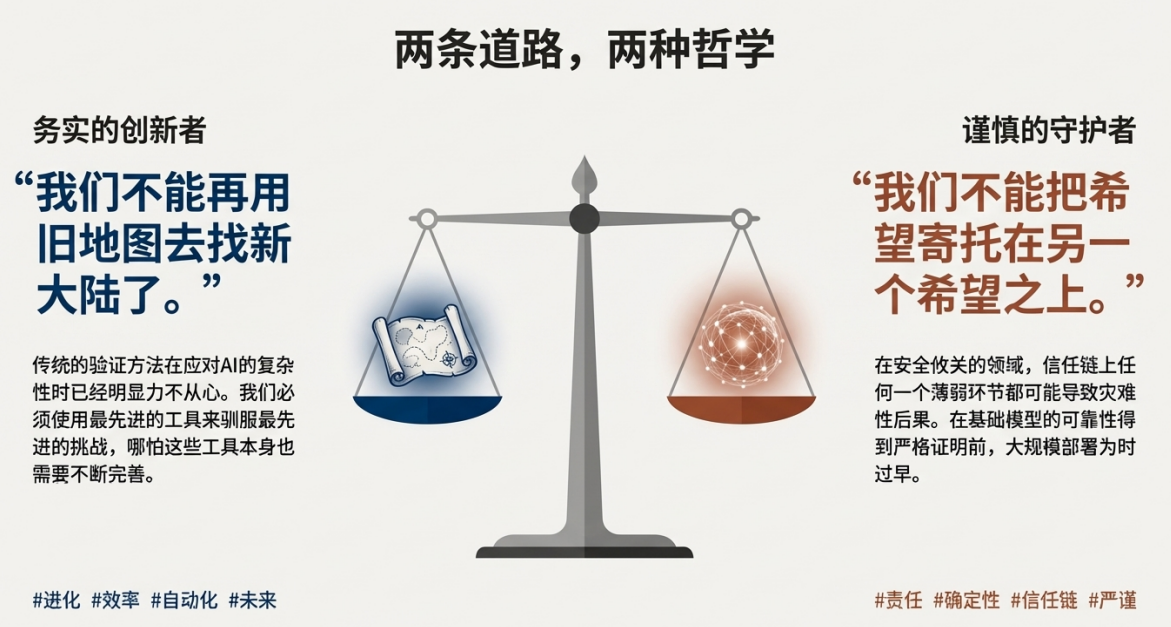

在拥抱创新与坚守安全之间寻求平衡

这场辩论没有简单的赢家。它深刻地揭示了在安全关键领域应用前沿AI技术时所面临的深刻权衡。一边是解决现有工程难题(如需求模糊、语义鸿沟)的巨大潜力;另一边则是引入一项我们自己都还没完全吃透的新技术所带来的内在风险。

这场辩论最终给我们留下了一个严峻的工程现实:我们面临着一个两难选择——一边是传统验证方法的已知局限,这些方法正逐渐失效;另一边则是概率性工具的未知风险,这些工具我们尚未能完全驾驭。未来的出路并非要在这场辩论中选出赢家,而在于如何构建新的系统架构,用形式化方法的严谨性去约束AI的概率性力量,确保即便我们“以AI验证AI”,人类的监督和判断力依然是安全最终的仲裁者。

今天先到这儿,希望对AI,云原生,技术领导力, 企业管理,系统架构设计与评估,团队管理, 项目管理, 产品管理,信息安全,团队建设 有参考作用 , 您可能感兴趣的文章:

微服务架构设计

视频直播平台的系统架构演化

微服务与Docker介绍

Docker与CI持续集成/CD

互联网电商购物车架构演变案例

互联网业务场景下消息队列架构

互联网高效研发团队管理演进之一

消息系统架构设计演进

互联网电商搜索架构演化之一

企业信息化与软件工程的迷思

企业项目化管理介绍

软件项目成功之要素

人际沟通风格介绍一

精益IT组织与分享式领导

学习型组织与企业

企业创新文化与等级观念

组织目标与个人目标

初创公司人才招聘与管理

人才公司环境与企业文化

企业文化、团队文化与知识共享

高效能的团队建设

项目管理沟通计划

构建高效的研发与自动化运维

某大型电商云平台实践

互联网数据库架构设计思路

IT基础架构规划方案一(网络系统规划)

餐饮行业解决方案之客户分析流程

餐饮行业解决方案之采购战略制定与实施流程

餐饮行业解决方案之业务设计流程

供应链需求调研CheckList

企业应用之性能实时度量系统演变

如有想了解更多软件设计与架构, 系统IT,企业信息化, 团队管理 资讯,请关注我的微信订阅号:

作者:Petter Liu

出处:http://www.cnblogs.com/wintersun/

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文连接,否则保留追究法律责任的权利。

该文章也同时发布在我的独立博客中-Petter Liu Blog。

浙公网安备 33010602011771号

浙公网安备 33010602011771号