背景

大语言模型(LLM)在代码生成方面无疑取得了惊人的进步,早已成为许多开发者不可或缺的日常工具。从自动补全到生成完整函数,AI正在重塑软件开发的生态。但当这些先进的AI模型生成错误代码时,背后的真正原因是什么?真的是因为任务太复杂、代码太难写了吗?一篇针对GPT-4o、Claude Sonnet-4、Llama-3.3-70B等六大主流模型和四大基准测试的深入研究揭示了几个出人意料的发现。结果表明,我们可能一直都搞错了重点。AI编码的失败,根源并非代码的复杂性,而是一些更深层次的“思维”陷阱。

意外发现一:代码越复杂,AI越容易失败?这是一个误解

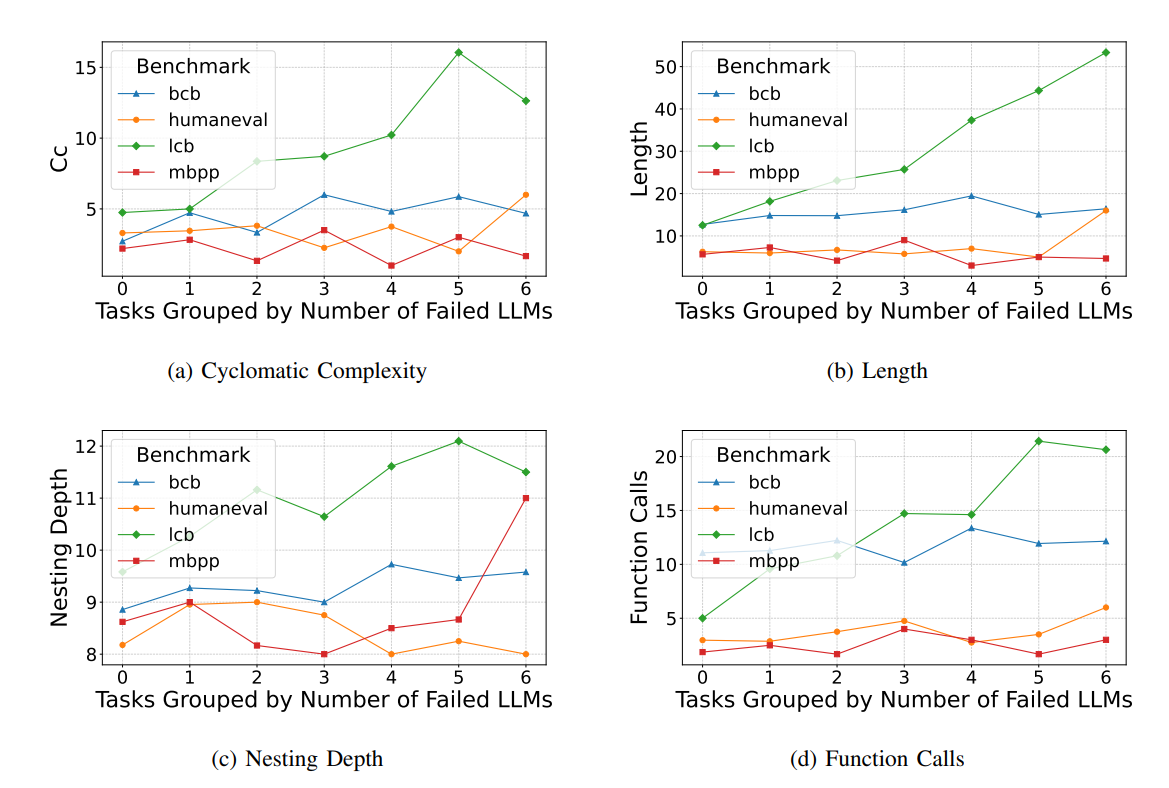

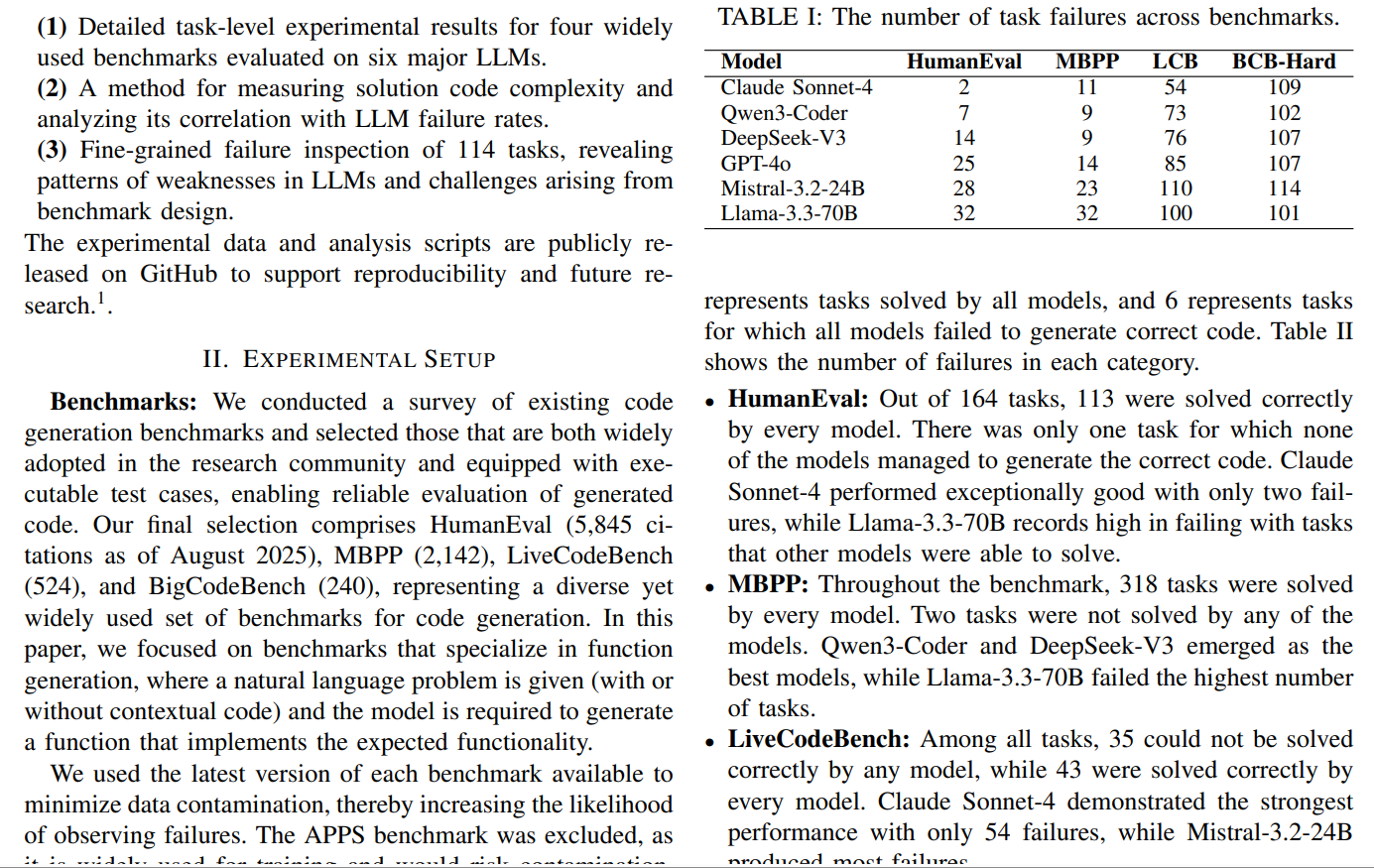

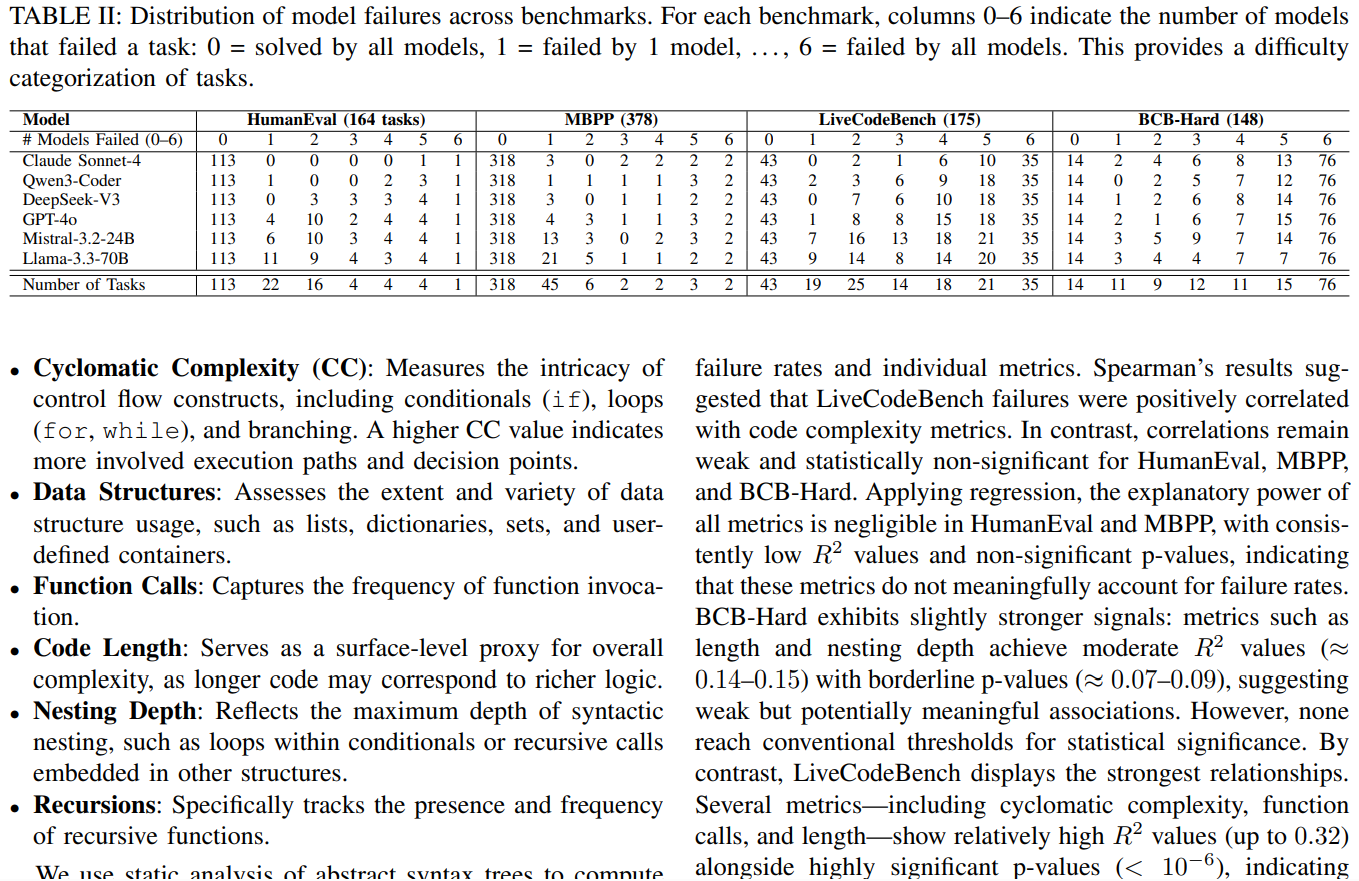

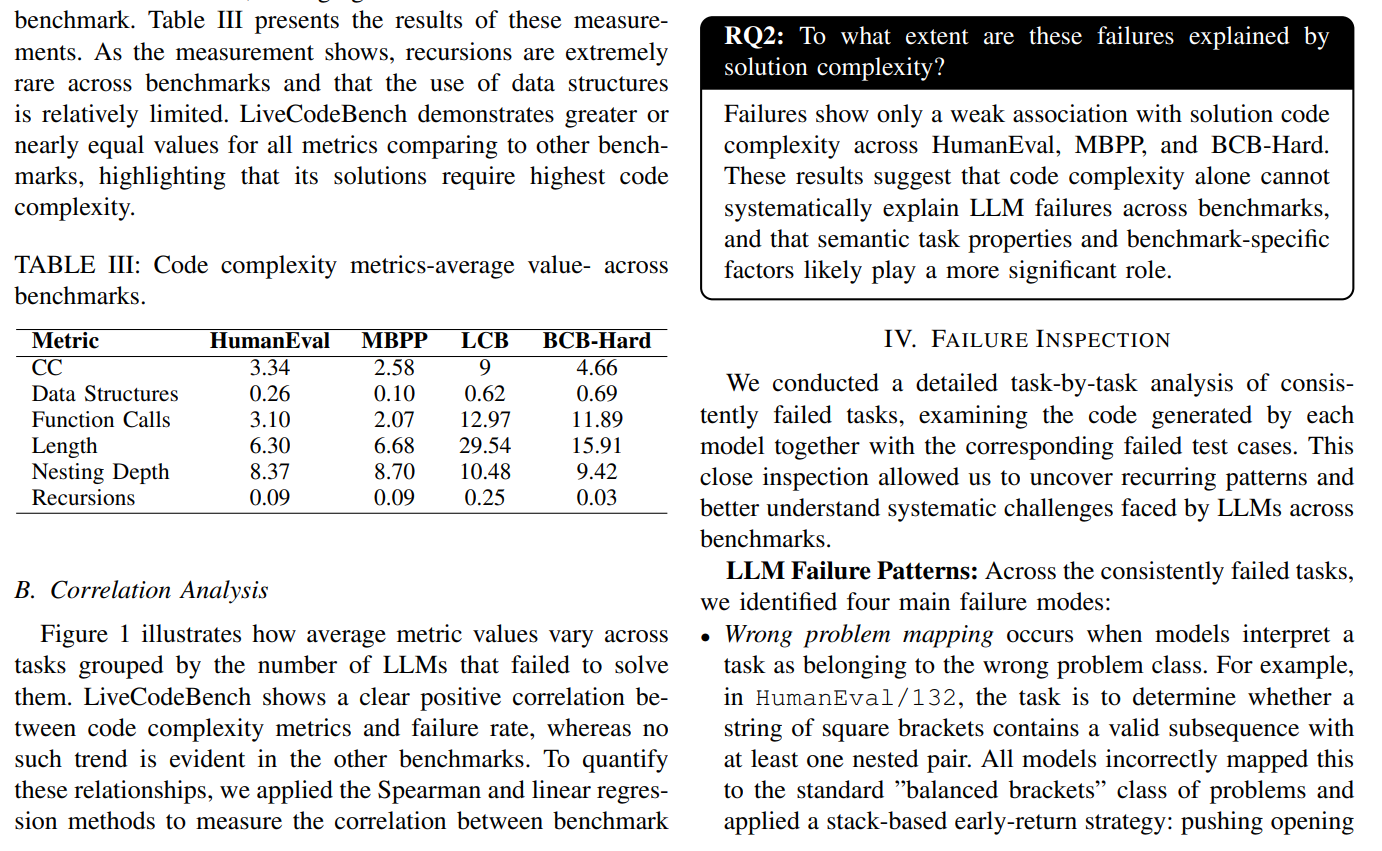

我们通常认为,代码越复杂,AI越容易出错。但这项研究的第一个发现就给这个普遍认知泼了一盆冷水。研究中的一个核心发现颠覆了我们的直觉:在HumanEval、MBPP和BCB-Hard这三个广受欢迎的基准测试中,解决方案代码的复杂性(如圈复杂度、代码长度、嵌套深度)与模型的失败率之间并没有表现出明显的正相关关系。

唯一的例外是LiveCodeBench,在这个基准测试中,任务失败率确实与代码复杂性存在较强关联。深入数据我们发现,LiveCodeBench的任务(多源于LeetCode等竞赛平台)在算法复杂度和代码长度上远超其他基准。这或许意味着,当任务的纯粹算法挑战达到一定阈值时,代码的静态复杂性才开始成为AI的“硬伤”,而在大多数常规编码任务中,问题出在别处。

研究表明,代码本身的复杂性并不能系统地解释大语言模型的失败。真正的挑战可能在于任务的语义特性和基准测试的设计本身。

解剖失败:LLM的四大“思维定式”陷阱

既然复杂性不是主因,那么真正的“罪魁祸首”是什么?研究人员像侦探一样,通过剖析114个所有模型都普遍失败的“悬案”,发现了模型在逻辑推理层面反复陷入的四种思维陷阱。

在这些模式中,“有缺陷的算法设计”和“错误的问题映射”是导致失败最主要的原因,尤其是在难度更高的BCB-Hard和LiveCodeBench基准测试中。

1. 错误的问题映射 (Wrong Problem Mapping) 这指的是模型将一个特定的、新颖的任务误解为另一个更常见、更熟悉的问题。例如,在HumanEval/132任务中,要求是判断一个括号字符串是否“包含至少一个嵌套对的有效子序列”。然而,所有模型都错误地将其当成了常规的“判断括号是否完全平衡”问题来解决,导致了失败。这暴露了模型倾向于套用“旧知识”,而忽略了问题的关键细节。

2. 有缺陷或不完整的算法设计 (Flawed/Incomplete Algorithm Design) 在这种情况下,模型理解了问题的大方向,但在具体实现的算法步骤上存在逻辑漏洞或考虑不周。例如,在BCB-Hard/945任务中,模型需要基于历史数据进行回归预测。它们正确地进行了数据处理和回归,但未能处理数据中可能存在的“非单调”趋势,导致算法在特定情况下失效。

3. 边界条件处理不当 (Edge Case Mishandling) 这是最常见的失败模式之一。模型生成的代码能够处理常规、普遍的输入,却在面对不常见或极端的边界情况时崩溃。例如,在BCB-Hard/964任务中,要求转换一个目录及其子目录下的所有文件。所有模型生成的代码都只迭代了顶层目录的文件,而未能按要求递归遍历子文件夹,导致测试失败。

4. 格式错误 (Formatting Mistakes) 有时,AI的算法逻辑是完全正确的,但仅仅因为输出结果的格式不符合基准测试的严格要求而被判为失败。一个典型的例子是LiveCodeBench/3736,它要求模型返回一个字符串形式的数字,如"23",但模型却返回了数字23。这种“差之毫厘”的错误凸显了当前模型在精确遵循指令方面的脆弱性。

意外发现三:“更强”的模型有时反而会输给“更实在”的模型

研究中一个非常有趣的反直觉现象发生在BCB-Hard基准测试中。在这个测试里,Llama-3.3-70B的表现竟然优于在其他测试中公认更强的Claude Sonnet-4。

原因令人深思:Llama-3.3-70B之所以成功,恰恰是因为它对任务提示进行了更“字面化”、更“实在”的解读。以BCB-Hard/147任务为例,任务要求遍历一个IP地址范围。Claude Sonnet-4遵循了更普遍、更专业的编程惯例,自动跳过了范围中的网络和广播地址——这在真实世界的开发中是合理的做法。然而,Llama-3.3-70B则严格按照提示,遍历了所有IP地址,一个不漏。结果,后者的“实在”行为恰好通过了刻板的测试用例,而前者的“专业”行为反而导致了失败。

这揭示了一个评估AI模型时的核心悖论:随着模型越来越“智能”,越来越能模仿人类开发者的专业直觉和惯例,它们反而可能在那些奖励绝对字面服从的刻板测试中“自作聪明”地失败。这迫使我们反思:我们到底希望AI成为一个遵循指令的工具,还是一个具备专业判断力的“同事”?

结论:我们该如何更好地“考验”AI?

这项研究清晰地告诉我们,当前顶级LLM生成代码的失败,更多是源于对问题语义的误解、逻辑推理的缺陷、对边界条件的忽视以及对刻板规则的适应性不足,而非代码本身的静态复杂性。此外,研究还发现,一些基准测试本身存在的“提示模糊”和“测试过严”等问题,也是导致模型失败的重要外部因素。

1. 对模型开发:精准指明优化方向

不再盲目追求 “提升整体性能”,而是针对性解决四大失败问题 —— 比如优化模型对题目细节的理解(避免任务映射错误)、强化算法完整性设计、补充边缘情况训练、适配多样化输出格式,让模型优化更有针对性。

2. 对基准测试设计:完善评价体系

揭示了现有测试的缺陷(如描述模糊、要求过严),后续可设计更清晰、合理的测试题,同时可基于共性失败任务打造 “故障诊断型基准”,更精准区分模型真实能力,而非只看表面得分。

3. 对实际应用:降低开发风险

帮助开发者了解 AI 生成代码的 “雷区”—— 比如复杂场景下的边缘情况、严格格式要求的任务,使用时需重点核查这些环节,避免直接套用模型输出导致 bug。

4. 对研究方向:开辟新视角

打破 “只看排名不看失败” 的研究惯性,提供了 “任务级失败分析 + 复杂度测量 + 失败模式归类” 的完整方法,为后续 LLM 能力短板研究提供了可复用的框架。

今天先到这儿,希望对AI,云原生,技术领导力, 企业管理,系统架构设计与评估,团队管理, 项目管理, 产品管理,信息安全,团队建设 有参考作用 , 您可能感兴趣的文章:

微服务架构设计

视频直播平台的系统架构演化

微服务与Docker介绍

Docker与CI持续集成/CD

互联网电商购物车架构演变案例

互联网业务场景下消息队列架构

互联网高效研发团队管理演进之一

消息系统架构设计演进

互联网电商搜索架构演化之一

企业信息化与软件工程的迷思

企业项目化管理介绍

软件项目成功之要素

人际沟通风格介绍一

精益IT组织与分享式领导

学习型组织与企业

企业创新文化与等级观念

组织目标与个人目标

初创公司人才招聘与管理

人才公司环境与企业文化

企业文化、团队文化与知识共享

高效能的团队建设

项目管理沟通计划

构建高效的研发与自动化运维

某大型电商云平台实践

互联网数据库架构设计思路

IT基础架构规划方案一(网络系统规划)

餐饮行业解决方案之客户分析流程

餐饮行业解决方案之采购战略制定与实施流程

餐饮行业解决方案之业务设计流程

供应链需求调研CheckList

企业应用之性能实时度量系统演变

如有想了解更多软件设计与架构, 系统IT,企业信息化, 团队管理 资讯,请关注我的微信订阅号:

作者:Petter Liu

出处:http://www.cnblogs.com/wintersun/

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文连接,否则保留追究法律责任的权利。

该文章也同时发布在我的独立博客中-Petter Liu Blog。

浙公网安备 33010602011771号

浙公网安备 33010602011771号