[置顶] 看一遍就懂-大模型架构及encoder-decoder详细训练和推理计算过程

posted @ 2026-01-25 18:21 GlenTt 阅读(473) 评论(0) 推荐(0)

posted @ 2026-01-25 18:21 GlenTt 阅读(473) 评论(0) 推荐(0)

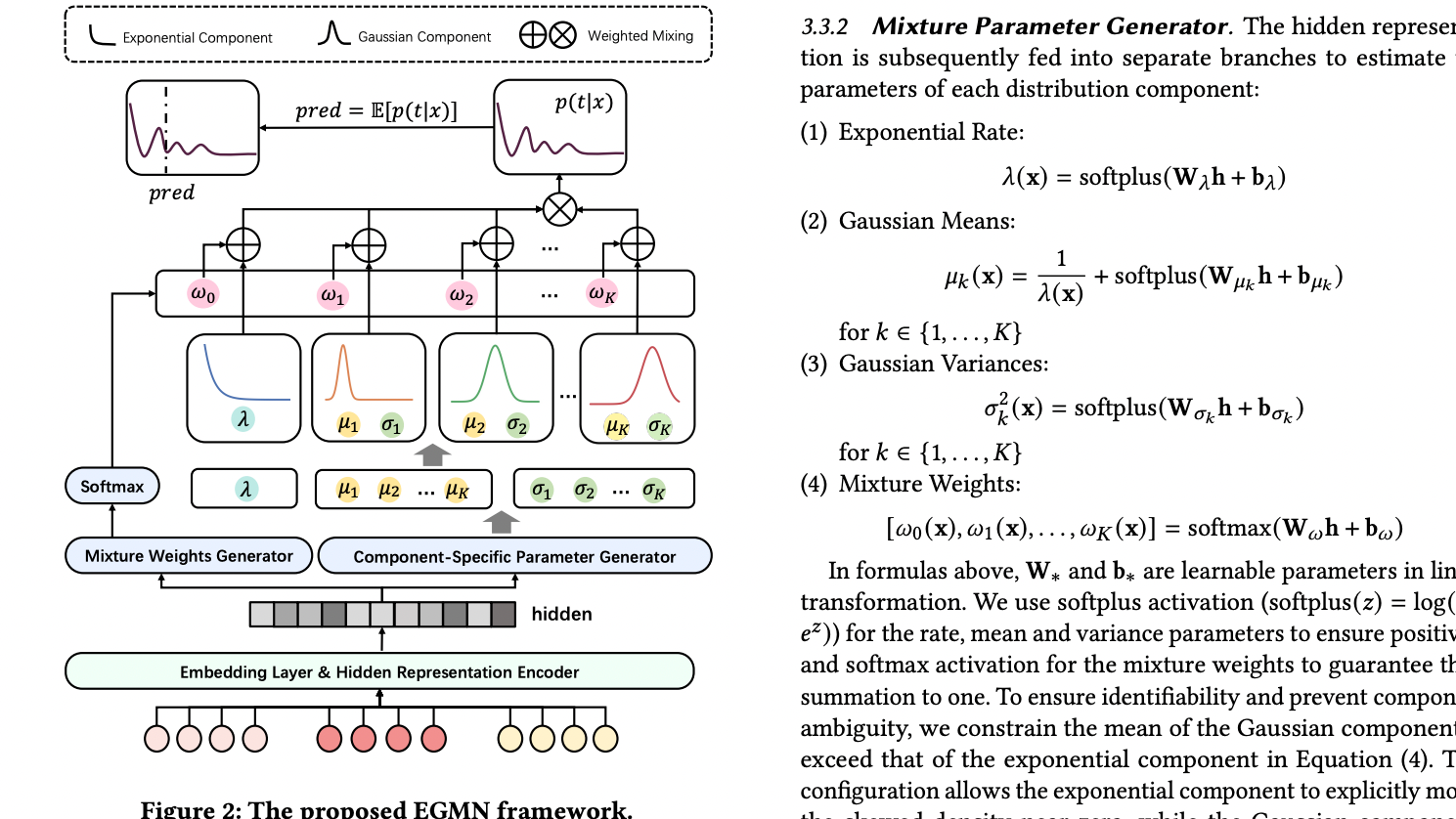

从点预测到分布建模:小红书-EGMN在视频观看时长预测中的方法与实践 原文:https://arxiv.org/pdf/2508.12665 一、引言:问题背景与研究动机 在短视频推荐系统中,观看时长(Watch Time)被广泛视为衡量用户满意度与内容质量的核心信号之一。与点击、点赞等离散反馈不同 阅读全文

从点预测到分布建模:小红书-EGMN在视频观看时长预测中的方法与实践 原文:https://arxiv.org/pdf/2508.12665 一、引言:问题背景与研究动机 在短视频推荐系统中,观看时长(Watch Time)被广泛视为衡量用户满意度与内容质量的核心信号之一。与点击、点赞等离散反馈不同 阅读全文

posted @ 2025-12-29 17:56 GlenTt 阅读(669) 评论(0) 推荐(0)

posted @ 2025-12-24 15:04 GlenTt 阅读(608) 评论(0) 推荐(0)

posted @ 2025-09-16 16:10 GlenTt 阅读(4770) 评论(2) 推荐(2)

注意力机制:从核心原理到前沿应用 如果你关注人工智能,无论是惊艳世人的GPT-4,还是精准洞察你购物偏好的推荐引擎,它们的背后都有一个共同的技术基石——注意力机制 (Attention Mechanism)。 然而,随着技术飞速发展,Attention的“家族”也日益庞大:Self-Attentio 阅读全文

注意力机制:从核心原理到前沿应用 如果你关注人工智能,无论是惊艳世人的GPT-4,还是精准洞察你购物偏好的推荐引擎,它们的背后都有一个共同的技术基石——注意力机制 (Attention Mechanism)。 然而,随着技术飞速发展,Attention的“家族”也日益庞大:Self-Attentio 阅读全文

posted @ 2025-09-15 10:17 GlenTt 阅读(828) 评论(0) 推荐(2)

2026年2月21日 #

posted @ 2026-02-21 12:19 GlenTt 阅读(164) 评论(0) 推荐(0)

2026年2月14日 #

posted @ 2026-02-14 11:31 GlenTt 阅读(207) 评论(0) 推荐(0)

2026年2月8日 #

posted @ 2026-02-08 18:56 GlenTt 阅读(280) 评论(0) 推荐(0)

2026年1月12日 #

posted @ 2026-01-12 10:18 GlenTt 阅读(556) 评论(0) 推荐(1)

2026年1月6日 #

posted @ 2026-01-06 20:27 GlenTt 阅读(619) 评论(0) 推荐(0)

2026年1月5日 #

posted @ 2026-01-05 16:38 GlenTt 阅读(65) 评论(0) 推荐(0)

2026年1月2日 #

posted @ 2026-01-02 13:24 GlenTt 阅读(695) 评论(0) 推荐(2)