随笔分类 - 深度学习

Deep Learning

摘要:Visual DL是由 PaddlePaddle 和 ECharts 合作推出的一款深度学习可视化工具,其能够可视化scalar、参数分布、模型结构、图像等。底层采用C编写,上层SDK以python为主,也可以使用C集成到其它平台。 如果你正在寻求深度学习任务设计的可视化工具,可以考虑Visual

阅读全文

摘要:一些caffe错误 训练时很快梯度爆炸,loss猛增至nan 如果找不到数据上的原因的话,可以怀疑caffe框架有问题,换用其它版本试试。比如我遇到的问题是在训练时使用了Accuracy层,而该层的实现代码在某次更新中GPU代码存在bug,复用了其它层的变量导致对loss的计算产生了影响。训练时去掉

阅读全文

摘要:Caffe在1.0版本仅支持两种信号的处理: 1) SIGHUP 2) SIGINT SIGHUP:caffe接收到此信号后进行snapshot,并不会中断caffe的训练. SIGINT:caffe接收到此信号后进行snapshot,并退出. 参考 "issue 2012" 对这个问题的讨论.在

阅读全文

摘要:参数正则化方法 Dropout 受人类繁衍后代时男女各一半基因进行组合产生下一代的启发,论文( "Dropout: A Simple Way to Prevent Neural Networks from Overfitting" )提出了Dropout。 Dropout是一种在深度学习环境中应用的

阅读全文

摘要:Network In Network 论文 "Network In Network" (Min Lin, ICLR2014). 传统CNN使用的线性滤波器是一种广义线性模型(Generalized linear model,GLM)。所以用CNN进行特征提取时,其实就隐含地假设了特征是线性可分的,可

阅读全文

摘要:pooling 是仿照人的视觉系统进行降维(降采样),用更高层的抽象表示图像特征,这一部分内容从Hubel&wiesel视觉神经研究到Fukushima提出,再到LeCun的LeNet5首次采用并使用BP进行求解,是一条线上的内容,原始推动力其实就是仿生,仿照真正的神经网络构建人工网络。 至于poo

阅读全文

摘要:Batch Normalization Ioffe 和 C. Szegedy 在2015年《Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift》论文中提出此方法来减缓

阅读全文

摘要:在caffe源码目录下的examples下面有个 "web_demo" 演示代码,其使用python搭建了Flask web服务器进行ImageNet图像分类的演示。 首先安装python的依赖库: 接下来,修改源码,仅三个代码文件: app.py 这是主程序的入口 exifutil.py 辅助代码

阅读全文

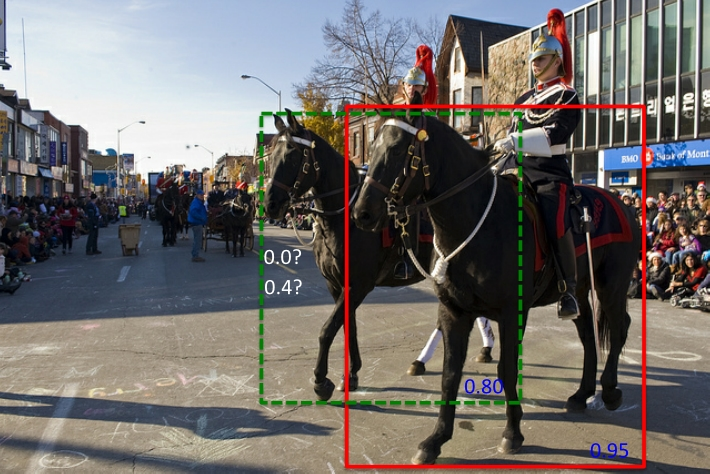

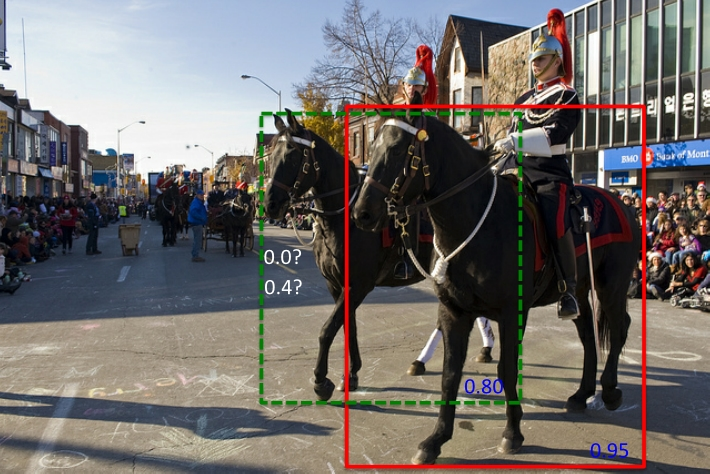

摘要: 本文介绍了非极大值抑制NMS 在目标检测中的应用,并介绍了NMS的改进算法Soft-NMS.

阅读全文

本文介绍了非极大值抑制NMS 在目标检测中的应用,并介绍了NMS的改进算法Soft-NMS.

阅读全文

本文介绍了非极大值抑制NMS 在目标检测中的应用,并介绍了NMS的改进算法Soft-NMS.

阅读全文

本文介绍了非极大值抑制NMS 在目标检测中的应用,并介绍了NMS的改进算法Soft-NMS.

阅读全文

摘要:Darknet windows移植 代码地址: "https://github.com/makefile/darknet" 编译要求: VS2013 update5 及其之后的版本(低版本对C++标准支持较差) 配置opencv来显示图片结果,如果不配置OpenCV,则支持的图片类型较少,结果将直接

阅读全文

摘要:权重初始化 模型权重的初始化对于网络的训练很重要, 不好的初始化参数会导致梯度传播问题, 降低训练速度; 而好的初始化参数, 能够加速收敛, 并且更可能找到较优解. 如果权重一开始很小,信号到达最后也会很小;如果权重一开始很大,信号到达最后也会很大。不合适的权重初始化会使得隐藏层的输入的方差过大,从

阅读全文

摘要:神经网络中使用激活函数来加入非线性因素,提高模型的表达能力。

本文对ReLU及其变种,Swish,Maxout,Sigmoid等做了介绍.

阅读全文

摘要:监督学习中通常通过对损失函数最优化(最小化)来学习模型。 本文介绍了几种损失函数和正则化项以及正则化对模型的影响。 损失函数 损失函数度量模型一次预测的好坏,风险函数度量平均意义下模型预测的好坏。 模型的输入输出是随机变量(X,Y)遵循联合分布P(X,Y),损失函数的期望是: \[ R_{exp}(

阅读全文

浙公网安备 33010602011771号

浙公网安备 33010602011771号