基于神经网络的图像融合算法

神经网络图像融合基础

核心思想

与传统基于变换域或稀疏表示的融合方法不同,神经网络通过学习大量图像数据中的特征表示,自动提取最适合融合的特征层次,实现更智能、更自适应的图像融合。

主要优势

- 特征自适应性:自动学习最优特征表示

- 端到端学习:直接从输入到输出,无需手动设计复杂规则

- 强泛化能力:适用于多种融合任务和场景

- 保持结构信息:更好地保留源图像的重要结构和纹理

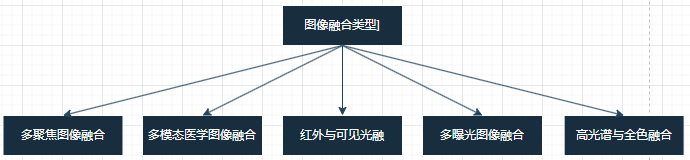

图像融合主要类型

主流神经网络架构

1. 卷积神经网络融合方法

基本CNN融合架构

% 简单的CNN融合网络示例

layers = [

imageInputLayer([256 256 2], 'Name', 'input') % 双输入源图像

convolution2dLayer(3, 64, 'Padding', 'same', 'Name', 'conv1')

reluLayer('Name', 'relu1')

convolution2dLayer(3, 64, 'Padding', 'same', 'Name', 'conv2')

reluLayer('Name', 'relu2')

convolution2dLayer(3, 32, 'Padding', 'same', 'Name', 'conv3')

reluLayer('Name', 'relu3')

convolution2dLayer(3, 1, 'Padding', 'same', 'Name', 'conv4') % 单通道输出

regressionLayer('Name', 'output')

];

2. 自编码器融合方法

自编码器通过编码器提取特征、解码器重建图像,非常适合图像融合任务。

% 自编码器融合网络

function layers = createFusionAutoencoder()

% 编码器部分

encoder = [

imageInputLayer([256 256 1], 'Name', 'input')

convolution2dLayer(5, 32, 'Padding', 'same', 'Name', 'enc_conv1')

reluLayer('Name', 'enc_relu1')

maxPooling2dLayer(2, 'Stride', 2, 'Name', 'enc_pool1')

convolution2dLayer(5, 64, 'Padding', 'same', 'Name', 'enc_conv2')

reluLayer('Name', 'enc_relu2')

maxPooling2dLayer(2, 'Stride', 2, 'Name', 'enc_pool2')

];

% 解码器部分

decoder = [

transposedConv2dLayer(5, 64, 'Stride', 2, 'Cropping', 'same', 'Name', 'dec_deconv1')

reluLayer('Name', 'dec_relu1')

transposedConv2dLayer(5, 32, 'Stride', 2, 'Cropping', 'same', 'Name', 'dec_deconv2')

reluLayer('Name', 'dec_relu2')

convolution2dLayer(1, 1, 'Padding', 'same', 'Name', 'dec_conv_out')

regressionLayer('Name', 'output')

];

layers = [encoder; decoder];

end

3. 生成对抗网络融合方法

GAN通过生成器和判别器的对抗训练,能产生视觉质量更高的融合图像。

% GAN融合框架示例

function [generator, discriminator] = createFusionGAN()

% 生成器

generator = [

imageInputLayer([256 256 2], 'Name', 'gen_input')

convolution2dLayer(5, 64, 'Padding', 'same', 'Name', 'gen_conv1')

leakyReluLayer(0.2, 'Name', 'gen_lrelu1')

convolution2dLayer(5, 128, 'Padding', 'same', 'Name', 'gen_conv2')

leakyReluLayer(0.2, 'Name', 'gen_lrelu2')

convolution2dLayer(5, 64, 'Padding', 'same', 'Name', 'gen_conv3')

leakyReluLayer(0.2, 'Name', 'gen_lrelu3')

convolution2dLayer(5, 1, 'Padding', 'same', 'Name', 'gen_conv_out')

tanhLayer('Name', 'gen_tanh') % 输出范围[-1,1]

];

% 判别器

discriminator = [

imageInputLayer([256 256 1], 'Name', 'dis_input')

convolution2dLayer(5, 64, 'Stride', 2, 'Padding', 'same', 'Name', 'dis_conv1')

leakyReluLayer(0.2, 'Name', 'dis_lrelu1')

convolution2dLayer(5, 128, 'Stride', 2, 'Padding', 'same', 'Name', 'dis_conv2')

leakyReluLayer(0.2, 'Name', 'dis_lrelu2')

convolution2dLayer(5, 256, 'Stride', 2, 'Padding', 'same', 'Name', 'dis_conv3')

leakyReluLayer(0.2, 'Name', 'dis_lrelu3')

fullyConnectedLayer(1, 'Name', 'dis_fc')

sigmoidLayer('Name', 'dis_sigmoid') % 输出真伪概率

];

end

MATLAB实现示例

完整的CNN图像融合流程

classdef NeuralImageFusion

properties

Net

TrainingOptions

end

methods

function obj = NeuralImageFusion()

% 初始化融合网络

obj.Net = obj.createFusionNetwork();

obj.TrainingOptions = obj.setTrainingOptions();

end

function layers = createFusionNetwork(obj)

% 创建深度融合网络

layers = [

imageInputLayer([256 256 2], 'Name', 'input', 'Normalization', 'none')

% 特征提取分支

convolution2dLayer(7, 32, 'Padding', 'same', 'Name', 'conv1')

batchNormalizationLayer('Name', 'bn1')

reluLayer('Name', 'relu1')

convolution2dLayer(5, 64, 'Padding', 'same', 'Name', 'conv2')

batchNormalizationLayer('Name', 'bn2')

reluLayer('Name', 'relu2')

convolution2dLayer(3, 128, 'Padding', 'same', 'Name', 'conv3')

batchNormalizationLayer('Name', 'bn3')

reluLayer('Name', 'relu3')

% 特征融合层

convolution2dLayer(1, 64, 'Padding', 'same', 'Name', 'fusion_conv')

reluLayer('Name', 'fusion_relu')

% 重建层

convolution2dLayer(3, 32, 'Padding', 'same', 'Name', 'recon_conv1')

reluLayer('Name', 'recon_relu1')

convolution2dLayer(3, 1, 'Padding', 'same', 'Name', 'recon_conv2')

regressionLayer('Name', 'output')

];

end

function options = setTrainingOptions(obj)

% 设置训练选项

options = trainingOptions('adam', ...

'InitialLearnRate', 0.001, ...

'MaxEpochs', 50, ...

'MiniBatchSize', 8, ...

'ValidationFrequency', 30, ...

'Plots', 'training-progress', ...

'Verbose', true);

end

function fusedImage = fuseImages(obj, imageA, imageB)

% 图像融合主函数

% 输入预处理

[inputTensor, originalSize] = obj.preprocessImages(imageA, imageB);

% 网络预测

if ~isempty(obj.Net)

outputTensor = predict(obj.Net, inputTensor);

% 后处理

fusedImage = obj.postprocessOutput(outputTensor, originalSize);

else

error('网络未训练,请先训练模型');

end

end

function [inputTensor, originalSize] = preprocessImages(obj, imgA, imgB)

% 图像预处理

originalSize = size(imgA);

% 调整尺寸为网络输入大小

imgA_resized = imresize(imgA, [256 256]);

imgB_resized = imresize(imgB, [256 256]);

% 归一化

imgA_norm = double(imgA_resized) / 255.0;

imgB_norm = double(imgB_resized) / 255.0;

% 创建输入张量 [H, W, 2]

inputTensor = cat(3, imgA_norm, imgB_norm);

inputTensor = reshape(inputTensor, [1, 256, 256, 2]);

end

function outputImage = postprocessOutput(obj, outputTensor, originalSize)

% 输出后处理

outputImage = squeeze(outputTensor);

outputImage = imresize(outputImage, originalSize(1:2));

outputImage = uint8(outputImage * 255);

end

function trainModel(obj, trainingData, validationData)

% 训练融合模型

fprintf('开始训练图像融合网络...\n');

% 这里需要准备训练数据

% trainingData: 包含源图像对和参考融合图像

% 示例训练代码

% trainedNet = trainNetwork(trainingData, obj.Net, obj.TrainingOptions);

% obj.Net = trainedNet;

fprintf('训练完成!\n');

end

end

end

使用示例

% 初始化融合系统

fusionSystem = NeuralImageFusion();

% 加载待融合图像

img1 = imread('source1.jpg');

img2 = imread('source2.jpg');

% 确保图像为灰度图

if size(img1, 3) == 3

img1 = rgb2gray(img1);

end

if size(img2, 3) == 3

img2 = rgb2gray(img2);

end

% 执行融合

fusedImg = fusionSystem.fuseImages(img1, img2);

% 显示结果

figure;

subplot(1, 3, 1); imshow(img1); title('源图像1');

subplot(1, 3, 2); imshow(img2); title('源图像2');

subplot(1, 3, 3); imshow(fusedImg); title('融合结果');

评估指标与损失函数

常用融合质量评估指标

function metrics = evaluateFusionQuality(fusedImg, srcImg1, srcImg2)

% 计算多种融合质量指标

% Q_AB/F: 基于梯度的融合质量

Q_ABF = calculateQabf(fusedImg, srcImg1, srcImg2);

% 互信息

MI = calculateMutualInformation(fusedImg, srcImg1, srcImg2);

% 结构相似性

SSIM1 = ssim(fusedImg, srcImg1);

SSIM2 = ssim(fusedImg, srcImg2);

% 特征相似性

FSI = calculateFeatureSimilarity(fusedImg, srcImg1, srcImg2);

metrics = struct(...

'Q_ABF', Q_ABF, ...

'MutualInformation', MI, ...

'SSIM1', SSIM1, ...

'SSIM2', SSIM2, ...

'FeatureSimilarity', FSI);

end

自定义损失函数

function loss = fusionLossFunction(Y, T, src1, src2)

% 融合专用损失函数

% Y: 网络输出, T: 目标(如果有), src1, src2: 源图像

% 强度一致性损失

intensity_loss = mse(Y, (double(src1) + double(src2)) / 2);

% 梯度保留损失

[Gx1, Gy1] = imgradientxy(src1);

[Gx2, Gy2] = imgradientxy(src2);

[Gx_f, Gy_f] = imgradientxy(Y);

gradient_loss = 0.5 * (mse(Gx_f, max(Gx1, Gx2)) + mse(Gy_f, max(Gy1, Gy2)));

% 结构相似性损失

ssim_loss1 = 1 - ssim(Y, src1);

ssim_loss2 = 1 - ssim(Y, src2);

ssim_loss = 0.5 * (ssim_loss1 + ssim_loss2);

% 总损失

alpha = 0.4; beta = 0.4; gamma = 0.2;

loss = alpha * intensity_loss + beta * gradient_loss + gamma * ssim_loss;

end

参考代码 基于神经网络的图像融合算法 www.youwenfan.com/contentcnl/78330.html

进阶技术与研究方向

1. 注意力机制融合

% 注意力机制示例

attention_layer = [

convolution2dLayer(1, 1, 'Padding', 'same', 'Name', 'attention_conv')

softmaxLayer('Name', 'attention_softmax') % 生成注意力权重

% 与特征图相乘实现注意力加权

];

2. 多尺度融合网络

- 金字塔结构处理不同尺度特征

- U-Net-like 编码器-解码器架构

- 残差连接保持细节信息

3. 零样本/少样本融合

- 无需大量训练数据的融合方法

- 基于预训练模型的迁移学习

- 元学习快速适应新融合任务

实用建议

- 数据准备:收集多样化的图像对进行训练

- 网络选择:根据具体应用选择合适的架构复杂度

- 损失函数设计:结合多种质量指标设计综合损失

- 评估验证:使用客观指标和主观评价相结合

- 实时性考虑:根据应用场景平衡精度和速度

基于神经网络的图像融合技术在医学影像、遥感、安全监控等领域都有广泛应用前景。随着深度学习技术的发展,这一领域仍在快速演进中。

浙公网安备 33010602011771号

浙公网安备 33010602011771号