随笔分类 - 机器学习

1

摘要:核技巧使用核函数直接计算两个向量映射到高维后的内积,从而避免了高维映射这一步。本文用矩阵的概念介绍核函数$K(x,y)$的充分必要条件:对称(半)正定。 对称正定看起来像是矩阵的条件。实际上,对于函数$K(x,y):\R^n\times \R^m\rightarrow \R$,将向量$x\in \R

阅读全文

摘要: 孤立森林(Isolation Forest)是经典的异常检测算法(论文网址)。本文用python对其进行实现,以及与常用的异常检测包PyOD进行效果对比。 简单来说,孤立森林(IForest)中包含若干孤立树(ITree),每颗树的创建是独立的,与其它树无关。假设数据集包含$n$个样本,每个样本都包

阅读全文

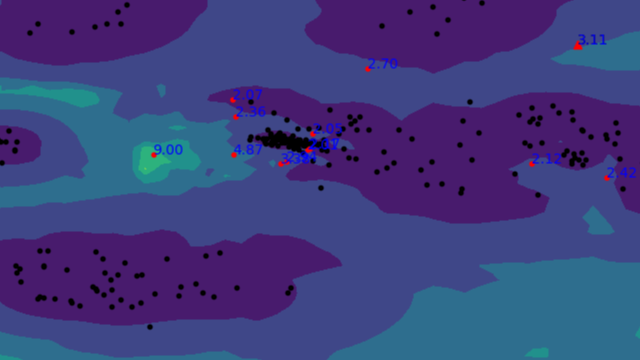

孤立森林(Isolation Forest)是经典的异常检测算法(论文网址)。本文用python对其进行实现,以及与常用的异常检测包PyOD进行效果对比。 简单来说,孤立森林(IForest)中包含若干孤立树(ITree),每颗树的创建是独立的,与其它树无关。假设数据集包含$n$个样本,每个样本都包

阅读全文

孤立森林(Isolation Forest)是经典的异常检测算法(论文网址)。本文用python对其进行实现,以及与常用的异常检测包PyOD进行效果对比。 简单来说,孤立森林(IForest)中包含若干孤立树(ITree),每颗树的创建是独立的,与其它树无关。假设数据集包含$n$个样本,每个样本都包

阅读全文

孤立森林(Isolation Forest)是经典的异常检测算法(论文网址)。本文用python对其进行实现,以及与常用的异常检测包PyOD进行效果对比。 简单来说,孤立森林(IForest)中包含若干孤立树(ITree),每颗树的创建是独立的,与其它树无关。假设数据集包含$n$个样本,每个样本都包

阅读全文

摘要: 局部异常因子(Local Outlier Factor, LOF)通过计算样本点的局部相对密度来衡量这个样本点的异常情况,可以算是一类无监督学习算法。下面首先对算法的进行介绍,然后进行实验。 LOF算法 下面介绍LOF算法的每个概念,以样本点集合中的样本点$P$为例。下面的概念名称中都加了一个k-,

阅读全文

局部异常因子(Local Outlier Factor, LOF)通过计算样本点的局部相对密度来衡量这个样本点的异常情况,可以算是一类无监督学习算法。下面首先对算法的进行介绍,然后进行实验。 LOF算法 下面介绍LOF算法的每个概念,以样本点集合中的样本点$P$为例。下面的概念名称中都加了一个k-,

阅读全文

局部异常因子(Local Outlier Factor, LOF)通过计算样本点的局部相对密度来衡量这个样本点的异常情况,可以算是一类无监督学习算法。下面首先对算法的进行介绍,然后进行实验。 LOF算法 下面介绍LOF算法的每个概念,以样本点集合中的样本点$P$为例。下面的概念名称中都加了一个k-,

阅读全文

局部异常因子(Local Outlier Factor, LOF)通过计算样本点的局部相对密度来衡量这个样本点的异常情况,可以算是一类无监督学习算法。下面首先对算法的进行介绍,然后进行实验。 LOF算法 下面介绍LOF算法的每个概念,以样本点集合中的样本点$P$为例。下面的概念名称中都加了一个k-,

阅读全文

摘要:图神经网络(GNN)目前的主流实现方式就是节点之间的信息汇聚,也就是类似于卷积网络的邻域加权和,比如图卷积网络(GCN)、图注意力网络(GAT)等。下面根据GCN的实现原理使用Pytorch张量,和调用torch_geometric包,分别对Cora数据集进行节点分类实验。 Cora是关于科学文献之

阅读全文

摘要:隐马尔可夫模型(Hidden Markov Model, HMM)是可用于标注问题的模型,描述由隐藏的马尔可夫链随机生成观测序列的过程,属于生成模型。马尔可夫链不懂的可以把本科的《概率论与数理统计》找回来看一下,并不难,就是离散状态之间的转换。下面直接定义基本概念,为后面的算法做准备。 基本概念 变

阅读全文

摘要:EM算法是一种迭代算法,用于含有隐变量的概率模型参数的极大似然估计。 使用EM算法的原因 首先举李航老师《统计学习方法》中的例子来说明为什么要用EM算法估计含有隐变量的概率模型参数。 假设有三枚硬币,分别记作A, B, C。这些硬币正面出现的概率分别是$\pi,p,q$。进行如下掷硬币试验:先掷硬币

阅读全文

摘要:K均值聚类是一种无监督学习分类算法。 介绍 对于$n$个$m$维特征的样本,K均值聚类是求解最优化问题: $\displaystyle C^*=\text{arg}\min\limits_{C}\sum\limits_{l = 1}^K\sum\limits_{x\in C_l}||x-x_l||^

阅读全文

摘要:PCA 主成分分析(Principal Components Analysis, PCA)是一种降维方法。假设数据集$X\in R^{n\times m}$包含$n$条$m$维数据,PCA即实现线性映射$Y=XD\in R^{n\times k}$。其中矩阵$D\in R^{m\times k},k

阅读全文

摘要:最基本的SVM(Support Vector Machine)旨在使用一个超平面,分离线性可分的二类样本,其中正反两类分别在超平面的一侧。SVM算法则是要找出一个最优的超平面。 下面从简单到复杂介绍三种SVM形式,然后介绍一种快速优化SVM的算法,最后用SVM实现人脸识别。 线性可分SVM 优化函数

阅读全文

摘要:在带等式和不等式约束的优化问题,可用拉格朗日对偶性将原始问题转换为对偶问题求解。 广义拉格朗日函数 称最优化问题 $\begin{equation} \begin{array}{lcl} \min\limits_{x\in R^n} f(x)\\ \begin{aligned} \text{s.t.

阅读全文

摘要:马尔可夫不等式 结论 对于任意非负随机变量$X$,$\forall \epsilon>0$,有: $\displaystyle P(X\ge\epsilon)\le\frac{E(X)}{\epsilon}$ 切比雪夫不等式是它的特例。 证明 $ \begin{align*} E(X) &= \in

阅读全文

摘要:基本流程 决策树是通过分次判断样本属性来进行划分样本类别的机器学习模型。每个树的结点选择一个最优属性来进行样本的分流,最终将样本类别划分出来。 构建决策树的关键是分流时最优属性$a$的选择。使用所谓信息增益$Gain(D,a)$来判别不同属性的划分性能,即划分前样本类别的信息熵,减去划分后样本类别的

阅读全文

摘要:介绍与推导 LDA是线性判别分析的英文缩写,该方法旨在通过将多维的特征映射到一维来进行类别判断。映射的方式是将数值化的样本特征与一个同维度的向量做内积,即: $y=w^Tx$ 因此,建立模型的目标就是找到一个最优的向量,使映射到一维后的不同类别的样本之间“距离”尽可能大,而同类别的样本之间“距离”尽

阅读全文

摘要:核密度估计,或称Parzen窗,目标是利用离散的数据本身拟合出一个连续的分布,属于非参数估计。所谓非参数估计,即该估计并没有预设某种分布函数来对其参数进行求解或拟合,比如机器学习中K近邻法也是非参估计的一种。 直方图 首先从直方图切入。对于随机变量$X$的一组抽样,即使$X$的值是连续的,我们也可以

阅读全文

摘要:简介 统计学习,或者说机器学习的方法主要由监督学习、无监督学习和强化学习组成(它们是并列的,都属于统计学习方法)。 统计学习方法要素 1、假设数据独立同分布。(同数据源的不同样本之间相互独立) 2*、假设要学习的模型属于某个函数的集合,称为假设空间。(你确定了这个函数的样式,就是假设空间,但是函数里

阅读全文

摘要:衡量模型泛化能力的标准就是性能能度量(performance measure)。以下分为两种任务进行记录。 回归任务 均方误差 回归任务最常用的性能度量就是均方误差(mean squared error),即: $\displaystyle E(f;\mathcal{D}) = \frac{1}{m

阅读全文

摘要:朴素贝叶斯法,就是使用贝叶斯公式的学习方法,朴素就是它假设输入变量(向量)的各个分量之间是相互独立的。所以对于分量之间不独立的分布,如果使用它学习和预测效果就不会很好。 简化策略 它是目标是通过训练数据集学习联合概率分布$P(X, Y)$用来预测。书上说,具体是先学习到先验概率分布以及条件概率分布,

阅读全文

摘要:下面介绍的各种熵尽管都与数据分布的混乱度相关,但是建议把相对熵(KL散度)和交叉熵单独拿出来理解。交叉熵和相对熵是针对同一个随机变量,它们是机器学习里额外定义的用来评估两个分布差异的方式,无法用韦恩图进行观察;而后面的条件熵等则是针对不同的随机变量之间的关系(可以看完本文再回来看这句话)。 信息熵

阅读全文

摘要:回归是指拟合函数的模型、图像等。与分类不同,回归一般是在函数可微的情况下进行的。因为分类它就那么几类,如果把类别看做函数值的话,分类的函数值是离散的,而回归的函数值通常是连续且可微的。所以回归可以通过梯度下降法来进行。 比如对于函数$y =b + wx$,$x$是输入变量,$w$和$b$是参数。可以

阅读全文

摘要:李航老师书上的的算法说明没怎么看懂,看了网上的博客,悟出一套循环(建立好KD树以后的K近邻搜索),我想应该是这样的(例子是李航《统计学习算法》第三章56页;例3.3): 步骤 结点查询标记 栈内元素(本次循环结束后) 最近点 最近距离 说明 A B C D E F G 初始化 0 0 0 0 0 0

阅读全文

1

浙公网安备 33010602011771号

浙公网安备 33010602011771号