跨越“仿真到实车”的鸿沟:如何构建端到端高置信度验证体系?

01 引言

随着自动驾驶功能复杂度的指数级增长,单纯依赖道路测试进行验证的成本高昂、周期漫长且无法穷尽所有可能的边缘场景。仿真测试因此成为研发流程中不可或缺的一环,它能够以低成本、高效率的方式大规模生成和复现高风险的“边缘案例”与“关键场景”,从而加速算法的迭代与验证。

然而,仿真的价值完全取决于其结果的置信度。一个高置信度的仿真平台,其输出应在统计意义上与真实世界的传感器数据、车辆行为和环境交互保持一致。若仿真与现实存在显著偏差,那么基于仿真得出的结论将失去意义,甚至产生误导。

因此,建立一套能够量化和缩小这一差距的体系,是当前自动驾驶研发面临的关键挑战。本文将从工程实践出发,系统性地剖析仿真置信度的三大核心挑战:传感器模型偏差、静态场景失真和动态场景还原误差,深入分析误差来源,提出可量化指标和对齐流程,为构建高置信度仿真提供参考。

02仿真技术置信度的三大核心挑战

1、传感器模型偏差

传感器是连接虚拟世界与感知算法的桥梁,其模型的保真度直接决定了仿真数据的有效性。偏差主要来源于对复杂物理过程的简化建模。

(1)相机模型

偏差主要来自光谱、光学系统和成像流水线(ISP)的建模不准确。

光谱与材质偏差:真实世界的光源拥有连续的光谱功率分布(SPD),而物体材质则由复杂的光谱双向反射分布函数(BRDF/BSDF)定义。传统仿真渲染常使用RGB三通道简化光谱,这会导致在特定光源(如LED频闪、钠灯)下,物体呈现的颜色和亮度与真实世界严重不符。

例如,两种材质在日光下颜色相近(同色异谱),但在车库的荧光灯下可能呈现显著差异,RGB渲染无法复现此现象。

光学与ISP偏差:镜头的光学像差(色差、畸变)、光晕、鬼影以及传感器噪声(光子噪声、读出噪声)等物理效应,对感知算法的稳定性至关重要。此外,ISP流水线中的自动曝光、白平衡、色彩校正矩阵(CCM)和色调映射等模块,其处理逻辑与真实硬件的差异,会导致最终输出图像在对比度、色彩饱和度等方面存在系统性偏差。

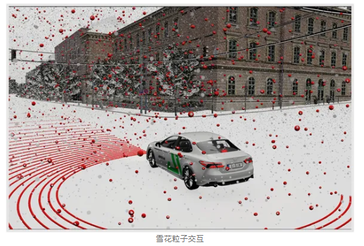

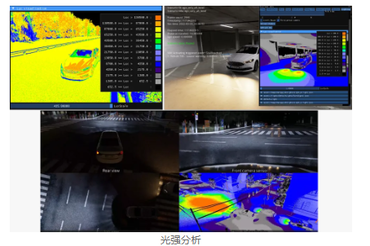

(2)激光雷达(LiDAR)模型

偏差主要来自激光衰减、多径反射和返回强度建模。

激光在与不同材质表面交互时,其能量衰减、漫反射和镜面反射特性各不相同。仿真若未能精确建模材质的反射率与激光波长的关系,将导致点云强度信息失真,影响基于强度的目标分类算法。同时,激光在复杂结构(如角落、潮湿路面)中的多径效应会产生伪影点,干扰障碍物检测。

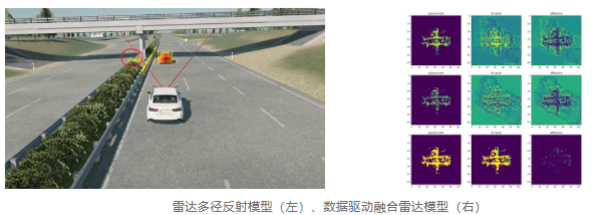

(3)雷达(Radar)模型

物理建模与数据驱动建模的挑战:雷达仿真模型通常分为两大类:基于物理的(如光线追踪)和数据驱动的(如基于神经网络)。光线追踪模型的核心挑战在于雷达截面积(RCS)的精确建模和多径效应的仿真。目标的RCS与几何形状、材质介电常数、入射角和频率强相关,简化模型会导致目标可探测性失真。

神经网络模型则利用其他传感器(如Camera、LiDAR)的融合信息来预测雷达检测结果,其置信度高度依赖于训练数据的质量和覆盖度,并面临仿真输入与真实输入间的域偏移问题。

验证的根本难题:真实雷达传感器的输出作为参考基准,本身受到偶然不确定性和认知不确定性的显著影响。此外,由于终端用户通常无法获取原始射频信号,验证工作只能基于信号处理后的数据,如点云(Point Cloud)或目标列表(Object List),这增加了验证的复杂性。因此,验证的核心不再是确定性地比较,而是评估仿真数据与真实数据在统计分布上的一致性。

2、静态场景模型偏差

静态场景为自动驾驶提供了地理空间基准,其几何、材质和光照的失真会直接影响感知和定位的可靠性。

(1)误差来源及其对感知的影响

这些误差主要源于几何、材质与光照的失真,并直接影响感知与定位算法的可靠性。

几何误差:道路的曲率、坡度、路缘石高度等几何元素的毫米级偏差,可能导致定位算法的漂移或规划模块的决策失误。

-

材质误差:主要体现在物理渲染(PBR)参数(如基础色、粗糙度、金属度)与真实世界的不符。ASAM OpenMATERIAL等标准的出现,旨在通过标准化物理材质属性(如折射率、表面粗糙度)来减少这类偏差[1]。

-

光照误差:自然光模型需考虑太阳位置、大气散射(瑞利/米氏散射)的物理过程。人造光源则需依赖标准的IES光域网文件来描述其空间光强分布。光照模型偏差会导致场景中的阴影、高光分布失真,干扰依赖视觉特征的算法。

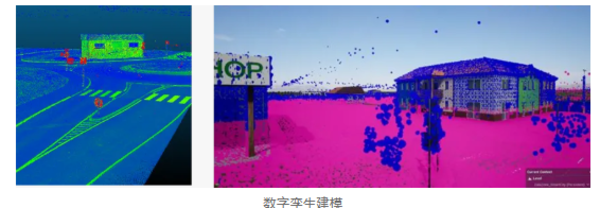

(2)基于真值(GT)通道的误差评估与新兴重建技术

为量化上述误差,业界主要依托GT通道进行精准评估,并运用NeRF/GS等新兴技术进行高保真重建

GT通道的作用:仿真环境可以生成完美的像素级真值数据,如深度图、法线图、语义分割图等。通过对比真实传感器采集的深度数据与仿真渲染的深度图,可以精确评估场景的几何误差(MAE/RMSE)。

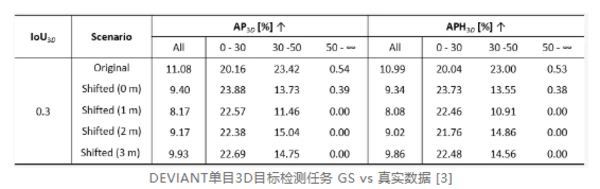

神经辐射场(NeRF)/高斯溅射(GS)技术的应用与验证:NeRF/GS等神经渲染技术能够从多视角图像中重建出高逼真的三维场景,极大地提升了场景的真实感和重建效率[2]。但其置信度同样需要严格验证:

精度评估:通过与高精度激光扫描仪采集的地面真实点云进行对比,评估NeRF/GS重建场景的几何精度(点云RMSE)[3].

对齐方法:将重建场景与车载高精地图(HD Map)进行坐标对齐,确保语义元素(车道线、交通标志)位置一致。

验证流程:在重建场景的虚拟相机位姿下,渲染图像并与拍摄的真实照片进行光照一致性对比,使用PSNR、SSIM等图像质量指标进行量化评估。同时,验证其在多模态传感器(相机+LiDAR)下的一致性。

3、动态场景还原偏差

动态场景的挑战在于时空四维的精确复现,误差来源更加复杂,涉及数据采集、轨迹重建和行为建模等多个环节。

(1)动力学误差来源

车辆动力学建模偏差:仿真中的车辆行为不仅依赖于轨迹,还依赖于动力学模型的响应 [4] 。简化的动力学模型(如点质量模型)无法准确复现轮胎滑移、悬挂运动等特性,导致在极限工况(如紧急避障)下,车辆的加速度、横摆角速度响应与真实车辆不符,使得TTC(碰撞时间)、制动距离等关键安全指标失信。

(2)交通流与交互行为失真

轨迹重建误差:从真实路采数据中提取的交通参与者轨迹,其精度受限于定位系统的漂移(如GPS/IMU融合误差)、感知算法的检测与跟踪误差、以及数据采样频率不足。低频或带噪的轨迹会导致关键交互(如切入、刹车)的时序失真。

微观交互行为失真:在闭环测试中,简单的回放轨迹无法复现真实交通中智能体之间的双向互动。例如,仿真中一辆Exo按照预设轨迹切入,Ego即使做出避让,该Exo也不会像真人驾驶员一样做出二次反应。这种缺乏交互性的行为模型导致场景的真实感下降,在测试自车的博弈和决策能力时效果欠佳[5]。

宏观交通分布失真:重建的交通流可能在宏观统计特征上与现实世界不符。例如,仿真场景中的车速分布、车头时距分布、车型比例等,如果与特定道路(如城市快速路)在特定时段(如晚高峰)的真实数据存在显著差异,那么在该场景下进行的测试将失去统计学意义[6]。

(3)硬件在环与同步性要求

时延与同步:在硬件在环(HIL)测试中,多传感器的渲染时钟、数据传输链路的时延和时间戳必须严格同步。毫秒级的时钟不同步或数据包丢失,就可能导致多传感器融合算法在关键时刻故障,无法有效复现真实世界中的融合感知问题。

(4)环境动态行为与验证指标

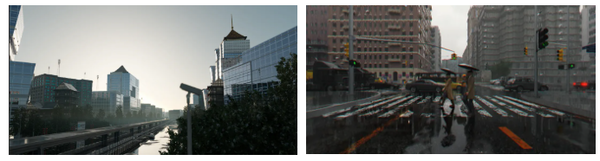

天气/光照:动态变化的天气(如雨量变化、雾气浓度)和光照,需要基于物理模型进行仿真,并通过与真实光照测量数据对比进行验证。

03 高置信度仿真测试技术路径

应对上述三大挑战,需要构建一个分层、闭环的验证体系,从传感器、静态场景到动态场景,逐级确保保真度并建立可信的量化评估流程。

1、物理高保真传感器建模

目标是基于物理渲染方程,无限缩小仿真数据与真实传感器原始数据之间的差距。其中确保渲染引擎遵循光线渲染方程,有效描述光能在场景中的传播和反射物理规律。

高保真建模意味着渲染器必须支持光谱渲染,并使用基于实测数据的BRDF/BSDF材质库,以确保光线与材质交互的物理正确性。

(1)分层验证方法与模型对齐

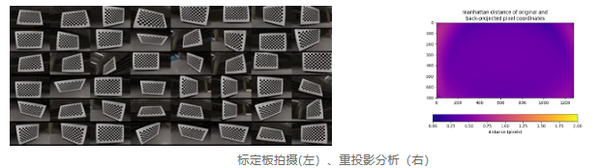

指标定义:几何一致性:重投影误差,用于评估相机内参及畸变模型的准确性,工程标准通常要求低于0.5像素。

色彩一致性:色差(ΔE2000),用于量化仿真与真实图像在标准色卡下的色彩偏差,目标通常是平均ΔE<3。

光度一致性:像素强度直方图统计差异,评估亮度、对比度等分布。

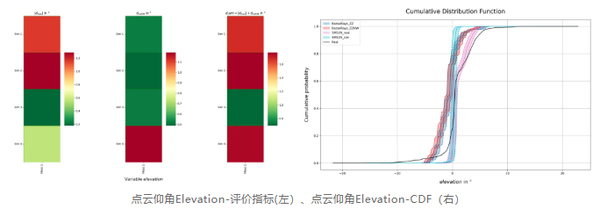

统计学指标:鉴于LiDAR和Radar输出的随机性和对环境的敏感性,验证应转向统计学方法,采用如Kolmogorov-Smirnov检验、Kullback-Leibler (KL) / Jensen-Shannon (JS) 散度[7]等

(2)标准化验证流程:

环境搭建:在受控光照环境(如光学暗室)和真实户外场景中,分别放置标准棋盘格、Macbeth色卡,或在可复现的真实环境中(如测试场的高速路段)设计特定场景(如空旷道路巡航、前车跟随),在仿真环境中精确复现该场景(包括车辆轨迹、道路几何与材质)。

数据采集:使用真实传感器和仿真传感器模型,在完全相同的内外参(位置、姿态)下标定和采集数据。

误差分析:计算上述定义的量化指标,分析仿真与真实数据的偏差

模型迭代:在RAW数据层面对齐噪声模型。对于相机模型来说,基于色卡和CCM校准流程,逐一验证ISP模块(如白平衡、去马赛克、色彩校正)的输出。

2、静态场景高保真重建与验证

目标是确保场景在几何、材质和光照三个维度上与现实世界一致。

(1)工程化验证流程

PBR材质要求:材质库应基于测量数据,并遵循如ASAM OpenMATERIAL等标准,确保不同仿真平台间的一致性。

(2)光照模型验证:

流程:在真实场景的关键位置使用照度计测量光照强度,并与仿真环境中对应点的渲染结果对比。对于人造光源,必须使用其IES文件进行建模。

指标:照度(Lux)误差,目标偏差通常要求低于10-15%。

(3)GS/NeRF场景验证:

几何误差:使用LiDAR点云作为地面真理,计算重建场景的几何RMSE。

光照一致性:在场景中放置虚拟的、已标定的相机模型,渲染图像并与真实照片对比(PSNR/SSIM)。

多模态一致性:基于下游感知任务验证从重建场景中生成的相机图像和LiDAR点云是否在空间和语义上保持一致。

3、动态场景高置信度还原

目标是实现交通流和关键交互行为在时空维度上的精确复现。

(1)数据驱动的轨迹与行为重建

多传感器同步:在数据采集阶段,必须使用高精度时钟同步方案(如PTP/gPTP协议)保证所有传感器(GPS/IMU, LiDAR, Camera)的时间戳在亚毫秒级对齐。

宏观轨迹重建:利用多传感器融合与平滑滤波算法(如Kalman滤波),从带噪的原始数据中重建出高频(如100Hz)、平滑且物理可信的轨迹[8],从而重建出特定路段的交通流。

微观智能体模型:这些模型可以根据场景上下文(如地图信息、其他车辆状态)进行条件化生成,从而实现智能体之间的闭环交互。例如,Waymo提出的Sim Agent[9]等模型,旨在学习一种能够对其他智能体行为和Ego车规划做出真实反应的策略.

(2)置信度验证方法与模型对齐

指标定义:轨迹精度:与高精度真值轨迹对比,计算RMSE、MAE等指标,工程标准通常要求关键场景下轨迹误差<10厘米。

时序指标:TTC、THW(车头时距)偏差分析,确保交互行为的时序一致性。

行为一致性:对比仿真与真实场景中车辆的关键行为决策点(如变道发起时刻、刹车点)是否一致。

交通流参数对比:在特定路段,对比仿真的交通流量(veh/h)、平均速度和密度是否与真实世界的观测数据(如来自线圈检测器的数据)匹配。

场景多样性与稀有事件频率:评估仿真平台生成“边缘场景”的能力,并验证这些关键场景出现的频率是否符合真实世界的统计规律,避免过度生成或缺失

统计建模:对于无法精确复现的随机行为(如行人意图),可采用统计建模方法,确保其行为分布在统计上与真实世界一致,并使用置信区间(CI)、偏差(Bias)和方差(Variance)来评估模型置信度。

(3)标准化验证流程:

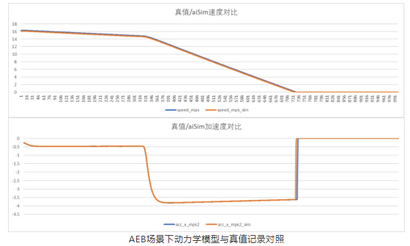

环境搭建:在测试场进行标准的车辆动力学测试(如双移线、阶跃转向)。

数据采集:记录车辆的输入(方向盘转角、制动压力)和状态输出(车速、加速度、横摆角速度)。

数据分析:在仿真中输入相同的控制序列,对比仿真动力学模型的输出与实车数据的差异。

模型迭代:调整动力学模型参数(如轮胎魔术公式参数、悬挂刚度),直到仿真与实测的响应曲线RMSE在预设范围内(如横摆角速度误差<5%)[10]。

系统精度验证:在HIL环境中,端到端测量从仿真场景生成到ECU接收到信号的总时延,确保其满足实时性要求,并通过对比原始路采数据和回放数据,验证行为的一致性。

统计学置信度评估:对于某些随机性强、难以精确复现的场景,可采用生成式模型或统计分布来描述其行为。通过大规模蒙特卡洛仿真,评估系统在这些随机扰动下的性能表现,并以统计指标(如失效概率、置信区间)来衡量验证结果的置信度

04 构建持续迭代的可验证仿真体系

实现高置信度的自动驾驶仿真并非一蹴而就的技术集成,而是一个持续迭代、系统化的工程过程。它要求我们从物理第一性原理出发,深刻理解每一个环节的误差来源,并为之设计可量化的验证指标和标准化的闭环验证流程。

本文提出的“三大挑战”与“三大技术路径”框架,旨在将抽象的“置信度”概念,分解为一系列具体的、可执行的工程任务。通过对传感器、静态场景和动态场景进行分层验证与模型对齐,我们可以逐步缩小仿真与现实之间的差距,最终构建一个物理可信、数据可依、工程可用的高置信度仿真验证体系。只有这样的体系,才能真正成为加速自动驾驶技术安全落地、提升研发效率的核心驱动力。

基于物理级的传感器模型、高精度的自研渲染引擎与 GS 场景重建技术,aiSim 能够精准还原真实传感器输入和复杂道路环境,并通过自适应场景泛化能力实现对不同城市、天气与光照条件的稳定迁移。依托这套可验证的物理一致性框架,aiSim 有效缩小了仿真与现实之间的差距,构建了可工程落地的高置信度仿真体系。

▍参考文献

[1] https://www.asam.net/standards/detail/openmaterial/

[2] https://arxiv.org/abs/2503.09464

[3] https://arxiv.org/html/2402.13255v2#S4

[4] https://www.tandfonline.com/doi/abs/10.1080/00423114.2013.868500

[5] https://arxiv.org/pdf/1910.03088

[6] https://ieeexplore.ieee.org/document/10186531

[7] https://tuprints.ulb.tu-darmstadt.de/23034/

[8] https://www.archivesoftransport.com/index.php/aot/article/view/796?articlesBySameAuthorPage=4

[9] https://arxiv.org/abs/2508.07453

[10] https://motorsportengineer.net/5-infallible-methods-to-validate-vehicle-dynamics-testing/

浙公网安备 33010602011771号

浙公网安备 33010602011771号