摘要:

吴恩达 Andrew Ng 的视频教程“改善深层神经网络:超参数调试、正则化以及优化”,主要介绍: 如何有效的运作神经网络,内容涉及超参数调优,如何构建数据,以及如何确保优化算法快速运行,从而使学习算法在合理时间内完成自我学习。 下面是笔记的索引: 第一周: 深度学习的实用层面 1.1 训练/开发/ 阅读全文

posted @ 2018-04-04 09:27

hejunlin

阅读(388)

评论(0)

推荐(0)

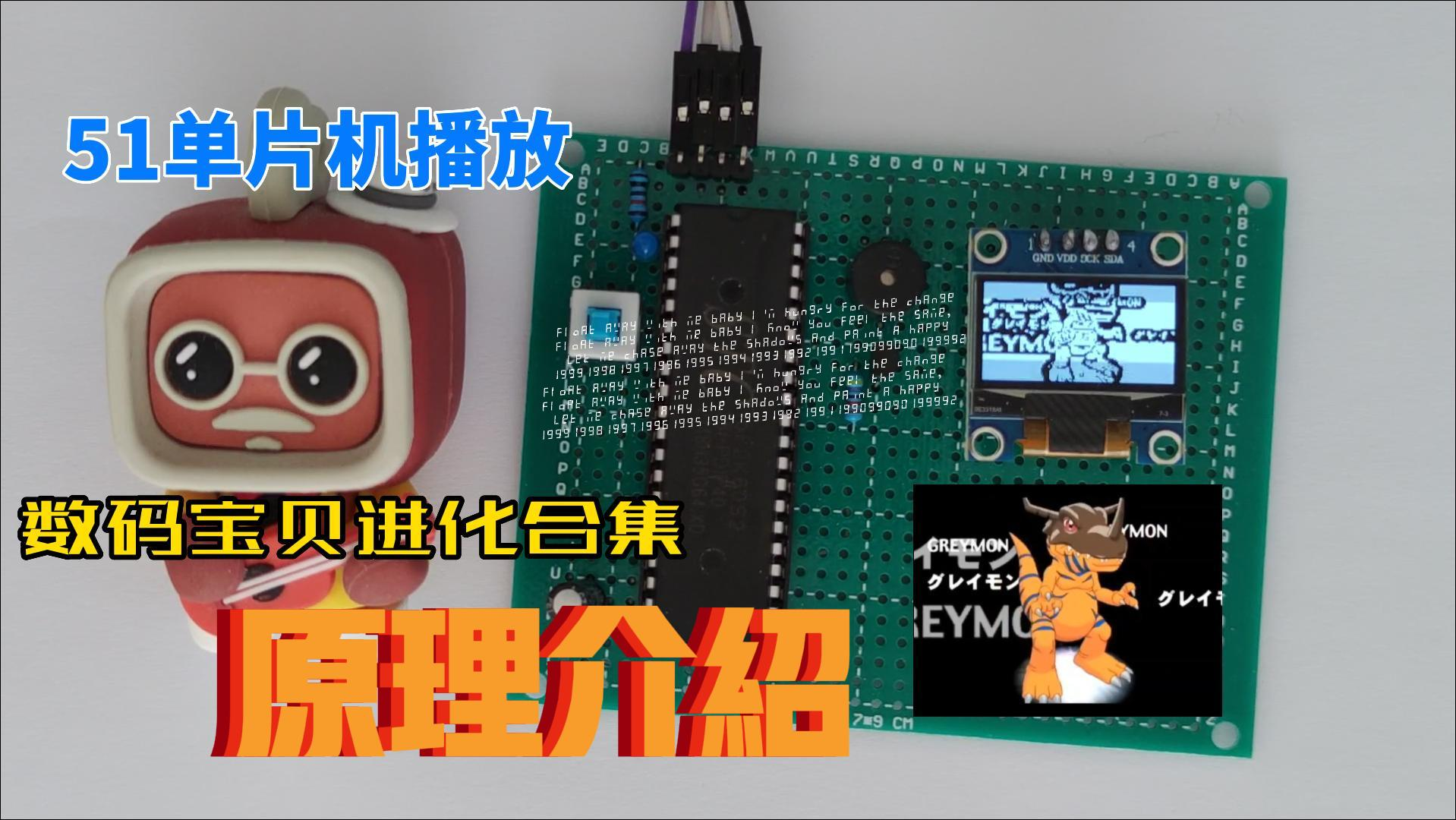

介绍 本文介绍在51单片机上,使用OLED12864(SSD1306)播放视频,并且使用蜂鸣器播放音乐。 (因为是gif的原因,看着会比较卡,实际上是不会有卡顿的,实际效果可以看文末的视频链接) 最终的效果如下: 播放bad apple的效果: 播放数码宝贝的效果: 使用到的主要元器件如下: 国产5

介绍 本文介绍在51单片机上,使用OLED12864(SSD1306)播放视频,并且使用蜂鸣器播放音乐。 (因为是gif的原因,看着会比较卡,实际上是不会有卡顿的,实际效果可以看文末的视频链接) 最终的效果如下: 播放bad apple的效果: 播放数码宝贝的效果: 使用到的主要元器件如下: 国产5  浙公网安备 33010602011771号

浙公网安备 33010602011771号