(cvpr25) Spiking Transformer with Spatial-Temporal Attention

(cvpr25) Spiking Transformer with Spatial-Temporal Attention

1、研究动机

脉冲神经网络(SNN)凭借其类生物特性和稀疏二进制计算的能量高效性,成为传统人工神经网络的重要替代方案。近年来,研究人员将 Transformer 的自注意力机制引入 SNN,如Spikformer,在目标跟踪、计算机视觉等任务中取得进展。这类架构通过二进制化QKV计算并去除复杂的 Softmax 操作,保留了 SNN 的能量优势。

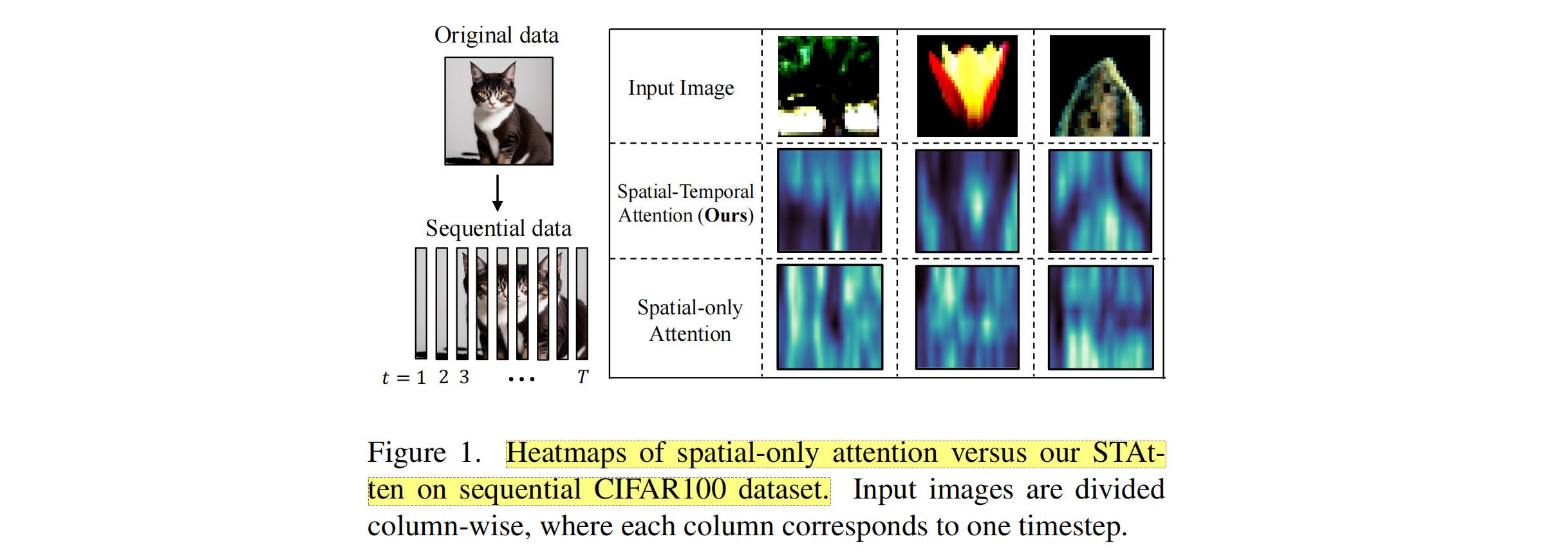

现有脉冲 Transformer 存在关键缺陷:仅关注空间注意力,忽略了脉冲信号固有的时间依赖性。脉冲信号是离散的、随时间动态变化的,但现有方法仅在单个时间步内建模 token 间的空间关系,导致特征表示不完整,性能受限。如下图所示,在时序化 CIFAR100 数据集上,纯空间注意力无法捕捉跨时间步演化的目标特征。

2、 STAtten 机制

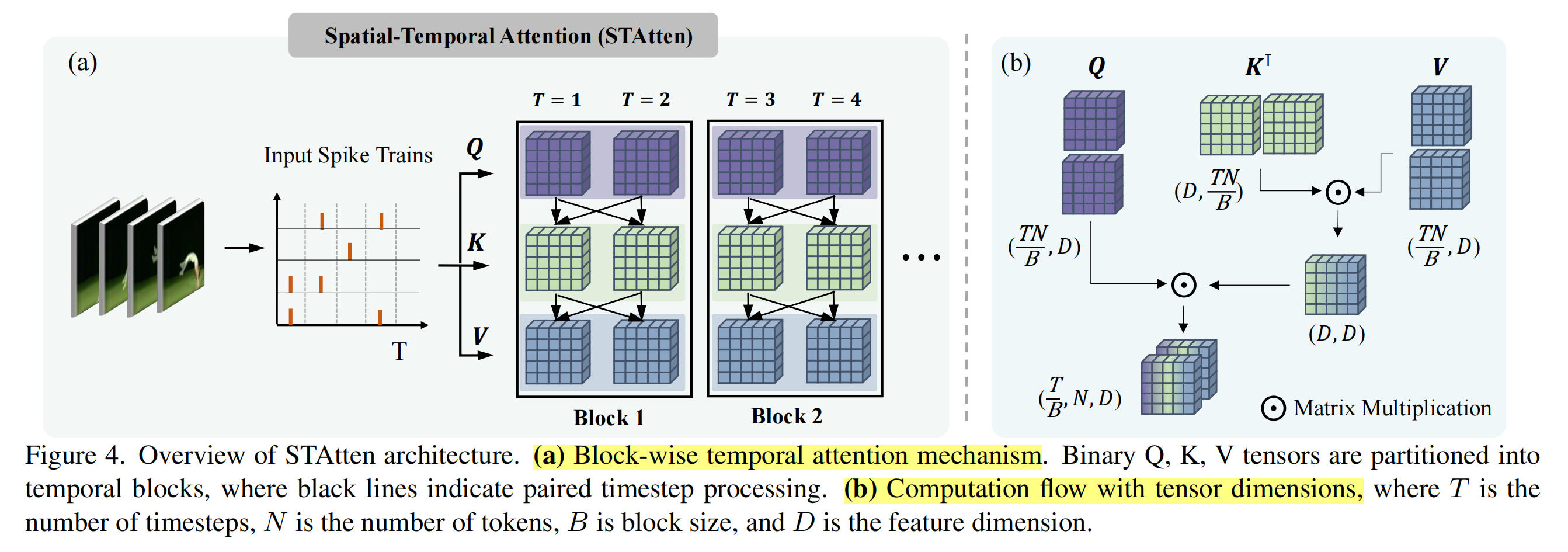

为在不增加计算复杂度和内存开销的前提下,融合时空信息, 作者提出了STAtten机制,主要创新为:块级时间划分 + 非 Softmax 计算重排序。整体流程如下图所示。

块级时空划分: 将时间序列划分为大小为B的块,仅在块内建模时空依赖,解决了全时空注意力的两个问题:1)内存开销,矩阵运算规模从(TN,D)缩小到(TN/B,D)。2)无效神经元,时间距离过远的脉冲信号相关性弱,块内局部时间关联可减少无效神经元。

计算流程: 1、输入大小为TxNxD的脉冲序列(T:时间步,N:token 数,D:特征维度)。2、按块大小B划分时间维度。对每个块,通过LIF神经元生成二进制QKV。3、重排序QKV运算(先计算KxV),避免Softmax约束。4、拼接所有块的输出,通过总面积和BN得到最终特征。

实验部分可以参考作者论文,这里不过多介绍。

浙公网安备 33010602011771号

浙公网安备 33010602011771号