会员

周边

新闻

博问

闪存

众包

赞助商

Chat2DB

所有博客

当前博客

我的博客

我的园子

账号设置

会员中心

简洁模式

...

退出登录

注册

登录

最爱丁珰

博客园

首页

新随笔

联系

订阅

管理

上一页

1

···

26

27

28

29

30

31

32

33

34

···

132

下一页

2025年3月6日

15.2.1 使用循环神经网络表示单个文本

摘要: 我们来想一下另一种方法的缺点: 一个简单的分类器如下 简单来说就是求出各个单词的\(e\)之后将他们加起来并平均然后传入\(\text{Softmax}\)层 这个算法有一个缺点就是忽略了单词的顺序,比如下面 这句话是一个很显然的负面评论,但是由于出现了很多次good,可能分类器会认为他是正面评论

阅读全文

posted @ 2025-03-06 12:39 最爱丁珰

阅读(65)

评论(0)

推荐(0)

2025年3月5日

14.2.2 层序softmax

摘要: 在层序softmax中,不是只有叶子节点才代表一个词元吗?那么为什么计算条件概率的时候要去看非叶子节点?非叶子节点代表什么?为什么非叶子节点有词向量?对此,deepseek的解释如下 在层序Softmax(Hierarchical Softmax)中,非叶子节点虽然不直接代表词元,但它们通过构建二叉

阅读全文

posted @ 2025-03-05 19:35 最爱丁珰

阅读(63)

评论(0)

推荐(0)

2025年3月4日

14.8.4 输入表示

摘要: 现在考虑BERT的输入。一般来说NLP里面的输入都是成对的,比如机器翻译,有一个源句子还有一个目标句子。那么这里如何让输入是两个句子呢?我们只用拼接起来就好了,如下 <cls>表示classification,sep表示句子分隔符(separation);Segment Embeddings就是用来

阅读全文

posted @ 2025-03-04 10:36 最爱丁珰

阅读(26)

评论(0)

推荐(0)

14.8.5 预训练任务

摘要: BERT的任务是构建一个通用的模型,那么在NLP里面,语言模型(看一些词,预测下一个词)显然是最通用的,所以我们将BERT训练成一个语言模型,即带掩码的语言模型。但是Transformer是双向的,而语言模型是单向的,这显然就不能直接训练,于是这就是我们带掩码的原因。<mask>就是我们要填写的词,

阅读全文

posted @ 2025-03-04 10:35 最爱丁珰

阅读(79)

评论(0)

推荐(0)

15.7.3 微调BERT

摘要: 在我们已经训练好BERT后,BERT就可以对输入的每一个词元返回抽取了上下文信息的特征向量(也就是对于任意一个词元,将这个词元当做查询,所有词元当做键值对) 一些任务如下 这里将<cls>的特征向量传递给全连接层的原因就是因为<cls>本来就是用来分类的,所以肯定传这个。当然也可以传其他的,反正我们

阅读全文

posted @ 2025-03-04 08:49 最爱丁珰

阅读(78)

评论(0)

推荐(0)

2025年3月3日

14.8.3 BERT:将ELMo与GPT结合起来

摘要: 想想吴恩达讲的CV里面,复用其他网络的结构,只在最后一层加入一个全连接层,对这个全连接层进行微调,也就是如下过程 那么CV里面可以这么用,NLP里面当然也可以这么用,如下 我们只需要调整这个新增加的简单输出层即可 BERT说白了,就是只有编码器的Transformer 他有两个版本,见下 block

阅读全文

posted @ 2025-03-03 22:39 最爱丁珰

阅读(39)

评论(0)

推荐(0)

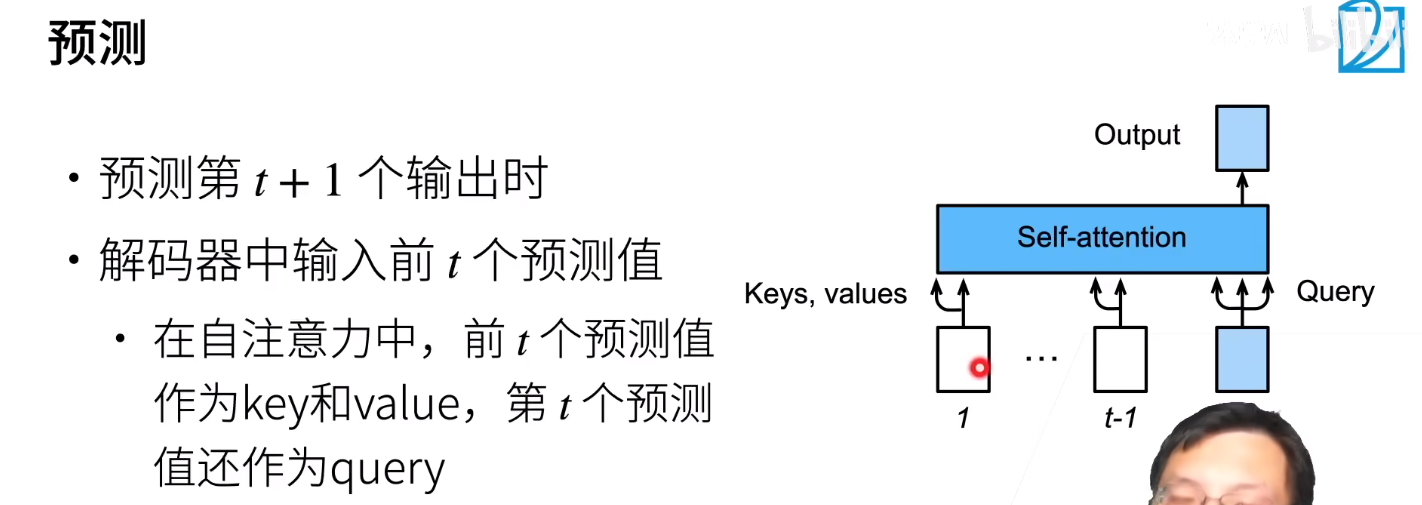

10.7.5 解码器

摘要:

阅读全文

posted @ 2025-03-03 22:01 最爱丁珰

阅读(10)

评论(0)

推荐(0)

10.7.2 基于位置的前馈网络

摘要: 注意,我们这里必须要将输入的前两维(batch_size和num_steps)结合起来,而不能将后两维(num_steps和dimension)结合起来,因为这里num_steps是变化的(num_steps是我们指定的超参数,指定之后编码器-解码器的确只能处理固定长度的序列,因为有truncate

阅读全文

posted @ 2025-03-03 21:50 最爱丁珰

阅读(58)

评论(0)

推荐(0)

10.6.2 比较卷积神经网络、循环神经网络和自注意力

摘要: CNN怎么做序列?实际上之前已经接触过了,就是把序列当成没有高只有宽的图片而已 将书上讲的复杂度汇总如下 CNN 计算复杂度:进行一次卷积计算,由于卷积层大小为\(k\),输入有\(d\)个通道,所以复杂度为\(O(kd)\);由于序列长为\(n\),所以计算完输出的一个通道的时间复杂度为\(O(k

阅读全文

posted @ 2025-03-03 15:09 最爱丁珰

阅读(84)

评论(0)

推荐(0)

2025年3月2日

第一次作业

摘要: 作业题目:请设计一份问卷,分别针对软件工程师和高年级同学,调查他们在设计、开发软件系统时通常会面临的困难和困惑,并调研其解决问题的途径和方法。 目录软件工程师版问卷一、基本信息二.设计痛点三、开发痛点四、解决方案高年级学生版问卷一、基本信息二.设计痛点三、开发痛点四、解决方案 软件工程师版问卷 一、

阅读全文

posted @ 2025-03-02 23:58 最爱丁珰

阅读(32)

评论(0)

推荐(0)

上一页

1

···

26

27

28

29

30

31

32

33

34

···

132

下一页

公告