NVIDIA显卡原生管理查询功能nvidia-smi的部分使用功能

本文是使用NVIDIA原生管理工具查询NVIDIA显卡使用情况的一些记录(使用远程管理工具的效率没有使用原生管理接口nvml的效率高,有效率需求者建议使用python版本捆绑的nvml库,具体:https://www.cnblogs.com/devilmaycry812839668/p/15565447.html)

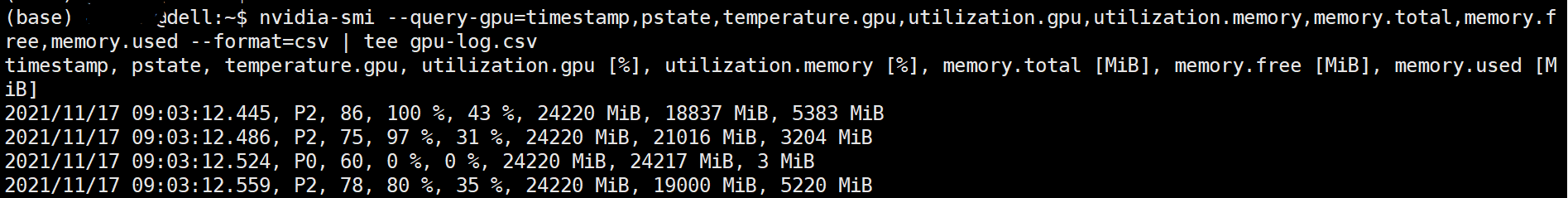

nvidia-smi --query-gpu=timestamp,pstate,temperature.gpu,utilization.gpu,utilization.memory,memory.total,memory.free,memory.used --format=csv | tee gpu-log.csv

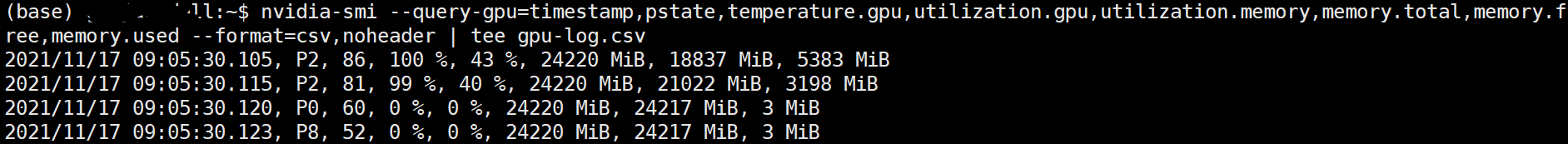

不打印列的title:

nvidia-smi --query-gpu=timestamp,pstate,temperature.gpu,utilization.gpu,utilization.memory,memory.total,memory.free,memory.used --format=csv,noheader | tee gpu-log.csv

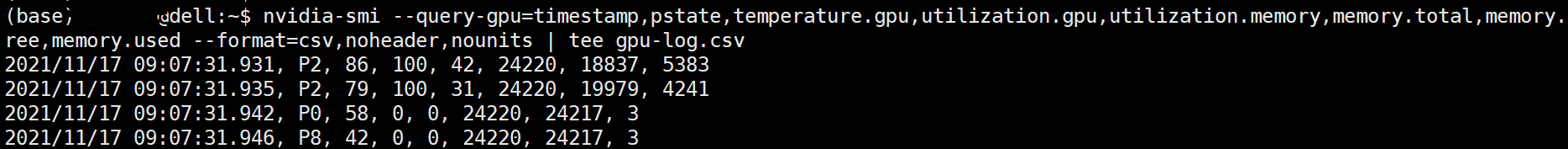

不打印列的title和单位:

nvidia-smi --query-gpu=timestamp,pstate,temperature.gpu,utilization.gpu,utilization.memory,memory.total,memory.free,memory.used --format=csv,noheader,nounits | tee gpu-log.csv

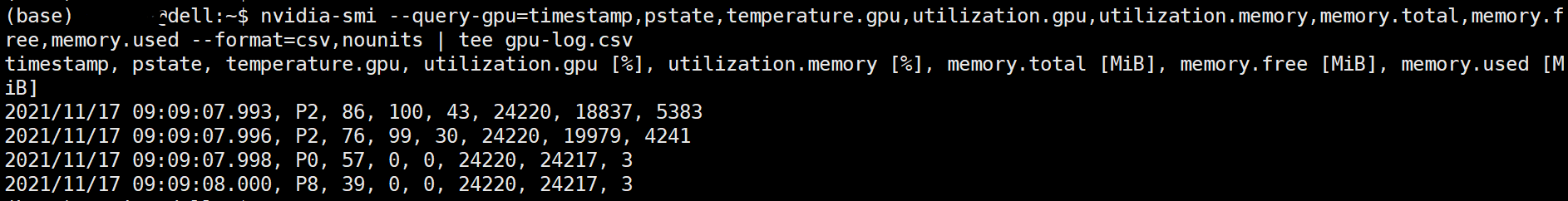

不打印单位:

nvidia-smi --query-gpu=timestamp,pstate,temperature.gpu,utilization.gpu,utilization.memory,memory.total,memory.free,memory.used --format=csv,nounits | tee gpu-log.csv

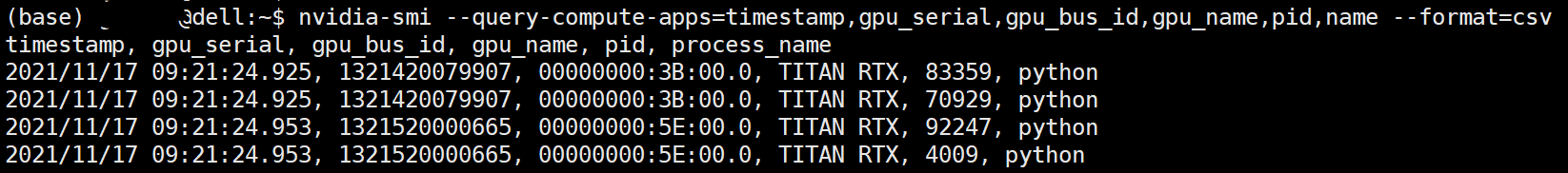

查询GPU上现在运行的程序:

nvidia-smi --query-compute-apps=timestamp,gpu_serial,gpu_bus_id,gpu_name,pid,name --format=csv

概览:

nvidia-smi

=====================================================

posted on 2021-11-17 09:02 Angry_Panda 阅读(791) 评论(0) 收藏 举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号