KDNuggets-博客中文翻译-十三-

KDNuggets 博客中文翻译(十三)

原文:KDNuggets

2021 年你应该开始阅读的数据科学书籍

原文:

www.kdnuggets.com/2021/04/data-science-books-start-reading-2021.html

评论

作者 Przemek Chojecki,Contentyze CEO

数据科学无疑是目前最热门的职业选择之一。许多公司(其中许多公司拥有数据科学部门)正在招聘数据科学家。成为数据科学家是一个重大成就。如果你已经是统计学家并希望提升自己,这也是一个磨练专业技能的绝佳机会。

我们的前三课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

本文讨论了适用于任何水平的数据科学热门书籍。

2021 年你应该开始阅读的数据科学书籍

初学者数据科学水平

如果你刚刚开始探索数据科学,可以查看以下这些书籍:

从零开始的数据科学书籍

在 《从零开始的数据科学》 这本书中,数据科学的概念是以易于理解的方式呈现给陌生的学习者的。你甚至不需要了解 Python 就可以开始。我强烈推荐你从这本书开始。

《Python 机器学习简介》

如果你愿意从初学者水平学习机器学习,并渴望了解更多内容,那么这本名为《Python 机器学习简介》的书是一个绝佳选择。请记住,你不需要已经掌握 Python。

数据科学职位

然后,为了成为一名合格的数据科学家,你可以看看我写的书《数据科学职位:如何成为数据科学家》,这本书提供了一个全面的逐步指南。

通过我在多个组织担任项目经理、数据科学分析师或首席技术官的经验,我能够看到招聘数据科学家和发展数据科学团队的过程。本书将告知你:

-

成为数据科学家首份工作的必备条件,

-

你应学习的技能,

-

你在面试中应展示的内容,

以及更多内容。

中级数据科学水平

如果你读过一两本数据科学书籍,并且自己做过一些数据科学任务,现在你习惯于处理数据,这里有一些书籍可以深化你对数据科学的理解。

《Python 数据分析》

《Python 数据分析》 建议使用 NumPy 和 pandas。此外,《Python 数据分析》是一个知识渊博的数据科学家可能会欣赏的绝妙资源。它也对 Python 语言的功能进行了适当的介绍。

Python 数据科学手册

《Python 数据科学手册》 是所有标准 Python 库的完美指南。强烈推荐 Pandas 库、Scikit-Learn 库和 NumPy 数学库。

这本详尽的工作手册将为数据科学家和数据挖掘人员提供处理数据的有效方法。数据科学家会喜欢其中的多种插图、对每个过程背后算法的简明解释,以及附属网站上的工具。这无疑是目前唯一详尽且最新的 Python 科学计算资源。

你将学习如何使用以下内容:

-

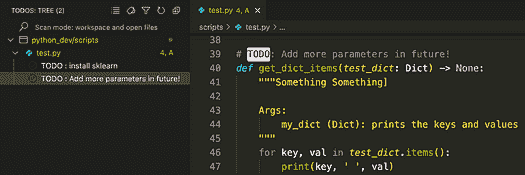

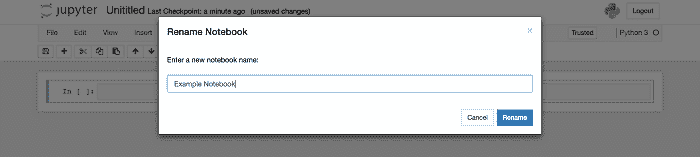

Jupyter 和 iPython 是可以用来进行数据处理的 Python 框架。

-

Numpy: 需要构建一个密集且有效的数据数组,用于 Python 中的数据处理。

-

Pandas 结合了强大的向量和 DataFrame,以便在 Python 中分析和检索带标签/列的数据。

-

Matplotlib 是一个 Python 绘图库,提供了多种功能用于绘图和数据可视化。

-

Scikit-learn: 是一个流行的 Python 机器学习库,提供了复杂的机器学习算法和高效的实现。

《Python 机器学习》书籍

Python 机器学习 介于中级和高级机器学习阶段之间。它适合所有该领域的专家以及其他人。它从机器学习和深度学习的温和介绍开始,然后转向更高级的方法。一本了不起的书!

动手实践机器学习:Scikit-Learn 和 TensorFlow (第 2 版)

动手实践机器学习:Scikit-Learn 和 TensorFlow (第 2 版) 是一本宝贵的资源,能够获得更多成果!这本书讨论了所有基础知识(分类过程、降维),甚至涉及神经网络和深度学习。

Python for Finance 书籍

如果你对金融和数据科学感兴趣,Python for Finance 是必读书籍。这本书强调了利用数据科学方法来评估资本市场,并且提供了几个出色的示例来证明这一点。它是一个极其现实的产品,通常适合那些不经常从事金融工作的人。

专家级数据科学水平

对于那些在数据科学方面有一定经验的人来说,阅读大量的科学研究文章比阅读书籍更为合适。这是因为这种方法更为现实,并且可以将深度学习融入到你的程序中,以超越传统统计学。

深度学习与 Python

深度学习与 Python 这本书的作者是 Keras 库的开发者之一,Keras 是 Python 最著名的机器学习库之一。这本书以实用的方法开始,因为你可以立即学习几种有用的技巧。它通常非常实际,因为你可以在阅读后立即应用于活动中。这是深度学习的终极必读书籍。

深度学习

深度学习 是一本关于深度学习算法的绝佳参考书。它包含了有限的编码量,并且对如何解决机器学习问题有很好的见解。该书被该领域的专家频繁引用。

如果你对数学感兴趣,那么你一定会喜欢 机器学习:概率视角。它是对机器学习过程背后数学的真正深入探索。

不,我不建议一口气读完。我的建议是享受一杯咖啡,坐下来,慢慢阅读。

如何在 2021 年成为数据科学家?

就这些了。希望这些书籍能帮助你成为更优秀的数据科学家!

如果你在寻找第一份入门级数据科学工作却不知道从哪里开始,请报名参加我的 数据科学工作课程。一旦你进入课程,我可以在我们的学习小组中直接回答你的问题,帮助你成为初级数据科学家。

如果你喜欢这篇文章,请查看我关于成为数据科学家的其他帖子:

[加入我的技术新闻通讯]

数据科学,人工智能,机器学习](https://creative-producer-9423.ck.page/c3b56f080d)

简介:Przemek Chojecki 是 Contentyze 的 CEO,文本编辑器 2.0,数学博士,福布斯 30 位 30 岁以下杰出人物。

原文。经许可转载。

相关:

-

2021 年 15 本免费的数据科学、机器学习与统计学电子书

-

另外 10 本免费必读机器学习与数据科学书籍

-

数据科学与机器学习:免费电子书

更多相关内容

数据科学与商业:学习预期价值框架的 3 个理由

原文:

www.kdnuggets.com/2018/07/data-science-business-expected-value-framework.html

评论

评论

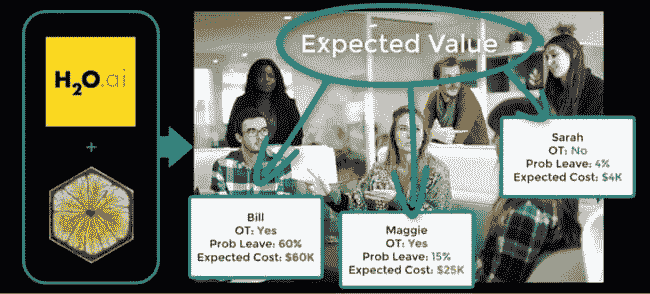

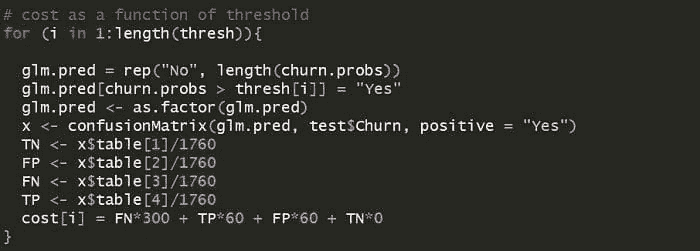

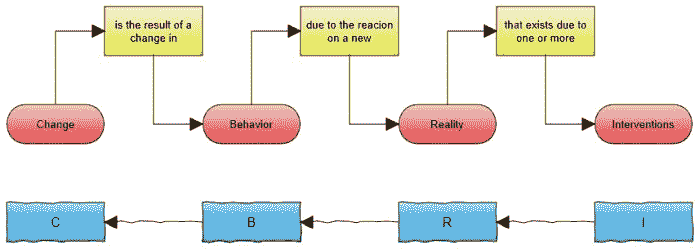

实施数据科学在商业中的最困难且最关键的部分之一是量化投资回报率或 ROI。在这篇文章中,我们强调了学习预期价值框架的三个理由,该框架将机器学习分类模型与 ROI 连接起来。此外,我们会指向我们最近发布的新视频,预期价值框架:使用 H2O 建模员工流失,这是我们旗舰课程的一部分:数据科学与商业 (DS4B 201)。该视频概述了使用 H2O 减少员工流失并计算 ROI 的步骤,将关键的 H2O 功能与过程联系起来。最后,我们将讨论一些与将预期价值应用于商业中的机器学习分类问题相关的预期价值框架常见问题。

学习预期价值框架的 3 个理由

我们的前 3 名课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

如果你想将数据科学与机器学习分类器的 ROI 联系起来,这里有你需要了解预期价值的 3 个理由。我们将使用与员工流失(也称为员工离职或员工流失)相关的DS4B 201 课程中的示例。

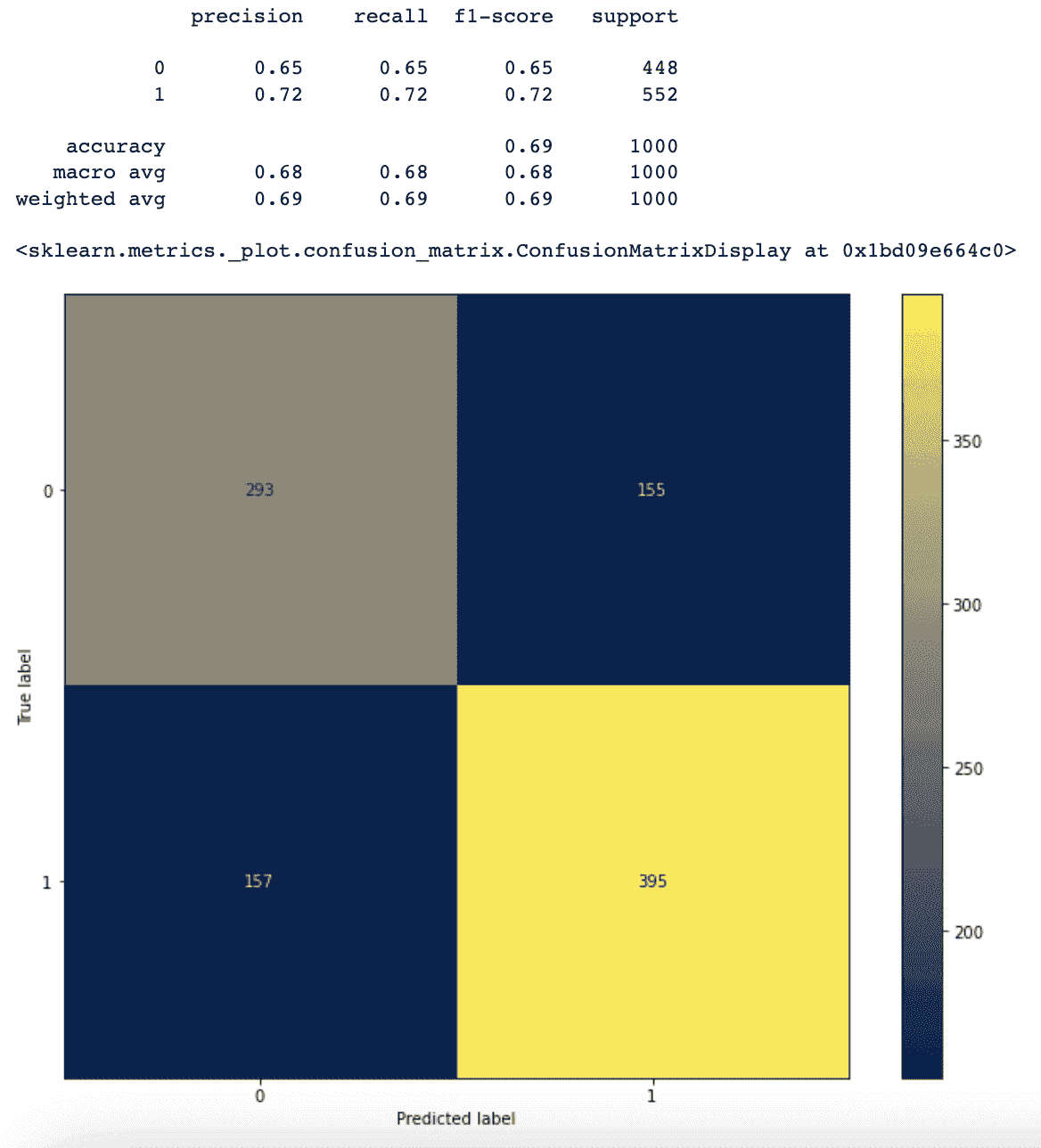

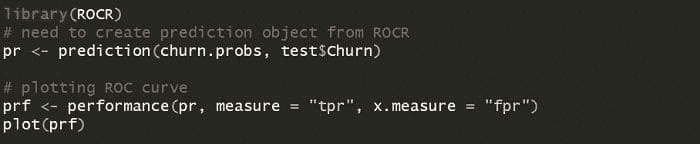

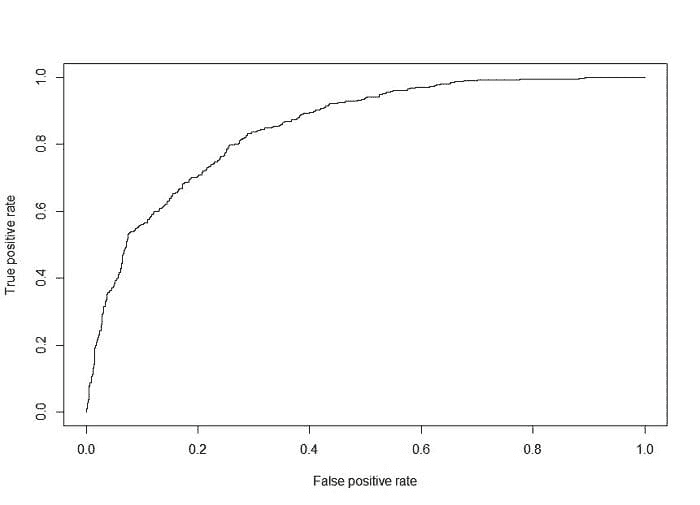

原因 #1: 分类机器学习算法经常最大化错误的指标

F1 是平衡精度和召回率的阈值(换句话说,它在减少假阳性和假阴性方面寻求一个相对平衡的阈值)。问题在于,在商业中,假阳性(类型 1 错误)和假阴性(类型 2 错误)相关的成本很少相等。实际上,在许多情况下,假阴性的成本要高得多(可能是 3 倍或更多!)。

示例: 员工流失的类型 1 和类型 2 错误成本

我们开发了一个预测算法,该算法发现员工在加班过多时离职的可能性是正常情况的 5 倍。

从 H2O + LIME 结果计算预期流失成本我们开发了一个建议,使用极其强大的 H2O 分类模型以及 LIME 来减少加班,并解释结果。像许多算法一样,我们默认通过处理类型 1 和类型 2 错误来优化。这会以大致相同的比例错误分类离职员工(类型 2 错误)和留任员工(类型 1 错误)。估计减少加班对员工的成本是如果员工离职,生产力损失的 30%。然而,错误减少留任员工的加班成本是类型 1 错误的 30%或 3 倍,还把它们当作相同处理! 商业问题的最佳阈值几乎总是低于 F1 阈值。这引出了你需要了解期望值框架的第二个理由。

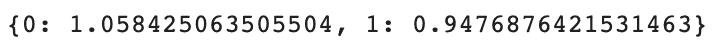

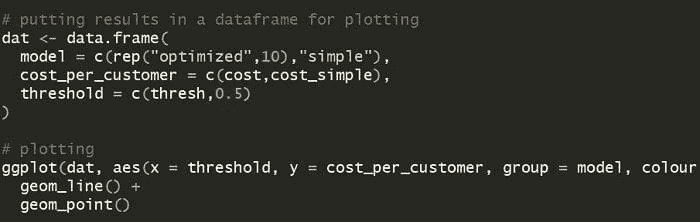

理由 #2: 解决方案是最大化期望值

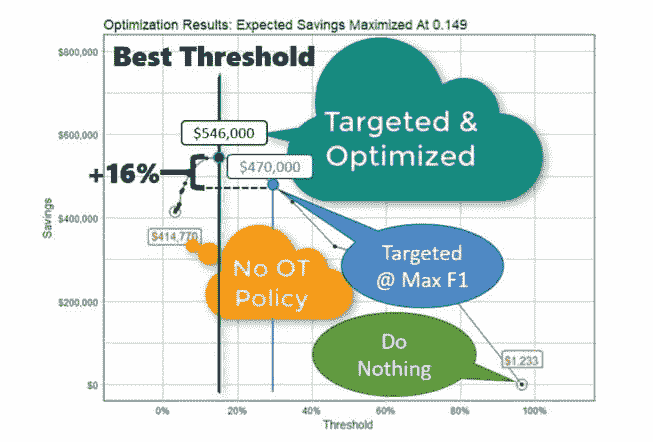

当我们需要使用商业成本来计算期望值时,我们可以通过迭代计算来找到最大化商业问题期望利润或节省的最佳阈值。通过在不同的阈值下迭代计算节省金额,我们可以查看哪个阈值优化了目标方法。

在详细的示例中,我们可以看到,在阈值优化结果中,最大节省($546K)发生在阈值 0.149 处,这比在最大 F1 阈值下的节省($470K)节省了 16%。值得一提的是,最大化 F1 的阈值是 0.280,对于包含总人口 15%的测试集来说,由于不够优化,导致了$76K 的额外成本($546K - $470K)。将这种低效扩展到整个数据集(训练数据 + 测试数据),这是每年错失的$500K 机会!

然而,模型基于多个假设,包括平均加班百分比、每位员工的预期净利润等等。

理由 #3: 期望值可以测试假设中的变异性

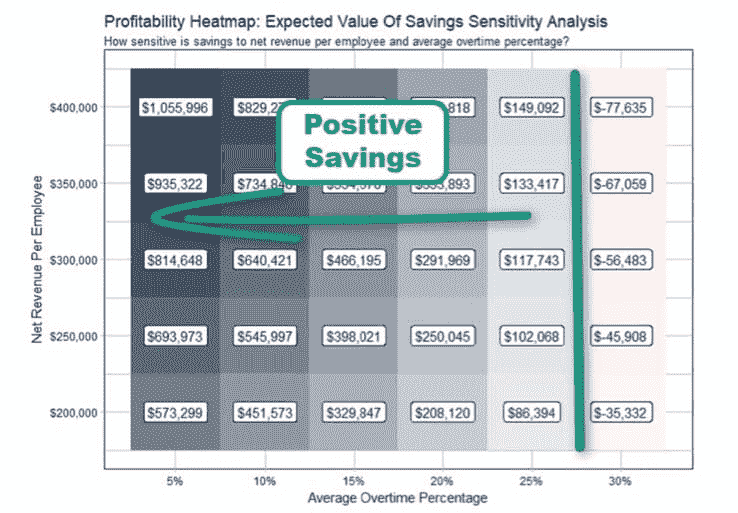

我们可以使用灵敏度分析以及期望值。我们测试模型假设对员工离职期望利润(或节省)的影响。

在下面的人力资源示例中,我们测试了平均加班百分比和每位员工的净收入的一系列值,因为我们对未来的估计可能存在偏差。在下面显示的敏感性分析结果中,我们可以在盈利能力热图中看到,只要平均加班百分比小于或等于 25%,实施有针对性的加班政策就能为组织节省资金。

敏感性分析结果(盈利能力热图)

哇!我们不仅可以测试最大化商业案例的最佳阈值,还可以使用期望值测试每年和每人变化的输入范围。如果你有兴趣了解如何将期望值框架应用于你的业务,我们会展示如何操作,提供代码,并展示在我们在**数据科学商业课程(DS4B 201 课程)****中的其他行业应用实例。

简介: Matt Dancho 是一位数据驱动的决策者。热衷于学习新工具、开发软件和与人合作以获取见解并做出更好的决策。喜欢与团队和个人合作以推动运营卓越。驻扎在美国宾夕法尼亚州州立大学。

相关:

更多相关话题

数据科学职业:7 个期望与现实

原文:

www.kdnuggets.com/2022/06/data-science-career-7-expectations-reality.html

在即将开始数据科学职业路径的人们的期望与数据科学家实际做的事情之间存在巨大差距。有些期望得到了满足,但许多新数据科学家发现他们的工作与他们预期的完全不同。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

这部分是因为数据科学是一个快速发展的领域。今天的流行词汇可能在明天就变成过时技术。另一个原因是因为它是一个广泛的领域——数据科学家发现他们必须在工作中扮演许多角色。此外,面试阶段通常存在一些误导:雇主对员工的需求非常迫切,因此会过分美化职位描述。而且,数据科学领域如此广泛,它包括数据清理、整理、机器学习、基础统计和数据可视化。

让我们来看看数据科学家的期望与他们实际面临的现实。

期望 #1:数据科学家的收入很高。

一般认为数据科学家需求很高,所以薪水也很丰厚。实际上,你的数据科学薪资在很大程度上取决于你生活的地方、你为谁工作、你处于职业生涯的哪个阶段以及你所在的行业。

那么 数据科学家赚多少钱 呢?薪资可以达到六位数,但 $60k-70k 范围的薪资也很常见。一些初级职位的平均薪资不到 $50k。尽管如此,大多数薪资水平仍然非常具有竞争力,并且附带许多福利。

期望 #2:你将通过关键见解影响你的业务。

许多人会告诉你,成为一名数据科学家不仅仅是与你处理数字和 Python 的技能有关。成为一名优秀的数据科学家意味着你具备商业洞察力。你知道这些数字意味着什么。你将把这些重要的洞察传达给公司领导团队的关键成员。

现实情况是,和其他任何角色一样,你必须屈服于政治。有时你所做的工作会对业务产生实际影响。你会开发出一个真正影响公司底线的算法。但是,往往情况下,甚至更多的是,你会制作一个电子表格、数据可视化,或者只是为一个需要数据用于明天演示的高管处理一些数字。Deliveroo 数据科学家 Jonny Brooks-Bartlett 写道:“你必须不断地做一些临时工作,比如从数据库中提取数据,以便在正确的时间将数据提供给正确的人,做一些简单的项目,以便让正确的人对你有正确的看法。”

期望 #3:全都是机器学习、人工智能和算法。

例如,目前人工智能在数据科学中是一个非常流行的流行词。新的数据科学家可能自然地认为他们将构建前沿算法,并从事机器学习工作。

然而,如上所述,很多工作只是临时的与数据相关的工作。这涉及大量的 ETL 和数据清理。虽然你的一部分时间肯定会花在令人兴奋的概念和技术上,但大部分时间不会。

此外,你的雇主通常会期望你尽快开始使用极其有限且笨拙的数据构建 AI 模型。Monica Rogati 在她关于如何避免招聘数据科学家的指南中 写道:“[新招聘的数据科学家] 预计需要投入一些精力来收集和清理数据——但他们没想到会如此复杂和混乱,缺失或难以访问的情况如此之多。”这完美地概括了作为新数据科学家是什么样的体验。

期望 #4:你可以在线学习所有你需要的知识。

有一种感觉是,训练营或 Coursera 课程将教会你成为 数据科学家 所需的一切。现实情况,如同几乎所有其他工作一样,是你需要在工作中进行大量学习。有一些沟通技巧和领导本能是你从 Coursera 课程中无法获得的。

对于数据科学家来说,这也更为真实,那就是工作取决于你如何对待它。许多初创公司雇佣数据科学家是因为投资者要求这样做。缺乏技术知识的创始人对你能做什么一无所知,所以你需要自己搞清楚并定义角色。(并且准备好在过程中遇到许多误解。)

期望 #5:一切都是数字。

作为数据科学家,你期望你的工作是纯粹的数学。你收集数据、进行分析、创建数据产品,并处理数字。但请记住,你的雇主并不像你一样中立。正如数据科学可以被意外地用于不良目的一样,数据科学家也可能如此。

我们都对亚马逊臭名昭著的反女性人工智能招聘工具有所了解。一些数据科学家开发了那个模型。一个更具道德灰色地带的例子是优步的 Greyball 项目,该项目帮助优步司机躲避执法,避免被罚款。同样,这个产品并不是像雅典娜从特拉维斯·卡兰尼克的额头上直接跳出来的。真实的人们是将其构建出来的。

作为数据科学家,你可能会被要求做一些值得怀疑的事情。公司并不一定是为了善意而存在;它们大多数是为了盈利。特别是当你正在开发可能影响许多人的产品时,保持对所需完成任务的分析思维是值得的。

期望 #6:你将被重视、理解和支持。

正如许多数据科学家所知,工作的现实是没有指导、基础设施不足,而且对你实际做的事情了解甚少。“数据科学家可能是为了编写智能机器学习算法来推动洞察,但因为他们的第一份工作是整理数据基础设施和/或创建分析报告,所以做不到这一点,” 布鲁克斯-巴特利特写道。特别是如果你在创业公司工作,你通常需要做大量的预数据科学工作来完善你的工具、架构和技术。而且 IT 团队并不总是合作。

此外,同事们会认为你能处理任何与“数据”相关的请求,无论当时流行的数据术语是什么。六七年前,数据科学家们会被要求用 Hadoop 存储和处理数据。C-suite 级别的高管可能会要求你处理“深度学习”相关的工作。同时,你也会被要求发送一个带有简单 VLOOKUP 公式的 Excel 表格。

“最终,你不再像你想象的那样构建复杂的算法和预测模型。你现在花费所有时间来提升 SQL 和数据准备技能,从系统中提取数据并转换为不同格式,向利益相关者展示这些数据,以便他们可以利用这些数据做出商业决策,”Natassha Selvaraj在讨论为什么这么多数据科学家离职时写道。

虽然数据科学家确实很抢手,但对这个角色的困惑如此之多,以至于你不总能获得完成工作的支持或基础设施。

期望 #7:你会热爱你的工作。

正如 Selvaraj 所指出的,许多数据科学家正在离职,但许多人仍然享受他们的生活。Glassdoor 列出它为美国第 3 大最佳工作,工作满意度相对较高(5 分中 4.1 分)。一项 KDNuggets 调查发现大多数数据科学家对他们的工作仍然感到满意。

像任何工作一样,做数据科学家可能会很乏味。它可能伴随有意外的任务。它可能具有挑战性。但它也可能非常有趣。作为数据科学家,你将被要求突破你的极限,并有机会对你的公司产生真正的影响(即使你也需要做一些琐碎的工作)。

一旦你度过了适应新角色的成长 pains,你将有权创建一个你喜欢的工作。“我处于一个可以只做数据科学的职位,”BullCityPicker在 Reddit 上写道,“极少的无聊会议,大量的‘别打扰我’时间,还有我选择有趣项目的自由。我为此得到很高的薪水。我有很多自主权,能够不断学习新东西,感到非常满意。”

成为数据科学家的现实是什么?

总结来说,作为数据科学家,你:

-

有机会赚很多钱——但这并不保证。

-

可能会影响最终结果——但如果你希望别人听你说话,你需要与他人友好相处。

-

将从事前沿技术——同时做大量枯燥的 SQL 查询。

-

仅通过在线学习就能做好准备——但你必须通过被扔进深水区来学习某些技能。

-

创建真正影响人的数据驱动产品——但这些影响既可能是负面的,也可能是正面的。

-

被你的同事和公司重视——但你也会遭到深刻误解和常常得不到足够的支持。

-

会喜欢你的工作——如果它适合你的话。

换句话说,数据科学家就像其他工作一样。这份工作与其他工作不同的是,数据科学也受到了被称为“21 世纪最性感的工作”营销的影响。这导致你和你的雇主之间产生了很多误解和期望不匹配的问题。

如果你知道期望是什么,并且仍然感兴趣,那么这将是一个非常有回报的职业路径。

内特·罗西迪 是一名数据科学家和产品战略专家。他还是一名讲授分析课程的兼职教授,并且是 StrataScratch 的创始人,该平台帮助数据科学家准备来自顶级公司的真实面试问题。你可以通过 Twitter: StrataScratch 或 LinkedIn 与他联系。

了解更多相关话题

数据科学已经改变,而非消亡!

作者提供的图像

随着技术的不断发展和人工智能在我们日常生活中的应用,许多人担心工作岗位的流失。甚至有人说数据科学在消亡。许多人表示,机器学习正在取代数据科学,并称数据科学是一个饱和的领域。随着 ChatGPT 等工具的广泛使用以及它们在编码任务等方面的应用,我们在质疑数据科学是否在消亡。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速入门网络安全职业生涯。

1. Google 网络安全证书 - 快速入门网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你组织的 IT 工作

3. Google IT 支持专业证书 - 支持你组织的 IT 工作

但真的是这样吗?真的在消亡吗?

当然不是。我们获得的数据越来越多,这些数据产生了推动决策的宝贵洞察。这些洞察无法由计算机生成,我们需要它们来进行数据科学。可以建立机器学习模型,并利用数据发现有价值的洞察,但关键因素是对数据的需求以及如何处理数据。

而要理解如何处理数据,你需要人类。你需要数据科学家!但是什么发生了变化?

数据科学的变化

由于生成式 AI 的发展以及每个人都想进入科技行业的热潮,数据科学中的各种元素正在发生变化。让我们回顾一下数据科学中的一些变化。

技能

诸如探索性数据分析这样的任务曾经提供了重要的洞察,现在发生了巨大的变化。它通常需要数据科学家和数据分析师的帮助。然而,现在有了像 ChatGPT 这样的工具以及快速的数据科学课程——每个人都相信自己能编码,并且在 Python 中技术熟练。

然而,这并不是真的。如果你具备正确的技能组合,并且在如 Python 等编程语言中非常熟练,你将会脱颖而出。组织仍会寻找高素质的数据科学家来完成任务,而不是 ChatGPT 的回答或那些只参加过快速数据科学课程的人。

作为一名数据科学家,你的工作将是适应当前的市场。不断学习和提升技能是你保持竞争力并被真正重视的方式。

这包括不断学习不同的软件架构、库、框架、编程语言等。

构建完整应用程序

许多人正在使用 ChatGPT 来帮助他们完成编码任务。但需要理解的是,ChatGPT 可以帮助你构建完整应用程序的模块,但无法将这些模块整合起来构建整个基础。

组织将需要一个了解所有不同模块及其如何组合的人。他们能够将所有模块拼凑在一起,因为他们了解每个模块的作用,并将它们结合起来构建基础。

这并不意味着 ChatGPT 没有帮助——它确实有。许多程序员利用 ChatGPT 来帮助他们处理代码块,这加快了他们的代码编写过程。同时,它也通过学习新知识帮助提高程序员的技能,使他们在编码中更加熟练。

所以,作为一名数据科学家,你需要掌握更多的知识,甚至是所有的知识。你需要了解数据科学的每一个元素,以及如何构建一个完整的应用程序。

角色的融合

数据科学中的角色会有很多,但需要注意的是,许多角色将会融合。你以前可能是数据分析的首选人选,但现在你需要成为一个全能型人才,并在整体数据科学中成为专家。例如,你将运用你的分析技能来构建应用程序。

原因在于越来越多的组织在考虑工作角色的效率,以及他们实际需要多少人。例如,我应该雇用一个擅长创建和展示数据可视化的人,还是找到一个能够做所有事情的数据科学家?从商业角度来看,你知道公司会选择谁。

我能给你的最好建议就是在你擅长的领域做到非常出色。做到你能做到的最好,以免感到被挤出。

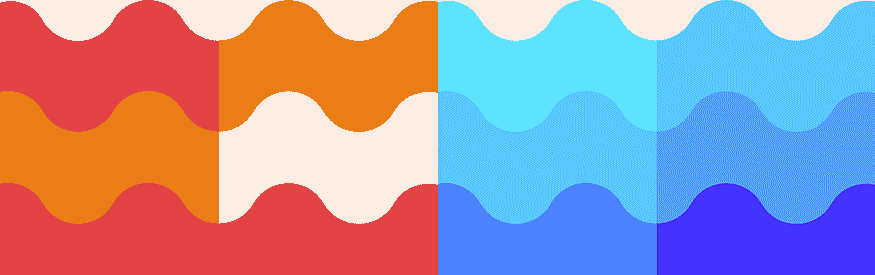

职业市场

数据科学的就业市场已经发生了变化。多年来,许多人试图通过快速培训营和一些 Jupyter Notebook 项目进入技术行业。不幸的是,这在当前市场中已经不再有效。具备熟练的技能组合、丰富的经验以及对数据科学的高级理解是至关重要的。

理解机器学习架构和高级数据分析是你需要完善的领域!你需要脱颖而出!

总结

我希望这篇博客能帮助你理解数据科学世界的变化,以及如果你想进入或在该领域发展——你需要做什么!与其感到被挤出,你只需要了解下一步需要做什么,以保持竞争力!

Nisha Arya 是一位数据科学家、自由技术作家和 KDnuggets 的社区经理。她特别关注提供数据科学职业建议或教程以及数据科学相关理论知识。她还希望探索人工智能如何对人类寿命产生好处。作为一个热衷的学习者,她致力于扩展自己的技术知识和写作技能,同时帮助引导他人。

相关阅读

数据科学备忘单 2.0

评论

由 Aaron Wang,麻省理工学院商业分析硕士 | 数据科学。

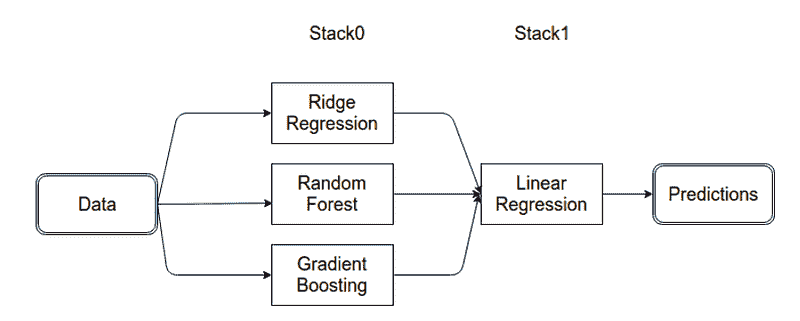

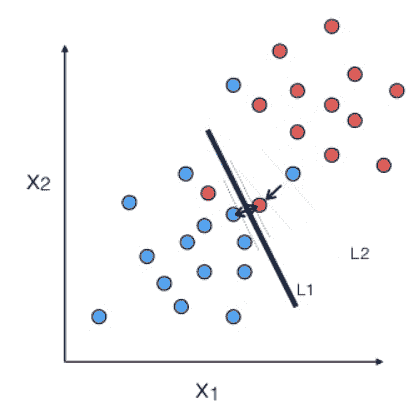

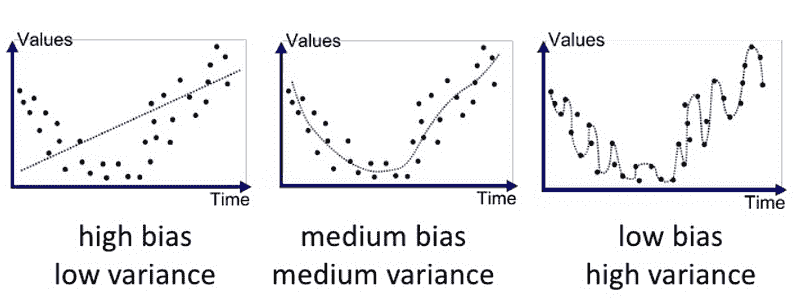

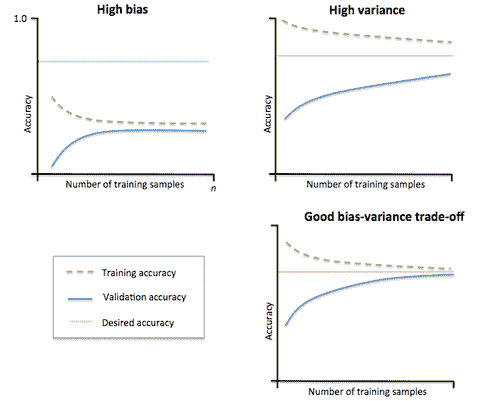

这个数据科学备忘单涵盖了一个学期的初级机器学习内容,基于麻省理工学院的机器学习课程 6.867 和 15.072。你应该至少具备基本的统计学和线性代数知识,尽管初学者仍然会发现这个资源有用。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 工作

灵感来源于 Maverick 的 数据科学备忘单(因此名字中有 2.0),可以在 这里 找到。

涵盖的主题:

-

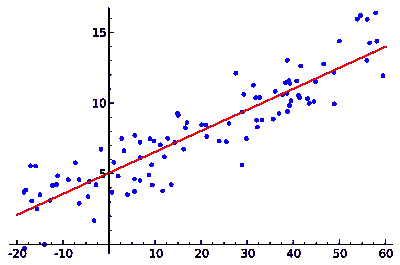

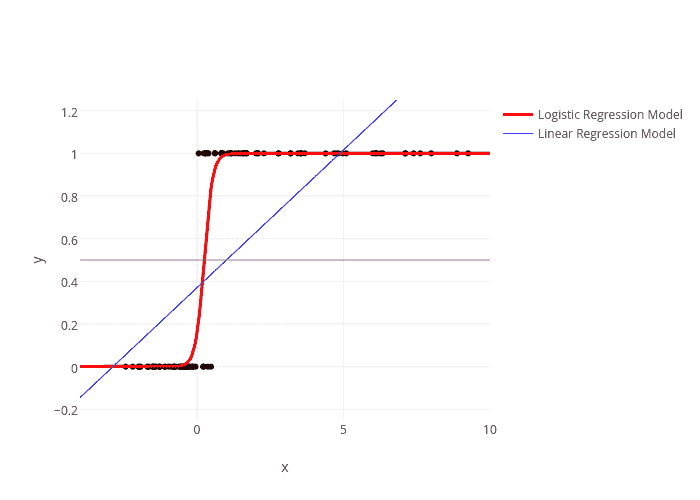

线性和逻辑回归

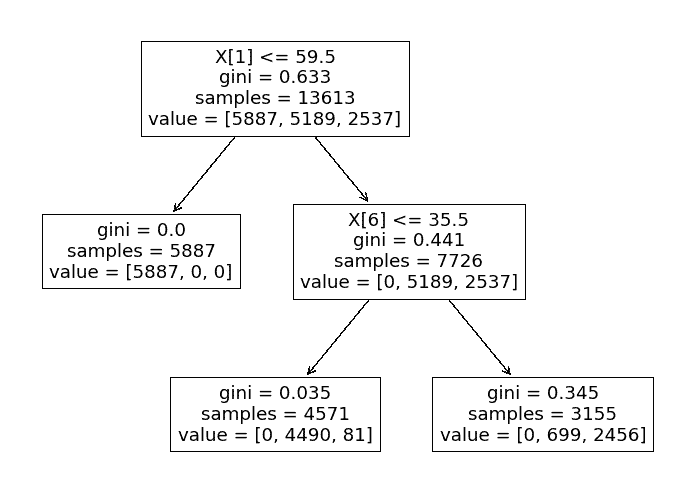

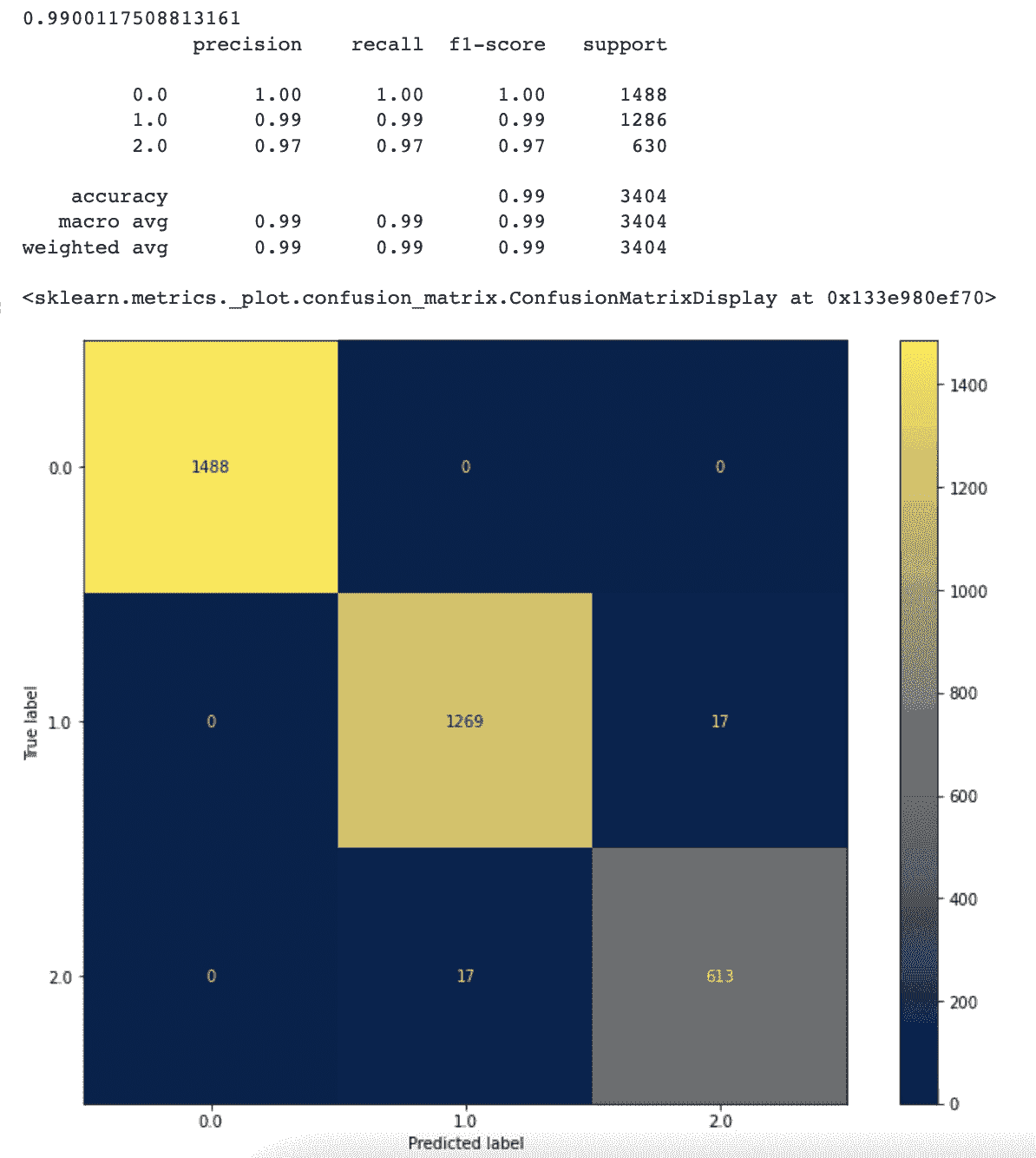

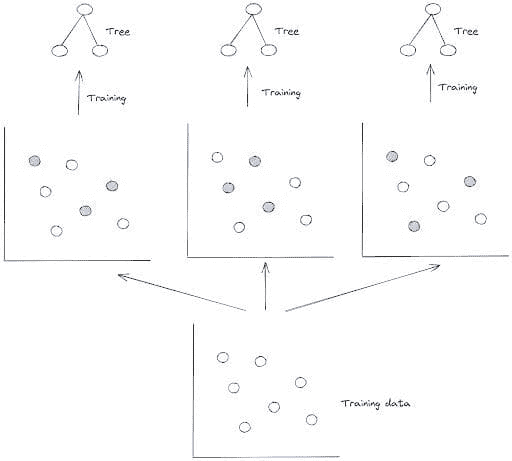

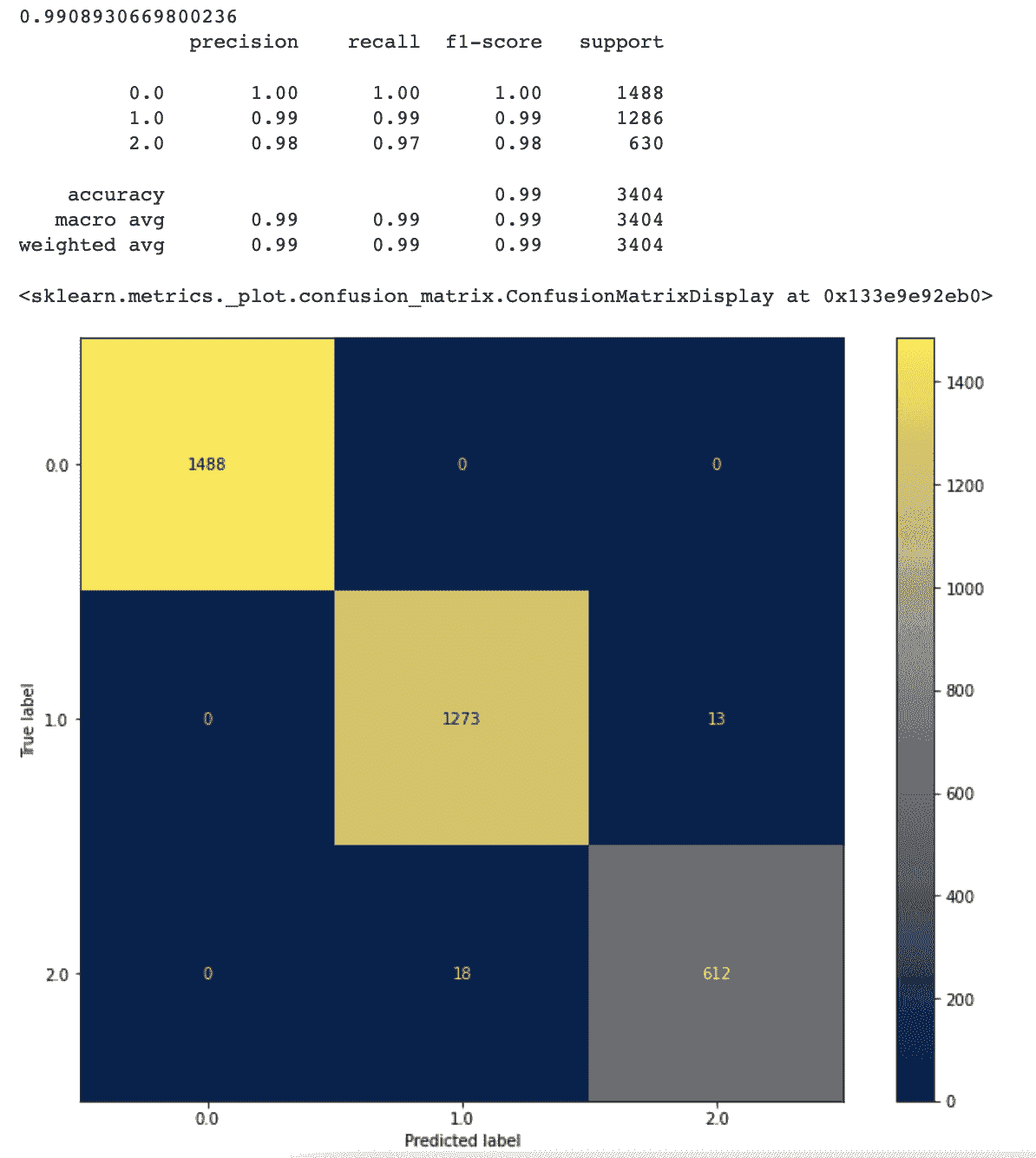

-

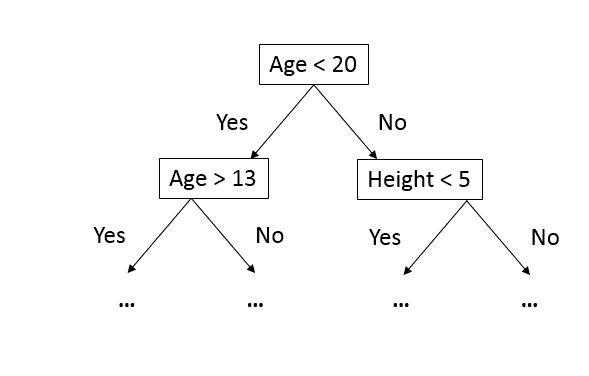

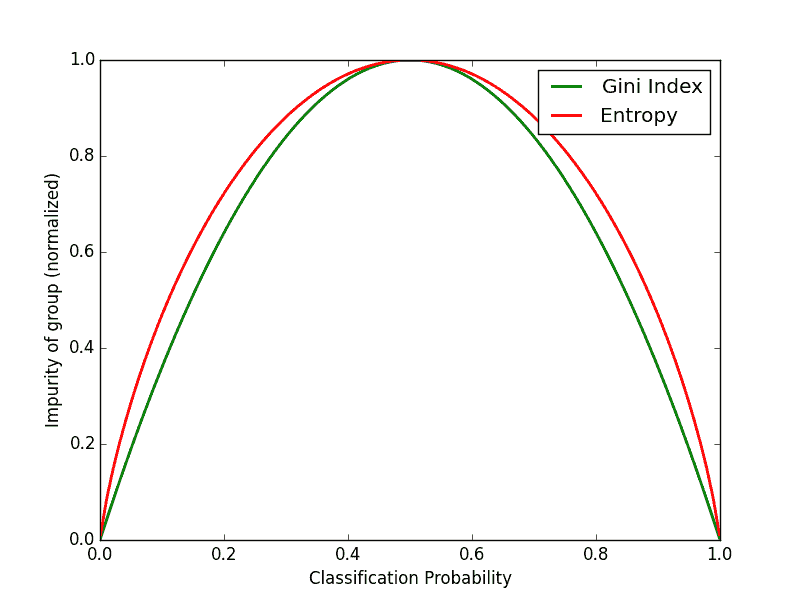

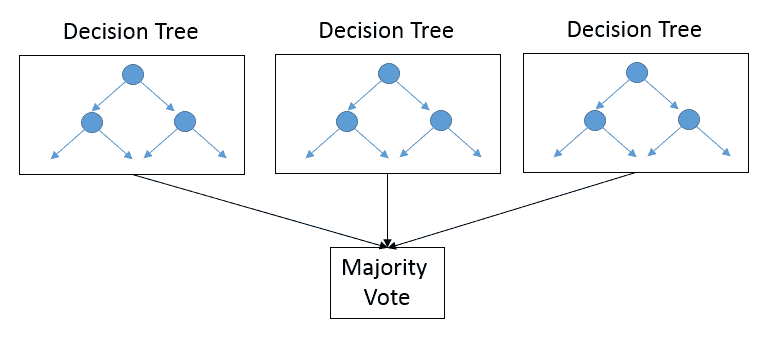

决策树和随机森林

-

支持向量机

-

K-最近邻

-

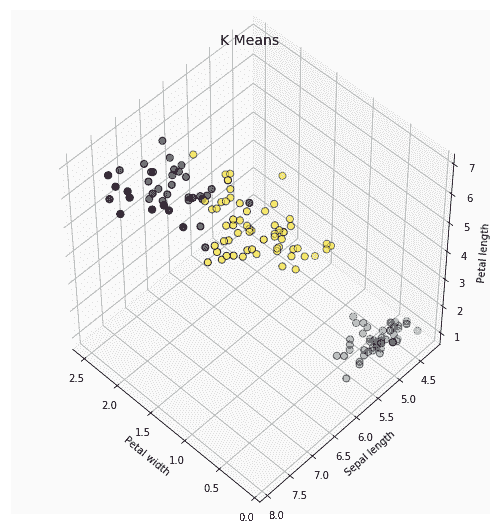

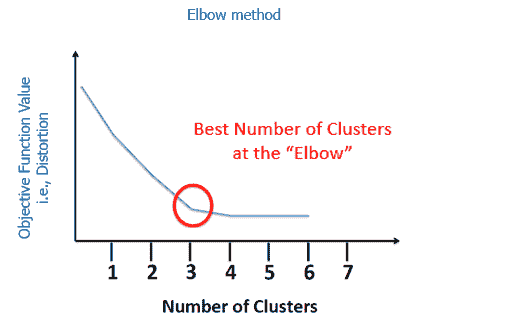

聚类

-

提升

-

降维(PCA、LDA、因子分析)

-

自然语言处理

-

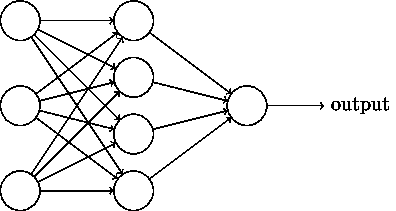

神经网络

-

推荐系统

-

强化学习

-

异常检测

-

时间序列

-

A/B 测试

这个备忘单将不定期更新新的改进信息,因此考虑在 GitHub 仓库 上关注或加星,以保持最新状态。

未来的补充(欢迎提供想法):

-

数据插补

-

生成对抗网络

为什么这个备忘单中没有涵盖 Python/SQL?

我计划让这个资源主要涵盖算法、模型和概念,因为这些内容变化不大且在各个行业中都很常见。技术语言和数据结构通常因工作职能而异,刷新这些技能可能在键盘上更有意义,而不是纸上。

许可证

欢迎在课堂、复习课中分享这个资源,或者分享给任何可能觉得有用的人 😃

本作品采用 知识共享署名-非商业性使用-相同方式共享 4.0 国际许可协议 进行许可

图像用于教育目的,由我创建,或借自我的同事 这里。

原始。经许可转载。

简介: 亚伦·王 目前在 MIT 攻读商业分析硕士学位,专注于商业与数据科学的交叉点。亚伦对 AI/ML 在技术领域的未来充满热情,愿意聊聊相关机会。

相关:

更多相关主题

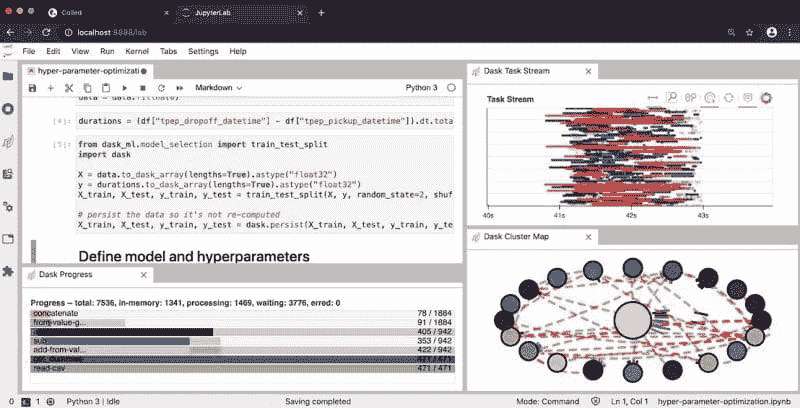

在云端使用 Dask 进行数据科学

评论

由 Hugo Bowne-Anderson,Coiled 数据科学推广负责人和市场营销副总裁

在数据科学和机器学习中,扩展大数据分析的能力变得越来越重要,并且增长迅速。幸运的是,像 Dask 和 Coiled 这样的工具使得人们可以轻松而迅速地做到这一点。

我们的前 3 个课程推荐

1. Google Cybersecurity Certificate - 快速进入网络安全职业生涯。

1. Google Cybersecurity Certificate - 快速进入网络安全职业生涯。

2. Google Data Analytics Professional Certificate - 提升你的数据分析水平

2. Google Data Analytics Professional Certificate - 提升你的数据分析水平

3. Google IT Support Professional Certificate - 支持你的组织 IT

3. Google IT Support Professional Certificate - 支持你的组织 IT

Dask 是在 PyData 生态系统和 Python 中扩展分析的热门解决方案。这是因为 Dask 设计用于并行化任何 PyData 库,因此可以无缝地与 PyData 工具配合使用。

扩展 分析以利用单个工作站的所有核心是开始处理大数据集时的第一步。

接下来,为了利用云上的集群(如 Azure、Google Cloud Platform、AWS 等),你可能需要 扩展 计算。

继续阅读,我们将:

-

使用 pandas 展示数据科学工作流中的常见模式,

-

利用 Dask 扩展工作流,利用单个工作站的核心,并且

-

演示如何将我们的工作流扩展到云端,使用 Coiled Cloud。

所有代码 在这里查看 github。

注意:在开始之前,考虑一下是否真的需要扩展你的计算。在开始之前考虑让 pandas 代码更高效。通过绘制学习曲线来衡量更多数据是否会提升模型表现。

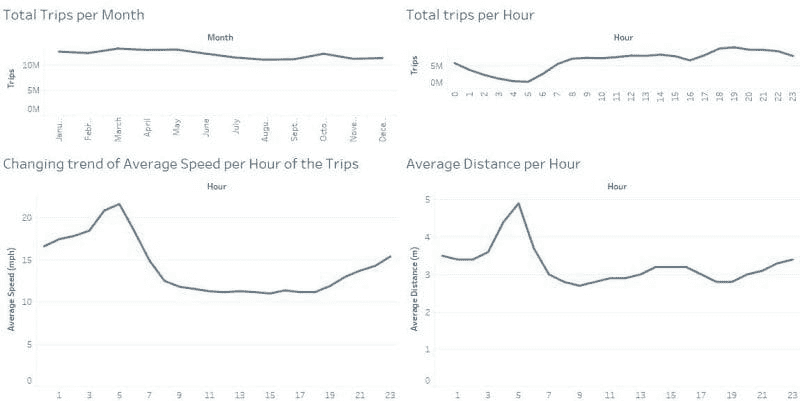

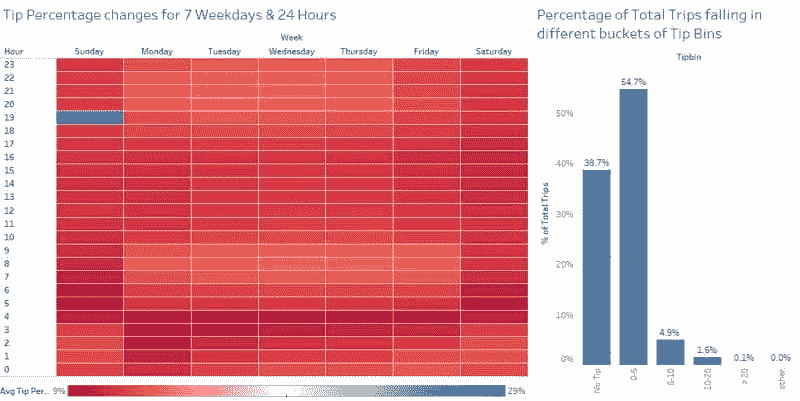

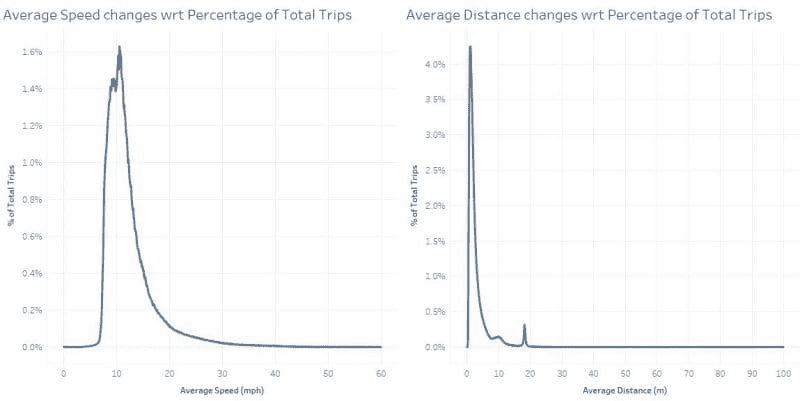

PANDAS 和 ETL:数据科学中的常见模式

首先,我们将使用 pandas 在内存数据集上介绍一个常见的数据科学模式。这是 NYC 出租车数据集的 700 MB 子集,总体约为 10 GB。

我们希望看到扩展的光芒四射,因此我们选择了一个相对乏味的工作流。现在我们读取数据,处理数据,创建特征,并将其保存为 Parquet(不可读但比 CSV 高效得多)。

# Import pandas and read in beginning of 1st file

import pandas as pd

df = pd.read_csv("data_taxi/yellow_tripdata_2019-01.csv")

# Alter data types for efficiency

df = df.astype({

"VendorID": "uint8",

"passenger_count": "uint8",

"RatecodeID": "uint8",

"store_and_fwd_flag": "category",

"PULocationID": "uint16",

"DOLocationID": "uint16",

})

# Create new feature in dataset: tip_ratio

df["tip_ratio"] = df.tip_amount / df.total_amount

# Write to parquet

df.to_parquet("data_taxi/yellow_tripdata_2019-01.parq")

这在我的笔记本电脑上大约花了 1 分钟,这是我们可以容忍的分析等待时间(也许)。

现在我们想对整个数据集执行相同的分析。

DASK: 扩展你的数据科学

数据集的 10GB 大小超过了我的笔记本电脑的 RAM,因此我们不能将其存储在内存中。

相反,我们可以编写一个 for 循环:

for filename in glob("~/data_taxi/yellow_tripdata_2019-*.csv"):

df = pd.read_csv(filename)

...

df.to_parquet(...)

然而,我的笔记本电脑上的多个核心通过这种方法没有得到充分利用,这也不是一种优雅的解决方案。这里就需要 Dask 来实现单机并行处理。

导入 Dask 的几个方面,我们将启动一个本地集群并启动一个 Dask 客户端:

from dask.distributed import LocalCluster, Client

cluster = LocalCluster(n_workers=4)

client = Client(cluster)

client

然后我们导入 Dask DataFrame,懒惰地读取数据,并执行 ETL 管道,就像之前用 pandas 做的那样。

import dask.dataframe as dd

df = dd.read_csv(

"data_taxi/yellow_tripdata_2019-*.csv",

dtype={'RatecodeID': 'float64',

'VendorID': 'float64',

'passenger_count': 'float64',

'payment_type': 'float64'}

)

# Alter data types for efficiency

df = df.astype({

"VendorID": "UInt8",

"passenger_count": "UInt8",

"RatecodeID": "UInt8",

"store_and_fwd_flag": "category",

"PULocationID": "UInt16",

"DOLocationID": "UInt16",

})

# Create new feature in dataset: tip_ratio

df["tip_ratio"] = df.tip_amount / df.total_amount

# Write to Parquet

df.to_parquet("data_taxi/yellow_tripdata_2019.parq")

在我的笔记本电脑上大约需要 5 分钟,我们可以称其为可接受的(我想)。但是,如果我们想做一些稍微复杂的事情(这是我们常做的!),这段时间将迅速增加。

如果我可以访问云上的集群,现在就是利用它的时候!

但首先,让我们反思一下我们刚刚解决了什么:

-

我们使用了一个 Dask DataFrame——一个大型虚拟数据框,按索引划分为多个 Pandas DataFrame

-

我们正在使用一个本地集群,包含:

-

一个 调度器(负责组织和分配工作/任务给工作者),以及,

-

工作者,用于计算这些任务

-

-

我们已经启动了一个 Dask 客户端,它是“集群用户的用户界面入口”。

总之——客户端存在于你编写 Python 代码的地方,客户端与调度器进行通信,传递任务。

COILED: 扩展你的数据科学

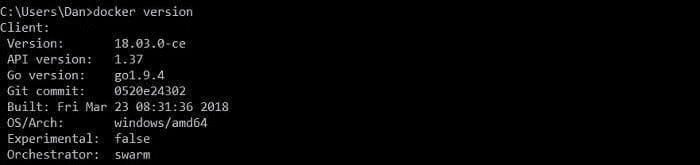

现在我们所期待的时刻到了——是时候跃入云端了。如果你可以访问云资源(如 AWS)并知道如何配置 Docker 和 Kubernetes 容器,你可以在云中启动一个 Dask 集群。然而,这将是耗时的。

进入一个方便的替代方案:Coiled,我们将在这里使用它。为此,我登录了 Coiled Cloud(目前 Beta 是免费的计算!),安装了 coiled,并进行了身份验证。请随意跟随并自己操作。

pip install coiled --upgrade

coiled login # redirects you to authenticate with github or google

然后我们进行必要的导入,启动一个集群(大约需要一分钟),并实例化我们的客户端:

import coiled

from dask.distributed import LocalCluster, Client

cluster = coiled.Cluster(n_workers=10)

client = Client(cluster)

接下来我们导入我们的数据(这次来自 s3),并执行我们的分析:

import dask.dataframe as dd

# Read data into a Dask DataFrame

df = dd.read_csv(

"s3://nyc-tlc/trip data/yellow_tripdata_2019-*.csv",

dtype={

'RatecodeID': 'float64',

'VendorID': 'float64',

'passenger_count': 'float64',

'payment_type': 'float64'

},

storage_options={"anon":True}

)

# Alter data types for efficiency

df = df.astype({

"VendorID": "UInt8",

"passenger_count": "UInt8",

"RatecodeID": "UInt8",

"store_and_fwd_flag": "category",

"PULocationID": "UInt16",

"DOLocationID": "UInt16",

})

# Create new feature in dataset: tip_ratio

df["tip_ratio"] = df.tip_amount / df.total_amount

# Write to Parquet

df.to_parquet("s3://hugo-coiled-tutorial/nyctaxi-2019.parq")

在 Coiled Cloud 上这花了多久?30 秒。 即使对于这个相对简单的分析,这也比我的笔记本电脑上所需的时间少了一个数量级。

很容易看出在单一工作流中进行这组分析的强大之处。我们不需要切换上下文或环境。而且,当我们完成后,可以简单地从 Coiled 切换回本地工作站的 Dask 或 pandas。云计算在需要时非常棒,但在不需要时可能会带来负担。我们刚刚经历了一个负担要少得多的体验。

你需要更快的数据科学吗?

你现在可以免费开始使用 Coiled 集群。Coiled 还处理安全、conda/docker 环境和团队管理,因此你可以专注于数据科学和工作。立即开始使用 Coiled Cloud。

简介: Hugo Bowne-Anderson Hugo Bowne-Anderson 是Coiled的首席数据科学传播官和市场营销副总裁(@CoiledHQ, LinkedIn)。他在数据科学家、教育者、传播者、内容营销员和数据战略顾问方面具有丰富经验,涉及工业界和基础研究。他还在耶鲁大学和冷泉港实验室等机构、SciPy、PyCon 和 ODSC 等会议以及 Data Carpentry 等组织中教授数据科学。他致力于传播数据技能、数据科学工具的使用以及开源软件,无论是个人还是企业。

相关:

-

Dask 中的机器学习

-

为什么以及如何在大数据中使用 Dask

-

Dask 中的 K-means 聚类:猫咪图片的图像滤镜

更多相关话题

数据科学命令行:探索数据

原文:

www.kdnuggets.com/2018/02/data-science-command-line-book-exploring-data.html

评论

数据科学的工具多种多样,涵盖了各种生态系统。Python 和 R 是一些比较受欢迎的编程环境,但还有许多其他选项,包括大量的编程和脚本语言、GUI 和基于 web 的工具。

数据科学的工具多种多样,涵盖了各种生态系统。Python 和 R 是一些比较受欢迎的编程环境,但还有许多其他选项,包括大量的编程和脚本语言、GUI 和基于 web 的工具。

一种较少考虑的攻击方式是严格的命令行方法。确实,你可能使用命令行来执行 Python 脚本,运行 C 程序,或调用 R 环境……或进行其他操作。但从终端运行整个过程呢?

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速入门网络安全职业。

1. 谷歌网络安全证书 - 快速入门网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你在 IT 领域的组织

3. 谷歌 IT 支持专业证书 - 支持你在 IT 领域的组织

回答这个问题的是Jeroen Janssens,他是现在免费提供的书籍《数据科学命令行》的作者。书籍的网站上:

本指南展示了命令行的灵活性如何帮助你成为更高效、更有生产力的数据科学家。你将学会如何将小而强大的命令行工具结合起来,以快速获取、清理、探索和建模你的数据。

...

发现为什么命令行是一种灵活、可扩展且可延展的技术。即使你已经熟练使用 Python 或 R 处理数据,通过利用命令行的强大功能,你的数据显示工作流将得到显著提升。

除了编写关于数据科学命令行工具的详尽调查外,Jeroen 还准备了一个Docker 镜像,其中包含 80 多种相关工具,这些工具在书中都有涉及。

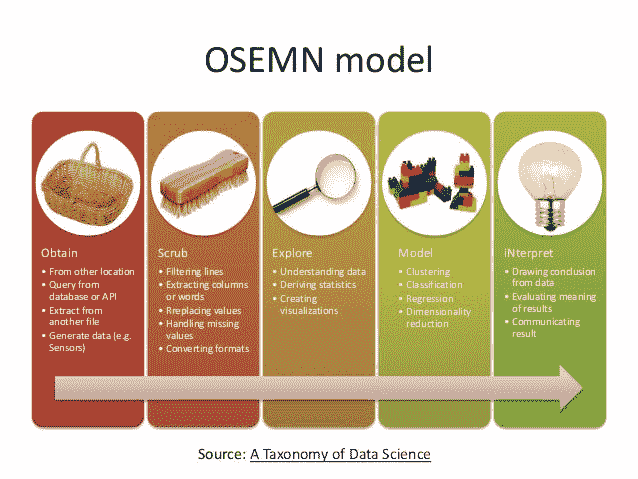

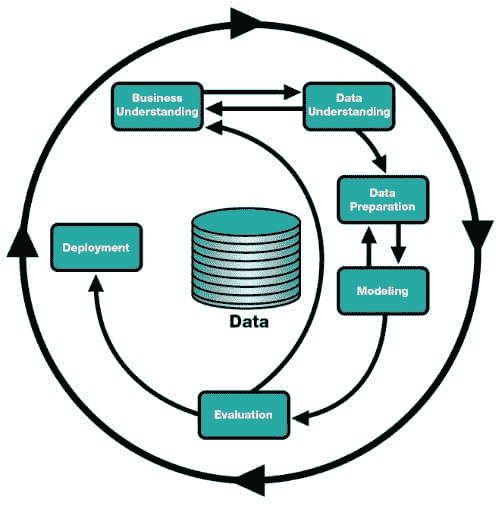

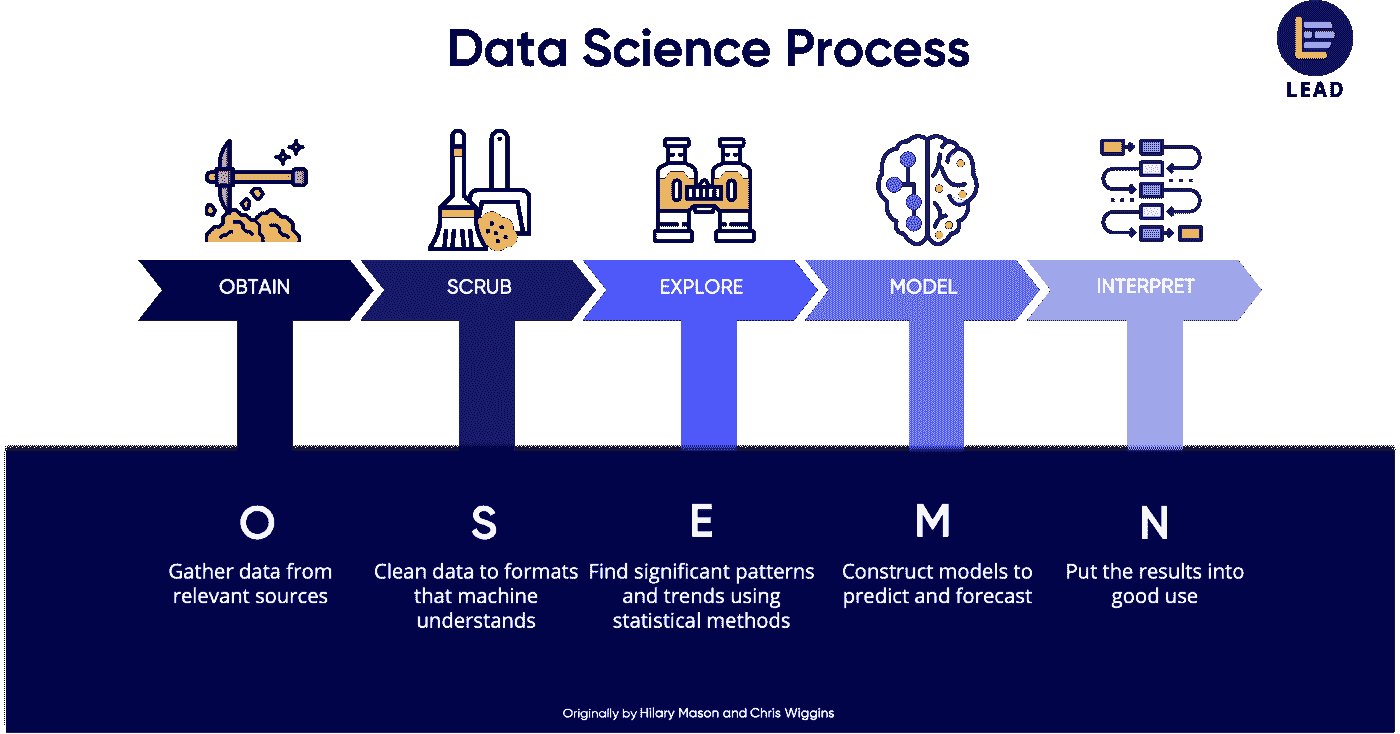

第七章《数据科学命令行》一书的标题为“探索数据”,重点介绍在OSEMN 模型的第三步中使用命令行工具。

OSEMN 模型(来源)。

你可以从三个视角探索数据。第一个视角是检查数据及其属性。在这里,我们想知道,例如,原始数据是什么样的,数据集有多少数据点,以及数据集具有哪些特征。

探索数据的第二种视角是计算描述性统计。这种视角对于了解单个特征非常有用。一个优势是输出通常简洁且为文本格式,因此可以在命令行上打印出来。

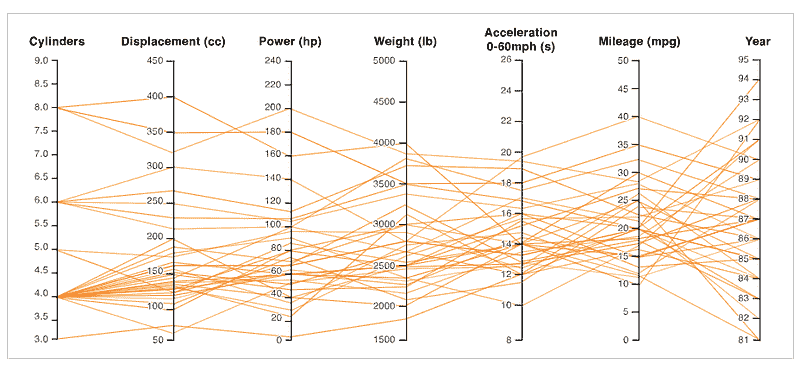

第三个视角是创建数据的可视化。从这个视角我们可以深入了解多个特征如何相互作用。我们将讨论一种在命令行上打印的可视化创建方式。然而,可视化最适合在图形用户界面上显示。可视化相对于描述性统计的一个优势是它们更灵活,并且可以传达更多的信息。

这里快速展示了你在命令行中探索数据时可以完成的任务。

首先,你需要安装python3-csvkit:

$ sudo apt install python3-csvkit

然后,下载一个 CSV 文件进行操作:

$ wget https://raw.githubusercontent.com/uiuc-cse/data-fa14/gh-pages/data/iris.csv

我们可以使用head打印iris.csv的前几行:

$ head iris.csv

sepal_length,sepal_width,petal_length,petal_width,species

5.1,3.5,1.4,0.2,setosa

4.9,3,1.4,0.2,setosa

4.7,3.2,1.3,0.2,setosa

4.6,3.1,1.5,0.2,setosa

5,3.6,1.4,0.2,setosa

5.4,3.9,1.7,0.4,setosa

4.6,3.4,1.4,0.3,setosa

5,3.4,1.5,0.2,setosa

4.4,2.9,1.4,0.2,setosa

很方便。但使用csvlook(python3-csvkit的一部分),你会得到一个更表格化的视图:

$ head iris.csv | csvlook

|---------------+-------------+--------------+-------------+----------|

| sepal_length | sepal_width | petal_length | petal_width | species |

|---------------+-------------+--------------+-------------+----------|

| 5.1 | 3.5 | 1.4 | 0.2 | setosa |

| 4.9 | 3 | 1.4 | 0.2 | setosa |

| 4.7 | 3.2 | 1.3 | 0.2 | setosa |

| 4.6 | 3.1 | 1.5 | 0.2 | setosa |

| 5 | 3.6 | 1.4 | 0.2 | setosa |

| 5.4 | 3.9 | 1.7 | 0.4 | setosa |

| 4.6 | 3.4 | 1.4 | 0.3 | setosa |

| 5 | 3.4 | 1.5 | 0.2 | setosa |

| 4.4 | 2.9 | 1.4 | 0.2 | setosa |

|---------------+-------------+--------------+-------------+----------|

更好。想查看整个文件吗?虽然我一直将cat的输出传输到more中:

$ cat iris.csv | more

... Jeroen 提倡使用less,这是一个更通用的命令行工具,操作风格类似于vi文本编辑器。它允许使用一系列单键命令在文本文件中移动。试试看('q'表示退出):

$ iris.csv csvlook | less -S

想知道数据集的属性名称吗?很简单,使用特殊的编辑器sed:

$ < iris.csv sed -e 's/,/\n/g;q'

sepal_length

sepal_width

petal_length

petal_width

species

很好。那么更多的属性元数据呢?

$ csvstat iris.csv

1\. sepal_length

Nulls: False

Min: 4.3

Max: 7.9

Sum: 876.5000000000002

Mean: 5.843333333333335

Median: 5.8

Standard Deviation: 0.8253012917851412

Unique values: 35

5 most frequent values:

5.0: 10

6.3: 9

5.1: 9

6.7: 8

5.7: 8

...

数据集中的唯一属性值计数如何?

$ csvstat iris.csv --unique

1\. sepal_length: 35

2\. sepal_width: 23

3\. petal_length: 43

4\. petal_width: 22

5\. species: 3

根据你对命令行的熟悉程度或依赖程度(或愿意成为的程度),你可以深入了解更高级的概念,如创建包含多个顺序执行命令的 bash 脚本。然而,这将从“命令行”数据科学转向更熟悉的脚本编写领域,但使用的是 bash 而不是例如 Python。你也可以做一些介于两者之间的事情,比如创建一个包含 bash 片段的库作为函数,并将它们添加到你的.bashrc配置文件中,以便在命令行上重复调用它们处理不同的数据。可能性仅受限于你的想象力和技能。

这只是《命令行中的数据科学》第七章中的一部分,而这本书只是触及了书中蕴含的丰富信息。

无论你怎么看,拥有命令行技能都是无价的。在这种情况下,你应该给这本书一个机会。

相关:

-

使用 Python 掌握数据准备的 7 个步骤

-

文本数据预处理的一般方法

-

Python 中的探索性数据分析

进一步了解这个话题

《命令行中的数据科学:免费电子书》

原文:

www.kdnuggets.com/2022/03/data-science-command-line-free-ebook.html

图片由作者提供

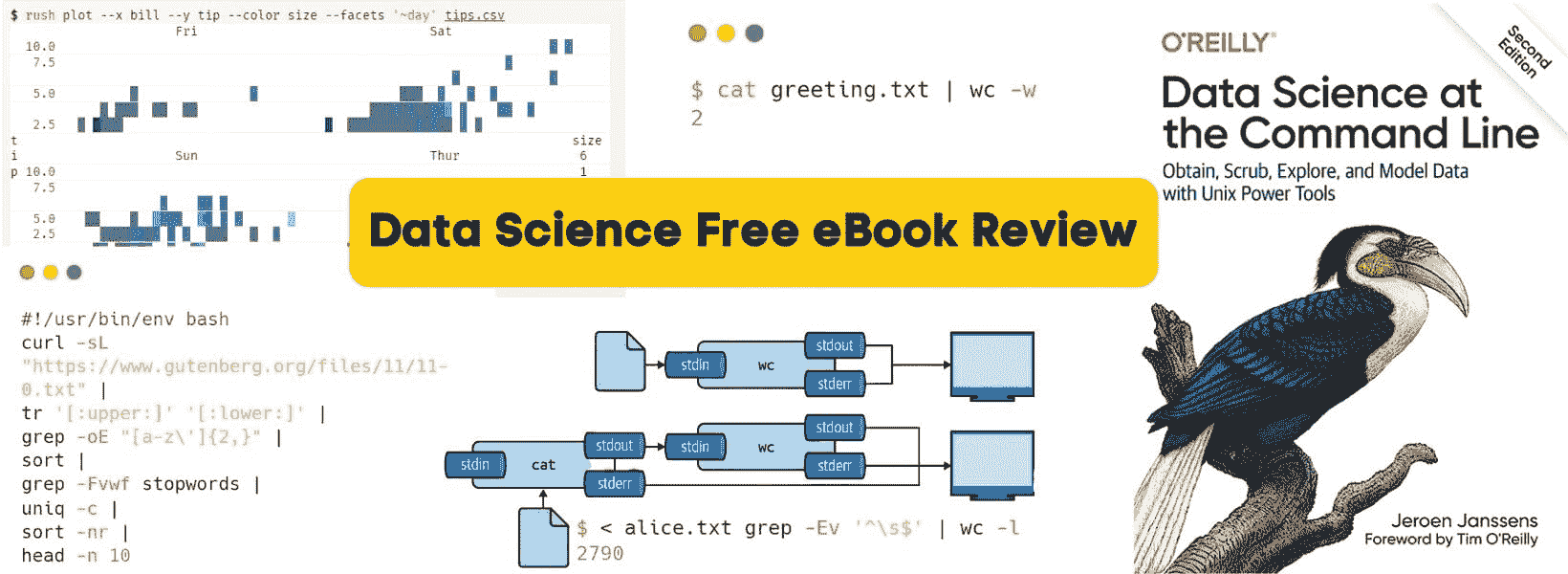

去年年底,我非常渴望了解关于 MLOps 的一切,最终目标是建立一个端到端的机器学习系统。像其他好奇的人一样,我报名参加了 Noah Gift 主办的 MLOps 事件。他在推广他的书和 Coursera 上的教程。我惊讶于自己从未学习过命令行工具以及它们在自动化中的重要性。在问答环节中,我告诉他我对这些工具的痴迷,他建议我参加他的 DataCamp 迷你课程:Python 中的命令行自动化。这门课程让我对数据管道、数据编辑、创建脚本以及如何在终端中用一行代码实现与 Python 中 15 行代码相同的结果有了新的看法。因此,我继续寻找有关命令行的最佳资料,最后找到了 Jeroen Janssens 的《命令行中的数据科学》(Amazon)。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

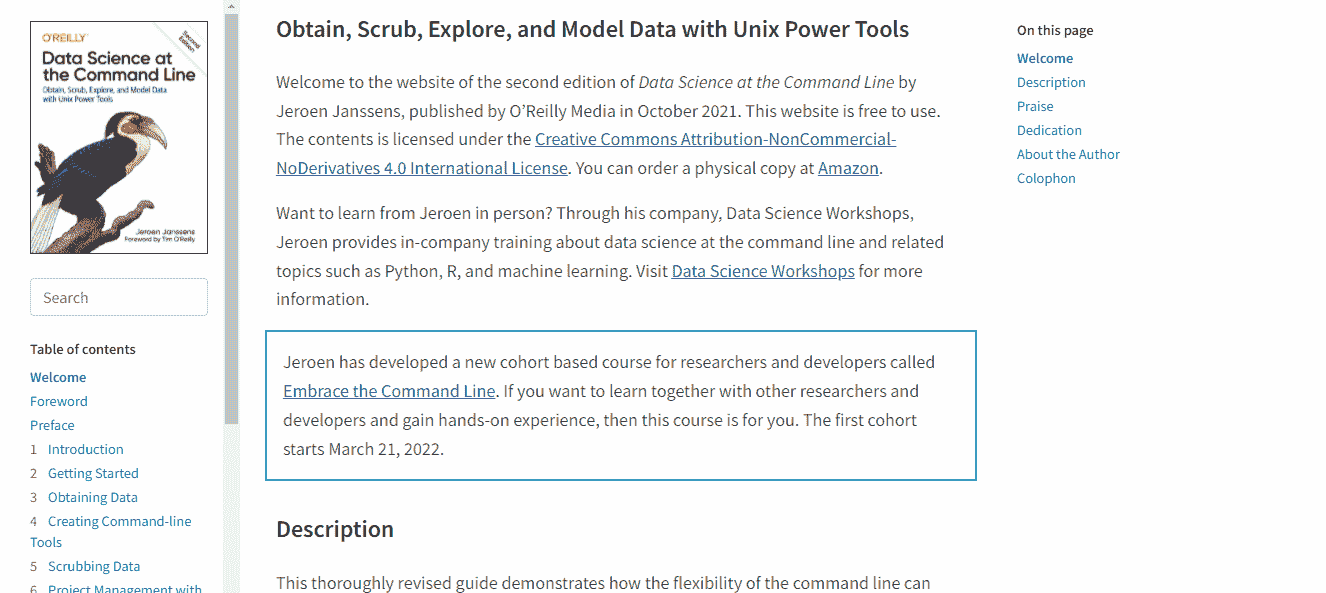

关于本书

获取免费电子书 | 在 GitHub 上收藏 | 在亚马逊上购买

本书通过编程示例解释了如何利用 Unix 强大工具执行与数据科学相关的所有任务。本书适合所有数据专业人士、工程师、系统管理员和研究人员。免费的电子书是互动式的,几乎没有时间就能掌握所有核心主题。我读过电子书、PDF 和纸质书,但这种阅读方式简直是一个新境界。它就像是在阅读你最喜欢的库的文档,但更好。

本书内容包括:

-

获取数据

-

创建命令行工具

-

清理数据

-

使用 Make 的项目管理

-

探索数据

-

并行管道

-

数据建模

-

多语言数据科学

在这本书中,你将学习如何使用 API、数据集和电子表格来提取数据。接着,进行数据清理和操作。之后,你将学习如何使用rush进行数据分析和可视化。你还将学会管理数据科学工作流程、创建并行管道以及构建机器学习模型(回归、分类)。除了核心主题,你还会学到如何利用 Unix 的强大工具提升你进行快速数据分析的效率。

我喜欢如何使用csvsql对 CSV 文件运行 SQL 查询,以及如何使用rush绘制各种图表。我从未见过任何机器学习工程师使用命令行工具进行数据预处理、创建模型和评估结果。当我第一次读到建模部分时,我感到怀疑,我知道他们必须使用 Python 或 R 脚本进行训练,但令我惊讶的是,作者使用了vw进行训练和评估。

特殊功能

这本书有许多突出的特点,但其中一些令人震惊的特性将在本评论中提到。

数据分析

一行代码的数据分析结合强大工具和 SQL 查询是我从未想象过的。这本书解释了多种提取和分析数据的方法,如使用 grep、header、trim 和 csvsql。

$ seq 5 | header -a val | csvsql --query "SELECT SUM(val) AS sum FROM stdin"

sum

15.0

数据可视化

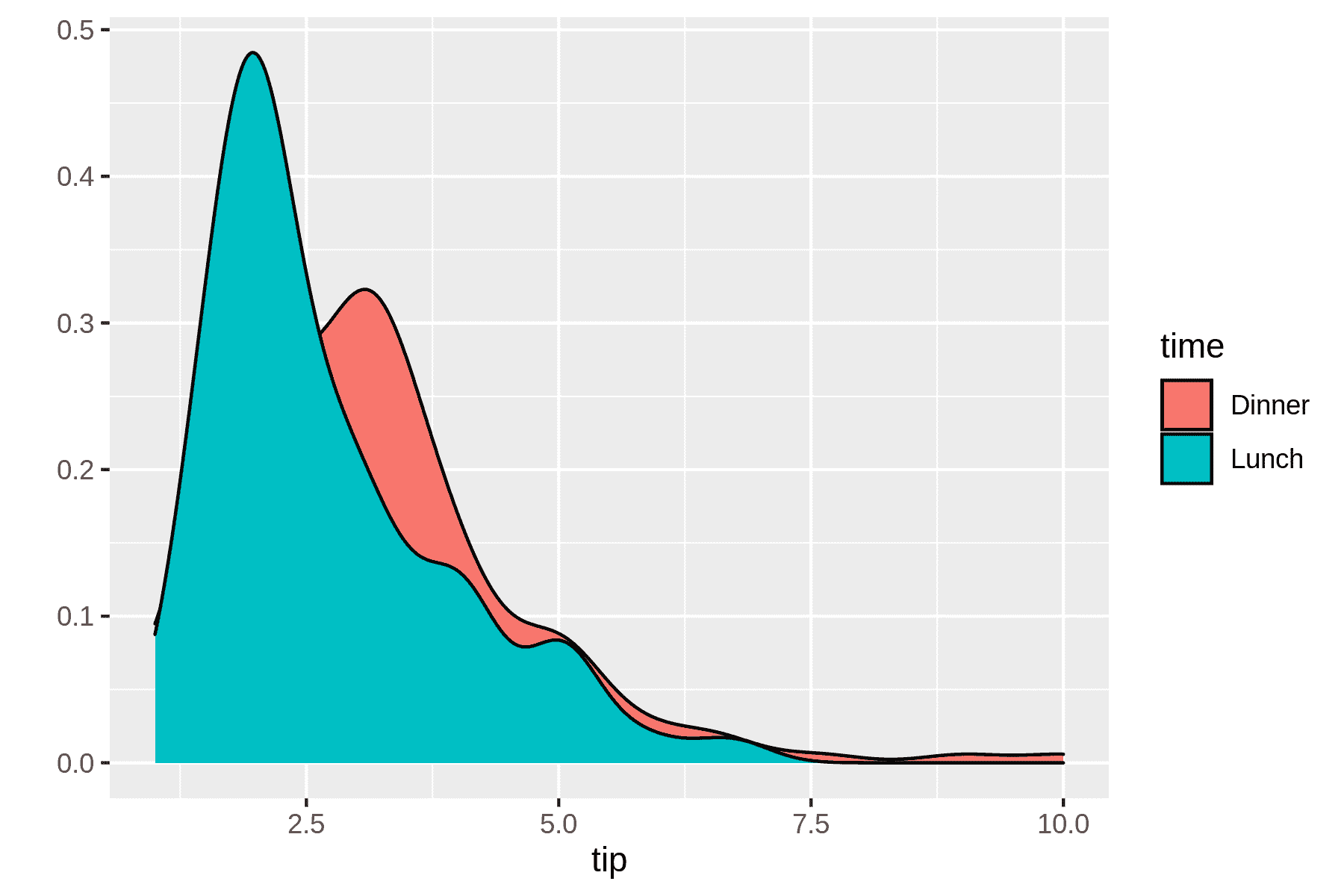

这本书展示了如何使用rush进行任何基于R的数据分析。运行复杂的统计函数,探索数据,然后使用ggplot以任何形式可视化数据。书中还教你如何创建自己的工具,以优化当前的工作流程。

$ rush plot --x tip --fill time --geom density tips.csv > plot-density.png

$ display plot-density.png

模型训练

我仍然对如何使用vw进行回归分析以及如何使用skll训练分类模型感到惊讶。我不想透露太多,因为你需要亲自体验才能理解。

$ skll -l classify.cfg 2>/dev/null

这些工具接受多个参数,并使用相同的算法训练模型。没有什么不同,只是我们用一行脚本完成所有这些。在 Python 中,我们需要写至少 20-30 行代码才能获得类似的结果。

$ < output/wine_summary.tsv csvsql --query "SELECT learner_name, accuracy FROM s

tdin ORDER BY accuracy DESC" | csvlook -I

│ learner_name │ accuracy │

├────────────────────────┼───────────┤

│ LogisticRegression │ 0.9953125 │

│ RandomForestClassifier │ 0.9953125 │

│ KNeighborsClassifier │ 0.99375 │

│ DecisionTreeClassifier │ 0.984375 │

GNU 并行管道

如果你正在处理大型文件或下载大型数据集,parallel将减少运行任何计算过程的时间。它将允许你并行化和分配命令及管道。parallel的最佳之处在于,你不需要修改当前的工具就能运行并行任务。

$ seq 0 2 100 | parallel "echo {}² | bc" | trim

0

4

16

36

64

100

144

196

256

324

... with 41 more lines

结论

数据科学是一个令人兴奋的领域,而命令行工具使其更加有趣,因为它简化了复杂性,并提供了用一行代码执行任务的新方法。书中完美地解释了这些强大工具的必要性以及如何利用它们改进当前的数据科学工作流程。如果你决定阅读这本书,我建议你通过编写脚本并自行测试来学习。书中还指导你拉取并运行 docker 镜像,以便你无需手动安装 Unix 强大工具。

这本免费 电子书 遵循 CC BY-NC-ND 4.0 许可协议。你也可以在 亚马逊购买纸质版。

Abid Ali Awan (@1abidaliawan) 是一位认证的数据科学专家,他热衷于构建机器学习模型。目前,他专注于内容创作和撰写有关机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是使用图神经网络构建一个 AI 产品,帮助那些受心理疾病困扰的学生。

更多相关主题

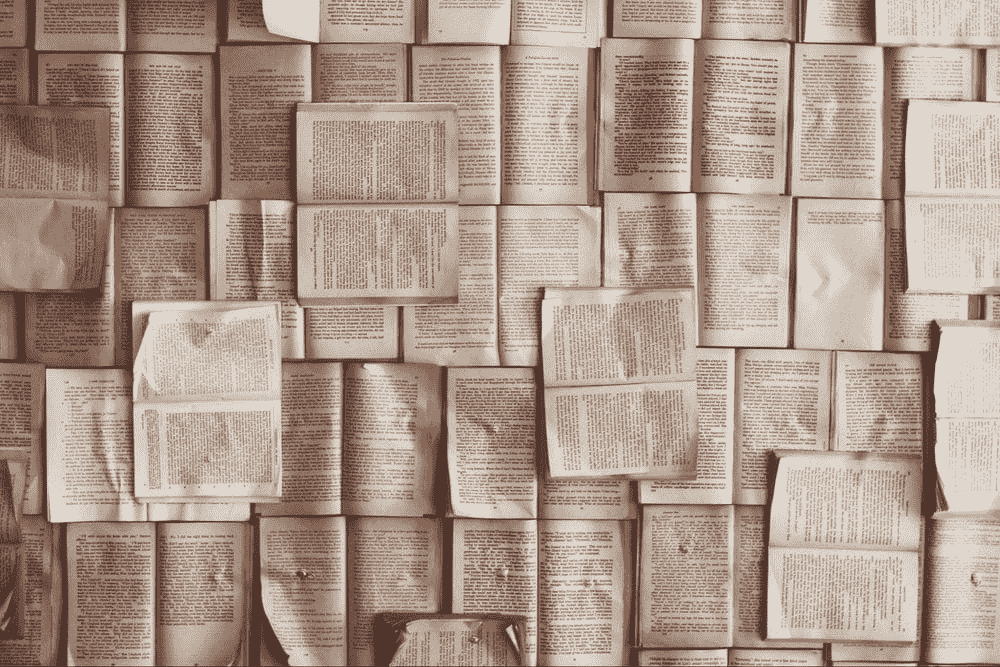

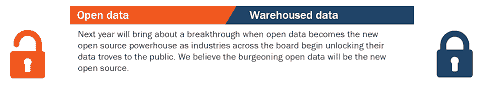

数据科学中最常用、最令人困惑和滥用的术语

原文:

www.kdnuggets.com/2015/02/data-science-confusing-jargon-abused.html

评论

评论

大数据正当红。全球网络设备系统每秒产生数 TB 的数据。负担得起的存储使得记录看似任意数量的信息成为可能。机器学习算法以及分布式计算,越来越能够从这些信息中提取可操作的智能。但“大数据”究竟意味着什么?

随着数据科学重要性的提升,与之相关的术语体系也在不断扩展。虽然许多术语定义明确,但其他术语则是流行词汇,在媒体中无处不在,却缺乏具体意义。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

在这篇文章中,我将从多个角度, namely 理论家、实证数据科学家和新闻稿的夸张表述,提供对数据科学流行词的看法,这些表述往往被主流媒体盲目重复。

大数据

理论家: 大数据是一个定义不明确的术语。它可能比中等规模数据大,但又比巨型数据小。

数据科学家: 与长期主导机器学习研究的玩具数据集不同,今天的大数据足够庞大,无法方便地适应单台工作站的主内存。分析大数据需要利用分布式计算和并行算法。简而言之,大数据 是指比单台机器的主内存能容纳的数据更多的数据。

新闻稿: 大数据对软件开发人员而言是一个宝贵的资源,对现代企业来说,像水对地球生存一样必要。大数据利用云计算的力量生成多彩的图表,否则你在今天的经济中就会像恐龙一样过时。你是否有大数据策略来跟上硅谷的步伐?

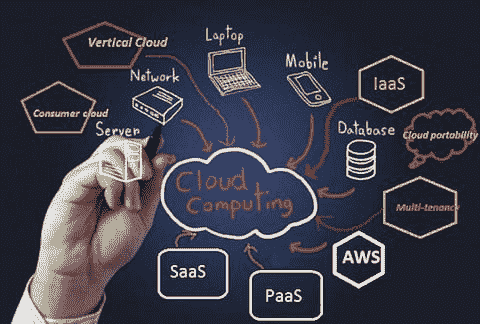

云计算

理论家: 云指的是远程计算。幸运的是,对分布式系统的兴趣激发了对可并行算法的关注。

数据科学家: 分布式计算资源的可用性大大扩展了数据科学社区的能力。我们可以在数十台或数百台虚拟机上同时训练模型。我们可以使用 Hadoop 等工具分配计算资源。所有这些都无需在硬件上进行重大前期资本投资。

新闻稿: 云。服务。平台。谷歌,亚马逊,脸书,Azure。云无处不在。一切都在向云端迁移。一切都生活在云端。甚至云本身也在云端。公共云,私人云,元云。你的业务有云战略吗?

深度神经网络

理论家: 深度神经网络指的是一种图形模型,其中数据通过一层层的节点进行计算。‘神经’这个词可能会误导人。尽管这些系统的经验表现令人印象深刻,但其数学属性仍然不甚了解。

数据科学家: 受到生物学的启发,深度神经网络由接收兴奋性或抑制性输入的节点组成,边缘模拟突触。这些模型在涉及机器感知和自然语言的许多任务中实现了最先进的性能。

新闻稿: 深度学习是一项激进的新技术,利用大脑的力量赋予机器类人的智能。这项变革性技术可能加速奇点的到来,催生出能够思考、感受、吸收人类知识总和并殖民半人马座α星的类人机器人一代。

隐私

理论家: 长期以来,“隐私”缺乏具体定义。在过去几年中,已经在数据库查询机制的背景下提出了一些隐私的数学定义。差分隐私量化了个人信息由于其包含在数据库中而泄露的概率。

数据科学家: 在互联网上,很可能没有人正在做任何保护你隐私的工作。我们是为了从数据库中提取信息而获得报酬的,而不是为了防止信息泄露而加固它们。为什么要在数据中添加噪音呢?这会使我们的算法性能看起来更差。隐私并不存在。

新闻稿: 你的信息经过四重加密,采用银行级的 Fort Knox 安全保护!没有人,甚至我们的 CEO 都无法查看你的私人信息。使用我们的产品,知道隐私是我们的首要任务!

预测编码 / 数据分析

理论家: 预测编码是文档分类的重新品牌化,用于向律师销售电子发现产品。数据分析是数据分析的同义词。

数据科学家: 当我们向一家律师事务所推介一个用户友好的二分类工具,以帮助通过线性模型和词袋表示法检索相关文档时,他们并未感到满意。在下一个演示文稿中,我们描述了“预测编码”,我们的突破性“数据分析”技术用于“知识大脑”。

新闻稿: 预测编码代表了人工智能与法律工作流程之间的变革性协同,以前所未有的规模为客户带来成功。最先进的预测编码数据分析将使你的竞争对手过时。

Zachary Chase Lipton 是加州大学圣地亚哥分校计算机科学工程系的博士生。在生物医学信息学部资助下,他对机器学习的理论基础和应用都感兴趣。除了在 UCSD 的工作外,他还曾在微软研究院实习。

Zachary Chase Lipton 是加州大学圣地亚哥分校计算机科学工程系的博士生。在生物医学信息学部资助下,他对机器学习的理论基础和应用都感兴趣。除了在 UCSD 的工作外,他还曾在微软研究院实习。

相关:

-

(深度学习的深层缺陷)’s 深层缺陷

-

差分隐私:如何使隐私与数据挖掘兼容

-

Geoff Hinton AMA:神经网络、大脑和机器学习

了解更多

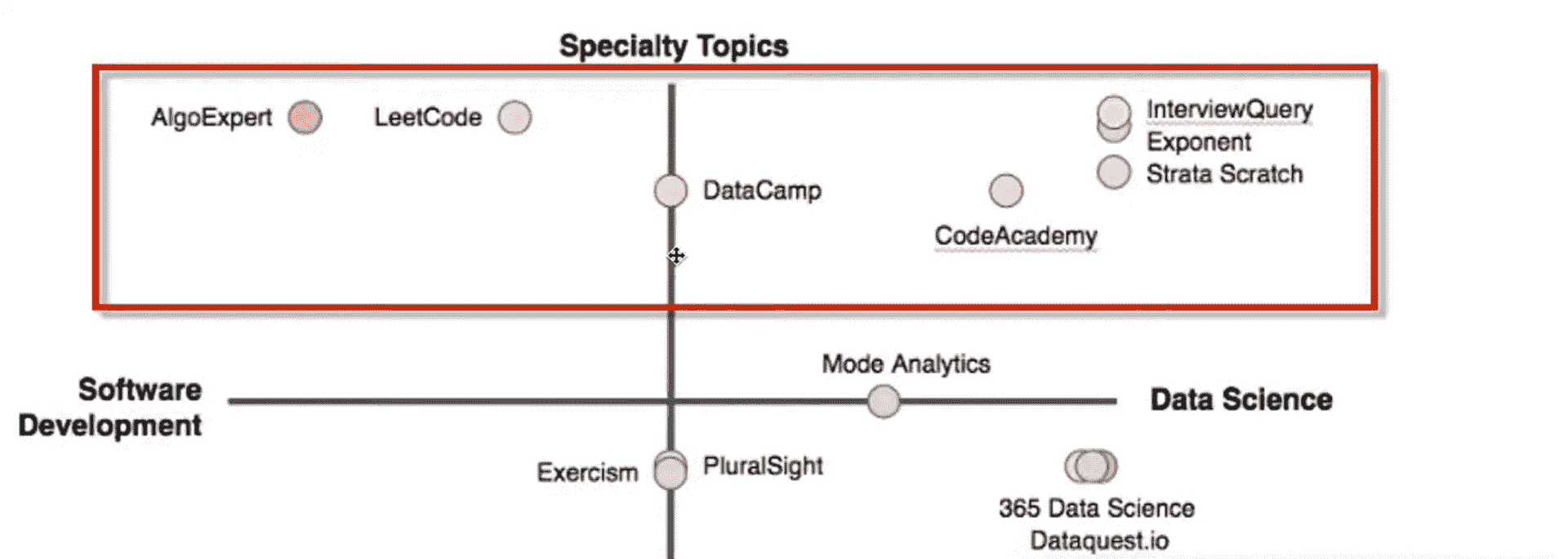

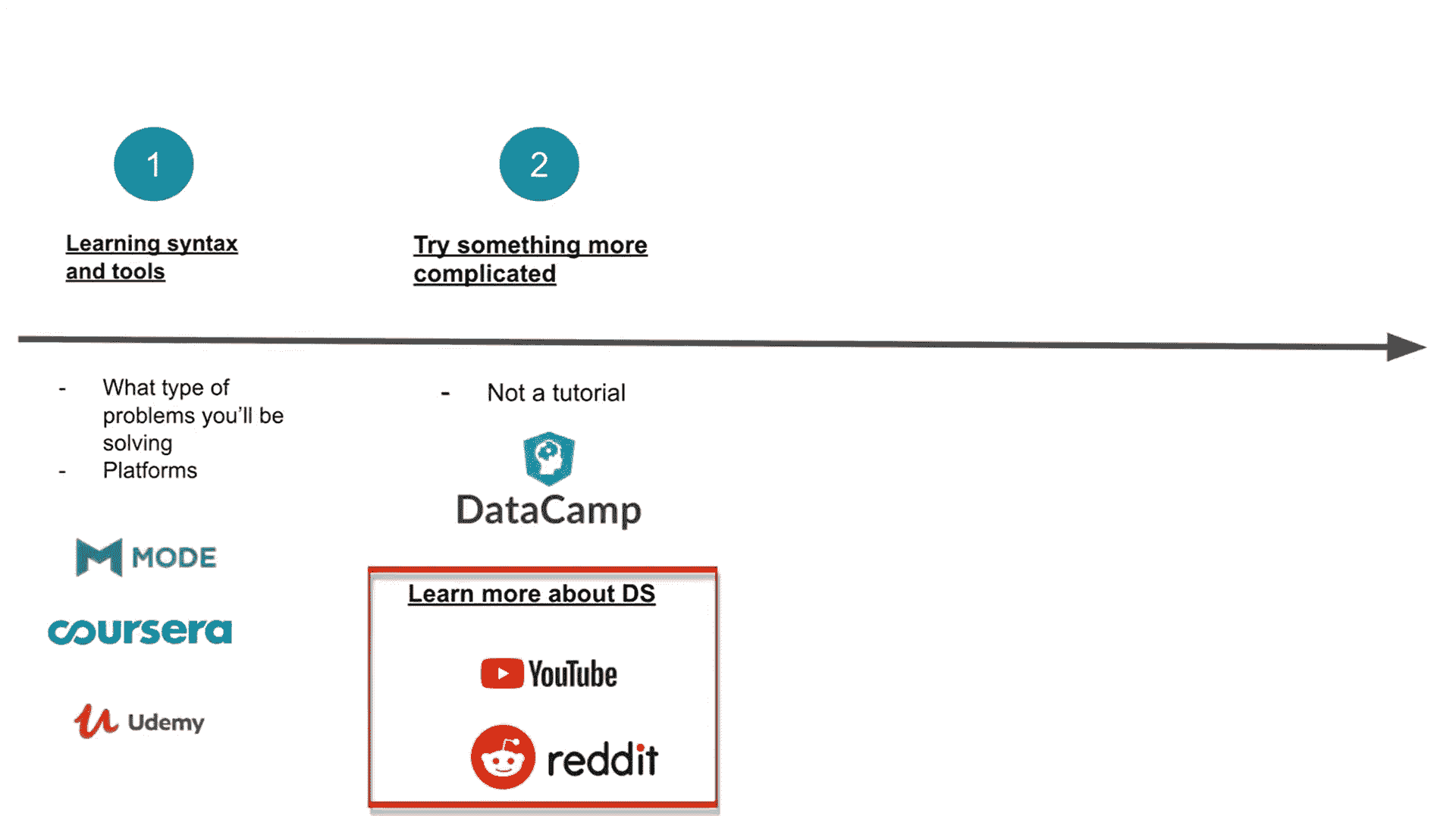

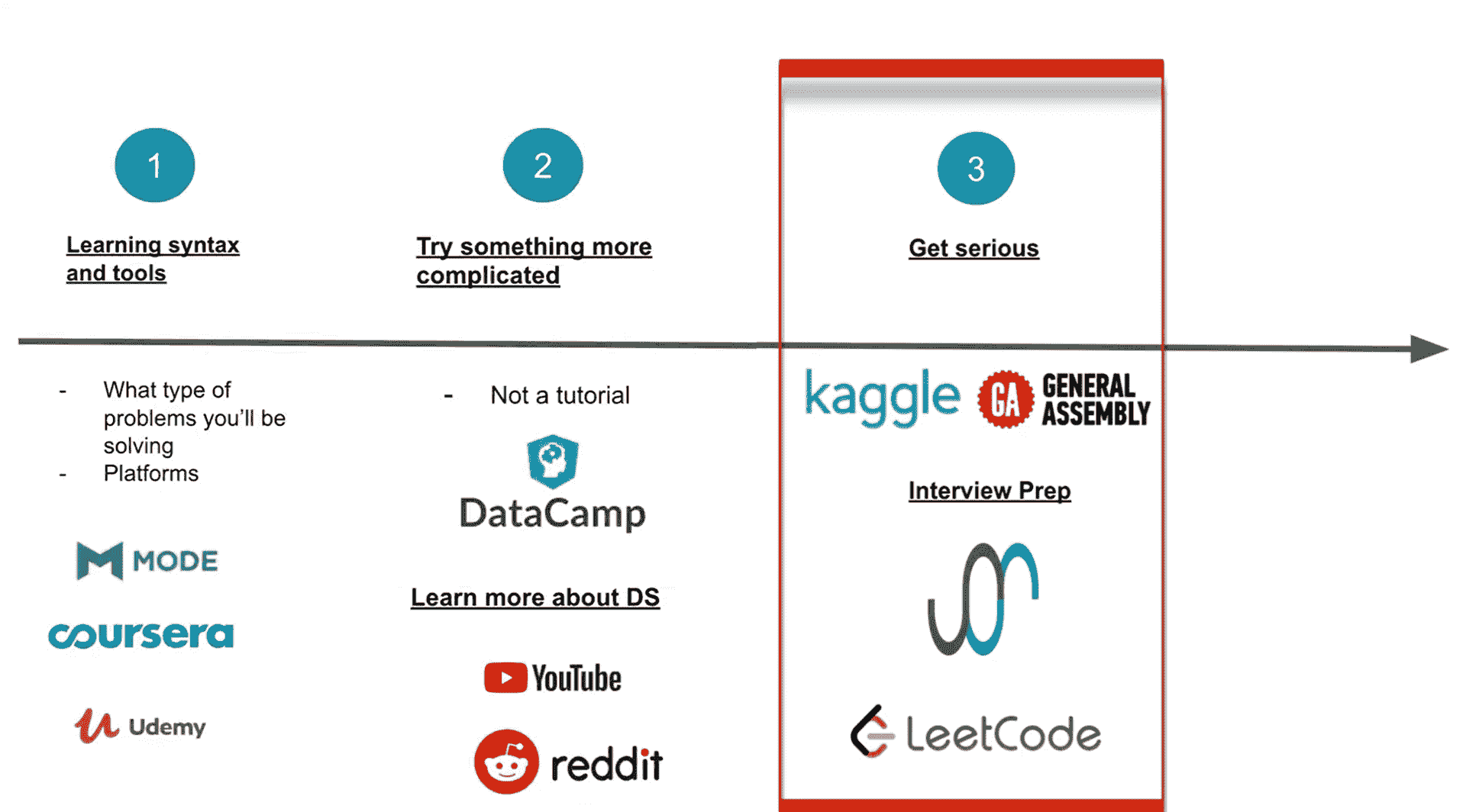

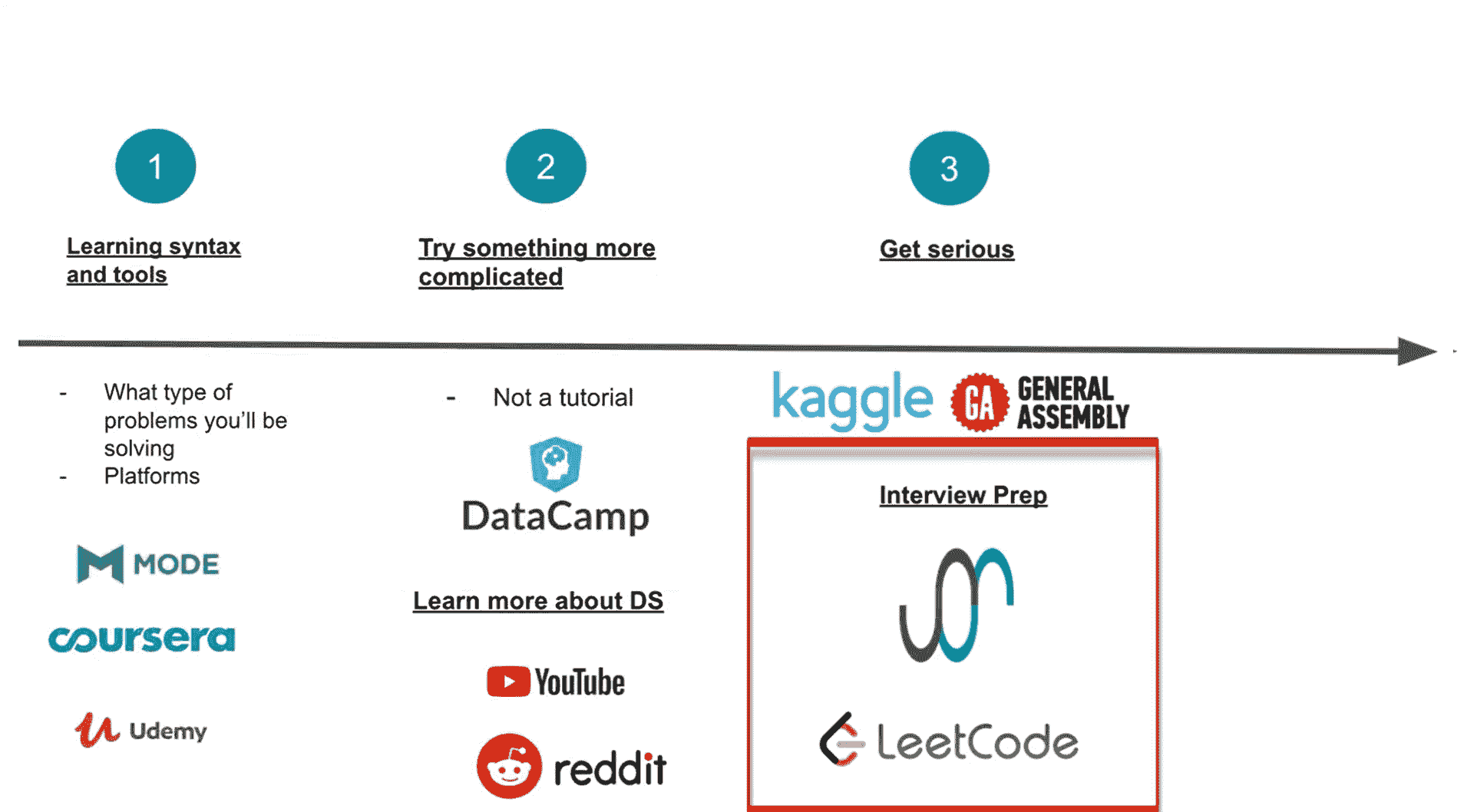

专业数据科学课程

原文:

www.kdnuggets.com/2021/03/data-science-curriculum-professionals.html

评论

由 布洛克·陶特,Odyssey Energy Solutions 的数据与系统专家。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持您组织的 IT 工作

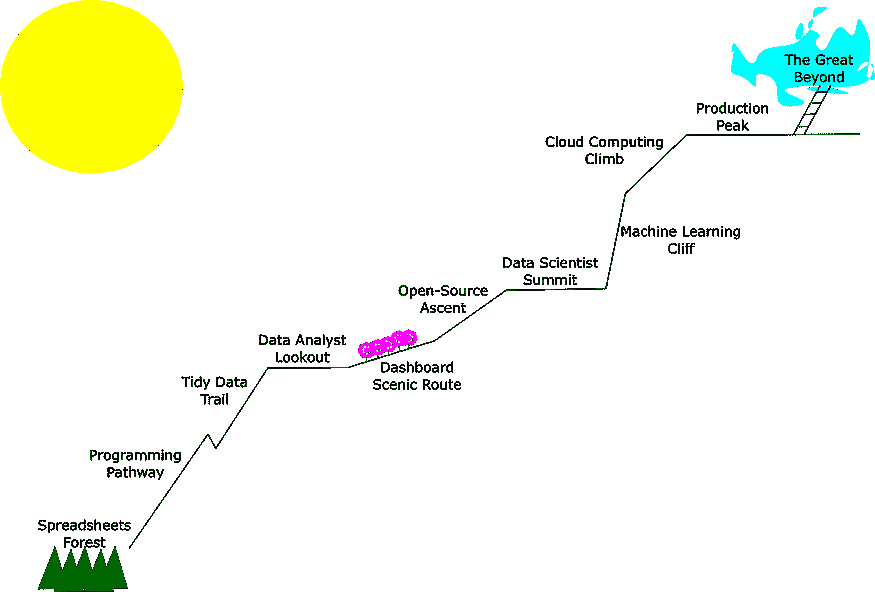

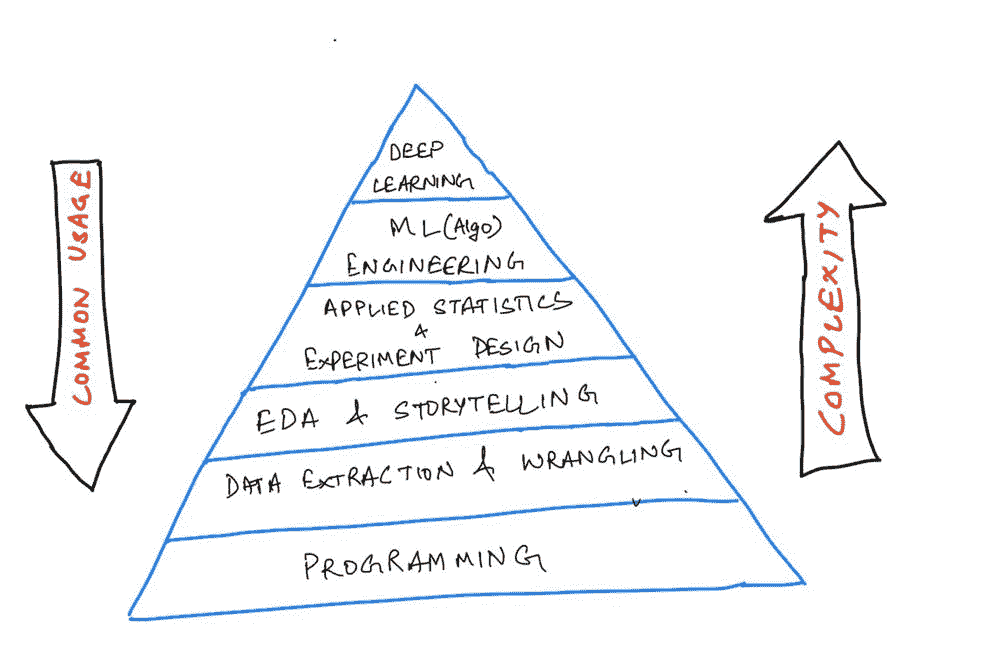

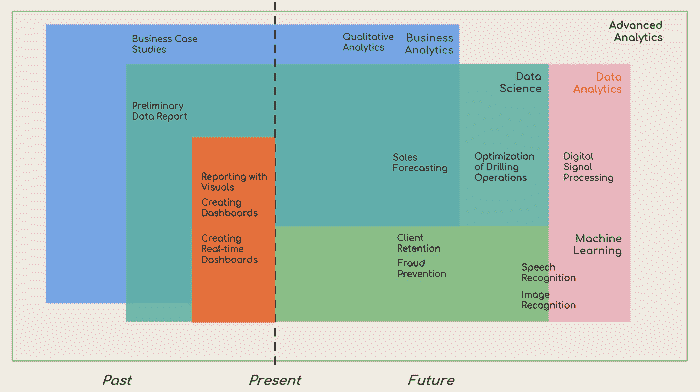

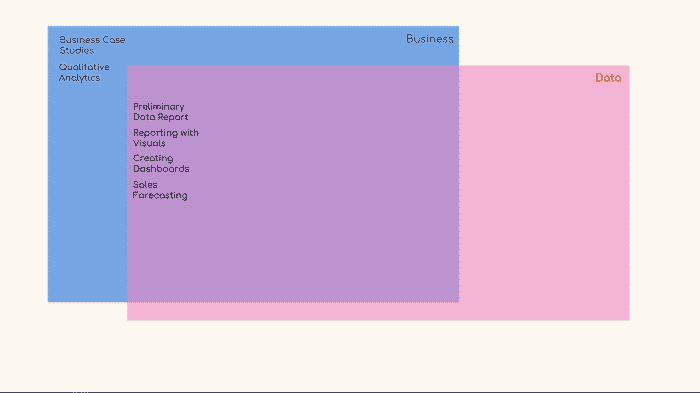

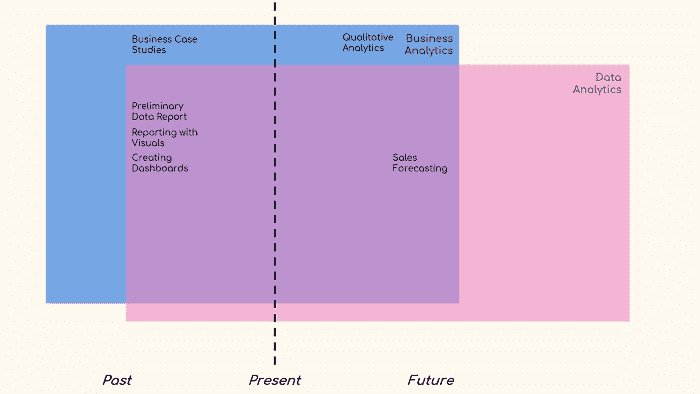

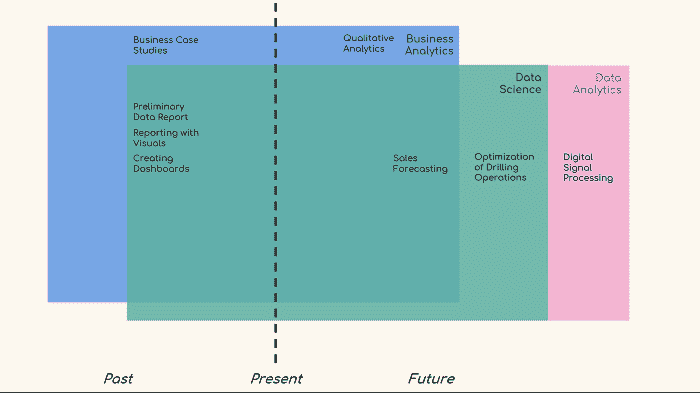

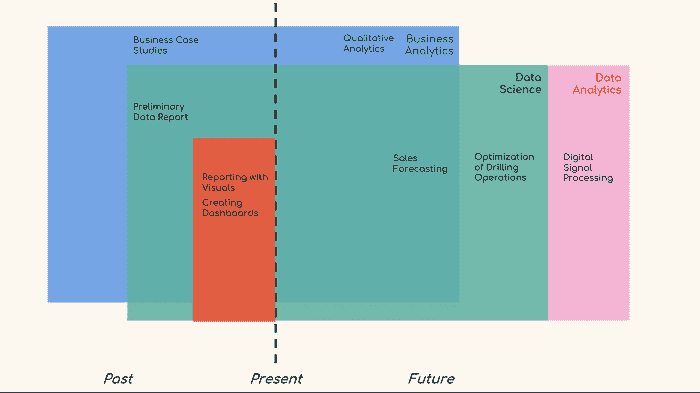

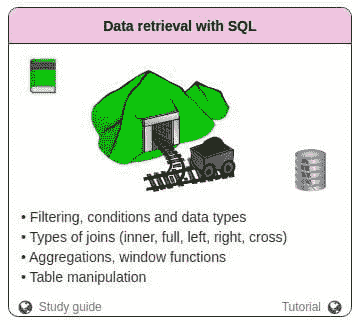

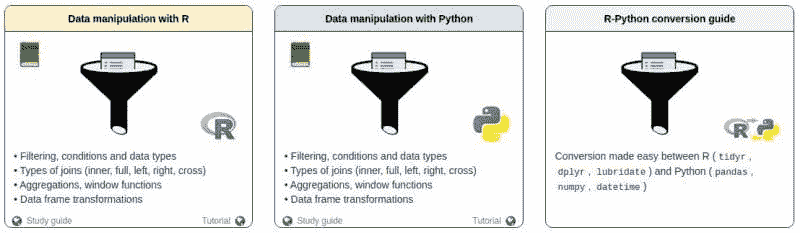

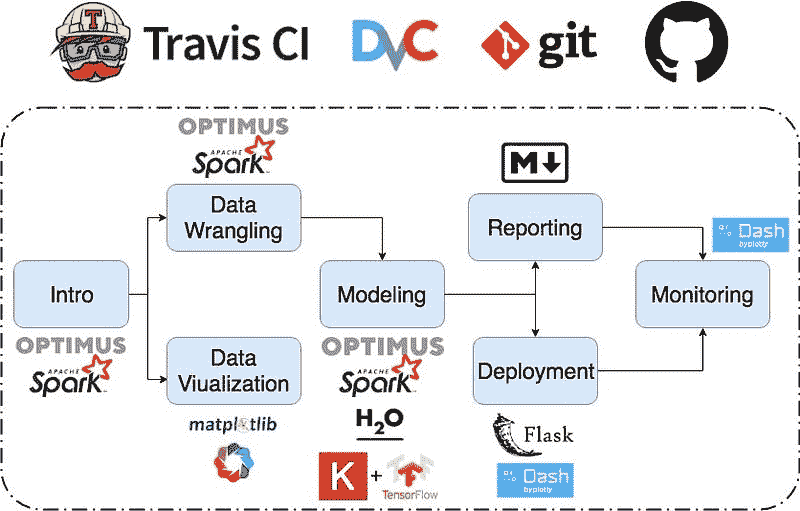

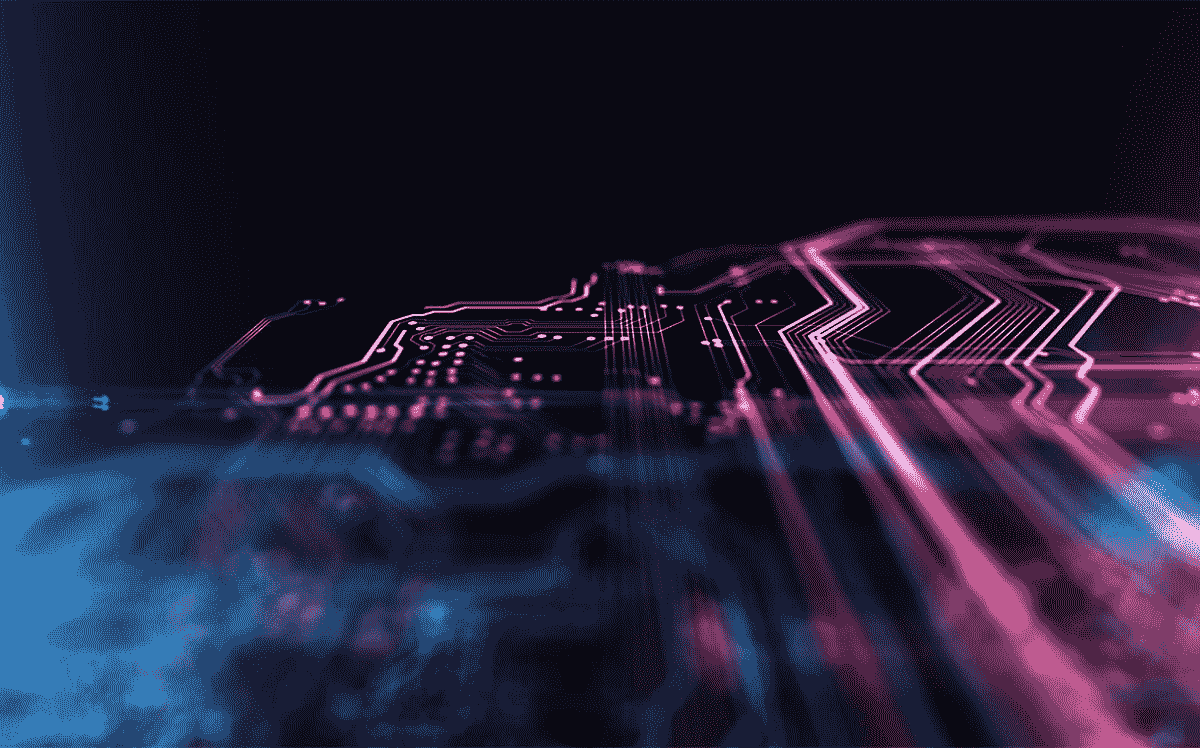

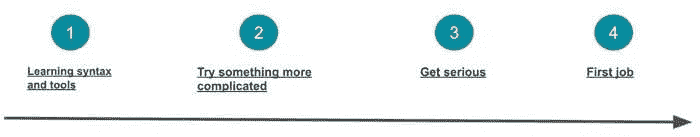

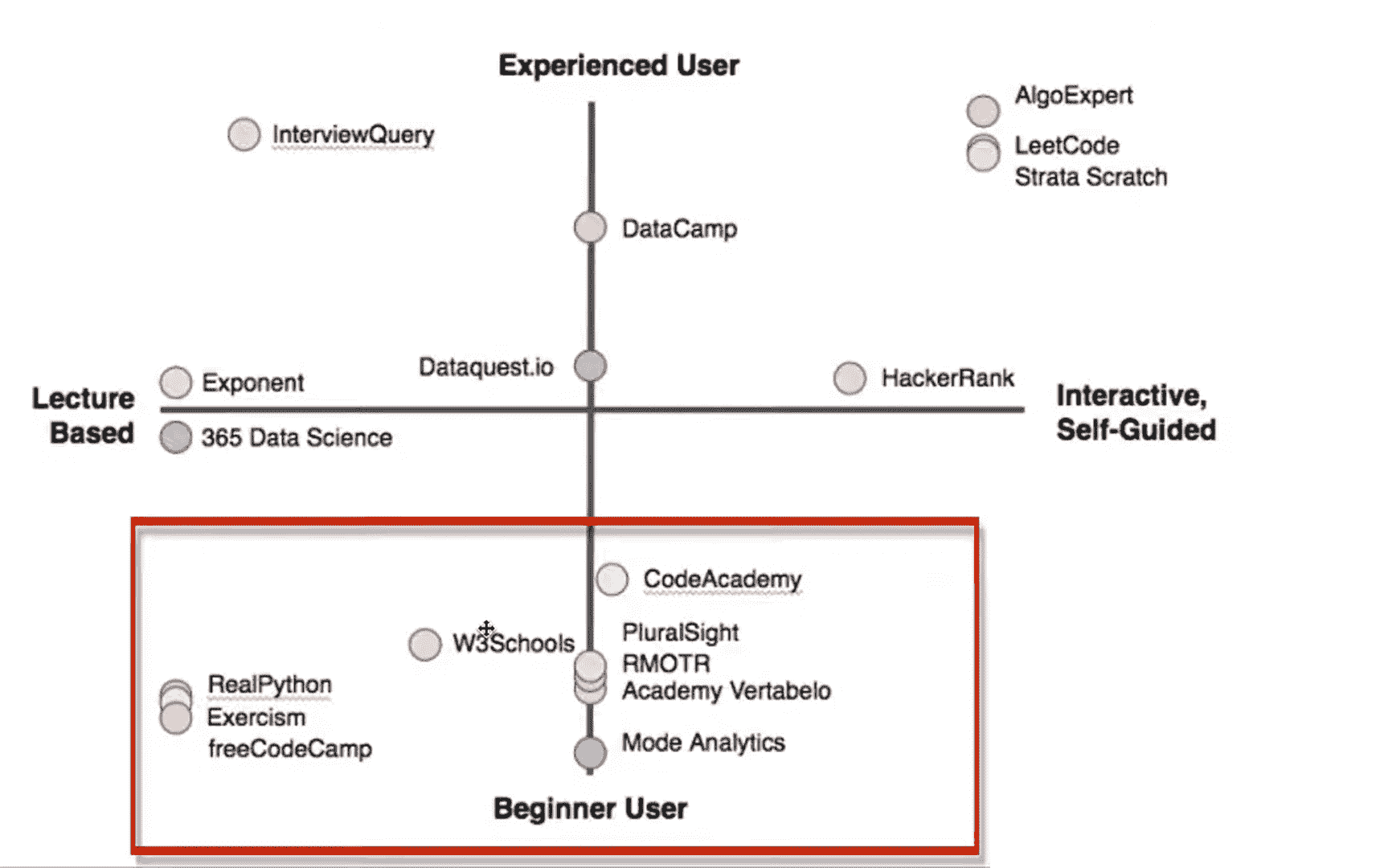

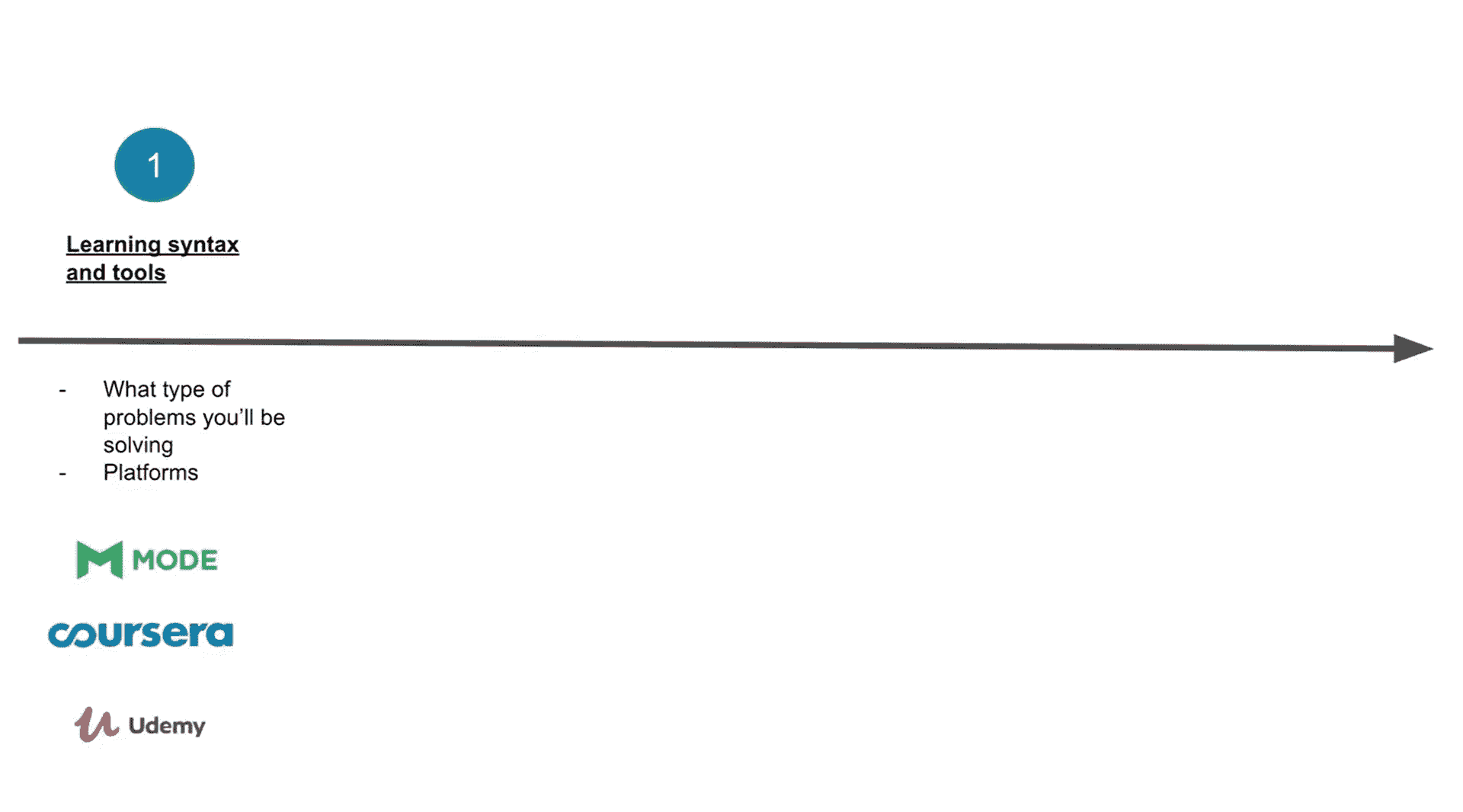

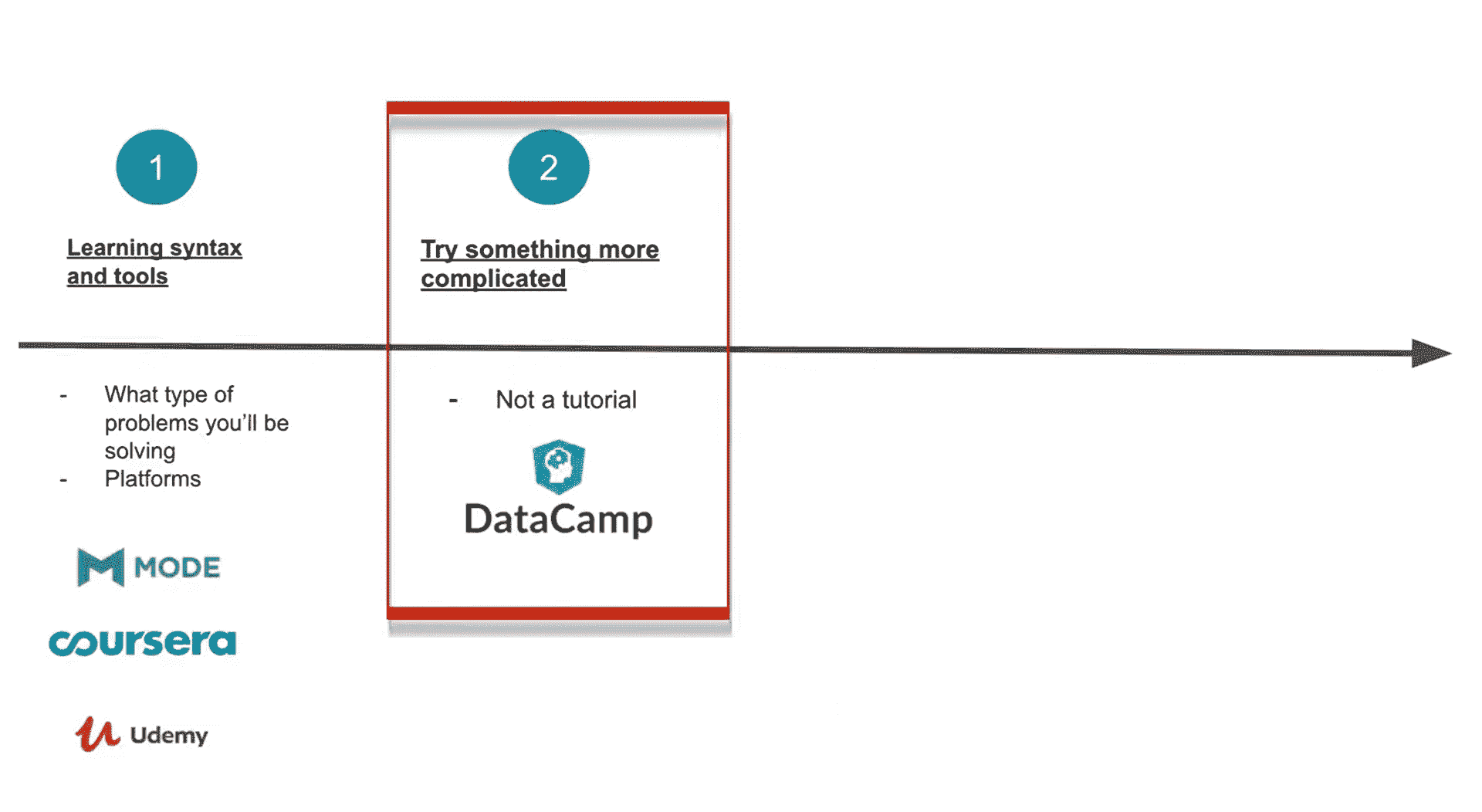

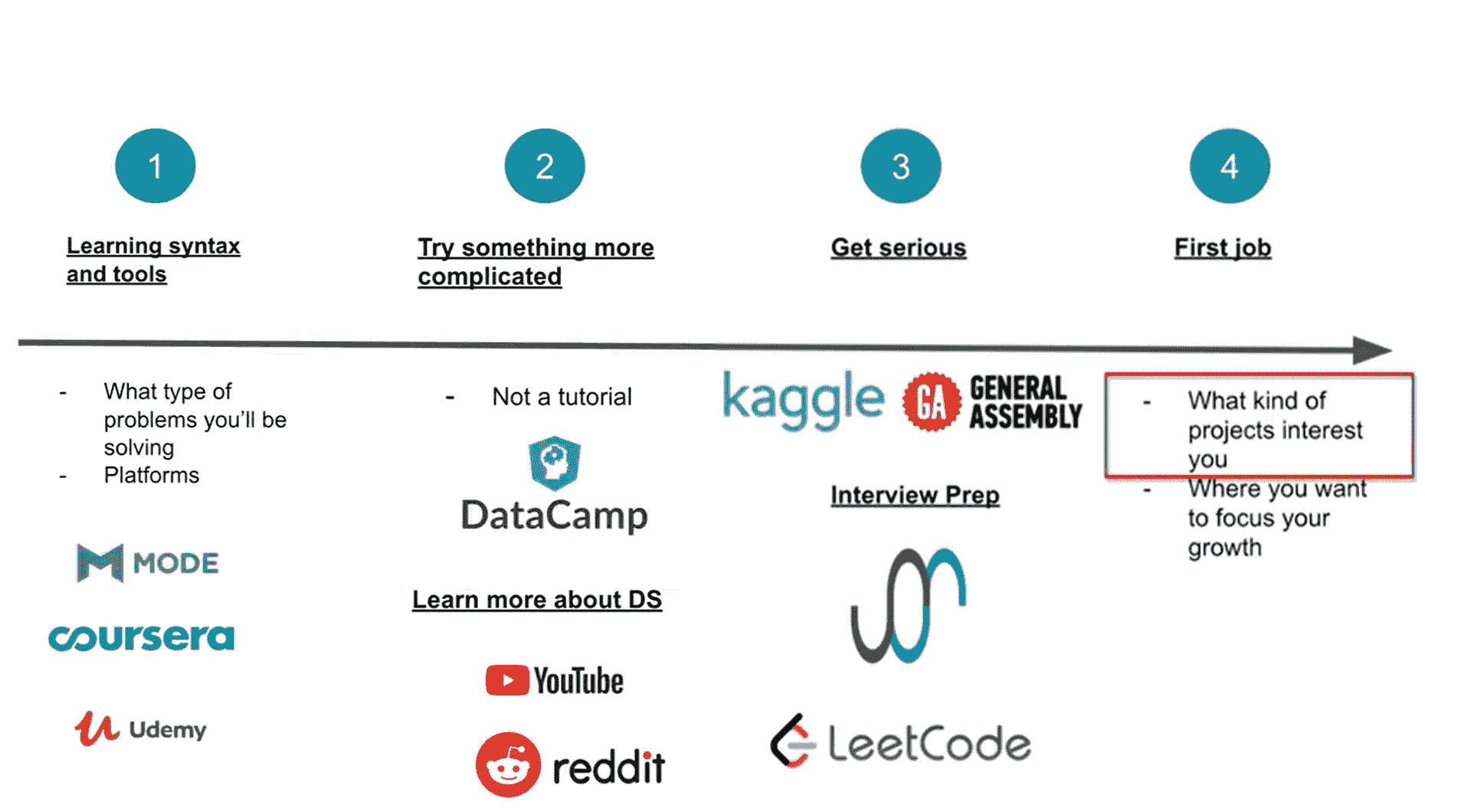

作者提供的图示。

如果你终于决定从 Excel 的复制粘贴转向可重复的数据科学,那么你需要知道最佳的路线。好消息是,有大量免费的资源可以帮助你,还有很棒的在线社区可以帮助你。坏消息是,选择哪些资源可能会让人感到不知所措。这里有一个直截了当的指南,你可以毫无遗憾地跟随,这样你就可以花更少的时间担心路径,更多的时间在上面跋涉。它基于我从一个从未上过统计课的可再生能源项目工程师到主要数据平台负责人的经历中学到的教训。

你在这里

在这段旅程的起点,你可以发现一群因必要而非激情进行数据分析的受过教育的个人。他们接受过工程师和商业分析师的培训,使用最简单的软件来运行他们的方程式。电子表格之所以美妙,是因为它们非常直观。你可以在每一步方程式中真实地看到并在隐喻中感受到数字。构建一个主电子表格是一个亲密的过程。(不相信我?试试看当他们展示他们的新模板时,你批评他们的颜色方案。)然而,一旦从原型转到全规模数据分析,电子表格很快会遇到局限性。一旦遇到需要整整一天时间才能修复的循环引用,开始计划在需要打开大文件或花一周时间尝试重建别人完成的分析时,你就该考虑转变了。在你旅程的第一步中,你需要去除电子表格的手动步骤,加快速度,并简化公式的跟踪。你需要开始编程。

第一次旅行:选择编程语言

现在你面临着人生中最重要的决定。大多数有抱负的数据科学家永远无法跨越这个巨大的障碍。你打算先学习哪种编程语言?为了减轻你的焦虑,你应该知道实际上没有错误的答案;这就像在选择一只小狗和一辆新车之间(或者对某些人来说,是猫和摩托车)。虽然有很多编程语言可以选择,但在目前的阶段,我只能推荐两个:Python 和 R。

你可以花几个月的时间阅读关于哪个更好的文章,但它们最终都说同样的话。所以,减轻你的负担,让这成为你最后一次纠结于这个话题。这份指南直截了当,记住吗?我会直白地告诉你。

如果你要与任何人合作,并且他们已经做出了这个选择,那就选择相同的语言。这样生活会更轻松。假设你是为你的团队开辟这条道路(这很棒),我可能推荐你选择 R。这种语言专门设计用于让非计算机程序员的生活更轻松,学习社区也非常棒。更重要的是,RStudio IDE(集成开发环境;你将在这里编辑代码)比使用 Python 更容易入门。(对于那些在大学里使用过 Matlab 的人来说,感觉就像是在使用 Matlab。)尽管如此,Python 是软件工程师更受欢迎的语言,在你开始构建机器学习应用程序时,实际世界中使用的频率也更高。

我个人开始是为了普通计算机编程目的自学 Python,并且在很多令人沮丧的东西上遇到了麻烦(比如该死的 PATH 变量),这使得进展开始时非常缓慢。当我开始学习数据科学时,我切换到了 R,并且真的很喜欢这种体验。最近,我深入研究了 Python 的数据科学包,现在在两者之间频繁切换(这实际上非常容易)。

如果你想更深入了解这个话题,你应该阅读 这篇文章 ,文章更详细地探讨了这个话题。然后,你应该选择一个并开始学习。

第二段征程:基础统计和整洁数据

一旦你选择了编程语言,你需要选择 IDE 和学习材料。如果你选择了 R,请使用 RStudio 并阅读 Garrett Grolemund 和 Hadley Wickham 的《R For Data Science》(通常缩写为 R4DS)。如果你选择了 Python,请下载 JupyterLab(使用 Anaconda)并阅读 Jake VanderPlas 的《Python Data Science Handbook》。这两本书都可以在网上免费获取。

这两本书将带你从完全新手提升到超越电子表格的能力,使你能够处理各种项目。所以,去做吧。拿一个让你非常沮丧的数据分析过程(也许是需要将数据从一堆 CSV 文件复制到一个模板中,也许是一个需要许多电子表格和在它们之间复制/粘贴数据的过程,等等),并编写一个 R/Python 脚本来完成它。当你遇到障碍时,向社区寻求支持。

推动我前进的最大一步是理解整洁数据的概念。因此,我建议阅读 Hadley Wickham 的《整洁数据》一文,并在你的代码中运用其原则。

此外,做数据分析最有趣的部分就是创建令人惊叹的可视化。确保你花大量时间玩弄你的图表。这些图表将帮助你让其他人看到你的代码比他们的电子表格更好。

最后,由于你现在正在进行更深入的数据分析,复习稳健统计学的原则可能会很有帮助。我推荐 David Spiegelhalter 的《统计学的艺术》。这本书不是教科书,而是讲解统计学数学背后的思维方式,对于编程者来说,比深入探讨数学本身更有用。

首个目的地

你做到了!通过这些非常简单的步骤,你现在可以称自己为数据分析师了。此时,你可以做 Excel 中能做的一切,甚至更多。数据分析现在快得多,你自动化了乏味的工作,制作图表的乐趣大大增加。对于许多人来说,这已经是你想要达到的最远目标。然而,接下来的几个步骤将看起来非常诱人。如果你觉得之前很有趣,等你做出第一个仪表板时就会更加精彩。

第三站:仪表板

查看 Shiny R 画廊 (shiny.rstudio.com/gallery/)。或者,如果你是 Python 爱好者,可以看看 Dash Enterprise 应用画廊 (dash-gallery.plotly.host/Portal/)。这些是仪表板,你可以将所有数据分析结果汇集在一个地方,让你的商业领导者惊叹于你的工作,并做出数据驱动的明智决策。(不错的口号,对吧?)进一步说,仪表板可以是 Web 应用,允许你的团队其他成员通过 GUI(图形用户界面)运行你的代码。你的团队当前使用的软件是否让你抓狂?你可以重新创建它,但量身定制以完全符合你的需求,真正减少点击次数。该程序的输出可能是一个漂亮的 PDF 报告。

简而言之,仪表盘很棒。你想要掌握制作这些仪表盘的技能。从将你的一个分析结果转化为仪表盘开始,然后逐步建立。使用 R 的 Shiny 包和 Python 的 Dash 包。还有大量文档可以帮助你,包括 Hadley Wickham 的《Mastering Shiny》一书,但与基础数据科学书籍不同,我不一定推荐完全读完这些书。只需开始编码,并在不确定如何做时使用它们。再说一次,学习社区是你的朋友。

第四阶段:包、GitHub、开源、环境

现在你的同事对你的仪表盘赞不绝口,羡慕你的自动化脚本,你将需要开始协作。一开始,你可能会通过电子邮件或文件共享与他人分享你的代码。类似地,每当你开始一个新的分析时,你很可能会复制上一个分析,然后在不同地方做些修改以适应新的数据。这是每个人的起点,但很快就会变得混乱。此外,你希望有更好的方法来跟踪代码的变化并允许其他人共同编辑。为了解决这些问题,你需要将代码转换为一个包,并将其托管在 GitHub 上。这样,每个人都可以访问代码,甚至可以将其开源,允许你与全球合作。

学习如何做到这一点的最佳资源是 Hadley Wickham 的《R Packages》和官方 Python Packaging 文档(packaging.python.org/overview/)。GitHub 的指南也是学习如何使用其平台的极好资源(guides.github.com/)。

当你第一次为团队构建应用程序时,管理本地环境会让你感到非常沮丧。我指的是,每个人的计算机上安装了不同的文件和操作系统中的细微差别,导致在他们的“环境”中运行的代码与在你的环境中行为不同。这是一件非常混乱的事情,涉及到计算机科学而非基础数据科学。我尽可能避免学习环境管理,但一旦我开始学习,它确实让我的生活变得容易多了。不管是主动学习还是出于必要,你都需要自己掌握这一技能。我从未找到过学习这方面的优秀资源,所以我在这里做了一个推荐你阅读的资源。

第二个目的地

你现在已经将数据分析技能提升到了一个新水平。你可以为开源代码做出贡献,并且现在具备了排查同事问题所需的技能。你可以领导一个高效的数据分析团队。拥有这些能力后,你正在寻找真正推动业务价值的方法,以便高层管理者不能再忽视你的工作。

第五阶段:高级统计与机器学习

如果你想真正为公司带来价值,你需要超越简单的线性回归和计算平均值。你需要开始深入研究高级统计和(提醒词!)机器学习。这一步是比较陡峭的。盲目尝试开源机器学习模型是可能的,但这有点像玩火。你真的需要理解你在做什么,否则计算机可能会将你的动机转化为一些疯狂的东西。我不是说你必须理解每个模型中所有的数学,但你应该对这些数学试图实现的目标感到舒适。你还应该开始从数据中提取更大的推论,识别出你未受过训练的眼睛所遗漏的模式。你应该学习更多统计的细微差别,以确保你得出的结论是负责任的。这部分确实是关于大权力需要大责任的。好好学习这些工具,你就可以做得更好。

最好的机器学习资源是 Coursera 上的机器学习课程,由斯坦福大学教授、机器学习名人 Andrew Ng 教授讲授。你可以在 GitHub 上找到 Python 和 R 的作业,而不是他在课程中使用的 Octave(编程语言)。紧接着这个课程的另一个极好的课程是 MIT 的深度学习入门(6.S191)课程。它是 MIT 课程,每年在课程结束后公开。该课程使用 Python 和一个叫 TensorFlow 的包。(注意,深度学习是一种机器学习,机器学习是一种人工智能。你说的内容部分取决于你想给谁留下深刻印象。)

在 Coursera 上有一门很好的高级统计课程,约翰斯·霍普金斯大学的“统计推断”(使用 R),或者密歇根大学的“用 Python 进行推断统计分析”。

第六步:云计算,数据管道

在某些时候,本地托管所有的处理过程将不再有意义。这可能是由于所需的计算能力、需要将来自多个来源的数据汇总到一个位置,或需要一个持续运行的应用程序而不是一次性分析。在这种情况下,你将转向云计算,这意味着你还必须找到将数据导入云中的方法。此时,你可能会从数据分析师/科学家过渡到数据工程师。这涉及到很多内容,其中大部分是特定于云托管提供商的。为了避免这种情况,你可以使用类似 RStudio Cloud 的工具,它会为你处理所有麻烦的工作。否则,你需要重新学习许多计算机科学概念,如分区、复制和网络。

要深入了解云服务,我写了 这篇文章。其他一些有用的资源包括 Google Cloud Labs(或类似的 Amazon、Microsoft 等材料)以及 Martin Kleppmann 的书《设计数据密集型应用》。

对于那些希望利用云计算能力但不打算实际托管应用程序的人,你绝对应该查看 Google Colab Notebooks。这些工具允许你在云端运行 Jupyter 笔记本,而不是在自己的计算机上,无需任何复杂的设置。它非常适合共享代码,同时也不必处理本地环境问题。

第三目的地

你已经达到了数据科学的圣地。你可以申请的职位有生产数据科学家或机器学习工程师。你现在具备了为大科技公司工作的技能,同时你在所在行业的专业知识也让你区别于普通数据科学家,这使得你的才能非常有吸引力。利用这些来清楚地为你的公司带来价值,这样你才能被认可你的真正价值。

伟大的未来

你可以考虑无数条下一步的路径。你可以深入研究神经网络和开源 AI 库,将人工智能带到你的行业。或者你可以投入到前端编码中,学习 JavaScript、HTML 和 CSS,将你开始构建的 web 应用提升到一个新的水平。或者你可以精通数据可视化和设计,更好地传达你的分析结果。或者你可以做其他无数的事情。因为你已经学会了如何在云端进行数据科学,天空不再是你的限制。

原文。经许可转载。

简介: 布罗克·陶特 是一位在可再生能源行业工作的工程师和数据科学家。

相关:

更多相关话题

数据科学课程路线图

原文:

www.kdnuggets.com/2019/12/data-science-curriculum-roadmap.html

(额外作者列表)

评论

我们在收到来自学术伙伴的多个请求后,冒险建议了一条课程路线图。作为一个团队,我们的大部分时间都花在了行业中,尽管我们中的许多人也曾在学术领域度过了一段时间。以下是一些广泛的建议,每种实施都不可避免地需要大量调整。考虑到这一点,以下是我们的课程推荐。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织在 IT 方面

3. Google IT 支持专业证书 - 支持你的组织在 IT 方面

更多的应用而非理论

我们想强调的是,准备学生将知识应用于行业环境中的单一最重要因素是以应用为中心的学习。使用现实数据回答实际问题是最佳准备方式。它将抽象概念与实际操作结合起来,同时教会数据机制和数据直觉,这在孤立情况下是不可能做到的。

以此为基础,我们提供了一系列主题,以便为数据科学实践做好准备。

课程原型

数据科学和数据中心的学术项目类型与我们在工作中识别的主要技能领域非常相似。有些项目强调工程,有些项目强调分析,还有些项目强调建模。这些的区别在于,分析关注我们能从数据中学到什么,建模关注估计我们希望拥有的数据的问题,而工程则关注如何使一切运行得更快、更高效、更稳健。

也有一些通用数据科学项目,在一定程度上涵盖了所有这些领域。此外,还有相当多的领域特定项目,教授特定领域的工程、分析和建模技能的子集。

这些项目模型的课程推荐会有所不同。然而,它们都会包含一些核心主题。分析、工程和建模中心的项目将有各自额外的主题领域。一般课程将包括一些分析、工程和建模课程的内容,但可能不会深入到相同的程度。学生通常会从这三个领域的任何组合中自行选择课程。

领域特定项目的课程看起来与一般项目类似,唯一不同的是,主题,甚至整个课程,将专注于该领域的特定技能。例如,一个侧重于精算的 数据分析项目可能包括保险公司最常用的软件工具、时间序列和稀有事件预测算法,以及在保险行业中被广泛接受的可视化方法。学生可以通过基于实际领域特定数据的项目来最佳地实践他们的技能。强烈建议参与实际项目或实习。在设计这些项目时,机构也可能考虑提供跨学科的学位和项目。领域特定项目通常结合了来自多个部门或学院的课程。

这是我们建议在每个领域中包含的主要主题,并列出了一些特别重要的子主题。

基础主题

-

编程

-

文件和数据操作

-

脚本编写

-

绘图

-

-

基本数据库查询

-

概率与统计

-

概率分布

-

假设检验

-

置信区间

-

统计显著性

-

-

代数

-

数据伦理

-

数据解释与沟通

-

演讲

-

技术写作

-

针对非技术受众的数据概念

-

分析主题

-

高级统计

-

实验设计

-

统计功效

-

A/B 测试

-

贝叶斯推断

-

因果推断

-

-

微积分

-

应用

-

成本效益权衡

-

实用意义

-

-

可视化

工程主题

-

软件工程

-

协作开发

-

版本控制与可重复性

-

数据流处理

-

生产工程

-

流水线建设

-

调试和单元测试

-

-

软件系统与基础设施

-

并行与分布式处理

-

客户-服务器架构

-

云计算

-

-

计算复杂性

-

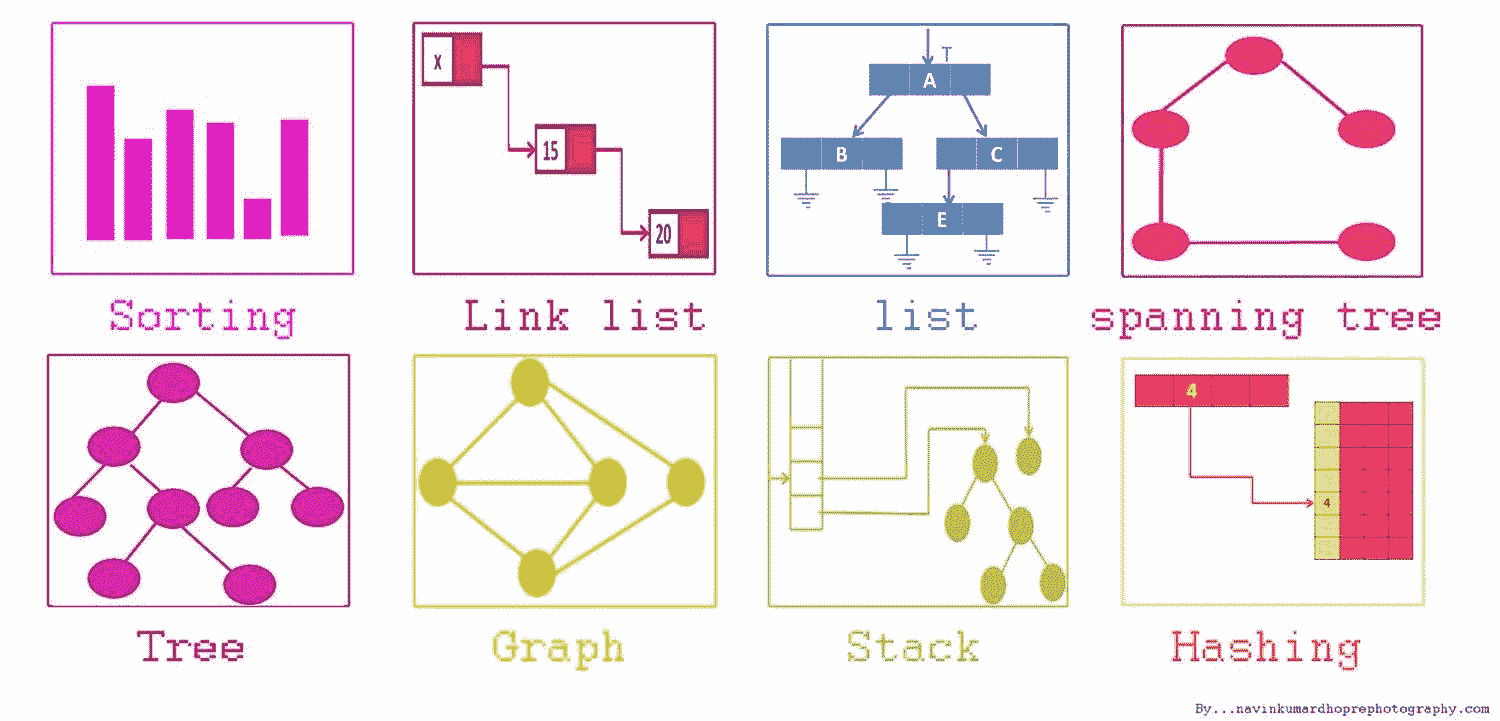

数据结构

-

数据库

-

设计

-

数据建模

-

高级数据库查询

-

-

数据管理

-

安全

-

隐私

-

治理

-

合规

-

建模主题

-

线性代数

-

监督学习

-

分类

-

回归

-

-

无监督学习

-

聚类

-

降维

-

-

神经网络

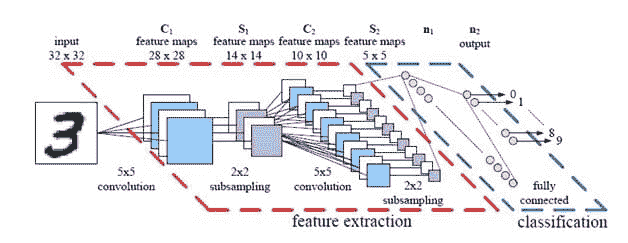

-

多层感知器

-

卷积神经网络

-

循环神经网络

-

-

特征工程

-

自然语言处理

-

计算机视觉

-

算法设计

-

优化

请注意,对于每个主题和子主题,有许多有效的方法可以将其拆分为课程。您机构的最佳方式将取决于许多因素,包括学期长度、每堂课的小时数、现有的部门界限、讲师的可用性以及学生预期的学习速度。这些建议假设一个为期两年的硕士课程,主要目标是为学生准备就业和持续职业发展,尽管它们也可以根据其他项目的范围进行扩大或缩小。

应该重申的是,注重应用的教学将更好地为学生准备职业职位。理论越是扎根于具体实例中,具体技能在解决更大问题的背景下被练习得越多,学生对如何运作以及在哪里应用的理解就越深刻。

原文。经许可转载。

相关:

-

2019 年 5 大著名深度学习课程/学校

-

应对数据科学技能日益增长的需求

-

我在数据科学硕士课程中学到的 7 件事

更多相关内容

自学数据科学课程

原文:

www.kdnuggets.com/2020/02/data-science-curriculum-self-study.html

评论

照片由 Kelly Sikkema 提供,来自 Unsplash。

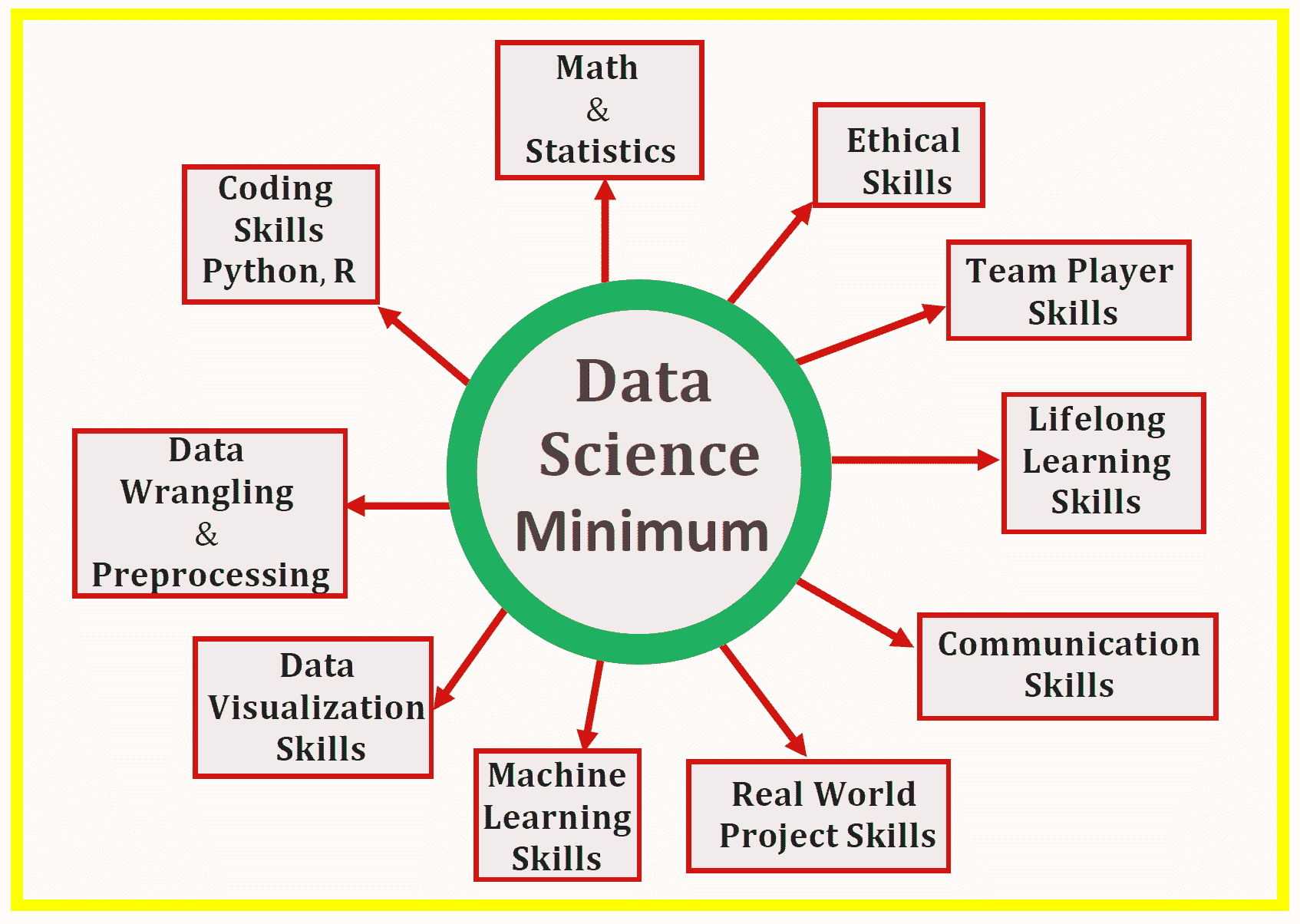

作为数据科学教育者,许多对数据科学感兴趣的人联系我寻求如何进入数据科学领域的指导。本文将讨论建立数据科学必备技能所需学习的推荐主题。

这里提出的主题,如果深入学习,将提供开始从事数据科学所需的最基本背景。这个课程大纲也可以用于设计数据科学入门级的大学课程。

请记住,仅仅通过课程获得的知识并不会使你成为数据科学家。课程学习必须配合一个顶点项目或实习。Kaggle 比赛可以用作顶点项目,因为它们提供了在真实数据科学项目上工作的机会。

以下列表呈现了学习入门数据科学的基本主题。

1. 数学基础

(I)多变量微积分

大多数机器学习模型是基于具有多个特征或预测变量的数据集构建的。因此,熟悉多变量微积分对于构建机器学习模型非常重要。你需要熟悉以下主题:

-

多变量函数

-

导数和梯度

-

步骤函数、Sigmoid 函数、Logit 函数、ReLU(整流线性单元)函数

-

代价函数

-

函数绘制

-

函数的最小值和最大值

(II)线性代数

线性代数是机器学习中最重要的数学技能。数据集表示为矩阵。线性代数用于数据预处理、数据转换和模型评估。你需要熟悉以下主题:

-

向量

-

矩阵

-

矩阵的转置

-

矩阵的逆

-

矩阵的行列式

-

点积

-

特征值

-

特征向量

(III)优化方法

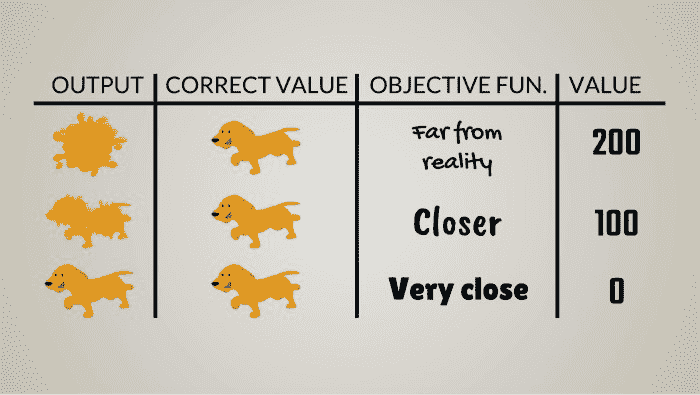

大多数机器学习算法通过最小化目标函数来执行预测建模,从而学习必须应用于测试数据的权重以获得预测标签。你需要熟悉以下主题:

-

代价函数/目标函数

-

似然函数

-

误差函数

-

梯度下降算法及其变体(例如,随机梯度下降算法)

2. 编程基础

Python 和 R 被认为是数据科学领域的顶级编程语言。你可以选择只专注于一种语言。Python 在工业界和学术培训项目中被广泛采用。作为初学者,建议你只专注于一种语言。

这里是一些需要掌握的 Python 和 R 基础主题:

-

基础 R 语法

-

R 编程的基础概念,如数据类型、向量运算、索引和数据框

-

如何在 R 中执行操作,包括排序、使用 dplyr 进行数据处理,以及使用 ggplot2 进行数据可视化

-

R studio

-

Python 的面向对象编程方面

-

Jupyter notebooks

-

能够使用 Python 库,如 NumPy、pylab、seaborn、matplotlib、pandas、scikit-learn、TensorFlow、PyTorch

3. 数据基础

学习如何处理各种格式的数据,例如,CSV 文件、pdf 文件、文本文件等。学习如何清理数据、填补数据、缩放数据、导入和导出数据,以及从互联网抓取数据。一些相关的包包括 pandas、NumPy、pdf tools、stringr 等。此外,R 和 Python 包含多个内置数据集,可用于练习。学习数据转换和降维技术,如协方差矩阵图、主成分分析(PCA)和线性判别分析(LDA)。

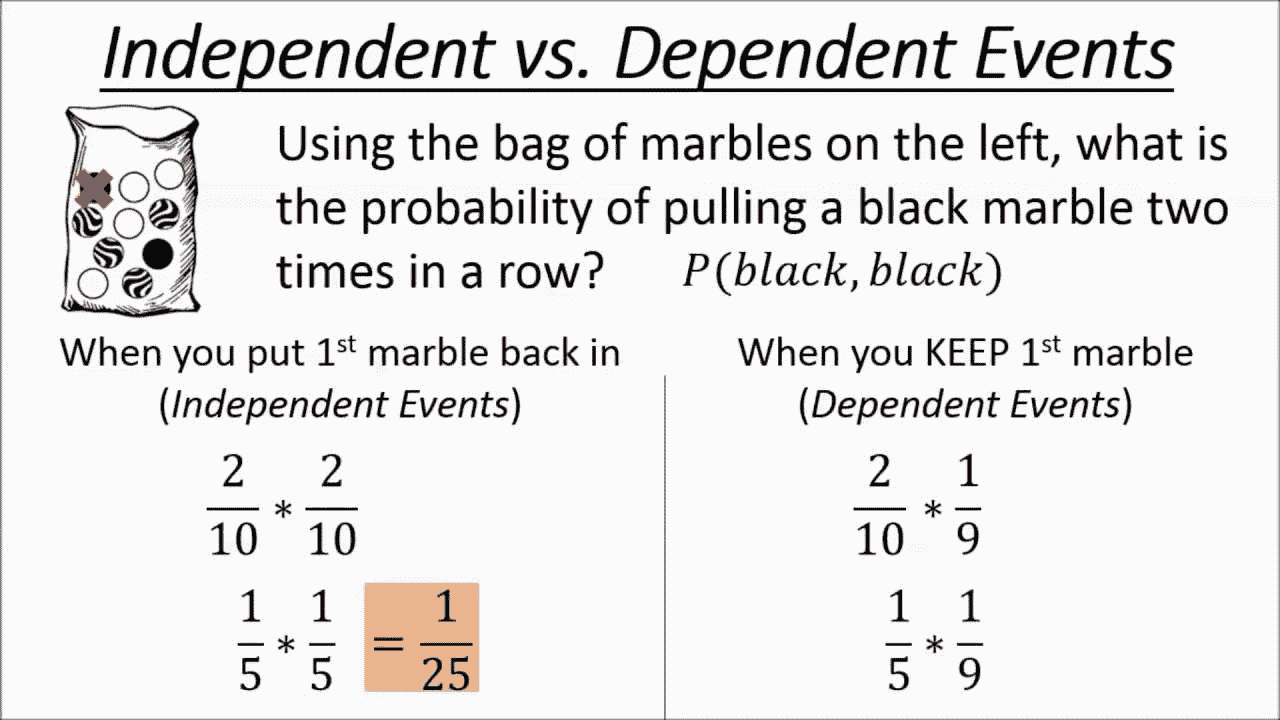

4. 概率与统计基础

统计和概率用于特征可视化、数据预处理、特征转换、数据填补、降维、特征工程、模型评估等。以下是你需要熟悉的主题:

-

平均数

-

中位数

-

众数

-

标准差/方差

-

相关系数和协方差矩阵

-

概率分布(二项分布、泊松分布、正态分布)

-

p 值

-

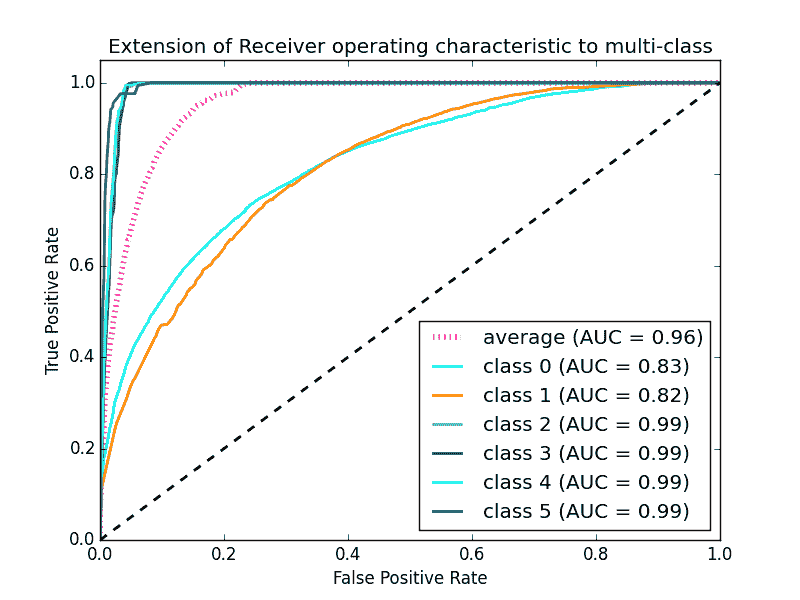

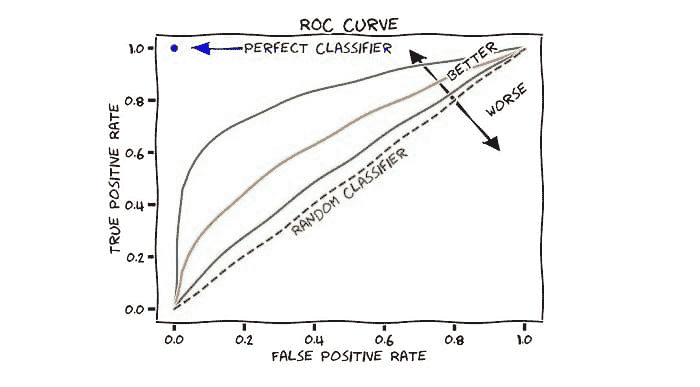

贝叶斯定理(精确度、召回率、正预测值、负预测值、混淆矩阵、ROC 曲线)

-

A/B 测试

-

蒙特卡罗模拟

5. 数据可视化基础

学习良好数据可视化的基本组件。良好的数据可视化由几个组件组成,这些组件必须组合在一起才能产生最终产品。

a) 数据组件: 决定如何可视化数据的一个重要第一步是了解数据的类型,例如,分类数据、离散数据、连续数据、时间序列数据等。

b) 几何组件: 在这里你决定什么样的可视化适合你的数据,例如,散点图、折线图、柱状图、直方图、Q-Q 图、平滑密度图、箱线图、配对图、热图等。

c) 映射组件: 在这里,你需要决定使用哪个变量作为 x 变量,哪个作为 y 变量。这一点尤为重要,特别是当你的数据集是多维的,具有多个特征时。

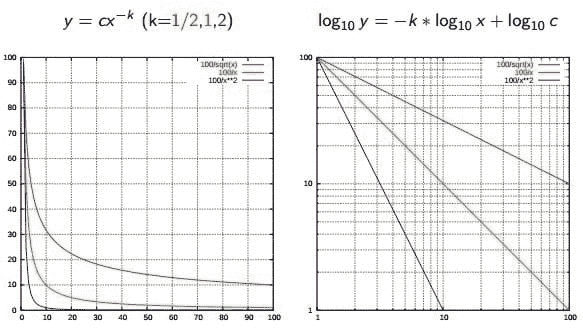

d) 尺度组件: 在这里,你决定使用什么样的尺度,例如,线性尺度、对数尺度等。

e) 标签组件: 这包括坐标轴标签、标题、图例、使用的字体大小等。

f) 伦理组件: 在这里,你需要确保你的可视化展示了真实的故事。你需要在清理、总结、操控和生成数据可视化时保持意识,确保你的可视化不会误导或操控你的观众。

重要的数据可视化工具包括 Python 的 matplotlib 和 seaborn 包,以及 R 的 ggplot2 包。

6. 线性回归基础

学习简单和多重线性回归分析的基础知识。线性回归用于具有连续结果的监督学习。执行线性回归的一些工具如下所示:

Python:NumPy、pylab、sci-kit-learn

R:caret 包

7. 机器学习基础

a) 监督学习(连续变量预测)

-

基础回归

-

多重回归分析

-

正则化回归

b) 监督学习(离散变量预测)

-

逻辑回归分类器

-

支持向量机(SVM)分类器

-

K 最近邻(KNN)分类器

-

决策树分类器

-

随机森林分类器

-

朴素贝叶斯

c) 无监督学习

- K 均值聚类算法

机器学习的 Python 工具:Scikit-learn、Pytorch、TensorFlow。

8. 时间序列分析基础

用于预测模型的时间依赖性场景,例如预测股票价格。分析时间序列数据有 3 种基本方法:

-

指数平滑

-

ARIMA(自回归积分滑动平均),是指数平滑的推广

-

GARCH(广义自回归条件异方差性),是一种用于分析方差的类似 ARIMA 的模型。

这三种技术可以在 Python 和 R 中实现。

9. 生产力工具基础

掌握如何使用基本的生产力工具,如 R studio、Jupyter notebook 和 GitHub 至关重要。对于 Python,Anaconda Python 是最佳的生产力工具。高级生产力工具,如 AWS 和 Azure,也是需要学习的重要工具。

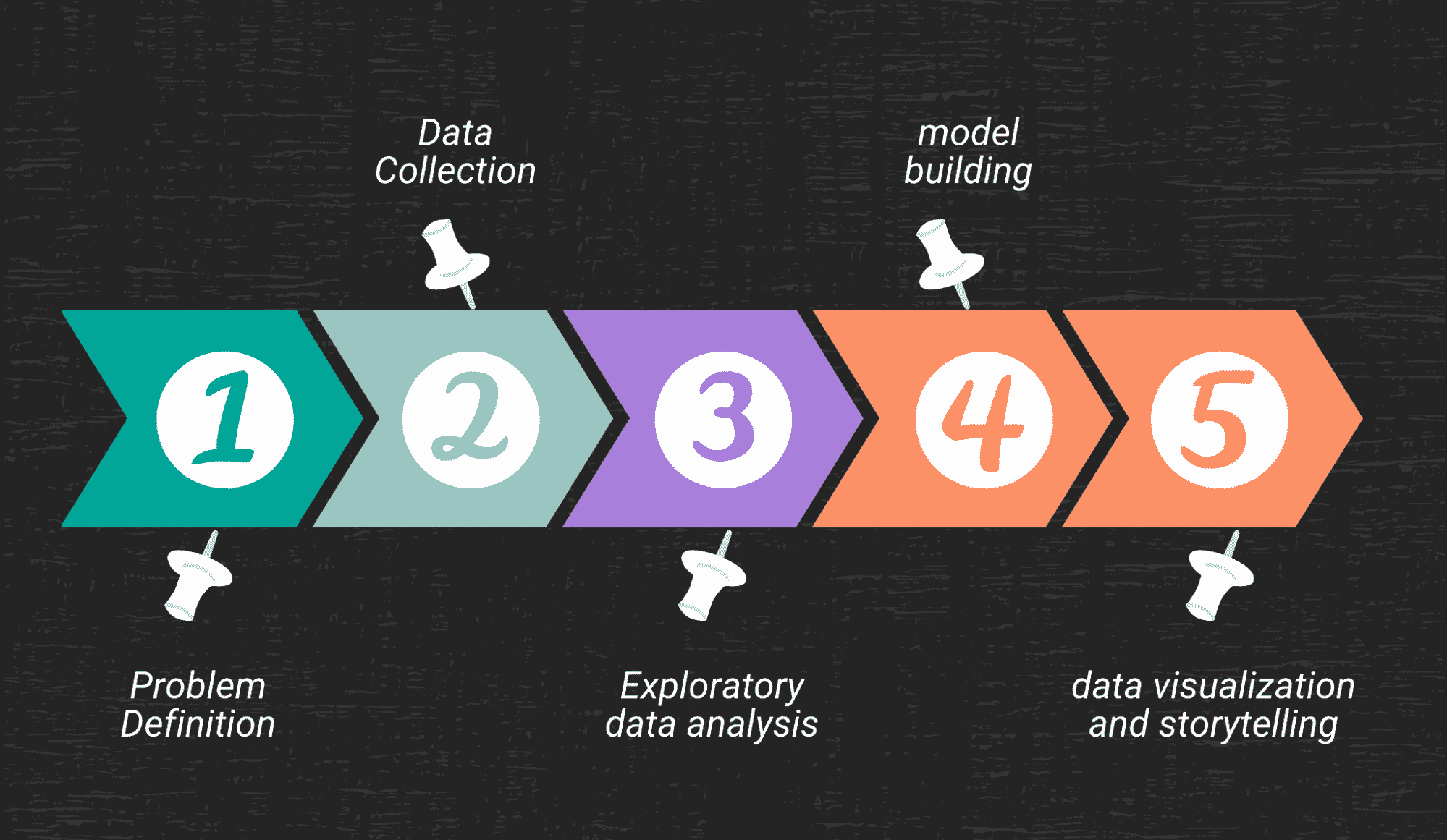

10. 数据科学项目规划基础

学习如何规划项目的基础知识。在构建任何机器学习模型之前,重要的是仔细规划你希望模型实现的目标。在深入编写代码之前,重要的是了解待解决的问题、数据集的性质、要构建的模型类型、如何训练、测试和评估模型。项目规划和组织对提高数据科学项目的生产力至关重要。以下提供了一些项目规划和组织的资源。

数据科学自学的有用资源

数据可视化的艺术——使用 Matplotlib 和 Ggplot2 进行天气数据可视化

数据科学 101——包含 R 和 Python 代码的简短课程

原文。已获许可转载。

相关:

更多相关话题

数据科学数据架构

原文:

www.kdnuggets.com/2015/09/data-science-data-architecture.html/2

数据流

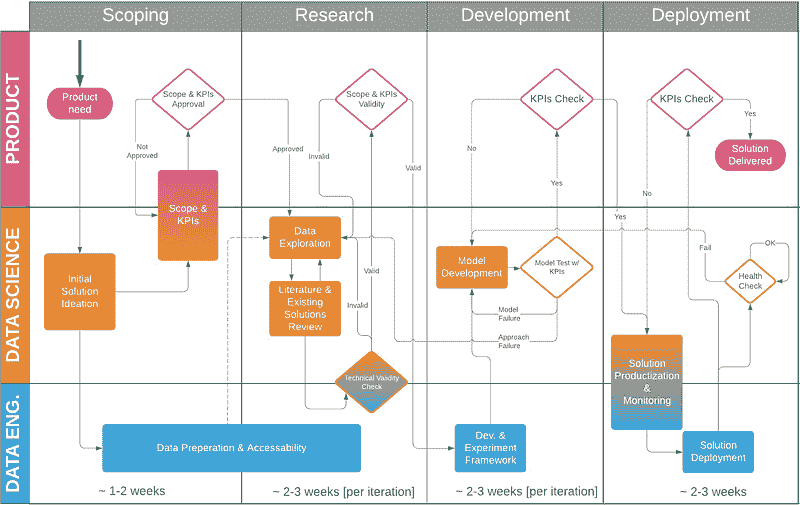

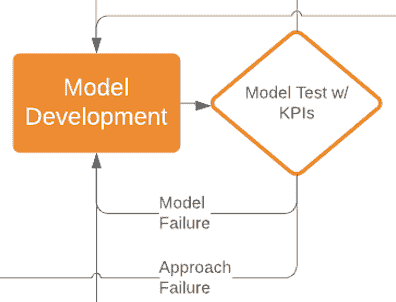

图 2 展示了分析应用的数据流。图片的左侧描述了数据库,右侧描述了分析堆栈:红点表示调度实例,蓝点表示实际分析过程。顶部部分“Dev”表示模型开发环境,而下部框“Prod”表示模型生产环境。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

在模型开发环境中,数据库被分为三个部分(或模式):

-

一个暂存区(或对数据科学家而言)只读环境,其中 IT 可以提供数据。为了确保没有混淆已交付的内容(从质量和数量的角度),此区域必须为只读。

-

数据科学的游乐场(或沙盒)。这是一个免费的区域,用于模型实验,回答临时问题,并开发报告和见解。

-

模型开发环境的下部表示预生产阶段。这是一个数据科学家与 IT 部门密切合作的区域。数据科学家和 IT 操作员的讨论围绕模型的交接过程展开。此外,IT 操作员需要了解模型的数据需求,并为模型准备操作环境。模型交接给操作团队需要配备审计结构。

下面描述的数据流支持数据科学家的完整工作流程:从临时报告到支持多个部门的模型。如前所述,流程从数据在只读(暂存)区域中可用开始。这里的数据是首次交付(数据科学家天生好奇,总是寻找新的数据源)和定期安排的数据交付(例如,每月的新客户、使用情况、交易等)的混合。最初,数据以原始形式到达,并被以这种形式进行探索。IT 和数据科学家之间的进一步合作可能会导致对某些数据聚合或选择的请求。定期数据交付由计划任务拾取,为数据科学数据集市准备数据。理想情况下,这是一个基于变更历史的数据集市,包含回答 90%临时问题的数据,并能够生成建模数据。另一种选择是存储每月快照,但这使得基于时间的选择和模型变得更加困难。请注意,演示环境旨在包含转换后的暂存区域数据,而不是原始数据的副本。此外,演示环境应理想上仅包含来自暂存区域的数据,以防止无法复制的模型。

从数据集市中,数据科学家创建两种类型的数据用于建模:分析数据和操作数据。分析数据指的是用于构建模型的数据。它是历史数据,并且在训练/测试/验证中被适当地拆分。操作数据指的是进行评分所需的数据。请注意,由于演示环境仅包含历史数据,因此操作数据仅指数据的格式,而不是其时效性。这一点非常重要,因为我遇到过多次情况,数据科学家以为需要最新的数据才能对模型进行评分(在开发环境中)。这给 IT 部门带来了不合理的压力,要求在开发环境中以高频率提供数据,并且未能将模型开发与模型生产分开所带来的所有不利后果。

一旦模型构建完成,即经过训练、测试、验证并确认在操作数据上得分,模型可以进入预生产阶段。与其将其作为一个独立的环境,不如在开发环境中专门保留一个区域。就模型存储而言,它可以是模型库中的一个文件夹;就数据库而言,最佳实践是不允许数据科学家创建所需的表,而是将表创建语句提供给 IT 部门,以便讨论命名规范等。IT 部门创建表之后,数据科学家可以将操作测试数据插入表中,以展示模型在预生产中的得分。这一点很重要,以便识别任何被忽视的依赖关系。

为了让模型在生产环境中运行,IT 部门需要在生产环境中提供操作数据。这有两个途径。首先,由于 IT 部门确切知道他们放置在只读暂存区中的内容,他们可以将其提供到生产环境中。模型的数据准备工作就交给数据科学家,他们作为模型评分作业的一部分完成这项工作。当向 IT 部门解释这个场景时,他们通常希望接管,并使用他们首选的 ETL 工具提供模型所需的确切数据。数据科学家则负责以 IT 部门可以重建的方式记录数据转换。通常这并非易事,因为数据科学家会提出非常有创意的数据转换方法,这可能难以在 ETL 工具中归档。实际上,这通常是选择折中之路:IT 部门提供半成品数据,数据科学工作流完成其余部分,然后进行模型评分。

最佳实践是不要让数据科学家将模型迁移到生产环境中。可以由具有强 IT 背景和对 IT 政策了解的某位数据科学团队成员担任 IT-数据科学联络员,并协助迁移工作。

数据科学需要 IT 部门和数据科学家之间的紧密互动。这是一个自下而上的过程,并且是敏捷的。这意味着,在进行分析之前,不能将其写成需要逐字遵循的规范列表。通常,数据科学家会先调查数据样本,并结合对业务的理解,然后确定模型构建和数据交付的需求。这是一个迭代的过程,随着洞察的深入,会出现新的或修改的数据需求。一个理解这一过程并能够参与其中的 IT 部门,可以极大地促进数据科学的成功及其对业务的提升。

总结性评论

文章讨论了 IT 架构如何支持数据科学家的工作流程。我发现这种架构适用于许多将数据科学作为非核心业务的公司(如金融机构、零售业、电信业和制造业等行业,而不是专注于深度学习的公司)。我也意识到技术的迅速变化,例如用 Hadoop 等替代传统数据库。在这些情况下,我发现,在训练环境中对数据库建模(或至少将数据库作为模型开发环境的一部分)往往提供了最大的灵活性。数据科学的价值来自于能够操作数据以确定分析的下一步。任何能够增强这种能力的架构都将导致数据科学的更好结果,从而促进更好的决策制定。

原文。

简历: Olav Laudy 是 IBM Analytics 亚太区首席数据科学家。

相关:

-

数据需求层级

-

自动统计学家及数据科学所渴望的自动化

-

数据科学的尴尬真相

更多相关话题

-

如何使用 Apache Kafka 构建可扩展的数据架构

构的范式转变](https://www.kdnuggets.com/exploring-data-mesh-a-paradigm-shift-in-data-architecture)

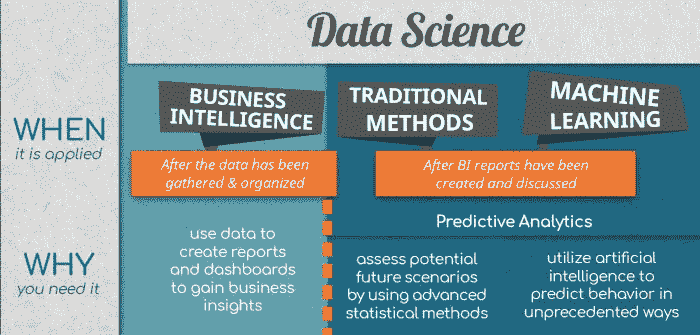

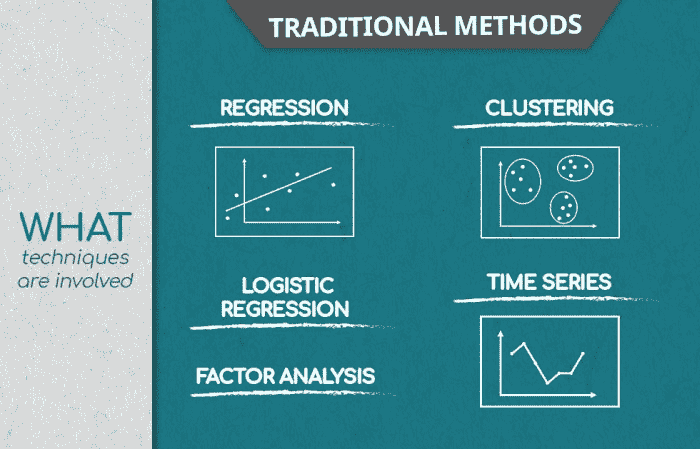

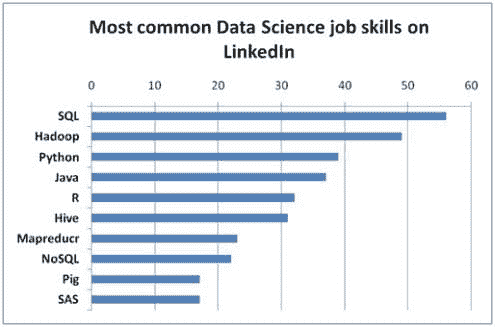

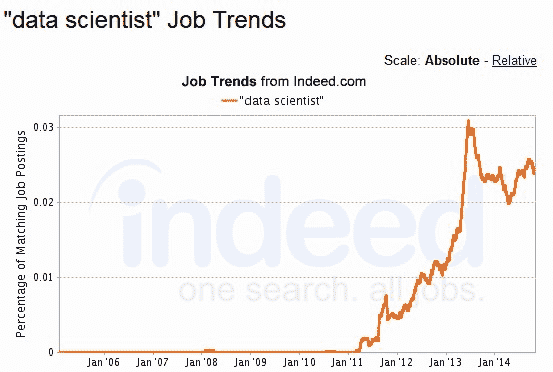

什么是数据科学,数据科学家做什么?

原文:

www.kdnuggets.com/2017/03/data-science-data-scientist-do.html

介绍

哈佛称什么职业为21 世纪最性感的工作?没错,就是数据科学家。

啊,是的,那神秘的数据科学家。那么,数据科学家的秘密武器到底是什么,这个“性感”的人每天在工作中到底做些什么呢?

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道

1. Google 网络安全证书 - 快速进入网络安全职业轨道

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你所在组织的 IT 工作

3. Google IT 支持专业证书 - 支持你所在组织的 IT 工作

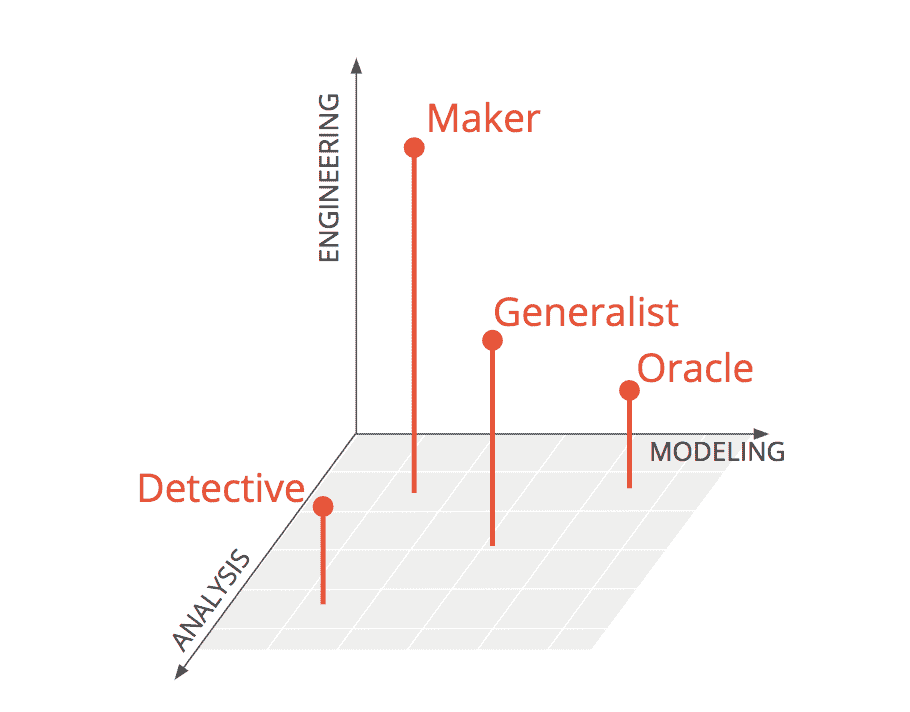

本文旨在帮助定义数据科学家的角色,包括典型的技能、资格、教育背景、经验和职责。由于数据科学家角色没有一个标准化的定义,而且理想的经验和技能组合在一个人身上相对较少,因此这一定义显得有些宽泛。

这一定义可能会更加混淆,因为有些角色有时被认为是相同的,但通常却大相径庭。这些角色包括数据分析师、数据工程师等。稍后会详细讨论。

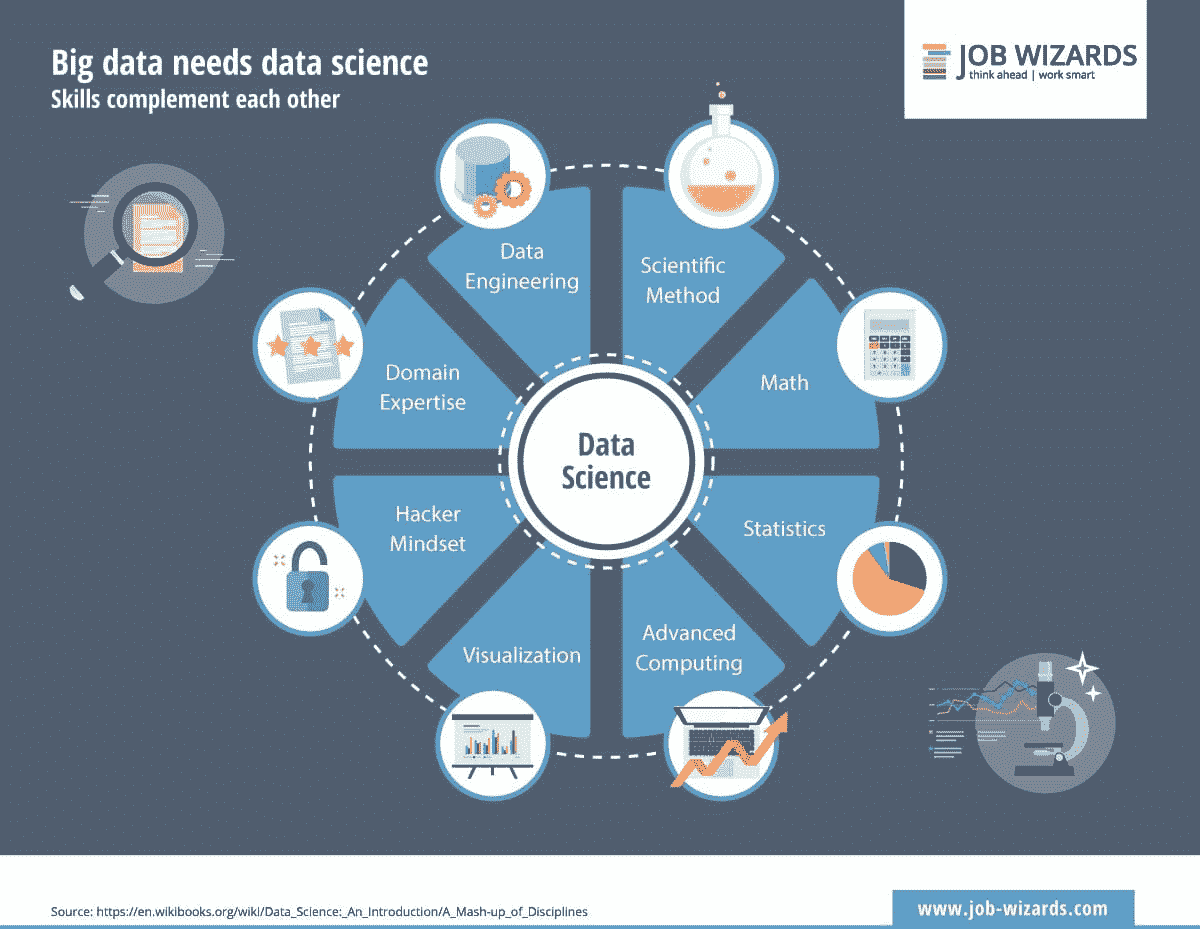

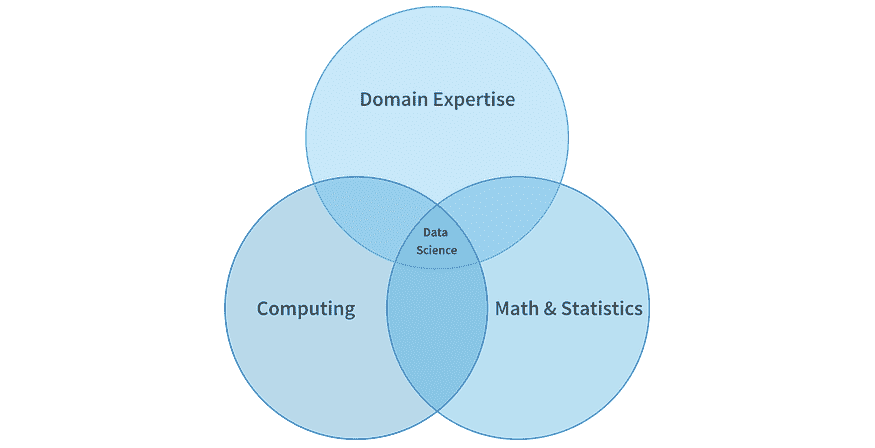

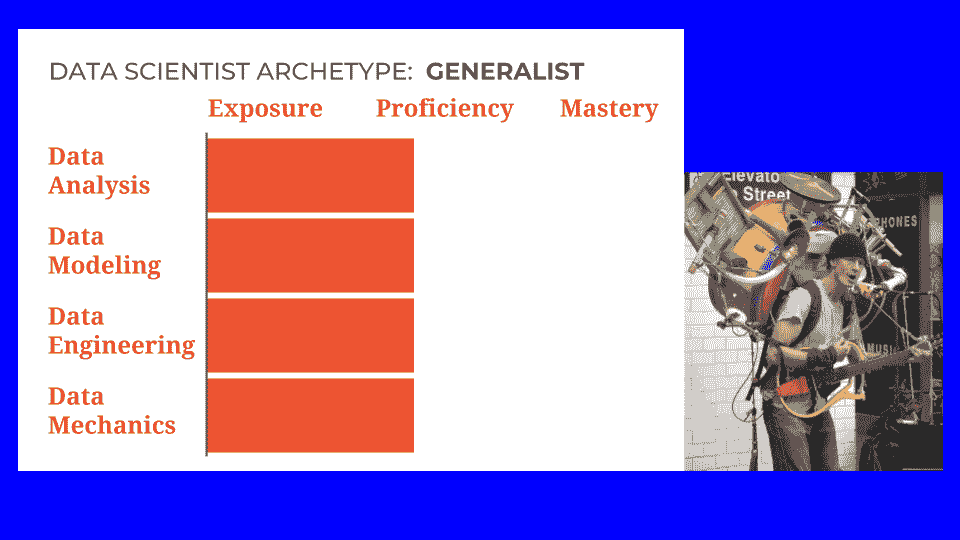

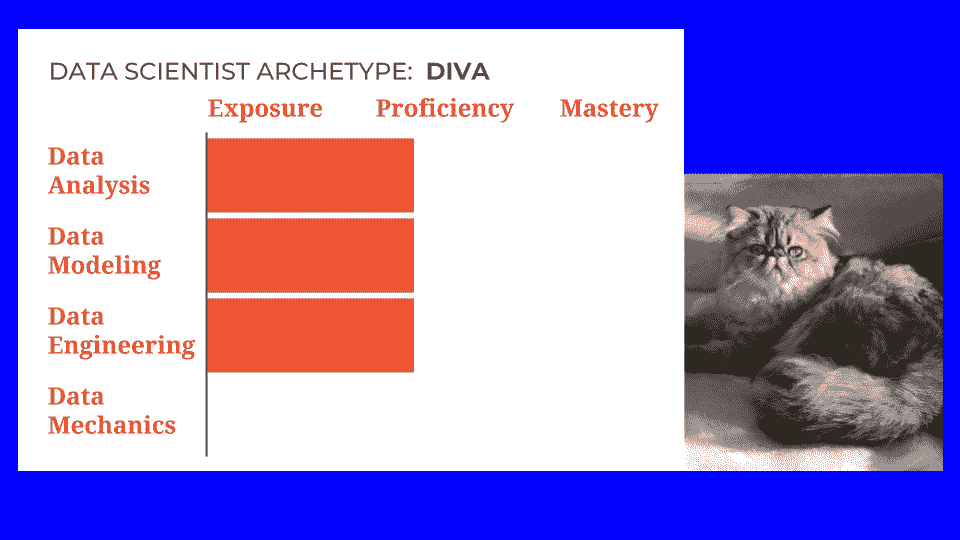

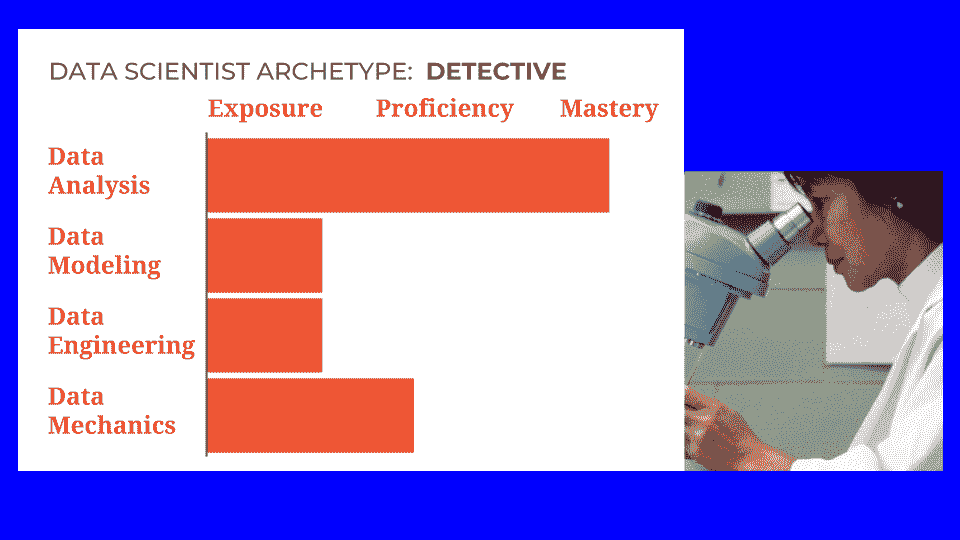

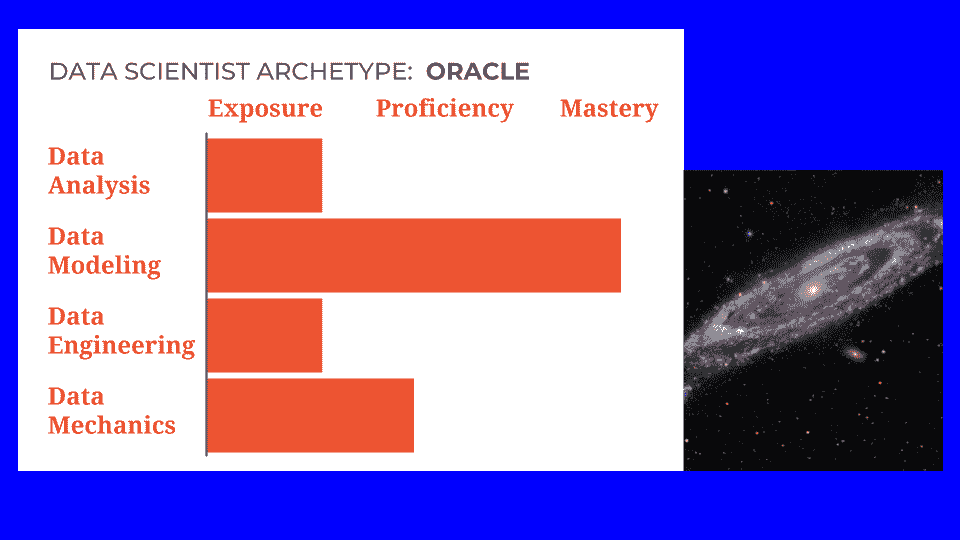

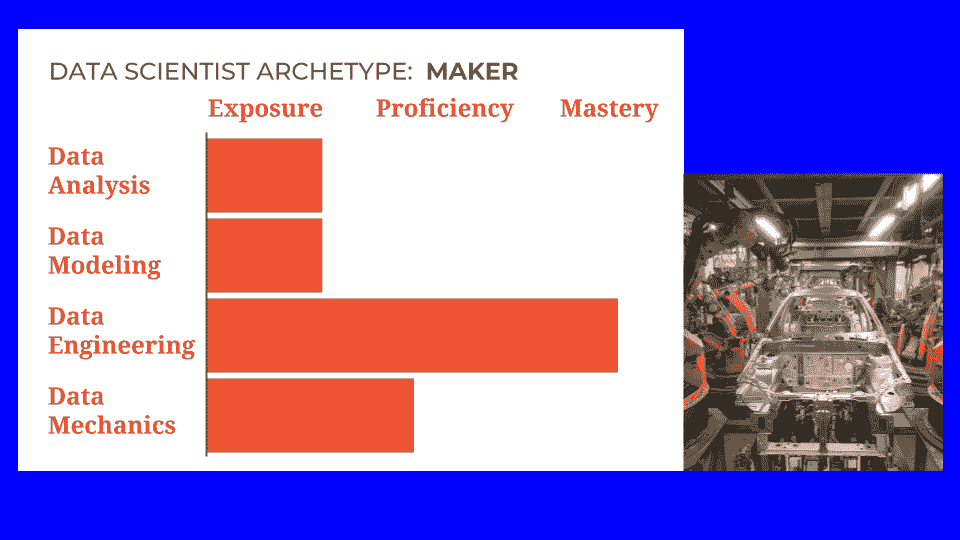

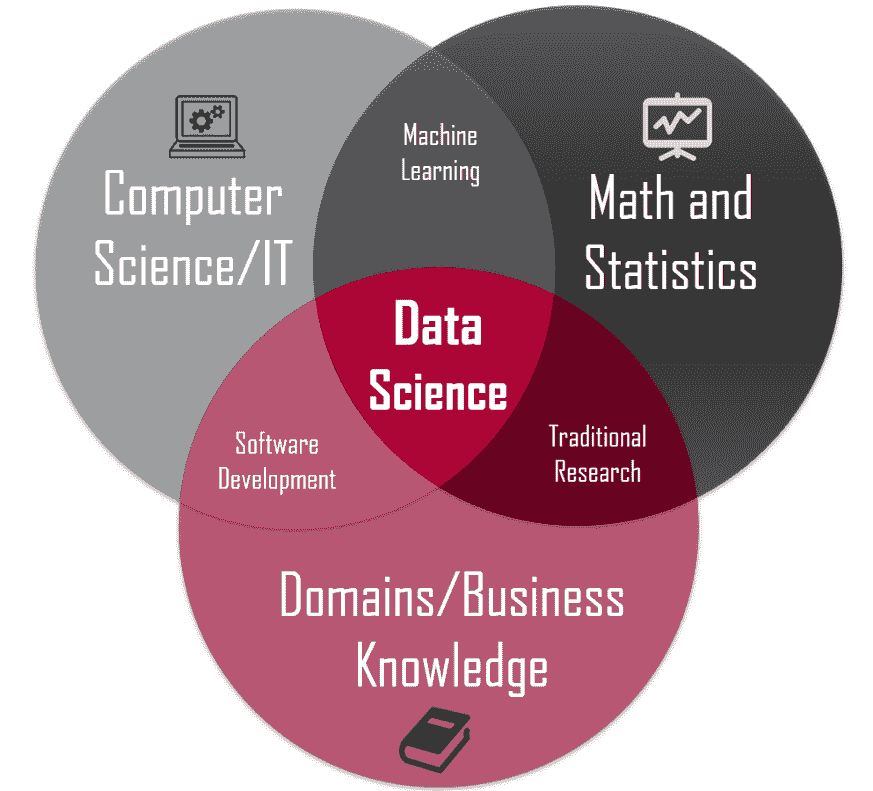

下面是一个图示,展示了数据科学家可能借鉴的一些常见学科。数据科学家在每个学科上的经验和知识水平,通常沿着从初学者到熟练者,再到专家的理想状态变化。

由 Calvin.Andrus(原创作品)CC BY-SA 3.0 (http://creativecommons.org/licenses/by-sa/3.0)),通过 Wikimedia Commons

尽管这些以及其他学科和专业领域(这里未展示)都是数据科学家角色的特征,但我喜欢将数据科学家的基础看作是建立在四个支柱上的。其他更具体的专业领域可以从这些支柱中衍生出来。

现在让我们讨论一下这些课程。

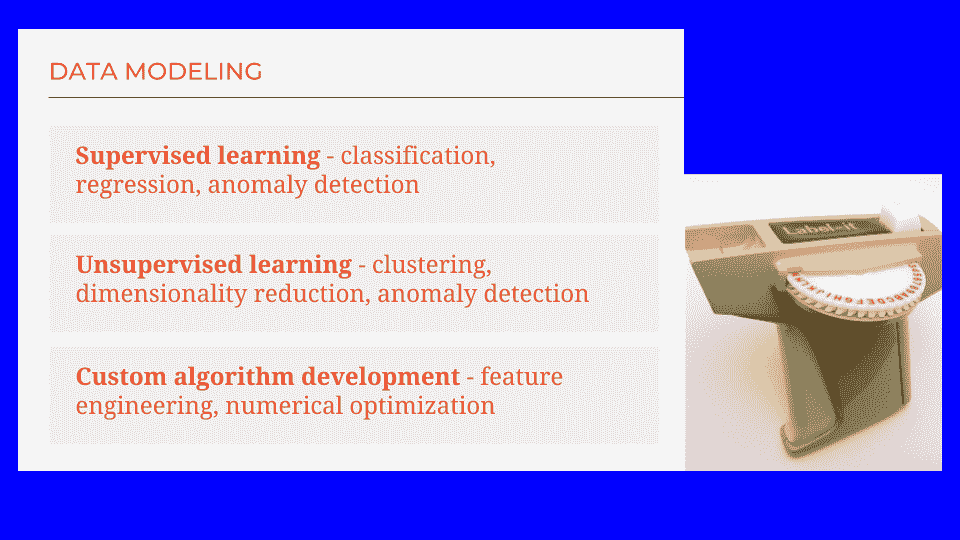

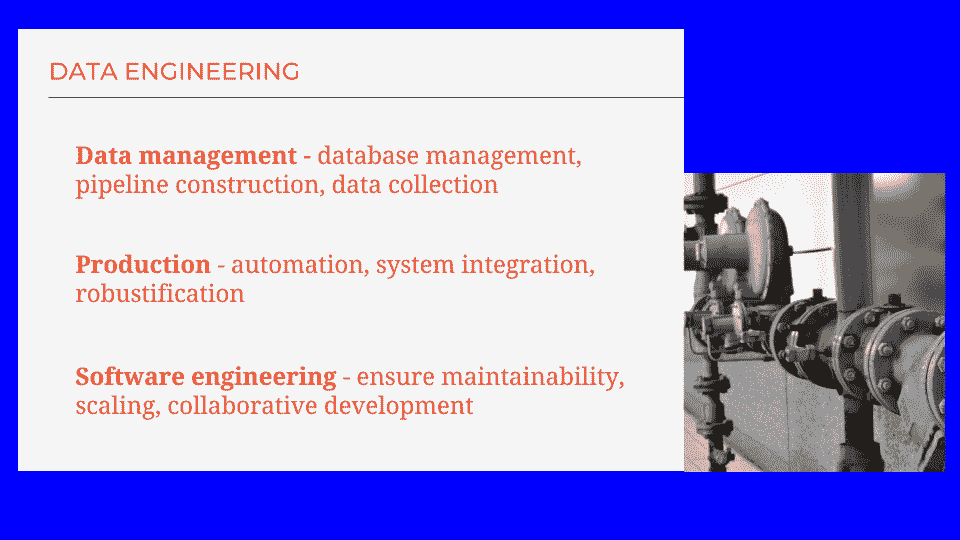

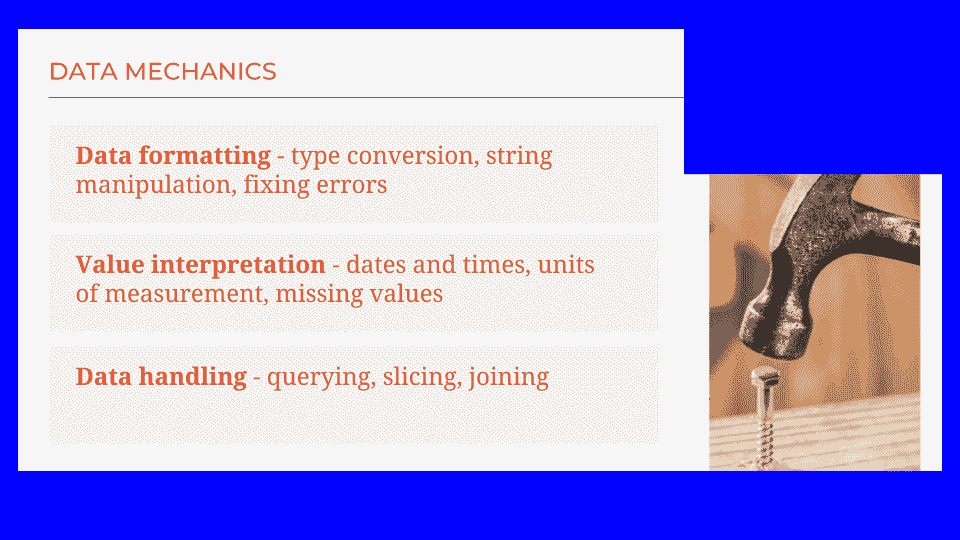

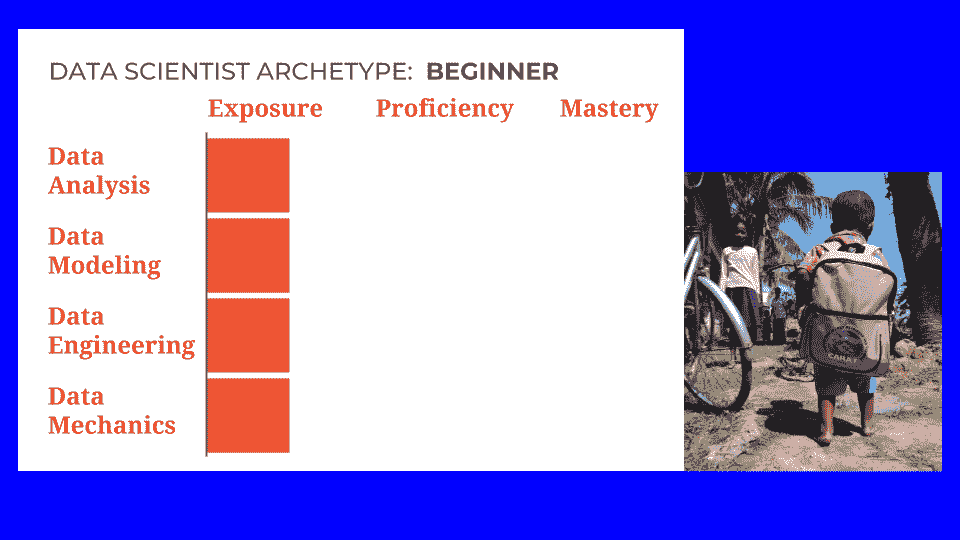

数据科学专业知识的支柱

尽管数据科学家通常来自许多不同的教育和工作经历背景,但大多数数据科学家应该在四个基本领域中表现出色,或者在理想情况下成为专家。这四个领域按优先级或重要性排序如下:

-

业务领域

-

统计与概率

-

计算机科学与软件编程

-

书面和口头沟通

还有其他非常期望的技能和专业知识,但在我看来,这四项是主要的。本文将称这些为数据科学家的支柱。

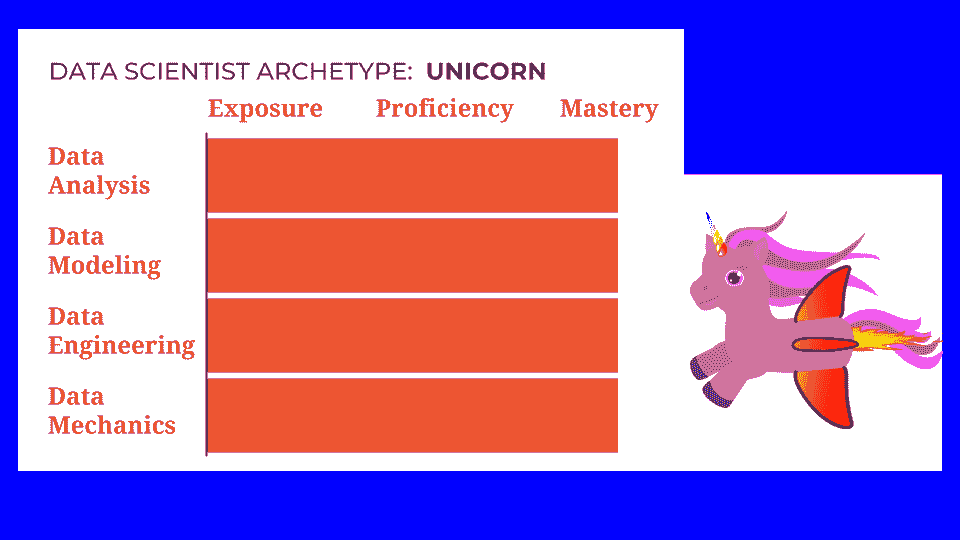

现实中,人们通常在这些支柱中的一两个方面很强,但通常在所有四个方面都不均衡。如果你遇到一个在所有方面都是真正专家的数据科学家,那么你基本上遇到了一只独角兽。

基于这些支柱,数据科学家应该能够利用现有的数据源,并在需要时创建新的数据源,以提取有意义的信息和可操作的见解。这些见解可以用来推动业务决策和变更,以实现业务目标。

这是通过商业领域的专业知识、有效的沟通和结果解释,以及利用所有相关的统计技术、编程语言、软件包和库、数据基础设施等来完成的。

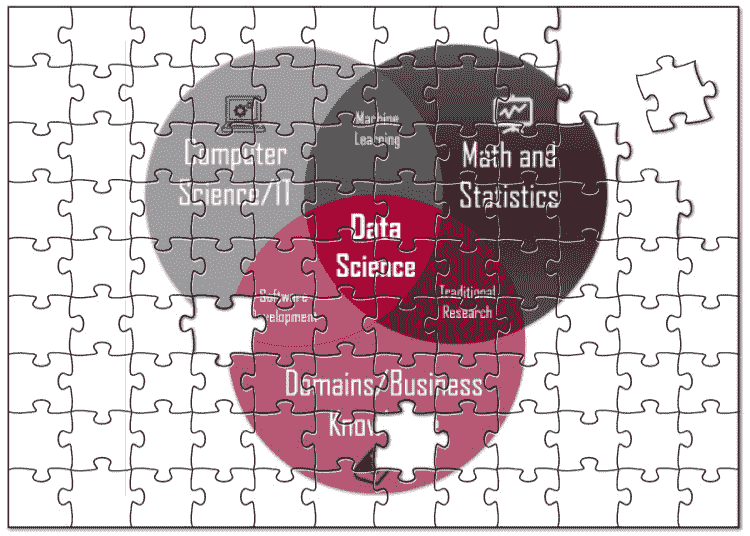

数据科学维恩图

可以找到许多不同版本的数据科学家维恩图,以帮助可视化这些支柱(或变体)及其相互关系。David Taylor 写了一篇关于这些维恩图的优秀文章,标题为数据科学维恩图之战。我强烈推荐阅读。

这是我最喜欢的数据科学家维恩图之一,由 Stephan Kolassa 创建。你会注意到图表中的主要椭圆形与上述支柱非常相似。

Farcaster 在英语维基百科 [GFDL (http://www.gnu.org/copyleft/fdl.html) 或 CC BY-SA 3.0 (http://creativecommons.org/licenses/by-sa/3.0)],通过 Wikimedia Commons

这就是这个过程的概要。那么这些支柱在这里如何发挥作用呢?

数据科学家的支柱、技能和教育深入分析

我们已经讨论了业务领域和沟通支柱,这代表了商业敏锐性和顶级的沟通技巧。这对于发现和目标阶段非常重要。在数据科学家通常需要向关键利益相关者(包括高管)展示和沟通结果时,这也非常有帮助。

因此,强大的软技能,特别是沟通(书面和口头)和公众演讲能力是关键。在传达和交付结果的阶段,关键在于数据科学家能够以易于理解、引人入胜和有见地的方式呈现结果,同时使用适合其受众的语言和术语水平。此外,结果应该始终与最初推动项目的商业目标相关联。

对于所有列出的其他阶段,数据科学家必须具备强大的计算机编程技能,以及统计学、概率论和数学知识,以便理解数据、选择正确的解决方案、实施解决方案并进行改进。

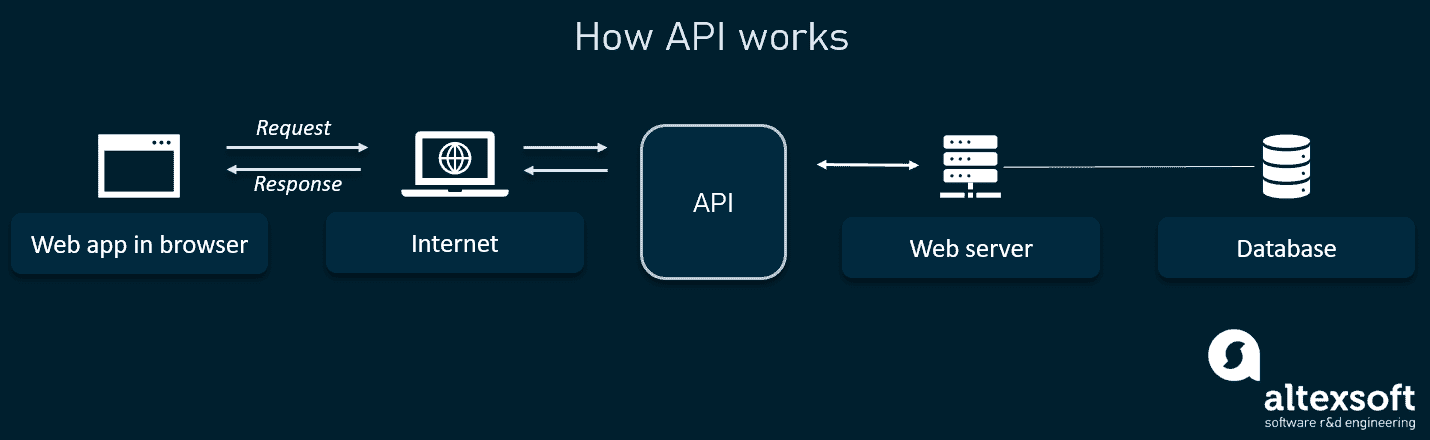

一个重要的话题是现成的数据科学平台和 API。可能会有人认为这些平台可以相对容易地使用,因此不需要在某些领域具有显著的专业知识,也就不需要一位强大且全面的数据科学家。

虽然确实许多现成的产品可以相对容易地使用,根据所解决的问题可能会获得相当不错的结果,但在数据科学的许多方面,经验和技能至关重要。

其中包括具备以下能力:

-

根据具体问题定制方法和解决方案,以最大化结果,包括根据需要编写新算法和/或显著修改现有算法的能力

-

访问和查询多种不同的数据库和数据源(RDBMS、NoSQL、NewSQL),以及将数据集成到以分析为驱动的数据源中(例如,OLAP、数据仓库、数据湖等)

-

找到并选择最佳的数据源和数据特征(变量),包括根据需要创建新的特征(特征工程)

-

了解所有可用的统计、编程和库/包选项,并选择最佳方案

-

确保数据具有高完整性(优质数据)、质量(正确的数据),并处于最佳状态,以保证结果准确、可靠且具有统计意义

- 避免与垃圾进垃圾出相关的问题

-

选择并实施最佳的工具、算法、框架、语言和技术,以最大化结果并根据需要进行扩展

-

选择正确的性能指标,并应用适当的技术以最大化性能

-

探索如何利用数据在没有来自上层的指导和/或交付物要求的情况下实现业务目标,即数据科学家作为创意提供者

-

跨部门有效合作,并与公司所有部门和团队协作

-

区分好结果和坏结果,从而降低由于错误结论和随后的决策可能带来的风险和财务损失

-

了解产品(或服务)客户和/或用户,并以他们为中心创建想法和解决方案

在教育方面,成为数据科学家没有单一的路径。许多大学创建了专门的数据科学和分析项目,大多数为硕士学位水平。一些大学和其他组织也提供认证项目。

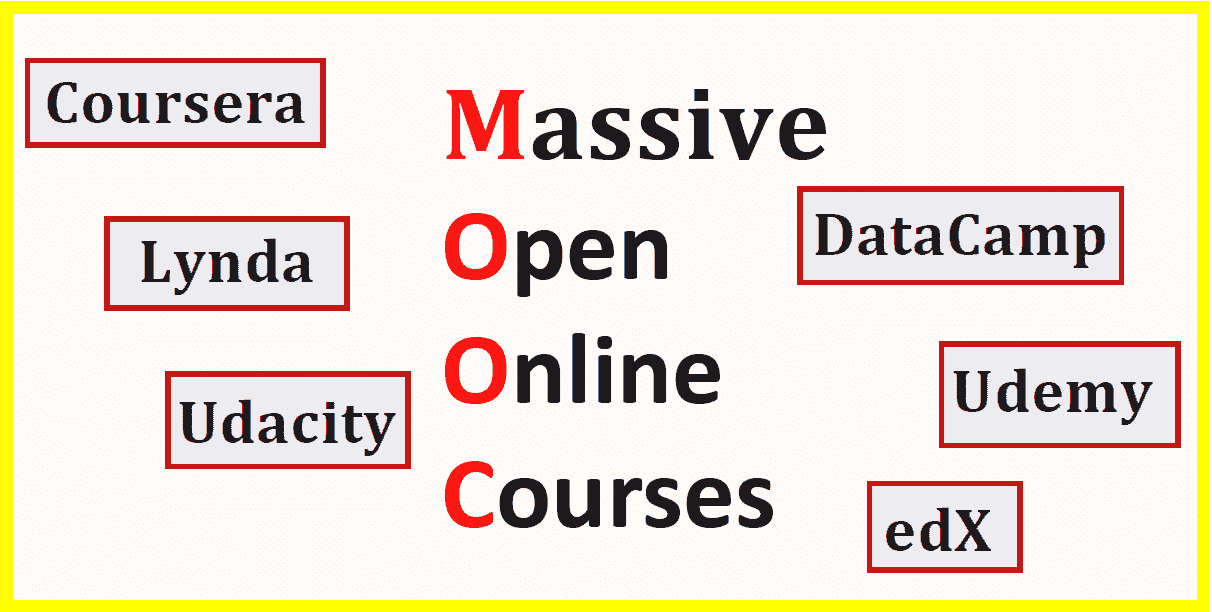

除了传统的学位和认证项目外,还有一些训练营,这些训练营从几天到几个月不等,还有在线自学课程和聚焦于数据科学及相关领域的大规模在线开放课程(MOOC),以及自我驱动的实践学习。

无论选择哪条学习路径,数据科学家应该具备高级的定量知识和高度的技术技能,主要涉及统计学、数学和计算机科学。

数据科学中的“科学”

科学一词通常与科学方法同义,也许你们已经注意到,上述过程与科学方法这一表达所特征化的过程非常相似。

这里有一张图像,展示了科学方法作为一个持续过程的可视化效果。

由 ArchonMagnus(原创) [CC BY-SA 4.0 (http://creativecommons.org/licenses/by-sa/4.0)],通过维基共享资源

一般来说,传统科学家和数据科学家都会提出问题和/或定义问题,收集和利用数据来得出答案或解决方案,测试解决方案以查看问题是否解决,并根据需要迭代以改进或最终确定解决方案。

数据科学家 vs. 数据分析师 vs. 数据工程师

如前所述,数据科学家的角色经常与其他类似角色混淆。主要有两个相关角色是数据分析师和数据工程师,这两者之间有显著的区别,也与数据科学有所不同。

让我们更详细地探讨这两个角色。

数据分析师

数据分析师与数据科学家共享许多相同的技能和责任,有时也有类似的教育背景。这些共享的技能包括:

-

访问和查询(例如,SQL)不同的数据来源

-

处理和清理数据

-

总结数据

-

理解和使用一些统计和数学技术

-

准备数据可视化和报告

然而,一些关键区别在于,数据分析师通常不是计算机程序员,也不负责统计建模、机器学习以及数据科学过程中的许多其他步骤。

使用的工具也通常不同。数据分析师经常使用如Microsoft Excel(可视化、数据透视表等)、Tableau、SAS、SAP和Qlik等用于分析和商业智能的工具。

分析师有时会执行数据挖掘和建模任务,但通常使用如IBM SPSS Modeler、Rapid Miner、SAS和KNIME等可视化平台。另一方面,数据科学家则通常使用R和Python等工具执行这些相同的任务,并结合相关的语言库。

最后,数据分析师在与高级业务经理和高管的互动中往往有显著差异。数据分析师通常从上层获取问题和目标,进行分析,然后报告他们的发现。

然而,数据科学家倾向于自己提出问题,依据对哪些业务目标最重要以及数据如何用于实现这些目标的了解。此外,数据科学家通常使用更高级的统计和建模技术、数据可视化,并以更具商业驱动的叙事方式强调报告。

数据工程师

在大数据时代,数据工程师变得越来越重要,可以被视为一种数据架构师。他们不太关注统计、分析和建模,更多关注数据架构、计算和数据存储基础设施、数据流等。

数据科学家和大数据应用使用的数据通常来自多个来源,并必须以优化分析、商业智能和建模的方式进行提取、移动、转换、集成和存储(例如,ETL/ELT)。

因此,数据工程师负责数据架构和设置所需的基础设施。因此,他们需要是熟练的程序员,具备与DevOps角色非常相似的技能,同时具备强大的数据查询编写能力。

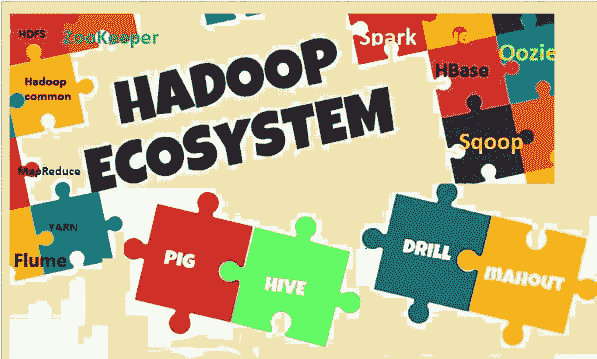

这个角色的另一个关键方面是数据库设计(RDBMS、NoSQL和NewSQL)、数据仓储和设置数据湖。这意味着他们必须非常熟悉许多可用的数据库技术和管理系统,包括与大数据相关的那些技术(例如,Hadoop和HBase)。

最后,数据工程师通常还会处理非功能性基础设施要求,如可扩展性、可靠性、耐用性、可用性、备份等。

数据科学家的工具箱

我们将以对一些典型工具的概述结束,这些工具属于数据科学家的所谓工具箱。

由于计算机编程是一个重要组成部分,数据科学家必须熟练掌握R、Python、SQL、Scala、Julia、Java等编程语言。通常不需要在所有这些语言中都成为专家,但R、Python和SQL确实是关键,而像Scala这样的语言在大数据领域也越来越重要。

对于统计、数学、算法、建模和数据可视化,数据科学家通常会尽可能使用现有的包和库。一些较为流行的包括Scikit-learn、e1071、Pandas、Numpy、TensorFlow、Matplotlib、D3、Shiny和ggplot2。

对于可重复的研究和报告,数据科学家通常使用诸如Jupyter、iPython、Knitr和R markdown等笔记本和框架。这些工具非常强大,因为代码和数据可以与关键结果一起交付,以便任何人都可以执行相同的分析,并在需要时进行扩展。

如今,数据科学家还应该能够使用与大数据相关的工具和技术。最受欢迎的例子包括Hadoop、Spark、Hive、Pig、Drill、Presto、Mahout等。

最后,数据科学家应该知道如何访问和查询许多顶级的RDBMS、NoSQL和NewSQL 数据库管理系统。一些最常见的包括MySQL、PostgreSQL、Redshift、MongoDB、Redis、Hadoop和HBase。

总结

哈佛对数据科学家的评价是正确的。这是一个极其重要且需求旺盛的角色,对企业实现其财务、运营、战略等目标的能力有着显著影响。

公司会收集大量数据,而这些数据往往被忽视或未充分利用。通过有意义的信息提取和可操作见解的发现,这些数据可以用于做出关键业务决策,并推动重大业务变革。它还可以用于优化客户成功及随后的获取、留存和增长。

如前所述,数据科学家可以对企业的成功产生重大积极影响,但有时也可能无意中造成财务损失,这也是为什么雇用一位顶尖数据科学家至关重要的众多原因之一。

希望这篇文章有助于揭示数据科学家的角色以及其他相关角色。

干杯!

亚历克斯·卡斯特鲁尼斯是Why of AI的创始人兼首席执行官,也是《AI for People and Business》的作者。他还是西北大学 Kellogg / McCormick MBAi 项目的兼职教授。

原文。经许可转载。

相关:

-

机器学习:完整详尽的概述

-

数据科学与大数据的解释

-

人工智能、深度学习与神经网络的解释

相关主题

数据科学定义幽默:一系列关于数据科学定义的古怪名言

原文:

www.kdnuggets.com/2022/02/data-science-definition-humor.html

由 Rupa Mahanti,顾问

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速入门网络安全职业

1. 谷歌网络安全证书 - 快速入门网络安全职业

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

数据科学是一个广泛的学科,涉及几乎所有的业务领域,从金融到公用事业,从制造业到医疗保健和生命科学。数据科学是当前数字世界中最流行的流行词之一。然而,围绕这一术语存在很多混乱,不同的人对这个术语有不同的定义。以下是一些关于数据科学定义的幽默而富有洞察力的名言,希望能让你开心一笑。

“数据科学的第一个规则是:不要问如何定义数据科学。”

―乔希·布卢姆 (Azam 2014)

“关于数据科学:它是一个跨学科的、非学科性的领域,人们以有趣的方式完成工作,但他们自己都不知道该怎么称呼。”

―凯瑟琳·卡森 (Azam 2014)

“定义数据科学就像定义互联网——问 10 个人,你会得到 10 个不同的答案。”

―米凯拉·S·帕克、阿林·E·伯吉斯和菲利普·E·伯恩 (Parker et al. 2021)

“数据科学不过是统计学在不同领域中的新瓶装旧酒版本。”

―兰迪·巴特利特 (Bartlett 2015)

“‘数据科学’这个术语实际上是一个同时意味着一切和什么都不意味着的术语。”

―尼克·亚当斯 (Azan 2014)

“数据科学完全是基于你拥有的数据——或者经常是你没有的数据——提出有趣的问题。”

―莎拉·贾维斯 (Darmody 2020)

“‘数据科学’的定义就是‘数据科学家’所做的事情。”

―哈兰·D·哈里斯 (Harris 2011)

“数据科学是数据的土木工程。”

―凯西·奥尼尔和瑞秋·舒特 (O’Neil and Schutt 2013)

“数据科学有一个有趣的特点,就是它是少数几个让从业者没有特定领域的研究领域之一。”

―米哈伊尔·梅夫 (Mew 2021)

“数据科学是使数据变得有用的科学。”

―卡西·科齐科夫 (Kozykorv 2018)

“数据科学并不在于数据的数量,而在于数据的质量。”

―朱安·李 (Coresignal 2021)

“数据科学的座右铭:如果一开始不成功,那就称之为版本 1.0。”

“数据科学很像做饭。虽然原料在开始时可能很吸引人,但只有当你真正开始切割、剁碎,并最终端出美味的菜肴时,乐趣才开始。大多数时候,你会得到一道菜,但在数据科学的世界里,我们称之为数据洞见。”

―理查德·科内利乌斯·苏万迪 (Suwandi 2020)

“数据科学是 80%处理数据,20%抱怨处理数据。”

―理查德·科内利乌斯·苏万迪 (Suwandi 2020)

“数据科学是艺术和科学的结合,仅受限于数据科学家探索的自由程度以及他们的创造能力。”

“数据科学的实际操作是一种红牛助力的黑客技术和浓缩咖啡激发的统计学的结合。”

“而且数据科学不仅仅是统计学,因为当统计学家完成了理论上的完美模型时,如果他们的工作依赖于此,很少有人能将制表符分隔的文件读入 R 中。”

―迈克·德里斯科尔 (O’Neil and Schutt 2013)

“数据科学:一个扩展统计学技术领域的行动计划。”

―威廉·克里夫兰 (Cleaveland 2001)

“学习数据科学就像去健身房,只有持续不断地做,你才会有所收益。”

—莫埃兹·阿里 (Suwandi, 2022)

“许多人把数据科学视为一项工作,但更准确的说法是,它是一种思维方式,一种通过科学方法提取洞见的手段。”

—Thilo Huellmann (Coresignal 2021)

笑声确实是最好的药,数据专业人士的生活中也确实需要更多的幽默。下次当你计划在数据领域进行演讲或展示时,最好以一些有趣或古怪的数据名言开场,以引起同事和客户的兴趣。它们不仅能轻松气氛,还会提供一些没有人会想到的有用建议,因为它们非常搞笑。为了享受更多这样的名言,可以看看这本书——数据幽默:有趣的数据、大数据、统计学和数据科学名言、双关语及妙句。

Rupa Mahanti 是一名顾问及《数据幽默:有趣的数据、大数据、统计学和数据科学名言、双关语及妙句》一书的作者。数据幽默:有趣的数据、大数据、统计学和数据科学名言、双关语及妙句。

更多相关主题

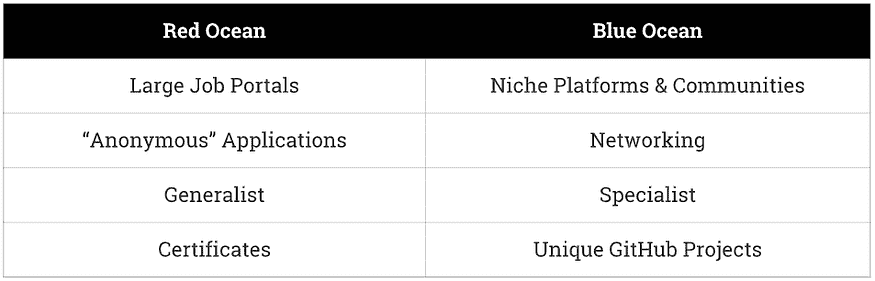

数据科学学位与课程:价值判断

原文:

www.kdnuggets.com/data-science-degrees-vs-courses-the-value-verdict

作者提供的图片

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

如果你想在数据科学领域找到工作,而你第一次没有获得计算机科学、数据科学或数学学位,你现在可能在考虑你的选择。你可以回到学校获得那个学位,或者尝试完成一个认证的数据科学课程或训练营。

两者都昂贵且耗时,但学位比大多数课程或训练营要昂贵和耗时得多。这个价格对雇主来说值得吗?让我们通过每种课程提供的内容来详细分析一下。

传统路径:数据科学学位

标准路线是获得数据科学、计算机科学或数学的学位(甚至两个)。这种结构化的学习将教会你在数据科学工作中表现出色所需的知识。

学位的一个好处是它可以让你扎实而全面地学习该主题。它提供了真正的深度和对理论概念的深刻理解,这些是你从密集的训练营或在线课程中无法获得的。

学位涵盖广泛而深入的主题,包括高级数学、统计学、计算机科学基础、数据结构、算法、机器学习、数据可视化,甚至可能包括近年来变得更加实用的人工智能、深度学习和大数据技术等专业领域。

这样广泛而深入的学习意味着你真正理解了基础知识。你不仅仅是一个代码工蜂;你明白如何以及何时使用特定的统计工具或进行特定的分析。

不仅如此,学位还具有分量。许多大学就像品牌名称,雇主会认可并钦佩。例如,拥有 MIT 数学学位的求职者会以积极的方式脱颖而出。

不过,正如我之前提到的,学位通常需要四年时间,尽管也有更短、更专注的选项。例如,如果四年太长,你可以选择一个加速课程或一个专注于数据科学的硕士学位,这通常需要一到两年时间。

这些替代方案有点像大学学位的速成版,提供了更集中、侧重于工作所需的课程——数据科学、机器学习和统计技能。对于那些已经毕业并希望立即转行进入数据科学职位而不愿花费四年时间的人来说,它们可能是一个有吸引力的选择。

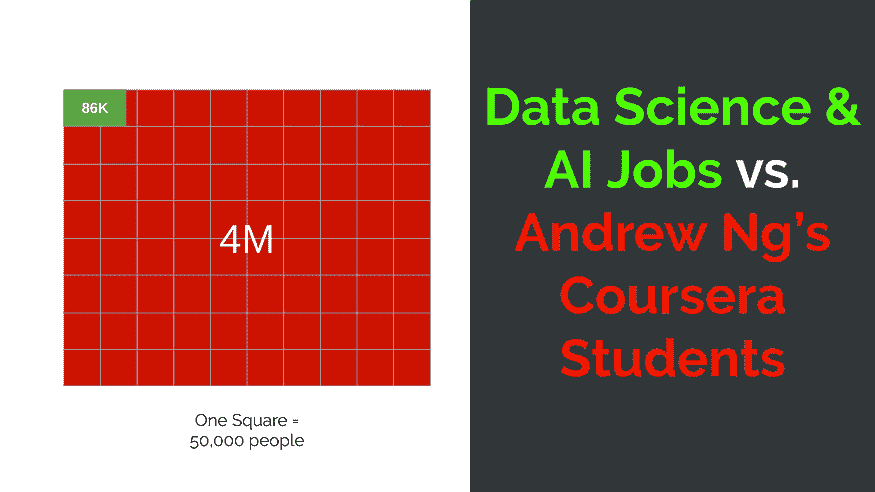

现代途径:在线课程和训练营

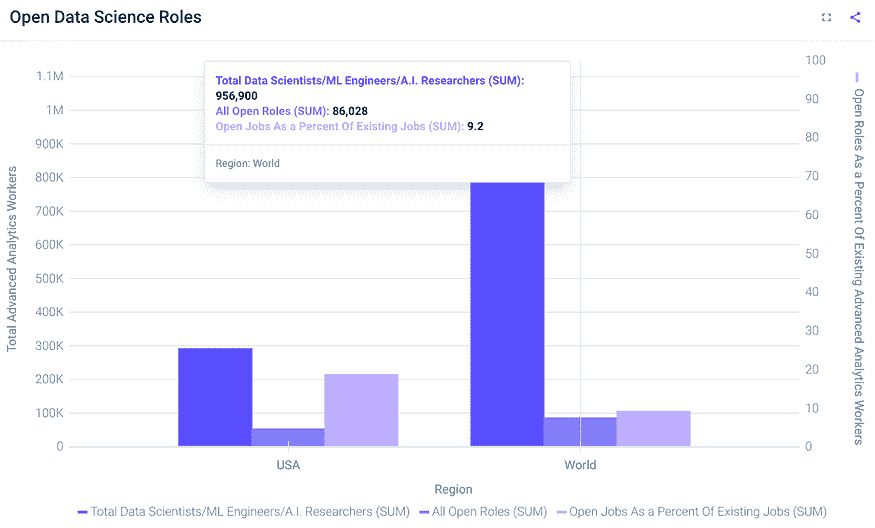

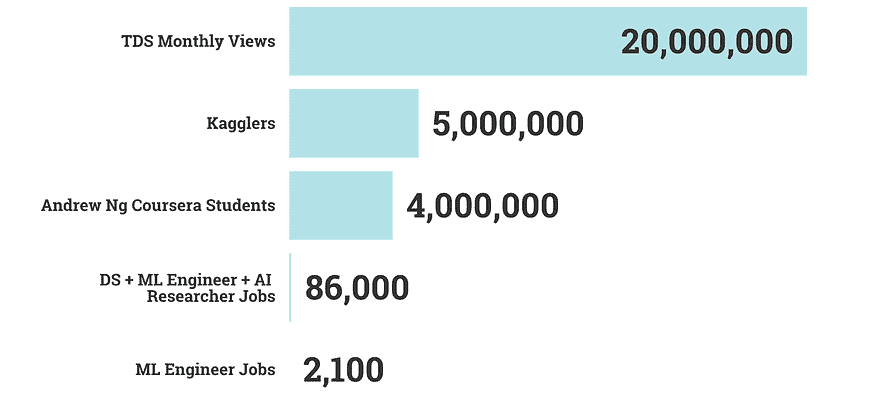

正如你所知道的,数据科学领域非常强劲且持续增长(不,没有泡沫)。这些领域的毕业生数量与职位空缺的数量不匹配。这意味着,虽然没有学位获得工作确实不容易,但也不是不可能——雇主只是希望你证明你的技能。

一种方法是通过结合在线课程、证书和训练营来做到这一点。这条路径更加灵活。你甚至可以兼职进行,同时进行现有工作。

与标准学位相比,这些课程的课程设置更具实用性,并根据当前的就业市场需求进行设计。它们包括类似实际数据科学工作的动手项目,教授你在标准职位描述中可能会看到的具体技能,如 Python、R、机器学习算法和数据可视化工具的熟练使用。这种方法对那些喜欢直接应用而非坐在讲堂里的学习者尤其有用。

许多训练营只持续几个月,通常在结束时提供某种工作安置机会。它们很昂贵,有时达到数万美元,但如果它们能帮助你在不到一年内找到六位数的工作,这可能会有很高的投资回报率。

问题在于,这条路线并没有提供完整的、整体的视角。你可能能够用优秀的项目充实你的简历,但在面试中可能会因为被问到训练营未涵盖的基础问题而表现不佳。

作者通过 supermeme.ai 创建

这就是为什么单一的训练营不够;你通常需要通过审计(或支付)Coursera 或 EdX 课程,或者进行自学、研究和实践来补充。

填补空白

学位无疑提供了无与伦比的深度和声望。但是,通过课程和训练营获得的敏捷性和实用技能不仅是一个值得的替代方案,而且实际上可能使你更好地为职场做准备。虽然学位是传统的,但它们也具有更大的惯性——课程和训练营可以比学位更快地响应不断变化的就业市场。此外,学位课程更加注重理论,对诸如面试准备等技能的重视较少。

作者创建于 supermeme.ai

也就是说,如果你选择课程和训练营的混合组合,你将错过从专注于一个主题一年的深度知识和学科信心。

幸运的是,我们推荐了一些资源,可以帮助你弥补这一差距,确保无论你选择了学位路径还是训练营方向,都能展现出全面且合格的候选人形象。

进一步了解数据科学主题

你可以通过两种方式进行。其一,你可以查看数据科学学位的课程大纲,并列出你想要学习的所有内容。其二,你可以从后向前推——选择一个理想的工作岗位,写下你想要学习的所有职位要求。无论哪种方式,编制你想要学习的主题列表。

有了这个列表,你可以利用以下资源来完善你的学习:

-

Coursera 和 edX: 如果你不想支付课程费用,你可以旁听课程以学习材料,尽管你无法获得结业证书。Coursera 和 edX 提供大量关于数据科学和数学理论与基础主题的全面课程。

-

可汗学院: 提供免费的课程,包括统计学和概率等大学级别的课程。

-

麻省理工学院开放课程: 你完全可以利用麻省理工学院这个品牌!这是一个宝贵的资源,提供了来自麻省理工学院的免费讲座和课程材料,涵盖计算机科学和数据科学的高级主题。

-

学术期刊和论文:这可能有点深奥,但阅读研究论文是深入理解高级数据科学主题的好方法,更重要的是,跟上当前研究趋势。一些论文需要付费获取,但许多可以在线免费获取。从 Google Scholar 开始。

为一个主题练习技能

如你所知,仅仅在简历上写“精通统计学”并不够,还需付出更多努力。

作者创建于 supermeme.ai

你需要应用你实际的数据科学技能,从编码到项目实施,并且要有项目来证明这一点。以下是一些资源,可以为你的简历增加额外的光彩。注意:这些资源对于学位型候选人尤其有用,因为学位通常比课程和训练营提供的实际项目机会要少。

-

DataCamp: 提供以编程、数据分析和机器学习等实际技能为重点的互动课程。

-

GitHub: 让你参与真实世界的项目,与他人合作,以获得实际经验并展示你的编码和项目管理技能。

-

Kaggle: 提供一个平台,让你与其他新人竞争,解决现实世界的问题,访问数据集,并与全球社区合作。

成功面试

无论你选择了学位还是训练营,你都需要在面试中表现出色才能获得工作。你应该准备数据科学工作面试,关注技术问题以及展示你的项目工作。以下是一些资源:

-

StrataScratch: 曾经希望你能提前知道面试官会问你什么吗?StrataScratch(我创办的)收集了 1000 多个真实的面试问题,包括编码和非编码问题,以及最佳答案,让你能够练习和准备面试官可能问你的任何问题。

-

会议和研讨会:建立联系和网络的重要性不可低估。参加这些活动,无论是亲自还是虚拟,了解最新趋势,与专业人士建立联系,甚至可能找到可以提供建议和面试见解的导师。

-

LeetCode: 提供大量编码挑战和问题,以提升你的算法和编码技能,这对于技术面试至关重要。

-

Glassdoor:提供关于公司特定面试问题和流程的见解,以及候选人对面试经历的评价。

最后的想法

如果你是一个有抱负的数据科学家,最好的做法是评估自己的现状。如果你有时间和资金可以用于学位,那是一个很好的选择,只要你将深厚的理论知识与实际操作和面试准备结合起来。如果你需要选择训练营或课程,那也是一个越来越有竞争力的选项——只要确保你完全掌握了相关概念。

两种选择都是可行的,但其中一种可能比另一种更适合你。希望这个价值指南能帮助你选择适合你的选项,并填补你需要的空白,从而获得理想的工作。

Nate Rosidi 是一名数据科学家,并且从事产品策略工作。他还是一名兼职教授,教授分析学,并且是 StrataScratch 的创始人,该平台帮助数据科学家准备面试,提供来自顶尖公司的真实面试问题。Nate 撰写有关职业市场的最新趋势,提供面试建议,分享数据科学项目,并涵盖 SQL 的所有内容。

更多相关主题

数据科学与残疾

评论

评论

2012 年在英国是一个重要的年份。全国洋溢着民族自豪感。联合杰克在大多数英国街道上高高飘扬,气氛热烈,因为我们举办了可以说是有史以来最好的奥运会。在比赛期间,我们见证了残疾运动员在残奥会和特殊奥运会上显著的崛起和应得的公众认可。塔尼·格雷-汤普森、艾莉·西蒙兹和李·皮尔森现在和莫·法拉赫、布拉德利·威金斯一样,可能会在酒吧和朋友们讨论的英国最佳奥运选手中被提及。之前存在的任何污名都被打破了,我们的英雄运动员带回了一个又一个金牌。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织的 IT

3. Google IT 支持专业证书 - 支持您的组织的 IT

由于奥运会,我们现在看到社会对残疾群体变得更加理解和包容,但联合国报告称世界上大约 15% 的人口遭受某种类型的残疾,越来越多人觉得我们需要做得更多,以帮助改善残疾人士的生活。

数据科学和人工智能在过去几年中成为技术的前沿,许多从业者对生活采取了更具慈善性质的观点,支持那些身心障碍者。

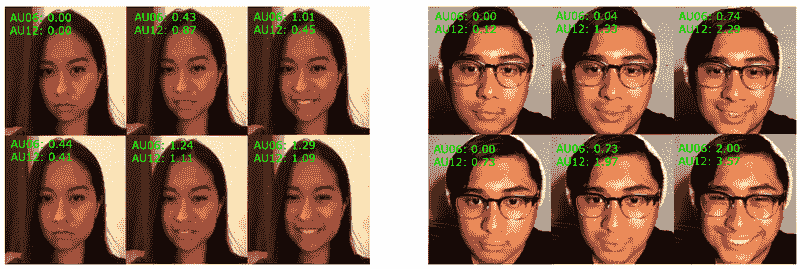

机器学习在支持自闭症谱系障碍(ASD)患者方面发挥着重要作用。这种状况大约影响每 100 人中的 1 人,其中男性比女性更容易被诊断出此病。它在大约 3 岁时影响儿童,导致他们在处理或参与人际互动或情感方面遇到困难,这使得融入其他儿童的群体非常困难。然而,伦敦知识实验室在将一组 ASD 儿童引入一款名为 Andy 的虚拟自主机器人方面取得了巨大成功。实验发现,儿童们与 Andy 互动非常积极,专心倾听,问答交流比与成年人更为自如。类似地,一款名为 Milo 的人工智能机器人已经在美国 50 多所学校推广,鼓励 ASD 儿童更加愿意面对面互动,在某些情况下,甚至允许与机器人进行身体接触,这是大多数 ASD 患者难以想象的。虽然目前没有公认的 ASD 治疗方法,但该实验为 ASD 儿童及成人的家庭带来了希望,期待他们有一天能够自如地与人工智能软件交谈,从而提升与他人互动的信心。

智能假肢是数据科学应用的另一个领域,旨在使残疾人的生活更加便捷。对于许多截肢者或失去一个或多个肢体功能的人来说,选择非常有限,而且通常非常原始,关注基本功能而非日常可用性。然而,由赛格威发明人 Dean Kamen 领导的 Deka 研究公司,首创了一款名为“Luke”臂的假肢(以致敬卢克·天行者命名)。这一技术的独特之处在于它更接近于人手内部的工作原理,机械等效的肌腱、肌肉和骨骼使用户具有更自然的运动范围,比过去 20 年更常见的钩子和爪子要接近人类手臂。该臂可以通过多种方式控制:通过附着在臂基部的微小神经末梢,或通过佩戴者鞋中的控制器。该项目获得了美国陆军研究办公室的显著资金支持,但大规模生产的假肢仍可能极为昂贵,有些估算约在 50,000 美元左右。尽管这可能不是每个需要假肢的人都能接受的答案,但这里展示的运动范围和技术复杂性为未来的类似技术带来了光明前景,届时可能会以更低的成本提供,并具有更多用途。

由世界上最著名的科学家之一斯蒂芬·霍金教授带到显著位置的技术——电子增强和替代通信系统(AAC)已成为那些由于运动神经元病或脑瘫等疾病而无法说话的人的生活中不可或缺的一部分。在这个市场上的最新创新之一,仍然与霍金自 1986 年起使用的‘Equaliser’设备紧密相关的是 DynaVox EyeMax。该设备利用计算机视觉技术,通过前置摄像头跟踪用户眼睛在命令屏幕上的运动,甚至可以编程使用特定的语调以防止言语被误解。它有潜力利用自然语言处理为许多失去语言能力的人提供发言功能,但该技术也有一些限制;每个设备必须为各自的用户单独编程,包括兴趣地点、朋友和家人的名字及其他独特信息,并且设备的费用通常不被健康保险覆盖。然而,预计未来将深度学习技术融入设备中应能减少编程所需的时间,这可能会使设备的成本降至更实惠的水平。

不仅仅是专业医疗公司认识到利用数据科学技术改善残疾人生活的财务和慈善价值。谷歌最近宣布,他们希望提升其智能手机和其他设备的可访问性,以帮助那些视力、听力或灵活性受限的用户。一个令人兴奋且独特的发展是为谷歌智能手机设计的盲文系统,它允许用户通过蓝牙将盲文设备连接到手机上。此外,Android 系统现在可以通过类似于斯蒂芬·霍金在轮椅上使用的‘开关’来控制。根据谷歌的说法,这为以前无法访问这些技术的新用户群体打开了大门,并允许用户使用与朋友相同的硬件,而不是使用定制的、可能不那么吸引人的设备。这些发展具有巨大的财务激励,因为 Switch Access 和 BrailleBack 都可以免费从 Android 上下载,这意味着与许多为残疾群体设计的技术不同,价格不再是障碍。总体而言,谷歌的贡献为其他技术公司树立了一个基准,促使他们跟随其在为残疾人士生产负担得起且易于使用的平台方面的领导,我们期待看到下一步是谁。

最后,有些东西目前确实更处于“概念验证”阶段,但对未来展现了巨大的潜力。2011 年,来自维吉尼亚理工大学 RoMeLa 机器人与机制实验室的 Dennis Hong 博士首创了一款设计用于让盲人或视力部分受损的人能够独立驾驶的汽车。该系统结合了能够学习预定路线并感知障碍物和行人的机器学习软件,以及一系列集成在压力垫手套中的传感器,能够告诉驾驶员他们应该去哪里,以及是否有需要避免的障碍物。在同年 TED 演讲中,Hong 博士展示了这款汽车,一名盲人在 Daytona Speedway 安全地完成了整个预定路线的驾驶。必须指出的是,有几个原因导致该系统无法立即实施,最少的是需要将路线精确输入到汽车的计算机中,以便传感器能够指导驾驶员,而这对每条道路来说并不现实。然而,它在数据科学和机器学习领域显示了巨大的进展,对盲人和部分视力受损群体来说是一个巨大的飞跃。

在将数据科学与残疾之间的关系标记为成功之前,必须解决几个问题。首先,当前出现的技术创新是否足够先进,可以现在就为那些有残疾的人带来益处,还是实际的突破可能要在 5 到 10 年后才会到来?同样,这些选项在经济上是否都是可行的,不是对生产者而言,而是对消费者而言,后者可能因收入有限而收入有限?此外,数据科学提供的创新是否仅限于让残疾人士的生活更轻松,还是例如,深度学习是否有可能被用来识别导致某些残疾的基因,从而给医生提供研究和限制这些基因的机会?

数据科学的未来看起来非常光明,因为几项创新已经在全球范围内对残疾人士的生活产生了显著的影响。下一步,无论是进入遗传学研究、深度学习集成还是其他领域,都取决于许多主要公司是否会超越财务报表,转而致力于改善全球数百万残疾人士的生活。希望不必等到下一届奥运会才会实现这一点。

原文。

相关内容:

-

埃博拉分析与数据科学教训

-

数据科学如何预测并减少不良出生结果

-

数据科学如何抗击疾病

更多相关内容

数据科学是否是一个即将消亡的职业?

图片由cottonbro studio提供

介绍

我们的前三大课程推荐

1. Google Cybersecurity Certificate - 快速进入网络安全职业的捷径。

1. Google Cybersecurity Certificate - 快速进入网络安全职业的捷径。

2. Google Data Analytics Professional Certificate - 提升你的数据分析技能

2. Google Data Analytics Professional Certificate - 提升你的数据分析技能

3. Google IT Support Professional Certificate - 支持你的组织的 IT 需求

3. Google IT Support Professional Certificate - 支持你的组织的 IT 需求

我最近阅读了一篇文章,描述了数据科学作为一个过度饱和的领域。文章预测,机器学习工程师将在未来几年取代数据科学家。

根据这篇文章的作者,大多数公司用数据科学来解决非常类似的业务问题。因此,数据科学家不再需要提出解决问题的新方法。

作者接着说,解决大多数数据驱动组织中的问题只需要基本的数据科学技能。这一角色很容易被一个机器学习工程师取代——一个具备基本数据科学算法知识的人员,同时还拥有部署机器学习模型的知识。

我在过去一年里阅读了许多类似的文章。

一些人表示,数据科学家的角色将被如 AutoML 之类的工具取代,而另一些人则将数据科学称为一个“即将消亡的领域”,将很快被数据工程和机器学习操作等角色取代。

作为与数据行业不同领域紧密合作的人,我希望就这个话题提供我的意见,并回答以下问题:

-

数据科学是否是一个即将消亡的职业,未来几年是否还会有需求?

-

自动化工具是否会使数据科学家失业?

-

数据科学是否已经过度饱和,未来是否会被新的角色取代?

-

数据科学家对组织来说是否有价值?他们如何为企业创造价值?

数据科学家是否还需要?

大多数组织中的数据科学工作流程非常相似。许多公司雇佣数据科学家来解决类似的业务问题。大多数建立的模型不要求你提出新颖的解决方案。

你在这些组织中解决数据驱动问题时采用的大多数方法可能已经被使用过,你可以从网上丰富的资源中借鉴灵感。

此外,像 AutoML 和 DataRobot 这样的自动化工具的兴起使得预测建模变得更加容易。

我在一些商业用例中使用 DataRobot,它是一个很棒的工具。它会遍历许多值,并为你的模型选择最佳参数,以确保你获得最准确的模型。

如果预测建模随着时间的推移变得更简单,那么为什么公司仍然需要数据科学家呢?为什么不使用自动化工具和机器学习工程师的组合来管理整个数据科学工作流程呢?

答案很简单:

首先,数据科学从来不是关于重新发明轮子或构建高度复杂的算法。

数据科学家的角色是通过数据为组织增值。在大多数公司中,这仅涉及构建机器学习算法的极小一部分。

其次,总会有一些问题是自动化工具无法解决的。这些工具有一套固定的算法供你选择,如果你发现一个需要多种方法组合来解决的问题,你将需要手动解决。

尽管这种情况并不常见,但仍然会发生——作为一个组织,你需要雇用足够熟练的人来处理这些问题。此外,像 DataRobot 这样的工具不能进行数据预处理或模型构建前的繁重工作。

人情味

作为一个曾为初创公司和大型公司创建数据驱动解决方案的人,情况与处理 Kaggle 数据集的体验非常不同。

没有固定的问题。通常,你会有一个数据集,并且会给你一个商业问题。你需要找出如何利用客户数据来最大化公司的销售额。

这意味着数据科学家所需的不仅仅是技术或建模技能。你需要将数据与当前的问题联系起来。你需要决定哪些外部数据源可以优化你的解决方案。

数据预处理既漫长又繁琐,这不仅因为它需要强大的编程技能,还因为你需要对不同的变量及其与当前问题的相关性进行实验。

你需要将模型的准确性与诸如转化率这样的指标联系起来。

模型构建并不总是这个过程的一部分。有时,简单的计算可能足以完成像客户排名这样的任务。只有某些问题需要你实际进行预测。

最终,数据科学家为组织提供的价值在于他们将数据应用于现实世界的用例的能力。无论是构建分割模型、推荐系统,还是评估客户潜力,除非结果是可解释的,否则对组织没有实际的好处。

只要数据科学家能够借助数据解决问题,并弥合技术与商业技能之间的差距,这一角色就会继续存在。

Natassha Selvaraj 是一位自学成才的数据科学家,对写作充满热情。您可以通过 LinkedIn 与她联系。

了解更多相关主题

时尚中的数据科学

评论

评论

作者 Preet Gandhi,纽约大学数据科学中心

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

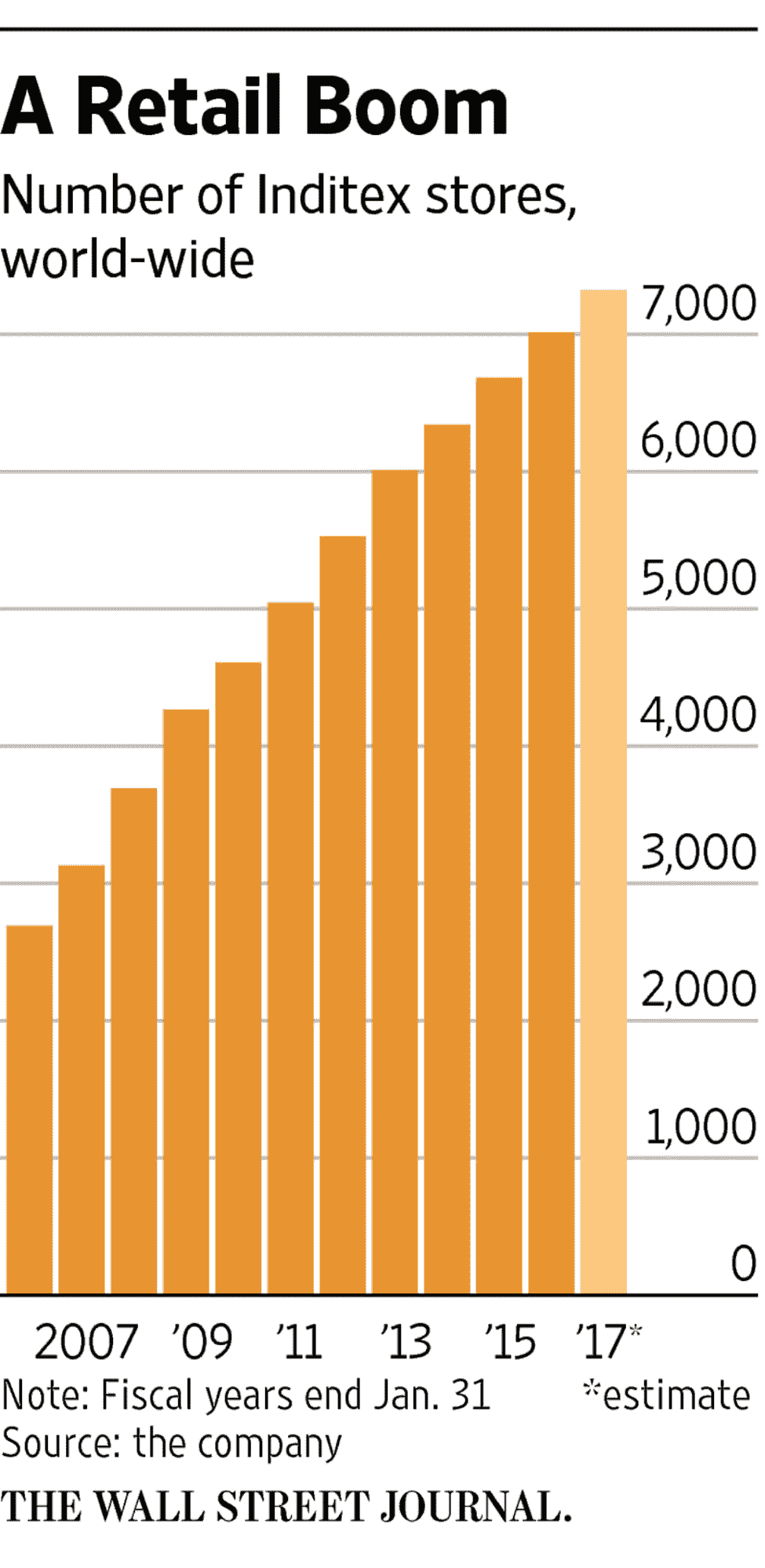

背景

你小时候常去的多少家商店现在已经不复存在了?还记得 Sears、Zellers、American Apparel、Wet Seal、The Limited 等吗?许多其他知名零售商如 Aeropostale、Bebe、A&F、Guess、J.C Penney、Payless、Rue2 等也在全国范围内关闭了数百家门店,以应对销售下滑。福布斯估计,在 2017 年最后一个季度,21 家零售商关闭了 3,591 家门店。它们无法与电商部门竞争,因为越来越多的消费者选择在家舒适地在线购物,而不是亲自去零售店。零售商被迫利用数据来升级其基础设施和服务,以为客户提供更好的体验。许多 Macy’s、Coach、Kate Spade、Nordstrom 等公司的招聘信息显示了零售和时尚巨头在面对竞争时的严重性和迫切性。

介绍

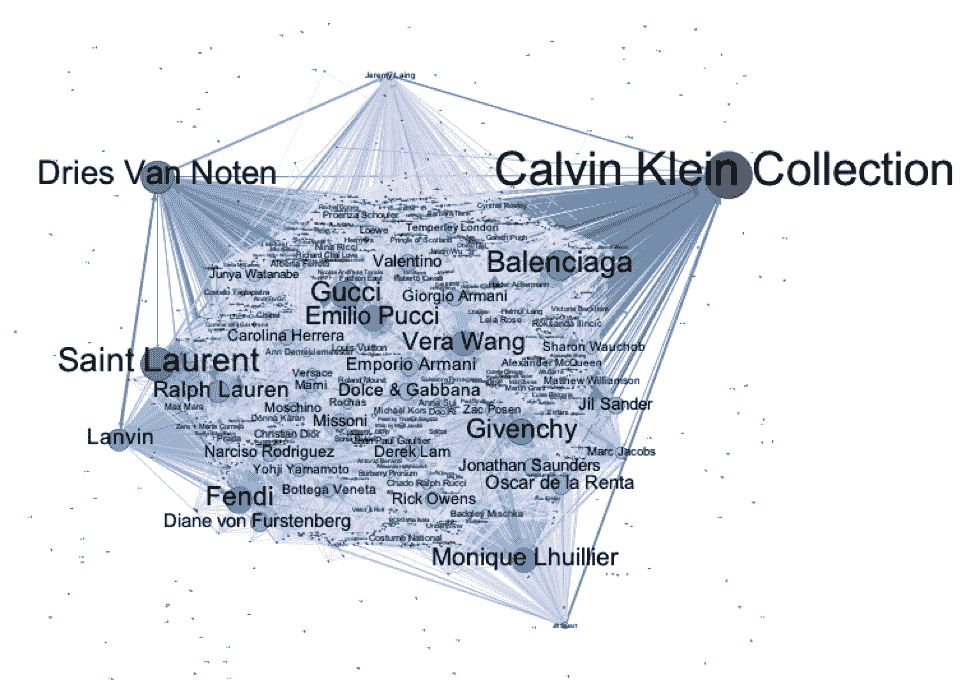

时尚行业是一个竞争激烈且动态变化的市场。趋势和风格瞬息万变。一季的系列或趋势需要来自最具创意的头脑的数千个工时,而最终的成功取决于时尚专家、博客作者和名人的简单“热”或“冷”判断。数据科学可以在历史数据上进行应用,以预测哪些趋势会变得“火爆”,从而潜在地节省大量时间和金钱。例如,利用以往销售数据训练良好的模型,可以帮助我们预测 Kanye West 的新 Yeezy 第 6 季系列是否会成功。数据科学家可以使用预测算法、视觉搜索、从照片中捕捉结构化数据、自然语言处理等概念。

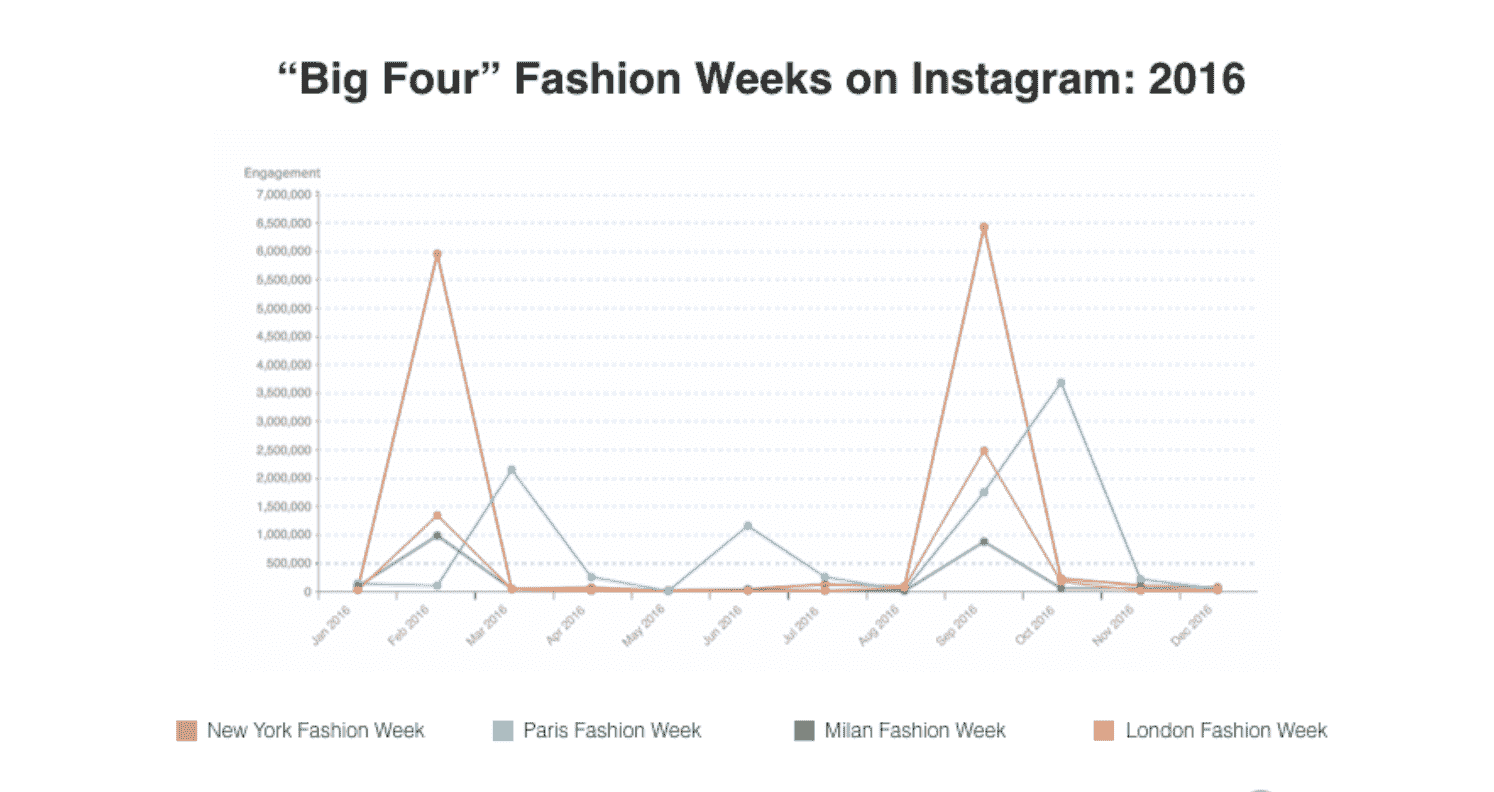

数据来源

时尚和零售行业的数据非常丰富。来自零售商和百货商店关于顾客消费习惯的大量历史数据是传统来源。随着社交媒体的出现,帖子互动、Instagram 趋势、Twitter 标签、最受欢迎的时尚博主的穿衣风格、名人时尚风格、流行名人的“点赞/反应”等,提供了丰富的见解数据。在发布系列之前测试反应的一种新技术是将照片发布在社交媒体(Facebook、Twitter、Instagram、Pinterest)上,并研究评论,以便在推出之前对系列进行修改。这里使用情感分析来获取公众意见的见解。这些网站的公开 API 是开放和易于使用的。数据可以通过这些 API 实时抓取并转换为可用的形式。在线数据源是原始的和未审查的,反映了公众意见。如果正确利用,这些数据具有很大的潜力。你在网上找到的大多数数据都是非结构化的:文本、图像、音频和 YouTube 视频。非结构化数据在原始形式下可能具有挑战性,需要清理和转换。

时尚和零售行业的数据非常丰富。来自零售商和百货商店关于顾客消费习惯的大量历史数据是传统来源。随着社交媒体的出现,帖子互动、Instagram 趋势、Twitter 标签、最受欢迎的时尚博主的穿衣风格、名人时尚风格、流行名人的“点赞/反应”等,提供了丰富的见解数据。在发布系列之前测试反应的一种新技术是将照片发布在社交媒体(Facebook、Twitter、Instagram、Pinterest)上,并研究评论,以便在推出之前对系列进行修改。这里使用情感分析来获取公众意见的见解。这些网站的公开 API 是开放和易于使用的。数据可以通过这些 API 实时抓取并转换为可用的形式。在线数据源是原始的和未审查的,反映了公众意见。如果正确利用,这些数据具有很大的潜力。你在网上找到的大多数数据都是非结构化的:文本、图像、音频和 YouTube 视频。非结构化数据在原始形式下可能具有挑战性,需要清理和转换。

一个有趣的数据来源是顾客在商店内的 wifi 信号。跟踪顾客的行为模式,以查看他们停留的时间、顺序访问的区域、回访的频率以及在每个区域停留的时间。这种数据可以用于安排商店内的系列,并将经常一起购买的商品放置在一起。

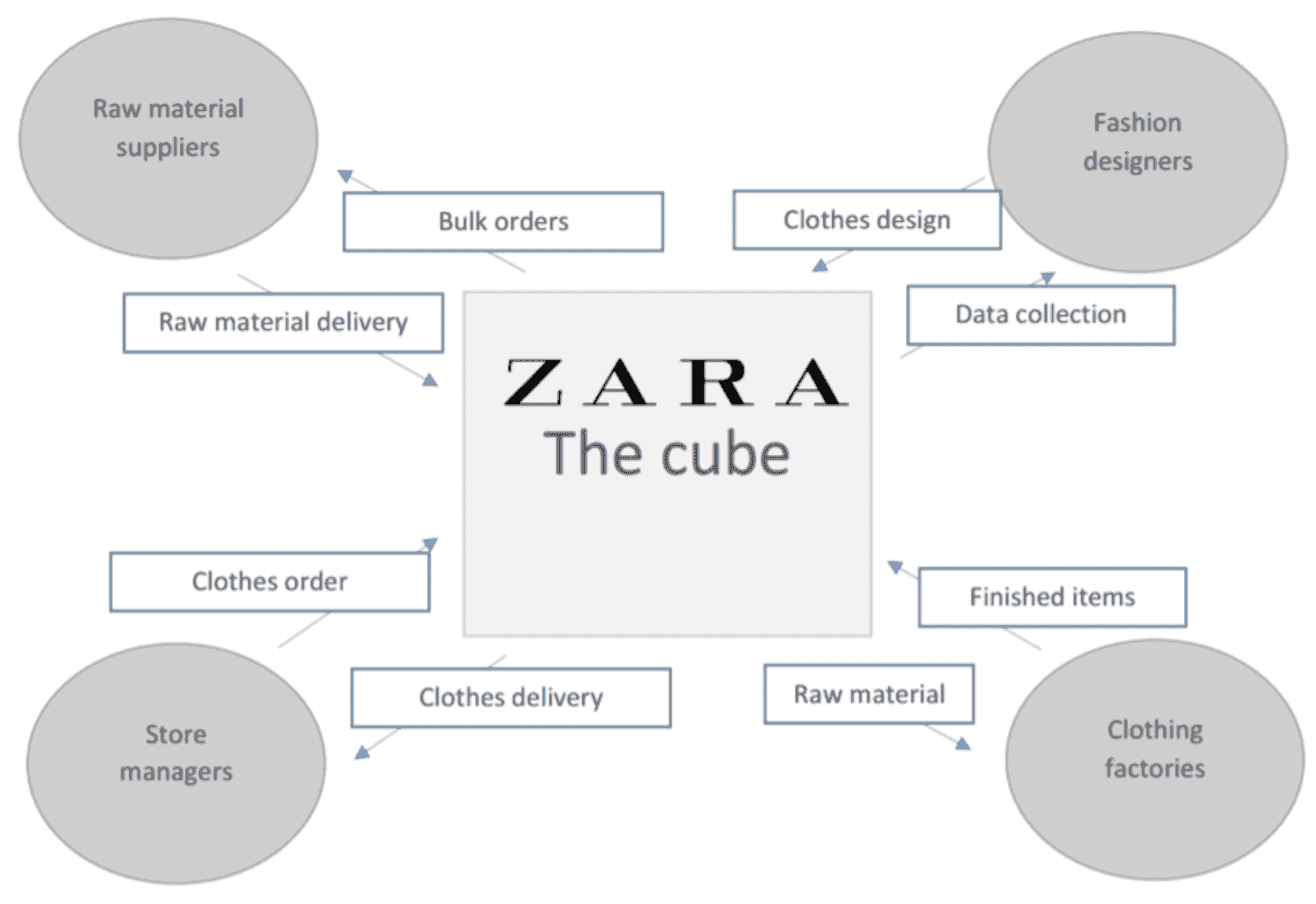

例如:Zara

Zara 是时尚界最受欢迎和成功的商店之一。他们采用了“快时尚”的概念,即从设计一个系列到将其运送到商店的整个过程最多需要三周。这个品牌的成功归功于这一动态概念,其中零售商研究顾客的选择和偏好,以创建迎合他们口味的系列。他们创造顾客渴望的产品,而不是销售他们设计的产品。顾客自己可能不知道他们具体在寻找什么,但 Zara 的聪明商业分析师和数据科学家利用数据来创建一个系列,使顾客会自动喜欢,因为这正是他们的“口味”。此外,Zara 在全球范围内都有商店,顾客的不同人口统计特征意味着像尺寸、体型、颜色偏好和数量等简单因素会有很大差异。生产适量的正确产品有助于减少浪费。

关键问题领域

1. 颜色选项

通过大数据,我们可以找到顾客偏好的颜色,以策划畅销系列。特定风格的颜色范围、颜色组合等可以从销售数据和在线零售数据中挖掘出来。许多时候,顾客会购买一件衣服的某种颜色,然后换成另一种颜色。退换货的数据可以用来生产更多的受欢迎颜色的商品。

2. 男装还是女装?

每个设计师的目标受众或性别不同,以增加他们的知名度或销售量。设计师需要决定每个系列中的商品数量及所需的多样性。他们有一套固定的资源,如预算和展示空间,并需要数据支持的指导方针来决定每个类别分配多少。这在许多商店如 Forever21、H&M 等很常见,通常看到女性商品占据两三层空间,而男性商品仅占一层。这些零售商知道要为特定客户类别提供更多选项以增加销售。这些见解来源于历史销售数据。

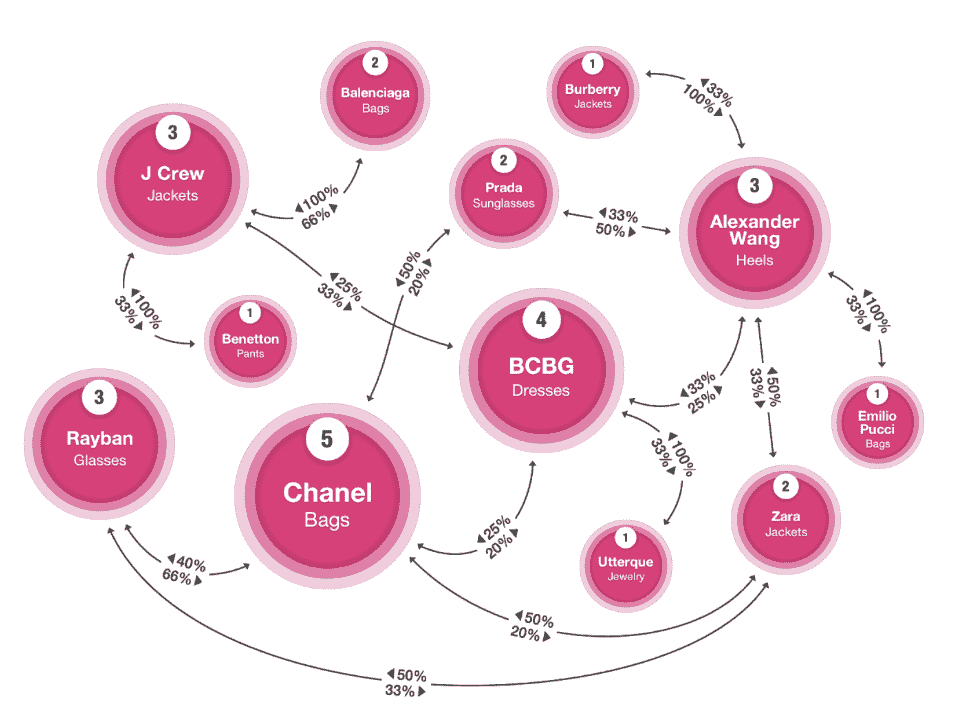

3. 将时装秀风格转变为零售商品

很多在时装秀上展示的风格在现实生活中并不“适穿”。时装秀上的趋势往往被夸张,过于奢华,不适合零售。服装需要经过修改才能在商店中销售。训练算法以建议哪些特征如颜色、面料、剪裁、长度、组合等需要更改,可以确保产品在上架时销售良好。此外,每个国家/地区的口味不同。因此,每个产品必须根据当地偏好进行调整。

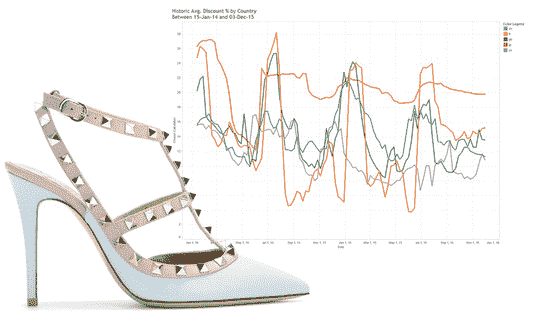

4. 服装价格

对于每件服装,设计师需要了解顾客愿意为其支付的价格,考虑到质量、风格、受欢迎程度和品牌价值。大数据应被用于平均之前的销售数据,以生成建议价格。竞争品牌的数据也可以用于设定价格,使其既不太高,又能带来良好的收入。

5. 揭示新的产品类别

品牌需要寻找市场上成功的新产品以及那些盈利潜力不大的产品。设计师需要考虑制作独特新产品是否会被顾客接受或拒绝。例如,创意鲜艳的印花可能适合瑜伽裤,但可能被认为对运动鞋过于花哨。大数据可以用于决定进入哪个类别以及是否继续销售某个特定的旧产品。

6. 店铺安排

顾客在购物时会表现出特定的行为,这些行为可以被研究以便将商品安排在一种增加大多数商品销售机会的方式中。关联数据挖掘可以帮助我们决定将产品如何分组,以便顾客可能会挑选到大多数商品。你可能已经注意到,在许多服装店中,配饰通常被放置在我们站在结账区域附近的位置,这会促使顾客购买这些配饰。Wi-Fi 数据可以用来跟踪顾客在商店中的移动,从而以最佳方式安排库存。

结论

毋庸置疑,我们可以说数据驱动的决策将在竞争激烈的时尚世界中为你提供优势。在创建任何产品之前,需要参考数据以查看其经济可行性和前景。选择性地使用你的数据来创建和转换你未来的顾客肯定会购买的产品线,将有助于零售商在电子商务的浪潮中生存下来。有些人可能会说,AI 可能会使创意变得单调,因为它只是创造顾客想要的东西。但这就是为什么结果应该仅用来补充人类的创造性洞察,而不是完全替代它。不过,在正确的时间以正确的价格创造正确的产品也无伤大雅。

简历: Preet Gandhi 是纽约大学数据科学中心的硕士生。她对大数据和数据科学充满热情。可以通过 pg1690@nyu.edu 联系她。

相关:

-

机器学习和机器人技术正在转变的 4 个行业

-

酒店行业的大数据分析

-

应用数据科学:解决预测性维护业务问题 第二部分

更多相关话题

数据科学在电影行业中的应用

原文:

www.kdnuggets.com/2019/07/data-science-film-industry.html

评论

评论

作者:弗兰基·沃拉斯。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

制作电影时涉及到无数因素,从确定制作成本到开发有针对性的营销活动。数据科学参与了几乎每一个步骤,数据科学领域的专业人士可以从电影行业中学到很多东西。

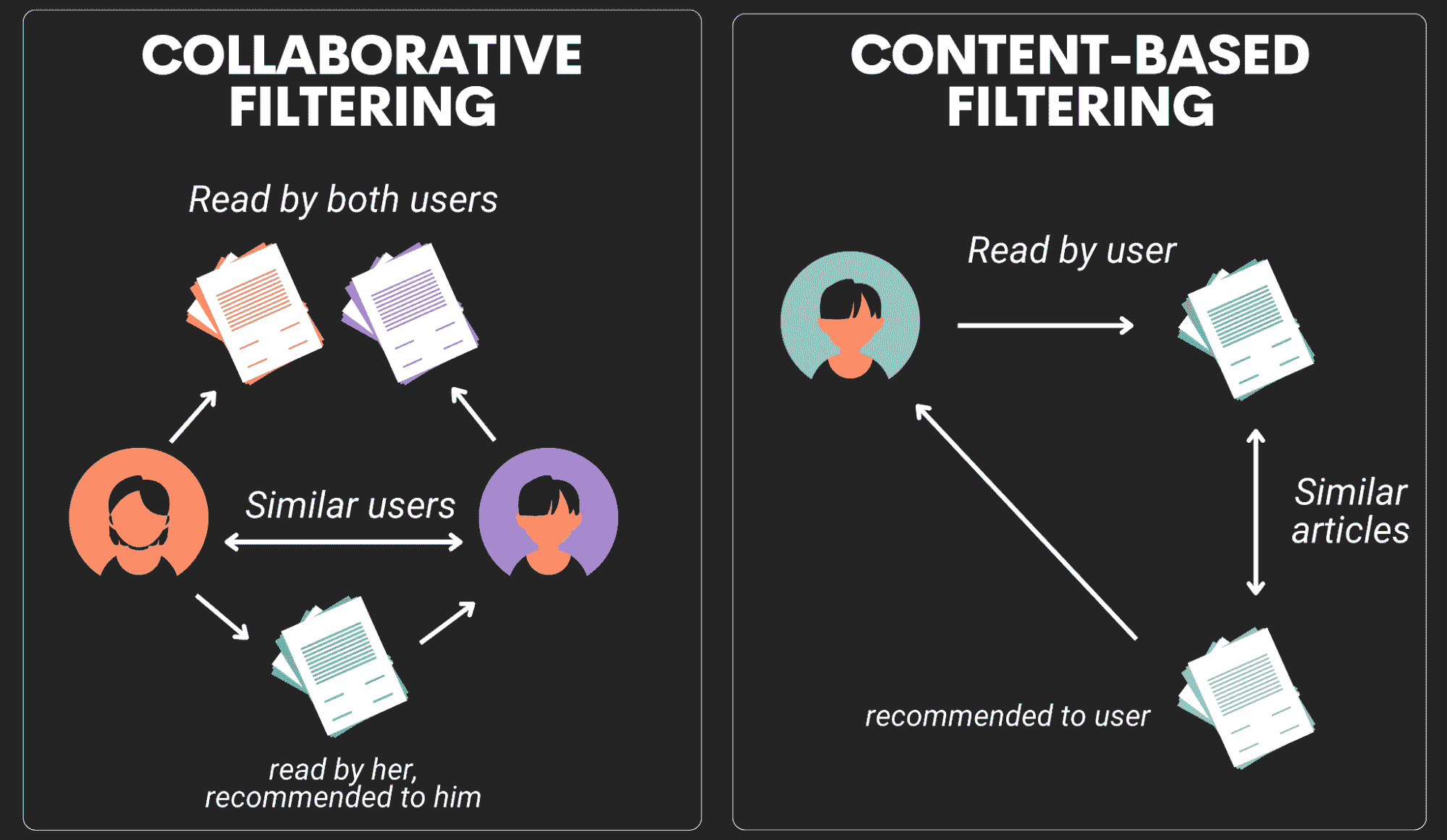

流媒体服务在数据科学革命的前沿。包括亚马逊、Hulu 和 Netflix 在内的制作公司分析大数据中的模式,以决定他们创作的内容类型,并提供个性化的观影推荐。通过这种方式,数据科学可以在前所未有的层次上帮助娱乐的制作和营销。

数据科学领域也在各种电影中作为重要主题出现。像艾伦·图灵和约翰·纳什这样的现实创新者的故事近年来被改编成主要电影,与那些使用预测分析、机器学习和人工智能作为中心情节的虚构故事并肩而立。

社会对数据科学影响的迷恋表明,关于这一主题的电影肯定会增多。此外,制作公司将继续利用这些技术更好地理解个人的观影习惯和偏好,以创作更受大众欢迎的内容。

电影成功指标与相关数据

图片来源:Pexels

技术可以告诉电影制作人他们应如何制作和营销任何一部电影。从选角决定到甚至营销中使用的颜色,电影的每一个方面都可以影响销售。利用技术,我们可以预测客户的偏好,并确定如何优化内容以达到最大的潜力。

预测观众对电影的期望几乎可以保证该电影的成功。在 2018 年,被华特迪士尼公司收购的 20 世纪福克斯公司发布了一篇论文,概述了如何使用机器学习分析电影预告片的内容。在这一过程中收集的数据用于比较预告片,并预测其他可能引起观众兴趣的电影。

20 世纪福克斯使用 Google 服务器和开源 AI 框架 TensorFlow 创建了 Merlin,一个“实验性的电影观众预测和推荐系统”。在 Merlin 的试运行中,该工具分析了超级英雄金刚狼的起源故事“Logan”的预告片,以预测“Logan”观众可能感兴趣的其他电影。在预测的 20 部电影中,11 部是正确的。

实际排名前五的电影都在预测名单中:X 战警: apocalypse;约翰·威克 2;奇异博士;蝙蝠侠大战超人:正义黎明;自杀小队。一般来说,观众在寻找一部以“坚韧的男性动作主角”为特色的超级英雄电影。

尽管其数据解释并不完美,Merlin 是过去十年软件开发演变的一个典型例子。为了让程序员更好地专注于改进 AI 算法,未来的软件开发必须包括旨在减少重复任务所花费时间的节省措施。由于 AI 设计用于专注于单一任务,它是提高程序数据分析准确性的理想起点。

大数据在分析中的作用

当大数据首次出现于 2010 年左右时,它有效地改变了将数据分析转化为有用洞察和利润的方法。大数据通常来源于外部,利用从互联网、公共数据源等收集的信息来做出更准确的预测。在娱乐行业中,大数据可以用于提供个性化的用户体验,并减少流媒体网站观众的流失率。

在用户可以选择的电影和电视节目种类繁多的情况下,留住观众对流媒体服务和电影制作公司至关重要。高流失率表明公司做错了什么,结合机器学习,大数据可以帮助公司识别问题领域。

在流媒体服务中,用户界面在观众留存中发挥着重要作用。例如,如果观众推荐不准确,可能会导致观众转向其他平台寻求娱乐。流媒体服务非常清楚积极用户体验的重要性。

为了保持观众的参与度,Netflix 开发并持续改进其自适应流媒体算法以优化流媒体质量并创造个性化用户体验。流媒体巨头会调整媒体的音频和视觉质量,以优化体验。他们还使用预测缓存,以便视频播放得更快或质量更高。例如,如果观众在观看一部系列剧,下一集将会被部分缓存。

与此同时,推荐系统基于显性和隐性信息。“显性数据是你字面上告诉我们的:你对《王冠》点赞,我们就知道了,”Netflix 产品创新副总裁 Todd Yellin 告诉 Wired。 “隐性数据实际上是行为数据。你没有明确告诉我们‘我喜欢《不可破的金米·施密特》’,你只是 binge 观看了它并在两个晚上内看完了,所以我们从行为上理解这一点。大多数有用的数据是隐性的。”

如果利润有所显示,Netflix 的算法无疑是成功的:自 2015 年以来,Netflix 的利润增长了超过 30%,年收入达到 166.14 亿美元。

电影行业中的预测分析

图片来源: Pexels

Merlin 和类似程序对预测分析的影响范围广泛,但需要更大范围的数据才能找到准确的模式。在过去几十年里,研究人员收集了数千部电影和电视节目的数据,以寻找可行的预测指标。在许多类别中发现了相关性,包括角色类型、情节复杂性、明星效应、预算和“buzz”,即围绕某部电影的社交讨论和市场推广。

Buzz 的显著特点在于,可以从许多来源获得有关这种现象的信息,例如社交媒体和评论。然而,围绕一部影片的 buzz 只是整体分析图景中的一小部分。数据分析必须在电影的每个生命周期阶段中使用,从开发到后期制作和发行。

预测分析可以帮助生产者、制作公司和高管做出战略决策、预测趋势,并更好地理解观众习惯。知情决策对电影制作过程至关重要,而获取高质量、高可用性的数据是客户保留和利润的关键s。数据科学家应注意电影行业利用预测分析和大数据的各种方式,并将这些知识带到其他行业和商业环境中。

个人简介: 弗兰基·华莱士是一位来自西北地区的自由撰稿人,他为多种在线博客撰稿。华莱士目前居住在爱达荷州的博伊西,是蒙大拿大学的应届毕业生。

相关:

更多相关话题

数据科学如何推动欺诈预防

原文:

www.kdnuggets.com/2022/09/data-science-fuels-fraud-prevention.html

图片由 Tima Miroshnichenko 提供

就像一个俄克拉荷马州的超级农场主被一个水力压裂公司接触一样,大多数电子商务公司并不知道他们所坐拥的潜在价值有多大。在这种情况下,我们谈论的不是自然资源,而是数据。数据挖掘被誉为新的石油热潮已经有 15 年了,但提炼原始数据的方法仍在不断探索中,我们可以用它来推动的机制也在不断发现中。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 加入网络安全职业的快车道

1. 谷歌网络安全证书 - 加入网络安全职业的快车道

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

许多电子商务公司熟悉利用他们从访问流量中收集的数据来进行客户细分和定向营销等功能。当然,这些都是利润收益清单上的首要想法,但产生令人印象深刻的利润的一部分也包括减轻欺诈带来的损失——这是一个逐年增加的关注点。数据科学也为此提供了动力。

利用数据增强您的欺诈解决方案

无论您转向哪个安全提供商,它提供的保护层都会从数据开始。一般来说,欺诈解决方案希望查看的数据点将从任何电子商务网站想要收集的信息开始。这些信息可能在数字市场中主动提供,意味着用户在提示时选择自行提供信息。常见的例子包括在网站上注册账户或订阅新闻通讯。这通常会产生如下数据点:

-

姓名

-

电子邮件地址

-

电话号码

-

物理地址

-

出生日期

或者,用户的数据点可能是被动收集的,用户没有有意、知情的参与:

-

IP 地址和其他连接信息

-

他们与网站的互动,包括花费的时间和其他行为生物识别数据

-

用于连接网站的设备的识别信息,一个设备指纹

单独来看,这些数据点可能无法提供有关单个客户的太多洞见。然而,拥有这些信息的公司能够较好地了解其访问者的合法性。欺诈软件可以利用这些数据点进行丰富化,将相对匿名的数据框架转变为完整的数字档案。

丰富你的欺诈打击能力

几乎所有使用身份验证来减少损失的欺诈解决方案都会大量依赖数据丰富化——即利用已知的数据点来扩展到相关的、更有用的数据点。通过这种方法,单一的(虽然重要)信息,如电话号码,可能会变成社交媒体上的帖子、照片以及朋友和家人。这些扩展的数据可以通过多种方式收集:

-

封闭源数据,或用户在注册或入职过程中自己提交的个人识别信息,这些信息无法在开放互联网的其他地方找到。

-

专有数据库中的聚合用户数据是另一种封闭源数据。许多欺诈预防解决方案利用庞大的数据库来交叉验证进入的流量。这些数据库可能包括历史上的良好或不良用户、欺诈交易行为、声誉数据,甚至信用历史,一些公司使用的专有数据库中数据参考点可能达到数十亿。

-

OSINT 数据,即开放源智能,是可以从公开可访问的来源中收集的数据集合,如与电子邮件或电话号码相关联的账户和注册信息、社交媒体上的图片和帖子、传统新闻来源、公共记录如结婚或逮捕、地理位置数据等。

在初步收集的数据点经过这种丰富化处理后,欺诈软件现在拥有一个更易于评估、更具决定性的用户档案。在审查档案时,会根据发现情况给每个用户分配一个欺诈评分。例如,通过 VPN 连接等潜在的欺诈指标会增加评分。一旦达到预定义的阈值,大多数解决方案提供自动阻止用户进程或将案件提升到人工处理的功能。

定义公司风险容忍度阈值是执行主动反欺诈计划的一部分——最有效的一种。就像你地板下的欺诈者一样,关于自己公司的数据越多,安全性就可以越高。设定明确的目标——例如,阻止 ATO 攻击——至关重要,清理你的数据并相应地标记它也同样重要。清理数据是关键。

在防止欺诈方面,这种数据准备对于支持几乎所有欺诈解决方案 AI 的机器学习算法至关重要。这些算法,无论依赖于什么模型,需要训练以为特定公司生成准确的结果。训练教会软件识别系统中欺诈者和良好客户之间的微妙差异,逐渐提高准确性,识别什么是合格的,什么是可疑的异常值。如果没有训练,信任机器学习算法自主运行是一项风险决定,但经过良好训练的算法可能只需很少的人工监督,从而释放资源。

数据驱动的欺诈调查示例

一个用户来到你的电子商务平台,注册一个新账户,并开始他们的购物之旅。他们的用户数据看起来合法,因为他们填写了注册表单的每个部分,包括有效的电话号、电子邮件地址、姓名和位置。

然后你的欺诈软件介入,以防万一。通过对与提供的凭证相关的 OSINT 数据进行查找,程序注意到这个用户的电子邮件地址似乎是新的,而且他们的电话号码没有与任何社交网络关联——在 2022 年非常不寻常。虽然这个用户可能只是对社交媒体漠不关心,但大多数欺诈系统可以定制以标记这样一个异常用户为潜在可疑对象,并在其旅程被升级到人工审查时暂停处理。

专门的欺诈团队中的人工审查员介入,仔细查看此用户。最初,审查员倾向于将此用户标记为欺诈的假阳性,尽管他们的数字存在感很小。尽管仍有些犹豫,他们决定放大视角,查看软件报告的数据趋势分析。这一分析讲述了不同的故事。

该软件自动从汇总数据中提取洞察,注意到该用户的设备指纹与 70 个其他用户几乎相同。此外,通过运行速度检查,程序显示所有这些用户在网站上停留的时间相似,并且所有用户都在过去 72 小时内访问过该网站。此外,对所有这些账户的IP 分析显示,其位置与注册时声称的地址非常不同,并且许多这些 IP 来源于之前被标记为可疑的数据中心代理。

欣慰的是,他们没有简单地给这个用户绿灯,欺诈团队成员阻止了所有具有相同资料的交易。他们设置了一个自定义规则以检测匹配该资料的未来连接,然后享受了一顿因充实而令人愉快的午餐。

关键要点

首先,任何电子商务业务最大的收获应该是,针对进站流量的欺诈预防解决方案对遏制系统内的欺诈是至关重要的。欺诈技术越来越复杂,根据 UK Finance 的数据,仅去年英国就因欺诈损失了£24 亿。

第二个关键点是要意识到,任何欺诈解决方案在获得模型的最佳数据时将最为有效。虽然提供一个低摩擦、低流失的购物体验对于每个电子商务部门都很重要,但这种体验必须与公司对欺诈损失的承受能力相衡量。通过要求额外的身份信息给客户旅程增加一点摩擦,不应导致巨大的投资回报率下降。此外,这可能会对你的客户群体提供更有洞察力的视角,正如前面讨论的那样,这些视角是驱动你欺诈缓解和希望中的利润的燃料。

Gergő Varga 自 2009 年以来一直在各种公司打击在线欺诈——甚至共同创办了自己的反欺诈初创公司。他是《Dummies 欺诈预防指南——SEON 特别版》的作者。他目前在 SEON 担任内容宣传员,利用他的行业知识保持市场营销的敏锐,协调不同部门以了解欺诈检测的前线情况。他住在匈牙利布达佩斯,是哲学和历史的狂热读者。

更多相关话题

数据科学游戏 – 学生竞赛

数据科学竞赛,一项学生竞赛。

每年,协会组织一场国际数据科学挑战赛,以促进学生在这一领域的技能。挑战赛分为两个阶段,团队由四名学生组成,其中最多允许一名博士生。挑战的第一步是在线进行的,提供排名。这个排名基于不同团队对问题解决方案的表现,前 20 名团队可以参加挑战赛的第二阶段。同一所大学的两个团队不能被选中进入最终阶段。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升您的数据分析水平

2. 谷歌数据分析专业证书 - 提升您的数据分析水平

3. 谷歌 IT 支持专业证书 - 支持您组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持您组织的 IT 工作

20 支入选的团队将在一个周末内处理由数据科学竞赛合作伙伴提供的数据,并在专业人士和数据科学专家面前展示他们的结果。颁奖典礼在合作伙伴的见证下结束挑战。

团队

我们的团队主要由数据科学家和来自巴黎萨克雷大学的学生组成。

重要信息

任何完成硕士或博士学位的学生都可以参加。我们邀请您查看条款和条件以获取更多细节。挑战赛将分为两个不同的阶段:

-

在线阶段在 Kaggle 上进行:任何团队(由 4 名学生组成)都可以申请。这个第一阶段将是有选择性的,将在 6 月举行。

-

最终阶段在巴黎举行,特别是在 Cap Gemini 的 Château Les Fontaines。第一阶段的前 20 名团队(每所大学 1 支团队:如果同一所大学有多支团队进入前 20 名,则仅选择最佳的团队)将在九月的整个周末进行竞争。

由学术研究人员和“Platine”成员代表组成的评审团将为最佳和最具创新性的工作颁发额外奖项。

下一位会是谁?

2015 年 6 月,20 支团队在整个周末竞争,挑战由谷歌·凯捷提供,地点为豪华的尚特勒·莱·丰丹。问题是预测 Youtube 视频标签。来自 5 个不同国家的 5 支团队因最佳成绩获得了我们的高级合作伙伴奖励。

| 大学 | 国家 | 2015 年数据科学排名 |

|---|---|---|

| 莫斯科国立大学 | 俄罗斯 | 1 |

| 拉萨比恩扎大学 | 意大利 | 2 |

| 巴黎高科电信学院 | 法国 | 3 |

| 阿姆斯特丹大学 | 荷兰 | 4 |

| 伦敦帝国学院 | 英国 | 5 |

相关:

-

在 Kaggle 数据科学竞赛中成功的 10 个步骤

-

KDD 杯竞赛的现状与未来

-

如何在不阅读数据的情况下主导数据科学竞赛

了解更多主题

数据科学历史与概述

原文:

www.kdnuggets.com/2020/11/data-science-history-overview.html

评论

由朱利亚诺·利戈里,全球首席信息官及数字化转型经理。

什么是数据科学?用简单的话说?

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

“数据科学”这一术语最近才出现,专门指定一种新职业,旨在解读海量的大数据。但解读数据有着悠久的历史,科学家、统计学家、图书馆员、计算机科学家等已讨论了多年。

如今,作为一个业务领域的数据科学确实非常复杂,由于其显著的受欢迎程度,有许多对数据科学的描述,例如:

数据科学涉及分析数据并从中提取有用的知识。建立预测模型通常是数据科学家的最重要活动(格雷戈里·皮亚特斯基,KDnuggets,

www.kdnuggets.com/tag/data-science)。数据科学涉及分析大数据,以提取与可能性和误差估计的相关性(布罗迪,2015 年)。

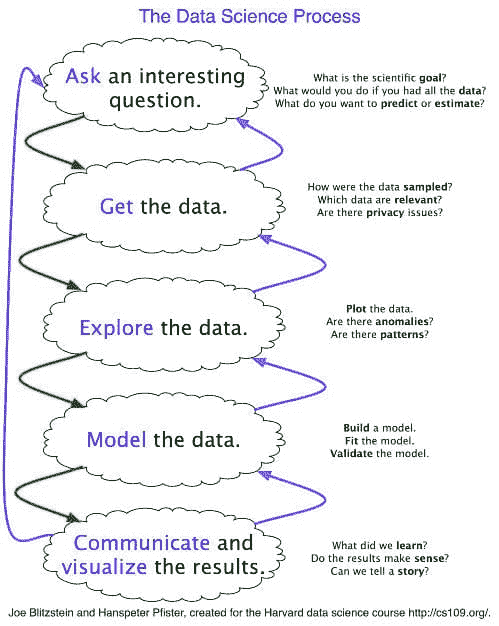

数据科学是一门新兴学科,它借鉴了统计方法和计算机科学的知识,以为各种传统学术领域提供有影响力的预测和见解(哈佛数据科学计划

datascience.harvard.edu)。

然而,用简单的话说,数据科学家只是尝试从大量数据中获取洞察,以帮助公司做出更聪明的业务决策。我们还将数据科学定义为一种通过数据推断可操作见解的方法论。

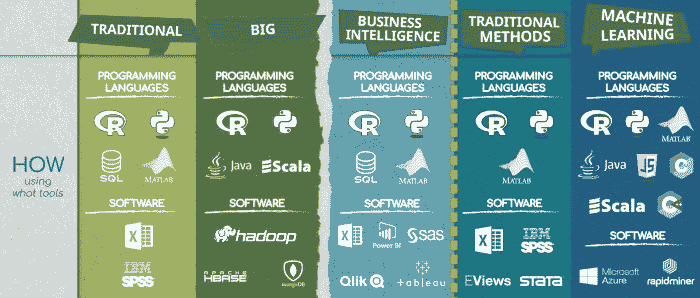

数据科学使用各种数据导向技术,包括SQL、Python、R和Hadoop等。然而,它还广泛使用统计分析、数据可视化、分布式架构等,以从数据集提取意义。通过数据科学应用提取的信息用于指导业务流程和实现组织目标。

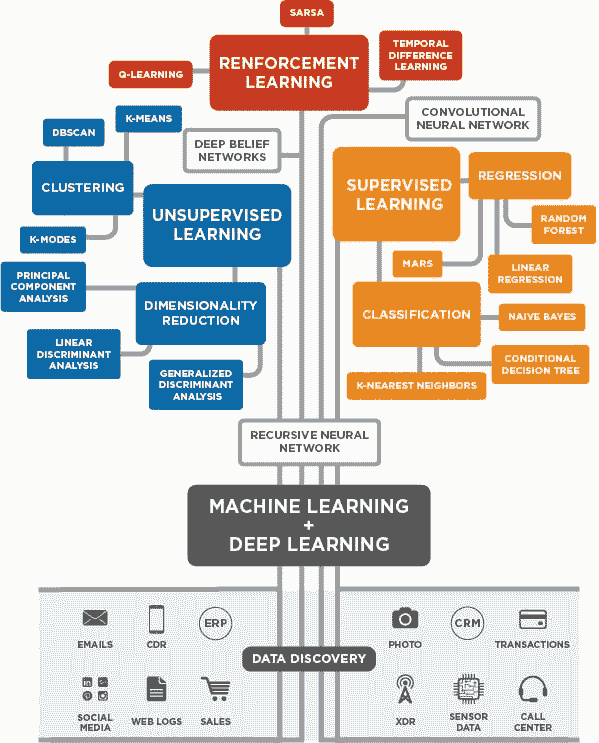

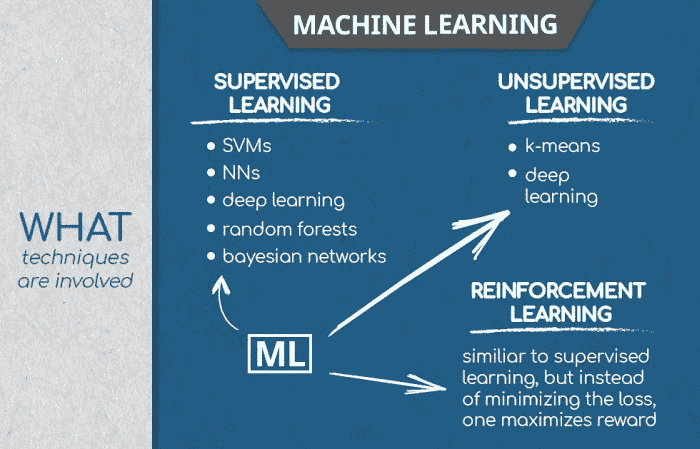

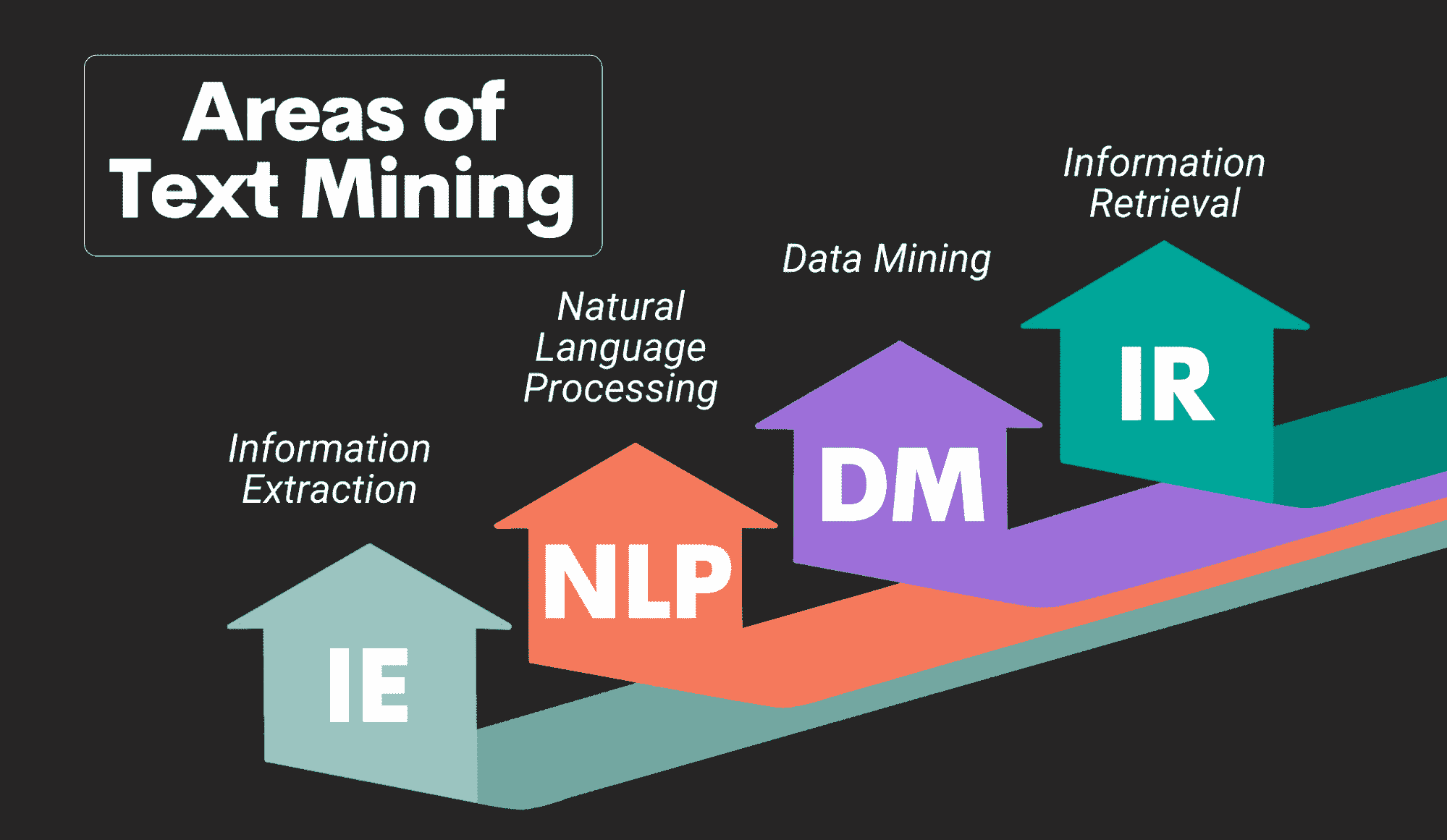

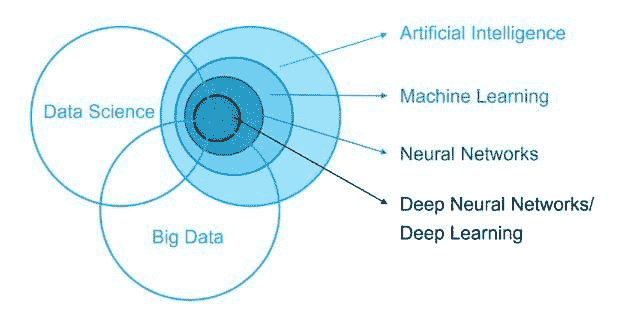

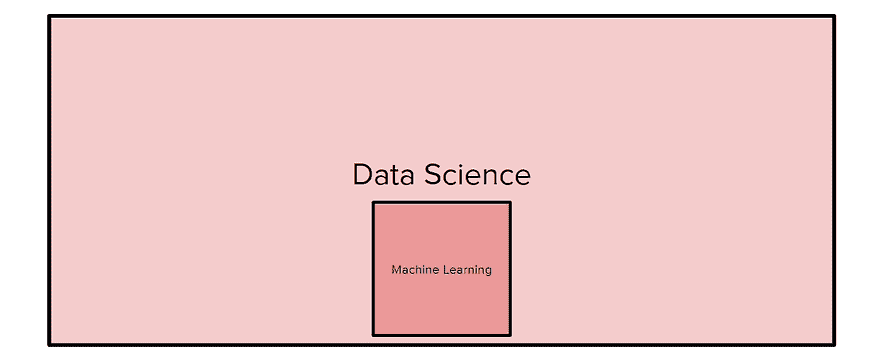

为了完成这一部分,我们还将提供数据挖掘、人工智能、机器学习和深度学习的简单定义,因为这些概念与数据科学及彼此相关。

-

数据挖掘旨在理解和发现数据中新的、以前未见的知识。

-

人工智能(AI)关注于让机器变得智能,旨在创建一个像人类一样行为的系统。

-

机器学习是人工智能的一个子集。机器学习旨在开发能够从历史数据中学习并通过经验改进系统的算法。

-

深度学习是机器学习(ML)的一个子集,在这个过程中,数据通过多个非线性变换来计算输出。

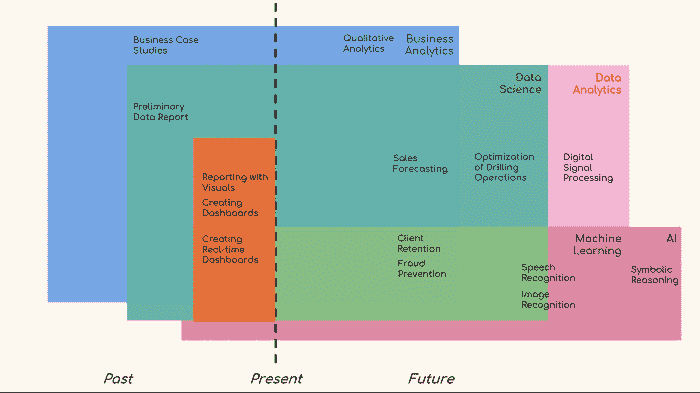

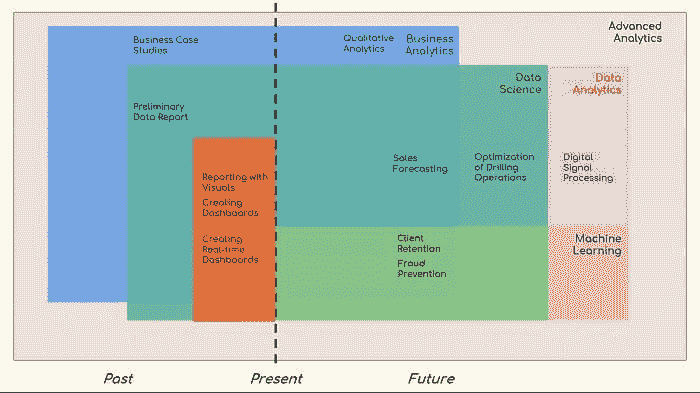

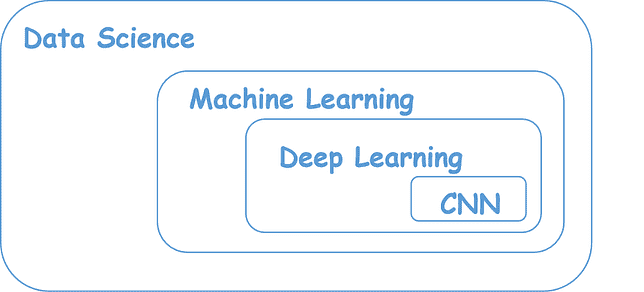

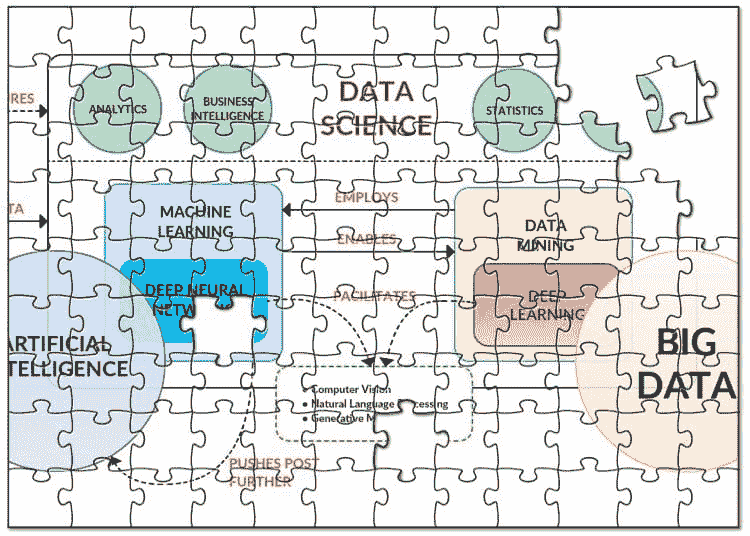

图 1 人工智能、机器学习、深度学习和数据科学之间的关系。

数据科学利用数据挖掘、机器学习、人工智能技术。

例如,深度学习需要在更强大的环境中运行 Jupyter。幸运的是,像 Saturn Cloud 这样的平台允许用户管理 Jupyter 开发环境。实际上,通过管理环境的资源,用户可以在必要时启用更多的 CPU、GPU 和内存。因此,专为云计算设计的平台允许保持环境成本低廉,使数据科学家只需为所使用的资源付费。

数据科学简史

数据科学彻底改变了我们世界的多个不同方面。让我们来看看数据科学的起源及其发展历程。

-

在 1962 年,约翰·W·图基在《数据分析的未来》中写道——数据科学历史上的第一个里程碑被全球公认为聪明的美国数学家约翰·图基。约翰·图基在统计学上的影响巨大,但最著名的词汇归功于他的是与计算机科学相关的术语。实际上,他是第一个引入“bit”一词作为“binary digit”缩写的人。

-

在 1974 年,彼得·瑙尔出版了《计算机方法简明调查》,这本书调查了各种应用领域的数据处理方法。术语“数据科学”变得更加明确,他给出了自己的定义:“处理数据的科学,一旦数据被建立,数据与其代表的内容的关系就委托给其他领域和科学。”

-

在 1977 年,国际统计计算协会(IASC)成立。

-

在 1989 年,格雷戈里·皮亚特基-夏皮罗组织并主持了第一次知识发现数据库(KDD)研讨会。

-

在 1994 年,《商业周刊》发布了一篇关于“数据库营销”的封面故事。

-

在 1996 年,国际分类学会(IFCS)会议上,第一次将“数据科学”一词纳入会议标题(“数据科学、分类和相关方法”)。同年,乌萨马·法亚德、格雷戈里·皮亚特基-夏皮罗和帕德雷克·史密斯发表了《从数据挖掘到知识发现数据库》。

-

1997 年,在他担任密歇根大学 H.C.卡佛统计学讲席教授的开幕讲座上,Jeff Wu 呼吁将统计学重新命名为“数据科学”,并将统计学家重新命名为“数据科学家”。

图 2 数据科学的历史。

自 21 世纪初以来,数据储备呈指数级增长,这在很大程度上要归功于高效且经济的处理和存储技术的出现。实时收集、处理、分析和展示数据和信息的能力为我们提供了前所未有的机会进行新的知识发现。为了处理这些海量数据,数据科学家需要高性能和大量的技术组合,以便在几秒钟内加快任务和数据处理速度。

由于有强大的平台可用,数据科学家如今可以利用人工智能、机器学习和深度学习等颠覆性技术。

数据科学实践中的挑战

尽管分析的采用增加了,但也带来了自己的一系列挑战。Kaggle 于 2017 年对 16000 名数据专业人士的样本进行的研究显示了他们职业中面临的 10 大最困难挑战:

-

脏数据(36% 报告)

-

数据科学人才短缺(30%)

-

公司政治(27%)

-

缺乏明确的问题(22%)

-

数据无法访问(22%)

-

结果未被决策者使用(18%)

-

向他人解释数据科学(16%)

-

隐私问题(14%)

-

缺乏领域专业知识(14%)

-

组织规模小,无法负担数据科学团队(13%)

这些挑战显得尤为突出。然而,我们需要意识到,每当一个新领域取得进展时,新的挑战也需要得到解决。我们必须拥抱变革,并确信这些变化有助于我们确保持续改进,获取新技能,拓展知识,探索新方法。

谁是数据科学家?

如上所述,随着操作数据的不断增长和新技术的出现,我们越来越需要具有分析敏锐性的专业人才,从海量数据中提取有价值的信息和见解,并做出精准决策。我们将这种类型的专家称为“数据科学团队”或简单称为“数据科学家”。

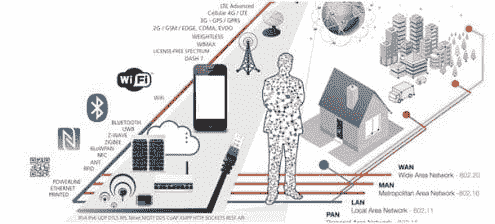

数据科学家是一个分析数据的专家,应该精通解决现代世界复杂问题所需的技术技能。今天新兴的技术,如人工智能、物联网、5G、机器人技术、区块链等,都严重依赖数据,只有那些能够操作数据并将其转化为有利产品的人,才能引领未来的数字业务。

因此,数据科学家在每个公司和组织的业务发展战略中扮演着至关重要的角色。正如托马斯·H·德文波特和 D.J.帕蒂尔所说,数据科学家是 21 世纪最性感的职业。

数据科学工具面向数据科学家

提供了丰富的软件工具支持数据科学家深入探索数据科学领域。如今,现有的平台使数据科学家能够使用他们最熟悉的工具(Python、Jupyter 和 Dask)进行大规模工作。通常,这些服务通过安全且可扩展的基础设施提供,以便在云环境中运行数据科学和机器学习工作负载。数据团队可以在自动化 DevOps 和 ML 基础设施工程下,以大规模在 Python 中开发和部署数据科学模型。

这些平台支持许多有用的 Python 库。

“Python 库是函数和方法的集合,使数据科学家可以执行许多操作而无需编写代码。”

-

NumPy 是一个为 Python 编程语言提供大规模、多维数组和矩阵支持的库。

-

Seaborn 是一个基于 matplotlib 的 Python 数据可视化库。

-

TensorFlow 是一个免费的开源软件库,用于跨多个任务的数据流和可微分编程。

-

PyTorch 是一个基于 Torch 库的开源机器学习库。

-

Numba 是一个开源 JIT 编译器,使用 LLVM 将 Python 和 NumPy 的子集翻译为快速的机器代码。

-

SciPy 是一个免费且开源的 Python 库,用于科学计算和技术计算。

-

Pandas 是一个为 Python 编程语言编写的数据处理和分析的软件库。

-

Scikit-learn 是一个免费的 Python 编程语言机器学习库。

-

Matplotlib 是一个用于 Python 编程语言及其数值数学扩展 NumPy 的绘图库。

-

Bokeh 是一个 Python 数据可视化库,提供高性能的交互式图表和绘图。

图 3 Python 库。

例如,广受认可的数据科学平台 Saturn Cloud 提供了一个全 Python 的端到端分析平台,在 AWS 上运行。包括:

-

Dask 允许组织扩展 Python 并显著减少运行时间。

-

协作工具、模型部署能力和机器学习生命周期的工具套件。

-

Prefect 提供了一个工作流编排框架,消除了开发者和数据科学家的手动工作。

-

与 Docker 和 Kubernetes 等服务的集成,使数据科学家能够构建自定义镜像,以满足他们最佳的开发期望。

-

Jupyter Notebooks 用于部署、管理和扩展 PyData 堆栈。

我们要去哪里?前景。

正如约翰·图基所预测的:“数据分析的未来可以涉及巨大的进步、克服真正的困难以及为所有科学和技术领域提供巨大服务。” 在过去的几年里,我们见证了许多数据驱动的技术创新,5G 超快的互联网速度、机器学习、云计算和区块链概念,这个显著的清单远非穷尽。数据的爆炸以及技术能力的增长只是一个开始,我们的生活正在随着技术创新变得“更智能”,这些创新很快可能会融入人类生活的各个方面。

原文。已获许可转载。

相关内容:

更多此类话题

数据科学与冒名顶替综合症

原文:

www.kdnuggets.com/2017/09/data-science-imposter-syndrome.html

评论

评论

我不是一个真正的数据科学家。

我从未使用过深度学习框架,比如 TensorFlow 或 Keras。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

我从未接触过 GPU。

我没有计算机科学或统计学学位。我的学位是机械工程学,真是奇怪。

我不知道 R。

但我还没有放弃希望。阅读了一些职位发布后,我发现成为真正的数据科学家只需五个博士学位和 87 年的工作经验。

如果这听起来很熟悉,你要知道你并不孤单。你不是唯一一个担心自己还能伪装成数据科学家的时间有多长的人。你不是唯一一个对下一个面试被笑出来而做噩梦的人。

冒名顶替综合症是一种感觉,认为你领域中的其他人都比你更有资格,你永远不会被雇佣,或者如果已经被雇佣,那你是招聘过程中的一个错误。尽管统计上看这种感觉不太可能,但我们中的大多数人感到低于平均水平。根据我与同事的交谈,我估计我们中有 9 成在某一时刻遭受过冒名顶替综合症。(如果这对你来说完全陌生,我建议你阅读 Kruger 和 Dunning 的“无能而无意识”一书。)

即便是伊沃克有时也会感到像冒名顶替者。(图片由 Diane Rohrer 提供。)

真正的数据科学家是什么样的

“数据科学”是一个激发了很多兴奋的术语,就像一个磁铁,吸引了许多相关的子领域。我们称之为数据科学的领域仍然相对年轻,但对于个人来说,已经过于广泛,无法在每个角落都成为专家。根据我的经验,通才的数据科学独角兽是一种神话中的生物。我们中的任何人都无法涵盖所有领域。那么我们该如何继续?

前进的道路有两条:通才和专家。

一个好的通才

-

对数据科学的每个部分都具有表面上的熟悉感,

-

认识到所有的术语和技术词汇,

-

对解决特定问题所需的工具和专长有一个良好的概念,并且

-

在技术评审中提出有见地的问题。

一个好的专家

-

深入理解一个领域,

-

能够将他们的专业领域解释给非专家,

-

理解不同方法之间的权衡,

-

了解当前的研究和新工具,并且

-

可以快速使用他们的工具来产生高质量的结果。

一名通才不一定了解算法的细节和工具的使用技巧。他们会告诉你数据清洗很关键,但可能无法列举替代缺失值的方法之间的权衡。他们会告诉你 Spark 是加速计算的好方法,但可能无法建议你使用最佳设置。

一名专家不一定对自己领域之外的内容了解很多。他们会知道如何在 5 亿个数据点上运行线性回归的最佳架构,但可能无法解释朴素贝叶斯分类器。他们会敏锐地把握平方损失、铰链损失和逻辑损失之间的权衡,但可能无法从 Hive 表中查询数据。

另一种描述通才和专家的方法是“广度”与“深度”。他们都是技术精通的,但他们的专长分布不同。我们每个人都是部分通才和部分专家。随着职业的发展,你会找到最适合你的混合方式。

这种区分在招聘数据科学家时也很有帮助。具体要求具有深度神经网络研究经验或金融数据可视化背景的求职者,将比要求“全栈”数据科学家更有效地吸引符合需求的申请者。

如何证明你是一个真正的数据科学家

传统上,我们通过高级学位来确立在某个领域的资格。不幸的是,对大多数人来说,数据科学领域的高级学位非常稀缺。我们没有一张纸作为盾牌,当有人质疑我们的资格时。因此,我们该怎么做呢?我们如何回答批评者、面试官、同事,甚至是我们内心最严厉的声音?

以木工为例。假设你想在厨房里安装一个定制的橱柜。三位木匠前来询问这项工作。第一位木匠展示了她的证书。她说:“我在城市顶级的橱柜制造商那里做了七年的学徒。”第二位木匠打开了她的工具箱,说:“我的凿子是最新设计的,没有人能比我的刨子更锋利。”第三位木匠递给你一个小盒子,樱桃色且光滑完美。当你用指尖拉动把手时,一个抽屉无声地滑出。她说:“这是我做的。”

认证、工具和作品集都是建立资历的热门方式。我不会争论哪一种优于另一种,但作品集对数据科学家特别有效。认证较少且尚未标准化。列出我们使用过的算法和计算机语言并不能传达我们对它们的熟悉程度或我们能用它们做什么。 构建项目 向非技术观众展示了我们能为他们做什么,并向技术面试官和同事展示了我们的专业知识。当然,这不能保证你会在第一次面试中得到工作。但即使没有,这也是正常的。 继续面试。

成为真正的数据科学家的感受

请注意,无论是全能型还是专门型的数据科学家都有很多不知道的事情。这意味着即使是真正的数据科学家也会大部分时间感到迷茫。我们的项目负责人会问我们不知道答案的问题。 同事会轻松地谈论我们从未听说过的算法。队友会写出我们完全无法解读的代码。文章会引用我们不知道存在的“热门”子领域。档案论文会抛出我们如同象形文字般难以理解的方程式。实习生会指出我们推理中的根本缺陷。这没关系。你没有做错。这没关系。

我们的目标不是积累答案,而是提出更好的问题。如果你在提出问题并利用数据寻找答案,那么你就是一名数据科学家。就这样。

原文。经许可转载。

相关内容:

-

KDnuggets 顶级博主:与顶级数据科学家 Brandon Rohrer 的访谈

-

数据科学口袋指南

-

如何获得数据科学工作:一个非常具体的指南

更多相关话题

数据科学如何改善高等教育

原文:

www.kdnuggets.com/2018/11/data-science-improving-higher-education.html

评论

评论

大数据为高等教育提供了巨大的机会。越来越多的高校以及政府正在使用数据科学来改进教育机构在招聘、学生互动和预算等方面的方式。

我们的前三大课程推荐

1. Google 网络安全证书 - 加入网络安全领域的快速通道。

1. Google 网络安全证书 - 加入网络安全领域的快速通道。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织的 IT 工作

3. Google IT 支持专业证书 - 支持您的组织的 IT 工作

以下是数据科学正在改善高等教育的六种方式。

1. 提高毕业率

几乎所有大学的主要目标之一是提高毕业率。有很多策略可以实现这一目标,数据可以帮助学校确定哪种策略最适合它们。

分析关于辍学学生与完成学业学生的数据,可以帮助学校识别出最有可能离开的学生特征。它还可以使学校为这些学生提供资源,以减少他们辍学的风险。

费城的天普大学一直在使用数据来提高其毕业率。它发现那些收入适中并获得部分佩尔助学金的学生最有可能辍学,即使与那些获得全额佩尔助学金的最低收入学生相比也是如此。它还发现,拥有四年高中外语学习经历的学生较不容易辍学。

使用这些数据,天普大学向处于风险中的学生提供了经济援助,并启动了帮助改善学生校园归属感的举措。该校的四年毕业率已从 20%上升到 44%,六年毕业率从 59%上升到 70%。

2. 改进招聘策略