KDNuggets-博客中文翻译-十九-

KDNuggets 博客中文翻译(十九)

原文:KDNuggets

如何成为数据工程师

评论

由 Anna Anisienia 提供,TrailStone Renewables 的 Python 工程师。

我们的前三名课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

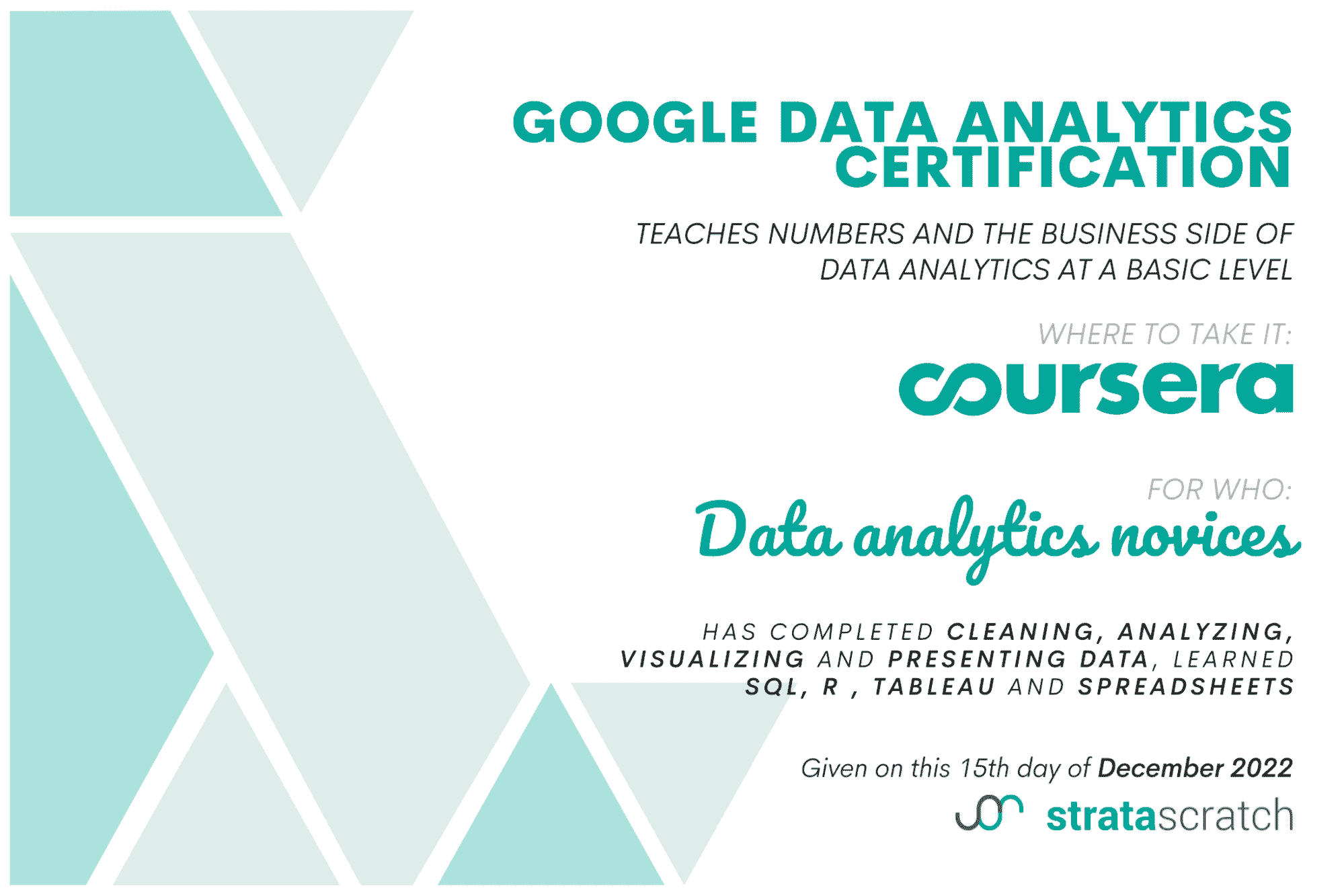

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

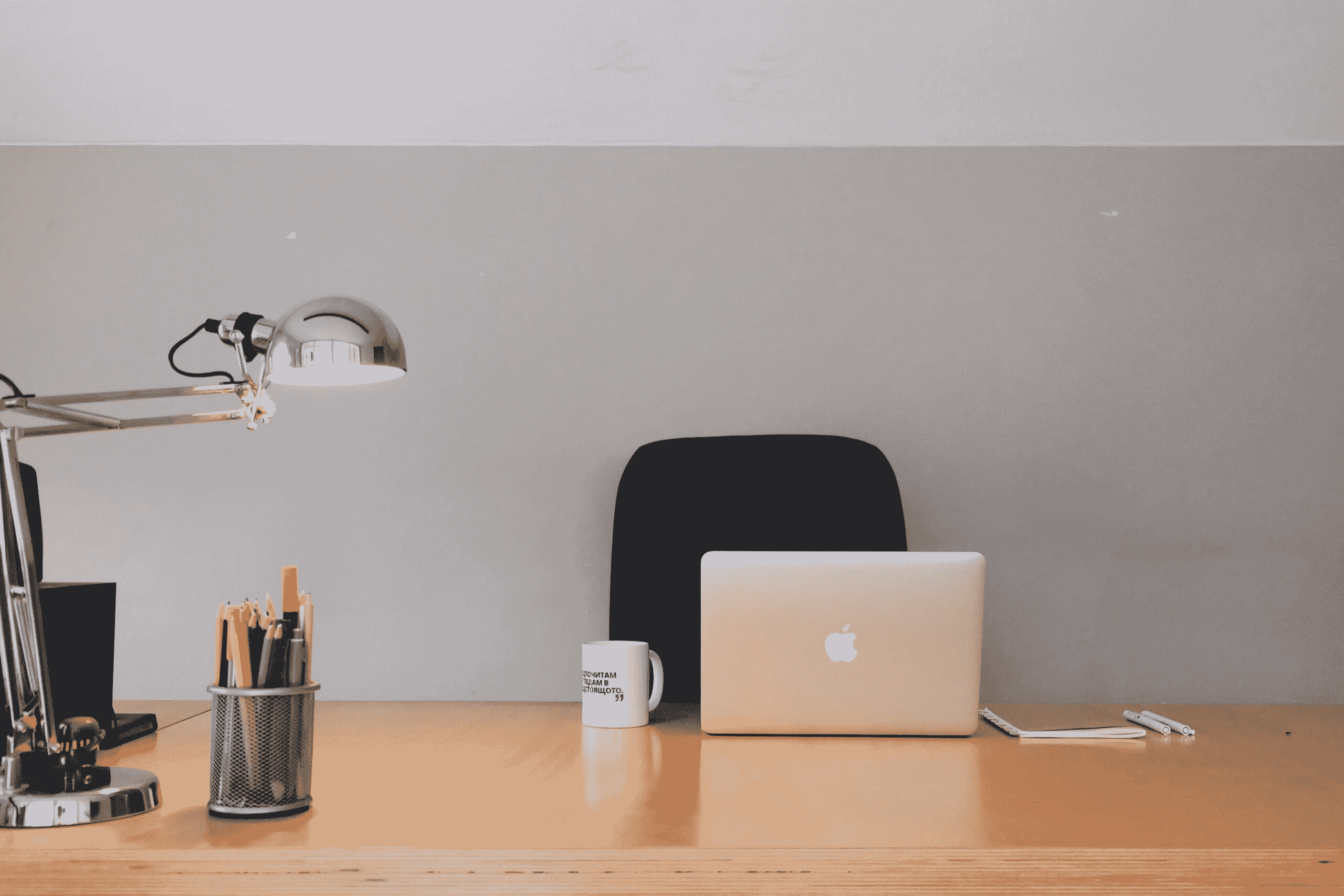

照片由 Nathan Riley 提供,发布于 Unsplash。

数据工程是一个迷人的领域。你可以处理各种有趣的数据、前沿技术,以及与不同的数据专业人员和领域专家合作。整个数据工程领域相对较新。作为数据工程师,你的角色对公司的成功至关重要——许多数据专业人士,包括数据分析师和数据科学家,都依赖你来完成他们的工作。你负责提供始终可用、可靠且结构合理的数据。

公司需要你根据真实数据和从中生成的 KPI 做出明智的决策。如果你做得好,他们愿意为此付出丰厚的薪资!让我们探讨一下哪些技能需求量大,哪些因素对未来职业前景影响较大,以及如何应对技术面试。

总体而言,通常很难给出任何真正的通用建议,但我总结了似乎最相关的技能,这些技能在招聘广告中被提及多次,并结合了我在这一领域的经验。

1. 成为 T 型专业人士

最好是成为全才(T 型横杆),即理解数据库、云计算、数据仓库、大数据的一般概念,并且至少了解一些 SQL、Python、Docker 和创建 ETL 的基础知识。

同时,你应该在至少一个特定领域具备更强的技能(T 型竖杆)。例如,你可能在编写Spark或Dask 数据操作方面非常出色,或者你可能拥有某些公司所需的领域知识,这使你在其他申请者中脱颖而出。

在许多情况下,精通 SQL + Python、Linux 和 AWS 的基础知识已足以让你获得一个薪酬不错的初级职位。

2. 处理数据的云服务

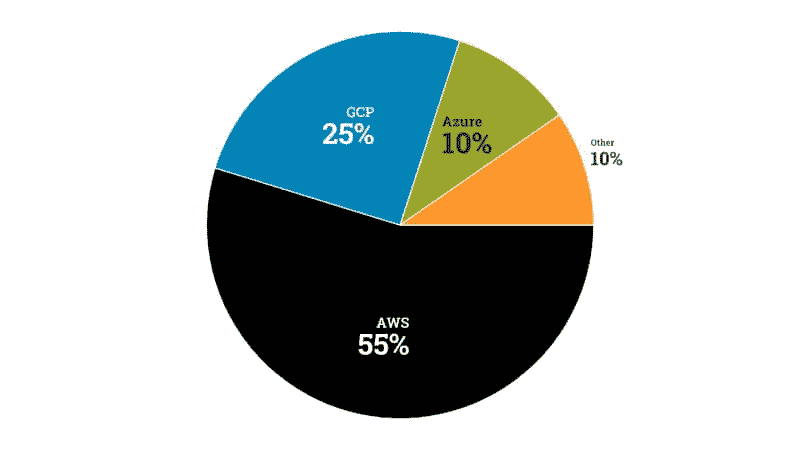

云计算革新并改变了许多行业。作为数据工程师,你需要了解存储、计算、网络和数据库的最重要服务。如果你对这些不太了解,我强烈推荐学习亚马逊网络服务——即使你最终使用的是谷歌云平台或微软 Azure,从 AWS 学到的概念也可以很容易地应用于不同的云服务商,因为许多云服务商的服务是类似的,其概念实际上是相同的(例如,块存储与对象存储与 NFS)。

如果你对 AWS 不太熟悉,可以参考这个链接,你会找到优秀的 AWS 免费课程——它们都是由 AWS 直接提供的。你不需要为额外的证书付费——根据我的经验,招聘人员和工程经理并不特别看重证书。他们希望招聘到有实际经验、知识丰富并能将其应用于业务问题的人。

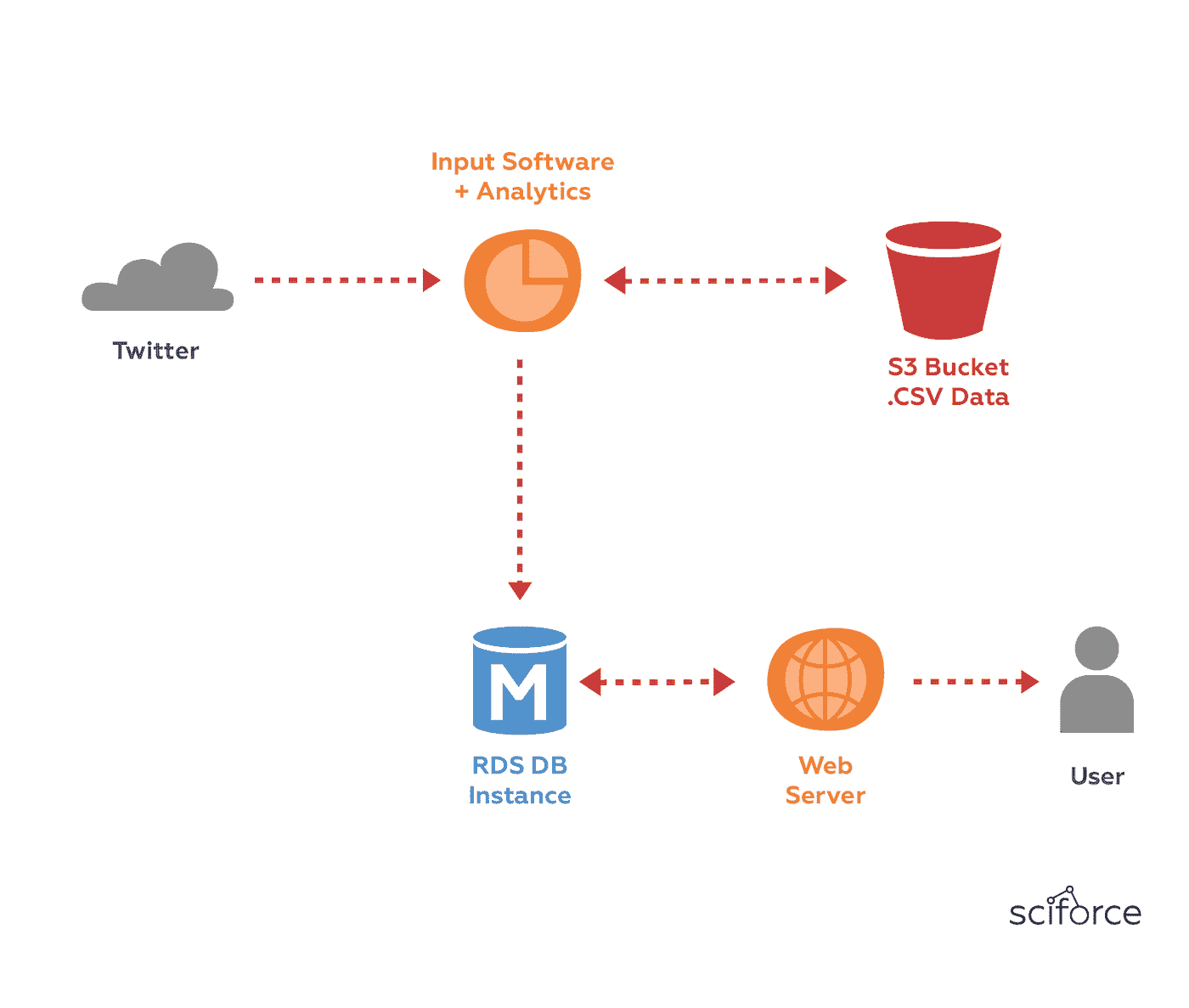

数据工程职位最重要的 AWS 服务包括:

-

能够以编程方式与S3上的文件进行交互(下载和上传 CSV 或 parquet 文件)

-

能够启动并 SSH 到EC2实例 + 了解一些 Linux 基础,以便通过 CLI 与之交互

-

IAM:了解如何创建 IAM 用户、为相关服务附加策略、使用它来配置AWS CLI的编程访问 + IAM 角色的基本工作原理

-

VPC:你应该知道什么是 VPC、子网,并了解它们的基本工作原理(你的 VPC 存在于特定的 AWS 区域,子网存在于该区域内的特定可用区)

-

RDS:了解如何启动或至少与关系数据库如 Postgres 进行交互。

此外,了解 AWS Lambda(无服务器功能即服务)、ECS 和 EKS(大规模运行容器)、亚马逊 Redshift(云数据仓库)、Athena(无服务器查询引擎,用于查询 S3 数据湖)以及 AWS Kinesis 或亚马逊 MSK(两者都用于实时流数据)也是有益的。但你可以首先关注列表中的服务。Edx 的课程解释了其中大多数。并且,记住要实践:使用 AWS 免费层,你可以(有限)访问这些基础服务,从而通过动手操作进行学习。

3. 构建 ETL 管道

成为数据工程师很大一部分是将来自各种来源的数据集成,转化为适合分析的形式,然后加载到某个数据湖或数据仓库。你应该有创建 ETL 的一些经验。这并不意味着你必须在大型公司的大数据项目中工作——即使是你在 Github 或博客中分享的自驱动项目也能在申请过程中大有裨益,并让你从人群中脱颖而出。

4. 管理、监控和调度 ETL 管道

数据工程师的主要职责之一是确保数据始终可用、可靠且结构合理。为了实现这一点,你需要调度和监控你的数据管道。许多公司使用如 Apache Airflow 或 Prefect 的工作流管理系统,所以了解其中之一可能会显著提高你获得优秀数据工程职位的机会。如果你想 了解更多相关内容,请阅读我之前的故事,例如 这篇文章 —— 在那篇文章中,我展示了如何在 AWS 上轻松设置一个 无服务器 Kubernetes 集群 的工作流管理系统。

5. 能够使用容器:Docker 和 Kubernetes

如果你使用 Python,你会知道你的代码可能会因为升级到新的 pandas 版本而突然失效。容器化是关键,因此 能够处理容器化工作负载 是(任何)工程职位中最关键且需求量最大的技能之一,因为它使你的代码自包含、无依赖,并且让你能够将代码部署到 几乎 任何环境。

6. 了解基本概念

这与成为 T 型专业人士相辅相成:你应该了解数据仓库、数据湖、大数据、REST APIs 和数据库的基础知识。在面试时不能解释 大数据的 3Vs 或 数据仓库的特性 会令人相当失望。此外,了解架构组件也是值得的。例如,在 这篇文章 中,我讨论了数据仓库架构和迁移到云端时的关键考虑因素。

7. 能够独立工作和学习

这不言而喻:随着技术的快速发展,你必须成为一个自我驱动的学习者,愿意不断学习和尝试新工具。这并不意味着你需要跟随每一个趋势,而是要保持开放的心态。

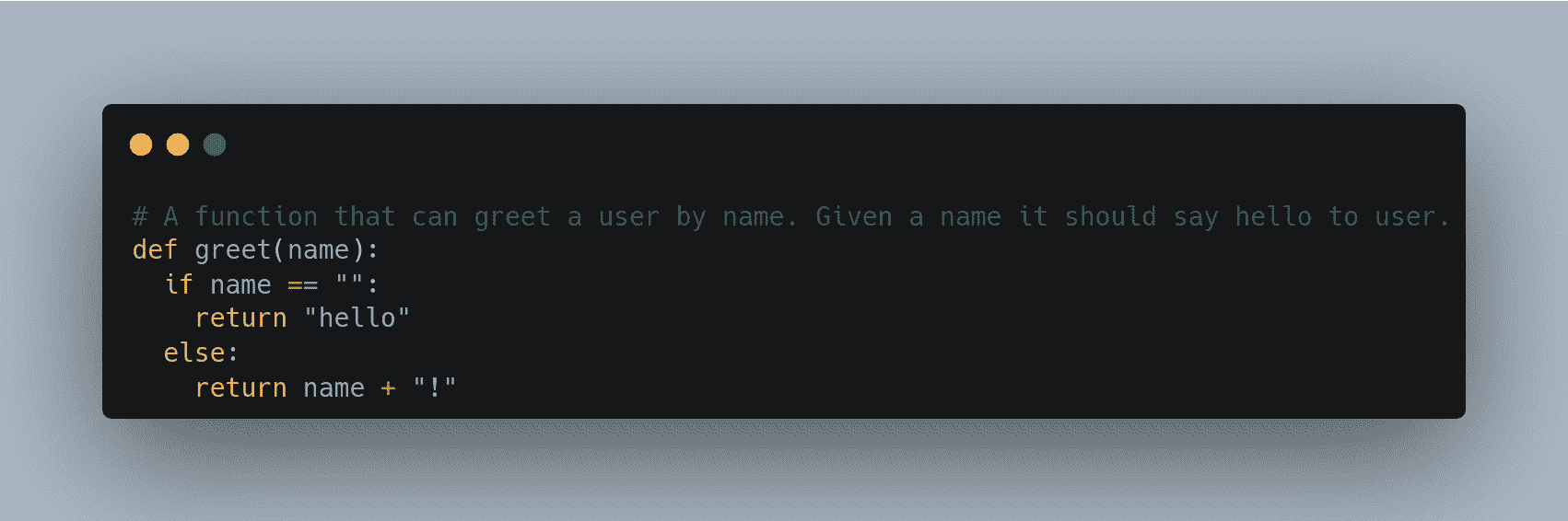

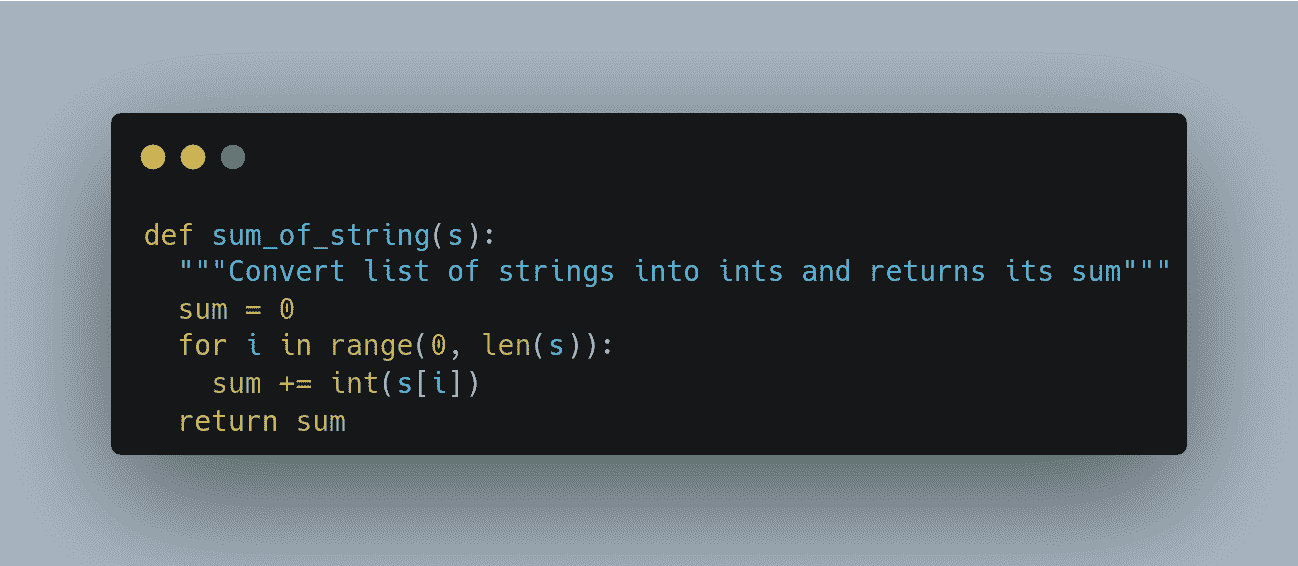

8. 编程技能

编程并不意味着你必须是一个 “黑客”,并且需要整天只写代码。更重要的是能够 快速学习 和知道如何编写 良好的抽象。在数据工程领域,这意味着 你知道如何编写 DRY 代码(Don’t Repeat Yourself),即:你不会将相同的代码从一个脚本复制粘贴到另一个脚本,而是知道如何 以模块化和可重用的方式编写函数或类。干净的代码可以被重用、扩展和参数化,易于维护,并且可以节省你和他人的时间。

举个例子:我曾在一家公司工作,那里的项目几乎没有模块化。在几乎每个 Python 项目中,人们都会复制相同的代码来建立日志记录、连接到数据仓库并从中加载一些数据,或者建立一个 S3 客户端并从某个 S3 桶中下载 CSV 文件。为了改善这一点,我创建了一个 Python 包:

-

它包含了几乎所有项目中所需的功能,我将其推送到一个新的 GitHub 仓库中。

-

这个软件包可以通过以下方式在任何地方安装:

pip install git+https://github.com/

/<PACKAGE_NAME>.git。

从长远来看,这个软件包为我们节省了大量时间,并使代码库更加干净。

如果你是 Python 初学者,那么你不需要学习如何创建包。一开始,如果你能编写好的 Python 函数并且知道如何使用基础的数据处理包如Pandas,那可能已经足够了。

许多公司也寻找了解 Scala、Java、R 或 C 的数据显示工程师(或任何其他语言)——无论编程语言是什么,如果你理解数据处理的基本数据类型以及函数式编程和模块化的原则,你可以获得更好的工作。

9. 命令行

能够使用Linux操作系统并通过bash 命令与其交互,是使你更加高效的关键技能之一。

许多框架和云服务的工作方式是通过声明性语言(如 Dockerfile 或 Kubernetes YAML 文件)定义资源和服务,然后通过命令行界面(CLI)进行部署。这种范式通常被称为基础设施即代码。例如,AWS CLI 允许你仅通过提交 bash 命令到 AWS API 来配置整个资源集群。其他云提供商(如 GCP 或 Azure)也提供类似的命令行接口。

10. 软技能

有些人可能会期望数据工程师只是做 ETL 和数据处理。但在每个工作中,拥有补充你个人资料的技能是有益的。假设你有两个候选人:

-

一位优秀的编码员但公共演讲能力差,

-

一位普通的编码员,但同时是一位出色的公共演讲者。

你会选择谁?许多公司会选择后者。雇主寻找全面发展的个人,他们还具备重要的软技能,如项目管理、公共演讲、文档编写,或擅长主持和组织活动。

在你的职业前景中起重要作用的因素

数据工程工作的薪资因地点、行业、所需技能和经验水平而异。下面,我列出了决定薪资和未来增长的 7 个最重要因素。有些因素很明显,但有些可能会让你感到惊讶:

-

地点——即使你申请的是远程工作,公司的薪资可能还是会根据你所在国家的生活标准来决定,以反映生活成本等因素。

-

行业——金融、汽车、科技或制药行业的公司通常支付的薪资比初创公司和电子商务公司要高得多。

-

工作经验——招聘人员对此非常关注,尽管这些年数本身并不能真正反映你从之前的工作中学到了多少东西,

-

专业知识——经验年限并不等同于专业知识(至少我认为是这样)。有时,人们在 Spark、Linux、Dask 或高级 SQL 方面表现出色。如果你能证明你真的对这些有深入了解,这可能比 20 年的拖拽式 ETL 经验更有价值。

-

实践经验——在工程领域,没有什么比实践经验更有价值。如果我们不能将知识应用于现实生活中,我们的知识是没有意义的。做个人项目并进行实践。不要只是阅读一些东西并认为你已经掌握了——如果你没有应用它,那一切只是你很快会忘记的理论。

-

教育背景——我个人发现招聘人员并不会像我预期的那样关注你的教育背景。当然,他们会查看你是否拥有学士、硕士甚至博士学位,但招聘人员通常不太关心你毕业于哪个大学或你的专业是什么。认证也是如此——许多技术经理更看重你在特定工具或编程语言上的实际经验,而不是任何官方的知识证明,他们可能更愿意在技术面试中亲自验证你的知识,而不是依赖证书。

-

你的特殊技能、领域知识和软技能(例如,处理冲突的能力)比你预期的更重要。招聘人员经常可能会拒绝某人,因为他们觉得这个人可能不适合团队和公司的文化。

面试准备

我听说过一些申请者在电话面试中无法回答关于他们申请的公司在做什么的问题。另外,像谈谈你自己和你为什么想换公司这样的问题非常普遍,提前考虑一下这些问题是很好的。

此外,如果你计划申请,你应该为一些(基础)技术问题做好准备。许多数据工程经理会要求你设计一个星型模式,或者给你一些编码问题,例如SQL 窗口函数、生成器、广播、Python 中的列表解析,Docker 镜像和 Docker 容器之间的区别,或者你会如何创建 Docker 镜像和运行 Docker 容器。

最后,相信自己并保持自信。

原文。已获得许可转载。

相关:

更多相关话题

如何成为数据科学家

评论

图片由 Burst 提供,来自 Pexels

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业

1. 谷歌网络安全证书 - 快速进入网络安全职业

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

数据科学家是当前最受欢迎的职业之一。随着数据在现代商业中扮演着越来越重要的角色,这个职业将变得更有价值。考虑到这种有前景的展望,现在是追求数据科学家职业的理想时机。

成为数据科学家可以是一个有回报和有利可图的职业。美国劳工统计局预计这些工作到 2029 年将 增长 15%,这比全国平均水平要快得多。数据科学家在 2019 年的中位工资为 $122,840。

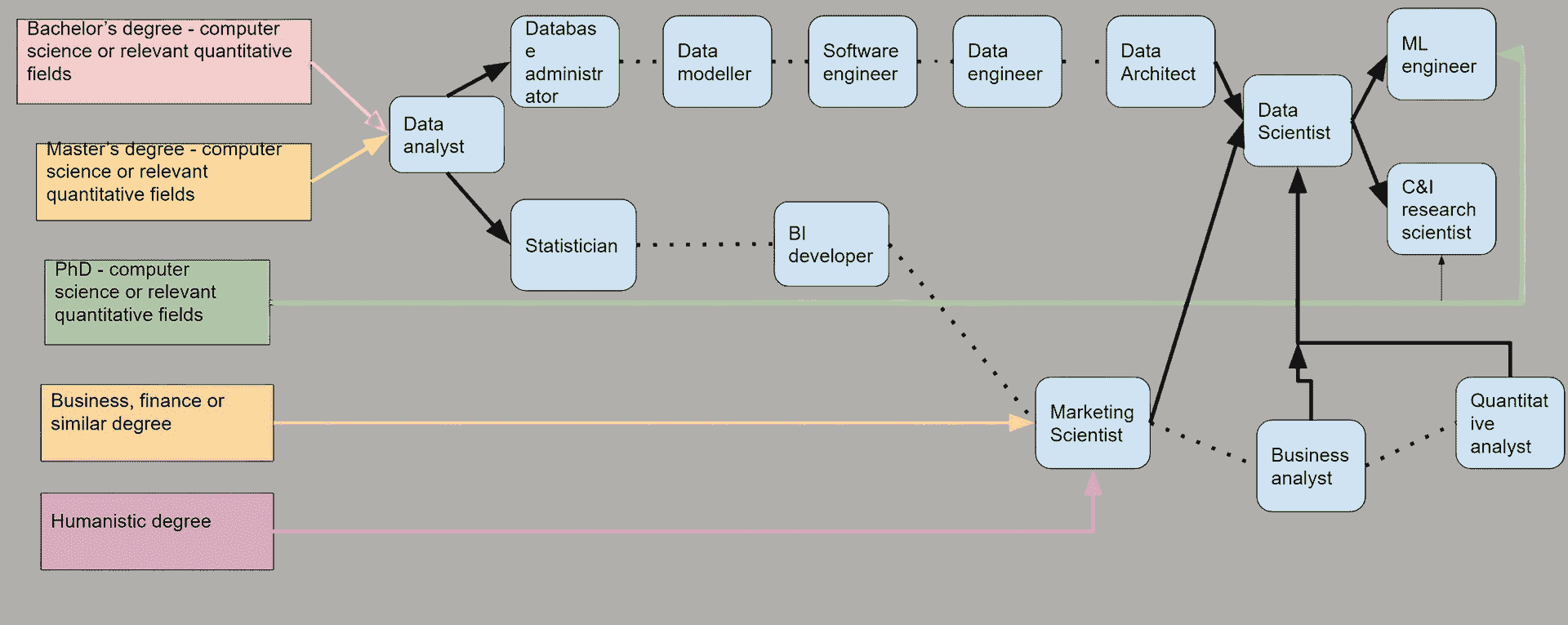

你可能不需要更多的说服理由来说明为什么你应该成为数据科学家,但如何做到这一点可能不太明显。这是开始你数据科学职业生涯的逐步指南。

获得正确的教育

与大多数职业一样,你需要适当的教育才能成为数据科学家。理想情况下,你应该获得相关领域的本科学位,比如计算机科学、信息系统或数据分析。大多数专业数据科学家还拥有硕士学位,通常是在数据科学领域的更专业化领域。

如果你已经有了学位,你不一定需要回到学校获得更相关的学位。不过,你应该查看一些在线项目,那里你可以参加一些数据科学课程。寻求一些额外的认证和执照也会有帮助。

在你的课堂上学到的技能并不是成为数据科学家所需的唯一教育。你还应该学习各种编程语言并寻求实践经验。你可以找到许多书籍和在线课程,这些都将帮助你提升这些技能。

建立你的作品集

仅有教育背景还不足以获得数据科学家的职位。大多数公司还会寻找你技能的具体证据。前 Apple 高级数据科学家 Mohammad Shokoohi-Yekta 表示,你应该熟悉代码并将数据科学应用于实际,而不仅仅是理论。

展示你在这一领域的舒适度和知识的最佳方式是通过你的作品集。尽早开始参与实际的数据科学项目,并将其汇编成作品集。你可以通过自由职业的数据工作和你感兴趣领域的宠物项目来做到这一点。

你的作品集应该展示各种不同的数据科学项目,以体现你的多样性。你应该展示在各种编程语言、行业和项目类型中的技能。如果你能参与任何与数据科学相关的竞赛,你在其中的工作将是一个极好的作品集补充。

寻找职位

一旦你拥有相关的教育背景和丰富的作品集,就该开始寻找职位了。

虽然多样性总是有帮助的,但你可能会在针对具有特定资格和认证的细分行业时更有好运。例如,所有国防部承包商都需要符合 CMMC 标准,所以你可以获得这个认证,提高获得国防部工作的机会。

记得根据每个潜在雇主调整你的简历和求职信。强调与你所申请的行业和职位最相关的技能和经验。除了通过像 Indeed 这样的网站申请职位外,拓展你的 LinkedIn 网络,并尝试建立一个受雇主关注的良好在线形象。

你可能一开始无法获得数据科学家的职位,这也是可以的。实际上,首先申请一个相关但更基础的职位如数据分析可能更好。从那里你可以发展你的职业。

职业发展

在职经验是推动你职业发展的最佳资源。因此,尽量不要对接受的第一个职位过于挑剔。如果你收到了一份稳定的数据相关领域工作的邀请,尽管这不是你理想的职位,你也可能还是要考虑接受它。把你的第一个数据职位看作是一个启动点。

拥有 50 到 500 名员工的公司是你在数据科学领域的理想首份工作的规模。在这些中型企业中,你将能够从资深数据科学家那里学习,并且有很多机会晋升。一旦你开始了你的第一个职位,就要主动尽可能多地参与项目,避免让自己过于分散。

你在公司内部寻求新机会的越多,你获得的相关经验就会越多。在工作时,寻找在当前公司和其他公司向上发展的机会。如果你表现出主动性和卓越的工作伦理,你很快就会在数据科学领域取得进步。

今天就开始你的数据科学职业生涯

开始数据科学职业生涯永远不会太晚。但如果你知道这是你想做的事情,不要拖延。你可以从今天开始获得所需的技能和经验。成为一名数据科学家远非易事,但如果你遵循这些步骤,你可以享受一段漫长而有意义的数据科学职业生涯。

简介:德文·帕提达 是一位大数据和技术作家,同时也是 ReHack.com 的主编。

相关:

-

我如何在被裁员后的两个月内获得 4 个数据科学职位,并使收入翻倍

-

数据专业人士如何在简历中添加更多变化

-

自动化如何改善数据科学家的角色

更多相关话题

如何快速上手 SQL——免费的学习资源列表

原文:

www.kdnuggets.com/2022/10/get-running-sql-list-free-learning-resources.html

Vector by storyset on Freepik

考虑到您点击了这篇文章,我想可以安全地说,您要么刚开始数据学习之旅,要么正在寻找提升 SQL 技能的方法!那么,您来对地方了,我不会让您失望!在本文中,您将简要了解 SQL 的背景,包括它如何以及为何变得流行,以及我发现的一些最佳免费课程/资源,用于开始和继续提升您的 SQL 技能!

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织在 IT 方面

3. 谷歌 IT 支持专业证书 - 支持您的组织在 IT 方面

为什么需要学习 SQL?以及最佳的学习方式

自 1970 年代,当两位 IBM 研究人员雷蒙德·博伊斯(Raymond Boyce)和唐纳德·钱伯林(Donald Chamberlin)开发出一种新的编码语言后,数据行业一直严重依赖 SQL 来有效查询和转换数据。随着数据团队将存储和计算转移到云网络服务器上,这一点变得更加明显。

随着这些变化,对于从事数据分析工作的人来说,掌握这种语言变得越来越重要。互联网上有很多关于不同备忘单的噪音,这些备忘单提供了最基本的 SQL 转换。凭借我作为数据分析师和数据科学家的多年经验,我可以告诉您,这些备忘单中的很少一部分能在长期内真正帮助到您。实际上,只有两种方法可以有效地使用 SQL——学习基础知识,然后继续提高技能,或者(更流行的方法)利用其他工具提高生产力,最佳的做法是两者的结合!

顶级免费入门课程

Udemy SQL 课程

Udemy 是一个在线学习和教学市场,提供超过 204,000 门课程和 5400 万学生。上述链接是一个全面的课程,评分为 4.5,已有超过 450,000 名学生完成了该课程!此外,该课程没有先决条件。

PopSQL

PopSQL 是一个现代化的 SQL 编辑器。它允许你与同事和朋友协作编写正确的 SQL 查询。既然你对这个概念有了坚实的基础,那么他们提供的学习 SQL 的资源也很有用。此外,这个资源将不同的语法分开,这样你只需要使用你想要的程序。我建议你在更好地理解你尝试运行的不同变换后使用它。

W3Schools.com

W3Schools 是最大的网站开发平台之一。它包含了大量关于多种编程语言的课程。他们的 SQL 教程将教你 MySQL、SQL Server、MS Access、Oracle、Sybase、Informix、Postgres 以及其他一些数据库系统。这个教程的优点是有大量的示例和测验来测试你的知识!此外,他们还提供 SQL 参考,你可以在这里找到各种关键字和函数。这个教程会给你一个证书,证明你已经掌握了 SQL 的基本知识。

可汗学院

可汗学院是一个 501(c)(3)非营利组织,像上述所有资源一样,它是完全免费的。这是一个初学者课程,你将学习如何使用 SQL 来存储、查询和操作关系型数据库中的数据。这个课程提供了多个视频、引人入胜的挑战和课程结束的测验来测试你的知识。虽然它比一些其他资源需要更多的自学,但对于任何想要学习或练习 SQL 技能的人来说,仍然是一个了不起的资源。

现在该怎么办?

现在你已经完成了 SQL 的入门课程,并且对查询结构和不同的变换有了基本了解,你面临一个选择。你应该知道你想达成什么目标以及如何达成它,但可能没有时间通过 Stackoverflow 或 Google 来完善那些特定查询的细节。这时你应该寻找不同的工具来帮助你节省时间,提高效率。以下是我推荐给任何新手或有志 SQL 用户的两个资源。这些资源来自我最近发布的一篇文章,标题为每个数据分析师都应该拥有的五大书签。

代码美化工具

互联网上有很多不同的 SQL 格式化工具,但这是我使用并喜欢的。这个工具非常适合你和你的同事,因为你们不再需要深入挖掘复杂的查询来找到试图运行的转换;SQL Formatter 会立即以结构化的方式格式化查询,使你和你的同事都更容易跟随。

从本质上讲,美化工具将把这些内容:

并将其转化为这个!

Rasgo

即便是最有经验的 SQL 开发人员也难以记住各种转换所需的所有语法。对此,许多 SQL 用户花费大量时间搜索过去的项目或不同的在线资源,如 Stackoverflow 和论坛,寻找答案。对于在数据驱动的企业中工作的数据从业者来说,节省时间几乎和数据质量一样重要。

我推荐使用这个 SQL 生成器——“SQL 生成器基本上是一个 SQL 查询的模板,允许你自定义列名和表结构,选择你要进行的操作,然后以多种不同的 SQL ‘风格’构造语法。”

我找到了一篇介绍如何使用 SQL 生成器的博客。另外,最近我发现我的秘密被揭露了;Suraj Gurav 最近写了一篇关于这个 SQL 生成器的评论,标题为 如何在不输入的情况下编写 SQL 查询。

结论

SQL 是处理数据时应了解的最重要的编程语言之一,更具体地说,是在旋转数据库中使用。初次接触这门编程语言时,可能会觉得非常难以驾驭。不过,我希望通过以上资源,你可以通过免费的课程获得对语言的良好基础理解,然后利用其他免费的资源进一步提升你的知识和能力!

乔什·贝瑞 (@Twitter) 领导 Rasgo 的面向客户的数据科学团队,并自 2008 年起从事数据和分析工作。乔什在 Comcast 工作了 10 年,期间建立了数据科学团队,并且是内部开发的 Comcast 功能商店的关键负责人之一——这是市场上首批功能商店之一。在离开 Comcast 后,乔什在 DataRobot 关键地领导了面向客户的数据科学建设。在业余时间,乔什会对棒球、F1 赛车、房地产市场预测等有趣话题进行复杂的分析。

更多相关主题

使用 Python 对你的数据预处理进行 2–6 倍的加速

原文:

www.kdnuggets.com/2018/10/get-speed-up-data-pre-processing-python.html

评论

评论

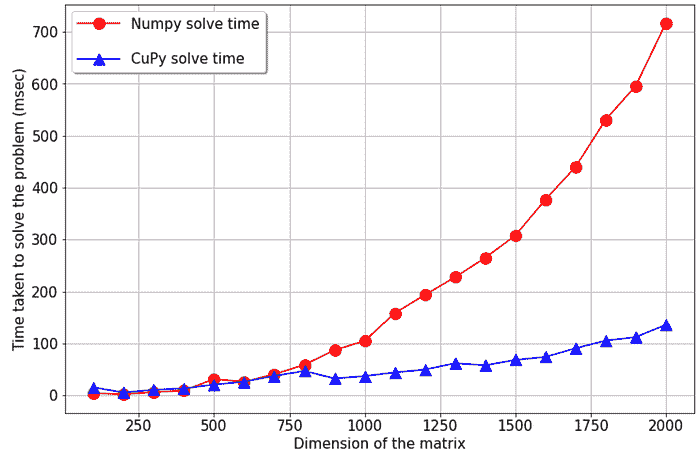

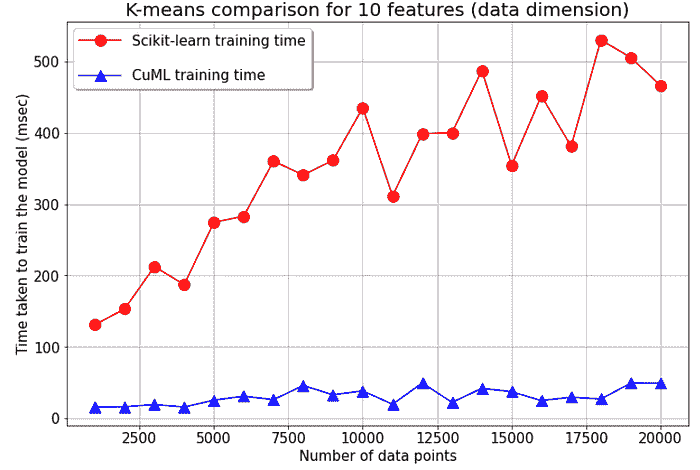

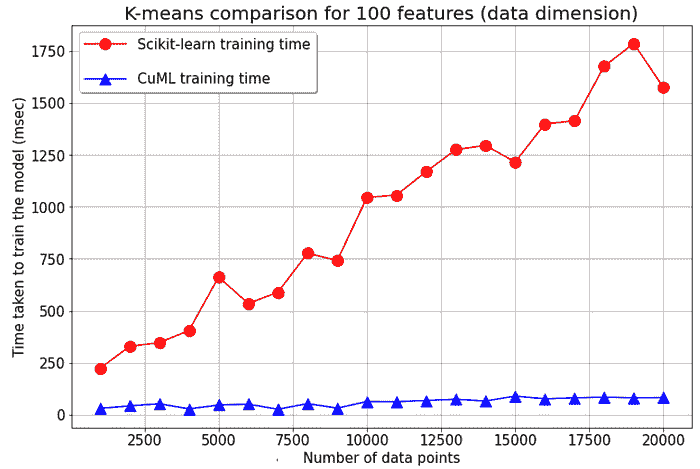

Python 是进行所有机器学习任务的首选编程语言。它易于使用,并且拥有许多出色的库,使得数据处理变得轻而易举!但当我们处理大量数据时,情况就会变得有些复杂……

如今,“大数据”一词通常指的是至少有数十万甚至 数百万 数据点的数据集!在如此规模下,每一个小计算都会累积起来,我们需要在编写每一步骤的代码时保持效率。考虑到机器学习系统效率时,一个常常被忽视的关键步骤是 预处理 阶段,我们必须对所有数据点应用某种操作。

默认情况下,Python 程序作为一个单一进程使用单个 CPU 执行。大多数现代机器用于机器学习时,至少 有 2 个 CPU 核心。这意味着,对于 2 个 CPU 核心的例子来说,当你运行预处理时,50% 或更多的计算机处理能力默认不会被使用!当你达到 4 核心(现代 Intel i5)或 6 核心(现代 Intel i7)时,情况会更糟。

但幸运的是,Python 标准库中有一个稍微隐蔽的功能,可以让我们利用所有的 CPU 核心!得益于 Python 的 concurrent.futures 模块,只需 3 行代码即可将普通程序转换为可以在 CPU 核心间并行处理数据的程序。

标准方法

让我们以一个简单的例子来说明,我们有一个文件夹中的图像数据集;也许我们甚至有成千上万或数百万张图像!为了处理时间,我们这里用 1000 张。我们希望将所有图像调整为 600x600 的大小,然后再传递给我们的深度神经网络。这就是在 GitHub 上你经常会看到的一些标准 Python 代码的样子。

这个程序遵循了你在数据处理脚本中经常会看到的简单模式:

-

你从一份你想要处理的文件列表(或其他数据)开始。

-

你使用

for循环逐个处理每一条数据,然后在每次循环迭代中运行预处理

我们来在一个包含 1000 个 jpeg 文件的文件夹上测试这个程序,看看运行需要多长时间:

time python standard_res_conversion.py

在我的 i7–8700k 六核 CPU 上,这给我带来了 7.9864 秒 的运行时间!对于这样一个高端 CPU 来说,这似乎有点慢。我们来看看如何加快速度。

快速方法

要理解我们如何希望 Python 并行处理事务,直观地思考并行处理本身是有帮助的。假设我们要完成同一个单一任务——将钉子钉入一块木头,我们有 1000 个钉子。如果每个钉子需要 1 秒,那么一个人完成这个工作需要 1000 秒。但如果我们有 4 个人在团队中,我们可以将桶分成 4 份,每个人处理自己的一份钉子。使用这种方法,我们只需 250 秒就能完成工作!

在我们的例子中,我们可以让 Python 对 1000 张图片做类似的处理:

-

将 jpg 文件列表分成 4 个较小的组。

-

运行 4 个独立的 Python 解释器实例。

-

让每个 Python 实例处理 4 个较小的数据组之一。

-

将 4 个进程的结果合并以获得最终的结果列表

最棒的是,Python 为我们处理了所有的繁重工作。我们只需告诉它要运行哪个函数以及使用多少个 Python 实例,它就会完成剩下的工作!我们只需更改3 行代码。

从上述代码:

with concurrent.futures.ProcessPoolExecutor() as executor:

启动与 CPU 核心数量相同的 Python 进程,在我的情况下是 6 个。实际的处理行是这一行:

executor.map(load_and_resize, image_files)

executor.map() 接受你希望运行的函数和一个列表作为输入,其中列表的每个元素都是函数的单个输入。由于我们有 6 个核心,我们将同时处理列表中的 6 个项目!

如果我们再次使用以下方法运行程序:

time python fast_res_conversion.py

我们获得了1.14265 秒的运行时间,几乎是 x6 的加速!

注意:启动更多 Python 进程并在它们之间传输数据会有一定的开销,因此你不会总是获得如此大的速度提升。但总体而言,你的加速通常会非常显著

它总是超级快速的吗?

使用 Python 并行池是处理数据列表并对每个数据点执行类似计算的绝佳解决方案。但这并不总是完美的解决方案。通过并行池处理的数据不会以任何可预测的顺序处理。如果你需要处理结果按特定顺序排列,那么这个方法可能不适合你。

你处理的数据也需要是 Python 知道如何“序列化”的类型。幸运的是,这些类型是相当常见的。来自官方 Python 文档:

-

None、True和False -

整数、浮点数、复数

-

字符串、字节、字节数组

-

包含仅可序列化对象的元组、列表、集合和字典

-

在模块顶层定义的函数(使用

[def](https://docs.python.org/3/reference/compound_stmts.html#def),而不是[lambda](https://docs.python.org/3/reference/expressions.html#lambda)) -

在模块顶层定义的内置函数

-

定义在模块顶层的类

-

类的实例,其

[__dict__](https://docs.python.org/3/library/stdtypes.html#object.__dict__)或调用[__getstate__()](https://docs.python.org/3/library/pickle.html#object.__getstate__)的结果是可序列化的(有关详细信息,请参见序列化类实例部分)。

喜欢阅读关于技术的内容吗?

在twitter上关注我,了解最新最酷的 AI、技术和科学!

简介: George Seif 是一名认证技术专家和 AI/机器学习工程师。

原文. 经授权转载。

相关:

-

5 个“干净代码”技巧将显著提升你的生产力

-

数据科学家需要了解的 5 种聚类算法

-

为你的回归问题选择最佳机器学习算法

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

更多相关内容

以几乎没有费用的代价获得大学级认证

原文:

www.kdnuggets.com/get-university-level-certified-for-next-to-nothing

图片来自 DALL-E

不是每个人都有奢侈的条件去上大学。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

首先,费用高昂——这是人们决定不上大学的最大因素。第二,很多人对生活没有明确的方向,在年轻时做出这样的决定可能很困难。

如果你曾经遇到这种情况,或者现在处于这种情况,但你仍然想提升自己以获得你想要的工作,而不必支付疯狂的学费——这篇文章就是为你准备的。

哈佛大学 - CS50s

哈佛大学是一所著名且先进的大学。我们在电影、老师等地方听说过他们。令人惊讶的是,你现在可以以极低的价格开始你的学习之旅。

当你注册免费审计课程时,这些课程是免费的。然而,如果你希望完成作业并获得认证,你将需要支付一定费用。但这个费用远低于学费——在 50 到 300 美元之间。

那么课程是什么呢?!

CS50 的计算机科学导论

链接: 计算机科学导论

如果你是一个想要开始数据职业但由于费用问题犹豫不决的人——这就是为你准备的。

在这门计算机科学导论课程中,你将学习编程和计算机科学的艺术。你将开拓思维,学习如何以算法思维解决编程问题。你将涉及抽象、算法、数据结构、软件工程、网络开发等概念。

这还不止于此!

你还将熟悉编程语言,如 C、Python、SQL、JavaScript 和 HTML。

你将与来自不同背景的志同道合的学习者互动,到最后能够开发和向同伴展示你的最终项目。

CS50 的 AP 计算机科学原理项目

链接: AP 计算机科学原理课程

入门课程不够吗?

别担心 - 了解 AP 计算机科学原理课程,其中还包括“计算机科学导论”和另一个深入的“技术理解”课程。在“技术理解”课程中,你将学习互联网、多媒体、安全、网页开发和编程。

本课程的重点是它面向高中生。了解虽然对科技专业人员的需求很高,但年轻人因学费昂贵而无法轻易进入该行业。

这就是该计划的作用,你可以以折扣价格£369(撰写时价格)获得最先进的大学资源和知识。

如果你不是高中生但仍希望参加这些课程,你需要单独注册:

-

链接: 计算机科学导论

-

链接: CS50 的技术理解

CS50 的《商务专业人员计算机科学》

链接: 商务专业人员计算机科学

假设你不想成为软件工程师或数据科学家,并且你当前享受你的角色。你可以是经理、产品经理或创始人,但鉴于科技行业的发展趋势,如果你能了解计算机科学的世界将会很好。

在《商务专业人员计算机科学》课程中,你将采用自上而下的方法,学习与计算机科学相关的科技行业的高级概念和设计决策。

你将重点关注的主要领域包括计算思维、编程语言、互联网技术、网页开发、技术栈和云计算。

CS50 的《Python 编程入门》

链接: Python 编程入门

或许你想从一开始就直接入门,开始学习编程。

CS50 的《计算机科学导论》课程更侧重于计算机科学及不同的语言。而在《Python 编程入门》中,你将学习最受欢迎的通用编程语言、数据科学和网页编程。

你将学习如何阅读和编写代码,查找和修复错误,提取数据,编写单元测试。学习函数、参数、变量、类型、条件语句、布尔表达式等。你不需要任何编程经验即可参加本课程。

本课程包含的练习是现实世界的编程问题,因此你可以对作为 Python 程序员的世界有一个真实的了解。

总结

就是这样。4 门课程,虽然非常相似,但针对的是不同的群体和不同的目标。一旦你对自己想走的路径有了清晰的理解,你将知道你需要哪个具体的课程来提升技能,争取到你想要的工作!

Nisha Arya 是一名数据科学家、自由撰稿人,以及 KDnuggets 的编辑和社区经理。她特别感兴趣于提供数据科学职业建议或教程,以及围绕数据科学的理论知识。Nisha 涵盖了广泛的话题,并希望探索人工智能如何有助于人类寿命的延续。作为一个热衷学习者,Nisha 寻求拓宽她的技术知识和写作技能,同时帮助指导他人。

更多相关话题

获取数据科学职位比以往任何时候都更加困难 - 如何将这一点转变为你的优势

原文:

www.kdnuggets.com/2020/10/getting-data-science-job-harder.html

评论

由 库尔蒂斯·派克斯,AI 作家。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 部门

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 部门

照片由 马丁·佩奇 在 Unsplash 上拍摄。

在撰写这篇文章时,由于我在上一家公司因为 Covid-19 的影响而遇到困难,我目前正在寻找新的数据科学家职位。

这次,我注意到情况比我上次求职时要困难得多,但与其利用这些挑战来延长我们成为数据科学家的梦想或在最坏的情况下放弃它们,不如我努力更好地理解这些挑战,以便找到一些解决方案,使其对我和你们最有利!

奇异的职位要求

这似乎是我与数据科学求职者讨论时的一个共同话题 —

现在没有人感到自己有资格了。

许多数据科学职位描述未能传达所广告职位的实际要求。

其主要影响之一是,那些根据职位描述优先考虑个人和技术技能的有志数据科学家可能会对履行角色的要求产生误解。另一个问题是,招聘人员会收到许多不符合要求的申请。

根据 杰雷米·哈里斯 的一篇精彩文章《数据科学职位发布的问题》,职位描述可能显得难以理解的原因有很多,关键在于你需要区分你所在的职位属于哪个类别:

-

解决问题的方式有很多,因此很难为职位描述缩小范围。

-

新的数据科学团队可能会鼓励人们成为全能型人才,这在职位描述中也有所体现。

-

公司缺乏了解他们所面临的问题以及解决这些问题的人应该具备哪些能力的经验。

-

由招聘人员编写。

解决方案

虽然这需要你的一些洞察力,但识别那些看似过于夸张的职位描述潜在原因是重要的,因为某些情况可能对你的数据科学家成长有害,比如成为万事通。

克服这一挑战的一个好方法是承认职位描述只是公司的一份愿望清单,他们希望聘请一个他们认为有能力解决实际问题的人。

就此而言,务必以一种让他人(公司)认为你具备解决他们挑战的能力的方式展示你的能力。此外,如果你满足任何职位描述的至少 50%的要求,那么你可能是合格的,应该尝试申请该职位——如果你完全符合职位描述的 100%,你可能会显得过于资深。

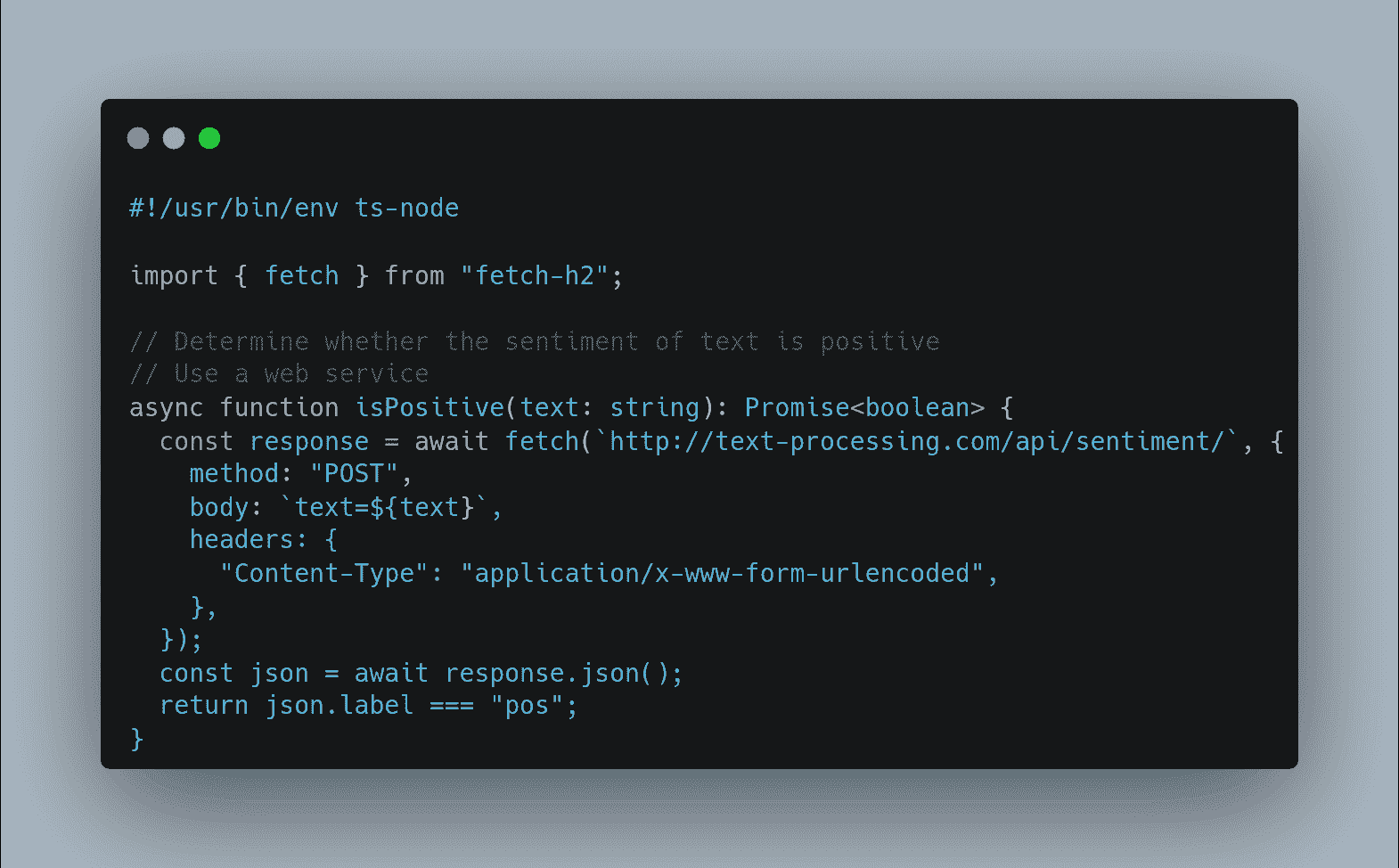

数据科学正变得越来越生产化

能够启动一个 Jupyter Notebook 并进行一些可视化,然后建立一个模型在过去曾有效,但在我看来,这已不足以让你引起关注。

Jupyter Notebooks 在进行实验时非常有用,但当你进入现实世界时,有一个阶段我们会超越实验阶段。我认为每个数据科学家都应该知道如何启动一个 Jupyter Notebook,但随着数据科学变得更加生产化,能够编写生产级代码的数据科学家将获得额外的加分,因为这样可以节省成本和时间。

这里有三个原因说明每位数据科学家都应该知道如何编写生产级代码:

-

数据科学家与工程师之间的沟通可能会出现信息丢失。

-

消除了过程中的延迟。

-

一石二鸟,因为一个人能做两个人的工作——这让你更有价值。

解决方案

尽管有争议,我相信数据科学家和软件工程师的技能在面对产品的数据科学应用时正在趋同,因此更多的数据科学家应该学习软件工程最佳实践。

如果你已经知道如何编写生产级代码,你可能会想查看Schaun Wheeler的一篇名为“生产化数据科学”是什么意思?的文章,它非常出色地总结了数据科学生产化中超越代码层面的系统最佳实践——这是一篇非常有趣的阅读。

“‘在生产中’意味着它是从业务到客户的管道的一部分。[...] 在数据科学中,如果某件事在生产中,那么它就处于将信息放在被消耗的位置上的路径上。”

竞争

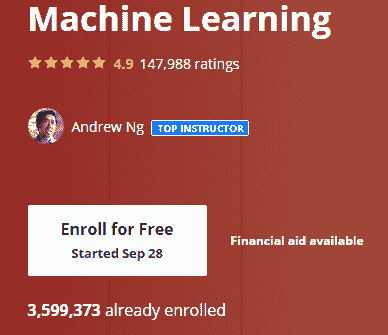

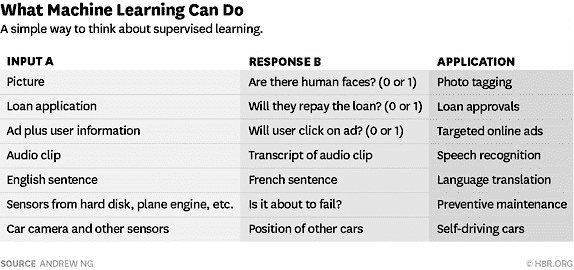

数据科学是地球上增长最快和最具前景的技术之一,很多人纷纷更新技能,争取成为数据科学家。为了证实这一点,自开设以来,超过 350 万人已报名参加安德鲁·吴的机器学习课程(这是数据科学的重要组成部分)。

这是 21 世纪最吸引人的工作是有原因的。

现在越来越多的人试图进入这一领域,因此工作竞争非常激烈。然而,这不应成为你决定不去寻找工作的理由!

解决方案

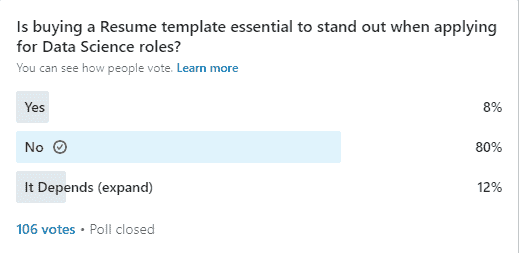

是的,我们确实需要做更多的事情来脱颖而出。然而,根据我在 LinkedIn 个人资料上进行的最近一次调查,这并不一定意味着拥有最华丽的简历。

当然,拥有一个出色的作品集是脱颖而出的好方法,但在提高获得机会的几率方面,似乎没有什么能超越主动联系招聘经理或在你申请的地方担任高级角色的数据科学家。

LinkedIn 使得找到在特定公司工作的人员变得非常容易,它应该成为求职过程的一部分。

结论

难以找到数据科学工作不应成为你不去寻找工作的理由。任何工作都会面临许多挑战,找到工作只是资格阶段,以验证雇主是否相信你能应对挑战,以及你是否相信雇主是你希望加入的团队。始终寻求自我提升,不要等到“准备好”才去申请,因为你可能永远不会感到准备好,不要害怕被拒绝或拒绝那些与你的目标不一致的公司。

原文。经许可转载。

个人简介: Kurtis Pykes 对利用机器学习和数据科学的力量帮助人们变得更高效和有效充满热情。

相关:

更多相关主题

我没有被聘为数据科学家。因此,我寻求了有关谁正在被聘用的数据。

原文:

www.kdnuggets.com/2019/09/getting-hired-data-scientist-sought-data.html

评论

由 Hanif Samad, 数据科学家

获取关于我想成为的数据。(图片来源于 David S.A 来自 Pixabay)

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 需求

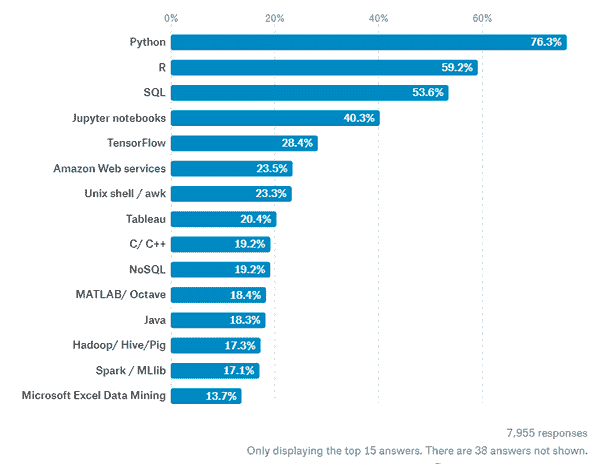

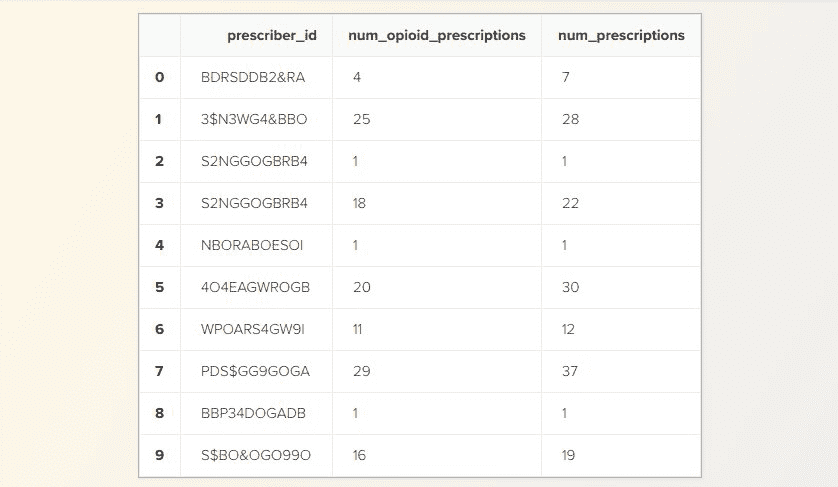

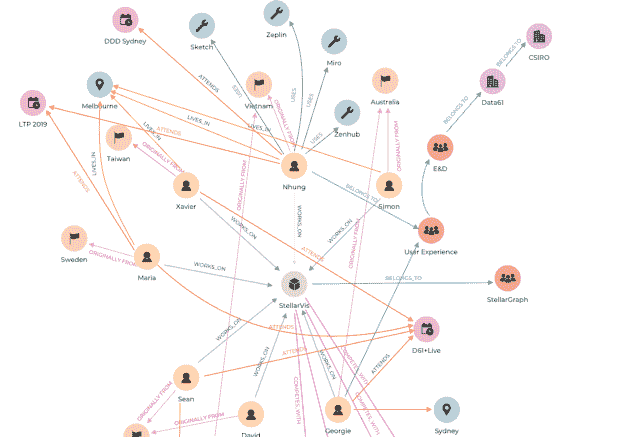

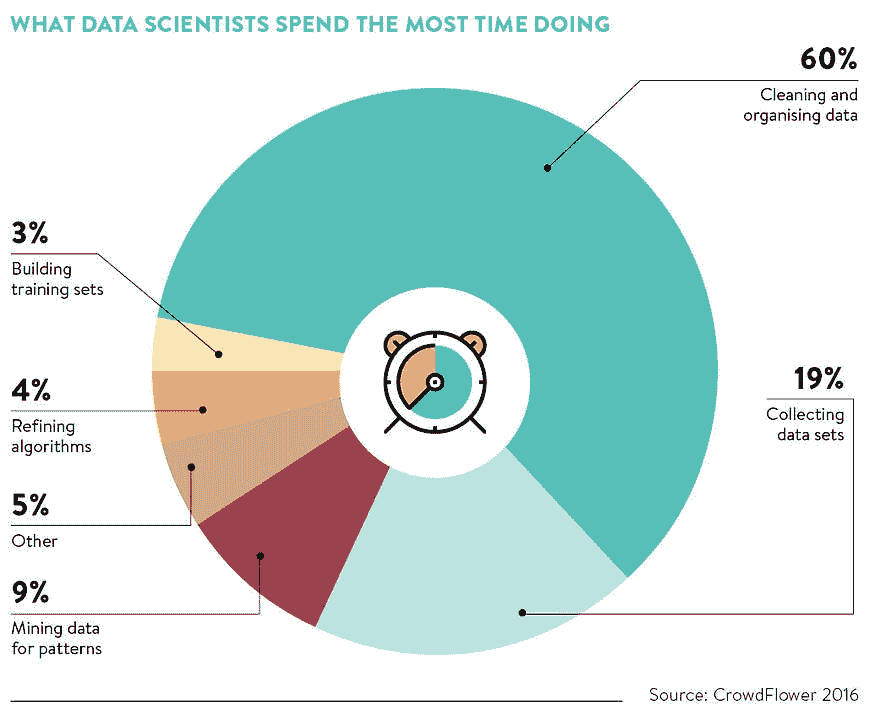

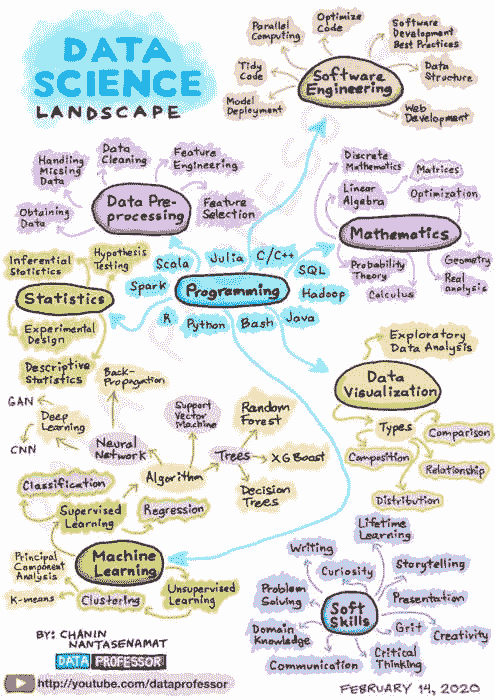

在我撰写这篇文章时,我的《Towards Data Science》主页上每一篇热门文章都在讨论如何应用或学习数据科学中的某项特定技能。每一篇都是如此。最上面的是一些大方向的技能,比如 如何与利益相关者合作 和 如何成为数据工程师,接下来是一系列非常具体的技能,包括关于 批量梯度下降与随机梯度下降的区别、多类文本分类、Faster R-CNN 等等。作为一个专注于“分享概念、想法和代码”的 Medium 平台,看到这些学习资源在《Towards Data Science》的追随者中如此受欢迎并不令人惊讶,他们可能正在进行数据中心的项目和职业。但对于一个希望优先考虑关键内容的新手来说,这可能会迅速变得令人困惑。是否应该训练成为一个 Kaggle 大师?在图像识别或自然语言处理领域应用神经网络? 两者都不是?那 Kubernetes 呢?学习如何部署模型,因为这完全是关于 将模型投入生产 的?而 Hadoop 到底发生了什么呢?

我的 LinkedIn 个人资料将我描述为一名软件工程师和数据科学家。根据我的工作经历,这对中的前半部分可能更准确,因为我只曾在数据科学领域获得短期合同工作。由于自愿从早期的医疗统计学家职业中转行,我对在新加坡(我的工作所在地)找到全职数据科学家职位的尝试感到烦恼。我看到一些只有本科学位的熟人很容易获得职位,而我的医学统计硕士学位和通用组的网页开发证书似乎并没有带来我所希望的那一击(在Conway 韦恩图中,或者说是我认为的两个中的三个)。我对一些“我是如何获得这样的职位”类型的自我庆祝建议也变得越来越没有耐心,毕竟这些建议的样本量仅为 1。

我意识到的是,我把数据科学的实践与成为数据科学一部分的策略混为一谈。令我惊讶的是,这两者原来并不相同。像大多数新手一样,我从杂乱无章的博客文章、数据科学职位要求的部分以及该领域的传闻中拼凑信息。这些来源以技能为重心,更不用说批评性和道德化的语气**,认为数据科学家可以并且应该学习一大堆东西,这讽刺地使初学者陷入了无休止追逐最新技能的循环,而最有效的策略可能是先迅速找到一个相关的数据职位,然后再在工作中学习技能。

丹尼尔·卡尼曼会称这是一个受到可得性启发式影响的例子。我认为我需要获得 10 种早餐前不可能掌握的技能,因为这正是我对数据科学家形象的理解,而没有停下来考虑到可能有成千上万的数据科学家已经成功被聘用,而他们中的大多数(按定义)并不是超级明星。我需要的不是另一篇关于数据科学家所需顶尖技能的自我陶醉的帖子,而是有关成功转行数据科学的人的实际数据。他们之前在做什么?

我需要的是……有关成功转行数据科学的人的实际数据。

数据科学家的数据

尽管有一些大规模的调查公开可用,关于谁是数据科学家的问题,我发现这些数据存在几个问题:

-

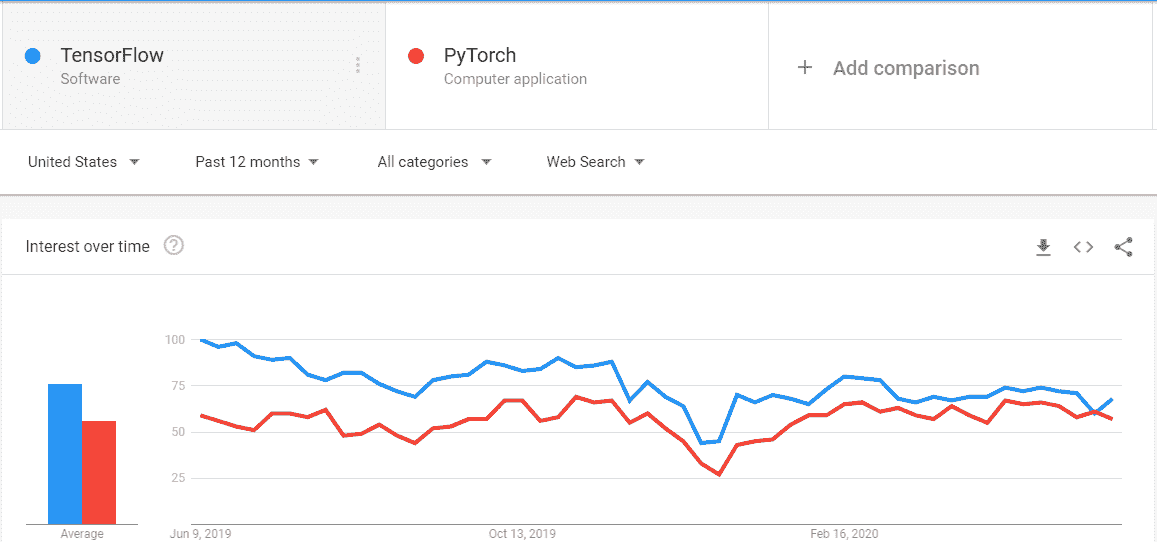

自我选择偏差。 由于这些调查与某些类型的组织有关,并且完全是自愿的,样本中可能会过度代表某种受访者群体。我发现 Kaggle 数据科学调查中热衷于 TensorFlow 的实践者过于突出,这可能与数据科学在商业中实际的实践方式非常不同。

-

受访者偏差。 由于完全是自愿的,并且对受访者没有反馈(你虚报自己不会受到任何后果),个别受访者可能更少受到打击来夸大他们的头衔、教育背景或其他数据。

-

市场代表性。 我的主要动机是找出在我的目标市场(新加坡)中实际被成功聘用为数据科学家的人的个人资料。从我所见,调查数据充斥着数据科学的志向者(主要是学生),关于在新加坡的实际数据科学家的具体数据很有限。

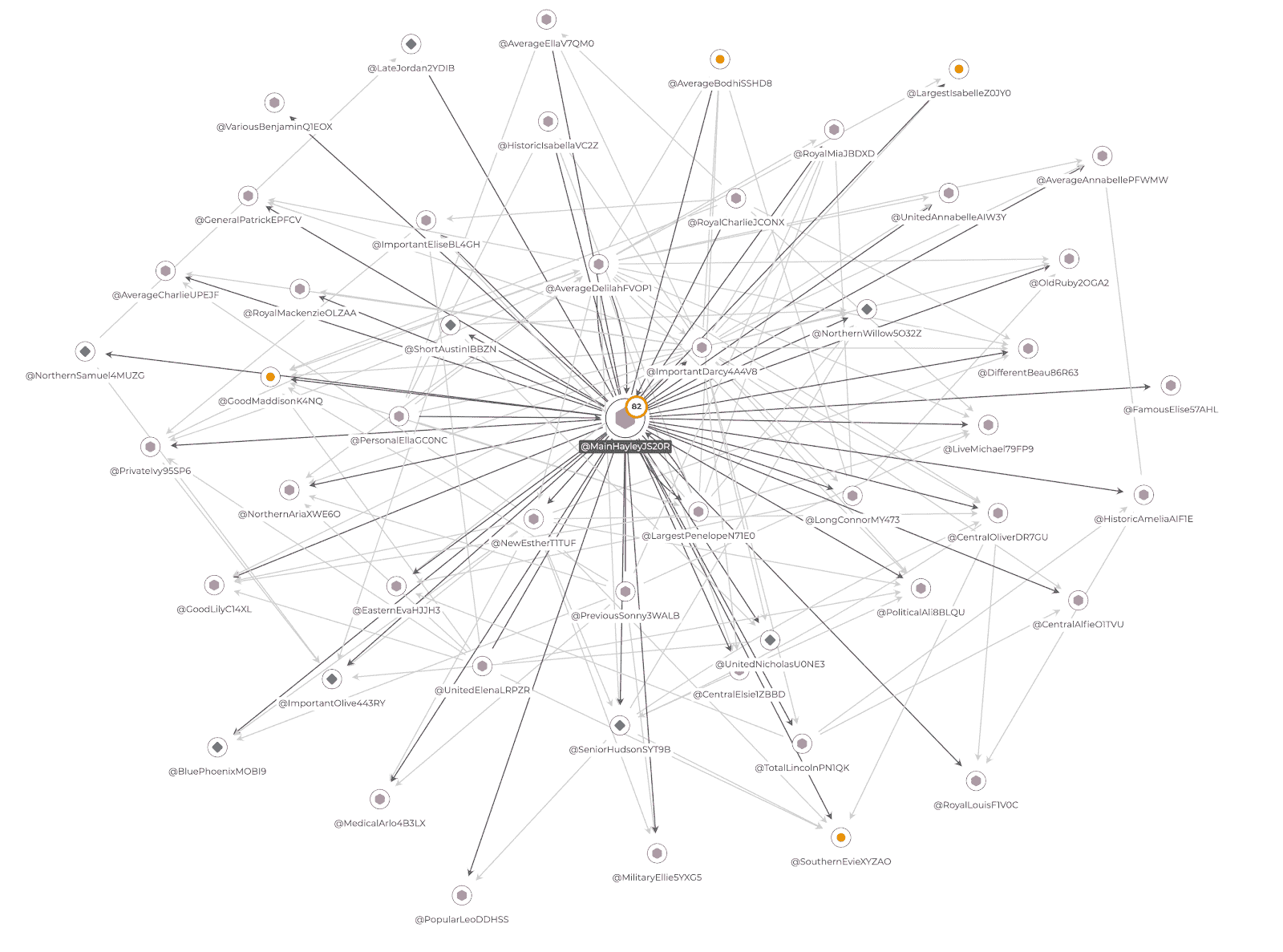

我毫不怀疑LinkedIn是我需要获取数据的地方。虽然可能仍存在一些选择偏差(LinkedIn 的算法可能没有向我展示一个真正随机的数据科学家样本¹),但我看到它在求职者和招聘行业中的广泛应用,作为内建的检查点,可以最大程度地减少受访者偏差并确保个人资料的真实性。LinkedIn 个人资料在某种程度上受到实际就业市场的压力。

此外,LinkedIn 允许我在搜索查询中指定我希望分析的个人资料地理位置,如果需要,可以限制在新加坡。但只有一个问题:获取数据本身。

爬取数据:别说我没警告过你

关于爬取 LinkedIn 数据的合法性曾有一些争议。虽然最近的判例确定这些信息是公开的,因此任何人都可以提取,但法律地位远未确定。无论如何,当你尝试爬取 LinkedIn 数据时,会遇到几个障碍:

-

你将违反 LinkedIn 的用户协议。尽管这些合同的可执行性仍然模糊,但你有可能因违反服务条款而面临账号被暂停的风险。

-

LinkedIn 对你可以点击的个人资料数量设置了上限,你的小 selenium 机器人会很快达到这个上限(特别是如果你花很多时间只是调试抓取器的话)。

-

LinkedIn 一直在悄悄地频繁更改其 HTML 标签,使得基于任何当前标签属性的抓取有效期相当短。

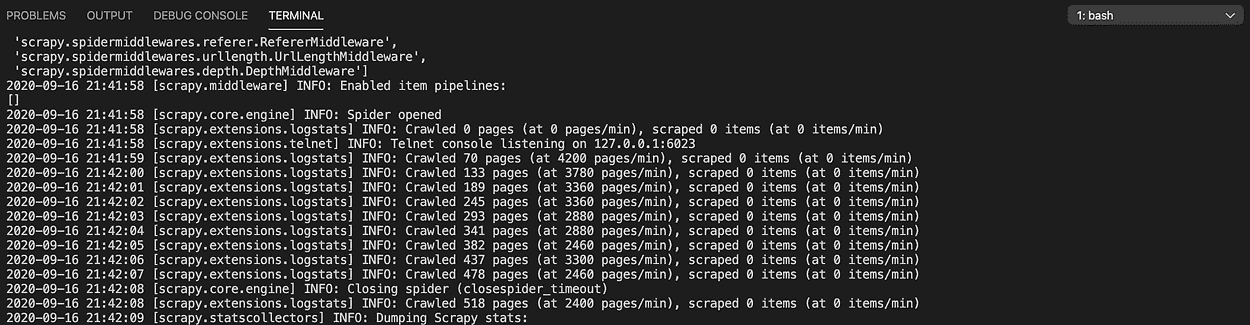

可以说,我编写的抓取器在标签被替换并且代码过时之前,仍然有足够长的时间来获得一个相当大的数据集(1027 个 LinkedIn 个人资料)。(如果你想了解更多关于代码的内容,欢迎随时联系我²)。

使用搜索查询“Data Scientist AND Singapore”,我从 LinkedIn 的 People 部分提取了尽可能多的个人资料。我认为相关的只有三个数据元素:当前职位(职位名称和雇主名称)、教育背景(最近的学校和研究领域)和经历(职位、组织以及以前角色的持续时间)。将自己限制在这三个元素不仅节省了编写和调试抓取器的时间,还尝试减少不遵守 LinkedIn 服务条款可能带来的责任范围。

在筛选掉数据科学志向者、学生以及信息不足的个人资料后,我剩下了 869 个数据科学家个人资料。现在我可以问:目前在职的数据科学家有哪些共同特征?

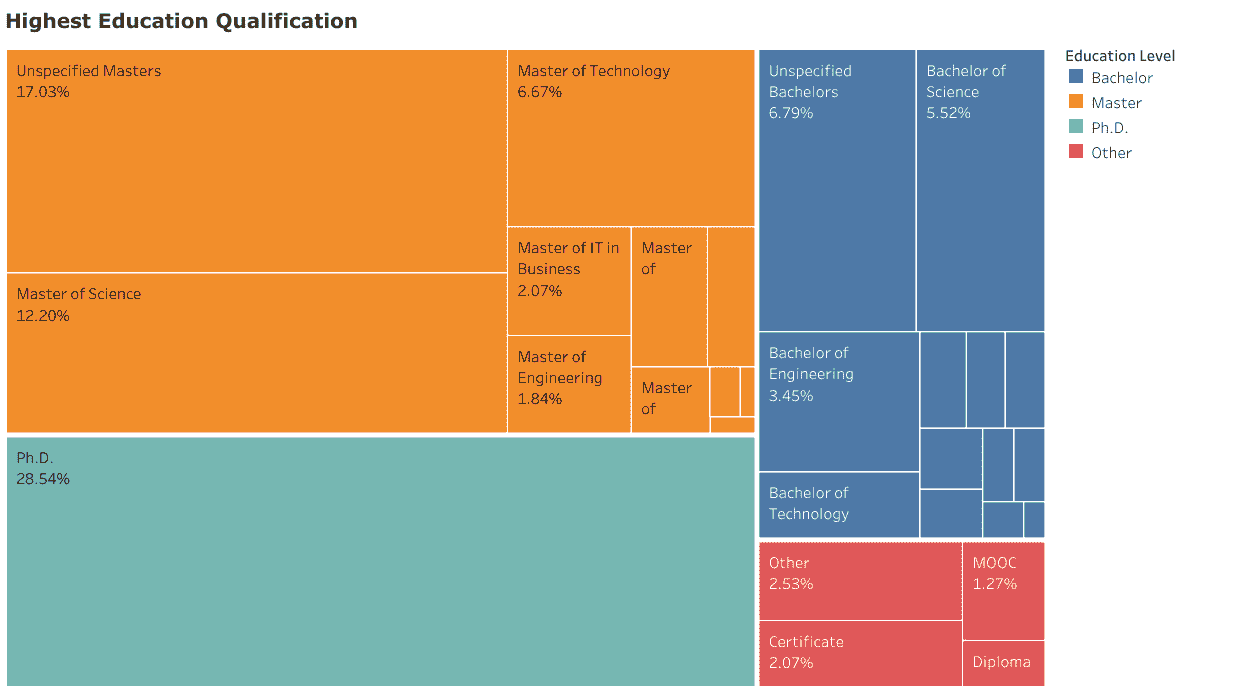

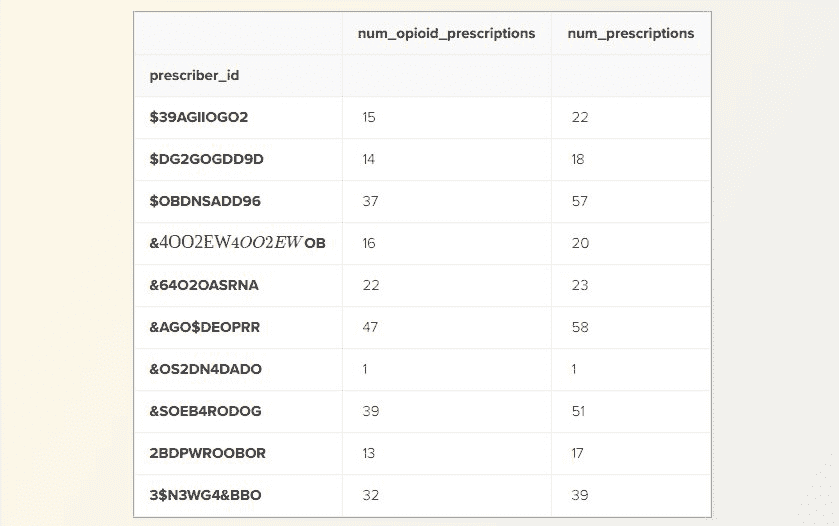

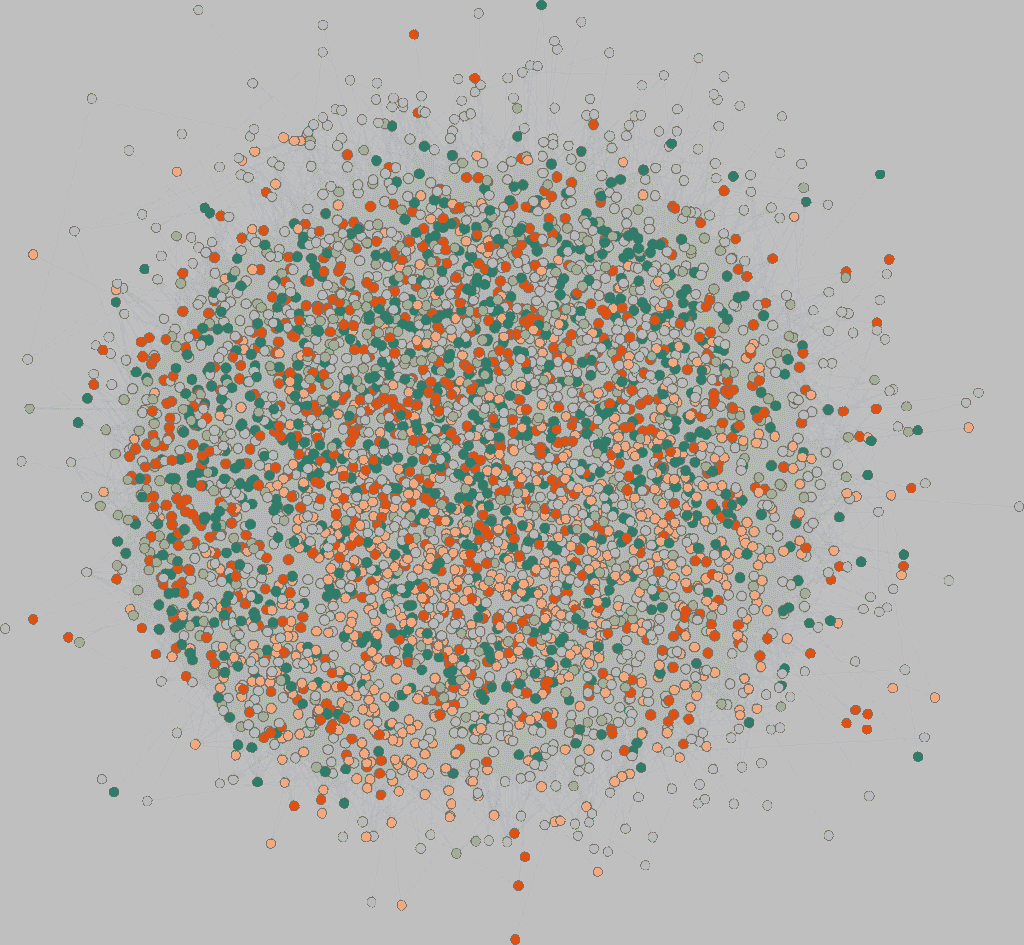

发现 1:大多数数据科学家拥有研究生学位

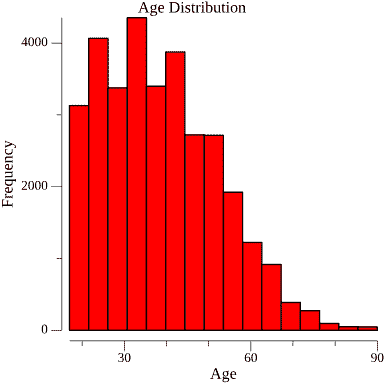

从数据中最引人注目的发现,并且已在其他地方得到证实,是大多数(73%)在职的数据科学家拥有超过学士学位的学位。一个多数(44%)拥有硕士学位,而博士学位在数量上超过了学士学位(29% 对 21%)。仅有 6% 的数据科学家报告了一些形式的 MOOC、训练营或非传统认证作为其主要资格。这表明,潜在雇主信任高级学位所提供的信号,以满足数据科学家职位的复杂要求。这也否定了数据科学训练营或其他非传统认证项目可以替代这些学位的观点。

LinkedIn 上一组数据科学家报告的最新教育资格

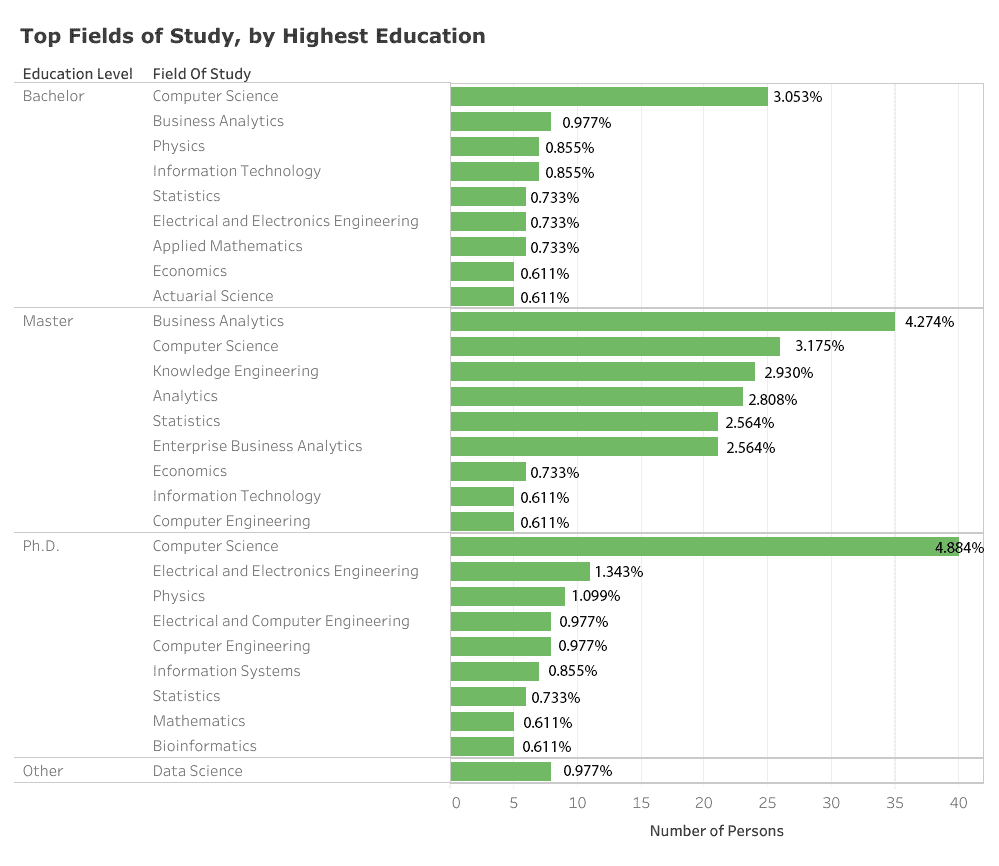

发现 2:计算机科学与工程,以及商业分析,主导了研究领域

数据中在计算机科学、数学与统计学以及工程学科构成数据科学职业基础的三位一体的普遍观念在某种程度上得到了验证。然而,存在差异。计算机科学远远超过所有其他单一领域,占所有研究学科的 14%。工程学是一个多样化的类别,包括化学、电子电气以及所谓的知识工程等不同领域,累计占研究学科的 22%。数学与统计学也以各种形式出现,包括应用数学、数学物理和统计学及应用概率,但似乎不如前者重要,累计只占研究学科的约 12%。在数据科学教育领域,商业分析及其他分析领域是一个意外的赢家,它们共同占有 15%的学科。这实际上是报告中最高学历为硕士学位的数据科学家的排名第一领域。

其他高度排名的领域包括物理学(3.5%)和信息技术(2.2%)。出现的图景是,虽然计算和工程相关领域在成为数据科学家的过程中持续相关,但数学和统计学正被以商业为导向的新兴分析领域(及其变种)所掩盖。尽管如此,还有非常长尾的其他领域代表了目前数据科学家所追求的广泛学科多样性。

LinkedIn 上的数据科学家样本报告的主要研究领域(尾部分布隐藏)。百分比是所有层级研究领域中的占比

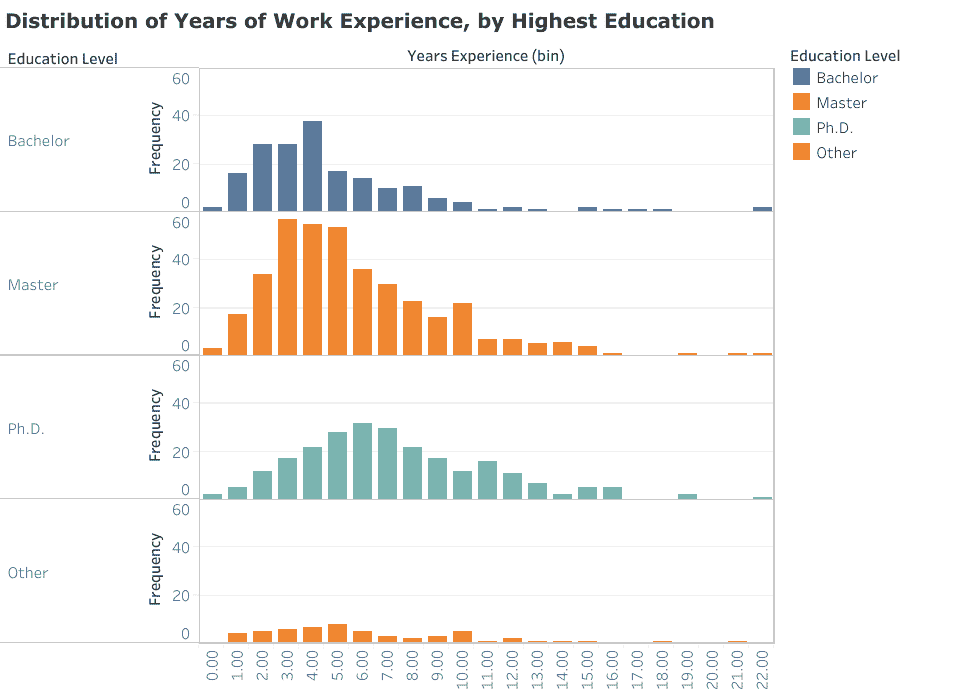

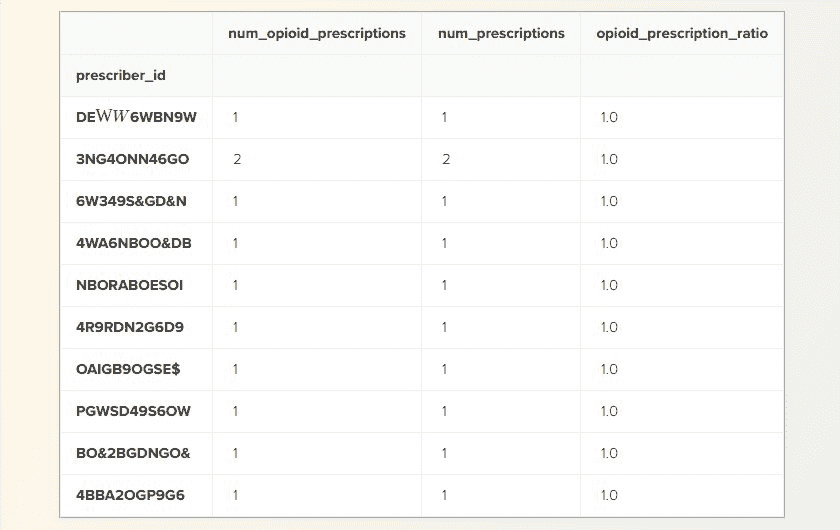

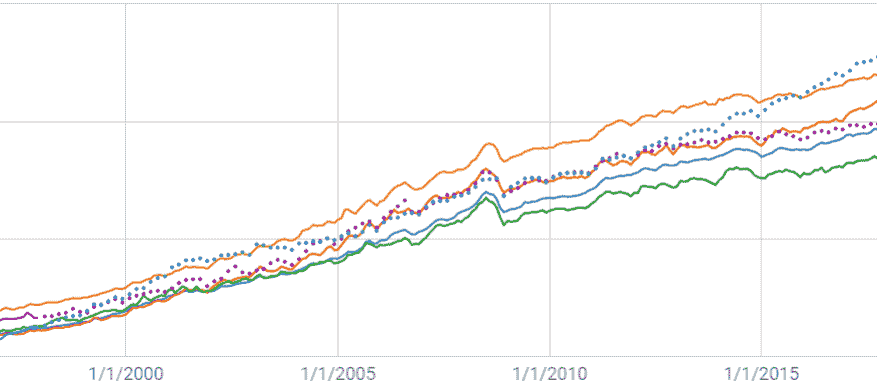

发现 3:目前在职的数据科学家往往处于职业中期

在这个样本中,数据科学家的报告工作经验的模态年份在4–6 年之间,具体取决于其最高学历水平。这看起来非常明显,但值得重申的是,大多数数据科学家并不是从英雄式的大规模开放在线课程中直接毕业的大学生,这一点有时在关于如何进入该领域的博客文章中给人的印象。与其他开放职位一样,填补这些职位的平均人选往往是有经验的人员。

作为额外的趣闻,没有报告非传统认证程序的数据科学家是新聘用的,他们都有至少 1 年的工作经验。

LinkedIn 上的数据科学家样本报告的累计工作经验年限

发现 4:大多数数据科学家职位是新的

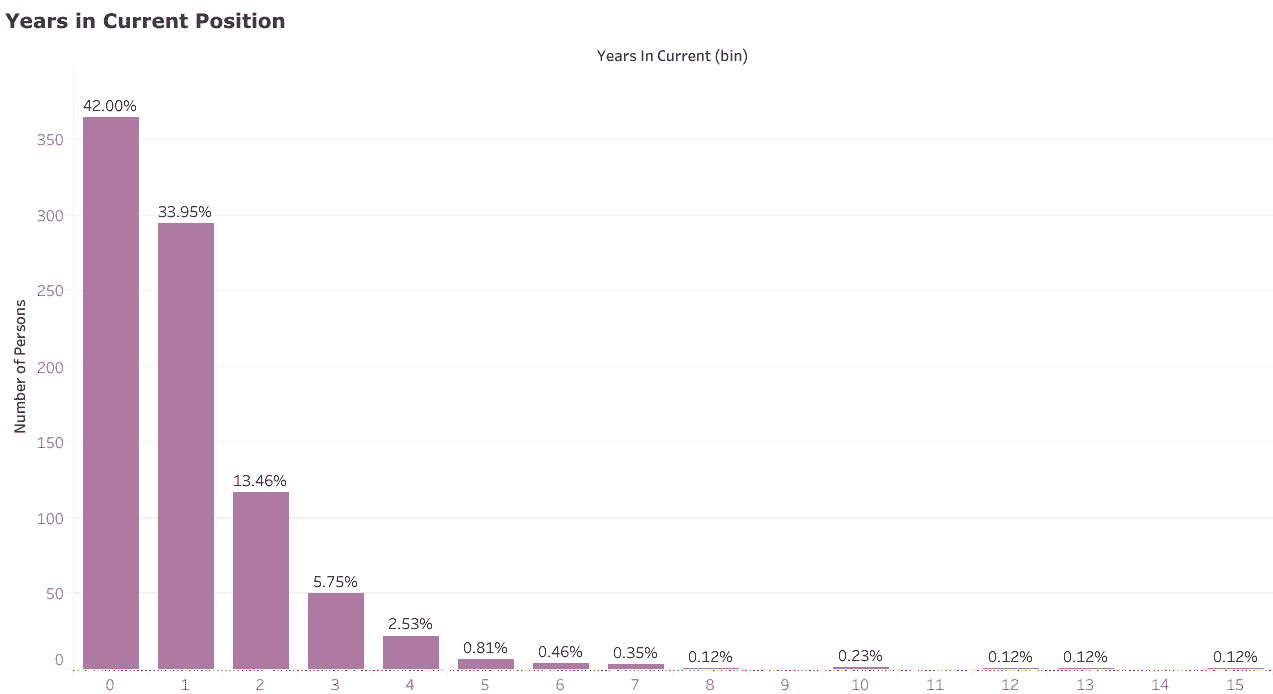

另一个支持上述发现的数据点是,大多数数据科学家(76%)在当前职位上待了不到 2 年,其中有 42%的人待了不到一年。这表明,尽管大多数数据科学职位相对较新,但填补这些职位的人已经在求职市场上待了一段时间。

来自 LinkedIn 的样本数据显示的数据科学家在当前角色中的年限。‘0’表示 0–1 年(不包括在内)

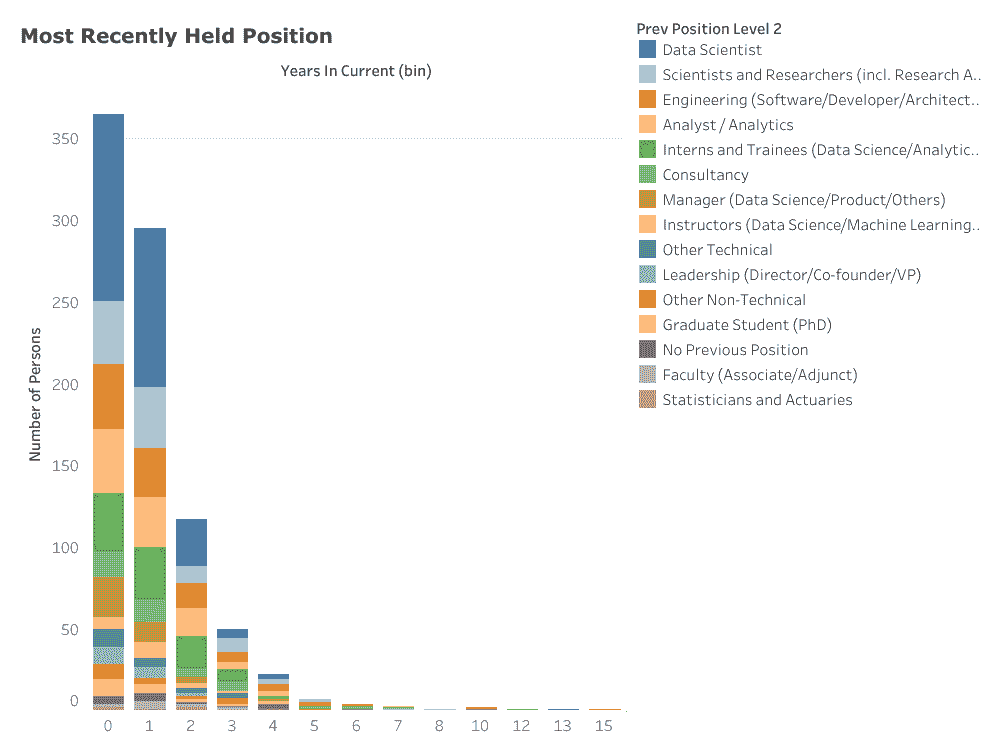

发现 5:研究员、软件工程师、分析师或数据科学实习生?很好。现有的数据科学家?更好。

了解数据科学家在当前职位之前做了什么是我想要获得的核心见解。也许并不令人惊讶(考虑到样本中大多数人拥有研究生学位),相当一部分(11%)报告说他们之前是科学家或研究员(包括研究助理和研究员)。另一个相当的部分(11%)报告说他们曾从事某种形式的软件工程职位,包括开发人员和解决方案架构师。还有一部分数据科学家之前是分析师(11%),包括数据分析师和系统分析师。有趣的是,实习生和培训生(11%)也是通往全面数据科学家角色的一个可行的前身,他们通常是数据科学或分析实习生。其他高度排名的前一个职位包括咨询(5%)、各种管理职位(5%)和数据科学讲师(3%)。

毫无悬念,已经成为数据科学家的人在争取新的数据科学职位时最具优势。样本中有 28%的人报告说他们的前一个职位是数据科学家。此外,这种 incumbency 优势似乎在增加——例如,1 年或更短时间内上任的雇员中,有 29%的人报告说他们的前一个职位是数据科学家,而在工作了 3 至 4 年的雇员中,仅有 12%报告说他们的前一个职位是数据科学家。

对我来说,值得注意的是统计学家和精算师在现有数据科学家的前一个角色中排名最末。

来自 LinkedIn 的样本数据显示的数据科学家最近的职位,按在当前角色中的年限分组。‘0’表示 0–1 年(不包括在内)

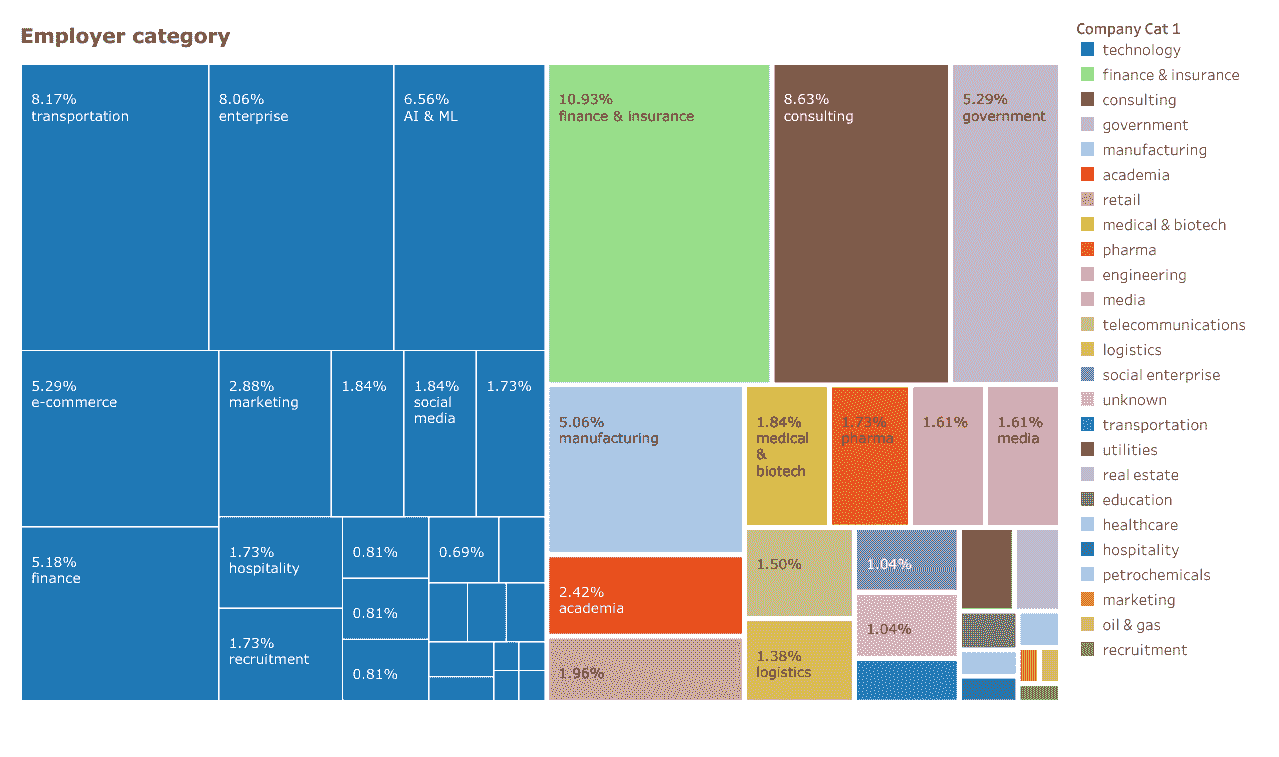

发现 6:一半的数据科学家职位来自非科技公司

尽管资金充足且成熟的科技公司(如谷歌或亚马逊)往往成为数据科学家最向往的地方,但值得注意的是,在这个样本中,几乎一半(49%)的数据科学家来自那些不直接创造技术产品的地方。这些地方通常是金融和保险(11%)、咨询(9%)、政府(5%)、制造业(5%)和学术界(2.4%)。在科技类别中,代表性较强的行业包括运输(8%,主要由于新加坡的打车应用 Grab)、企业(8%,包括 IBM、SAP 和微软)、电子商务(5%)和金融(5%)。在这里,我们可以看到像 DBS 银行这样的金融机构招聘数据科学家与像Refinitiv这样的金融科技公司使用数据科学为这些机构创造技术产品之间的区别。

我将某些科技公司标记为AI & ML(6.5%)。这包括像DataRobot这样有实际自动化机器学习产品记录的公司,也包括像Amaris.AI这样的新兴公司。

如果数据科学家的非技术公司与技术公司之间的分界恰好符合其他地方提出的Type A 与 Type B 数据科学家分类,那将是太过便利了,因为这表明工作市场(至少在新加坡)在提供机会方面相当公平。不过,这将是一个有趣且有价值的假设进行验证。

从 LinkedIn 上的数据科学家样本报告的雇主类别

结论:这对我意味着什么?

如果你对获得数据科学家职位很认真,与其为从随机博客文章中获取所需技能而烦恼,不如更好地了解谁确切地在这个领域取得了成功。最常见的特征组合可能是拥有计算机科学、工程、数学或分析学的硕士或博士学位;在行业中工作了约 4-6 年;并且曾在之前的工作中担任研究员、软件工程师、分析师或数据科学实习生²。**然而,不要犯认为这种组合构成了大多数数据科学家的谬误,因为这代表了概率的乘积(这些概率可能本身并不独立)。正如这篇文章和其他研究所指出的那样,数据科学家的背景非常多样,比软件工程师等其他职位更为广泛。然而,出现的趋势是某些特定的个人资料确实更受青睐,而你简历中“突出”的程度可能与其偏离这些个人资料的程度成正比。

最后,我要指出的是,尽管数据对从非传统认证如 MOOCs 和训练营获得的技能的必要性保持沉默,但它确实对这些技能的足够性有所暗示:它们显然是不足够的。研究生学位是你作为数据科学家前景的更好指标。这并不是说获得这些技能不重要;数据科学发展迅速,许多重要的算法和技术不会被传统学术课程涵盖。这只是暗示获得特定技能可能是在满足除你作为数据科学家即时可雇佣性之外的其他需求。

大量关于数据科学的专业课程层出不穷,这些课程似乎旨在利用那些一直被告知需要特定技能组合才能取得突破的求职者的不安。了解谁实际上被聘为数据科学家会给这些存在性考虑带来严酷的现实冲击。

备注

¹ 如果有理由质疑数据的有效性,那就是怀疑样本的代表性。LinkedIn 仅显示与你有至少 3 层关系的个人资料,并且这些个人资料可能经过非随机算法排序(我的爬虫按顺序提取了顶部的个人资料结果)。可以说,我的网络中可能没有足够的中心节点来获得真正随机的数据科学家样本。获取来自其他 LinkedIn 账户的更多个人资料并进行敏感性分析将对这个问题提供更多的见解。

² 本文中的所有可视化(以及更多)已被整理到一个名为“谁是新加坡的数据科学家?”的 Tableau 故事中。如果你对数据或代码有任何实质性问题,请参考本文的答疑部分,或写邮件发送至admin@hanifsamad.com。

更新 2019 年 8 月 5 日:似乎对我用来抓取数据的代码有相当大的兴趣。我目前正在准备一篇后续文章,与那些有兴趣的读者分享。敬请关注。

个人简介: Hanif Samad 是一位来自新加坡的统计学家、软件工程师和数据科学家。他专注于值得解决的问题。

原文。经许可转载。

相关:

-

如果你是从开发者转行数据科学,这里是你最好的资源

-

成为一名超级数据科学家的 13 项技能

-

从数据分析师成长为数据科学家的秘密武器

更多相关话题

开始自动文本摘要

原文:

www.kdnuggets.com/2019/11/getting-started-automated-text-summarization.html

我们的三大课程推荐

1. Google 网络安全证书 - 快速开启网络安全职业生涯。

1. Google 网络安全证书 - 快速开启网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织在 IT 领域

3. Google IT 支持专业证书 - 支持你的组织在 IT 领域

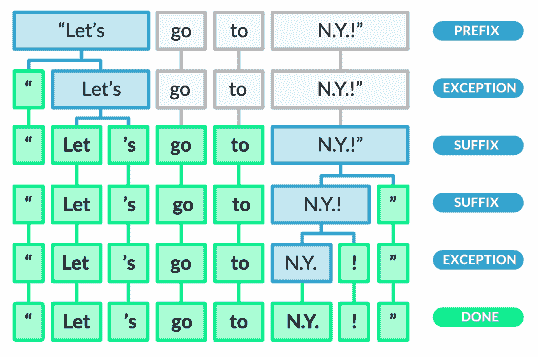

自动文本摘要是指使用某种形式的启发式或统计方法对文档或多个文档进行摘要。此处的摘要是指一个简化的文本,准确捕捉并传达我们想要摘要的文档中最重要和相关的信息。

摘要技术有两种分类:抽取式和生成式。我们将在此重点讨论抽取式方法,它通过识别文本中重要的句子或摘录并逐字复述这些内容作为摘要。不会生成新的文本;仅使用现有文本进行摘要。这与生成式方法不同,生成式方法使用更强大的自然语言处理技术来解释文本并生成新的摘要文本。

这篇文章将演示一个抽取式摘要过程,使用简单的词频方法,在 Python 中实现。在开始之前,请注意我们不会在这篇文章中花费太多精力进行数据预处理、分词、标准化等操作(类似于上次),也不会介绍任何能够轻松有效执行这些任务的库。我希望重点介绍文本摘要的步骤,略过其他重要的概念。我计划在这篇文章后续进行更多的跟进,并在过程中逐步增加我们自然语言处理任务的复杂性。

此外,例如,由于我们在这里进行了一些最小化的分词,你将会体会到何时进行分词,且更有效的处理方法可以作为读者的练习。

让我们明确一下我们要做什么:

-

处理文本输入(如一篇简短的新闻文章)

-

执行最小化的文本预处理

-

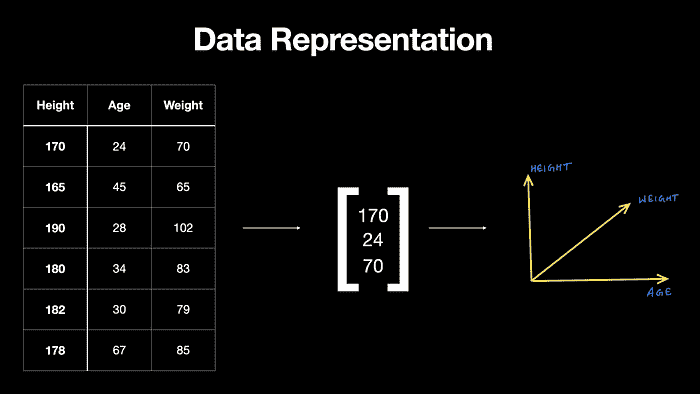

创建数据表示

-

使用这种数据表示法执行摘要

有多种文本摘要方法,如上所述,我们将使用一种非常基础的提取方法,这种方法基于给定文章中的词频。

由于我们几乎不依赖库,我们的导入语句很少:

from collections import Counter

from string import punctuation

from sklearn.feature_extraction.stop_words import ENGLISH_STOP_WORDS as stop_words

我们需要punctuation和stop_words模块来识别这些元素,以便在对单词和句子进行评分时确定它们的相对重要性。对于这个任务,我们不会认为标点符号或停用词“重要”。为什么?与语言建模任务相比,其中这些元素无疑是有用的,或者与文本分类任务相比,这些元素可能会有用,但很明显,包含频繁出现的停用词或重复的标点符号会导致偏向这些标记,对我们没有益处。我们有各种理由希望不排除停用词(任意删除它们应当避免),但这似乎不是其中之一。

接下来,我们需要一些文本来测试我们的摘要技术。我手动从 CNN 复制并粘贴了这篇文章,但你可以随意寻找自己的:

# https://www.cnn.com/2019/11/26/politics/judiciary-committee-hearing/index.html

text = """

The House Judiciary Committee has invited President Donald Trump or his counsel to participate in the panel's first impeachment hearing next week as the House moves another step closer to impeaching the President.

The committee announced that it would hold a hearing December 4 on the "constitutional grounds for presidential impeachment," with a panel of expert witnesses testifying.

House Judiciary Chairman Jerry Nadler sent a letter to Trump on Tuesday notifying him of the hearing and inviting the President or his counsel to participate, including asking questions of the witnesses.

"I write to ask if you or your counsel plan to attend the hearing or make a request to question the witness panel," the New York Democrat wrote.

In the letter, Nadler said the hearing would "serve as an opportunity to discuss the historical and constitutional basis of impeachment, as well as the Framers' intent and understanding of terms like 'high crimes and misdemeanors.' "

"We expect to discuss the constitutional framework through which the House may analyze the evidence gathered in the present inquiry," Nadler added. "We will also discuss whether your alleged actions warrant the House's exercising its authority to adopt articles of impeachment."

The Judiciary Committee hearing is the latest sign that House Democrats are moving forward with impeachment proceedings against the President following the two-month investigation led by the House Intelligence Committee into allegations that Trump pushed Ukraine to investigate his political rivals while a White House meeting and $400 million in security aid were withheld from Kiev.

The hearing announcement comes as the Intelligence Committee plans to release its report summarizing the findings of its investigation to the House Judiciary Committee soon after Congress returns from its Thanksgiving recess next week.

Democratic aides declined to say what additional hearings they will schedule as part of the impeachment proceedings.

The Judiciary Committee is expected to hold multiple hearings related to impeachment, and the panel would debate and approve articles of impeachment before a vote on the House floor.

The aides said the first hearing was a "legal hearing" that would include some history of impeachment, as well as evaluating the seriousness of the allegations and the evidence against the President.

Nadler asked Trump to respond by Sunday on whether the White House wanted to participate in the hearings, as well as who would act as the President's counsel for the proceedings. The letter was copied to White House Counsel Pat Cipollone.

"""

我说过我们没有进行分词吗?实际上,我们确实进行了分词,只是做得很差。但现在让我们不再关注这个问题。我们需要两个简单的分词函数:一个用于将句子分词成单词,另一个用于将文档分词成句子:

def tokenizer(s):

tokens = []

for word in s.split(' '):

tokens.append(word.strip().lower())

return tokens

def sent_tokenizer(s):

sents = []

for sent in s.split('.'):

sents.append(sent.strip())

return sents

我们需要单个单词来确定它们在文档中的相对频率,并分配相应的分数;我们需要单个句子来随后汇总每个单词的分数,以确定句子的“重要性”。

请注意,我们在这里使用“重要性”作为文档中相对词频的同义词;我们将每个单词的出现次数除以文档中出现频率最高的单词的出现次数。这种高频等于真正的重要性吗?假设它等于重要性是幼稚的,但这也是引入文本摘要概念的最简单方法。对我们这里的“重要性”假设感兴趣吗?可以尝试像 TF-IDF 或词嵌入这样的东西。

好的,我们开始分词吧:

tokens = tokenizer(text)

sents = sent_tokenizer(text)

print(tokens)

print(sents)

['the', 'house', 'judiciary', 'committee', 'has', 'invited', 'president', 'donald', 'trump', 'or', 'his', 'counsel', 'to', 'participate', 'in', 'the', "panel's", 'first', 'impeachment', 'hearing', 'next', 'week', 'as', 'the',

'house', 'moves', 'another', 'step', 'closer', 'to', 'impeaching', 'the', 'president.', 'the', 'committee', 'announced', 'that', 'it', 'would', 'hold', 'a', 'hearing', 'december', '4', 'on', 'the', '"constitutional', 'grounds', 'for',

...

'the', 'white', 'house', 'wanted', 'to', 'participate', 'in', 'the', 'hearings,', 'as', 'well', 'as', 'who', 'would', 'act', 'as', 'the', "president's", 'counsel', 'for', 'the', 'proceedings.', 'the', 'letter', 'was', 'copied', 'to',

'white', 'house', 'counsel', 'pat', 'cipollone.']

["The House Judiciary Committee has invited President Donald Trump or his counsel to participate in the panel's first impeachment hearing next week as the House moves another step closer to impeaching the President", 'The committee

announced that it would hold a hearing December 4 on the "constitutional grounds for presidential impeachment," with a panel of expert witnesses testifying', 'House Judiciary Chairman Jerry Nadler sent a letter to Trump on Tuesday

...

seriousness of the allegations and the evidence against the President', "Nadler asked Trump to respond by Sunday on whether the White House wanted to participate in the hearings, as well as who would act as the President's counsel for the

proceedings", 'The letter was copied to White House Counsel Pat Cipollone', '']

如果你在家跟着做,最好不要看得太仔细,否则你会看到我们简单的分词方法哪里失败了。继续...

现在我们需要计算文档中每个单词的出现次数。

def count_words(tokens):

word_counts = {}

for token in tokens:

if token not in stop_words and token not in punctuation:

if token not in word_counts.keys():

word_counts[token] = 1

else:

word_counts[token] += 1

return word_counts

word_counts = count_words(tokens)

word_counts

{'house': 10,

'judiciary': 5,

'committee': 7,

'invited': 1,

'president': 3,

...

"president's": 1,

'proceedings.': 1,

'copied': 1,

'pat': 1,

'cipollone.': 1}

我们糟糕的分词再次出现在上面的最终标记中。在下一篇文章中,我会向你展示一些可以替换的分词工具,以帮助解决这个问题。为什么不从一开始就这样做呢?正如我所说,我想专注于文本摘要的步骤。

现在我们有了单词计数,我们可以构建一个单词频率分布:

def word_freq_distribution(word_counts):

freq_dist = {}

max_freq = max(word_counts.values())

for word in word_counts.keys():

freq_dist[word] = (word_counts[word]/max_freq)

return freq_dist

freq_dist = word_freq_distribution(word_counts)

freq_dist

{'house': 1.0,

'judiciary': 0.5,

'committee': 0.7,

'invited': 0.1,

'president': 0.3,

...

"president's": 0.1,

'proceedings.': 0.1,

'copied': 0.1,

'pat': 0.1,

'cipollone.': 0.1}

就这样:我们将每个单词的出现次数除以最常出现单词的频率,以获得我们的分布。

接下来我们要使用我们生成的频率分布来对句子进行评分。这只是简单地将每个单词在句子中的得分相加,并保留这个得分。我们的函数接受一个 max_len 参数,用于设置要考虑用于汇总的句子的最大长度。由于我们对句子的评分方式,很容易看出,我们可能会偏向长句子。

def score_sentences(sents, freq_dist, max_len=40):

sent_scores = {}

for sent in sents:

words = sent.split(' ')

for word in words:

if word.lower() in freq_dist.keys():

if len(words) < max_len:

if sent not in sent_scores.keys():

sent_scores[sent] = freq_dist[word.lower()]

else:

sent_scores[sent] += freq_dist[word.lower()]

return sent_scores

sent_scores = score_sentences(sents, freq_dist)

sent_scores

{"The House Judiciary Committee has invited President Donald Trump or his counsel to participate in the panel's first impeachment hearing next week as the House moves another step closer to impeaching the President": 6.899999999999999,

'The committee announced that it would hold a hearing December 4 on the "constitutional grounds for presidential impeachment," with a panel of expert witnesses testifying': 2.8000000000000007,

'House Judiciary Chairman Jerry Nadler sent a letter to Trump on Tuesday notifying him of the hearing and inviting the President or his counsel to participate, including asking questions of the witnesses': 5.099999999999999,

'"I write to ask if you or your counsel plan to attend the hearing or make a request to question the witness panel," the New York Democrat wrote': 2.5000000000000004,

'In the letter, Nadler said the hearing would "serve as an opportunity to discuss the historical and constitutional basis of impeachment, as well as the Framers\' intent and understanding of terms like \'high crimes and misdemeanors': 3.300000000000001,

'\' "\n"We expect to discuss the constitutional framework through which the House may analyze the evidence gathered in the present inquiry," Nadler added': 2.7,

'"We will also discuss whether your alleged actions warrant the House\'s exercising its authority to adopt articles of impeachment': 1.6999999999999997,

'The hearing announcement comes as the Intelligence Committee plans to release its report summarizing the findings of its investigation to the House Judiciary Committee soon after Congress returns from its Thanksgiving recess next week': 5.399999999999999,

'Democratic aides declined to say what additional hearings they will schedule as part of the impeachment proceedings': 1.3,

'The Judiciary Committee is expected to hold multiple hearings related to impeachment, and the panel would debate and approve articles of impeachment before a vote on the House floor': 4.300000000000001,

'The aides said the first hearing was a "legal hearing" that would include some history of impeachment, as well as evaluating the seriousness of the allegations and the evidence against the President': 2.8000000000000007,

"Nadler asked Trump to respond by Sunday on whether the White House wanted to participate in the hearings, as well as who would act as the President's counsel for the proceedings": 3.5000000000000004,

'The letter was copied to White House Counsel Pat Cipollone': 2.2}

现在我们已经对句子的相对重要性进行了评分,剩下的就是选择(即“提取性汇总”中的“提取”)前 k 个句子来代表文章的总结。这个函数将使用我们上面生成的句子得分以及一个值来确定用于汇总的得分最高的 k 个句子。它将返回一个由前句子连接成的字符串总结,以及用于汇总的句子得分。

def summarize(sent_scores, k):

top_sents = Counter(sent_scores)

summary = ''

scores = []

top = top_sents.most_common(k)

for t in top:

summary += t[0].strip()+'. '

scores.append((t[1], t[0]))

return summary[:-1], scores

让我们使用这个函数生成总结。

summary, summary_sent_scores = summarize(sent_scores, 3)

print(summary)

The House Judiciary Committee has invited President Donald Trump or his

counsel to participate in the panel's first impeachment hearing next week as

the House moves another step closer to impeaching the President. The hearing

announcement comes as the Intelligence Committee plans to release its report

summarizing the findings of its investigation to the House Judiciary Committee

soon after Congress returns from its Thanksgiving recess next week. House

Judiciary Chairman Jerry Nadler sent a letter to Trump on Tuesday notifying

him of the hearing and inviting the President or his counsel to participate,

including asking questions of the witnesses.

并且我们来检查一下总结句子的得分,以确保准确性。

for score in summary_sent_scores: print(score[0], '->', score[1], '\n')

6.899999999999999 -> The House Judiciary Committee has invited President

Donald Trump or his counsel to participate in the panel's first impeachment

hearing next week as the House moves another step closer to impeaching the President

5.399999999999999 -> The hearing announcement comes as the Intelligence Committee

plans to release its report summarizing the findings of its investigation to

the House Judiciary Committee soon after Congress returns from its Thanksgiving

recess next week

5.099999999999999 -> House Judiciary Chairman Jerry Nadler sent a letter to

Trump on Tuesday notifying him of the hearing and inviting the President or

his counsel to participate, including asking questions of the witnesses

在快速浏览下,这个总结看起来很合理,考虑到文章的内容。可以在其他文本上尝试这个简单的方法以获取更多证据。

下一篇总结文章将在几个关键方面建立在这个简单的方法之上,即:

-

合适的分词方法

-

对我们基线方法的改进,使用 TF-IDF 权重而不是简单的词频

-

使用实际数据集进行汇总

-

我们结果的评估

下次见。

Matthew Mayo (@mattmayo13) 是一名数据科学家及 KDnuggets 的主编,KDnuggets 是开创性的在线数据科学和机器学习资源。他的兴趣领域包括自然语言处理、算法设计与优化、无监督学习、神经网络以及机器学习的自动化方法。Matthew 拥有计算机科学硕士学位和数据挖掘研究生文凭。他可以通过 editor1 at kdnuggets[dot]com 联系到。

更多相关主题

入门数据清理

原文:

www.kdnuggets.com/2022/01/getting-started-cleaning-data.html

背景矢量图由 rawpixel.com 创建 - www.freepik.com

数据清理是预处理阶段的一部分,是在数据挖掘阶段开始之前必须进行的重要步骤。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

数据质量是衡量数据集适用于其特定目的的程度以及在决策中受信任的程度。它由准确性、完整性、一致性、有效性和及时性等特征组成。

为了实现数据质量,需要进行一个过程。那就是数据清理。数据清理包括基于数据类型和识别出的问题的不同技术。

总结来说,错误数据要么是正确的,要么被删除,要么被填补。

不相关的数据

这是不需要的、无用的数据,或不适用于要解决的问题的数据。

例如,如果我们分析关于患者生活方式选择及其对 BMI 的影响的数据,他们的地址或电话号码作为变量是不相关的。然而,他们的吸烟状态或病史对于解决问题是重要且相关的。

你必须确定一条数据不重要且与问题无关。此时,你可以将其删除。否则,请进一步探索数据,寻找变量之间的相关性。

如果你仍然不确定,可以向该领域的专家或公司内的高层请教。他们可能会看到你未曾注意到的特定变量的相关性。

数据重复

重复数据是数据集中重复出现的数据。这通常发生于:

-

用户可能会不小心提交相同的答案两次

-

请求被提出了两次,原因可能包括错误信息或纯粹是重复提交请求。

-

数据来自不同来源的组合

像这样的示例应该从数据中删除,因为它会影响你的分析过程。

数据类型

有各种数据类型,如字符串、整数和浮点数。确保数据在正确的数据类型转换中对于你的分析阶段很重要。确保“True”或“False”答案被存储为布尔数据类型。确保患者的名字被存储为字符串数据类型。

这可以通过进行总结统计,即数据分析来轻松检查。它给你提供了数据的总体统计视图,帮助你识别缺失值、每个变量的数据类型等。

如果一些数据值无法转换为特定的数据类型,它们应该被转换为 NaN 值或其他值,表示该值不正确,需要解决。

语法错误

语法错误是诸如拼写、标点或不正确值的错误。

空白字符

空白字符是用于间隔的字符,具有“空”表示。如果空白字符出现在开头或结尾,应该将其移除。例如:

" hello world " => "hello world"

填充字符

填充字符是仅用于填充字符串中的空白空间,以创建统一的长度,使数据集中的所有内容对齐。下面的示例将一个 3 位整数转换为 6 位整数。

123 => 000123

字符串错误

字符串通常最容易出错,因为它们可以以各种方式输入。你可能会说‘Hello’或者错误地输入‘Hllo’。例如,进行了一项调查以更好地了解一个城市的人口统计。如果没有下拉菜单来选择性别,数据可能会呈现如下:

Gender:

Male

F

Man

Female

Fem

MAle

解决这个问题的方式有很多,一种方法是手动将每个值映射为“男”或“女”。

dataframe['Gender:'].map({'Man': 'Male', 'Fem': 'Female', ... }]

数据清理的方法

让我们来看看你可以清理原始数据的不同方法。

1. 标准化

将数据放在相同的标准化格式中有助于清理数据并识别数据中的错误。例如,确保所有字符串值都是小写或大写,以避免混淆,这是一个良好的开始。

确保特定列中的数值都转换为相同的单位。例如,患者的体重通常可以用磅(lbs)或千克(kg)表示。将它们统一为相同的单位可以让分析师的工作变得稍微轻松一些。

2. 缩放

缩放数据意味着将其转换为适应特定范围,比如 0-100 或 0-1。通过缩放,我们可以更好地绘制、比较和分析数据。例如,将用户去健身房的访问次数从整数转换为百分比,显示他们在特定时间段内利用健身房的程度。

3. 规范化

规范化是重新组织数据的过程,以确保没有重复的数据,并且数据存储在一个地方。规范化的目的是改变你的观察结果,以便它们可以被描述为正态分布。

许多人将数据标准化和数据归一化混淆,然而,它们并不相同。归一化通常将值缩放到[0,1]的范围内,而标准化通常将数据缩放为均值为 0、标准差为 1。

4. NaN / 缺失值

避免缺失值是很困难的,因此我们必须以某种方式处理它们。然而,忽略它们只会使问题变得更糟。你可以通过不同的方法来处理它们。

-

丢弃:最简单的解决方案是如果缺失值随机发生,则丢弃行或列。

-

填补:填补缺失值是基于其他观察值进行计算的。

-

你可以使用诸如均值和中位数之类的统计值。然而,这些值并不能保证是“无偏”的数据。

-

另一种方法是使用线性回归。你可以使用两个变量之间的最佳拟合线来填补缺失值。

-

在数据用于做出重要决策、进行统计分析以及向社会提供事实时,填补缺失值可能具有争议。缺失的数据有其价值并且具有信息性。例如,如果进行调查时,来自特定年龄组或宗教群体的用户拒绝回答问题。缺失值背后的原因对调查执行者来说非常重要,可以为分析师寻找相关性和结果提供有用信息。

丢弃或填补缺失值与默认值不同。标记这些值很重要,并可能允许进一步的当前和未来分析。

下一步

在预处理阶段后,包括丢弃或填补数据;重新评估数据,并确保清理过程没有违反任何规则或参数是很重要的。

传递数据或进入下一阶段时,如果没有报告数据的质量,与清理过程同样重要。有一些软件和库可以检测并报告这些变化,显示是否违反了任何规则。

报告数据中的错误可以帮助企业确定这些错误最初发生的原因,数据是否仍有用以及如何在未来避免这些错误。

结论

你可能会坐在那里几个小时试图清理数据,直到你感到沮丧。然而,分析坏数据没有意义。权宜之计无法解决问题的根源。你必须理解面临的问题,并找出最好的解决办法。

Nisha Arya 是一名数据科学家和自由撰稿人。她特别感兴趣于提供数据科学职业建议或教程及理论知识。她还希望探索人工智能在延长人类寿命方面的不同方式。作为一个热衷于学习的人,她寻求拓宽自己的技术知识和写作技能,同时帮助指导他人。

更多相关内容

使用 PyTorch 和 Ray 开始分布式机器学习

原文:

www.kdnuggets.com/2021/03/getting-started-distributed-machine-learning-pytorch-ray.html

评论

由 Michael Galarnyk、Richard Liaw 和 Robert Nishihara 编写

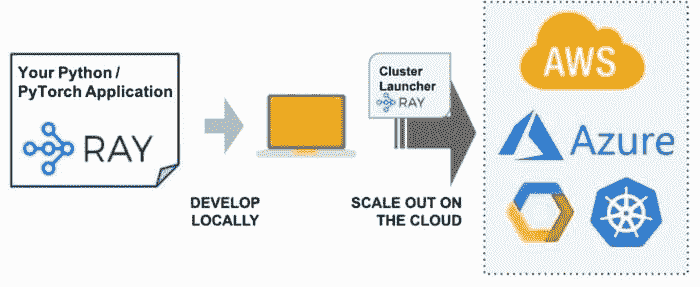

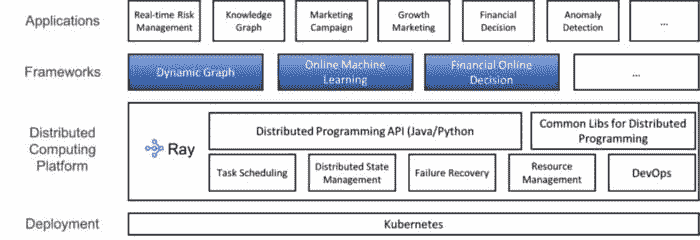

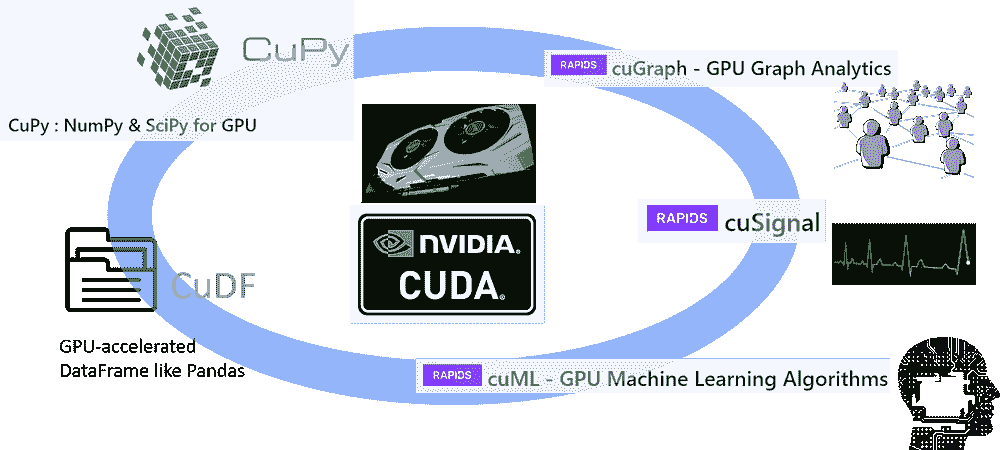

今天的机器学习 需要 分布式计算。无论你是在 训练网络、调整超参数、服务模型 还是 处理数据,机器学习计算密集型,且在没有集群的情况下可能会变得极其缓慢。 Ray 是一个流行的分布式 Python 框架,可以与 PyTorch 配合使用,迅速扩展机器学习应用程序。

本文涵盖了 Ray 生态系统的各个方面以及它如何与 PyTorch 一起使用!

什么是 Ray

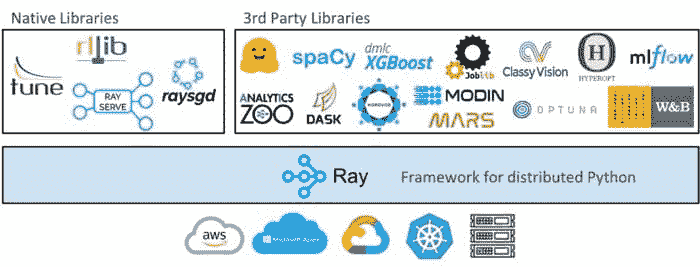

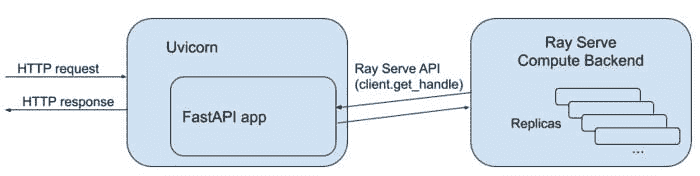

Ray 是一个开源的并行和分布式 Python 库。上图显示了从高层次来看,Ray 生态系统包括三个部分:核心 Ray 系统、用于机器学习的可扩展库(包括原生和第三方)以及 在任何集群或云提供商上启动集群的工具。

核心 Ray 系统

Ray 可以用来 扩展 Python 应用程序 跨多个核心或机器。它具有几个主要优点,包括:

-

简单性:你可以在不重写代码的情况下扩展 Python 应用程序,且相同的代码可以在单台机器或多台机器上运行。

-

鲁棒性:应用程序可以优雅地处理机器故障和抢占。

-

性能:任务以毫秒级延迟运行,扩展到数万核心,并处理最小序列化开销的数值数据。

库生态系统

由于 Ray 是一个通用框架,社区已经在其基础上构建了许多库和框架来完成不同的任务。这些库中的绝大多数支持 PyTorch,只需对代码进行最小的修改,并与其他库无缝集成。以下只是生态系统中一些 众多库。

RaySGD

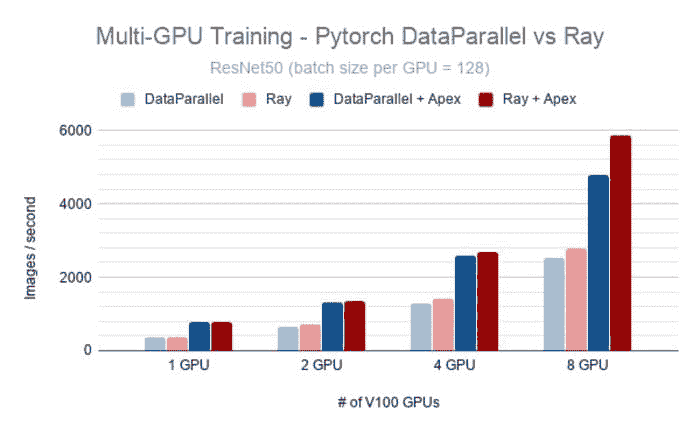

在 p3dn.24xlarge 实例上比较 PyTorch 的 DataParallel 与 Ray(Ray 在底层使用 PyTorch 的 Distributed DataParallel)。 图片来源。

RaySGD 是一个为数据并行训练提供分布式训练包装器的库。例如,RaySGD TorchTrainer 是一个围绕 torch.distributed.launch 的包装器。它提供了一个 Python API,以便轻松地将分布式训练集成到更大的 Python 应用程序中,而不是需要将训练代码包装在 bash 脚本中。

该库的一些其他优点包括:

-

易于使用:您可以扩展 PyTorch 的原生 DistributedDataParallel,而无需监控单独的节点。

-

可扩展性:您可以向上或向下扩展。从单个 CPU 开始。通过更改 2 行代码,扩展到多节点、多 CPU 或多 GPU 集群。

-

加速训练:内置支持 NVIDIA Apex 的混合精度训练。

-

故障容错:支持在云机器被抢占时自动恢复。

您可以通过安装 Ray(pip install -U ray torch)并运行下面的代码来开始使用 TorchTrainer:

该脚本将下载 CIFAR10,并使用 ResNet18 模型进行图像分类。通过更改一个参数(num_workers=N),可以利用多个 GPU。

如果您想了解更多关于 RaySGD 以及如何在集群中扩展 PyTorch 训练的信息,请查看这篇 博客文章。

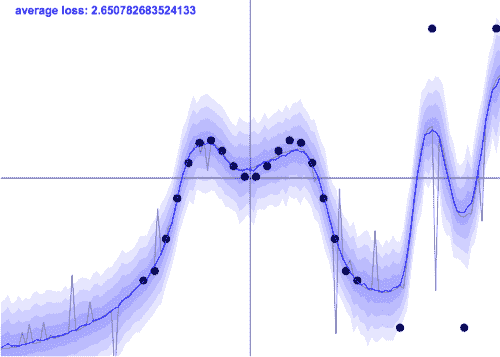

Ray Tune

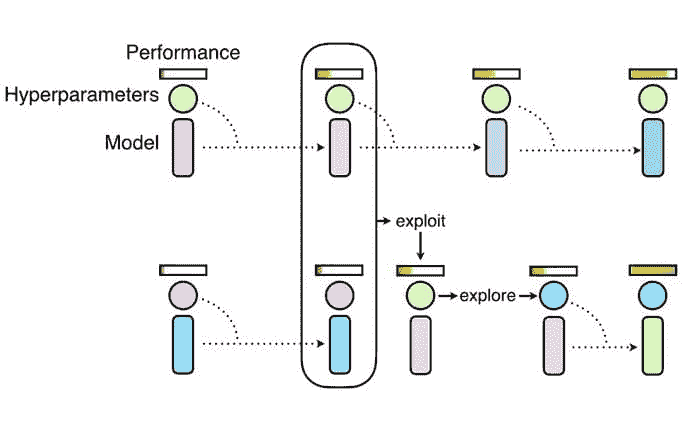

Ray Tune 对优化算法(如上所示的 Population Based Training)的实现 可以与 PyTorch 一起使用,以获得更高性能的模型。图片来自 Deepmind。

Ray Tune 是一个用于实验执行和超参数调优的 Python 库,适用于任何规模。一些库的优点包括:

-

在不到 10 行代码的情况下启动多节点 分布式超参数搜索 的能力。

-

对每个主要机器学习框架的支持 包括 PyTorch。

-

对 GPU 的一级支持。

-

自动管理检查点和日志记录到 TensorBoard。

-

访问最新的算法,例如 基于人群的训练(PBT)、贝叶斯优化搜索(BayesOptSearch)、HyperBand/ASHA。

你可以通过安装 Ray(pip install ray torch torchvision)并运行下面的代码来开始使用 Ray Tune。

如果你想了解如何将 Ray Tune 集成到你的 PyTorch 工作流中,应该查看这篇 博客文章。

Ray Serve

Ray Serve 不仅可以单独用于模型服务,还可以用于 扩展其他服务工具,如 FastAPI。

Ray Serve 是一个易于使用的可扩展模型服务库。该库的一些优势包括:

-

使用单一工具包服务于从深度学习模型(PyTorch、TensorFlow 等)到 scikit-learn 模型,再到任意 Python 业务逻辑的所有内容。

-

扩展到多个机器,无论是在你的数据中心还是在云端。

如果你想学习如何将 Ray Serve 和 Ray Tune 集成到你的 PyTorch 工作流中,应该查看 文档 和 完整代码示例。

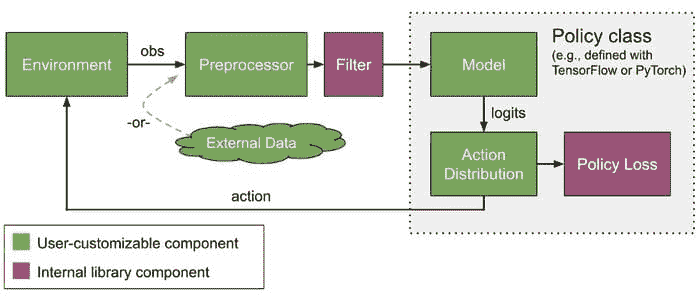

RLlib

RLlib 提供了自定义训练几乎所有方面的方法,包括神经网络模型、动作分布、策略定义、环境以及样本收集过程。

RLlib 是一个强化学习库,提供高扩展性和统一的 API,适用于各种应用。一些优势包括:

-

原生支持 PyTorch、TensorFlow Eager 和 TensorFlow(1.x 和 2.x)。

-

支持无模型、有模型、进化、规划和多智能体算法

-

通过简单的配置标志和自动包装器支持复杂模型类型,如注意力网络和 LSTM 堆栈

-

与其他库兼容,如 Ray Tune。

Cluster Launcher

Ray 集群启动器简化了在任何集群或云提供商上启动和扩展的过程。

一旦你在笔记本电脑上开发了一个应用程序并想要将其扩展到云端(可能是更多的数据或更多的 GPU),接下来的步骤并不总是很清晰。这个过程要么是让基础设施团队为你设置,要么是按照以下步骤进行。

1. 选择一个云提供商(AWS、GCP 或 Azure)。

2. 导航管理控制台以设置实例类型、安全组、竞价价格、实例限制等。

3. 确定如何将你的 Python 脚本分发到集群中。

更简单的方法是使用 Ray 集群启动器来启动和扩展机器跨任何集群或云提供商。集群启动器允许你自动扩展、同步文件、提交脚本、端口转发等。这意味着你可以在 Kubernetes、AWS、GCP、Azure 或私有集群上运行 Ray 集群,而无需了解集群管理的底层细节。

结论

Ray 为 Ant Group 的 Fusion Engine 提供了分布式计算基础。

本文介绍了 Ray 在 PyTorch 生态系统中的一些好处。Ray 被广泛应用于 Ant Group 使用 Ray 支持其金融业务、LinkedIn 在 Yarn 上运行 Ray、Pathmind 使用 Ray 将强化学习与模拟软件连接 等。如果你对 Ray 有任何问题或想了解更多关于 并行和分布式 Python 的信息,请通过 Discourse 或 Slack 加入我们的社区。

原文。经授权转载。

相关:

-

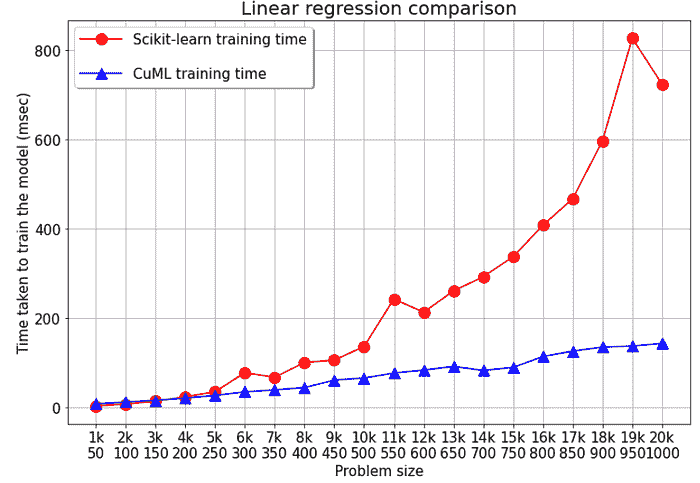

如何加速 Scikit-Learn 模型训练

-

训练 sklearn 快速 100 倍

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT

更多相关主题

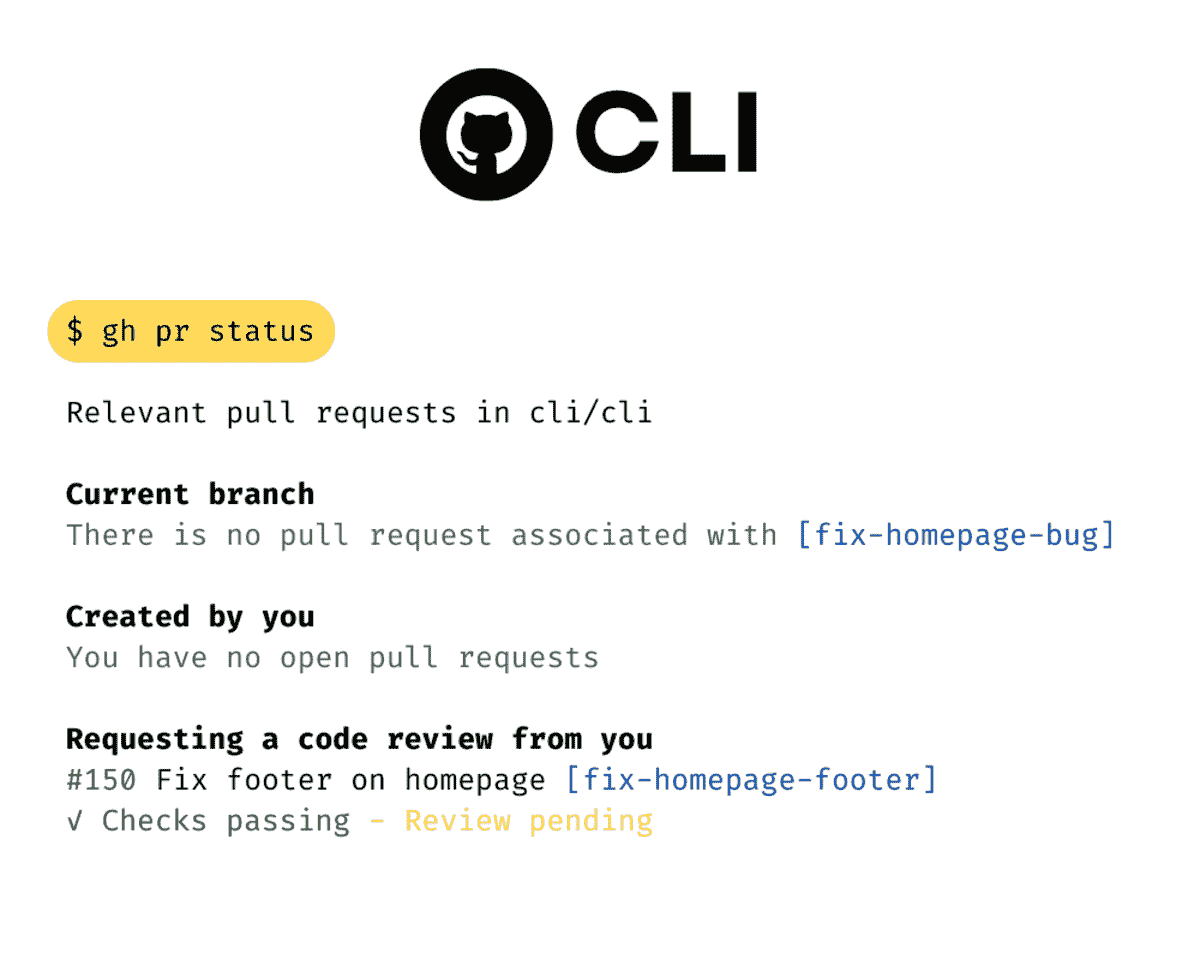

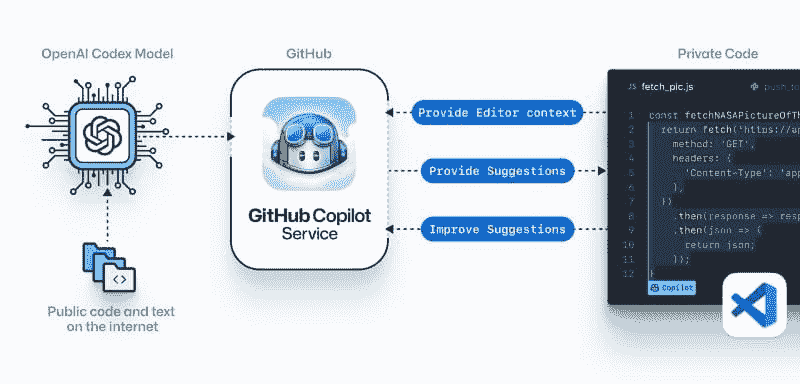

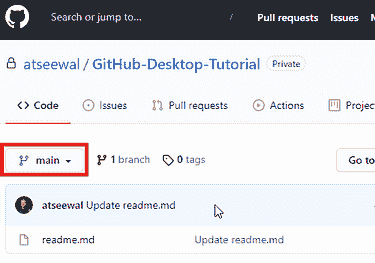

GitHub CLI 入门

原文:

www.kdnuggets.com/2023/03/getting-started-github-cli.html

作者提供的图像

GitHub CLI 将所有 GitHub 功能带入你的命令行界面。你可以通过输入几个关键词来创建新的远程仓库、查看和修改它。此外,它还允许你启动代码空间、管理 gists 并运行 GitHub Actions。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

主要特点:

-

快速认证。

-

在网页浏览器上查看仓库、拉取请求、提交和文件。

-

创建、查看和管理 codespaces。

-

创建、发布和管理 GitHub 仓库。

-

创建、查看、发布和管理 GitHub gits。

-

检查问题的状态、创建新问题以及在终端中查看问题。

-

使用命令行创建拉取请求、审查它并合并。

-

查看 GitHub Actions 工作流列表,并管理工作流和运行。

-

查看你的 GitHub 个人资料的全局状态。

快速设置

安装

首先,我们需要安装 CLI 工具,它适用于所有操作系统。

macOS

GitHub CLI 可以通过 Homebrew CLI 工具轻松安装。它也可以在 MacPorts、Conda、Spack 和可下载的二进制文件上找到。

$ brew install gh

或

$ brew upgrade gh

Windows

GitHub CLI 可以通过 Winget CLI 工具轻松安装。它也可以在 scoop、Chocolatey、Conda 和可下载的 MSI 上找到。

$ winget install --id GitHub.cli

或

$ winget upgrade --id GitHub.cli

Linux

GitHub CLI 可以通过 apt 在 Ubuntu 中安装,也可以从 Releases · cli/cli 进行二进制安装。

$ sudo apt update

$ sudo apt install gh

认证

安装后,你需要与 GitHub 主机进行认证。

启动浏览器进行认证,使用:

$ gh auth login

完成后,认证令牌将被内部存储。

你还可以通过从文件中读取令牌来对 github.com 进行身份验证。

$ gh auth login --with-token < mytoken.txt

注意:首次启动代码空间时,你可能需要额外的认证。这非常简单,就像浏览器认证一样。

GitHub CLI 命令

认证成功后,你可以尝试写一个简单的命令来检查状态:

$ gh status

上述命令将显示分配的 Issues、分配的 Pull Requests、审查请求、提及和仓库活动。

或者输入:

gh repo list [user-name]

查看公共和私有仓库的列表。

作者提供的 Gif

GitHub CLI 正在不断发展,现在你可以访问 GitHub 生态系统中提供的所有内容。

这是使用 GitHub CLI 可以做的事情的列表:

-

使用别名创建 gh 命令的快捷方式。

-

使用单个命令浏览几乎所有的 GitHub 网站内容。

-

创建、查看、交互和管理 codespaces、gits、repositories 和 GitHub actions。

-

添加和管理 gh 扩展。

-

审查、编辑和合并 Pull requests 和 Issues。

-

设置秘密、ssh-key 和 gpg-key。

-

体验交互式搜索。

-

以及配置。

通过阅读 手册了解所有 GitHub 命令和示例。

结论

如果你是新手并希望了解有关 Git 和 GitHub 的所有内容,请阅读 Github 和 Git 初学者教程。你将学习 Git 的工作原理、基本命令,以及如何在数据科学项目中使用它。此外,你将了解 GitHub 协作平台,以及如何通过几个步骤创建你的第一个 GitHub 仓库。

GitHub CLI 适合专业人士和初学者。它通过提供 GitHub 功能的命令使你的生活更轻松。你还可以使用命令自动化设置,并为重复的命令创建别名。

使用 GitHub CLI,你可以在不离开 IDE 的情况下构建、测试、部署和协作,使其成为一个超级工具。

Abid Ali Awan (@1abidaliawan) 是一位认证的数据科学专业人士,喜欢构建机器学习模型。目前,他专注于内容创作,并撰写有关机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是利用图神经网络为面临心理健康问题的学生开发 AI 产品。

更多相关主题

一小时入门机器学习!

原文:

www.kdnuggets.com/2017/11/getting-started-machine-learning-one-hour.html

由 Abhijit Annaldas,微软。

我在为我的一小时讲座规划议程。传达学习路径、设置环境并解释重要的机器学习概念,在经过深思熟虑后,终于成为了议程的一部分。我最初考虑了各种讲座方式,包括 - 使用线性回归的 Python 实践、详细解释线性回归,或者仅仅分享我过去 18 个月的学习历程。但我想要开始一个能让观众获得大量新信息和问题的讲座,激发他们的好奇心和兴趣。我认为我在这个方面做得还不错。基本上,就是为了让他们入门机器学习。这就是为什么这个指南最终被称为一小时入门机器学习的原因。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

这次讲座的笔记非常适合初学者,但仅仅是为了帮助我自己准备讲座而编排的。因此,我从中写出了一个机器学习入门指南,现已完成。我非常高兴最终形成的样子,并且很兴奋能与大家分享!

学习机器学习有两种主要的方法:理论机器学习方法和应用机器学习方法。我在之前的 博客文章中写过关于这方面的内容。

理论机器学习

以下是你可以开始学习的主题(按我认为的合适顺序排列)。对于理论性的机器学习学习,下面的主题应当被认真和深入地学习。

-

微积分 - 基础课程,Coursera,高级课程,Coursera

-

概率和统计 - MIT

-

实现机器学习研究想法的编程语言。

前进的道路可能是阅读研究论文,实施研究工作/新算法,发展专业知识,并在研究路径上进一步选择一个专业化方向。

应用机器学习

-

对上述基础知识(1 到 4)的良好理解。

-

Python 或 R 编程语言,根据你的偏好。

-

学习使用选择的编程语言中的流行机器学习、数据处理和可视化库。我个人使用 Python 编程语言,因此我将在下面详细说明。

-

必须了解的 Python 库:numpy,pandas,scikit-learn,matplotlib

快速开始选项

如果你想了解机器学习是什么以及它可能是什么样的,可以尝试这种方法进行实验,快速上手。如果你想长期认真从事数据科学,这不是一个理想的方法。

-

了解机器学习概念概述(下文)

-

学习 Python 或 R

-

理解并学习使用你选择的语言中的流行库

Python 环境设置

-

Python

-

代码编辑器 / IDE

-

Visual Studio Code(搜索并安装 Python 扩展,选择下载量最多的一个)

-

Notepad++

-

Jupyter(与 Anaconda 一起安装)

-

-

安装 Python 包

-

使用 pip 管理包,Python 的本地工具:

pip install <package-name> -

使用 anaconda 管理包:

conda install <package-name>

-

-

管理 Python(本地)虚拟环境(如果需要多个环境)

-

创建虚拟环境:

python -m venv c:\path\to\env\folder -

命令帮助:

python -m venv -h -

切换环境:

activate.bat脚本位于虚拟环境文件夹中 -

Python(本地)虚拟环境 文档

-

-

管理 Anaconda 虚拟环境(如果需要多个环境)

-

默认 conda 环境 -

root -

列出可用环境 -

conda env list -

创建新环境 -

conda create --name environment_name -

切换到环境 -

activate environment_name或source activate environment_name -

Anaconda 虚拟环境 文档

-

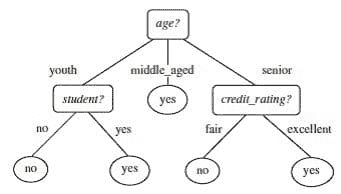

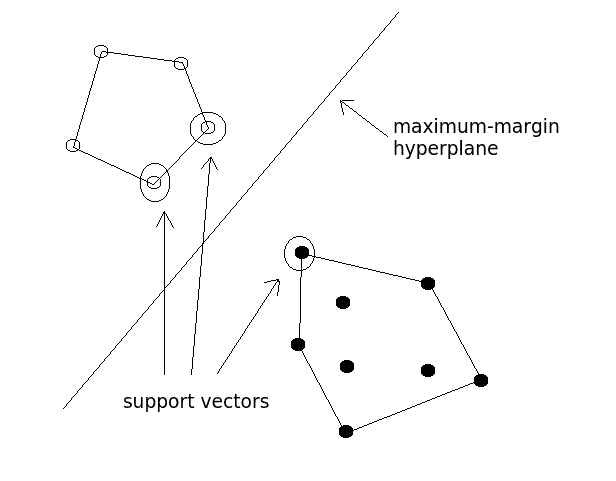

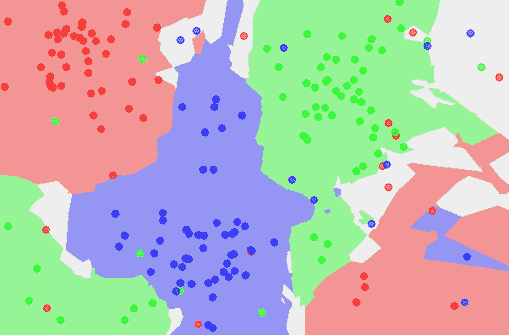

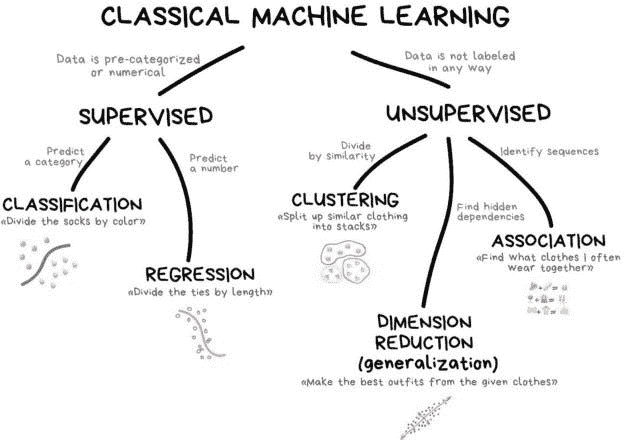

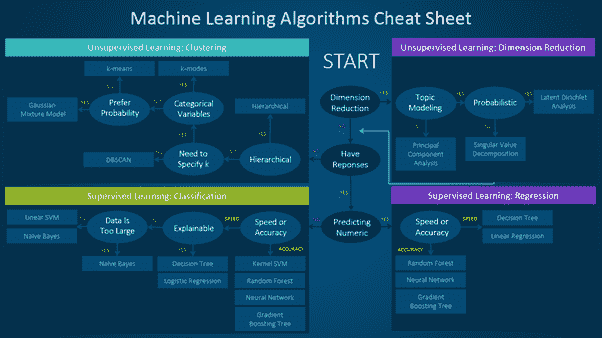

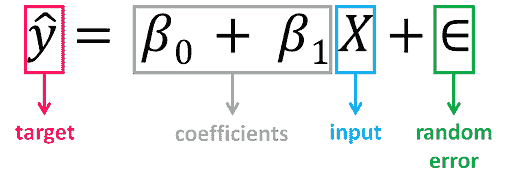

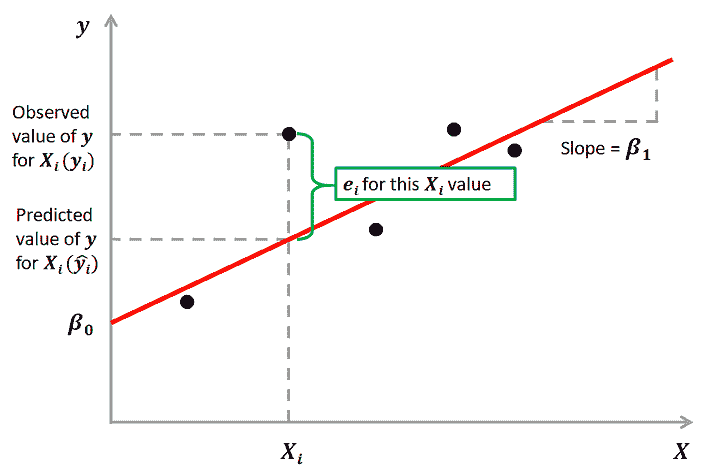

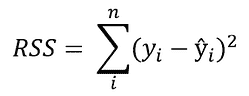

机器学习概念概述

-

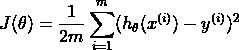

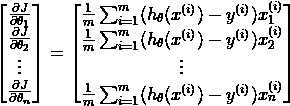

机器学习:是一种通过函数 f(x) 从大量数据集中寻找模式的方法,该函数有效地推广到未见的 x,以发现未见数据中的学习模式,并进行机器学习模型训练所需的推断。

-

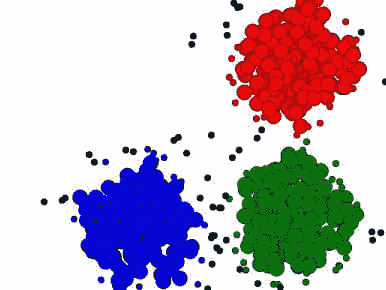

数据集:用于应用机器学习并从中发现模式的数据。对于监督类型的机器学习应用,数据集包含 x(输入/属性/独立变量)和 y(目标/标签/依赖变量)数据。对于无监督数据,它只是 x,输入数据的输出是某种学习到的模式(如聚类、组等)

-

训练集:数据集的一个子集,提供给(训练)机器学习算法以学习模式

-

评估/验证/交叉验证集:数据集 的一个子集,不在 训练集 中,用于评估机器学习算法的表现。

-

测试集:用于预测学习到的见解的 数据集。对于监督问题,像 训练集 中的目标/标签 y 需要预测,因此它不是 训练集 的一部分。对于无监督,训练 和 测试 集可以是相同的。

-

类型:

-

监督:在监督问题中,历史数据包括需要为未来/未见数据预测的标签(目标属性、结果)。例如,对于房价预测,我们有房屋(面积、卧室数量、位置等)和价格的数据。在这里,通过用给定的数据(X - 数据)和价格(Y - 标签)训练机器学习模型后,将来将对新的/未见数据(X)预测价格(Y)。

-

无监督:在无监督学习中,没有标签或目标属性。一个典型的例子是根据学习到的模式对数据进行聚类。例如,对于包含房屋详情(面积、位置、价格、卧室数量、楼层数量、建造日期等)的数据集,算法需要找出是否存在隐藏的模式。例如,有些房屋非常昂贵,而其他房屋价格则比较常见。有些房屋非常大,而有些房屋则是普通大小。根据这些模式,记录/数据被聚类为奢侈住宅、非奢侈住宅、平房、公寓等组。

-

强化学习:在强化学习中,一个‘代理’在‘环境’中进行操作,并接收正反馈或负反馈。正反馈告诉代理它做得很好,代理会继续执行类似的计划/动作。负反馈则告诉代理它做错了什么,并应该改变行动路线。代理和环境都是软件/编程实现的。强化学习的核心是构建一个代理(或以某种方式构建代理的行为),使其能够在环境中成功完成特定任务。

-

-

预处理:在现实世界中,数据很少以清晰整洁的状态存在,可以直接应用于机器学习算法。预处理是清理数据以供机器学习算法使用的过程。一些常见的预处理步骤包括……

-

缺失值:当某些值缺失时,通常通过添加中位数/均值,删除相应的行,或使用前一行的值等方法处理。这些处理方法有很多,具体需要做什么取决于数据的种类、解决的问题和业务目标。

-

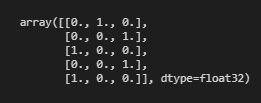

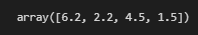

分类变量:离散的有限值集合。例如‘汽车类型’,‘部门’,等。这些值被转换为数字或向量。转换为向量称为独热编码。在 Python 中有多种方法可以实现这一点。一些机器学习算法/库本身通过内部编码处理分类列。一种编码方法是使用sklearn.preprocessing.OneHotEncoder。

-

缩放:将列中的值按比例缩放到一个公共范围,例如 0 到 1。将所有列中的值都调整到一个共同范围,可能在一定程度上提高准确性和训练速度。

-

文本:文本需要使用自然语言处理技术(本指南不涉及)进行处理。如果没有预处理,通常会从供机器学习算法训练的数据中排除。

-

不平衡数据集:数据不应该有偏差或偏斜。例如,考虑一个分类任务,其中一个算法将数据分类为 A、B 和 C 三种不同的类别。如果数据集中某一类的记录相对于其他类别非常少/多,则称之为偏倚/不平衡。通常,在这种情况下,通过从现有数据中合成生成更多随机数据来对数据进行过采样。一些机器学习算法/库允许提供权重或某些参数,以在内部平衡数据集,而无需我们进行修正。例如,SVM:不平衡类别的分离超平面 在 scikit-learn 中。

-

异常值:异常值需要根据问题和业务情况逐个处理。

-

-

数据转换:当数据集中的一列/属性没有固有模式时,它会被转换为如 log(值)、sqrt(值) 等形式,其中转换后的值可能会展现出有趣的模式/均匀性。这显然是根据具体情况而定的,需要数据探索来找到合适的转换方式。

-

特征工程:特征工程是从现有数据中提取隐藏见解的过程。考虑一个住房价格预测数据集,其中包含“地块宽度”、“地块长度”、“卧室数量”和“价格”列。在这里,我们发现缺少房子的一个关键属性“面积”,但可以根据“地块宽度”和“地块长度”计算得出。因此,数据集中添加了一个计算列“面积”。这就是特征工程。特征工程的难度可能不同,有时一个衍生属性就在眼前,如此处的例子,有时它确实隐藏得很深,需要大量思考。

-

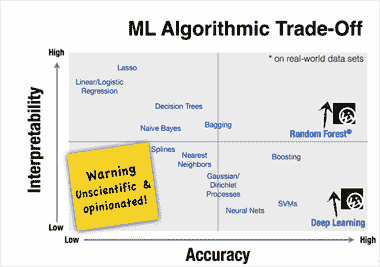

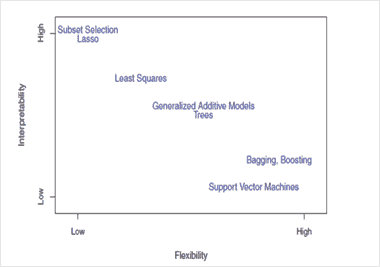

训练:这是一个主要步骤,其中机器学习算法在给定数据上进行训练,以寻找可以应用于未见数据的通用模式。以下是这一阶段的一些重要细节……

-

特征选择:并非所有特征/列都对学习有贡献。这些是数据不会影响结果的列。这些特征会从数据集中删除。决定训练哪些特征和排除哪些特征是根据应用的机器学习算法提供的特征重要性来决定的。大多数现代算法都会提供特征重要性。如果算法不提供,scikit-learn 具有 特征选择能力 可以帮助特征选择。同时,相关特征也会被删除。

-

降维:降维也旨在找出所有特征中最重要的特征,目的是减少数据的维度。与基于特征重要性的特征选择的主要区别在于,降维中选择的是特征的子集和/或派生特征。换句话说,我们可能无法将提取的特征映射回原始特征。你可以在 scikit-learn 中找到更多关于降维的信息这里。

-

特征选择与降维:在我看来,解决目标的两种方法中应该选择其中之一。如果我们既做基于特征重要性的特征选择,又做降维,应该首先进行基于特征重要性的特征选择,然后再引入降维。显而易见,我们应在每一步评估性能,以了解哪些有效,哪些无效。基于特征重要性的特征选择容易解释,因为所选特征是所有特征的子集,而降维则不是这样。

-

评估指标:评估指标是用于评估预测正确性的指标。机器学习算法在训练时使用评估指标来评估、计算成本并在成本凸函数上进行优化。虽然每个算法都有默认的评估指标,但建议根据业务案例/问题指定确切的评估指标。例如,有些问题可以容忍假阳性,但不能容忍假阴性。通过指定评估指标,可以控制模型的这些细节。

-

参数调优:尽管如今大多数最先进的算法都有合理的默认参数值,但调整参数总是有帮助的,可以控制模型的准确性并改善整体预测。参数调优可以通过反复更改和评估准确性来进行尝试和错误。或者,可以提供一组参数值,尝试这些参数的所有/不同排列,以找到最佳参数组合。这可以使用一些称为scikit-learn 中的超参数优化器的辅助函数来完成。

-

过拟合(偏差):过拟合是指机器学习模型几乎记住了所有的训练数据,并且在训练集中的数据上预测几乎非常准确。这是一种模型无法泛化并预测未见过的数据的状态。这也被称为模型具有高偏差。过拟合可以通过使用正则化、调整不适当配置的超参数、保留部分数据集以使用正确的交叉验证策略来处理。

-

欠拟合(方差):欠拟合是指机器学习模型即使在对训练数据集中的数据进行预测时,预测效果也不好。这也被称为模型具有高方差。可以通过添加更多数据、增加/删除特征、尝试不同的机器学习算法等方式来处理欠拟合。

-

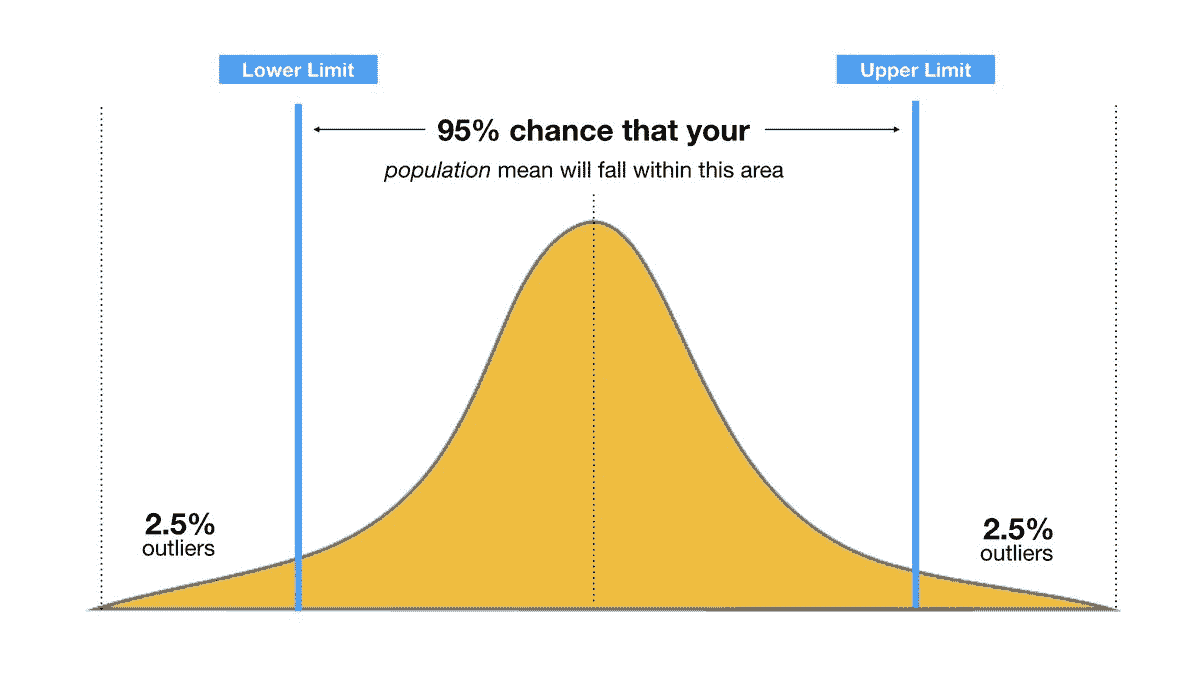

偏差与方差权衡(甜点):模型训练的目标是找到一个甜点,使模型的交叉验证误差最小。最初,交叉验证误差和训练误差都很高(欠拟合/高方差)。随着模型的训练,误差会下降到一个点,在该点交叉验证误差最小且接近训练误差(甜点)。这是最优点。在这个点之后,如果模型继续降低误差(在训练集上),它几乎会记住训练集,最终导致过拟合,这意味着在未见过的数据上误差较高。

-

正则化:当模型尝试进一步学习(降低误差,趋向过拟合)时,正则化有助于抵消过拟合的效果。正则化通常是一个在成本/误差计算期间添加的参数。机器学习算法可能不会总是明确提供正则化参数。在这种情况下,通常有其他参数可以调整,以引入所需的正则化程度。

-

-

预测:要使用训练好的机器学习模型进行预测,需要调用模型的预测方法,并将测试数据集作为参数传递。测试数据集应该按照对训练数据集进行的预处理方式进行处理。换句话说,格式应与喂给机器学习模型进行训练的训练数据相同。

-

其他术语:

- 模型堆叠:当单一的机器学习算法效果不好时,会使用多个机器学习算法进行预测,并以不同的方式将这些预测结果组合在一起。最简单的方式是加权预测。有时,会在第一层模型的预测结果上使用其他机器学习模型(元模型)。这可以复杂到任何程度,并且可以有不同的流程。

深度学习

有趣的是,今天解决的大多数(我猜超过 90%)机器学习问题都是通过仅使用随机森林、梯度提升决策树、SVM、KNN、线性回归、逻辑回归来解决的。

但是,有一些问题无法通过上述技术解决。像图像分类、图像识别、自然语言处理、音频处理等问题使用了一种叫做深度学习的技术。开始深度学习之前,我相信掌握上述所有概念是至关重要的。

优质的深度学习资源…

-

Fast.ai – 感谢Pranay Tiwari的建议!

如果你了解深度学习概念并希望动手实践,一些流行的深度学习库包括:Keras、CNTK、Tensorflow、tflearn、sonnet、pytorch、caffe、Theano

练习

是的,实践是最重要的,如果不提到练习机器学习,这个指南将是不完整的。为了进一步练习和掌握你的技能,以下是你可以做的事情…

-

从各种在线数据源获取数据集。其中一个受欢迎的数据源是 UCI 机器学习库。此外,你还可以 搜索“机器学习数据集”。

-

参加在线机器学习/数据科学黑客马拉松。一些受欢迎的赛事包括 - Kaggle、HackerEarth,等等。如果你开始时遇到非常困难的任务,尝试坚持一会儿。如果仍然感觉困难,可以先放一放,寻找其他任务。不必灰心。通常在线黑客马拉松中的问题具有一定的难度,这可能不适合初学者。

-

写博客记录你学到的东西!这将帮助你巩固对该主题的理解和思考。

-

在 Quora 上关注数据科学、机器学习相关话题,有很多很棒的建议以及问题/答案可以学习。

-

开始听播客(可通过以下链接获取)

-

查看我 数据科学学习资源 页面上的一些有用链接。

结束语

如果你认真考虑机器学习/数据科学领域,并且考虑转行,请思考一下你的动机以及你为什么想做这个。

如果你确定,我有一个建议给你。绝不要放弃或怀疑这一切是否值得。这绝对是值得的,我可以这样说,因为我在过去 18 个月里几乎每天、每个周末以及每一个空闲时间都走在这条路上(除了旅行或被日常工作压得喘不过气来)。掌握数据科学的道路并不容易。正如他们所说,“罗马不是一天建成的!”。你需要学习很多科目。不同的学习优先级之间需要权衡。即使学到了很多,你仍会发现一些你之前从未想到/听说过的新事物。你不断发现的新概念/技术可能会让你觉得自己仍然知道的很少,还有很多内容需要掌握。这很正常。坚持下去。设定大目标,规划小任务,并专注于手头的任务。如果有新的东西出现,记下它,稍后再处理。

谢谢你!

如果你一直阅读到这里,我感谢你的努力和时间。我希望这份指南对你有用,并使你开始自己的学习冒险变得稍微容易一些。如果在未来某个时候,你认为这份指南对你的学习冒险有所帮助,请回来在这里留下评论。或者通过 avannaldas .at. hotmail .dot. com 联系我。我很乐意听到你的反馈。知道这对你有帮助,并且我为此付出的努力是值得的,会让我感到极大的满足。

这是我写的最大的一篇文章。我花了很多小时来写作、编辑和审阅。如果你发现任何错误或可以改进的地方,请在评论中或通过电子邮件告诉我。我会尽快修正,并将其归功于你。这将帮助每一个阅读此文的人。

再次感谢!

祝一切顺利!

个人简介:Abhijit Annaldas 是一名软件工程师,同时也是一位饱含热情的学习者,他在机器学习方面拥有相当的知识和专长。他通过不断学习新事物和不懈的实践,每天都在提升自己的专业技能,自 2012 年 6 月以来,作为微软印度的软件工程师,他在不同的微软和开源技术中积累了丰富的企业级应用开发经验。

原文。经许可转载。

相关:

-

如何在 10 天内学习机器学习

-

Python 机器学习游击指南

-

基于密度的空间聚类与噪声(DBSCAN)

更多相关主题

Pandas 入门速查表

原文:

www.kdnuggets.com/2022/09/getting-started-pandas-cheatsheet.html

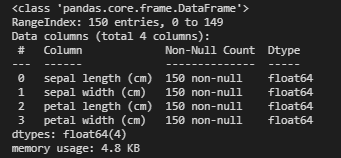

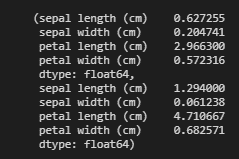

Pandas 入门

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 部门

3. Google IT 支持专业证书 - 支持你的组织的 IT 部门

Pandas 是 Python 生态系统中使用最广泛且最受依赖的库之一。Pandas 通常是数据科学家进行数据处理、分析和操作的第一选择。

你有需要处理的表格数据吗?基本上,使用 Pandas 是不可避免的,也不应该寻找其他解决方案。Pandas 功能丰富,强大且灵活。想要检查数据?Pandas 可以帮助你。需要查询数据?Pandas 能满足你的需求。必须为机器学习准备表格数据?Pandas 会为你提供帮助。

KDnuggets 的 Abid Ali Awan 进一步 描述了 Pandas 如下:

Pandas 是一个灵活且易于使用的数据分析和数据操作工具。在数据科学家中广泛用于数据准备、清理数据和进行数据科学实验。Pandas 是一个开源库,帮助你用简单易用的语法解决复杂的统计问题。

你知道如何在你的项目中利用 Pandas 吗?你真的应该知道!有很多资源可以帮助你,但直接上手实践总是一个好主意。但你该如何寻找快速参考呢?

为了帮助你,KDnuggets 制作了这个精彩的 Pandas 入门指南,涵盖了你 Pandas 之旅中的一些重要初步步骤。

你可以 在这里下载速查表。

Pandas 入门速查表

这份快速参考备忘单指南将提供你开始查询和修改 DataFrames 所需的基本 Pandas 操作,DataFrames 是该库的基本数据结构。它将展示如何创建 DataFrames、导入和导出数据、检查 DataFrames,以及如何对 DataFrames 进行子集提取、查询和重塑。一旦你掌握了这些入门操作,你应该准备好进行更高级的 Pandas 任务。

学习 Pandas 是值得的。初学者常常被操作的广度和一开始令人畏惧的语法所吓倒。但通过一步步学习、掌握基础,并在练习时随手参考(比如这份备忘单),你将很快在 Python 最常用的数据处理库中取得进展。

更多相关话题

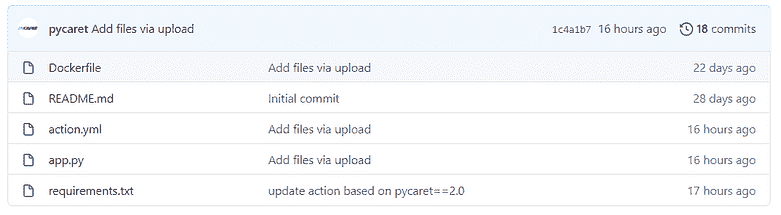

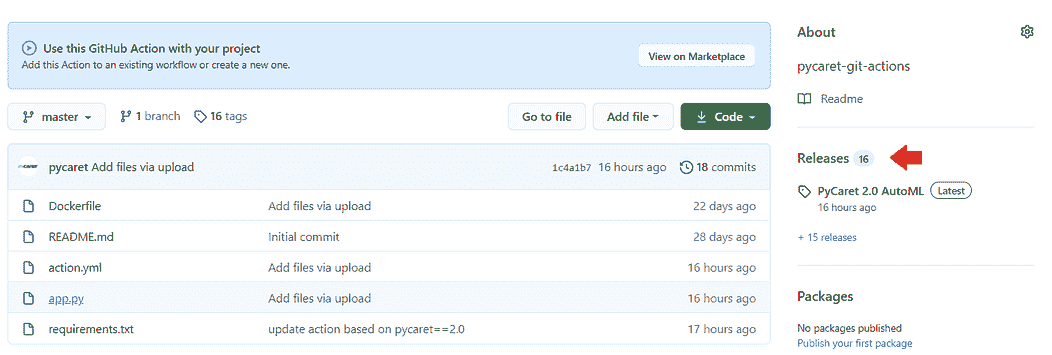

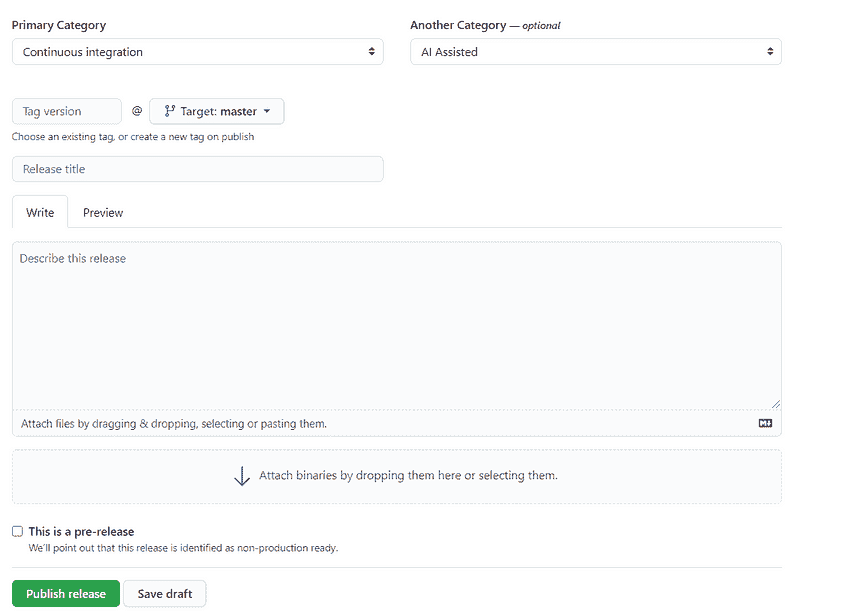

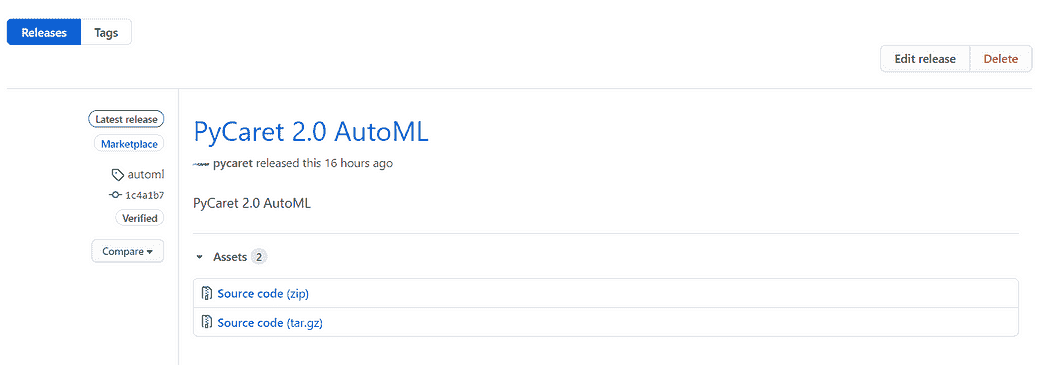

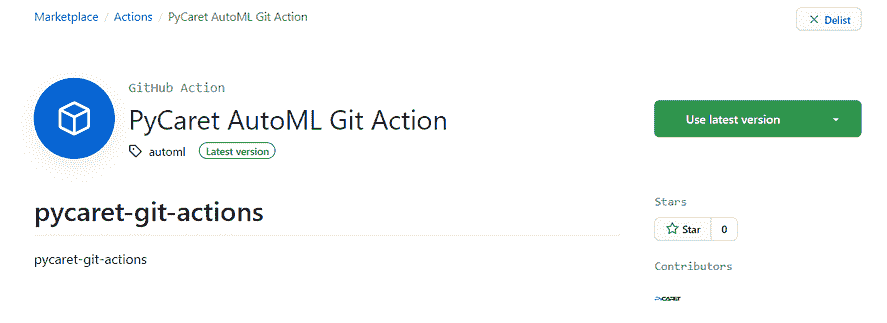

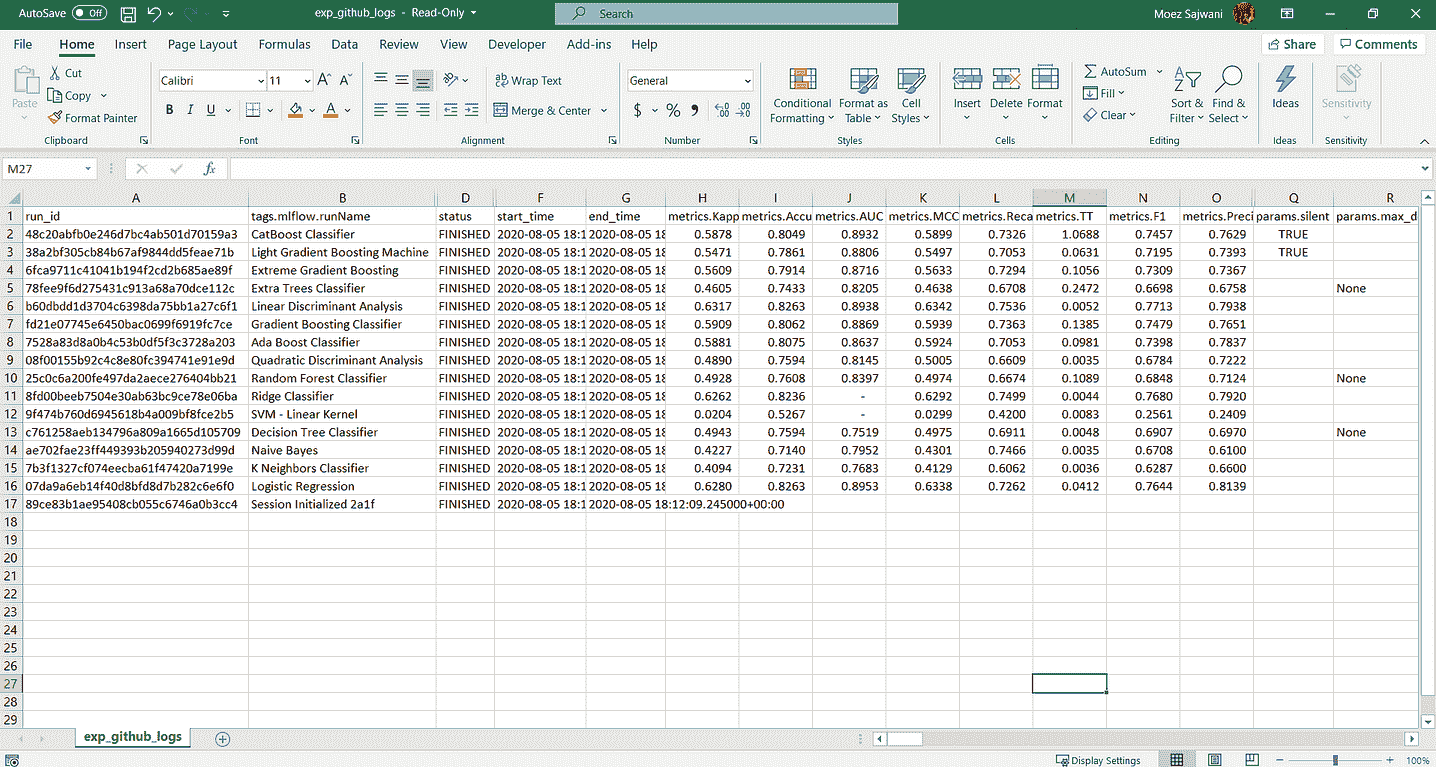

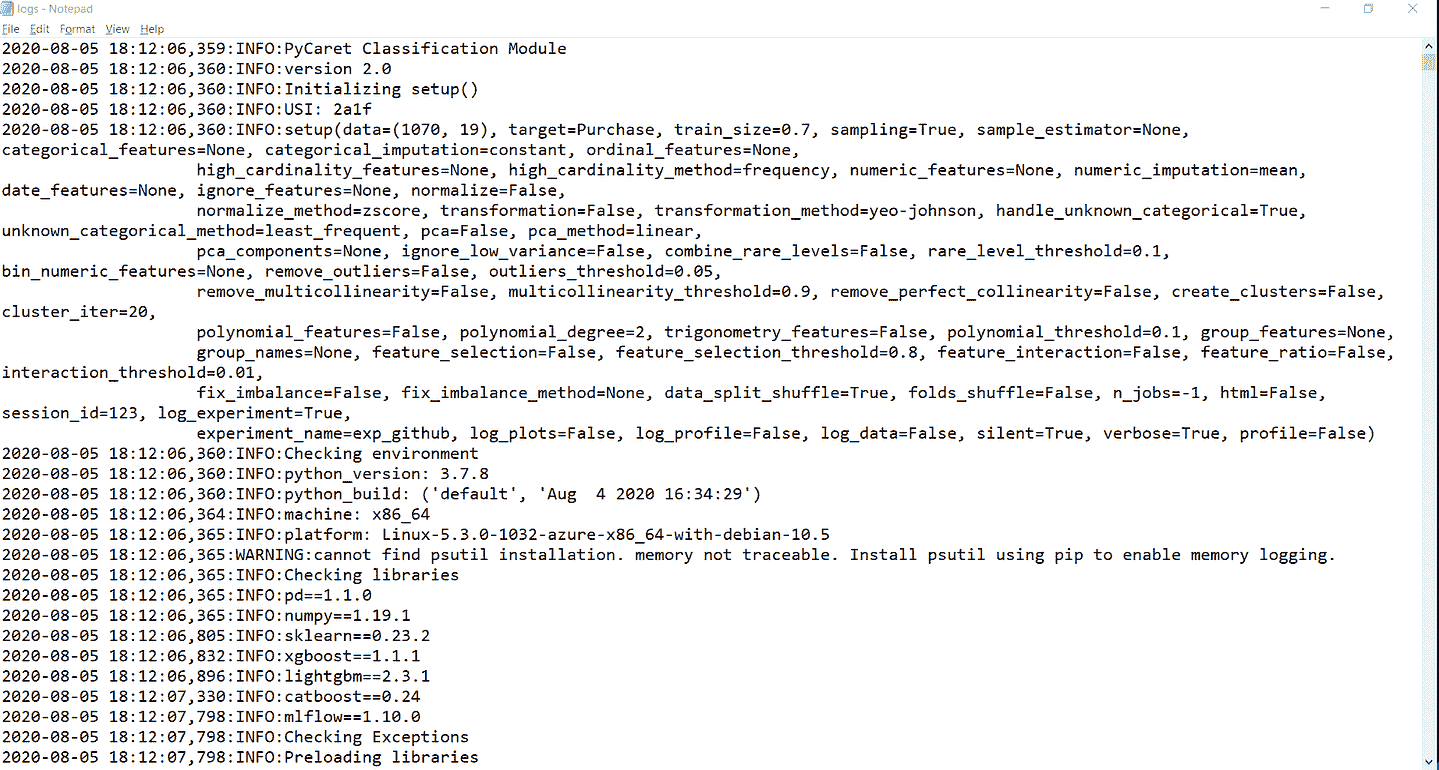

开始使用 PyCaret

图片由编辑提供

任何 AI 模型的训练和部署都经历漫长的数据过程。其中一些步骤是标准化的,可以自动化,从而实现快速的模型开发和部署。PyCaret 是为大规模生产机器学习模型而开发的软件包之一。让我们开始学习它吧。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

什么是 PyCaret?

PyCaret 是一个开源、低代码的数据科学 Python 包,通过自动化 ML 工作流来加速实验周期。它将数百行代码替换为仅几行,促进更快、更高效的实验。

它是围绕多个 ML 库和框架(如 scikit-learn、LightGBM/XGBoost/CatBoost 等提升库、spaCy、Hyperopt、Ray 等)构建的封装器,提供无缝且灵活的开发。

图片由 Pycaret 提供

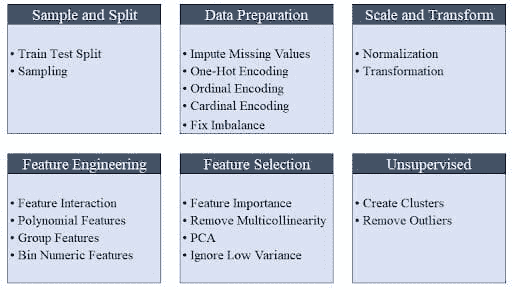

PyCaret 简单易用,其操作按顺序存储在一个准备部署的管道中。PyCaret 自动处理预处理、特征工程以及超参数调优,全部开箱即用。

图片由 Moez Ali 提供

它的模型库拥有超过 70 个未经训练的模型,适用于分类、回归、聚类等任务,模块覆盖了包括监督和无监督方法在内的广泛领域。

PyCaret 一应俱全——无论是与 SHAP 框架的集成以实现可解释性,还是与 MLFlow 的集成以跟踪实验。

安装

Pycaret 可以使用 pip 安装。默认安装仅安装硬依赖项,如下所示。

pip install pycaret

要安装完整版本,请在终端/命令行中运行以下命令。

pip install pycaret[full]

亲自动手!

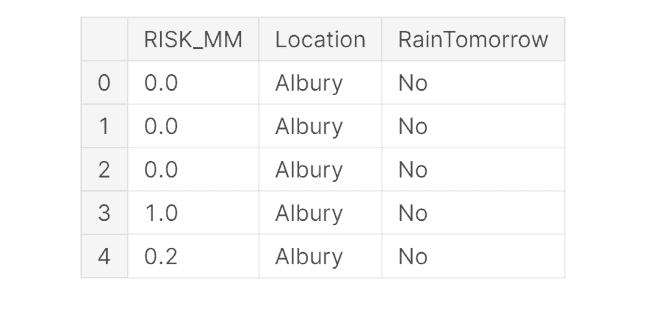

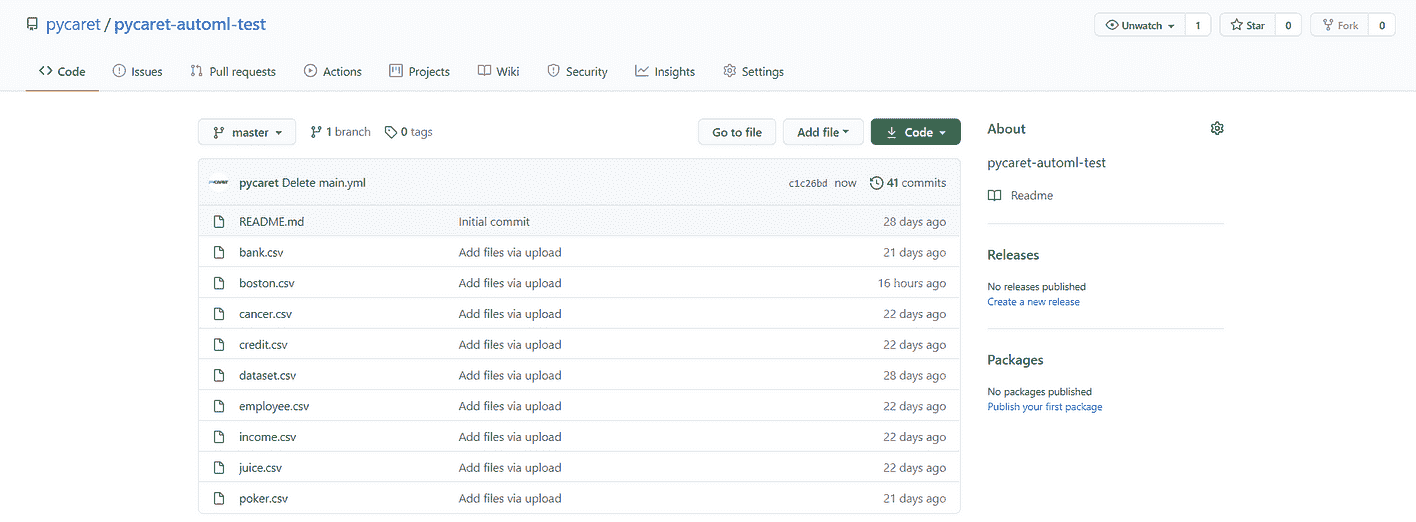

Pycaret 提供一些标准的 数据集。我们将使用“波士顿住房价格”数据集 (boston.csv) 进行本教程。

首先,让我们导入诸如 PyCaret 中的“get_data”库,用于将数据加载到 Jupyter 环境中,以及“plotly express”库用于绘图/绘制图表。

from pycaret.datasets import get_data

import plotly.express as px

from pycaret.regression import *

如果在导入库时遇到任何错误,可能是因为需要先解决的依赖性问题。请注意,PyCaret 目前不兼容 Python 3.9。本演示使用的是 Google Colab 中的 Python 3.7。

使用之前从 pycaret.datasets 导入的 get_data 函数将数据集加载到 Jupyter Notebook 中。get_data 函数返回一个数据框,可以按如下所示进行存储。

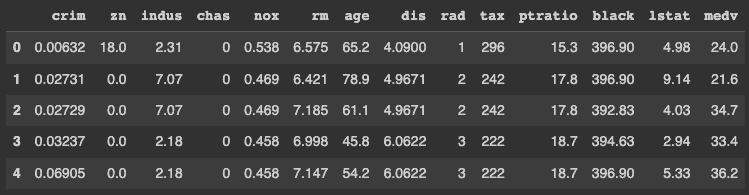

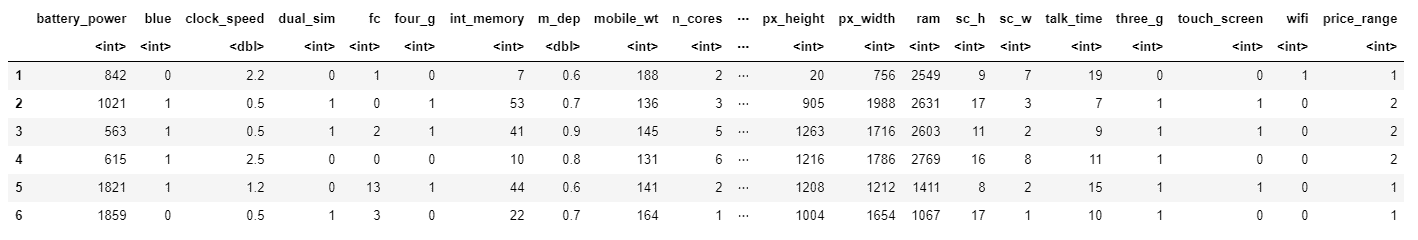

data = get_data('boston')

PyCaret 默认显示数据框的前五行。因此,你不需要显式调用 dataframe.head() 函数。

数据集中的每一行代表波士顿地区的一个郊区或城镇。数据最初来自 1970 年的波士顿标准大都市统计区(SMSA),数据字典来源于 这里。

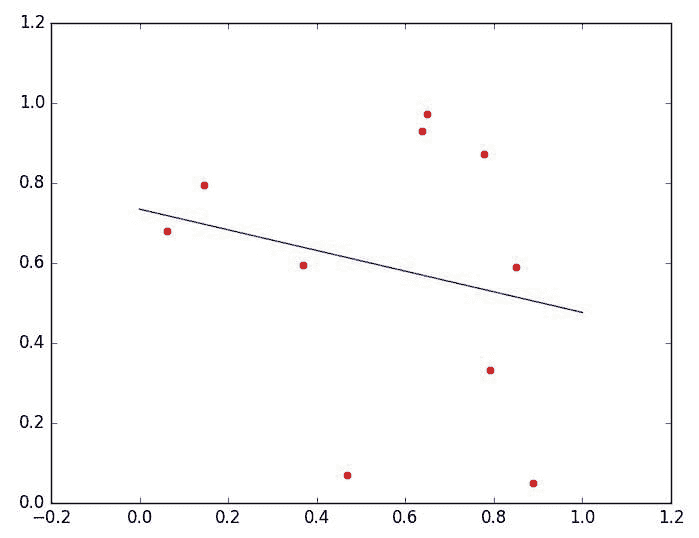

我们正在解决一个回归问题,考虑到目标变量 MEDV 的连续性。

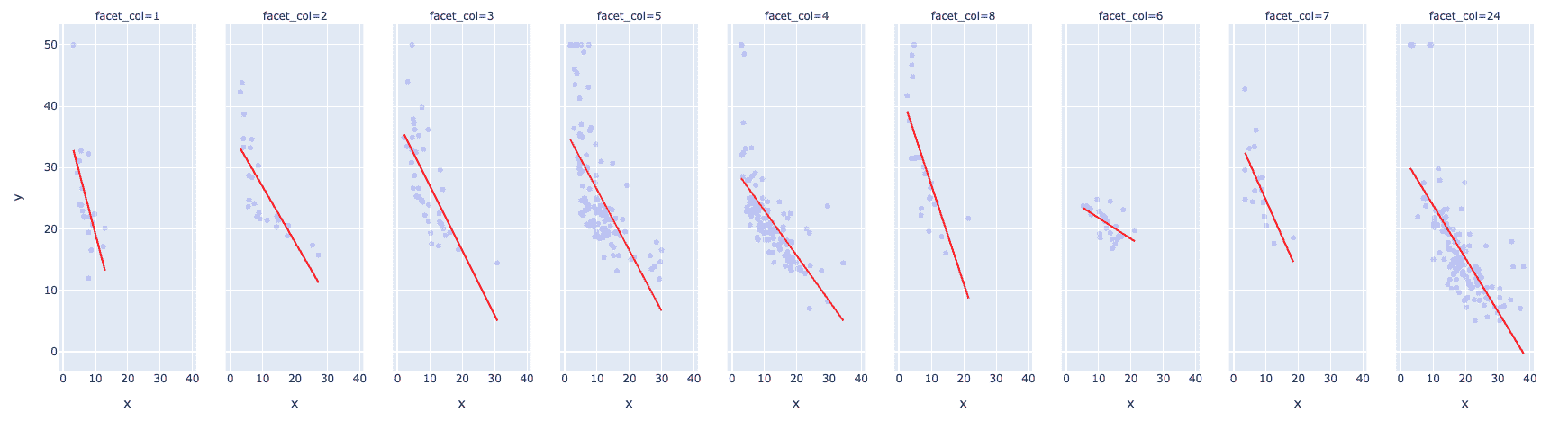

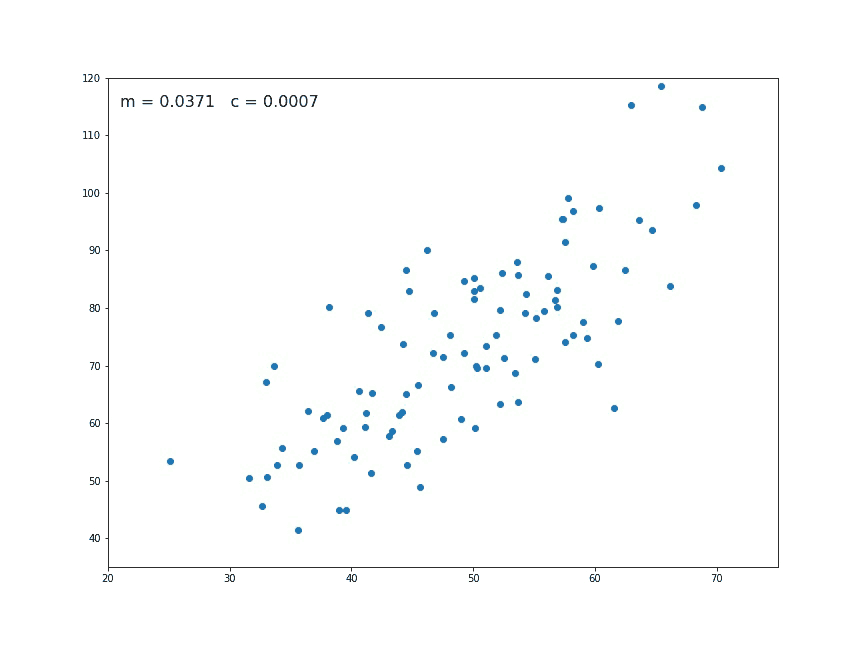

下面的图表展示了具有以下特征的有趣散点图:

-

中位数自有住房价值(MEDV,单位为$1000)与人口低社会经济地位百分比(LSTAT)之间的双变量分布

-

将径向公路(RAD)的可达性指数作为一个分面列(相当于 Seaborn 中的“色调”)添加到方程中

-

使用 trendline 参数值为 “OLS” 的趋势线,表示普通最小二乘法

-

使用参数 trendline_color_override 将趋势线的颜色设置为红色以便于可见

fig = px.scatter(x = data['lstat'], y = data['medv'], facet_col =

data['rad'], opacity = 0.2, trendline = 'ols',

trendline_color_override = 'red')

fig.show()

图表显示了中位数住房价格与人口低社会经济地位之间的强负相关关系。这意味着人口的经济状况越弱,可支配收入越低,因此住房价格也会越低。

RAD 值为 24 的数据拟合效果良好,排除了一些异常值,并且在记录数量方面有不错的支持。

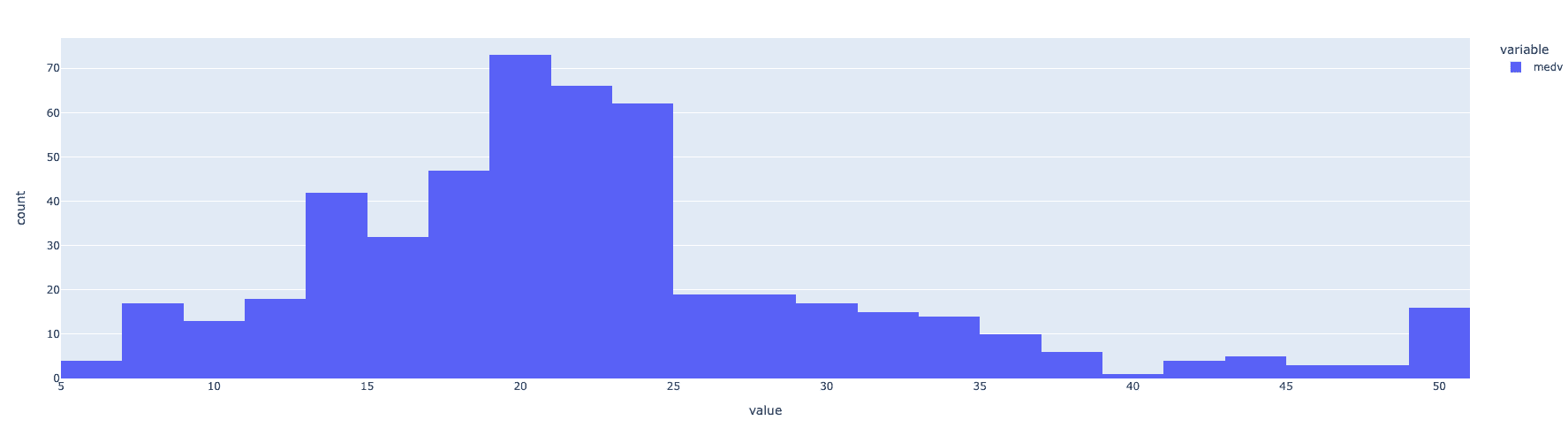

查看目标变量,即 MEDV 的分布,似乎在除了一些异常值外,分布相当接近正态分布。

fig = px.histogram(data, x=["medv"])

fig.show()

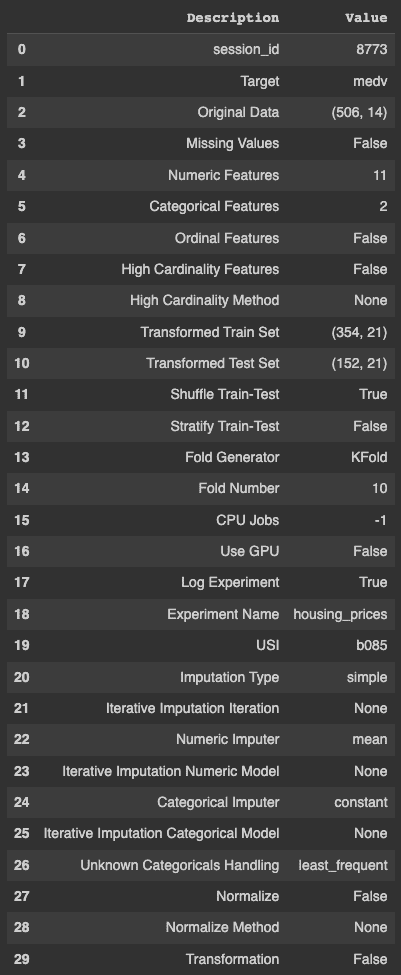

使用 setup 函数设置 PyCaret 实验非常简单。该函数使用以下参数作为输入——数据框、目标变量名称、一个用于记录实验结果的布尔值以及名称。

s = setup(data, target = 'medv', log_experiment = True,

experiment_name = 'housing_prices')

从 PyCaret 输出可以明显看出,它自动完成了许多任务,包括但不限于识别缺失值、连续和分类特征、变量的基数、划分训练集和测试集,并执行交叉验证,这些都需要相当的时间和资源。

一旦实验设置完成,你需要运行 compare_models() 来对特定问题的多种算法进行实验。以下代码将最佳模型存储在一个变量中。

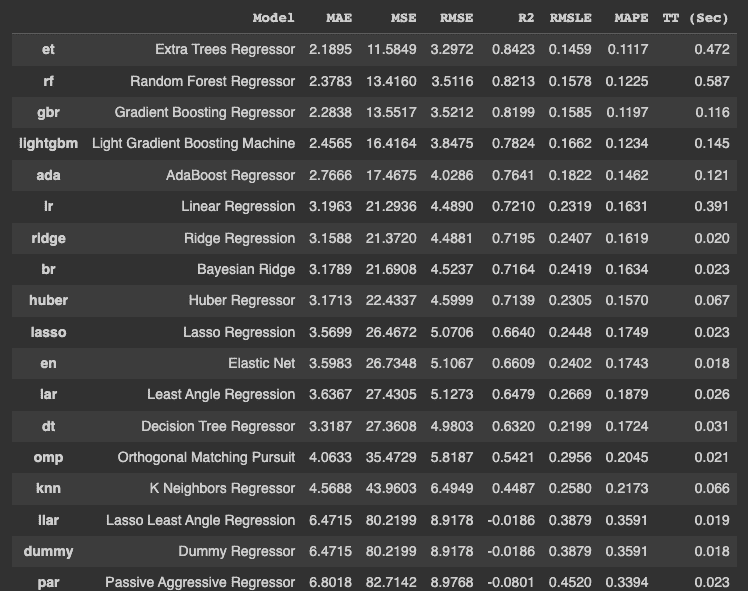

best_model = compare_models()

上述代码在不同算法上训练和测试模型,并按错误的升序排列它们。它还显示了以秒为单位的训练时间,在最后一列中以 ‘TT (Sec)’ 表示。

值得注意的是,训练时间是基于使用所有 CPU 核心的,在不同机器上可能会有所不同。

“get_params()” 方法用于检索最佳模型的超参数,在我们的例子中,这个最佳模型是 Extra Tree Regressor。

best_model.get_params()

{'bootstrap': False

'ccp_alpha': 0.0,

'criterion': 'mse',

'max_depth': None,

'Max_features': 'auto',

'max_leaf_nodes': None,

'max_samples': None,

'min_impurity_decrease': 0.0,

'min_impurity_split': None,

'min_samples_leaf': 1,

'min_samples_split': 2,

'min_weight_fraction_leaf': 0.0,

'n_estimators': 100,

'n_jobs': -1,

'oob_score': False,

'random _state': 8773,

'verbose': 0,

'warm_start': False}

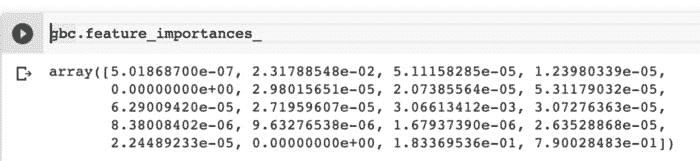

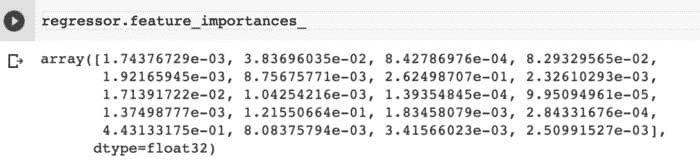

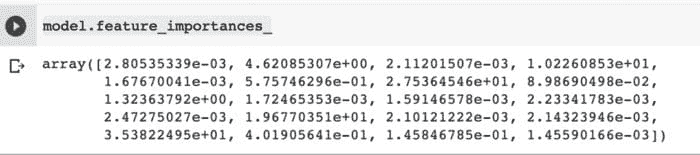

特征重要性可以使用以下代码绘制。

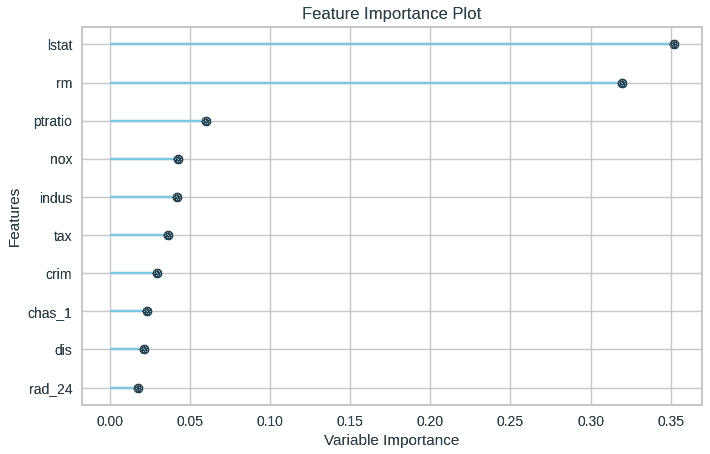

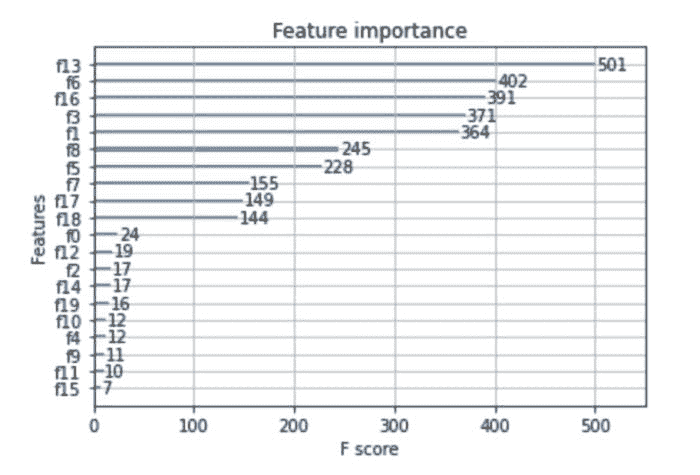

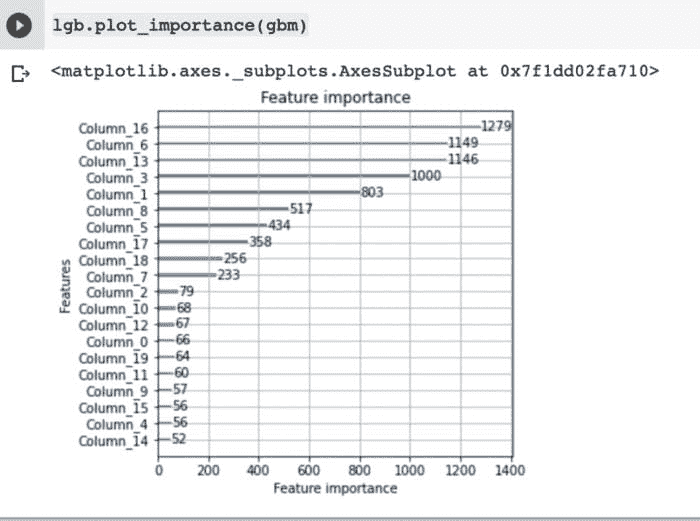

plot_model(best_model, plot = 'feature')

该可视化使得识别前 n 个特征变得更容易,最重要的特征位于顶部。

模型预测使用 predict_model() 函数生成。

data_cpy = data.copy()

data_cpy.drop(‘medv’, axis = 1, inplace = True)

y_pred = predict_model(best_model, data = data_cpy)

save_model() 函数用于保存训练好的模型以便于部署。

save_model(best_model, 'my_best_pipeline')

总结

在这篇文章中,你了解了 PyCaret 如何通过自动化大量重复任务来简化许多数据科学家和机器学习工程师的工作。文章还演示了如何使用 PyCaret 包自动化机器学习管道中的标准步骤。

Vidhi Chugh 是一位 AI 策略专家和数字化转型领袖,她在产品、科学和工程的交汇处工作,致力于构建可扩展的机器学习系统。她是获奖的创新领袖、作者和国际演讲者,致力于使机器学习普及并打破术语,使每个人都能参与这一转型。

更多主题

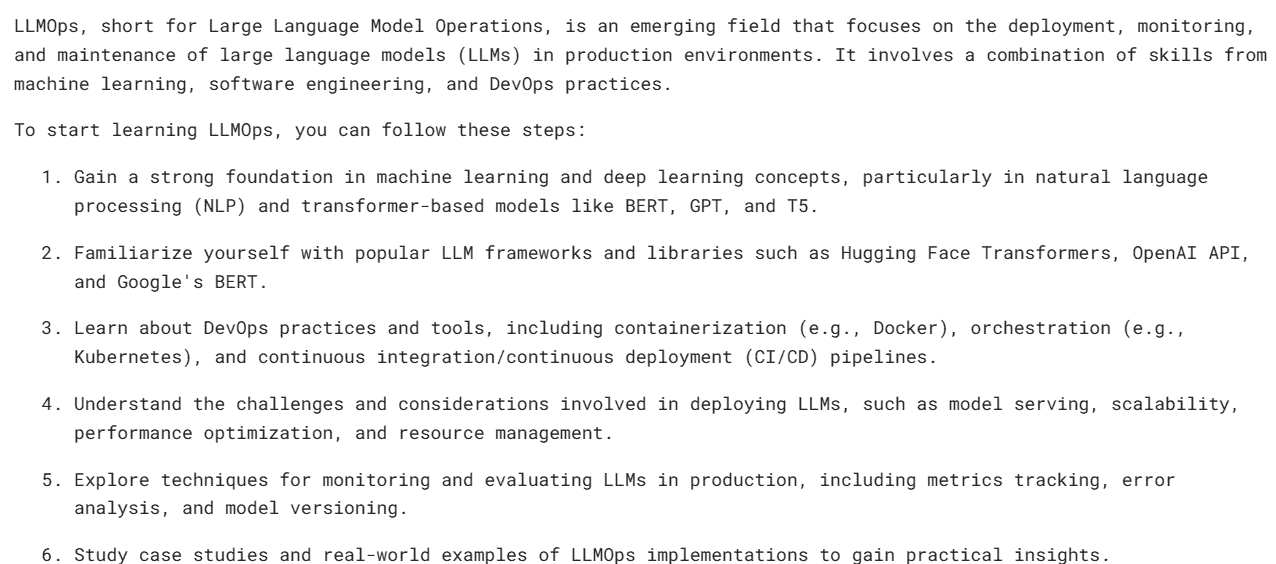

使用 Python 和 Apache Flink 入门

原文:

www.kdnuggets.com/2015/11/getting-started-python-apache-flink.html

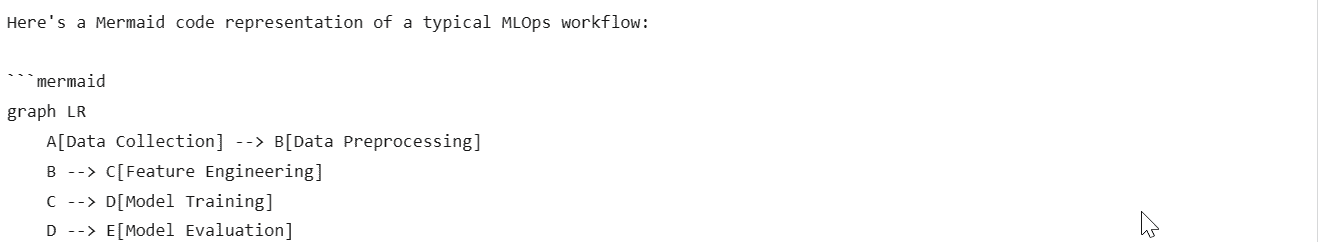

在我关于 Apache 中大数据/机器学习项目广度的上一篇文章之后,我决定尝试一些更大的项目。这篇文章作为一个简要指南,帮助你开始使用全新的 python API 来进入 Apache Flink。Flink 在高层次上与 Spark 非常相似,但其底层是一个真正的流处理平台(与 Spark 的小而快速的批处理流式处理方法相对)。这催生了许多有趣的用例,在这些用例中,大量的数据需要快速且复杂地处理。

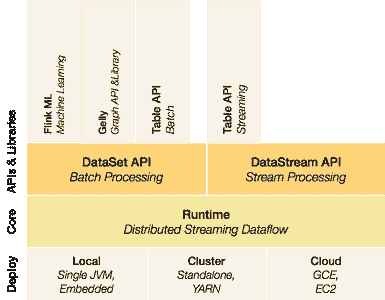

基本思想是一个代码流平台,上面有两个处理 API 和一组库。

图 1 Flink 架构。

在 Flink 的 1.0 版本中,将提供一个 python API,类似于 Spark。虽然在 1.0 之前的版本中已有,但存在已知的错误,使其使用变得困难或不可能。因此,首先,我们需要构建 master 分支(除非你正在阅读的是 v1.0 版本的内容,如果是这种情况,只需按照Flink 的说明进行构建)。

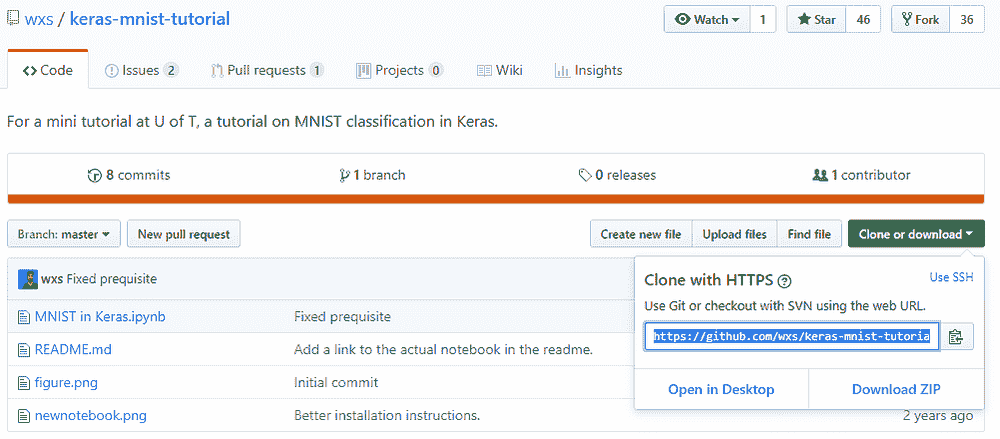

git clone https://github.com/apache/flink

cd flink mvn clean install -DskipTests

此时,最新版本的 Flink 构建将会在 flink 目录下的 build-target 中创建符号链接。你可以用以下命令启动 Flink。

./build-target/bin/start-cluster.sh ./build-target/bin/start-webclient.sh

这将启动一个简单的用户界面,地址是 localhost:8080,以及一个作业管理器和一个任务管理器。现在我们可以运行一个简单的脚本,为你的项目创建一个新的目录,并在其中创建一个 python 文件:

cd .. mkdir flink-examples cd flink-examples touch wordcount.py

然后将 Flink 文档中的示例稍微修改后添加到 wordcount.py 中:

from flink.plan.Environment import get_environment

from flink.plan.Constants import INT, STRING, WriteMode

from flink.functions.GroupReduceFunction \

import GroupReduceFunction

class Adder(GroupReduceFunction):

def reduce(self, iterator, collector):

count, word = iterator.next()

count += sum([x[0] for x in iterator])

collector.collect((count, word))

if __name__ == "__main__":

output_file = 'file:///.../flink-examples/out.txt'

print('logging results to: %s' % (output_file, ))

env = get_environment()

data = env.from_elements("Who's there? I think \

I hear them. Stand, ho! Who's there?")

data \

.flat_map(lambda x, c: [(1, word) for word in \

x.lower().split()], (INT, STRING)) \

.group_by(1) \

.reduce_group(Adder(), (INT, STRING), combinable=True) \

.map(lambda y: 'Count: %s Word: %s' % (y[0], y[1]), STRING) \

.write_text(output_file, write_mode=WriteMode.OVERWRITE)

env.execute(local=True)

并用以下命令运行它:

cd .. ./flink/build-target/bin/pyflink3.sh ~./flink-examples/word_count.py

在 out.txt 中你现在应该能看到:

Count: 1 Word: hear Count: 1 Word: ho! Count: 2 Word: i Count: 1 Word: stand, Count: 1 Word: them. Count: 2 Word: there? Count: 1 Word: think Count: 2 Word: who's

就这样,完全是一个最小的示例,用于在 Apache Flink 中使用 python。代码在这里:github.com/wdm0006/flink-python-examples,我会在这个仓库中以及这里添加更多的高级示例。

简介: Will McGinnis, @WillMcGinnis,拥有奥本大学机械工程学位,但现在主要从事软件开发。他是 Predikto 的首位员工,目前帮助构建该公司在重工业领域的预测性维护顶级平台。在工作之余,他通常会从事与 Python、Flask、scikit-learn 或骑行相关的工作。

原文.

相关内容

-

Apache Flink 及流处理的案例

-

快速大数据: Apache Flink 与 Apache Spark 在流数据处理中的对比

-

采访: Stefan Groschupf,Datameer 谈分析中的准确性与简洁性的平衡

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

更多相关主题

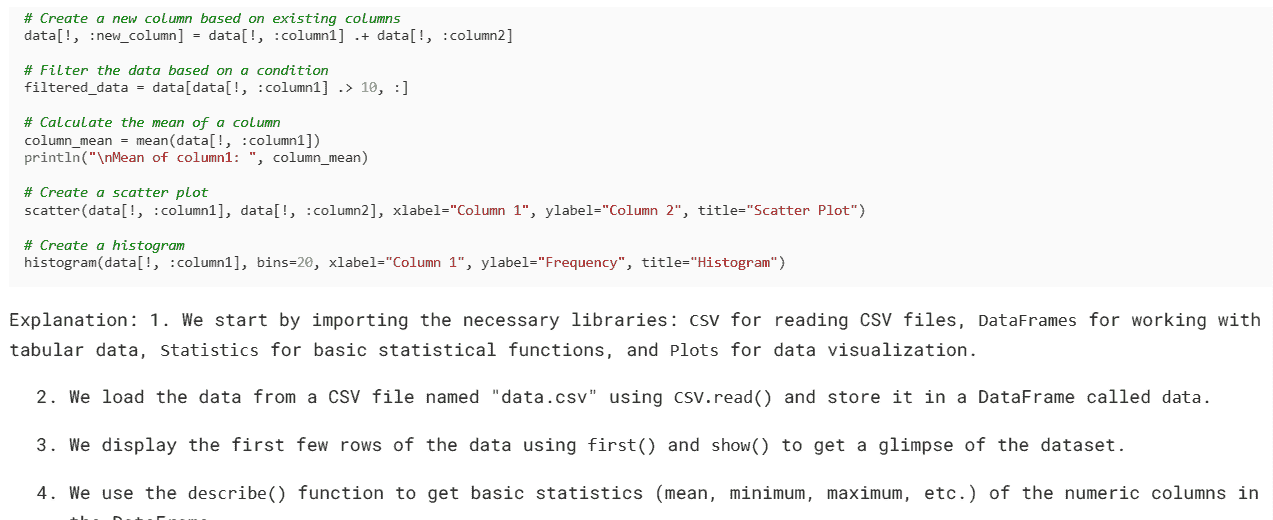

开始使用 Python 进行数据分析

原文:

www.kdnuggets.com/2017/07/getting-started-python-data-analysis.html

一位朋友最近问了这个问题,我认为如果在这里发布可能会对其他人有帮助。这是为那些对 Python 完全陌生的人准备的,旨在提供从零到一的最简单路径。

-

下载适用于你的操作系统的 Python 3.X 版本的 Anaconda 发行版,点击这里。选择这个预打包的发行版可以避免很多安装相关的问题。它附带了大多数重要的数据分析包。

-

一旦安装完成,测试以确保默认的 Python 解释器是你刚刚安装的那个。这很重要,因为你的系统可能已经安装了一个 Python 版本,但它不包含 Anaconda 包中的所有好东西,因此你需要确保新安装的版本是默认的。在 Mac/Linux 上,这可能意味着在终端中输入

which python。或者你可以直接运行 Python 解释器,确保版本与你下载的一致。如果一切顺利,安装时应该已经完成。如果没有,你需要在这里停止并修复它。 -

在你的 shell 中输入

jupyter notebook命令。这应该会打开一个浏览器窗口。如果没有,打开浏览器并导航到http://localhost:8888。在那里,创建一个新的 Python 笔记本。 -

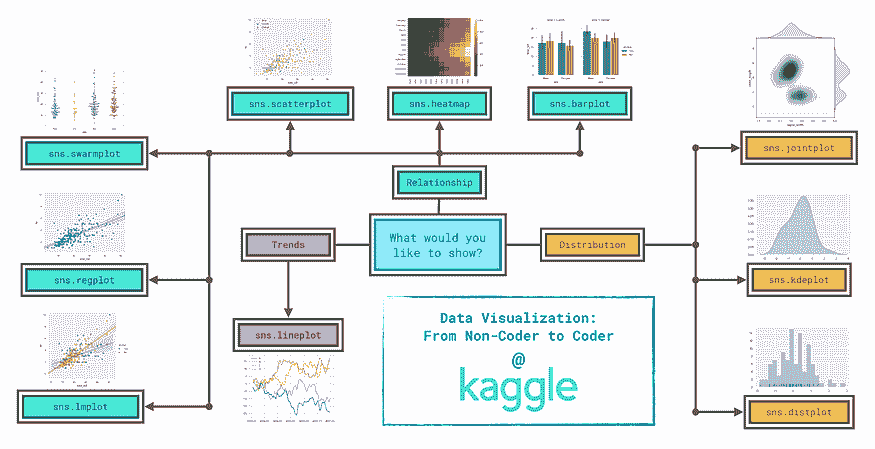

前往 www.kaggle.com 的 kernels 部分,并筛选 Python kernels。这些大多是其他人在 Kaggle 网站上免费提供的数据集上进行分析或构建模型的 jupyter 笔记本。寻找标题中包含 EDA(探索性数据分析)的笔记本,而不是那些构建预测模型的笔记本。找一个感兴趣的,开始在你的笔记本中重建它。

注意:你会发现当你尝试重建这些分析时会遇到导入错误。这可能是因为他们安装了不包含在 Anaconda 发行版中的包。你最终需要学习如何与 conda 包管理器交互,这将是你将来需要面对的众多问题之一。通常只需使用

conda install <package_name>,但你需要找到正确的包名称,有时还需要指定其他详细信息。有时你还需要使用pip install <other_package_name>,但这些都将在后面学习。

高级库总结

这是你将频繁互动的重要库的快速总结。

-

NumPy:具有很多科学计算的核心功能。在底层调用的是 C 编译代码,因此比用 Python 编写的相同函数要快得多。不是最用户友好的。

-

SciPy:类似于 NumPy,但提供了更多从分布中抽样、计算检验统计量等的手段。

-

MatPlotLib:主要的绘图框架。一个必要的恶习。

-

Seaborn:在 MatPlotLib 后导入,它会默认使你的图表更美观。虽然也有自己的功能,但我发现最酷的功能运行得太慢。

-

Pandas:主要是对 NumPy/SciPy 的一个简单封装,使其更易于使用。非常适合与称为 DataFrame 的数据表交互。还提供了绘图功能的封装,以便快速绘图,同时避免了 MPL 的复杂性。我主要使用 Pandas 来处理数据。

-

Scikit-learn:拥有许多监督和无监督机器学习算法。还提供许多用于模型选择的指标和一个很好的预处理库,用于执行如主成分分析或编码分类变量等任务。

快速提示

-

在 jupyter 笔记本中,在运行单元格前在任何对象前加上问号,它将打开该对象的文档。当你忘记了你尝试调用的函数需要你传递哪些参数时,这非常有用。例如,

?my_dataframe.apply将解释pandas.DataFrame对象的apply方法,这里用my_dataframe代表。 -

你可能总是需要参考你使用的任何库的文档,所以最好在浏览器中保持文档打开。因为可选参数和细节太多了。

-

在不可避免的故障排除任务中,stackoverflow 可能有答案。

-

接受你将会做一些你暂时无法完全理解的事情,否则你可能会被那些不重要的细节所困扰。有一天你可能需要了解虚拟环境,这其实并不难,但有许多这样的绕道会给刚入门的人带来不必要的痛苦。

-

阅读其他人的代码。这是学习规范和最佳实践的最佳方式。这就是 Kaggle 内核真正有帮助的地方。GitHub 还支持在浏览器中显示 jupyter 笔记本,因此网络上有大量的示例。

原文。已获得许可转载。

简介: Zak Jost 是亚马逊网络服务公司在西雅图地区的研究科学家。

相关:

-

相关性介绍

-

掌握 Python 数据准备的 7 个步骤

-

数据科学基础:从数据中可以挖掘出哪些模式?

更多相关话题

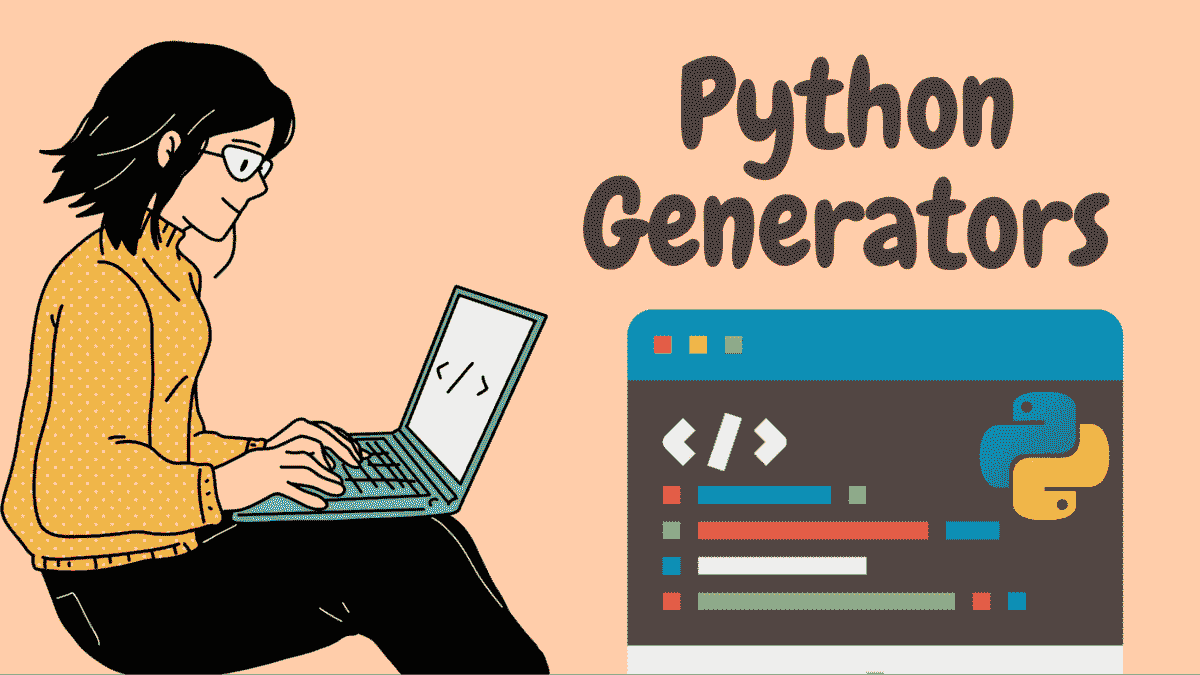

入门 Python 生成器

原文:

www.kdnuggets.com/2023/02/getting-started-python-generators.html

图片由作者提供

学习如何使用 Python 生成器可以帮助你编写更 Pythonic 和高效的代码。当你需要处理大型序列时,使用生成器尤其有用。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

在本教程中,你将学习如何通过定义生成器函数和生成器表达式来使用 Python 生成器。然后你将了解到,使用生成器可以是一个内存高效的选择。

在 Python 中定义生成器函数

要理解生成器函数与普通 Python 函数的不同,让我们从一个常规的 Python 函数开始,然后将其重写为生成器函数。

请考虑以下函数 get_cubes()。它接受一个数字 num 作为参数,并返回数字 0、1、2 直到 num -1 的立方列表:

def get_cubes(num):

cubes = []

for i in range(num):

cubes.append(i**3)

return cubes

上述函数通过遍历数字 0、1、2,直到 num -1,并将每个数字的立方添加到 cubes 列表中。最后,它返回 cubes 列表。

你已经可以看出,这不是创建新列表的推荐 Pythonic 方式。与其使用 for 循环并使用 append() 方法,你可以使用一个 列表推导式 表达式。

这是使用列表推导式而不是显式的 for 循环和 append() 方法的 get_cubes() 函数的等效形式:

def get_cubes(num):

cubes = [i**3 for i in range(num)]

return cubes

接下来,让我们将这个函数重写为生成器函数。下面的代码片段展示了如何将 get_cubes() 函数重写为生成器函数 get_cubes_gen():

def get_cubes_gen(num):

for i in range(num):

yield i**3

从函数定义中,你可以看出以下区别:

-

我们使用 yield 关键字,而不是 return 关键字。

-

我们不返回一个序列或填充一个可迭代对象,如 Python 列表,以获取序列。

那么生成器函数是如何工作的呢?为了理解,让我们调用上述定义的函数并仔细查看。

理解函数调用

让我们调用 get_cubes() 和 get_cubes_gen() 函数,看看它们在各自函数调用中的区别。

当我们用数字 6 作为参数调用get_cubes()函数时,我们得到预期的立方列表。

cubes_gen = get_cubes_gen(6)

print(cubes_gen)

Output >> [0, 1, 8, 27, 64, 125]

现在用相同的数字 6 作为参数调用生成器函数,看看会发生什么。你可以像调用普通 Python 函数一样调用生成器函数get_cubes_gen()。

cubes_gen = get_cubes_gen(6)

print(cubes_gen)

如果你打印出cubes_gen()的值,你会得到一个生成器对象,而不是包含每个数字立方的整个结果列表。

Output >> <generator object get_cubes_gen at 0x011B6530>

那么你如何访问序列中的元素呢? 要进行编码,请启动一个 Python REPL 并导入生成器函数。在这里,我将代码放在了gen_example.py文件中,因此我从get_cubes_gen()模块中导入了get_cubes_gen()函数。

>>> from gen_example import get_cubes_gen

>>> cubes_gen = get_cubes_gen(6)

你可以用生成器对象作为参数调用next()。这样做会返回 0,即序列中的第一个元素。

>>> next(cubes_gen)

0

现在当你再次调用next()时,你会得到序列中的下一个元素,即 1。

>>> next(cubes_gen)

1

要访问序列中的后续元素,你可以继续调用next(),如所示:

>>> next(cubes_gen)

8

>>> next(cubes_gen)

27

>>> next(cubes_gen)

64

>>> next(cubes_gen)

125

对于num = 6,结果序列是数字 0、1、2、3、4 和 5 的立方。现在我们已经到达了 125,5 的立方,当你再次调用 next() 时会发生什么?

我们看到StopIteration异常被抛出。

>>> next(cubes_gen)

Traceback (most recent call last):

File "<stdin>", line 1, in <module>

StopIteration</module></stdin>

从底层来看,生成器函数会执行直到遇到yield语句,控制权会返回到调用点。然而,与正常的 Python 函数不同,生成器函数在return语句之后会暂时挂起执行,并保持其状态,这有助于我们通过调用next()获取后续元素。

你也可以使用 for 循环遍历生成器对象。当StopIteration异常被抛出时,控制会退出循环(这就是 for 循环在底层的工作原理)。

for cube in cubes_gen:

print(cube)

# Output

0

1

8

27

64

125

cubes_gen = (i**3 for i in range(num))

Python 中的生成器表达式

另一种常见的使用生成器的方法是使用生成器表达式。这里是get_cubes_gen()函数的生成器表达式等效版本:

cubes_gen = (i**3 for i in range(num))

上述生成器表达式可能看起来与列表推导类似,只是使用了()代替[]。然而,正如讨论的那样,存在以下关键差异:

-

列表推导表达式生成整个列表并将其存储在内存中。

-

另一方面,生成器表达式按需生成序列的元素。

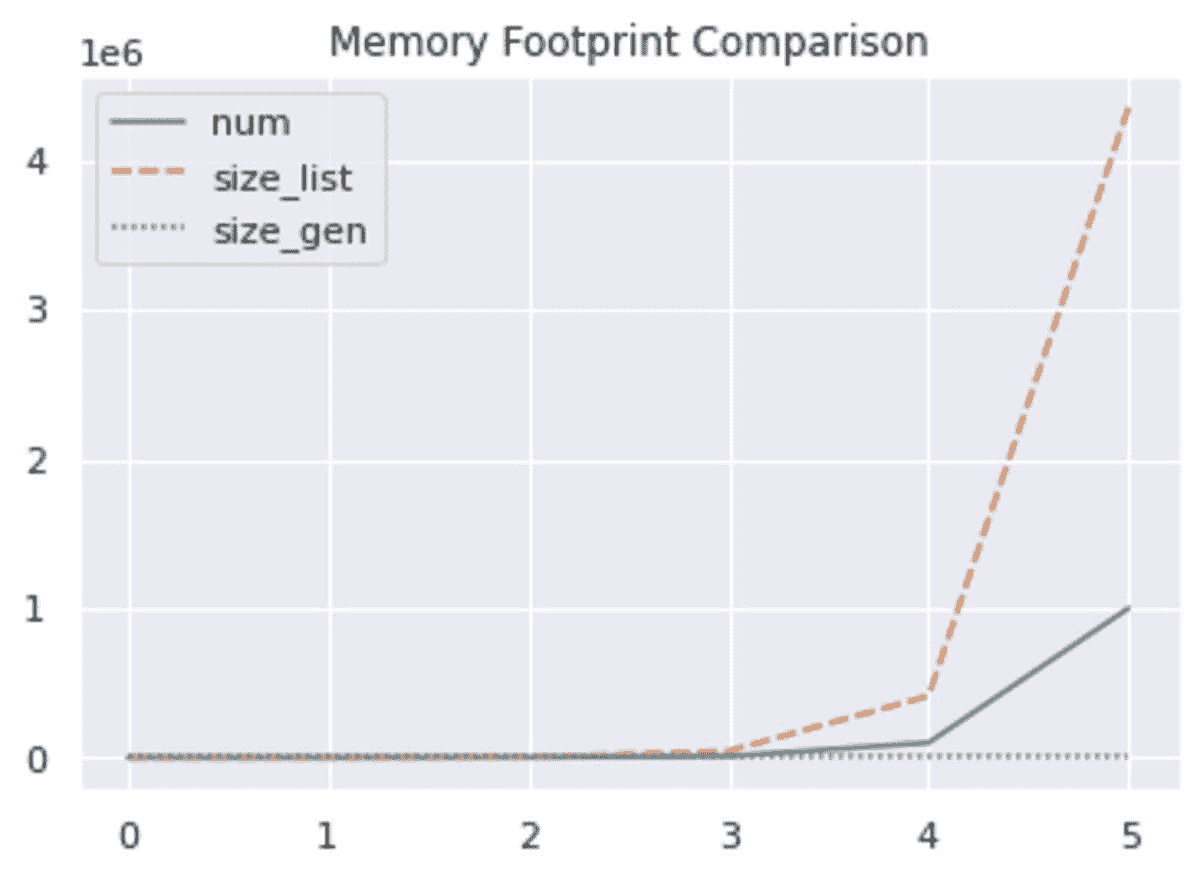

Python 生成器与列表:理解性能改进

在上一节的示例函数调用中,我们生成了从零到五的数字的立方序列。对于这样的短小序列,使用生成器可能不会给你带来显著的性能提升。然而,当你处理较长的序列时,生成器无疑是一个节省内存的选择。

要查看实际效果,可以生成一个更广范围内 num 值的立方序列:

size_l = []

size_g = []

# run for various values of num

for i in [10, 100, 1000, 10000, 100000, 1000000]:

cubes_l = [j**3 for j in range(i)]

cubes_g = (j**3 for j in range(i))

# get the sizes of static list and generator expression

size_l.append(sys.getsizeof(cubes_l))

size_g.append(sys.getsizeof(cubes_g))

现在让我们打印出静态列表和生成器对象在内存中的大小(如上面代码片段中num变化时):

print(f"size_l: {size_l}")

print(f"size_g: {size_g}")

从输出中我们看到,生成器对象具有恒定的内存占用,而列表的内存随着num的增加而增长。这是因为生成器执行延迟评估并按需生成序列中的后续值。它不会提前计算所有值。

# Output

size_l: [92, 452, 4508, 43808, 412228, 4348728]

size_g: [56, 56, 56, 56, 56, 56]

为了更好地了解静态列表和生成器的大小如何随num的变化而变化,我们可以绘制num的值以及列表和生成器的大小,如下所示:

在上图中,我们看到当num增加时,生成器的大小保持不变,而列表的大小则极为庞大。

结论

在本教程中,你已经了解了生成器在 Python 中的工作原理。下次你需要处理大型文件或数据集时,可以考虑使用生成器来高效地进行迭代。当你使用生成器时,可以对生成器对象进行迭代,读取一行或一小块,处理或应用所需的变换,而不需要将原始数据集存储在内存中。然而,请记住,你不能将这些值存储在内存中以便以后处理。如果需要,你必须使用列表。

Bala Priya C 是一位技术写作人,喜欢创作长篇内容。她的兴趣领域包括数学、编程和数据科学。她通过编写教程、操作指南等形式与开发者社区分享她的学习成果。

更多相关内容

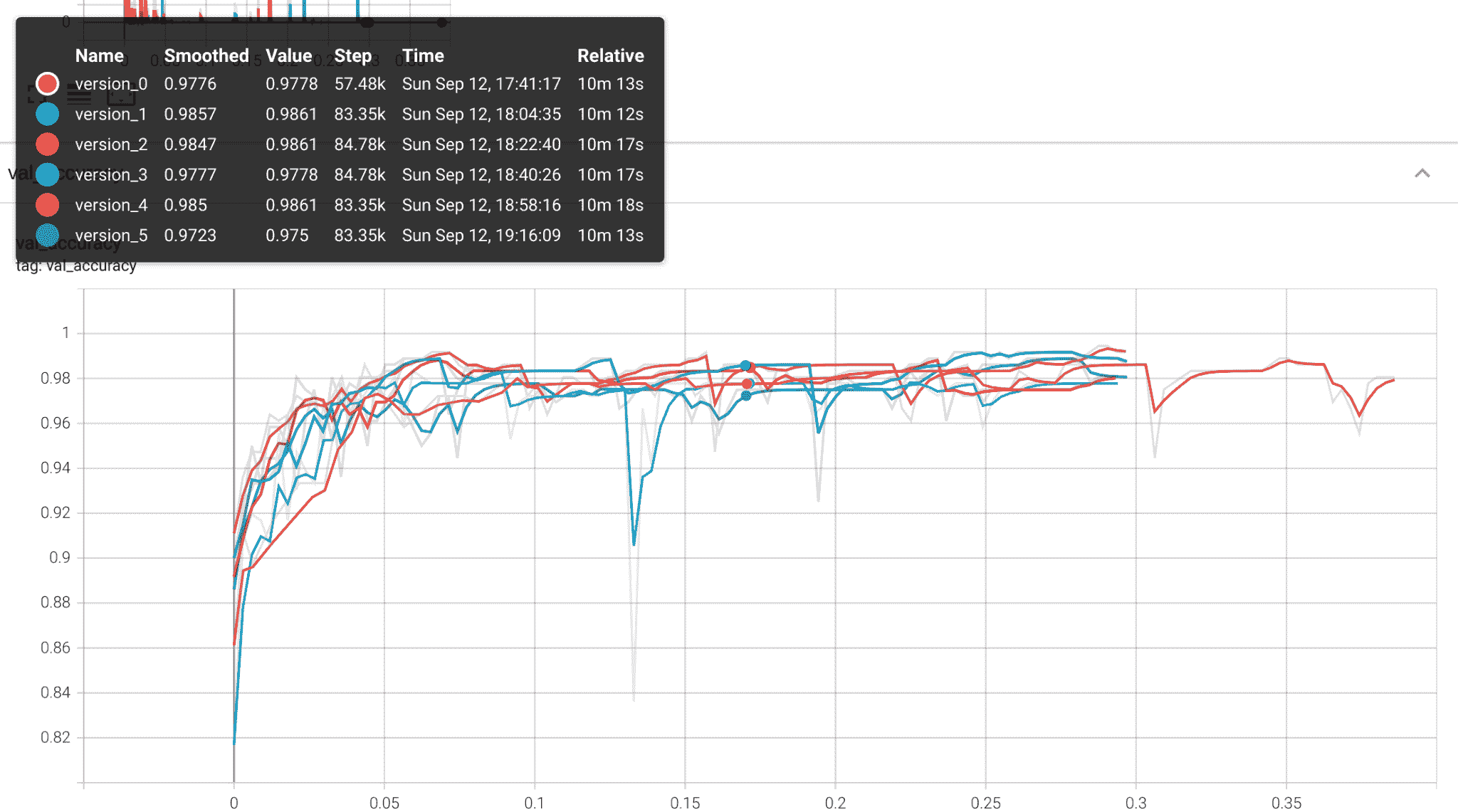

PyTorch Lightning 入门

原文:

www.kdnuggets.com/2021/10/getting-started-pytorch-lightning.html

评论

PyTorch Lightning 入门:高性能研究的高级库

像 TensorFlow 和 PyTorch 这样的库处理了大多数构建深度学习模型时的复杂性,这些模型既能快速训练又能快速推断。可以预测的是,这使得机器学习工程师大部分时间都花在了抽象的下一层级上,进行超参数搜索、验证性能,以及对模型和实验进行版本管理,以跟踪所有内容。

深度学习远不止将一些层拼接在一起。

如果说 PyTorch 和 TensorFlow(现在还有 JAX)是深度学习的蛋糕,那么更高层次的库就是糖霜。多年来,TensorFlow 在高层次的 Keras API 上有了它的“糖霜”,该 API 自 2019 年 TF 2.0 发布后成为 TensorFlow 的官方部分。同样,PyTorch 用户受益于高层次的 fastai 库,该库在效率和迁移学习方面表现非常出色。这使得 fastai 成为 Kaggle 竞赛平台上成功数据科学家的最爱。最近,另一个简化的 PyTorch 封装库在恰如其名的 PyTorch Lightning 中迅速获得关注。

PyTorch Lightning 实际上从 2019 年起就存在,至少在某种程度上。它起初是 William Falcon 在纽约大学攻读博士期间进行的一个副项目。到 2020 年(我们指的是从 3 月开始的 2020 年),PyTorch Lightning 不再只是个人项目,因为 Falcon 宣布了风险投资。与此同时,开源(在 Apache 2.0 许可证下)代码库从 Falcon 的个人 GitHub 账户迁移到了其专用的个人资料。截止目前,PyTorch Lightning 已增长到超过 15,000 个星标和近 2,000 个分叉,几乎与 fastai(有超过 21,000 个星标)一样受欢迎,并且明显比 PyTorch 内部的高层次库 Ignite(约有 4,000 个星标)更受欢迎!

fastai 旨在促进首个 fastai 课程, 实用深度学习编程课程,而 PyTorch Lightning 的目的是简化生产研究。Fastai 专注于迁移学习和效率,其易用性使其成为 Kaggle 数据科学竞赛平台上受欢迎的高级库,有超过 4,500 个笔记本 参考该库。相比之下,关于 PyTorch Ignite 的只有 100 多个 笔记本,而 PyTorch Lightning 有 约 500 个。PyTorch Lightning 是一个相对较新的库,但它也针对不同的用户群体。PyTorch Lightning 简化了开发新模型的工程方面,如日志记录、验证和钩子,目标是机器学习研究人员。

研究就是回答和验证问题,在本教程中,我们将看看 PyTorch Lightning 如何帮助我们简化这个过程。我们将设置一个简单的模拟研究问题,是否使用“高级”激活函数(如所谓的 swish 函数)相较于更标准的修正线性单元(ReLU)具有任何优势。我们将使用来自 SciKit-Learn 的极其小的数字数据集来设置实验。从数字开始应该使这个项目对在高效笔记本上运行代码的人更易于访问,但鼓励读者使用更真实的图像数据集,如 CIFAR10,以获取额外积分。

作为一个专为生产研究设计的库,PyTorch Lightning 也简化了硬件支持和分布式训练,我们将在最后展示如何轻松将训练转移到 GPU。

开始使用:安装 PyTorch Lightning

现在许多 Python 项目都可以轻松通过 pip 安装 PyTorch Lightning,我们建议使用你喜欢的虚拟环境管理器来管理安装和依赖项,以免混乱你的基本 Python 安装。我们将提供三个示例,第一个是使用 virtualenv 和 pip,我们假设你使用的是 Linux 或 Mac 的 Unix 风格命令行,或者你足够聪明,可以使用类似 Git Bash 或 Anaconda Prompt 的工具适配 Windows。导航到本教程的项目文件夹后:

virtualenv ptl_env --python=python3

source ptl_env/bin/activate

pip install pytorch-lightning

pip install torchvision

pip install scikit-learn

你也可以使用 Anaconda来管理你的虚拟环境:

conda create -n ptl_env

conda activate ptl_env

conda install -n ptl_env pytorch-lighnting -c conda-forge

conda install -n ptl_env torchvision

conda install -n ptl_env scikit-learn

或者结合这两者,创建一个新的 Anaconda 环境,然后使用 pip 安装软件包。对于更一般的使用,使用 pip 和 Anaconda 一起有一些 警告,但对于本教程来说应该没问题:

conda create -n ptl_env

conda activate ptl_env

conda install -n ptl_env pip

pip install pytorch-lightning

pip install torchvision

pip install scikit-learn

使用 PyTorch Lightning

PyTorch Lightning 采用的设计策略围绕着 LightningModule 类。这个类继承自pytorch.nn.Module类,提供了一个方便的入口点,并尝试尽可能将训练和验证过程的许多内容组织在一个地方。

这种策略的一个关键特性是,典型的训练和验证循环的内容被定义在模型本身中,可以通过一个类似于 keras、fastai 甚至 SciKit-Learn 的fit API 访问。与其他示例中fit是通过模型本身访问不同,在 PyTorch Lightning 中,fit是通过 Trainer 对象访问的。但我们还是提前了,首先让我们通过导入我们需要的一切来为我们的实验做准备。

import os

import numpy as np

import torch

import torch.nn as nn

import torch.nn.functional as F

from torchvision import transforms

from torch.utils.data import DataLoader, random_split

from torchvision.datasets import MNIST

# for rapid prototyping with a small dataset

import sklearn

import sklearn.metrics

import sklearn.datasets

# for building intuition with a few tens of thousands of samples

from torchvision.datasets import MNIST

import pytorch_lightning as pl

from pytorch_lightning.metrics import functional as FM

然后我们可以继续定义我们的模型:

class MyClassifier(pl.LightningModule):

def __init__(self, dim=28, activation=nn.ReLU()):

super(MyClassifier, self).__init__()

self.image_dim = dim

self.hid_dim = 128

self.num_classes = 10

self.act = activation

self.feature_extractor = nn.Sequential(\

nn.Conv2d(1, 4, 3, padding=1), \

self.act, \

nn.Conv2d(4, 4, 3, padding=1), \

self.act, \

nn.Conv2d(4, 1, 3, padding=1), \

self.act, \

nn.Flatten())

self.head = nn.Sequential(\

nn.Linear(self.image_dim**2, self.hid_dim), \

self.act, \

nn.Linear(self.hid_dim, self.hid_dim), \

self.act, \

nn.Linear(self.hid_dim, self.num_classes))

def forward(self, x):

x = self.feature_extractor(x)

output = self.head(x)

return output

def training_step(self, batch, batch_index):

x, y = batch

output = self.forward(x)

loss = F.nll_loss(F.log_softmax(output, dim = -1), y)

y_pred = output.argmax(-1).cpu().numpy()

y_tgt = y.cpu().numpy()

accuracy = sklearn.metrics.accuracy_score(y_tgt, y_pred)

self.log("train loss", loss)

self.log("train accuracy", accuracy)

return loss

def validation_step(self, batch, batch_idx):

x, y = batch

output = self.forward(x)

loss = F.cross_entropy(output, y)

pred = output.argmax(-1)

return output, pred, y

def validation_epoch_end(self, validation_step_outputs):

losses = 0

outputs = None

preds = None

tgts = None

for output, pred, tgt in validation_step_outputs:

preds = torch.cat([preds, pred]) if preds is not None else pred

outputs = torch.cat([outputs, output], dim = 0) \

if outputs is not None else output

tgts = torch.cat([tgts, tgt]) if tgts is not None else tgt

loss = F.nll_loss(F.log_softmax(outputs, dim = -1), tgts)

y_preds = preds.cpu().numpy()

y_tgts = tgts.cpu().numpy()

fm_accuracy = FM.accuracy(outputs, tgts)

# pytorch lightning prints a deprecation warning for FM.accuracy,

# so we'll include sklearn.metrics.accuracy_score as an alternative

accuracy = sklearn.metrics.accuracy_score(y_tgts, y_preds)

self.log("val_accuracy", accuracy)

self.log("val_loss", loss)

def configure_optimizers(self):

return torch.optim.Adam(self.parameters(), lr=3e-4)

值得注意的是,训练功能被委托给training_step函数中的模块本身。大多数有一定 PyTorch 实践经验的机器学习从业者会对重载forward函数的做法非常熟悉,而 LightningModule 对象还有许多更多的方法可以重载,以实现对内置的相对无痛的日志记录和评估功能的精细控制。

定义我们的MyClassifier模型类的代码可能看起来相当冗长,但这种策略在实际开始训练时大大简化了流程,我们稍后将看到。LightningModule类中包含了许多其他的回调和函数,所有这些都可以被重载以实现更精细的控制。这些回调的完整列表可以在PyTorch Lightning 文档中找到。

在本教程中,我们还将定义一个torch.utils.data.Dataset对象来包装来自 SciKit-Learn 的数字数据集。这应该使得在切换到像 MNIST 或 CIFAR10 这样更大、更具信息量的数据集之前,能够快速地让一切正常运行。

class SKDigitsDataset(torch.utils.data.Dataset):

def __init__(self, mode="train"):

super(SKDigitsDataset, self).__init__()

x, y = sklearn.datasets.load_digits(return_X_y = True)

num_samples = int(x.shape[0] * 0.8)

np.random.seed(42)

np.random.shuffle(x)

np.random.seed(42)

np.random.shuffle(y)

if mode == "train":

self.x = x[:num_samples]

self.y = y[:num_samples]

elif mode == "val":

self.x = x[num_samples:]

self.y = y[num_samples:]

else:

self.x = x

self.y = y

self.transform = lambda my_dict: \

(torch.tensor(my_dict["x"]).float(), \

torch.tensor(my_dict["y"]).long())

def __len__(self):

return self.x.shape[0]

def __getitem__(self, index):

got_x = self.x[index].reshape(-1, 8, 8)

got_y = self.y[index]

sample = {"x": got_x, "y": got_y}

sample = self.transform(sample)

return sample

既然所有的准备工作都完成了,实际启动训练运行变得非常简单。我们只需要创建一个数据集,并将其输入到DataLoader中,实例化我们的模型,创建一个 PyTorch Lightning Trainer对象,然后调用 trainer 的 fit 方法。以下是一个简化版本:

dataset = SKDigitsDataset()

dataloader = DataLoader(dataset)

model = MyClassifier(dim=8)

trainer = pl.Trainer()

trainer.fit(model, dataloader)

但当然,我们会希望在整个训练过程中持续记录验证指标,利用我们在模型中重载的validation_step和validation_epoch_end方法。以下是我用来启动训练运行的实际代码,使用if __name__ == "__main__":模式,这为将 Python 文件作为模块运行提供了一个简单的入口点。

if __name__ == "__main__":

# if using digits from sklearn

train_dataset = SKDigitsDataset(mode = "train")

val_dataset = SKDigitsDataset(mode = "val")

dim = 8

validation_interval = 1.0

train_dataloader = DataLoader(train_dataset)

val_dataloader = DataLoader(val_dataset)

model = MyClassifier(dim=dim, activation=nn.ReLU())