KDNuggets-博客中文翻译-十二-

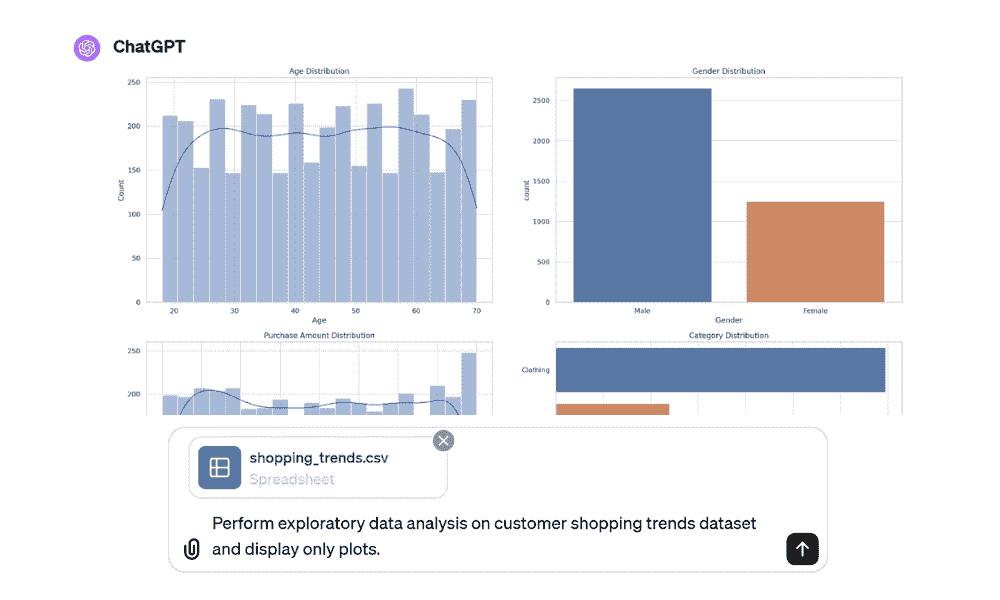

KDNuggets 博客中文翻译(十二)

原文:KDNuggets

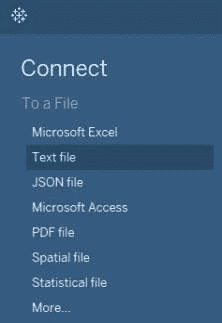

使用 CountVectorizer 将文本文件转换为令牌计数

原文:

www.kdnuggets.com/2022/10/converting-text-documents-token-counts-countvectorizer.html

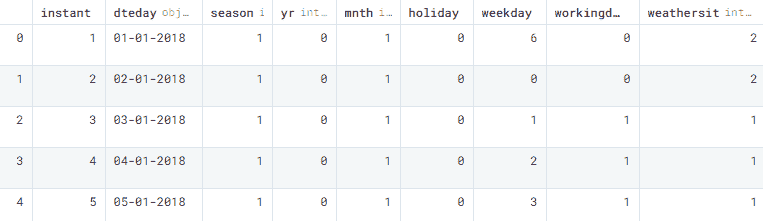

我们每天都在与机器互动——无论是询问“OK Google,设置早上 6 点的闹钟”还是“Alexa,播放我喜欢的播放列表”。但这些机器并不理解自然语言。那么当我们与设备交谈时会发生什么?它需要将语音即文本转换为数字,以便处理信息并学习上下文。在这篇文章中,你将学习一种使用 CountVectorizer 将语言转换为数字的流行工具。Scikit-learn 的 CountVectorizer 用于将文本语料库重新转换并预处理为令牌计数向量表示。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 工作

它是如何工作的?

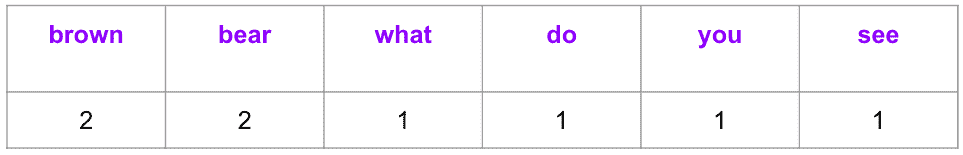

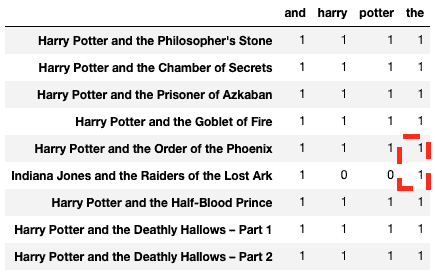

我们以一本流行儿童书的书名为例来说明 CountVectorizer 是如何工作的。

text = ["Brown Bear, Brown Bear, What do you see?"]

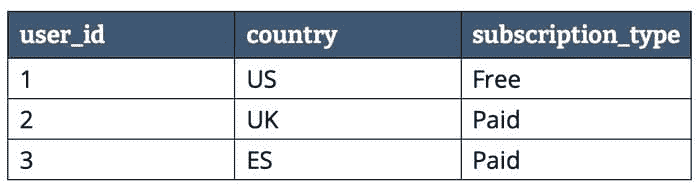

向量中有六个独特的词,因此向量表示的长度为六。该向量表示每个令牌/词在文本中的出现频率。

让我们添加另一个文档到我们的语料库中,以观察结果矩阵的维度如何增加。

text = ["Brown Bear, Brown Bear, What do you see?", “I love you to the moon and back”]

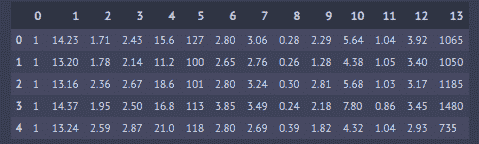

CountVectorizer 将生成以下输出,通过添加一个文档,矩阵从 1 X 6 变为 2 X 13。

矩阵中的每一列表示由语料库中的所有令牌组成的字典中的唯一令牌(单词),而每一行表示一个文档。上述示例有两个书名,即由两行表示的文档,每个单元格包含一个值,标识文档中对应的单词计数。由于这种表示方式,某些单元格在对应文档中令牌缺失时会有零值。

值得注意的是,随着语料库规模的增加,将巨大的矩阵存储在内存中变得不可管理。因此,CountVectorizer 将它们存储为稀疏矩阵,这是一种压缩形式的完整矩阵。

实操!

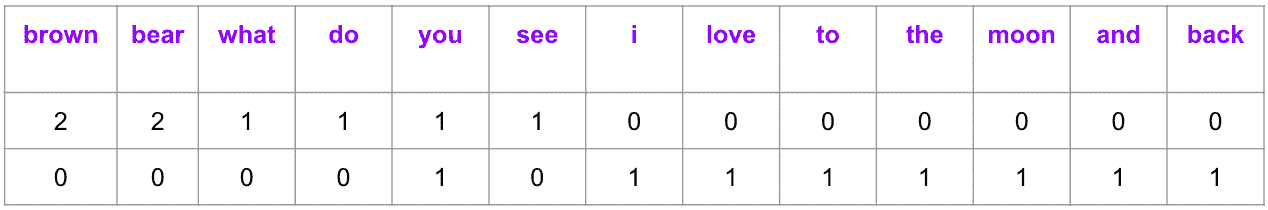

让我们选择《哈利·波特》系列的八部电影和一部《印第安纳·琼斯》电影进行演示。这将帮助我们了解 CountVectorizer 的一些重要属性。

首先导入 Pandas 库和来自 Sklearn > feature_extraction > text 的 CountVectorizer。

import pandas as pd

from sklearn.feature_extraction.text import CountVectorizer

将文档声明为字符串列表。

text = [

"Harry Potter and the Philosopher's Stone",

"Harry Potter and the Chamber of Secrets",

"Harry Potter and the Prisoner of Azkaban",

"Harry Potter and the Goblet of Fire",

"Harry Potter and the Order of the Phoenix",

"Indiana Jones and the Raiders of the Lost Ark",

"Harry Potter and the Half-Blood Prince",

"Harry Potter and the Deathly Hallows - Part 1",

"Harry Potter and the Deathly Hallows - Part 2"

]

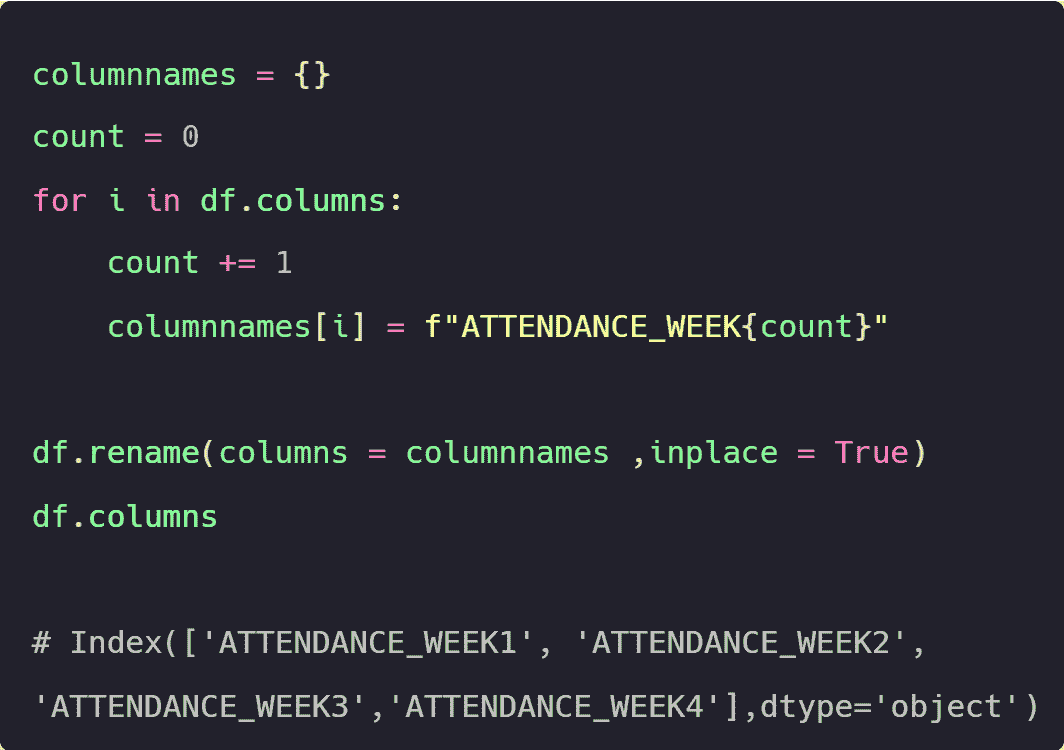

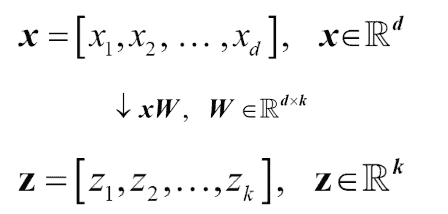

向量化

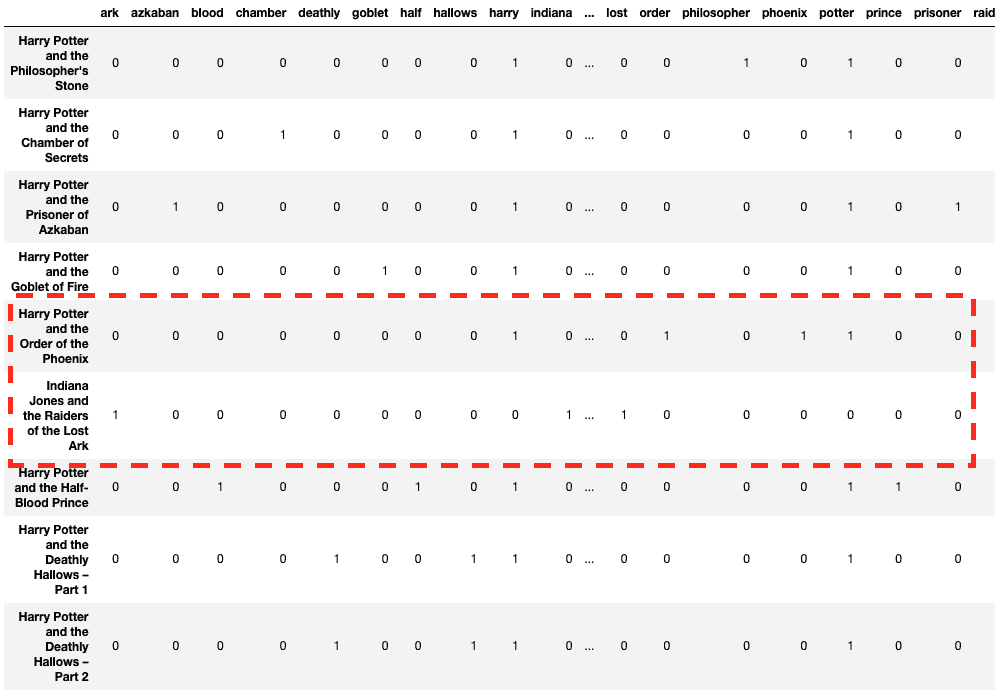

初始化 CountVectorizer 对象时设置 lowercase=True(默认值)以将所有文档/字符串转换为小写。接下来,调用 fit_transform 并将文档列表作为参数传递,然后将列和行名称添加到数据框中。

count_vector = CountVectorizer(lowercase = True)

count_vektor = count_vector.fit_transform(text)

count_vektor = count_vektor.toarray()

df = pd.DataFrame(data = count_vektor, columns = count_vector.get_feature_names())

df.index = text

df

好消息!文档已转换为数字。但仔细观察会发现,“哈利·波特与凤凰令”与“印第安纳·琼斯与失落的圣杯”相比,与其他哈利·波特电影相似——至少在初步观察时是这样。

你一定在想像 ‘and’、‘the’ 和 ‘of’ 这样的令牌是否对我们的特征集添加了任何信息。这引导我们到下一步,即去除停用词。

stop_words

像 ‘and’、‘the’ 和 ‘of’ 这样的无用令牌称为停用词。去除停用词很重要,因为它们会影响文档的相似性,并不必要地扩展列的维度。

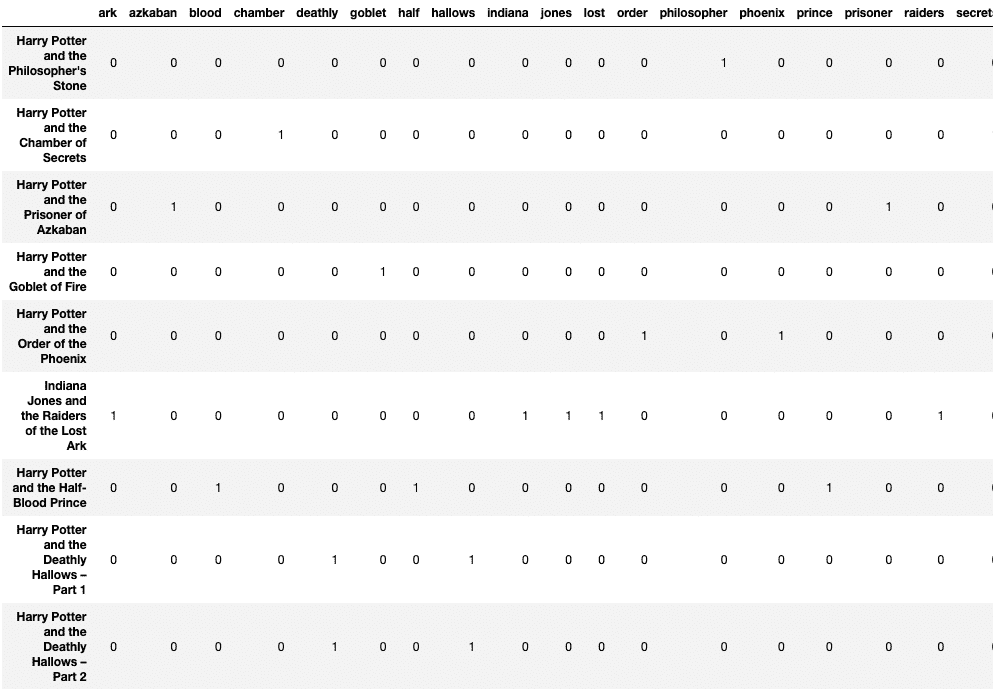

参数 ‘stop_words’ 删除这些预先识别的停用词——指定 ‘english’ 会删除特定于英语的停用词。你还可以显式添加一个停用词列表,即 stop_words = [‘and’, ‘of’, ‘the’]。

count_vector = CountVectorizer(lowercase = True, stop_words =

'english')

count_vektor = count_vector.fit_transform(text)

count_vektor = count_vektor.toarray()

df = pd.DataFrame(data = count_vektor, columns = count_vector.get_feature_names())

df.index = text

df

看起来更好!现在行向量看起来更有意义。

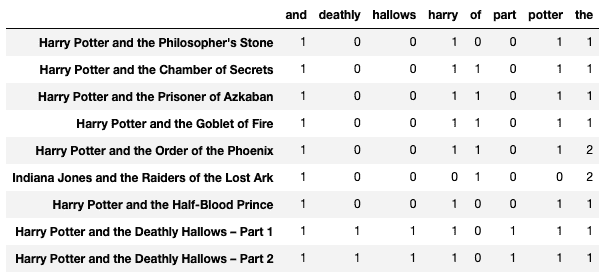

max_df

像 “Harry” 和 “Potter” 这样的单词不是“停用词”,但它们相当常见,对 Count Matrix 添加的信息很少。因此,你可以添加 max_df 参数来将重复的单词作为特征进行处理。

count_vector = CountVectorizer(lowercase = True, max_df = 0.2)

count_vektor = count_vector.fit_transform(text)

count_vektor = count_vektor.toarray()

df = pd.DataFrame(data = count_vektor, columns = count_vector.get_feature_names())

df.index = text

df

以下输出演示了停用词以及“harry”和“potter”从列中被删除:

min_df

它正好与 max_df 相反,表示应具有特定特征的最小文档数量(或比例和百分比)。

count_vector = CountVectorizer(lowercase = True, min_df = 2)

count_vektor = count_vector.fit_transform(text)

count_vektor = count_vektor.toarray()

df = pd.DataFrame(data = count_vektor, columns = count_vector.get_feature_names())

df.index = text

df

以下列(单词)在至少两个文档中出现。

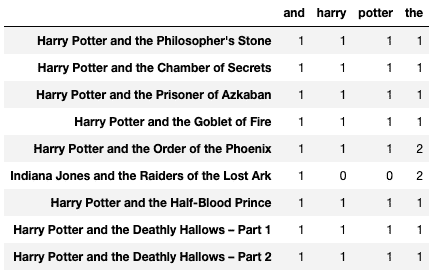

max_features

它代表最常出现的特征/单词/列。

count_vector = CountVectorizer(lowercase = True, max_features = 4)

count_vektor = count_vector.fit_transform(text)

count_vektor = count_vektor.toarray()

df = pd.DataFrame(data = count_vektor, columns = count_vector.get_feature_names())

df.index = text

df

选择了下列四个最常出现的单词。

binary

binary 参数将文档中所有正出现的单词替换为‘1’。它表示单词或令牌的存在与否,而不是频率,并且在情感分析或产品评论等分析中非常有用。

count_vector = CountVectorizer(lowercase = True, binary = True,

max_features = 4)

count_vektor = count_vector.fit_transform(text)

count_vektor = count_vektor.toarray()

df = pd.DataFrame(data = count_vektor, columns = count_vector.get_feature_names())

df.index = text

df

与先前的输出进行比较后,名为“the”的列的频率表在下方结果中被限制为‘1’:

vocabulary_

它返回列的位置,并用于将算法结果映射到可解释的单词。

count_vector = CountVectorizer(lowercase = True)

count_vector.fit_transform(text)

count_vector.vocabulary_

上述代码的输出如下所示。

{

'harry': 10,

'potter': 19,

'and': 0,

'the': 25,

'philosopher': 17,

'stone': 24,

'chamber': 4,

'of': 14,

'secrets': 23,

'prisoner': 21,

'azkaban': 2,

'goblet': 7,

'fire': 6,

'order': 15,

'phoenix': 18,

'indiana': 11,

'jones': 12,

'raiders': 22,

'lost': 13,

'ark': 1,

'half': 8,

'blood': 3,

'prince': 20,

'deathly': 5,

'hallows': 9,

'part': 16

}

摘要

本教程讨论了文本预处理的重要性,即将其矢量化作为机器学习算法的输入。文章还展示了 sklearn 实现 CountVectorizer 的各种输入参数在一小组文档上的应用。

Vidhi Chugh 是一位获奖的 AI/ML 创新领袖和 AI 伦理学家。她在数据科学、产品和研究的交汇点上工作,以提供业务价值和见解。她倡导以数据为中心的科学,是数据治理领域的领先专家,致力于构建值得信赖的 AI 解决方案。

相关主题

乳腺癌分类的卷积神经网络

原文:

www.kdnuggets.com/2019/10/convolutional-neural-network-breast-cancer-classification.html

评论

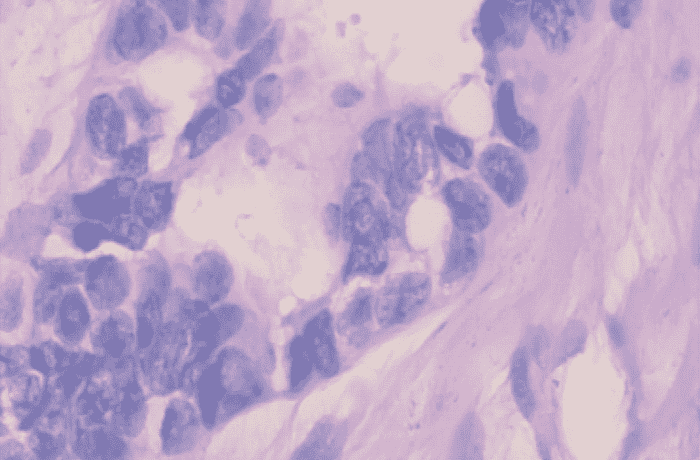

乳腺癌是全球女性和男性中第二常见的癌症。在 2012 年,它占所有新癌症病例的约 12%,以及所有女性癌症的 25%。

乳腺癌开始于乳房中的细胞失控生长。这些细胞通常形成肿瘤,肿瘤通常可以通过 X 光看到或触摸到。肿瘤是恶性的(癌症),如果细胞能生长到(侵入)周围组织或扩散(转移)到身体的远处区域。

我们的前 3 名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

这里是一些快速事实:

-

美国约 1/8 的女性(约 12%)将在其一生中发展为侵袭性乳腺癌。

-

2019 年,预计美国将诊断出 268,600 例侵袭性乳腺癌新病例,以及 62,930 例非侵袭性(原位)乳腺癌新病例。

-

大约 85%的乳腺癌发生在没有乳腺癌家族史的女性身上。这些癌症通常是由于衰老过程和生活中的遗传突变,而不是遗传突变。

-

如果一名女性有一位一度亲属(母亲、姐妹、女儿)被诊断出患有乳腺癌,她患乳腺癌的风险几乎会翻倍。不到 15%的乳腺癌患者有家族成员被诊断为乳腺癌。

挑战

构建一个算法,通过观察活检图像自动识别患者是否患有乳腺癌。由于关系到人们的生命,算法必须极其准确。

数据

数据集可以从 这里 下载。这是一个二分类问题。我按如下方式拆分数据—

dataset train

benign

b1.jpg

b2.jpg

//

malignant

m1.jpg

m2.jpg

// validation

benign

b1.jpg

b2.jpg

//

malignant

m1.jpg

m2.jpg

//...

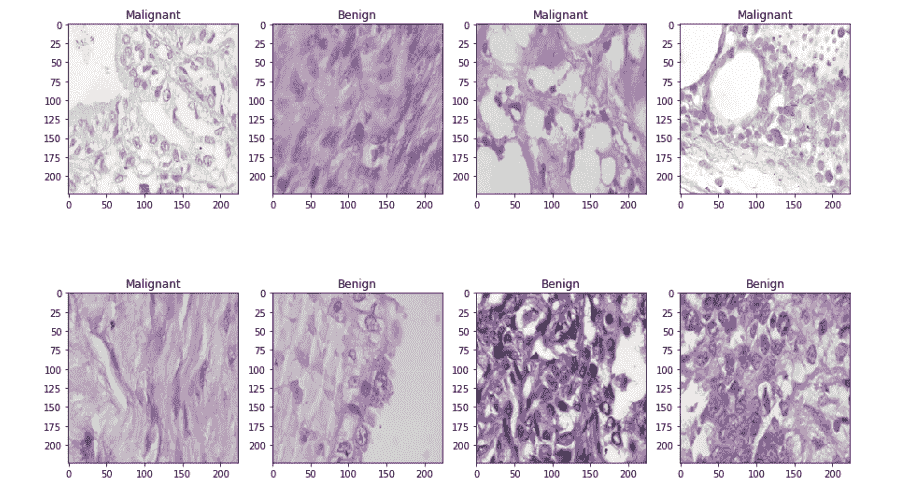

训练文件夹中每个类别有 1000 张图像,而验证文件夹中每个类别有 250 张图像。

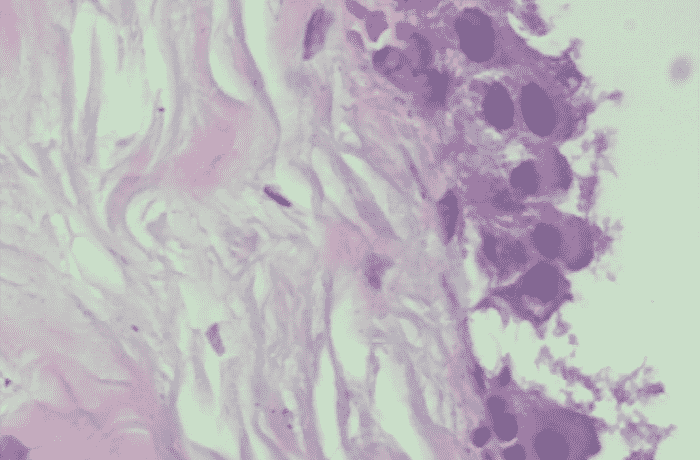

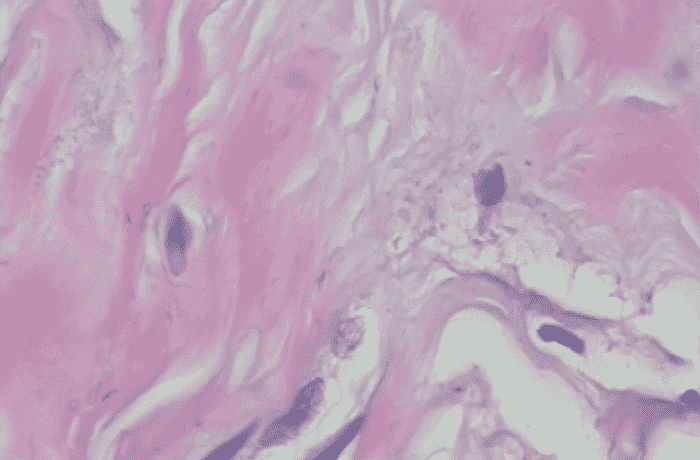

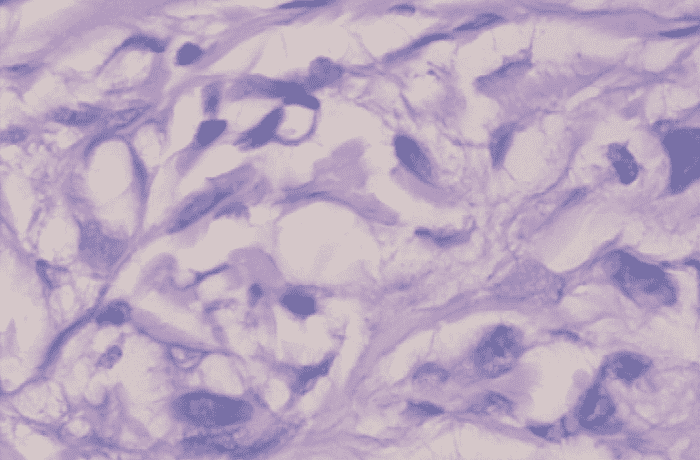

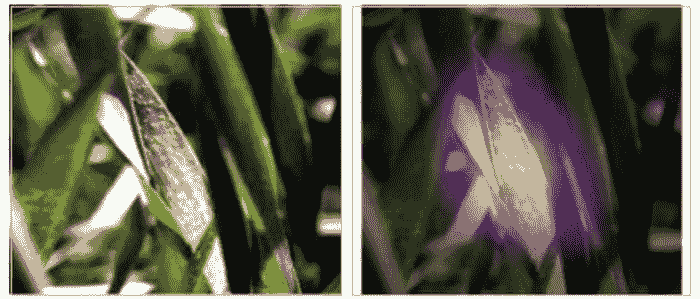

良性样本

恶性样本

环境和工具

图像分类

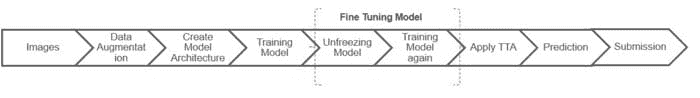

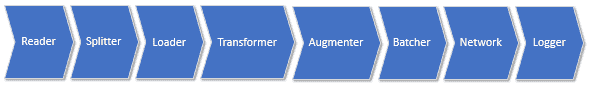

完整的图像分类流程可以形式化为如下:

-

我们的输入是一个训练数据集,包括N张图像,每张图像都标记为 2 种不同类别之一。

-

然后,我们使用这个训练集训练一个分类器,让它学习每个类别的样子。

-

最后,我们通过让分类器预测一组从未见过的新图像的标签来评估分类器的质量。然后,我们将这些图像的真实标签与分类器预测的标签进行比较。

代码在哪里?

话不多说,我们开始写代码吧。完整的项目可以在 github 上找到 这里。

让我们先加载所有的库和依赖项。

接下来,我将图像加载到相应的文件夹中。

之后,我创建了一个由零组成的 numpy 数组用于标记良性图像,类似地,创建了一个由一组成的 numpy 数组用于标记恶性图像。我还打乱了数据集,并将标签转换为分类格式。

然后,我将数据集拆分为两个部分——训练集和测试集,分别包含 80%和 20%的图像。让我们看看一些示例的良性和恶性图像。

良性样本与恶性样本

我使用了 16 的批量大小。批量大小是深度学习中最重要的超参数之一。我倾向于使用较大的批量大小来训练我的模型,因为它允许通过 GPU 的并行性加速计算。然而,众所周知,过大的批量大小会导致较差的泛化效果。在一个极端的情况下,使用等于整个数据集的批量大小可以保证收敛到目标函数的全局最优解。然而,这会导致较慢的收敛速度。另一方面,使用较小的批量大小已被证明可以更快地收敛到良好的结果。这可以通过以下直观解释:较小的批量大小允许模型在必须查看所有数据之前开始学习。使用较小批量大小的缺点是模型不一定能收敛到全局最优解。因此,通常建议从较小的批量大小开始,利用更快的训练动态,并在训练过程中逐渐增加批量大小。

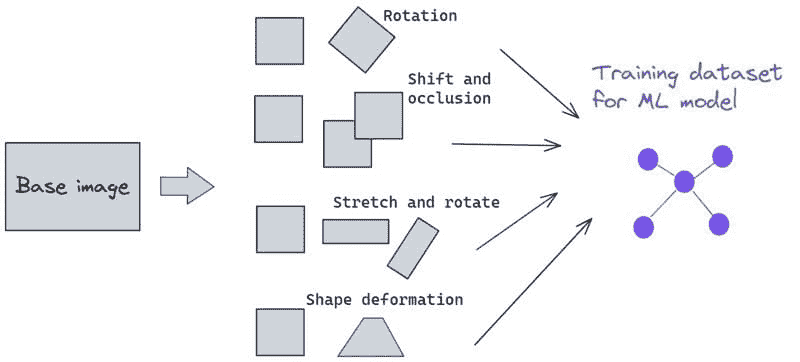

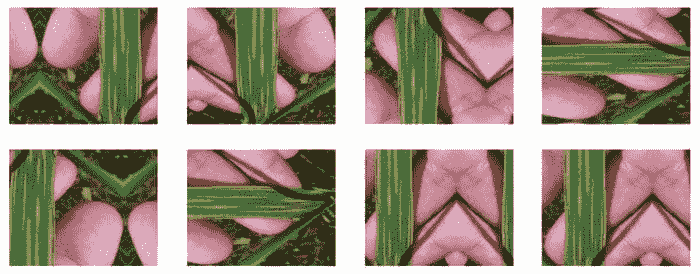

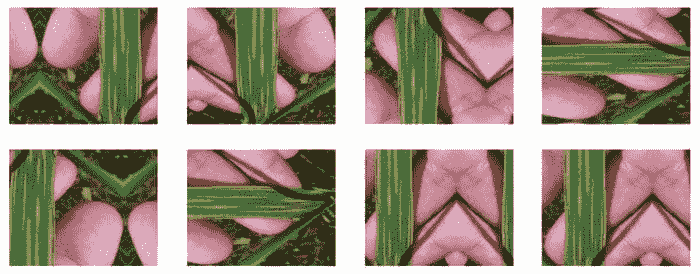

我还进行了数据增强。数据增强是一种有效的方法,可以增加训练集的规模。增强训练样本可以让网络在训练过程中看到更多的多样化,但仍具有代表性的数据点。

然后,我创建了一个数据生成器,以自动化的方式将数据从我们的文件夹中提取到 Keras 中。Keras 提供了方便的 Python 生成器函数来实现这一目的。

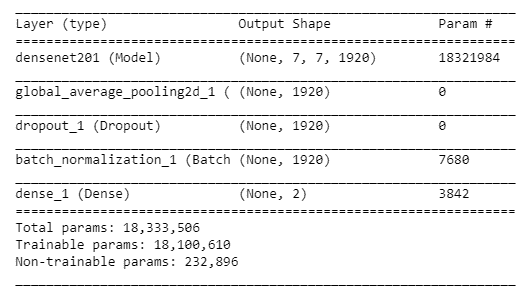

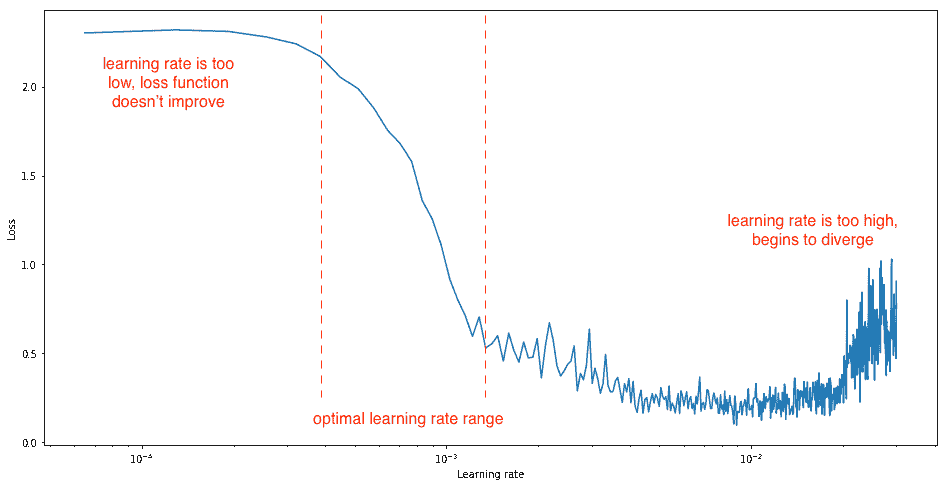

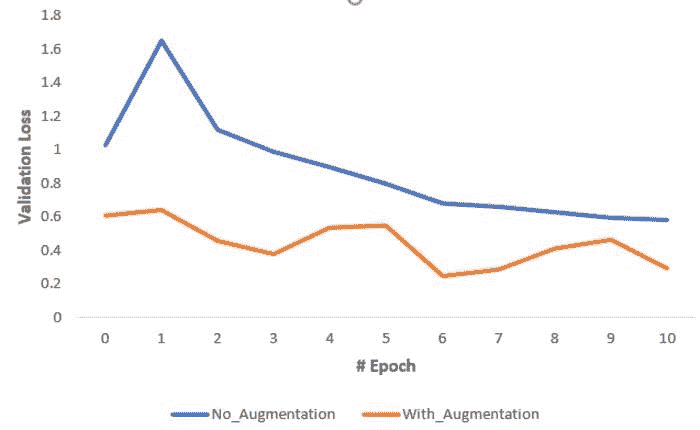

下一步是构建模型。这可以通过以下 3 个步骤描述:

-

我使用了 DenseNet201 作为预训练权重,它已经在 Imagenet 竞赛中进行了训练。学习率选择为 0.0001。

-

此外,我使用了全局平均池化层,后面跟着 50% 的 dropout 来减少过拟合。

-

我使用了批量归一化和一个包含 2 个神经元的全连接层用于 2 个输出类别,即良性和恶性,激活函数为 softmax。

-

我使用了 Adam 作为优化器,binary-cross-entropy 作为损失函数。

让我们看看每一层的输出形状和涉及的参数。

模型总结

在训练模型之前,定义一个或多个回调是很有用的。比较实用的有:ModelCheckpoint 和 ReduceLROnPlateau。

-

ModelCheckpoint:当训练需要很长时间才能取得好结果时,通常需要很多迭代。在这种情况下,最好仅在改进指标的纪元结束时保存表现最佳的模型副本。

-

ReduceLROnPlateau:当某项指标停止改善时,减少学习率。模型在学习停滞时通常会受益于将学习率减少 2-10 倍。这个回调监控一个量,如果在‘耐心’数量的纪元内没有看到改进,学习率将被减少。

ReduceLROnPlateau。

我训练了模型 20 个纪元。

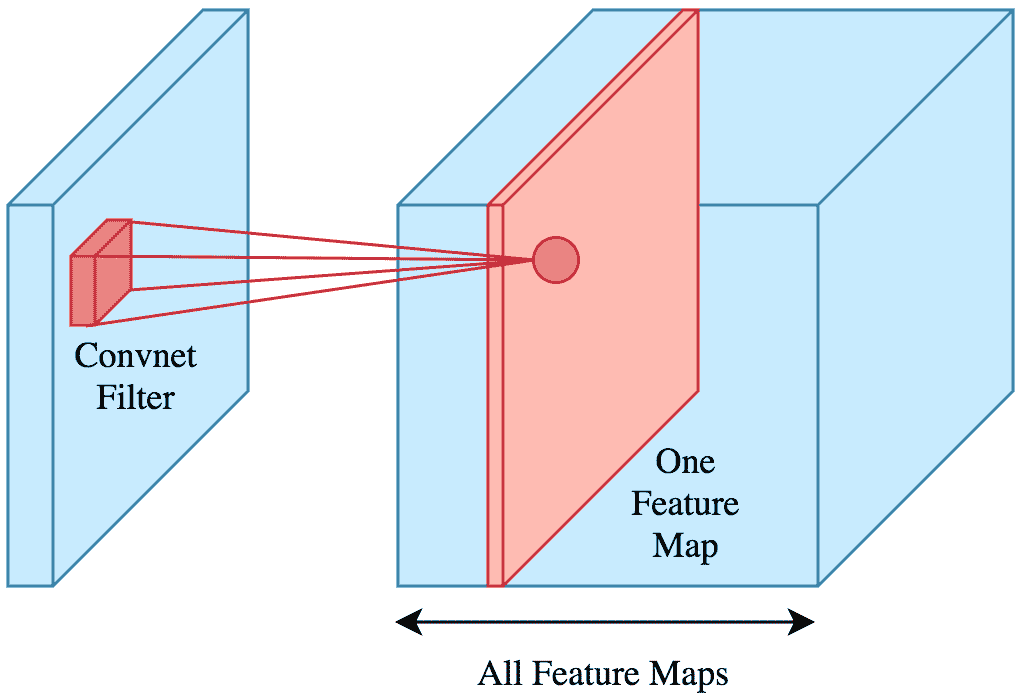

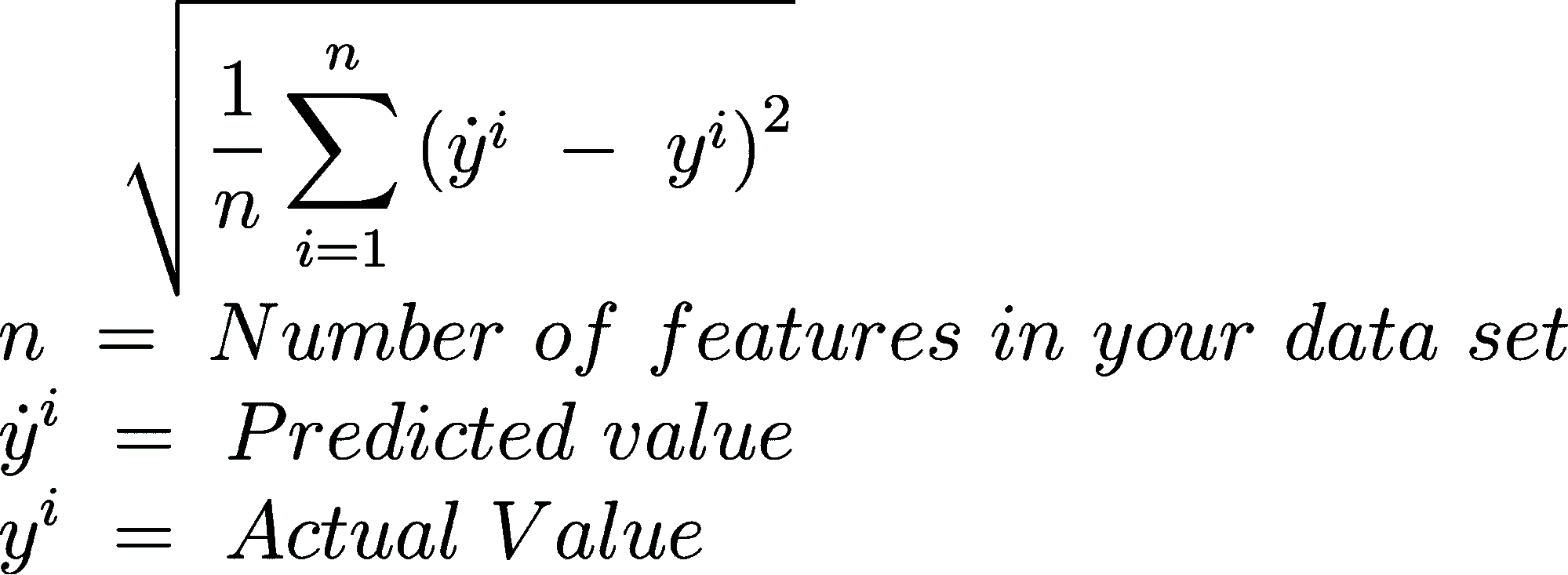

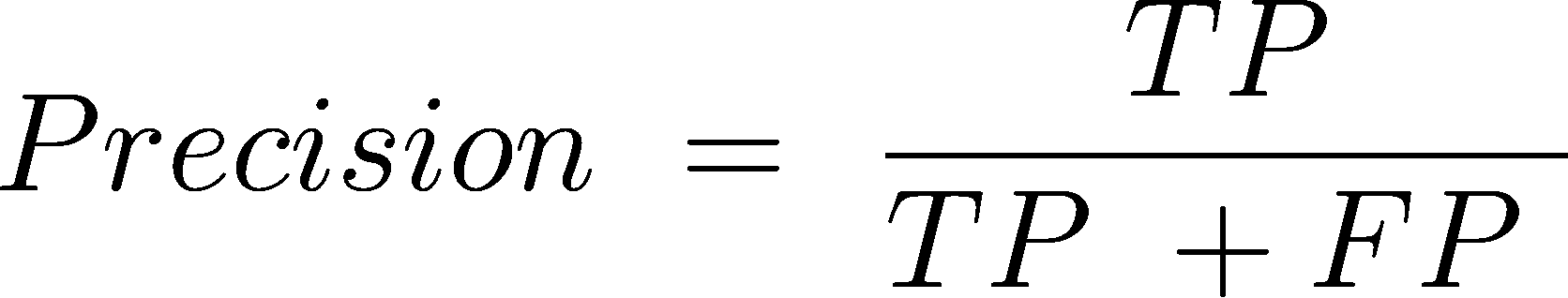

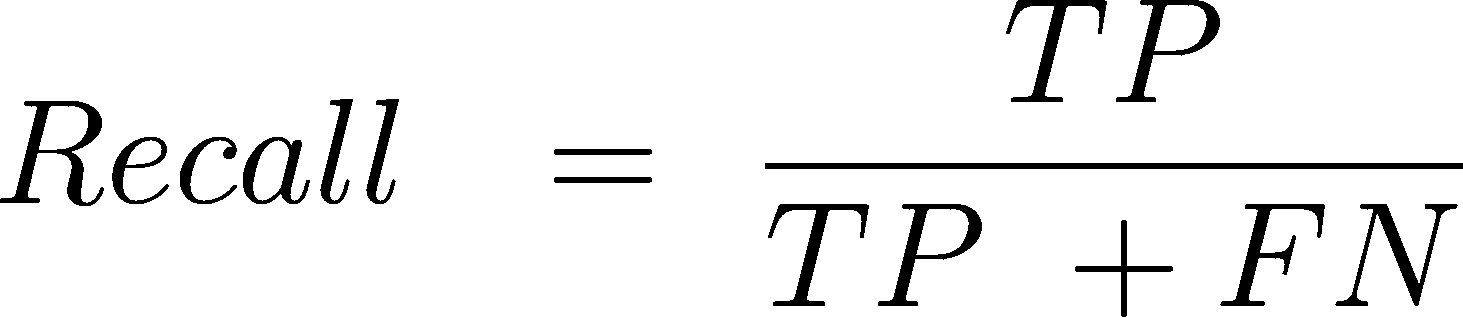

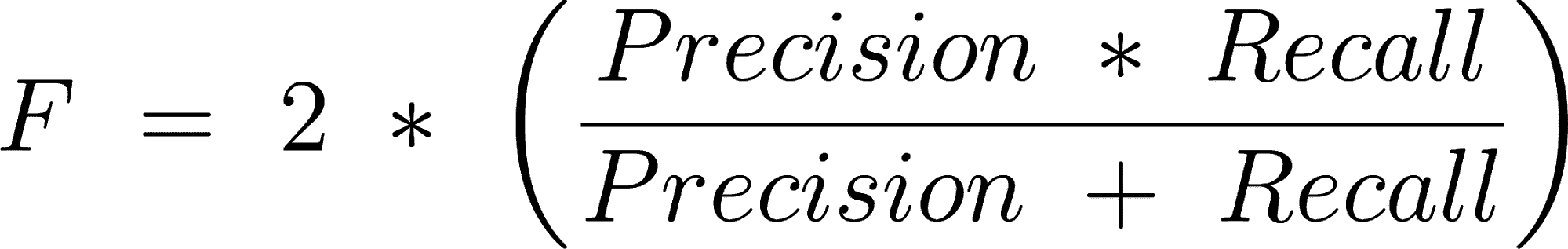

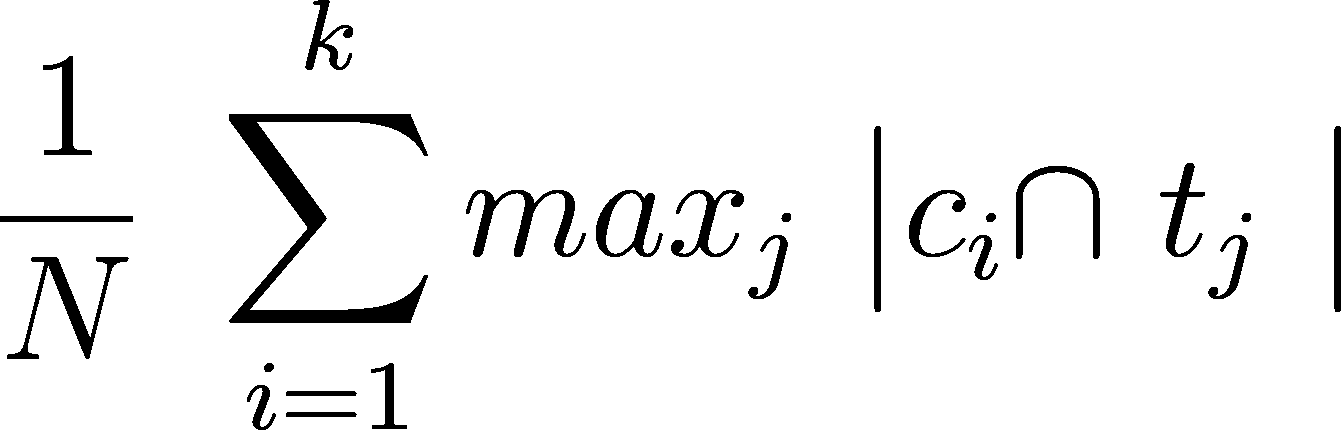

性能指标

评估模型性能的最常见指标是准确率。然而,当你的数据集中只有 2% 是一个类别(恶性)而 98% 是另一个类别(良性)时,错误分类分数就没有意义了。你可以有 98% 的准确率,但仍然可能抓不到任何恶性病例,这会使模型表现很糟糕。

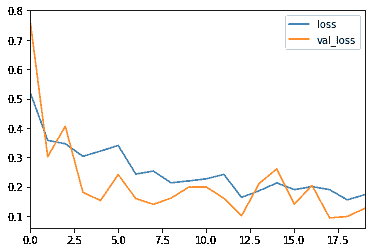

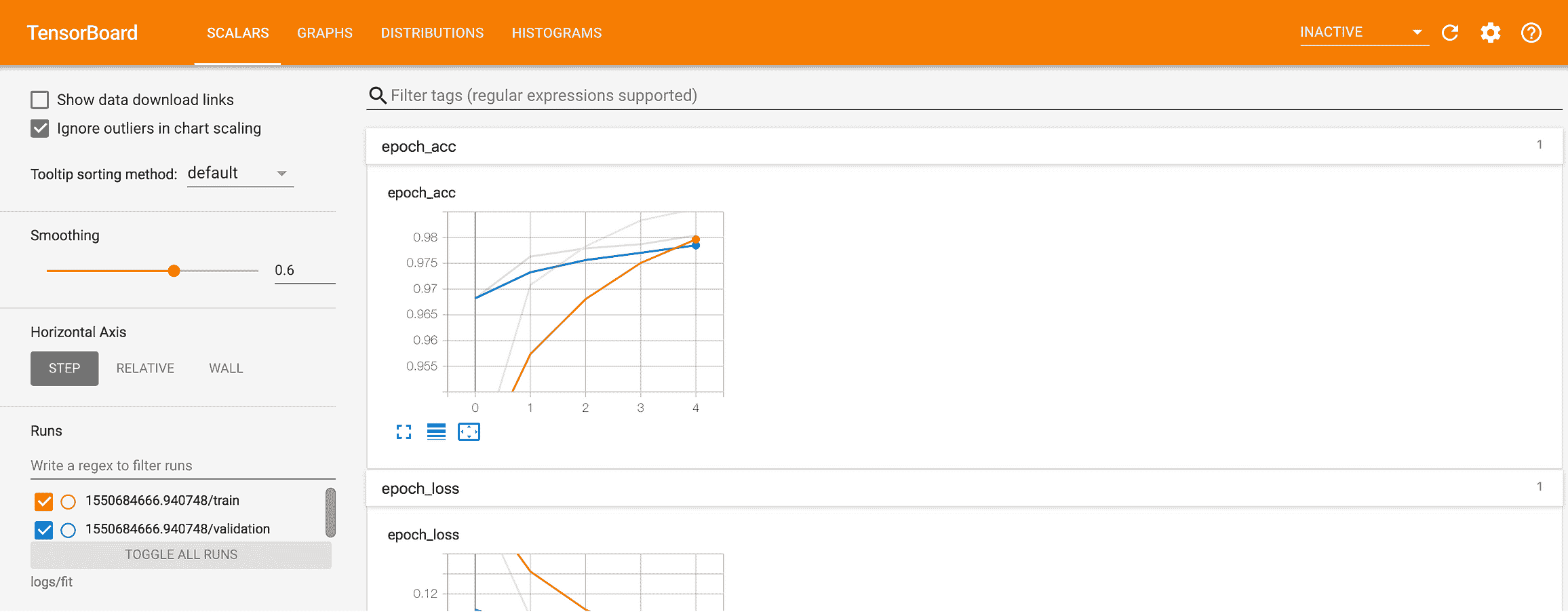

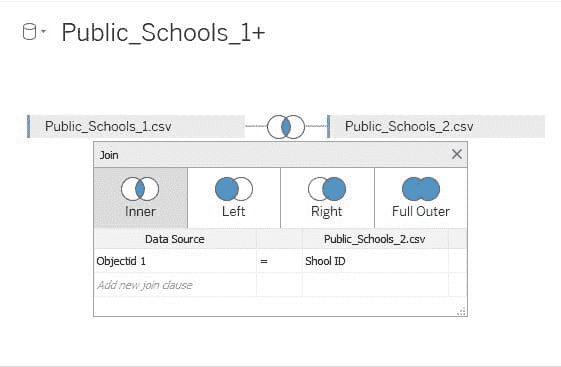

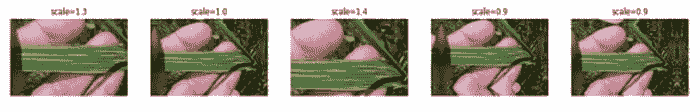

损失 vs 纪元

准确率 vs 纪元

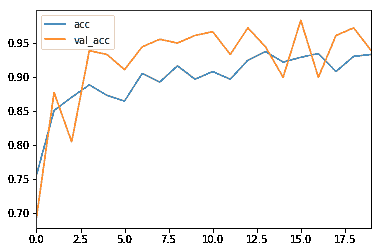

精确度、召回率和 F1-Score

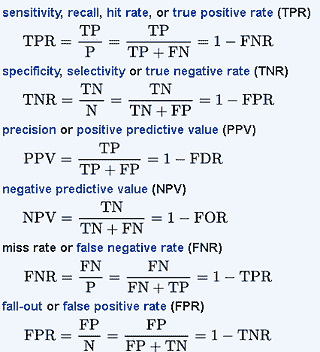

为了更好地了解错误分类,我们通常使用以下指标来更好地了解真正例(TP)、真正负例(TN)、假正例(FP)和假负例(FN)。

精确度 是正确预测的正观察值与总预测正观察值的比率。

召回率 是正确预测的正观察值与实际类别中所有观察值的比率。

F1-Score 是精确度和召回率的加权平均值。

F1-Score 越高,模型越好。对于这三个指标,0 是最差的,而 1 是最好的。

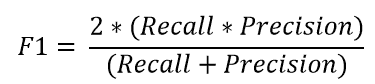

混淆矩阵

混淆矩阵是分析分类错误时非常重要的指标。矩阵的每一行代表预测类别中的实例,每一列代表实际类别中的实例。对角线表示已正确分类的类别。这有助于我们不仅知道哪些类别被误分类,还知道它们被误分类为何种类别。

混淆矩阵

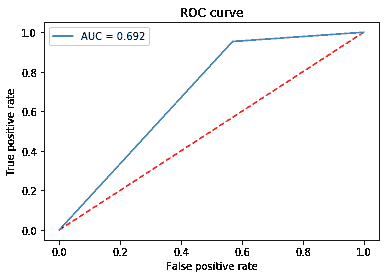

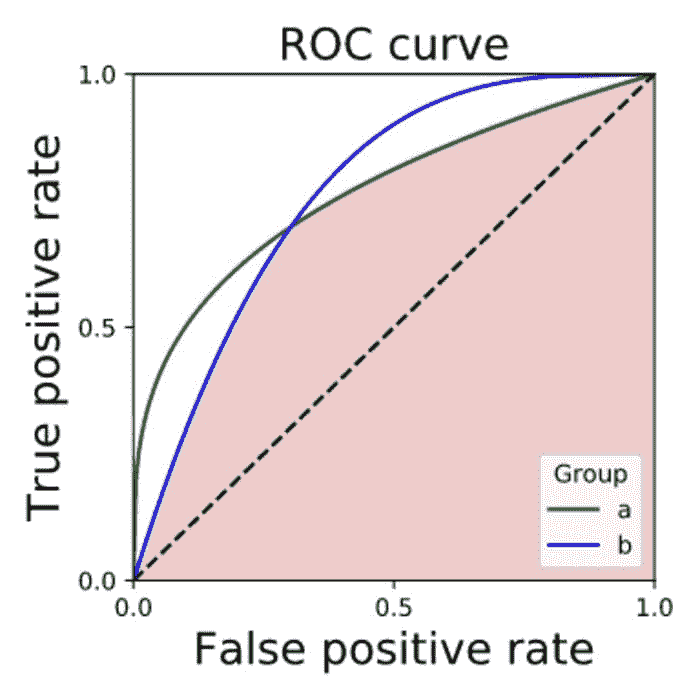

ROC 曲线

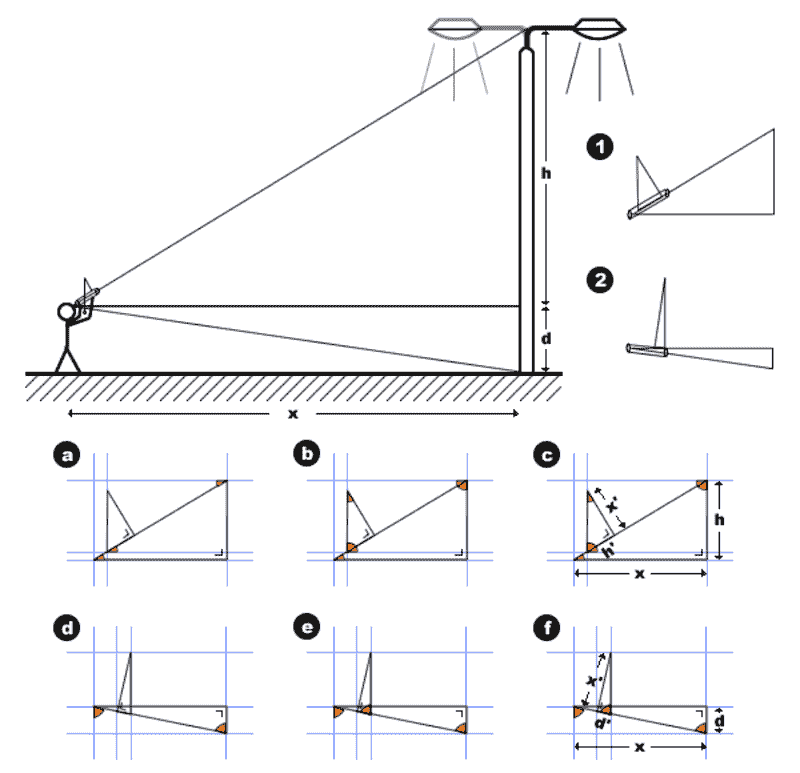

45 度线是随机线,其下的曲线面积(AUC)为 0.5。曲线距离这条线越远,AUC 越高,模型越好。模型的最高 AUC 为 1,此时曲线形成一个直角三角形。ROC 曲线还可以帮助调试模型。例如,如果曲线的左下角更接近随机线,则表明模型在 Y=0 时分类错误。而如果在右上角随机,则表明错误发生在 Y=1。

ROC-AUC 曲线

结果

最终结果

结论

尽管这个项目还远未完成,但看到深度学习在如此多样的现实问题中的成功是值得注意的。在这篇博客中,我展示了如何使用卷积神经网络和转移学习对一组显微镜图像进行良恶性乳腺癌分类。

参考文献/进一步阅读

转移学习一站式指南

在 Keras 中使用卷积神经网络(CNN)预测侵袭性导管癌

使用卷积神经网络对组织病理切片进行良恶性分类

尽管从组织病理图像中成功检测恶性肿瘤在很大程度上依赖于长期的...

深度学习确实可以在数据较少的情况下实现

离开前

对应的源代码可以在这里找到。

使用卷积神经网络的良性与恶性分类器 数据集可以从这里下载。 pip install…

联系方式

如果你想了解我最新的文章和项目,请关注我在 Medium 的账号。这些是我的一些联系信息:

祝阅读愉快,学习愉快,编码愉快!

个人简介:Abhinav Sagar 是 VIT Vellore 的大四本科生。他对数据科学、机器学习及其在现实世界问题中的应用感兴趣。

原文。经许可转载。

相关:

-

使用深度学习检测乳腺癌

-

如何轻松使用 Flask 部署机器学习模型

-

使用机器学习理解癌症

更多相关话题

卷积神经网络:使用 TensorFlow 和 Keras 的 Python 教程

原文:

www.kdnuggets.com/2019/07/convolutional-neural-networks-python-tutorial-tensorflow-keras.html

评论

卷积神经网络是深度学习在过去十年频繁上头条的原因之一。今天我们将训练一个图像分类器,利用 TensorFlow 的 eager API 来判断图像中是否包含狗或猫。

人工神经网络最近对多个行业产生了影响,因为它们在许多领域展现出了前所未有的能力。然而,不同的深度学习架构在每个领域都有所擅长:

-

图像分类(卷积神经网络)。

-

图像、音频和文本生成(GANs, RNNs)。

-

时间序列预测(RNNs, LSTM)。

-

推荐系统(玻尔兹曼机)。

-

大量其他内容(例如,回归分析)。

我们的前三推荐课程

1. Google 网络安全证书 - 快速开启网络安全职业生涯。

1. Google 网络安全证书 - 快速开启网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

今天我们将重点关注列表中的第一个项目,虽然每一个都值得单独写一篇文章。

什么是卷积神经网络?

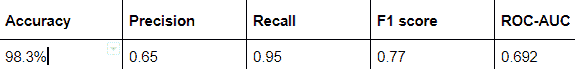

在多层感知器(MLP),也就是普通神经网络中,每一层的神经元都连接到下一层的所有神经元。这种层被称为全连接层。

一个多层感知器。来源:astroml

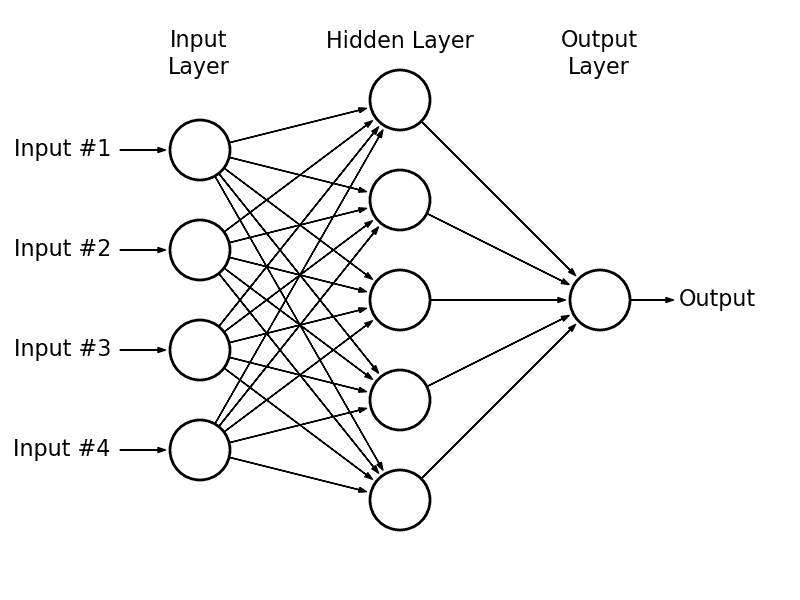

卷积神经网络是不同的:它们具有卷积层。

在全连接层上,每个神经元的输出将是对上一层的线性变换,并与一个非线性激活函数(例如,ReLu 或 Sigmoid)组合。

相反,卷积层中每个神经元的输出仅是上一层子集的一个函数。

来源:Brilliant

卷积层上的输出将是对上一层的一个子集应用卷积的结果,然后是一个激活函数。

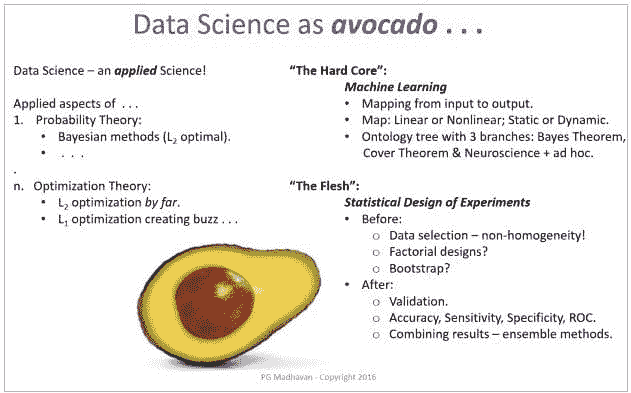

什么是卷积?

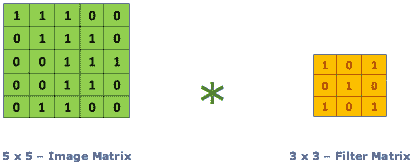

卷积操作,给定一个输入矩阵A(通常是前一层的值)和一个(通常小得多的)权重矩阵,称为卷积核或滤波器 K,将输出一个新的矩阵B。

来源于@RaghavPrabhu

如果K是一个CXC矩阵,B中的第一个元素将是:

-

取A的第一个CXC子矩阵。

-

将每个元素乘以其在K中的相应权重。

-

将所有的乘积相加。

这最后两个步骤等同于将A的子矩阵和K展平,并计算结果向量的点积。

然后我们将K向右滑动以获取下一个元素,依此类推,重复这个过程直到A的每一行。

卷积可视化,来源于@RaghavPrabhu

根据我们的需求,我们可以选择仅从卷积核居中于Cth行和列的位置开始,以避免“越界”,或者假设“A 之外”的所有元素具有某种默认值(通常是 0)——这将决定B的大小是否小于A的大小或相同。

如你所见,如果A是一个NxM矩阵,那么现在B中的每个神经元的值将不再依赖于NM权重,而仅依赖于CC(少得多)个权重。

这使得卷积层比全连接层轻得多,帮助卷积模型学习得更快。

当然,我们在每一层会使用许多卷积核(每一层的输出是一个矩阵的堆叠)。然而,这仍然需要比我们老旧的多层感知机(MLP)少得多的权重。

为什么这样做有效?

为什么我们可以忽略每个神经元对大多数其他神经元的影响?因为整个系统的前提是每个神经元受其“邻居”强烈影响。然而,远处的神经元对它只有很小的影响。

这个假设在图像中是直观正确的——如果我们考虑输入层,每个神经元将是一个像素或像素的 RGB 值。这也是为什么这种方法在图像分类中效果如此之好的部分原因。

例如,如果我选择一张有蓝天的图片区域,附近的区域很可能也会显示蓝天,使用类似的色调。

像素的邻居通常会有类似的 RGB 值。如果没有,那么这可能意味着我们在图形或物体的边缘。

如果你用笔和纸(或计算器)进行一些卷积操作,你会发现某些卷积核会在某种边缘上增加输入的强度,而在其他边缘上则可能会减少它。

例如,考虑以下卷积核 V 和 H:

用于垂直和水平边缘的滤波器

V 过滤器处理垂直边缘(即上方和下方颜色差异很大的地方),而 H 过滤器处理水平边缘。注意其中一个是另一个的转置版本。

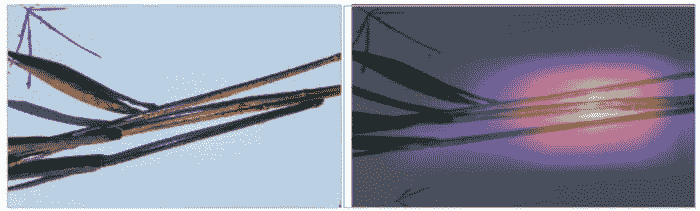

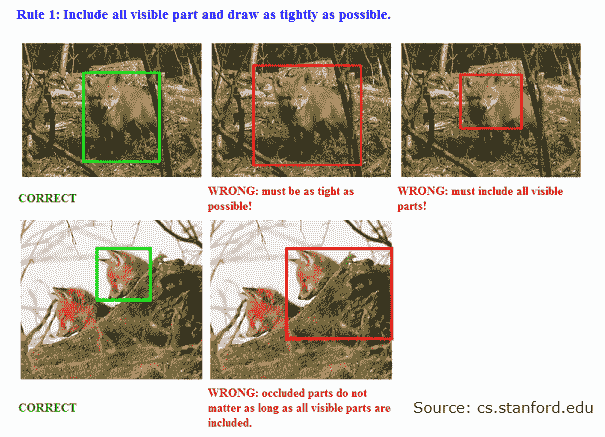

通过示例了解卷积

这是未经过滤的小猫图片:

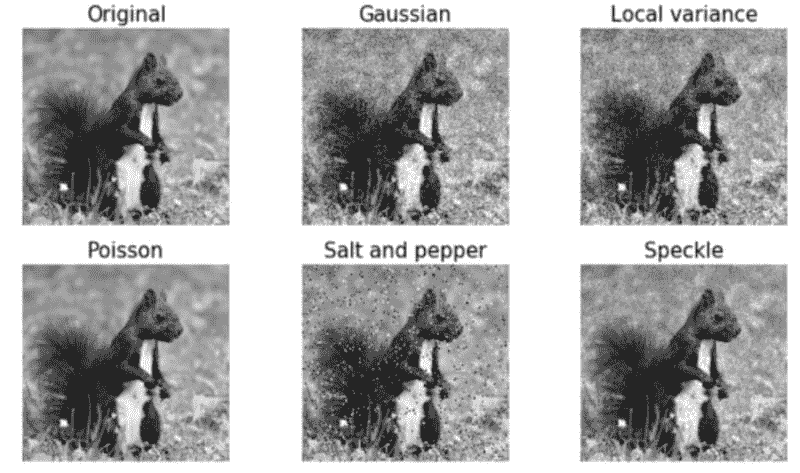

如果我们分别应用水平和垂直边缘滤镜,会发生以下情况:

我们可以看到一些特征变得更加明显,而其他特征则逐渐消失。有趣的是,每个滤镜展示了不同的特征。

这就是卷积神经网络如何学习识别图像中的特征。

让它们自行调整内核权重要比任何手动方法都简单。想象一下尝试手动表达像素之间的关系!

为了真正理解每个卷积对图像的作用,我强烈建议你在 这个网站 上玩一玩。它比任何书籍或教程都对我帮助更大。去吧,收藏它。这很有趣。

好了,你已经学了一些理论知识。现在让我们进入实际操作部分。

如何在 TensorFlow 中训练卷积神经网络?

TensorFlow 是 Python 最受欢迎的深度学习框架。

我也听说过 PyTorch 很不错,尽管我从未有机会尝试。

我已经写过一个关于 如何使用 TensorFlow 的 Keras API 训练神经网络,重点讲解了 AutoEncoders。

今天会有所不同:我们将尝试三种不同的架构,看看哪一种效果更好。

和往常一样,所有代码都可以在 GitHub 上找到,你可以自己尝试或跟随操作。当然,我也会展示 Python 代码片段。

数据集

我们将训练一个神经网络来预测图像中是否包含狗或猫。为此,我们将使用 Kaggle 的 cats and dogs Dataset。它包含 12500 张猫的图片和 12500 张狗的图片,分辨率各异。

使用 NumPy 加载和预处理我们的图像数据

神经网络接收一个特征向量或矩阵作为输入,通常具有 固定尺寸。我们如何从图片中生成这个特征向量或矩阵?

幸运的是,Python 的图像库为我们提供了一种简单的方法,将图像加载为 NumPy 数组。即一个 HeightxWidth 的 RGB 值矩阵。

我们已经在 Python 中的图像滤镜 中做过这个,所以我将重用那段代码。

不过我们仍然需要解决固定尺寸的问题:我们为 输入层 选择什么 尺寸?

这很重要,因为我们需要调整每张图片的大小到所选择的分辨率。我们不希望扭曲长宽比过多,以免带来过多噪声给网络。

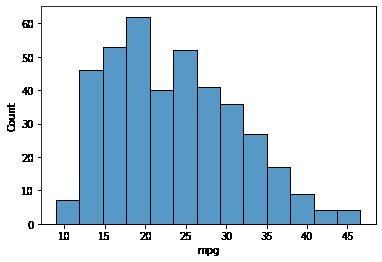

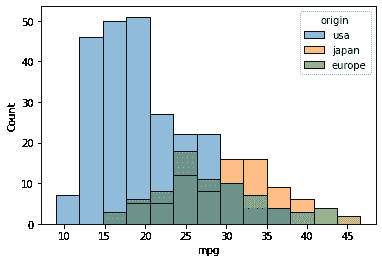

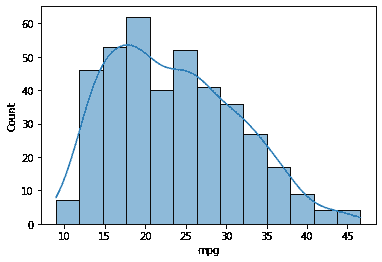

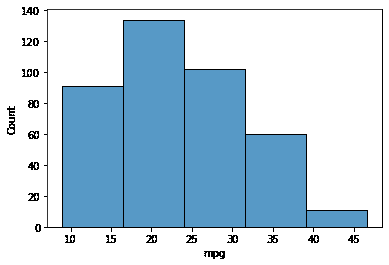

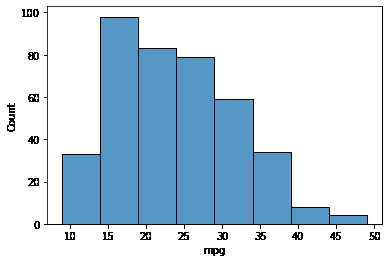

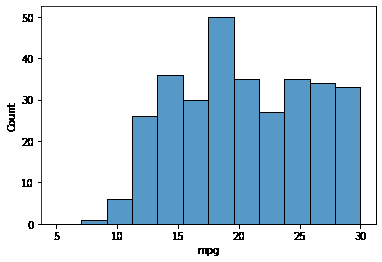

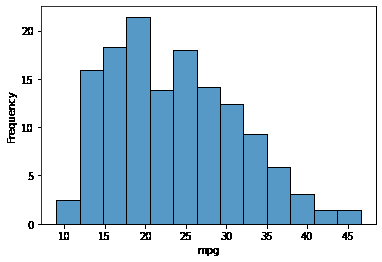

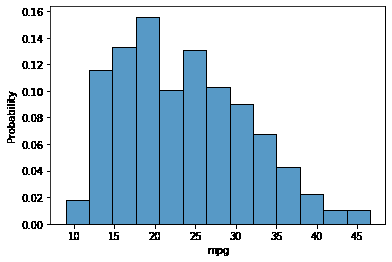

这是我们可以查看数据集中最常见的形状的方式。

我对前 1000 张图片进行了抽样,尽管当我查看 5000 张时结果没有变化。

最常见的形状是 375×500,不过我决定将其缩小到网络输入的 1/4。

这就是我们现在的图像加载代码的样子。

最后,你可以使用这段代码加载数据。我选择使用 4096 张图片作为训练集,1024 张作为验证集。然而,这只是因为我的 PC 由于 RAM 大小无法处理更多数据。

如果你在家尝试,可以将这些数字增加到最大值(例如训练集 10K 和验证集 2500)!

训练我们的神经网络

首先,作为一个基准,让我们看看普通MLP在这个任务上的表现。如果卷积神经网络如此革命性,我期望这次实验的结果会非常糟糕。

这是一个单隐层全连接神经网络。

本文的所有训练都使用了 AdamOptimizer,因为它是最快的。我仅为每个模型调整了学习率(这里是 1e-5)。

我训练了这个模型 10 个轮次,它基本上收敛到随机猜测。

我确保打乱训练数据,因为我按顺序加载它可能会导致模型偏差。

我使用了MSE作为损失函数,因为它通常更直观。如果你的 MSE 在二分类中是 0.5,你就相当于总是预测为 0。然而,具有更多层的 MLP 或不同损失函数表现没有更好。

从历史上看,其他成熟的监督学习算法,如Boosted Trees (使用 XGBoost),在图像分类上的表现甚至更差。

训练卷积神经网络

一个卷积层能带来多大好处?我们来给模型添加一个卷积层看看。

对于这个网络,我决定添加一个卷积层(24 个卷积核),然后是 2 个全连接层。

最大池化仅仅是将每四个神经元减少为一个神经元,取四者中的最高值。

仅经过 5 个训练轮次,它的表现已经好得多,比之前的网络要好。

通过 0.36 的验证 MSE,它已经比随机猜测好很多。然而,请注意,我不得不使用小得多的学习率。

此外,尽管它在更少的训练轮次中学到了更多,但每个训练轮次花费的时间要长得多。模型也变得相当沉重(200+ MB)。

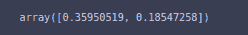

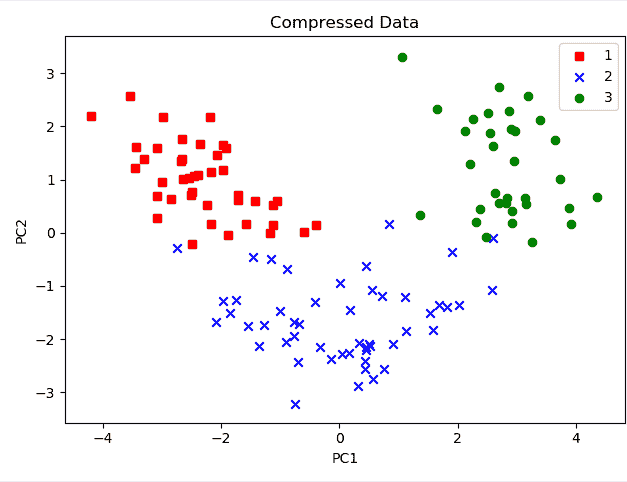

我决定开始测量预测与验证标签之间的 Pearson 相关性。这个模型得分为 15.2%。

具有两个卷积层的神经网络

由于那个模型表现更好,我决定尝试一个更大的模型。我添加了另一个卷积层,并将两个层都做得更大(每个 48 个卷积核)。

这意味着模型可以从图像中学习更复杂的特征。但这也意味着我的 RAM 几乎要爆炸了。此外,训练时间也长得多(15 个周期需要半小时)。

结果非常出色。预测和标签之间的皮尔逊相关系数达到了 0.21,验证 MSE 低至 0.33。

让我们测量一下网络的准确率。由于 1 表示猫,0 表示狗,我可以说“如果模型预测的值高于某个阈值 t,那么预测为猫。否则预测为狗。”

尝试了 10 个直接阈值后,这个网络的最高准确率为 61%。

更大的卷积神经网络

既然增加模型的大小明显使模型学得更好,我尝试将两个卷积层都做得更大,每个128 个滤波器。

我保持了模型的其他部分不变,也没有改变学习率。

这个模型最终达到了 30%的相关性!它的最佳准确率为 67%,这意味着它在三分之二的情况下是正确的。

我仍然认为一个更大的模型可能会更好地拟合数据。

因此,对于下一次训练,我决定将全连接层的大小增加一倍,达到 512 个神经元。

不过,我确实将第一个卷积层的大小减少了一半,只保留了 64 个滤波器。

通常,我发现如果我把第一个卷积层做得更小,并在它们更深时增加其大小,我会得到更好的模型性能。

幸运的是,我的预测是正确的!

拥有两倍大小的全连接层的模型达到了0.75 的验证损失和42%的相关性。

它的准确率为 75%,这意味着它在 4 次中正确预测了 3 次!

这清楚地表明它学到了东西,即使这不是最先进的分数(更不用说打败人类了)。

这证明了,至少在这种情况下,增加全连接层的大小比增加卷积滤波器的数量效果更好。

我本可以继续尝试越来越大的模型,但收敛已经花了大约一个小时。

通常,模型的大小和时间限制之间存在权衡。

模型的大小限制了网络对数据的拟合程度(小模型会欠拟合),但我不想等 3 天让我的模型学习。

如果你有业务截止日期,通常也会面临相同的问题。

结论

我们已经看到卷积神经网络在图像分类任务上比普通架构明显更好。我们还尝试了不同的度量标准来衡量模型性能(相关性、准确率)。

我们了解了模型大小(防止欠拟合)和收敛速度之间的权衡。

最后,我们使用了 TensorFlow 的 eager API 来轻松训练深度神经网络,并使用 numpy 进行(尽管简单的)图像预处理。

对于未来的文章,我相信我们可以在不同的池化层、滤波器大小、步幅以及不同的预处理上进行更多实验。

你觉得这篇文章有用吗?你是否希望了解更多其他内容?是否有任何不够清楚的地方?请在评论中告诉我!

如果你有任何问题,或者想要联系我,请在Twitter、Medium或Dev.to找到我。

如果你想成为数据科学家,这里是我推荐的机器学习阅读清单。

个人简介:卢西亚诺·斯特里卡 是布宜诺斯艾利斯大学的计算机科学学生,同时也是 MercadoLibre 的数据科学家。他还在www.datastuff.tech上撰写关于机器学习和数据的文章。

原文。经许可转载。

相关:

-

3 本帮助我成为数据科学家的机器学习书籍

-

训练神经网络以模仿洛夫克拉夫特的写作风格

-

每个数据科学家都应该了解的 5 种概率分布

更多相关内容

Cookiecutter 数据科学:如何组织您的数据科学项目

原文:

www.kdnuggets.com/2018/07/cookiecutter-data-science-organize-data-project.html

评论

评论

由 DrivenData 提供

我们的前 3 名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升您的数据分析水平

2. 谷歌数据分析专业证书 - 提升您的数据分析水平

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 需求

为什么使用这个项目结构?

我们不是在谈论细枝末节的缩进美学或拘泥于格式标准——最终,数据科学代码质量关乎正确性和可重复性。

当我们考虑数据分析时,我们通常只关注最终报告、洞察或可视化。虽然这些最终产品通常是主要事件,但很容易专注于使产品看起来漂亮,而忽视生成它们的代码质量。因为这些最终产品是程序性生成的,代码质量依然重要!我们不是在谈论细枝末节的缩进美学或拘泥于格式标准——最终,数据科学代码质量关乎正确性和可重复性。

众所周知,良好的分析通常是非常零散和偶然探索的结果。尝试性实验和快速测试可能不起作用的方法都是获得好结果的过程的一部分,并且没有魔法弹药可以将数据探索转化为简单的线性进展。

话虽如此,一旦开始,它不是一个可以仔细考虑代码或项目布局结构的过程,因此最好从一个干净、逻辑的结构开始,并在整个过程中坚持使用。我们认为使用这样的标准化设置是一个相当大的胜利。原因如下:

其他人会感谢你

没有人在创建新的 Rails 项目之前坐下来考虑他们想把视图放在哪里;他们只是运行

rails new来获得像其他人一样的标准项目骨架。

一个明确定义的标准项目结构意味着新来者可以在不深入阅读大量文档的情况下开始理解分析。这也意味着他们不必在了解非常具体的内容之前阅读 100%的代码。

组织良好的代码往往是自我文档化的,因为组织本身为你的代码提供了上下文而无需过多开销。人们会感谢你,因为他们可以:

-

更容易与你合作完成这项分析。

-

从你的分析中学习过程和领域知识。

-

对分析得出的结论感到自信。

一个很好的例子可以在任何主要的网络开发框架中找到,比如 Django 或 Ruby on Rails。在创建一个新的 Rails 项目之前,没有人会坐下来考虑他们想把视图放在哪里;他们只需运行rails new来获取一个标准的项目骨架,因为这个默认的项目结构是合乎逻辑的且在大多数项目中合理标准化,对于从未见过特定项目的人来说,找出各种活动部分会容易得多。

另一个很好的例子是文件系统层级标准用于类似 Unix 的系统。/etc目录有一个非常具体的目的,/tmp文件夹也是如此,每个人(或多或少)都同意遵守这个社会契约。这意味着 Red Hat 用户和 Ubuntu 用户都大致知道在何处寻找某些类型的文件,即使在使用对方的系统时——或者说任何其他符合标准的系统!

理想情况下,当同事打开你的数据科学项目时,应该是这样的。

你会感谢自己。

曾经尝试过重现几个月前甚至几年前做过的分析吗?你可能写过代码,但现在很难判断你应该使用make_figures.py.old、make_figures_working.py 还是 new_make_figures01.py 来完成任务。以下是一些我们在存在主义恐惧中学会提出的问题:

-

我们是否应该在开始之前先将列 X 加入数据,还是这已经从其中一个笔记本中得到了?

-

说到这一点,我们需要先运行哪个笔记本才能运行绘图代码:是“处理数据”还是“清理数据”?

-

地理图表的 shapefiles 是从哪里下载的?

-

等等,无限重复。

这些问题类型是痛苦的,并且是项目组织不善的症状。一个好的项目结构鼓励采用使得重新回到旧工作变得更加容易的实践,例如关注点分离、将分析抽象为一个DAG,以及版本控制等工程最佳实践。

这里没有任何约束。

“愚蠢的一致性是小心眼者的鬼怪” — 拉尔夫·瓦尔多·爱默生(以及PEP 8!)

对几个默认文件夹名称不太满意?正在处理一个稍微非标准的项目,与当前结构不完全匹配?更愿意使用不同于(少数)默认值的包?

加油吧! 这是一个轻量级结构,旨在成为许多项目的良好起点。或者,正如 PEP 8 所说:

项目内的一致性更为重要。一个模块或函数内的一致性是最重要的。... 但要知道何时不一致——有时样式指南的建议不适用。遇到疑问时,运用你最好的判断。查看其他示例,决定什么看起来最好。并且不要犹豫去询问!

入门

考虑到这一点,我们创建了一个用于 Python 项目的数据科学 cookiecutter 模板。你的分析不必用 Python 进行,但模板确实提供了一些 Python 的样板代码,你可能需要删除(例如在src文件夹中,以及docs中的 Sphinx 文档骨架)。

需求

-

Python 2.7 或 3.5

-

cookiecutter Python 包 >= 1.4.0:

pip install cookiecutter

启动一个新项目

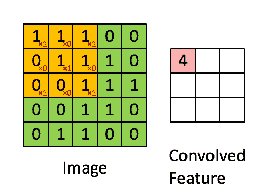

启动一个新项目就像在命令行中运行这个命令一样简单。无需先创建目录,cookiecutter 会为你完成这项工作。

cookiecutter https://github.com/drivendata/cookiecutter-data-science

示例

目录结构

├── LICENSE

├── Makefile <- Makefile with commands like `make data` or `make train`

├── README.md <- The top-level README for developers using this project.

├── data

│ ├── external <- Data from third party sources.

│ ├── interim <- Intermediate data that has been transformed.

│ ├── processed <- The final, canonical data sets for modeling.

│ └── raw <- The original, immutable data dump.

│

├── docs <- A default Sphinx project; see sphinx-doc.org for details

│

├── models <- Trained and serialized models, model predictions, or model summaries

│

├── notebooks <- Jupyter notebooks. Naming convention is a number (for ordering),

│ the creator's initials, and a short `-` delimited description, e.g.

│ `1.0-jqp-initial-data-exploration`.

│

├── references <- Data dictionaries, manuals, and all other explanatory materials.

│

├── reports <- Generated analysis as HTML, PDF, LaTeX, etc.

│ └── figures <- Generated graphics and figures to be used in reporting

│

├── requirements.txt <- The requirements file for reproducing the analysis environment, e.g.

│ generated with `pip freeze > requirements.txt`

│

├── setup.py <- Make this project pip installable with `pip install -e`

├── src <- Source code for use in this project.

│ ├── __init__.py <- Makes src a Python module

│ │

│ ├── data <- Scripts to download or generate data

│ │ └── make_dataset.py

│ │

│ ├── features <- Scripts to turn raw data into features for modeling

│ │ └── build_features.py

│ │

│ ├── models <- Scripts to train models and then use trained models to make

│ │ │ predictions

│ │ ├── predict_model.py

│ │ └── train_model.py

│ │

│ └── visualization <- Scripts to create exploratory and results oriented visualizations

│ └── visualize.py

│

└── tox.ini <- tox file with settings for running tox; see tox.testrun.org

意见

项目结构中隐含了一些观点,这些观点源于我们在数据科学项目合作中的经验,有些是关于工作流程的,有些是关于简化工作生活的工具的。这些观点是该项目的基础——如果你有想法,请贡献或分享。

数据是不可变的

切勿编辑你的原始数据,特别是不要手动编辑,尤其是在 Excel 中。不要覆盖你的原始数据。不要保存原始数据的多个版本。将数据(及其格式)视为不可变的。你编写的代码应该将原始数据通过管道传递到最终分析中。你不需要每次都运行所有步骤来生成新的图表(见分析是一个 DAG),但任何人都应该能够仅使用src中的代码和data/raw中的数据重现最终产品。

此外,如果数据是不可变的,它不需要像代码那样进行源代码管理。因此,默认情况下,数据文件夹包含在 .gitignore 文件中。 如果你有少量数据,且很少更改,你可能希望将数据包含在仓库中。Github 目前会警告文件超过 50MB,并拒绝超过 100MB 的文件。其他存储/同步大数据的选项包括 AWS S3 及其同步工具(例如,s3cmd)、Git Large File Storage、Git Annex 和 dat。目前,我们默认要求使用 S3 存储桶,并使用 AWS CLI 将 data 文件夹中的数据与服务器同步。

笔记本用于探索和交流

像 Jupyter notebook、Beaker notebook、Zeppelin 等笔记本包以及其他文学编程工具对于探索性数据分析非常有效。然而,这些工具在再现分析结果时可能效果较差。当我们在工作中使用笔记本时,我们通常会将 notebooks 文件夹进一步细分。例如,notebooks/exploratory 包含初步探索,而 notebooks/reports 是更为完善的工作,可以导出为 html 文件到 reports 目录。

由于笔记本是源代码管理的挑战性对象(例如,json 的差异通常不可读,合并几乎不可能),我们建议不要直接在 Jupyter 笔记本上与他人协作。我们建议有效使用笔记本的两个步骤:

-

遵循一个命名规范,显示所有者和分析的顺序。我们使用

<step>-<ghuser>-<description>.ipynb的格式(例如,0.3-bull-visualize-distributions.ipynb)。 -

重构好的部分。不要在多个笔记本中编写执行相同任务的代码。如果这是数据预处理任务,将其放入

src/data/make_dataset.py的管道中,并从data/interim加载数据。如果是有用的工具代码,将其重构到src中。

现在,默认情况下,我们将项目转换为一个 Python 包(参见 setup.py 文件)。你可以导入你的代码并在笔记本中使用类似以下的单元格:

# OPTIONAL: Load the "autoreload" extension so that code can change

%load_ext autoreload

# OPTIONAL: always reload modules so that as you change code in src, it gets loaded

%autoreload 2

from src.data import make_dataset

分析是一个有向无环图(DAG)

在分析中,通常会有长时间运行的步骤来预处理数据或训练模型。如果这些步骤已经运行过(并且你将输出存储在类似于data/interim的目录中),你不希望每次都重新运行它们。我们更喜欢make来管理相互依赖的步骤,特别是那些长时间运行的步骤。Make 是 Unix 平台上常见的工具(并且在 Windows 上也可用)。遵循make文档、Makefile 约定和便携性指南将帮助确保你的 Makefile 在不同系统上有效运行。这里有一些 示例供你入门。许多数据人员,包括Mike Bostock,将make作为他们的首选工具。

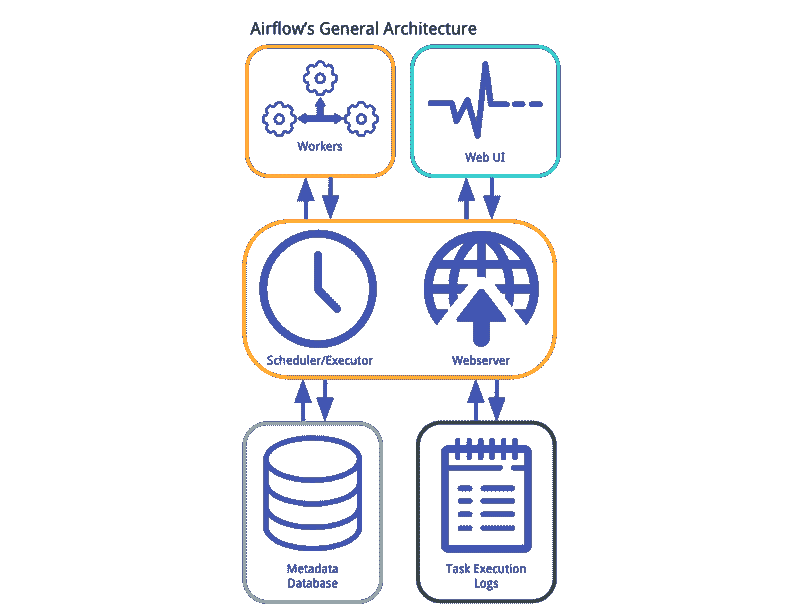

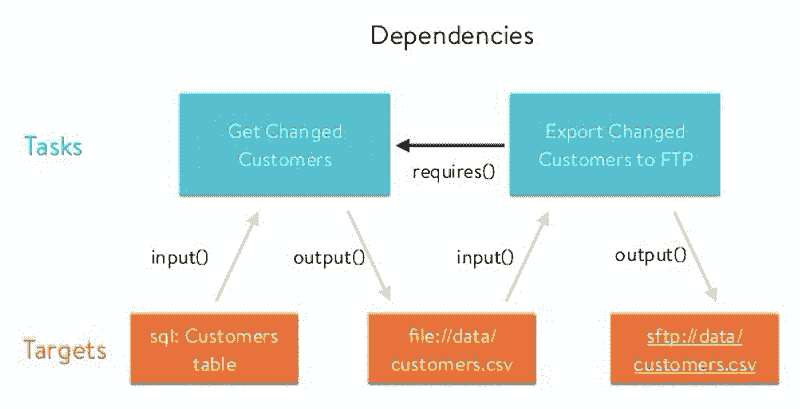

还有其他一些管理 DAG 的工具是用 Python 编写的,而不是使用 DSL(例如,Paver、Luigi、Airflow、Snakemake、Ruffus或Joblib)。如果这些工具更适合你的分析,请随意使用它们。

从环境开始构建。

重现分析的第一步总是重现运行分析的计算环境。你需要相同的工具、相同的库以及相同的版本,以确保一切协调一致。

一种有效的方法是使用virtualenv(我们推荐使用virtualenvwrapper来管理虚拟环境)。通过在仓库中列出所有的需求(我们包含了一个requirements.txt文件),你可以轻松追踪重建分析所需的包。以下是一个好的工作流程:

-

在创建新项目时运行

mkvirtualenv。 -

使用

pip install安装分析所需的包。 -

运行

pip freeze > requirements.txt以固定用于重建分析的确切包版本。 -

如果你发现需要安装另一个包,重新运行

pip freeze > requirements.txt并将更改提交到版本控制系统中。

如果你对重建环境有更复杂的需求,可以考虑基于虚拟机的方法,如Docker或Vagrant。这两种工具使用基于文本的格式(Dockerfile 和 Vagrantfile),你可以轻松地将其添加到版本控制中,以描述如何创建一个具有所需要求的虚拟机。

保持秘密和配置不在版本控制中

你真的不希望在 Github 上泄露你的 AWS 秘密密钥或 Postgres 用户名和密码。言尽于此——请参见Twelve Factor App原则。这里有一种方法:

将你的秘密和配置变量存储在一个特殊的文件中

在项目根文件夹中创建一个.env文件。由于.gitignore,此文件不应被提交到版本控制仓库中。以下是一个示例:

# example .env file

DATABASE_URL=postgres://username:password@localhost:5432/dbname

AWS_ACCESS_KEY=myaccesskey

AWS_SECRET_ACCESS_KEY=mysecretkey

OTHER_VARIABLE=something

使用一个包来自动加载这些变量。

如果你查看src/data/make_dataset.py中的存根脚本,它使用了一个名为python-dotenv的包,将此文件中的所有条目加载为环境变量,因此可以通过os.environ.get访问。以下是从python-dotenv文档中改编的示例代码:

# src/data/dotenv_example.py

import os

from dotenv import load_dotenv, find_dotenv

# find .env automagically by walking up directories until it's found

dotenv_path = find_dotenv()

# load up the entries as environment variables

load_dotenv(dotenv_path)

database_url = os.environ.get("DATABASE_URL")

other_variable = os.environ.get("OTHER_VARIABLE")

AWS CLI 配置

使用 Amazon S3 存储数据时,管理 AWS 访问的简单方法是将访问密钥设置为环境变量。然而,在一台机器上管理多个密钥集(例如在多个项目中工作时),最好使用凭证文件,通常位于~/.aws/credentials。一个典型的文件可能如下所示:

[default]

aws_access_key_id=myaccesskey

aws_secret_access_key=mysecretkey

[another_project]

aws_access_key_id=myprojectaccesskey

aws_secret_access_key=myprojectsecretkey

在初始化项目时,你可以添加配置文件名;假设没有设置适用的环境变量,配置文件的凭证将作为默认值使用。

在更改默认文件夹结构时要保守

为了使这种结构适用于多种不同类型的项目,我们认为最好的方法是对你的项目更改文件夹保持宽容,但对所有项目的默认结构保持保守。

我们创建了一个folder-layout标签,专门用于提议添加、删除、重命名或移动文件夹的问题。更广泛地说,我们还创建了一个needs-discussion标签,用于需要进行仔细讨论和广泛支持的问题。

贡献

Cookiecutter Data Science 项目有其明确的观点,但不怕犯错。最佳实践在变化,工具在进化,经验在积累。这个项目的目标是让开始、结构化和共享分析变得更容易。 鼓励拉取请求和提交问题。我们很想知道什么对你有效,什么无效。

如果你使用了 Cookiecutter 数据科学项目,请链接回此页面或 给我们留言 并 告诉我们!

相关项目和参考文献链接

项目结构和可重复性在 R 研究社区中有更多讨论。如果你在使用 R,这里有一些项目和博客文章可能对你有所帮助。

-

项目模板 - 一个 R 数据分析模板

-

"设计项目" 在 Nice R Code 上

-

"我的研究工作流程" 在 Carlboettifer.info 上

-

"计算生物学项目的快速指南" 在 PLOS 计算生物学上

最后,感谢Cookiecutter项目 (github),它帮助我们减少了在编写模板代码上的时间,使我们能够将更多时间用于完成实际工作。

简介: DrivenData 是一家以使命驱动的数据科学公司,将数据科学、机器学习和人工智能的强大能力带到应对全球最大挑战的组织。DrivenData Labs (drivendata.co) 帮助以使命为导向的组织利用数据更聪明地工作,提供更有影响力的服务,并充分发挥机器智能的潜力。DrivenData 还举办在线机器学习竞赛 (drivendata.org),在这里,全球热情的数据科学家为社会影响构建算法。

原版。经授权转载。

相关:

-

与机器学习算法相关的数据结构

-

Python 正则表达式备忘单

-

Python 中的函数式编程介绍

更多相关话题

数据科学的核心

评论

评论

作者:PG Madhavan, Ph.D.,算法学家 - 商业数据科学。

阅读了一些最近的博客后,我感到数据科学从业者对他们领域的性质感到一丝焦虑。数据科学到底是什么——这个问题似乎一直潜伏在表面下方……

我们的前三课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

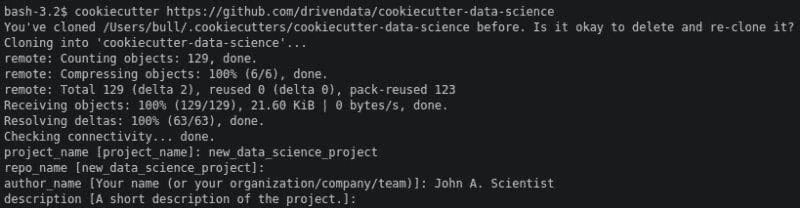

作为一个年轻的研究和工作领域,数据科学的定义自然需要时间才能明朗。在此期间,看看这是否适合你……

数据科学是许多理论的应用方面。我的方向是贝叶斯的,因此我把概率论放在首位。许多其他科学也起着重要作用——例如,物理学和统计力学就发挥了重要作用。我们已经很长时间习惯于 L2 优化(欧几里得距离度量),但目前在 L1 优化(出租车距离度量)方面有了越来越多的活动。L1 优化将我们从均方误差最优性的舒适区中推了出来,带来了 2 阶思维的挑战!

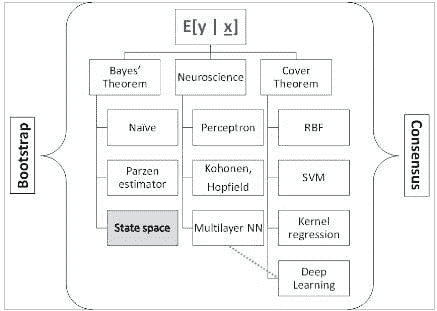

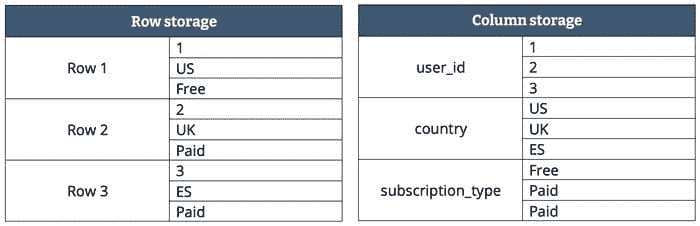

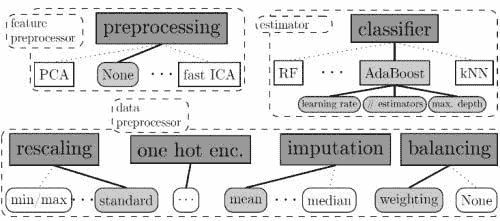

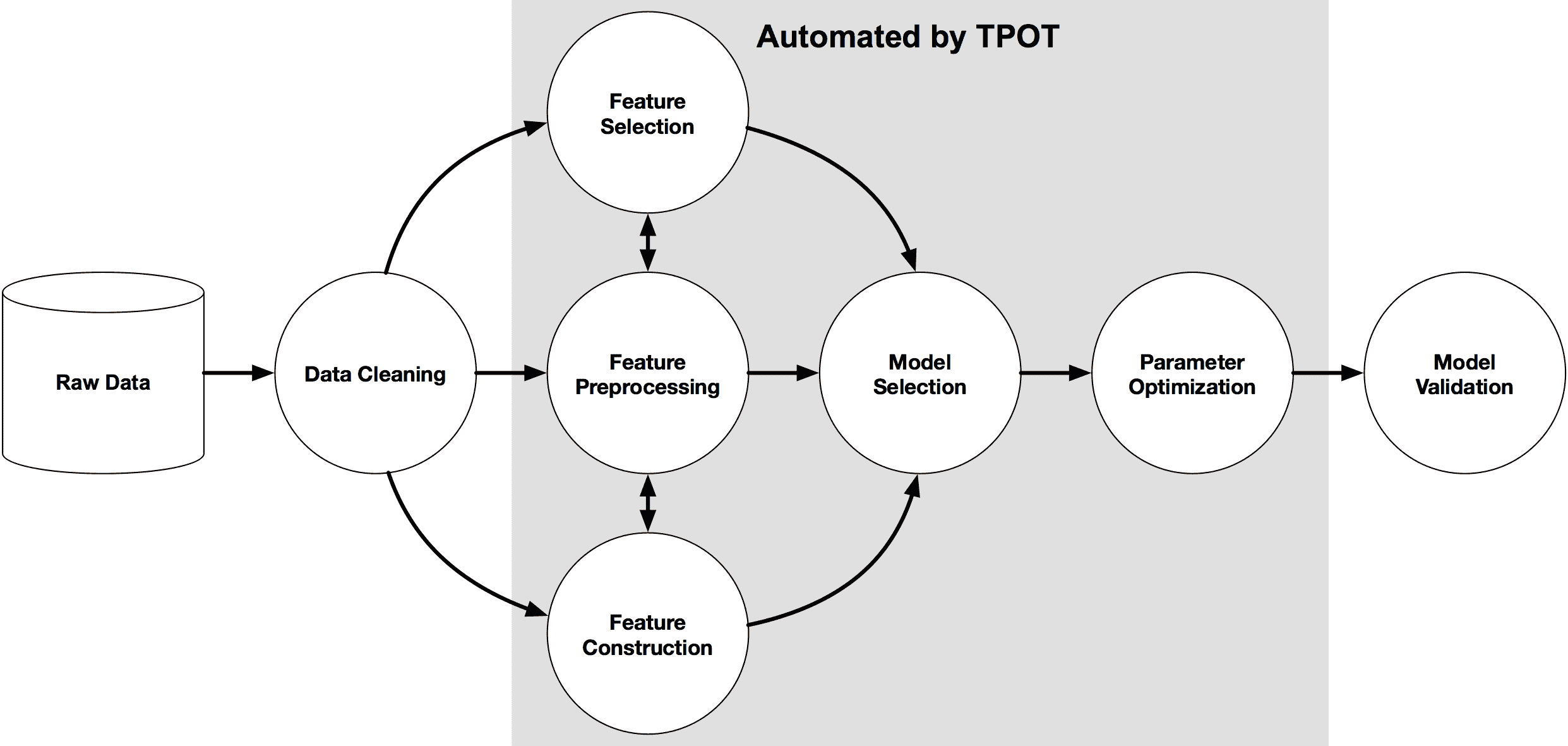

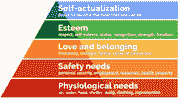

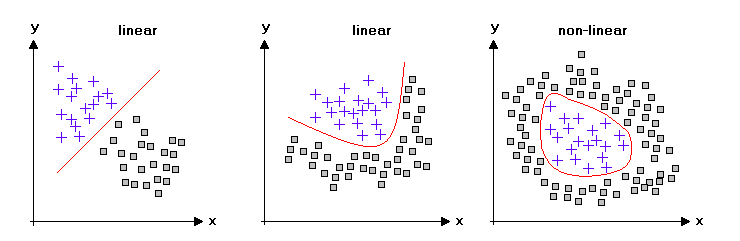

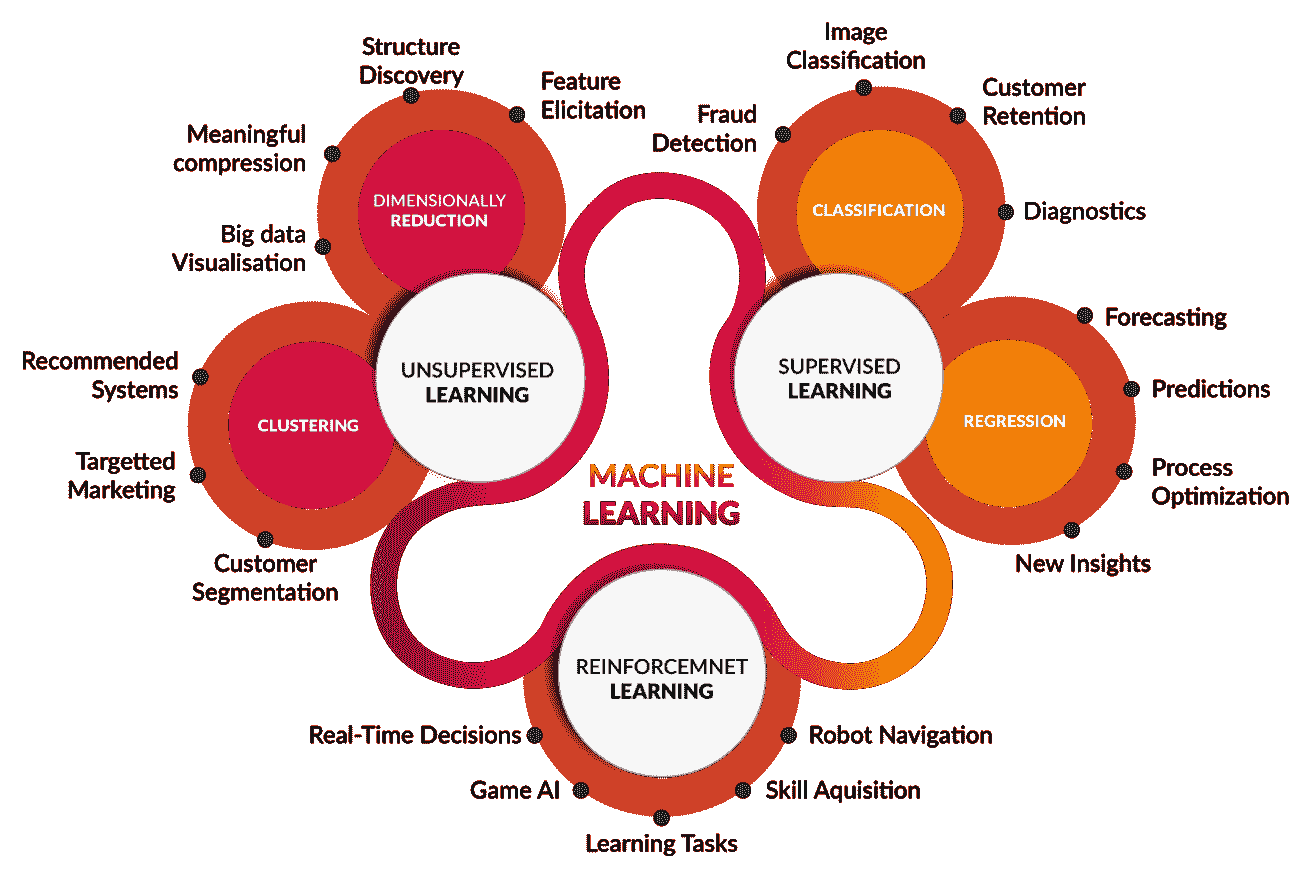

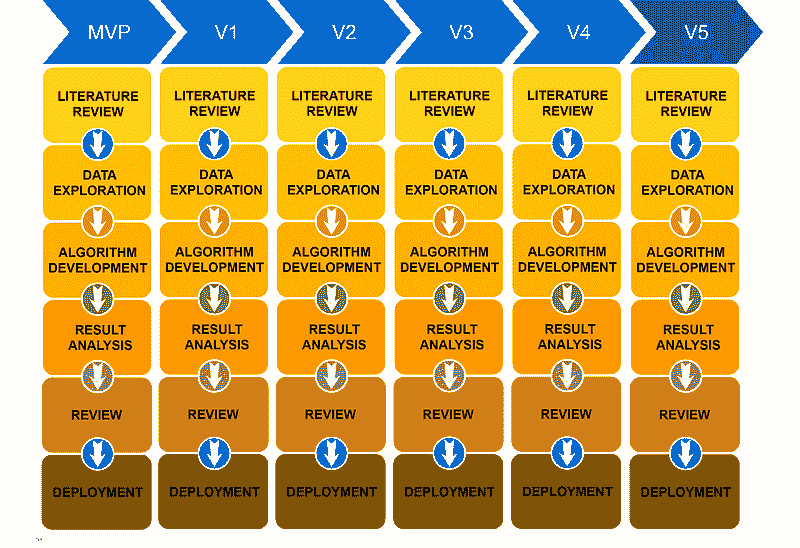

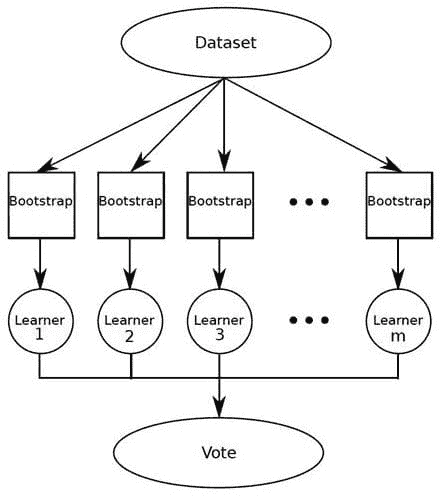

毫无疑问,数据科学的核心是机器学习(ML)——这个话题的确是“核心”!机器学习基本上关注于找到输入和输出向量空间之间极其重要的“映射”(有关该主题的完整开发,请参见“SYSTEMS Analytics: Adaptive Machine Learning workbook”)。有很多工具和技巧,使得对机器学习的全面理解可能会让人感到沮丧;所以我在下面整理了一个本体,组织了我们对机器学习的所有知识。重点是将大量材料分为 3 个主题:贝叶斯定理、覆盖定理和神经科学与特定方法。在机器学习实践中,这些方法被“自助”方法和“共识”方法“包裹”起来。

“鳄梨的核心”在大的括号内。

-

覆盖定理说明(来自Haykin, 2006):“在高维空间中非线性地转换的复杂模式分类问题,比在低维空间中更可能是线性可分的,前提是空间不是密集填充的。”

-

从输出的条件概率密度函数中估计条件期望值 E[ y | x],其中‘y’是输出,‘x’是输入,是硬核概率方法的核心内容。我个人最喜欢的是使用状态空间数据模型和卡尔曼滤波器来估计参数。

-

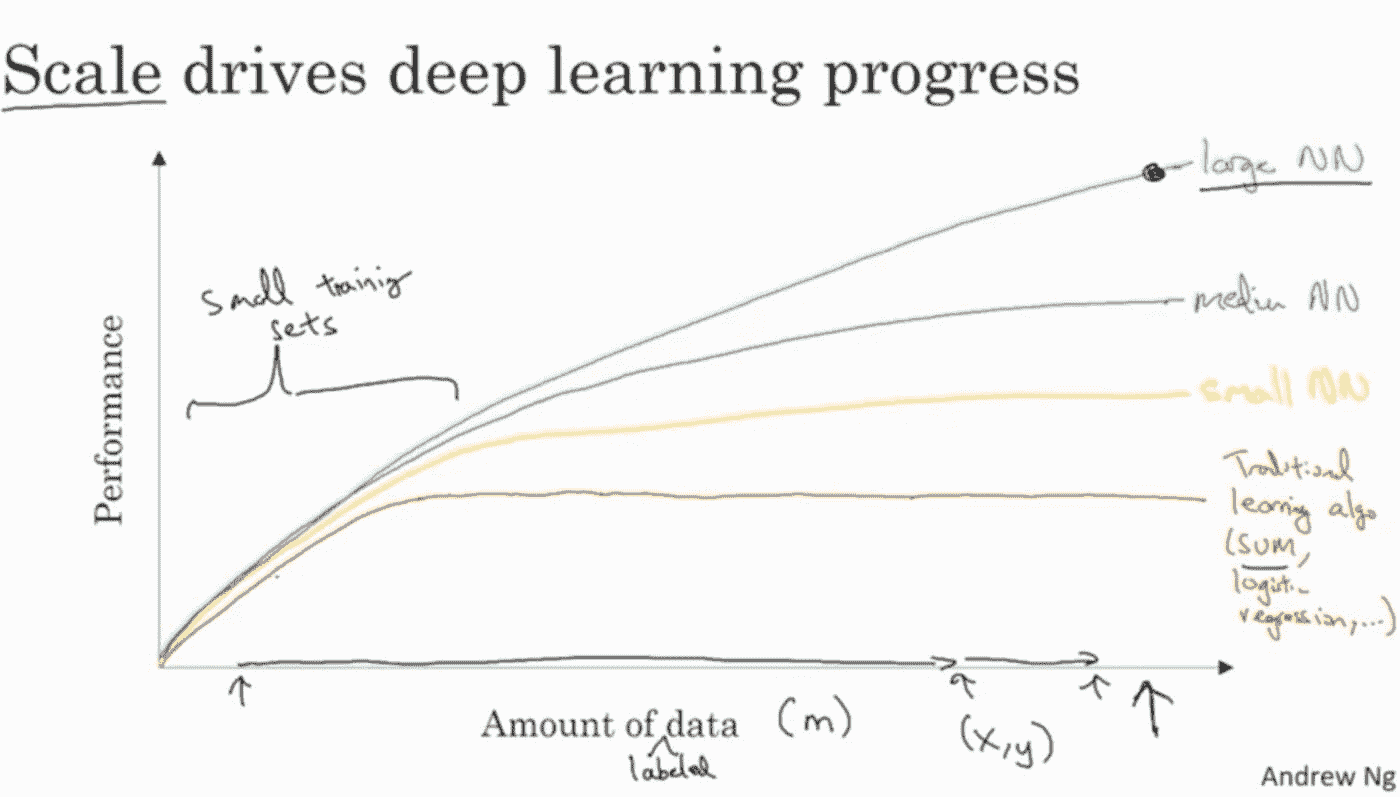

中间分支是一个由神经科学主导的“包罗万象”的领域,从感知机开始。深度学习是这种方法在本体论中最新的表现形式(结合了高维度)。

统计实验设计提供了周围的“实质”!

输入侧:自助方法

目标是最大化训练集信息的使用。

-

有许多方法:

-

自助训练集;有放回地抽样训练集。

-

蒙特卡罗方法;用于概率密度估计。

-

特征子空间。

-

统计学中的实验设计原则;“分组”、因子设计等。

-

还有更多。

-

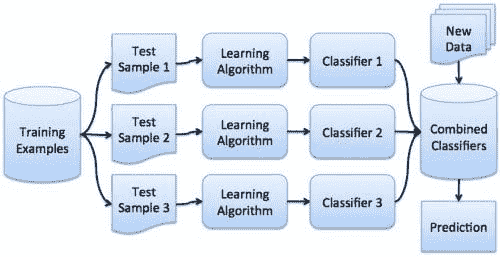

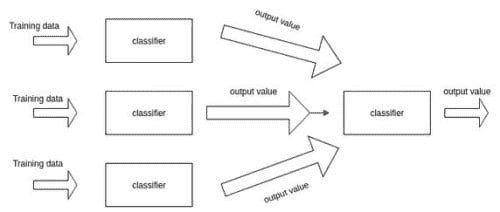

输出侧:共识方法

使用独立的机器学习方法解决问题并结合结果。

-

结合“弱学习者”。

-

随机森林。

-

AdaBoost。

-

还有更多。

-

大多数机器学习工作倾向于学习输入和输出之间的静态映射,然后将其投入“生产”,隐含假设这种关系将保持不变!我挑战这种假设,并提供了在现实生活中动态变化的情况下最佳解决方法的方式,详见本博客:“对动态机器学习的需求:贝叶斯精确递归估计”。

机器学习映射的实际使用需要严格的实验设计框架(Box 等,一本老经典)。正如我们在上面的本体树中看到的,当你用强有力的统计实验学科围绕坚实的机器学习映射时,我们可以从数据科学中获得稳健、可重复且实际有用的结果!

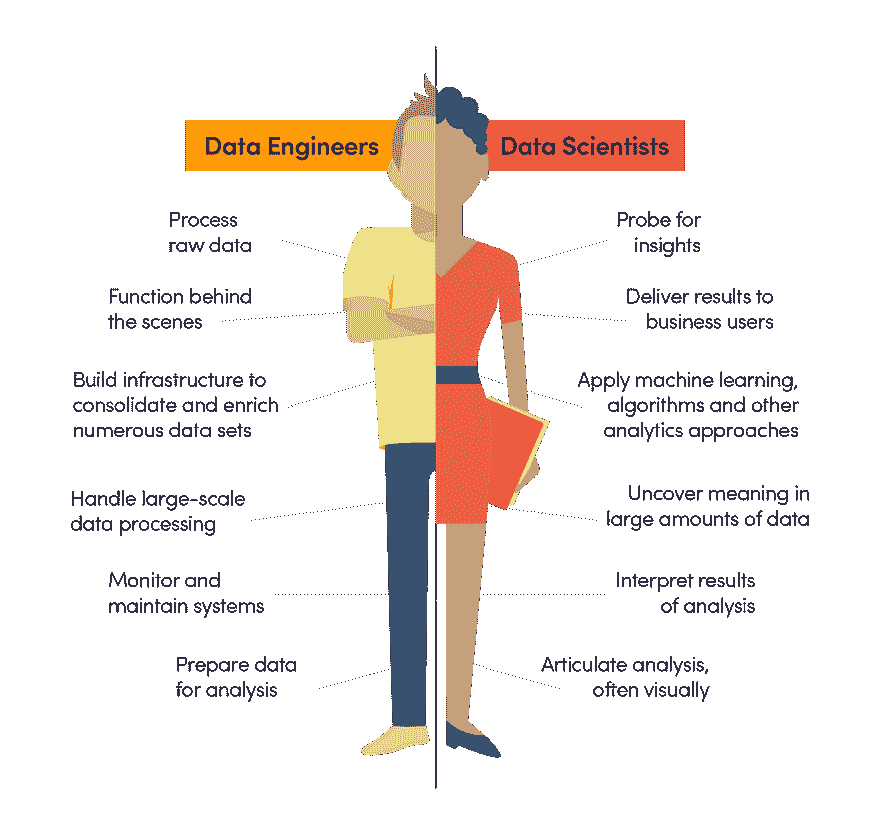

在实现数据科学解决方案方面,数据科学是一项“团队运动”和“对抗性运动”。

没有数据科学就没有与数据的持续接触。数据会影响算法、代码、业务应用和日常使用。

数据科学解决方案的开发需要 (1) 一位具备深厚和广泛数学技能的算法专家,(2) 一位拥有数据库和云操作系统技能的编码员,以及 (3) 一位具有定量倾向的商业专业人员。我还没有遇到过具备这三种技能到所需深度的个人!同样重要的是,每种角色的个人气质差异明显。因此,快速的数据科学解决方案开发需要一个真实或虚拟的三人团队。数据科学解决方案的部署和操作通常可以由具备应用统计学思维的合格 STEM 毕业生完成(该人欣赏日常业务应用中的统计实验方面)。

数据科学的最佳时光尚未到来!还有其他科学可以挖掘以获取新技术,更多的计算能力意味着可以完成更多的任务,很快,由数据科学提供的强大“智能增强”将改变商业、工作和娱乐的性质,带来更好的变革——下一次“工业”革命!

简介:PG Madhavan, Ph.D. 是一位数据科学专家 + 教练,在机器学习算法、产品和业务方面有着深厚且均衡的经验。

简介:PG Madhavan, Ph.D. 是一位数据科学专家 + 教练,在机器学习算法、产品和业务方面有着深厚且均衡的经验。

相关:

-

理论数据发现:利用物理学理解数据科学

-

构建数据科学投资组合:机器学习项目第一部分

-

如何为您的团队确定合适的数据科学家?

更多相关内容

新调查:你拥有哪些数据科学技能,哪些技能是你想要的?立即投票

原文:

www.kdnuggets.com/2020/08/core-hot-data-science-skills-poll.html

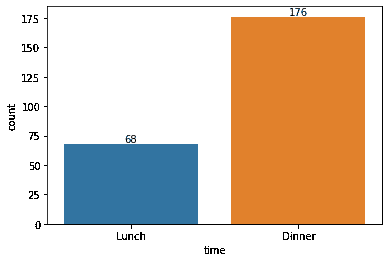

调查已结束 - 以下是结果:

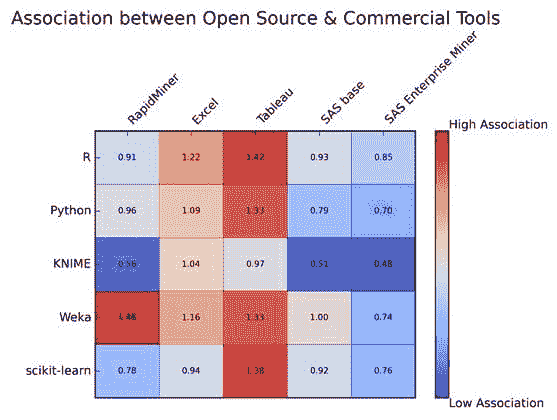

我们分析了数据科学技能调查的结果,包括 8 个技能类别,超过 50% 的受访者掌握的 13 项核心技能,数据科学家希望学习的热门/新兴技能,以及数据科学家希望学习的顶级技能。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

新的 KDnuggets 调查提出了两个相关问题:

1. 你目前掌握哪些技能/知识领域(能够在工作或研究中使用的水平)?

2. 你希望添加或改进哪些技能?

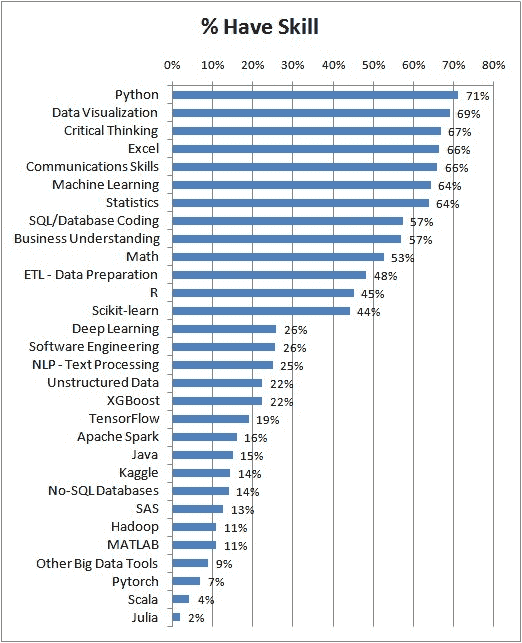

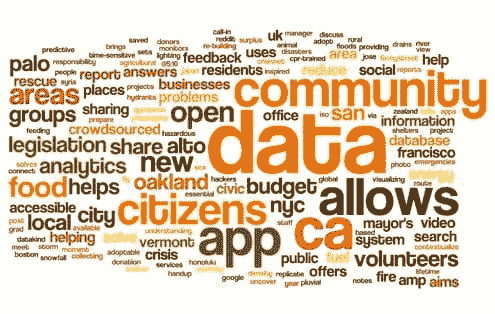

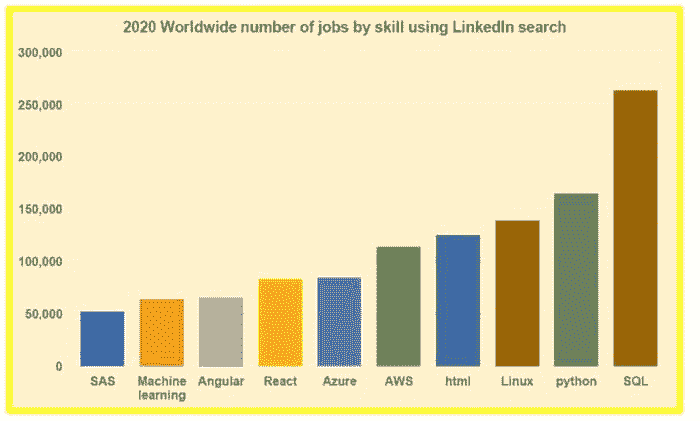

图 1. 来自 去年数据科学技能调查分析 的结果。

图 1. 来自 去年数据科学技能调查分析 的结果。

技能被收集到几个相关的子部分,读者被要求指出他们目前掌握哪些技能以及他们希望添加或改进哪些技能。请注意,你可能既有某项技能又希望改进它。

你可以 在这里阅读去年的调查分析。

更多相关主题

哪些数据科学技能是核心的,哪些是热点/新兴的?

原文:

www.kdnuggets.com/2019/09/core-hot-data-science-skills.html

评论最新的 KDnuggets 调查问卷

1. 你目前拥有哪些技能/知识领域(达到可以在工作或研究中使用的水平)? 和

2. 你想增加或改善哪些技能?

我们基于之前的 KDnuggets 文章和调查挑选了 30 项技能 - 见本文末尾的有用链接,以及外部来源。

总体而言(*),本次调查共收到超过 1,500 票 - 样本足够大,可以得出有意义的结论。平均每位受访者报告拥有 10 项技能,并希望增加或改善 6.5 项技能。

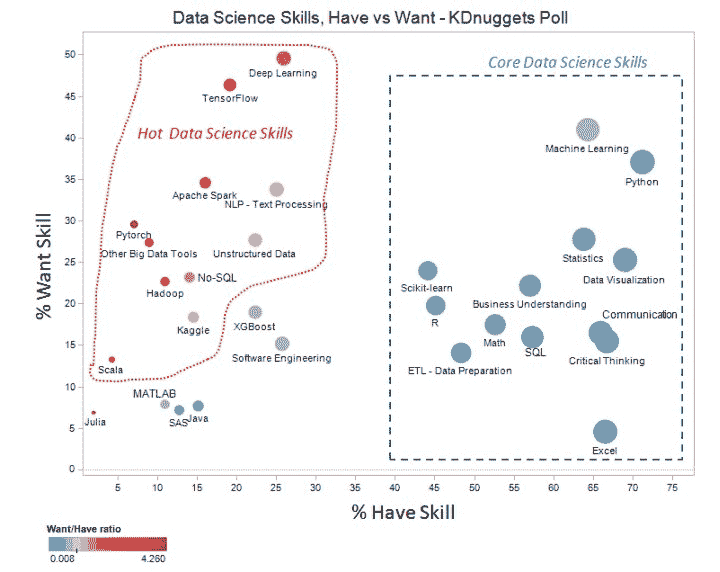

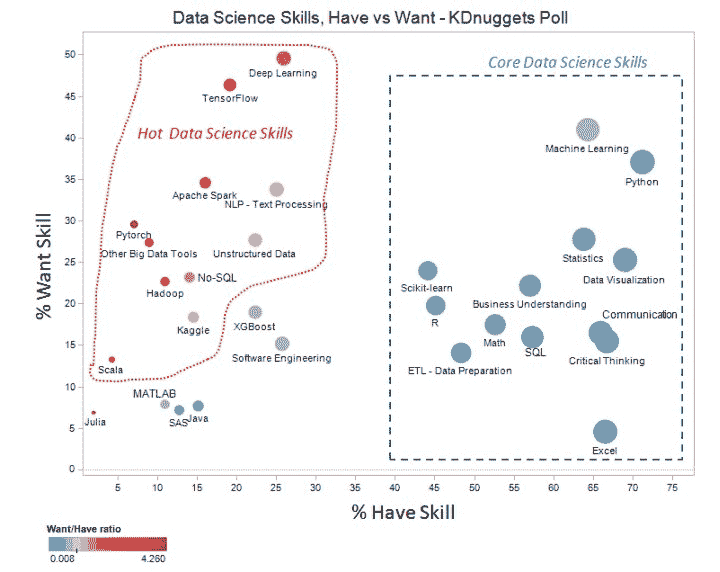

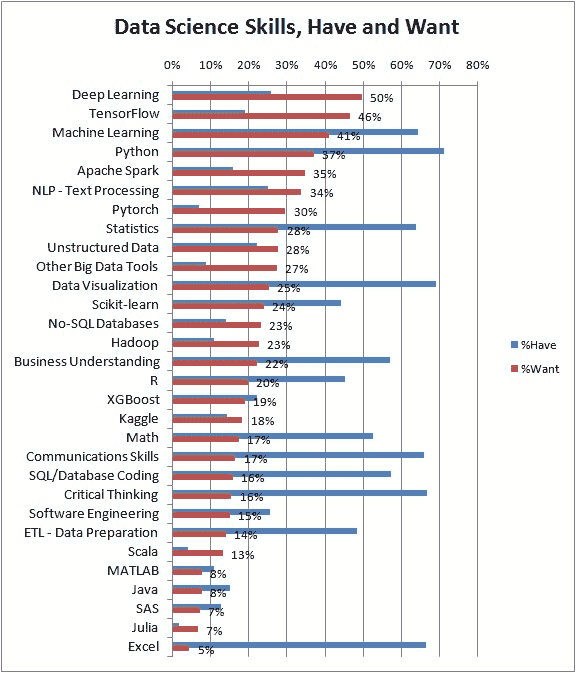

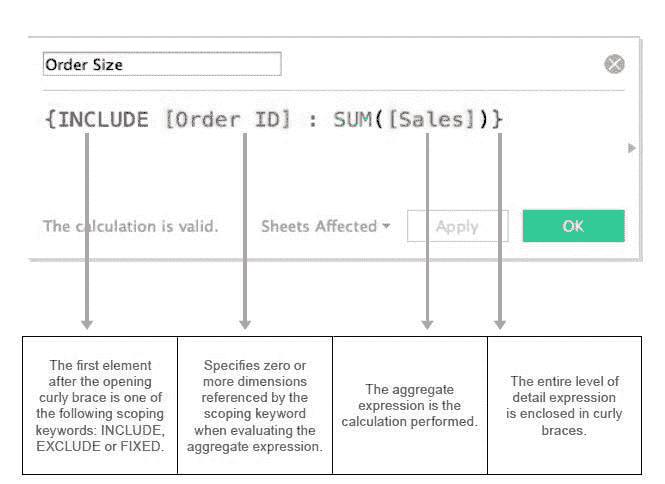

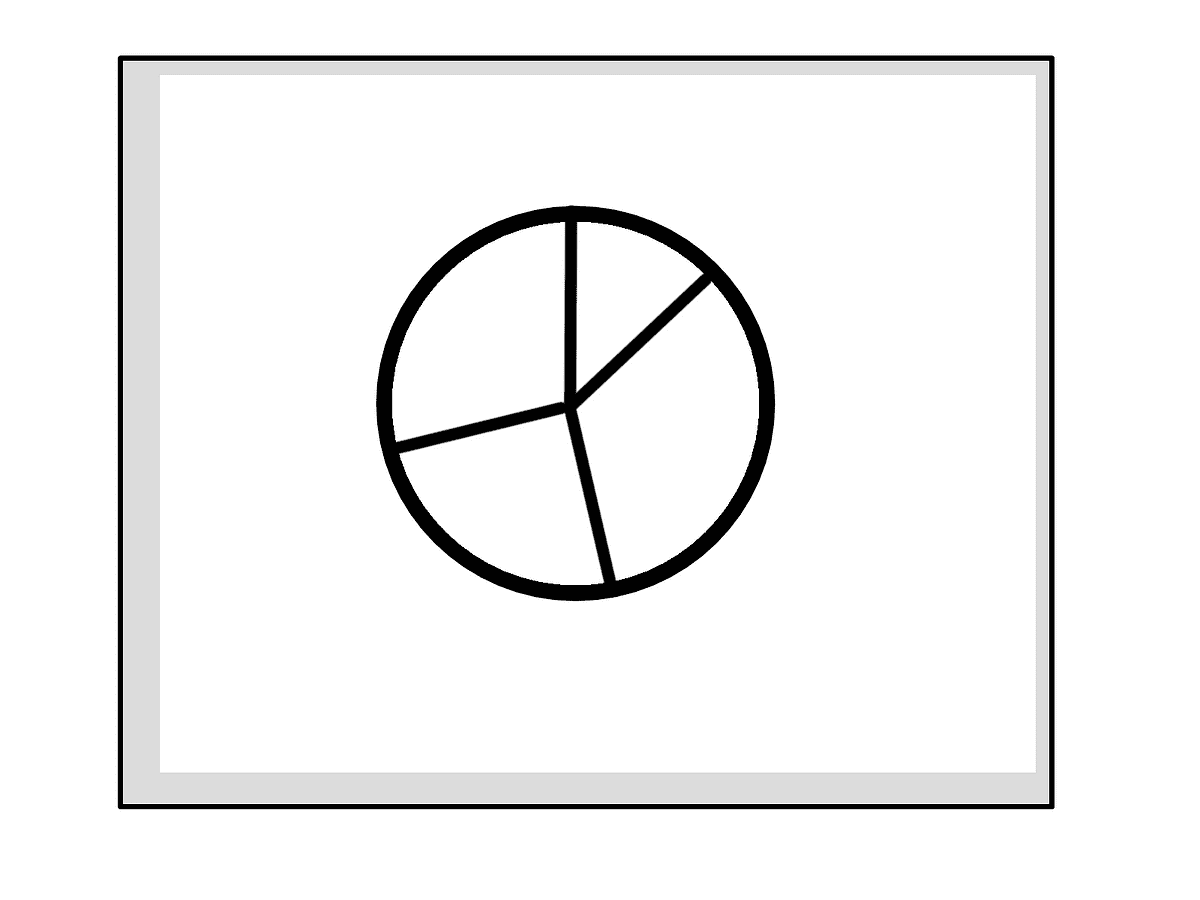

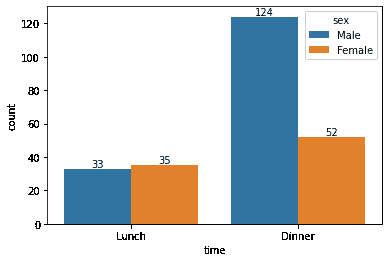

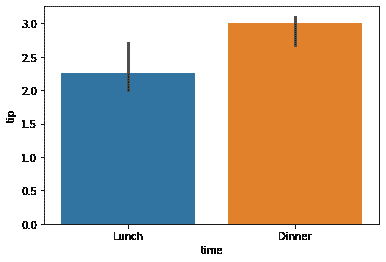

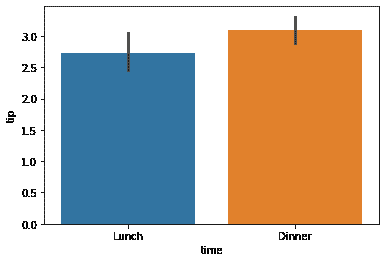

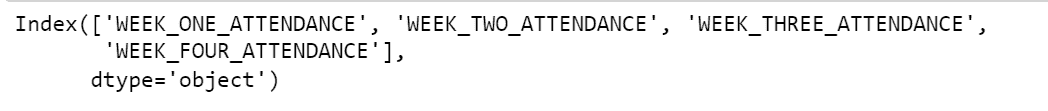

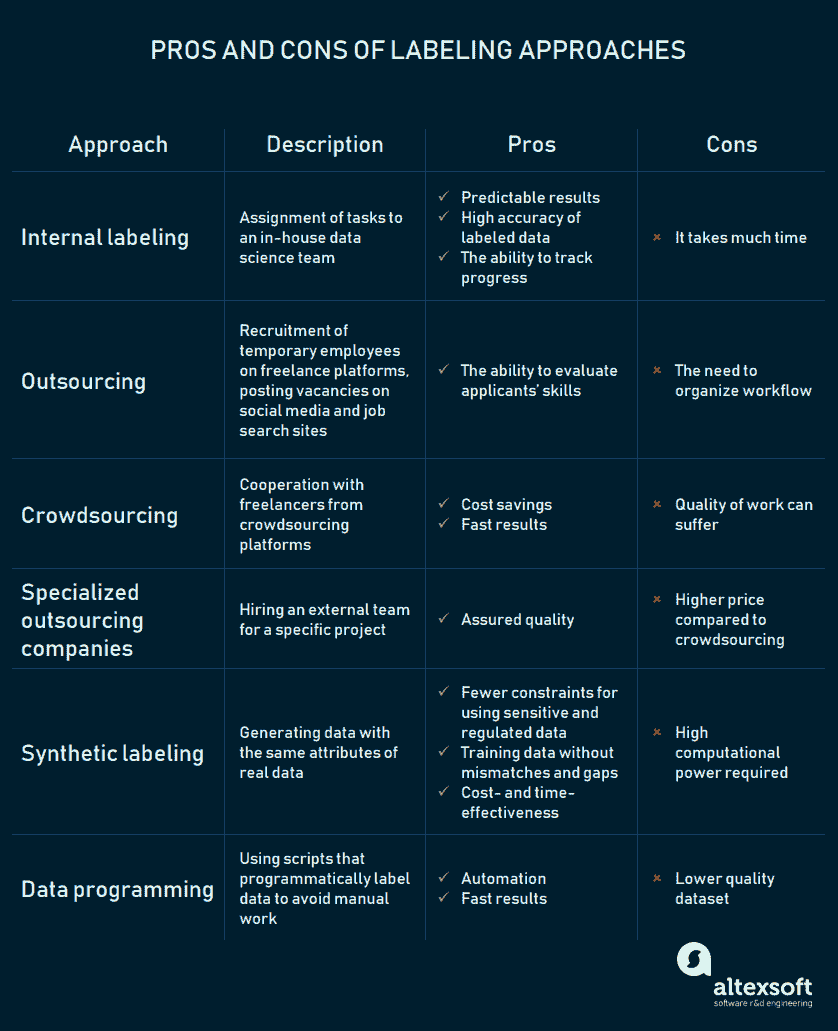

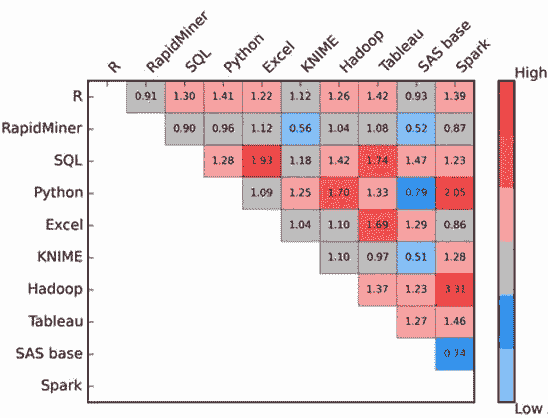

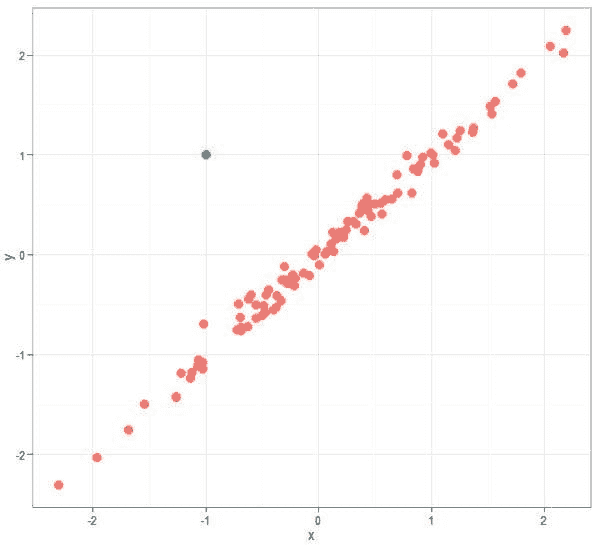

下图 1 显示了主要发现,X 轴显示拥有技能的百分比 - 对第一个调查问题的回答,Y 轴显示希望拥有技能的百分比 - 对第二个调查问题的回答。每个圆圈的大小与拥有该技能的受访者百分比成正比,而颜色则取决于 Want/Have 比例(红色为高 - 超过 1,蓝色为低 - 少于 1)。

注意:其他大数据工具 条目指的是除 Hadoop 或 Spark 外的大数据工具。

图 1:数据科学相关技能,拥有技能与希望增加或改善的技能

我们在此图表中注意到两个主要的集群。

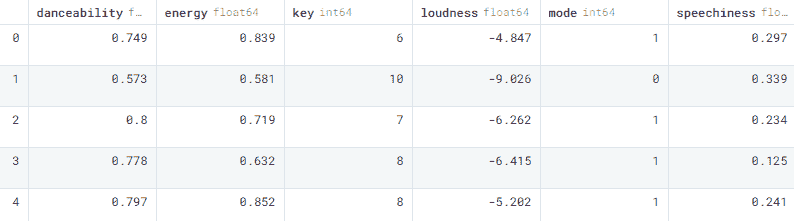

集群 1,在图表右侧的蓝色虚线矩形中,包括超过 40% 受访者拥有的技能,且 Want/Have 比例小于 1。我们称之为核心数据科学技能。它们列在表 1 中。

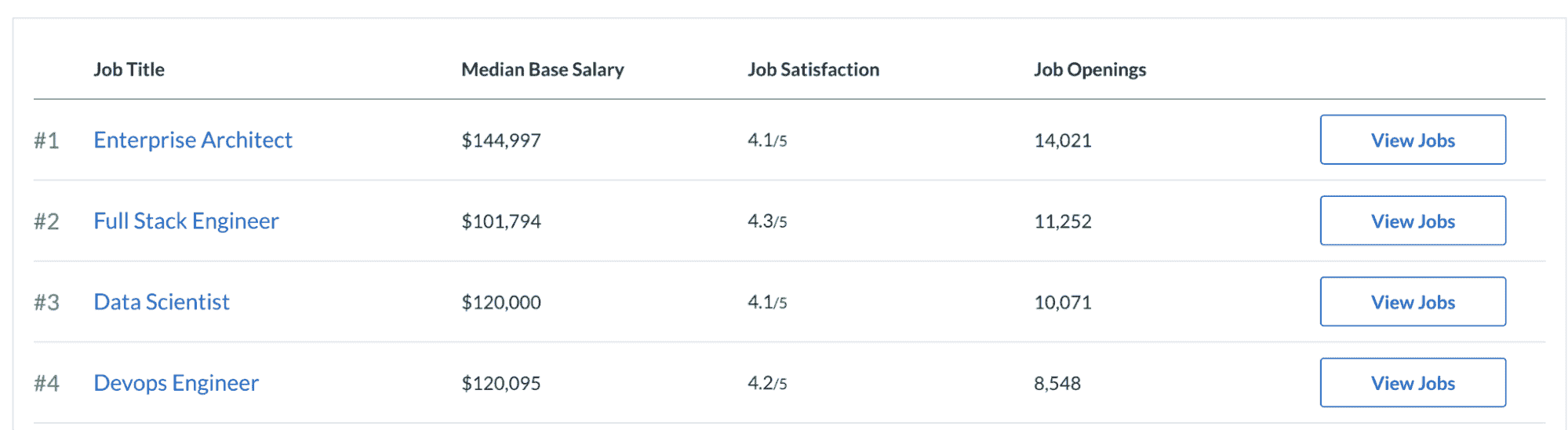

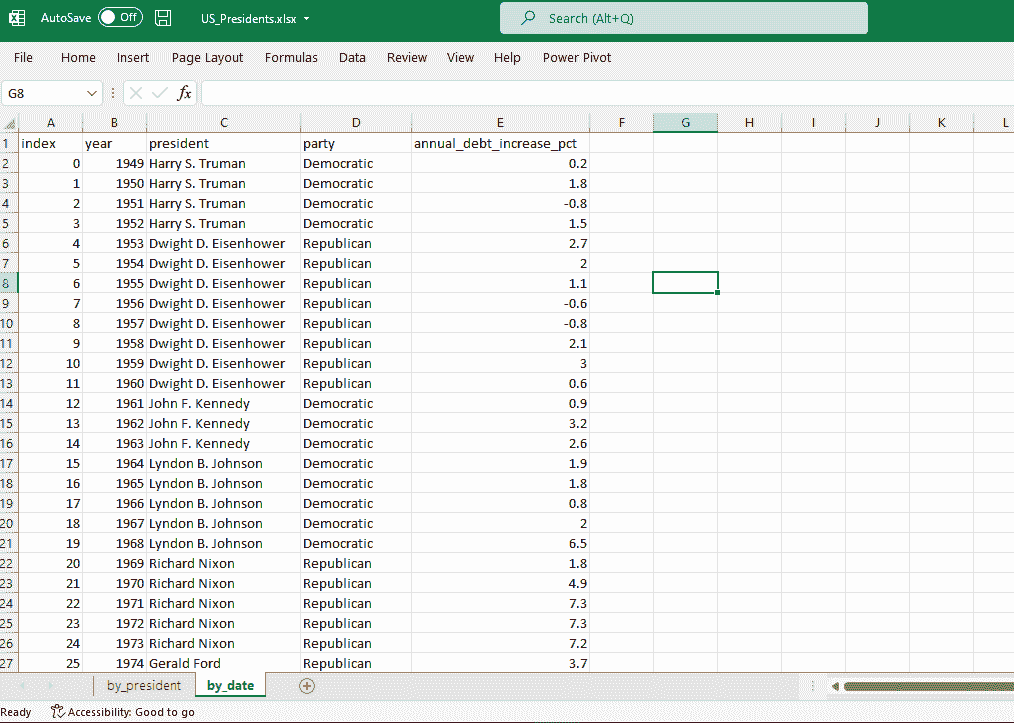

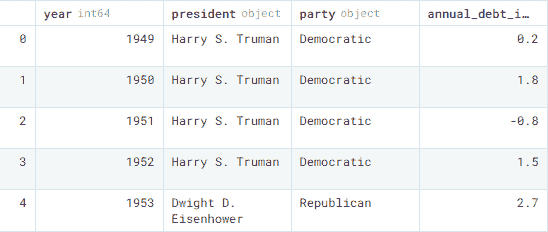

表 1:核心数据科学技能,按 %Have 递减排序

| 技能 | %Have | %Want | %Want/ %Have |

|---|---|---|---|

| Python | 71.2% | 37.1% | 0.52 |

| 数据可视化 | 69.0% | 25.3% | 0.37 |

| 批判性思维 | 66.7% | 15.5% | 0.23 |

| Excel | 66.5% | 4.6% | 0.07 |

| 沟通技能 | 65.9% | 16.5% | 0.25 |

| 机器学习 | 64.3% | 41.0% | 0.64 |

| 统计学 | 63.8% | 27.8% | 0.44 |

| SQL/数据库编码 | 57.3% | 16.0% | 0.28 |

| 商业理解 | 57.0% | 22.2% | 0.39 |

| 数学 | 52.6% | 17.5% | 0.33 |

| ETL - 数据准备 | 48.3% | 14.1% | 0.29 |

| R | 45.1% | 19.8% | 0.44 |

| Scikit-learn | 44.1% | 24.0% | 0.54 |

其中,添加或改善欲望最强的技能是机器学习(41%)和 Python(37%)。增长最少的技能是 Excel - 只有 7% 的人希望增加或改善他们的 Excel 技能。

第二类(见图 1 左侧,并用红色边框标记)包括当前较不流行的技能(%Have< 30%),但正在增长,%Want/%Have 比例超过 1 - 见表 2。我们称之为热点/新兴数据科学技能。

表 2:热点/新兴数据科学技能,按 %Want/%Have 递减排序

| 技能 | %Have | %Want | %Want/ %Have |

|---|---|---|---|

| Pytorch | 7.0% | 29.6% | 4.26 |

| Scala | 4.2% | 13.3% | 3.14 |

| 其他大数据工具 | 8.9% | 27.4% | 3.08 |

| TensorFlow | 19.1% | 46.4% | 2.44 |

| Apache Spark | 16.0% | 34.6% | 2.16 |

| Hadoop | 10.9% | 22.7% | 2.08 |

| 深度学习 | 25.9% | 49.6% | 1.92 |

| No-SQL 数据库 | 14.0% | 23.2% | 1.65 |

| NLP - 文本处理 | 25.0% | 33.8% | 1.35 |

| Kaggle | 14.5% | 18.4% | 1.27 |

| 非结构化数据 | 22.3% | 27.7% | 1.24 |

有趣的是,尽管有观点认为 Hadoop 在下降,但在这次调查中,更多人想学习 Hadoop 而不是已经了解它,因此它可能仍会增长。

尽管 Julia 的需求/拥有比例为3.4,我们仍未将其列为热门/新兴技能,因为只有 2%的投票者选择了它,它目前还没有足够的支持。

剩余技能 - XGBoost、软件工程、Java、MATLAB、SAS 的拥有比例在 10%到 30%之间,但没有增长 - 需求/拥有比例 < 1。

表 3:其他数据科学技能,按拥有比例的降序排列

| 技能 | %拥有 | %需求 | %需求/ %拥有 |

|---|---|---|---|

| 软件工程 | 25.7% | 15.2% | 0.59 |

| XGBoost | 22.3% | 19.0% | 0.85 |

| Java | 15.1% | 7.7% | 0.51 |

| SAS | 12.7% | 7.2% | 0.57 |

| MATLAB | 10.9% | 7.9% | 0.73 |

| Julia | 2.0% | 6.9% | 3.44 |

这里是关于调查的更多细节。图 2 按拥有比例的降序排列了所有技能。

图 2:数据科学技能 KDnuggets 读者拥有的

图 3 显示了读者想要增加或改善的技能,以及他们拥有的技能的叠加。

图 3:数据科学技能 KDnuggets 读者想要增加或改善(红色)和拥有(蓝色)

我们看到当前和有志成为数据科学家的顶级技能包括深度学习、Tensorflow、机器学习和 Python。

调查还询问了就业类型:

-

行业/自雇,64.4%

-

政府/非营利,7.2%

-

学术/大学,7.0%

-

学生,14.3%

-

其他/北美,7.1%

区域分布如下:

-

美国/加拿大,37.9%

-

欧洲,28.3%

-

亚洲,19.3%

-

拉丁美洲,6.1%

-

非洲/中东,4.8%

-

其他,3.5%

本次调查提供了初步分析,根据本帖的受欢迎程度,我们将进一步深入研究技能、就业类型和地区之间的关联。

注意:我们最初使用 Google 表单进行这项调查,但遭到机器人攻击,每个 Julia 和 MATLAB 的投票均超过 50,000 票。我们删除了机器人投票,同时保留了其他投票,并使用另一个平台重新启动调查,但不包括 Julia 和 MATLAB - 以避免再次攻击。最终 Julia 和 MATLAB 的结果是基于第一次调查版本中的有效投票估算的。

相关:

-

Python 引领数据科学和机器学习的 11 大平台:趋势与分析

-

Python 蚕食 R:2018 年分析、数据科学、机器学习的顶级软件:趋势与分析

-

成为摇滚明星数据科学家的 13 项顶级技能

-

数据科学家最需要的技能

-

我没有被聘为数据科学家。因此我寻找了谁在被雇佣的数据。

如何提升作为数据科学家的市场竞争力

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

更多相关主题

使用 Biopython 进行冠状病毒 COVID-19 基因组分析

原文:

www.kdnuggets.com/2020/04/coronavirus-covid-19-genome-analysis-biopython.html

评论

新兴的全球传染病 COVID-19 由新型严重急性呼吸综合症冠状病毒 2 型 (SARS-CoV-2) 引起,自 2019 年 12 月底在中国首次发现以来,对全球公共卫生和经济带来了重大影响。

冠状病毒是一个庞大的病毒家族,能够引起范围广泛的疾病。第一个已知的由冠状病毒引起的严重疾病出现在 2003 年中国的严重急性呼吸综合症 (SARS) 疫情中。第二次严重疾病的爆发发生在 2012 年沙特阿拉伯的中东呼吸综合症 (MERS) 中。现在是 COVID-19 的持续爆发。

“通过比较已知冠状病毒株的可用基因组序列数据,我们可以确定 COVID-19 是通过自然过程起源的,”Scripps 研究所免疫学和微生物学副教授、论文通讯作者 Kristian Andersen 博士说。

因此,在这篇文章中,我们将解释和分析 COVID-19 DNA 序列数据,并尝试获取关于组成其蛋白质的尽可能多的见解。之后我们将把 COVID-19 DNA 与 MERS 和 SARS 进行比较,并理解它们之间的关系。

如果你对基因组学不熟悉,我建议你在继续之前查看 用机器学习和 Python 解密 DNA 测序 以获得 DNA 数据分析的基本理解。

冠状病毒是包膜病毒家族的一员,这些病毒在动物宿主细胞的细胞质中复制。它们通过具有 5′ 端帽结构和 3′ 聚腺苷酸化链的单链正义 RNA 基因组((+)ssRNA 分类的病毒),长度约为 30 kb 来识别。(已知最大病毒)。

现在,让我们使用 Python 来处理 COVID-19 DNA 序列数据。

首先,安装 Python 包如 Biopython 和 squiggle,它们将帮助你在 Python 中处理生物序列数据。

pip install biopython

pip install Squiggle

加载基本库:

import numpy as np

import pandas as pd

pd.plotting.register_matplotlib_converters()

import matplotlib.pyplot as plt

%matplotlib inline

import seaborn as sns

import os

数据集可以从 Kaggle 下载。

我们将使用 Bio.SeqIO 来解析 DNA 序列数据(fasta)。它提供了一个简单统一的接口来输入和输出各种序列文件格式。

from Bio import SeqIOfor sequence in SeqIO.parse('/coronavirus/MN908947.fna', "fasta"):

print(sequence.seq)

print(len(sequence),'nucliotides')

所以它产生了序列及其长度。

GCAATGGATACAACTAGCTACAGAGAAGCTGCTTGTTGTCATCTCGCAAAGGCTCTCAATGACTTCAGTAACTCAGGTTCTGATGTTCTTTACCAACCACCACAAACCTCTATCACCTCAGCTGTTTTGCAGAGTGGTTTTAGAAAAATGGCATTCCCATC......AGAATGACAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAA29903 nucliotides

将互补 DNA 序列加载到可比对的文件中

from Bio.SeqRecord import SeqRecord

from Bio import SeqIO

DNAsequence = SeqIO.read('/coronavirus/MN908947.fna', "fasta")

SeqIO.read() 将提供有关序列的基本信息。

SeqRecord(seq=Seq('ATTAAAGGTTTATACCTTCCCAGGTAACAAACCAACCAACTTTCGATCTCTTGT...AAA', SingleLetterAlphabet()), id='MN908947.3', name='MN908947.3', description='MN908947.3 Severe acute respiratory syndrome coronavirus 2 isolate Wuhan-Hu-1, complete genome', dbxrefs=[])

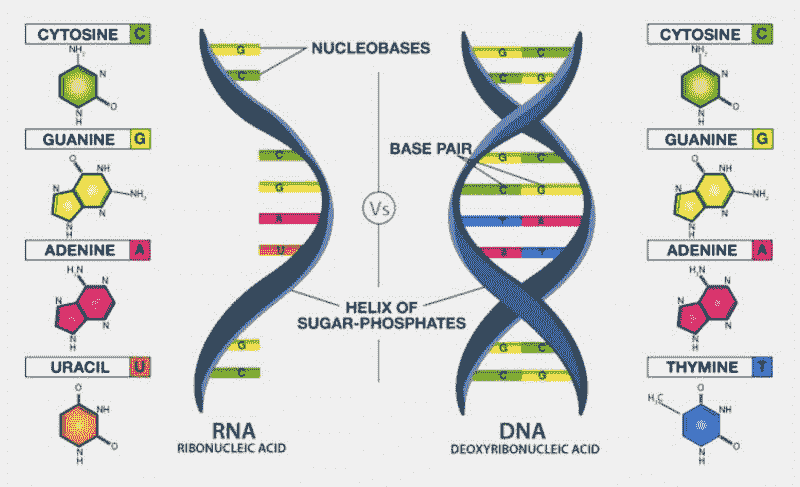

由于输入序列是 FASTA(DNA),而冠状病毒是 RNA 类型的病毒,我们需要:

-

将 DNA 转录为 RNA(ATTAAAGGTT… => AUUAAAGGUU…)

-

将 RNA 翻译为氨基酸序列(AUUAAAGGUU… => IKGLYLPR*Q…)

在当前的场景中,.fna 文件以 ATTAAAGGTT 开始,然后我们调用 transcribe(),所以 T(胸腺嘧啶)被替换为 U(尿嘧啶),因此我们得到的 RNA 序列以 AUUAAAGGUU 开始。

DNA = DNAsequence.seq#Convert DNA into mRNA Sequence

mRNA = DNA.transcribe() #Transcribe a DNA sequence into RNA.

print(mRNA)

print('Size : ',len(mRNA))

transcribe() 将 DNA 转换为 mRNA。

UAUUUUAGUGGAGCAAUGGAUACAACUAGCUACAGAGAAGCUGCUUGUUGUCAUCUCGCAAAGGCUCUCAAUGACUUCAGUAACUCAGGUUC...UAAUAGCUUCUUAGGAGAAUGACAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAAA

Size : 29903

DNA 和 mRNA 之间的区别在于 碱基 T(胸腺嘧啶)被 U(尿嘧啶)取代。

接下来,我们需要使用 translate() 方法将 mRNA 序列翻译为氨基酸序列,我们会得到类似 IKGLYLPR*Q(这是所谓的 STOP 密码子,实际上是蛋白质的分隔符)的东西。

Amino_Acid = mRNA.translate(table=1, cds=False)

print('Amino Acid', Amino_Acid)

print("Length of Protein:",len(Amino_Acid))

print("Length of Original mRNA:",len(mRNA))

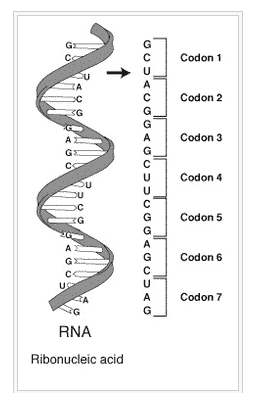

在下面的输出中,氨基酸由 * 分隔。

Amino Acid : IKGLYLPR*QTNQLSISCRSVL*TNFKICVAVTRLHA*CTHAV*LITNYCR*QDTSNSSIFCRLLTVSSVLQPIISTSRFRPGVTER*DGEPCPWFQRENTRPTQFACFTGSRRARTWLWRLRGGGLIRGTSTS*RWHLWLSRS*KRRFAST*TALCVHQTFGCSNCTSWSCYG...*SHIAIFNQCVTLGRT*KSHHIFTEATRSTIECTVNNARESCLYGRALMCKINFSSAIPM*F**LLRRMTKKKKKKKKKKLength of Protein : 9967

Length of Original mRNA : 29903

在我们的场景中,序列看起来像这样:IKGLYLPR*QTNQLSISCRSVL*TNFKICVAVTRLHA,其中:

IKGLYLPR 编码第一个蛋白质(每个字母编码一个氨基酸),QTNQLSISCRSVL 编码第二个蛋白质,以此类推。

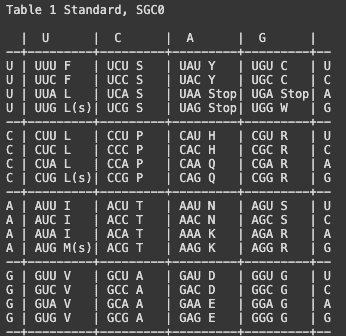

请注意,蛋白质中的序列少于 mRNA 中的序列,因为 3 个 mRNA 用于生成一个蛋白质的单体,即氨基酸,使用下面的密码子表。* 用于表示终止密码子,在这些区域蛋白质已完成其完整长度。这些密码子经常出现,导致蛋白质长度较短,通常这些蛋白质在生物学上作用不大,将在进一步分析中被排除。

好的,首先了解什么是遗传密码和 DNA 密码子?

遗传密码 是由活细胞用来翻译编码在遗传物质(DNA 或 mRNA 的核苷酸三联体或 密码子)中的信息成蛋白质的一组规则。

标准遗传密码表通常表示为 RNA 密码子表,因为当细胞中的核糖体制造蛋白质时,是 mRNA 指导蛋白质合成。mRNA 序列由基因组 DNA 的序列决定。以下是一些密码子的特征:

-

大多数密码子指定一个氨基酸。

-

三个 “终止” 密码子标志着蛋白质的结束。

-

一个 “起始” 密码子 AUG 标志着蛋白质的开始,同时编码氨基酸甲硫氨酸。

一系列密码子组成了信使 RNA(mRNA)分子的一部分。每个密码子由三个核苷酸组成,通常对应一个单独的氨基酸。这些核苷酸用字母 A、U、G 和 C 表示。这是 mRNA,使用 U(尿嘧啶)。DNA 则使用 T(胸腺嘧啶)。这个 mRNA 分子将指示一个核糖体根据这个代码合成蛋白质。来源

from Bio.Data import CodonTable

print(CodonTable.unambiguous_rna_by_name['Standard'])

RNA 密码子表

现在让我们识别所有蛋白质(氨基酸链),基本上在终止密码子(由*标记)处进行分离。然后,移除任何少于 20 个氨基酸的序列,因为这是已知的最小功能性蛋白质(如果感兴趣)。

#Identify all the Proteins (chains of amino acids)

Proteins = Amino_Acid.split('*') # * is translated stop codon

df = pd.DataFrame(Proteins)

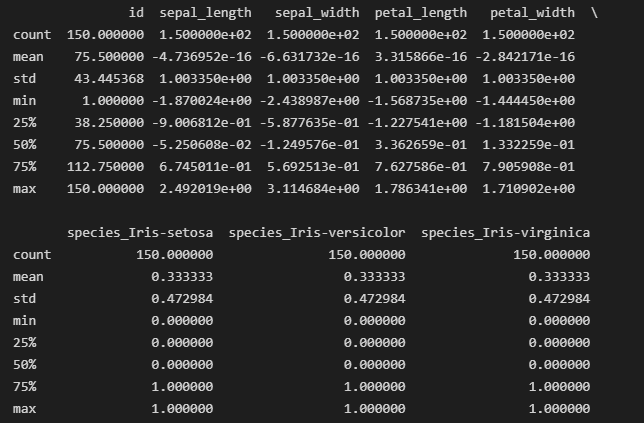

df.describe()

print('Total proteins:', len(df))def conv(item):

return len(item)def to_str(item):

return str(item)df['sequence_str'] = df[0].apply(to_str)

df['length'] = df[0].apply(conv)

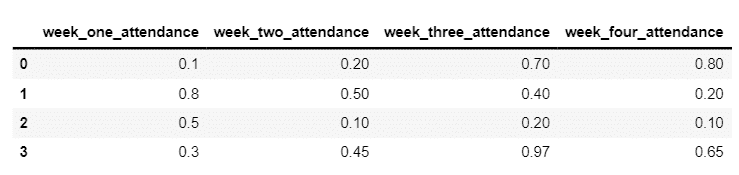

df.rename(columns={0: "sequence"}, inplace=True)

df.head()# Take only longer than 20

functional_proteins = df.loc[df['length'] >= 20]

print('Total functional proteins:', len(functional_proteins))

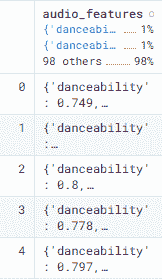

functional_proteins.describe()

使用 ProtParam 的 Biopython 中的 Protparam 模块进行蛋白质分析。

ProtParam 中的可用工具:

-

count_amino_acids:简单地计算氨基酸在蛋白质序列中重复的次数。 -

get_amino_acids_percent:与之前的方法相同,只是返回整个序列的百分比数量。 -

molecular_weight:计算蛋白质的分子量。 -

aromaticity:根据 Lobry & Gautier (1994, Nucleic Acids Res., 22, 3174-3180)计算蛋白质的芳香性值。 -

flexibility:实现了 Vihinen et al. (1994, Proteins, 19, 141-149)的柔性方法。 -

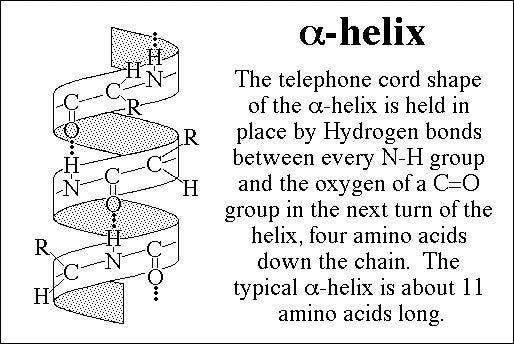

isoelectric_point:此方法使用模块IsoelectricPoint来计算蛋白质的 pI 值。 -

secondary_structure_fraction:此方法返回一组氨基酸在螺旋、转角或片段中的比例。 -

螺旋中的氨基酸:V、I、Y、F、W、L。

-

转角中的氨基酸:N、P、G、S。

-

表中的氨基酸:E、M、A、L。

列表包含 3 个值:[螺旋、转角、片段]。

from __future__ import division

poi_list = []

from Bio.SeqUtils import ProtParam

for record in Proteins[:]:

print("\n")

X = ProtParam.ProteinAnalysis(str(record))

POI = X.count_amino_acids()

poi_list.append(POI)

MW = X.molecular_weight()

MW_list.append(MW)

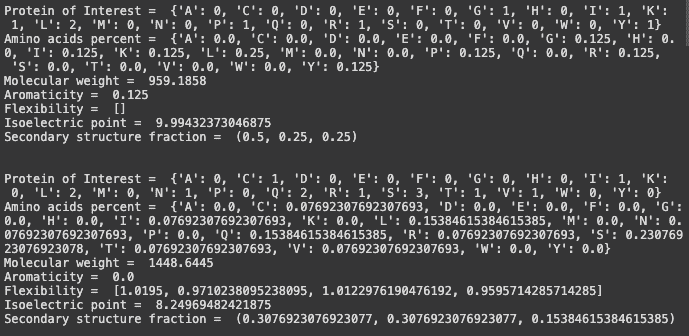

print("Protein of Interest = ", POI)

print("Amino acids percent = ",str(X.get_amino_acids_percent()))

print("Molecular weight = ", MW_list)

print("Aromaticity = ", X.aromaticity())

print("Flexibility = ", X.flexibility())

print("Isoelectric point = ", X.isoelectric_point())

print("Secondary structure fraction = ", X.secondary_structure_fraction())

绘制结果:

MoW = pd.DataFrame(data = MW_list,columns = ["Molecular Weights"] )#plot POI

poi_list = poi_list[48]

plt.figure(figsize=(10,6));

plt.bar(poi_list.keys(), list(poi_list.values()), align='center')

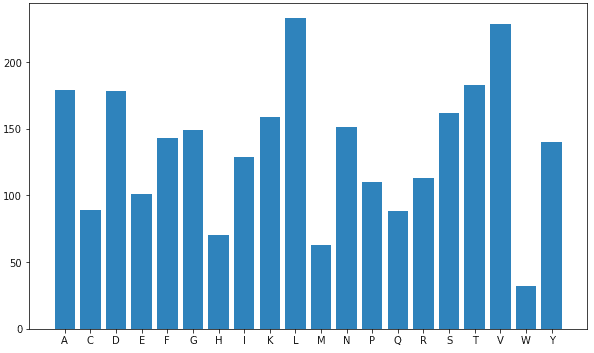

看起来这个蛋白质中的[**赖氨酸(L)**](https://www.sciencedirect.com/topics/medicine-and-dentistry/lysine)和[**缬氨酸(V)**](https://pubchem.ncbi.nlm.nih.gov/compound/Valine)数量较多,这表明有较多的α-螺旋。

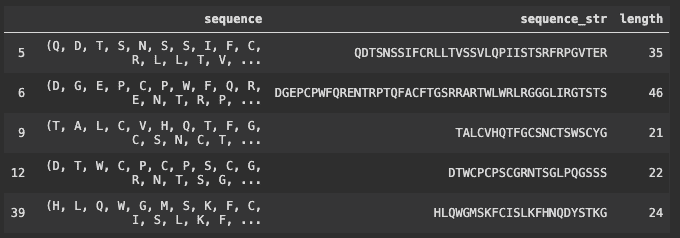

现在让我们比较 COVID-19/COV2、MERS 和 SARS 之间的相似性。

加载 SARS、MERS 和 COVID-19 的 DNA 序列文件(FASTA)。

#Comparing Human Coronavirus RNA

from Bio import pairwise2SARS = SeqIO.read("/coronavirus/sars.fasta", "fasta")MERS = SeqIO.read("/coronavirus/mers.fasta", "fasta")COV2 = SeqIO.read("/coronavirus/cov2.fasta", "fasta")

序列长度:SARS:29751,COV2:29903,MERS:30119

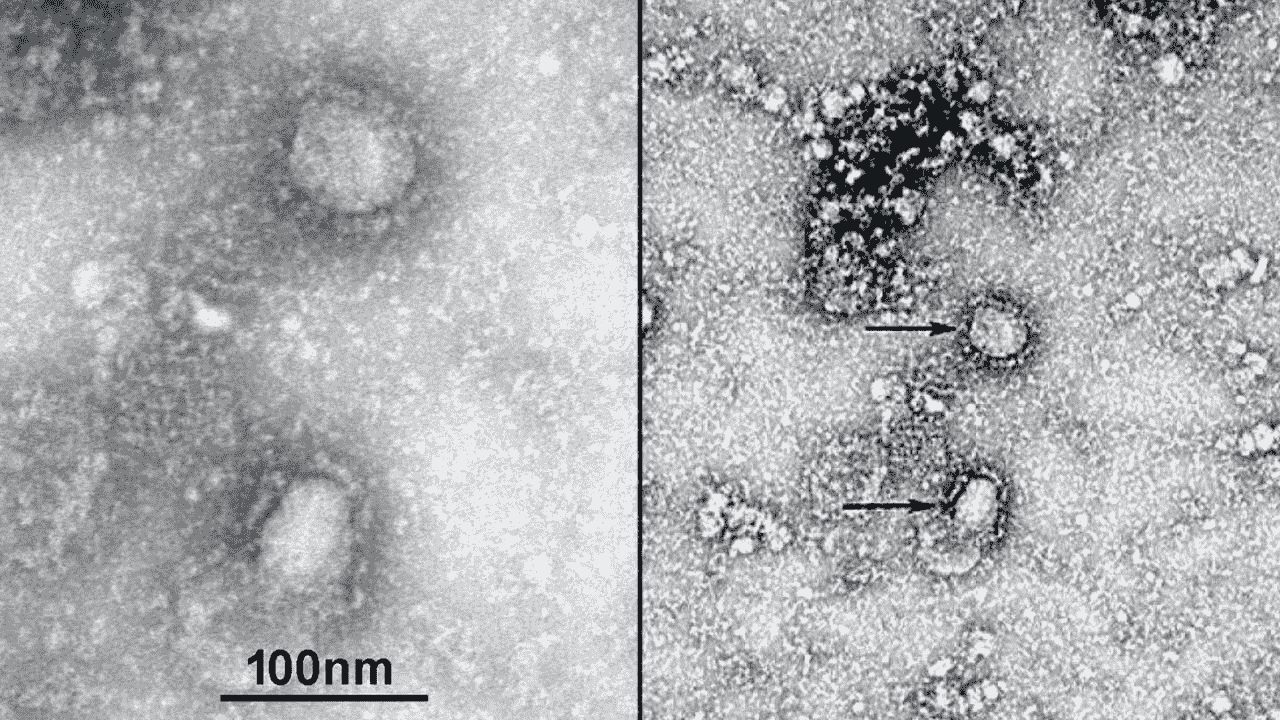

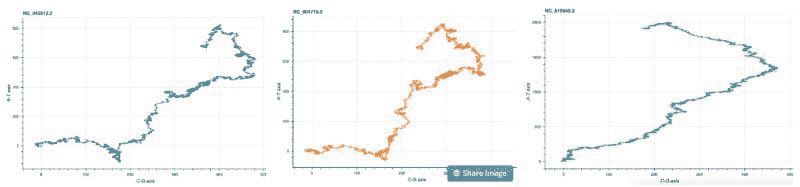

在比较相似性之前,让我们分别可视化 COV2、SARS 和 MERS 的 DNA。

#Execute on terminal

Squiggle cov2.fasta sars.fasta mers.fasta --method=gates --separate

分别对 COV2、SARS 和 MERS 的 DNA 进行可视化。

我们可以观察到 COV2 和 SARS 的 DNA 结构几乎相同,而 MERS 的 DNA 结构与前两者有所不同。

现在让我们使用序列比对技术来比较所有 DNA 序列的相似性。

序列比对是将两个或多个序列(DNA、RNA 或蛋白质序列)按特定顺序排列的过程,以识别它们之间的相似区域。

识别相似区域使我们能够推断大量信息,如物种之间的保守性状、不同物种的遗传关系、物种的进化等。

两序列比对一次只比较两个序列,并提供最佳可能的序列比对。两序列比对易于理解,并且从结果序列比对中推断出的信息非常出色。

Biopython 提供了一个特殊的模块,Bio.pairwise2,用于使用两序列比对方法识别比对序列。Biopython 应用了最佳算法来找到比对序列,其表现与其他软件相当。

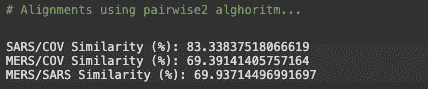

# Alignments using pairwise2 alghoritmSARS_COV = pairwise2.align.globalxx(SARS.seq, COV2.seq, one_alignment_only=True, score_only=True)print('SARS/COV Similarity (%):', SARS_COV / len(SARS.seq) * 100)MERS_COV = pairwise2.align.globalxx(MERS.seq, COV2.seq, one_alignment_only=True, score_only=True)print('MERS/COV Similarity (%):', MERS_COV / len(MERS.seq) * 100)MERS_SARS = pairwise2.align.globalxx(MERS.seq, SARS.seq, one_alignment_only=True, score_only=True)print('MERS/SARS Similarity (%):', MERS_SARS / len(SARS.seq) * 100)

比较结果

完整病毒基因组(29,903 个核苷酸)的系统发育分析显示,COVID-19 病毒与一组SARS 类冠状病毒(贝塔冠状病毒属,萨尔贝科病毒亚属)关系最为密切(83.3% 核苷酸相似性),这些病毒之前在中国的蝙蝠中被发现。

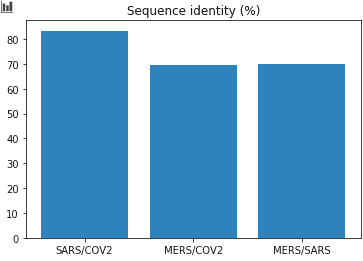

绘制结果:

# Plot the data

X = ['SARS/COV2', 'MERS/COV2', 'MERS/SARS']

Y = [SARS_COV/ len(SARS.seq) * 100, MERS_COV/ len(MERS.seq)*100, MERS_SARS/len(SARS.seq)*100]

plt.title('Sequence identity (%)')

plt.bar(X,Y)

结论

我们已经看到了如何解读和分析 COVID-19 DNA 序列数据,并尝试获取尽可能多的关于构成其蛋白质的见解。在我们的结果中,我们发现该蛋白质中的[**亮氨酸(L**](https://www.sciencedirect.com/topics/medicine-and-dentistry/lysine)**)**和[**缬氨酸(V)**](https://pubchem.ncbi.nlm.nih.gov/compound/Valine)的数量较高,这表明该蛋白质中有较多的α-螺旋。

后来我们将 COVID-19 的 DNA 与 MERS 和 SARS 进行了比较。我们发现 COVID-19 与 SARS 关系密切。

这篇文章的内容就是这些。我希望你们喜欢阅读这篇文章,请在评论区分享你的建议/观点/问题。

感谢阅读!!!

个人简介: 纳格什·辛格·乔汉 是一位数据科学爱好者,关注大数据、Python 和机器学习。

原文。经许可转载。

相关:

-

通过机器学习探索生物信息学的世界

-

人工智能如何帮助管理传染病

-

数据科学家如何训练和更新模型以应对 COVID-19 复苏

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

更多相关主题

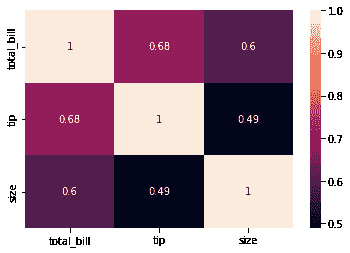

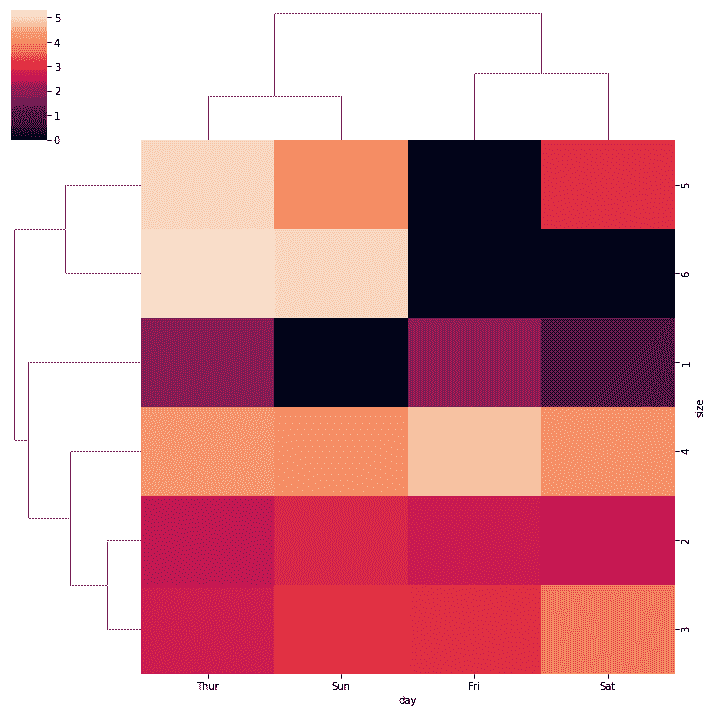

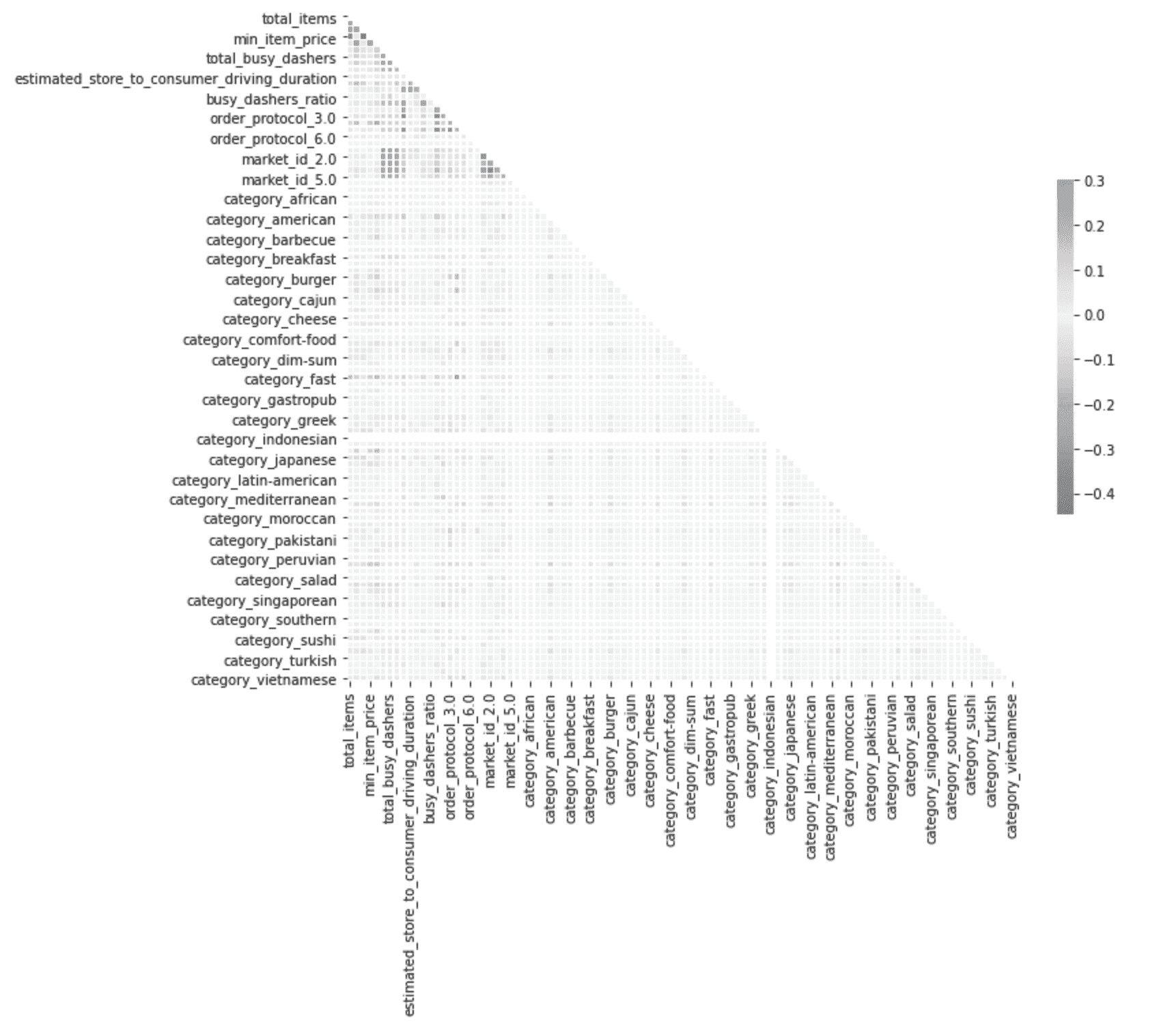

当相关性优于因果关系时

原文:

www.kdnuggets.com/2021/08/correlation-better-causation.html

评论

作者 布列塔尼·戴维斯,Narrator.ai 数据主管

我们的前三名课程推荐

1. Google 网络安全证书 - 加快进入网络安全职业的步伐。

1. Google 网络安全证书 - 加快进入网络安全职业的步伐。

2. Google 数据分析专业证书 - 提升你的数据分析水平

2. Google 数据分析专业证书 - 提升你的数据分析水平

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

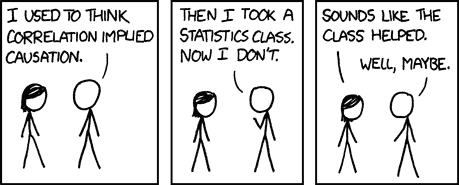

“相关性不等于因果关系”

我不喜欢这个说法。不是因为它不准确(当然它是准确的)。我不喜欢它用来解除分析师武装的方式。这一句简单的话可以让任何分析在话语一出时陷入停滞。

当利益相关者说“是的……但相关性不等于因果关系”时,那就是“你的见解不够好,无法让我采取行动”的代名词。即终结者。

这个流行的说法让决策者相信他们需要因果见解才能用数据做出决定。是的,在一个完美的世界里,我们只会依据因果见解行事。但实际上,这一要求并不合理。更多时候,当利益相关者要求“因果关系”来做决策时,往往需要过长时间,他们失去耐心,最终完全没有数据做决定。

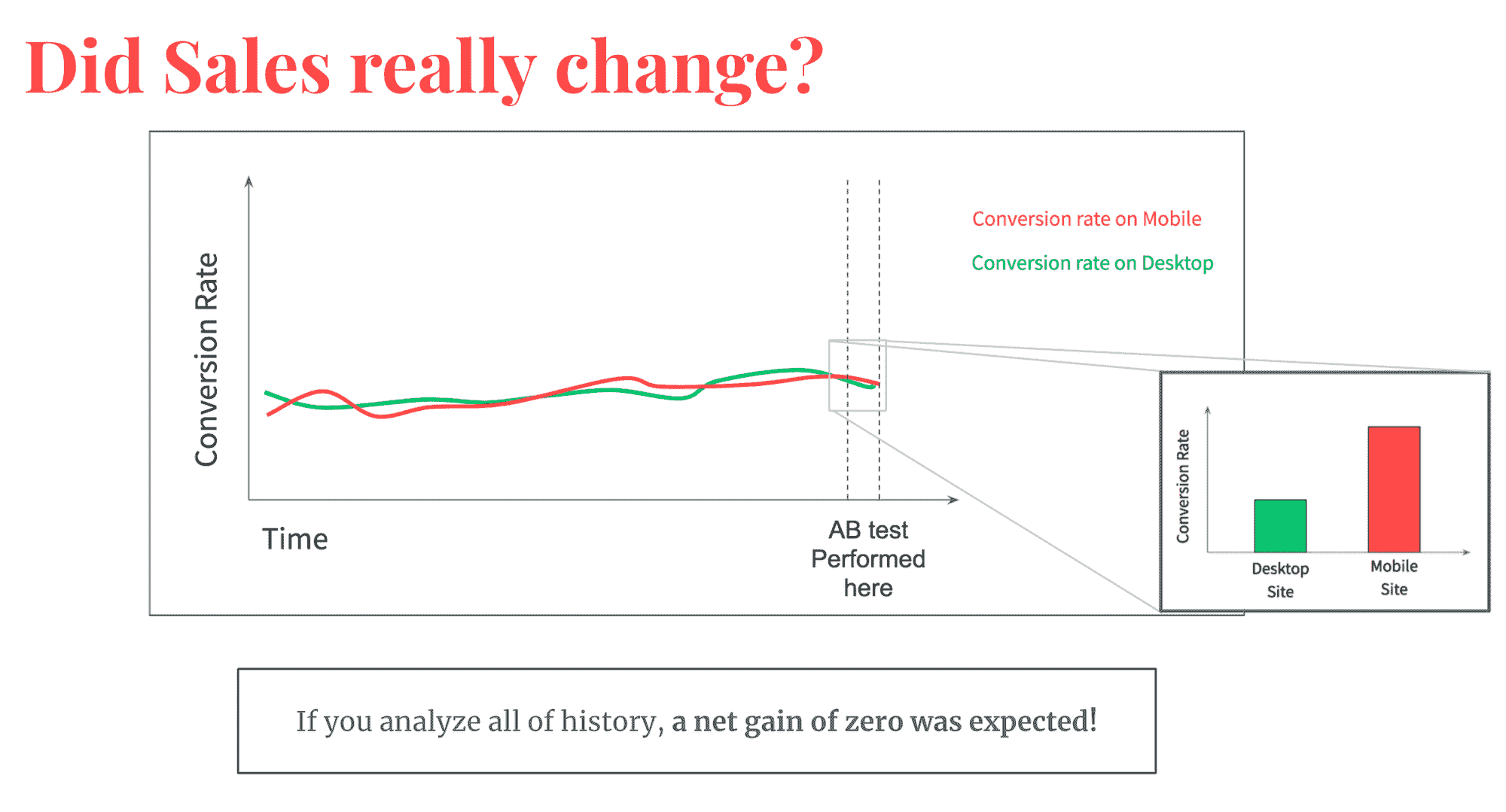

考虑一下 A/B 测试。例如,这是团队目前应对因果关系要求的最常见方式。但 A/B 测试的正确执行出奇困难——正如无数统计学家挥手示意我们承认这一事实(比如 这个 和 这个)。悲哀的现实是,A/B 测试需要大量数据、完美的工程实施和高度的统计严谨性来正确完成……所以我们最终在没有有效结果的情况下发布新功能。

这种情况时常发生!但数据团队通过做出半心半意的因果证明尝试,最后依然根据直觉做决定,这并没有帮助我们。我们需要改变这种方法。

因果关系的缺点

现实是,证明因果关系是非常困难的。这不仅需要更高水平的统计严谨性,还需要大量精心收集的数据。这意味着你必须等待很长时间才能做出任何因果声明。这对其他因果推断方法也是如此,而不仅仅是 A/B 测试。

最终,因果关系在用数据做决策时是一个不切实际的要求。所以让我们停止尝试,找到另一种方法。让我们回到使用相关性上来。

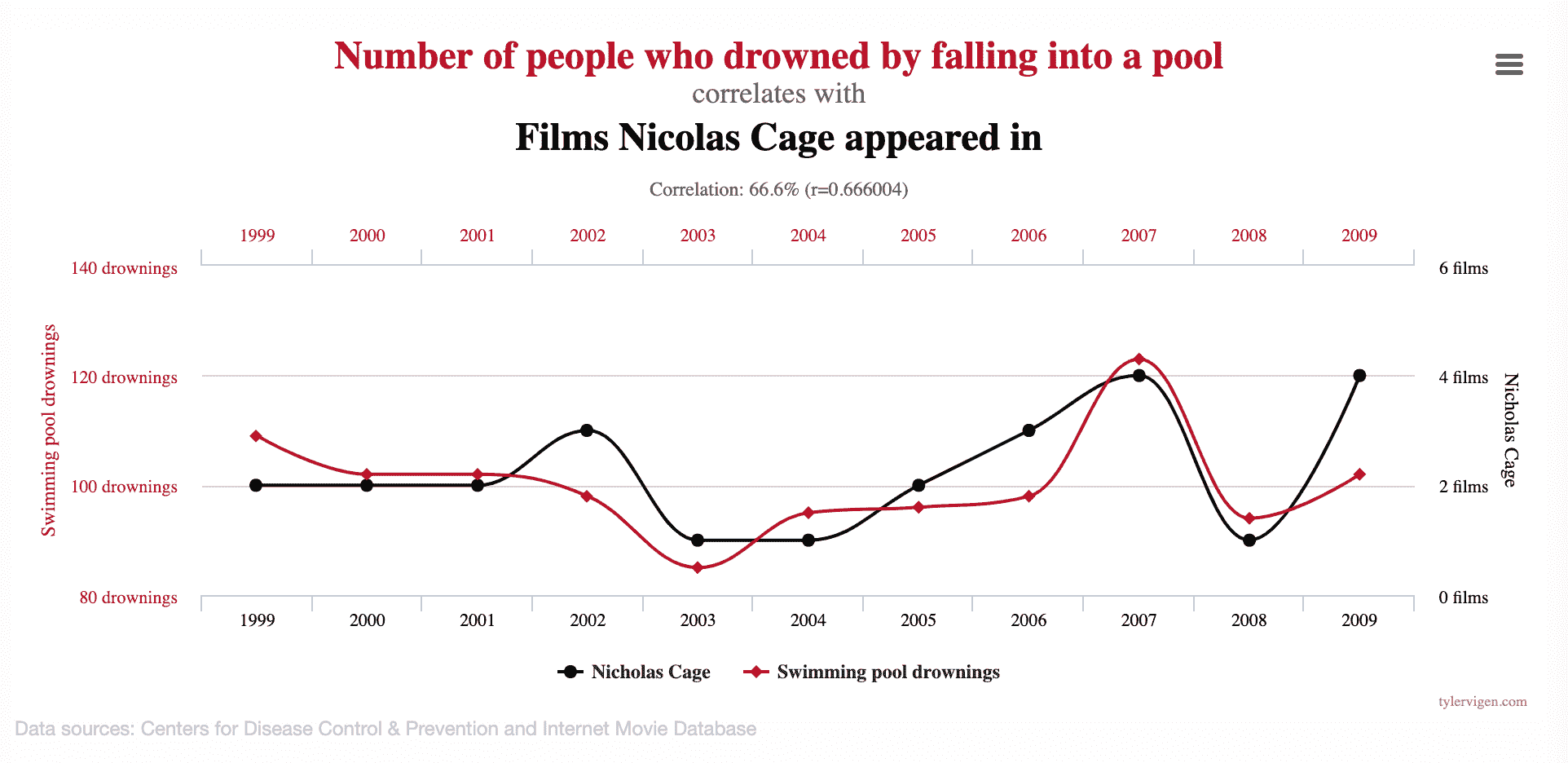

我不是建议完全自由的尝试。我们不想得到那些“技术上相关”但没有合理解释的荒谬见解,比如这些。我说的是在商业环境中使用相关性,以最大化做出“最佳”决策的机会。并以这样的方式进行,使我们可以信任这些见解提供了关于任何给定决策如何影响我们关心的事物的合理期望。毕竟,这就是数据的目标。

解决方案:一种使用相关性来指导决策的启发式方法

要从相关性中获得可信的见解,我们希望最大化我们在数据中看到的相关关系实际上是因果关系的机会。我们可以通过遵循以下四个最佳实践来做到这一点。

1. 在测试相关性时要有意图

不要关联随机的事物。搜索足够长的时间,你必定会找到一个真正“令人惊讶”的相关性,就像这样。这种关系很可能是偶然的,这样你就浪费了你的时间和其他人的时间。统计学家将这种方法称为“p-hacking”。

来源: https://www.tylervigen.com/spurious-correlations

来源: https://www.tylervigen.com/spurious-correlations

相反,要专注于已经存在关联的事物。一个很好的方法是关注客户的行动。如果你试图关联围绕客户行动的数据,你可以保证只探索那些实际以某种方式相关的行为。这听起来简单,但容易被忽视。例如,我们不应该看“我们推出课程的时间”如何影响客户报名的可能性,我们应该看“客户看到课程的时间”如何影响他们的报名可能性。因为我们从客户及其行动的角度来看所有行为,我们可以保证这些行动是相关的,增加了我们看到的相关关系也是因果关系的可能性。

2. 关联转化率,而不是总量

在大多数分析中,我们试图评估特定决策或变化将如何影响客户行为。客户行为最好用转化率来表示,而不是总量。如果我告诉你 10 人转化了,而 30 人转化了,这并不能告诉我客户的行为思维。如果我告诉你网站上 10%的人转化了,而 30%的人转化了,那么你就能更好地理解客户的转化意愿。

现在,设想一下将总电话咨询与总转化进行关联。我们可能会看到总电话咨询的增加与总转化的增加高度相关。显然是的,因为我们有更多的人在漏斗中,但我们直观地知道更多的电话咨询并不会引起更多的转化。它们只是因为受到另一因素(量)的影响而相关。通过查看转化率,我们可以更容易地挖掘出可以用来影响客户行为的见解。

你可能还想关联其他标准化指标(如平均订单价值),但如果可能的话,应避免这样做。这些指标可能具有更大的方差,这意味着你需要更多的数据来找到可靠的见解,或者你需要对指标进行降维(有效地将其转化为转化率),以减少方差,然后再进行分析。我现在不打算详细讨论这个,但我们将在未来的博客文章中涉及。在此期间,转化率始终是一个安全的选择。

3. 确保趋势在较长时间内保持一致

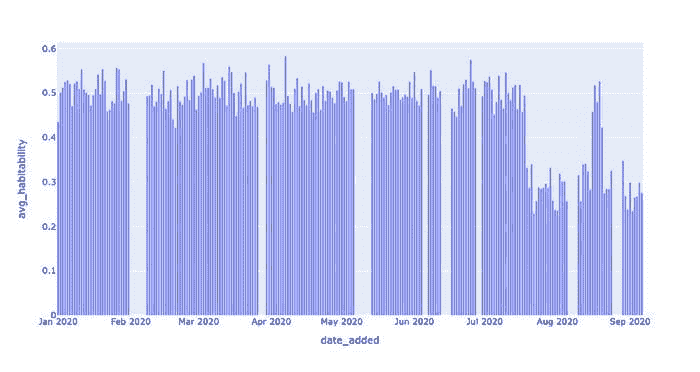

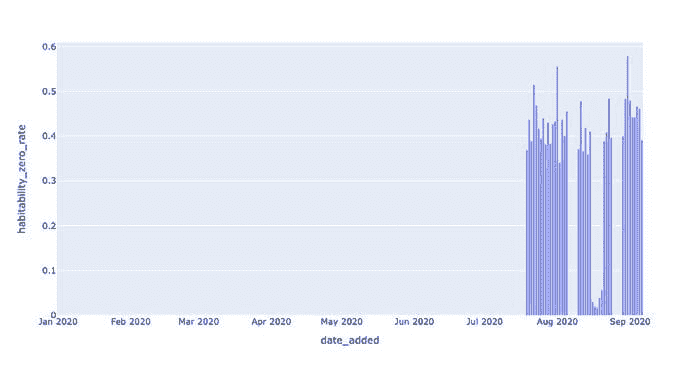

你的业务和客户总在变化,因此了解这一点很重要。我们通常会以聚合的方式查看相关性,将时间剥离出分析。然而,所有事物都在随时间变化,所以过去存在的相关性可能今天已经消失,如果不对数据进行时间上的分析,你将无法发现这一点。

由于历史行为是预测未来行为的最佳指标,我们需要查看数据随时间的变化情况,特别是我们分析的特征也在变化时。如果拥有 X 的人一直有更高的指标 Y,那么我们可以更容易地相信,当我们让更多人做 X 时,我们更有可能提高 Y。只要这种影响在时间上保持一致,我们就可以更有信心这些趋势在未来也是可靠的。

一个很好的例子是回顾你之前进行的 A/B 测试。当我们这样做时,我们发现其中一些测试在短时间内具有统计学意义,但随着时间推移并不一致。这是 A/B 测试中的 常见风险,因此许多专家建议进行常绿测试。不过这涉及很多工程复杂性,大多数团队最终没有设立。

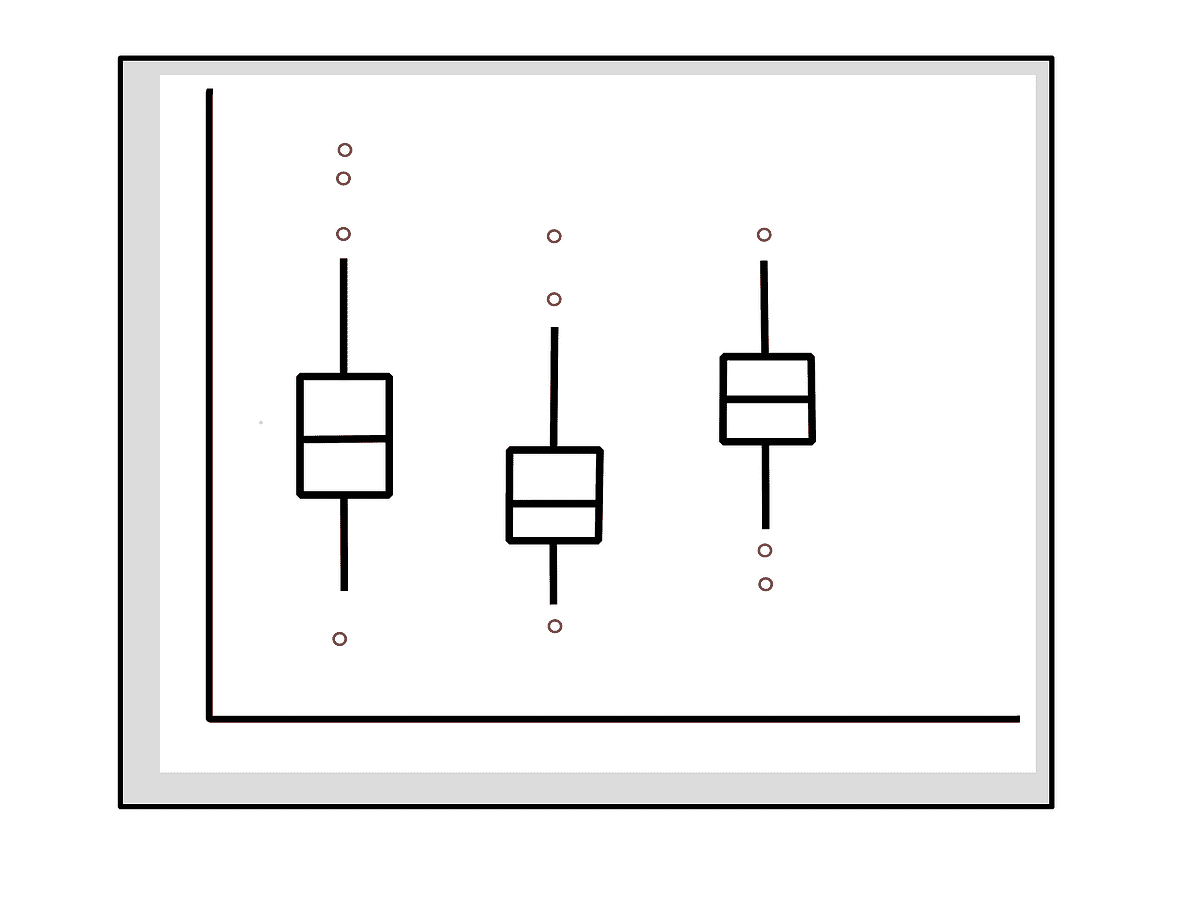

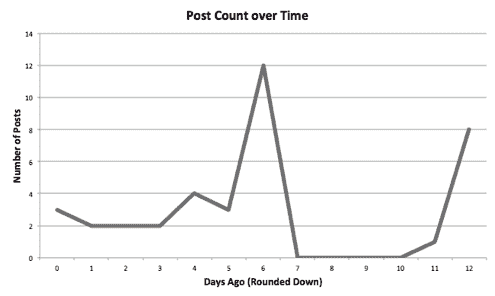

A/B 测试可以显示显著性,但对长期没有影响

A/B 测试可以显示显著性,但对长期没有影响

4. 始终监测结果

使用相关性的方法的缺陷在于我们可能会出错。虽然当我们遵循上述最佳实践时这种可能性较小,但仍然存在风险。但如果我们能迅速基于相关发现采取行动,并且密切监控结果,我们可以显著减少任何错误决策成为灾难的风险。顺便说一下,这同样适用于因果洞察。总是有风险事情不会按你预期的那样发展(像在这个警示故事中)。

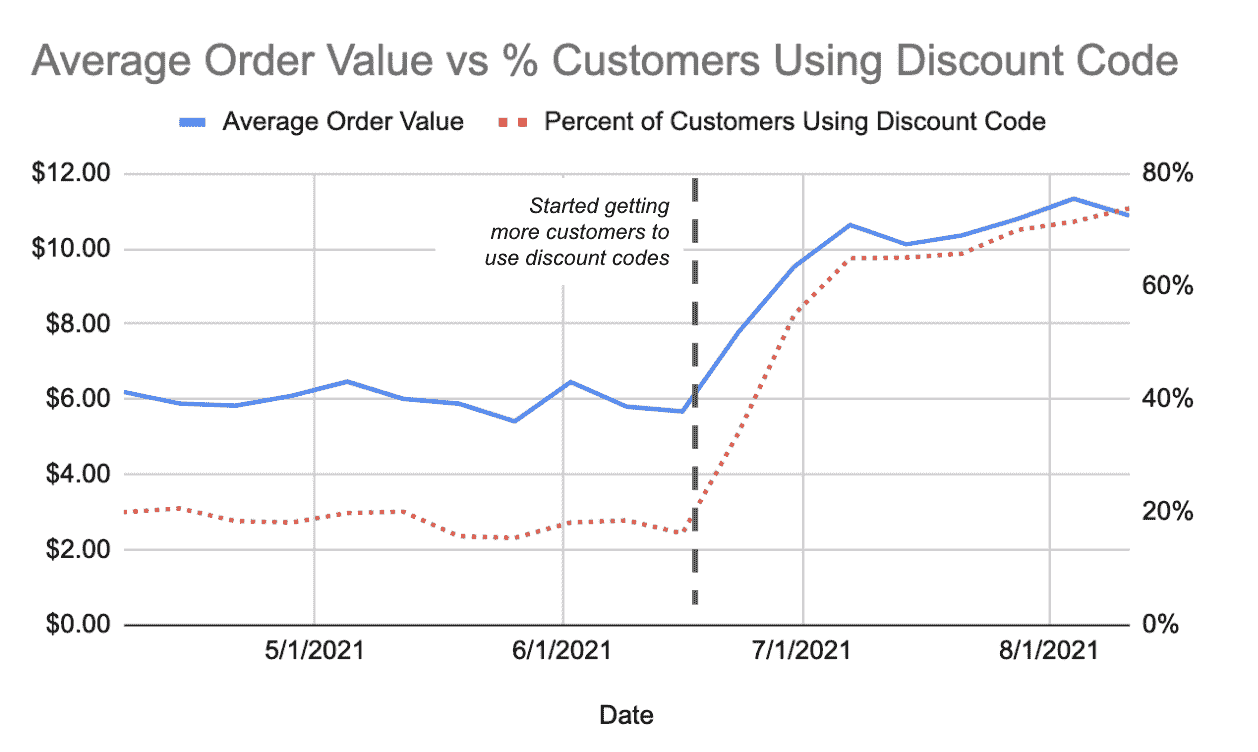

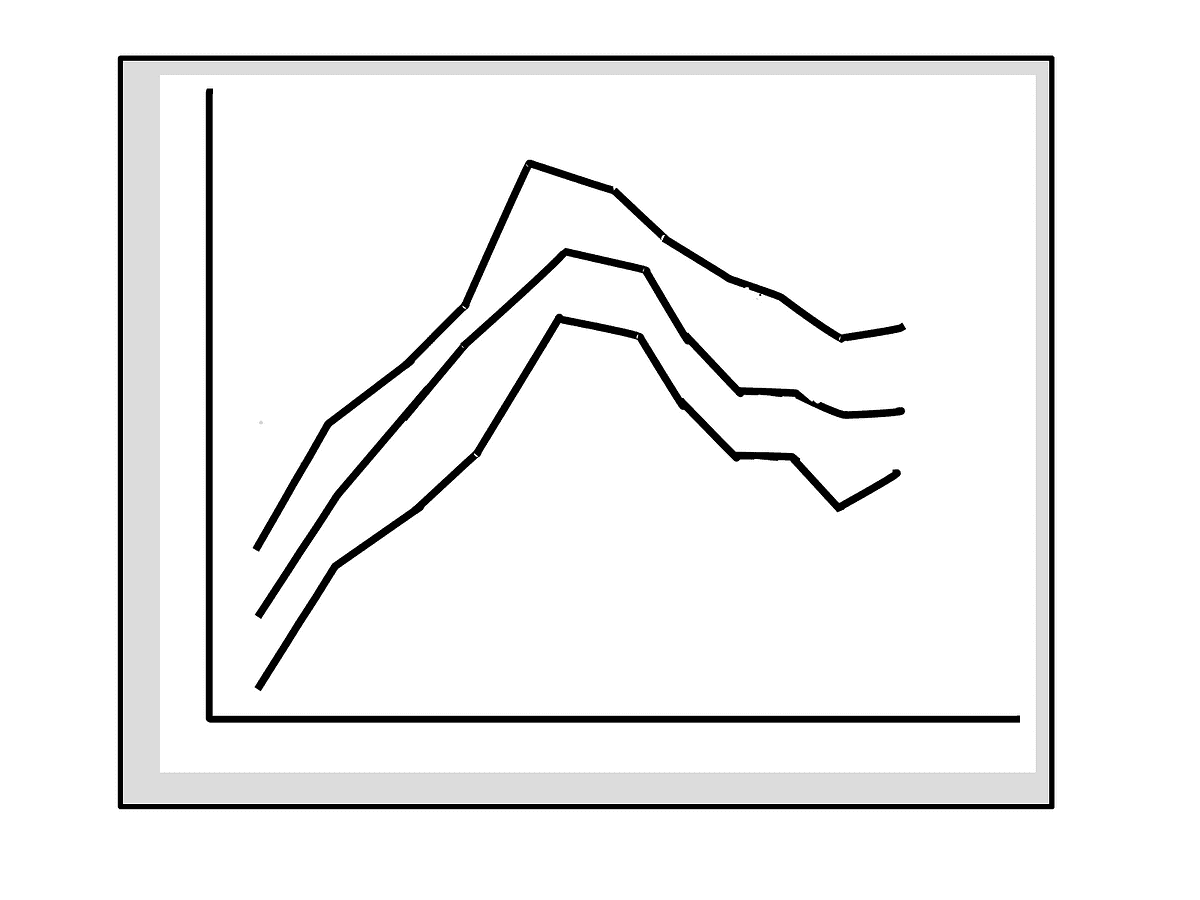

在监测结果时,跟踪你所做的改变如何影响你想要实现的结果是很重要的。假设你发现使用折扣码的顾客与平均订单价值之间存在正相关。一旦你发现了相关趋势,你会希望将更多顾客慢慢转移到表现更好的群体中。然后,我们可以使用下面的图表来监控结果。

如果我们在做出更改时能跟踪这些数据,我们可以始终判断是否做出了正确的决策,并在未做对时快速纠正。

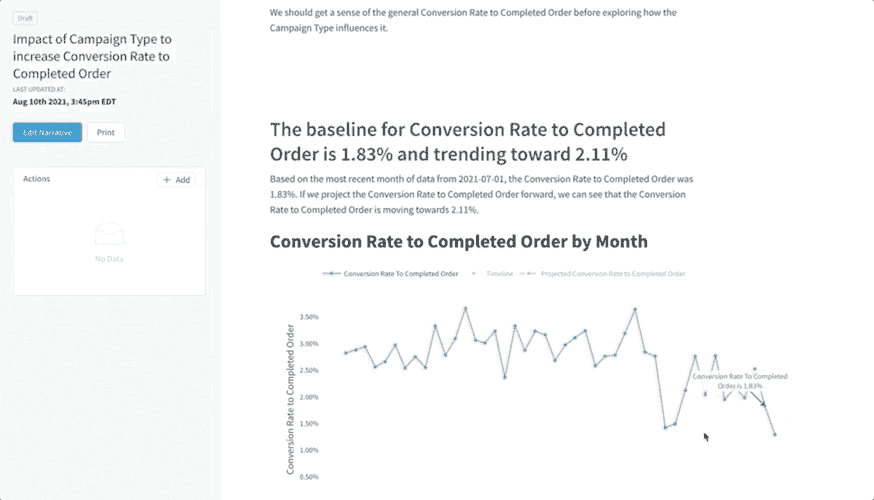

一种可重复、可靠的方法

我们可以自动化这种方法,分析结果将类似于下方的分析,使决策者能够更快地做出数据驱动的决策。

示例自动生成的分析由 叙述者 的分析按钮创建

示例自动生成的分析由 叙述者 的分析按钮创建

结论

实践中,我们需要准确的洞察力,并且必须迅速行动。等待两个月的分析以确定因果关系或等待四周的 A/B 测试完成并不实际。但是,如果我们能够迅速基于相关性做出行动,尤其是在这些相关性经过上述技术严格评估之后,我们将能做出更好的决策,更快地行动。因此,让我们淘汰“相关性不等于因果关系”这一说法,对相关性本身多一些信任。

简历: 布列塔尼·戴维斯 是 Narrator.ai 的数据主管。

原文。转载授权。

相关:

-

数据科学的 8 个基础统计概念

-

数据科学家必须了解的 10 个统计概念

-

你应该对预测变量的共线性有多担心?这要视情况而定…

更多相关话题

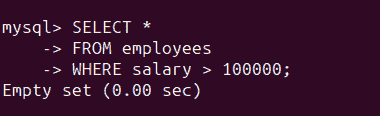

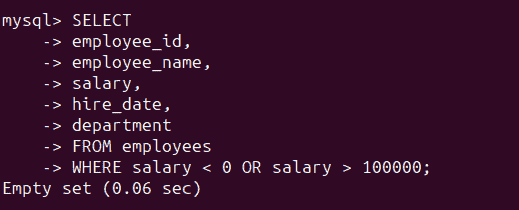

破解 SQL 面试

评论

由 Xinran Waibel, Netflix 数据工程师。

照片由 Green Chameleon 提供,来自 Unsplash。

SQL 是数据分析和数据处理最重要的编程语言之一,因此 SQL 问题总是数据科学相关职位面试的一部分,如数据分析师、数据科学家和 数据工程师。SQL 面试旨在评估候选人的技术和解决问题的能力。因此,不仅要基于样本数据编写正确的查询,还要考虑各种场景和边界情况,就像处理实际数据集一样。

我曾帮助设计和进行数据科学候选人的 SQL 面试问题,并且自己也经历了许多大型科技公司和初创公司的 SQL 面试。在这篇博客文章中,我将解释 SQL 面试问题中常见的模式,并提供如何在 SQL 查询中整洁处理它们的技巧。

提问

要顺利通过 SQL 面试,最重要的是确保你掌握了给定任务和数据样本的所有细节,通过提出尽可能多的问题来理解需求。这将节省你后来在解决问题上的时间,并使你能够妥善处理边界情况。

我注意到许多候选人往往直接进入解决方案,而没有对 SQL 问题或数据集有充分的理解。后来,当我指出他们解决方案中的问题时,他们不得不反复修改查询。最终,他们在迭代过程中浪费了很多面试时间,甚至可能没有找到正确的解决方案。

我建议把 SQL 面试当作与工作中的业务伙伴合作来对待。在提供解决方案之前,你需要收集所有关于数据请求的需求。

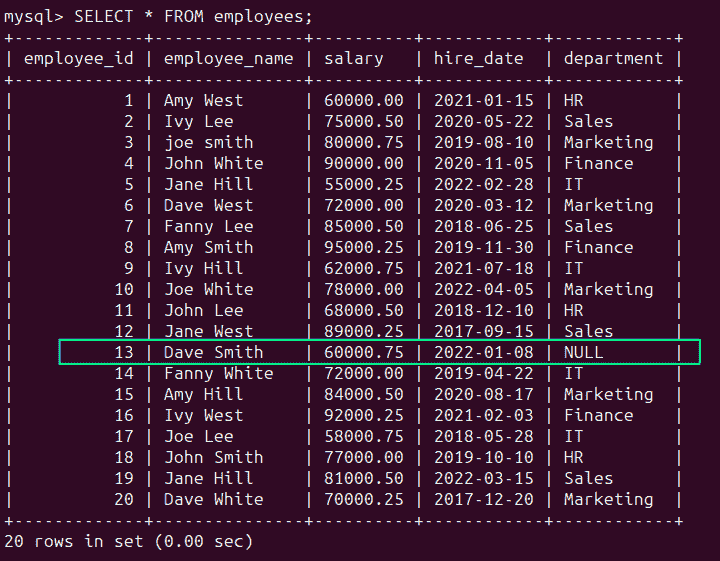

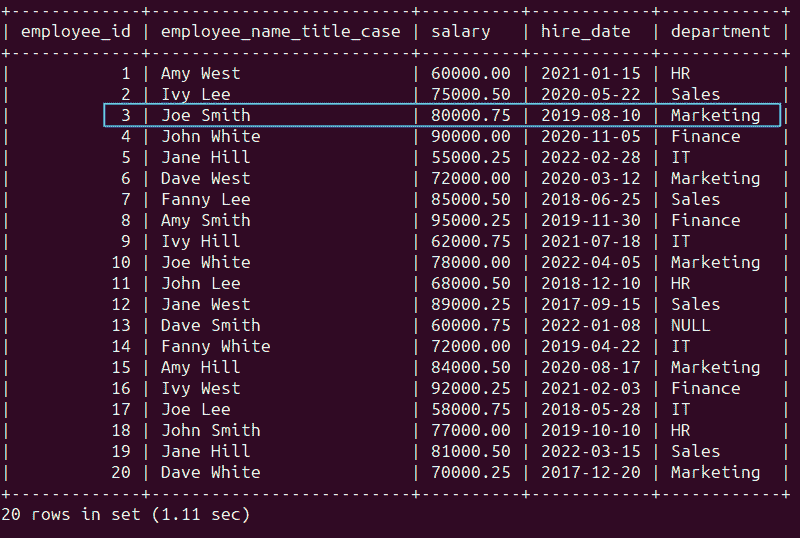

示例

找出薪资最高的前三名员工。

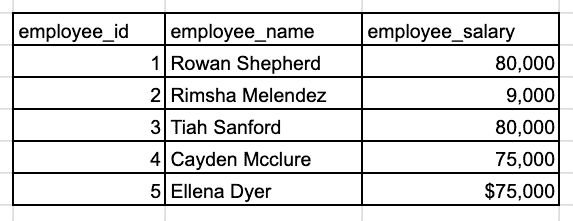

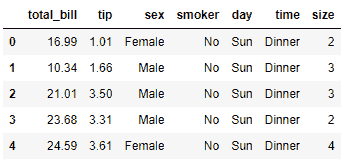

样本 employee_salary 表。

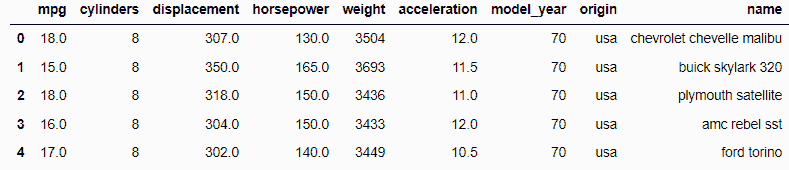

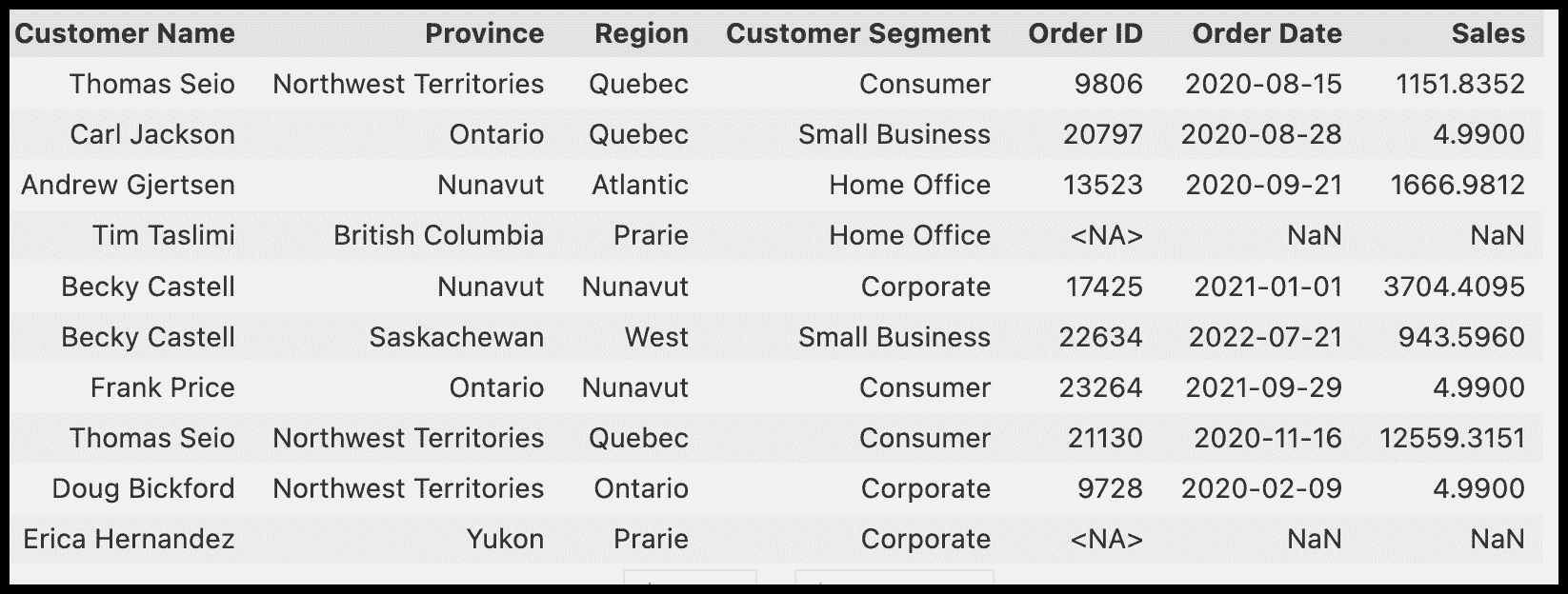

你应该询问面试官澄清“前三名”的定义。我是否需要在结果中包含确切的三名员工?如何处理平局情况?此外,仔细查看样本员工数据。薪资字段的数据类型是什么?是否需要在计算之前清理数据?

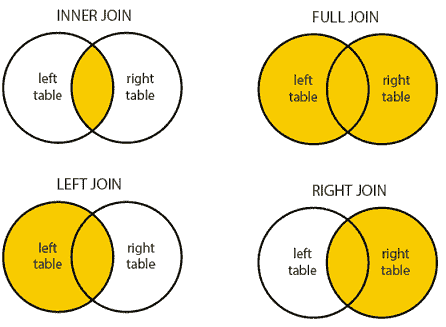

哪种 JOIN

来源:dofactory.

在 SQL 中,JOIN 经常用于将多个表的信息结合起来。有 四种不同的 JOIN 类型,但在大多数情况下,我们只使用 INNER、LEFT 和 FULL JOIN,因为 RIGHT JOIN 不太直观,并且可以很容易地用 LEFT JOIN 替代。在 SQL 面试中,你需要根据给定问题的具体要求选择合适的 JOIN。

示例

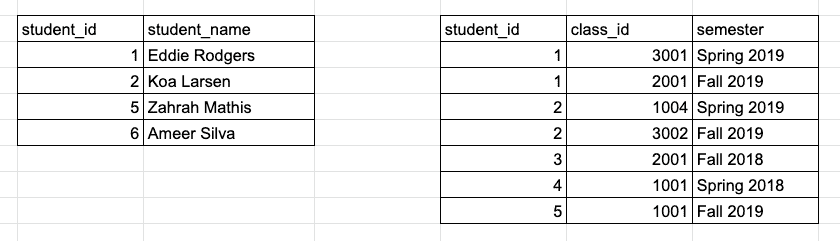

找出每个学生修过的课程总数。(提供学生 ID、姓名和修课数。)

![]() *

*

示例学生和 class_history 表。

正如你可能注意到的,并不是所有出现在 class_history 表中的学生都在 student 表中,这可能是因为这些学生已不再在校。(在事务型数据库中,这其实很典型,因为记录通常在不活跃后会被删除。)根据面试官是否希望结果中包含不活跃学生,我们需要使用 LEFT JOIN 或 INNER JOIN 来结合两个表:

WITH class_count AS (

SELECT student_id, COUNT(*) AS num_of_class

FROM class_history

GROUP BY student_id

)

SELECT

c.student_id,

s.student_name,

c.num_of_class

FROM class_count c

-- CASE 1: include only active students

JOIN student s ON c.student_id = s.student_id

-- CASE 2: include all students

-- LEFT JOIN student s ON c.student_id = s.student_id

图片由 petr sidorov 提供,来自 Unsplash。

GROUP BY

GROUP BY 是 SQL 中最重要的函数,因为它广泛用于数据汇总。如果你在 SQL 问题中看到 sum、average、minimum 或 maximum 等关键词,这通常是一个很大的提示,表明你可能需要在查询中使用 GROUP BY。一个常见的陷阱是将 WHERE 和 HAVING 混合使用在与 GROUP BY 相关的数据过滤中——我见过很多人犯这个错误。

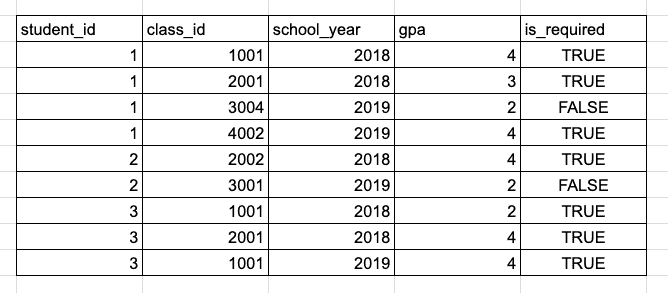

示例

计算每个学生每学年的平均必修课 GPA,并找出每学期符合院长名单要求的学生(GPA ≥ 3.5)。

![]() *

*

示例 GPA 历史表。

由于我们在 GPA 计算中仅考虑必修课程,我们需要使用 WHERE is_required = TRUE 排除选修课程。我们需要每个学生每年的平均 GPA,因此我们将按 student_id 和 school_year 列进行 GROUP BY,并计算 gpa 列的平均值。最后,我们仅保留学生平均 GPA 高于 3.5 的行,这可以通过 HAVING 实现。让我们把一切整合在一起:

SELECT

student_id,

school_year,

AVG(gpa) AS avg_gpa

FROM gpa_history

WHERE is_required = TRUE

GROUP BY student_id, school_year

HAVING AVG(gpa) >= 3.5

请记住,每当在查询中使用 GROUP BY 时,你只能选择分组列和聚合列,因为其他列的行级信息已被丢弃。

有些人可能会疑惑 WHERE 和 HAVING 之间的区别,或者为什么我们不直接写 HAVING avg_gpa >= 3.5 而不指定函数。我将在下一节中详细解释。

SQL 查询执行顺序

大多数人从 SELECT 开始自上而下地编写 SQL 查询,但你知道 SELECT 是 SQL 引擎执行的最后几个函数之一吗?下面是 SQL 查询的执行顺序:

-

FROM, JOIN

-

WHERE

-

GROUP BY

-

HAVING

-

SELECT

-

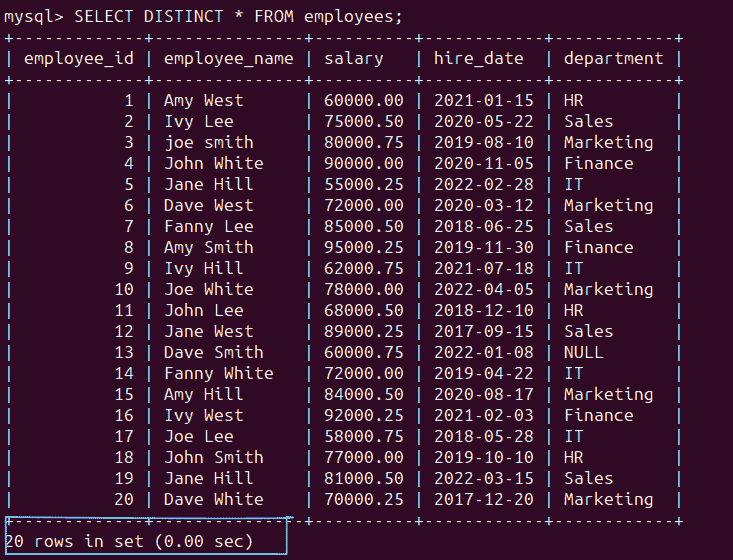

DISTINCT

-

ORDER BY

-

LIMIT, OFFSET

再次考虑前面的例子。因为我们想在计算平均 GPA 之前筛选出可选课程,我使用了 WHERE is_required = TRUE 而不是 HAVING,因为 WHERE 在 GROUP BY 和 HAVING 之前执行。我不能写 HAVING avg_gpa >= 3.5 的原因是 avg_gpa 是作为 SELECT 的一部分定义的,因此在 SELECT 之前执行的步骤中无法引用它。

我建议在编写查询时遵循执行顺序,这对于那些在编写复杂查询时遇到困难的人很有帮助。

照片由 Stefano Ghezzi 提供,来自 Unsplash。

窗口函数

窗口函数 也经常出现在 SQL 面试中。常见的窗口函数有五种:

-

RANK/DENSE_RANK/ROW_NUMBER:这些函数通过对特定列进行排序来为每行分配一个排名。如果给定了任何分区列,行会在它所属的分区组内排名。

-

LAG/LEAD:它从指定顺序和分区组中检索前一行或后一行的列值。

在 SQL 面试中,理解排名函数的区别并知道何时使用 LAG/LEAD 是非常重要的。

示例

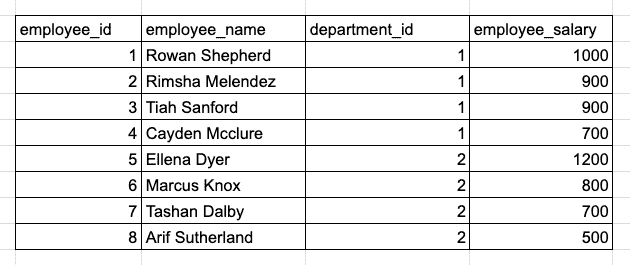

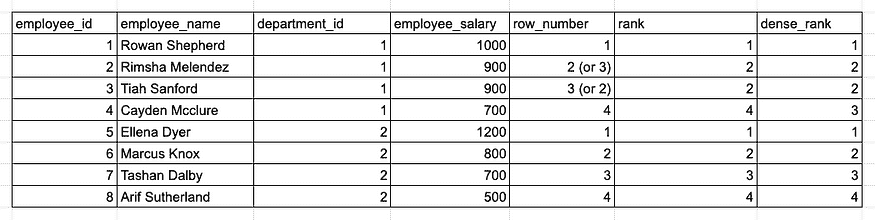

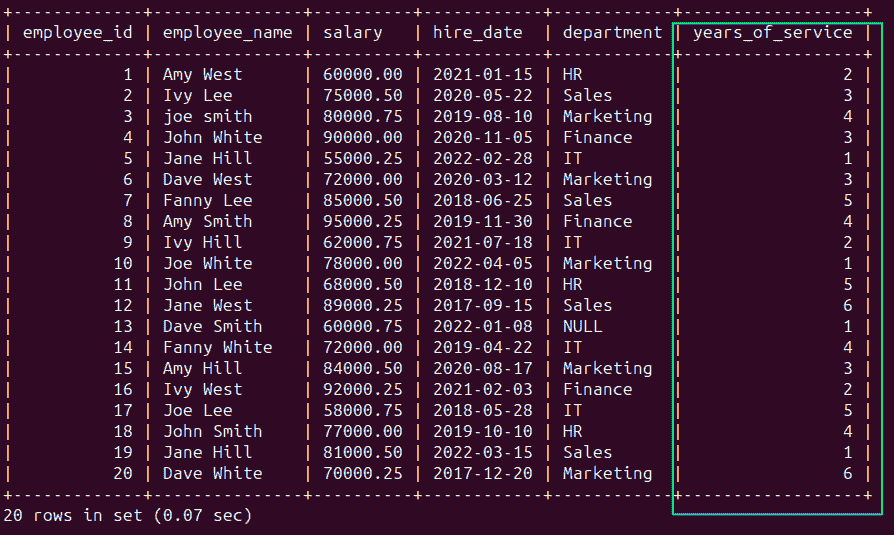

找到每个部门中薪资最高的前 3 名员工。

另一个示例 employee_salary 表。

当 SQL 问题要求“TOP N”时,我们可以使用 ORDER BY 或排名函数来回答问题。然而,在这个例子中,它要求计算“每个 Y 中的 TOP N X”,这强烈暗示我们应该使用排名函数,因为我们需要在每个分区组内对行进行排名。

以下查询准确地找到 3 名薪资最高的员工,无论是否有并列:

WITH T AS (

SELECT

*,

ROW_NUMBER() OVER (PARTITION BY department_id ORDER BY employee_salary DESC) AS rank_in_dep

FROM employee_salary)

SELECT * FROM T

WHERE rank_in_dep <= 3

-- Note: When using ROW_NUMBER, each row will have a unique rank number and ranks for tied records are assigned randomly. For exmaple, Rimsha and Tiah may be rank 2 or 3 in different query runs.

此外,根据如何处理并列情况,我们可以选择不同的排名函数。细节很重要!

ROW_NUMBER、RANK 和 DENSE_RANK 函数的结果比较。

照片由 Héctor J. Rivas 提供,来自 Unsplash。

复制

另一个常见的 SQL 面试陷阱是忽略数据重复。虽然某些列在样本数据中似乎有不同的值,但候选人需要考虑所有可能性,就像他们在处理真实世界的数据集一样。例如,在前面的employee_salary表中,可能会有员工共享相同的姓名。

避免潜在重复问题的一种简单方法是始终使用 ID 列来唯一标识不同记录。

示例

使用employee_salary表计算所有部门每个员工的总工资。

正确的解决方案是通过employee_id进行分组,并使用SUM(employee_salary)计算总工资。如果需要员工姓名,可以在最后与员工表连接以检索员工姓名信息。

错误的方法是通过employee_name进行分组。

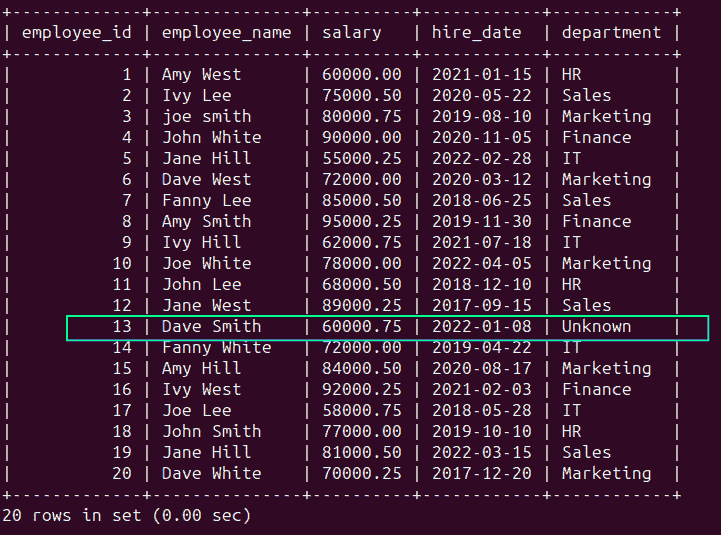

NULL

在 SQL 中,任何谓词都可能产生三种值之一:true、false 和NULL,一个保留的关键字表示未知或缺失的数据值。处理 NULL 数据集可能出乎意料地棘手。在 SQL 面试中,面试官可能会特别关注你的解决方案是否处理了 NULL 值。有时候,如果一个列不允许 NULL(例如 ID 列),这点是明显的,但对于大多数其他列,可能会存在 NULL 值。

我建议确认样本数据中的关键列是否允许 NULL,如果允许,请使用IS (NOT) NULL、IFNULL和COALESCE等函数来处理这些边界情况。

(想了解更多关于如何处理 NULL 值的信息?查看我关于 SQL 中 NULL 处理的指南。)

沟通

最后但同样重要的是——在 SQL 面试中保持沟通。

我面试过许多候选人,他们除了有问题时几乎不说话,这在他们最终提出完美解决方案的情况下是可以接受的。然而,在技术面试中,保持沟通通常是一个好主意。例如,你可以讨论你对问题和数据的理解,计划如何解决问题,为什么选择某些函数而不是其他替代方案,以及你考虑了哪些边界情况。

总结:

-

始终先提问以获取所需的详细信息。

-

仔细选择 INNER、LEFT 和 FULL JOIN。

-

使用 GROUP BY 来汇总数据,并正确使用 WHERE 和 HAVING。

-

理解三种排名函数之间的区别。

-

了解何时使用 LAG/LEAD 窗口函数。

-

如果你在创建复杂查询时遇到困难,可以尝试遵循 SQL 执行顺序。

-

考虑潜在的数据问题,如重复和 NULL 值。

-

与面试官沟通你的思路。

为了帮助你了解如何在实际的 SQL 面试中运用这些策略,我将在下面的视频中带你逐步解答一个 SQL 面试问题:

原文。经授权转载。

简介: Xinran Waibel 是一位经验丰富的数据工程师,位于旧金山湾区,目前在 Netflix 工作。她也是《Towards Data Science》、《Google Cloud》和《The Startup》在 Medium 上的技术作者。

相关:

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 领域

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 领域

更多相关话题

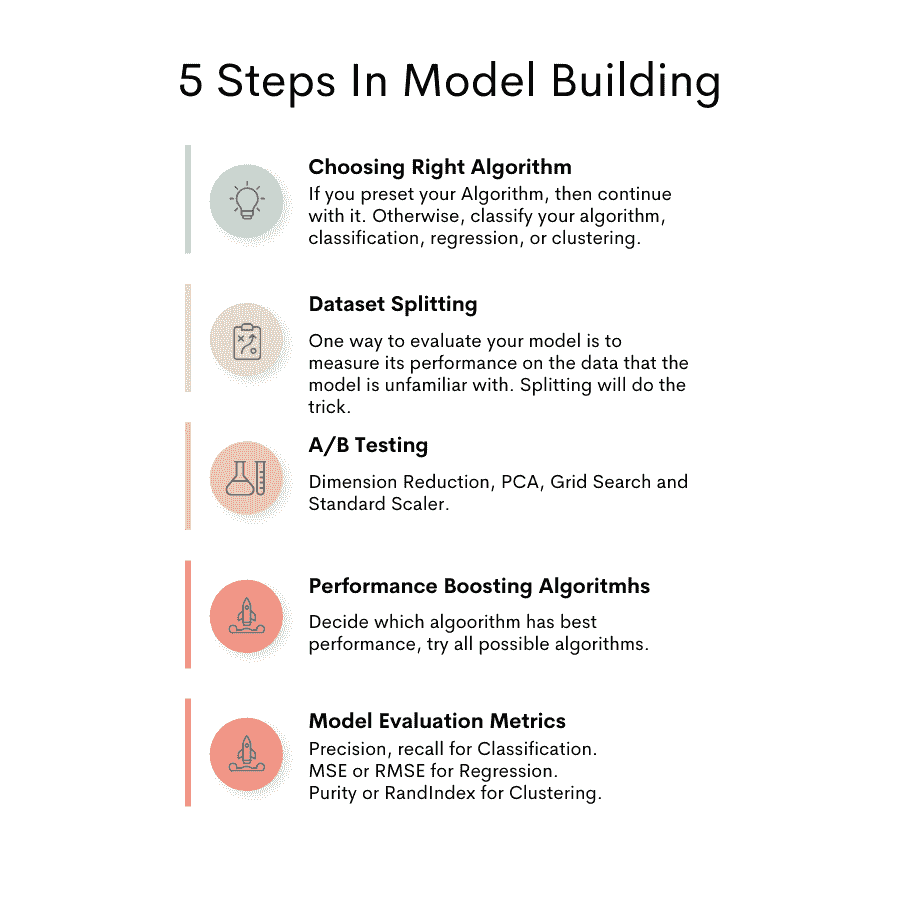

破解数据科学家面试

原文:

www.kdnuggets.com/2019/01/cracking-data-scientist-interview.html

评论

评论

作者:Ajit Samudrala,Symantec 数据科学家

在 2018 年 8 月完成了我在 Sirius 的数据科学实习后,我开始寻找全职数据科学职位。我的初始搜索非常随意,简历和 Linkedin 个人资料也只是平庸。毫无意外地,我花了一个月才开始取得进展。经过 40 天的搜索,我收到了 Google 针对数据科学家的职位的首个回应。我激动不已,因为我甚至在最疯狂的梦想中都没想到会收到 Google 的电话。虽然我未能进入现场面试,但这是一次很好的学习经历。之后,我还与 Apple、SAP、Visa、Walmart、Nielsen、Symantec、Swiss Re、AppNexus、Catalina、Cerego 和另外 40 家公司进行数据科学家/机器学习工程师的面试。最终,我加入了 Symantec 在 Mountain View 的总部。我将以问答的形式总结我的经历,并试图揭穿初学者在成为数据科学家过程中可能存在的任何误解。

我们的前三名课程推荐

1. Google 网络安全证书 - 快速进入网络安全领域。

1. Google 网络安全证书 - 快速进入网络安全领域。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你所在组织的 IT 工作

3. Google IT 支持专业证书 - 支持你所在组织的 IT 工作

1. 整个求职过程中最困难的部分是什么?

面试的反复无常。数据科学家是一个非常泛泛的术语;在我的求职过程中,我见过几种不同的类型。例如,我面试的 Google 职位主要集中在统计建模和实验设计。而与 Cerego 的面试则主要基于深度学习和自然语言处理。有些公司对软件开发和编码的重视程度与数据科学相当。我发现深度学习角色通常要求有相当的软件开发知识。

面试各种角色的问题在于,可能会变成一个无所不通但无所精通的人。我就经历过这种情况;我发现自己有时专注于统计学,一天后又转向机器学习/深度学习。虽然学习两个领域是好事,但要同时掌握这两个领域需要更长的时间。

2. 整个求职过程中最精彩的部分是什么?

我面试了从大公司到初创公司的各个领域。了解这些公司/团队如何利用数据科学解决业务问题让我大开眼界。我特别被几个用例震撼了,一个是在医疗保健领域,另一个是在机器人技术领域。在求职结束时,我感到会怀念与经理们的那些有趣的介绍。

3. 面试中主要需要哪些技能才能取得成功?

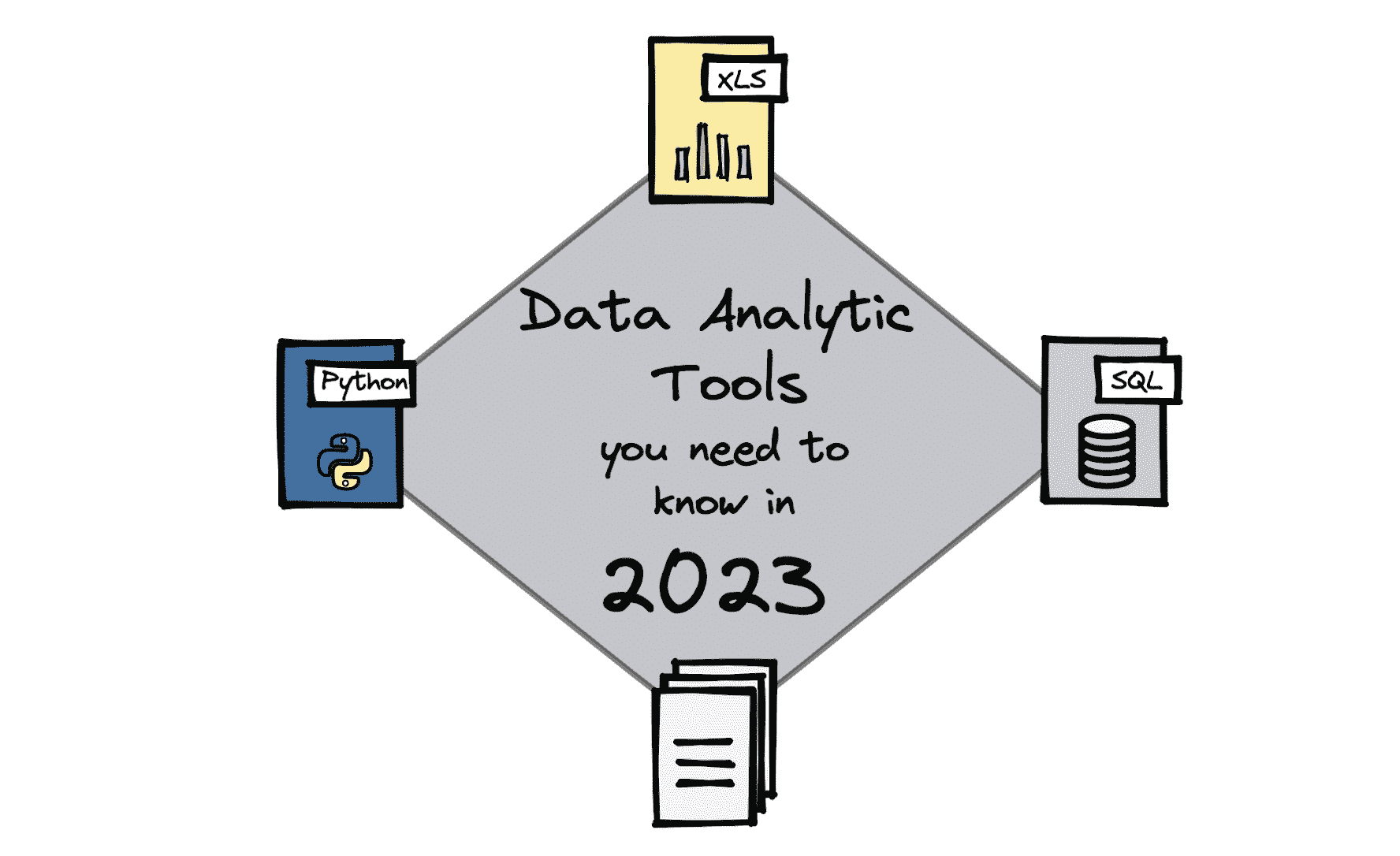

如第一个问题所建议的,每个角色所需的技能有所不同。尽管如此,我强烈推荐在 SQL、Python、机器学习/深度学习、统计学和分布式计算方面打下坚实的基础。掌握计算机科学基础知识,如算法和数据结构,尤其对面试技术公司时非常有帮助。一旦基础知识掌握到位,你可以深入研究你的兴趣领域。

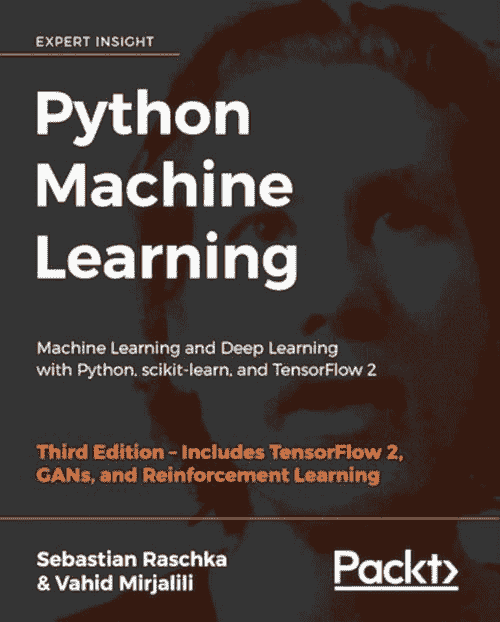

4. 可能有成千上万的在线数据科学资源/导师/播客可供选择。我应该在哪里学习?

不要被数据科学/机器学习周围的各种喧嚣所迷惑。有许多机构、个人和书籍声称可以在 100 天或 3 个月内教授机器学习。虽然我不能对这些声明的真实性发表评论,但我强烈建议远离这些,并坚持使用 Coursera、MIT OpenCourseWare、斯坦福在线课程、NPTEL 等受欢迎且可靠的资源。此外,你无需花费任何费用就能从这些来源学习。

5. 除了学习概念,我应该把大部分时间花在什么地方?

花时间在 stats.stackexchange 和 Kaggle 上。利用 StackExchange 提升理论知识,用 Kaggle 进行应用实践。许多统计学/机器学习的概念并不十分直观,所以可以大胆搜索最基本的问题,如“随机森林是否总是比决策树表现更好?”,我敢打赌,有一些好心人可能在 StackExchange 上详细回答了许多类似的问题。

话虽如此,我发现许多数据科学面试已从测试理论知识转向通过家庭作业和案例研究来测试应用能力。Kaggle 非常有用,因为有许多精美的内核详细阐述了思考过程和解决方案的方法。

6. 如何在家庭作业和案例研究中表现出色?

大多数面试官更关注你的方法而非家庭作业的结果。所以,创造性和失败是可以接受的。

准备一个包含所有可重用函数的机器学习模板。在 Scikit-Learn 和 Matplotlib 上构建一个 API,以便你可以快速进行探索性数据分析(EDA)和构建基本模型。一旦完成了基本模型,你可以通过堆叠不同的模型、使用一个模型的预测来改善另一个模型,或其他任何可能引起面试官兴趣的疯狂尝试来开始发挥创意。如果成功了,那很好。如果失败了,你仍然会因为尝试不同的方法而获得好评。

关于案例研究,我认为最佳来源是 Google、Facebook、Twitter、eBay、Zillow 等公司的官方数据科学博客。通过阅读这些博客,你可以了解这些公司如何用机器学习/统计建模解决业务问题以及他们在过程中遇到的挑战。

7. 如何从人群中脱颖而出?

你可以用几种不同的方法来实现这一点。在我看来,培养阅读、消化和实施研究论文的能力会让你在众人中脱颖而出。尽管对初学者来说这是一个艰巨的任务,但从实现简单的组件的论文开始是一个不错的起点。起初,我曾经很难阅读研究论文,但几个月后,我至少能够从中实现基本的组件。

在流行的数据科学博客上写文章也可以帮助你获得一些额外的分数。选择一个未被广泛探索的话题或对一个概念给出独特的观点,以从你的工作中获得最大收益。

8. 领域专长的重要性如何?

在某些领域,面试官可能会非常重视领域专长。然而,对于一个入门级的数据科学家来说,我认为这不应该成为问题,你不必犹豫去申请任何领域的数据科学家职位。

9. 我是否应该申请技能要求过高的职位?

是的,你应该这样做。我曾收到一些职位的电话,这些职位的 JD 包含了一些不常见的术语,如 VAEs、GANs、Transformers、NLU、RF 学习、C++等。尽管破解这些可能很困难,但你仍然可以获得很好的学习经验。

10. 我是否应该做一些认证或投资时间学习一些工具?

虽然获得认证是好的,但我认为这在数据科学中不会给你的申请增加实质性的价值。关于工具,了解流行的部署工具是有益的。除此之外,花时间掌握开源框架,如 Hive、Kafka、Spark 等,是一种好方法。

11. 我的未来计划是什么?

我将继续从我的工作和才华横溢的同事那里学习。此外,我计划学习 RF 学习和 Java。如果有好的课程或书籍,请告诉我。我还会尽量在 Medium 上活跃,发布我的学习成果。

12. 随机提示

-

在面试中使用数据科学家的语言。

-

在家庭作业中编写干净且易于理解的代码。

-

练习 LeetCode 上的简单和中级问题,以备战白板面试。

-

如果失败不要灰心;在获得我的第一个工作机会之前,我经历了 43 次面试失败。

-

准备好面对面试的不确定性。许多公司仍未形成数据科学面试的标准流程。我参加的其中一个面试完全基于贝叶斯推断。

-

不要被互联网上阅读到的疯狂内容吓倒。大多数公司并不需要或使用这些内容。首先要掌握基础知识。

如果有我遗漏的常见问题,请在帖子下方评论。我会根据您的反馈不断更新帖子。您可以在 LinkedIn 上这里与我联系。

附言:本文针对初学者或首次转行进入数据科学领域的人。

个人简介:Ajit Samudrala 是 Symantec 的数据科学家。

原文。转载已获许可。

相关:

-

在接受那份华丽的数据科学工作之前再三思考

-

为什么你不应该成为数据科学通才

-

Netflix 数据科学面试问题: 如何通过 AI 面试

更多相关内容

机器学习中的博弈论速成课程:经典与新观念

原文:

www.kdnuggets.com/2020/03/crash-course-game-theory-machine-learning.html

评论

博弈论是数学中最迷人的领域之一,它影响了经济学、社会科学、生物学以及计算机科学等多个领域。关于博弈论的思考方式有很多种,但我发现一种虽然过于简化但非常有用的方式是:

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

博弈论是带有激励的概率

游戏在人工智能(AI)的发展中扮演了关键角色。首先,游戏环境正在成为强化学习或模仿学习等领域的热门训练机制。理论上,任何多智能体 AI 系统都可以接受其参与者之间的游戏化互动。制定游戏原理的数学分支称为博弈论。在人工智能(AI)和深度学习系统的背景下,博弈论对实现多智能体环境中的关键能力至关重要,在这些环境中,不同的 AI 程序需要互动或竞争以实现目标。

博弈论的历史与计算机科学的历史息息相关。目前博弈论的许多研究可以追溯到计算机科学先驱如艾伦·图灵或约翰·冯·诺依曼的工作。由电影《美丽心灵》普及的著名纳什均衡是现代系统中许多人工智能交互的基石。然而,使用博弈论原理来建模人工智能宇宙时,往往超出了纳什均衡的范围。理解使用博弈论原理设计人工智能系统的影响,一个好的起点是理解我们在社会或经济交互中通常遇到的不同类型的游戏。

我们每天参与数百次基于游戏动态的互动。然而,这些游戏化环境的架构完全不同,参与者的激励和目标也各异。如何将这些原则应用于 AI 代理建模?这是一个推动整个 AI 研究领域(如多智能体强化学习)的挑战。

尽管游戏显然是博弈论的最直观体现,但这远不是这些概念唯一应用的领域。从这个角度来看,还有许多其他领域可以受到博弈论与 AI 结合的影响。事实上,大多数涉及多个“参与者”合作或竞争以完成任务的场景都可以通过 AI 技术进行游戏化和改进。尽管之前的陈述是一种概括,但我希望它传达了博弈论与 AI 是一种思考和建模软件系统的方法,而不是具体的技术。

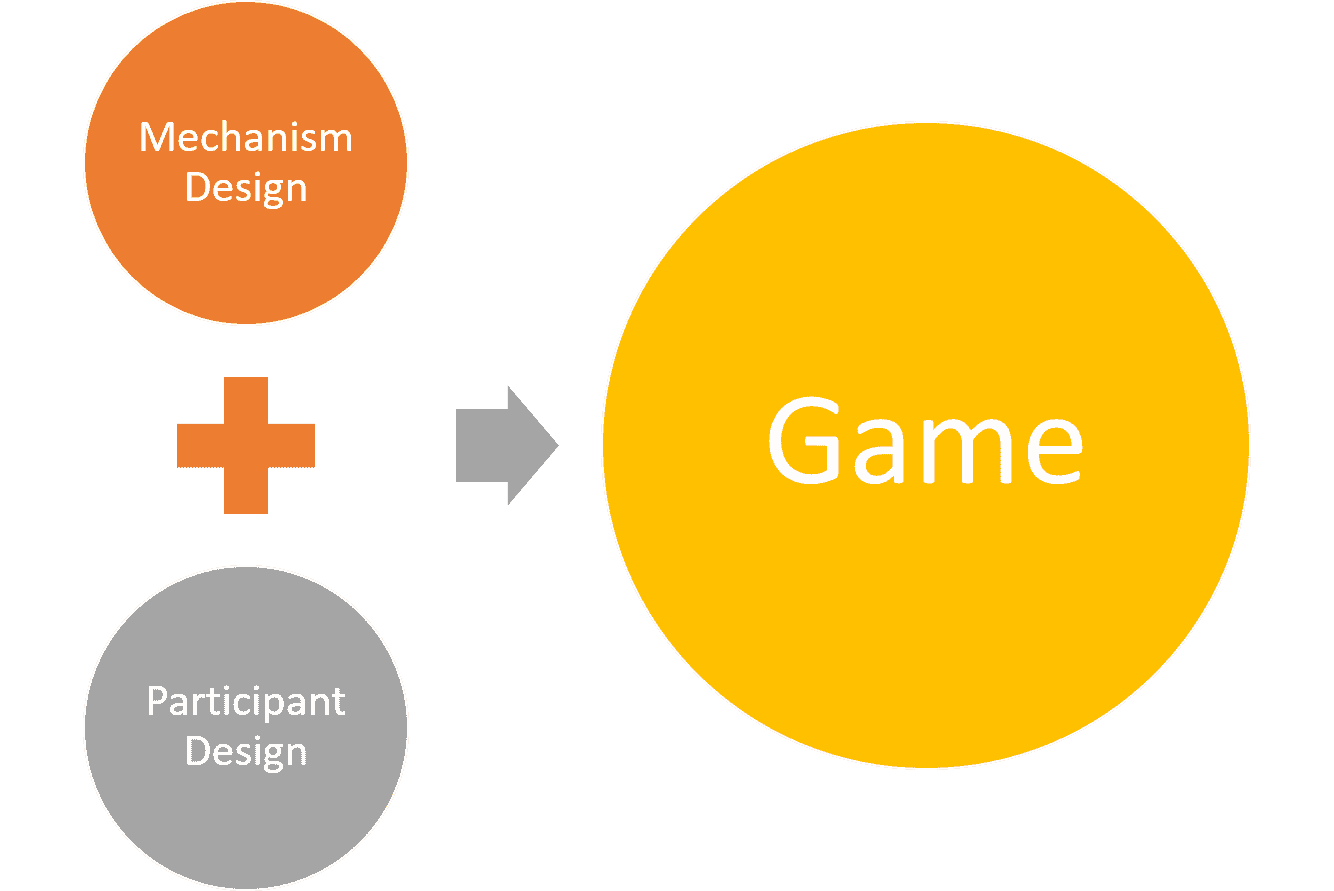

为了使一个 AI 场景成为使用博弈论的良好候选者,它应该涉及多个参与者。例如,像 Salesforce Einstein 这样的销售预测优化 AI 系统并不是应用博弈论原则的理想候选者。然而,在多参与者环境中,博弈论可以极为有效。设计 AI 系统中的游戏动态可以总结为两个基本步骤:

-

参与者设计: 博弈论可以用来优化参与者的决策,以获得最大效用。

-

机制设计: 反向博弈论专注于为一组智能参与者设计游戏。拍卖是机制设计的经典例子。

数据科学家应该了解的 5 种游戏类型

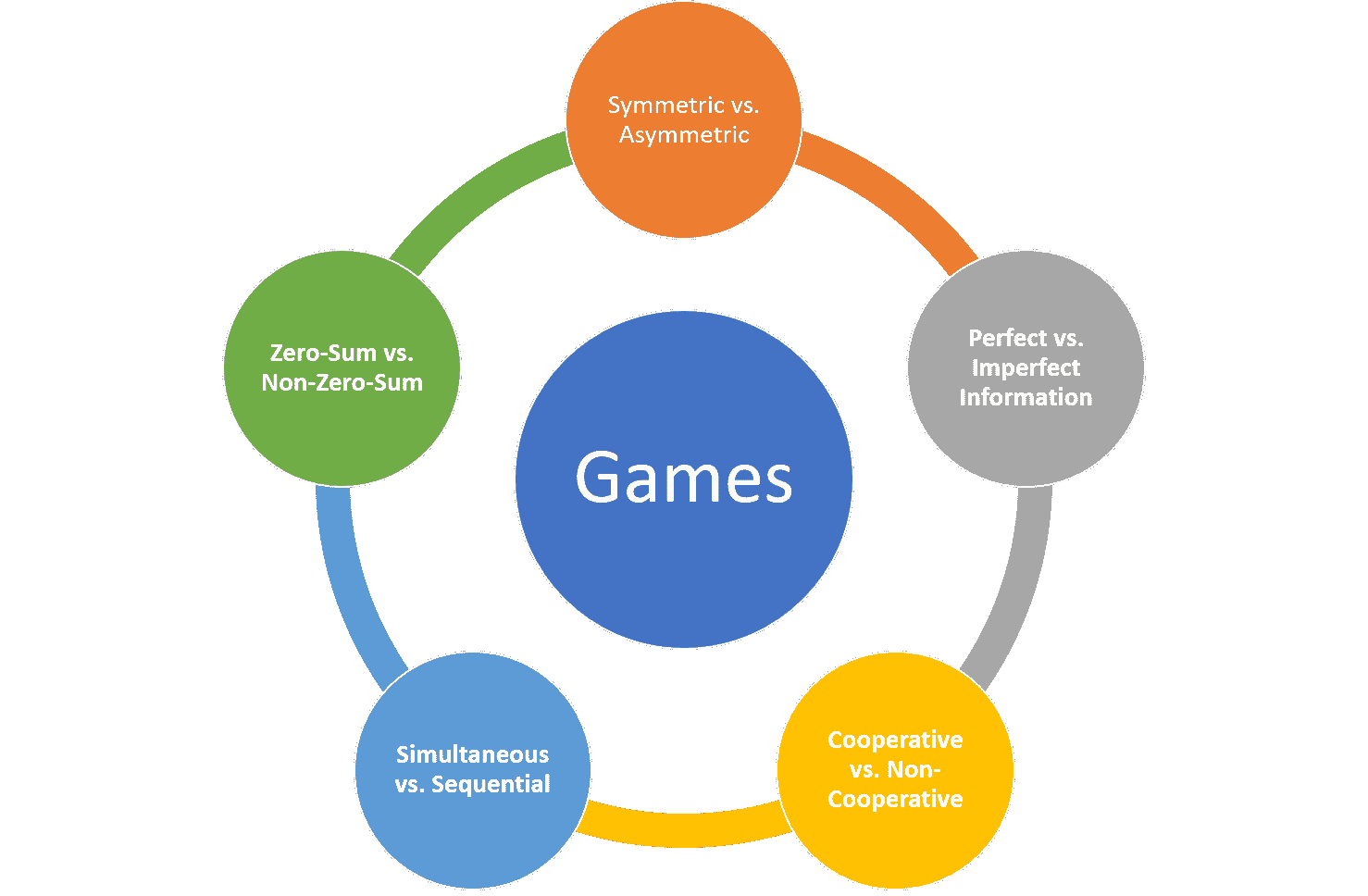

假设我们正在建模一个涉及多个代理的 AI 系统,这些代理将合作和竞争以实现特定目标。这是博弈论的经典例子。自 20 世纪 40 年代以来,博弈论一直专注于建模我们现在在多智能体 AI 系统中每天看到的最常见的互动模式。理解环境中的不同游戏动态是设计高效游戏化 AI 系统的关键要素。在高层次上,我喜欢使用五个要素标准来理解 AI 环境中的游戏动态:

对称与不对称。

最简单的游戏分类之一是基于其对称性。对称博弈描述了一种环境,在这种环境中每个玩家有相同的目标,结果仅取决于所涉及的策略。棋类游戏是对称博弈的经典例子。我们在现实世界中遇到的许多情境缺乏数学对称的优雅,因为参与者通常有不同甚至冲突的目标。商业谈判是一个不对称博弈的例子,在这种博弈中,每一方有不同的目标,并从不同的角度评估结果(例如:赢得合同与最小化投资)。

完美信息与不完美信息

另一种重要的游戏分类是基于可用信息的类型。完美信息博弈指的是每个玩家都可以看到其他玩家的动作的环境。棋类游戏再次是完美信息博弈的一个例子。许多现代互动基于这样一种环境,即每个玩家的动作对其他玩家是隐藏的,博弈理论将这些情境分类为不完美信息博弈。从扑克牌游戏到自动驾驶汽车场景,不完美信息博弈无处不在。

合作博弈与非合作博弈

合作博弈环境是指不同的参与者可以建立联盟以最大化最终结果的环境。合同谈判通常被建模为合作博弈。不合作情境描述的是禁止玩家形成联盟的环境。战争是非合作博弈的终极例子。

同时博弈与顺序博弈

顺序博弈发生在一个玩家对其他玩家早期行动有信息的环境中。棋盘游戏大多本质上是顺序的。同时博弈则代表了两个玩家可以采取同时行动的情境。证券交易是同时博弈的一个例子。

零和博弈与非零和博弈

零和博弈指的是一种情境,其中一个玩家的获胜总是转化为其他玩家的损失。棋盘游戏是零和博弈的例子。非零和博弈通常出现在多个玩家可以从一个玩家的行动中获益的情境中。经济互动中多个参与者合作以增加市场规模就是非零和博弈的一个例子。

纳什均衡

对称博弈主宰了人工智能世界,其中大多数基于过去一个世纪最著名的数学理论之一:纳什均衡。

纳什均衡以 约翰·福布斯·纳什 的名字命名,这位美国数学家因在电影 《美丽心灵》 中由拉塞尔·克劳饰演而被铭记。基本上,纳什均衡描述了一种情况,其中每个玩家都选择了一种策略,并且没有玩家可以通过改变策略来获得更大的利益,同时其他玩家保持其策略不变。

纳什均衡是一个美丽且极其强大的数学模型,用于解决许多博弈论问题,但在许多不对称博弈环境中也存在不足。首先,纳什方法假设玩家具有无限的计算能力,而这在现实世界中几乎不可能发生。此外,许多纳什均衡模型未能考虑到风险这一概念,而风险在大多数不对称博弈和经济市场中是普遍存在的。因此,有许多不对称博弈场景很难使用纳什均衡进行实现。这在需要在解决方案的数学优雅性与实施的实际性之间找到正确平衡的多智能体 AI 系统中尤为重要。

对机器学习产生影响的博弈论新思想

多智能体 AI 系统是 AI 生态系统中最令人着迷的研究领域之一。近期在多智能体系统等领域的进展正在推动博弈论的边界,依赖于该领域的一些最复杂的思想。以下是一些在现代机器学习中非常常见的博弈论子学科的例子。

平均场博弈

平均场博弈(MFG) 是博弈论领域中相对较新的一个领域。MFG 理论在 2006 年由 Minyi Huang、Roland Malhamé 和 Peter Caines 在蒙特利尔,以及 Jean-Michel Lasry 和菲尔兹奖得主 Pierre-Louis Lions 在巴黎发表的一系列独立论文中首次提出。从概念上讲,MFG 包括用于研究具有大量理性玩家的微分博弈的方法和技术。这些代理不仅对自身状态(如财富、资本)有偏好,还对群体中其余个体的分布有偏好。MFG 理论研究这些系统的广义纳什均衡。

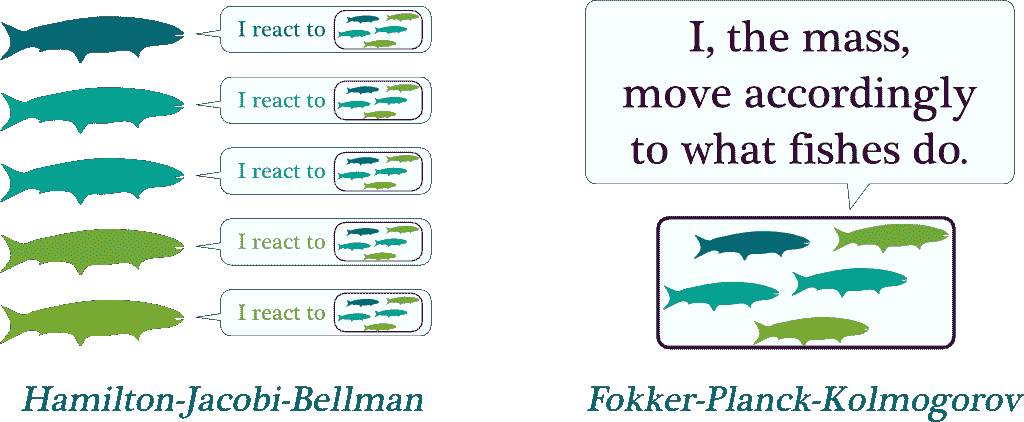

平均场博弈的经典例子是鱼群如何以协调的方式朝同一方向游动。从理论上讲,这种现象确实很难解释,但它的根源在于鱼对最近群体行为的反应。更具体地说,每条鱼并不关心其他鱼的个体行为,而是关心附近的鱼群整体的运动。如果我们将其转化为数学术语,鱼对鱼群的反应可以用哈密顿-雅可比-贝尔曼方程来描述。另一方面,鱼群行为的聚合决定了质量的运动,对应于福克-普朗克-科尔莫戈罗夫方程。均场博弈理论就是这两个方程的结合。

随机游戏

随机游戏可以追溯到 1950 年代,由诺贝尔经济学奖得主Lloyd Shapley引入。从概念上讲,随机游戏是由有限数量的玩家在有限状态空间上进行的,每个状态下,每个玩家选择有限个行动之一;这些行动的结果决定了每个玩家的奖励以及对后继状态的概率分布。

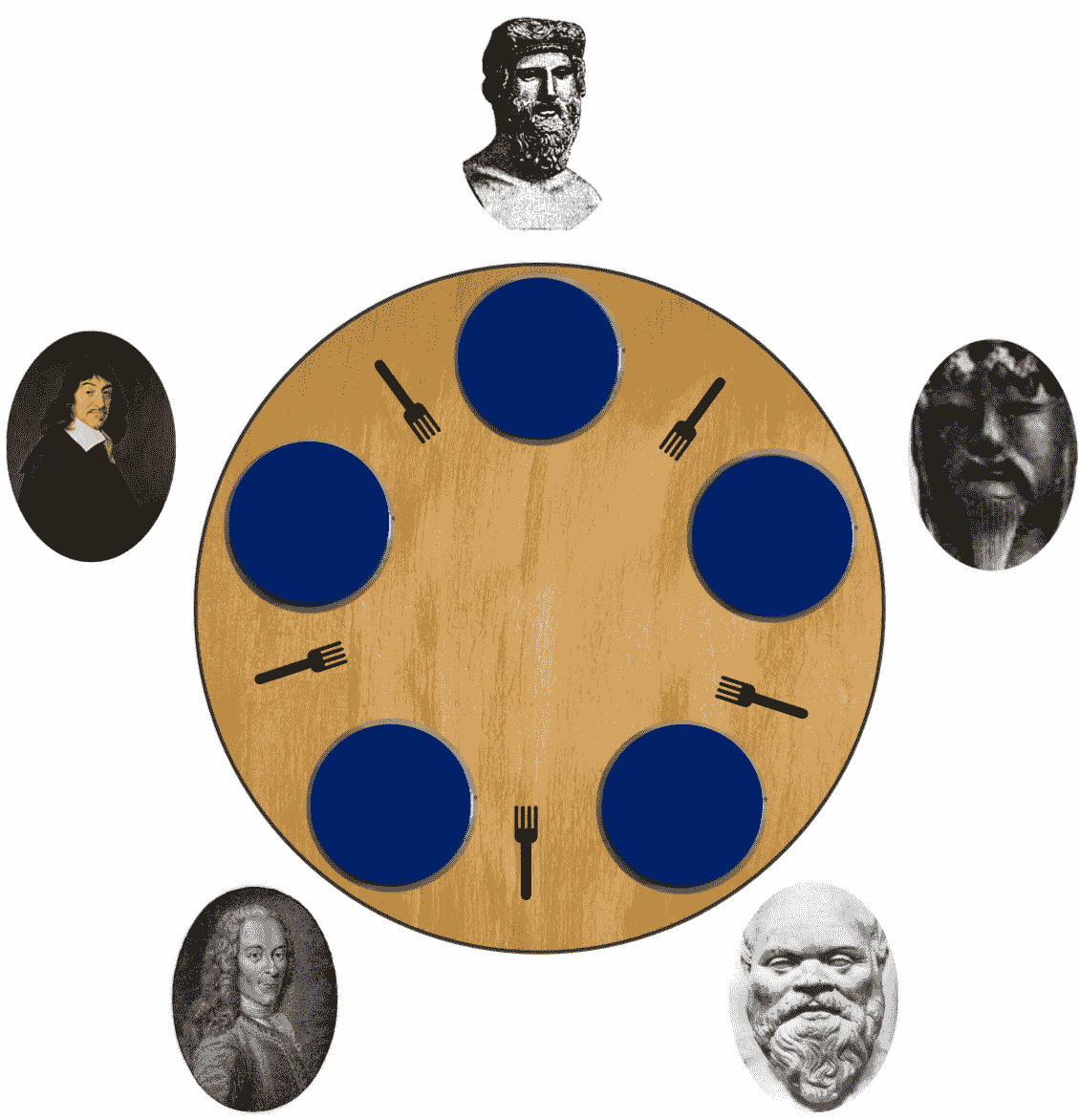

一个经典的随机游戏形式是哲学家就餐问题,其中有 n + 1 名哲学家(n ≥ 1)坐在一个圆桌旁,中间有一碗米饭。任何两个相邻的哲学家之间都有一根筷子,两个哲学家都可以使用。由于桌子是圆的,所以筷子的数量与哲学家的数量相同。要从碗里吃饭,哲学家需要同时获得他能接触到的两根筷子。因此,如果一个哲学家在吃饭,那么他的两个邻居不能同时吃饭。哲学家的生活非常简单,包括思考和吃饭;为了生存,哲学家需要不断地思考和吃饭。任务是设计一个协议,使所有哲学家都能生存。

演化博弈

演化博弈论(EGT)受达尔文进化理论的启发。EGT 的起源可以追溯到 1973 年,约翰·梅纳德·史密斯和乔治·R·普赖斯对竞赛的形式化分析,研究了策略的数学标准,以预测竞争策略的结果。从概念上讲,EGT 是将博弈论的概念应用于一个多样化策略的群体在时间上互动以形成稳定解决方案的情况,这个过程是通过选择和复制的演化过程来实现的。EGT 的主要思想是许多行为涉及到一个群体中多个代理的互动,而这些代理中的任何一个的成功取决于其策略如何与其他代理的策略互动。虽然经典博弈论关注的是静态策略,也就是说那些不会随时间变化的策略,但演化博弈论则不同于经典博弈论,它关注的是策略如何随着时间演变,以及哪些动态策略在这一演化过程中最成功。

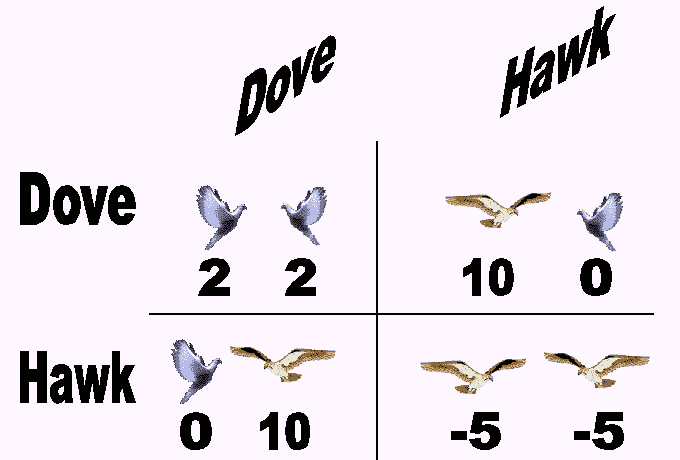

EGT 的一个经典例子是鹰鸽博弈,该博弈模拟了鹰与鸽子之间对可分享资源的争夺。在游戏中,每个参赛者都会遵循以下两种策略中的一种:

-

鹰:发起攻击性行为,直到受伤或对手退却为止。

-

鸽子:如果对手发起攻击性行为,则立即撤退。

如果我们假设(1)每当两个个体都发起攻击性行为时,最终会发生冲突,并且两个个体受伤的可能性相同,(2)冲突的成本会将个体适应度降低一个常数值C,(3)当一只鹰遇到一只鸽子时,鸽子会立即撤退,鹰获得资源,以及(4)当两只鸽子相遇时,资源将被平分,那么鹰鸽博弈的适应度收益可以根据以下矩阵总结:

逆博弈论

在许多情况下,问题不是优化参与者在博弈中的策略,而是围绕理性参与者的行为设计博弈。这就是逆博弈论的作用。拍卖被认为是逆博弈论的一个主要例子。

博弈论正在经历一场由人工智能和多智能体系统进化推动的复兴。由计算机科学传奇人物如艾伦·图灵或约翰·冯·诺依曼制定的博弈论原则,如今已成为地球上一些最智能系统的核心,最近在人工智能领域的进展也在推动博弈论研究。随着人工智能的不断发展,我们应当看到博弈论领域出现新的、更具创新性的思想,这些思想将融入主流的深度学习系统中。

原文。经许可转载。

相关内容:

-

博弈论介绍(第一部分)

-

2020 年机器学习趋势

-

马尔可夫链介绍

更多相关话题

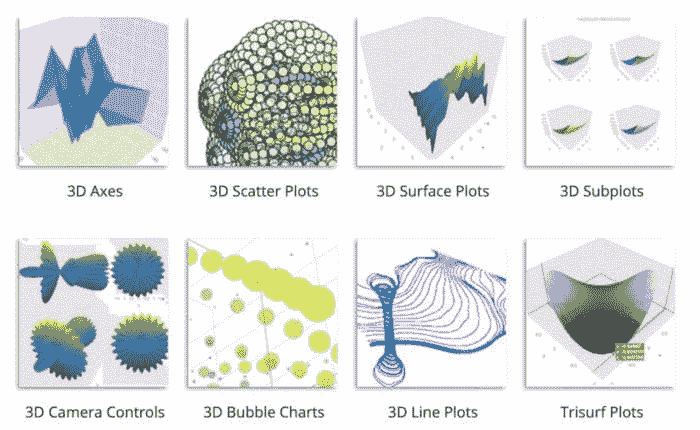

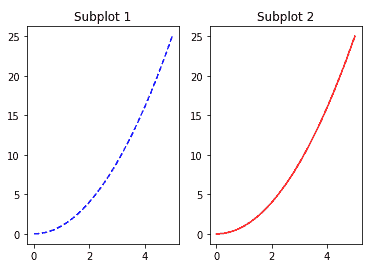

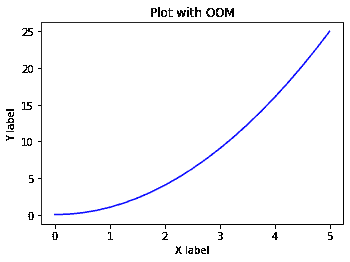

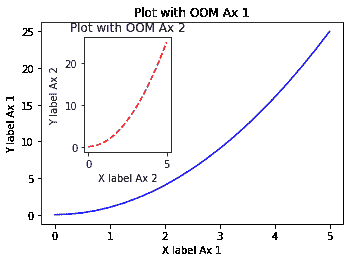

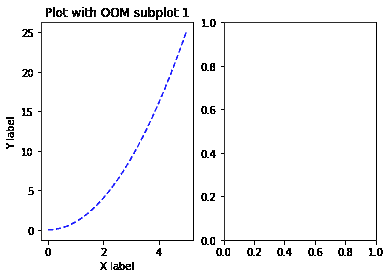

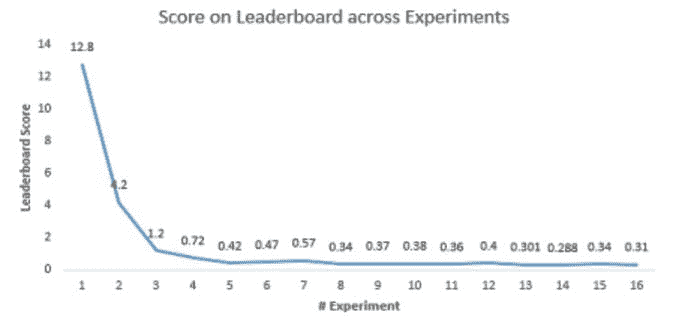

如何在深度学习中创建自定义实时图表

原文:

www.kdnuggets.com/2020/12/create-custom-real-time-plots-deep-learning.html

评论

图像来源:Pixabay

我们所说的实时图表是什么意思?

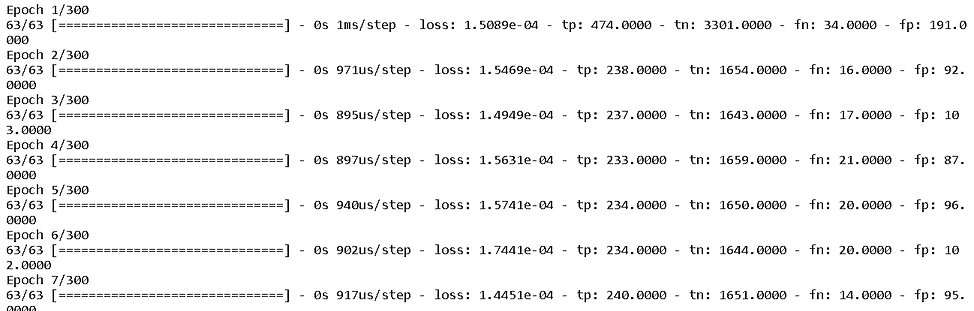

训练一个复杂的深度学习模型和一个大数据集可能是非常耗时的。随着训练轮次的增加,大量数字在屏幕上闪烁。你的眼睛(和大脑)会感到疲倦。

那个令人兴奋的准确度图表在哪里,不断更新你的进展情况?你怎么知道模型是否在学习有用的东西?以及,学习的速度有多快?

一个实时视觉更新会非常棒,不是吗?

毕竟,人类是视觉动物。

在这里,我们收集了一些有趣的事实,以强调在科学交流中使用视觉辅助工具的重要性...

说到视觉,我并不是指在你打开模型的详细输出时屏幕上滚动的大量数字。

不是这个。

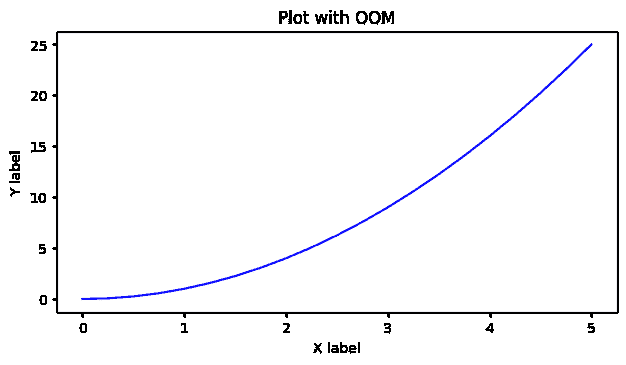

我们要这个。

让我们看看如何实现这个目标。

那个令人兴奋的准确度图表在哪里,不断更新你的进展情况?你怎么知道模型是否在学习有用的东西?以及,学习的速度有多快?

我们所说的自定义图表是什么意思?

对于常规任务,有很多现成的工具。但许多时候,我们需要定制化的输出。

Tensorboard 很酷,但可能无法满足所有需求。

如果你在进行深度学习任务时使用 TensorFlow/Keras,可能你已经听说过或使用过 Tensorboard。它是一个非常棒的仪表板工具,你可以传递训练日志,并获得极佳的可视化更新。

在机器学习中,要改进某些东西,你通常需要能够衡量它。TensorBoard 是一个提供...

图像来源:Tensorboard

你可以非常轻松地使用 Tensorboard 获取标准的损失和准确度图表。如果你只想监控这些内容,而不关心其他内容,可以停止阅读本文,直接使用 Tensorboard。

但如果你有一个高度不平衡的数据集,并且你想绘制精准度、召回率和 F1 分数呢?或者,另一种不那么常见的分类指标,比如 马修斯系数?再或者,你只关心真正负样本和假负样本的比例,想创建你自己的指标?

如何在训练过程中看到这些非标准指标的实时更新?

Keras 有内置的混淆矩阵计算功能

幸运的是,Keras 提供了与混淆矩阵相关的四个基本量的基本日志——真正的正例 (TP)、假正例 (FP)、真正的负例 (TN) 和假负例 (FN)。这些来自 Keras Metrics 模块。

模块: tf.keras.metrics | TensorFlow Core v2.3.0

内置指标。

我们可以简单地在模型的训练日志中定义一个指标列表,并在编译模型时传递该列表。

**metrics** = [

tf.keras.metrics.TruePositives(name="tp"),

tf.keras.metrics.TrueNegatives(name="tn"),

tf.keras.metrics.FalseNegatives(name="fn"),

tf.keras.metrics.FalsePositives(name="fp"),

]

然后,

model.compile(

optimizer=tf.keras.optimizers.Adam(lr=learning_rate),

loss=tf.keras.losses.BinaryCrossentropy(),

** metrics=metrics**,

)

所以,我们可以将这些度量(尽管它们是在训练数据集上计算的)作为训练日志的一部分。一旦得到这些度量,我们可以根据原理定义计算我们想要的任何自定义指标。例如,这里展示了一些非标准指标的公式,

图片来源: 维基百科

但是,我们如何从这些计算值创建自定义实时图表呢?

我们当然使用回调!

如何在训练过程中看到这些非标准指标的实时更新?

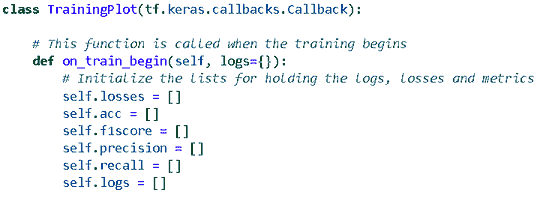

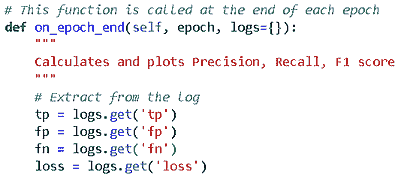

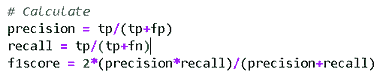

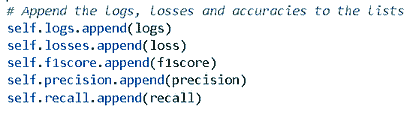

用于实时可视化的自定义回调

回调是一种神奇的工具类,可以在训练的某些点(或者每个纪元)被调用。简而言之,它们可以在训练过程中实时处理与模型性能或算法相关的数据。

这是 TensorFlow 官方的 Keras 回调页面。但为了我们的目的,我们必须编写一个自定义绘图类,它派生自基础 Callback 类。

模块: tf.keras.callbacks | TensorFlow Core v2.3.0

回调:在模型训练过程中在特定点调用的工具。

演示 Jupyter notebook

演示 Jupyter notebook 在我的 Github 仓库中 位于这里。这个仓库 包含许多其他有用的深度学习教程风格的笔记本。请随意加星或 fork。

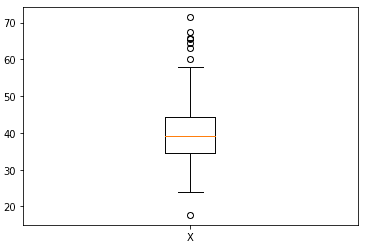

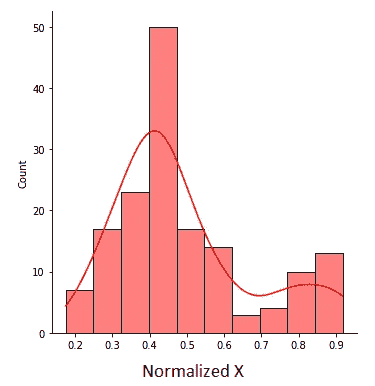

一个不平衡的数据集

图片来源: Pixabay

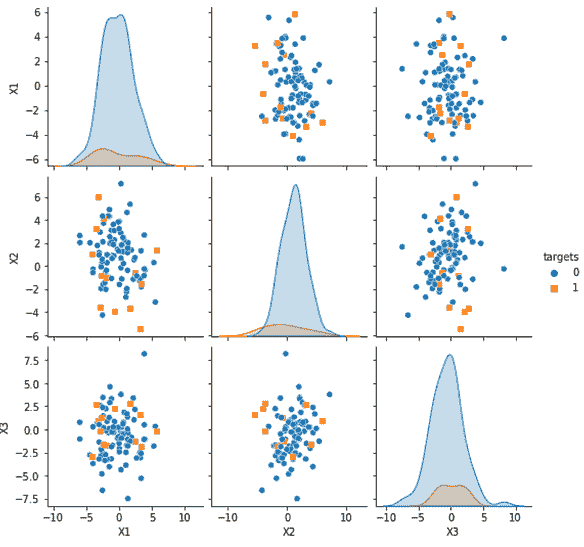

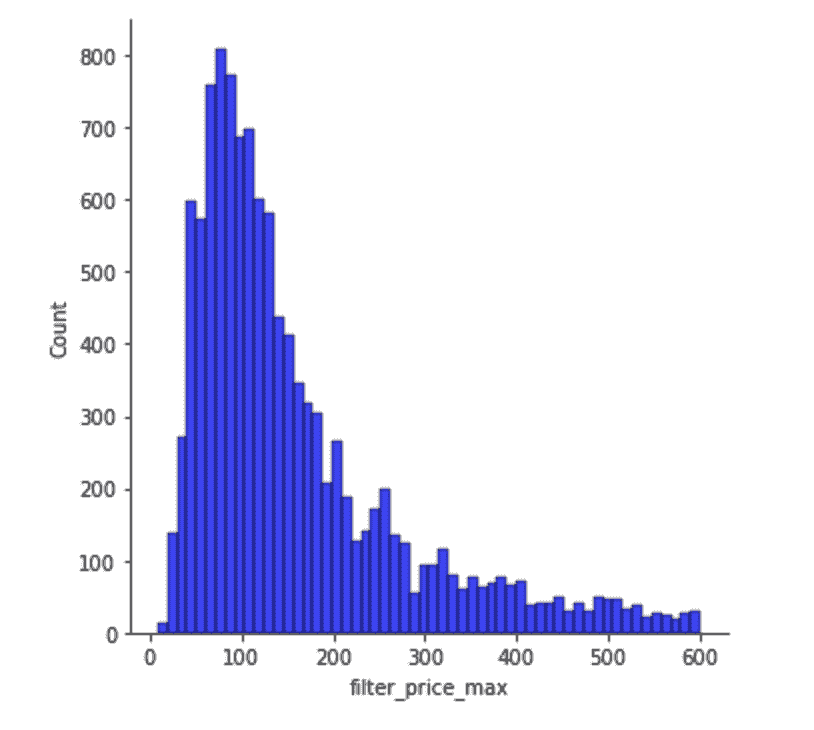

我们为演示中的二分类任务创建了一个具有不平衡类别频率(负样本远多于正样本)的合成数据集。这种情况在实际数据分析项目中非常常见,它强调了需要一个用于自定义分类指标的可视化仪表盘的必要性,在这种情况下准确率不是一个好的指标。

以下代码创建了一个包含90% 负样本和 10% 正样本的数据集。

from sklearn.datasets import make_classificationn_features = 15

n_informative = n_featuresd = make_classification(n_samples=10000,

n_features=n_features,

n_informative=n_informative,

n_redundant=0,

n_classes=2,

**weights=[0.9,0.1]**,

flip_y=0.05,

class_sep=0.7)

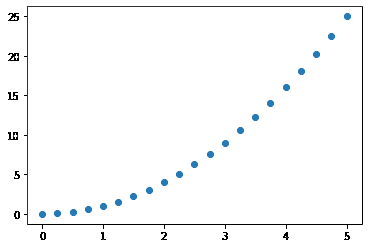

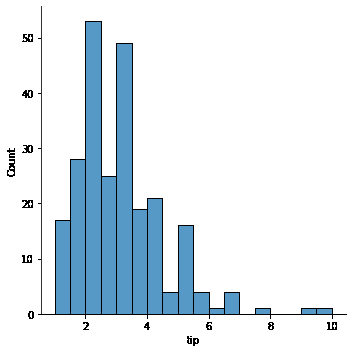

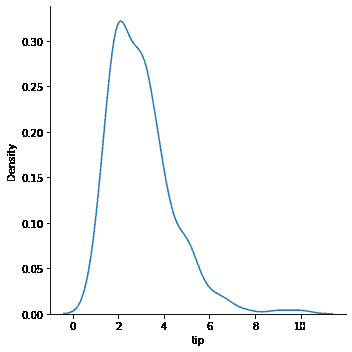

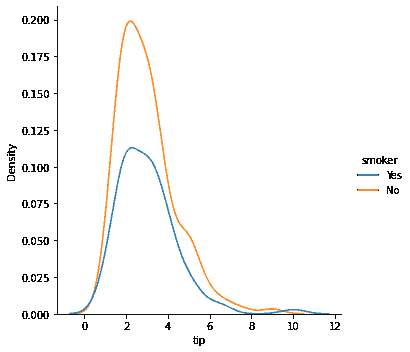

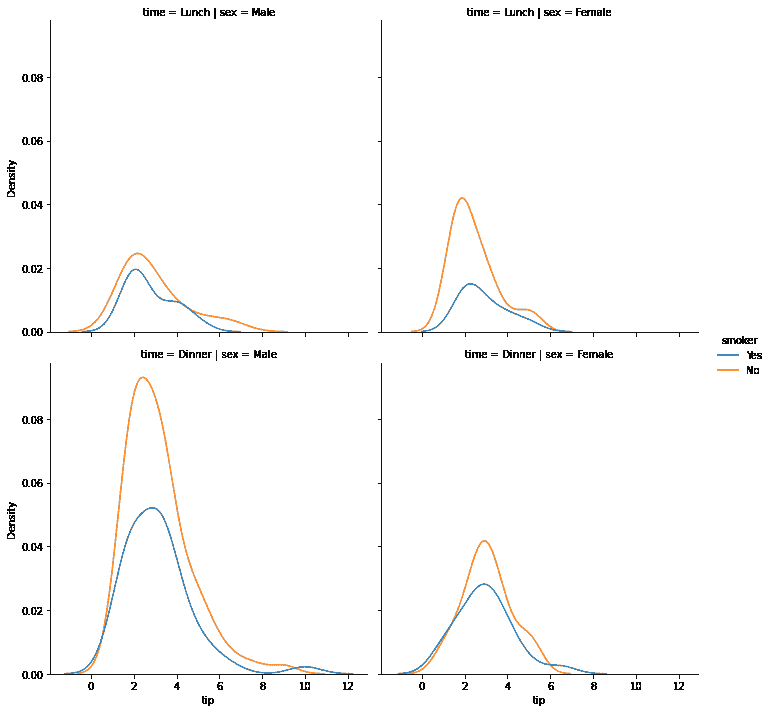

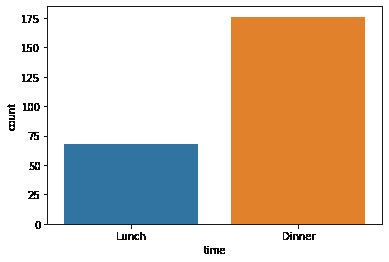

下图显示了两个类别的样本数据分布。注意核密度图的失衡。

合成数据集按类别分布

回调是一类很棒的工具,可以在训练的某些点(或者每个周期)调用。

自定义回调类

自定义回调类主要执行以下操作,

-

初始化一系列列表以存储值

-

从模型中提取每个周期结束时的指标

-

从这些提取中计算分类指标

-

并将其存储在这些列表中

-

创建多个图表

这里是初始化,

这里是提取,

这里是计算,

这里是存储,

此外,我不会用标准的 Matplotlib 绘图代码来让你觉得枯燥,除了以下这部分,它在每次迭代时刷新你的 Jupyter notebook 图表。

from IPython.display import clear_output# Clear the previous plot

clear_output(wait=True)

此外,你不必每个周期都绘图,因为这可能会增加负担并减慢显示或机器的速度。你可以选择每隔 5 个周期绘制一次。只需将整个绘图代码放在一个条件下(这里epoch是你从训练日志中获得的周期数)

# Plots every 5th epoch

if epoch > 0 and epoch%5==0:

不用担心这些如何协同工作,因为演示笔记本仍然在这里供你使用。

结果

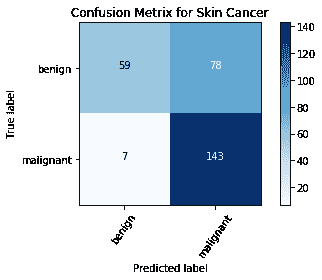

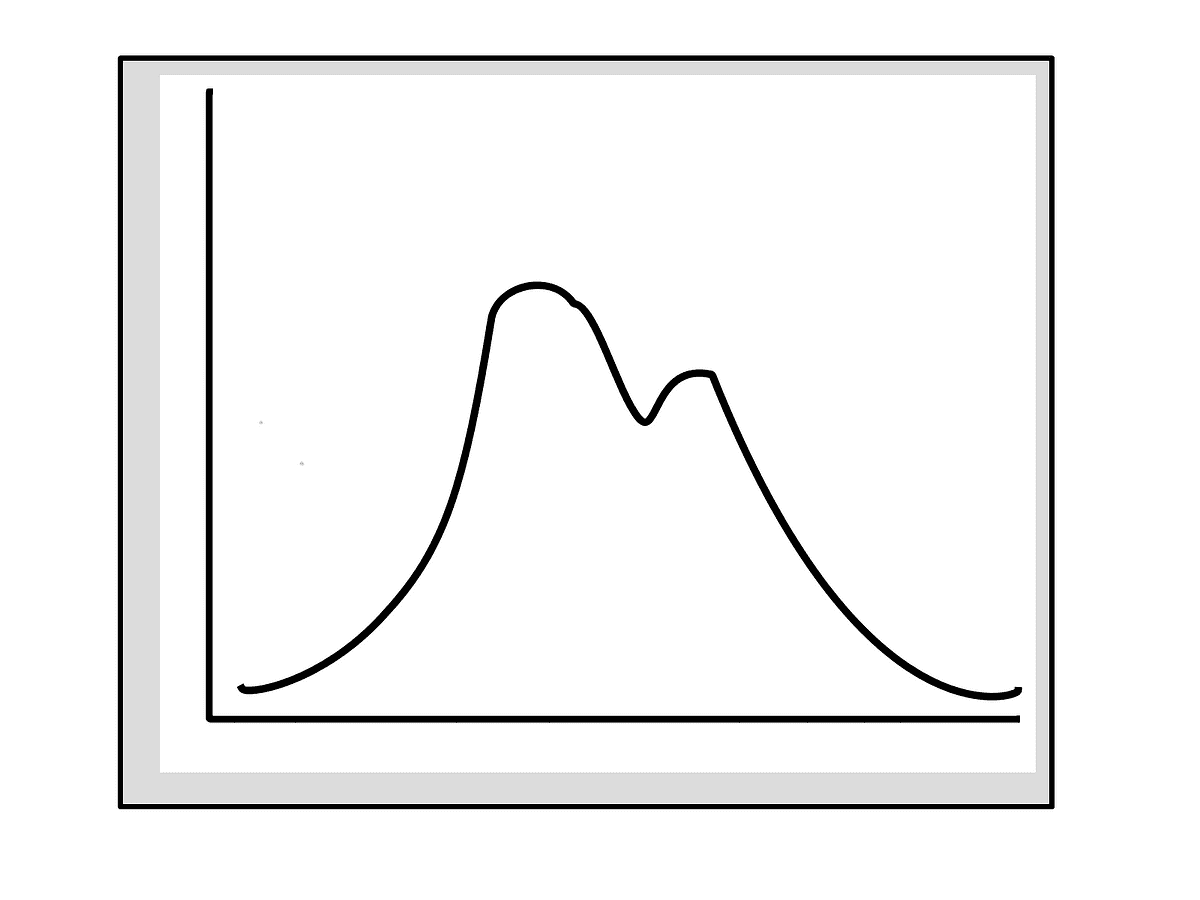

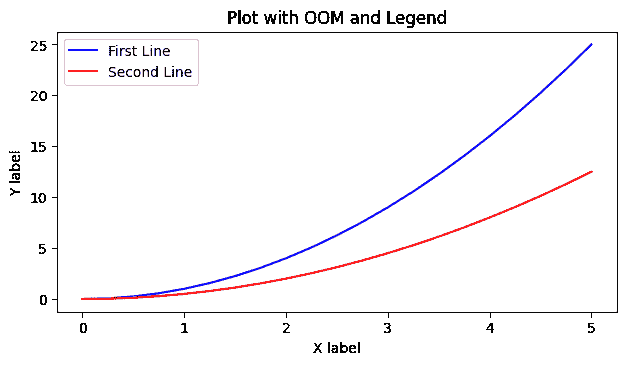

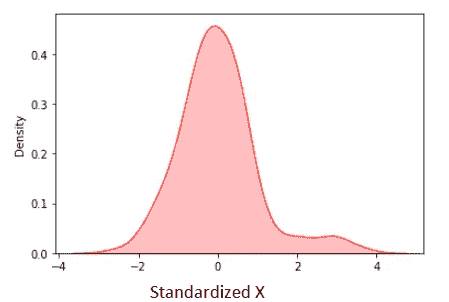

这里是一个典型的结果,显示了损失和精度/召回率/F1 分数的简单仪表板风格。注意,召回率开始时较高,但精度和 F1 分数对于这个不平衡的数据集较低。这些是你可以通过这种回调实时计算和监控的指标!

更多结果 — 概率分布!

你可以在每个周期结束时对模型(在那个点训练好的)进行任何计算,并可视化结果。例如,我们可以预测输出概率,并绘制它们的分布。

def on_epoch_end(self, epoch, logs={}):

# Other stuff

m = self.model

preds = m.predict(X_train)

plt.hist(preds, bins=50,edgecolor='k')

注意,开始时只有少数样本获得高概率,随着时间的推移,模型开始学习数据的真实分布。

摘要

我们展示了如何通过简单的代码片段创建一个实时深度学习模型性能的仪表板。按照这里概述的方法,你无需依赖 Tensorboard 或任何第三方软件。你可以创建自己的计算和图表,尽可能自定义。

请注意,上述方法仅适用于 Jupyter Notebook。对于独立的 Python 脚本,您需要进行不同的调整。

关于这个话题,还有另一篇精彩的文章,您可以在这里查看。

如何在 Keras 中绘制模型训练图 — 使用自定义回调函数和 TensorBoard

在处理犬种识别时,我开始探索不同的训练过程可视化方法……

您可能还喜欢……

如果您喜欢这篇文章,您可能还会喜欢以下我撰写的深度学习文章,

您是否在 Keras 深度学习模型中使用了“Scikit-learn 包装器”?

如何使用 Keras 的特殊包装类进行超参数调优?

我们展示了如何用几行代码展示深度 CNN 模型中各层的激活图……

我们展示了如何构建一个通用的工具函数来自动从目录中提取图像,并……

您可以查看作者的 GitHub** 代码库**,以获取机器学习和数据科学的代码、想法和资源。如果您和我一样,对 AI/机器学习/数据科学充满热情,请随时 在 LinkedIn 上添加我 或 在 Twitter 上关注我。

Tirthajyoti Sarkar - 高级首席工程师 - 半导体、AI、机器学习 - ON…

通过写作让数据科学/机器学习概念易于理解:https://medium.com/@tirthajyoti 开源和……

原文。经授权转载。

相关内容:

-

用于比较、绘图和评估回归模型的简单 Python 包

-

初学者的 20 个核心数据科学概念

-

通过 Yann LeCun 的免费课程学习深度学习

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯

1. Google 网络安全证书 - 快速进入网络安全职业生涯

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织在 IT 领域

3. Google IT 支持专业证书 - 支持您的组织在 IT 领域

更多相关内容

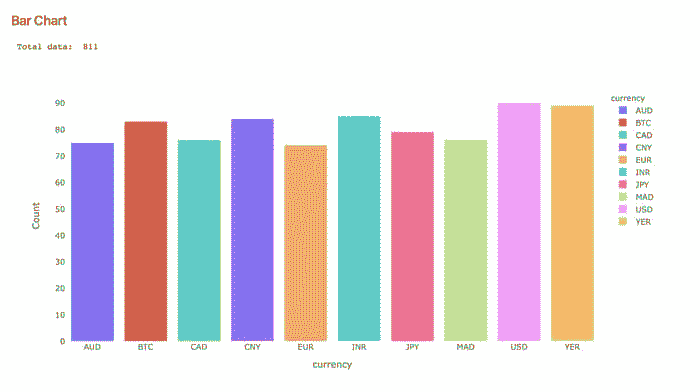

使用 Python 和 Dash 创建仪表盘

原文:

www.kdnuggets.com/2023/08/create-dashboard-python-dash.html

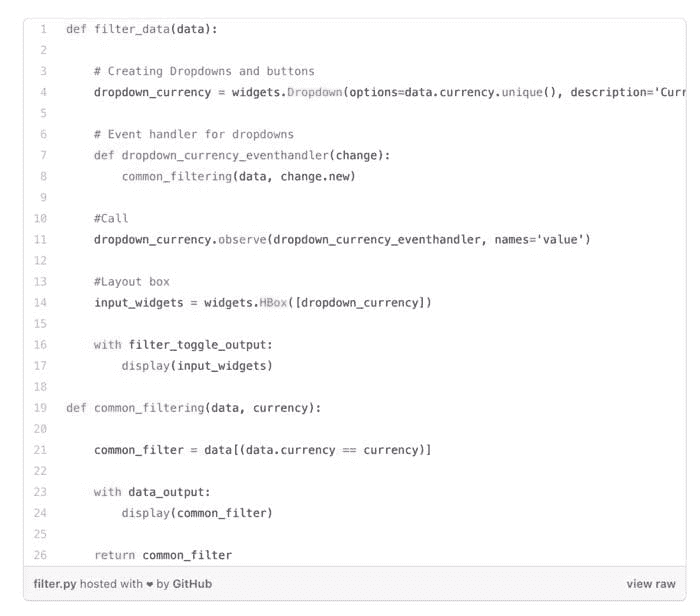

介绍

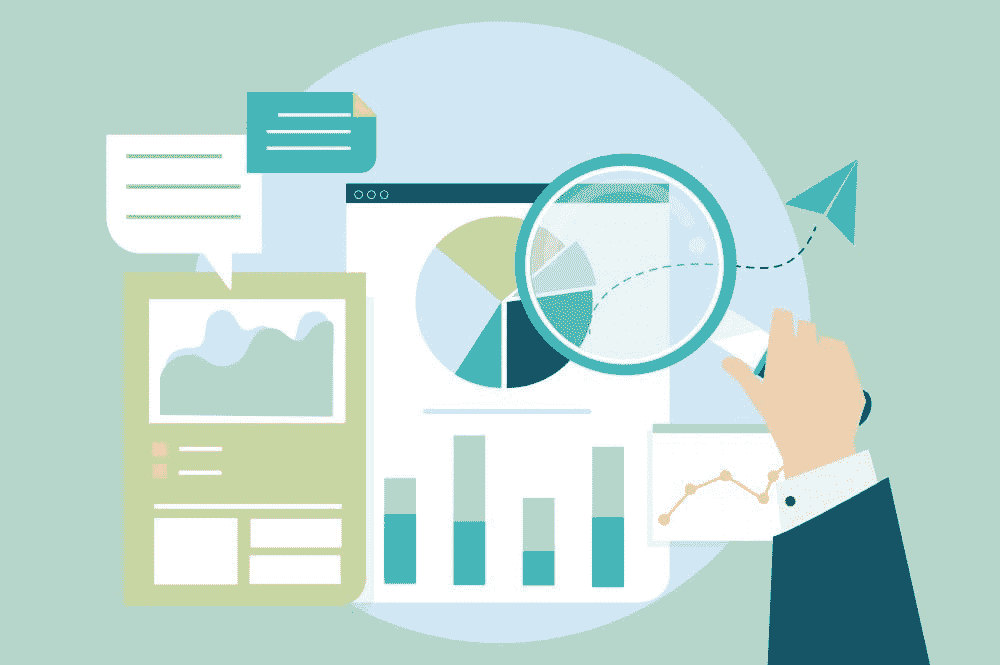

在数据科学和分析的领域中,数据的力量不仅在于提取洞察力,还在于有效地传达这些洞察力;这就是数据可视化发挥作用的地方。

数据可视化是信息和数据的图形化表现。它使用图表、图形和地图等视觉元素,使得更容易看出原始数据中的模式、趋势和异常值。对于数据科学家和分析师而言,数据可视化是一个重要工具,它有助于更快、更准确地理解数据,支持数据故事讲述,并有助于做出数据驱动的决策。

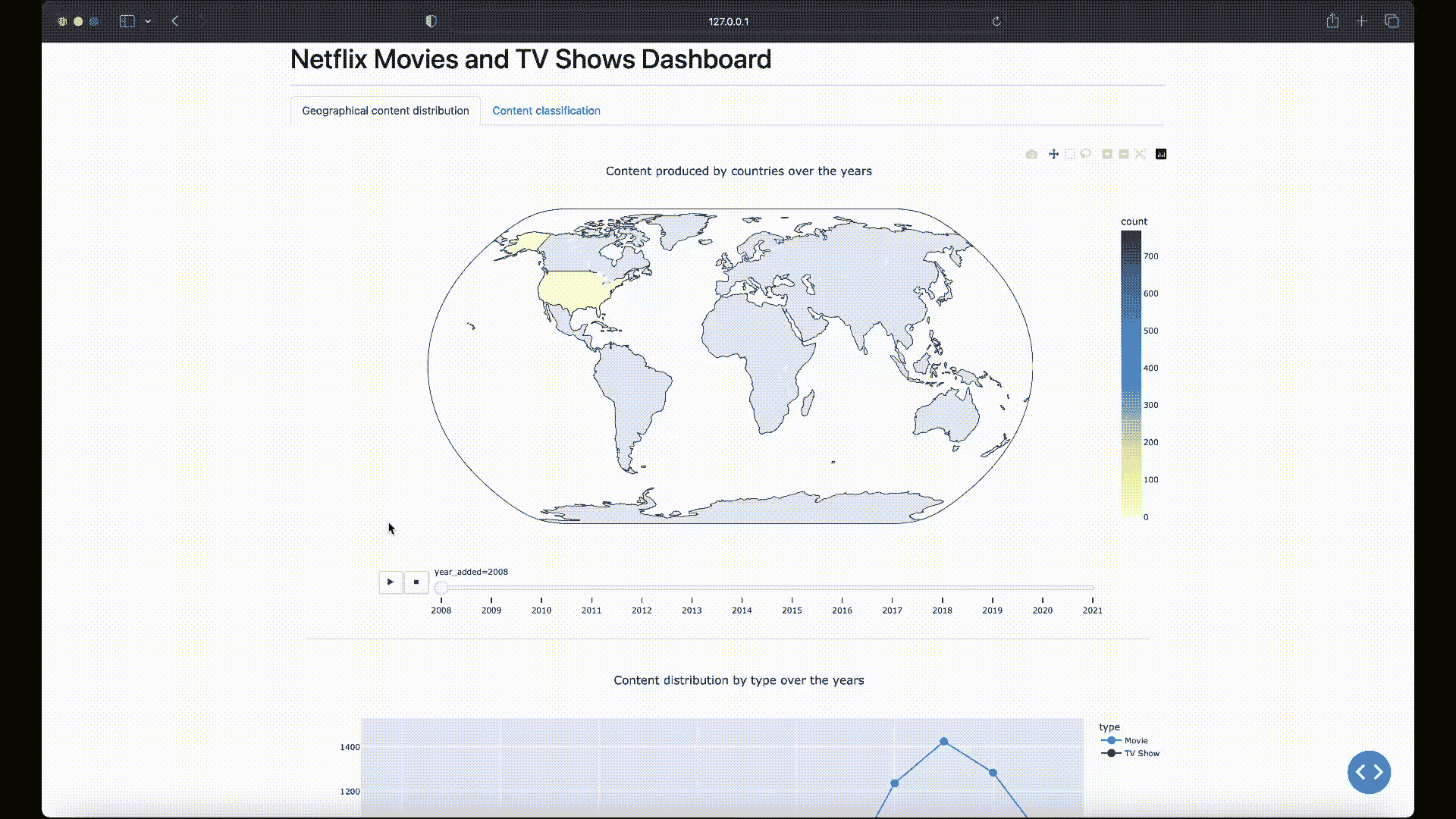

在这篇文章中,你将学习如何使用Python和Dash框架创建一个仪表盘来可视化 Netflix 的内容分布和分类。

什么是 Dash?

Dash 是一个由Plotly开发的开源低代码框架,用于在纯 Python 中创建分析性 Web 应用程序。传统上,为了实现这些目的,人们可能需要使用JavaScript 和 HTML,这需要你在后台(Python)和前端(JavaScript、HTML)技术方面都有专业知识。

然而,Dash 弥补了这一差距,使数据科学家和分析师能够仅使用 Python构建交互式、美观的仪表盘。这种低代码开发的特点使 Dash 成为创建分析仪表盘的合适选择,尤其是对于那些主要使用 Python 的人。

数据集分析

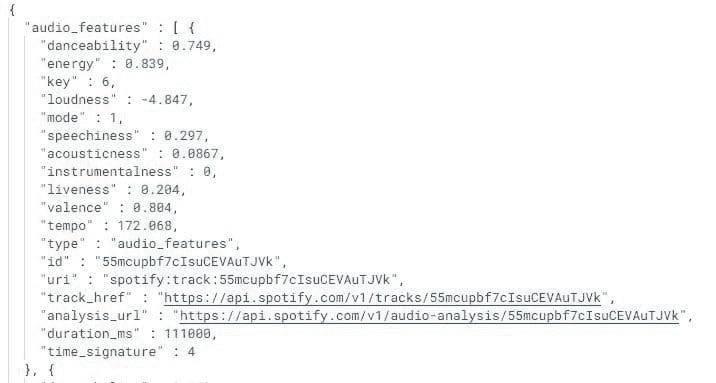

现在你已经了解了 Dash,让我们开始我们的实践项目。你将使用Netflix 电影和电视节目数据集,该数据集由Shivam Bansal创建,并可以在Kaggle上获得。

该数据集包含了截至 2021 年 Netflix 上可用的电影和电视节目的详细信息,如内容类型、标题、导演、演员、制作国家、发行年份、评级、时长等。

尽管数据集创建于 2021 年,但它仍然是发展数据可视化技能和理解媒体娱乐趋势的宝贵资源。

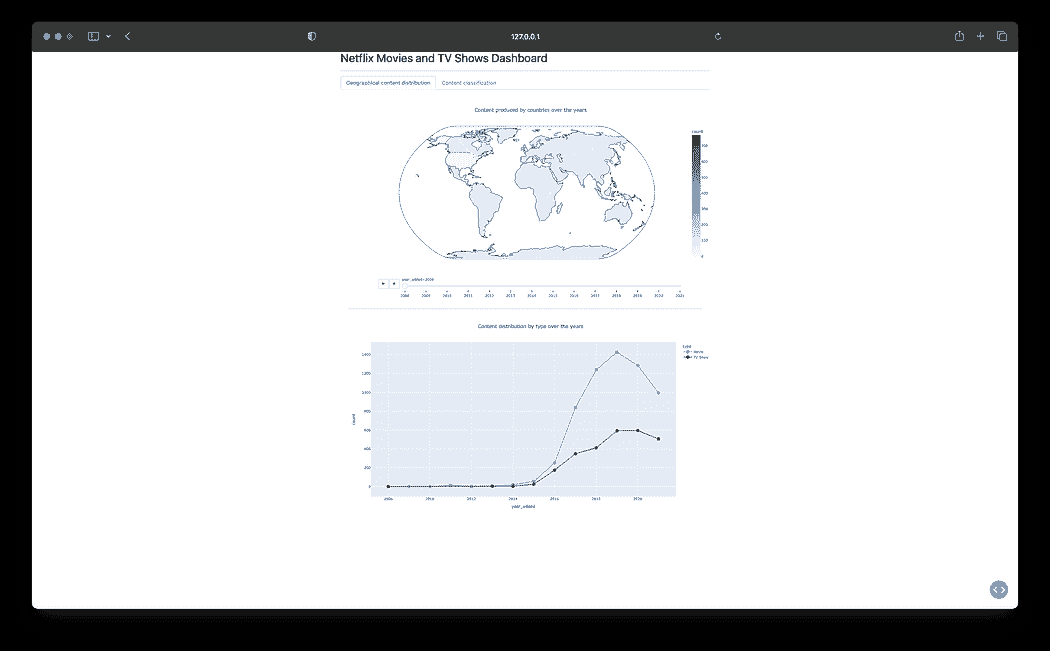

使用该数据集,你的目标是创建一个仪表盘,允许可视化以下几点:

-

地理内容分布:一张地图图表展示了内容生产在不同国家之间的年度变化。

-

内容分类:这个可视化将 Netflix 的内容分为电视节目和电影,以查看哪些类型最为突出。

设置项目工作区

让我们开始创建一个名为netflix-dashboard的项目目录,然后通过以下命令初始化和激活 Python 虚拟环境:

# Linux & MacOS

mkdir netflix-dashboard && cd netflix-dashboard

python3 -m venv netflix-venv && source netflix-venv/bin/activate

# Windows Powershell

mkdir netflix-dashboard && cd netflix-dashboard

python -m venv netflix-venv && .\netflix-venv\Scripts\activate

接下来,你需要安装一些外部包。你将使用pandas进行数据处理,dash创建仪表板,plotly绘制图表,以及dash-bootstrap-components为仪表板添加一些样式:

# Linux & MacOS

pip3 install pandas dash plotly dash-bootstrap-components

# Windows Powershell

pip install pandas dash plotly dash-bootstrap-components

清理数据集

在 Netflix 数据集中,你会发现director、cast和country列中有缺失值。将date_added列的string值转换为datetime以便于分析也会很方便。

要清理数据集,你可以创建一个新的文件clean_netflix_dataset.py,其中包含以下代码,然后运行它:

import pandas as pd

# Load the dataset

df = pd.read_csv('netflix_titles.csv')

# Fill missing values

df['director'].fillna('No director', inplace=True)

df['cast'].fillna('No cast', inplace=True)

df['country'].fillna('No country', inplace=True)

# Drop missing and duplicate values

df.dropna(inplace=True)

df.drop_duplicates(inplace=True)

# Strip whitespaces from the `date_added` col and convert values to `datetime`

df['date_added'] = pd.to_datetime(df['date_added'].str.strip())

# Save the cleaned dataset

df.to_csv('netflix_titles.csv', index=False)

开始使用 Dash

设置好工作空间并清理数据集后,你准备开始制作仪表板了。创建一个新的文件app.py,其中包含以下代码:

from dash import Dash, dash_table, html

import pandas as pd

# Initialize a Dash app

app = Dash(__name__)

# Define the app layout

app.layout = html.Div([

html.H1('Netflix Movies and TV Shows Dashboard'),

html.Hr(),

])

# Start the Dash app in local development mode

if __name__ == '__main__':

app.run_server(debug=True)

让我们解析一下app.py中的代码:

-

app = Dash(__name__):这一行初始化了一个新的 Dash 应用程序。可以把它看作是你应用的基础。 -

app.layout = html.Div(…):app.layout属性允许你编写类似 HTML 的代码来设计应用的用户界面。上述布局使用了html.H1(…)标题元素作为仪表板标题,并在标题下方添加了一个水平规则html.Hr()元素。 -

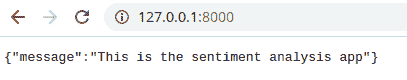

app.run(debug=True):这一行启动了一个开发服务器,在本地开发模式下提供你的 Dash 应用。Dash 使用Flask,一个轻量级的 web 服务器框架,将你的应用提供给 web 浏览器。

运行app.py后,你会在终端中看到一条消息,指示你的 Dash 应用正在运行并可以在127.0.0.1:8050/访问。打开此 URL 以在你的 web 浏览器中查看:

你的第一个 Dash 应用程序!

结果看起来很简单,对吧?别担心!这一部分旨在展示最基本的 Dash 应用结构和组件。你很快会添加更多功能和组件,使其成为一个令人惊叹的仪表板!

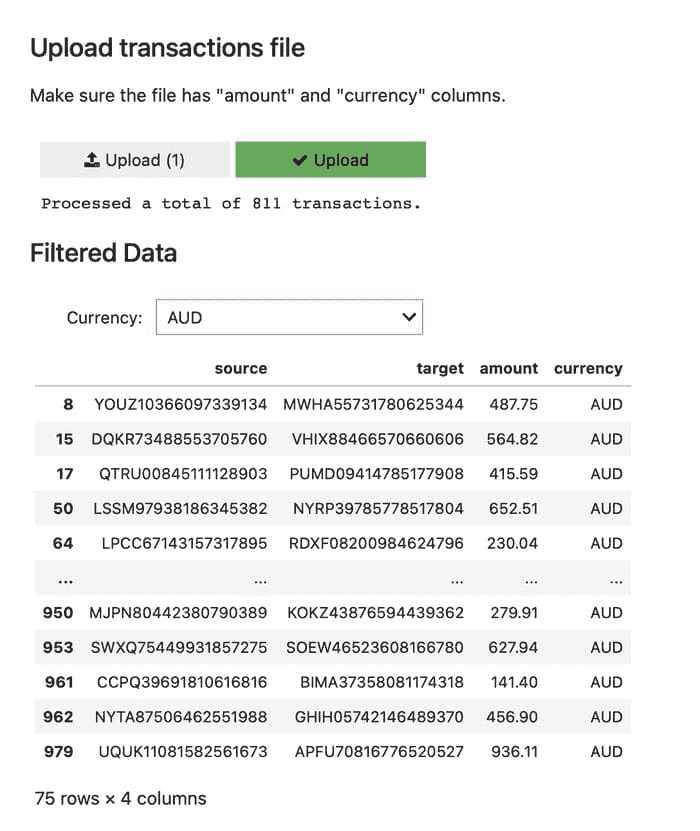

纳入 Dash Bootstrap 组件

下一步是编写仪表板布局的代码并为其添加一些样式!为此,你可以使用Dash Bootstrap Components (DBC),一个为 Dash 提供 Bootstrap 组件的库,使你能够开发具有响应式布局的样式化应用。

仪表板将以选项卡布局样式化,这提供了一种在同一空间内组织不同类型信息的紧凑方式。每个选项卡将对应于一个独特的可视化。

让我们继续修改app.py的内容以纳入 DBC:

from dash import Dash,dcc, html

import pandas as pd

import dash_bootstrap_components as dbc

# Initialize the Dash app and import the Bootstrap theme to style the dashboard

app = Dash(__name__, external_stylesheets=[dbc.themes.BOOTSTRAP])

app.layout = dbc.Container(

[

dcc.Store(id='store'),

html.H1('Netflix Movies and TV Shows Dashboard'),

html.Hr(),

dbc.Tabs(

[

dbc.Tab(label='Geographical content distribution', tab_id='tab1'),

dbc.Tab(label='Content classification', tab_id='tab2'),

],

id='tabs',

active_tab='tab1',

),

html.Div(id='tab-content', className='p-4'),

]

)

if __name__ == '__main__':

app.run(debug=True)

在这个修改后的布局中,你会看到新的组件:

-

dbc.Container:使用dbc.Container作为顶级组件将整个仪表板布局包裹在一个响应式和灵活的容器中。 -

dcc.Store:这个 Dash Core 组件允许你将数据存储在客户端(用户的浏览器)上,通过本地存储数据来提升应用性能。 -

dbc.Tabs和dbc.Tab:每个dbc.Tab代表一个独立的标签页,包含不同的可视化内容。label属性显示在标签页上,tab_id用于标识标签页。dbc.Tabs的active_tab属性用于指定 Dash 应用启动时的活动标签页。

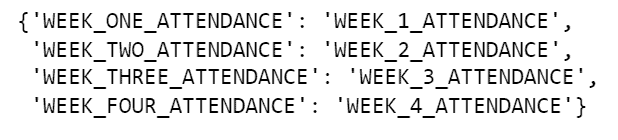

现在运行app.py。生成的仪表板将具有 Bootstrap 样式布局,包含两个空标签页:

集成 Bootstrap 以实现标签样式布局

干得不错!你终于准备好将可视化内容添加到仪表板中。

添加回调和可视化

在使用 Dash 时,通过回调函数实现交互性。回调函数是在输入属性变化时自动调用的函数。之所以称为“回调”,是因为它是一个被 Dash 在应用发生变化时“回调”的函数。

在这个仪表板中,你将使用回调函数在选定的标签页中呈现相关的可视化,每个可视化将存储在components目录下的独立 Python 文件中,以便更好地组织和模块化项目结构。

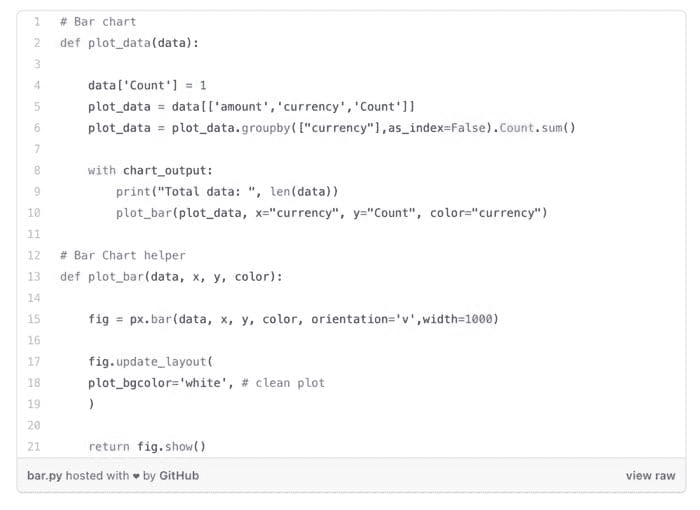

地理内容分布可视化

创建一个名为components的新目录,在其中创建一个geographical_content.py文件,该文件将生成一个区域图,展示 Netflix 的内容生产如何随年份在各国之间变化:

import pandas as pd

import plotly.express as px

from dash import dcc, html

df = pd.read_csv('netflix_titles.csv')

# Filter out entries without country information and if there are multiple production countries,

# consider the first one as the production country

df['country'] = df['country'].str.split(',').apply(lambda x: x[0].strip() if isinstance(x, list) else None)

# Extract the year from the date_added column

df['year_added'] = pd.to_datetime(df['date_added']).dt.year

df = df.dropna(subset=['country', 'year_added'])

# Compute the count of content produced by each country for each year

df_counts = df.groupby(['country', 'year_added']).size().reset_index(name='count')

# Sort the DataFrame by 'year_added' to ensure the animation frames are in ascending order

df_counts = df_counts.sort_values('year_added')

# Create the choropleth map with a slider for the year

fig1 = px.choropleth(df_counts,

locations='country',

locationmode='country names',

color='count',

hover_name='country',

animation_frame='year_added',

projection='natural earth',

title='Content produced by countries over the years',

color_continuous_scale='YlGnBu',

range_color=[0, df_counts['count'].max()])

fig1.update_layout(width=1280, height=720, title_x=0.5)

# Compute the count of content produced for each year by type and fill zeros for missing type-year pairs

df_year_counts = df.groupby(['year_added', 'type']).size().reset_index(name='count')

# Create the line chart using plotly express

fig2 = px.line(df_year_counts, x='year_added', y='count', color='type',

title='Content distribution by type over the years',

markers=True, color_discrete_map={'Movie': 'dodgerblue', 'TV Show': 'darkblue'})

fig2.update_traces(marker=dict(size=12))

fig2.update_layout(width=1280, height=720, title_x=0.5)

layout = html.Div([

dcc.Graph(figure=fig1),

html.Hr(),

dcc.Graph(figure=fig2)

])

上述代码通过'country'和'year_added'过滤和分组数据,然后计算每个国家在df_counts数据框中每年的内容生产量。

然后,px.choropleth函数使用df_counts数据框中的列作为其参数值来构建地图图表:

-

locations='country':允许你指定'country'列中包含的地理位置值。 -

locationmode='country names':这个参数“告诉函数”提供的locations是国家名称,因为 Plotly Express 也支持其他位置模式,如 ISO-3 国家代码或美国州名。 -

color='count':用于指定用于着色地图的数值数据。这里,它指的是'count'列,该列包含每个国家每年的内容生产量。 -

color_continuous_scale='YlGnBu':为地图中的每个国家构建一个连续的颜色比例,当color指定的列包含数值数据时。 -

animation_frame='year_added':这个参数在'year_added'列上创建动画。它在地图图表中添加一个年份滑块,允许你查看表示各国内容生产演变的动画。 -

projection='natural earth':这个参数没有使用df_countsDataFrame 中的任何列;然而,'natural earth'值用于设置地球世界地图的投影。

在层析图地图下方,还包含了一个带标记的折线图,展示了内容数量的变化情况,按类型(电视节目或电影)分类,显示多年变化。

为了生成折线图,创建了一个新的 DataFramedf_year_counts,该 DataFrame 通过'year_added'和'type'列对原始df数据进行分组,统计每种组合的内容数量。

然后使用px.line处理这些分组数据,其中'x'和'y'参数分别分配给'year_added'和'count'列,'color'参数设置为'type'以区分电视节目和电影。

内容分类可视化

下一步是创建一个名为 content_classification.py的新文件,该文件将生成一个树图图表,以从类型和类别的角度可视化 Netflix 的内容:

import pandas as pd

import plotly.express as px

from dash import dcc, html

df = pd.read_csv('netflix_titles.csv')

# Split the listed_in column and explode to handle multiple genres

df['listed_in'] = df['listed_in'].str.split(', ')

df = df.explode('listed_in')

# Compute the count of each combination of type and genre

df_counts = df.groupby(['type', 'listed_in']).size().reset_index(name='count')

fig = px.treemap(df_counts, path=['type', 'listed_in'], values='count', color='count',

color_continuous_scale='Ice', title='Content by type and genre')

fig.update_layout(width=1280, height=960, title_x=0.5)

fig.update_traces(textinfo='label+percent entry', textfont_size=14)

layout = html.Div([

dcc.Graph(figure=fig),

])

在上述代码中,数据加载后,对'listed_in'列进行调整,通过拆分和展开每个内容的多种类型来处理多个类型,为每个类型创建一个新行。

接下来,创建df_counts DataFrame,以'type'和'listed_in'列对数据进行分组,并计算每种类型-类别组合的数量。

然后,将df_counts DataFrame 中的列用作px.treemap函数参数的值,如下所示:

-

path=['type', 'listed_in']:这些是树图中表示的层次类别。'type'和'listed_in'列分别包含内容的类型(电视节目或电影)和类别。 -

values='count':树图中每个矩形的大小对应于'count'列,表示每种类型-类别组合的内容数量。 -

color='count':'count'列也用于为树图中的矩形着色。 -

color_continous_scale='Ice':当由color表示的列包含数字数据时,为树图中的每个矩形构建一个连续的颜色刻度。

在创建了两个新的可视化文件后,你当前的项目结构应该如下所示:

netflix-dashboard

├── app.py

├── clean_netflix_dataset.py

├── components

│ ├── content_classification.py

│ └── geographical_content.py

├── netflix-venv

│ ├── bin

│ ├── etc

│ ├── include

│ ├── lib

│ ├── pyvenv.cfg

│ └── share

└── netflix_titles.csv

实现回调函数

最后一步是修改app.py,以导入components目录中的两个新可视化,并实现回调函数,以在选择标签时渲染图表:

from dash import Dash, dcc, html, Input, Output

import dash_bootstrap_components as dbc

from components import (

geographical_content,

content_classification

)

app = Dash(__name__, external_stylesheets=[dbc.themes.BOOTSTRAP])

app.layout = dbc.Container(

[

dcc.Store(id='store'),

html.H1('Netflix Movies and TV Shows Dashboard'),

html.Hr(),

dbc.Tabs(

[

dbc.Tab(label='Geographical content distribution', tab_id='tab1'),

dbc.Tab(label='Content classification', tab_id='tab2'),

],

id='tabs',

active_tab='tab1',

),

html.Div(id='tab-content', className='p-4'),

]

)

# This callback function switches between tabs in a dashboard based on user selection.

# It updates the 'tab-content' component with the layout of the newly selected tab.

@app.callback(Output('tab-content', 'children'), [Input('tabs', 'active_tab')])

def switch_tab(at):

if at == 'tab1':

return geographical_content.layout

elif at == 'tab2':

return content_classification.layout

if __name__ == '__main__':

app.run(debug=True)

回调装饰器@app.callback监听'tabs'组件的'active_tab'属性的变化,由Input对象表示。

每当'active_tab'发生变化时,switch_tab函数会被触发。这个函数检查'active_tab'的 id,并返回要在'tab-content' Div 中渲染的相应布局,如Output对象所示。因此,当你切换标签时,相关的可视化会出现。

最后,再次运行app.py以查看包含新可视化的更新仪表板:

Netflix 电影和电视节目仪表板 — 最终结果

总结

本文教会了您如何创建一个仪表板来探索和可视化 Netflix 的内容分布和分类。通过利用 Python 和 Dash 的力量,您现在已经能够创建自己的可视化,从而为您的数据提供宝贵的洞察。

您可以在以下 GitHub 仓库查看此项目的完整代码:github.com/gutyoh/netflix-dashboard

如果您觉得这篇文章对您有帮助,并且想扩展对 Python 和数据科学的知识,考虑查看 Hyperskill 上的数据科学入门课程。

如果您对本博客有任何问题或反馈,请在下面的评论中告诉我。

赫尔曼·罗斯 是 Hyperskill Go 编程课程的技术作者,他将对教育科技的热情与赋能下一代软件工程师的使命融合在一起。同时,作为伊利诺伊大学厄本那-香槟分校的硕士生,他还深入数据领域。

原始. 经许可转载。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

进一步阅读此主题

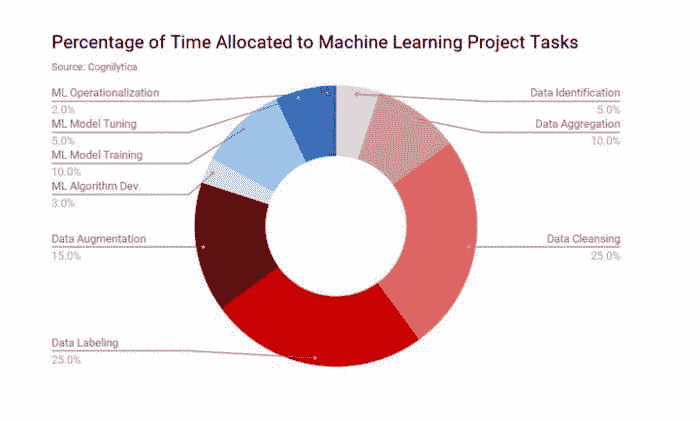

如何为机器学习创建数据集

原文:

www.kdnuggets.com/2022/02/create-dataset-machine-learning.html

为什么为机器学习(ML)创建数据集很重要

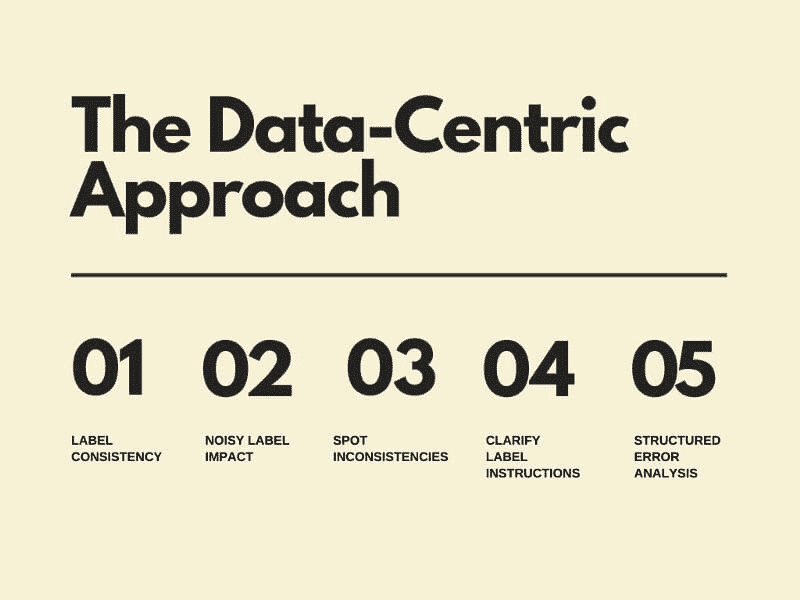

一些非凡的事情正在发生。

算法领域的入门门槛正在逐日降低。这意味着任何拥有正确目标和技能的人都可以找到适用于机器学习(ML)和人工智能(AI)任务的优秀算法——计算机视觉、自然语言处理、推荐系统,甚至是自动驾驶。

开源计算已经取得了长足的进展,许多开源倡议推动了数据科学、数字分析和 ML 的发展。大学和企业研发实验室的研究人员每天都在创造新的算法和 ML 技术。我们可以放心地说,算法、编程框架、ML 包,甚至是学习这些技术的教程和课程已经不再是稀缺资源。

但高质量数据确实是稀缺的。数据集——经过妥善策划和标注的——仍然是稀缺资源。

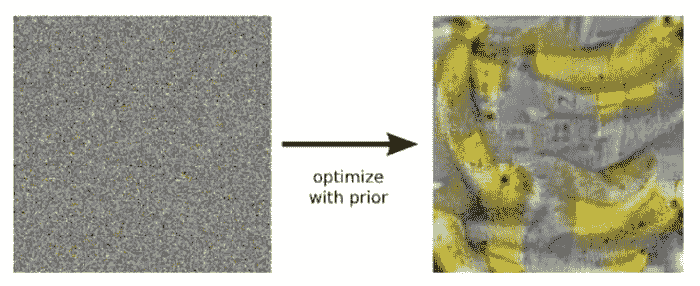

图 1:算法太多,但几乎没有好的数据集

高质量数据即使在基本 ML 任务中也很具有挑战性

通常,讨论的重点不是如何为你正在开发的酷炫 AI 驱动的旅行或时尚应用获取高质量数据。这类消费者、社交或行为数据的收集本身就存在问题。

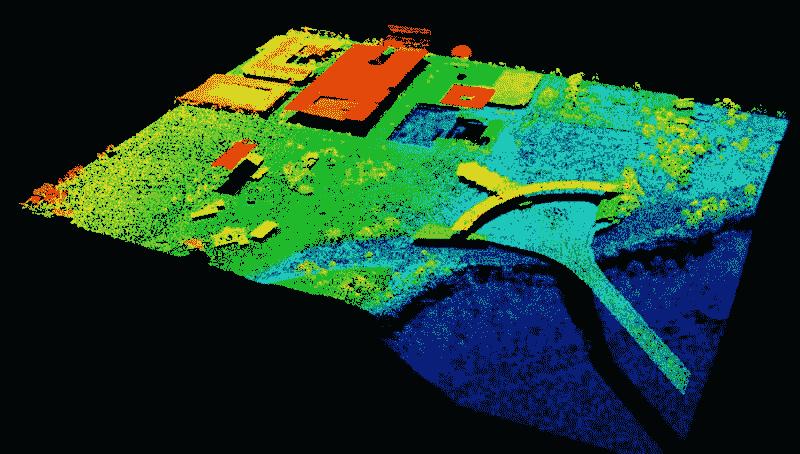

每个应用领域都有其特定的数据需求挑战,例如,自主驾驶车辆所需的 LiDAR 数据需要特定的 3D 点云数据集来进行对象识别和语义分割,这些数据集非常难以人工标注。

图 2:一个 LiDAR 3D 点云数据集 - 训练时极难手动标注。图片 来源于此论文

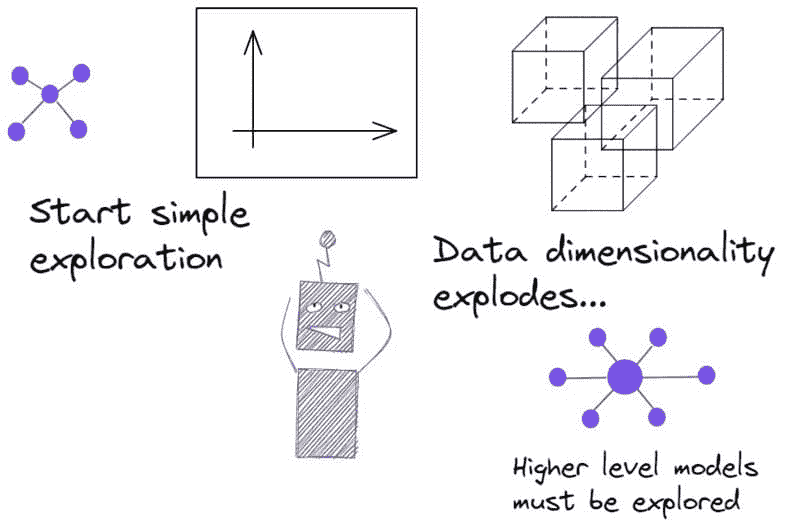

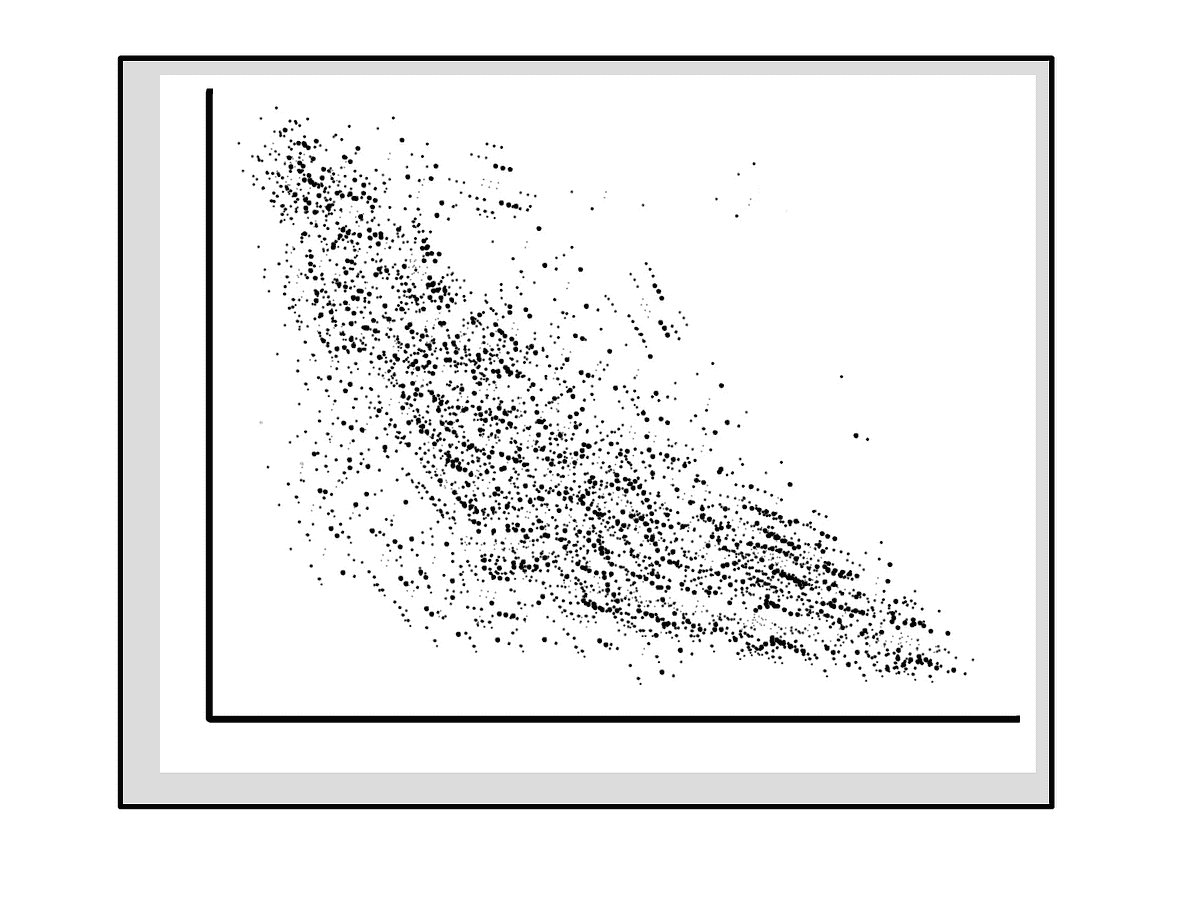

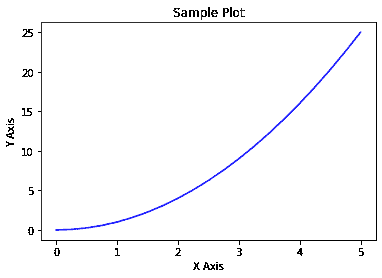

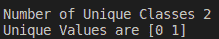

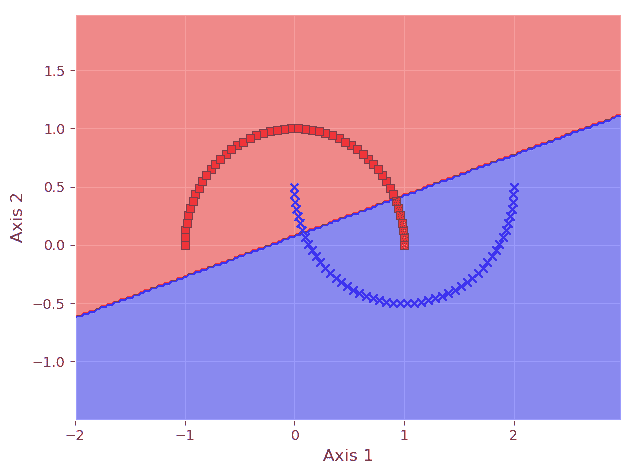

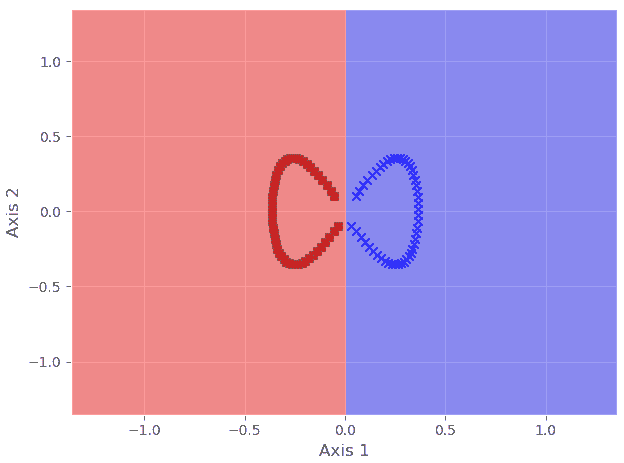

然而,即使获得用于基本 ML 算法测试和构思的高质量数据集也是一种挑战。假设一位 ML 工程师从头开始学习,最理智的建议是从简单的小规模数据集入手,他/她可以将数据绘制在二维平面上,以直观地理解数据模式,并以直观的方式查看 ML 算法的内部工作方式。然而,随着数据维度的增加,视觉判断必须扩展到更复杂的领域——例如学习和样本复杂性、计算效率、类别不平衡等概念。

图 3:数据和机器学习模型的探索从简单开始——然后爆炸。数据集也必须不断演变。

合成数据集的救援

人们总是可以通过实验来评估和调整机器学习算法,获取真实数据集或生成数据点。然而,使用固定的数据集时,样本数量、潜在模式和正负样本之间的类别分离度都是固定的。这样的固定数据集无法测试或评估机器学习算法的许多方面。以下是一些例子:

-

测试数据和训练数据的比例如何影响算法的性能和鲁棒性

-

在不同程度的类别不平衡面前,指标的鲁棒性如何

-

必须进行哪些类型的偏差-方差权衡

-

算法在训练数据和测试数据中的各种噪声特征下的表现(即标签和特征集中的噪声)

合成数据集在所有这些情况下都能派上用场。合成数据是通过人工制造而非真实世界事件生成的信息。这种数据最适合用于模型的简单验证,但也用于帮助训练。合成数据集的潜在好处在于敏感应用——医学分类或金融建模,在这些领域中,获取高质量标注数据集通常是昂贵且禁止的。

适用于机器学习的好数据集的特征(合成的或真实的)

合成数据集是通过程序生成的,真实数据集则来源于各种渠道——社交或科学实验、医疗治疗历史、商业交易数据、网页浏览活动、传感器读数或自动摄像机或激光雷达拍摄的图像的人工标记。不论来源如何,数据集都应该具备一些理想的特征,以便对机器学习算法的开发和性能调整具有价值。

以下是一些例子:

-

数据集应具有数字、二进制或分类(有序或无序)特征的混合,并且特征的数量和数据集的长度应当具有一定的复杂性

-

对于合成数据,应该以可控的方式注入随机噪声

-

数据集必须具备一定的随机性

-

如果是合成的,用户应该能够选择多种统计分布来生成这些数据,即底层的随机过程/参数可以精确控制和调整

-

如果用于分类算法,则类别分离度应足够大,以实现良好的分类准确性,但也不应过大,以免使问题变得简单。对于合成数据,这应当是可控的,以便将学习问题设置为简单或困难

-

生成速度应相当高,以便对特定机器学习算法进行大量不同数据集的实验,即如果合成数据基于真实数据集的数据增强,则增强算法必须计算高效。

-

对于真实数据集,数据生成成本应低且过程应资源高效,以确保机器学习训练不会过度影响业务目标。

-

对于回归问题,可以使用复杂的非线性生成过程来获取数据——真实物理模型或物理过程的计算机模拟可以帮助实现这一目标。

回归、分类和聚类数据集创建用于机器学习

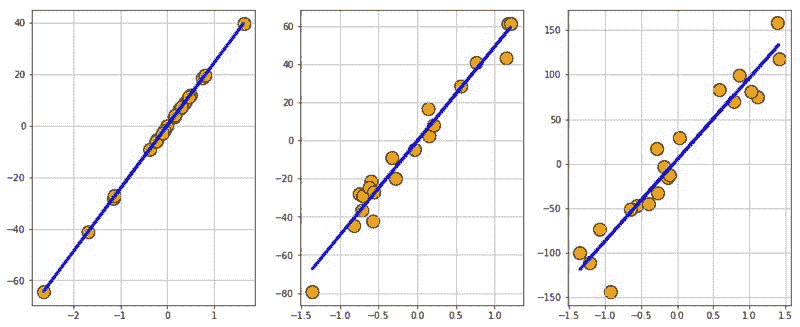

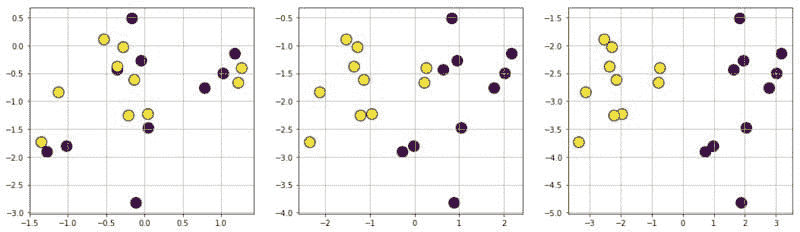

Scikit-learn 是基于 Python 的数据科学软件栈中最流行的机器学习库。除了优化的机器学习例程和管道构建方法外,它还拥有丰富的合成数据生成工具。我们可以创建各种数据集用于常规机器学习算法训练和调优。

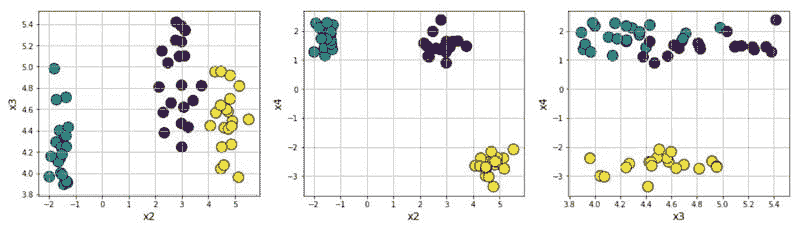

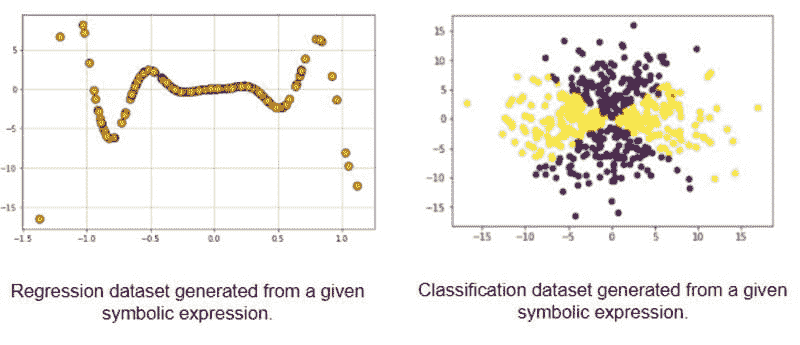

图 4:使用 Scikit-learn 创建的回归数据集。

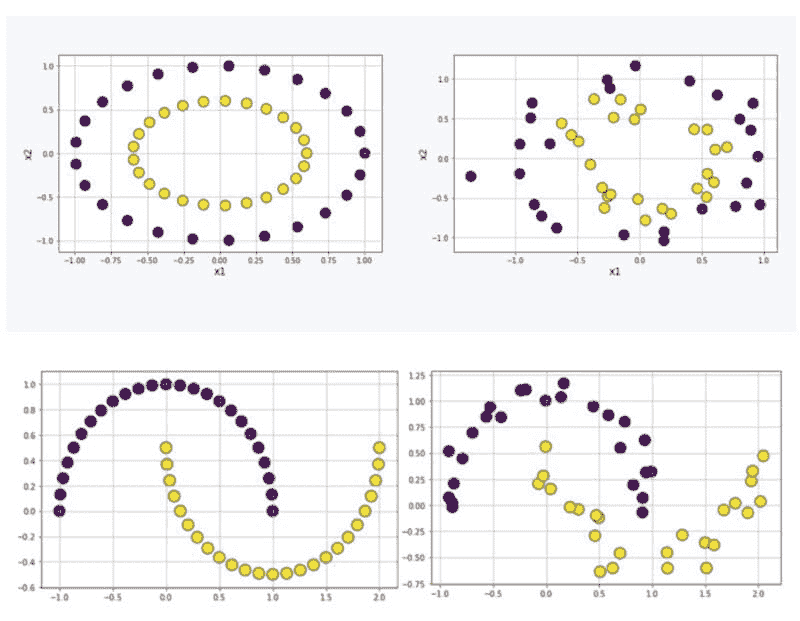

图 5:使用 Scikit-learn 创建的分类数据集。

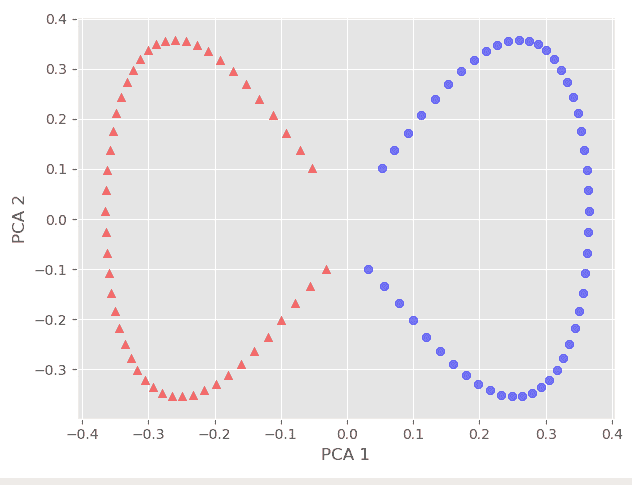

图 6:使用 Scikit-learn 创建的聚类数据集。

图 7:用于测试基于核的算法的非线性数据集。

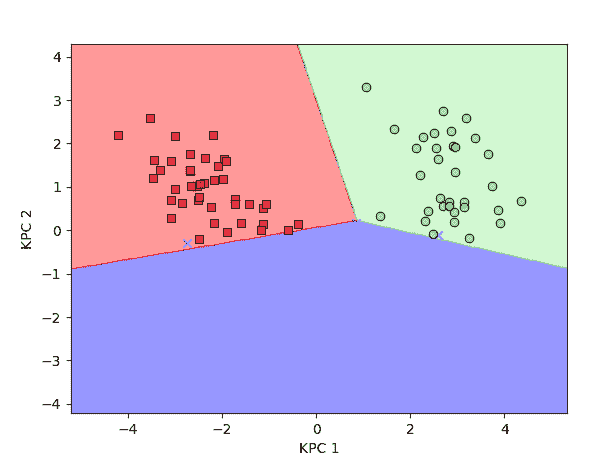

高斯混合模型

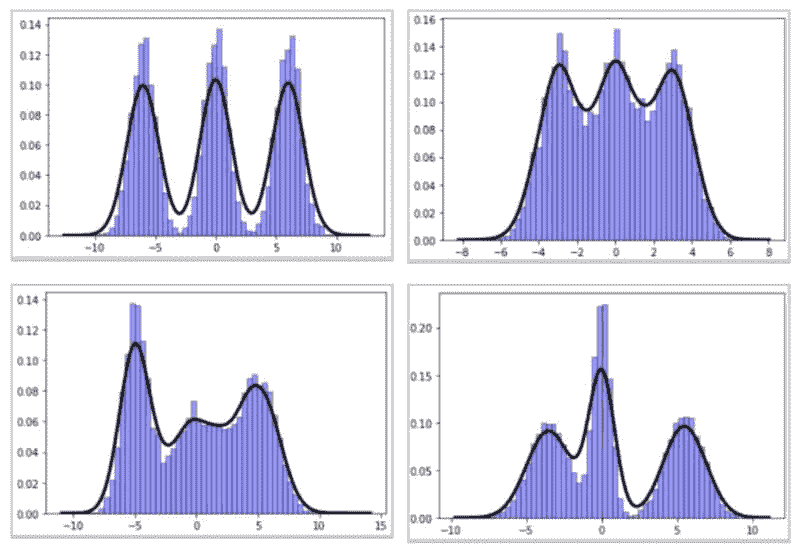

高斯混合模型(GMM)是非常有趣的研究对象。它们在无监督学习和主题建模领域被广泛使用,特别是在大规模文本处理/自然语言处理任务中。即使在自动驾驶和机器人导航算法中,它们也有许多应用。只需少量代码,就可以创建有趣的数据集,模拟具有任意形状和复杂性的 GMM 过程。

以下是一些相同的合成数据示例:

图 8:合成创建的高斯混合模型数据集。

从符号表达式生成数据集