KDNuggets-博客中文翻译-九-

KDNuggets 博客中文翻译(九)

原文:KDNuggets

2020 年最佳 GIS 课程

评论 来源

来源

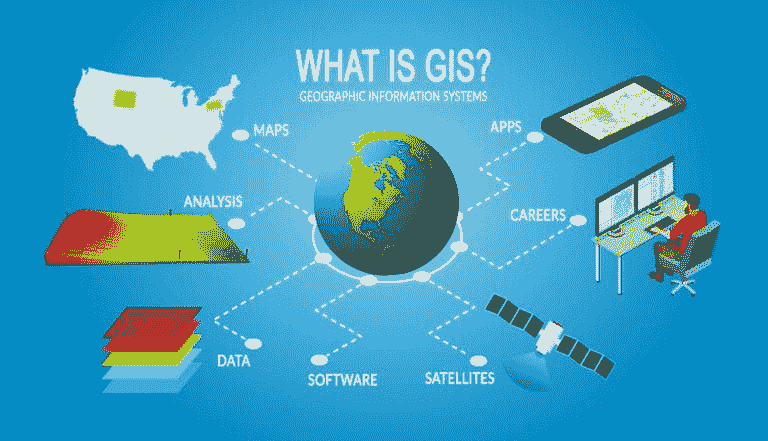

地理信息系统分析是对空间关系和模式的分析。随着物联网(IoT)的兴起,空间组件被融入社会,更多的数据可以连接,并且很可能具有时空组件。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 需求

2020 年,GIS 分析在主流数据科学领域中出现得越来越频繁。由于新冠疫情,分析师们纷纷使用地图 API 来快速可视化并总结他们的发现。相比于金融、制造和营销,GIS 在数据科学领域并不是大众的默认选择。

1. Mike Miller 在 Udemy 上的课程

这不是一门课程,而是一个提供各种关于 GIS 课程的讲师。

Mike Miller 是一位 GIS 网页程序员,他提供 YouTube 教程,并在 Udemy 上有一系列关于使用 php、QGIS、PostGIS 和 leaflet.js 等技术的 GIS 应用程序网页编程课程可供购买。

2. Esri 提供的免费课程

对于 GIS 领域的人来说,Esri 无需多介绍。Esri 是 GIS 软件 ArcGIS 的主要服务提供商。与 QGIS 和 CARTO 一起,它是市场上前三大 GIS 软件之一。

在 ESRI 课程网站中,简单地筛选可用的免费课程。来自 ESRI 的课程自然会围绕使用 ArcGIS 进行,因此你需要获取该软件才能参加这些课程。

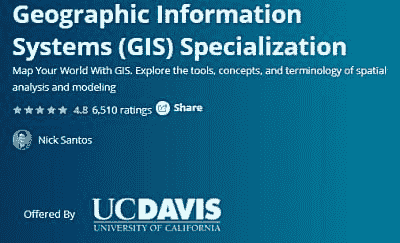

3. UC Davis 地理信息系统(GIS)专业化课程

这门课程与 Esri 合作开发,使用 ArcGIS。在整个课程中,学生可以学习基础的空间分析以及卫星影像分析。这是一个面向初学者的课程。

4. 延世大学的空间数据科学与应用

来源

来源

这门课程将探讨 GIS 的数据科学方面,并使用 QGIS、R、POSTGIS、POSTGRESQL 和 Hadoop 等多种技术。该课程将使用更多开源软件如 QGIS 和 R,因此可以被更广泛的受众访问。

该课程面向的是中级水平的学生,需要你已经参加过更基础或初级的课程才能跟上进度。

相关:

-

R、SQL 和 Tableau 中的犯罪数据地理时间序列预测入门

-

OpenStreetMap 数据到 ML 训练标签用于目标检测

-

Python、Selenium 和 Google 用于地理编码自动化:免费和付费

更多相关话题

最佳 Instagram 账号推荐:数据科学、机器学习与人工智能

原文:

www.kdnuggets.com/2022/08/best-instagram-accounts-follow-data-science-machine-learning-ai.html

图片由编辑提供

很多人使用 Instagram —— 如果它还不是,那么它肯定是最顶尖的社交媒体应用之一。我做的一件事就是关注关于数据科学、机器学习和人工智能的 Instagram 账号。

我们的前 3 名课程推荐

1. 谷歌网络安全证书 - 快速入门网络安全职业。

1. 谷歌网络安全证书 - 快速入门网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

我也关注其他类型的内容,但当我看到代码、需要解决的问题或理论知识时,这会刺激我的大脑。这让我理解我知道什么以及我需要进一步学习的内容。

我整理了这篇博客,以帮助你找到应该关注的 Instagram 账号,从而获取最佳的数据科学、机器学习和人工智能内容。

@GitHub

如果你还没有使用 GitHub,GitHub 是一个用于版本控制、软件开发和协作的代码托管平台。他们的页面涵盖了所有相关的软技能和硬技能——使其成为数据科学初学者的好 Instagram 页面。当你点击他们简历中的链接时,你可以进一步探索每个帖子以及详细的博客——适合喜欢简化和详细信息的人。

@itsthatlady.dev

如果你刚刚进入开发行业,需要一些额外的指导 —— @itsthatlady.dev 的 Kadesha 是一个很棒的 Instagram 账号。她提供职业建议和各种资源给技术新手。她会指导你应选择哪些最佳路径,包括哪个地点适合工作、应该参加哪些培训项目等等。如果你想要一些互动性更强的内容,有人与你对话 —— 这是适合你的页面!

@madewithcode

由 Google 创建的 Instagram 页面,旨在激励女孩编程。我们都知道技术行业男性主导,这使得女性在进入行业时感到不太舒适。该页面庆祝在技术行业中的女性,并展示她们如何激励各年龄段的女性进入这一行业。他们还与 Teen Vogue 合作,鼓励高中和大学女生更有兴趣追求技术职业。

@NvidiaAI

如果你对 AI 特别感兴趣,并且想了解 Nvidia 当前的进展——这是一个有趣的页面。它会为你提供关于他们新产品的丰富内容,介绍他们的成就以及可能的未来方向。他们还会发布即将举行的活动和工作坊,这是一种保持信息更新、建立网络和发展职业生涯的好方式。你还可以了解到其他人如何使用 NvidiaAI 创新他们当前的业务,使用 #IAMAI 标签,可能会指导你找到适合你的商业方向或创业目标。

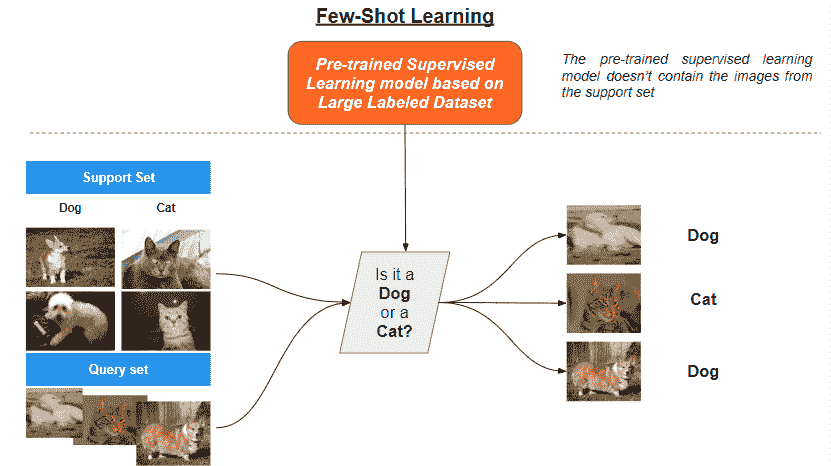

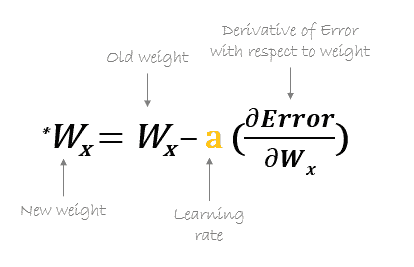

@learn.machinelearning

如果你在寻找直接的机器学习知识,并且对学习更多感兴趣——这是一个理想的页面。Uday Kiran 是该页面的创始人,他们的目标是帮助人们入门机器学习。内容涵盖了机器学习的一切,从如何入门到机器学习的解释,甚至是像 Google 和 Snapchat 这样的公司如何使用机器学习。你还可以通过测验来测试你的知识,获取项目创意和技巧!

@machinelearning

另一个学习机器学习的页面是 machinelearning!他们的目标是以直观的方式呈现机器学习。他们也可以在 Medium 和 YouTube 上找到。我个人喜欢他们内容在格式和展示上的一致性。他们提供关于各种主题的简洁但信息丰富的幻灯片,例如统计学、数学、数据科学等!他们有超过 100 篇帖子,以及在 Medium 和 YouTube 上的内容供你学习。

@python.learning

如果你选择了 Python 作为你的编程语言,这是一个值得关注的 Instagram 页面。它为你提供了职业信息、不同的课程、机器学习的理论知识以及更多内容。更棒的是,为了让你的编程职业生涯更加顺利,它还不断更新一些幽默的段子,帮助你度过学习新编程语言的过渡期。边学习边笑一笑是没有问题的。

@neuralnet.ai

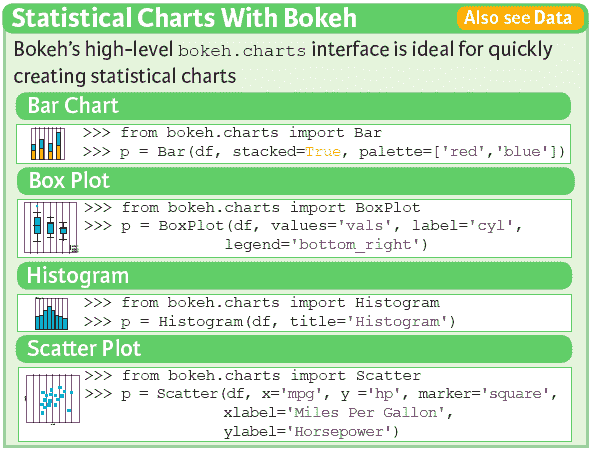

如果你对神经网络和提升深度学习知识感兴趣——你找到了你的页面!类似于 @machinelearning,这个页面的表现一致性吸引了我的注意。他们提供了良好的可视化,内容简单但重要,有助于你扩展深度学习的知识。他们还有一个 GitHub 页面、用于测试你对深度学习理解的测验,并且引导你阅读他们认为最好的机器学习书籍:动手实践机器学习:Scikit-Learn、Keras 和 TensorFlow。

结论

如果你偶尔在 Instagram 上浏览,关注其中一些页面将帮助你保持在技术领域的领先地位,并帮助你弄清楚下一步该做什么。Instagram 上还有很多其他页面,如果你知道哪些好的页面,请在下面的评论中分享,以便其他人可以改进他们在数据科学、机器学习和人工智能方面的旅程。

尼莎·阿利亚 是一名数据科学家和自由撰稿人。她特别关注提供数据科学职业建议或教程,以及围绕数据科学的理论知识。她还希望探索人工智能在延长人类寿命方面的不同方式。作为一个热衷于学习的人,她寻求拓宽自己的技术知识和写作技能,同时帮助引导他人。

更多相关主题

2022 年数据科学最佳学习资源

原文:

www.kdnuggets.com/2022/01/best-learning-resources-data-science-2022.html

作者图片 | 照片由 jannoon028 提供

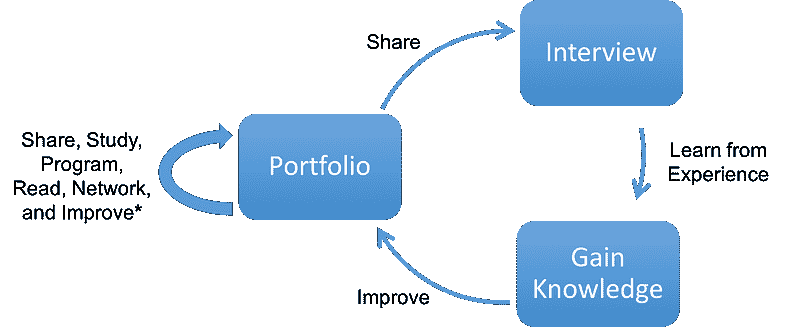

当我开始我的数据科学职业生涯时,我对从哪里开始、学习什么或哪些课程最好感到困惑。简单的谷歌搜索无法帮助你,你可能会浪费很多时间寻找合适的资源。在经历了这种困难之后,我向自己承诺要简化事情,以帮助他人。这个博客包含了帮助你快速启动职业生涯的最佳书籍、课程、平台、认证和社交网络的列表。

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力。

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作。

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作。

书籍

作者图片

有些人喜欢阅读书籍,因此今年有一些有趣的书籍可供选择。在我们跳到书单之前,花点时间问问自己喜欢哪种编程语言。大多数人会选择Python,但R和Julia也非常受欢迎,因为它们都是为数据科学设计的。

初级水平: 数据分析的 Python:使用 Pandas、NumPy 和 IPython 进行数据整理

中级水平: 数据科学实用统计学

R 爱好者: 数据科学中的 R

未来语言: Julia 数据科学

课程

作者图片

我的旅程开始于 Codecademy 和 DataCamp 的课程,这些课程教会了我 Python、R、SQL 和统计学的基础知识。我强烈建议初学者尝试任何数据科学课程,并尽量按时完成。

以下列表包含免费课程、付费课程和短期教程。这些课程将帮助你建立坚实的基础,以便开始进行实际的数据项目。

免费课程

付费课程

-

Udacity: 学习成为数据科学家在线课程

-

DataCamp: Python 数据科学家轨迹

-

Coursera: IBM 数据科学专业证书

-

Codecademy: 数据科学家职业路径

教程

平台

作者提供的图像

如果我在开始数据科学之旅之前就知道Kaggle,我的生活会更轻松。这些平台提供示例、简单的指南以及进行实验的能力。你可以从笔记本中学习,或与专家数据科学社区讨论想法。

如果你想在数据科学和机器学习领域取得成功,只需在 Kaggle 上创建一个账户,并开始参与各种讨论。同时,创建一个GitHub账户,从更大的开发者社区中学习。

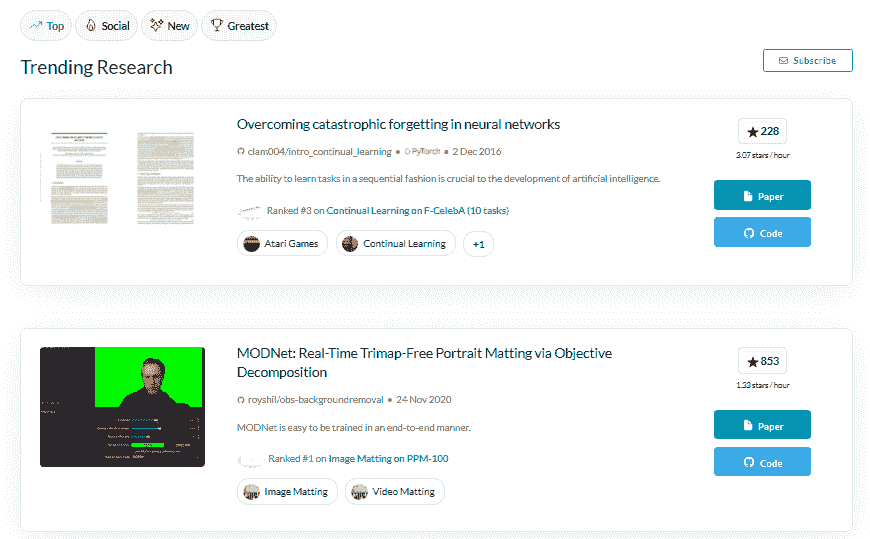

附加: 使用 Paperswithcode 和 DAGsHub 学习应用机器学习。

博客

图像来自 freepik

数据科学博客提供了关于特定工具、新概念和适合初学者的教程的简短信息。在完成几个课程后,我立刻爱上了 Towards Data Science 和 Analytics Vidhya 上易于跟随的博客。它们仍在帮助我在数据分析和机器学习方面不断进步。

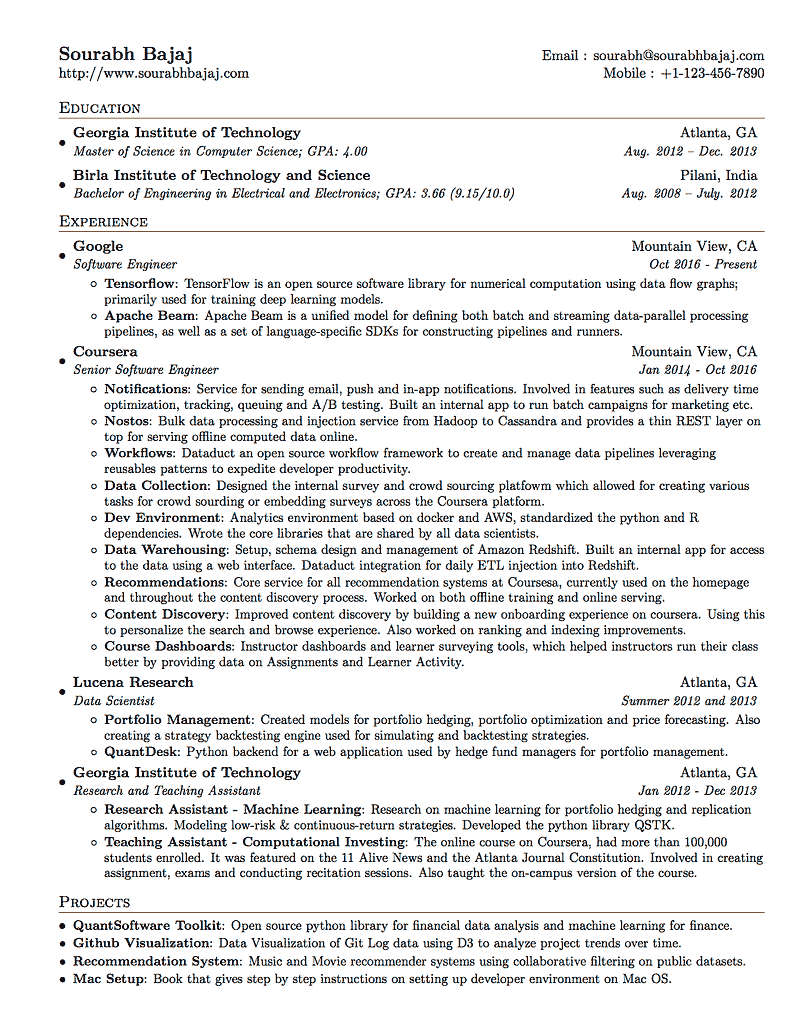

认证

作者提供的示例证书

如果你没有数据科学学位,认证将为你在求职市场上提供优势。目前大多数平台都提供认证考试,许多认证是值得的。

这些认证考试将考察你在数据分析、编程技能、统计思维、建模和展示方面的能力。

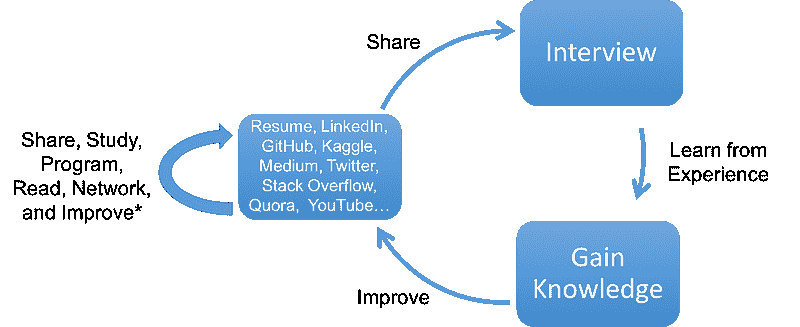

数据社交网络

作者提供的图片 | 元素来源于 freepik

你如何保持对不断变化的数据科学领域的更新?通过关注专家、影响者或加入数据科学社交网络。这些社交网络包括 Discord(Learn AI Together)、LinkedIn、Twitter、Dev.to 和 Reddit(r/datascience)。

结论

我收到了很多直接消息和邮件,询问“如何开始学习数据科学。”大多数人说,他们认为如果能够学会基础知识,就能开始赚取六位数的薪水,这种心态是错误的。因此,如果你是为了错误的理由去做这件事,我建议你在这里停止,开始寻找你喜欢的事物。这个过程会变得困难,你会失去方向。简而言之,你将浪费时间和金钱去做你不喜欢的事情。

在这篇博客中,我们了解了最佳的学习资源和平台。开始关注 Twitter 或 LinkedIn 上的数据影响者,在 Kaggle 上创建一个账户,从一个免费的课程开始,然后完成一个付费课程,以深入了解机器学习和最佳编码实践。

"数据科学需要奉献和努力工作。"

Abid Ali Awan (@1abidaliawan) 是一位认证的数据科学专业人士,喜欢构建机器学习模型。目前,他专注于内容创作和撰写有关机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是使用图神经网络为那些面临心理健康困扰的学生开发一个 AI 产品。

更多相关内容

Scikit-learn 的最佳机器学习框架和扩展

原文:

www.kdnuggets.com/2021/03/best-machine-learning-frameworks-extensions-scikit-learn.html

评论

很多包实现了 Scikit-learn 估算器 API。

如果你已经熟悉 Scikit-learn,你会发现这些库的集成非常简单。

使用这些包,我们可以扩展 Scikit-learn 估算器的功能,我将在这篇文章中展示如何使用其中一些。

数据格式

在这一部分,我们将探索可以用于处理和转换数据的库。

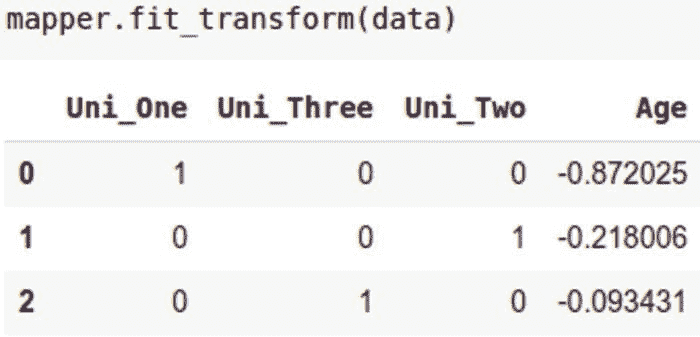

Sklearn-pandas

你可以使用这个包将 ‘DataFrame’ 列映射到 Scikit-learn 转换中。然后你可以将这些列组合成特征。

要开始使用这个包,通过 pip 安装 ‘sklearn-pandas’。‘DataFrameMapper’ 可用于将 pandas 数据帧列映射到 Scikit-learn 转换中。我们来看看怎么做。

首先,创建一个虚拟 DataFrame:

data =pd.DataFrame({

'Name':['Ken','Jeff','John','Mike','Andrew','Ann','Sylvia','Dorothy','Emily','Loyford'],

'Age':[31,52,56,12,45,50,78,85,46,135],

'Phone':[52,79,80,75,43,125,74,44,85,45],

'Uni':['One','Two','Three','One','Two','Three','One','Two','Three','One']

})

DataFrameMapper 接受一个元组列表——第一个项的名称是 Pandas DataFrame 中的列名。

第二个传递的项是将应用于该列的转换类型。

例如,‘LabelBinarizer’ 可以应用于 ‘Uni’ 列,而 ‘Age’ 列则使用 ‘StandardScaler’ 进行缩放。

from sklearn_pandas import DataFrameMapper mapper = DataFrameMapper([

('Uni', sklearn.preprocessing.LabelBinarizer()),

(['Age'], sklearn.preprocessing.StandardScaler())

])

在定义映射器之后,接下来我们使用它来拟合和转换数据。

mapper.fit_transform(data)

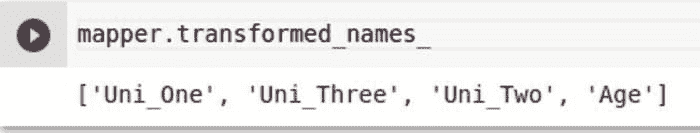

映射器的 transformed_names_ 属性可用于显示转换后的结果名称。

mapper.transformed_names_

传递df_out=True给映射器将把结果返回为 Pandas DataFrame。

mapper = DataFrameMapper([

('Uni', sklearn.preprocessing.LabelBinarizer()),

(['Age'], sklearn.preprocessing.StandardScaler())

],df_out=True)

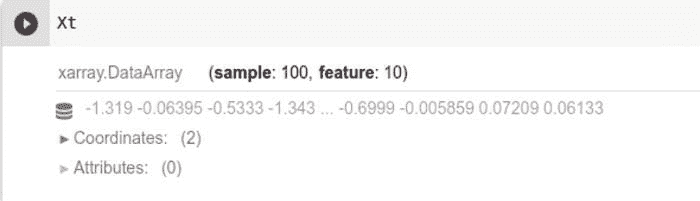

Sklearn-xarray

这个包将来自 xarray 的 n 维标记数组与 Scikit-learn 工具结合起来。

你可以将 Scikit-learn 估算器应用于 ‘xarrays’,而不会丢失它们的标签。你还可以:

-

确保 Sklearn 估算器与 xarray DataArrays 和 Datasets 之间的兼容性,

-

使估算器能够更改样本数量,

-

具有预处理转换器。

Sklearn-xarray 基本上是 xarray 和 Scikit-learn 之间的桥梁。为了使用其功能,通过 pip 或 ‘conda’ 安装 ‘sklearn-xarray’。

该包具有包装器,可以让你在 xarray DataArrays 和 Datasets 上使用 sklearn 估算器。为了说明这一点,首先我们创建一个 ‘DataArray’。

import numpy as np

import xarray as xr

data = np.random.rand(16, 4)

my_xarray = xr.DataArray(data)

从 Sklearn 中选择一种转换应用于此 ‘DataArray’。在这种情况下,我们来应用 ‘StandardScaler’。

from sklearn.preprocessing import StandardScaler

Xt = wrap(StandardScaler()).fit_transform(X)

包装的估算器可以无缝地在 Sklearn 管道中使用。

pipeline = Pipeline([

('pca', wrap(PCA(n_components=50), reshapes='feature')),

('cls', wrap(LogisticRegression(), reshapes='feature'))

])

在拟合此管道时,您只需传入 DataArray。

类似地,DataArrays 可以在交叉验证网格搜索中使用。

为此,您需要从 ‘sklearn-xarray’ 创建一个 ‘CrossValidatorWrapper’ 实例。

from sklearn_xarray.model_selection

import CrossValidatorWrapper from sklearn.model_selection

import GridSearchCV, KFold

cv = CrossValidatorWrapper(KFold())

pipeline = Pipeline([

('pca', wrap(PCA(), reshapes='feature')),

('cls', wrap(LogisticRegression(), reshapes='feature'))

])

gridsearch = GridSearchCV(

pipeline, cv=cv, param_grid={'pca__n_components': [20, 40, 60]}

)

之后,您将把 ‘gridsearch’ 拟合到 ‘DataArray’ 数据类型中的 X 和 y。

自动化机器学习

是否有工具和库可以将 Sklearn 集成以更好地进行自动化机器学习?是的,有一些例子。

Auto-sklearn

通过这个,您可以使用 Scikit-learn 进行自动化机器学习。对于设置,您需要手动安装一些依赖项。

$ curl https://raw.githubusercontent.com/automl/auto-sklearn/master/requirements.txt | xargs -n 1 -L 1 pip install

接下来,通过 pip 安装 ‘auto-sklearn’。

使用此工具时,您无需担心算法选择和超参数调整。Auto-sklearn 会为您处理这些。

这是得益于最新进展在贝叶斯优化、元学习和集成构建领域。

要使用它,您需要选择一个分类器或回归器,并将其拟合到训练集上。

from autosklearn.classification

import AutoSklearnClassifier

cls = AutoSklearnClassifier()

cls.fit(X_train, y_train)

predictions = cls.predict(X_test)

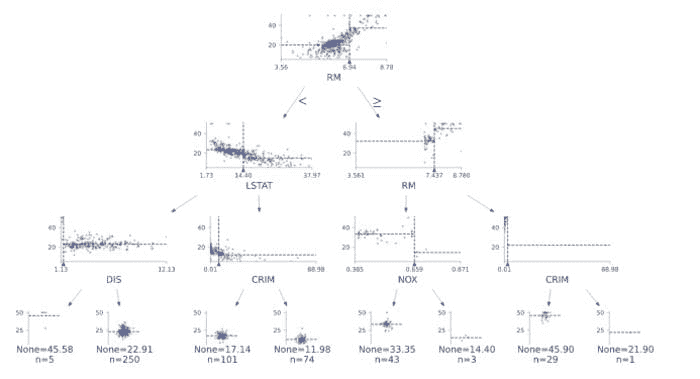

Auto_ViML – 自动化变体可解释机器学习(发音为 “Auto_Vimal”)

给定某个数据集,Auto_ViML 尝试不同的模型和特征,最终选定表现最佳的模型。

该软件包还会在构建模型时选择最少数量的特征。这会为您提供一个更简单且易于解释的模型。该软件包还:

-

通过建议更改缺失值、格式和添加变量来帮助您清理数据;

-

自动分类变量,无论是文本、数据还是数字;

-

当详细信息设置为 1 或 2 时,会自动生成模型性能图;

-

让您使用 ‘featuretools’ 进行特征工程;

-

当 ‘Imbalanced_Flag’ 设置为 ‘True’ 时,处理不平衡数据

要查看实际效果,请通过 pip 安装 ‘autoviml’。

from sklearn.model_selection import train_test_split, cross_validate

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.1, random_state=42)

X_train, X_val, y_train, y_val = train_test_split(X_train, y_train, test_size=0.25, random_state=54)

train, test = X_train.join(y_train), X_val.join(y_val)

model, features, train, test = Auto_ViML(train,"target",test,verbose=2)

TPOT – 基于树的管道优化工具

这是一个基于 Python 的自动化机器学习工具。它使用遗传编程来优化机器学习管道。

它探索多个管道以便选出最适合您的数据集的管道。

通过 pip 安装 ‘tpot’ 开始进行尝试。运行 ‘tpot’ 后,您可以将生成的管道保存到文件中。文件将在探索过程完成后或当您终止过程时导出。

下面的代码片段展示了如何在数字数据集上创建分类管道。

from tpot import TPOTClassifier

from sklearn.datasets import load_digits

from sklearn.model_selection import train_test_split

digits = load_digits()

X_train, X_test, y_train, y_test = train_test_split(digits.data, digits.target, train_size=0.75, test_size=0.25, random_state=42)

tpot = TPOTClassifier(generations=5, population_size=50, verbosity=2, random_state=42)

tpot.fit(X_train, y_train)

print(tpot.score(X_test, y_test))

tpot.export('tpot_digits_pipeline.py')

Feature Tools

这是一个自动特征工程的工具。它通过将时间序列和关系数据集转换为特征矩阵来工作。

通过 pip 安装‘featuretools[complete]’以开始使用它。

深度特征合成(DFS)可以用于自动特征工程。

首先,你需要定义一个包含数据集中所有实体的字典。在‘featuretools’中,实体是一个单独的表。然后,定义不同实体之间的关系。

下一步是将实体、关系列表和目标实体传递给 DFS。这将为你提供特征矩阵及其对应的特征定义列表。

import featuretools as ft

entities = {

"customers" : (customers_df, "customer_id"),

"sessions" : (sessions_df, "session_id", "session_start"),

"transactions" : (transactions_df, "transaction_id", "transaction_time")

}

relationships = [("sessions", "session_id", "transactions", "session_id"),

("customers", "customer_id", "sessions", "customer_id")]

feature_matrix, features_defs = ft.dfs(entities=entities,

relationships = relationships,

target_entity = "customers")

Neuraxle

你可以使用 Neuraxle 进行超参数调优和 AutoML。通过 pip 安装‘neuraxle’以开始使用它。

除了 Scikit-learn,Neuraxle 还兼容 Keras、TensorFlow 和 PyTorch。它还具有:

-

并行计算和序列化,

-

通过提供对这类项目至关重要的抽象来处理时间序列。

要使用 Neuraxle 进行自动化机器学习,你需要:

-

一个定义好的管道

-

一个验证分割器

-

通过‘ScoringCallback’定义评分指标

-

选择的‘hyperparams’仓库

-

选择的‘hyperparams’优化器

-

一个‘AutoML’循环

完整的示例请查看这里。

实验框架

现在是时候介绍几个你可以用于机器学习实验的 SciKit 工具了。

SciKit-Learn 实验室

SciKit-Learn 实验室是一个命令行工具,你可以用来运行机器学习实验。要开始使用它,请通过 pip 安装skll。

在那之后,你需要获取一个SKLL格式的数据集。

接下来,为实验创建一个配置文件,然后在终端中运行实验。

$ run_experimen experiment.cfg

当实验完成时,多个文件将存储在结果文件夹中。你可以使用这些文件来检查实验。

Neptune

Scikit-learn 与 Neptune 的集成让你可以使用 Neptune 记录你的实验。例如,你可以记录你的 Scikit-learn 回归器的总结。

from neptunecontrib.monitoring.sklearn import log_regressor_summary

log_regressor_summary(rfr, X_train, X_test, y_train, y_test)

查看这个笔记本以获取完整示例。

模型选择

现在让我们转移话题,看看专注于模型选择和优化的 SciKit 库。

Scikit-optimize

这个库实现了基于序列模型的优化方法。通过 pip 安装‘scikit-optimize’以开始使用这些功能。

Scikit-optimize 可以通过基于贝叶斯定理的贝叶斯优化来进行超参数调优。

你可以使用‘BayesSearchCV’根据这一理论获得最佳参数。一个 Scikit-learn 模型作为第一个参数传递给它。

from skopt.space import Real, Categorical, Integer

from skopt import BayesSearchCV

regressor = BayesSearchCV(

GradientBoostingRegressor(),

{

'learning_rate': Real(0.1,0.3),

'loss': Categorical(['lad','ls','huber','quantile']),

'max_depth': Integer(3,6),

},

n_iter=32,

random_state=0,

verbose=1,

cv=5, n_jobs=-1,

)

regressor.fit(X_train,y_train)

适配后,你可以通过‘best_params_’属性获得模型的最佳参数。

Sklearn-deap

Sklearn-deap 是一个用于实现进化算法的包。它减少了你找到最佳模型参数所需的时间。

它并不会尝试每一种可能的组合,而是只演化出结果最佳的组合。通过 pip 安装‘sklearn-deap’。

from evolutionary_search import EvolutionaryAlgorithmSearchCV

cv = EvolutionaryAlgorithmSearchCV(estimator=SVC(),

params=paramgrid,

scoring="accuracy",

cv=StratifiedKFold(n_splits=4),

verbose=1,

population_size=50,

gene_mutation_prob=0.10,

gene_crossover_prob=0.5,

tournament_size=3,

generations_number=5,

n_jobs=4)

cv.fit(X, y)

生产用模型导出

继续前进,现在我们来看看可以用来导出模型以供生产的 Scikit 工具。

sklearn-onnx

sklearn-onnx 实现了将 Scikit-learn 模型转换为ONNX。

要使用它,你需要通过 pip 获取‘skl2onnx’。一旦你的管道准备好,你可以使用‘to_onnx’函数来转换模型为 ONNX 格式。

from skl2onnx import to_onnx

onx = to_onnx(pipeline, X_train[:1].astype(numpy.float32))

Treelite

这是一个用于决策树集合的模型编译器。

它处理各种基于树的模型,如随机森林和梯度提升树。

你可以用它导入 Scikit-learn 模型。这里的‘model’是一个 scikit-learn 模型对象。

import treelite.sklearn

model = treelite.sklearn.import_model(model)

模型检查和可视化

在这一部分,我们将探讨可以用于模型可视化和检查的库。

Dtreeviz

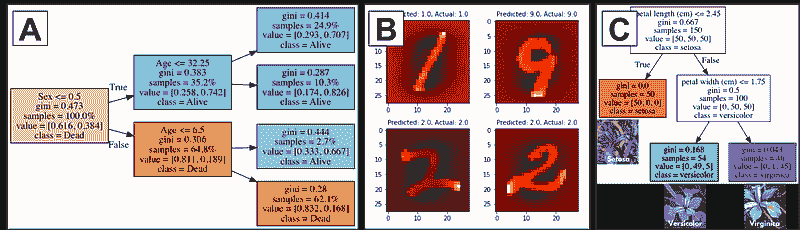

dtreeviz 用于决策树的可视化和模型解释。

from dtreeviz.trees import dtreeviz

viz = dtreeviz(

model, X_train, y_train,

feature_names=boston.feature_names,

fontname="Arial", title_fontsize=16,

colors = {"title":"red"}

)

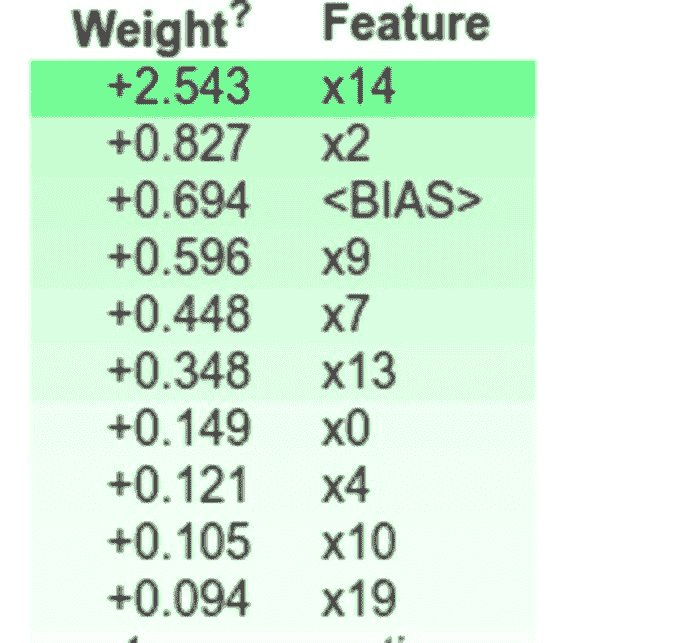

Eli5

eli5 是一个可以用于调试和检查机器学习分类器的包。你还可以用它来解释这些分类器的预测。

例如,Scikit-learn 估算器权重的解释可以如下所示:

import eli5

eli5.show_weights(model)

其他 SciKit 工具

dabl– 数据分析基础库

dabl 提供了常见机器学习任务的样板代码。它仍在积极开发中,因此不推荐用于生产系统。

import dabl

from sklearn.model_selection import train_test_split

from sklearn.datasets import load_digits

X, y = load_digits(return_X_y=True)

X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=1)

sc = dabl.SimpleClassifier().fit(X_train, y_train)

print("Accuracy score", sc.score(X_test, y_test))

skorch

Skorch 是 PyTorch 的 Scikit-learn 封装器。

它允许你在 Scikit-learn 中使用 PyTorch。它支持多种数据类型,如 PyTorch Tensors、NumPy 数组和 Python 字典。

from skorch import NeuralNetClassifier

net = NeuralNetClassifier(

MyModule,

max_epochs=10,

lr=0.1,

iterator_train__shuffle=True,

)

net.fit(X, y)

最后的思考

在本文中,我们探讨了一些扩展 Scikit-learn 生态系统的流行工具和库。

如你所见,这些工具可以用于:

-

处理和转换数据,

-

实现自动化机器学习,

-

执行自动特征选择,

-

进行机器学习实验,

-

选择适合你问题的最佳模型和管道,

-

导出模型以供生产…

…以及更多!

尝试在您的 Scikit-learn 工作流程中使用这些包,您可能会惊讶于它们的便利性。

个人简介:德里克·穆伊提是一位数据科学家,对分享知识充满热情。他通过 Heartbeat、Towards Data Science、Datacamp、Neptune AI、KDnuggets 等博客积极贡献于数据科学社区。他的内容在互联网上的观看次数已超过百万。德里克还是一名作者和在线讲师。他还与各个机构合作,实施数据科学解决方案以及提升员工技能。您可能想查看他的Python 完整数据科学与机器学习训练营课程。

原文。经许可转载。

相关:

-

数据科学、数据可视化和机器学习的顶级 Python 库

-

深度学习、自然语言处理和计算机视觉的顶级 Python 库

-

在 TensorFlow 中修剪机器学习模型

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 管理

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 管理

更多相关主题

最佳稀疏数据机器学习模型

原文:

www.kdnuggets.com/2023/04/best-machine-learning-model-sparse-data.html

作者提供的图片

稀疏数据是指特征值为零的数据集。这会在不同领域造成问题,特别是在机器学习中。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

稀疏数据可能由于不适当的特征工程方法而发生。例如,使用一热编码创建大量虚拟变量。

稀疏性可以通过计算数据集中零值的比例与总元素数的比率来衡量。解决稀疏性问题将影响你的机器学习模型的准确性。

此外,我们应区分稀疏性和缺失数据。缺失数据仅意味着某些值不可用。在稀疏数据中,所有值都是存在的,但大多数值为零。

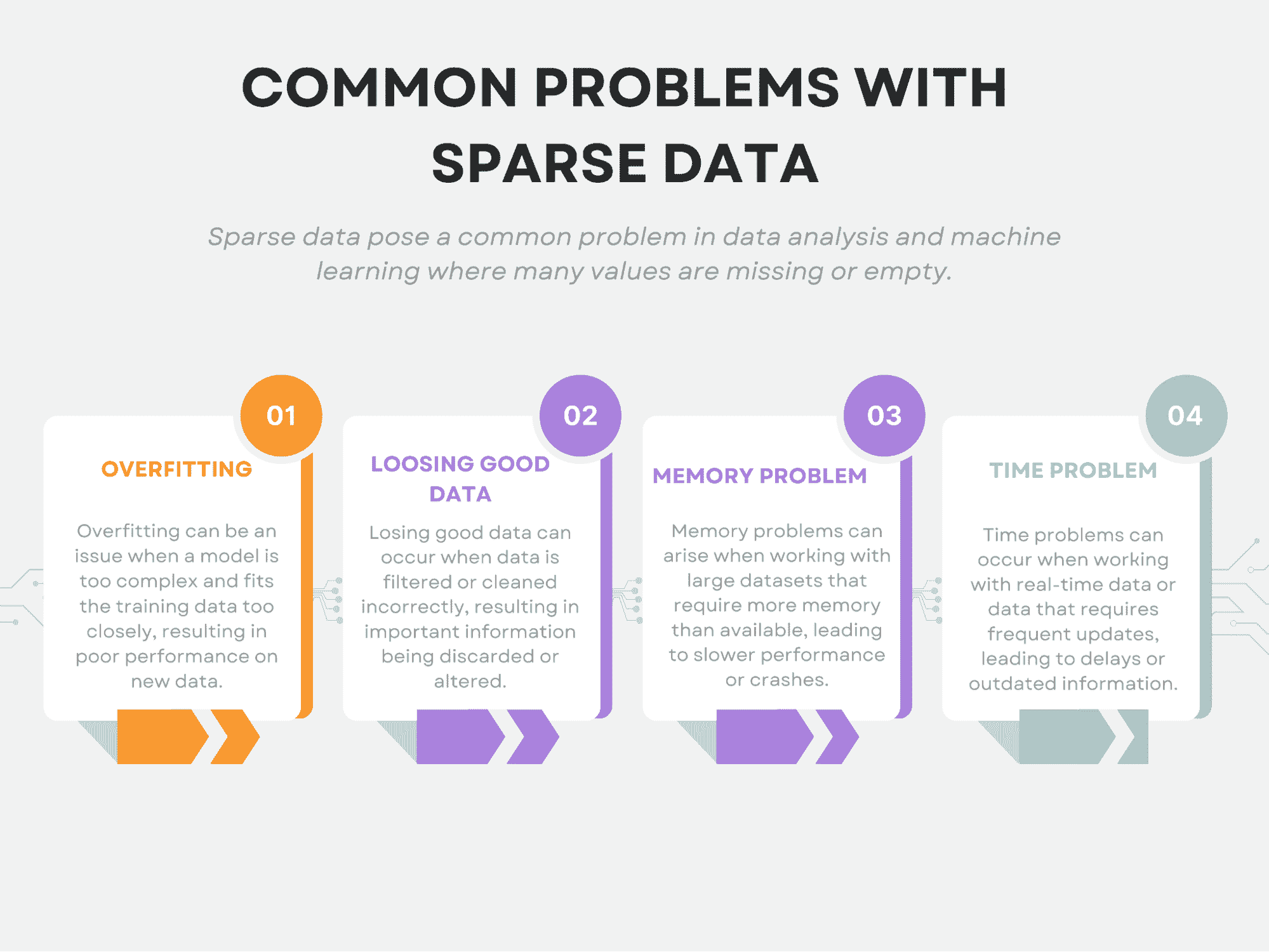

此外,稀疏性对机器学习带来了独特的挑战。具体来说,它会导致过拟合、丢失有用数据、内存问题和时间问题。

本文将探讨与稀疏数据相关的这些常见问题。然后,我们将介绍处理这些问题的技术。

最后,我们将应用不同的机器学习模型于稀疏数据,并解释为什么这些模型适用于稀疏数据。

在整个文章中,我将主要使用 scikit-learn 库,如果你希望修改代码和参数,我也会提供官方文档链接。

现在让我们开始讨论稀疏数据的常见问题。

稀疏数据的常见问题

稀疏数据可能对数据分析提出独特的挑战。我们已经提到了一些最常见的问题,包括过拟合、丢失有用数据、内存问题和时间问题。

现在,让我们详细查看每一项。

作者提供的图片

过拟合

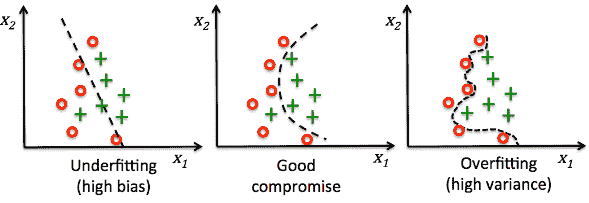

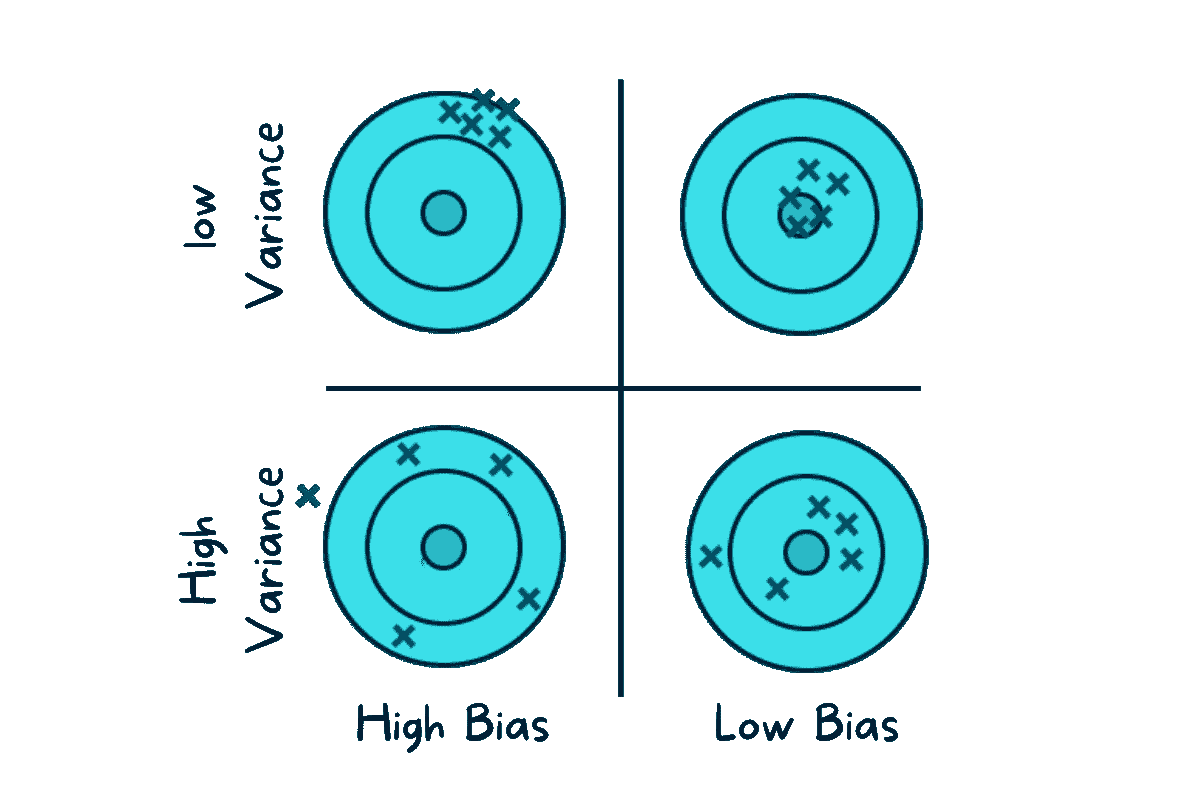

过拟合发生在模型变得过于复杂,开始捕捉数据中的噪声而不是潜在模式时。

在稀疏数据中,可能有大量特征,但只有少数特征与分析实际相关。这会使得识别哪些特征重要、哪些不重要变得困难。

结果可能导致模型对数据中的噪声过拟合,并在新数据上表现不佳。

如果你对机器学习不熟悉或想了解更多,你可以参考scikit-learn 关于过拟合的文档。

丢失有用数据

稀疏数据的一个最大问题是它可能导致潜在有用信息的丢失。

当我们拥有非常有限的数据时,识别数据中的有意义模式或关系变得更加困难。这是因为任何数据集固有的噪声和随机性在数据稀疏时更容易掩盖重要特征。

此外,由于可用数据的数量有限,我们更有可能错过数据中一些真正有价值的模式或关系。特别是在由于采样不足而导致数据稀疏的情况下,这一点尤其真实。在这种情况下,我们甚至可能未意识到丢失了数据点,因此可能无法意识到我们正在丢失有价值的信息。

这就是为什么如果移除过多特征,或者数据压缩过度,可能会丢失重要信息,从而导致模型准确性降低。

内存问题

内存问题可能由于数据集的巨大规模而出现。稀疏数据通常导致许多特征,存储这些数据可能需要计算上的高开销。这可能限制一次能处理的数据量,或者需要大量计算资源。

这里你可以查看使用 scikit-learn 进行数据缩放的不同策略。

时间问题

时间问题也可能由于数据集的巨大规模而发生。稀疏数据可能需要更长的处理时间,特别是当处理大量特征时。这可能限制数据处理的速度,在时间敏感的应用中可能会有问题。

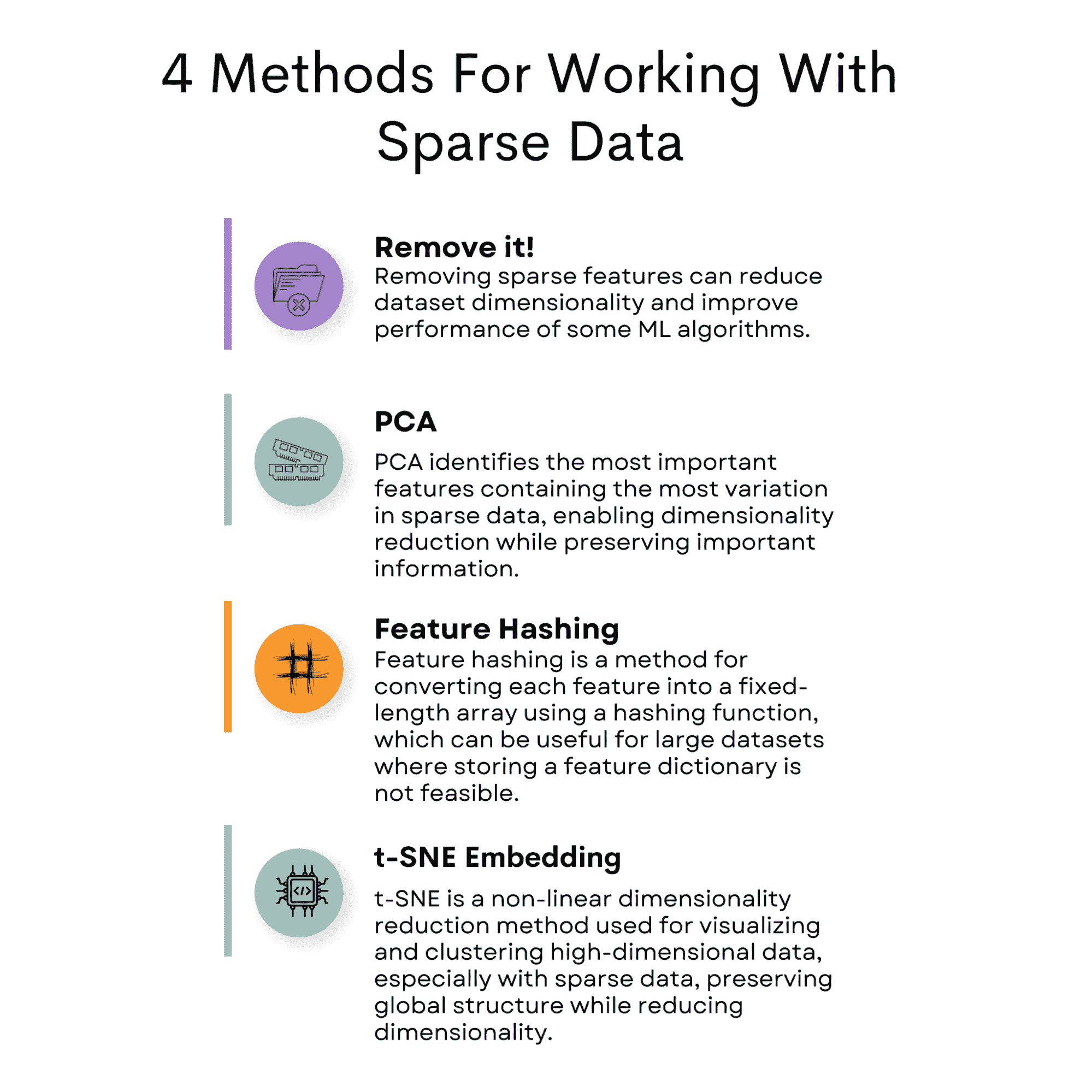

处理稀疏特征的方法有哪些?

作者提供的图片

稀疏数据在数据分析中带来了挑战,因为其非零值出现频率较低。然而,有几种方法可以缓解这个问题。

一个常见的方法是移除导致数据集稀疏的特征。

另一个选项是使用主成分分析(PCA)来减少数据集的维度,同时保留重要信息。

特征哈希是一种可以采用的技术,它涉及将特征映射到固定长度的向量。

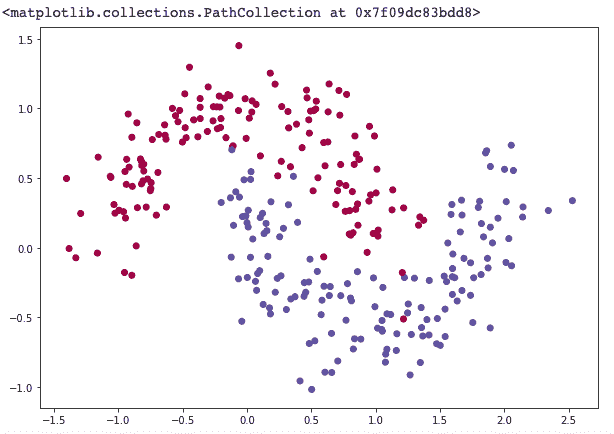

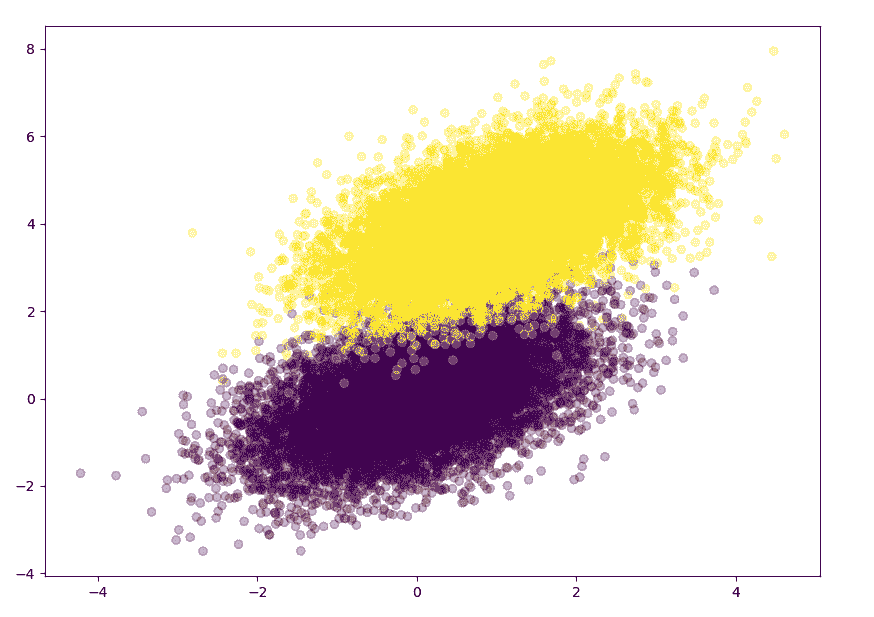

T-分布随机邻域嵌入(t-SNE)是另一种有用的方法,可以用来可视化高维数据集。

除了这些技术,选择一个适合处理稀疏数据的机器学习模型,如 SVM 或逻辑回归,也是至关重要的。

通过实施这些策略,可以有效解决数据分析中与稀疏数据相关的挑战。

现在我们先从减少稀疏数据的策略开始,然后我们将深入探讨模型。

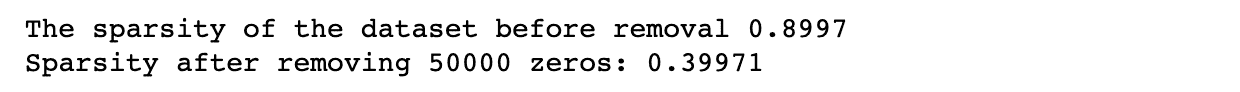

移除它!

在处理稀疏数据时,一种方法是移除包含大多数零值的特征。这可以通过设置每个特征中非零值的百分比阈值来完成。任何低于该阈值的特征都可以从数据集中移除。

这种方法可以帮助减少数据集的维度,并提高某些机器学习算法的性能。

代码示例

在这个示例中,我们设置了数据集的维度以及稀疏度,稀疏度决定了数据集中有多少值为零。

然后,我们生成具有指定稀疏度的随机数据,以检查我们的方法是否有效。在此步骤中,我们计算稀疏度以供之后比较。

接下来,代码设置要移除的零的数量,并随机移除数据集中特定数量的零。然后,我们重新计算修改后的数据集的稀疏度,以检查我们的方法是否有效。

最后,我们重新计算稀疏度以查看变化。

这是代码。

import numpy as np

# Set the dimensions of the dataset

num_rows = 1000

num_cols = 100

# Set the sparsity level of the dataset

sparsity = 0.9

# Generate random data with the specified sparsity level

data = np.random.random((num_rows, num_cols))

data[data < sparsity] = 0

# Calculate the sparsity of the dataset

num_zeros = (data == 0).sum()

total_elements = data.shape[0] * data.shape[1]

sparsity = num_zeros / total_elements

print(f"The sparsity of the dataset before removal {sparsity:.4f}")

# Set the number of zeros to remove

num_zeros_to_remove = 50000

# Remove a specific number of zeros randomly from the dataset

zero_indices = np.argwhere(data == 0)

zeros_to_remove = np.random.choice(

zero_indices.shape[0], num_zeros_to_remove, replace=False

)

data[

zero_indices[zeros_to_remove, 0], zero_indices[zeros_to_remove, 1]

] = np.nan

# Calculate the sparsity of the modified dataset

num_zeros = (data == 0).sum()

total_elements = data.shape[0] * data.shape[1]

sparsity = num_zeros / total_elements

print(

"Sparsity after removing {} zeros:".format(num_zeros_to_remove), sparsity

)

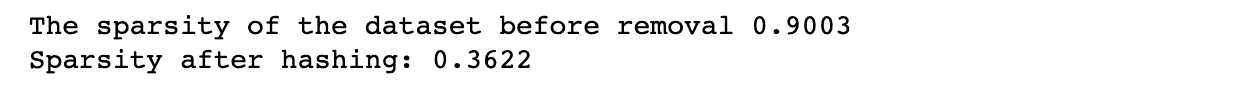

这是输出结果。

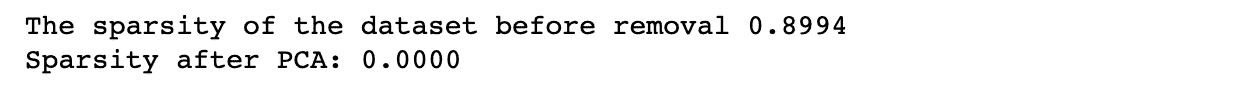

PCA

PCA 是一种流行的降维技术。它识别数据的主成分,这些主成分是数据变化最大的方向。

然后可以使用这些主成分在较低维度的空间中表示数据。

在稀疏数据的背景下,PCA 可以用来识别数据中包含最多变异的最重要特征。

通过仅选择这些特征,我们可以减少数据集的维度,同时保留大部分重要信息。

你可以使用 scikit-learn 库来实现 PCA,我们将在接下来的代码示例中这样做。这里是官方文档,如果你想了解更多信息。

代码示例

要对稀疏数据应用 PCA,我们可以使用 Python 中的 scikit-learn 库。

该库提供了一个 PCA 类,我们可以使用它来拟合 PCA 模型并将数据转换为较低维度的空间。

在接下来的代码的第一部分,我们创建一个数据集,如同在前一部分中一样,具有给定的维度和稀疏度。

在第二部分,我们将应用 PCA 将数据集的维度减少到 10。之后,我们将重新计算稀疏度。

这是代码。

import numpy as np

# Set the dimensions of the dataset

num_rows = 1000

num_cols = 100

# Set the sparsity level of the dataset

sparsity = 0.9

# Generate random data with the specified sparsity level

data = np.random.random((num_rows, num_cols))

data[data < sparsity] = 0

# Calculate the sparsity of the dataset

num_zeros = (data == 0).sum()

total_elements = data.shape[0] * data.shape[1]

sparsity = num_zeros / total_elements

print(f"The sparsity of the dataset before removal {sparsity:.4f}")

# Apply PCA to the dataset

pca = PCA(n_components=10)

data_pca = pca.fit_transform(data)

# Calculate the sparsity of the reduced dataset

num_zeros = (data_pca == 0).sum()

total_elements = data_pca.shape[0] * data_pca.shape[1]

sparsity = num_zeros / total_elements

print(f"Sparsity after PCA: {sparsity:.4f}")

这是输出结果。

特征哈希

处理稀疏数据的另一种方法叫做特征哈希。这种方法通过哈希函数将每个特征转换为固定长度的值数组。

哈希函数将每个输入特征映射到固定长度数组中的一组索引。如果多个输入特征映射到相同的索引,则将这些值相加。特征哈希对于存储大型特征字典可能不可行的大型数据集非常有用。

我们将在下一部分一起讨论这个内容,但如果你想深入了解,这里可以查看 scikit-learn 库中特征哈希器的官方文档。

代码示例

在这里,我们再次使用相同的方法来创建数据集。

然后我们使用 scikit-learn 的 FeatureHasher 类对数据集应用特征哈希。

我们使用n_features参数指定输出特征的数量,并使用input_type参数指定输入类型为字典。

然后我们使用 FeatureHasher 对象的 transform 方法将输入数据转换为哈希数组。

最后,我们计算结果数据集的稀疏度。

这是代码。

import numpy as np

# Set the dimensions of the dataset

num_rows = 1000

num_cols = 100

# Set the sparsity level of the dataset

sparsity = 0.9

# Generate random data with the specified sparsity level

data = np.random.random((num_rows, num_cols))

data[data < sparsity] = 0

# Calculate the sparsity of the dataset

num_zeros = (data == 0).sum()

total_elements = data.shape[0] * data.shape[1]

sparsity = num_zeros / total_elements

print(f"The sparsity of the dataset before removal {sparsity:.4f}")

# Apply feature hashing to the dataset

hasher = FeatureHasher(n_features=10, input_type="dict")

data_dict = [

dict(("feature" + str(i), val) for i, val in enumerate(row))

for row in data

]

data_hashed = hasher.transform(data_dict).toarray()

# Calculate the sparsity of the reduced dataset

num_zeros = (data_hashed == 0).sum()

total_elements = data_hashed.shape[0] * data_hashed.shape[1]

sparsity = num_zeros / total_elements

print(f"Sparsity after feature hashing: {sparsity:.4f}")

这是输出结果。

t-SNE 嵌入

t-SNE(t-分布随机邻域嵌入)是一种非线性降维技术,用于可视化高维数据。它在减少数据的维度的同时保持其全局结构,已成为机器学习中可视化和聚类高维数据的热门工具。

t-SNE 特别适用于处理稀疏数据,因为它可以有效地降低数据的维度,同时保持其结构。t-SNE 算法通过计算高维和低维空间中数据点之间的成对距离来工作。然后,它最小化这些距离在高维和低维空间中的差异。

为了在稀疏数据上使用 t-SNE,数据必须首先转换为密集矩阵。这可以通过各种技术完成,如 PCA 或特征哈希。数据转换完成后,t-SNE 可以用来获得数据的低维嵌入。

此外,如果你对 t-SNE 感兴趣,这里是 scikit-learn 的官方文档,可以查看更多信息。

代码示例

以下代码首先设置数据集的维度和稀疏度级别,生成具有指定稀疏度级别的随机数据,并计算应用 t-SNE 之前数据集的稀疏度,正如我们在前面的示例中所做的那样。

它然后对具有 3 个组件的数据集应用 t-SNE,并计算 t-SNE 嵌入的稀疏度。最后,它打印出 t-SNE 嵌入的稀疏度。

这是代码。

import numpy as np

# Set the dimensions of the dataset

num_rows = 1000

num_cols = 100

# Set the sparsity level of the dataset

sparsity = 0.9

# Generate random data with the specified sparsity level

data = np.random.random((num_rows, num_cols))

data[data < sparsity] = 0

# Calculate the sparsity of the dataset

num_zeros = (data == 0).sum()

total_elements = data.shape[0] * data.shape[1]

sparsity = num_zeros / total_elements

print(f"The sparsity of the dataset before removal {sparsity:.4f}")

# Apply t-SNE to the dataset

tsne = TSNE(n_components=3)

data_tsne = tsne.fit_transform(data)

# Calculate the sparsity of the t-SNE embedding

num_zeros = (data_tsne == 0).sum()

total_elements = data_tsne.shape[0] * data_tsne.shape[1]

sparsity = num_zeros / total_elements

print(f"Sparsity after t-SNE: {sparsity:.4f}")

这是输出结果。

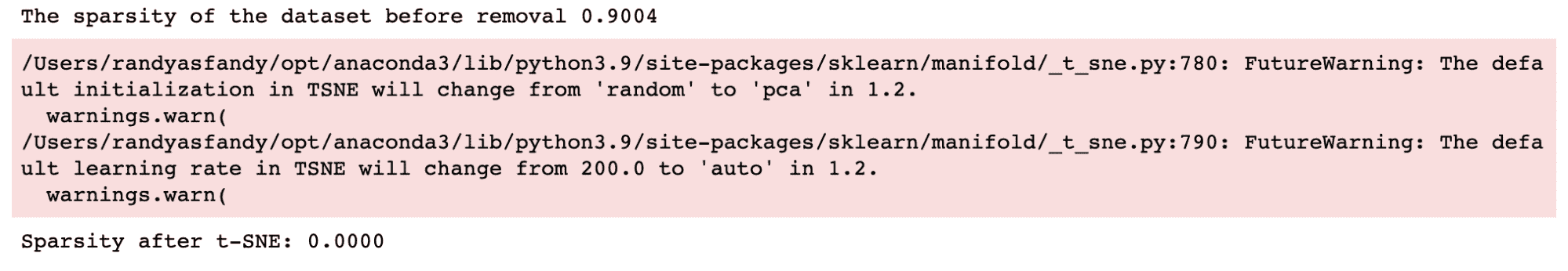

稀疏数据的最佳机器学习模型

既然我们已经解决了处理稀疏数据的挑战,我们可以探索专门为稀疏数据设计的机器学习模型。

这些模型可以处理稀疏数据的独特特征,例如大量特征中有许多零和有限的信息,这使得传统模型很难实现准确预测。

通过使用专门为稀疏数据设计的模型,我们可以确保预测结果更加精准可靠。

现在我们来谈谈适合稀疏数据的模型。

SVC(支持向量分类器)

SVC(支持向量分类器)与线性核可以很好地处理稀疏数据,因为它使用训练点的子集,即支持向量,进行预测。这意味着它可以高效地处理高维稀疏数据。

你也可以使用支持向量进行回归。

如果你想了解更多关于支持向量算法的内容,包括分类和回归,我在 这里解释了支持向量机。

逻辑回归

这也可以很好地处理稀疏数据,因为逻辑回归使用正则化项来控制模型复杂性,这有助于防止在稀疏数据集上的过拟合。

如果你想了解更多关于逻辑回归以及其他分类算法的信息,请查看 机器学习算法概述:分类。

KNeighboursClassifier

该算法可以很好地处理稀疏数据,因为它计算数据点之间的距离,并且能够处理高维数据。

你可以在 这里的机器学习算法 查看 KNN 和其他你需要了解的数据科学算法。

MLPClassifier

MLPClassifier 在输入数据标准化时可以很好地处理稀疏数据,因为它使用梯度下降进行优化。

这里你可以看到 MLP 分类器的实现,以及其他算法,借助 ChatGPT 的帮助。

决策树分类器

当特征数量较少时,它可以很好地处理稀疏数据。如果你对决策树不了解,我在 这里解释了决策树和随机森林,这是我们分析稀疏数据模型的最终模型。

RandomForestClassifier

RandomForestClassifier 在特征较少时可以很好地处理稀疏数据。

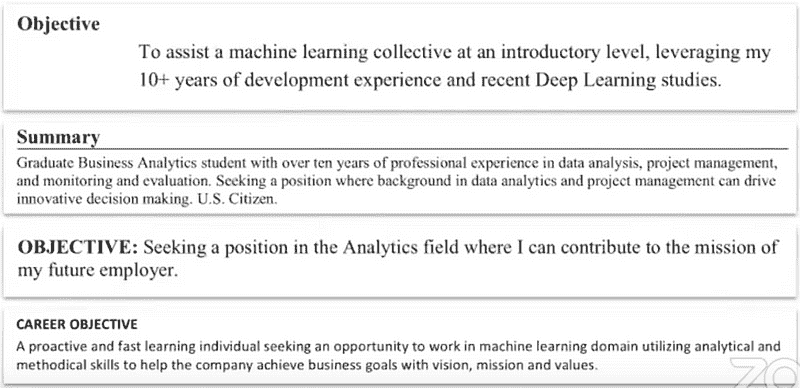

图片由作者提供

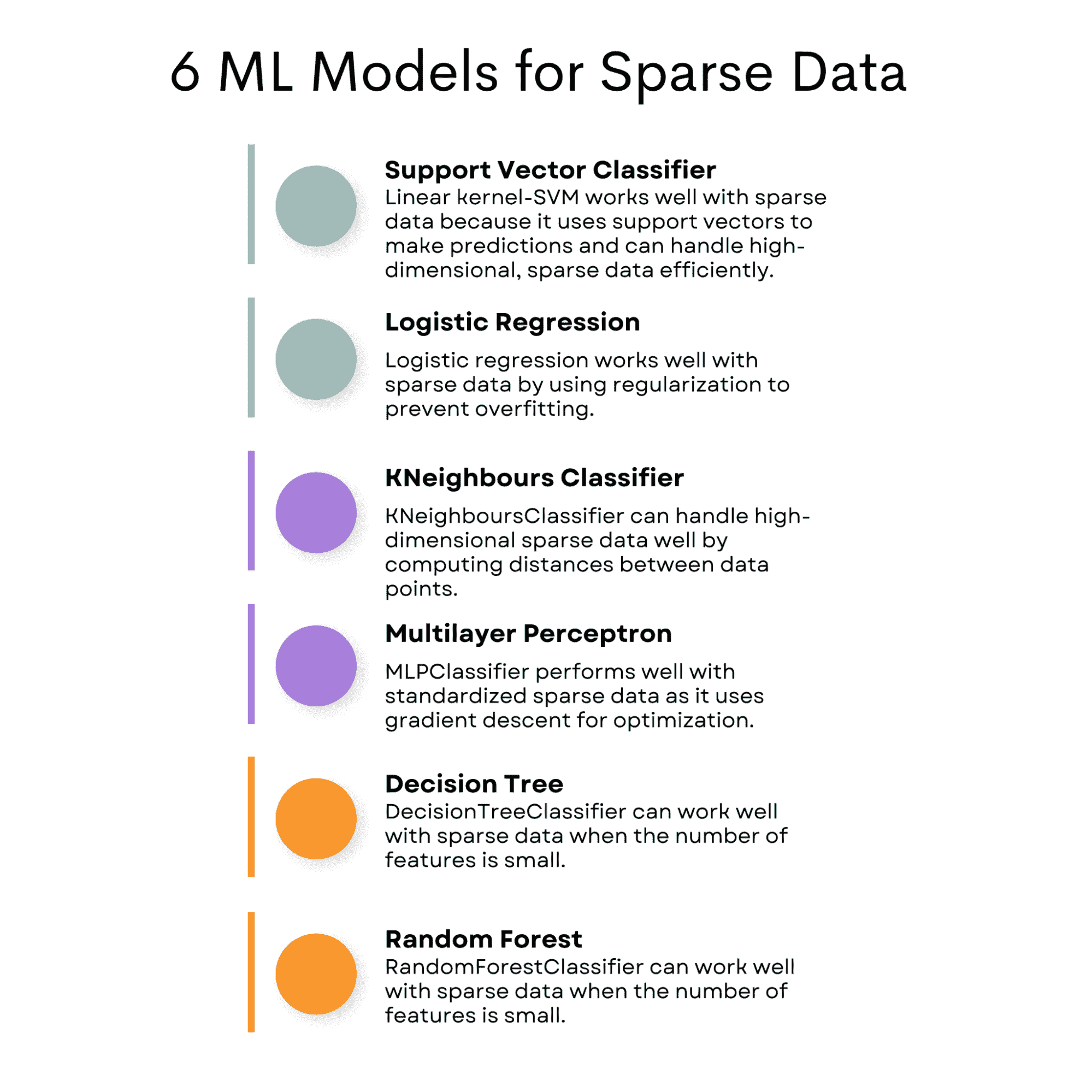

现在,我将展示这些模型在生成的数据上的表现。但是,我会添加另一个算法,以查看这些算法是否会超越这个通常不适合稀疏数据的算法。

代码示例

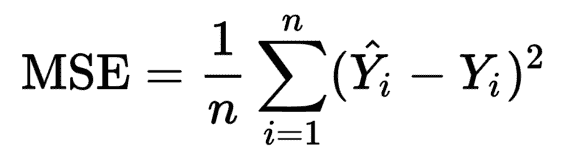

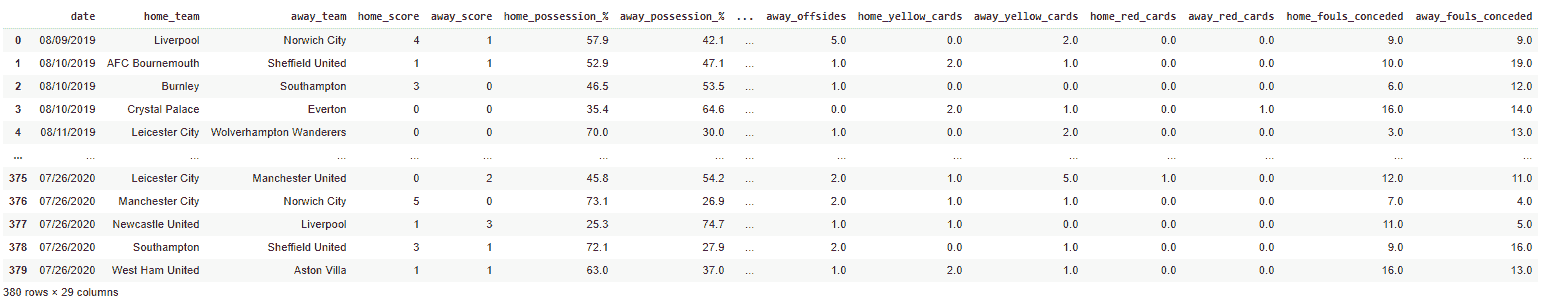

在本节中,我们将测试多个机器学习模型在稀疏数据集上的表现,这是一种包含大量空值或零值的数据集。

我们将计算数据集的稀疏性,并使用 F1 分数评估模型。

然后,我们将创建一个包含每个模型 F1 分数的数据框,以比较它们的表现。此外,我们将过滤掉在评估过程中可能出现的任何警告。

import numpy as np

from scipy.sparse import random

import numpy as np

from scipy.sparse import random

from sklearn.model_selection import train_test_split

from sklearn.metrics import f1_score

from sklearn.svm import SVC

from sklearn.linear_model import LogisticRegression, Lasso

from sklearn.cluster import KMeans

from sklearn.neighbors import KNeighborsClassifier

from sklearn.neural_network import MLPClassifier

from sklearn.datasets import make_classification

from sklearn.preprocessing import StandardScaler

from sklearn.model_selection import train_test_split

from sklearn.exceptions import ConvergenceWarning

import warnings

# Generate a sparse dataset

X = random(1000, 20, density=0.1, format="csr", random_state=42)

y = np.random.randint(2, size=1000)

# Calculate the sparsity of the dataset

sparsity = 1.0 - X.nnz / float(X.shape[0] * X.shape[1])

print("Sparsity:", sparsity)

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size=0.2, random_state=42

)

# Train and evaluate multiple classifiers

classifiers = [

SVC(kernel="linear"),

LogisticRegression(),

KMeans(

n_clusters=2,

init="k-means++",

max_iter=100,

random_state=42,

algorithm="full",

),

KNeighborsClassifier(n_neighbors=5),

MLPClassifier(

hidden_layer_sizes=(100, 50),

max_iter=1000,

alpha=0.01,

solver="sgd",

verbose=0,

random_state=21,

tol=0.000000001,

),

DecisionTreeClassifier(),

RandomForestClassifier(),

]

# Create an empty DataFrame with column names

df = pd.DataFrame(columns=["Classifier", "F1 Score"])

# Filter out the specific warning

warnings.filterwarnings(

"ignore", category=ConvergenceWarning

) # Filter warning that mlp classifier will possibly print out.

for clf in classifiers:

clf.fit(X_train, y_train)

y_pred = clf.predict(X_test)

f1 = f1_score(y_test, y_pred)

df = pd.concat(

[

df,

pd.DataFrame(

{"Classifier": [type(clf).__name__], "F1 Score": [f1]}

),

],

ignore_index=True,

)

df = df.sort_values(by="F1 Score", ascending=True)

df

这里是输出结果。

到目前为止,你可能会发现一个不适合稀疏数据的算法。没错,答案是 KMeans。但为什么呢?

KMeans 通常不适合稀疏数据,因为它基于距离度量,这在高维稀疏数据中可能会出现问题。

也有一些算法我们甚至不能尝试。例如,如果你试图将 GaussianNB 分类器包含在这个列表中,你会遇到错误。它提示 GaussianNB 分类器期望的是密集数据而不是稀疏数据。这是因为 GaussianNB 分类器假设输入数据遵循高斯分布,因此不适合稀疏数据。

结论

总结来说,处理稀疏数据可能会面临各种问题,比如过拟合、丢失有效数据、内存和时间问题。

然而,有几种方法可以处理稀疏特征,包括移除特征、使用 PCA 和特征哈希。

此外,某些机器学习模型如 SVM、Logistic Regression、Lasso、Decision Tree、Random Forest、MLP 和 k-最近邻适合处理稀疏数据。

这些模型已被设计为高效处理高维和稀疏数据,使它们成为处理稀疏数据问题的最佳选择。使用这些方法和模型可以提高模型的准确性,节省时间和资源。

Nate Rosidi 是一位数据科学家和产品战略专家。他还担任分析学兼职教授,并且是 StrataScratch 的创始人,该平台帮助数据科学家准备面试,提供来自顶级公司的真实面试问题。可以通过 Twitter: StrataScratch 或 LinkedIn 与他联系。

了解更多

最佳机器学习 YouTube 视频(10 分钟以内)

原文:

www.kdnuggets.com/2020/06/best-machine-learning-youtube-videos-under-10-minutes.html

评论

机器学习教育内容通常以学术论文或博客文章的形式呈现。这些资源非常宝贵。然而,它们有时可能篇幅较长,耗时较多。如果你只是想学习基本概念,而不需要所有背后的数学和理论,简洁的机器学习视频可能是更好的选择。此列表中的 YouTube 视频涵盖了诸如机器学习是什么、自然语言处理基础、计算机视觉的工作原理以及视频游戏中的机器学习等概念。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

1. 机器学习是什么? | 机器学习基础

上传日期: 2018 年 9 月 19 日

频道: Simplilearn

Simplilearn 的视频清晰简明地解释了许多机器学习的基本概念。在视频中,Simplilearn 解释了监督学习、无监督学习和强化学习之间的区别。此外,他们简要介绍了 K 近邻算法。视频使用了良好的视觉效果、图表和简单的示例。最后,视频包含了一个快速的测验和对一些最有趣的机器学习应用的简短概述。

2. 自然语言处理(NLP)基础

上传日期: 2018 年 6 月 6 日

频道: SparkCognition

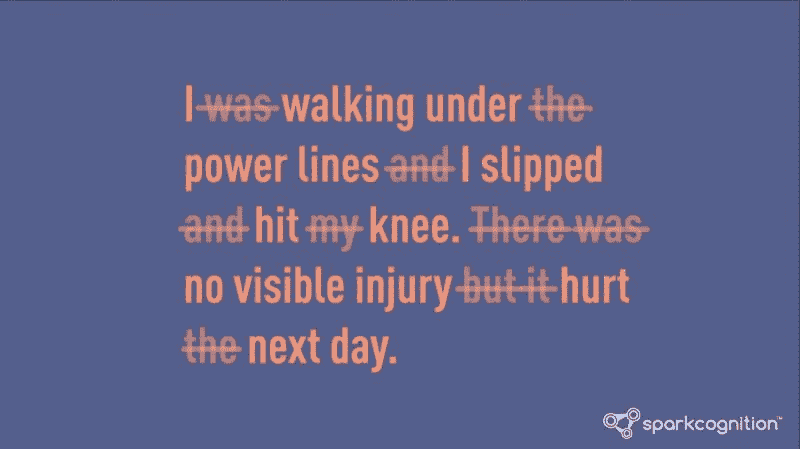

AI 解决方案提供商 SparkCognition 在这段不到五分钟的视频中解释了 NLP 的基础知识。他们能够在如此短的时间内传递如此多的信息令人赞叹。

NLP – 停用词

该视频使用了出色的视觉效果和动画,以帮助创建清晰简明的解释。它简要地涉及了结构化数据与非结构化数据、停用词以及 NLP 如何改善搜索引擎。最后,SparkCognition 解释了企业如何利用 NLP 分析数据,提升运营效率和安全性。

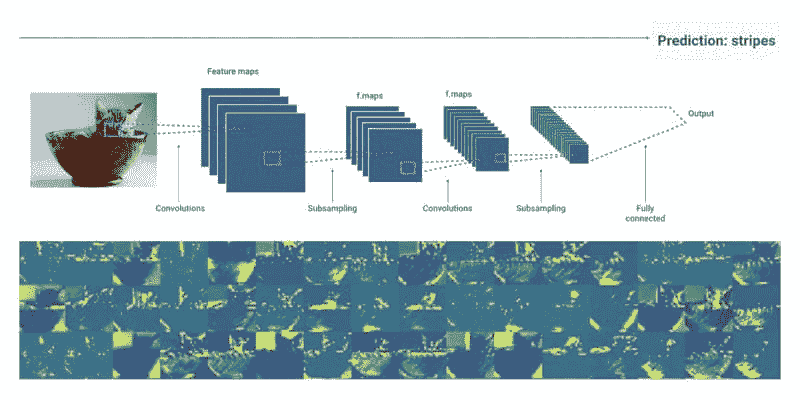

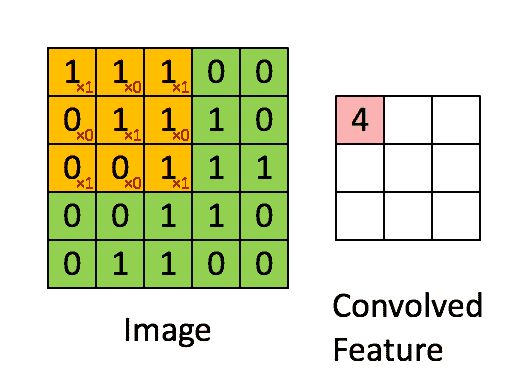

3. 计算机视觉的工作原理

上传日期: 2018 年 4 月 19 日

频道: Google Cloud Platform

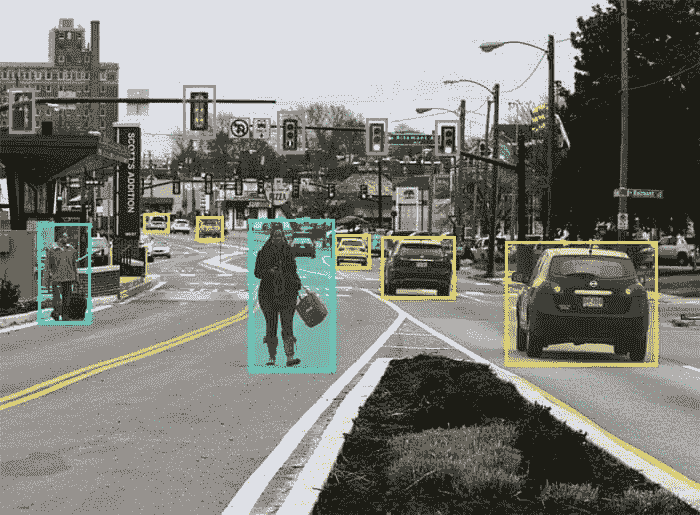

计算机视觉是机器学习领域最大的研究领域之一。Google 的这个视频提供了对计算机视觉工作原理的深入但简洁的解释。在视频中,他们解释了计算机如何看待图像以及机器学习模型如何被训练以识别物体。

CNNs

此外,视频简要解释了卷积神经网络(CNN)以及它们如何使用labeled training data进行预测和提高准确性。最后,视频还提到 CNNs 擅长理解空间特征,但在处理时间特征时存在困难。视频时长刚过七分钟,Google 成功地用出色的视觉辅助展示了大量信息。

4. 多智能体捉迷藏

上传日期: 2019 年 9 月 17 日

频道: OpenAI

来自 OpenAI 的这个实验非常有趣,展示了多智能体竞争如何导致智能行为。

在这个视频中,OpenAI 解释了他们如何用简单规则和初步工具构建一个虚拟的捉迷藏世界。在这个世界里,他们放置了多个角色,分为躲藏者和寻找者。在经过数百万轮游戏后,代理开始通过强化学习学会利用工具来获得优势。他们开始合作,找到创造性的方法来赢得比赛。最终,他们甚至学会了利用编程中的漏洞来作弊取得胜利。有关实验的更多评论视频可以在Two Minute Papers频道找到。

5. MarI/O – 游戏中的机器学习

上传日期: 2015 年 6 月 13 日

频道: SethBling

在这个视频中,Twitch 主播和计算机程序员 SethBling 介绍了 MarI/O,这是一款他开发的 AI 程序,学会了如何玩《超级马里奥世界》。

Seth 展示了程序的游戏技能,并解释了神经网络的基础知识和 MarI/O 的 24 小时进化学习系统。他讲解了神经网络如何被训练以玩游戏,神经网络看到什么,以及它如何学习做出决策并随着时间的推移进化。

每个视频不到 10 分钟,非常适合在通勤或午休时观看,同时增强你对机器学习基础知识的了解。观看以上视频后,你应该能更好地理解机器学习是什么、自然语言处理和计算机视觉的基础知识,以及游戏中的机器学习。

想了解更多关于机器学习的文章吗?请查看20 Best YouTube Channels for AI and Machine Learning以及下面的相关资源。

个人简介:Limarc Ambalina 是一位驻东京的作家,专注于 AI、科技和流行文化。他曾为包括 Hacker Noon、Japan Today 和 Towards Data Science 在内的多个出版物撰稿。

原文。经许可转载。

相关:

-

5 篇关于面部识别的机器学习论文

-

10 篇必读的机器学习文章(2020 年 3 月)

-

5 篇关于情感分析的必读论文

更多相关内容

2019 年欧洲最佳数据科学与分析硕士课程

原文:

www.kdnuggets.com/2019/04/best-masters-data-science-analytics-europe.html/2

荷兰

-

代尔夫特理工大学计算机科学硕士学位 - 数据科学与技术方向在本课程的数据科学与技术方向中,你将学习如何工程化和开发能够处理和解释海量数据集的系统,以提取重要信息。将解决数据分析的基本和实际问题,包括数据和软件的安全性、信息可视化、数据驱动的决策和高性能计算算法等。 (24 个月课程,欧盟:$4,567,非欧盟:$32,574 全额学费,计算机科学排名:75)

-

JADS 联合硕士数据科学与创业为期两年的硕士课程在数据科学和创业领域真正实现了跨学科的商业、技术和分析的结合。它综合了埃因霍温理工大学和蒂尔堡大学的独特优势:埃因霍温的技术专长与蒂尔堡的商业、法律和社会见解。 (24 个月课程,欧盟:$4,860,非欧盟:$35,540 全额学费)

-

莱顿大学统计科学硕士学位: 数据科学这一专业方向使你更好地理解统计模型,特别是与数据科学相关的模型,包括它们在广泛的实证研究中的应用和解释。凭借这些知识,你将能够批判性地研究科学研究并开发新的模型和技术。本课程将讨论的数据挖掘、机器学习、网络、模式识别和深度学习。数据科学:计算机科学选项可用,点击此处了解更多信息。 (24 个月课程,欧盟:$4,589,非欧盟:$41,111 全额学费,计算机科学排名:275)

-

拉德布德大学计算机科学硕士:数据科学在本课程中,你将学习如何利用计算机将数据转化为知识,并将这些知识转化为解决方案。 (24 个月课程,欧盟:$4,589,非欧盟:$25,769 全额学费,计算机科学排名:325)

-

阿姆斯特丹大学信息系统硕士:数据科学方向。在这个为期一年的项目中,你将掌握数据科学所用的理论和工具。我们将教你如何在不同领域(如医疗保健、媒体与通信、智能城市、生命科学和数字人文学科)使用这些工具处理数据。(12 个月项目,欧盟:$4,589,$16,433 全部学费,计算机科学排名:75)

-

新 阿姆斯特丹大学商业数据科学硕士。你对数据科学和商业感兴趣吗?你是否拥有分析思维和智力好奇心?如果是,这个硕士课程适合你。(12 个月项目,欧盟:$4,589,$16,433 全部学费,计算机科学排名:75)

-

蒂尔堡大学数据科学商业与治理硕士课程,重点关注数据分析和数据挖掘领域的知识和专业技能,同时涵盖大数据的经济、管理和法律视角。满足政府组织、公司和学术界对具有分析技能的员工日益增长的需求。(12 个月项目,欧盟:$2,339,非欧盟:$16,287 全部学费,计算机科学排名:575)

-

蒂尔堡大学商业分析与运营研究硕士课程,教授通用的数据科学和优化方法,使你能够在各种应用中解决决策问题。(12 个月项目,欧盟:$2,339,非欧盟:$16,287 全部学费,计算机科学排名:575)

-

新 马斯特里赫特大学决策数据科学硕士。你是否喜欢为复杂问题提出优雅的解决方案?你是否觉得从大量数据中提取模式具有挑战性?那么你应该考虑攻读数据科学决策硕士。(24 个月项目,法定学费:$2,345,机构学费:$18,917 全部学费,计算机科学排名:575)

挪威

- 新 挪威生命科学大学(NMBU)数据科学硕士。在挪威生命科学大学(NMBU)的数据科学项目中,你将学习如何将信息学、数学和统计学与数据分析结合起来,以应对大数据挑战。(24 个月项目,免费学费)

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 支持

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 支持

波兰

-

新 华沙经济学院的高级分析 – 大数据硕士学位。该项目的毕业生可以在制造公司、银行、保险和电信公司、公共行政及专注于高级数据分析的研究中心担任高级数据分析师。该项目还为学生进行研究和攻读第三周期学习做准备。(24 个月项目,欧盟:全学费$7,979,非欧盟:全学费$10,783)

-

新 科兹敏斯基大学的大数据分析硕士学位。科兹敏斯基大学的金融与会计硕士项目中的大数据分析专业是一个为期两年的英语授课项目,与全球公司行业专家合作进行。(24 个月项目,欧盟:全学费$2,998)

葡萄牙

- 新 Nova IMS 的数据科学与高级分析硕士学位。数据科学与分析的受欢迎程度在过去几年中稳步增长,无论是在行业还是学术界。数据科学与高级分析硕士学位(数据科学专业)旨在培养市场导向的人才,他们希望将有效的分析模型应用于不同的商业问题,解读结果及其对业务的影响,以便做出数据驱动的决策来优化业务流程。(24 个月项目,全学费$7,822,计算机科学排名:125)

俄罗斯

-

诺沃西比尔斯克国立大学的大数据分析硕士学位。数据科学中的创新项目导向培训由构思和塑造大数据世界未来的头脑和双手主导。您的文凭将只显示“理学硕士”,因为我们的“巫师”学位尚未正式确立。(24 个月项目,全学费$11,681,计算机科学排名:325)

-

ITMO 大学的机器学习与数据分析硕士课程。机器学习与数据分析硕士课程是俄罗斯为数不多的提供数据科学教育的课程之一,数据科学在信息时代变得越来越重要。学生将学习如何使用最新工具和分析方法来分析实际数据。这是学习数据收集、存储和检索、机器学习算法和数据挖掘技术、数据可视化和建模最佳实践的绝佳机会。(24 个月课程,俄罗斯学生:$3,280,非俄罗斯学生:$3,587 全部学费,CS 排名:125)

-

乌拉尔联邦大学的适应性数据分析硕士课程该课程的毕业生将有资格在适应性数据分析和大数据领域的不同产业、领域和所有权形式、机构和组织中从事职业,包括金融、信用和保险机构、市政当局和政府、学术及机构研究组织。(24 个月课程,$5,750 全部学费,CS 排名:575)

-

全新 国家研究大学的应用统计与神经网络分析硕士课程。国家研究大学 - 高等经济学院(HSE)的应用统计与网络分析硕士课程适合希望通过获得应用统计研究生学位来提升统计知识和资质的学生,无论其主要学习领域如何。(24 个月课程,$10,508 全部学费,CS 排名:225)

西班牙

-

IE 人文科学与技术学院的商业分析与大数据硕士课程的两个硕士学位是创新性的学位,旨在培养新一代数据驱动和创新导向的专业人才,具备追求成功商业分析与大数据职业生涯所需的所有技能。(10 个月课程,$39,538 全部学费)

-

巴塞罗那科技学院的大数据解决方案硕士课程 大数据与创新分析硕士课程将帮助你成为能够在任何组织中发现见解并推动创新的国际专业人士。你将学习如何从数据中提取相关见解,并利用最先进的分析和数据技术为任何类型的组织或行业生成战略解决方案。(9 个月课程,$29,095 全部学费,CS 排名:125)

-

巴塞罗那经济研究生院数据科学硕士。该项目为毕业生设计和构建数据驱动的决策系统提供了准备,提供了预测、描述和规范分析的全面培训。(9 个月项目,$20,780 全部学费)

-

巴塞罗那大学数据科学基础硕士。该项目提供了进行数据建模和分析所需的算法和数学基础,通过实践导向的课程,培养应对数据项目的专业技能。它强调理解数据科学背后算法的基础,并能够修改和创建符合数据项目需求的新特定算法。(12 个月项目,欧盟:$3,291,非欧盟:$5,683 全部学费,计算机科学排名:175)

-

全新 马德里卡洛斯三世大学大数据分析硕士。马德里卡洛斯三世大学的大数据分析硕士项目旨在对与数据分析相关责任的专业人员进行(再)培训,特别是那些涉及公司内大数据量评估的人员。(12 个月项目,欧盟:$3,291,非欧盟:$5,683 全部学费,计算机科学排名:175)

瑞典

-

斯基夫德大学数据科学硕士。该项目重点关注三个主要领域:智能数据分析、编程和决策支持。示例课程包括人工智能、数据挖掘、编程、可视分析和商业智能。(12 个月或 24 个月,欧盟:免费,非欧盟:$30,900 全部学费)

-

林雪平大学统计学与机器学习硕士。该项目专注于利用统计学的力量构建高效模型、做出可靠预测和优化决策的现代机器学习和数据库管理方法。该项目为学生提供了在劳动力市场上最受重视的独特技能。(24 个月项目,欧盟:免费,非欧盟:$23,446 全部学费)

-

全新 哥德堡大学应用数据科学硕士。数据科学关注于从大量数据中提取意义。由于大数据集的日益可用以及这些数据所带来的机会和挑战,这一领域近年来迅速发展。(24 个月项目,欧盟:免费,非欧盟:$30,537 全部学费,计算机科学排名:425)

-

新 查尔姆斯理工大学数据科学硕士。随着数字革命的到来,数据科学和人工智能(AI)已成为我们生活和社会的重要组成部分。凭借在机器学习方面的坚实基础,以及对数据科学和 AI 多样化问题的理解,你将拥有广泛的职业选择。数据科学课程由查尔姆斯理工大学提供。(24 个月课程,欧盟:免费,非欧盟:学费$30,327)

瑞士

-

洛桑联邦理工学院数据科学硕士。该项目为你提供从基础到实施的全面教育,从算法到数据库架构,从信息理论到机器学习。该硕士课程由计算机与通信科学学院、数学研究所和工程学院合作提供,为期两年,全部用英语授课。(24 个月课程,学费$2,532,计算机科学排名:24)

-

ETH 数据科学硕士。ETH 提供的专门数据科学硕士项目,与数学系以及信息技术和电气工程系合作,提供高质量的教育,培养下一代数据科学家。该课程为期两年,全部用英语授课。(24 个月课程,学费$2,320,计算机科学排名:9)

-

日内瓦大学商业分析硕士课程。该项目旨在支持学生在不确定的情况下管理、分析和使用数据,以便在战略、战术和操作决策中做出明智的选择;为学生在数字化转型中高效领导做好准备,为企业和社会创造价值;并弥合大学教育与职业需求之间的差距。(24 个月课程,学费$2,025)

-

新 苏黎世大学数据科学硕士。数据科学主要学习项目的核心包括信息学领域的选修模块以及一个硕士项目。(24 个月课程,学费$2,965,计算机科学排名:125)

-

新 卢塞恩应用科学与艺术大学的应用信息与数据科学硕士课程。该跨学科硕士课程为学生应对数字经济的技术和管理挑战做好准备。课程为所有与数据相关的职能、商业领域、公司和组织开辟了广泛的就业和发展机会。(24 个月项目,$2,965 全额学费)

土耳其

-

新 伊斯坦布尔塞希尔大学的数据科学硕士课程。伊斯坦布尔塞希尔大学的数据科学(含论文)研究生项目旨在通过培养明天的数据科学家来填补预计的数据科学技能缺口。(24 个月项目,$8,000 全额学费)

-

新 TED 大学的应用数据科学硕士课程。自 2000 年代初以来,数据科学这一概念以惊人的速度获得认可,旨在扩展统计学的应用范围,近年来已成为本世纪最需要的专业领域之一。在 TED 大学的应用数据科学项目中了解更多。(18 个月项目,$8,000 全额学费)

英国

-

帝国理工学院的商业分析硕士课程是一个为期一年的全日制课程,旨在为数据和证据驱动的决策制定未来做好准备。您将从领先的从业者和世界级的教师那里学习如何应用最新的学术思想和分析、计算工具,以帮助做出商业决策。(12 个月项目,$36,897 全额学费,计算机科学排名:15)

-

爱丁堡大学的数据科学硕士课程旨在吸引希望在工业界或公共部门建立数据科学家职业的学生,以及希望在进一步培训(如我们的数据科学 CDT)之前探索该领域的学生。(12 个月项目,欧盟:$17,992,非欧盟:$40,026 全额学费,计算机科学排名:21)

-

伦敦大学学院的数据科学硕士课程将为学生提供分析工具,以运用现代计算方法设计复杂的技术解决方案,并强调严谨的统计思维。该课程结合了从入门级别开始的核心统计和机器学习方法培训,以及涵盖统计计算和建模更多专业知识的选修课程。(12 个月项目,欧盟:$18,018,非欧盟:$37,040,计算机科学排名:37)

-

伦敦经济学院的数据科学硕士课程提供数据科学方法的培训,强调统计学视角。你将接受理论方面的全面基础培训,以及数据科学的技术和实际技能。(12 个月课程,欧盟:$36,579,非欧盟:$37,299 全额学费,计算机科学排名:125)

-

伦敦城市大学的数据科学硕士课程适合拥有数量化本科背景或能展示数量化技能的学生。学生通常处于职业生涯的早期阶段,涵盖经济学、统计学和计算机科学等多种职业。学生将对数据充满好奇,并希望学习新技术以提升职业生涯,并参与当前激动人心的行业发展。该课程包括一些复杂的编程任务,由于课程的应用性质,许多学生拥有数学或统计学背景,并享受与算法打交道。(12 个月课程,欧盟:$12,712,非欧盟:$22,816 全额学费,计算机科学排名:375)

-

南安普顿大学的数据科学硕士课程将培训学生成为熟练的数据科学家。你将获得数据挖掘、机器学习和数据可视化等领域的高级知识,包括最新的技术、编程工具包以及工业和社会应用场景。(12 个月课程,欧盟:$12,060,非欧盟:$31,943 全额学费,计算机科学排名:125)

-

伦敦大学金史密斯学院的数据科学硕士课程将提供分析未来商业、数字媒体和科学中关键大数据的技术和实际技能。(12 个月课程,欧盟:$13,220,非欧盟:$19,609 全额学费,计算机科学排名:525)

-

巴斯大学的数据科学硕士课程在此课程中,你将学习到具有普遍相关性的强大统计基础,并发展对概率机器学习技术的专业知识。你将获得在实践中应用这些知识的核心软件技术的专业技能,解决小型和大型数据集的挑战。(12 个月课程,欧盟:$12,386,非欧盟:$28,683 全额学费,计算机科学排名:375)

-

伦敦国王学院的数据科学硕士课程。该课程是一个跨学科的学习项目,将为您提供在数据收集、整理、策划和分析方面的高级技术和实践技能。它还考察数据科学家的职业、法律和伦理责任。这是一个理想的学习路径,适合有定量学科背景的毕业生或具备相关工作经验的人。(12 个月课程,欧盟:$12,907,非欧盟:$33,246 全部学费,计算机科学排名:75)

-

格拉斯哥大学的数据科学硕士课程。该数据科学硕士课程为您提供了对大型数据集分析和使用的全面基础,并结合开发项目的经验,为您在大数据和 IT 行业中担任负责职位做好准备。除了学习反映前沿技术和国际认可学术人员专长的一系列课程外,您还将进行一个重要的编程团队项目,并培养自己在数据科学项目中的能力。(12 个月课程,欧盟:$10,430,非欧盟:$27,405 全部学费,计算机科学排名:125)

-

东伦敦大学的数据科学硕士课程。该数据科学硕士课程旨在为希望在数据中心、主要是定量领域的广泛专业学科和就业领域中建立专业知识和就业机会的学生提供机会。因此,跨学科方法是课程实施的核心。(12 个月课程,欧盟:$11,186,非欧盟:$17,288 全部学费)

-

卡迪夫大学的数据科学与分析硕士课程。该课程旨在提供处理、收集、存储和分析大量复杂数据集所需的全面技能。您将由数学学院和计算机科学与信息学学院的专家授课,这将使您从不同的角度了解该主题,并可接触到两个学院的广泛模块。(12 个月课程,欧盟:$12,190,非欧盟:$28,227 全部学费,计算机科学排名:275)

-

兰卡斯特大学数据科学硕士。该课程在多学科学习方面具有独特的专注。有效的数据科学需要从多个学科中汲取技能,因此我们的课程由计算机与通信学院、数学与统计系以及兰卡斯特大学管理学院联合提供。(12 个月课程,欧盟:$12,190,非欧盟:$26,727 全部学费,计算机科学排名:175)

-

全新 埃塞克斯大学大数据与文本分析硕士。埃塞克斯大学的大数据与文本分析课程帮助你获得大规模处理文本数据的实际知识,以将这些数据转化为有意义的信息,并有机会参与来自实际行业需求的项目,这些需求由我们的工业合作伙伴提出。(12 个月课程,欧盟:$11,786,非欧盟:$22,894 全部学费,计算机科学排名:375)

-

全新 南威尔士大学数据科学硕士。在南威尔士大学的数据科学课程中,你将学习如何应用高级分析技能和知识来解决一系列现实世界的问题。(12 个月课程,$17,470 全部学费,计算机科学排名:375)

-

全新 利兹贝克特大学数据科学硕士。数据和信息被认为是当今社会经济、商业和文化生活的核心。利兹贝克特大学的数据科学课程将为你提供先进的信息和分析技能,以在数字知识经济中取得成功。(12 个月课程,$17,470 全部学费)

-

全新 布鲁内尔大学伦敦数据科学与分析硕士。布鲁内尔大学伦敦的数据科学与分析课程与 SAS(市场领先的商业分析软件和服务提供商,也是商业智能市场最大的独立供应商)联合举办。(12 个月课程,欧盟:$13,220,非欧盟:$24,407 全部学费)

乌克兰

- 全新 乌克兰天主教大学计算机科学硕士,数据科学方向。计算机科学硕士数据科学方向课程由乌克兰天主教大学提供。(18 个月课程,$6,300 全部学费)

当然,如果你认为我们遗漏了应该添加到此列表中的课程,请在下方评论告知我们。你可以在 此链接 上找到关于其他欧洲国家和其他项目的更多详细信息。

资源:

相关内容:

更多相关内容

2019 年最佳数据科学与分析硕士课程 – 在线

原文:

www.kdnuggets.com/2019/04/best-masters-data-science-analytics-online.html

评论

数据科学与分析是一个非常热门的领域,对数据科学家的需求仍在强劲增长。许多大学参与其中,并创建了许多该领域的学位,主要是硕士学位。

回到 2017 年,我们进行了一系列关于这些学位的最佳文章,涵盖了美国、欧洲和在线课程。幸运的是,我们现在更新了这些全面的列表,并添加了更多的硕士课程。第一个这些列表已经发布 - 2019 年最佳数据科学与分析硕士 - 欧洲。在这篇文章中,我们将专注于在线硕士课程。

我们的前三课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

CS 排名是顶级大学的计算机与信息系统研究生项目排名前 1-50。它们提供前 50 所学校的单独 CS 排名,然后是下一组 450 所学校的范围(51-100、101-150 等)。为了区分排名相同范围的学校,我们在范围的起始位置添加了 Top Universities 排名除以 10 的值。当然,这个排名在计算上并不是 100% 科学的,但它确实给出了提供这些课程的学校的一个很好的概念。

我们包括了 2017 年版本的信息,以便你了解这些学校在过去几年中的变化。像往常一样,如果我们遗漏了任何内容,请在评论区告诉我们,我们将相应地更新表格。

| CS 排名(2017) | 大学,学位 | 描述 | 学期学分 | 学费(2017) |

|---|---|---|---|---|

| 3 (3) | CMU Tepper 商业分析硕士 | MSBA 旨在帮助拥有技术背景的个人深化分析技能,并晋升到高级商业分析师职位。 | 24 | $67575 ($62500) |

| 4 (4) | 加州大学伯克利分校 信息与数据科学硕士 | 在线提供的信息与数据科学硕士(MIDS)课程为数据科学专业人士培养成为该领域的领导者。通过融合跨学科课程、经验丰富的教师、成功的同行网络和在线学习的灵活性,认证的 datascience@berkeley 项目将加州大学伯克利带到你所在的任何地方。 | 2027 学分 | $66150 ($62991) |

| 24 (28) | 乔治亚理工学院 分析硕士 | 分析硕士是一个跨学科的学位项目,结合了乔治亚理工学院在统计学、运筹学、计算机科学和商业领域的优势,通过结合世界级的谢勒商学院、计算学院和工程学院的专业知识,毕业生将学会以独特和跨学科的方式整合技能,从而深入了解分析问题。 | 2436 学分 | $9900 ($9900) |

| 31 (30) | 伊利诺伊大学香槟分校 数据科学计算机科学硕士 | 这个完全在线的专业硕士学位使学习者获得了伊利诺伊大学教员的知识,他们在数据科学领域做出了开创性的研究。MCS-DS 毕业生将特别适合进入今天行业中薪资高、需求大的职业轨道。 | 17.532 学分 | $19200 ($19200) |

| 44 (50) | 南加州大学 计算机科学硕士(数据科学) | 计算机科学硕士(数据科学)课程为学生提供计算机科学的核心背景,以及在获取、存储、访问、分析和可视化大型、异构和实时数据方面的算法、统计和系统专业知识,这些数据涉及包括能源、环境、健康、媒体、医学和交通在内的多种现实世界领域。 | 2432 学分 | $55886 ($55886) |

| 75 (56.5) | 威斯康星大学 数据科学硕士 | 在数据科学竞争激烈的领域,硕士学位是顶级公司高级职位的要求。在线 UW 数据科学硕士课程是忙碌成人的明智选择,适合那些希望提升职业生涯或开始全新职业,但没有时间参加校园课程的人。 | 17.512 课程 | $30600 ($29700) |

| 75 (59.1) | 波士顿大学大都会学院 应用商业分析硕士 | 计算机信息系统硕士(MS)项目旨在为希望将信息系统的技术能力与管理和组织问题知识结合的学生提供设计。 | 18-2440 学分,兼职学费 | $34400 ($34400) |

| 125 (52.7) | 约翰斯·霍普金斯大学 数据科学硕士 | 严谨的课程聚焦于计算机科学、统计学和应用数学的基础,同时融入实际案例。学生可以选择在线学习或在约翰斯·霍普金斯应用物理实验室的先进设施中实地学习,从实践工程师和数据科学家那里获得知识。毕业生准备好在涉及数据管道和存储、统计分析以及从数据中提取故事的专业职位中取得成功。 | 17.510 门课程 | $53740 ($52170) |

| 125 (60.3) | 宾夕法尼亚州立大学 数据分析职业硕士 | 在全面的基础课程中,教学重点放在大数据和数据库设计过程中。你可以学习数据管理技术和用于描述性、规范性和预测性分析的数据分析技术,以在各种学科中利用竞争优势。 | 17.530 学分 | $29250 ($27900) |

| 125 (113.8) | 西北大学 SPS 数据科学硕士 | 数据科学与商业战略的结合创造了对能够做出数据驱动决策的专业人才的需求,从而推动组织前进。你可以在西北大学的在线数据科学硕士项目中建立在当今数据驱动的世界中所需的基本分析和领导技能。 | 1812 门课程 | $53148 ($52410) |

| 125 (229.3) | 罗格斯大学 分析与数据科学硕士 | 商业与科学硕士学位的分析专业为学生的数据驱动决策做准备。它将计算机科学、统计学、机器学习、数据挖掘和大数据领域结合起来。学生将获得多种技能,包括分析大型数据集的能力、开发支持决策的建模解决方案的能力以及深入理解数据分析如何推动商业决策。 | 18-24 | $23136 ($23136) |

| 125 (NEW) | 都柏林大学 数据分析硕士及专业文凭 | 该课程将帮助你分析和理解通过自由获取的在线信息的大量数据集。这是一项极其宝贵的技能,受到雇主的强烈需求。 | 3690 学分 | \(7575 (\)) |

| 175 (170.5) | 德克萨斯农工大学 分析学硕士 | 统计学系提供的兼职分析学硕士课程提供来自排名靠前的梅斯商学院的课程,面向具有强大定量技能的在职专业人士,例如拥有科学、数学、商业和工程学位的本科生。 | 24 | $65000 ($54904) |

| 175 (171.9) | 亚利桑那州立大学 商业分析硕士 | 亚利桑那州立大学的 W.P. Carey 商业分析硕士(MS-BA)学位为你发展成长的职业领域提供了所需的工具,同时给予你按自己的时间表学习的灵活性。 | 1633 学分 | $39622 ($39622) |

| 175 (235.6) | 诺斯伊斯特大学 分析学专业硕士 | 分析学硕士项目帮助满足雇主的需求,通过核心课程和整合的实践学习机会,为学生提供端到端的分析教育。该项目使学生深入理解数据处理的机制(即数据的收集、建模和结构化),并具备识别和传达数据驱动洞察的能力,这些洞察最终会影响决策。 | 2445 学分小时 | $34200 ($29070) |

| 175 (NEW) | 俄亥俄大学 商业分析硕士 | 这个在线商业分析硕士课程超越了传统工具和方法。它传授你深入挖掘组织数据并用以做出关键商业决策所需的高级分析技能。 | 16-20 | \(35250 (\)) |

| 175 (NEW) | 莱斯大学 商业分析硕士 | 在莱斯商学院,你将建立有效开展业务所需的基础——然后学习如何跨团队思考和工作,以最大化组织内每个部门的产出。 | 24 | \(129000 (\)) |

| 225 (131.4) | 印第安纳大学布卢明顿 数据科学硕士 | 提供广泛的课程,涵盖数据挖掘、云计算、健康与医学、网络安全、高性能计算、机器学习和人工智能等主题,你可以根据自己的兴趣定制课程。 | 18 | $15172 ($15172) |

| 275 (322.6) | 圣母大学 数据科学硕士 | 该项目以方便的在线格式提供卓越的学术教育,优化了复杂定量材料的学习。它包含由圣母大学教职工授课的小班实时课程,面对面的专属沉浸周以及圣母大学所知名的个人关注学生成功。 | 21 | $48000 ($48000) |

| 325 (240.5) | 伊利诺伊理工学院 数据科学硕士 | 在伊利诺伊理工学院的数据科学硕士项目中,你将学习如何使用高级数学、统计学和计算机科学来探索数据。特别是,你将学习如何分析数据、可视化结果,并清晰地表达发现。完成该项目后,你将能够思考需要解决的实际问题,而不仅仅是寻找技术解决方案。 | 16 | $30985 ($30985) |

| 325 (402) | 锡拉丘兹大学 商业分析硕士 | BusinessAnalytics@Syracuse 是锡拉丘兹大学马丁·J·惠特曼管理学院提供的在线商业分析硕士项目。该项目帮助以数据为驱动的思考者发展或提升解读复杂数据的能力,并指导其组织做出更明智、更具操作性的决策。 | 2436 学分 | $54000 ($54000) |

| 375 (NEW) | 利物浦大学 大数据分析硕士 | 利物浦大学在线大数据分析硕士课程旨在提供使你能够利用大数据和分析的潜力来转变业务决策和规划的技能。 | 24-3390 学分 | \(变化 (\)) |

| 425 (283.3) | 加州大学河滨分校 数据科学硕士 | 在线工程硕士(数据科学专业)项目可以教你如何从大量数据中提炼出有价值的见解。课程设计旨在使毕业生能够开发高效的技术,以识别、分析和可视化数据组中的隐藏模式,从而提取关键信息。 | 13 | $24990 ($24990) |

| 425 (348.1) | 爱荷华州立大学 商业分析硕士 | 商业分析硕士是一个跨学科的研究生项目,旨在帮助在职专业人士应对“大数据”环境中的数据分析和商业智能挑战。该项目的开发旨在满足当今企业和组织面临的激烈全球竞争和不断的技术干扰的需求。 | 2130 学分,混合在线-校园 | $24000 ($21570) |

| 525 (1020.1) | 俄勒冈州立大学 数据分析硕士 | 该 45 学分的硕士学位项目具有跨学科课程,提供统计学、计算机科学和数学的扎实基础知识。你还可以选择健康分析的研究生选项。 | 17.545 学分 | $23445 ($23445) |

| 575 (1036.1) | 密苏里大学 数据与分析硕士 | 密苏里大学的数据与分析硕士学位是一个 34 学分的在线交付跨学科项目。我们欢迎来自各种学术背景的学生,成为密苏里及区域性相关行业中的高效数据科学家。我们的项目通过在多个学科中提供独特的课程重点,反映了数据科学不断发展的领域。 | 2434 学分 | $34000 ($34000) |

| 1000 (401.1) | CUNY SPS 数据科学硕士 | 数据科学硕士(以前为数据分析硕士)在线学位项目帮助学生获得进入或在快速增长的数据科学领域中晋升所需的证书和技能。 | 17.530 学分 | $13200 ($13200) |

| 1000 (1023.5) | 美国大学 商业分析硕士 | Kogod 商学院的分析硕士(MSAn)项目培养学生成为数据分析方面的专家。学生将学习如何利用数据解决各种组织和业务挑战,涉及财政绩效和运营效果。 | 1533 学分 | $54186 ($54186) |

| 1000 (1026.1) | 俄克拉荷马大学 数据科学与分析硕士 | 俄克拉荷马大学提供的在线数据科学与分析硕士学位由计算机科学学院和工业与系统工程学院合作开发。 | 1433 学分 | $26103 ($26103) |

| 1000 (1046.1) | 科罗拉多大学 商业分析硕士 | 商业分析教你使用数学模型来增强职场决策能力。这让你理解更常见的建模程序类型——大数据预测建模、数据分析、预测、运营管理及其他高级定量方法,从而学会基于数据做出决策。 | 2430 学分 | $39450 ($39450) |

| 1000 (1056.1) | 奥克拉荷马州立大学 商业分析硕士 | 提供在多平台环境中进行数据分析的实际应用,包括深入接触 SAS(r)工具以及使用 Python、R、SQL、Tableau 等其他工具和编程语言的培训。此外,该项目非常重视软技能和商业洞察力的发展。 | 2433 学分在线,37 学分校园 | $奥克拉荷马州居民: 13365, 非奥克拉荷马州居民: 33990 ($14175) |

| 1000 (n/a) | 贝克学院 商业智能 MBA | 我们的商业智能 MBA 项目旨在为希望了解更多信息资源的经理设计。你将能够上由经验丰富的商业经理和 IT 专业人士主讲的课程,帮助你全面了解商业世界。 | 17.538 学分小时 | $17100 ($17100) |

| 1000 (n/a) | 贝伊帕斯大学 应用数据科学硕士 | 贝伊帕斯的应用数据科学项目引导学生学习统计主题,从最大似然、假设检验和调查抽样,到重采样方法、时间序列分析和贝叶斯分析,再到各种回归方法,最终深入探讨支持向量机、树基方法、神经网络、图模型、EM 算法和集成学习等机器学习方法。 | 12-2436 学分 | $29340 ($29340) |

| 1000 (n/a) | 贝尔维尤大学 商业分析硕士 | 贝尔维尤大学的商业分析硕士课程旨在满足对能够利用前沿专业知识将大数据转化为战略资产的领导者的需求。 | 17.536 学分小时 | $20700 ($20340) |

| 1000 (n/a) | 布兰查德斯顿科技学院 应用数据科学与分析硕士 | 该项目与行业合作伙伴共同设计。我们硕士课程的毕业生将具备在数据科学和大数据分析为关键组成部分的行业中就业的能力,如保险、零售、制药、生物技术、商业、旅行、电信、政府和情报等部门。 | 24 兼职 | $2320 ($2320) |

| 1000 (n/a) | 卡佩拉大学 分析硕士 | 卡佩拉的分析硕士课程培养数据分析专业人员处理、理解和转化数据,以开发解决实际问题的方案,同时有效地向组织提供洞察和沟通结果。 | 1248 学分 | $25020-33360 ($32400) |

| 1000 (n/a) | 中央康涅狄格大学 数据挖掘硕士 | 数据挖掘硕士课程使学生能够在大型数据集中过滤出有趣且有用的模式和趋势。课程提供最先进的数据建模方法,帮助学生为信息时代的职业做好准备。 | 17.533 学分 | $21681 ($21681) |

| 1000 (n/a) | 科罗拉多技术大学 计算机科学硕士 - 数据科学 | CTU 的计算机科学硕士 - 数据科学方向专注于从结构化或非结构化数据中提取洞察和知识的方法、流程和系统。在 MSCS 课程的核心基础上,方向课程旨在为有意从事数据科学领域的人提供基础和专注的知识。 | 2448 学分,6 学期 | $28080 ($28080) |

| 1000 (n/a) | 德保罗大学 预测分析硕士 | 预测分析硕士课程应对了数据科学家日益增长的需求,这些科学家需要具备技术和分析技能的完美结合,以应对大数据分析的挑战。课程强调技术能力和实际经验,并为学生提供高级数据挖掘、多变量统计、机器学习和数据库处理技能。 | 17.552 学分小时 | $43160 ($43160) |

| 1000 (n/a) | 数据科学技术学院 信息系统与大数据工程人工智能硕士 | 这个为期 9 个月的高级硕士课程(3 个月的课程,6 个月的实习),秋季和春季有两个入学机会,旨在为你打开大数据工程职位的大门,结合数学与计算机科学的卓越,这是所有行业都在寻找的。 | 9 | $7900 ($4640) |

| 1000 (n/a) | 数据科学技术学院 应用数据科学与大数据硕士 | 这个为期 6 个月的课程和 6 个月实习的应用硕士课程,秋季和春季有两个入学机会,旨在为你打开大数据分析职位的大门,这是所有行业都在寻找的。 | 6 | $7900 ($7680) |

| 1000 (n/a) | 达科他州立大学 分析学硕士 | 通过该项目,你将获得并磨练成为分析和数据科学专业人士所需的技能。 | 1030 学分 | $13320 ($13320) |

| 1000 (n/a) | 埃尔姆赫斯特学院 数据科学硕士 | 埃尔姆赫斯特的数据科学硕士项目采取全面的方法,课程整合了统计学、计算机科学和商业,这些技能领域对在新兴的大数据领域取得成功至关重要。 | 2410 课程,30 学分兼职 | $25350 ($25350) |

| 1000 (n/a) | 全帆大学 商业分析硕士 | 全帆大学的商业智能理学硕士项目教你如何收集和分析大数据,以更好地服务于客户需求。通过技术作为解读的视角,你将创建视觉表现,传达对任何行业至关重要的信息。 | 1236 学分 | $28008 ($28008) |

| 1000 (n/a) | 拉萨尔大学 分析学硕士 | 我们的压缩课程格式允许你一次专注于一个主题领域,同时在不到两年的时间内完成课程。每门课程长度为八周,允许你每学期完成两门课程。我们的学期有秋季、春季和夏季。该项目的学生将发展定义和协调大数据源、模拟预测模型和可视化结果的策略。学生将与来自不同行业的内部和外部数据源进行工作。 | 2030 学分 | $26250 ($26250) |

| 1000 (n/a) | 路易斯大学在线 数据科学硕士 | 路易斯大学的数据科学硕士在线学位旨在提供提升的数学和计算机科学技能,以应对围绕大数据分析的问题。路易斯大学的数据科学硕士在线项目为你提供数据挖掘、数据可视化、预测分析和数据管理的技能。 | 2433 学分 | $26235 ($26235) |

| 1000 (n/a) | 圣路易斯大学 商业数据分析硕士 | 该项目旨在帮助学生获得可立即应用于工作场所的实用知识,由一支活跃的专业人士团队授课,使用当前商业新闻驱动的真实案例。MSBDA 为当前从业者和职业转换者提供了获得研究生级别资格证书的机会,授予高质量的在线学位。 | 17.530 学期学时 | $22950 ($22950) |

| 1000 (n/a) | 凤凰大学 信息系统硕士与研究生商业分析证书 | 通过我们的信息系统硕士与研究生商业分析证书(MIS/BA),你将发展所需的统计分析、数据关系管理和分析编程技能,帮助企业做出基于证据的决策。 | 17.542 credits | $29316 ($31080) |

| 1000 (n/a) | 雷吉斯大学 数据科学硕士 | 受我们的耶稣会传统启发,雷吉斯大学的数据科学硕士项目为你准备了一个需求旺盛的数据分析职业,帮助你从数据中提取见解,并以社会负责的方式沟通这些见解如何影响你工作的企业和你周围的世界。 | 17.536 credits | $25560 ($25560) |

| 1000 (n/a) | 圣玛丽学院 数据科学硕士 | 我们主要的在线项目将为你提供所需的数学和计算深度,以精炼别人仅仅使用的工具。你将建立一个坚实的数学基础——在不断变化的世界中一种持久的技能——使你能够应对现在和未来的复杂数据挑战,无论你使用什么编程语言。 | 2436 credits | $31946 ($28944) |

| 1000 (n/a) | 南达科他州立大学 数据科学硕士 | SDSU 的数据科学硕士项目是一个 30 学分的项目,设计为在一个日历年内完成,从 6 月到 5 月,尽管学生可以根据需要多花一年时间完成。为了方便起见,暑期课程提供在线学习,学生可以在夏季在线开始项目,并在随后的学年在校园内完成。 | 1230 credits | $13320 ($13320) |

| 1000 (n/a) | 圣约瑟夫大学 商业智能与分析硕士 | 圣约瑟夫大学的在线商业智能与分析硕士(MSBIA)——这是首批完全在线提供的商业智能与分析硕士学位之一——由商业智能和分析行业中心的专家设计和提供。你可以从三个职业发展方向中选择:通用方向、数据分析或编程语言。 | 2430 credits | $17520 ($17520) |

| 1000 (n/a) | 南卫理公会大学 数据科学硕士 | DataScience@SMU 是一个为当前和未来的数据科学专业人士设计的在线数据科学硕士课程。通过互动课程、协作小组活动和在线面对面课堂,你将获得做出有意义的数据驱动决策所需的技术、分析和沟通技能。 | 20-28 | $57084 ($57084) |

| 1000 (n/a) | 南新罕布什尔大学 数据分析硕士 | 我们的数据分析硕士在线课程专注于数据分析在广泛行业中的战略和高级应用。课程涵盖数据挖掘、可视化、建模、优化及数据的伦理使用。 | 1512 学分 | $22572 ($22572) |

| 1000 (n/a) | 滑铁卢大学 数据分析硕士 | SRU 的数据分析硕士学位为 33 学分,可以在全日制 10 个月或兼职 2 年内完成。该项目的一个特别显著特点是其与专业证书项目标准的对齐验证。 | 1033 学分 | $16269 ($16269) |

| 1000 (n/a) | 阿拉巴马大学亨茨维尔 管理科学-商业分析硕士 | MSMS-BA 课程旨在满足课程质量、教师卓越和项目相关性的最高标准,符合商学院的 AACSB 国际认证标准 - 高等商学院协会。 | 1230 学分 | $21810 ($21810) |

| 1000 (n/a) | 马里兰大学大学学院 数据分析硕士 | 马里兰大学大学学院的数据分析硕士课程结合了技术和商业学科的学习,使你成为一名具有强大职业潜力的数据分析师。你将学习如何管理和操控数据、创建数据可视化,并做出战略性的基于数据的推荐以影响业务成果。 | 17.536 学分 | $24984 ($24984) |

| 1000 (n/a) | 维拉诺瓦大学 分析硕士 | 与其他结合现有学位课程的项目不同,我们的分析课程专门设计以满足当前商业需求。课程涉及数据管理、商业智能、预测和处方模型及其在所有业务职能中的应用,我们的项目可以为你在分析领域的成功做好准备。 | 24 | $43400 ($43400) |

| 1000 (n/a) | 西弗吉尼亚大学 商业数据分析硕士 | 西弗吉尼亚大学商学院提供的在线商业数据分析硕士课程,帮助学生在统计技术、数据挖掘、数据库利用及分析工具方面获得专业知识。“大数据”正在推动企业和非营利组织的决策,并创造对数据分析技能的需求。 | 17.530 学分 | $30690 ($29790) |

| 1000 (NEW) | 莫拉维安研究生在线 预测分析硕士 | 莫拉维安研究生在线的预测分析硕士课程通过提供个性化的学生支持、由实际行业指导的课程以及一对一的职业指导,帮助学生成功提升职业发展。 | - | 未说明 |

| 1000 (NEW) | 北中部大学 数据科学硕士 | 这个数据科学硕士课程旨在帮助学生深入理解这一新兴的跨学科领域。学生将获得包括数据生命周期在内的广泛知识基础,并学习如何将大量非结构化数据处理成组织可以利用的可用数据集。 | 23 | $30530 |

| 1000 (NEW) | 爱丁堡纳皮尔大学 数据科学硕士课程 | 数据科学是商业和公共部门的一个主要增长领域,且目前缺乏具备所需数据科学知识和技能的专业人士。该以工作为基础的硕士数据科学课程旨在解决这一短缺问题。 | 24-33 180 学分 | $9060 |

| 1000 (NEW) | 德雷克塞尔大学 数据科学硕士 | 在当今就业市场中最快速增长的领域之一脱颖而出,德雷克塞尔大学的在线数据科学硕士学位课程将帮助你通过创建机器学习算法来分析和处理数据,从而解决公司问题。 | 2445 学分 | $56925 |

| 1000 (NEW) | 梅里马克学院 数据科学硕士 | 在课堂上学习可以实际应用于工作的技能。梅里马克学院的在线数据科学硕士学位课程教授学生使用最新工具和分析方法解决问题。 | 1632 学分 | $28320 |

| 1000(新) | 梅里马克学院 商业分析硕士 | 通过在工作中立即使用的适用技能来利用你的时间。梅里马克学院的在线商业分析硕士学位课程教学生解决问题和可视化数据集,使用最新的行业工具和分析方法。 | 1632 学分 | $28320 |

| 1000(新) | 特拉华大学 应用统计硕士 | 特拉华大学的在线应用统计硕士课程(ASTAT)将学生培养成数据专业人士,能够满足对统计学专业知识日益增长的需求。我们的学生从受尊敬的大学获得高质量、负担得起且相关的教育,并准备好在数据科学、大数据、商业分析和相关职业中取得成功。 | NA 根据要求提供 | NA - 根据要求提供 |

| 1000(新) | 瓦尔纳自由大学 数据科学硕士 | 瓦尔纳自由大学“切尔诺里泽茨·赫拉巴尔”提供的数据科学硕士课程专注于计算机科学的前沿问题,符合国际、欧洲和国家标准与要求。我们的目标是培养更多数据科学领域的专业人才,以满足软件公司的需求。 | 12 | $5391 |

| 1000(新) | 约翰逊与威尔斯大学 数据分析硕士 | 事实是:今天的企业依赖数据。通过这个硕士课程为自己在数据分析领域的成功职业做好准备。你将通过这个在线数据分析硕士学位获得数据挖掘、分析、管理和可视化、预测、建模、优化和仿真的专业知识。 | 2432 学分 | $23744 |

| 1000(新) | 肯特州立大学 数字科学(数据科学)硕士 | 数字科学硕士(MDS)学位是为来自各种背景的毕业生设立的职业硕士项目。入学不要求有数字科学学士学位,学生可以在秋季或春季学期入学。 | 1232 学分 | $21524 |

资源:

相关:

了解更多相关内容

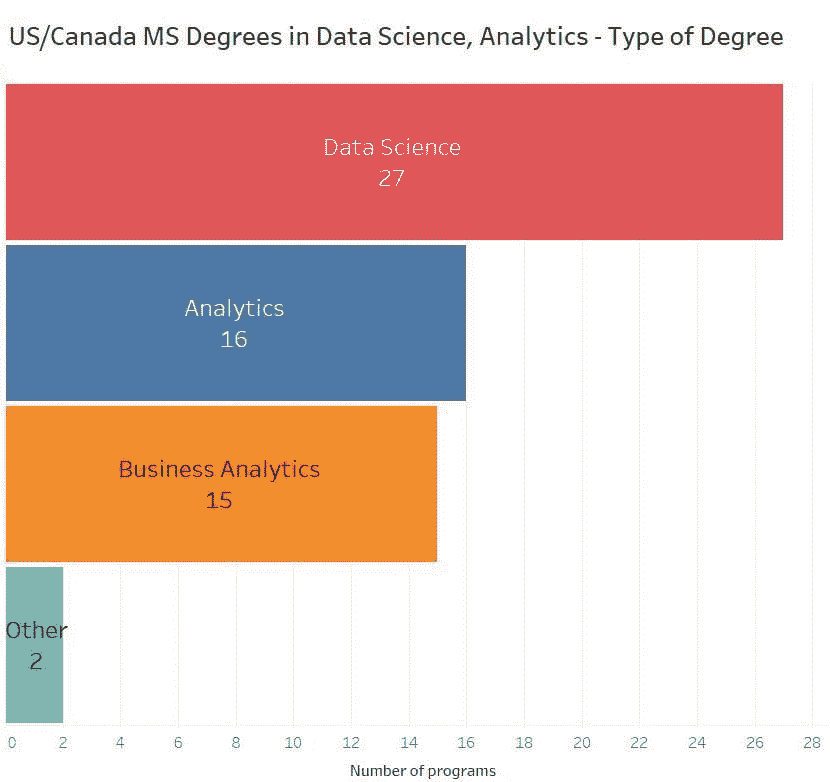

美国/加拿大最佳分析学、商业分析、数据科学硕士课程

原文:

www.kdnuggets.com/2019/05/best-masters-data-science-analytics-us-canada.html

评论

评论

数据科学和分析是一个非常热门的领域,对数据科学家的需求仍在强劲增长。许多大学介入并创建了许多相关学位,主要是硕士学位。

这是更新后的分析学、数据科学硕士课程条目:

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

回到 2017 年,我们曾经发布了一系列文章,探讨了美国、欧洲和在线的最佳学位。幸运的是,我们现在已经更新了这份全面的名单,并添加了许多新的硕士课程。

我们已经发布了我们权威的在线硕士指南以及欧洲的指南,这篇文章将重点介绍美国和加拿大的项目。

包含了 CS 排名,这是前 50 名大学的计算机与信息系统研究生课程排名。虽然这个排名在计算方式上并非 100%科学,但它确实提供了关于提供这些课程的学校的良好参考。未出现在排名中的大学被标记为 NA。

我们包含了 2017 年版本的信息,以便您了解这些学校在过去几年中的变化。和往常一样,请在评论区告诉我们如果我们遗漏了任何内容,我们会相应地更新列表。

-

麻省理工学院商业分析硕士学位。该项目专为计划从事数据科学行业的在读学生或近期大学毕业生量身定制,也适合寻求职业发展或转行的人员,特别是工程师、数学家、物理学家、计算机程序员及其他高科技专业人士。(12 个月课程,整个课程学费 77,350 美元(2017 年学费为 57,350 美元),计算机科学排名:1(2017 年计算机科学排名:1))

-

斯坦福大学统计学硕士:数据科学数据科学方向通过硕士核心课程和编程要求,培养扎实的数学、统计、计算和编程技能,同时通过数据科学及相关领域课程的通用和专门选修课程提供基础的数据科学教育。(24 个月课程,每年 32,658 美元(32,658 美元/年),计算机科学排名:2(2))

-

卡内基梅隆大学计算数据科学硕士该项目使你掌握开发下一代大规模信息系统部署中涉及的技术层面以及分析这些系统生成的数据所需的技能和知识。(16 个月课程,整个课程 76,500 美元(75,484 美元),计算机科学排名:3(3))

-

哈佛大学数据科学硕士学位该项目将提供在统计建模、机器学习、优化、大规模数据集管理与分析以及数据获取方面的扎实准备。该项目还将关注可重复的数据分析、协作问题解决、可视化和沟通,以及数据科学中的安全和伦理问题。(18 个月课程,全程学费 44,816 美元(44,816 美元),计算机科学排名:7(6))

-

多伦多大学应用计算硕士(数据科学方向)由计算机科学系和统计科学系共同提供,教授计算机科学与统计学交汇处的数据科学。(16 个月课程,公民学费 26,000 美元(11,320 美元),国际学生学费 56,000 美元(27,590 美元),每年,计算机科学排名:11(10))

-

华盛顿大学数据科学硕士学位该硕士项目为你提供从大型、嘈杂且异质的数据集中提取知识的技术技能——大数据——以提供可供人们和组织使用的见解。在此项目中,你将深入掌握管理、建模和可视化大数据的技能,以满足今天工业、政府、非营利和研究组织日益增长的需求。(17.5 个月课程,46,575 美元(46,125 美元)全程学费,计算机科学排名:17(16))

-

哥伦比亚大学的数据科学硕士该项目允许学生将数据科学技术应用于他们感兴趣的领域,基于四门基础课程。我们的学生有机会进行原创研究,纳入一个顶点项目,并与行业合作伙伴和教职工互动。(18 个月课程,全额学费$58,080($58,080),计算机科学排名:18(29))

-

纽约大学的数据科学硕士这是一个高度选择性的项目,面向具有数学、计算机科学和应用统计学强大背景的学生。该学位专注于开发新的数据科学方法。课程提供两种结构化研究生项目的方式,让学生有机会通过不同方向追求专业化。(24 个月课程,全额学费$62,028($62,028),计算机科学排名:20(32))

-

滑铁卢大学的数学硕士(统计学或计算机科学)这两个学位不同,但都提供数据科学专业化。在这些项目中,你将学习应用和开发方法,以从可用数据中获得洞察,理解、预测和改进商业战略、产品和服务、市场营销活动、医学、公共卫生与安全以及其他众多领域。(18 至 24 个月课程,加拿大居民$11,466($11,466),国际学生$30,666($30,666),全额学费,计算机科学排名:22(31))

-

乔治亚理工学院的分析学硕士这是一个跨学科的学位项目,结合了乔治亚理工学院在统计学、运筹学、计算机科学和商业领域的优势,通过结合 Scheller 商学院、计算机学院和工程学院的世界级专业知识,毕业生将学会以独特和跨学科的方式整合技能,从而深入洞察分析问题。(24 个月课程,提供在线选项,本州居民$43,416($43,416),外州学生$59,940($59,940),在线课程$9,900($9,900),计算机科学排名:24(28))

-

不列颠哥伦比亚大学的数据科学硕士是一个由 UBC 计算机科学系和统计系共同开发的专业课程,旨在满足这一需求,为学生提供快速通道进入优秀职业。通过使用描述性和规范性技术,学生从非结构化和结构化的数据中提取和分析数据,然后以帮助组织基于数据做出明智决策的方式传达这些分析结果。(10 个月课程,$31,836($24,033)本州居民;$43,709($32,675)国际学生,计算机科学排名:28(23))

-

德克萨斯大学奥斯汀分校的商业分析硕士学位 这是一个 10 个月的项目,将教会你如何利用大量数据并将其用于构建更好的商业模式。(10 个月的项目,州内 $43,000($43,000),州外 $48,000($48,000)全项目,CS 排名:29(26))

-

宾夕法尼亚大学的数据科学工程硕士学位 数据科学学位课程可以在一到两年内完成。它结合了机器学习、大数据分析和统计学等核心主题的前沿课程,以及各种选修课程,并提供在选择的领域专长 – 深度领域 – 应用这些技术的机会。(12 或 24 个月的项目,全学费 $67,660($67,660),CS 排名:34(39))

-

南加州大学的计算机科学硕士学位(数据科学) 该项目为学生提供计算机科学的核心背景,并在获取、存储、访问、分析和可视化大规模、多样化和实时数据方面提供算法、统计和系统方面的专门知识。这些数据与包括能源、环境、健康、媒体、医学和交通等各种现实世界领域相关。该项目既提供现场课程也提供在线课程。(24 个月的项目,州内 $55,886($55,886),州外 $63,634($63,634),在线 $61,984($61,984)全学费,CS 排名:44(50))

-

加州大学圣地亚哥分校的数据科学与工程高级研究硕士学位 在这个项目中,工程专业人员将软件程序员、数据库管理员和统计学家的技能结合起来,创建数据的数学模型,识别趋势/偏差,然后以有效的可视化方式展示,使他人能够理解。(24 个月的项目,全学费 $39,121($39,100),CS 排名:46(38))

-

马里兰大学学院公园分校的商业分析硕士学位 该项目深入探讨了大数据的理解及其对商业的优势利用。作为华盛顿特区地区最好的项目之一,MSBA 涵盖了网络安全、信息系统、供应链和交通、社交媒体和网络分析、预测以及定量分析等主题。(16 个月的项目 $49,892($49,042)州内,$62,762($62,422)州外全学费,CS 排名:50(47))

-

新 密歇根大学的商业分析硕士学位 商业分析硕士课程培训学生利用数据和统计信息制定商业策略。(12 个月的项目,州内 $21,241,州外 $48,579 全学费,CS 排名:50)

-

威斯康星大学麦迪逊分校的统计学-数据科学硕士。利用统计思维的力量将帮助你将数据放入上下文中,并将其含义传达给他人。你将通过现实的战略规划会议来提升分析、推理和沟通技巧。因此,MS-DS 将使你在与专业人士和商业领袖的团队合作中,具备坚实的技能,并能够领导基于数据推理的讨论。(12 个月或 24 个月项目,州内学费 $23,820 ($23,820),州外学费 $48,810 ($48,810),计算机科学排名:75(75))

-

波士顿大学城市学院的应用商业分析硕士。该项目全面覆盖了在数据驱动的商业决策过程中使用的最先进的概念、技术和工具。无论是在线学习、校园学习还是两者结合,学生将获得使用各种分析模型和决策支持工具的实践经验,并将其应用于营销、运营、产品和技术创新、金融服务等领域的大数据集和互联数据输入。(18 个月或 24 个月项目,每学期 $25,490 ($25,490),计算机科学排名:75(75))

-

印第安纳大学布鲁明顿分校的数据科学硕士。通过广泛的课程选择,如数据挖掘、云计算、健康与医学、网络安全、高性能计算、机器学习和人工智能,你可以根据兴趣定制课程。(18 个月项目,现场学习:州外 $43,717 ($43,717),州内 $15,172 ($15,172);在线学习:州外 $21,457 ($21,457),州内 $13,470 ($13,470),计算机科学排名:75(125))

-

新 芝加哥大学的分析学硕士。该硕士课程基于应用统计学的核心,为学生提供高级分析培训,以发展从大数据中提取洞见和构建自动化人工智能系统的能力。(12 个月项目,全学费 $4,640,计算机科学排名:75)

-

约翰斯·霍普金斯大学的数据科学硕士。严格的课程重点关注计算机科学、统计学和应用数学的基础,同时结合现实世界的例子。通过在线和在约翰斯·霍普金斯应用物理实验室的现代设施现场学习,学生从实践中的工程师和数据科学家那里学习。毕业生准备好在涉及数据管道和存储、统计分析以及提取数据故事的专业工作中取得成功。(17.5 个月项目,全学费$52,170,CS 排名:125(75))

-

马萨诸塞大学安姆赫斯特分校的计算机科学硕士(数据科学方向)。该项目旨在满足对数据科学领域扩展和增强培训的需求。它要求完成数据科学理论、数据科学系统、数据分析和统计课程。它教你开发和应用方法来收集、整理和分析大规模数据,并利用这些分析进行发现和决策。(24 个月项目,州内学费$25,000,州外学费$46,400,CS 排名:125(75))

-

西北大学的分析硕士。该项目教授学生在当今竞争激烈、数据驱动的世界中推动商业成功的技能。借助著名教授和来自主要公司的讲师的专业知识,我们将数学和统计学研究与先进的信息技术和数据管理教学相结合。(15 个月项目,每季度$18,040(全学费$52,239),CS 排名:125(125))

-

西蒙弗雷泽大学的大数据专业硕士。学生将很好地准备成为数据科学家/程序员、数据解决方案架构师和首席数据官,能够提供影响战略决策的见解。该项目具有挑战性,适合在计算机科学或定量领域(如工程或物理)有强大能力的学生。(16 个月项目,居民学费$27,592,国际学费$32,898,CS 排名:125(125))

-

北卡罗来纳州立大学的分析硕士。如果你擅长数学和统计编程,并且对数据工作充满热情,那么这个项目适合你。MSA 独特地设计了,使像你这样的个人能够从大量和多样的数据中提取并有效沟通可操作的见解。(10 个月项目,州内学费$23,460,州外学费$43,466,CS 排名:125(125))

-

弗吉尼亚大学的数据科学硕士 我们严格的职业硕士项目通过将课堂学习与在行业、学术界和政府合作伙伴处进行的实际项目相结合,为学生准备好领导数据科学前沿领域。 (11 个月项目,$25,534($25,534)州内,$40,626($40,626)州外,CS 排名:175(175))

-

德克萨斯 A&M 大学的分析硕士 这是一个兼职硕士学位,提供来自排名靠前的梅斯商学院的课程,面向具有强大定量技能的在职专业人士,例如理科、数学、商业和工程领域的学士学位持有者。提供在线和现场选项。 (24 个月项目,$65,000($54,904)学费全额,CS 排名:175(175))

-

亚利桑那州立大学的商业分析硕士 该项目为你进入动态扩展的数据驱动分析和战略业务决策领域做好准备。你将获得帮助公司利用数据获取竞争优势所需的技能。ASU 还提供在线项目,你可以在这里找到更多信息。 (9 个月项目,$10,970($10,970)州内,$21,888($21,888)州外,$23,508($23,508)国际学费全额,CS 排名:175(175))

-

女王大学的管理分析硕士 在这个项目中,你将从北美一些最优秀的管理教育者那里学习。此外,还会有几次课程包括行业专家和从业者。这确保了你能够从当前在行业中工作的人的角度了解最新趋势和实践。 (16 个月项目,$63,500($44,600)居民,$80,000($67,750)国际,学费全额,CS 排名:175(175))

-

新 伊利诺伊大学芝加哥分校(UIC)的商业分析硕士。商业分析硕士提供了一个全面的方法,学生在数据管理、机器学习和预测分析方面发展专业知识,同时建立坚实的商业技能背景。学生获得分析大型数据集并通过数据可视化、统计建模和数据挖掘技术生成洞察的技能。该项目课程强调行业经验、曝光度和跨多个分析项目的合作。 (12 个月项目,$5,830 州内,$11,950 州外,CS 排名:175)

-

全新 密歇根州立大学的商业分析硕士。如今的数据比以往任何时候都多,分析已成为每个重大商业决策的一部分。通过密歇根州立大学的商业分析硕士课程,你可以成为这一新兴转型和领先新行业的重要组成部分。(12 个月项目,本州生全学费$36,000,外州生全学费$39,000,CS 排名:175)

-

明尼苏达大学的数据科学硕士。该项目通过汇集数据收集和管理、数据分析、可扩展的数据驱动模式发现及其基本概念,提供了大数据及其分析的坚实基础。(18 或 24 个月项目,本州生每学期$8,364($8,364),外州生每学期$12,942($12,942),CS 排名:225(125))

-

罗格斯大学的分析与数据科学硕士课程。该项目为学生的数据驱动决策制定做好准备。它将计算机科学、统计学、机器学习、数据挖掘和大数据等领域结合在一起。学生将获得多种技能,包括分析大数据集的能力、开发建模解决方案以支持决策的能力以及深入理解数据分析如何推动商业决策。提供在线选项。(24 个月项目,$23,136($23,136)本州生,$28,128($28,128)外州生全学费,CS 排名:225(225))

-

东北大学的专业分析硕士。该项目帮助满足雇主的需求,提供一个全面的分析教育,包括核心课程和综合实践学习机会。该项目为学生提供了对数据工作机制的深刻理解,以及识别和传达数据驱动洞察的能力,最终影响决策。提供在线选项。(24 个月项目,全学费$34,200($29,070),CS 排名:225(225))

-

伊利诺伊理工学院的数据科学硕士。在这个项目中,你将学习使用高级数学、统计学和计算机科学探索数据。你将学习如何分析数据、可视化结果并表达发现。你将带着解决实际问题的能力而非仅仅找到技术解决方案的能力离开该项目。提供在线选项。(16 个月项目,全学费$30,985($30,985),CS 排名:225(225))

-

新 加州大学戴维斯分校商业分析硕士。在为期一年的课程中,你将受益于我们与位于旧金山和硅谷的前沿大数据公司深厚的联系。(12 个月课程,全额学费$57,200,计算机科学排名:225)

-

爱荷华州立大学商业分析硕士。该项目是一个跨学科的研究生课程,面向在“海量数据”环境中处理数据分析和商业智能的在职专业人士。它旨在满足今天面临激烈全球竞争和不断技术变革的企业和组织的需求。在线提供。(21 个月课程,全额学费$24,000($21,570),计算机科学排名:325(325))

-

新 乔治梅森大学数据分析硕士。该证书课程旨在帮助有兴趣解决如何将商业分析、网络防御/取证、能源、金融、基因组学、医疗保健、情报、执法或运输等应用中产生的大量数据转化为有意义的信息的学生。该项目面向那些可能在大数据应用领域发展的研究生。(12 个月课程,本州学生全额学费$15,826,外州学生全额学费$37,333,计算机科学排名:325)

-

新 中佛罗里达大学数据分析硕士(大数据)。数据分析硕士是一个 30 学分的跨学科项目,旨在培养学生开发算法和计算机系统,以促进从大量数据中发现信息。它将利用大数据分析的技术方面,包括算法设计、编程、获取、管理、挖掘、分析和解释数据。(12 个月课程,全额学费$36,300,计算机科学排名:375)

-

新 乔治城大学公共政策数据科学硕士。该课程独特地结合了数据科学与定量公共政策分析,为毕业生提供前沿的计算、分析和领导能力。(12 个月课程,全额学费$54,570,计算机科学排名:425)

-

美国大学商业分析硕士学位。该项目旨在培养学生成为数据分析专家。学生将学习如何利用数据解决与财政绩效和运营效益相关的各种组织和商业挑战。在线提供。(15 个月课程,全额学费$54,186($54,186),计算机科学排名:NA(325))

-

圣玛丽大学的计算与数据分析硕士。MSc CDA 课程的主要重点是培养高素质的计算和数据分析专业人士,以推动创新和组织成功。MSc CDA 通过实践学习机会和行业互动,帮助学生为数据科学行业中的有利可图的职业做好准备。(16 个月课程,$19,000($17,000)本地生,$35,000($33,000)国际生全额学费,CS 排名:NA)

-

俄克拉荷马大学的数据科学与分析硕士。该课程的毕业生将具备设计和构建工具以提取、吸收和分析数据的技能,以及预测和提升企业在各个领域未来表现的系统理解。课程由计算机科学学院和工业与系统工程学院合作提供。(14 个月课程,$32,500($26,103)全额学费,CS 排名:NA)

-

科罗拉多大学丹佛分校的商业分析硕士。商业分析教你使用数学模型来增强工作场所的决策能力。这使你理解更常见的建模程序——大数据预测建模、数据分析、预测、运营管理及其他高级定量方法——从而基于数据做出决策。提供在线和晚间课程选项。(24 个月课程,$39,450($39,450)全额学费,CS 排名:NA)

-

贝尔维尤大学的商业分析硕士。该课程旨在满足对能通过前沿专业知识将大数据转化为战略资产的领导者的需求。提供在线课程。(24 个月课程,$20,700($20,340)全额学费,CS 排名:NA)

-

德保罗大学的预测分析硕士。该课程应对了对数据科学家的需求,要求具备技术和分析技能,以应对大数据分析的挑战。课程强调技术熟练度和实践经验,提供数据挖掘、多变量统计、机器学习和数据库处理方面的高级技能。(17.5 个月课程,$43,160($43,160)全额学费,CS 排名:NA)

-

雷吉斯大学的数据科学硕士。受耶稣会传统的启发,该项目为您准备了一份有需求的职业,分析数据,从中获取见解,并以社会负责的方式沟通其对您工作的业务及周围世界的影响。 (24 个月项目,$25,560($25,560)全额学费)

-

南达科他州立大学的数据科学硕士。这是一个 30 学分的项目,设计为在一个日历年内完成,即从 6 月到 5 月,尽管学生如果愿意,可以花费超过一年完成。为了方便起见,夏季课程可以在线学习,以便学生可以在夏季在线开始项目,并在随后的学年内在校园完成。 (12 个月项目,$13,320($13,320)全额学费,计算机科学排名:NA)

-

阿拉巴马大学亨茨维尔分校的管理科学-商业分析硕士。该项目旨在满足最高的课程质量、师资优秀和项目相关性标准,符合 AACSB 国际商学院联合会的认证要求。 (12 个月项目,$21,810($21,810)全额学费,计算机科学排名:NA)

-

密歇根大学迪尔伯恩分校的数据科学硕士。课程包括必修核心课程和技术选修课程,提供在当前就业市场高度需求的各个数据科学领域建立知识和职业技能的机会。 (18 至 24 个月项目,州内$20,490($20,490)全额学费,州外$35,280($35,280)全额学费,计算机科学排名:NA)

-

旧金山大学的数据科学硕士。该项目提供技术课程以及通过为期九个月的实习项目获得的无与伦比的实践经验。学生每周两天在位于湾区及其他地区的合作公司现场工作。课程受到来自 Facebook、Eventbrite、Buzzfeed 等数据科学家顾问委员会的影响,涵盖了机器学习、数据获取、统计建模、数据库管理、数据可视化、自然语言处理和深度学习等主题。 (12 个月项目,$48,825($48,825)全额学费,计算机科学排名:NA)

-

田纳西大学查塔努加分校计算机科学-数据科学硕士课程。该硕士课程旨在培养学生在专业思维和直觉方面的技能,使学生能够做出合理的专业评估和决策。毕业生应能够在商业、政府和教育的研究、开发和规划层面承担责任,或继续进行更进一步的正式培训。(24 个月课程,本州学费$20,040,外州学费$32,236,计算机科学排名:NA)

-

全新 克拉克大学商业分析硕士课程。通过掌握商业中最受欢迎的领域,迎接大数据的潮流——加速你的职业发展。(12 个月课程,全额学费$55,770,计算机科学排名:NA)

-

全新 新罕布什尔大学分析硕士课程。大数据是个大问题,各行各业——从职业体育队(想想《点球成金》和选秀)到医疗保健(基因编码和疾病预防)——都需要分析和数据科学专家。在仅仅 12 个月内,你可以成为其中的一员。(12 个月课程,本州学费$14,170,外州学费$27,810,计算机科学排名:NA)

-

全新 托马斯·爱迪生大学数据科学与分析硕士课程。托马斯·爱迪生州立大学(TESU)与 Statistics.com 的统计教育研究所合作,提供完全在线的数据科学与分析硕士学位课程,专门针对在职成人的独特需求进行设计。(12 个月课程,本州学费$7,519,外州学费$9,967,计算机科学排名:NA)

-

全新 耶希瓦大学数据分析与可视化硕士课程。在耶希瓦大学的 30 学分数据分析与可视化硕士课程中,你将开发一个适合工作的项目组合,并加深对数据科学和可视化的核心原则、模式和实践的理解。(12 个月课程,全额学费$32,070,计算机科学排名:NA)

资源:

相关:

更多相关内容

轻松找到最匹配的数据分布

原文:

www.kdnuggets.com/2021/10/best-matching-distribution-data-effortlessly.html

评论

我们的目标是什么?

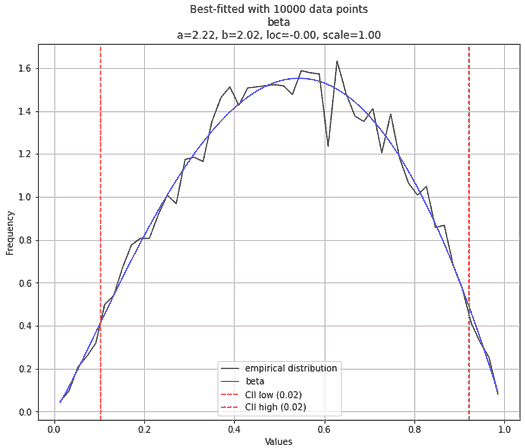

图片来源:由作者准备,使用了 Pixabay 图片(免费使用)

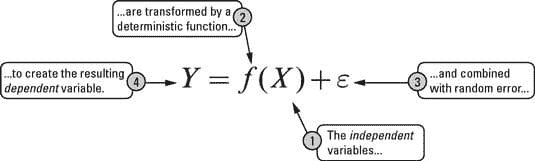

你有一些数据点。最好是数值型的。

你想找出这些数据可能来自哪个统计分布。经典的统计推断问题。

当然,有严格的统计方法可以实现这个目标。但是,也许你是一个忙碌的数据科学家。或者是一个更忙的程序员,他恰好被分配了这个数据集,需要迅速编写一个应用端点,以找到最匹配数据的分布。以便另一个机器学习应用可以使用基于此分布生成的一些合成数据。

简而言之,你没有很多时间,想要找到一种快速的方法来发现最匹配的数据分布。

基本上,你希望对多个分布运行一批自动化的拟合优度(GOF)测试,并快速总结结果。

当然,你可以从头开始编写代码,使用例如 Scipy 库逐一运行标准 GOF 测试,针对多个分布进行测试。

或者,你可以使用这个小巧但实用的 Python 库——distfit 来为你完成繁重的工作。

Distfit——一个用于自动拟合数据分布的 Python 库

根据他们的网站,**distfit** 是一个用于单变量分布概率密度拟合的 Python 包。它通过残差平方和(RSS)和其他 GOF 测量来确定在 89 种理论分布中最好的拟合。

让我们看看如何使用它。这是 演示笔记本。

按照常规安装,

pip install -U distfit

生成测试数据并进行拟合

生成一些正态分布的测试数据,并将它们拟合到 distfit 对象中。

基本上,你希望对多个分布运行一批自动化的拟合优度(GOF)测试,并快速总结结果

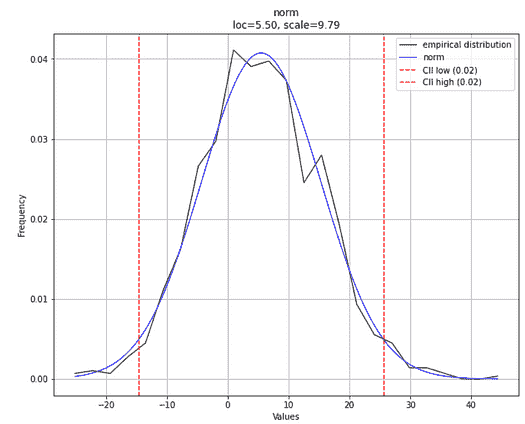

拟合效果如何?

那么,拟合效果如何?

注意,在上面的代码中,模型dist1对生成分布或其参数(即正态分布的loc或scale参数)没有任何了解,也不知道我们调用了np.random.normal来生成数据。

我们可以通过一段简单的代码一次性测试拟合优度和估计参数,

dist1.plot(verbose=1)

这是预期的图(注意,由于生成数据的随机性质,图形在你的情况下肯定会有所不同)。

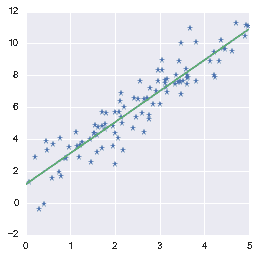

注意图例副标题中拟合过程估计的**loc**和**scale**参数。这些参数值与我们之前设置的值非常接近,不是吗?估计的分布类型显示为norm,即正态分布。完全正确。

作者创建的图像

关于拟合模型的更多信息

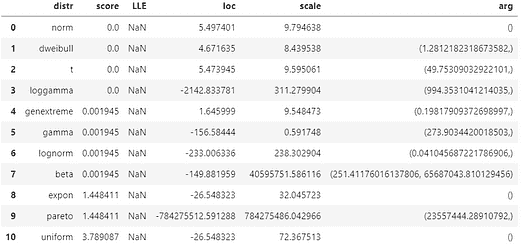

使用另一行代码,你可以获取所有拟合到数据(内部)并测试拟合优度的分布的摘要。

dist1.summary

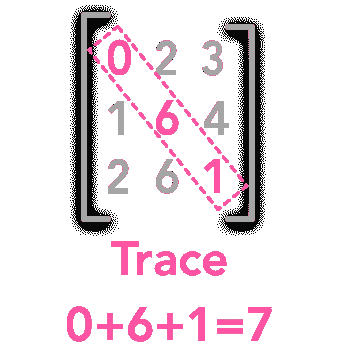

你会得到如下结果,

作者创建的图像

这显示了所有测试过的各种分布的参数。它还显示了**score**,表明拟合优度**——即预期数据和给定数据之间的距离,数值越低越好。请注意,在这个模型中有多个分布的得分相同且为零,但根据内部逻辑,正态分布被选择为最可信的分布。

为什么在这个摘要中只有 10 个分布?因为默认情况下,它使用最受欢迎的 10 个分布的列表进行扫描。你可以在初始化distfit对象时将确切的列表作为参数指定。

使用 Scipy 内部

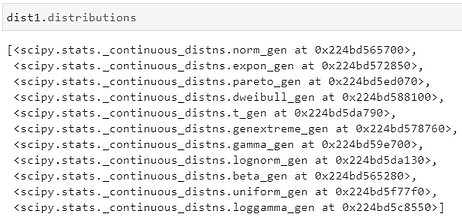

如果你输入dist1.distributions,你将看到用于拟合过程的函数列表,这些函数来自 Scipy 包。

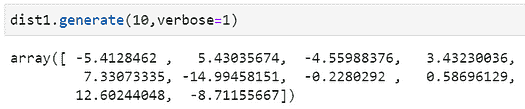

不要仅仅停留在拟合阶段,还要生成合成数据

作为附加功能,distfit模型提供了一个 API,可以基于最佳拟合分布轻松生成数据。在这里,我们生成了 10 个随机变量,loc=5.5和scale=9.79(如之前拟合的)。

需要注意的事项

如果两个或多个分布的数据形状相似度很高,估计可能会出错。特别是,当样本量(训练数据)较小时。

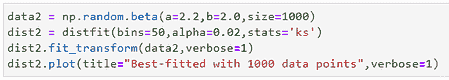

例如,让我们从Beta 分布生成一些数据,参数选择使得它们看起来几乎像正态分布。如果我们选择α和β相等或接近相等,我们可以实现这一点。然后,如果你拟合 1000 个数据点,你可能会得到正态分布作为最佳拟合分布。

作者创建的图像

然而,如果你将样本量扩展到 10,000 个点,你很可能会得到正确的答案。

作者创建的图像

你可以做的其他事情

你可以选择使用哪种统计测试(RSS、Kolmogorov-Smirnov 等)来确定最佳拟合。

你还可以指定确切的列表来遍历分布。

你可以使用distfit.predict方法来预测响应变量的概率。

我们只展示了连续分布拟合的例子。你也可以对离散分布进行拟合。

为什么这是“高效数据科学”的一个例子?

我认为使用像distfit这样的工具包是高效数据科学的一个绝佳例子。

我在这篇文章中写了什么是高效的数据科学。本质上,它意味着以更高的速度、更稳健的方式进行相同的数据科学活动。

你可以用 Scipy 函数从头编写纯 Python 代码,循环遍历各种分布,并对你拥有的数据进行 GOF 测试。但既然已经有人为这个任务编写了一个优秀的库(配有高质量的文档),你为什么还要浪费时间呢?

这就是为什么你可以在想要将单变量数据拟合到最佳分布并一次性获取所有统计属性时考虑使用distfit。

你可以查看作者的GitHub库,以获取机器学习和数据科学的代码、创意和资源。如果你像我一样,对 AI/机器学习/数据科学充满热情,请随时在 LinkedIn 上添加我或关注我在 Twitter 上。

原文。已获许可转载。

简历: Tirthajyoti Sarkar 是 Adapdix Corp 的数据科学/机器学习经理。他定期为 KDnuggets 和 TDS 等出版物撰写与数据科学和机器学习相关的各种主题。他撰写了数据科学书籍,并为开源软件做出贡献。Tirthajyoti 拥有电子工程博士学位,目前正在攻读计算数据分析硕士学位。可以通过 tirthajyoti at gmail[dot]com 联系他。

相关:

-

用 Python 创建带有异常签名的合成时间序列

-

如何在 Python 中进行“无限制”数学运算

-

用合成数据教 AI 分类时间序列模式

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

更多相关话题

更新的在线分析、商业分析、数据科学硕士学位

原文:

www.kdnuggets.com/2020/09/best-online-masters-data-science-analytics-online.html

评论

当前的疫情深刻改变了许多事情,但对 AI 和数据科学教育的需求并没有减少。变化在于在线教育的转变加速了。

现在有更多大学提供在线学位,包括 AI、数据科学和机器学习,因此我们将此目录主要限制在那些拥有顶级大学计算机科学排名的大学。特别感谢 Asel Mendis 收集了本博客中使用的大部分数据。

我们的前三课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

我们在 2017 年和 2019 年发布了类似的名单。

这是我们 2020 年最佳在线硕士学位项目的目录,包括 AI、商业分析、数据分析、数据科学和机器学习。

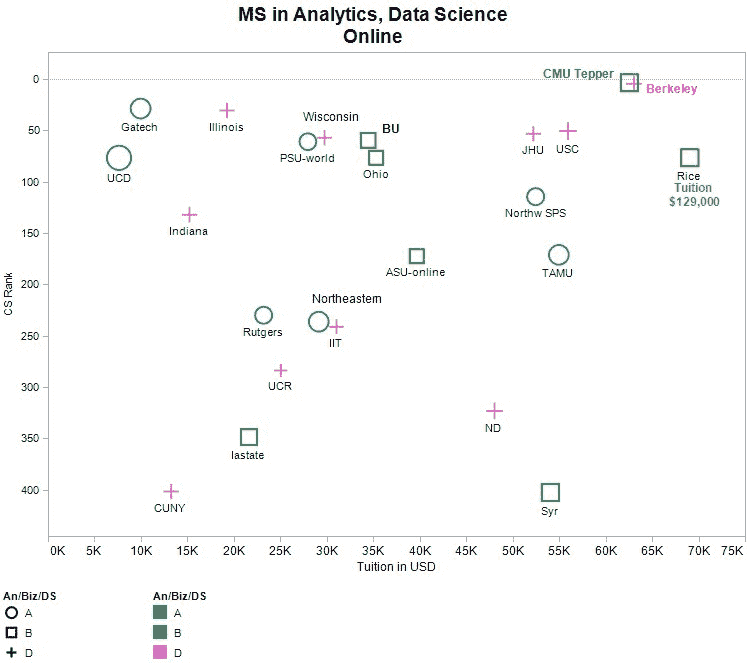

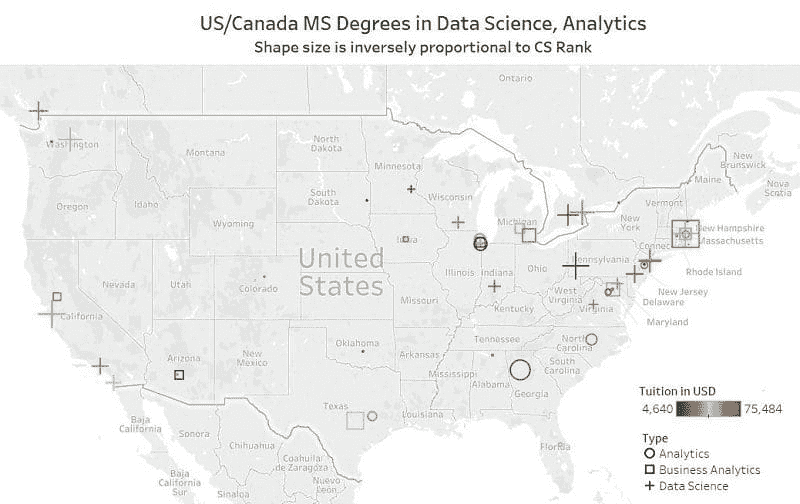

CS 排名是Top Universities 计算机与信息系统研究生项目的排名。他们为前 50 所学校提供了单独的排名,然后为接下来的 450 所学校提供了范围(51-100、101-150 等)。

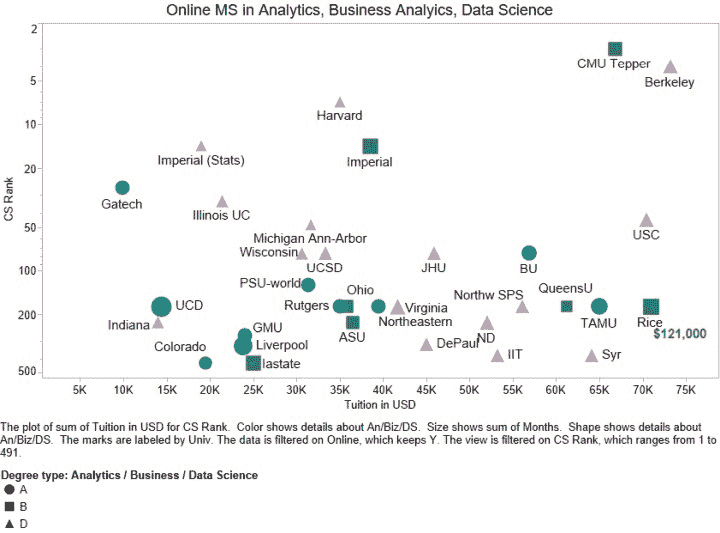

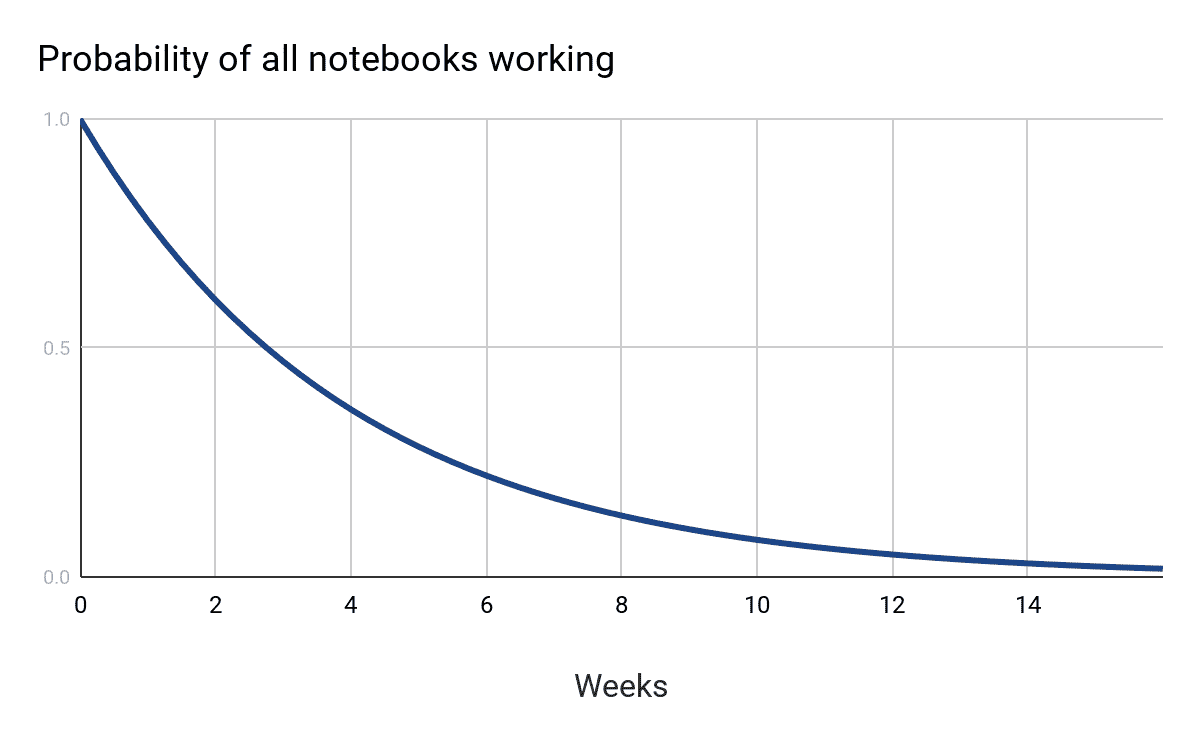

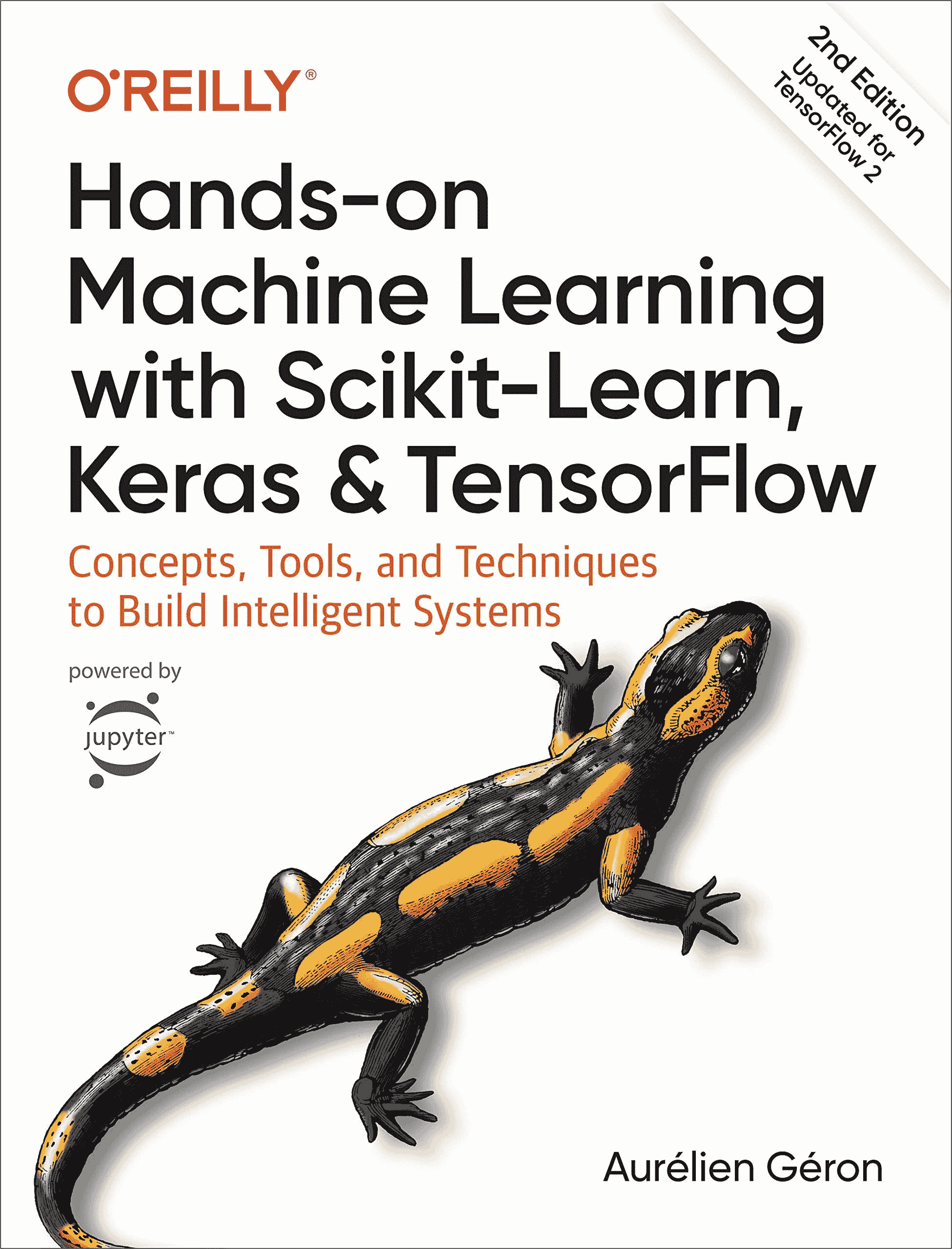

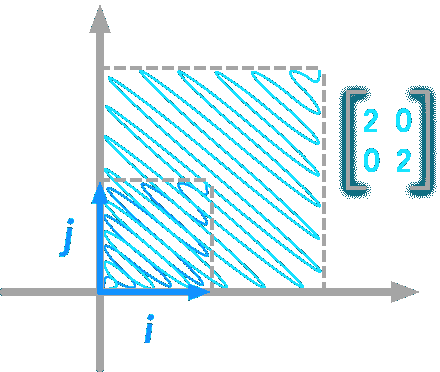

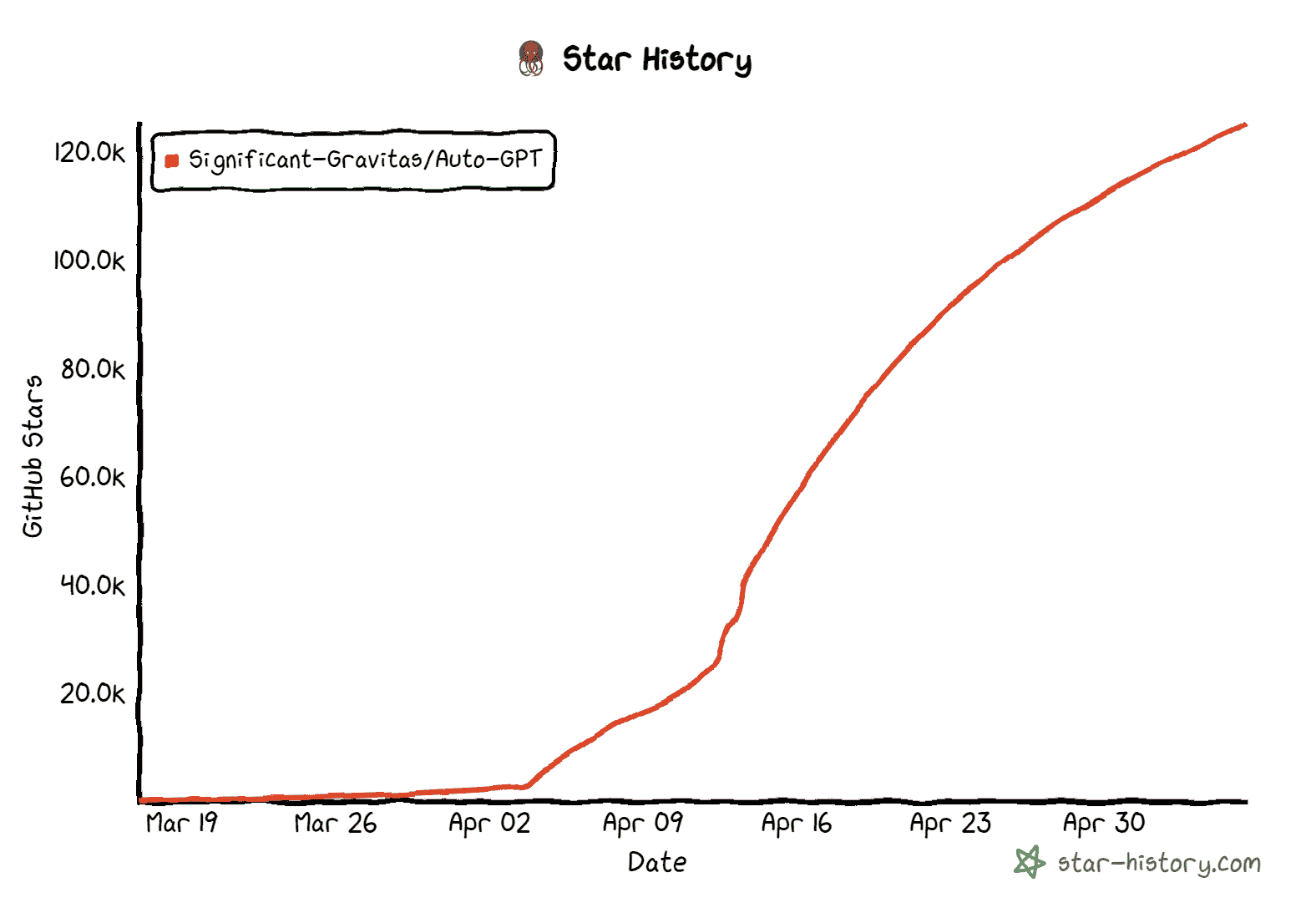

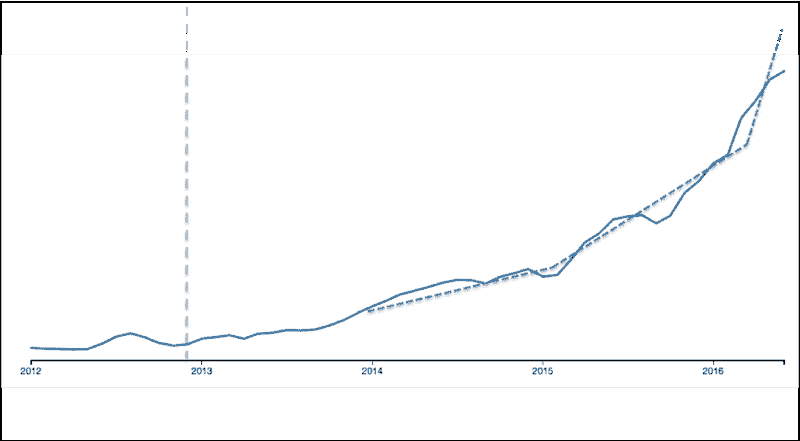

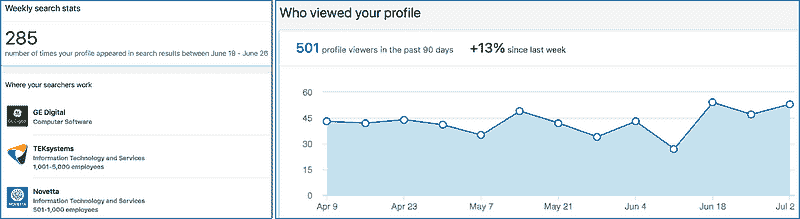

下图 1 展示了排名与学费的关系,适用于排名<500 的学校。排名范围内,我们取了该范围的中点。

图 1:顶级在线分析、商业分析、数据科学硕士学位。

仅显示了 Top Universities 计算机科学排名<500 的学校。

形状/颜色对应学位类型:蓝色圆形代表分析,绿色方形代表商业,紫色三角形代表数据科学。形状的大小对应教育的时长。

一些观察:

-

这份名单中的几乎所有学校都来自美国,除了 DSTI(法国)、帝国学院(英国)、利物浦大学(英国)、UCD(爱尔兰)和女王大学(加拿大)。

-

尽管我们没有 2019 年的所有学费数据,但我们看到许多学校在 2020 年提高了学费。这一趋势无法持续太久。

-

我们没有看到学校排名与学费之间的明显相关性。

一些商业分析项目非常昂贵(Rice 的学费为 121,000 美元),而乔治亚理工学院仅需 9,900 美元。鉴于在线获得优质教育的便利和众多选择,许多顶级以外的学校是否能够继续收取如此高的在线教育学费仍然值得怀疑。

最受欢迎的学位名称是“数据科学”,在超过一半的情况下使用。

调查的学校中,数据分析占比为 17%,商业分析占比为 9%。

以下是学位名称的频率(去除 MS、MSc、硕士等):

-

数据科学,35

-

数据分析,11

-

商业分析,6

-

分析,2

-

分析与数据科学,2

-

人工智能,1

-

CS 和定量方法,1

-

数据科学与人工智能,1

-

管理分析,1

-

管理信息系统,1

-

硕士统计学(数据科学),1

-

信息学专业研究,1

-

战略分析,1

下表提供了 64 个顶级在线硕士项目的详细信息。

在一些情况下,当没有 CS 顶级大学排名时,

我们为整个大学提供了全球排名前列的大学排名。

表 1:顶级在线分析、商业分析、数据科学硕士学位。

| CS 排名 2020 | 大学,学位 | 描述 | 时长 | 学费(美元) |

|---|---|---|---|---|

| 3 | CMU Tepper 商业分析硕士 | MSBA 旨在为有技术背景的人士提供深入分析技能,并晋升为高级业务分析师职位。 | 18-24 个月 | 66820 |

| 4 | UC Berkeley 信息与数据科学硕士 | 在线授课的信息与数据科学硕士(MIDS)项目培养数据科学专业人士成为该领域的领军人物。通过融合跨学科课程、经验丰富的教师、成就斐然的同侪网络和灵活的在线学习,这一认证项目将 UC Berkeley 带到你身边,无论你身在何处。 | 20 | 73224 |

| 7 | 哈佛大学 数据科学硕士 | 此学位让你深入理解数据科学方法,包括预测建模、数据挖掘、机器学习、人工智能、数据可视化和大数据。 | 12 | 35000 |

| 14 | 伦敦帝国学院 商业分析硕士 | 你将学习如何应用最新的学术思维和分析及计算工具来帮助做出商业决策。尽管我们的项目建立在严格的技术和定量培训基础上,但也高度应用。选修课程和项目专注于某一行业,给予你根据个人兴趣调整课程的机会。 | 校内 12 个月,在线 22 个月 | 38500 |

| 14 | 伦敦帝国学院 数据科学硕士(MSc Statistics (Data Science)) | 课程将关注与大规模科学数据处理相关的各种工具和技术,包括机器学习理论、数据转换与表示、数据可视化以及使用分析软件。 | 12 | 19000 |

| 27 | 乔治亚理工学院 分析学硕士(MS in Analytics) | 通过乔治亚理工学院的在线分析学硕士(OMS Analytics),你可以建立并增强你的专业知识,使自己对众多公司更具价值。我们的跨学科方法为你提供了向一些最具知识的商业智能、统计学和运筹学领域的专家学习的机会,以及大数据和高性能计算领域的专家。 | 12-24 | 9900 |

| 33 | 伊利诺伊大学厄本那-香槟分校 数据科学计算机硕士(Master of Computer Science in Data Science) | 本课程通过聚焦数据科学的课程,要求完成 32 学分的研究生课程,每门课程 4 学分,共八门研究生课程。MCS-DS 包括机器学习、数据挖掘、数据可视化和云计算的必修课程。 | 12-18 | 21440 |

| 44 | 南加州大学 应用数据科学硕士(MS in Applied Data Science) | 我们的学生沉浸于数据分析的整体领域、分析师和/或数据科学家的角色,以及信息学技能可以应用于关键组织任务的领域。他们理解数据管理、数据可视化、数据挖掘和人工智能技术(特别是机器学习)对分析过程的重要性,以及这些技术如何应用于现实世界的挑战。 | 18-24 | 70471 |

| 48 | 密歇根大学 应用数据科学硕士(Master of Applied Data Science) | 应用数据科学硕士(MADS)项目将为你提供从头到尾管理数据科学的全面准备,适用于各种现实世界情境。该项目在灵活的在线格式中融合了理论、计算和应用。MADS 项目包括数据收集、处理、分析、可视化、报告和干预的学习和应用。它将使你能够学习如何用数据得出结论并做出决策,同时关注数据使用的伦理问题。 | 12 | 31688 |

| 75 | 波士顿大学 应用数据分析硕士学位 | 适合中期职业 IT 专业人士或具有计算机科学背景的学生,该项目专注于分析培训,提供坚实的数据分析知识,并在学术严谨的框架内考察最新行业工具和方法的呈现及应用。 | 16-24 | 56864 |

| 75 | 约翰斯·霍普金斯大学 数据科学硕士学位 | 严谨的课程设置专注于计算机科学、统计学和应用数学的基础,同时结合实际案例。通过在线学习和在约翰斯·霍普金斯应用物理实验室的先进设施中现场学习,学生可以向实践中的工程师和数据科学家学习。 | 12-24 | 45950 |

| 75 | 普渡大学 商业分析硕士学位 | 适合希望利用对技术和分析专业知识日益增长需求的在职专业人士。 | 12-24 | 32064 |

| 125 | 宾夕法尼亚州立大学世界校园 数据分析专业研究生硕士学位 | 该项目通过大学内三个学术部门的强大合作关系提供,给你提供了从具有多样背景的教师那里受益的机会。凭借广泛的经验,我们的教师可以教授你如何在大规模和超大规模及不同领域中使用统计学、计算机科学、机器学习和软件工程来收集、分类、分析和建模数据。 | 12-24 | 31380 |

| 175 | 诺斯伊斯特大学 信息学专业研究生硕士学位 | 本项目通过平衡的课程设置,结合信息科学知识和技术技能培训,以及对商业基础和 IT 创新战略思维的理解,帮助学生在 IT 应用和管理职位上取得成功。通过将计算技能和应用与信息战略、数据治理、伦理和商业智能的实际挑战相结合,学生在信息技术管理、系统设计与开发、信息安全、人机交互、数据分析、云计算和网络服务及企业架构等领域获得能力。 | 18 | 39500 |

| 175 | 西北大学 数据科学硕士 | 数据科学硕士项目的学生获得了在当今数据密集型世界中成功所需的关键技能。他们学习如何利用关系型和文档数据库系统及基于开源系统(如 R、Python 和 TensorFlow)构建的分析软件。他们学会了如何使用传统统计学和机器学习方法进行可靠的预测。 | 12-24 个月 | 56100 |

| 175 | 俄亥俄大学 商业分析硕士 | 这个在线商业分析硕士项目超越了传统的工具和方法。它传授了你需要的高级分析技能,以深入挖掘组织数据并利用这些数据做出关键的商业决策。 | 16-20 个月 | 35820 |

| 175 | 皇后大学 全球管理分析硕士 | 针对寻求掌握将分析应用于商业需求的全球专业人士。了解不仅如何有效使用数据,还如何构建和管理复杂项目并领导高绩效团队。 | 12 个月 | 61200 |

| 175 | 莱斯大学 商业分析硕士 | 在莱斯商学院,你将建立有效开展业务所需的基础,然后学习如何跨团队思考和工作,以最大化组织内每个部门的产出。 | 24 个月 | 121,000 |

| 175 | 罗格斯大学 分析与数据科学硕士 | 商业与科学硕士学位中的分析课程为数据驱动的决策制定做好准备。它将计算机科学、统计学、机器学习、数据挖掘和大数据领域结合在一起。学生将获得各种技能,包括分析大数据集的能力、开发建模解决方案以支持决策的能力,以及对数据分析如何驱动商业决策的透彻理解。 | 18-24 个月 | 35000 |

| 175 | 德克萨斯农工大学 分析硕士 | 分析硕士项目的使命是将工作专业人士转变为能够使用现代分析技术协作解决商业问题的领导者。 | 24 个月 | 65000 |

| 175 | 都柏林大学 数据分析硕士和专业文凭 | 本课程将帮助你分析和理解通过大量自由获取的在线信息定期创建的大数据集。这是一项极其有价值的技能,雇主对这一技能的需求很高。 | 36 个月 | 14437 |

| 175 | 弗吉尼亚大学 数据科学硕士 | 弗吉尼亚大学数据科学学院的新在线数据科学硕士(MSDS)课程扩展了我们前沿课程的可及性,超越了夏洛茨维尔。数据科学在几乎所有行业中的应用是 21 世纪最重要的任务之一。我们很高兴欢迎来自地区、国家和全球的新一届多样化学生。 | 24 | 41728 |

| 225 | 亚利桑那州立大学 商业分析硕士 | 如果你想站在大数据的前沿,在线商业分析硕士将教你如何操控、解析和分析静态数据。你将深入了解大数据和数据分析,同时学习如何利用数据为业务关键解决方案提供支持。 | 16 | 36500 |

| 225 | 印第安纳大学 数据科学硕士 | 该项目旨在为中期职业人士提供便利和灵活性。你将在一个易于访问和直观的格式中,获得你选择主题的深入专业知识。 | 12-18 | 14000 |

| 225 | 圣母大学 数据科学硕士 | 圣母大学在线数据科学硕士项目由应用与计算数学与统计系(ACMS)提供,并得到门多萨商学院、信息技术办公室和赫斯堡图书馆教职员工的参与。 | 21 | 52000 |

| 275 | 乔治·梅森大学 数据分析工程硕士 | 数据分析工程(DAEN)硕士项目是乔治·梅森大学沃尔根诺工程学院的一个跨学科项目。该项目为学生提供了广泛的数据分析算法、工具和流程的知识和经验,并专注于灵活且广泛的课程,以帮助毕业生解决各种现实世界的问题。 | 12-24 | 24000 |

| 115 全球 | 德保罗大学 数据科学硕士 | 我们的在线学习项目模拟了课堂体验,提供 100%软件、教师顾问、职业服务及广泛校友网络的访问。了解如何管理和分析复杂数据,开发数据科学模型以支持决策,并有效地向非技术观众传达分析结果。 | 12-24 | 44980 |

| 325 | 利物浦大学 人工智能硕士 | 该项目将为你提供开发、设计和评估各种用途的智能系统所需的技能。 | 30 | 23895 |

| 375 | 伊利诺伊理工学院 数据科学硕士 | 数据科学硕士项目的学生深入探讨给定问题的基本前提,学习重新构建问题,并确定结果是否合理。他们通过探索和改进现有数据的结构、创建和评估模型、构建和测试假设来实现这一目标。他们学习如何分析数据、可视化结果,同样重要的是,如何清晰地表达他们的发现。 | 12-24 | 53262 |

| 375 | 锡拉丘兹大学 应用数据科学硕士 | 应用数据科学硕士的跨学科课程专注于四个关键学习能力:数据采集和组织、技术分析、可视化和沟通以及实际应用。每个能力为学生提供了一个发展资源和演示作品集的机会,同时在一个或多个感兴趣领域中增长他们的专业知识。 | 12-24 | 64152 |

| 223 全球 | 科罗拉多州立大学全球 数据分析硕士 | 学生通过商业智能和数据分析准备成为组织领导者。作为 CSU Global 的数据分析硕士(MSDA)学生,你将提升与各种核心业务职能——会计、金融、物流、管理和战略——相关的决策技能。 | 12-18 | 19500 |

| 425 | 爱荷华州立大学 商业分析硕士 | 商业分析硕士是一个面向在职专业人士的跨学科研究生项目,解决“大数据”环境中处理数据分析和商业智能的挑战。该项目旨在满足当今企业和组织在激烈的全球竞争和不断的技术变革中的需求。 | 21 | 25000 |

| 525 | 德雷克塞尔大学 数据科学硕士 | 德雷克塞尔大学的在线数据科学硕士课程是计算机科学和信息系统的结合。通过课程,你将学习如何操作和总结数据;深入挖掘数据和文本;确定趋势;并将你的发现编织成一个能够清晰传达给组织的故事。 | 12 | 60390 |

| 525 | 加州大学河滨分校 数据科学硕士 | 在线工程硕士学位,专注于数据科学,能够教会你从大量数据中提炼有价值的见解。课程设计使毕业生能够开发高效的技术,以识别、分析和可视化数据组中的隐藏模式,提取关键信息。 | 13 | 29988 |

| 575 | 密苏里大学 数据科学与分析硕士 | MU 的在线数据科学与分析硕士学位将为你提供将大数据转化为智能数据所需的知识、工具和经验。如果你希望帮助各行各业的公司解决复杂的数据问题,这可能是适合你的学位。 | 12-18 | 37878 |

| 575 | 俄勒冈州立大学 数据分析硕士 | 在俄勒冈州立大学的在线数据分析硕士项目中,你将探索有趣且具有挑战性的真实数据问题,同时装备自己以应对大规模数据的量化工具。 | 12-18 | 25200 |

| 575 | 德州理工大学 数据科学硕士 | 我们为期一年的数据科学硕士课程已获得 STEM 认证。学生将学习如何使用先进技术、操作大数据,并利用统计方法解读数据。掌握这些技能后,学生将获得将理解转化为组织战略所需的商业技能。 | 12 | 25064 |

| 446 全球 | 布兰迪斯大学 战略分析硕士 | 布兰迪斯大学一贯被《美国新闻与世界报道》评为全国顶尖大学,拥有培养变革者的悠久历史。我们为专业人士设计的前沿、100% 在线课程,均衡关注数据的艺术与科学。通过我们的战略分析硕士项目,你将掌握将数据分析转化为有洞察力、数据驱动故事所需的技术和战略技能,以影响关键决策者。 | 12-24 | 35350 |

| 725 全球 | 沃斯特理工学院 数据科学硕士 | 我们便捷的在线格式并不是唯一的好处;我们提供量身定制的数据科学学习路径。除了教授数据科学基础的核心课程外,你还可以从各种选修课程中选择,为未来的数据科学事业做好准备。 | 12-24 | 53130 |

| 775 全球 | 俄克拉荷马州立大学 商业分析与数据科学硕士 | 一个 37 学分的 STEM 项目,通过将课堂上获得的知识应用于解决现实世界的商业问题,提供实际的数据分析经验,使用软件包括 Alteryx、Colab、PowerBI、Python、R、SAS、Tableau 等。 | 36 个月(兼职) | 11880 |

| na | 奥斯汀佩大学 计算机科学与定量方法硕士 | 与在线数据科学学位类似,奥斯汀佩大学的课程将计算机科学、数学和商业分析结合起来,以帮助制定业务和组织决策。 | 12-18 | 17000 |

| na | 贝帕斯大学 应用数据科学硕士 | 贝帕斯大学的应用数据科学项目带领学生学习从最大似然、假设检验和调查抽样,到重抽样方法、时间序列分析和贝叶斯分析,各种回归方法,以及最终详细讲解支持向量机、树基方法、神经网络、图模型、EM 算法和集成学习等机器学习方法。 | 12-24 月 | 29340 |

| na | 贝尔维尤大学 数据科学硕士 | 贝尔维尤大学的在线数据科学硕士学位旨在让你掌握策划、分析和从大型数据集中发现相关信息的能力。你将学习到解决几乎任何领域复杂问题所需的工具、方法和系统。虽然不需要数据科学或计算经验,但具有一些数学、计算和统计学背景会有所帮助。 | 12-18 | 17850 |

| na | 卡布里尼大学 数据科学硕士 | 在这个完全在线的学位项目中,学生获得了为数据导向的职业做准备的基本技能,如商业智能分析师、数据挖掘分析师、IT 项目经理和数据库管理员。 | 24 个月 | 25380 |

| na | 科罗拉多技术大学 计算机科学硕士 - 数据科学 | 计算机科学硕士(MSCS)学位课程包括核心课程,旨在提供计算机科学最重要学科如计算机算法、操作系统、数据库、安全和网络,以及软件工程的相关和高级教学。 | 12-24 | 29280 |

| na | CUNY 职业研究学院 数据科学硕士 | 该项目的学习目标和严格的实践课程围绕雇主需求设计。在项目期间,学生使用流行的编程语言如R和Python构建越来越复杂的项目组合,反映当前 IT 工作场所的经验和需求。学生构建预测和规范性模型,进行演示练习,并在便捷的在线环境中审阅彼此的工作,确保他们具备当今市场上最受重视的专业知识。 |

12-18 | 16635 |

| na | 达文波特大学 数据分析硕士 | 该课程为已经熟悉数据分析和新入门者提供了数据挖掘、数据可视化、沟通和预测分析的技能。你还将掌握现代数据仓库和云计算等备受追捧的技能,并精通行业标准软件,如SQL、R Programming、IBM SPSS Statistics、IBM SPSS Modeler、Tableau、RStudio等。 |

12-18 | 26460 |

| na | 丹佛大学 数据科学硕士 | 在线数据科学硕士课程包括 15 门课程,为学生提供编程、数据挖掘、机器学习、数据库管理和数据可视化等关键能力的知识和技能。 | 18-24 | 64080 |

| na | 数据科学技术学院 (DSTI) 应用数据科学与 AI 硕士 | 该课程将使你深入理解人工智能技术的主要科学基础,专注于建模而非数据科学 API 和框架的调查。该应用硕士课程在应用数学及其实现方面具有“深度优先”的特点,由“法国数学学派”的教授主讲。 | 12 | 8700 欧元 |

| na | 数据科学技术学院 (DSTI) 应用数据分析硕士 | 该课程将通过数据分析增强决策能力,从而提升你的商业技能和职业机会。在此应用硕士课程中,你将掌握进行分析所需的技术和工具,并提供相关且结构化的报告,提高公司项目的投资回报率。 | 12 | 5700 欧元 |

| na | 数据科学技术学院 (DSTI) 人工智能数据工程应用硕士 | 该课程将让你深入了解大数据与 IT 方面的知识,以及数据科学。课程将提供追求成功职业生涯所需的基础,包括计算机科学和数学理解,以及实际项目。 | 12 | 8700 euro |

| na | 埃尔姆赫斯特学院 数据科学硕士 | 我们采取全面的方法,将分析和机器学习与业务整合。这个创新课程赋予你在统计学、分析方法和编程工具方面的技术能力,同时提升你重要的业务技能。结果是:一个全面的知识基础,让你能够掌握那些让他人困惑的信息,在任何专业环境中创造真实的业务价值。 | 24 | 26550 |

| na | 刘易斯大学 数据科学硕士 | 在线数据科学硕士课程为你提供数据挖掘、数据可视化、预测分析和数据管理的技能。刘易斯大学的在线数据科学硕士学位旨在为你提供更高的数学和计算机科学技能,以应对大数据分析中遇到的问题。 | 12-18 | 31590 |

| na | 马里兰大学全球校区 数据分析硕士 | 马里兰大学全球校区的数据分析硕士课程旨在满足对能够将不断增长的机构数据转化为有价值资产的高技能专业人才的日益增长的需求。你将获得使用各种分析工具的实践经验,学习如何管理和操作数据,创建数据可视化,并提出数据驱动的战略建议以影响业务结果。 | 12 | 17280 |

| na | 玛丽维尔大学 数据科学硕士 | 我们在顶级雇主的建议下建立了我们的课程,这些雇主在各行业中使用数据科学,因此我们的课程重点关注现代数据科学工具箱中最需要的技能,如多种编程语言的计算机编程、机器学习、预测建模和大数据分析。 | 12-18 | 27540 |

| na | 梅里马克学院 数据科学硕士 | 该课程通过工程学院和商学院的合作提供,将数据科学家所需的工程技能与将数据集转化为利益相关者可用的见解的商业智慧相结合。 | 12-16 | 30464 |

| na | 北中大学 数据科学硕士 | 我们的数据科学硕士项目旨在帮助学生深入理解这一新兴的跨学科领域。学生将获得包括数据生命周期在内的广泛知识,学会如何将大量非结构化数据处理成组织可以利用的可用数据集。 | 23 | 31970 |

| na | 俄克拉荷马州立大学 管理信息系统硕士 | MIS 项目不要求未来的学生拥有商业背景或学位。33-34 学时的课程包括 22 学时的核心课程(兼职学生为 21 学时核心课程)和一个选修/选项领域,以便学生可以专注于 MIS 的兴趣领域。除非另有说明,否则所有课程均可通过在线学习选项获得。 | 12-18 | 17127 |

| na | 雷吉斯大学 数据科学硕士 | 从保险到银行,再到医疗保健,几乎每个行业都认识到数据及其分析和解释的重要性。数据科学硕士学位将为你在预测分析、统计、数据可视化和数据工程等领域的热门职业机会做好准备。 | 12-18 | 34200 |

| na | 罗切斯特理工学院(RIT)数据科学硕士 | 鼓励学生与数据科学、分析和基础设施领域的专家合作,提供解决实际问题的实践经验。课程包括学生选择选修课程的机会,以追求数据科学广泛领域及其各种应用领域中的多种职业路径。该项目为所有背景的学生,无论是科学、工程还是商业背景,都提供了从事数据科学职业的准备。 | 24 | 35730 |

| na | 圣母大学圣玛丽学院(IN)数据科学硕士 | 在我们的数据科学硕士项目中,一个职业科学硕士(PSM)项目,你将发展成一名具有深厚分析技能的专业从业者。成为一个全面的个人,具备数据科学的深厚知识,同时具备有效沟通和项目管理的能力。 | 24 | 29700 |

| na | 南方卫理公会大学(SMU)数据科学硕士 | 旨在为当前和未来的数据科学专业人士提供所需的高级技能,以管理、分析、挖掘和理解复杂数据,从而在组织中做出战略决策。 | 20-28 | 57084 |

| na | 新罕布什尔大学 (SNHU) 数据分析硕士 | 让你深入学习这一领域,磨练当前劳动力市场上最受追捧的技能之一。你将学习如何使用高级统计技术和工具进行数据和信息管理,以收集和分析大数据集。你还将学习如何应用你的计算、分析和建模技能,为关键利益相关者提供决策支持。 | 15 | 22572 |

| na | 圣地亚哥大学 应用数据科学硕士 | 应用数据科学硕士项目由数据科学专家与关键行业和政府利益相关者紧密合作开发,提供深入的实践和技术培训,旨在使毕业生在这一重要且快速发展的领域获得职业成功。 | 12-24 | 33300 |

| na | 威斯康星大学 数据科学硕士 | 该数据科学硕士项目将教你如何利用最新工具和分析方法 harness 大数据的力量。创新的虚拟实验室让你可以远程访问软件工具和编程语言,如 R、Python、SQL Server 和 Tableau,从而节省购买和安装这些应用程序的成本、时间和麻烦。 | 12-18 | 30600 |

| na | Utica College 数据科学硕士 | Utica 的 30 学分在线数据科学硕士项目将帮助你在组织和社会背景下考虑数据,从而影响各种组织和行业的战略和政策制定。 | 24 | 24900 |

| na | Walsh College 数据分析硕士 | 让你掌握评估、解释和转化信息的知识和技能,以解决复杂的商业问题,并帮助组织实施战略性的数据驱动解决方案。对于没有技术背景的学生,MSDA 包括对数据库、编程和网络的介绍。 | 18-24 | 25500 - 31450 |

| na | 西部 governors 大学 (WGU) 数据分析硕士 | 拥有你的 M.S. 数据分析学位,你将成为数据挖掘、管理、映射和处理的专家,使你能够提高收入潜力并最大化职业发展机会。 | 18-24 个月 | 10620 |

我们希望此列表对你有用,如果我们遗漏了什么,请在评论中添加。

相关

-

2019 年最佳数据科学与分析硕士 – 欧洲版

-

数据科学 MOOCs 过于肤浅

-

4 门免费的数学课程,提升你的数据科学技能

更多相关内容

人工智能、分析、数据科学、机器学习最佳播客前 10 名

原文:

www.kdnuggets.com/2019/07/best-podcasts-ai-analytics-data-science-machine-learning.html

评论

在日常通勤或休息时间收听播客是保持在数据科学领域最新并确保你不断学习的高效有效方式。

以下的 KDnuggets Top 10 列表 突出了截至 2019 年最活跃和受欢迎的播客,这些播客包含数据科学和机器学习的对话。我们审查了更多的播客,因此此列表仅包括在 iTunes 上评分最高(4.5+)、评论最多且当前月份内至少有一集的新播客。所有节目描述均改编自播客列表。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 在 IT 领域支持你的组织

3. Google IT 支持专业证书 - 在 IT 领域支持你的组织

我们还分享了一些新的和引人注目的播客,这些播客要么太新,无法与大名单竞争,要么已经有一段时间没有发布,但仍然是绝佳的资源,或涵盖更广泛的话题。 你仍然应该考虑查看这些节目,因为它们可能会带来一些对你下一次大数据冒险至关重要的知识点!

告诉我们你对我们精选内容的看法,并请分享你认为应考虑在未来最佳播客列表中的最爱播客。

播客前 10 名

#1. 数据怀疑者 由 Kyle Polich 主持 | 276 集,2014 – 2019,iTunes

包含有关数据科学、统计学、机器学习和人工智能的访谈和讨论,重点是应用批判性思维和科学方法来评估主张的真实性和方法的有效性。

最新一集: (20 min.) 与 Prasanth Pulavarthi 的访谈,讨论 Onyx 格式用于深度神经网络。

#2. 数据故事 由 Enrico Bertini 和 Moritz Stefaner 主持 | 143 集,2012 – 2019,iTunes

关于数据分析、可视化及相关话题的最新发展讨论。

最新一期:(42 分钟)Evan Peck 是本期节目的嘉宾,他将谈论他和他的学生最近发表的关于“数据是个人的”研究。该研究包括对宾夕法尼亚州乡村的 42 次访谈,目的是查看不同教育背景的人们如何对一组不同的数据可视化进行排名。

#3. 与 Lex Fridman 的人工智能,MIT AI | 34 集,2018 – 2019,iTunes

关于智能和人工智能的本质的对话,在 MIT 及其以外,从深度学习、机器人学、AGI、神经科学、哲学、心理学、认知科学、经济学、物理学和数学的角度出发。

最新一期:(44 分钟)Chris Urmson 曾是 Google 自动驾驶汽车团队的首席技术官,是 Carnegie Mellon 大学 DARPA 大挑战和 DARPA 城市挑战的关键工程师和领导者。今天,他是 Aurora Innovation 的首席执行官,这是他与 Sterling Anderson(前 Tesla Autopilot 总监)和 Drew Bagnell(Uber 前自主性和感知负责人)共同创立的自动驾驶软件公司。

#4. Linear Digressions 由 Udacity 提供 | 237 集,2014 – 2019,iTunes

通过有趣(且常常非常不寻常)的应用探索机器学习和数据科学。

最新一期:(16 分钟)如果你是 Google 或 Netflix,并且你有一个推荐或搜索系统作为你的主打产品,那么测试算法改进的最佳方法是什么?A/B 测试是测试用户对软件变化响应的经典答案,但在返回排名列表的算法上下文中思考 A/B 测试的意义时,事情会变得很复杂。这就是我们本周讨论交错测试的原因——这是一种简单的 A/B 测试修改,使得两种算法之间的对决变得更加容易,并且它允许你用比传统 A/B 测试少得多的数据来进行测试。

#5. TWiML&AI 由 Sam Charrington 主持 | 300 集,2016 – 2019,iTunes

This Week in Machine Learning & AI 专为机器学习和人工智能爱好者的高度目标化受众量身定制。涵盖机器学习、人工智能、深度学习、自然语言处理、神经网络、分析和深度学习等技术。

最新一期:(75 分钟)扎克里·利普顿,特普商学院助理教授,专注于机器学习在医疗保健中的应用,以帮助医生进行诊断和治疗。我们讨论了医疗领域的监督学习、分布变化下的鲁棒性、跨行业机器学习系统的伦理问题以及“公平洗白”的概念。

#6. SuperDataScience 来自 Kirill Eremenko | 250 期,2017 – 2019,iTunes

将全球最具启发性的数据科学家和分析师带给您,帮助您在数据科学领域建立成功的职业生涯。数据呈指数增长,从事分析工作的人薪资也在不断上升。这个播客可以帮助您学习如何迅速提升您的分析职业生涯。

最新一期:(66 分钟)与 Webfor 的数字战略创始人兼主任凯文·盖奇的聊天。您将了解数字助手是什么以及它们的未来发展方向,借助像谷歌的雷·库兹韦尔这样的专家。您将听到凯文对“可测量的东西会被管理”的哲学以及这对营销和数据科学的意义。您还将了解为什么网站变得越来越不重要,如何将细分市场逐渐过渡到个性化,创建令人惊叹的客户体验,磁盘配置文件、自然语言处理、计算机视觉及其在未来营销中的作用。

#7. Talking Machines 来自 Tote Bag Productions | 84 期,2015 – 2019,iTunes

凯瑟琳·戈尔曼和尼尔·劳伦斯带来与领域专家的清晰对话、对行业新闻的深入讨论以及对您的问题的有用回答。机器学习正在改变我们可以向周围世界提出的问题,我们在这里探讨如何提出最佳问题以及如何利用这些答案。

最新一期:(45 分钟)我们讨论了边际似然性和交叉验证,凯瑟琳对 PosterSession.ai仍然感到兴奋,我们发明了 Deep Quaggles,并听取了波士顿大学伊莱恩·恩索西教授的对话。