KDNuggets-博客中文翻译-二十五-

KDNuggets 博客中文翻译(二十五)

原文:KDNuggets

数学 2.0:机器学习的基本重要性

原文:

www.kdnuggets.com/2021/09/math-fundamental-importance-machine-learning.html

评论

由 Dr. Claus Horn,人工智能研究员和讲师

一些人,特别是在当前数据科学的热潮中,将机器学习视为仅仅是另一种算法。它是数字化的一部分,帮助我们自动化事务,仅此而已。不幸的是,这种解释完全忽略了主要的观点。机器学习不仅仅是编程计算机的另一种方式;它代表了我们理解世界方式的根本转变。它是数学 2.0。

科学理论通过建立世界的模型来帮助我们理解世界。它们的有用性在于它们允许我们对未来做出预测。直到历史上的这一点,我们对世界的最复杂模型都是用数学语言(数学 1.0)编写的。现在这一点正在发生变化。即将到来的科学模型将是机器学习模型(可能是神经网络):数学 2.0。

原因在于机器学习模型允许我们描述更高复杂度的现象。我们在数学理论中能够描述的功能关系非常有限,相比之下,例如现代深度学习能够很好地将一万像素值映射到狗或猫的概念。

回到 2003 年,在我攻读物理学博士学位期间,我们在扫描几拍字节的数据时,寻找新型基本粒子的迹象,这些数据记录在德国高能物理中心 DESY(当时是世界上最大的数据库之一,谷歌成立才五年)。

我们发现,对观测变量应用独立选择的常规过程有些乏味,因为在改变一个变量的切割之后,我们必须重新检查所有其他变量。因此我们想:我们能否自动化这个过程?事实上,我们想到的一个简单算法允许我们自动优化选择。后来我们发现,计算机科学家有一个术语来形容我们所做的事情:他们称之为机器学习。

很快,这种新方法显然意味着我们需要调整我们的科学工作流程。与其利用所有物理学知识来增加信号与背景的比率,不如仅做最小限度的清理切割,让算法来完成工作。后来,随着深度学习的出现,CERN 的研究人员意识到,即使是物理量的重建也是适得其反的。仅凭原始测量数据,深度学习能够超越任何人工选择的物理学家(见下图)。因此,数学 2.0 让我们能看到基于数学 1.0 的模型无法看到的粒子。

图 1: 基于低级特征(黑色)和物理学家通常使用的高级特征(红色)的深度学习算法性能比较。 (图取自参考文献 1 的 2014 年《自然》论文。)

人们一直在疑惑为何大多数物理模型非常简单,大多数情况下仅涉及三次或更低次的多项式。也许原因在于我们只能看到我们能够用语言表达的内容。

物理学中发生的事情现在也发生在其他领域:一段给定的氨基酸序列总是以相同的方式折叠。在这里有很多规律性!实际上,是蛋白质的结构决定了它的功能。然而,我们无法产生一个数学函数来描述这种关系。但我们可以构建一个能够做到这一点的机器学习模型。 构建这样一个模型是一个重要的里程碑,因此有关于 AlphaFold(这个模型的名称)是否值得诺贝尔奖的猜测。

由于 Math 2.0 让我们描述比 Math 1.0 更复杂的关系,未来十年可能会看到生物学的转变。数字生物学将用 Math 2.0 的语言书写。其他科学领域中也会有许多机会,特别是那些关系更复杂的领域,如社会科学。

因此,掌握 Math 2.0 的语言应该是每个学术课程的核心组成部分,也是每位学生,尤其是在科学领域的学生,的基本能力。

当然,科学理论不仅仅是数学。主要的困难在于找到合适的概念和量来描述给定范围的现象。这一点不会改变。但数学不仅帮助我们建立模型和推导预测。它还允许我们通过代数计算和推导新的简化洞察,并通过微积分回答关于系统动态的问题。

我们仍处于 Math 2.0 革新的起始阶段,但我预测,与数学的发展类似,我们将会看到一个新领域的出现,这个领域将研究机器学习模型的系统及其构建方式、自动优化自身的方式,以及如何利用这些模型获得新的洞察,使我们以新的视角看待世界。

这些发展将带来科学计算的下一层次,并为我们提供一种新的科学方法,这要归功于 Math 2.0。

参考文献:

- Baldi, P., Sadowski, P. & Whiteson, D. 利用深度学习在高能物理中寻找奇异粒子。Nat Commun 5, **4308 (2014)。 https://doi.org/10.1038/ncomms5308

个人简介: Dr. Claus Horn 是一位人工智能领域的研究员和讲师,他相信 21 世纪人类条件进步的最高潜力存在于人工智能与生命科学的交汇点。

原文。经许可转载。

相关:

-

机器学习如何利用线性代数解决数据问题

-

反脆弱性与机器学习

-

自然语言处理中的线性代数

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你组织的 IT 工作

3. Google IT 支持专业证书 - 支持你组织的 IT 工作

更多相关话题

机器学习数学:免费电子书

原文:

www.kdnuggets.com/2020/04/mathematics-machine-learning-book.html

图片来源于 Freepik

数学是机器学习的基础,对理解该领域的根基至关重要。要成功成为一名机器学习从业者,掌握相关的数学基础是绝对必要的。你可以转向哪里来复习机器学习数学,或通过扩展基础来加深理解?

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 管理

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 管理

机器学习数学 是由 Marc Peter Deisenroth、A Aldo Faisal 和 Cheng Soon Ong 合著的一本书,旨在激励人们学习数学概念,由剑桥大学出版社出版。根据作者的说法,该书的目标是提供必要的数学技能,以便后续阅读更高级的机器学习主题书籍。

直接来自书中的页面:

虽然机器学习取得了许多成功故事,并且有丰富的可用软件来设计和训练灵活的机器学习系统,但我们认为机器学习的数学基础对于理解更复杂的机器学习系统所建立的基本原则是重要的。理解这些原则可以促进创造新的机器学习解决方案,理解和调试现有的方法,并了解我们所使用方法的固有假设和限制。

《机器学习数学》分为两个部分:

-

数学基础

-

使用数学基础的机器学习算法示例

目录内容如下:

第一部分:数学基础

-

引言和动机

-

线性代数

-

解析几何

-

矩阵分解

-

向量微积分

-

概率与分布

-

连续优化

第二部分:核心机器学习问题

-

当模型遇见数据

-

线性回归

-

使用主成分分析的降维

-

使用高斯混合模型的密度估计

-

使用支持向量机的分类

显然,书的第一部分涵盖了纯数学概念,没有涉及机器学习。第二部分则将注意力转向将这些新获得的数学技能应用于机器学习问题。根据你的需求,你可以选择自上而下或自下而上的方式来学习机器学习及其基础数学,或者选择其中一部分作为重点。

图片来自机器学习数学

你可以在这里下载该书的 PDF。该书已经出版并可以购买纸质版,作者们还将继续提供免费可下载的 PDF 版本。

该书旨在提供一本简短而精炼的书籍,并通过练习和 Jupyter 笔记本进行补充。要了解更多信息,你可以在这里找到配套网站。

担心这本书是否值得你的时间?不要只听我的话;看看这些重量级人物怎么说:

这本书很好地覆盖了机器学习所需的所有基本数学概念。我期待与学生、同事以及任何有兴趣建立扎实基础的人分享它。”

—乔厄尔·皮诺,麦吉尔大学和 Facebook

“近年来,机器学习领域得到了极大的发展,成功应用的范围也越来越广。这本综合性的教材涵盖了现代机器学习的关键数学概念,重点关注线性代数、微积分和概率论。无论是作为新手教程还是机器学习研究人员和工程师的参考书,它都将非常有价值。”

—克里斯托弗·比晓普,微软研究院剑桥

“这本书提供了对现代机器学习背后的数学的精彩阐述。强烈推荐给任何想要深入了解机器学习基础的人。”

—皮特·阿贝尔,加州大学伯克利分校

我希望你觉得这本书和其他人一样有用。

马修·梅奥 (@mattmayo13)是一名数据科学家,同时也是 KDnuggets 的主编,KDnuggets 是开创性的在线数据科学和机器学习资源。他的兴趣包括自然语言处理、算法设计与优化、无监督学习、神经网络和机器学习的自动化方法。马修拥有计算机科学硕士学位和数据挖掘研究生文凭。他可以通过 editor1 at kdnuggets[dot]com 联系。

更多相关主题

一个 IT 工程师需要学习多少数学才能进入数据科学领域?

原文:

www.kdnuggets.com/2017/12/mathematics-needed-learn-data-science-machine-learning.html

评论

评论

免责声明和前言

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在的组织进行 IT 工作

首先,免责声明,我不是 IT 工程师 😃 我在半导体领域工作,专注于高功率半导体,作为技术开发工程师,我的日常工作主要涉及半导体物理、硅制造过程的有限元模拟或电子电路理论。当然,这项工作中确实涉及一些数学,但无论好坏,我并不需要涉及数据科学家所需的那种数学。

然而,我有许多 IT 行业的朋友,并且观察到许多传统的 IT 工程师对学习/贡献于数据科学和机器学习/人工智能这个激动人心的领域充满热情。我自己也在涉足这个领域,学习一些可以应用于半导体器件或工艺设计领域的技巧。但当我开始深入研究这些激动人心的主题(通过自学)时,我很快发现自己不知道/只对/大多忘记了本科时学习的一些基本数学知识。在这篇 LinkedIn 文章中,我聊了聊这个话题...

现在,我拥有一所美国知名大学的电气工程博士学位,但仍然觉得自己在准备扎实掌握机器学习或数据科学技术时感到不够全面,因为没有对一些必要的数学知识进行复习。我并无意冒犯 IT 工程师,但我必须说,他/她的工作性质和长期的培训通常使他/她与应用数学的世界保持距离。他/她可能每天处理大量数据和信息,但可能不会强调对这些数据的严格建模。通常情况下,时间压力很大,重点放在“用数据满足你即时的需求然后继续前进”而不是对数据进行深入探究和科学探索。不幸的是,数据科学应该始终关于科学(而非数据),按照这个思路, 某些工具和技术变得不可或缺。

这些工具和技术——通过探查潜在动态建模一个过程(物理或信息),严格估计数据源的质量,训练识别信息流中隐藏模式的能力,或明确理解模型的局限性——是健全科学过程的标志。

这些内容通常在应用科学/工程学科的高级研究生课程中教授。或者,通过类似领域的高质量研究生级别的研究工作也可以掌握。不幸的是,即便在传统 IT(开发运维、数据库或质量保证/测试)领域拥有十年的职业生涯,也不足以严格传授这类培训。简单来说,这没有必要。

时代在变迁

直到现在。

你看,在大多数情况下,拥有无可挑剔的 SQL 查询知识、清晰的整体业务需求感和对相应关系型数据库管理系统的一般结构的了解,对于执行提取-转换-加载周期并为公司创造价值来说,已经足够了。但如果有人突然出现,开始问一些奇怪的问题,比如“你的人工合成测试数据集足够随机吗”或“你如何知道下一个数据点是否在你数据的底层分布的 3-sigma 范围内”?或者,甚至是隔壁计算机科学毕业生/极客偶尔的调侃,即“与数据表(即矩阵)相关的任何有意义的数学操作的计算负荷随着表的大小(即行和列的数量)的增加呈非线性增长”,可能会让人感到沮丧和困惑。

而且,这些类型的问题正在越来越频繁和紧迫地出现,仅仅因为数据是新的货币。

高管、技术经理、决策者已经不满足于仅仅通过传统 ETL 工具获得的干巴巴的表格描述。他们想要看到隐藏的模式,渴望感受到列之间的微妙互动,希望获取完整的描述性和推断性统计数据,这些数据可能有助于预测建模并将数据集的投影能力扩展到超出其包含的值的即时范围之外。

今天的数据必须讲述一个故事,或者,如果你愿意,可以唱一首歌。然而,要听到它美妙的旋律,人们必须掌握音乐的基本音符,并且

那些是数学真理。

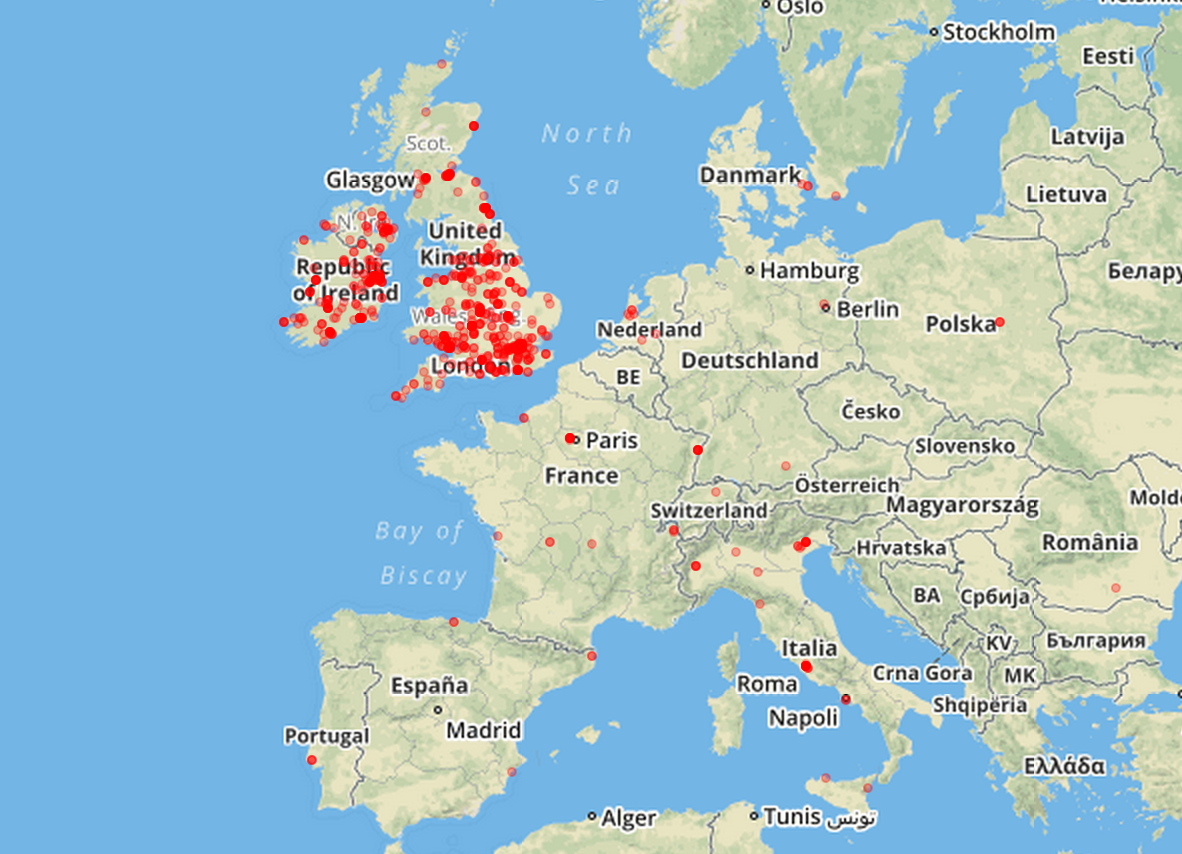

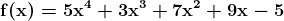

不再赘述,让我们来探讨核心问题。一个普通的 IT 工程师如果想进入商业分析/数据科学/数据挖掘领域,必须学习/复习哪些基本数学主题/子主题?我将在下面的图表中展示我的想法。

基础代数、函数、集合论、绘图、几何学

从根本开始总是一个好主意。现代数学的建筑基于一些关键基础——集合论、泛函分析、数论等。从应用数学学习的角度来看,我们可以通过一些简明的模块(没有特定顺序)来简化这些主题的学习:

a) 集合论基础,b) 实数和复数及其基本性质,c) 多项式函数、指数、对数、三角恒等式,d) 线性和二次方程,e) 不等式、无穷级数、二项式定理,f) 排列和组合,g) 图形绘制和绘图,笛卡尔坐标系和极坐标系,圆锥曲线,h) 基本几何学和定理,三角形性质。

微积分

艾萨克·牛顿想要解释天体的运动。然而,他没有足够好的数学工具来描述他的物理概念。因此,他在隐藏在乡村农场避开城市英国的瘟疫爆发时发明了这一分支数学(或某种现代形式的数学)。从那时起,它被认为是任何分析研究——无论是纯科学还是应用科学、工程学、社会科学、经济学等领域高级学习的入口。

因此,微积分的概念和应用出现在数据科学或机器学习领域的许多地方也就不足为奇了。需要覆盖的最重要主题如下 -

a) 单变量函数、极限、连续性和可微性;b) 平均值定理、不确定形式和 L'Hospital 法则;c) 极值和最小值;d) 积分和链式法则;e) 泰勒级数;f) 积分学的基本和平均值定理;g) 定积分和不定积分的计算;h) 贝塔函数和伽马函数;i) 二变量函数、极限、连续性、偏导数;j) 常微分方程和偏微分方程的基础知识。

线性代数

在 Facebook 上收到新的朋友建议?一个久未联系的专业联系人突然在 LinkedIn 上添加了你?Amazon 突然为你的下次假期阅读推荐了一本绝佳的浪漫惊悚小说?或者 Netflix 挖掘出一部你正好合口味的小众纪录片?

知道如果你学习线性代数的基础知识,你将掌握关于技术行业那些高人一等的人所利用的基本数学对象的知识,这不是很棒吗?

至少,你将了解控制你在 Target 上购物、使用 Google Map 驾驶、在 Pandora 上听的歌曲,或在 Airbnb 上租房的数学结构的基本属性。

需要学习的基本主题包括(这不是一个有序或详尽的列表):

a) 矩阵和向量的基本属性——标量乘法、线性变换、转置、共轭、秩、行列式;b) 内积和外积;c) 矩阵乘法规则和各种算法;d) 矩阵的逆;e) 特殊矩阵——方阵、单位矩阵、三角矩阵、稀疏矩阵和密集矩阵的概念、单位向量、对称矩阵、厄米矩阵、反厄米矩阵和单位矩阵;f) 矩阵分解概念/LU 分解、高斯/Gauss-Jordan 消去法、解 Ax=b 线性方程组;g) 向量空间、基、张成、正交性、正交归一性、线性最小二乘法;h) 奇异值分解;i) 特征值、特征向量和对角化。

这里有一篇很好的 Medium 文章,讲述了你可以用线性代数完成的事情。

统计学与概率

死亡和税收是唯一确定的,其余的都遵循正态分布。

在讨论数据科学时,掌握统计学和概率学基本概念的重要性不容低估。许多从业者实际上称机器学习不过是统计学习。我在做我的第一个机器学习 MOOC 时,跟随了广为人知的“统计学习导论”,并立即意识到自己在这个主题上的概念缺口。为了弥补这些缺口,我开始参加其他关注基础统计学和概率学的 MOOC,并阅读/观看相关主题的视频。这个领域广泛而无尽,因此有针对性的规划对于覆盖最重要的概念至关重要。我尽力列出这些内容,但我担心这是我最可能短缺的领域。

a) 数据摘要和描述统计、集中趋势、方差、协方差、相关性,b) 概率:基本概念、期望、概率计算、贝叶斯定理、条件概率,c) 概率分布函数——均匀分布、正态分布、二项分布、卡方分布、学生 t 分布、中心极限定理,d) 抽样、测量、误差、随机数,e) 假设检验、A/B 测试、置信区间、p 值,f) 方差分析,g) 线性回归,h) 效能、效应量、均值检验,i) 研究研究和实验设计。

这里有一篇关于数据科学家统计知识必要性的不错文章。

专题:优化理论,算法分析

这些主题与传统的应用数学讨论略有不同,因为它们主要与理论计算机科学、控制理论或运筹学等专业领域相关且广泛使用。然而,基本理解这些强大技术的能力在机器学习实践中非常有用,因此值得在这里提及。

例如,几乎每种机器学习算法/技术都旨在最小化某种估计误差,并受各种约束条件的限制。这本身就是一个优化问题,通常通过线性规划或类似技术来解决。另一方面,理解计算机算法的时间复杂度总是一种令人满足和洞察力深刻的体验,因为当算法应用于大数据集时,时间复杂度变得极其重要。在这个大数据时代,数据科学家通常需要提取、转换和分析数十亿条记录,他/她必须非常小心选择合适的算法,因为这可能意味着从惊人的表现到彻底失败的差异。算法的一般理论和属性最好在正式的计算机科学课程中学习,但要理解它们的时间复杂度(即,算法在给定数据大小下运行所需的时间)如何分析和计算,一个必须具备对数学概念如动态规划或递归方程的基础了解。对数学归纳法证明的熟悉也可能非常有帮助。

后记

感到害怕?学习这些作为前提的主题让你感到困惑?不要担心,你会边学边用。目标是保持你的思维窗户和大门开放,欢迎新知识。

甚至有一个简明的MOOC 课程来帮助你入门。请注意,这是一个针对高中或大一水平知识的初学者课程。这里还有一篇关于数据科学的 15 个最佳数学课程的总结文章在 kdnuggets 网站上。

但你可以放心,在复习这些话题后,许多你可能在本科时学过的,或者即使是学习新概念,你会感到如此充满力量,以至于你肯定会开始听到数据所唱的隐秘音乐。这就意味着你向成为数据科学家的目标迈出了重要的一步……

#数据科学, #机器学习, #信息, #技术, #数学

如果你有任何问题或想法,请联系作者,邮箱地址是tirthajyoti[AT]gmail.com。你也可以查看作者的GitHub 库获取其他有趣的 Python、R 或 MATLAB 代码片段和机器学习资源。你也可以在 LinkedIn 上关注我。

简介:Tirthajyoti Sarkar 是一位半导体技术专家、机器学习/数据科学爱好者、电子工程博士、博客作者和作家。

原文。经许可转载。

相关:

-

为什么你应该忘记数据科学代码中的‘for-loop’,而应该拥抱向量化

-

15 门用于数据科学的数学 MOOC 课程

-

回归分析真的属于机器学习吗?

更多相关话题

通过反复试验建立机器学习模型

原文:

www.kdnuggets.com/2018/09/mathworks-building-machine-learning-model-through-trial-error.html

赞助文章。

由 Seth DeLand, 产品营销经理, 数据分析,MathWorks

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

机器学习的路线图充满了反复试验。对于概念新手的工程师和科学家来说,他们将不断调整和改变他们的算法和模型。在这个过程中,挑战将会出现,特别是在处理数据和确定正确模型时。

在构建机器学习模型时,了解现实世界的数据是不完美的,不同类型的数据需要不同的方法和工具,并且在确定正确模型时总会有权衡。

以下系统化工作流程描述了如何开发一个用于手机健康监测应用的训练模型,该应用跟踪用户一天中的活动。输入由手机的传感器数据组成。输出将是执行的活动:行走、站立、坐着、跑步或跳舞。由于目标是分类,这个示例将涉及 监督学习。

获取和加载数据

用户将坐下并持有手机,记录传感器数据,并将其存储在标记为“sitting”的文本文件中。然后,他们应站立持手机,记录传感器数据,并将其存储在标记为“standing”的文本文件中。对于跑步、行走和跳舞也如此操作。

预处理数据

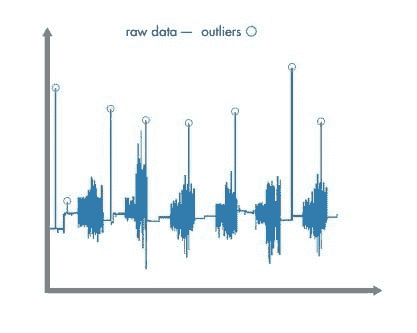

由于机器学习算法无法区分噪声和有价值的信息,因此必须在训练前清理数据。数据可以通过数据分析工具进行预处理,如 MATLAB。为了清理数据,用户可以导入和绘制数据,并去除异常值。在此示例中,异常值可能是由于在加载数据时不小心移动了手机。用户还必须检查缺失的数据,这些数据可以通过近似值或来自另一个样本的可比数据来替换。

图 1:数据预处理包括移除任何异常值,即那些位于数据其余部分之外的数据点。清理后,将数据分成两部分。一半用于训练模型,另一半用于测试和交叉验证。

图 1:数据预处理包括移除任何异常值,即那些位于数据其余部分之外的数据点。清理后,将数据分成两部分。一半用于训练模型,另一半用于测试和交叉验证。

使用预处理数据提取特征

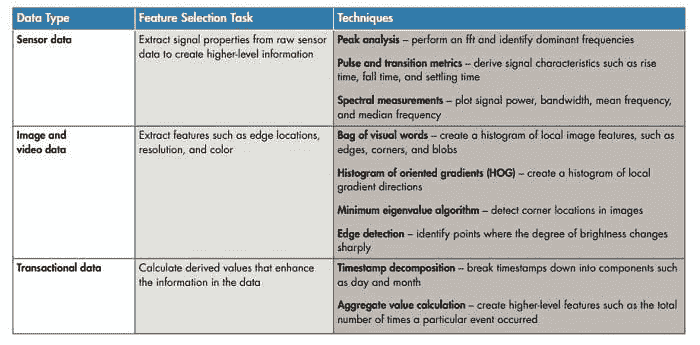

原始数据必须转化为机器学习算法可以使用的信息。为此,用户必须提取能够对电话数据内容进行分类的特征。

在这个例子中,工程师和科学家必须区分特征,以帮助算法在步行(低频率)和跑步(高频率)之间进行分类。

图 2:从数据类型中提取特征将原始数据转化为可以用于机器学习模型的高级信息。构建和训练模型

图 2:从数据类型中提取特征将原始数据转化为可以用于机器学习模型的高级信息。构建和训练模型

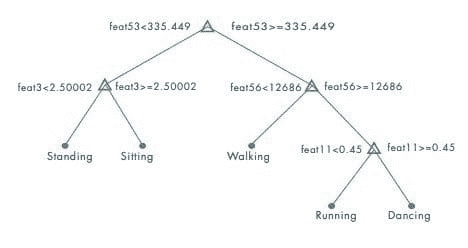

从一个简单的决策树开始。

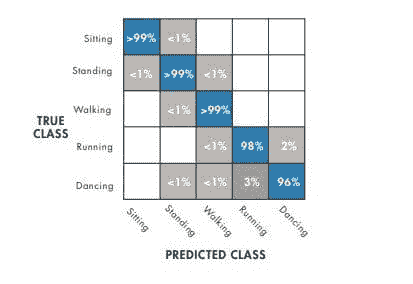

图 3:决策树根据特征特性建立分类参数。绘制混淆矩阵以观察其性能。

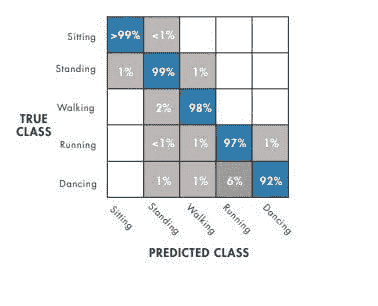

图 3:决策树根据特征特性建立分类参数。绘制混淆矩阵以观察其性能。 图 4:这个矩阵展示了一个在区分跑步和跳舞方面有困难的模型。根据上述混淆矩阵,这表明要么决策树不适用于这种数据,要么应使用不同的算法。

图 4:这个矩阵展示了一个在区分跑步和跳舞方面有困难的模型。根据上述混淆矩阵,这表明要么决策树不适用于这种数据,要么应使用不同的算法。

K 最近邻(KNN)算法存储所有训练数据,将新点与训练数据进行比较,并返回“K”个最近点中最频繁的类别。这显示出更高的准确性。

图 5:将 KNN 算法进行更改可以提高准确性——尽管仍有进一步改进的空间。另一种选择是多类支持向量机(SVM)。

图 5:将 KNN 算法进行更改可以提高准确性——尽管仍有进一步改进的空间。另一种选择是多类支持向量机(SVM)。 图 6:SVM 表现很好,几乎所有活动的准确率都达到了 99%。这被证明效果更好,并展示了通过反复试验达成目标的过程。

图 6:SVM 表现很好,几乎所有活动的准确率都达到了 99%。这被证明效果更好,并展示了通过反复试验达成目标的过程。

改进模型

如果模型不能可靠地区分跳舞和跑步,则需要进行改进。可以通过使模型更复杂(以更好地适应数据)或更简单(以减少过拟合的可能性)来改进模型。

为了简化模型,可以通过以下方法减少特征数量:相关矩阵,以便可以移除相关性不高的特征;主成分分析(PCA)以消除冗余;或顺序特征减少,重复减少特征直到没有进一步改进。为了使模型更复杂,工程师和科学家可以将多个简单模型合并为一个更大的模型或添加更多数据源。

一旦训练和调整完成,可以使用在预处理期间预留的“留出”数据集来验证模型。如果模型能够可靠地分类活动,那么它就准备好用于手机应用程序了。

对于第一次训练机器学习模型的工程师和科学家来说,会遇到挑战,但应该意识到试错是过程的一部分。上述工作流程提供了构建机器学习模型的路线图,这些模型还可以用于预测维护、自然语言处理和自动驾驶等各种应用。

探索这些其他资源,深入了解机器学习方法和示例。

-

监督学习工作流程和算法:了解监督学习过程中的工作流程和步骤。

-

MATLAB 机器学习示例:通过探索示例、文章和教程开始机器学习之旅。

-

MATLAB 中的机器学习:下载这本电子书,提供机器学习基础知识的逐步指南以及高级技术和算法。

更多相关主题

常见的机器学习障碍

原文:

www.kdnuggets.com/2019/09/mathworks-common-machine-learning-obstacles.html

赞助文章。

作者:Seth DeLand,MathWorks 数据分析产品营销经理

从事机器学习建模的工程师和科学家在处理数据时常常面临挑战。两个最常见的障碍与选择合适的分类模型和消除数据过拟合有关。

分类模型根据特定特征集将项目分配到离散组或类别。由于每个数据集的独特性和期望结果,确定最佳分类模型通常会遇到困难。过拟合发生在模型与可能包含噪声或错误的有限训练数据过于贴合时。过拟合的模型无法很好地推广到训练集之外的数据,限制了其在生产系统中的实用性。

图 1:分类学习器应用程序用于训练和比较各种分类器。© 1984–2019 The MathWorks, Inc.

通过整合可扩展的软件工具和机器学习技术,工程师和科学家可以识别最佳模型并防止过拟合。

选择分类模型

分类模型类型可能具有挑战性,因为每种模型类型都有其自身的特点,这可能是根据问题的不同而成为优势或劣势。

首先,你必须回答一些关于数据类型和用途的问题:

-

这个模型的目的是什么?

-

数据有多少?是什么类型的数据?

-

需要多少细节?存储是否是限制因素?

回答这些问题可以帮助缩小选择范围并选择正确的分类模型。工程师和科学家可以使用交叉验证来测试模型评估数据的准确性。经过交叉验证后,你可以选择最合适的分类模型。

分类模型有很多种类型,这里列出了五种常见类型:

-

逻辑回归:由于其简单性,这个模型通常被用作基准。它用于数据可以被分类为两个可能类别的问题。逻辑回归模型返回每个数据点属于各个类别的概率。

-

k-最近邻 (kNN):这种简单而有效的分类方法根据数据点与训练数据集中其他点的距离来对数据点进行分类。kNN 的训练时间较短,但除非对数据应用权重,否则该模型可能会将无关属性误认为重要属性,特别是在数据点数量增加时。

-

决策树:这些模型通过视觉方式预测响应,从根到叶的决策路径相对容易跟随。当展示结论如何得出时,这种类型的模型特别有用。

-

支持向量机(SVM):该模型使用超平面将数据分为两个或更多类别。它准确,不容易过拟合,并且相对容易解释,但对于较大的数据集,训练时间可能较长。

-

人工神经网络(ANNs):这些网络可以配置和训练以解决各种不同的问题,包括分类和时间序列预测。然而,训练后的模型通常难以解释。

工程师和科学家可以通过使用可扩展的软件工具来简化决策过程,以确定哪个模型最适合一组特征,评估分类器性能,比较和提高模型准确性,并最终导出最佳模型。这些工具还帮助用户探索数据,选择特征,指定验证方案,并训练多个模型。

图 2:深度神经网络的训练进度,显示训练集和验证集的准确性和损失。© 1984–2019 The MathWorks, Inc.

消除数据过拟合

过拟合发生在模型适应特定数据集但对新数据的泛化能力较差时。过拟合通常难以避免,因为它通常是训练数据不足的结果,特别是当负责模型的人没有收集数据时。避免过拟合的最佳方法是使用足够的训练数据来准确反映模型的多样性和复杂性。

数据正则化和泛化是工程师和科学家可以应用的两种额外方法来检查过拟合。正则化是一种防止模型过度依赖个别数据点的技术。正则化算法向模型引入额外信息,并通过使模型更简洁和准确来处理多重共线性和冗余预测变量。这些算法通常通过对复杂度施加惩罚来工作,例如将模型的系数添加到最小化中或包括粗糙度惩罚。

泛化将可用数据分成三个子集。第一个是训练集,第二个是验证集。在训练过程中监控验证集上的误差,并对模型进行微调直到准确。第三个子集是测试集,用于在训练和交叉验证阶段后对完全训练的分类器进行测试,以检验模型是否未过拟合训练和验证数据。

有六种交叉验证方法可以帮助防止过拟合:

-

k-fold: 将数据划分为 k 个随机选择的子集(或折叠),每个子集大小大致相等,其中一个子集用于验证用其余子集训练的模型。这个过程重复 k 次,因为每个子集在验证中使用一次。

-

Holdout: 将数据分为指定比例的两个子集,用于训练和验证。

-

Leave one out: 使用 k-fold 方法对数据进行分割,其中 k 等于数据中的总观察数。

-

Repeated random subsampling: 执行蒙特卡罗重复实验,随机分隔数据并汇总所有运行的结果。

-

Stratify: 将数据分割,使得训练集和测试集在响应或目标的类别比例上大致相同。

-

Resubstitution: 使用训练数据进行验证而不进行分离。这种方法往往会产生过于乐观的性能估计,如果数据量足够,应避免使用。

机器学习的老手和初学者在分类和过拟合方面都可能遇到问题。尽管机器学习中的挑战可能显得令人生畏,但利用正确的工具和使用本文介绍的验证方法将帮助工程师和科学家更轻松地将机器学习应用于现实世界的项目中。

要了解更多关于分类建模和过拟合的信息,以及 MATLAB 如何帮助克服这一机器学习挑战,请参见下面的链接或通过电子邮件联系我 sdeland@mathworks.com。

-

试用分类学习器应用程序: 通过在浏览器中运行 MATLAB 来创建和训练机器学习模型。

-

分类示例: 查看这些 25 个分类示例,包括判别分析和朴素贝叶斯。

-

提高浅层神经网络的泛化能力并避免过拟合: 这是一个过拟合的示例。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织在 IT 方面的工作

3. 谷歌 IT 支持专业证书 - 支持您的组织在 IT 方面的工作

更多相关话题

将预测性维护从理论转向实践

原文:

www.kdnuggets.com/2019/12/mathworks-predictive-maintenance-theory-practice.html

赞助文章。

由 Philipp H. F. Wallner,工业自动化与机械行业经理,MathWorks

如今你经常听到预测性维护及其价值。它是一个理想的状态,设备操作员可以预测即将发生的故障,预先安排维修,最小化对工厂操作的干扰,最重要的是,保护设备免受灾难性故障。我们都能欣然接受预测性维护的价值,或者我应该说预测性维护的预期价值?

当谈到在现场设备上实施预测性维护时,我们的明亮眼睛很快失去了光泽。事实证明,少数公司实际实施了预测性维护,这引发了一个问题,为什么会这样?

在与行业领袖的对话中,存在一个一致的主题,即设备制造商和操作员必须克服的四个关键挑战,以便成功地与数据科学界合作并在操作中实施预测性维护解决方案:

1. 促进合作以利用现有领域知识,同时设计算法。 公司如何帮助促进数据科学家与领域专家之间的合作,以便设计出基于统计方法结合领域知识的强大预测性维护算法?数据科学家和领域专家如何紧密合作,以确保每个强大预测性维护应用的关键组成部分——数据分析方法和领域知识——都得到充分利用?

成功的预测性维护应用程序结合了:基于统计的数据分析方法,如机器学习,以及研发工程师对设备的领域专业知识(在许多情况下,已经在仿真模型中捕获)。仅用数据分析方法来处理预测性维护将会遗漏工程和运营团队中持有的重要信息,这些团队负责构建和支持设备。

2. 在缺乏故障数据的情况下训练算法。 机器学习的一个关键方面是使用来自现场的数据来训练算法。这包括来自正常生产使用的“好”数据以及捕获的故障数据,用于各种操作设备时可能出现的错误场景。但是,当目标是避免设备首先出现故障时,你从哪里获得故障数据呢?

对于将预测性维护应用于从风力涡轮机到空气压缩机等工业系统的组织来说,这成为了一个日益重要的难题。作为解决这一困境的途径,可以使用模拟模型生成合成故障数据,以在缺乏现场测量故障数据的情况下训练算法。

图 1. 一个用于训练故障分类机器学习算法以克服缺乏测量故障数据的三重泵模拟模型,位于 Simulink 和 Simscape 中。© 1984–2019 The MathWorks, Inc.

3. 部署用于运行中的算法。 一旦预测性维护算法在桌面上完成设计和训练,就需要将其部署到设备上。此步骤的工作量高度依赖于现有的 IT 和 OT 基础设施。虽然有些算法在实时硬件平台上实现(例如,嵌入式控制器、工业 PC 或 PLC),但其他算法将被集成到现有的非实时基础设施中(例如,运行 Windows 或 Linux 的边缘设备)或在云中。越来越多的公司选择使用能够自动生成 C 或 IEC 61131-3 代码、.NET 组件或独立可执行文件的工具链,例如这家国际包装和纸品制造商,它使用预测性维护软件来减少塑料制造厂的废料和机器停机时间。

图 2. 一个基于 MATLAB 的人机界面(HMI),使设备操作员在故障发生之前能够接收潜在故障的警告。© 1984–2019 The MathWorks, Inc.

4. 制定预测性维护的商业案例。 每个公司在开始实施预测性维护之前必须能够回答的主要问题是,我将如何通过此方法产生收入?

如果你无法回答这个“关键问题”,你为建立复杂的预测性维护解决方案所做的所有努力将很快陷入停滞。了解你的商业案例并制定预测性维护的货币化策略,将有助于说服公司管理层为实施预测性维护应用程序的投资提供正当理由。

对于设备操作员来说,设备在运行过程中不易出现故障通常足以证明投资的合理性,但对设备制造商来说,这一案例则稍显挑战。我见到的一些有希望的想法,用于帮助建立实施预测性维护的案例包括

-

将服务费用与操作员(即他们的客户)运行的设备的预测性维护挂钩;

-

使用知识产权保护销售已部署的预测维护算法;以及

-

转向一种完全新的基于使用的商业模式(例如,销售压缩空气的立方米而不是压缩机,或电梯使用小时而不是整个电梯)。

要了解更多有关本文博客帖子中涵盖的主题的信息,请发送电子邮件至 pwallner@mathworks.com 的工业自动化与机械行业经理 Philipp H. F. Wallner,或查看以下链接:

-

预测维护(视频系列):了解更多关于预测维护的概念和工作流程。

-

使用 Simulink 生成故障数据(示例):此示例展示了如何使用仿真模型生成故障和健康数据。它使用一个传动系统,并对齿轮齿故障、传感器漂移故障和轴磨损故障进行建模。

-

Mondi 实施基于统计的健康监测和机器学习预测维护以优化制造过程(客户参考):查看 Mondi Gronau 如何减少工厂中的废料和机器停机时间,每年节省超过 50,000 欧元。

-

MATLAB 中的预测维护简介(电子书):学习如何开发你的预测维护、状态监测和异常检测算法。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

更多相关内容

矩阵分解解读

原文:

www.kdnuggets.com/2020/12/matrix-decomposition-decoded.html

评论

由 Tanveer Sayyed, 数据科学爱好者

要理解矩阵分解,我们首先需要理解特征值(从现在开始称为 lambda)和特征向量。在理解 lambda 和特征向量的直觉之前,我们首先需要揭示在线性代数中使用矩阵和向量的目的。

那么矩阵和向量在线性代数中的目的是什么呢?

在机器学习中,我们通常关注的矩阵的列是特征。因此,我们在心中天然地将矩阵视为神圣的。现在这可能会让你感到惊讶,因为—矩阵的 目的是“作用于”(输入)向量,以给出(输出)向量! 记住线性回归的线性代数方程:

(X^T . X)^-1 . X^T **.** y **------>** coefficients

***[---m-a-t-r-i-x----] . [input vector]* ------> *[output vector]***

正确的阅读方式是——我们“应用”矩阵到一个向量(y)上,以得到输出向量(系数)。换句话说——矩阵“转换/扭曲”输入向量以成为输出向量。一个向量输入,通过矩阵变换/扭曲,输出另一个向量。这就像是微积分中的函数:一个数字 x(比如 3)输入,得到一个数字 f(x)(例如 27,如果 f(x) = x³)。

关于 lambda 和特征向量的直觉

既然矩阵的目的已经明确,那么定义特征向量就会变得容易。如果我们发现输入向量和输出向量仍然彼此平行,那么这个向量就是特征向量。这意味着它们保持了变形或未受到影响。“平行”指的是以下两种情况之一:

------------**>** ------------**>**

------------**>** **<**------------

1\. 2.

在学校里,我们被教导力是一个向量。它具有方向以及magnitude。同样,特征向量可以被看作是变形的方向,而 lambda 则是在该方向上的变形幅度。因此,矩阵被分解/因式分解(就像 6= 3*2 一样)为一个向量及其幅度,可以表示为两者的乘积:

A.x = λ x

where,

…… A is a **square** matrix,

…… x is eigenvector of A

…… λ is the scalar eigenvalue

这称为特征分解。但是我们如何找到特征向量呢?从 λs 中找! 这里是方法:

A.x - λx = 0 …. (rearranging above equation)

(A - λI) . x = 0 …. (eq.1)Now x is a non-zero vector.

In matrices, if we want the product to be equal to zero,

then the term (A - λI) must be singular! That is,

the determinant of this whole term must be = 0\.

Hence,

|A - λI| = 0 ….. (eq.2) Solve eq.2 and

substitute ‘each’ value of λ in eq.1 to get

the corresponding eigenvector for that λ.

重要的是了解和理解这些步骤,因此我们将不会手动执行这些操作,因为在numpy库中已经存在一个函数。(我们将使用这段代码来展示和重新缩放特征向量)。例如:

特征向量 e1 = [-1, 0.5] 和 e2 = [-1, -1] 是粉色的,而输出向量是绿色的。

注意 λ 的效果 [-1, 5]。λ 负责特征向量的缩放(大小的变化)。λ1 是 负的,因此我们观察到负向变换——输出向量相对于 e1 移动 相反,并且缩放为 e1 长度的 1 倍。而 λ2 是 正的,因此我们观察到正向变换——输出向量与 e2 在 相同 方向上移动,并且缩放为 e2 长度的 5 倍。

现在,在我们转向特征向量和 λ 的应用之前,让我们先了解它们的属性:

-

我们只能找到 方形 矩阵的特征向量和 λ。

-

如果 A 的形状是(n,n),则最多会有 n 个 独立的 λ 及其对应的特征向量。

--------------**>**--------------**>**--------------------------**>**------

(2,2) (4,4) (8,8)

Take the line above. We can observe 3 eigenvectors, but they are not

independent as they are just multiples of each other and are part of the **same** line x = y.

-

λ 的 和 = 矩阵的迹(对角线之和)。

-

λ 的 积 = 矩阵 A 的行列式。

-

对于 三角形 矩阵,λ 是对角线值。

-

重复的 λ 是问题的根源。每重复一个 λ,我们将减少一个独立的特征向量。

-

矩阵的 对称性 越好越好。对称矩阵意味着 A = transpose(A)。对称矩阵产生“实数” λ。随着我们从对称矩阵转向非对称矩阵,λ 开始变成复数(a + i b),因此特征向量开始映射到虚拟空间而不是实空间。尽管矩阵 A 的每个元素都是实数,但如代码所示,这种情况仍然发生。

特征向量和 λ 的应用

首先,我们需要明确特征值(λ)不是线性的。这意味着如果 x, α 和 y, β 分别是矩阵 A, B 的特征值和 λ,则:

A . B ≠ αβ (x . y),而且,A + B ≠ αx + βy。

但是当涉及到计算矩阵的幂时,即寻找 A²⁰ 或 B⁵⁰⁰ 时,它们确实很有用。如果 A, B 是小矩阵,可能可以在我们的机器上计算结果。但是想象一下一个巨大的矩阵,列数众多,那时是否可行?我们是否会重复输入 B 500 次或循环 500 次?不,因为矩阵乘法是计算密集型的。所以让我们通过讨论同一矩阵的第二种因式分解/分解方式来理解“特征量”如何提供帮助。这是从以下方程推导出的:

**S^-1 . A . S = Λ** …. (eq.3)

where,

S***** is eigenvector matrix (each eigenvector of A is a column in matrix-S)

A is our square matrix

Λ (capital lambda) is a diagonal matrix of all lambda values*****[For S to be invertible, all eigenvectors *must* be independent (the above stated property-2 must be satisfied). And by the way, **very few** matrices fulfill it].

**Now, let's get our matrix from eq.3:**

1\. Left multiplication by S --> (S.S^-1).A.S = S.Λ

--> A.S = S.Λ

2\. Right multiplication by S^-1 --> A.S.(S^-1) = S.Λ.(S^-1)

**--> A = S.Λ.S^-1

*The matrix A has thus been factorized into three terms: S and Λ and S^-1.***

Now 12² can also be calculated as squares of its prime factors viz 3² * 2² * 2².

Similarly lets also do for A²:

A² = A . A

= (S . Λ . S^-1).(S . Λ . S^-1)

= S . Λ . (S^-1 . S) . Λ . S^-1

= S . Λ . Λ . S^-1

A² = S . Λ**²**. S^-1

Generalizing as:

**A^K = S . Λ^K. S^-1**

现在看看通过因式分解计算大幂是多么方便。

现在让我们更深入地探讨一下为什么会这样。再举一个例子:

观察 F¹ 和 F⁵ 的特征向量。它们保持不变并始终指向相同的方向。因此,矩阵的幂对特征向量完全没有影响!但是观察 λ,当指数从 1 改变为 5 时;λ1 增加(1.618 到 11.09)的速度远远快于 λ2 减少(-0.618 到 -0.09)。因此 λ2 的影响几乎可以忽略不计。这表明矩阵总体上是递增的,这可以从 F⁵[5,3,3,2] 的值中验证。

由于我们知道矩阵乘法在计算上是耗时的,因此对于任何方阵,如果它的每个 |λ| < 0,则我们知道矩阵是一个稳定的矩阵;如果每个 |λ| > 0,则矩阵在膨胀,是一个不稳定的矩阵,所以最好不要继续前进。

上面的例子实际上是斐波那契矩阵,其中矩阵 F 每次自乘时会增加/扩展约1.6180399倍!我们来验证一下:

0, 1, 1, 2, 3, 5, 8, 13, 21, 34.... is the Fibonacci Series

5 * 1.6180399 **≈** 8

8 * 1.6180399 **≈** 13

13 * 1.6180399 **≈** 21

而这个数字就是 λ 的值……这难道不是令人惊讶吗!!!

特征值(eigenvalues)的美妙之处在于,尽管它们数量非常少,但它们可以揭示矩阵/变换f函数的属性的隐藏秘密。

“特征值”的另一个应用当然是主成分分析——PCA!

为什么选择 PCA?

PCA 用于特征提取/维度减少,这指的是通过投影将数据的已知变量减少到较少的变量中,同时保留“几乎”相同数量的信息。有两种等价的方式来解释 PCA:

(i) 最小化投影误差,

(ii) 最大化投影的方差。

在这里,极其重要的一点是,上述两个陈述实际上是同一个事物的两个方面,因此最小化一个就等同于最大化另一个。

投影的必要性是什么?

我们需要它,因为当有 1000 个特征时,我们有 1000 个未知变量。结果是,我们需要 1000 个同时方程来解所有变量!但是“如果”没有解决方案呢?例如,考虑一下 2 个变量的情况:

a + b = 2

a + 2b = 2 ….?

PCA 的作用是,它找到最接近当前问题的近似,以便保留初始数据的某些属性(换句话说,噪声被减少)。因此,投影有助于将噪声与数据分离(代码示例见下文)。这是通过最小化最小二乘投影误差来完成的,这给出了最佳可能的解决方案。

最小化投影误差是否与线性回归中的最小二乘误差最小化相同?

不。以下是原因:

贡献者:Andrew Ng

这个图示也暗示了为什么 PCA 也可以用于无监督学习!

那么“特征值”在哪些方面有所贡献?

为此,我们需要了解 PCA 的步骤:

-

由于 PCA 对缩放非常敏感,因此我们首先需要对矩阵 A 进行标准化/归一化。M = mean(A),然后 C = A − M。

-

下一步是记住,为了获得最佳结果,即利用“特征值”,我们需要一个方阵,并且它是对称的(属性-7)。那么,哪个矩阵满足这两个条件呢?嗯……啊哈!——协方差矩阵!所以我们得到:V = cov(C)

-

既然我们已经得到我们想要的东西,就快速分解一下。

特征值, 特征向量 = np.linalg.eig(V)

-

然后将特征值按降序排列。它们对应的特征向量现在代表了降维子空间的组件。在降维子空间中,这些组件(特征向量)现在已经成为我们的新坐标轴,我们知道坐标轴总是正交的。(这只有在 PCA 中的每个组件都是独立的特征向量时才会发生)。这些坐标轴的组合产生了投影数据。(点击这里链接以获得更好的理解。让每个组件直接指向你。你会看到第一个组件捕获了最高的方差,其次是第二个,然后是第三个)

-

选择 k 个特征值以保留最大解释方差。k 个特征值捕获的方差量称为解释方差。

重要的是了解这些步骤,所以我们将不会手动执行这些操作,因为sklearn库中已经存在一个函数。为了简单起见,我们将把二维数据降到一维数据,同时观察噪声在过程中产生的效果。以下是代码:

注意投影与主成分完全平行。红点和绿点的接近度(相对于黑点和绿点)表明噪声已经在很大程度上减少。

(如果你发现任何错误/不正确的地方,请回复。欢迎批评。)

参考文献:

[www.youtube.com/playlist?list=PLE7DDD91010BC51F8(Prof.](https://www.youtube.com/playlist?list=PLE7DDD91010BC51F8(Prof.) 吉尔伯特·斯特朗,斯坦福大学。我的大部分内容都来自这里。)

www.youtube.com/watch?v=vs2sRvSzA3o(可能是对特征值和特征向量的最佳可视化表示)

hadrienj.github.io/posts/Deep-Learning-Book-Series-Introduction/(可视化向量的代码)

en.wikipedia.org/wiki/Singular_value_decomposition

你对 PCA 了解的与不了解的一切 · Its Neuronal

medium.com/@zhang_yang/python-code-examples-of-pca-v-s-svd-4e9861db0a71

个人简介:Tanveer Sayyed 是数据科学爱好者。热情的读者。艺术爱好者。异议爱好者……其余时间则在土星的环上摇摆。

原文。经许可转载。

相关:

-

机器学习数学:免费电子书

-

数据科学的基础数学:积分与曲线下的面积

-

数据科学和机器学习的免费数学课程

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 部门

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 部门

更多相关话题

数据科学(或机器学习)的矩阵乘法

原文:

www.kdnuggets.com/2022/11/matrix-multiplication-data-science-machine-learning.html

作者提供的图片

主要收获

-

矩阵乘法在数据科学和机器学习中扮演着重要角色

-

要使两个矩阵之间的乘法定义明确,这两个矩阵必须兼容,即矩阵 A 的列数必须等于矩阵 B 的行数。

-

矩阵乘法不满足交换律,即 AB ≠ BA。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

矩阵乘法在数据科学和机器学习中扮演着重要角色。考虑一个具有 m 个特征和 n 个观测值的数据集,如下所示:

基本的回归模型可以表示如下:

其中  是 n×m 特征矩阵,而 w 是 m×1 权重系数或回归系数矩阵。这里我们观察到

是 n×m 特征矩阵,而 w 是 m×1 权重系数或回归系数矩阵。这里我们观察到  的计算涉及特征矩阵 X 和回归系数矩阵 w 之间的矩阵乘法。由于 X 是一个 n × m 矩阵,而 w 是一个 m × 1 矩阵,因此 X 和 w 之间的矩阵乘法是明确的。在矩阵形式中,上述方程可以简化为

的计算涉及特征矩阵 X 和回归系数矩阵 w 之间的矩阵乘法。由于 X 是一个 n × m 矩阵,而 w 是一个 m × 1 矩阵,因此 X 和 w 之间的矩阵乘法是明确的。在矩阵形式中,上述方程可以简化为

其中 Xw 代表矩阵 X 和 w 之间的乘法。**

矩阵乘法的定义

设 A 为一个 n×p 矩阵,B 为一个 p×m 矩阵,

乘积矩阵 C = AB 是一个 n×m 矩阵,其元素为

矩阵乘法的性质

矩阵乘法不具有交换性,也就是说

AB≠BA

Python 中的矩阵乘法实现

使用 for 循环

import numpy as np

A = np.array([[1,2,3],[4,5,6]]) # create (2 x 3) matrix

B = np.array([[7,8],[9,10],[11,12]]) # create (3 x 2) matrix

A.shape[1] == B.shape[0] # ensures two matrices are compatible

C = np.zeros((2,2)) # (2 x 2) matrix

for i in range(2):

for k in range(2):

for j in range(3):

C[i,k]= C[i,k] + A[i,j]*B[j,k]

print(C)

[[ 58, 64]

[139, 154]]

使用 Numpy 库

C = np.dot(A, B)

print(C)

[[ 58, 64]

[139, 154]]

请注意,np.dot(B, A)会产生以下输出:

print(np.dot(B, A))

[[ 39 54 69]

[ 49 68 87]

[ 59 82 105]]

很明显,我们看到 np.dot(A, B) ≠ np.dot(B, A)。

总结来说,我们讨论了矩阵乘法的数学基础。我们还演示了如何使用简短的 python 代码执行矩阵乘法,以及使用 numpy 中内置的矩阵乘法方法。

本杰明·O·塔约 是一位物理学家、数据科学教育者和作家,也是 DataScienceHub 的所有者。之前,本杰明曾在中央俄克拉荷马大学、大峡谷大学和匹兹堡州立大学教授工程和物理学。

更多相关话题

建立成熟的机器学习团队

原文:

www.kdnuggets.com/2020/03/mature-machine-learning-team.html

评论

由张纪超,Georgian Partners 的软件工程总监撰写。

虽然新员工的知识和技能可以推动单个项目的成功,但良好的流程才能推动整个项目组合和团队的成功。在创建流程时,与团队合作,专注于采取小步骤和快速迭代想法,而不是重大突破。

我们的前 3 个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你们组织的 IT 工作

3. Google IT 支持专业证书 - 支持你们组织的 IT 工作

你还需要选择最适合你们目标的技术栈。技术不应替代良好的流程和合适的团队。相反,在你实施流程时,寻找能够提高效率的技术。

在创建流程时,与团队合作,专注于采取小步骤和快速迭代想法,而不是重大突破。

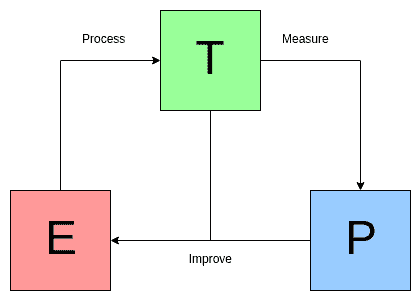

成熟度框架是如何工作的?

建立机器学习团队并非易事。我们的 ML 框架模型展示了构建团队的演变过程,并提供了在成熟过程中应关注的重点指导。

共有五个级别。

在每个级别,你的组织都将面临一套独特的挑战,无论是制定战略、增加新员工,还是实施更成熟的流程。

入门

首先,为你们组织内的机器学习(ML)制定战略和应用重点。在此阶段,与你的领导团队讨论以下问题:

-

你的解决方案能够支持哪些业务流程?

-

你的关键客户和受众是谁?

-

你如何解决他们的日常痛点或改进

他们的工作流程?

-

他们寻找哪些关键见解?

-

他们目前在哪些方面遇到困难?

-

自动化如何改善流程和工作角色?你的用户是否定期基于数据做出决策?

与产品管理、客户成功、支持、销售以及客户本身沟通,以收集回答这些问题所需的信息。

利用收集到的信息进行头脑风暴,寻找业务自动化的机会,始终牢记最终目标是改善客户的生活。考虑如何利用你独特的数据为客户提供最有价值的见解。你可以使用价值/成本框架来优先考虑这些机会,如下面的机会矩阵所示。这使你在招聘之前能够建立优先级列表,并明确招聘的原因。

接下来,进行数据审计,以了解你的数据如何支持已识别的机会。考虑如何收集任何缺失的数据,或重新调整你的流程以收集未来使用的额外数据。请记住,一些关键的机器学习项目在所需数据到位之前无法开始。

有了愿景和策略,你就准备好进行第一次招聘,将这些计划付诸实践。

探索

让你的第一次招聘发挥作用!在这个早期阶段,将你的机器学习团队视为一个创业中的创业公司通常是更好的。通常,寻找具有广泛技能并习惯于跨机器学习开发过程工作的通才候选人更为理想。你的理想候选人应该在类似的创业环境中工作过——那些能在有限资源下创造性解决问题的人。这是因为在企业中,角色更加专业化,团队有更多资源来解决问题。你的早期招聘人员需要做一切工作,直到你准备好扩展团队。

首先,聘请或指派一名产品经理,帮助验证市场问题、制定产品需求并管理路线图。如果你招聘 PM,必须具备第一手的机器学习经验。你也可能找到一位高级科学家,可以暂时担任 PM 角色。

内部分配有其优缺点。它们可以帮助团队快速了解领域和背景,但可能需要外部导师或培训资源来指导他们完成第一个机器学习项目。

接下来需要招聘的角色包括一名用于实验的机器学习科学家和一名能够支持实验、建立数据管道并将预测和模型集成到核心应用中的机器学习工程师。聘请最资深的科学家,以为你的团队设立长期成功的基础。

一名高级招聘人员可以:

-

帮助建立和吸引一支一流的数据科学团队。

-

通过选择最可行的途径来加速研发。

-

推动知识产权的创建,并开发接近生产就绪的机器学习模型。

-

高效设置工具和处理流程,并考虑规模问题。

理想情况下,你聘用的科学家还应具备数据工程技能,并能在团队扩展之前承担部分这方面的工作。以至少两名技术成员开始团队能推动更有效的头脑风暴,并平衡研究与实施之间的权衡。

利用组织中其他领域的专业知识来指导团队。科学家和工程师可以在此期间学习你的行业以及他们要解决的问题。

选择好的沟通者会带来结果。他们能够提出正确的问题,以了解你的业务,并清晰地向领导团队汇报他们的发现。一旦你的招聘到位,向包括产品、工程、营销和客户成功在内的跨职能团队提供期望的简要说明。

完成第一个项目

根据我们的经验,对于第一个项目,不必过于担心流程和工具。让团队找到解决方案并做他们需要做的事情以使第一个产品顺利推出。确保机器学习团队有灵活性选择所需的计算资源。与软件工程相比,计算需求(核心数、内存、GPU 等)变化更快,这使得预订所需的机器变得具有挑战性。云平台通常在时间和成本上更高效。

在第一个项目中,你想要建立动力,并迅速展示投资于机器学习(ML)的回报率。

寻找以下类型的项目:

-

专注于一个使用案例

-

可以在较高的成功率下完成

-

可以在相对较短的时间框架内完成

这种方法还为你的团队提供了一些额外的喘息空间,以便在处理更复杂的项目之前了解业务。

尽管选择一个可能提供更高回报的项目很有诱惑,但这也是有风险的。过于雄心勃勃的项目可能需要更长的时间才能推向市场,甚至可能失败。造成延迟的原因有很多:你的数据可能比预期的更混乱,你可能会发现额外的需求,或者你可能没有部署的流程。延迟会随着时间的推移导致信心和支持的丧失,并可能对初创的机器学习团队造成致命打击。

构建

完成机器学习产品开发的完整周期后,你的下一步优先事项是建立市场推广的能力和其他机会的可重复流程。

重新审视你的优先事项,确保路线图仍然合理。验证你是否正在解决市场问题,就像你对待任何其他产品一样。早期采用者或顾问委员会可以提供帮助。然后,制定你的市场推广计划,保持对解决买家问题的关注。为所有参与购买决策的人创建买家角色。考虑他们需要看到什么才能继续前进。建立一个销售支持和营销计划,以在买家旅程中传达正确的信息。

当你开始迭代并将更多模型投入生产时,到了扩展规模并在团队中招聘更多专业角色的时候。例如,你可以引入:

-

一位专职产品经理,如果之前是兼职角色,以制定完整的产品战略和长期路线图。

-

一名数据工程师负责构建所有可用数据的目录,以及架构和构建数据管道。

-

更多的数据科学家用于提升模型构建的吞吐量。

-

一名机器学习架构师负责监督整体技术愿景和实施。

-

一名 QA 工程师。

随着团队的成长,集中精力优化流程,以减少摩擦、提高可预测性,并促进跨功能协作。可以使用敏捷方法作为起点,但需要根据机器学习进行调整。请记住,数据科学工作不像软件开发那样可预测,需要更快的迭代。

如果整个团队一次只处理一个项目,Kanban 可以加速迭代,而不需要冗长的规划周期。可以通过团队深度探讨来鼓励知识共享,克服技术挑战。

现在是确定机器学习技术栈的时候了。生态系统发展迅速,新产品不断涌现。主要的选择包括语言(Python 或 R)、框架(Tensorflow 或 PyTorch)、云服务提供商、ETL 和部署解决方案。

我们的应用人工智能原则提供了一个务实的框架,以协助在你的软件解决方案中采用机器学习及其他人工智能构件。

白皮书:

-

为你提供了一个启动框架,帮助避免常见错误。

-

提供成熟度模型,以便你可以衡量自己的进展。

扩展

随着团队的成熟和数据差距的弥补,新的机会将会出现。其他产品线或业务部门可能希望利用机器学习。为了把握这一势头,你需要组建新的机器学习团队。

不过,首先考虑一下组织结构。通常会组建由几个科学家、一两名工程师和一名产品人员组成的小团队。这些团队负责一个产品线或内部业务职能。尽可能寻找具备匹配这些领域的专业技能的人选。询问团队瓶颈所在,并进行调整,以在科学家和工程师之间创建良好的平衡。

对于大型数据科学组织,有三种常见模型。

-

分散式模型:在分散式模型中,个别数据科学团队向相应的产品或业务部门汇报。这种模式允许数据科学团队与其业务相关者密切合作,但也有将数据科学团队孤立的风险。

-

集中式模型:在集中式模型中,所有数据科学团队都向 CTO 或数据科学负责人汇报。这种方法促进了同行之间的合作,有助于招聘和知识共享。如果采用这种模型,请特别关注与业务目标的对齐。

-

混合模型:第三种方法,已经在许多案例中成功采用,是一种混合模式,其中数据科学团队与业务伙伴紧密合作,但仍集中汇报。

查看这篇文章以深入讨论这个话题。

每个成长中的团队都会面临效率问题。随着团队的发展,抽出一些时间,远离日常的繁忙事务,专注于长期项目。例如,通过完善注释的数据目录、数据仓库和 ETL 解决方案来实现数据访问的民主化。寻求系统化地自动化工作流程中的手动步骤,提高其他工具的可用性,如管道编排和数据/模型质量监控。

随着你将越来越多的模型投入生产,你需要监控每个模型的版本并比较性能。

有关如何跟踪机器学习产品性能的一些考虑,请参阅我们《应用人工智能原则》第 5 条,了解性能目标和《信任原则》第 9 条,使信任可衡量。

高级

在高级阶段,你是一个成熟的 ML 组织,拥有一个与产品和工程团队紧密对齐的 ML 团队。你的流程和工具使你能够管理生产中的多个 ML 模型。你的团队和公司被认为是你领域的思想领袖,你能够利用这一点明确区分你的竞争对手。

在此时添加一名首席工程师和一名首席产品经理,以推动由科学家领导的子团队的最佳实践。考虑任命一位数据科学负责人,以推动子团队之间的最佳实践和一致性。

作为一个高级团队,根据你的行业和使用案例,考虑以下新兴角色。

-

随着团队和产品组合的扩展,添加更多工具以保持生产力:

-

使用一个集中且可搜索的笔记本库来实现知识发现。

-

添加一个可发现的功能/模型存储,以便重用。

-

使用基于元数据的编排来跟踪数据/模型依赖关系并管理变更。

-

构建统一的 ETL 和训练基础设施管理,以降低计算成本。

处于前沿的公司可能正在开发自己的 ML 框架,以填补开源和商业工具的空白,并可能将最新的 ML 研究部署到生产中,以建立强大而独特的产品。

为什么使用成熟度框架?

我们的成熟度框架允许处于 AI/ML 成熟路径上的公司对当前状况进行诚实评估,并了解达到下一个阶段所需的措施。

原文。经许可转载。

简介: 季超是我们的软件工程总监,并且是 Georgian Impact 团队的成员。在这个角色中,他领导我们的内部软件工程工作,并支持投资组合参与。在加入 Georgian Partners 之前,季超是亚马逊的软件开发工程师,他在设计和开发数据平台、商业分析和机器学习系统方面工作,以支持供应链优化和履行。在亚马逊之前,季超是 Bloomberg 的高级软件开发人员,他设计并实施了 Bloomberg Tradebook 股票交易系统的软件组件,并倡导 OOD/OOP/C++的最佳实践。他还曾是 IBM 的高级软件开发人员,致力于编译器技术、编程语言实现和测试失败调查的专家系统。

相关:

更多相关内容

通过组织来最大化你的数据科学家生产力

原文:

www.kdnuggets.com/2022/03/maximize-productivity-data-scientist-organizing.html

Kaleidico 来自 Unsplash

有时感觉一天的时间不够用。当你正在完成一个任务时,另一个请求可能会出现。如果你处理数据,原本希望用几个小时完成的任务可能会变成几天。

你的 8 小时工作日可能会变成 9 小时、10 小时,有时甚至更多。你开始花费如此多的时间在工作上,以至于忽视了个人生活。

有很多文章解释了如何提高你的工作生产力;然而,数据科学家的生活却是不同的。组织自己将为你节省大量时间和精力,使你的工作日更加顺畅;让你能按时完成工作。

我们都会遇到这种情况;大多数时候我们做得很好,但有时工作太多导致我们偏离了规律,组织工作也就无从谈起。我总是对人们说,关于组织自己;如果花费不到 10 分钟,马上去做。

当涉及到在数据导向环境中组织自己时,可能会感到不堪重负。文件、笔记本和文档繁多,容易变得混乱。以下是一些帮助你在处理数据时进行组织的提示。

给文件起具有描述性的名称

当你在浏览成千上万的数据集时,这将为你节省大量时间。很多时候文件会丢失,因为团队成员不记得文件名;然而,如果你给文件起具有描述性的名称,Mac 或 Windows 上的快速搜索可以解决这个问题,节省你的时间。

以下是给文件命名时需要考虑的一些要点,无论是在项目开始前还是思考新系统时。

文件名称需要:

-

一致性

-

对你和你的同事有意义

-

容易访问

在开始一个新项目或重新考虑现有系统之前,如果你的团队能就以下几个方面达成一致,将会很有帮助:

-

词汇 – 确保大家使用统一的语言

-

标点符号 – 需要仔细考虑标点符号,如大写字母、连字符和空格,以及它们的使用效果。

-

日期 – 这将帮助你区分项目,使你能够回顾旧项目。例如:YYYY-MM-DD

-

顺序 - 讨论并达成共识,确定哪个元素应该优先,以便文件可以轻松找到。例如,按日期、项目代码和客户排序文件名。

创建文件夹

将所有的数据集、笔记本和输出集中在一个地方会很快变得混乱。为特定项目创建文件夹,并包含子文件夹,将帮助您区分不同的内容,也能更容易找到文件等。向团队其他成员解释这一过程,并确保每个人使用相同的系统,将解决缺失数据集、笔记本等问题。

如果团队成员想回顾一个旧项目,他们将能够舒适地做到这一点,因为项目将被划分,并附有描述性文件名。如果每个人都遵守程序,他们将不需要咨询其他团队成员这些文件的位置。

文档

作为数据科学家,您每天会处理大量的数据集,这些数据集可能彼此不同。您可能在进行一个项目时遇到与以前的项目类似的问题;然而,您不记得问题是否相同或解决方案是什么。

文档,文档,文档。我们的脑袋很棒,但我们不能保证记住所有事情。然而,如果我们记得把所有东西写下来;至少我们有可以参考的东西。

在每个项目开始时记录数据是一个好的实践;这可能包括研究或可能影响项目的问题。随着项目的进展,继续添加信息对理解问题和解决方案非常重要,同时也能了解下次应该避免的事项。这是改善组织工作流程的重要因素。

有几种方法可以将文档添加到您的数据中:

-

嵌入文档 - 这是指一个文档,通常结构为文本文件或二进制文件,嵌入到另一个文档中。

-

支持文档 - 这是附带数据的独立文件。它提供了背景、解释或关于如何使用数据的说明。

Sigmund 通过 Unsplash

一旦这些数据科学项目工作流程的元素被修正并且所有团队成员遵守,您将开始看到生产力的变化;这将使您能够专注于其他紧迫的问题。这些可以是数据整理、修复错误等。

Nisha Arya 是一位数据科学家和自由职业技术写作员。她特别感兴趣于提供数据科学职业建议或教程,以及围绕数据科学的理论知识。她还希望探索人工智能如何能够促进人类寿命的不同方式。她是一个热衷学习者,寻求拓宽自己的技术知识和写作技能,同时帮助指导他人。

更多相关主题

利用 ChatGPT 最大化数据分析效率

原文:

www.kdnuggets.com/maximizing-efficiency-in-data-analysis-with-chatgpt

编辑提供的图像

随着数据成为最有价值的商业资产,数据分析在组织决策中扮演着至关重要的角色。公司需要全面检查、转化和建模数据,以发现有用的信息并帮助决策。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

随着组织必须处理越来越多的数据,分析数据变得越来越具挑战性。在这种情况下,ChatGPT 能够参与数据分析过程是一项宝贵的资产。

ChatGPT 能够理解和生成类似人类的文本,帮助你查询数据集、生成代码片段以及解释结果。因此,当组织将这个先进的语言模型整合到数据分析过程中时,它简化了工作流程并提高了效率。

本文探讨了将 ChatGPT 无缝融入数据分析工作流的过程、挑战和案例研究。让我们简要了解 ChatGPT 的定义和功能。

什么是 ChatGPT 以及它能做什么?

在过去一年中,ChatGPT 已经成为科技界及其他领域的家喻户晓的名字。它是基于 OpenAI 的 GPT-3.5 架构开发的语言模型。在这里,GPT 代表“生成预训练变换器”。基本上,这是一个人工智能模型,可以理解人类提供的输入,并生成类似人类的文本作为回应。

ChatGPT 可以执行多种任务。其中一些包括:

-

理解人类使用的自然语言

-

理解讨论的上下文

-

生成连贯而多样的响应以应对各种提示

-

从一种语言翻译成另一种语言

-

基于其训练知识资源回答问题

-

生成代码片段和解释

-

基于提示写故事和诗歌

几乎所有职业的人都可以利用 ChatGPT 的这些功能来简化个人和职业生活。

数据分析的效率重要性

实时决策

在任何需要即时决策的商业环境中,高效的数据分析是必需的。它使组织能够快速提取有意义的数据洞察,从而确保及时和明智的决策。

资源优化

所有商业资源都很宝贵,包括人力和时间。高效的数据分析可以简化分析过程,从而明智地利用你的宝贵资源。

超越竞争对手

通过分析数据,公司可以获得可操作的洞察,从而帮助他们在竞争中保持领先。

提高生产力

如果数据分析过程变得高效,它减少了分析师生成洞察所需的时间和精力。这不仅提高了他们的生产力,还使他们能够专注于更复杂和战略性的任务。

提高准确性

高效的数据分析方法对于数据验证和质量检查非常有用。因此,你可以获得准确的结果,减少由于分析过程效率低下而可能出现的错误。

ChatGPT 在数据分析中的相关特性

高级数据分析

这是 ChatGPT-4 的独特功能。这允许用户直接将数据上传到平台以编写和测试代码。如果你没有访问权限,这里是如何免费获取付费 ChatGPT 计划的方法。

解决问题

如果你在数据分析过程中遇到障碍,ChatGPT 可以为与数据、算法或分析方法相关的问题建议故障排除解决方案。

理解自然语言

由于 ChatGPT 能理解自然语言文本,用户可以使用普通语言与这个模型互动。实际上,这是最受欢迎的 ChatGPT 特性之一。

解释概念

ChatGPT 可以用易于理解的语言解释数据分析概念、统计方法和机器学习技术。希望学习数据分析基础的用户可以利用它。

头脑风暴创意

即使是在数据分析策略的头脑风暴会议中,ChatGPT 也可以协助制定假设、实验设计或处理复杂数据问题的方法。

协助工具使用

ChatGPT 还可以指导你使用不同的数据分析工具或平台。它是解释工具功能的有用资源。

帮助文档编写

ChatGPT 可以帮助解释方法、记录代码以及撰写数据分析项目的文档。

数据解释

ChatGPT 能够解释分析数据的结果。它可以告诉你统计发现和机器学习预测的含义。

使用 AI 和 NLP 在数据分析中的优势

-

从非结构化数据源自动提取洞察

-

增强的自然语言交互用于查询和报告

-

提高数据处理和分析的效率和速度

-

情感分析和基于上下文的数据解释

-

多语言数据分析的语言翻译

-

通过 AI 建议强化决策过程

-

支持大数据集的自动文档处理

-

趋势分析和模式识别

如何将 ChatGPT 集成到数据分析工作流中

以下是如何将 ChatGPT 融入你的数据分析工作流。这可能涉及也可能不涉及将其集成到数据分析工具中。

确定具体的使用案例

根据你的行业和组织需求,你需要定义你希望使用 ChatGPT 的情况。这可能是自然语言查询、代码辅助、数据解释或协作沟通。仅选择 ChatGPT 能够增值的领域。

选择集成点

如果你想将 ChatGPT 融入你的数据分析工作流,请确定它最有益的地方。你可以在数据探索阶段、编写代码时或输出数据解释时纳入它。

选择互动方式

然后,你需要选择用户如何与 ChatGPT 互动。你可以选择将其集成到数据分析工具中,或通过网页界面使用它。此外,你还可以通过 ChatGPT API 来使用它。实现 API 可以通过进行 API 调用来完成。关于如何发起 API 请求和处理响应的详细 OpenAI 文档是可用的。

用户培训和指南

完成这些后,你必须教会用户如何与 ChatGPT 互动,以进行有效的数据分析。创建一个指南,说明其局限性和获取准确响应的最佳实践。处理敏感数据时还应有严格的安全和隐私规定。这将确保与 ChatGPT 的互动符合数据隐私法规。

评估与改进

你应定期评估 ChatGPT 在数据分析工作流中的表现。始终寻找优化其效果的方法,以最大限度地发挥它的作用。你还可以收集用户反馈,以了解用户可能面临的任何挑战。

ChatGPT 在数据分析中的使用案例

代码辅助

你可以使用 ChatGPT 来获得编码任务的帮助。例如,你可以要求它生成一个特定数据分析任务的代码片段,ChatGPT 会做到这一点。

自然语言查询

ChatGPT 可以用来处理数据分析中的自然语言查询。你可以要求它总结数据集或根据标准筛选数据。

结果解释

ChatGPT 的一个关键使用案例是结果解释。要求 ChatGPT 进行统计分析或将见解转化为模式将节省你的时间和精力。

探索性数据分析(EDA)

使用 ChatGPT 进行探索性数据分析意味着获得理解数据和制定假设的帮助。它可以为你提供有关数据转换和关键变量检查的指导。

情感分析

你可以让 ChatGPT 分析数据集中客户的情感。例如,你可以提供用户反馈,它会告诉你反馈是积极的、消极的还是中立的。

如何克服将 ChatGPT 集成到数据分析中的挑战

如果你计划将 ChatGPT 集成到数据分析中,明智的做法是了解可能遇到的挑战及其解决方法。

可靠性

ChatGPT 不能保证提供 100%准确的数据。这是将该语言模型应用于数据分析过程中的最大挑战。为避免这一点,你需要通过与已知数据交叉验证 ChatGPT 提供的信息的准确性,或通过用户反馈循环来验证信息。

理解上下文

如果你向 ChatGPT 提供复杂或高度专业化的上下文进行数据分析,它可能会难以理解。因此,在与 ChatGPT 互动时,你必须提供尽可能多的上下文,并且使用更简单、更明确的语言。

管理模糊性

在数据分析过程中,ChatGPT 可能需要处理模糊的查询或复杂的要求。用户可以通过使查询更加具体或添加更多细节来解决这个问题。

数据隐私和安全

如果你希望 ChatGPT 分析数据,可能需要与模型分享敏感和私密的原始数据。为了克服这一点,你必须使用数据匿名化技术来掩盖敏感数据。

最终想法

可以理解的是,人工智能(AI)通过自动化复杂任务和从大量数据集中提取有价值的见解来提高数据分析效率。随着这项技术的不断发展,ChatGPT 可以对数据分析产生突破性的影响。

该模型的自然语言处理功能可以生成代码片段、与数据互动并提供上下文见解。未来,预计 ChatGPT 将拥有领域特定的知识,使其能够与各种行业的数据进行更细致的互动。

对于数据分析,它能够提供针对特定分析任务的定制解决方案。用户可以与数据分析平台协作,促进更具动态性的问题解决方法。可以肯定的是,ChatGPT 将发挥其在数据分析普及化方面的作用,使更多用户能够访问和使用数据分析。

Vijay Singh Khatri**** 计算机科学学士,专注于编程和市场营销。我非常喜欢撰写技术文章和创造新产品。

更多主题

掌握季节性和提升业务成果的终极指南

图片由 upklyak 提供,来自 Freepik

企业每年在广告上花费数十亿以提高产品的知名度和消费者的兴趣,从而推动更多的购买。为了接触更广泛的受众,企业会推出有针对性的广告或活动,以吸引新客户。广告通过多种媒体进行广播,包括电视、广播、杂志、在线、社交媒体,甚至在商店中进行,以覆盖广泛的受众。由于选择众多以及必须最大化投资回报(ROI)的压力,有效分配广告资源成为一个重大挑战。在这种情况下,媒体组合建模对企业优化广告支出和最大化 ROI 变得至关重要。通过估算在某些媒体渠道上应该花费多少资金以实现特定目标(如增加销售额或品牌知名度),媒体组合建模成为企业的有用工具。这使得企业能够比较各种渠道的表现,识别改进的机会,并合理分配资源。数据驱动的洞察使企业能够调整其营销方法,提高支出的价值,并加速实现业务目标的过程。媒体组合建模是一种统计分析技术,通过分析历史广告数据(包括支出、广告展示量或点击量、产品销售、新客户获得等)来理解不同媒体渠道对业务结果的影响。这使得企业能够优化广告预算组合,提升其 ROI。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT 部门

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT 部门

除了媒体渠道的影响,媒体混合建模还考虑了外部因素,例如业务是否进行过任何促销活动、假期或任何可能影响销售的特殊事件。这是为了避免对媒体渠道绩效的影响进行任何形式的高估。

但企业需要解决并纳入其媒体混合模型中的一个关键因素是季节性。

什么是季节性,为什么它对媒体广告如此重要

简单来说,我们可以将季节性定义为时间序列数据的一种特征,其中我们可以观察到每年都会重复的可预测且规律的行为。因此,我们可以说任何可预测并且每年都会重复的行为就是季节性行为。

那么,季节性与周期性效应有何不同?周期性效应是指可以跨越不同时间段的效应。它们可能持续时间长于或短于一年,例如由于水管故障导致某地区水过滤设备销售的增加。这种效应并不规律或可预测,也可能不会每年重复。而流感季节导致流感药物销售的增加可以被称为季节性,因为它每年从 12 月到 2 月重复,并且可以预测。

那么季节性为何对媒体广告如此重要?季节性主要在两个方面影响媒体混合建模。首先,观察到媒体消费模式的变化;其次,广告效果的变化。正如我们上面讨论的,媒体混合建模如何帮助营销人员了解各种媒体渠道对销售或其他关键绩效指标(如新客户获取)的影响。将季节性纳入这些模型使广告主能够更准确地反映全年广告绩效的变化。例如,在节假日期间,各种媒体渠道可能会观察到观众增加或参与度提高,这使得它们在接触各自目标受众时更加成功。当广告主认识到并考虑季节性时,他们能够最大化媒体分配计划的效果。他们能够调整广告预算、活动和渠道选择,以便与季节性趋势和消费者需求保持一致。这确保了营销工作在最有可能产生最大影响的时间集中,从而优化广告投资回报。

时间序列数据中的季节性表现是什么样的?

我们可以通过使用季节性因素或虚拟变量将季节性纳入媒体组合模型中,以表示特定的季节性事件,例如节假日。这些因素捕捉了不同时间段对媒体响应的影响,并帮助调整模型的预测。这些变量捕捉了不同时间段对媒体响应的影响,并有助于模型的预测。

在 Python 中,我们有一个名为seasonal_decompose的 Statsmodel 库,它可以帮助我们生成季节性变量。该库将时间序列分为三个组成部分,即趋势、季节性和残差。季节性可以用两种模型表示:加法模型或乘法模型。

为了简化,我们假设我们使用的是加法模型。当时间序列的方差在不同值之间没有变化时,可以使用加法模型。在数学上,我们可以将加法模型表示为趋势、季节性和残差的各个组成部分相加。

图 1:8 个月的收入季节性分解

趋势因素

趋势成分描述了时间序列在较长时间内发生的变化,并且更具系统性。它反映了序列的根本增加或减少,并提供了对长期收集的数据的整体趋势及其幅度的指示。这有助于确定数据的基本模式以及数据的方向性。在图 1 中,我们可以看到 8 个月的收入季节性分解,如果我们查看趋势,会发现每年的夏季收入有所下降。这一见解对广告商至关重要,因为他们可以据此调整策略或支出模式。

季节性因素

季节性因素指的是在较短时间内(通常是一年内)发生的重复模式。这是外部影响如天气、节假日或其他文化事件所导致的频繁波动的表现。季节性特征的反复出现的峰值和谷值反映了数据中可以预期的规律。在上图的图 1 中,我们可以看到每隔一个月就有一个峰值,这可以帮助企业识别对收入产生影响的外部因素。

残差因素

随机和无法解释的变化无法归因于趋势或季节性,称为残差成分,也称为误差或噪声成分。它考虑了在趋势和季节性成分考虑后仍然存在的任何波动或异常。残差成分表示数据中不可预测且缺乏系统性模式的部分。

季节性分析面临的挑战

-

多重季节性:在某些时间序列数据中,可以观察到每日、每周以及每月的多重季节性模式,这些模式用简单的季节分解方法难以捕捉,可能需要更复杂的处理过程。

-

数据稀疏:如果我们在一段时间内没有均匀分布的数据,即采样频率较低或数据点非常少,则可能影响季节性估计。因此,建议至少有 2 年的每日或每周数据集,以获得更高质量的季节性估计。

-

非平稳性:如果时间序列数据具有变化的方差,这将影响季节性估计。

特定季节中的数据点有限或稀疏可能会妨碍季节效应的准确估计,特别是在处理较短的时间序列或采样频率较低的数据时。

-

不规则性:数据中常常由于一些外部因素存在异常值,这可能会扭曲季节性分析。建议在进行季节性分析之前进行数据筛选,例如异常值检测和去除。

最后,我们看到季节性如何影响媒体组合建模,并推动战略业务决策。通过在媒体组合模型中纳入季节性,营销人员可以根据消费者行为和市场动态的波动来优化他们的广告策略和预算分配。了解季节性模式使公司能够瞄准正确的受众,选择最佳的媒体渠道,并在最佳时机进行广告活动以达到最大的效果。通过利用季节性分析信息,公司可以提高广告活动的效率和效果,增加客户参与度,创造销售机会,并最终提高投资回报率。季节性使公司能够调整和量身定制其营销策略,以适应不断变化的消费者需求和偏好,从而在动荡的环境中获得竞争优势。

Mayukh Maitra 是沃尔玛的数据科学家,专注于媒体组合建模领域,拥有超过 5 年的行业经验。从构建基于马尔科夫过程的医疗结果研究模型到执行基于遗传算法的媒体组合建模,我不仅在改善人们的生活方面有所贡献,还通过有意义的洞察力将企业提升到一个新的水平。在加入沃尔玛之前,我曾在 GroupM 担任数据科学经理,专注于广告技术领域,在 Axtria 担任决策科学高级助理,工作于健康经济学和结果研究领域,并在 ZS Associates 担任技术分析师。除了我的专业角色,我还参与了多个同行评审会议的评审和技术委员会,并有机会评审多个技术奖项和黑客马拉松。

更多相关话题

了解 Gorilla:UC 伯克利和微软的 API 增强 LLM 超越 GPT-4、Chat-GPT 和 Claude

图片来自 Adobe Firefly

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您组织的 IT 需求

我最近开始了一份专注于 AI 的教育新闻通讯,目前已有超过 160,000 名订阅者。TheSequence 是一份没有废话(即没有炒作、新闻等)的 ML 取向新闻通讯,阅读时间为 5 分钟。其目标是让您了解最新的机器学习项目、研究论文和概念。请通过下面的链接订阅尝试一下:

大型语言模型(LLMs)的最新进展彻底改变了该领域,使其具备了自然对话、数学推理和程序合成等新能力。然而,LLMs 仍面临固有的局限性。它们的信息存储能力受到固定权重的限制,其计算能力也受限于静态图和狭窄的上下文。此外,随着世界的发展,LLMs 需要重新训练以更新其知识和推理能力。为了克服这些限制,研究人员已开始赋予 LLMs 工具。通过访问广泛而动态的知识库和支持复杂计算任务,LLMs 可以利用搜索技术、数据库和计算工具。领先的 LLM 提供商已开始集成插件,允许 LLMs 通过 API 调用外部工具。从有限的手动编码工具转向访问大量云 API,这一过渡有可能将 LLMs 转变为计算基础设施和网络的主要接口。像预订假期或举办会议这样的任务,可能像与一个可以访问航班、租车、酒店、餐饮和娱乐网络 API 的 LLM 对话一样简单。

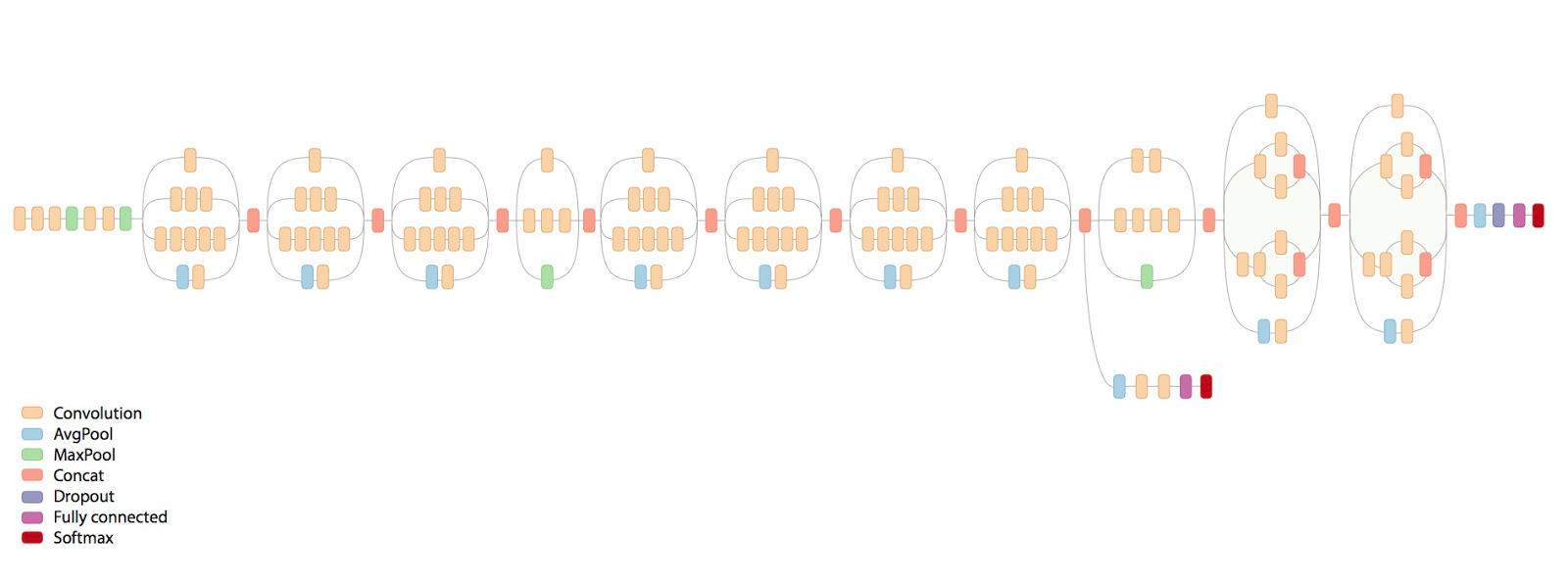

最近,UC Berkeley 和 Microsoft 的研究人员揭示了Gorilla,这是一个专门为 API 调用设计的 LLaMA-7B 模型。Gorilla 依靠自我指导微调和检索技术,使 LLM 能够从一个大规模且不断发展的工具集合中准确选择,这些工具通过其 API 和文档表达出来。作者通过从主要模型库如 TorchHub、TensorHub 和 HuggingFace 中抓取机器学习 API,构建了一个名为 APIBench 的大型 API 语料库。使用自我指导,他们生成了指令和相应 API 的配对。微调过程涉及将数据转换为用户代理聊天风格的对话格式,并对基础 LLaMA-7B 模型进行标准指令微调。

图片来源:UC Berkeley

API 调用通常带有约束,这增加了 LLM 理解和分类调用的复杂性。例如,一个提示可能要求调用具有特定参数大小和精度约束的图像分类模型。这些挑战突显了 LLM 不仅需要理解 API 调用的功能描述,还需要对嵌入的约束进行推理。

数据集

当前的技术数据集涵盖了三个不同的领域:Torch Hub、Tensor Hub 和 HuggingFace。每个领域提供了大量的信息,揭示了数据集的多样性。例如,Torch Hub 提供了 95 个 API,奠定了坚实的基础。相比之下,Tensor Hub 更进一步,拥有多达 696 个 API。最后,HuggingFace 以惊人的 925 个 API 领先,使其成为最全面的领域。

为了提升数据集的价值和可用性,进行了额外的努力。数据集中的每个 API 都附带了一组 10 个精心设计且独特定制的指令。这些指令作为训练和评估的不可或缺的指南。此举确保每个 API 超越了单纯的表示,实现了更强的利用和分析能力。

架构

Gorilla 引入了检索感知训练的概念,其中指令调优的数据集包含一个额外的字段,用于参考检索到的 API 文档。这种方法旨在教会 LLM 根据提供的文档解析和回答问题。作者展示了这种技术使 LLM 能够适应 API 文档的变化,提升了性能,减少了幻觉错误。

在推理过程中,用户以自然语言提供提示。猩猩可以在两种模式下操作:零样本和检索。在零样本模式下,提示直接输入到猩猩 LLM 模型中,该模型返回推荐的 API 调用以完成任务或目标。在检索模式下,检索器(BM25 或 GPT-Index)从 API 数据库中检索最新的 API 文档。这些文档与用户提示一起连接,并附有指示 API 文档参考的消息。然后将连接的输入传递给猩猩,猩猩输出要调用的 API。在此系统中,除了连接步骤外,不会进行提示调整。

图片来源:UC 伯克利

归纳程序合成在多个领域取得了成功,通过合成满足特定测试用例的程序。然而,当涉及评估 API 调用时,仅依靠测试用例是不够的,因为验证代码的语义正确性变得困难。以图像分类为例,该任务有超过 40 个不同的模型可用。即使将其缩小到特定的模型系列,如 Densenet,也有四种可能的配置。因此,存在多种正确答案,使得通过单元测试确定所用 API 是否在功能上等同于参考 API 变得困难。为了评估模型的性能,使用收集的数据集对其功能等价性进行比较。为了识别 LLM 在数据集中调用的 API,采用 AST(抽象语法树)树匹配策略。通过检查候选 API 调用的 AST 是否为参考 API 调用的子树,可以追踪使用的是哪个 API。

识别和定义幻觉是一个重大挑战。AST 匹配过程被利用来直接识别幻觉。在这种情况下,幻觉指的是调用一个不在任何数据库中的 API,本质上是调用一个完全虚构的工具。值得注意的是,这种幻觉的定义不同于错误地调用 API,后者被定义为一种错误。

AST 子树匹配在识别数据集中被调用的具体 API 中扮演了至关重要的角色。由于 API 调用可能具有多个参数,因此每个参数都需要进行匹配。此外,考虑到 Python 允许默认参数,需要定义在数据库中每个 API 应匹配的参数。

图片来源:UC 伯克利

《行动中的猩猩》

研究人员与论文一起,开源了 Gorilla 的一个版本。该版本包括一个包含多个示例的笔记本。此外,以下视频清晰地展示了 Gorillas 的一些魔力。

Gorilla 是工具增强 LLM 领域中最有趣的方法之一。希望我们能在一些主要的 ML 中心看到该模型的分发。

Jesus Rodriguez 目前是 Intotheblock 的首席技术官。他是一位技术专家、执行投资者和创业顾问。Jesus 创立了 Tellago,这是一家获奖的软件开发公司,专注于通过利用新兴企业软件趋势帮助公司成为卓越的软件组织。

原文。已获得许可转载。

相关话题

认识 MetaGPT:由 ChatGPT 提供支持的 AI 助手,将文本转换为 Web 应用

原文:

www.kdnuggets.com/meet-metagpt-the-chatgptpowered-ai-assistant-that-turns-text-into-web-apps

图片由作者提供

作为白天的数据科学家和晚上的自由职业者,我的日程安排非常紧张。

当 ChatGPT 去年首次发布时,它对我的日常生活来说简直是天赐之物。我用它来更快地学习数据科学概念,编写编程教程,创建数据可视化,甚至起草电子邮件。

GPT-4 和 代码解释器 的发布让我大开眼界,并为我的工作流程带来了无与伦比的效率提升。

就在我以为情况再也不会更好时,我发现了一个更具突破性的东西:MetaGPT。

什么是 MetaGPT?

MetaGPT 由 Pico 提供,允许用户利用自然语言的力量构建他们设想的任何类型的应用程序。

你只需输入一个文本提示,MetaGPT 就会自动将你的输入转换为一个功能完整的 Web 应用程序。

该工具在后台使用 GPT-4,这使其能够理解复杂的提示,并为 Web 应用程序构建底层逻辑。

尽管 MetaGPT 当前的功能可能看起来很令人印象深刻,但这只是生成 AI 领域未来发展的冰山一角。随着我们不断完善 AI 模型,无代码平台能够提供的功能将不断扩展,从而让技术开发的领域更加民主化。

我们正在开创一个未来,在这个未来中,任何人都可以将他们的应用程序想法变为现实,而无需大量投资或花费多年学习编程语言。

如何使用 MetaGPT 构建自己的 Web 应用程序?

这里有 6 个步骤,你可以用来在几分钟内构建自己的 ChatGPT 驱动的 Web 应用程序:

步骤 1:访问 MetaGPT

要访问 MetaGPT,请导航到 Pico 网站并创建一个免费账户。然后你将看到一个类似这样的界面:

你可以在文本框中输入任何应用程序想法,然后选择“创建”。

步骤 2:创建提示

由于我对了解不同的 MBTI 人格类型及其如何影响我们日常互动产生了新的兴趣,我向 MetaGPT 提出了以下应用程序想法:

Build me a ChatGPT-powered app that…

“Can predict my MBTI personality type based on a sentence”

在将这个提示输入到 MetaGPT 并点击“创建”后,将会出现以下界面:

步骤 3:向 MetaGPT 输入用户详细信息

工具正在询问我们需要从用户那里获取什么信息以构建这个应用程序。

它还根据我们输入的提示提出了一些 AI 生成的建议:

我决定使用第三个提示 - 让我们构建一个基于用户解决问题的方法预测其个性类型的应用程序。

第四步:自定义你的 MetaGPT 应用程序

MetaGPT 还允许你创建一个定制的 ChatGPT 提示,让你指定你希望应用程序如何创建。

你还可以选择一种美学(你希望应用程序的外观),甚至可以输入你的网站链接,这将被包含在应用程序的底部。

现在,让我们点击“构建我的应用程序”来看看 MetaGPT 会生成什么。

仅需几秒钟,MetaGPT 就会生成一个符合我们要求的应用程序:

在屏幕的右侧是工具生成的应用程序的视觉表示。你可以在左侧调整应用程序的界面,通过输入提示来指定你希望反映的任何设计更改。

例如,你可以要求 MetaGPT“将按钮颜色更改为蓝色”,它将生成相应的代码。这使得非程序员可以指定设计更改,而无需编写一行代码。

第五步:编辑 MetaGPT 生成的代码

该平台还允许你查看和修改用于构建 Web 应用程序的代码。

你可以点击“编辑代码”按钮,这让你查看并修改界面中的代码:

第六步:分享你的 MetaGPT Web 应用程序

最后,MetaGPT 创建一个可共享的 URL,并将你的 Web 应用程序托管在一个临时域名上,让你可以部署你的 Web 应用并与他人分享。

你可以点击这个链接来访问我刚刚通过 MetaGPT 构建的 MBTI 个性预测应用程序。

你只需输入一个解释你解决问题方法的提示,应用程序就会生成一个基于你的句子的个性类型预测。

这是我的结果:

这个应用程序几乎准确地猜测了我的个性类型!我是一名 INFP,它将我的类型辨识为 INFJ,这相当接近。

由于 MetaGPT 由 ChatGPT 驱动,基础语言模型的自然语言和推理能力在推动如此细致的预测中发挥了关键作用。

MetaGPT 为 ChatGPT 驱动的网页应用程序 - 下一步

MetaGPT 是一个强大的无代码应用程序,可以将文本输入转换为网页应用程序。

以下是一些你可以用来进行数据科学和分析的工具:

1. 模型部署

你可以使用 MetaGPT 构建机器学习应用程序的原型,以查看它在真实环境中的表现。

过去,这些原型需要创建者具备 HTML、CSS 和 JavaScript 等网页开发框架的知识,而数据科学家往往不具备这些知识。

像 MetaGPT 这样的工具帮助消除了这种入门障碍,使你能够加快从创意到构建功能原型的过渡。

2. 简化的数据库交互

我见过的 MetaGPT 最具创新性的应用之一就是这个 SQL 查询生成器 工具。

当我作为数据科学实习生加入我的第一家公司时,我不知道如何编写 SQL 查询,并且必须经历一个陡峭的学习曲线才能成功访问和操作数据库中的数据。

像这样的查询生成器应用程序对像我这样的数据专业人员来说是福音,即使我们可能对 SQL 不太精通,但仍需要在日常工作中使用它。

你只需上传现有的数据库模式,并指定你想使用的表。

然后,在纯文本中输入你希望查询执行的内容,点击“生成查询”。

只需几秒钟,网页应用程序就会编写出执行预期操作的 SQL 查询。

3. 跨团队协作

如果你是数据科学家,可以使用像 MetaGPT 这样的平台构建数据科学应用程序,并在组织内部的不同团队之间共享它们。

这使数据科学和分析能力得以民主化,使其他部门更容易获取这些能力。

例如,如果营销团队有数据分析需求,他们可以简单地将数据集上传到应用程序中,获得所需的输出,而不是每次都找数据科学团队。

这样,作为数据科学家,你可以将精力集中在更复杂的任务上,比如优化模型性能和研究新算法,而不是执行重复的分析任务。

本文就到此为止,感谢阅读。我很想听听你对 MetaGPT 的评论,以及你计划如何利用这个平台将你的应用程序创意变为现实!

Natassha Selvaraj 是一位自学成才的数据科学家,对写作充满热情。你可以通过 LinkedIn 与她联系。

更多相关主题

变压器的内存复杂度

原文:

www.kdnuggets.com/2022/12/memory-complexity-transformers.html

变压器模型的关键创新是引入了自注意力机制,它为输入序列中的所有位置对计算相似度分数,并且可以并行评估每个标记,避免了递归神经网络的顺序依赖,从而使变压器能够大大超越以前的序列模型如 LSTM。

其他地方有很多深度解释,因此在这里我想分享一些面试设置中的示例问题。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

在一个有 100 万标记的书籍上运行变压器模型的问题是什么?解决这个问题的办法是什么?

以下是供读者参考的一些提示:

简而言之,

如果你尝试在长序列上运行大型变压器模型,你会发现内存不够用。

根据谷歌研究博客(2021 年):

现有变压器模型及其衍生模型的一个限制是,完整的self-attention mechanism的计算和内存需求与输入序列长度的平方成正比。使用当前常见的硬件和模型尺寸,这通常将输入序列限制在大约 512 个标记左右,并且阻止变压器直接应用于需要更大上下文的任务,如问答、文档摘要或基因组片段分类。

查看Dr.Younes Bensouda Mourri来自Deeplearning.ai的解释:

解决变压器模型的内存复杂度问题。

对变换器进行的两个“改革”使其在内存和计算方面更高效:可逆层减少内存,局部敏感哈希(LSH)减少大输入大小下点积注意力的成本。

当然,还有其他解决方案,如 扩展变换器构建 (ETC)等。我们将在后续文章中深入探讨更多细节!

快乐练习!

注意:回答面试问题有不同的角度。此新闻通讯的作者并未尝试找到一个详尽回答问题的参考,而是希望分享一些快速见解,帮助读者思考、练习并在必要时进行进一步研究。

图片来源/好读物: 论文。通过 Deepmind 改进语言模型,通过数万亿个标记进行检索(2022) 博客。通过 Google(2021)使用稀疏注意力方法构建更长序列的变换器

视频/答案来源: 自然语言处理中的注意力模型由Dr.Younes Bensouda Mourri 提供,来自Deeplearning.ai

Angelina Yang 是一位数据和机器学习高级执行官,拥有超过 15 年的经验,致力于提供先进的机器学习解决方案和能力,以提高金融服务和金融科技行业的业务价值。专长包括在客户体验、监控、对话式 AI、风险与合规、营销、运营、定价和数据服务领域的 AI/ML/NLP/DL 模型开发和部署。

原文。经授权转载。

更多相关主题

你的机器学习代码消耗了多少内存?

原文:

www.kdnuggets.com/2021/07/memory-machine-learning-code-consuming.html

评论

图片来源:Pixabay

为什么要分析内存使用情况?

假设你写了一个很酷的机器学习(ML)应用程序或创建了一个全新的神经网络模型。现在你想通过某个网络服务或 REST API 部署这个模型。

或者,你可能是基于来自制造厂的工业传感器的数据流开发了这个模型,现在你需要将模型部署到工业控制 PC 之一,以便基于持续输入的数据做出决策。

“兴奋地开发了一个全新的 ML 模型”。图片来源:Pixabay

作为数据科学家,你可能会收到工程/平台团队非常常见的问题:“你的模型/代码占用了多少内存?”或者“在给定的数据负载下,代码的内存峰值是多少?”

这很自然,因为硬件资源可能有限,单个 ML 模块不应占用系统的全部内存。这在边缘计算场景中尤其如此,即 ML 应用可能在边缘运行,例如在工业 PC 上的虚拟化容器内。

此外,你的模型可能是运行在那块硬件上的数百个模型之一,你必须对内存使用的峰值有一定了解,因为如果大量模型在同一时间内达到内存峰值,可能会导致系统崩溃。

现在,你开始好奇了,不是吗?

图片来源:Pixabay

… 硬件资源可能有限,单个 ML 模块不应占用系统的全部内存。这在边缘计算场景中尤其如此…

不要犯这个根本错误

注意,我们讨论的是你整个代码的运行时内存剖面(一个动态量)。这与 ML 模型的大小或压缩无关(你可能将其保存为磁盘上的特殊对象,如Scikit-learn Joblib dump、一个简单的 Python Pickle dump、TensorFlow HFD5等)。

Scalene:一个整洁的内存/CPU/GPU 分析工具

这里有一篇关于一些旧的内存分析工具的文章,用于 Python。

在本文中,我们将讨论Scalene——你的终极工具,用于解答你的工程团队提出的问题。

根据其GitHub 页面,“Scalene 是一个高性能的 CPU、GPU 和内存分析工具,提供其他 Python 分析工具无法做到的功能。它的运行速度比其他分析工具快几个数量级,同时提供更详细的信息。”

它是在麻省大学开发的。查看这个视频以获取全面的介绍。

安装

毕竟,它是一个 Python 包。因此,通常按照常规安装即可,

**pip install scalene**

目前仅适用于 Linux 操作系统。我没有在 Windows 10 上进行测试。

在 CLI 或 Jupyter Notebook 中使用

使用 Scalene 非常简单直接,

**scalene <yourapp.py>**

另外,你可以通过使用这个魔法命令在 Jupyter Notebook 中使用它,

**%load_ext scalene**

示例输出

这是一个示例输出。我们将很快深入探讨这个话题。

特性

以下是 Scalene 的一些酷炫功能。大多数功能都是不言而喻的,可以从上面的截图中了解,

-

行或函数:报告整个函数和每个独立代码行的信息

-

线程:支持 Python 线程。

-

多进程:支持使用

multiprocessing库 -

Python 与 C 的时间:Scalene 区分了在 Python 与原生代码(例如库)中的时间

-

系统时间:它区分系统时间(例如,休眠或执行 I/O 操作)

-

GPU:它还可以报告在 NVIDIA GPU 上花费的时间(如果存在)

-

拷贝量:报告每秒拷贝的数据量(以 MB 为单位)

-

检测泄漏:Scalene 可以自动定位可能导致内存泄漏的代码行!

一个具体的机器学习代码示例

让我们开始将 Scalene 用于内存分析标准机器学习代码的实际操作。我们将查看两种不同类型的机器学习模型——原因很快会得到澄清。我们将使用 Scikit-learn 库来创建所有三个模型,并利用其合成数据生成函数来创建我们的数据集。

-

一个多重线性回归模型

-

使用相同数据集的深度神经网络模型

建模代码对于所有三个模型遵循完全相同的结构。外部 I/O 操作也在下图中标出,我们将看到它们可能会或不会主导内存分析,具体取决于模型类型。

图片来源:作者制作(拥有版权)

线性回归模型

代码文件在我的 GitHub 仓库中。

我们使用标准导入和两个变量NUM_FEATURES和NUM_SMPLES来进行一些后续实验。

我们没有展示数据生成和模型拟合代码。它们很标准,可以在这里查看。我们将拟合的模型保存为 pickle 格式,并与测试 CSV 文件一起加载以进行推理。

我们在main循环下运行所有内容,以便清晰地进行 Scalene 执行和报告(你很快会明白的)。

当我们运行命令时,

$ scalene linearmodel.py --html >> linearmodel-scalene.html

我们得到这些结果作为输出。注意,这里我使用了**--html**标志并将输出管道到一个 HTML 文件中以便于报告**。

那么,这个结果中有什么引人注目的地方?

内存占用几乎完全由外部 I/O 主导,比如 Pandas 和 Scikit-learn 估算器的加载,以及少量内存用于将测试数据写入磁盘上的 CSV 文件。

实际的机器学习建模、Numpy 或 Pandas 操作和推理完全不影响内存!

随着模型和数据的规模扩大会发生什么?

我们可以扩大数据集大小(行数)和模型复杂性(特征数),并运行相同的内存分析,以记录各种操作在内存消耗方面的表现。结果如下。

这里的X 轴表示特征数/数据点数的配对。请注意,这个图展示的是百分比而不是绝对值,以展示各种操作的相对重要性。

图片来源:作者提供(拥有版权)

所以,对于线性回归模型……

从这些实验中,我们得出结论,Scikit-learn 的线性回归估算器相当高效,实际模型拟合或推理并不消耗大量内存。

但是,它确实有一个固定的内存占用量,这在加载时会被消耗。然而,随着数据大小和模型复杂性的增加,该代码占用的比例会减少。

因此,如果你在处理这样的小型线性模型时,可能需要关注数据文件 I/O 以优化你的代码以获得更好的内存性能。

深度神经网络会发生什么?

如果我们用一个 2 隐层的神经网络(每个隐层 50 个神经元)运行类似的实验,那么结果如下。代码文件在这里。

图片来源:作者提供(拥有版权)

很明显,神经网络模型在训练/拟合步骤中消耗大量内存,这与线性回归模型不同。然而,对于特征数量少且数据量大的情况,拟合所需的内存量较少。

你也可以尝试各种架构和超参数,并记录内存使用情况,以找到适合你情况的设置。

遵循实验方法

如果你用相同的 代码文件 反复进行实验,结果会因硬件、磁盘/CPU/GPU/内存类型而大相径庭。本文的目的是提供一种内存分析实验的方法,而不是关注实际值或趋势。我希望你能带走对你自己代码进行内存分析实验的方法。

一些关键建议

-

最好在代码中编写小函数,专注于单一任务

-

保留一些自由变量,如特征数量和数据点数量,以便可以用最小的修改运行相同的代码文件,检查数据/模型扩展时的内存使用情况。

-

如果你在比较一个机器学习算法与另一个算法,尽量保持整体代码结构和流程尽可能一致,以减少混淆。最好只是更改估算器类,并比较内存使用情况。

-

数据和模型输入/输出(导入语句、磁盘上的模型持久化)在内存占用方面可能会出乎意料地占据主导地位,具体取决于你的建模场景。在进行优化时,千万不要忽视它们。

-

基于上述原因,考虑比较来自多个实现/包的相同算法的内存使用情况(例如 Keras 与 PyTorch 与 Scikit-learn)。如果内存优化是你的主要目标,你可能需要寻找内存占用最小但仍能满意完成工作的实现,即使它在特性或性能方面不是绝对最佳的。

-

如果数据输入/输出成为瓶颈,可以探索更快的选项或其他存储类型,例如将 Pandas CSV 替换为 parquet 文件和 Apache Arrow 存储。请查看这篇文章,

读取 Parquet 文件(使用 Arrow)与使用 Pandas 读取 CSV 的速度有多快?

你还可以使用 Scalene 做其他事情

在这篇文章中,我们只讨论了关注于经典机器学习建模代码的最基本内存分析。Scalene CLI 还有其他选项,你可以利用这些选项,

-

仅分析 CPU 时间而不分析内存使用情况

-

仅分析非零内存占用的情况

-

指定 CPU 和内存分配的最低阈值

-

设置 CPU 采样率

-

多线程并检查差异

有时需要最终验证

对于资源有限的情况,最好能托管一个验证环境/服务器,该环境将接受给定的建模代码(开发完成后)并通过这样的内存分析器运行,以生成运行时统计数据。如果它满足预定的内存占用标准,建模代码才会被接受用于进一步部署。

图片来源:作者制作(拥有版权)

如果内存优化是您的主要目标,您可能需要寻找一种内存占用最小但能够令人满意地完成工作的实现方案。

总结

在这篇文章中,我们讨论了内存分析在与平台/工程团队顺畅对接、将代码部署到服务/机器上的重要性。内存分析也可以揭示一些基于特定数据和算法优化代码的惊人方法。

我们展示了一个典型的 ML 建模代码示例,使用强大而轻量的 Python 库 Scalene 进行分析。我们展示了一些线性回归和神经网络模型的代表性结果,并提供了一些一般性的建议。

希望这些工具和技术能帮助您在将 ML 代码实施并部署到生产环境中获得更多成功。

您可以查看作者的GitHub** 代码库**,获取机器学习和数据科学方面的代码、想法和资源。如果您像我一样,对 AI/机器学习/数据科学充满热情,请随时在 LinkedIn 上添加我或在 Twitter 上关注我。

原文。经许可转载。

相关:

-

作为数据科学家的可重用 Python 代码管理

-

5 个 Python 数据处理技巧与代码片段

-

GitHub Copilot:您的 AI 编程伙伴 – 到底有什么大惊小怪的?

我们的前三大课程推荐

1. Google 网络安全证书 - 快速入门网络安全职业生涯

1. Google 网络安全证书 - 快速入门网络安全职业生涯

2. Google 数据分析专业证书 - 提升您的数据分析能力

2. Google 数据分析专业证书 - 提升您的数据分析能力

3. Google IT 支持专业证书 - 支持您的组织的 IT 工作

3. Google IT 支持专业证书 - 支持您的组织的 IT 工作

更多相关内容

如何合并 Pandas DataFrames

图片由catalyststuff在Freepik上提供

在数据处理过程中,两个或更多数据集之间的数据合并是典型的。在本博客中,我们将学习如何使用 Pandas 进行数据合并以及各种提升数据合并技能的技巧。让我们深入探讨数据合并技术。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升您的数据分析能力

2. Google 数据分析专业证书 - 提升您的数据分析能力

3. Google IT 支持专业证书 - 支持您组织的 IT

3. Google IT 支持专业证书 - 支持您组织的 IT

合并 Pandas DataFrame

首先,我们需要导入 Pandas Python 包。

import pandas as pd

合并两个 Pandas DataFrames 需要使用 Pandas 包中的 merge 方法。这个函数会根据我们意图连接的变量或列合并两个 DataFrame。让我们通过一个示例 DataFrame 来尝试 Pandas 的合并方法。

# Create Population DataFrame

df1 = pd.DataFrame({

'Country': ['America', 'Indonesia', 'France'],

'Location': ['New York', 'Jakarta', 'Paris'],

'Population': [731800, 575030, 183305]

})

# Create Income DataFrame

df2 = pd.DataFrame({

'Country': ['America', 'America', 'Indonesia', 'India', 'France', 'Greece'],

'Location': ['New York', 'Chicago', 'Jakarta', 'Mumbai', 'Paris', 'Yunani'],

'Income': [1000, 1500, 1400, 1100, 900, 1200]

})

# Merge Dataframe

merged_df = pd.merge(df1, df2, on='Country')

merged_df

图片由作者提供

在上面的示例中,我们创建了两个具有稍微不同列的 DataFrame,并在‘Country’列上合并它们。结果是两个 DataFrame 中具有相似值的行被合并在一起。我们通过一行代码成功合并了两个不同的 DataFrame。

应用可选参数

Pandas 的.merge 方法有各种可选参数可以利用。让我们看一下其中一些有用的参数。

重命名合并的同名列

在上面的示例中,我们可以看到一个名为‘Location’的列,在合并后该列带有后缀 _x 和 _y。如果我们想在合并时更改列名,可以使用以下代码来实现。

merged_df = pd.merge(df1, df2, on='Country', suffixes = ('_Population', '_Income'))

merged_df

图片由作者提供

在这段代码中,我们传递了带有两个值的元组作为 suffixes 参数;第一个和第二个 DataFrame 的名称。在我的示例中,我们将第一个 DataFrame 命名为 Population,将第二个命名为 Income。

基于不同列名进行合并

如果我们有两个 DataFrame,其列名不同但指代相同的定义,我们仍然可以合并它们,但需要指定要合并的 DataFrame 和列。

df2 = pd.DataFrame({

'Index': ['America', 'America', 'Indonesia', 'India', 'France', 'Greece'],

'Location': ['New York', 'Chicago', 'Jakarta', 'Mumbai', 'Paris', 'Yunani'],

'Income': [1000, 1500, 1400, 1100, 900, 1200]

})

merged_df = pd.merge(df1, df2, left_on='Country', right_on = 'Index')

merged_df

图片由作者提供

在上述示例中,我们将第二个 DataFrame 的‘Country’列更改为‘Index’,然后通过在每个 DataFrame 中指定列名来合并数据集。Left_on 参数用于第一个 DataFrame,right_on 用于第二个 DataFrame。

更改合并类型

Pandas 合并方法中有五种不同的合并类型。默认情况下,合并是内连接,只包括在两个列中都有匹配值的行。然而,我们可以通过将值传递给 how 参数来更改合并类型:

- 左连接

左连接仅使用第一个 DataFrame 的值。

merged_df = pd.merge(df1, df2, on='Country', how = 'left')

merged_df

图片由作者提供

- 右连接

右连接仅使用第二个 DataFrame 的值。

merged_df = pd.merge(df1, df2, on='Country', how = 'right')

merged_df

图片由作者提供

- 外连接

通过使用两个 DataFrame 键的并集来包含两个 DataFrame 中的所有行。

图片由作者提供

- 交叉连接

从两个 DataFrame 创建一个笛卡尔积

merged_df = pd.merge(df1, df2, how = 'cross')

merged_df

图片由作者提供

通过两个或更多不同的列进行合并

使用 Pandas 合并可以将两个 DataFrame 与两个或更多不同的列连接在一起。我们需要在 on 参数中指定要合并的列列表。

merged_df = pd.merge(df1, df2, on = ['Country', 'Location'])

merged_df

图片由作者提供

结论

在数据处理过程中,合并两个不同的 DataFrame 是一种常见的活动。为此,我们可以使用 Pandas 的 merge 方法。在 Pandas merge 中,我们可以访问各种可选参数以执行特定任务,包括更改合并列的名称、基于不同列名称合并 DataFrame、更改合并类型以及通过两个或更多列进行合并。

Cornellius Yudha Wijaya 是一名数据科学助理经理和数据撰稿人。尽管全职工作于 Allianz Indonesia,他仍喜欢通过社交媒体和写作媒体分享 Python 和数据技巧。

更多相关主题

在 Python 中合并 Pandas DataFrames

原文:

www.kdnuggets.com/2020/12/merging-pandas-dataframes-python.html

评论

作者 Dean McGrath, 渴望成为数据分析师

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT

介绍

作为数据科学家,我们经常需要同时分析来自多个数据源的数据。要成功实现这一目标,我们需要能够高效地使用各种方法合并不同的数据源。今天我们将探讨使用 Pandas 内置的 .merge() 函数来通过几种不同的连接方法合并两个数据源。

入门

对于那些刚接触数据科学或尚未接触 Python Pandas 的人,我们建议首先阅读 Pandas 系列 & DataFrame 解析 或 Python Pandas 迭代 DataFrame。这两篇文章将为你提供安装说明和今天文章的背景知识。

Pandas 合并

Pandas 内置的 .merge() 函数提供了一种强大的方法,通过数据库风格的连接来合并两个 DataFrames。

语法

上述 Python 代码片段显示了 Pandas .merge() 函数的语法。

参数

-

right— 这将是你要连接的 DataFrame。 -

how— 在这里,你可以指定你希望两个 DataFrame 如何连接。默认值是inner,但是你可以传递left进行左外连接,right进行右外连接,outer进行完全外连接。 -

on— 如果两个 DataFrame 都包含一个共享的列或一组列,你可以将这些列传递给on作为合并的键。 -

left_on— 在这里,你可以指定一个列或标签列表,用于连接左侧 DataFrame。当你希望在两个 DataFrame 中连接的列名不同的时候,这个参数非常有用。 -

right_on— 条件与left_on相同,只是针对右侧 DataFrame。 -

left_index— 如果你希望使用索引来连接左侧 DataFrame,那么传入True。 -

right_index— 如果你希望使用索引来连接右侧 DataFrame,那么传入True。 -

sort— 如果你希望连接的键按字母顺序排序,可以传入True。 -

suffixes— 如果两个 DataFrame 共享列标签名称,则可以指定应用于重叠部分的后缀类型。默认的是左侧使用_x,右侧使用_y。 -

indicator— 如果你希望标记行的来源,可以将此参数设置为True。此标记将指示行的键是否仅出现在左侧 DataFrame、右侧 DataFrame,或两者都出现。 -

validate— 在这里,你可以检查 DataFrame 是如何连接的以及键之间的关系。你可以传入以下参数来检查:1:1检查键是否在左侧和右侧 DataFrame 中唯一,1:m检查合并的键是否仅在左侧 DataFrame 中唯一,m:1检查合并的键是否仅在右侧 DataFrame 中唯一。

实际应用

接下来,我们将通过几个示例来演示如何自己使用 merge 函数。下面提供的代码片段将帮助你创建两个我们将在后续故事中使用的 DataFrame。

上面的 Python 代码片段创建了两个 DataFrame,你可以使用它们来继续以下示例。

上面的控制台输出显示了执行 Python 代码片段以创建两个 DataFrame 的结果。

内连接

内连接方法是 Pandas merge 的默认方法。当你传入 how='inner' 时,返回的 DataFrame 只会包含两个 DataFrame 中共享的列的值。

上面的 Python 代码片段演示了如何使用内连接来连接两个 DataFrame。

上面的图片显示了内连接两个 DataFrame 后的控制台输出。

从上面的控制台输出截图中,我们可以看到内连接对两个 DataFrame 的影响。由于值 a、c、e 和 f 在两个 DataFrame 中不共享,它们不会出现在控制台输出中。输出还演示了处理两个 DataFrame 之间共享列标签时默认的后缀应用。

左连接

Pandas 的左连接函数类似于 SQL 中的左外连接。返回的 DataFrame 将包含左侧 DataFrame 中的所有值,以及在合并过程中与右侧 DataFrame 中的连接键匹配的任何值。

上面的 Python 代码片段展示了使用左连接来合并两个 DataFrame 的语法。

上面的截图显示了使用左连接合并两个 DataFrame 的控制台输出。

如果右侧 DataFrame 中的值与合并列不匹配,则在返回的 DataFrame 中将插入 NaN,不是数字。

右连接

Pandas 右连接执行的功能类似于左连接,但连接方法应用于右侧 DataFrame。

上面的 Python 代码片段展示了使用 Pandas 右连接合并两个 DataFrame 的语法。

上面的截图显示了使用右连接合并两个 DataFrame 的结果。

如上所示,右侧 DataFrame 中不存在的任何键,在左侧 DataFrame 中将插入一个 NaN 值。

外连接

Pandas 外连接合并两个 DataFrame,并本质上反映了左外连接和右外连接的结果。外连接将返回左侧和右侧 DataFrame 的所有值。如果 Pandas 无法在合并的 DataFrame 中找到一个值,将使用 NaN 代替。

上面的 Python 代码片段展示了使用外连接连接两个 DataFrame 的语法。

上面的截图显示了使用外连接合并两个 DataFrame 的结果。

在使用外连接合并两个 DataFrame 时,有时了解新 DataFrame 中记录的来源是有用的信息。你可以通过将 indicator=True 作为参数传递给 .merge() 函数来查看记录的来源,这将创建一个标题为 _merge 的新列。

总结

要成为成功的数据科学家,你需要具备处理来自多个数据源的数据的技能,并且经常是同时进行的。我们常常需要结合数据源来丰富数据集或在当前数据中合并历史快照。Pandas 提供了一个强大的方法来通过内置的 .merge() 函数连接数据集。Pandas .merge() 函数提供了创建不同类型连接的灵活性,以实现所需的输出。

感谢你抽出时间阅读我们的故事——希望你觉得它有价值!

个人简介:Dean McGrath (@DeanMcGrath8) 是一名有志的数据分析师,并且是 Towards Data Science 的贡献者。

原文。经许可转载。

相关内容:

-

Pandas 升级版:使用 Dask 完成端到端的数据科学

-

每个复杂的 DataFrame 操作,直观解释与可视化

-

10 个被低估的 Python 技能

更多相关话题

元数据如何改善安全性、质量和透明度

原文:

www.kdnuggets.com/2022/04/metadata-improves-security-quality-transparency.html

Spotify 如何与像 Apple 这样的巨头抗衡?一个字:数据。通过机器学习和 AI,Spotify 通过提供更个性化和定制化的体验为用户创造价值。让我们快速了解一下用于增强其平台的聚合信息层:

-

Spotify 使用自然语言处理(NLP)扫描关于你正在听的音乐的讨论论坛,然后将你的偏好与其他讨论相似的音乐匹配;

-

音乐的组成被分析以了解音调、声音、响度、音质(即大调或小调)以及其他用于推荐类似歌曲和艺术家的因素;

-

当然,Spotify 会在听音乐时测量行为,追踪重复播放或跳过歌曲,建立偏好,从而改进推荐。

这里的核心数据是音乐——歌曲的基本组成部分,如标题、艺术家和时长。选择一首歌来听定下了基线(也许你喜欢它的低音线)。其他一切都可以视为元数据:关于如何听歌、歌曲的构成以及其他类似的音乐的附加元素。

我们的前 3 名课程推荐

1. Google Cybersecurity Certificate - 快速进入网络安全职业道路。

1. Google Cybersecurity Certificate - 快速进入网络安全职业道路。

2. Google Data Analytics Professional Certificate - 提升你的数据分析技能

2. Google Data Analytics Professional Certificate - 提升你的数据分析技能

3. Google IT Support Professional Certificate - 支持组织的 IT 需求

3. Google IT Support Professional Certificate - 支持组织的 IT 需求

在这里,元数据是 Spotify 算法的驱动力,它被不断收集和应用,以提供智能推荐,保持你不断听歌。

什么是元数据?

简单来说,在技术行业中,“meta”指的是底层定义或描述。更直接地说,元数据提供了关于数据的上下文,超出你在行和列中看到的内容。

这个定义相当广泛,但主要是因为它几乎可以用于任何目的——它可以详细告诉你每一列标题的含义,谁上传了数据及何时,整个数据集的列数和行数,原始数据来源,甚至仓储和居留要求。

元数据如何组织?

有 3 种主要的元数据类型相互作用:行政性、描述性和结构性。每种类型在解释相应数据方面发挥不同的作用。

结构化元数据 – 提供数据元素组织方式的见解。这便于快速和轻松的导航,如目录或页码。结构化元数据允许将类似数据分组,记录唯一数据集之间的关系。

管理性元数据 – 提供有关数据的技术信息。它涵盖数据的来源、数据类型和访问或使用许可等方面。

描述性元数据 – 添加有关所有者、数据创建/发布时间以及数据包含内容的信息。其基本目的是简化识别,并提供数据的快照。

这些类型的元数据的组合使组织能够高效地在大量数据中导航,使其在需要时容易找到所需的信息。

元数据为何重要?

53%的分析消费者在定位和访问数据内容时遇到困难。随着数据量的增加,组织了解其拥有的数据、数据位置和使用方式变得越来越重要。

元数据的作用不仅限于描述数据。元数据可以使数据发现变得更加容易,并帮助增加对数据集的理解。例如,以图书馆书籍为例。如果文本是主要数据,则书籍封面可能包含书籍的简要总结和其他人的评论。重要的是,图书馆还可能附加数据,为书籍提供类别、类型和唯一标识符,以便于组织和检索。

元数据还可以通过确保组织在数据集级别跟踪使用情况、共享和许可权限,来协助遵守监管要求。通过附加使数据使用方式、目的以及可以或不可以共享对象的元数据,您可以将安全性和合规性内建于数据本身。

数据目录平台中的元数据管理

通过管理您的元数据,您实际上是在创建数据资产的百科全书。元数据管理是数据管理的一个子集,而数据管理本身属于数据治理的范畴。

因此,关注元数据管理的主要原因与实施数据治理策略的原因相同:提高数据安全性、数据质量和整体透明度。

提高数据安全性:

-

元数据将使用限制和许可直接与数据绑定

-

揭示数据所有权和维护者,以便明确角色

-

将与数据集相关的信息整合和编纂,以确保不会丢失

提高数据质量:

-

设计/实施组织范围的本体论

-

实体解析/记录关联变得更加简单

-

对于随时间变化的洞察

提高透明度:

-

增加了组织内部和跨团队的可发现性

-

创建可审计的使用、访问和更新记录

-

分享信息而不泄露敏感数据

精细的元数据管理不仅是将这些丰富信息与数据集本身连接起来,而是以一种易于访问、执行和管理的方式来处理。

元数据在数据目录中的好处是什么?

使用 ThinkData Works 的特定工具和功能,你可以解锁源于元数据的宝贵收益:

自定义元数据 – 向数据集添加任何元数据的能力,包括关联/相关的数据集、上传使用协议、成本与许可以及数据字典

可配置的属性定义 – 数据目录允许你在数据集中输入模式描述,将元数据绑定到属性

数据集版本控制/修订 – 每个数据集结构随着模式的变化而产生的版本,以及每次数据更新时跟踪的修订。这样,用户可以在更新其模型和仪表板时跟踪数据的稳定版本

数据健康监控 – 一个用于报告和警报配置的仪表板,根据数据随时间变化的情况,包括“宏观”信息(如行和列计数)或“微观”信息(如值类型或值范围)

访问审计 – 具体的使用统计信息和描述用户行为、API 调用及对数据进行或进行的数据操作的信息。

灵活管理,严格治理

元数据管理是健全数据治理的关键部分 – 是有效数据战略中最重要的部分之一。我们知道每个组织都有独特的需求,因此一个好的元数据解决方案应当强大且可执行,同时足够灵活以便按照每家公司量身定制的数据管理方式。

通过提供全面的元数据管理,ThinkData Works 使我们的客户能够在强大、安全的基础上构建数据驱动的解决方案。

你认为你的业务是否需要一个数据目录来查找、理解和使用可信的数据以推动业务成果? 联系我们 以解锁数据的价值。

Tim Lysecki 是 ThinkData Works 的产品营销经理,他负责塑造公司的市场战略,指导媒体报道公司和产品,并扩展客户名单。在业余时间,他还是一位热衷于创作歌曲、表演和摄影的人。

更多相关内容

介绍 MetaGPT 的数据解释器:SOTA 开源 LLM 基于的数据解决方案

原文:

www.kdnuggets.com/metagpt-data-interpreter-open-source-llm-based-data-solutions

图像由作者使用 Midjourney 创建

MetaGPT 是一个多智能体框架,用于将角色分配给各种智能体,形成协作实体,这些实体能够协调工作以执行复杂指令。MetaGPT 自称为“作为多智能体系统的软件公司”,为你提供这些协作实体的预期用途的想法。MetaGPT 可作为独立应用程序从命令行使用,也可作为库在你自己的 Python 脚本中使用,提供了所需的灵活性和控制。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

该项目始于 2023 年 4 月,利用 ChatGPT,目前在撰写时 GitHub 上已有近 40K 星标。其 GitHub 仓库进一步描述如下:

MetaGPT 接收一行要求作为输入,并输出用户故事/竞争分析/需求/数据结构/API/文档等。

在内部,MetaGPT 包括产品经理/架构师/项目经理/工程师。它提供了一个软件公司的整个过程以及精心编排的标准操作程序(SOP)。

MetaGPT 的软件公司多智能体示意图(逐步实施)(来自 MetaGPT 的 GitHub)

MetaGPT 可用于代码生成、原型设计、项目规划等。它被认可为 杰出的开源成就,并且持续成为 GitHub 上的热门仓库。

这就是 MetaGPT。现在让我们深入讨论 数据解释器、Deep Wisdom's 最新 MetaGPT 改进和成就。

介绍 MetaGPT 数据解释器的完整视频

展示如何通过动态规划、工具利用、增强推理和基于经验的验证来应对电力负荷预测挑战。

案例:

t.co/GhNH54Ahhi… pic.twitter.com/Xc5aam1TXz— MetaGPT (@MetaGPT_) 2024 年 3 月 19 日

数据解释器是 MetaGPT 框架中的另一个成员代理,专注于评估和解决数据相关任务。从论文中:

在这项研究中,我们介绍了数据解释器,这是一种通过代码解决问题的解决方案,强调三项关键技术以增强数据科学中的问题解决能力:1) 使用分层图结构进行动态规划,以实现实时数据适应性;2) 动态工具集成,以提高执行期间的代码熟练度,丰富所需的专业知识;3) 反馈中的逻辑不一致性识别,通过经验记录提高效率。[...] 与开源基准相比,它展示了优越的性能,在机器学习任务中表现出显著改进,从 0.86 提高到 0.95。此外,它在 MATH 数据集上表现出 26%的提升,在开放性任务上则取得了 112%的显著改善。

这些发现确实令人印象深刻。而且无需盲目相信这些结果,因为他们已经发布了这些结果。Deep Wisdom 还提供了大量示例,以展示他们的数据解释器代理如何与现有的 MetaGPT 框架一起使用。

这个示例展示了它如何用于 NVIDIA 股票趋势分析。要查看 MetaGPT 数据解释器提示的样子,我将在下面重复一遍:

从 Yahoo Finance 获取 NVIDIA Corporation (NVDA)的股票价格数据,重点关注过去 5 年的历史收盘价。总结统计数据(均值、中位数、标准差等)以了解收盘价的集中趋势和离散程度。分析数据以发现任何明显的趋势、模式或异常情况,可能使用滚动平均或百分比变化。创建一个图表来可视化所有的数据分析。保留 20%的数据集用于验证。对训练集训练预测模型。报告模型的验证准确率,并可视化预测结果。

你可以查看上面链接的示例笔记本,以跟随 MetaGPT 的过程并查看结果。剧透:Deep Wisdom 没有分享这些结果,因为它们并不令人印象深刻 😃

阅读完整论文以获取所有相关信息。有关安装和使用的更多信息,请查看项目的GitHub 仓库。根据我的经验,我可以证明 MetaGPT 是一个值得查看的项目,并且随着数据解释器代理的加入,这一点比以前更加真实。

马修·梅奥 (@mattmayo13) 拥有计算机科学硕士学位和数据挖掘研究生文凭。作为KDnuggets与Statology的执行编辑,以及Machine Learning Mastery的特约编辑,马修致力于使复杂的数据科学概念变得易于理解。他的专业兴趣包括自然语言处理、语言模型、机器学习算法以及探索新兴的人工智能。他的使命是让数据科学社区中的知识变得更加民主化。马修从 6 岁起就开始编程。

更多相关主题

Meta 的新数据分析师专业认证已发布!

原文:

www.kdnuggets.com/metas-new-data-analyst-professional-certification-has-dropped

图片由作者提供

我们的三大课程推荐

1. Google 网络安全证书 - 快速开启网络安全职业生涯。

1. Google 网络安全证书 - 快速开启网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT 需求

3. Google IT 支持专业证书 - 支持你的组织 IT 需求

Coursera 平台上推出了一个新的专业认证 - Meta 数据分析师专业证书。

如果你曾考虑进入数据分析市场,现在是个绝佳机会。目前美国数据分析师的中位年薪为$82,000+,该领域有超过 90,000+个职位空缺。

让我们直接进入课程…

Meta 数据分析师认证

链接: Meta 数据分析师专业证书

本课程面向希望从数据分析师角度进入技术行业的初学者。你可以根据自己的时间和节奏进行学习。如果每周投入 10 小时,整个课程需要 5 个月完成,但如果你能投入更多时间,则可以更快完成!

该认证由 5 门课程组成:

-

数据分析入门

-

使用电子表格和 SQL 进行数据分析

-

Python 数据分析

-

市场营销统计学

-

数据管理入门

我将学到什么?

在这 5 门课程中,你将学习到:

-

如何收集、清理、排序、评估和可视化数据

-

学习如何应用 OSEMN 框架来指导数据分析过程

-

确保你采取的方法能提供可操作的见解

-

使用统计分析,如假设检验和回归分析,做出数据驱动的决策

-

理解有效数据管理的基础原则

-

理解数据资产在组织中的可用性

我将从此认证中获得什么?

如果你计划参加此认证,这里是一些特点和附带的好处:

-

从 Meta 获得专业级培训

-

展示你在准备好项目上的能力

-

符合热门职位要求:数据分析师、助理数据分析师和业务分析师

-

简历和 LinkedIn 评审,提供个性化反馈

-

使用互动工具和模拟面试来实践你的技能

-

借助 Coursera 的求职指南获得职业支持

总结

在 5 个月内,你可能准备好开始新的职业生涯,获得所需的支持和指导。随着数据价值的提升,对数据分析师的需求持续增长。

祝学习愉快!

Nisha Arya是一名数据科学家、自由技术作家,以及 KDnuggets 的编辑和社区经理。她特别关注提供数据科学职业建议或教程以及理论基础知识。Nisha 涉及广泛的话题,并希望探索人工智能如何有益于人类寿命的不同方式。作为一个热衷的学习者,Nisha 寻求拓宽她的技术知识和写作技能,同时帮助指导他人。

更多相关内容

我该使用哪个指标?准确度与 AUC

准确度和 AUC(曲线下面积)是评估模型性能优劣的指标。两者都对根据你试图解决的业务问题来评估模型性能有所帮助。那么你应该在何时使用哪一个呢?简短的回答是 - 这要看情况!

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

在这篇文章中,我们将首先描述这两个指标,然后详细了解每个指标,并理解何时使用它们。

什么是准确度?

准确度是最受欢迎的指标,用来确定模型做出正确预测的百分比。

它是通过将正确预测的数量与数据集中样本总数的比率来计算的。结果以百分比形式表示,例如,如果模型正确预测了数据集中 90%的项目,则准确度为 90%。

从数学上讲,它写作:

公式中的四个成分基于实际值和下述对应的模型预测:

-

真阳性(TP) - 模型正确识别为正类的实例数量。

-

真阴性(TN) - 模型正确识别为负类的实例数量。

-

假阳性(FP) - 模型错误识别为负类的实例数量。

-

假阴性(FN) - 模型错误识别为正类的实例数量。

这些指标通过对模型预测的概率得分应用适当的截止值来得出。关于每个术语及其与混淆矩阵的关系的详细解释在这篇文章中有所说明。

什么是 AUC?

AUC 代表“曲线下面积”,全称为“接收者操作特征曲线下的面积”。它捕捉 ROC(接收者操作特征)曲线下的面积,并比较不同阈值下真实正例率(TPR)与假正例率(FPR)之间的关系。

但在深入了解 AUC 之前,让我们首先了解这些新术语的含义。

TPR 或真实正例率

这是所有正样本中被正确预测为正实例的比例。例如,如果模型的任务是识别欺诈交易,那么 TPR 被定义为所有欺诈交易中被正确预测的欺诈交易的比例。

FPR 或假正例率

这是被错误预测为负例的负样本的百分比。继续以欺诈检测模型为例,FPR 被定义为所有合法交易中被错误预测为欺诈警报的比例。

从数学上讲,TPR 和 FPR 的表达式如下:

现在我们理解了 TPR 和 FPR 的定义,让我们了解它们如何与 AUC 指标相关。

编辑提供的图片

从上面的图片中可以看出,左上角,即高 TPs 和低 FPs,是理想状态。因此,紫色曲线代表了 AUC 为 1 的完美分类器,即该曲线下的矩形区域为 1。

但在现实应用中,构建这样的理想分类器实际上是不可实现的。因此,了解分类器的下界是重要的,红色对角线表示这一点。它被标注为随机分类器,AUC 为 0.5,即红色虚线下的三角形面积。这被称为随机分类器,因为其预测效果与随机抛硬币一样好。

总之,机器学习模型的表现介于随机分类器和完美分类器之间,这表明期望的 AUC 在 0.5(随机状态)和 1(完美状态)之间。

本质上,数据科学家旨在最大化 AUC,即曲线下面积更大。这表示模型在生成正确预测方面的好坏,即力求最高的 TPR,同时保持最低的 FPR。

何时使用准确率?

准确率用于平衡的数据集,即类别分布均等时。

现实生活中的一个例子是欺诈检测,它必须正确识别并区分欺诈交易(关注类别)与常规交易。通常,欺诈交易很少,即它们在训练数据集中出现的频率低于~1%。

在这种情况下,准确率会偏袒模型的表现,即使模型将每笔交易都识别为非欺诈性交易,也会宣称模型良好。这样的模型虽然准确率高,但未能预测任何欺诈交易,违背了构建模型的目的。

何时使用 AUC?

AUC 非常适合处理不平衡的数据集。例如,欺诈检测模型必须正确识别欺诈,即使这意味着将一些(少量的)非欺诈交易标记为欺诈。

在专注于正确识别目标类别(欺诈交易)即 TP 时,模型很可能会犯一些错误,即 FP(将非欺诈交易标记为欺诈)。因此,查看一个比较 TPR 和 FPR 的度量是重要的,这就是 AUC 的作用。

你应该选择哪个指标以及何时选择?

准确率和 AUC 都用于分类模型。然而,在决定使用哪一个时,有一些事项需要注意。

高准确率的模型表明预测错误很少。然而,这并没有考虑这些错误预测的商业成本。在这些业务问题中使用准确率度量忽略了诸如 TP 和 FP 的细节,并给模型预测带来了夸大的信心,这对业务目标有害。

在这种情况下,AUC 是首选指标,因为它在最佳选择的阈值下校准了敏感性和特异性之间的权衡。

此外,准确率衡量单个模型的表现,而 AUC 则比较两个模型,并评估同一模型在不同阈值下的表现。

总结

选择适当的指标对于获得期望的结果至关重要。准确率和 AUC 是两个常用的评估指标,用于客观地衡量模型性能。它们都有助于评估模型的表现,并将一个模型与另一个模型进行比较。文章解释了为什么准确率对平衡数据来说是足够的,但 AUC 适合衡量模型在不平衡数据集上的表现。

Vidhi Chugh是一位获奖的 AI/ML 创新领袖和 AI 伦理学家。她在数据科学、产品和研究的交叉点上工作,以提供商业价值和见解。她提倡以数据为中心的科学,并在数据治理领域是一位领先专家,致力于构建值得信赖的 AI 解决方案。

更多相关话题

评估深度学习对象检测器的指标

原文:

www.kdnuggets.com/2020/08/metrics-evaluate-deep-learning-object-detectors.html

评论

由 Venkatesh Wadawadagi, Sahaj Software Solutions

已经采用了不同的方法来解决对准确对象检测模型日益增长的需求。最近,随着卷积神经网络(CNN)和 GPU 加速深度学习框架的普及,对象检测算法开始从新的角度进行开发。R-CNN、Fast R-CNN、Faster R-CNN、R-FCN、SSD 和 Yolo 等 CNN 显著提高了该领域的性能标准。

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 需求

一旦你训练了第一个对象检测器,下一步就是了解其性能。确实,你可以看到模型找到了你提供的图片中的所有对象。很好!但你如何量化这一点?我们应该如何决定哪个模型更好?

由于分类任务仅评估对象在图像中出现的概率,对于分类器来说,从正确预测和错误预测中识别正确预测是一个直接的任务。然而,对象检测任务进一步通过与相应置信度得分关联的边界框来定位对象,以报告对象类别的边界框被检测到的确定程度。

检测器的结果通常由边界框列表、置信度水平和类别组成,如下图所示:

对象检测指标作为评估模型在对象检测任务中表现的衡量标准。它还使我们能够客观地比较多个检测系统或将它们与基准进行比较。在大多数竞赛中,平均精度(AP)及其衍生指标是用于评估检测结果并排名的指标。

理解各种指标:

IoU:

所有先进指标中的指导原则是所谓的交并比(IoU)重叠度量。它字面上定义为检测边界框与真实边界框的交集与并集的比值。

将预测边界框和真实标签之间的重叠面积除以它们的联合面积,得到交并比。

交并比(IoU)分数 > 0.5 通常被认为是“好”的预测。

IoU 指标确定了正确检测到的物体数量以及产生的假阳性数量(将稍后讨论)。

真正例 [TP]

检测数(IoU>0.5)

假阳性 [FP]

检测数(IoU<=0.5)或检测到多次

假阴性 [FN]

未检测到或检测到的物体数(IoU<=0.5)

精确度

精确度衡量你的预测准确性,即预测正确的百分比。

精确度 = 真正例 / (真正例 + 假阳性)

召回率

召回率衡量你找到所有正例的能力。

召回率 = 真正例 / (真正例 + 假阴性)

F1 分数

F1 分数是精确度和召回率的调和均值(HM)。

AP

平均精确度(AP)的通用定义是找到精确度-召回曲线下的面积。

mAP

物体检测的 mAP 是计算所有类的 AP 的平均值。mAP@0.5 表示在 IOU 阈值 0.5 处计算的 mAP。

mAP 与其他指标

mAP 是衡量神经网络灵敏度的良好指标。因此,较高的 mAP 表明模型在不同置信度阈值下的稳定性和一致性。精确度、召回率和 F1 分数是在给定置信度阈值下计算的。

如果“模型 A”的精确度、召回率和 F1 分数优于“模型 B”,但“模型 B”的 mAP 优于“模型 A”,这种情况表明“模型 B”在较高置信度阈值下的召回率很差,或在较低置信度阈值下的精确度很差。因此,“模型 A”在该置信度阈值下的较高精确度、召回率和 F1 分数表明,它在所有三个指标方面都优于“模型 B”。

哪个指标更重要?

通常为了分析表现更好的模型,建议使用验证集(用于调整超参数的数据集)和测试集(用于评估完全训练好的模型性能的数据集)。

在验证集上

-

使用 mAP 从所有训练权重中选择表现最好的模型(更稳定且一致的模型)。使用 mAP 来了解模型是否需要进一步训练/调整。

-

检查类级 AP 值以确保模型在各类中的稳定性和优良性。

-

根据用例/应用,如果你对假阴性完全宽容而对假阳性高度不容忍,则应使用精确度来训练/调整模型。

-

根据使用案例/应用,如果你对假阳性完全容忍且对假阴性高度不容忍,那么相应地训练/调整模型时使用召回率。

在测试集上

-

如果你对假阳性(FPs)和假阴性(FNs)都持中立态度,那么使用 F1 分数来评估表现最佳的模型。

-

如果你不接受假阳性(FPs),而对假阴性(FNs)不太关心,那么选择具有更高精准度的模型。

-

如果你不接受假阴性(FNs),而对假阳性(FPs)不太关心,那么选择具有更高召回率的模型。

-

一旦决定了要使用的指标,尝试对给定模型使用多个置信度阈值(例如 0.25、0.35 和 0.5),以了解哪个置信度阈值下所选指标对你更有利,并且了解可接受的权衡范围(例如,你希望精准度至少为 80% 并有一定的召回率)。一旦决定了置信度阈值,就可以在不同模型中使用它,以找出表现最佳的模型。

参考文献

个人简介:Venkatesh Wadawadagi 是 Sahaj Software Solutions 的解决方案顾问。他帮助企业使用 AI 驱动的解决方案解决复杂问题。他专注于深度学习、计算机视觉、机器学习、自然语言处理(NLP)、嵌入式 AI、商业智能和数据分析。

相关:

-

机器学习中的模型评估指标

-

零售中的图像识别和目标检测

-

你应该知道的更多分类问题性能评估指标

相关主题

数据科学备忘单

原文:

www.kdnuggets.com/2018/09/meverick-lin-data-science-cheat-sheet.html

评论

评论

目前有很多备忘单,质量参差不齐,涵盖了各种不同的话题,这些话题都被视为“数据科学”范畴。一些非常好,一些还不错,但许多并不值得你的时间。偶尔可以发现一些宝石,涵盖了某些特定领域,并达到一定的理解水平。

这就是最近由 Maverick Lin 发布的 "数据科学备忘单" 的用武之地。这是一个相对广泛的初级理解深度的工作,但它做得非常好。这份 9 页的资料简明扼要地涵盖了数据科学的诸多方面:

-

统计与概率

-

数据准备

-

特征工程

-

建模

-

机器学习

-

深度学习

-

SQL

-

…还有更多

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织在 IT 方面

3. Google IT 支持专业证书 - 支持您的组织在 IT 方面

值得强调的是,这对数据科学的资深专家可能没有立即的价值,但鼓励初学者查看一下,也适合那些准备面试或只是寻找轻松复习材料的人。

您可以访问 Github 仓库 获取更多信息,或从这个 直接下载链接 下载备忘单。

感谢 Maverick Lin 制作这个备忘单,它是一个不断发展的进行中的工作。

相关:

-

Docker 备忘单

-

数据可视化备忘单

-

SQL 备忘单

更多相关话题

F1 分数的微观、宏观和加权平均值,清晰解释

原文:

www.kdnuggets.com/2023/01/micro-macro-weighted-averages-f1-score-clearly-explained.html

作者图片和Freepik

F1 分数(也称 F 度量)是评估分类模型性能的常用指标。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

在多类别分类的情况下,我们采用平均方法来计算 F1 分数,从而在分类报告中得到一组不同的平均分数(宏观、加权、微观)。

本文讨论了这些平均值的含义,如何计算它们,以及选择哪个来进行报告。

(1)基础知识回顾(可选)

注意:如果你已经对精确率、召回率和 F1 分数的概念很熟悉,可以跳过这一部分。

精确率

通俗定义: 在我做出的所有正例预测中,有多少是真正的正例?

计算: 真正例数(TP)除以真正例数(TP)和假阳性(FP)的总数。

精确率的公式 | 作者图片

召回率

通俗定义: 在所有实际的正例中,我正确预测为正例的有多少?

计算: 真正例数(TP)除以真正例数(TP)和假阴性(FN)的总数。

召回率的公式 | 作者图片

如果你比较精确率和召回率的公式,你会发现它们看起来很相似。唯一的不同是分母的第二项,对于精确率是假阳性,对于召回率是假阴性。

F1 分数

为了全面评估模型性能,我们应该检查精确率和召回率。F1 分数作为一个有用的指标,考虑了这两者。

定义:精确率和召回率的调和均值,用于更平衡地总结模型性能。

计算:

F1 分数的方程 | 图片由作者提供

如果我们用真正例(TP)、假正例(FP)和假负例(FN)来表示,我们会得到这个方程:

F1 分数的另一种方程 | 图片由作者提供

(2) 设置动机示例

为了说明 F1 分数的平均概念,我们将在本教程中使用以下示例。

想象一下,我们已经在一个包含三类图像的多类数据集上训练了一个图像分类模型:飞机、船和汽车。

图片由 macrovector 提供 — freepik.com

我们使用这个模型来预测****十个测试集图像的类别。以下是原始预测:

我们的演示分类器的样本预测 | 图片由作者提供

运行sklearn.metrics.classification_report后,我们得到以下分类报告:

分类报告来自 scikit-learn 包 | 图片由作者提供

讨论的重点是带有每类分数(即每个类别的分数)和平均分数的列(橙色)。

从上面可以看出,数据集是不平衡的(十个测试集实例中只有一个是“船”)。因此,正确匹配的比例(即准确率)在评估模型性能时将无效。

相反,让我们查看混淆矩阵以全面理解模型预测。

混淆矩阵 | 图片由作者提供

上面的混淆矩阵使我们能够计算真正例(TP)、假正例(FP)和假负例(FN)的关键值,如下所示。

从混淆矩阵中计算的 TP、FP 和 FN 值 | 图片由作者提供

上表为我们计算每个三类中的每类的精确度、召回率和 F1 分数奠定了基础。

重要的是要记住,在多类分类中,我们计算每个类别的 F1 分数,采用一对其余(OvR)的方法,而不是像二分类那样计算一个整体的 F1 分数。

在这种OvR方法中,我们分别为每个类别确定指标,就好像每个类别都有一个不同的分类器。以下是每个类别的指标(显示了 F1 分数的计算):

然而,与其有多个每类 F1 分数,不如平均它们以获得一个单一数字来描述总体性能。

现在,让我们讨论平均方法,这些方法导致了分类报告中的三种不同的平均 F1 分数。

(3) 宏观平均

宏观平均可能是所有平均方法中最简单的。

宏观平均 F1 分数(或宏观 F1 分数)是通过所有每个类别 F1 分数的算术平均(即未加权平均)计算得出的。

此方法对所有类别一视同仁,无论其支持度值如何。

宏观 F1 分数计算 | 图片来源于作者

我们计算得到的0.58与我们的分类报告中的宏观平均 F1 分数相匹配。

(4) 加权平均

加权平均 F1 分数是通过计算所有类别的 F1 分数的平均值来得到的,同时考虑每个类别的支持度。

支持度指的是数据集中该类别的实际出现次数。例如,船的支持度值为 1 意味着只有一个实际标签为船的观察。

“权重”本质上是指每个类别的支持度相对于所有支持度值总和的比例。

加权 F1 分数计算 | 图片来源于作者

使用加权平均,输出的平均值将考虑到每个类别按该类别示例数加权的贡献。

计算得到的0.64与我们分类报告中的加权平均 F1 分数一致。

(5) 微观平均

微观平均通过计算真实正例(TP)、假阴性(FN)和假正例(FP)的总和来计算全局平均F1 分数。

我们首先将所有类别的 TP、FP 和 FN 值相加,然后将这些值代入 F1 方程,得到我们的微观 F1 分数。

微观 F1 分数计算 | 图片来源于作者

在分类报告中,你可能会想知道为什么我们的微观 F1 分数0.60显示为“准确率”,以及为什么没有‘微观平均’的行。

这是因为微观平均本质上计算的是正确分类观察结果在所有观察结果中的比例。如果我们考虑这一点,这一定义就是我们用来计算整体准确率的标准。

此外,如果我们对精确率和召回率进行微观平均,我们将得到相同的0.60值。

所有微观平均指标的计算 | 作者提供的图像

这些结果意味着,在每个观察结果只有单一标签的多类别分类情况下,微观-F1、微观精确率、微观召回率和准确率共享相同的值(即,本示例中的0.60)。

这也解释了为什么分类报告只需要显示一个准确率值,因为微观-F1、微观精确率和微观召回率也有相同的值。

微观-F1 = 准确率 = 微观精确率 = 微观召回率

(6) 我应该选择哪种平均方式?

一般而言,如果你在处理一个类别不平衡的数据集,其中所有类别同样重要,使用宏观平均将是一个不错的选择,因为它对所有类别一视同仁。

这意味着,对于我们涉及飞机、船只和汽车分类的示例,我们将使用宏观-F1 分数。

如果你有一个不平衡的数据集,但希望对数据集中样本更多的类别赋予更大的贡献,那么加权平均是首选。

这是因为,在加权平均中,每个类别对 F1 平均值的贡献是根据其大小加权的。

假设你有一个平衡的数据集,并且希望得到一个易于理解的整体性能指标,不论类别如何,那么你可以选择准确率,这本质上是我们的微观F1 分数。

在你离开之前

我欢迎你加入我的数据科学学习之旅! 关注我的Medium页面,并查看我的GitHub以获取更多令人兴奋的数据科学内容。同时,祝你在解释 F1 分数时玩得愉快!

Kenneth Leung 是波士顿咨询集团(BCG)的数据科学家、技术作者和药剂师。

原文。经允许转载。

更多相关内容

如何在 SQL Server 中执行 R 和 Python 使用机器学习服务

原文:

www.kdnuggets.com/2018/06/microsoft-azure-machine-learning-r-python-sql-server.html

评论

评论

作者 Kyle Weller,Microsoft Azure 机器学习

你知道吗?你可以在 T-SQL 语句中编写 R 和 Python 代码。 机器学习服务 在 SQL Server 中消除了数据移动的需求。你无需通过网络传输大量和敏感的数据,或通过示例 csv 文件丢失准确性,你可以让 R/Python 代码在你的数据库中执行。轻松通过 SQL 存储过程部署你的 R/Python 代码,使其在你的 ETL 过程中或任何应用程序中可用。在数据库中训练和存储机器学习模型,将智能带到数据所在的位置。

你可以安装并运行任何最新的开源 R/Python 包,以在 SQL Server 上处理大量数据构建深度学习和 AI 应用程序。我们还提供了 Microsoft 的 前沿 高性能算法,包含在 RevoScaleR 和 RevoScalePy APIs 中。使用这些与开源世界中的最新创新结合,能够为你的应用程序带来无与伦比的选择、性能和规模。

如果你对尝试 SQL Server 机器学习服务感到兴奋,请查看下面的动手教程。如果你没有在 SQL Server 中安装机器学习服务,你首先需要按照我在这里发布的入门教程进行操作:

使用教程

在本教程中,我将介绍如何在 T-SQL 语句中执行 R 和 Python 的基础知识。如果你更喜欢通过视频学习,我也在 YouTube 上发布了教程:

基础知识

打开 SQL Server Management Studio 并连接到你的服务器。打开一个新的查询窗口并粘贴以下基本示例:(虽然我在这些示例中使用的是 Python,但你也可以用 R 完成所有操作)

EXEC sp_execute_external_script @language = N'Python', @script = N'print(3+4)'

sp_execute_external_script 是一个特殊的系统存储过程,它使 R 和 Python 在 SQL Server 中的执行成为可能。这里有一个“language”参数,允许我们在 Python 和 R 之间进行选择。还有一个“script”参数,我们可以在其中粘贴 R 或 Python 代码。如果你没有看到输出打印 7,请返回并查看 这篇文章 中的设置步骤。

参数介绍

现在我们讨论了一个基本示例,让我们开始添加更多内容:

EXEC sp_execute_external_script @language = N'Python', @script = N' OutputDataSet = InputDataSet; ', @input_data_1 = N'SELECT 1 AS Col1';

机器学习服务提供了 SQL 和 R/Python 之间更自然的通信,通过一个接受任何 SQL 查询的输入数据参数。输入参数名为“input_data_1”。

你可以在 Python 代码中看到,定义了一些默认变量来在 Python 和 SQL 之间传递数据。默认变量名是“OutputDataSet”和“InputDataSet”。你可以像下面这个示例一样更改这些默认名称:

EXEC sp_execute_external_script @language = N'Python', @script = N' MyOutput = MyInput; ', @input_data_1_name = N'MyInput', @input_data_1 = N'SELECT 1 AS foo', @output_data_1_name = N'MyOutput';

当你执行这些示例时,你可能会注意到它们每个都返回一个带有“(No column name)”的结果?你可以通过在语句末尾添加 WITH RESULT SETS 子句来指定返回列的名称,该子句是列名和其数据类型的逗号分隔列表。

EXEC sp_execute_external_script @language = N'Python', @script = N' MyOutput = MyInput; ', @input_data_1_name = N'MyInput', @input_data_1 = N' SELECT 1 AS foo, 2 AS bar ', @output_data_1_name = N'MyOutput' WITH RESULT SETS ((MyColName int, MyColName2 int));

输入/输出数据类型

好的,我们来多讨论一下 SQL 和 Python 之间使用的输入/输出数据类型。你的输入 SQL SELECT 语句通过 Python Pandas 包 将一个“Dataframe”传递给 Python。你从 Python 返回 SQL 的输出也需要是 Pandas Dataframe 对象。如果你需要将标量值转换为数据框,这里有一个示例: