KDNuggets-博客中文翻译-二十四-

KDNuggets 博客中文翻译(二十四)

原文:KDNuggets

机器学习与网络安全资源

原文:

www.kdnuggets.com/2017/01/machine-learning-cyber-security.html

评论

作者:Faizan Ahmad,Fsecurify

机器学习与网络安全的数据:

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

机器学习在网络安全中的一个重要数据来源是 SecRepo。这个网站包含了各种你可以使用的数据。我没有找到比这个网站更好的网络安全数据来源。

论文:

让我们看看一些很好的论文,这些论文展示了机器学习在网络安全中的应用。

-

快速、精简且准确:使用神经网络建模密码猜测能力。 这是篇很棒的论文,作者使用神经网络破解密码。我已经阅读了这篇论文,真的很棒。

-

超越封闭世界:使用机器学习进行网络入侵检测。这篇论文讨论了使用机器学习进行网络入侵检测。这是另一篇很好的论文。

-

基于异常载荷的网络入侵检测。另一篇被大量引用的论文。

-

基于元数据和结构特征的恶意 PDF 检测。数据科学在网络安全中的独特应用。

-

利用机器学习破坏你的垃圾邮件过滤器。另一本值得阅读的好书。

以下论文来自于 covert.io。你可以查看他们的网站,那里有大量的论文,但数量太多,并且并非所有的论文都很易读和新颖。

书籍:

关于数据科学和机器学习在网络安全中的应用,市面上并没有很多书籍,但我找到了一些看起来相当有前途的书。我将在即将到来的假期中阅读这些书籍。

演讲:

关于这一主题有一些精彩的演讲。我也收集了它们。

-

5 分钟内构建一个杀毒软件 – 新鲜的机器学习 #7。一个有趣的视频。

这些是我找到的不错的内容。我还没全部观看,但它们似乎都很不错。如果你找到更多的讲座,请在评论中告诉我。

教程:

我找到了一些与这个话题相关的很棒的教程。

-

点击安全数据黑客项目。该项目包含许多带有笔记本和代码的教程。这是每个对 ML 在信息安全中应用感兴趣的人必读的内容。

-

大数据和数据科学用于安全与欺诈检测。 很不错的一篇。

-

使用深度学习破解验证码系统。 值得一读。

课程:

关于这个话题也有一些课程。不过这里是我找到的几个。

- 斯坦福大学的网络安全数据挖掘。 这是使用数据进行网络安全的最佳课程之一。讲师在幻灯片中提供了很多应用和技术。课程页面上还有很多学生使用机器学习进行安全的项目。

杂项:

-

系统通过人类专家的输入预测 85%的网络攻击。 必读文章。

-

在mlsecproject上发布了一份使用机器学习的网络安全开源项目列表。

就这些了。这些是我能找到的一些与此主题相关的非常好的资源。如果你知道其他资源,请在下方评论,我会添加进去。

简介: Faizan Ahmad 是一名富布赖特本科生,目前在 NUCES FAST 学习,同时担任巴基斯坦拉合尔管理科学大学的研究助理。

相关:

-

使用机器学习检测恶意网址

-

数据科学家如何缓解敏感数据暴露的脆弱性?

-

大数据安全的 5 个最佳实践

更多相关话题

Dask 中的机器学习

评论

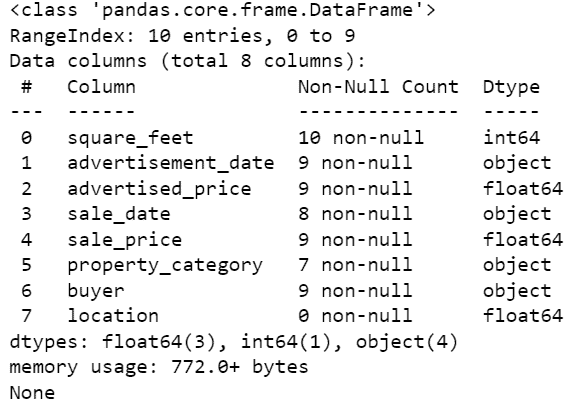

在个人电脑上处理几 GB 的数据通常是一个艰巨的任务,除非该电脑具有高 RAM 和大量计算能力。

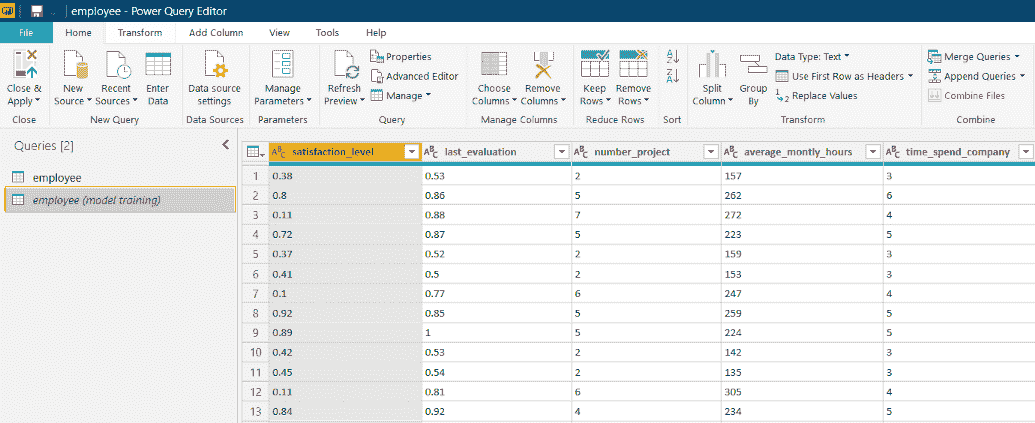

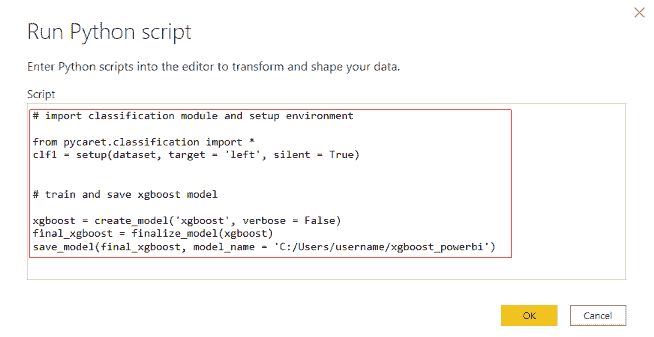

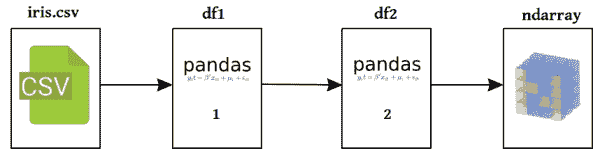

尽管如此,数据科学家仍然需要寻找替代方案来处理这个问题。一些解决方法包括调整 Pandas 以使其能够处理大型数据集,购买 GPU 机器或在云端购买计算资源。在本文中,我们将看到如何使用Dask在本地机器上处理大数据集。

我们的前三个课程推荐

1. Google Cybersecurity Certificate - 快速进入网络安全职业道路

1. Google Cybersecurity Certificate - 快速进入网络安全职业道路

2. Google Data Analytics Professional Certificate - 提升您的数据分析技能

2. Google Data Analytics Professional Certificate - 提升您的数据分析技能

3. Google IT Support Professional Certificate - 支持您的组织的 IT

3. Google IT Support Professional Certificate - 支持您的组织的 IT

Dask 和 Python

Dask 是一个用于 Python 的灵活并行计算库。它被构建为能够很好地与其他开源项目(如 NumPy、Pandas 和 scikit-learn)集成。在 Dask 中,Dask 数组 相当于 NumPy 数组,Dask DataFrames 相当于 Pandas DataFrames,而 Dask-ML 相当于 scikit-learn。

这些相似性使得将 Dask 轻松地融入您的工作流程。使用 Dask 的优势在于您可以将计算扩展到计算机上的多个核心。这使得您能够处理内存无法容纳的大型数据集。它还帮助加快通常需要很长时间的计算。

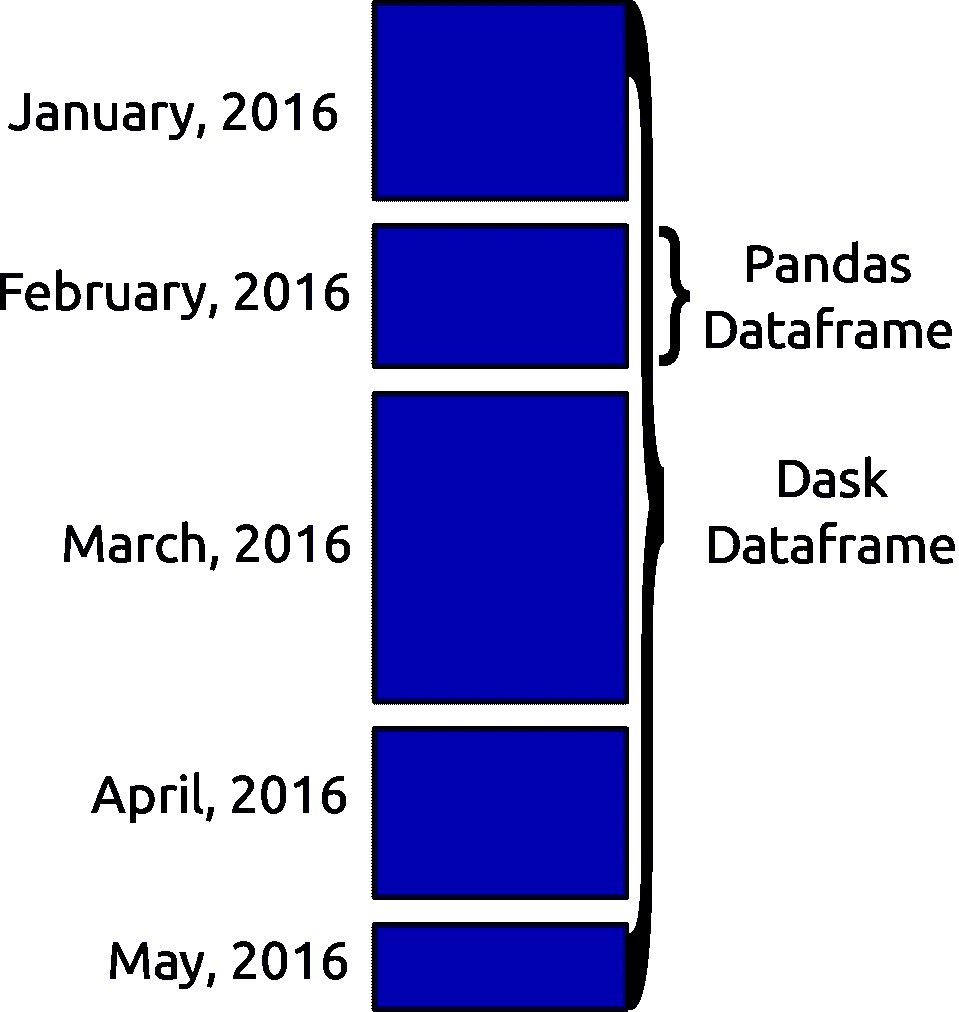

Dask DataFrames

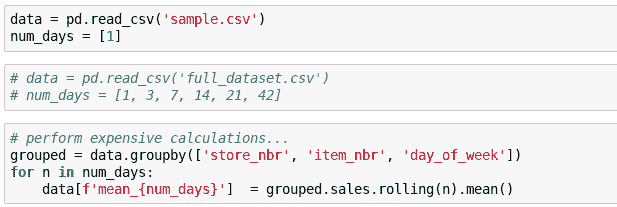

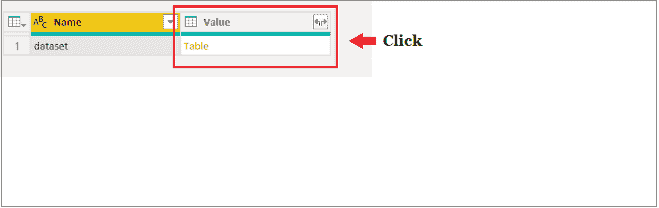

当加载大量数据时,Dask 通常会读取数据的一个样本以推断数据类型。如果某一列的数据类型不同,这通常会导致问题。为了避免类型错误,通常的好做法是事先声明数据类型。Dask 通过将数据切分成块(由 blocksize 参数定义)来加载大型文件。

data_types ={'column1': str,'column2': float}

df = dd.read_csv(“data,csv”,dtype = data_types,blocksize=64000000 )

Dask DataFrame 中的命令与 Pandas 中的命令大致相同。例如,获取 head 和 tail 是类似的:

df.head()

df.tail()

DataFrame 上的函数是懒惰执行的。这意味着它们不会被计算,直到调用 compute 函数。

df.isnull().sum().compute()

由于数据是分区加载的,一些 Pandas 函数如 sort_values() 可能会失败。解决方法是使用 nlargest() 函数。

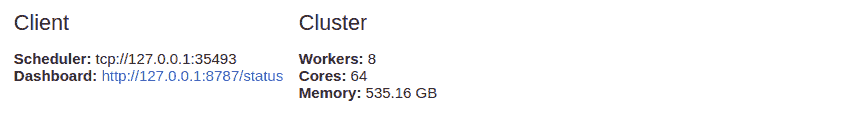

Dask 集群

并行计算是 Dask 的关键,因为它允许在多个核心上运行计算。Dask 提供了一个在单台计算机上工作的机器调度器。它不具备扩展性。它还提供了一个可以扩展到多台计算机的分布式调度器。

使用 dask.distributed 需要你设置一个 Client。如果你打算在分析中使用 dask.distributed,这应该是你首先做的事情。它提供了低延迟、数据本地性、工作节点之间的数据共享,并且易于设置。

from dask.distributed import Client

client = Client()

即使在单台机器上使用 dask.distributed 也是有利的,因为它通过仪表板提供了一些诊断功能。

如果未声明 Client,默认将使用单机调度器。它通过使用进程或线程在单台计算机上提供并行性。

Dask ML

Dask 还使你能够以并行方式进行机器学习训练和预测。dask-ml 的目标是提供可扩展的机器学习。当你在 scikit-learn 中声明 n_jobs = -1 时,你可以并行运行计算。Dask 利用这一能力来使你能够在集群中分配计算。这是通过 joblib 实现的,该包允许 Python 中的并行处理和管道化。使用 Dask ML,你可以实现 scikit-learn 模型以及其他库,如 XGboost。

这就是简单实现的样子。

首先像往常一样导入 train_test_split,用于将数据分成训练集和测试集。

from dask_ml.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

接下来,导入你想使用的模型并实例化它。

from sklearn.ensemble import RandomForestClassifier

model = RandomForestClassifier(verbose=1)

然后你需要导入 joblib 以启用并行计算。

import joblib

接下来,使用并行后端运行你的训练和预测。

from sklearn.externals.joblib import parallel_backend

with parallel_backend(‘dask’):

model.fit(X_train,y_train)

predictions = model.predict(X_test)

机器学习正迅速接近数据采集地点——边缘设备。订阅 Fritz AI 新闻通讯以了解更多关于这一过渡以及如何帮助扩展你的业务。

限制和内存使用

Dask 中的单个任务不能并行运行。工作节点是继承了 Python 计算的所有优缺点的 Python 进程。在分布式环境中工作时,还应注意确保数据安全和隐私。

Dask 有一个中央调度器,用于跟踪工作节点和集群上的数据。这个调度器还控制从集群中释放数据。一旦任务完成,它会从内存中清除数据,以释放内存供其他任务使用。如果某个 client 需要某些数据,或者它对正在进行的计算很重要,它会保留在内存中。

另一个 Dask 的限制是它没有实现 Pandas 中的所有函数。Pandas 接口很庞大,因此 Dask 并未完全实现它。这意味着在 Dask 上尝试一些操作可能会比较困难。此外,Pandas 上慢的操作在 Dask 上也同样慢。

当你不需要 Dask DataFrame 时

在以下情况下,你可能不需要 Dask:

-

当有一些 Pandas 函数尚未在 Dask 中实现时。

-

当你的数据完全适合计算机的内存时。

-

当你的数据不是表格形式时。在这种情况下,可以尝试 dask.bag 或 dask.array。

最后的思考

在这篇文章中,我们看到我们如何使用 Dask 在本地机器或以分布式方式处理巨大数据集。我们了解到,由于 Dask 的熟悉语法和扩展能力,我们可以使用 Dask。它能够扩展到数千个核心。

我们还看到我们可以在机器学习中使用它来训练和运行预测。你可以通过查看这些官方文档中的演示文稿来了解更多信息:

简历: 德里克·穆伊提 是一位数据分析师、作家和导师。他致力于在每项任务中取得卓越成果,并且是 Lapid Leaders Africa 的导师。

原文。已获许可转载。

相关:

-

为什么以及如何在大数据中使用 Dask

-

五个有趣的数据工程项目

-

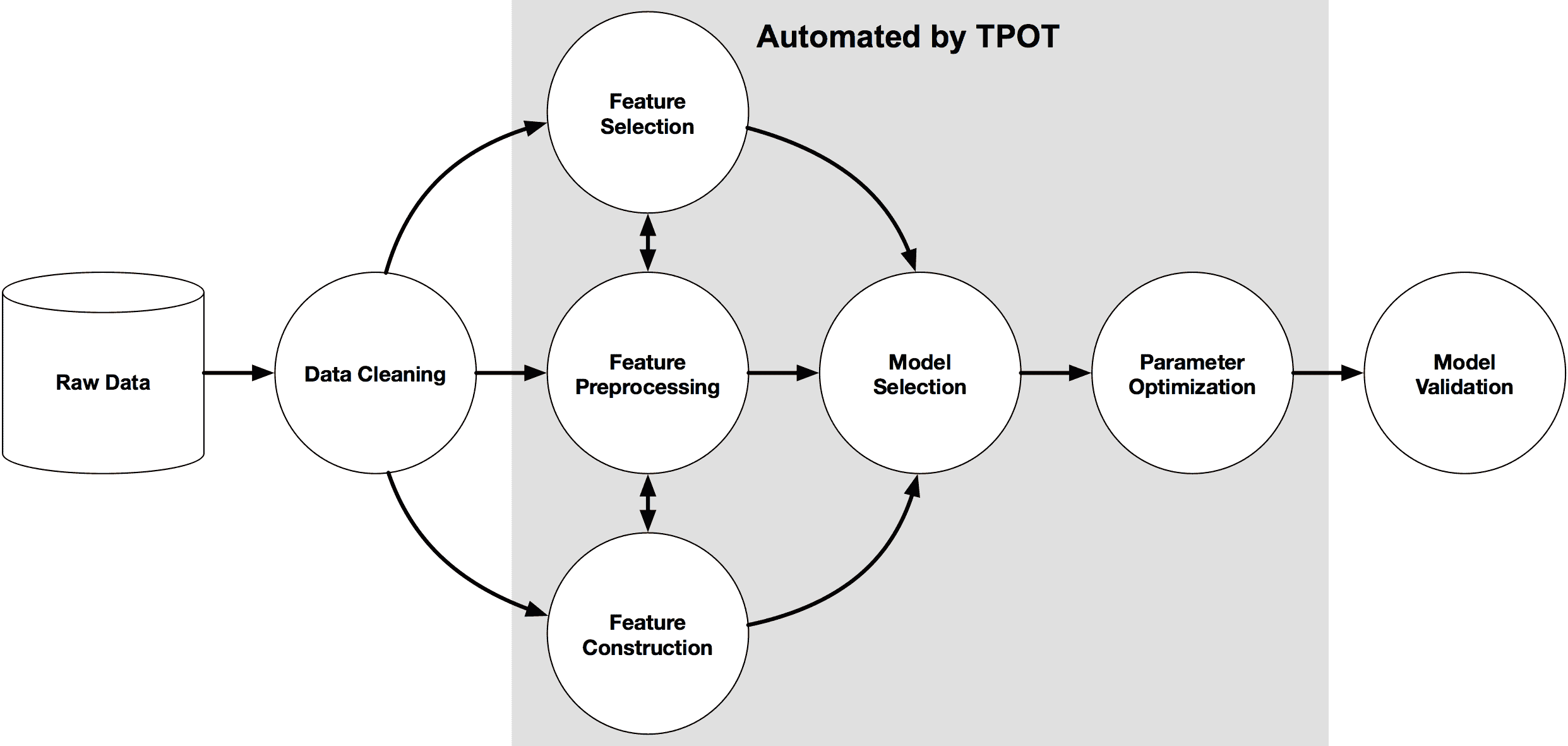

Python 中的自动化机器学习

相关阅读

50 个有用的机器学习与预测 API

原文:

www.kdnuggets.com/2015/12/machine-learning-data-science-apis.html/2

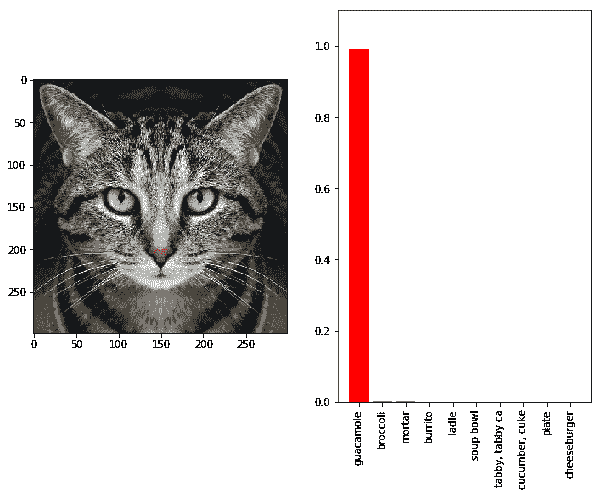

面部和图像识别

-

Animetrics Face Recognition:这个 API 可以用于检测照片中的人脸,并与一组已知面孔进行匹配。该 API 还可以将主题添加或移除到可搜索的画廊中,并将面孔添加或移除到主题中。

-

Betaface:一个面部识别和检测的网络服务。功能包括多面孔检测、面孔裁剪、123 个面部点检测(22 个基础点,101 个高级点)、面孔验证、识别、在非常大的数据库中进行相似性搜索等。

-

Eyedea Recognition:一个识别服务,提供眼睛面孔、车辆、版权和车牌检测。该 API 的主要价值在于可以即时了解对象、用户和行为。

-

Face++:一个提供检测、识别和分析的面部识别和检测服务,供应用程序使用。用户可以调用程序进行训练、检测面孔、识别面孔、分组面孔、操控人员、创建面孔集合、创建组和获取信息。

-

FaceMark:FaceMark 是一个能够在正面面孔照片上检测 68 个点,在侧面面孔照片上检测 35 个点的 API。

-

Google Cloud Vision API:帮助你快速大规模地找到你喜欢的图片,并获得丰富的注释。它将图像分类到数千个类别(例如,“船”,“狮子”,“埃菲尔铁塔”),检测带有相关情感的面孔,并识别多种语言中的打印文字。

-

Microsoft Project Oxford Vision:允许开发者访问和集成 Microsoft Project Oxford 的视觉功能。一些示例 API 方法包括处理图像、检测图像和返回缩略图。

-

Rekognition:提供优化用于社交照片应用的面部和场景图像识别。利用眼睛、嘴巴、面部和鼻子以及情绪识别和性别相关特征,Rekognition API 可以预测性别、年龄和情绪。

-

FaceRect:一个能够在图像中检测面孔的 API。该 API 可以在给定的图像中检测多个面孔,包括正面和侧面面孔,并搜索每个检测到的面孔中的面部特征(眼睛、鼻子、嘴巴)。

-

Kairos: 一个面部识别 API,允许用户将先进的安全功能集成到他们的应用程序和服务中。

-

Skybiometry Face Detection and Recognition: 提供面部检测和识别服务,可作为 discontinued face.com API 的替代品。

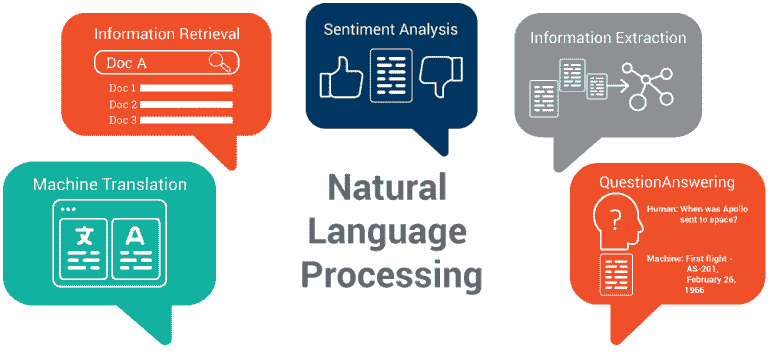

文本分析、自然语言处理、情感分析

-

AlchemyAPI: AlchemyAPI 提供人工智能作为服务。目前可用的文本分析功能包括实体提取、情感分析、关键词提取、概念标记、关系提取、文本分类、作者提取、语言检测、文本提取、微格式解析和 RSS/ATOM 订阅源检测。

-

AlchemyAPI Keyword Extraction: 从文本、HTML 或发布的网页内容中提取主题关键词。此 API 会对目标文本进行规范化,去除广告、导航链接和其他不必要的内容,然后提取主题关键词。

-

Bitext Sentiment Analysis: 一套多语言语义服务。目前提供四种语义服务:实体和概念提取、情感分析和文本分类。

-

Calais: 使用自然语言处理、机器学习和其他方法,Calais 将文档中的实体(人、地点、组织等)、事实(某人“x”在公司“y”工作)和事件(某人“z”在日期“x”被任命为公司“y”的主席)进行分类和链接。

-

Semantic Biomedical Tagger: 具有内置能力识别 133 种生物医学实体类型,并将它们语义链接到知识库系统中。

-

Free Natural Language Processing Service: 情感分析、内容提取和语言检测。

-

nlpTools: 解码在线新闻来源进行情感分析和文本分类。为了分析一行文本的情感或分类,开发者可以使用此 API 来返回一个类别标签以及该文本的情感条件,范围从积极、中性到消极。

-

Diffbot Analyze: 提供开发者工具,可以识别、分析并提取任何网页的主要内容和部分。

-

Skyttle: Market Sentinel 的文本挖掘引擎,分析文本中的主题关键词和短语级情感。支持的语言包括英语、法语、德语、俄语。

-

Speech2Topics:分析音频和视频,以外推大数据,使用自然语言处理和语音识别。

-

TweetSentiments:使用支持向量机算法对推文进行语义分析,从而确定推文是积极的、消极的还是中性的。

-

Text Processing: 提供包括总结文档、标记文档、词干化、去除停用词、标记词性(POS)、从印尼语翻译成英语和检索词汇定义等功能。

-

MeaningCloud 文本分类:文本分类 API 执行预分类任务,如:提取文本、分词、去除停用词和词形还原。使用基于规则的过滤和统计文档分类,该 API 可以在广泛的环境中进行准确的分类。

翻译

-

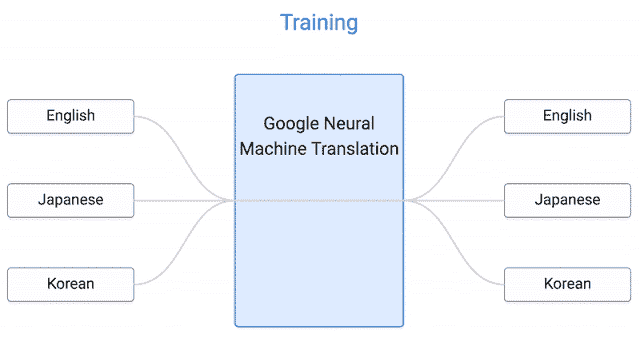

Google Translate:目前为第二版,Google Translate 为自动机器翻译领域的研究人员提供工具,以帮助比较、对比,并在 Google 的统计机器翻译系统基础上进行构建。

-

LangId:快速检索有关任何语言的信息,而无需指定语言。

-

MotaWord:提供 70 多种语言的翻译。该 API 还允许开发者获取每个翻译的报价,提交翻译项目及文档和风格指南,跟踪翻译项目的进度,并实时获取活动动态。

-

WritePath 翻译:API 允许开发者访问并将 WritePath 的功能与其他应用程序集成。一些示例 API 方法包括检索字数、提交翻译文档以及获取翻译后的文档和文本。

-

IBM Watson 语言翻译:使用统计机器翻译技术提供特定领域的翻译。他们目前提供三个领域(对话、专利和新闻),可以在总共七种语言之间进行翻译。

参考资料:Mashape 博客 & Programmable Web

我们是否遗漏了您最喜欢的 API?我们将继续更新列表!在评论中告诉我们您的想法。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速开启网络安全职业生涯

1. Google 网络安全证书 - 快速开启网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

相关:

-

5 个最佳机器学习 API 用于数据科学

-

预测和机器学习的 API:投票结果和分析

-

预测分析培训资源热榜

相关内容

免费高质量机器学习与数据科学书籍与课程:隔离版

原文:

www.kdnuggets.com/2020/04/machine-learning-data-science-books-courses-quarantine.html

评论

你现在有机会待在家里吗?由于 COVID-19,许多人被限制在家中隔离、居家避难或类似的情况。如果你发现自己处于这种情况,并且正在寻找免费的学习材料,比如书籍和课程,以便充分利用并提升你的数据科学和机器学习技能,这些我之前编写的文章将对你有帮助。总的来说,你会找到链接到这些材料的小型合集,总计超过 100 本高质量的书籍和课程。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

我们也借此机会向那些当前无法享受这种奢侈的关键工作者致敬。KDnuggets 想向所有在这次疫情期间奋战在一线的工作者表示感谢:医生、护士、医学研究人员、邮递员、警察、消防员、急救人员、药店工作人员、超市店员、餐饮服务提供者、卡车司机、供应链上的每一个人,以及所有提供关键服务以保护脆弱群体、前线医疗工作者,并让我们其他人能够在家工作的人。谢谢你们!

10 本机器学习和数据科学必读书籍

10 本更多免费的必读书籍,涵盖机器学习和数据科学

另外 10 本免费的必读书籍,涵盖机器学习和数据科学

10 本免费的必看机器学习和数据科学课程

10 本更多的必看免费课程,涵盖机器学习和数据科学

另有 10 本免费的必看课程,涵盖机器学习和数据科学

10 本免费的顶级机器学习课程

10 个免费顶级自然语言处理课程

免费数学课程用于数据科学与机器学习

相关:

-

2020 年每个数据科学家必读的 50 本免费书籍

-

理解机器学习的 24 本最佳(免费)书籍

-

数据科学家的最佳免费流行病学课程

更多相关内容

7 个做机器学习时常见的错误

原文:

www.kdnuggets.com/2015/03/machine-learning-data-science-common-mistakes.html

作者:程涛(@chengtao_chu)。

统计建模很像工程学。

在工程学中,有多种方法可以构建键值存储,每种设计对使用模式做出不同的假设。在统计建模中,有各种算法可以构建分类器,每种算法对数据做出不同的假设。

在工程学中,有多种方法可以构建键值存储,每种设计对使用模式做出不同的假设。在统计建模中,有各种算法可以构建分类器,每种算法对数据做出不同的假设。

当处理少量数据时,尝试尽可能多的算法并选择最佳算法是合理的,因为实验成本较低。但当面对“大数据”时,提前分析数据并据此设计建模流程(预处理、建模、优化算法、评估、生产化)是值得的。

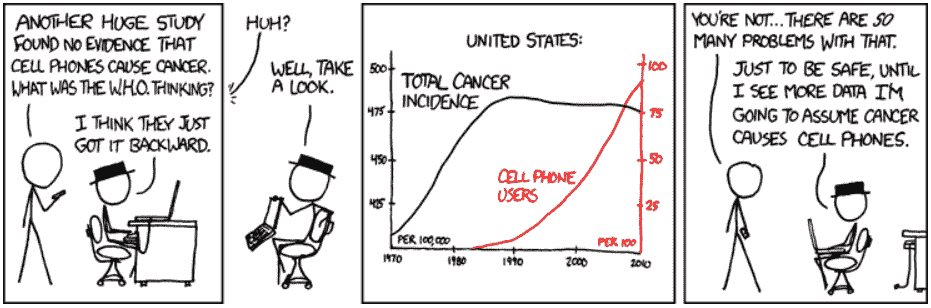

正如我在之前的帖子中指出的,有许多方法可以解决给定的建模问题。每种模型假设的情况不同,如何判断这些假设是否合理并不明显。在行业中,大多数从业者选择他们最熟悉的建模算法,而不是选择最适合数据的算法。在这篇文章中,我想分享一些常见的错误(即“不要做”的事)。一些最佳实践(即“要做”的事)我会在未来的文章中分享。

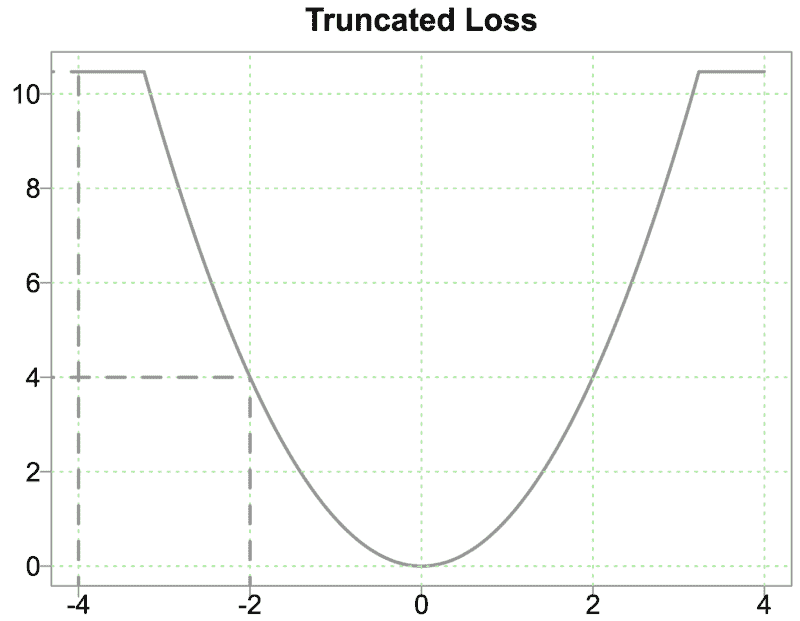

1. 以为默认损失函数是正确的

许多从业者使用默认的损失函数(例如,平方误差)训练并选择最佳模型。实际上,现成的损失函数很少与业务目标一致。以欺诈检测为例。当尝试检测欺诈交易时,业务目标是最小化欺诈损失。现成的二分类器损失函数对假阳性和假阴性给予相同的权重。为了与业务目标对齐,损失函数不仅应对假阴性施加比假阳性更大的惩罚,还应根据金额对每个假阴性施加惩罚。此外,欺诈检测中的数据集通常包含高度不平衡的标签。在这些情况下,应通过上采样/下采样来倾斜损失函数,偏向于稀有情况。

2. 对非线性交互使用简单线性模型

在构建二元分类器时,许多从业者会立刻选择逻辑回归,因为它简单。然而,许多人也会忘记逻辑回归是线性模型,并且预测变量之间的非线性交互需要手动编码。回到欺诈检测,高阶交互特征如“账单地址 = 送货地址且交易金额 < $50”对模型性能至关重要。因此,应优先选择像带有核的 SVM 或树基分类器等非线性模型,它们可以内置高阶交互特征。

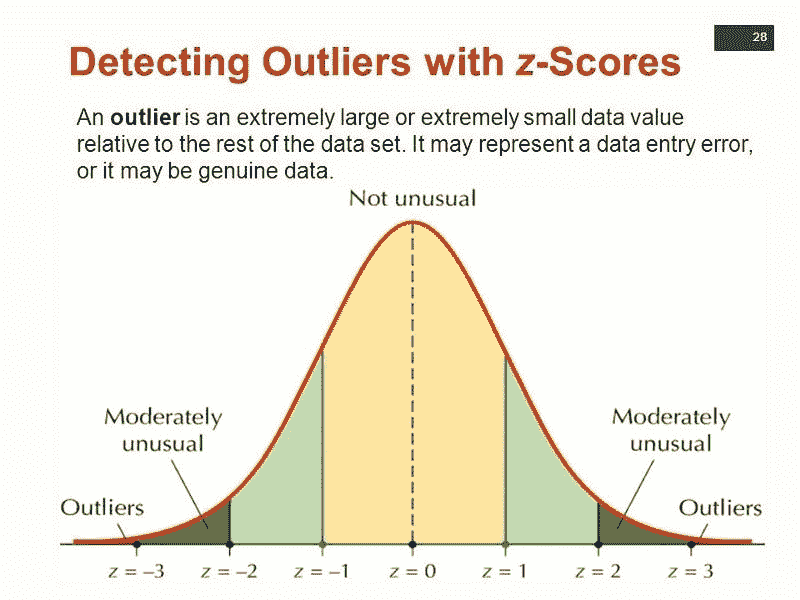

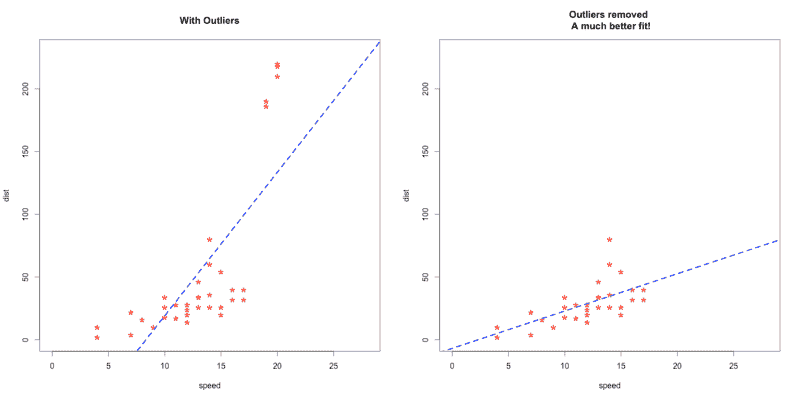

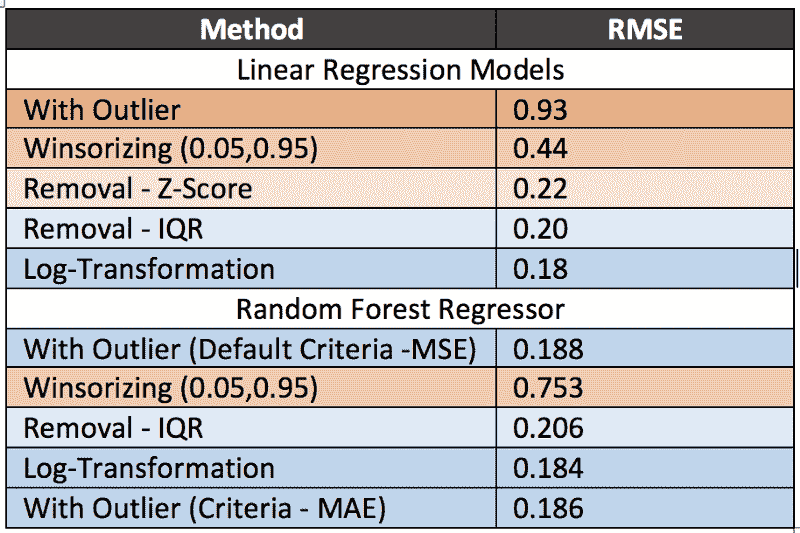

3. 忘记异常值

异常值很有趣。根据上下文,它们可能值得特别关注,或者应该完全忽略。例如,在收入预测中,如果观察到收入的异常峰值,可能应该额外关注一下,找出峰值的原因。但如果异常值是由于机械故障、测量误差或其他无法普遍化的原因造成的,那么在将数据输入建模算法之前,最好过滤掉这些异常值。

一些模型对异常值比其他模型更敏感。例如,AdaBoost 可能会将这些异常值视为“困难”案例,并对异常值施加巨大权重,而决策树可能只是将每个异常值计为一个错误分类。如果数据集中包含大量异常值,那么要么使用对异常值具有鲁棒性的建模算法,要么在建模之前过滤掉异常值。

一些模型对异常值比其他模型更敏感。例如,AdaBoost 可能会将这些异常值视为“困难”案例,并对异常值施加巨大权重,而决策树可能只是将每个异常值计为一个错误分类。如果数据集中包含大量异常值,那么要么使用对异常值具有鲁棒性的建模算法,要么在建模之前过滤掉异常值。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业

1. 谷歌网络安全证书 - 快速进入网络安全职业

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 需求

更多相关话题

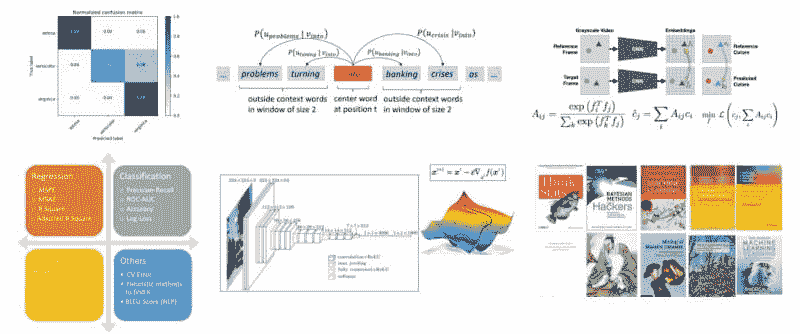

最佳机器学习语言、数据可视化工具、深度学习框架和大数据工具

原文:

www.kdnuggets.com/2018/12/machine-learning-data-visualization-deep-learning-tools.html

评论

评论

由 Altexsoft。

原文。经许可转载。

最训练有素的士兵不能空手完成任务。数据科学家有自己的武器——机器学习(ML)软件。已经有大量文章列出了可靠的机器学习工具,并深入描述了它们的功能。然而,我们的目标是获取行业专家的反馈。

这就是为什么我们采访了数据科学实践者——真正的专家——关于他们为自己的项目选择的有用工具。我们联系的专家有不同的专长,分别在 Facebook 和三星等公司工作。其中一些代表了 AI 初创公司(Objection Co、NEAR.AI 和 Respeecher);一些在大学(哈尔科夫国立无线电电子大学)教授。AltexSoft 的数据科学团队也参与了讨论。

如果你在寻找特定类型的机器学习工具,只需跳到你感兴趣的领域:

最受欢迎的机器学习语言

你在一家民族餐馆用餐,对文化不太熟悉。你可能会先询问服务员菜单上的词语是什么含义,甚至在了解你将使用什么餐具之前。所以,在讨论数据科学家最喜欢的工具之前,我们先来了解一下他们使用哪些编程语言。

Python:一种流行的语言,拥有高质量的机器学习和数据分析库。

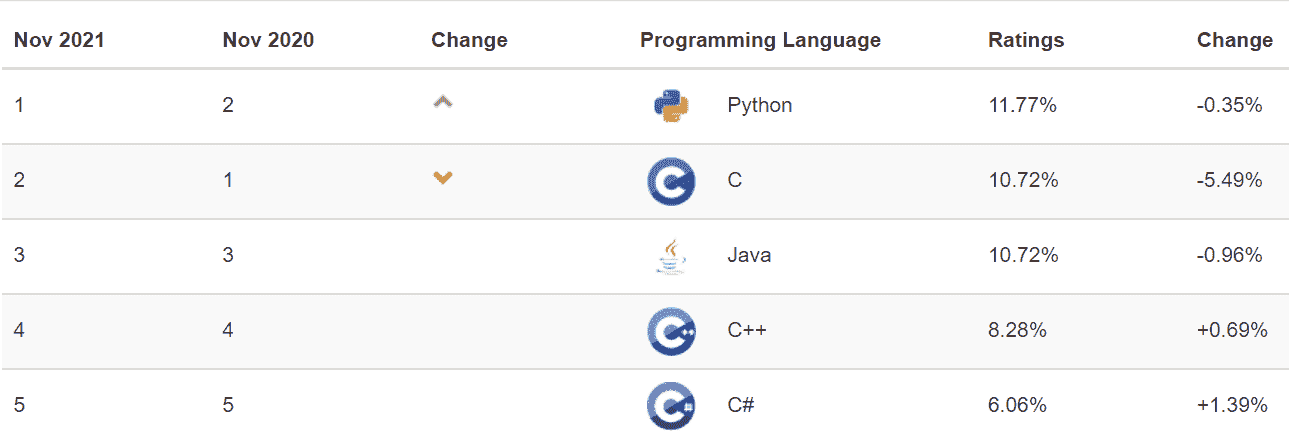

Python 是一种通用语言,因其可读性、良好的结构和相对平缓的学习曲线而受到青睐,并继续获得越来越高的受欢迎度。根据 Stack Overflow 年度开发者调查 的数据,Python 可以称得上是增长最快的主要编程语言。它排名第七,受欢迎程度为 38.8%,现已超过 C#(34.4%)。

Respeecher 的研究负责人 Grant Reaber,专注于应用于语音识别的深度学习,将 Python 作为“几乎所有人目前都将其用于深度学习。 Swift 用于 TensorFlow 听起来是一个很酷的项目,但我们会等到它更加成熟再考虑使用它,” Grant 总结道。

NEAR.AI 初创公司的联合创始人 Illia Polosukhin ,曾在 Google Research 负责 NLU 的深度学习团队,也继续使用 Python:“Python 一直以来都是数据分析的语言,并且随着时间的推移,成为了深度学习的事实标准语言,所有现代库都是为其构建的。”

Python 机器学习的一个应用场景是模型开发,特别是原型设计。

AltexSoft 的数据科学能力负责人 Alexander Konduforov 说他主要将 Python 用作构建机器学习模型的语言。

Vitaliy Bulygin,三星乌克兰的首席工程师,认为 Python 是快速原型设计的最佳语言之一。“在原型设计过程中,我找到最佳解决方案并将其重写为项目所需的语言,例如 C++,” 这位专家解释道。

Facebook AI 研究员 Denis Yarats 指出,这种语言有着惊人的深度学习工具集,如 PyTorch 框架或 NumPy 库(我们将在文章后面讨论)。

C++:一种用于 CUDA 上并行计算的中级语言

C++ 是一种灵活的、面向对象的、静态类型的语言,基于 C 编程语言。由于其可靠性、性能以及支持大量应用领域,该语言在开发者中仍然非常受欢迎。C++ 具有高级和低级语言的特点,因此被认为是一种中级编程语言。该语言的另一应用是开发能够在实时约束下直接与硬件交互的驱动程序和软件。由于 C++ 足够简洁以解释基本概念,因此也用于研究和教学。

数据科学家使用这种语言处理多种但具体的任务。 Andrii Babii 是哈尔科夫国立无线电电子大学(NURE)的高级讲师,他使用 C++ 在 CUDA 平台上并行实现算法,以加速基于这些算法的应用程序。

“当我为 CUDA 编写自定义内核时,我需要 C++,” Denis Yarats 补充道。

R:用于统计计算和图形的语言

R,作为一种统计、可视化和数据分析的语言和环境,是数据科学家的首选。它是 S 编程语言 的另一种实现。

R 及其编写的库提供了众多图形和统计技术,如经典统计测试、线性和非线性建模、时间序列分析、分类、聚类等。你可以轻松地通过 R 机器学习包扩展语言。该语言允许创建高质量的图表,包括公式和数学符号。

Alexander Konduforov 指出,使用 R 进行机器学习能够快速进行数据分析和可视化。

数据分析和可视化工具

pandas:增强分析和建模的 Python 数据分析库

现在是时候稍微谈谈 Python 的 pandas,一个名字非常可爱的免费库。数据科学爱好者 Wes McKinney 开发了这个库,以便在 Python 中方便地进行数据分析和建模。在 pandas 之前,这种编程语言 仅适用于数据准备和处理。

pandas 通过将 CSV、JSON 和 TSV 数据文件或 SQL 数据库转换为数据框(一个看起来像 Excel 或 SPSS 表格的 Python 对象,具有行和列)来简化分析。更重要的是,pandas 与 IPython 工具包和其他库结合,以提高性能并支持协作工作。

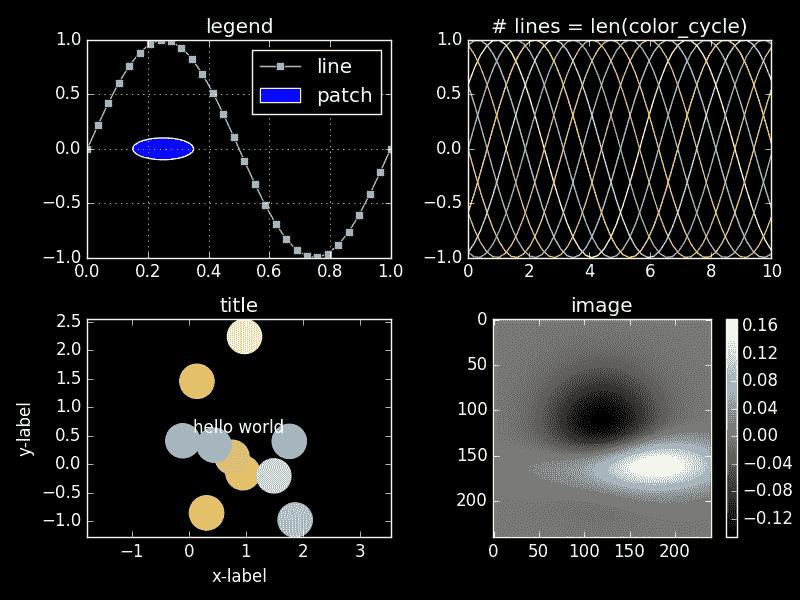

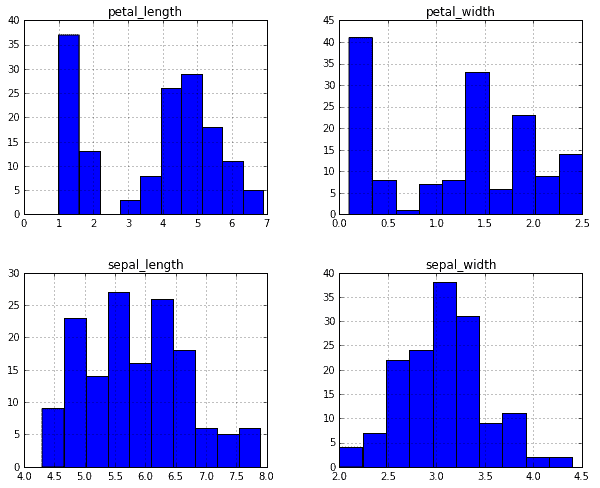

matplotlib:用于高质量可视化的 Python 机器学习库

matplotlib 是一个 Python 2D 绘图库。绘图是机器学习数据的可视化。matplotlib 源自 MATLAB:其开发者 John D. Hunter 模拟了 Mathworks 的 MATLAB 软件中的绘图命令。

虽然主要用 Python 编写,但该库通过 NumPy 和其他代码进行了扩展,因此即使在处理大数组时也表现良好。

matplotlib 允许用几行代码生成生产质量的可视化。库的开发者 强调 了使用的简便性:“如果你想看到数据的直方图,你不应该需要实例化对象、调用方法、设置属性等等,它应该直接工作。”

matplotlib 可视化演示。图像来源:matplotlib Style Gallery

该库的功能可以通过第三方可视化包扩展,如 seaborn、ggplot 和 HoloViews。专家们还可以使用 Basemap 和 cartopy 投影和制图工具包添加额外功能。

数据科学从业者注意到 matplotlib 的灵活性和集成能力。例如,Andrii Babii 更倾向于将 matplotlib 与 seaborn 和 ggplot2 一起使用。

Denis Yarats(Facebook AI Research)表示,他选择 matplotlib 主要是因为它很好地集成到 Python 工具集,并且可以与 NumPy 库或 PyTorch 机器学习框架一起使用。

Alexander Konduforov 和他的 AltexSoft 团队也使用 matplotlib。除了众多的 Python 机器学习库如 pandas,以及支持 R 和 Python 的 Plotly,团队还选择 dplyr、ggplot2、 tidyr 和 Shiny R 库。“这些工具是免费的,但你必须至少了解一些编程才能使用它们,有时还需要额外的时间。”

Jupyter notebook:协作工作能力

Jupyter Notebook 是一款免费的互动计算网页应用程序。用户可以创建和共享包含实时代码的文档,开发和执行代码,以及展示和讨论任务结果。文档可以通过 Dropbox、电子邮件、GitHub 和 Jupyter Notebook Viewer 共享,并可以包含图形和叙述性文本。

Notebook 功能丰富,并提供多种使用场景。

它可以与许多工具集成,如 Apache Spark、pandas 和 TensorFlow。它支持 40 多种语言,包括 R、Scala、Python 和 Julia。除此之外,Jupyter Notebook 还支持容器平台——Docker 和 Kubernetes。

NEAR.AI 的 Illia Polosukhin 分享了他主要用于自定义临时分析的 Jupyter Notebook:“这个应用程序允许快速进行任何数据或模型分析,并能够连接到远程服务器上的内核。你还可以与同事分享结果笔记本。”

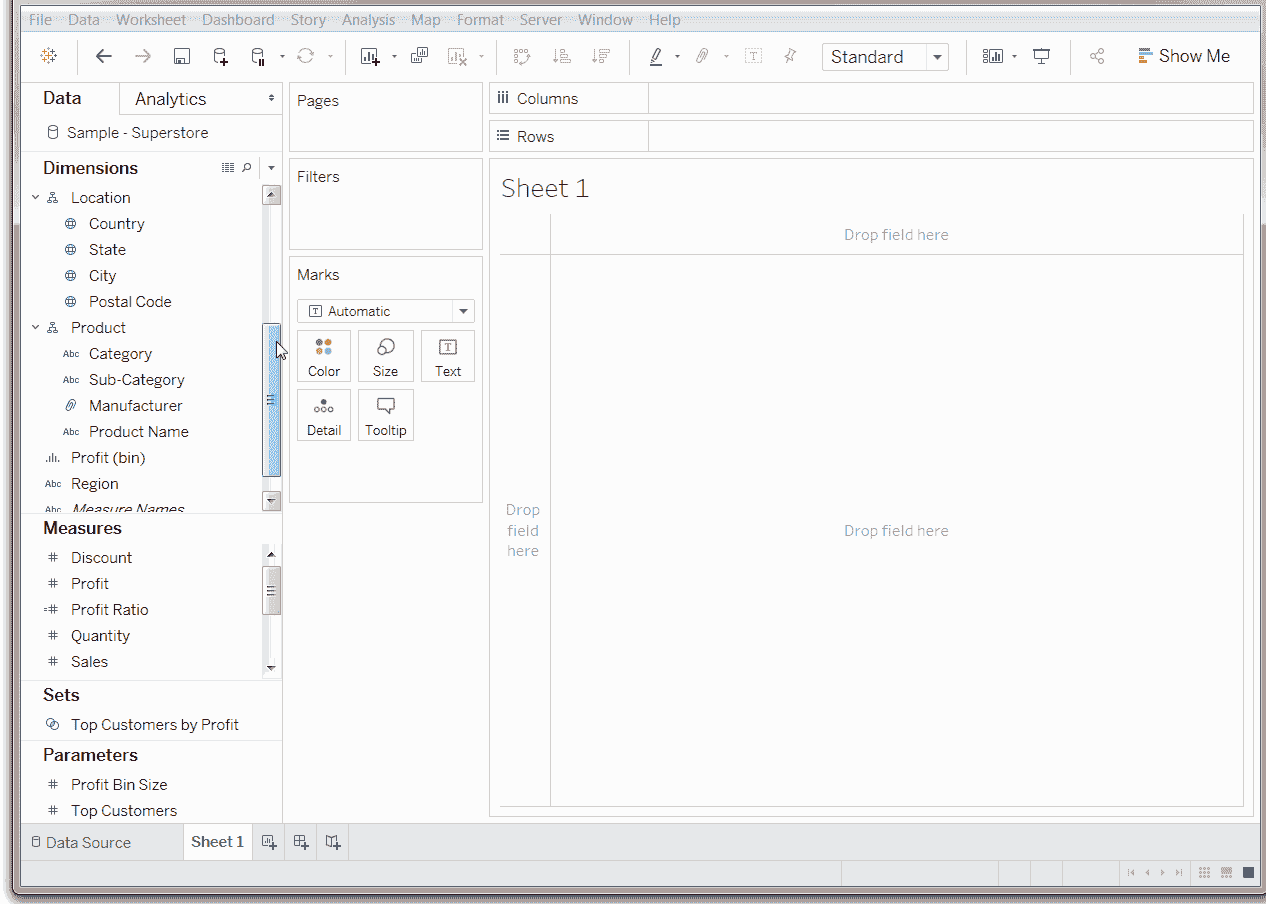

Tableau:强大的数据探索能力和互动可视化

Tableau 是一款用于数据科学和商业智能的数据可视化工具。许多具体功能使这款软件在各种行业和数据环境中解决问题时非常高效。

通过数据探索和发现,Tableau 软件可以快速从数据中提取见解并以易于理解的格式展示出来。它不需要出色的编程技能,并且可以轻松安装在各种设备上。虽然需要编写少量脚本,但大多数操作都是通过拖放完成的。

Tableau 拖放菜单的工作原理

Tableau 支持实时分析和云集成(例如与 AWS、Salesforce 或 SAP),允许结合不同的数据集和集中数据管理。

易用性和一整套功能是数据科学家选择这个工具的原因。 “Tableau 具有许多内置功能,不需要编码。你可以在 UI 中进行大量数据预处理、分析和可视化,这节省了大量精力。不过,由于它不是免费的产品,你需要购买许可证,” Alexander Konduforov 说。

一般机器学习框架

NumPy:一个用于 Python 科学计算的扩展包

前面提到的 NumPy 是一个用于 Python 数值计算的扩展包,它取代了 NumArray 和 Numeric。它支持多维数组(表格)和矩阵。机器学习数据以数组的形式表示,而矩阵是一个二维的数字数组。NumPy 包含广播功能,作为与 C/C++ 和 Fortran 代码集成的工具。它的功能还包括傅里叶变换、线性代数和随机数能力。

数据科学从业者可以使用 NumPy 作为存储多维通用数据的有效容器。通过定义任意数据类型的能力,NumPy 可以轻松快捷地与多种数据库集成。

scikit-learn:一个易于使用的机器学习框架,适用于众多行业

scikit-learn 是一个开源 Python 机器学习库,建立在 SciPy(科学 Python)、NumPy 和 matplotlib 之上。

scikit-learn 最初由 David Cournapeau 于 2007 年作为 Google Summer of Code 项目开始,目前由志愿者维护。截至今天,共有 1,092 人为其做出贡献。

该库设计用于生产使用。简单性、优质的代码、协作选项、性能以及用通俗语言编写的广泛文档都促进了它在各种专业人士中的受欢迎程度。

scikit-learn 为用户提供了许多成熟的监督学习和无监督学习算法。来自 Machine Learning Mastery 的数据科学从业者 Jason Brownlee 指出,该库专注于数据建模,而不是数据加载、处理和总结。他建议使用 NumPy 和 pandas 来处理这三项功能。

Denis Yarats 使用 NumPy、pandas 和 scikit-learn 进行一般机器学习:“我喜欢它们的简洁和透明。这些工具被广泛采用,经过多年的使用,经过了许多人的考验,这也很好。”

Aleksander 观察到:“AltexSoft 数据科学团队主要使用像 scikit-learn 和 xgboost 这样的 Python 库来进行分类和回归任务。”

Andrii Babii 更喜欢将 scikit-learn 与 R 语言库和包 一起使用。“我使用这个组合是因为它开源,功能丰富且互补,”数据科学家解释道。

NLTK:基于 Python 的人类语言数据处理平台

NLTK 是一个用于开发处理人类语言的 Python 程序的平台。

Aleksander Konduforov 更喜欢这个工具用于 NLP 任务。“NLTK 是 Python 中处理文本的标准库,具有许多有用的功能。例如,不同类型的文本、句子和单词处理、词性标注、句子结构分析、命名实体识别、文本分类、情感分析等。所有这些库都是免费的,提供了足够的功能来解决我们大多数任务,” 专家指出。

神经网络建模的 ML 框架

TensorFlow:大规模机器学习的灵活框架

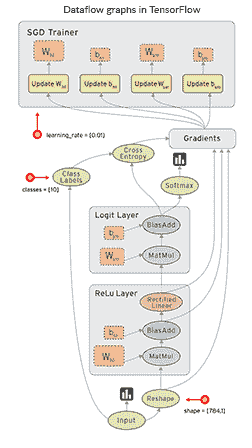

TensorFlow 是一个开源的软件库,用于机器学习和深度神经网络研究,由 Google AI 组织中的 Google Brain Team 开发并于 2015 年发布。

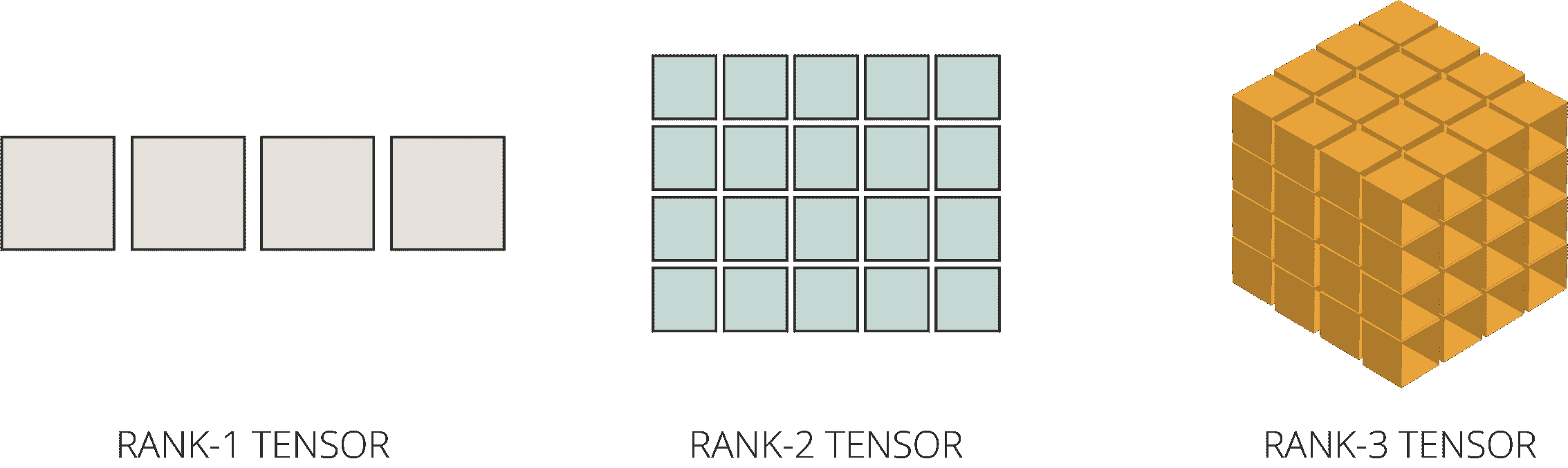

这个库的一个显著特点是,数值计算通过由节点和边组成的数据流图来完成。节点代表数学运算,而边是多维数据数组或 张量,这些操作在其上执行。

TensorFlow 中操作间数据流的可视化

TensorFlow 中操作间数据流的可视化

TensorFlow 灵活,可以在各种计算平台(CPU、GPU 和 TPU)和设备上使用,从桌面到服务器集群,再到移动设备和边缘系统。它支持 Mac、Windows 和 Linux。

这个框架的另一个优势是,它既适用于研究,也适用于重复的机器学习任务。

TensorFlow 开发工具丰富,特别是对于 Android。三星乌克兰的首席工程师 Vitaliy Bulygin 建议:“如果你需要在 Android 上实现某些功能,使用 TensorFlow。”

Curtis Boyd,Objection Co 的首席执行官,他的公司提供自动化差评移除策略,他表示他的团队选择使用 TensorFlow 进行机器学习,因为它是开源的且非常容易集成。

TensorBoard:一个用于模型训练可视化的好工具

TensorBoard 是一个工具套件,用于图形化表示 TensorFlow 中机器学习的不同方面和阶段。

TensorBoard 读取 TensorFlow 事件文件,这些文件包含在 TensorFlow 运行时生成的总结数据(关于模型特定操作的观察)。

通过图示展示的模型结构可以让研究人员确保模型组件的位置和连接都正确。

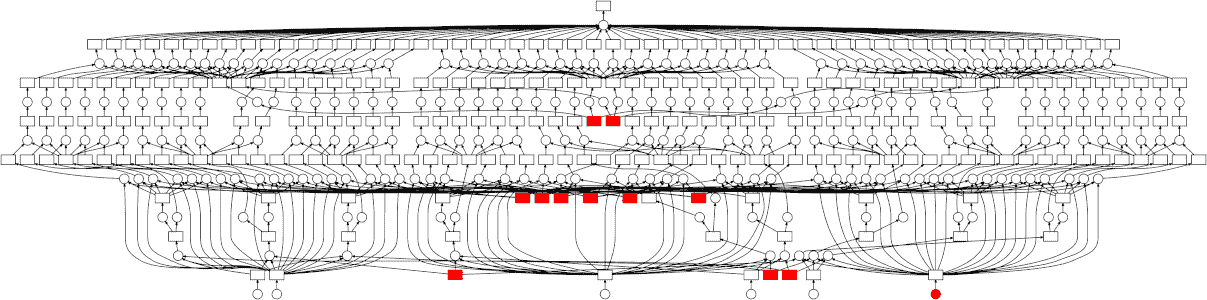

TensorBoard 中的模型图形表示

使用图形可视化工具,用户可以探索模型抽象的不同层次,放大或缩小图示的任何部分。TensorBoard 可视化的另一个重要好处是,相同类型和相似结构的节点会用相同的颜色显示。用户还可以按设备(CPU、GPU 或两者的组合)查看颜色,使用“追踪输入”功能高亮特定节点,并一次性可视化一个或多个图表。

这种可视化方法使 TensorBoard 成为模型性能评估的热门工具,特别是对于深度神经网络等复杂结构的模型。

Grant Reaber 指出 TensorBoard 使得模型训练的监控变得简单。Grant 和他的团队也使用这个工具进行自定义可视化。

Illia Polosukhin 也选择了 TensorBoard。“TensorBoard 在模型开发过程中显示指标,并允许做出有关模型的决策。例如,在调整超参数并选择表现最佳的参数时,监控模型性能非常方便,”Illia 总结道。

除了显示性能指标外,TensorBoard 还可以展示许多其他信息,如直方图、音频、文本和图像数据、分布、嵌入和标量。

PyTorch:易于使用的研究工具

PyTorch 是一个开源机器学习框架,支持深度神经网络并加速 GPU。由 Facebook 团队与 Twitter、SalesForce、NRIA、ENS、ParisTech、Nvidia、Digital Reasoning 和 INRIA 的工程师们共同开发,首次发布于 2016 年 10 月。PyTorch 基于 Torch 框架,但与前身 Lua 编写的框架不同,它支持常用的 Python。

PyTorch 的开发理念是提供尽可能快速和灵活的建模体验。值得一提的是,PyTorch 的工作流程类似于NumPy,这是一个基于 Python 的科学计算库。

动态计算图是使该库受欢迎的特性之一。在大多数框架如 TensorFlow、Theano、CNTK 和 Caffe 中,模型是以 静态 的方式构建的。数据科学家必须更改整个神经网络的结构 —— 从头重建 —— 才能改变其行为。PyTorch 使这一过程更简单、更快。该框架允许随意更改网络行为,而不会出现延迟或开销。

Denis Yarats 来自 Facebook AI Research 认为,构建模型 动态(在运行时)的能力是使用 PyTorch 的一个重要因素。“我使用 PyTorch——它是最好的。我曾尝试过许多深度学习框架,包括 TensorFlow、Torch、Keras 和 Theano。没有一个比 PyTorch 更简单、更强大。由于我从事深度学习研究,我重视快速修改和调试模型的能力。”

伊利亚·波洛苏金和维塔利·布柳金也强调了通过使用动态计算图实现的研究的便利性和灵活性,这也是他们选择 PyTorch 作为深度学习工具的原因。

Keras:轻量级、易于使用的快速原型设计库

Keras 是一个 Python 深度学习库,可以在 Theano、TensorFlow 或 CNTK 之上运行。Google Brain 团队成员弗朗索瓦·肖莱开发了它,以便数据科学家能够快速进行机器学习实验。

该库可以在 GPU 和 CPU 上运行,并支持递归网络和卷积网络及其组合。

利用该库的高级、易于理解的接口、将网络划分为易于创建和添加的独立模块的序列,可以实现快速原型设计。

数据科学家表示,建模速度是该库的一个优势。来自三星的维塔利·布柳金指出,Keras 与 TensorFlow 结合可以实现非常快速的神经网络实施。他建议,如果工具集足够完成特定任务,则应继续使用 Keras。如果不够,最好用 PyTorch 进行研究。

Caffe2:具有移动部署支持的深度学习库

Caffe2,是 Caffe 的改进版,是 Facebook 为简化和灵活处理复杂模型并支持移动部署而构建的开放机器学习框架。

用户可以通过多种方式组织计算,该库可以在桌面、云端或数据中心安装和运行。

该库具有本地 Python 和 C++ API,允许开发人员交替使用,便于快速原型设计和后期优化。

部署的模型可以通过与 Xcode、Visual Studio 和 Android Studio IDE 的集成,在移动设备上快速运行。该框架还允许快速扩展或缩减,无需重新设计。

快速原型设计、研究和开发是使用 Caffe2 的优势。“我使用它是因为它有清晰的代码结构,并且容易扩展以研究新方法,” NURE 的高级讲师 Andrii Babii 总结道。

大数据工具

Apache Spark: 分布式计算工具

使用 Apache Spark 进行大数据处理就像驾驶一辆法拉利:它更快、更便捷,并且在相同时间内可以探索更多内容,相比普通汽车。

Apache Spark 是一个分布式开源集群计算框架,通常配备有内存数据处理引擎。该引擎的功能包括 ETL(提取、转换和加载)、机器学习、数据分析、批处理和数据流处理。

Apache Spark 的流处理能力是 Facebook AI 的研究员 Denis Yarats 使用它的原因之一:“这个工具使用数据流/流处理概念进行分布式计算,并且允许将解决方案扩展到大型集群。”

尽管主要使用 Scala 编写,但引擎提供了 Java、Python、Clojure 和 R 的高级开发者 API。

Apache Spark 的其他有益特性包括多种运行选项(本地、集群、云或本地部署)和从任何数据源访问数据的能力。

MemSQL: 一个为实时应用设计的数据库

MemSQL 是用于实时分析的分布式内存 SQL 数据库平台。它处理和分析流数据,并执行 PB 级查询,以支持即时通讯、在线游戏或社区存储解决方案等实时应用。MemSQL 支持 关系 SQL、地理空间 或 JSON 数据的查询。

简而言之,该平台可以同时提供数据库、实时数据处理和数据仓库服务,帮助用户实现数据效率。

“MemSQL 让你不必担心数据的大小,并且可以像使用普通 SQL 数据库一样操作,” NEAR.AI 的 Illia Polosukhin 强调道。

结论

我们通过比较 机器学习工具 和 库,明确了它们的使用场景和需求。在准备过程中,这对我们帮助很大。我们计划下个月写一篇关于 航空公司如何使用人工智能解决方案 的文章。如果你是一个活跃的机器学习从业者,请随时在评论区或直接联系我们,分享你偏好的工具。我们也乐意分享你的评论。

简介: Altexsoft 是一家旅行与酒店科技咨询公司。他们与在线旅行社、旅行管理解决方案提供商以及旅行科技初创公司合作,开发定制软件。

资源:

相关:

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析水平

2. Google 数据分析专业证书 - 提升你的数据分析水平

3. Google IT 支持专业证书 - 支持你的组织的 IT。

3. Google IT 支持专业证书 - 支持你的组织的 IT。

更多相关话题

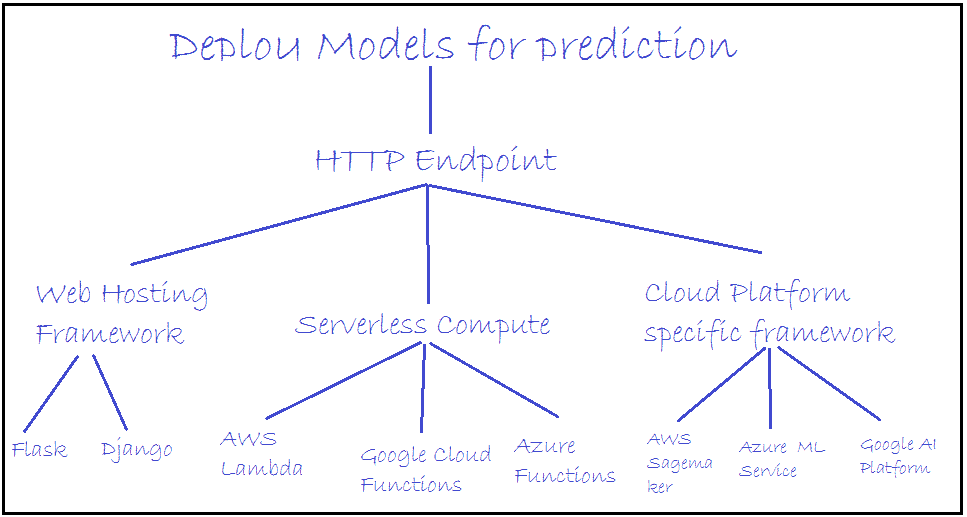

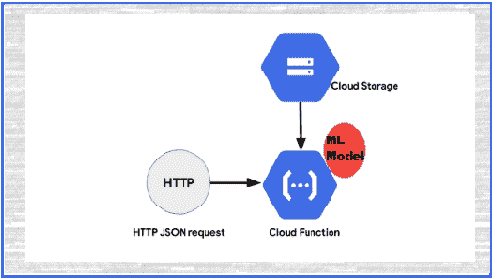

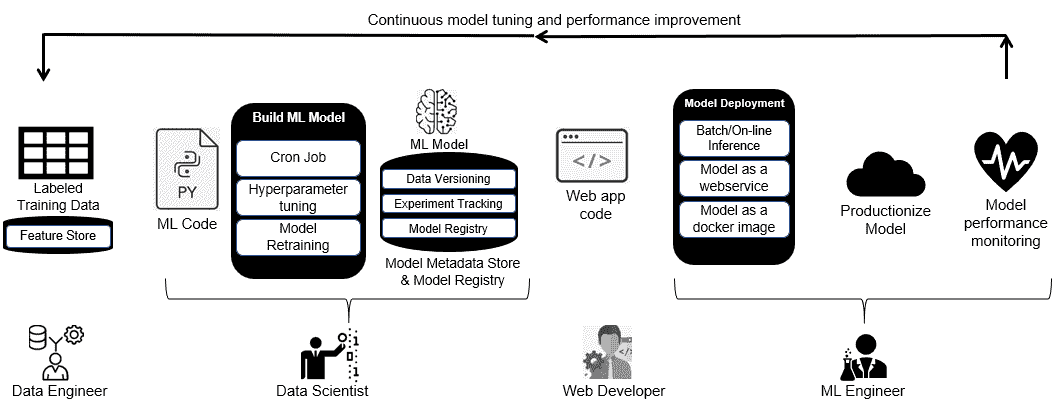

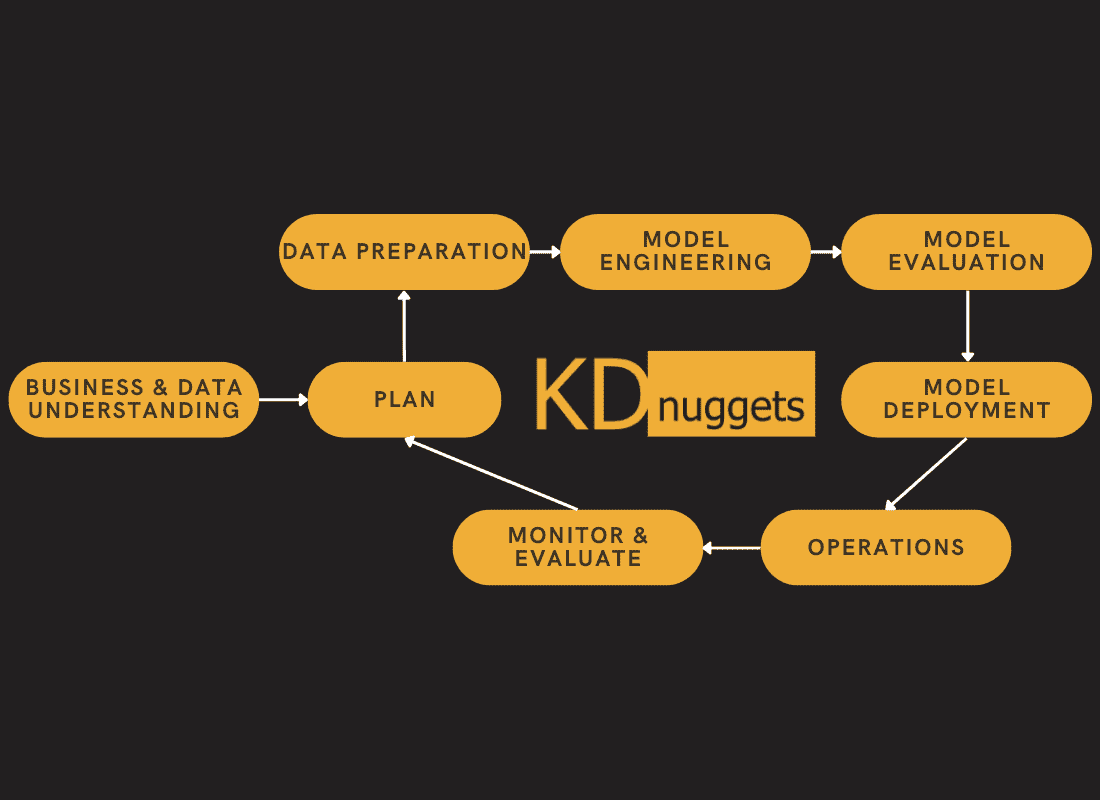

为什么机器学习部署很困难?

原文:

www.kdnuggets.com/2019/10/machine-learning-deployment-hard.html

评论

作者 亚历山大·贡法洛涅里,AI 顾问。

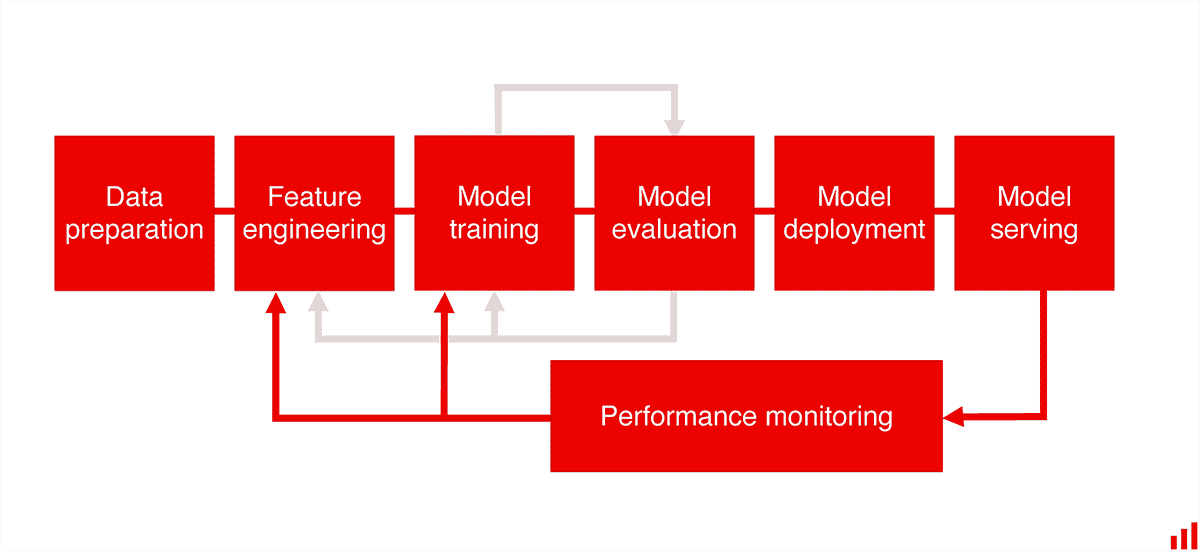

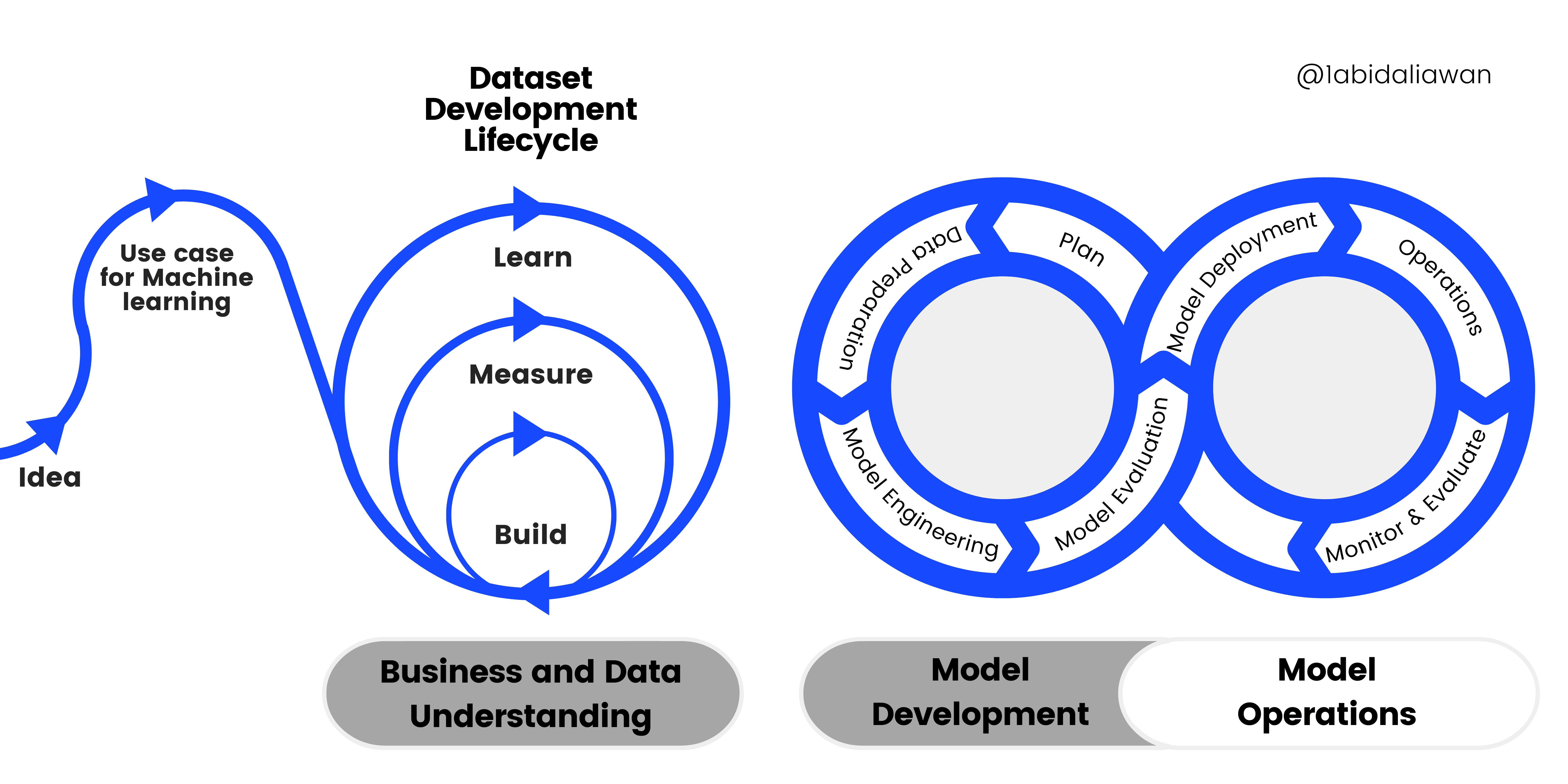

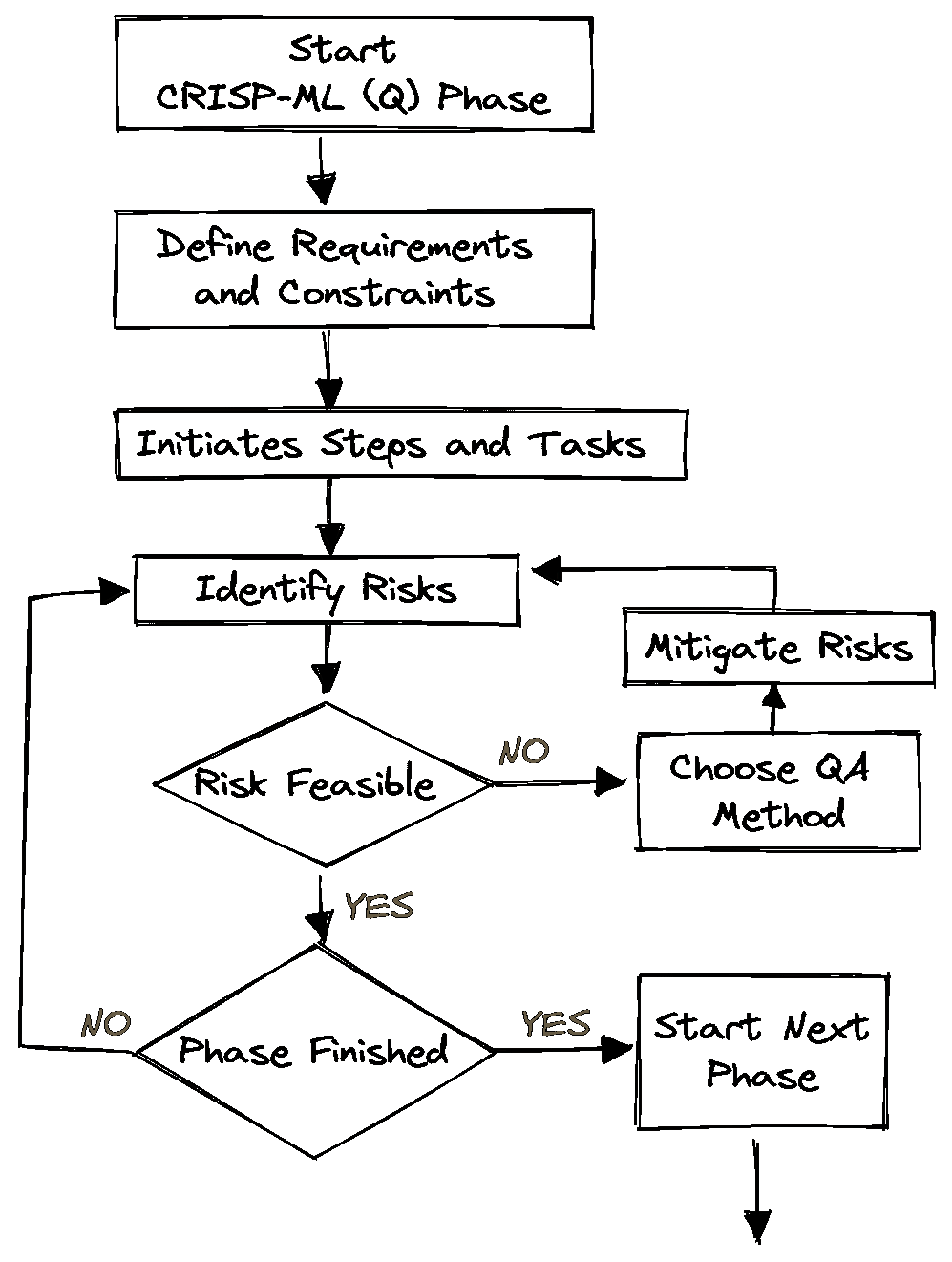

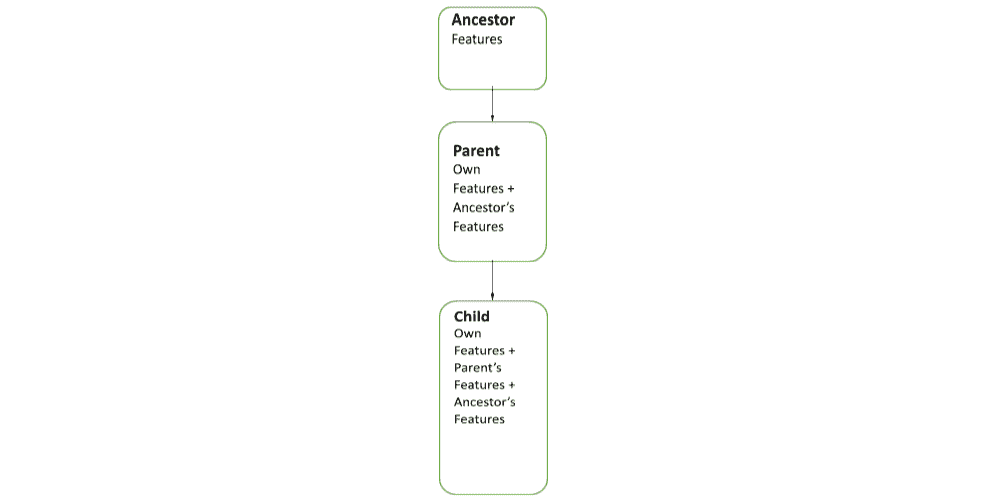

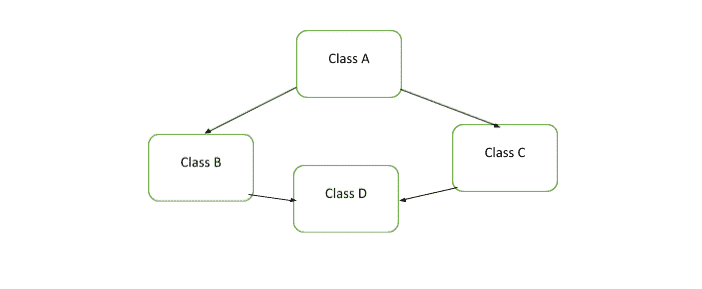

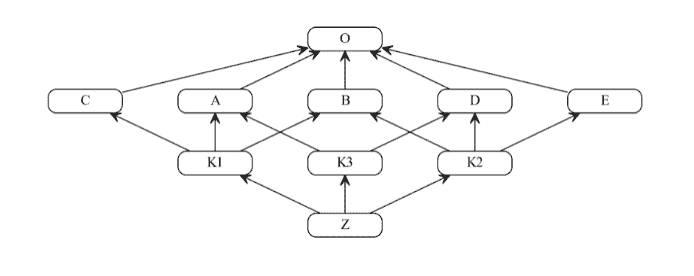

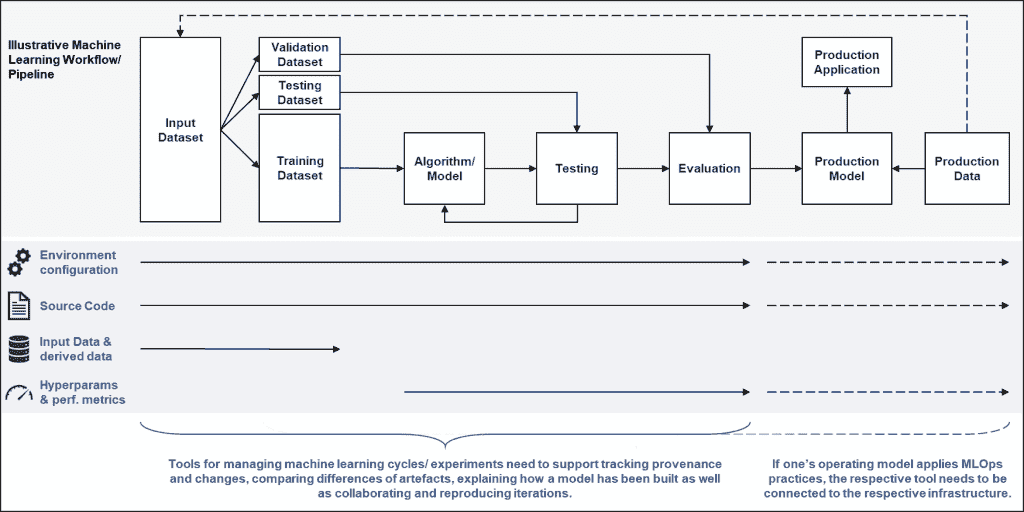

经过几个 AI 项目,我意识到,在大规模部署机器学习(ML)模型是那些希望通过 AI 创造价值的公司面临的最重要挑战之一,随着模型变得越来越复杂,这一挑战也在不断增加。

根据我的顾问经验,只有极少数的机器学习项目能够投入生产。AI 项目可能因为很多原因失败,其中之一就是部署。每个决策者都需要完全理解部署的工作原理,以及在这一关键步骤中如何降低失败的风险。

一个已部署的模型可以定义为任何无缝集成到生产环境中的代码单元,能够接收输入并返回输出。

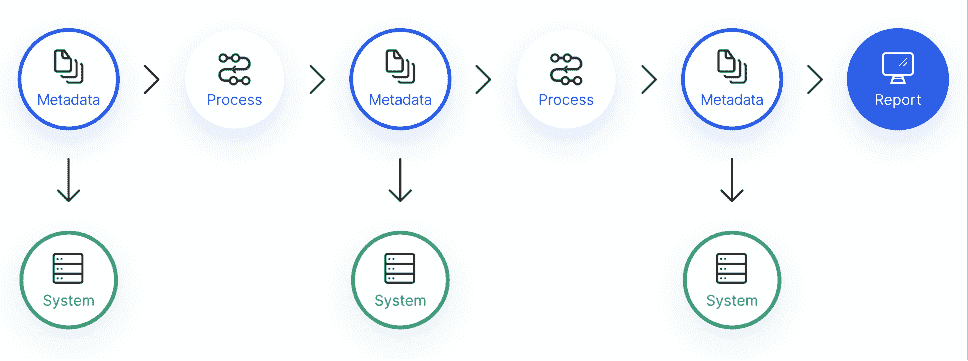

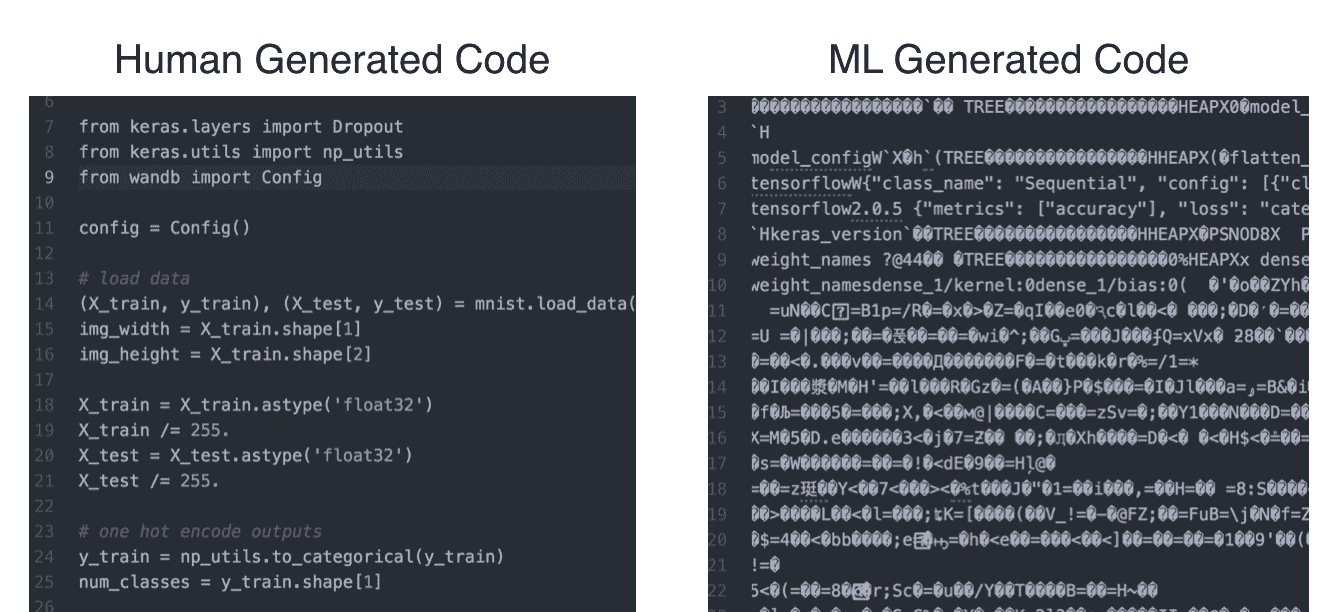

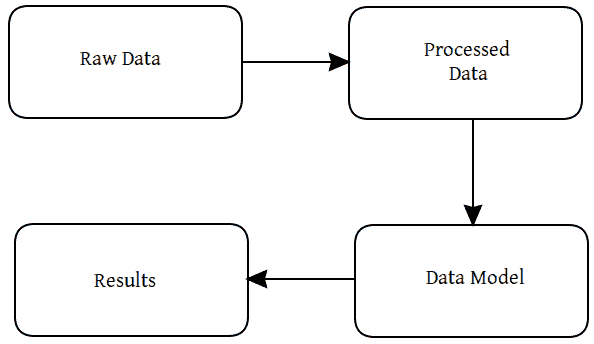

我发现,为了将工作投入生产,数据科学家通常必须将其数据模型移交给工程团队进行实施。而在这个步骤中,一些最常见的数据科学问题出现了。

挑战

机器学习具有一些独特的特点,使得在大规模部署时更具挑战性。这些是我们正在处理的一些问题(其他问题也存在):

管理数据科学语言

如你所知,机器学习应用通常由不同的编程语言编写的元素组成,这些元素之间并不总是能够良好互动。我多次看到过一个机器学习管道,从 R 开始,继续在 Python 中,然后在另一种语言中结束。

通常,Python 和 R 是目前最受欢迎的机器学习应用语言,但我注意到,由于速度等各种原因,生产模型很少使用这些语言。将 Python 或 R 模型移植到 C++ 或 Java 等生产语言中是复杂的,并且通常会导致原始模型的性能(速度、准确性等)下降。

R 包在软件新版本发布时可能会出错。此外,R 的速度较慢,无法高效处理大数据。

这是一个很好的原型设计语言,因为它允许轻松的互动和问题解决,但它需要被转换为 Python、C++ 或 Java 以用于生产。

容器化技术,如 Docker,可以解决由各种工具引入的不兼容性和可移植性问题。然而,自动依赖检查、错误检查、测试和构建工具无法跨越语言障碍解决问题。

可重现性也是一个挑战。确实,数据科学家可能会构建多个模型版本,每个版本使用不同的编程语言、库或相同库的不同版本。手动跟踪这些依赖项非常困难。为了解决这些挑战,需要一个 ML 生命周期工具,能够在训练阶段自动跟踪和记录这些依赖项,并将它们与训练后的模型一起打包成一个可以部署的工件。

我建议你依赖一个可以即时将代码从一种语言翻译成另一种语言的工具或平台,或者允许你的数据科学团队将模型部署到 API 后面,以便可以在任何地方集成。

计算能力和 GPU

神经网络通常非常深,这意味着训练和使用它们进行推断需要大量的计算能力。通常,我们希望我们的算法能为许多用户快速运行,这可能成为一个障碍。

此外,许多生产中的 ML 今天依赖于 GPU。然而,它们稀缺且昂贵,这容易为扩展 ML 任务增加另一层复杂性。

可移植性

模型部署的另一个有趣挑战是缺乏可移植性。我注意到这通常是遗留分析系统中的一个问题。由于缺乏将软件组件轻松迁移到另一个主机环境并在那里运行的能力,组织可能会被锁定在特定平台上。这可能为数据科学家在创建和部署模型时带来障碍。

可扩展性

可扩展性是许多 AI 项目中的一个真实问题。确实,你需要确保你的模型能够扩展并满足生产中性能和应用需求的增加。在项目开始时,我们通常依赖于相对静态的数据,规模也较易管理。随着模型进入生产阶段,它通常会暴露于更大体积的数据和数据传输模式。你的团队将需要多个工具来监控和解决随着时间推移而出现的性能和可扩展性挑战。

我相信,通过采用一致的、基于微服务的生产分析方法,可以解决可扩展性问题。团队应该能够通过简单的配置更改,快速将模型从批处理迁移到按需处理或流处理。类似地,团队应该有选项来扩展计算和内存的使用,以支持更复杂的工作负载。

机器学习计算工作呈峰值状态

一旦你的算法被训练完成,它们并不总是会被使用——你的用户只会在需要时调用它们。

这可能意味着你在早上 8:00 仅支持 100 次 API 调用,但在早上 8:30 支持 10,000 次。

根据经验,我可以告诉你,扩展和缩减同时确保不为不需要的服务器付费是一个挑战。

由于所有这些原因,只有少数数据科学项目最终会投入生产系统。

强化以实现操作化

我们总是花费大量时间使我们的模型准备就绪。增强模型的鲁棒性包括将原型准备好,以便它能够实际服务于所需的用户数量,这通常需要大量工作。

在许多情况下,整个模型需要用适合当前架构的语言重新编码。仅这一点就往往是大规模且痛苦的工作源,导致部署延迟数月。完成后,它必须集成到公司的 IT 架构中,并处理之前讨论的所有库问题。此外,访问生产中的数据通常是一项艰巨的任务,往往受到技术和/或组织数据孤岛的困扰。

更多挑战

在我的项目中,我还注意到以下问题:

-

如果我们改变了输入特征,那么其余特征的重要性、权重或使用方式可能会发生变化,也可能不会。机器学习系统必须设计得使特征工程和选择的变化能够轻松追踪。

-

当模型不断迭代和微调时,跟踪配置更新,同时保持配置的清晰性和灵活性,变成了额外的负担。

-

一些数据输入可能会随着时间变化。我们需要一种方法来理解和跟踪这些变化,以便能全面理解我们的系统。

-

机器学习应用中可能出现多种问题,这些问题不会被传统的单元/集成测试识别。部署错误版本的模型、遗漏特征以及在过时的数据集上训练只是一些例子。

测试与验证问题

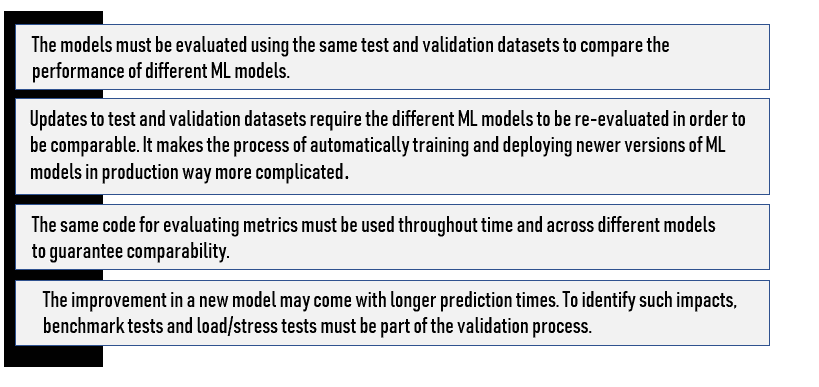

正如你可能已经知道的那样,模型由于数据变化、新方法等而不断演变。因此,每次发生这样的变化时,我们必须重新验证模型性能。这些验证步骤带来了几个挑战:

除了离线测试中的模型验证外,评估生产中模型的性能非常重要。通常,我们在部署策略和监控部分进行规划。

机器学习模型需要比普通软件应用程序更频繁地更新。

自动化机器学习平台

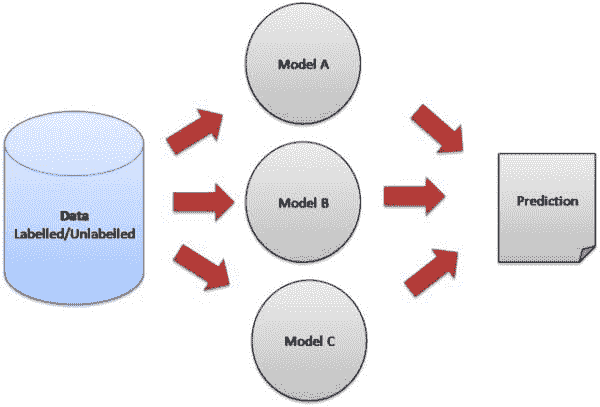

你们中的一些人可能听说过自动化机器学习平台。这可能是更快生成模型的好解决方案。此外,该平台可以支持多个模型的开发和比较,以便业务可以选择最符合其预测准确性、延迟和计算资源要求的模型。

多达 90%的企业机器学习模型可以自动开发。数据科学家可以与业务人员合作,开发目前自动化无法达到的小部分模型。

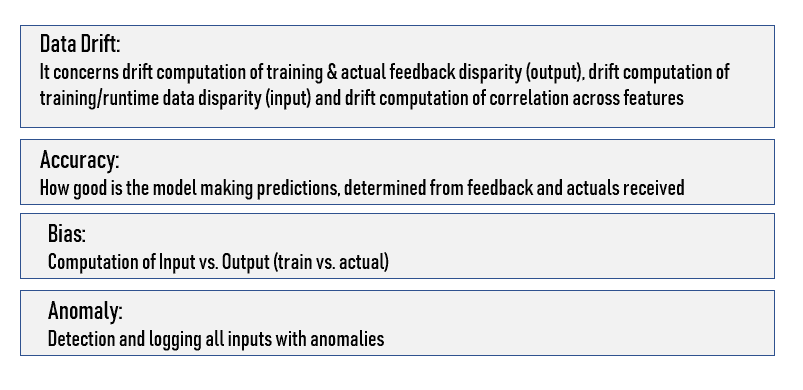

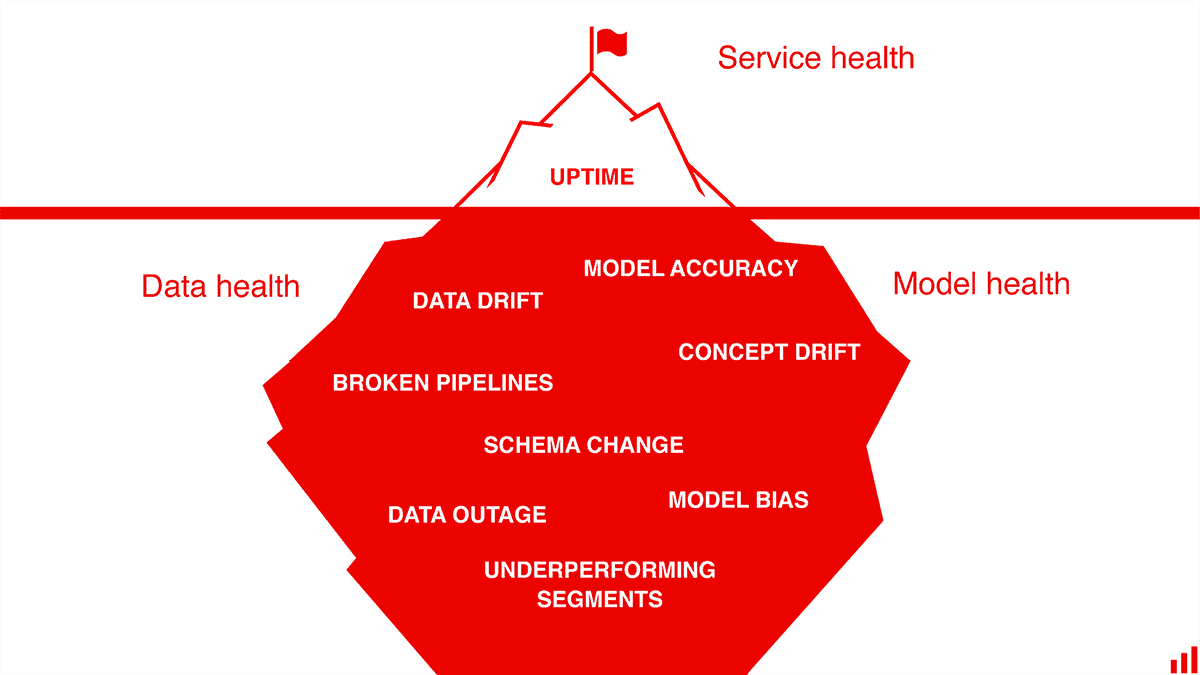

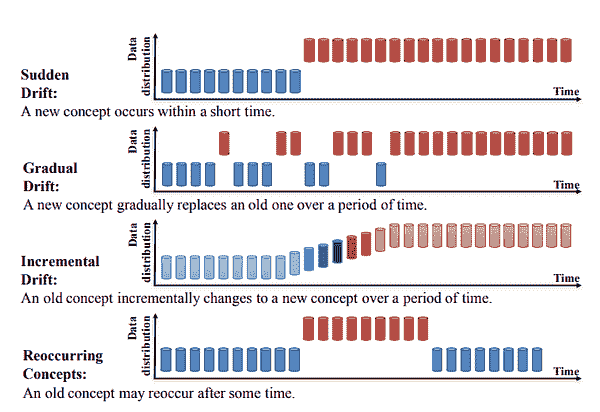

许多模型会经历漂移(性能随时间下降)。因此,已部署的模型需要被监控。每个已部署的模型应记录所有输入、输出和异常。模型部署平台需要提供日志存储和模型性能可视化功能。密切关注模型性能是有效管理机器学习模型生命周期的关键。

需要通过部署平台监控的关键要素。

发布策略

探索多种部署软件的方法(这是一个很棒的长篇文章),其中“影子模式”和“金丝雀”部署对于机器学习应用特别有用。在“影子模式”中,你可以捕捉新模型在生产环境中的输入和预测,而不实际提供这些预测。相反,你可以自由分析结果,如果发现错误,不会有重大后果。

随着架构的成熟,考虑启用渐进式或“金丝雀”发布。这种做法是将发布范围限制在少数客户中,而不是“全有或全无”。这需要更成熟的工具,但当发生错误时,它可以最小化影响。

结论

机器学习仍处于早期阶段。实际上,软件和硬件组件都在不断发展,以满足当前机器学习的需求。

Docker/Kubernetes 和微服务架构可以用来解决异质性和基础设施挑战。现有工具可以在某些方面大大解决问题。我相信,将所有这些工具结合起来实现机器学习的运作是今天面临的最大挑战。

部署机器学习是且将继续是一个困难的过程,这是组织必须面对的现实。不过,值得庆幸的是,一些新架构和产品正在帮助数据科学家。此外,随着越来越多的公司扩展数据科学操作,他们也在实施使模型部署更容易的工具。

原文。转载自许可。

个人简介:亚历山大·贡法隆内里是一位人工智能顾问,并广泛撰写有关人工智能的文章。

相关内容:

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯

1. Google 网络安全证书 - 快速进入网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

更多相关话题

使用机器学习检测恶意 URL

原文:

www.kdnuggets.com/2016/10/machine-learning-detect-malicious-urls.html

评论

评论

作者:Faizan Ahmad,Fsecurify CEO。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速开启网络安全职业生涯。

1. Google 网络安全证书 - 快速开启网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

随着过去几年机器学习的增长,许多任务都借助机器学习算法来完成。不幸或幸运的是,关于机器学习算法在安全方面的工作很少。因此,我想在Fsecurify上展示一些内容。

几天前,我有了一个想法:如果我们可以使用某种机器学习算法从非恶意 URL 中检测恶意 URL 会怎样。对此主题已经有一些研究,所以我认为应该尝试一下,从零开始实现一些东西。让我们开始吧。

数据收集

第一个任务是收集数据。我做了一些搜索,发现了一些提供恶意链接的网站。我设置了一个小爬虫,爬取了许多来自不同网站的恶意链接。接下来的任务是寻找清晰的 URL。幸运的是,我不需要爬取任何数据。已经有一个数据集可用。如果我没有提及数据来源,请不要担心。你将在本文末尾获得数据。

所以,我收集了大约 400,000 个 URL,其中大约 80,000 个是恶意的,其他的是干净的。这就是我们的数据集。接下来我们继续。

分析

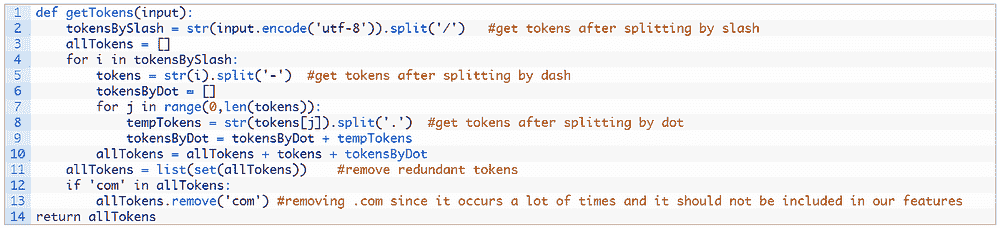

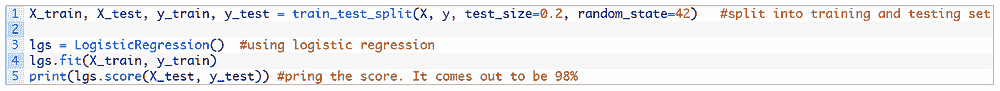

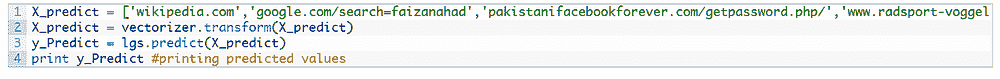

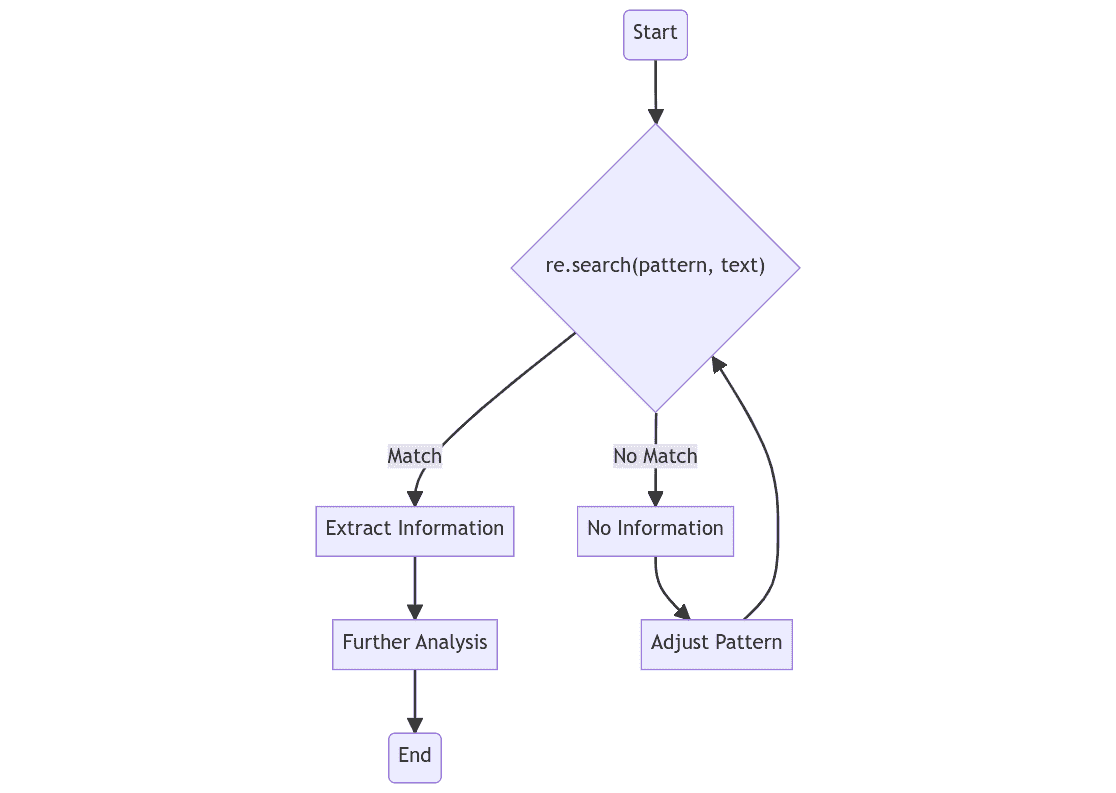

我们将使用逻辑回归,因为它速度很快。第一步是对 URL 进行标记化。我为此编写了自己的标记化函数,因为 URL 与其他文档文本有所不同。

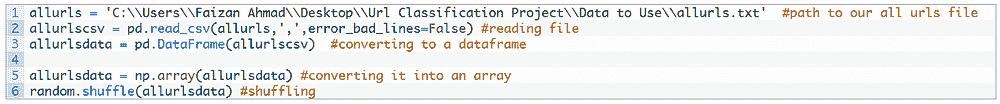

下一步是加载数据并将其存储到列表中。

既然我们已经将数据放入列表中,我们需要对 URL 进行向量化。我使用了tf-idf 分数,而不是使用词袋分类,因为 URL 中的某些词比其他词更重要,例如 ‘virus’, ‘.exe’, ‘.dat’ 等。让我们将 URL 转换为向量形式。

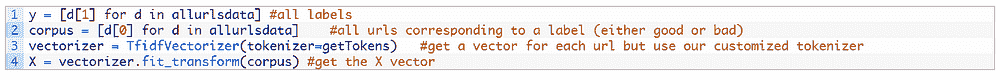

我们有了向量。现在让我们将其转换为测试和训练数据,并进行逻辑回归分析。

就是这样。看,它简单却有效。我们获得了 98%的准确率。这是一个非常高的值,能让机器有效检测恶意网址。想测试一些链接看看模型的预测是否准确吗?当然。我们来试试。

结果非常惊人。

-

wikipedia.com (好网址)

-

google.com/search=faizanahmad (好网址)

-

pakistanifacebookforever.com/getpassword.php/ (坏网址)

-

www.radsport-voggel.de/wp-admin/includes/log.exe (坏网址)

-

ahrenhei.without-transfer.ru/nethost.exe (坏网址)

-

www.itidea.it/centroesteticosothys/img/_notes/gum.exe (坏网址)

这正是一个人类可能预测的结果。不是吗?

数据和代码可在Github获取。

简历: Faizan Ahmad 是一名富布赖特计算机科学本科生,同时也是 Fsecurify 的首席执行官。

相关:

-

大数据安全的 5 个最佳实践

-

数据科学家如何缓解敏感数据暴露的漏洞?

-

大数据与数据科学在安全和欺诈检测中的应用

更多相关内容

进行机器学习时的 7 个常见错误

www.kdnuggets.com/2015/03/machine-learning-data-science-common-mistakes.html/2

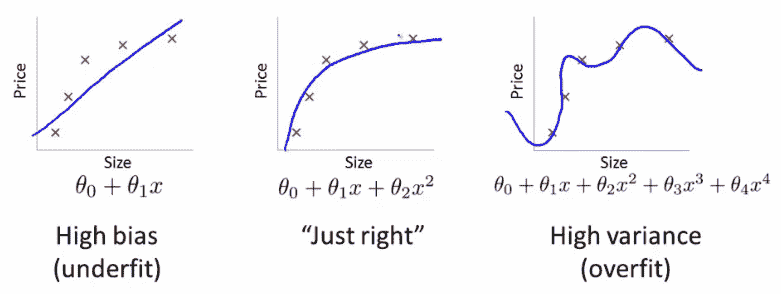

4. 当 n<<p 时使用高方差模型

支持向量机(SVM)是最流行的现成建模算法之一,其最强大的特性之一是能够使用不同的核函数来拟合模型。SVM 的核函数可以看作是自动组合现有特征以形成更丰富特征空间的一种方式。由于这种强大的功能几乎是免费的,因此大多数从业者在训练 SVM 模型时默认使用核函数。然而,当数据的 n<<p(样本数量 << 特征数量)——在医疗数据等行业中很常见——时,更丰富的特征空间意味着更高的过拟合风险。实际上,当 n<<p 时,高方差模型应该完全避免。

5. 没有标准化的 L1/L2/... 正则化

对线性或逻辑回归施加 L1 或 L2 惩罚大系数是一种常见的正则化方法。然而,许多从业者没有意识到在应用这些正则化之前标准化特征的重要性。

回到欺诈检测的例子,假设有一个具有交易金额特征的线性回归模型。如果没有正则化,当交易金额的单位是美元时,拟合的系数将比单位为美分时的拟合系数大约大 100 倍。使用正则化时,由于 L1 / L2 对较大系数的惩罚更多,因此如果单位是美元,交易金额会受到更多的惩罚。因此,正则化存在偏倚,倾向于惩罚较小规模的特征。为了解决这个问题,作为预处理步骤,标准化所有特征并使其具有相同的基础。

6. 使用线性模型而不考虑多重共线性预测变量

想象构建一个包含两个变量 X1 和 X2 的线性模型,假设真实模型是 Y=X1+X2。理想情况下,如果数据观察时噪声很小,线性回归解决方案将恢复真实模型。然而,如果 X1 和 X2 存在共线性,则对大多数优化算法而言,Y=2X1、Y=3X1-X2 或 Y=100X1-99X2 都是同样有效的。这个问题可能不会对估计造成偏差,但确实使问题变得条件不良,并使系数权重无法解释。

7. 从线性或逻辑回归中解读系数的绝对值作为特征重要性

由于许多现成的线性回归模型返回每个系数的 p 值,许多从业者认为,对于线性模型来说,系数的绝对值越大,对应的特征就越重要。这种情况很少发生,因为(a)改变变量的尺度会改变系数的绝对值,(b)如果特征之间存在多重共线性,系数可能会从一个特征转移到其他特征。此外,数据集中的特征越多,特征之间存在多重共线性的可能性就越大,通过系数解释特征重要性也就越不可靠。

那么,这里是:实际应用机器学习时的 7 个常见错误。这个列表并不是详尽无遗的,而只是为了促使读者考虑可能不适用于当前数据的建模假设。为了获得最佳的模型性能,选择最适合假设的建模算法非常重要——而不仅仅是你最熟悉的算法。

原文:机器学习中的常见错误

是 Codecademy 的分析总监。专长:数据工程和机器学习。曾任职于:Google、LinkedIn 和 Square。

相关:

-

11 种聪明的过拟合方法及如何避免它们

-

大数据是否加速了医学研究?还是没有?

-

统计学教会我们关于大数据分析的 10 件事

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全领域的职业生涯。

1. Google 网络安全证书 - 快速进入网络安全领域的职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织在 IT 领域

3. Google IT 支持专业证书 - 支持你的组织在 IT 领域

更多相关话题

机器学习驱动的防火墙

原文:

www.kdnuggets.com/2017/02/machine-learning-driven-firewall.html

评论

评论

作者:Faizan Ahmad,Fsecurify CEO。

最近,我一直在思考将机器学习应用于我可以做的安全项目并与大家分享的方法。几天前,我偶然发现了一个叫做ZENEDGE的网站,提供AI 驱动的网络应用防火墙。我喜欢这个概念,想做一些类似的东西并与社区分享。所以,让我们做一个吧。

fWaf – 机器学习驱动的网络应用防火墙

数据集:

首先需要做的是找到标记的数据,但我找到的数据相当旧(2010 年)。有一个网站叫做SecRepo,提供了很多安全相关的数据集。其中之一是包含数百万个查询的 http 日志。这是我想要的数据集,但它没有标记。我使用了一些启发式方法和我以前的安全知识,通过编写几个脚本来标记数据集。

在修剪数据之后,我想收集更多的恶意查询。因此,我去找了payloads,并找到了一些包含 Xss、SQL 及其他攻击负载的著名 GitHub 仓库,并将它们全部用于我的恶意查询数据集。

现在,我们有两个文件;一个包含干净的网络查询(1000000),另一个包含恶意的网络查询(50000)。这就是我们训练分类器所需的所有数据。

训练:

对于训练,我使用了逻辑回归,因为它速度快,我需要快速的东西。我们可以使用 SVM 或神经网络,但它们比逻辑回归稍慢。我们的问题是二分类问题,因为我们需要预测一个查询是否恶意。我们将使用ngrams作为我们的标记。我阅读了一些研究论文,使用 ngrams 对于这种项目来说是一个好主意。对于这个项目,我使用了n=3。

让我们直接进入代码部分。

让我们定义我们的分词器函数,它将提供 3 个 grams。

def getNGrams(query):

tempQuery = str(query)

ngrams = []

for i in range(0,len(tempQuery)-3):

ngrams.append(tempQuery[i:i+3])

return ngrams

让我们加载查询数据集。

filename = 'badqueries.txt'

directory = str(os.getcwd())

filepath = directory + "/" + filename

data = open(filepath,'r').readlines()

data = list(set(data))

badQueries = []

validQueries = []

count = 0

for d in data:

d = str(urllib.unquote(d).decode('utf8'))

badQueries.append(d)

filename = 'goodqueries.txt'

directory = str(os.getcwd())

filepath = directory + "/" + filename

data = open(filepath,'r').readlines()

data = list(set(data))

for d in data:

d = str(urllib.unquote(d).decode('utf8'))

validQueries.append(d)

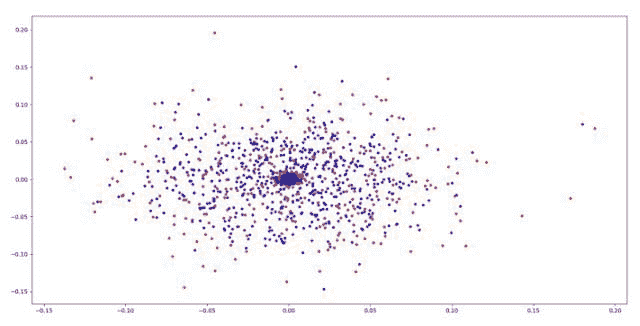

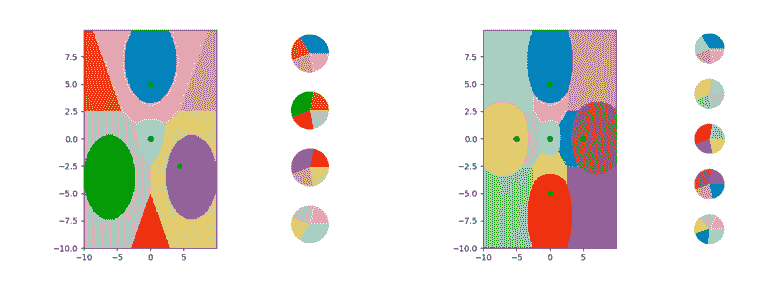

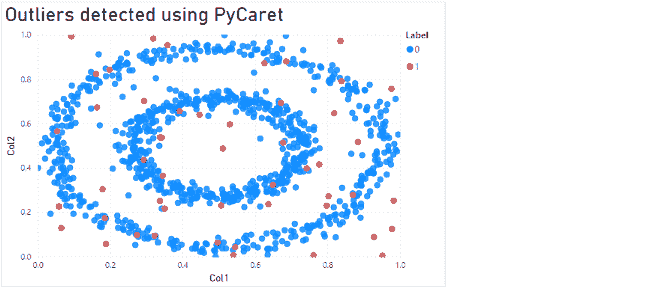

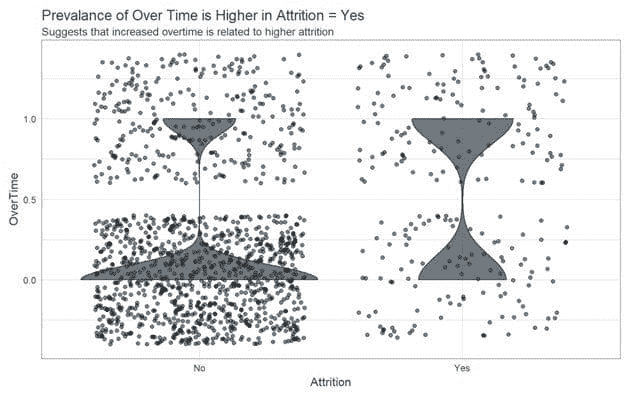

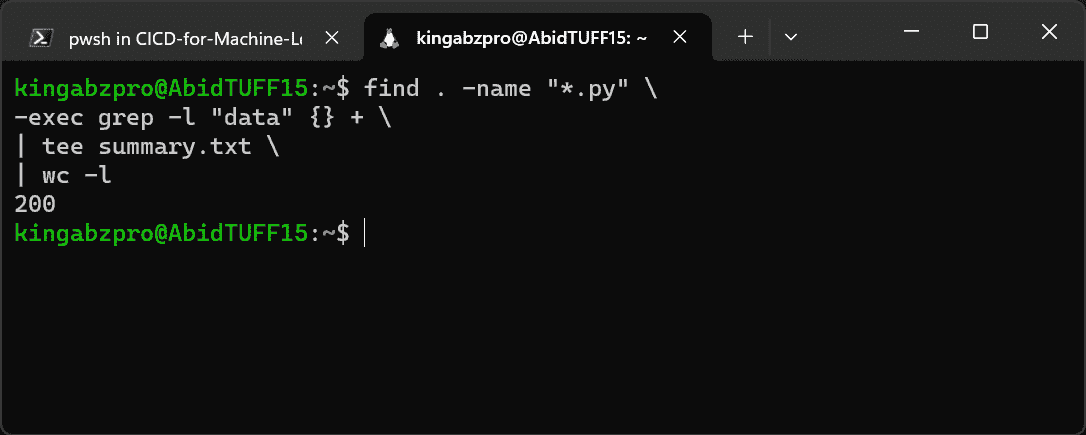

现在我们已经将数据集加载到好的查询和坏的查询中。让我们尝试可视化它们。我使用了主成分分析来可视化数据集。红色的是坏查询的 ngrams,蓝色的是好查询的 ngrams。

我们可以看到,坏点和好点确实在不同的位置出现。让我们继续深入。

badQueries = list(set(badQueries))

tempvalidQueries = list(set(validQueries]))

tempAllQueries = badQueries + tempvalidQueries

bady = [1 for i in range(0,len(tempXssQueries))]

goody = [0 for i in range(0,len(tempvalidQueries))]

y = bady+goody

queries = tempAllQueries

现在让我们使用 Tfidvectorizer 将数据转换为 tfidf 值,然后使用我们的分类器。我们使用 tfidf 值是因为我们想给我们的 ngrams 赋予权重,例如 ngram ‘<img’ 应该有较大的权重,因为包含此 ngram 的查询很可能是恶意的。你可以在这个 链接 中了解更多关于 tfidf 的信息。

vectorizer = TfidfVectorizer(tokenizer=getNGrams)

X = vectorizer.fit_transform(queries)

X_train, X_test, y_train, y_test = train_test_split(X, y,

test_size=0.2, random_state=42)

现在我们一切准备就绪,让我们应用逻辑回归。

lgs = LogisticRegression()

lgs.fit(X_train, y_train)

print(lgs.score(X_test, y_test))

就这些了。

这是大家都期待的部分,你一定想看到准确度,对吧?准确度达到 99%。这非常惊人,对吧?但你不会相信,直到你看到一些证据。所以,让我们检查一些查询,看看模型是否将其检测为恶意的。这是结果。

wp-content/wp-plugins (CLEAN)

<script>alert(1)</script> (MALICIOUS)

SELECT password from admin (MALICIOUS)

"> (MALICIOUS)

/example/test.php (CLEAN)

google/images (CLEAN)

q=../etc/passwd (MALICIOUS)

javascript:confirm(1) (MALICIOUS)

"> (MALICIOUS)

foo/bar (CLEAN)

foooooooooooooooooooooo (CLEAN)

example/test/q=<script>alert(1)</script> (MALICIOUS)

example/test/q= (MALICIOUS)

fsecurify/q= (MALICIOUS)

example/test/q= (MALICIOUS)

看起来不错,不是吗?它能很好地检测恶意查询。

接下来呢? 这是一个周末项目,还有很多可以做或添加的东西。我们可以进行多类分类,以检测恶意查询是 SQL 注入还是跨站脚本攻击或其他任何注入。我们可以拥有一个更大的数据集,包含所有类型的恶意查询,并在其上训练模型,从而扩展其检测的恶意查询类型。还可以将此模型保存并与 Web 服务器一起使用。如果你做了上述任何操作,请告诉我。

数据和脚本: github.com/faizann24/F<wbr>waf-Machine-Learning-driven-We<wbr>b-Application-Firewall

希望你喜欢这篇文章。我们致力于向社区免费提供安全资源。欢迎提出你的意见和批评。

Fsecurify

简介:Faizan Ahmad 是现任 Fulbright 本科生,正在拉合尔的 NUCES FAST 学习。

相关:

-

机器学习与网络安全资源

-

使用机器学习检测恶意 URL

-

通过 Databricks 实现 Apache Spark 的端到端安全

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路

1. Google 网络安全证书 - 快速进入网络安全职业道路

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

更多相关话题

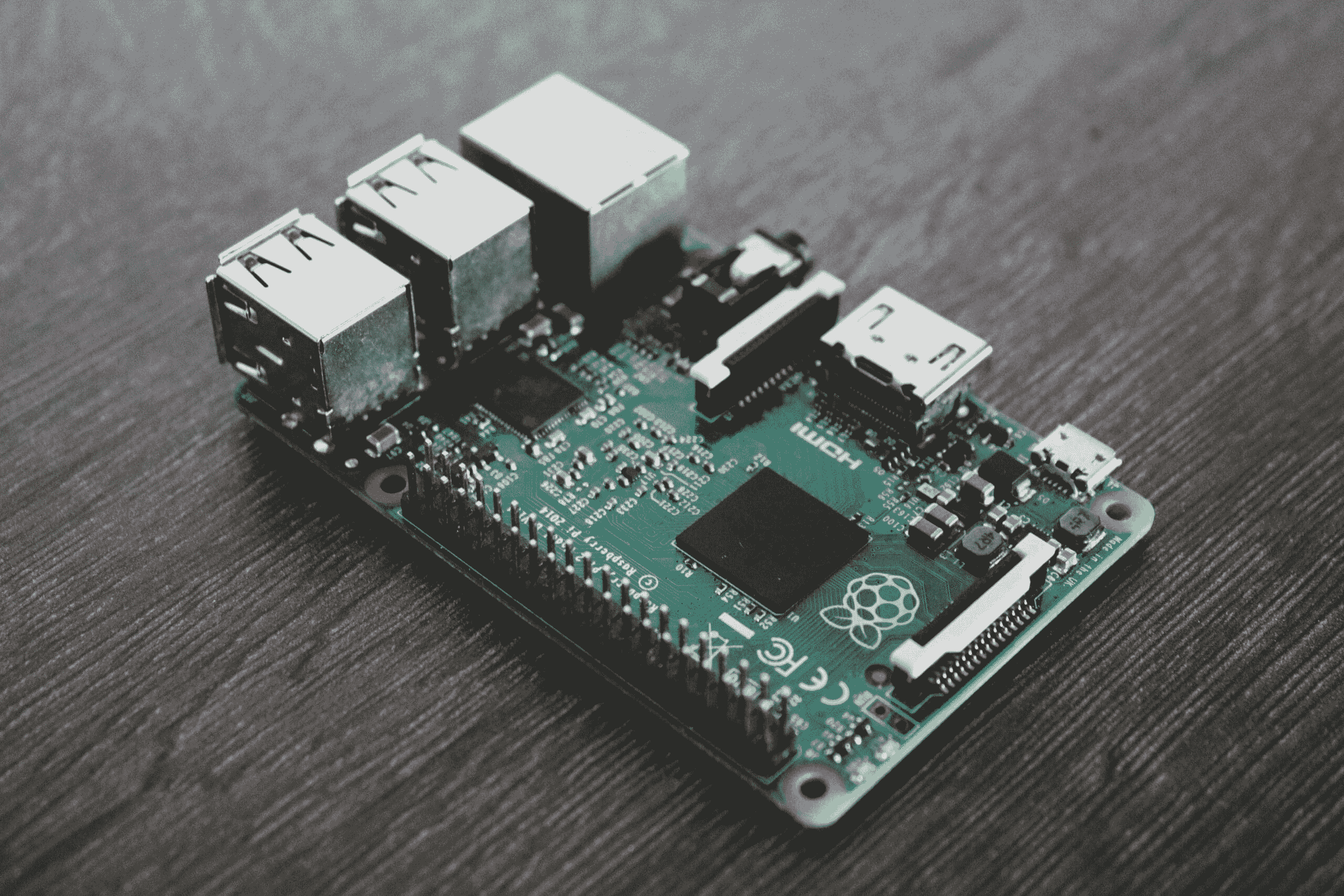

边缘上的机器学习

照片由 Alessandro Oliverio 提供

在过去的十年里,许多公司已经转向云端来存储、管理和处理数据。这似乎是一个更有前景的机器学习解决方案领域。通过在云端部署 ML 模型,你可以使用大量由第三方维护的强大服务器。你可以在最新的图形处理单元(GPUs)、张量处理单元(TPUs)和视觉处理单元(VPUs)上生成预测,而不必担心初始设置成本、可扩展性或硬件维护。此外,云解决方案提供了强大的服务器,这些服务器可以比本地服务器更快地进行推断(生成预测的过程)。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速入门网络安全职业。

1. 谷歌网络安全证书 - 快速入门网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

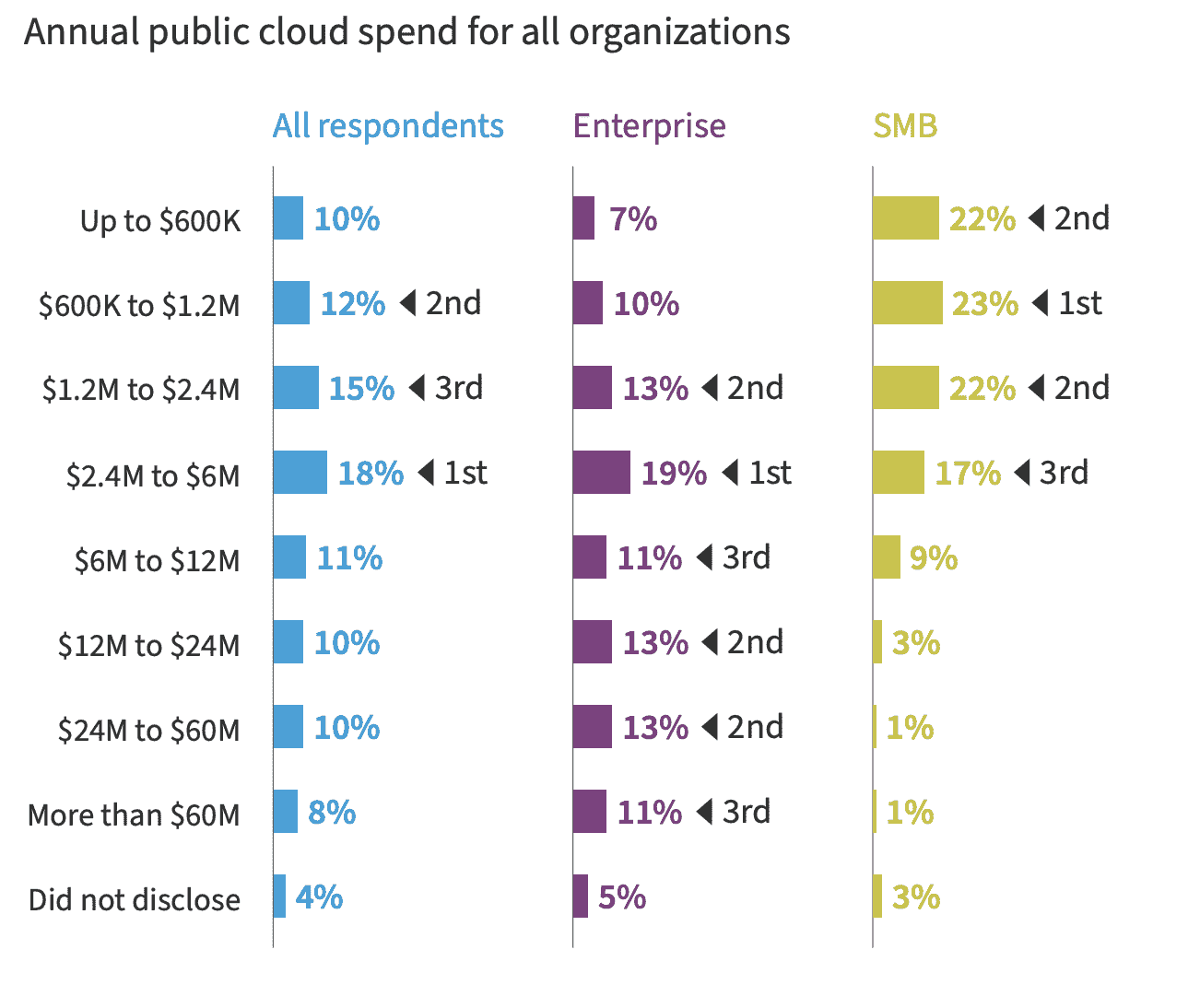

可能有人会认为在云端部署 ML 模型更便宜。毕竟,你不需要构建基础设施或维护所有内部系统。你只需为服务器使用的时间付费。然而,这种看法远非真实。云成本逐年上涨,大多数组织很难控制这些成本。Gartner 最近的报告预测,到 2022 年,终端用户在公共云服务上的支出将接近 5000 亿美元 [1]。

像 Netflix、Snapchat、Tik Tok 和 Pinterest 这样的巨大公司每年在云端账单上的支出已经达到数亿美元 [2, 3]。即便是小型和中型企业(SMBs),这笔费用也平均在一百万左右。机器学习工作负载需要大量计算,这在云端的成本很高。尽管云解决方案提供了管理 ML 应用程序的简便方法,但边缘 ML 最近也开始迅速发展。

从云端 ML 到边缘 ML

为了控制运行成本,公司开始寻找将尽可能多的计算推送到终端用户设备上的方法。这意味着将机器学习模型放在消费者设备上,这些设备可以独立进行推断,无需互联网连接,实时进行,而且没有额外成本。例如,亚马逊的 Alexa 和 Echo 是一个语音控制的虚拟助手,使用机器学习为你执行各种任务。在 2020 年 9 月,亚马逊发布了 AZ1 Neural Edge 处理器,使 Alexa 能够在设备上进行推断,而不是与云端交互。通过将计算移到边缘设备,Echo 能够以两倍的速度运行,同时由于数据在本地处理,也提供了隐私保护[4]。

性能

你可以构建一个精确度最高的最先进的机器学习模型,但如果响应时间多了几毫秒,用户可能会离开。尽管将机器学习模型部署到云端可以访问高性能的硬件,但这并不一定意味着你的应用程序的延迟会减少。通过网络传输数据通常比用特殊硬件加速模型性能的开销要大。你可以将深度学习模型的性能提高几毫秒,但网络传输的数据可能需要几秒钟。

离线推断

云计算要求你的应用程序有稳定的互联网连接,以进行持续的数据传输。而边缘计算允许你的应用程序在没有互联网连接的情况下运行。这在网络连接不可靠但应用程序严重依赖计算的区域尤为有益。例如,一款心脏监测应用可能需要实时推断以预测患者心脏的健康状况。即使互联网连接中断,模型也应在边缘设备上生成推断。

数据隐私

边缘计算提供了数据隐私的好处。用户的个人数据在靠近用户的地方处理,而不是在公司数据中心积累。这也使得数据更不容易被网络拦截。事实上,对于许多使用场景来说,边缘计算是遵守隐私合规的唯一途径。智能手机制造商越来越多地将面部识别系统集成到用户的手机解锁功能中。用户不希望他们深度个人化的数据被转移或存储在云端。

成本

可能最吸引人转向边缘机器学习的理由是你不需要支付云端计算的重复成本。如果你的模型保留在用户的设备上,所有计算都由该设备承担。模型利用消费者设备的处理能力,而不是支付云端计算费用。

边缘机器学习的当前局限性

到目前为止,你已经看到边缘机器学习如何让你获得竞争优势。然而,当前机器学习基础设施的现状表明,还需要大量的工作来有效利用这种优势。最先进的深度学习模型 notoriously 大,而在边缘设备上部署这些模型是另一个挑战。边缘设备涵盖了从智能手机到嵌入式处理器和物联网设备等各种任意硬件。真正的挑战在于如何将机器学习模型编译以优化的方式在异构硬件平台上运行。这是一个不断增长的研究领域,公司正在投入数十亿美元以领先于机器学习硬件竞赛[5]。包括 NVIDIA、苹果和特斯拉在内的大公司已经在开发自己的 AI 芯片,以优化运行特定的机器学习模型。

参考资料

-

“Gartner 预测 2022 年全球公共云终端用户支出将接近 5000 亿美元,”2022 年 4 月 19 日,Gartner,

www.gartner.com/en/newsroom/press-releases/2022-04-19-gartner-forecasts-wordwide-public-cloud-end-user-spending-to-reach-nearly-500-billion-in-2022 -

马修·古丁(Matthew Gooding),“三分之一的云计算支出浪费掉了,”2022 年 3 月 21 日,Tech Monitor

techmonitor.ai/technology/cloud/cloud-spending-wasted-oracle-computing-aws-azure -

阿米尔·埃夫拉提(Amir Efrati),凯文·麦克劳克林(Kevin McLaughlin),“随着 AWS 使用量的激增,公司对云账单感到惊讶,”2019 年 2 月 25 日,《信息报》(The Information)

www.theinformation.com/articles/as-aws-use-soars-companies-surprised-by-cloud-bills -

拉里·迪根(Larry Dignan),“亚马逊的 Alexa 在 Echo 上获得了新大脑,通过人工智能变得更聪明并旨在营造氛围,”2020 年 9 月 25 日,ZDNet,

www.zdnet.com/article/amazons-alexa-gets-a-new-brain-on-echo-becomes-smarter-via-ai-and-aims-for-ambience/ -

奇普·惠恩(Chip Huyen),“机器学习编译器和优化器的友好介绍,”2021 年 9 月 7 日,

huyenchip.com/2021/09/07/a-friendly-introduction-to-machine-learning-compilers-and-optimizers.html

Najia Gul 是 IBM 的数据科学家,专注于构建、建模、部署和维护机器学习模型。她还是数据和人工智能公司的开发者倡导者,帮助他们制作面向技术受众的内容。可以在她的个人网站找到她。

更多相关内容

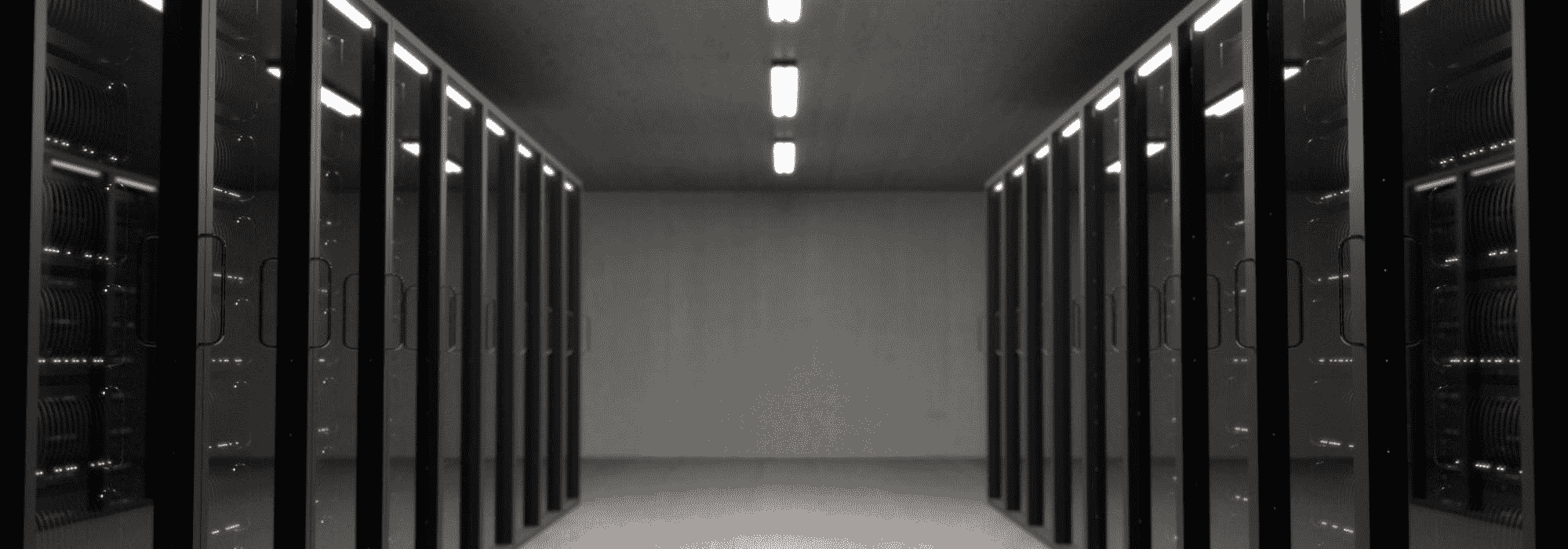

如何高效进行机器学习

原文:

www.kdnuggets.com/2018/03/machine-learning-efficiently.html

评论

评论

Radek Osmulski,自学开发者

我刚刚完成一个项目,在项目进行到 80%时,我觉得几乎没有任何进展。我投入了大量时间,但最后完全失败了。

我知道或不知道的数学,我编写代码的能力——这些都是次要的。我处理项目的方式才是问题所在。

我现在相信,构建机器学习工作的结构是有艺术性的,或说是工艺性的,而我曾经喜欢的数学重的书籍似乎都没有提到这一点。

我做了一些自我反思,回到了Jeremy Howard在Practical Deep Learning for Coders MOOC中提到的内容,这就是这篇文章的来源。

10 秒规则

我们坐在电脑前做事。对宇宙产生影响。降低预测成本或减少模型运行时间。

这里的关键词是做。这包括移动代码。重命名变量。可视化数据。疯狂地敲击键盘。

但盯着计算机屏幕空白地看两分钟,让它进行计算,以便我们可以一次次地运行它们,尽管参数稍作修改,这并不是在做事。

这也使我们面临机器学习工作的最大祸根——额外浏览器标签的诅咒。按下 ctrl+t 是如此容易,跟踪我们在做什么也变得如此困难。

这个解决方案可能听起来很荒谬,但它有效。不要让计算超过 10 秒钟,当你在处理一个问题时。

那我怎么调整我的参数呢?我怎么能对问题有任何有意义的了解?

所需的只是以一种能创建代表性样本的方式来子集你的数据。这可以用于任何领域,在大多数情况下,只需随机选择一些示例进行处理即可。

一旦你对数据进行子集划分,工作就变得互动起来。你进入了一个专注的流状态。你不断进行实验,找出什么有效,什么无效。你的手指从键盘上永远不会离开。

时间被拉长了,你所做的工作时间与如果你让自己分心时所做的工作时间不相等,甚至不如你所做的 5 小时工作。

如何构建代码以促进这种工作流程?使其非常简单地切换到在完整数据集上运行。

当你快要结束编码会话时,取消注释该单元格并运行所有代码。

成为时间浪费者

这补充了上述内容。但它还远不止这些。

根据你如何结构化代码,性能的提升可以有几个数量级的差距。了解某个操作的运行时间以及如果你做了某些更改它将运行多长时间是很有益的。你可以尝试弄清楚差异的原因,这会立即让你成为一个更好的程序员。

更重要的是,这与承诺不运行任何超过 10 秒钟的代码是密切相关的。

测试自己

一旦你在数据处理管道中犯了错误且未被发现,几乎是不可能恢复的。在很大程度上,这同样适用于模型构建(尤其是当你开发自己的组件如层等时)。

关键是随着进展不断检查数据。在转换前后查看数据。总结它。如果你知道合并后不应该有 NAs,就检查确实没有。

测试一切。

长期保持理智的唯一方法是短期内保持警惕。

急于成功

在解决问题时你应该关注的第二件事是什么(我会马上谈到第一件事)?创建一个比随机机会更好的模型,任何端到端的数据处理管道。

这可以且应该是你能想到的最简单的模型。通常这意味着线性组合。但你需要开始感受问题的本质。你需要开始建立一个可能性的基准。

比如你花了 3 天时间构建一个非常复杂的模型,但它完全没有效果,或者效果远不如你预期的那样好。你会怎么做?

在这个阶段,你一无所知。你不知道是否在处理数据时犯了错误,也不知道数据是否无用。你没有线索是否模型中可能存在问题。祝你好运,希望在没有可靠组件的情况下解开这些混乱。

此外,建立一个简单的模型可以让你从整体上看待情况。也许有缺失数据?也许类别不平衡?也许数据标签不正确?

在开始处理更复杂的模型之前,了解这些信息是很有用的。否则,你可能会构建出一个非常复杂的模型,虽然客观上可能很棒,但却完全不适合当前的问题。

不要调整参数,调整架构

“哦,如果我再加一层线性层,我相信模型会表现得更好”

“也许再增加 0.00000001 的 dropout 会有帮助,看起来我们对训练集的拟合有点过度了”

尤其是在早期,调整超参数是绝对适得其反的。但这确实非常诱人。

这几乎不需要任何工作,而且很有趣。你可以看到计算机屏幕上的数字变化,感觉像是你在学习一些东西并取得进展。

这只是一种幻象。更糟糕的是,你可能会过拟合你的验证集。每次你运行模型并根据验证损失进行更改时,你都会使模型的泛化能力受到惩罚。

你更好地投资时间于探索架构。你会学到更多。突然间,集成变得可能。

解放小鼠

你计划使用电脑多长时间?即使我偶然变得富有到不再需要工作一天,我仍会每天使用电脑。

如果你打网球,你会练习每一个动作。你甚至可能会花钱请人告诉你如何在特定击球时调整手腕的位置!

但现实是,你最多只会打这么多小时的网球。为什么不对使用电脑也同样认真呢?

使用鼠标是不自然的。它很慢。需要复杂且精确的动作。从任何上下文中,你只能访问有限的操作集合。

使用键盘让你感到自由。老实说,我也不知道为什么它会有如此大的差别。但确实如此。

一个人在用电脑时没有使用鼠标。

最后但同样重要的是

除非你有一个好的验证集,否则你做的任何事情都没有意义。

我可以推荐给你最终的资源。这是一篇直言不讳且基于实践的文章。

如何(以及为什么)创建一个好的验证集 由 Rachel Thomas 撰写。

如果你觉得这篇文章有趣并且想保持联系,你可以在 Twitter 上 这里 找到我。

简介: Radek Osmulski 是一位自学成才的开发者,对机器学习充满热情。他是 Fast.ai 国际研究员,并且是该领域的积极学生。你可以在 Twitter 上 这里 与他联系。

原文。经许可转载。

相关:

-

关于机器学习你需要知道的 5 件事

-

机器学习新手的十大算法导览

-

用 Python 精通机器学习的 7 个步骤

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能。

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 需求

更多相关内容

在加密数据上进行机器学习

原文:

www.kdnuggets.com/2022/08/machine-learning-encrypted-data.html

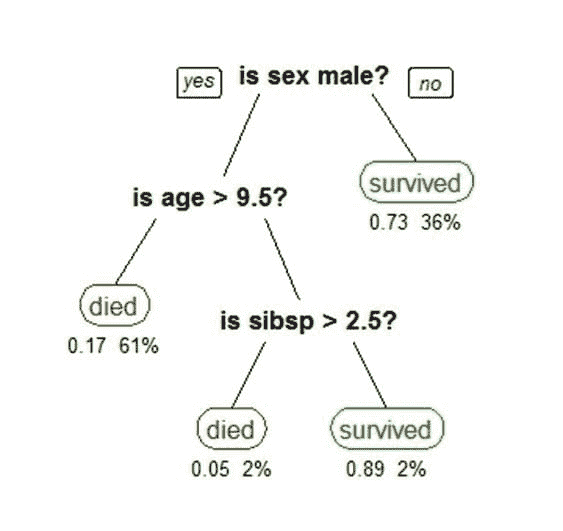

本博客介绍了一种隐私保护机器学习(PPML)解决方案,用于 Kaggle 上的泰坦尼克挑战,使用Concrete-ML开源工具包。其主要目标是展示全同态加密(FHE)如何用于保护数据,同时使用机器学习模型进行预测而不降低其性能。在这个例子中,将考虑XGBoost分类器模型,因为它实现了接近最先进的准确度。

我们的前 3 名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持组织中的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持组织中的 IT 工作

竞赛

Kaggle是一个在线社区,让任何人都可以围绕机器学习和数据科学构建和分享项目。它提供数据集、课程、示例和竞赛,任何愿意发现或提升自己领域知识的数据科学家都可以免费使用。其简易性使其成为 ML 社区中最受欢迎的平台之一。

此外,Kaggle 提供了几个难度不同的教程,供新手开始在真实例子中操作基本数据科学工具。在这些教程中可以找到Titanic 竞赛。它通过使用一组简单的乘客数据来介绍一个二分类问题,这些乘客在悲惨的泰坦尼克号船难中旅行。

Concrete-ML 团队为本次竞赛发送的 Jupyter Notebook 可以在此处找到。它是借助几个其他公开可用的笔记本创建的,以提供清晰的指南和高效的结果。

准备工作

在能够构建模型之前,需要进行一些准备步骤。

包要求

Concrete-ML 是一个 Python 包,因此代码使用这种编程语言编写。还需要一些额外的包,包括用于数据预处理的 Pandas 框架以及一些 scikit-learn 交叉验证工具。

import numpy as np

import pandas as pd

from sklearn.model_selection import GridSearchCV, ShuffleSplit

from xgboost import XGBClassifier

from concrete.ml.sklearn import XGBClassifier as ConcreteXGBClassifier

清洗数据

Kaggle 平台提供了训练数据集和测试数据集。完成这些后,让我们加载数据并提取目标 ID。

train_data = pd.read_csv("./local_datasets/titanic/train.csv")

test_data = pd.read_csv("./local_datasets/titanic/test.csv")

datasets = [train_data, test_data]

test_ids = test_data["PassengerId"]

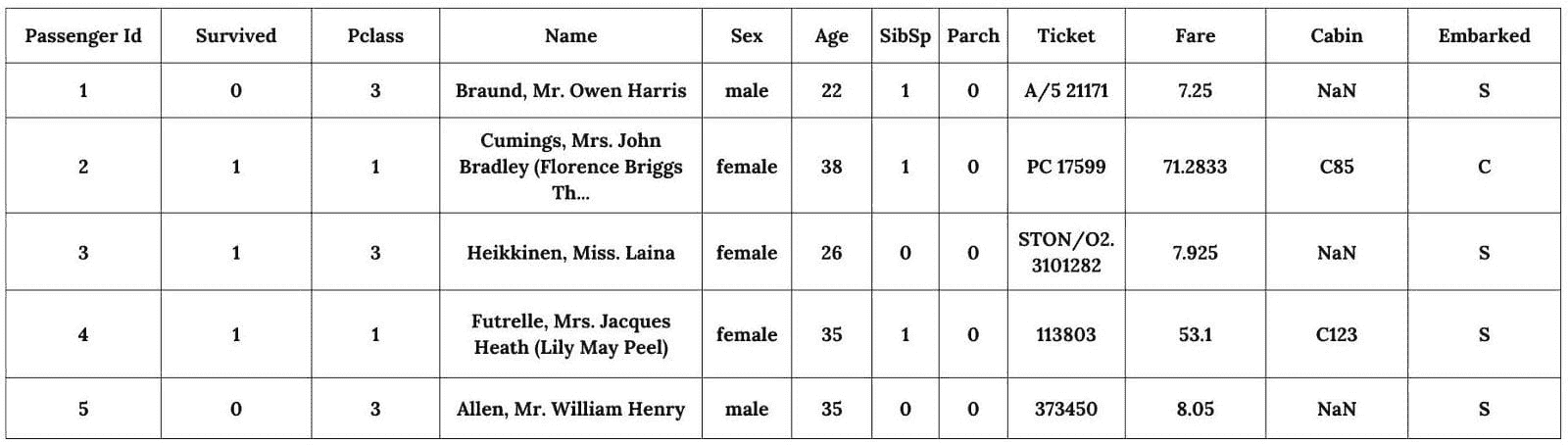

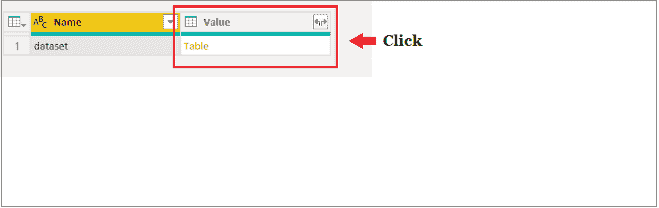

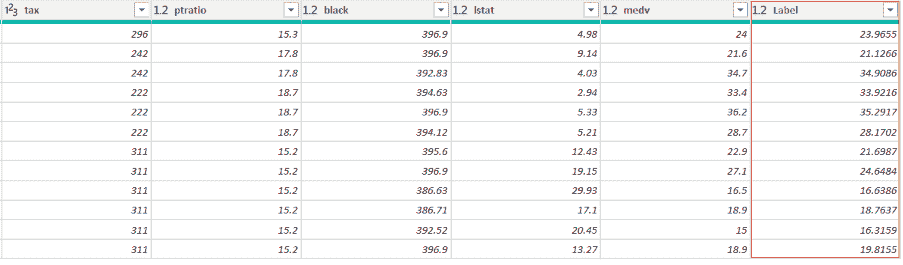

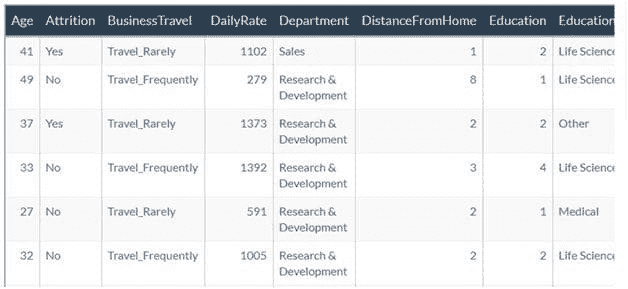

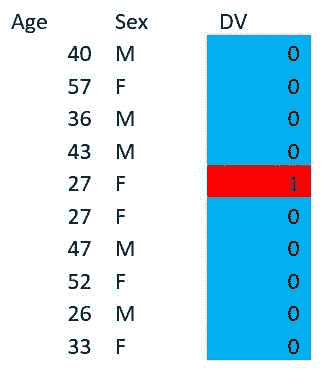

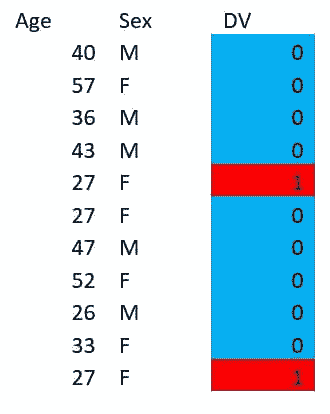

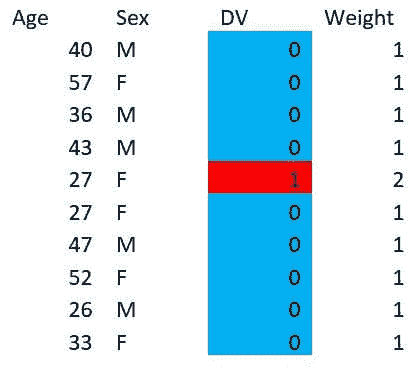

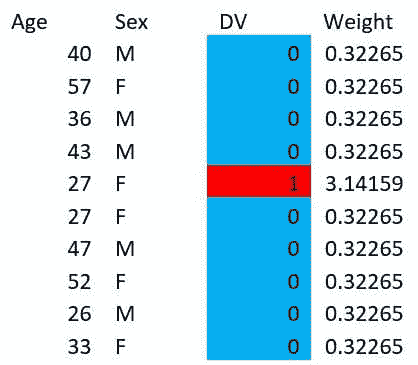

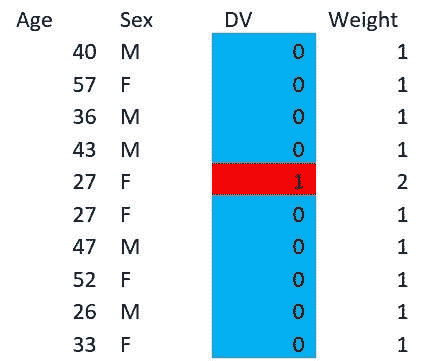

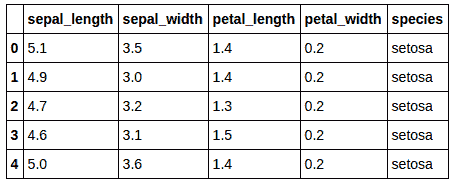

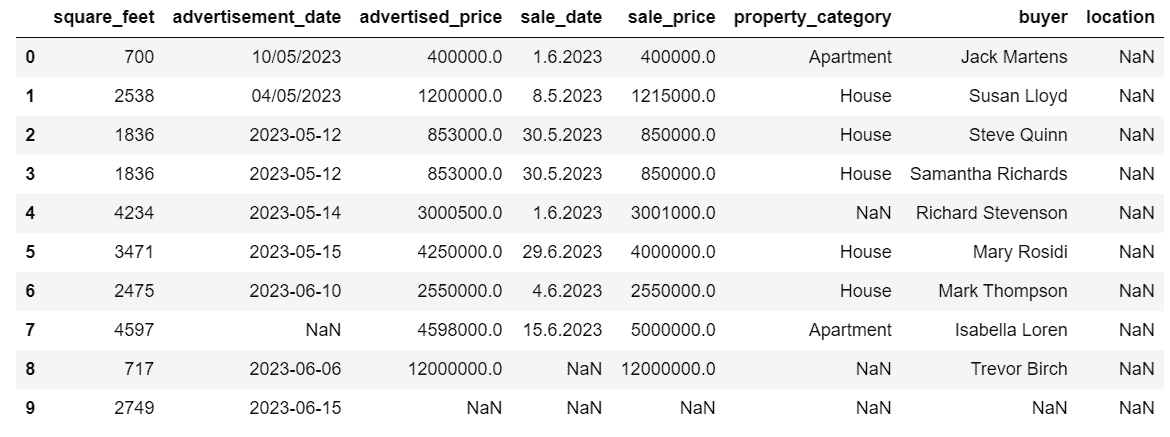

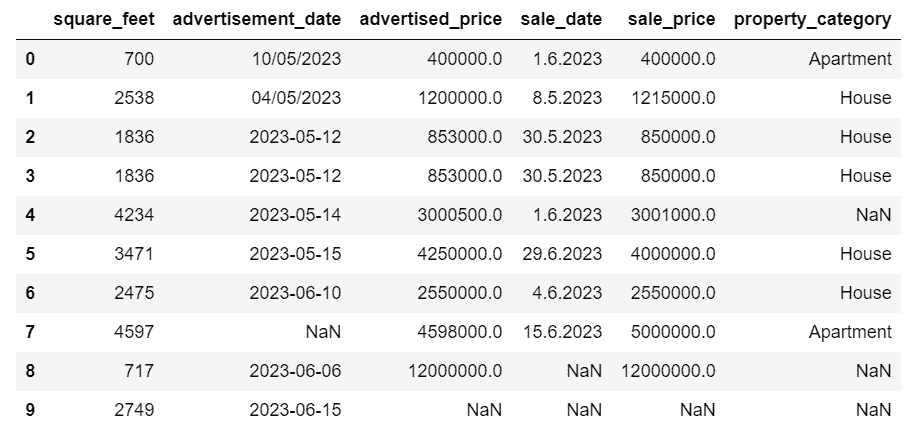

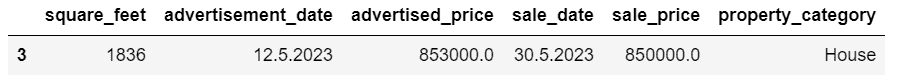

数据的样子如下:

可以做出以下几项陈述:

-

目标变量是 Survived 变量。

-

一些变量是数值型的,如 PassengerID、Pclass、SbSp、Parch 或 Fare。

-

一些变量是类别型的(非数值型的),如 Name、Sex、Ticket、Cabin 或 Embarked。

第一步预处理是删除 PassengerId 和 Ticket 变量,因为它们似乎是随机标识符,对生存没有影响。此外,我们注意到 Cabin 变量中有些值缺失。因此,我们必须通过打印每个变量缺失值的总数来进一步调查这一观察结果。

print(train_data.isnull().sum())

print(test_data.isnull().sum())

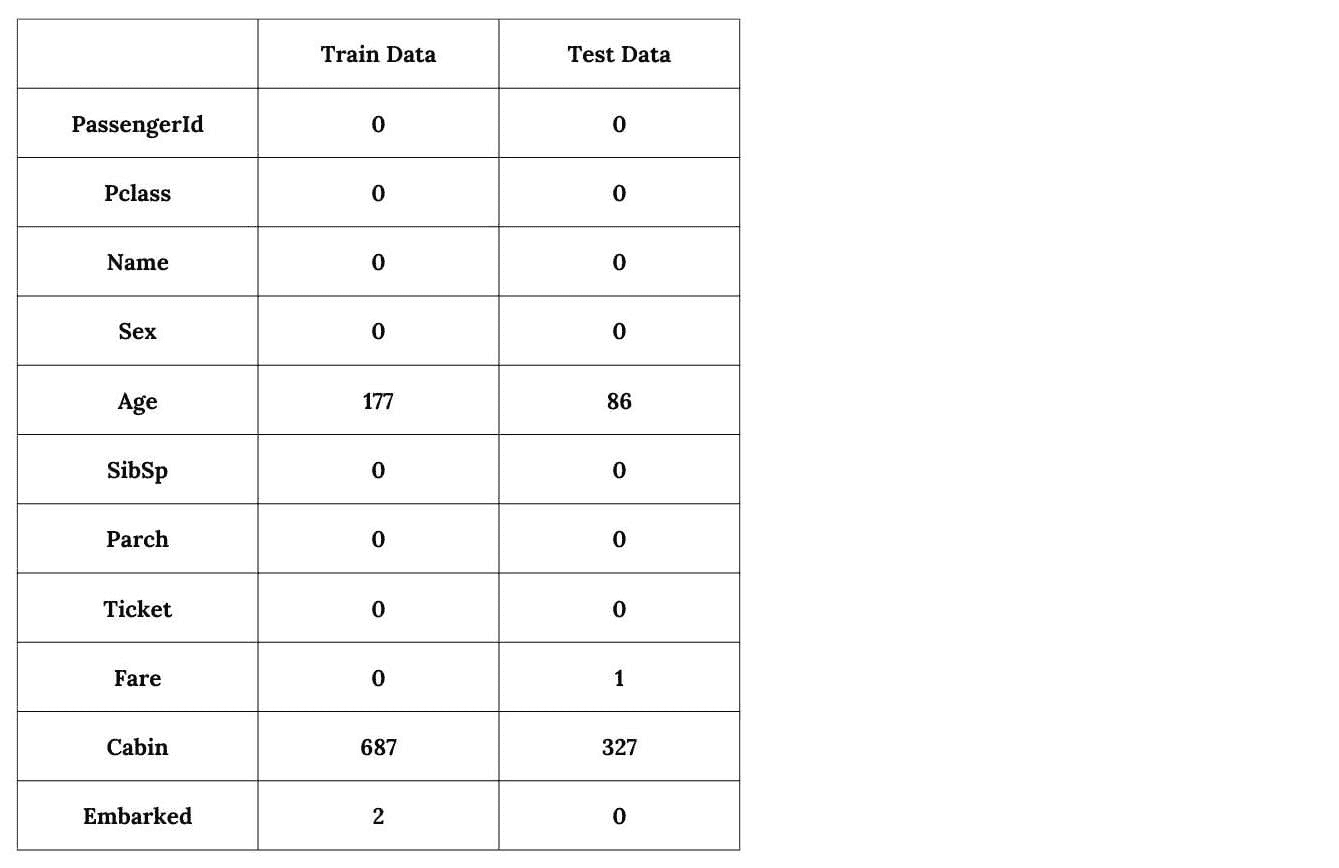

这将输出以下结果。

似乎有四个变量是不完整的,即 Cabin、Age、Embarked 和 Fare。然而,Cabin 变量似乎缺失的数据最多:

for incomp_var in train_data.columns:

missing_val = pd.concat(datasets)[incomp_var].isnull().sum()

if missing_val > 0 and incomp_var != "Survived":

total_val = pd.concat(datasets).shape[0]

print(

f"Percentage of missing values in {incomp_var}: "

f"{missing_val/total_val*100:.1f}%"

)

Percentage of missing values in Cabin: 77.5%

Percentage of missing values in Age: 20.1%

Percentage of missing values in Embarked: 0.2%

Percentage of missing values in Fare: 0.1%

由于 Cabin 变量缺失了超过 2/3 的值,因此保留它也可能不合适。因此,我们从两个数据集中删除这些变量。

drop_column = ["PassengerId", "Ticket", “Cabin”]

for dataset in datasets:

dataset.drop(drop_column, axis=1, inplace=True)

关于其他三个存在缺失值的变量,删除它们可能会丢失大量可能帮助模型预测乘客生存的相关信息。对于年龄变量尤其如此,因为其值中有超过 20% 缺失。因此,可以使用其他技术来填补这些不完整的变量。由于年龄和票价都是数值型的,缺失值可以用现有数据的中位数来替代。对于类别变量 Embarked,我们使用最常见的值作为替代。

for dataset in datasets:

dataset.Age.fillna(dataset.Age.median(), inplace=True)

dataset.Embarked.fillna(dataset.Embarked.mode()[0], inplace=True)

dataset.Fare.fillna(dataset.Fare.median(), inplace=True)

工程新特征

此外,我们还可以从已有的变量中手动创建新变量,以帮助模型更好地解释一些行为,从而提高预测准确性。在所有可用的选项中,选择了四个新特征:

-

家庭规模:个人旅行时所陪伴的家庭成员数,1 表示单独旅行。

-

IsAlone:一个布尔变量,表示个人是否单独旅行(1)或非单独旅行(0)。这可能帮助模型强调旅行时是否与亲属同行。

-

标题:个人的称谓(如先生、女士等),通常表示某种社会地位。

-

Farebin 和 AgeBin:Fare 和 Age 变量的分箱版本。它将值分组在一起,通常减少了轻微观察误差的影响。

我们为两个数据集创建这些新变量。

# Function that helps generating proper bin names

def get_bin_labels(bin_name, number_of_bins):

labels = []

for i in range(number_of_bins):

labels.append(bin_name + f"_{i}")

return labels

for dataset in datasets:

dataset["FamilySize"] = dataset.SibSp + dataset.Parch + 1

dataset["IsAlone"] = 1

dataset.IsAlone[dataset.FamilySize > 1] = 0

dataset["Title"] = dataset.Name.str.extract(

r" ([A-Za-z]+)\.", expand=False

)

dataset["FareBin"] = pd.qcut(

dataset.Fare, 4, labels=get_bin_labels("FareBin", 4)

)

dataset["AgeBin"] = pd.cut(

dataset.Age.astype(int), 5, labels=get_bin_labels("AgeBin", 5)

)

# Removing outdated variables

drop_column = ["Name", "SibSp", "Parch", "Fare", "Age"]

dataset.drop(drop_column, axis=1, inplace=True)

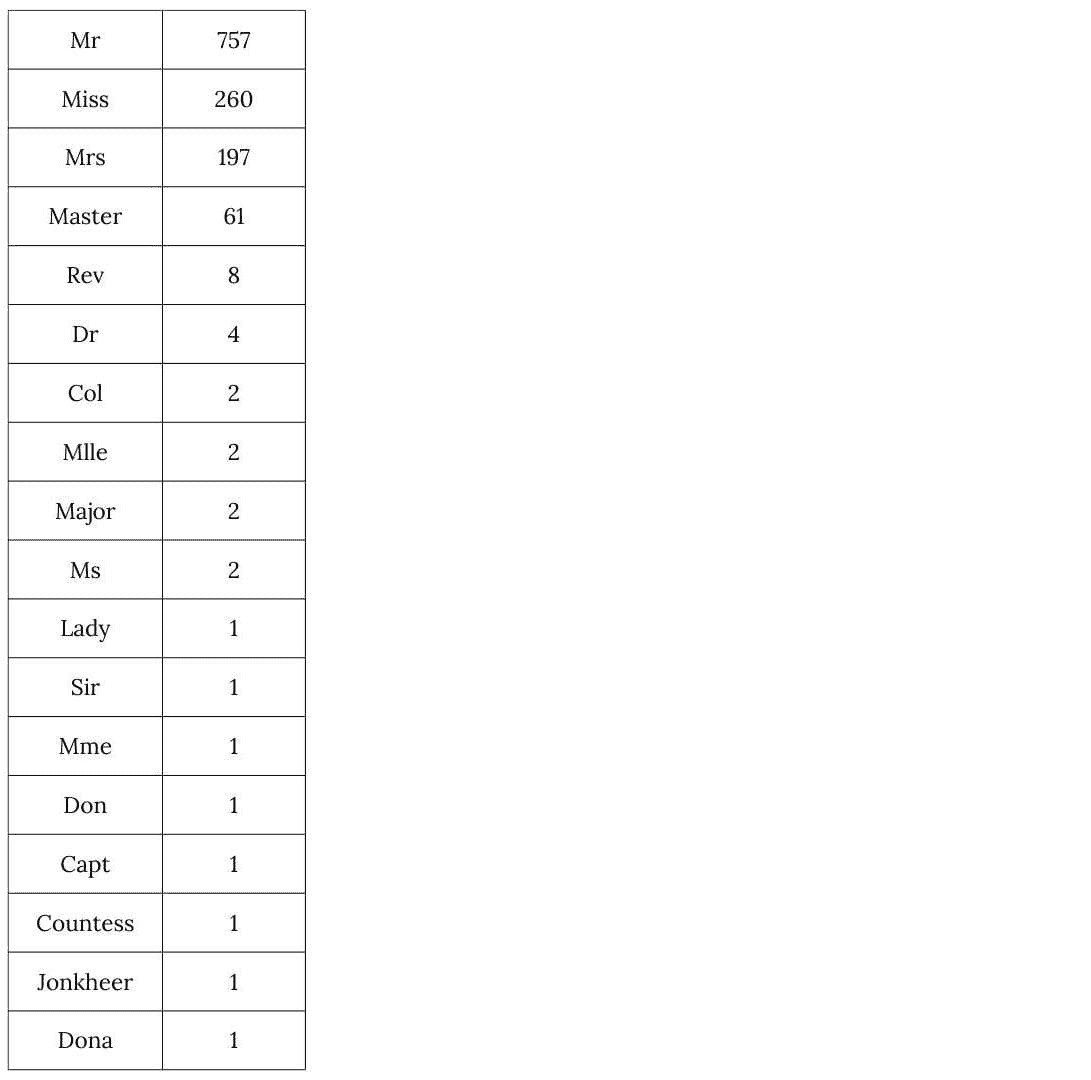

此外,打印数据集中的不同标题显示,只有少数几个标题代表了大多数个体。

data = pd.concat(datasets)

titles = data.Title.value_counts()

print(titles)

为了防止模型变得过于特定,将所有“少见”的标题归为一个新的“Rare”变量。

uncommon_titles = titles[titles < 10].index

for dataset in datasets:

dataset.Title.replace(uncommon_titles, "Rare", inplace=True)

应用虚拟化

最后,我们可以对剩余的分类变量进行“虚拟化”。虚拟化是一种将分类(非数值)数据转换为数值数据的常见技术,无需映射值或考虑它们之间的任何顺序。其思想是提取变量中所有不同的值,并创建一个新的相关的二进制变量。

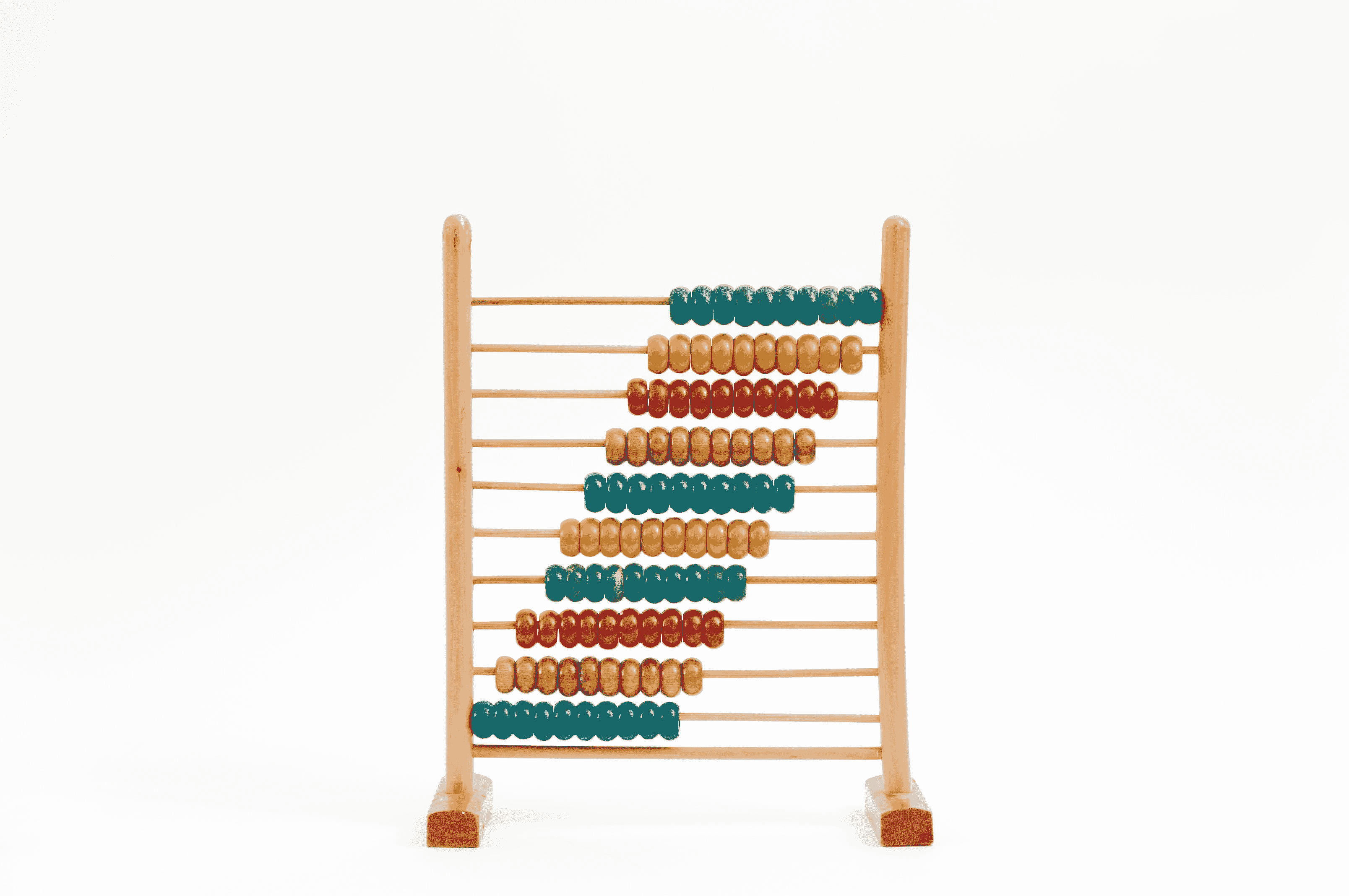

例如,“Embarked”变量有三个分类值,“S”、“C”和“Q”。虚拟化数据将创建三个新变量,“Embarked_S”、“Embarked_C”和“Embarked_Q”。然后,“Embarked_S”(或“Embarked_C”和“Embarked_Q”)的值对于在“Embarked”变量中最初标记为“S”(或“C”和“Q”)的每个数据点设置为 1,否则设置为 0。

categorical_features = train_data.select_dtypes(exclude=np.number).columns

x_train = pd.get_dummies(train_data, prefix=categorical_features)

x_test = pd.get_dummies(test_data, prefix=categorical_features)

x_test = x_test.to_numpy()

然后,我们将目标变量与其他变量分开,这是训练之前的必要步骤。

target = "Survived"

x_train = x_train.drop(columns=[target])

x_train = x_train.to_numpy()

y_train = train_data[target].to_numpy()

构建模型

使用 XGBoost 进行训练

首先,使用 XGBoost 构建一个分类模型。由于需要事先固定几个参数,我们使用 scikit-learn 的 GridSearchCV 方法进行交叉验证,以最大化找到最佳参数的机会。给定的范围故意较小,以保持每次推理的 FHE 执行时间相对较低(低于 10 秒)。实际上,我们发现,在这个特定的 Titanic 示例中,具有更多估算器或最大深度的模型并没有显著提高准确率。然后,我们使用训练集来拟合这个模型。

cv = ShuffleSplit(n_splits=5, test_size=0.3, random_state=0)

param_grid = {

"max_depth": list(range(1, 5)),

"n_estimators": list(range(1, 5)),

"learning_rate": [0.01, 0.1, 1],

}

model = GridSearchCV(

XGBClassifier(), param_grid, cv=cv, scoring="roc_auc"

)

model.fit(x_train, y_train)

使用 Concrete-ML 进行训练

现在,让我们使用 Concrete-ML 的 XGBClassifier 方法进行相同的操作。

为了做到这一点,我们需要指定输入、输出和权重将被量化的位数。这个值会影响模型的精度及其推理运行时间,因此可能导致网格搜索交叉验证找到不同的参数集。在我们的例子中,将该值设置为 2 位可以在更快的运行速度下获得出色的准确度评分。

param_grid["n_bits"] = [2]

x_train = x_train.astype(np.float32)

concrete_model = GridSearchCV(

ConcreteXGBClassifier(), param_grid, cv=cv, scoring="roc_auc"

)

concrete_model.fit(x_train, y_train)

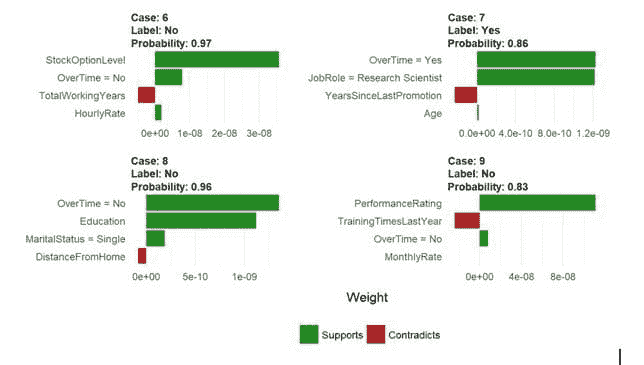

Concrete-ML API 设计得尽可能接近最常见的机器学习和深度学习 Python 库,以使其使用尽可能简单。此外,它使任何数据科学家可以在没有加密知识的情况下使用 Zama 的技术。因此,构建和拟合 FHE 兼容的模型对任何习惯于使用 scikit-learn 工具等常见数据科学工作流程的人来说,都变得非常直观和方便。实际上,这些观察对于预测过程仍然有效,只需考虑几个额外的步骤。

预测结果

首先,我们使用 XGBoost 模型在清晰的环境中计算预测结果。

clear_predictions = model.predict(x_test)

此外,也可以使用 Concrete-ML 模型在清晰的环境中计算预测。这将本质上执行库的 XGBoost 版本的模型,并考虑量化过程。这里不涉及任何 FHE 相关的计算。

clear_quantized_predictions = concrete_model.predict(x_test)

为了使用 FHE 实现相同的功能,需要额外的编译步骤。通过提供一个用于表示可达值范围的输入数据子集,编译方法构建一个适当的 FHE 电路,该电路将在预测过程中执行。请注意,execute_in_fhe 参数也需要设置为 True。

fhe_circuit = concrete_model.best_estimator_.compile(x_train[:100])

fhe_predictions = concrete_model.best_estimator_.predict(

x_test, execute_in_fhe=True

)

使用配备 8 个 11 代 Intel® Core™ i5-1135G7 处理器(2.40GHz,4 核心,每个核心 2 线程)的机器,每次推理的平均执行时间在 2 到 3 秒之间。这不包括密钥生成时间,密钥生成仅在所有预测之前发生一次,时间不超过 12 秒。

此外,FHE 计算预计是准确的。这意味着 FHE 中执行的模型会产生与 Concrete-ML 模型相同的预测,后者在清晰的环境中执行并仅考虑量化。

number_of_equal_preds = np.sum(

fhe_predictions == clear_quantized_predictions

)

pred_similarity = number_of_equal_preds / len(clear_predictions) * 100

print(

"Prediction similarity between both Concrete-ML models"

f"(quantized clear and FHE): {pred_similarity:.2f}%"

)

Concrete-ML 模型(量化清晰和 FHE)之间的预测相似度:100.00%

然而,正如之前所见,网格搜索交叉验证是在 XGBoost 模型和 Concrete-ML 模型之间分别进行的。因此,这两个模型没有共享相同的超参数集合,使它们的决策边界不同。

因此,逐一比较它们的预测结果的相似性是不相关的,应该仅考虑 Kaggle 平台给出的最终准确性分数来评估它们的表现。

因此,我们将 XGBoost 和 Concrete-ML 模型的预测结果保存为 csv 文件。然后,可以使用这个 链接 在 Kaggle 平台上提交这些文件。FHE 模型的准确率约为 78%,可在公开的 排行榜 上查看。相比之下,XGBoost 清晰模型的得分为 77%。

实际上,使用给定的数据集,大多数提交的笔记本似乎都没有超过 79% 的准确率。因此,额外的预处理和特征工程可能有助于提高我们当前的分数,但可能不会提高太多。

submission = pd.DataFrame(

{

"PassengerId": test_ids,

"Survived": fhe_predictions,

}

)

submission.to_csv("titanic_submission_fhe.csv", index=False)

submission = pd.DataFrame(

{

"PassengerId": test_ids,

"Survived": clear_predictions,

}

)

submission.to_csv("titanic_submission_xgb_clear.csv", index=False)

感谢阅读!我们的主要目标不仅是建立一个预测模型来回答“哪些人更可能生存?”这个问题,还要在加密数据上实现这一点。

这一切得益于我们的 Python 包:Concrete-ML,旨在简化数据科学家对全同态加密(FHE)的使用。

Roman Bredehoft 是 Zama 的机器学习工程师。

更多相关信息

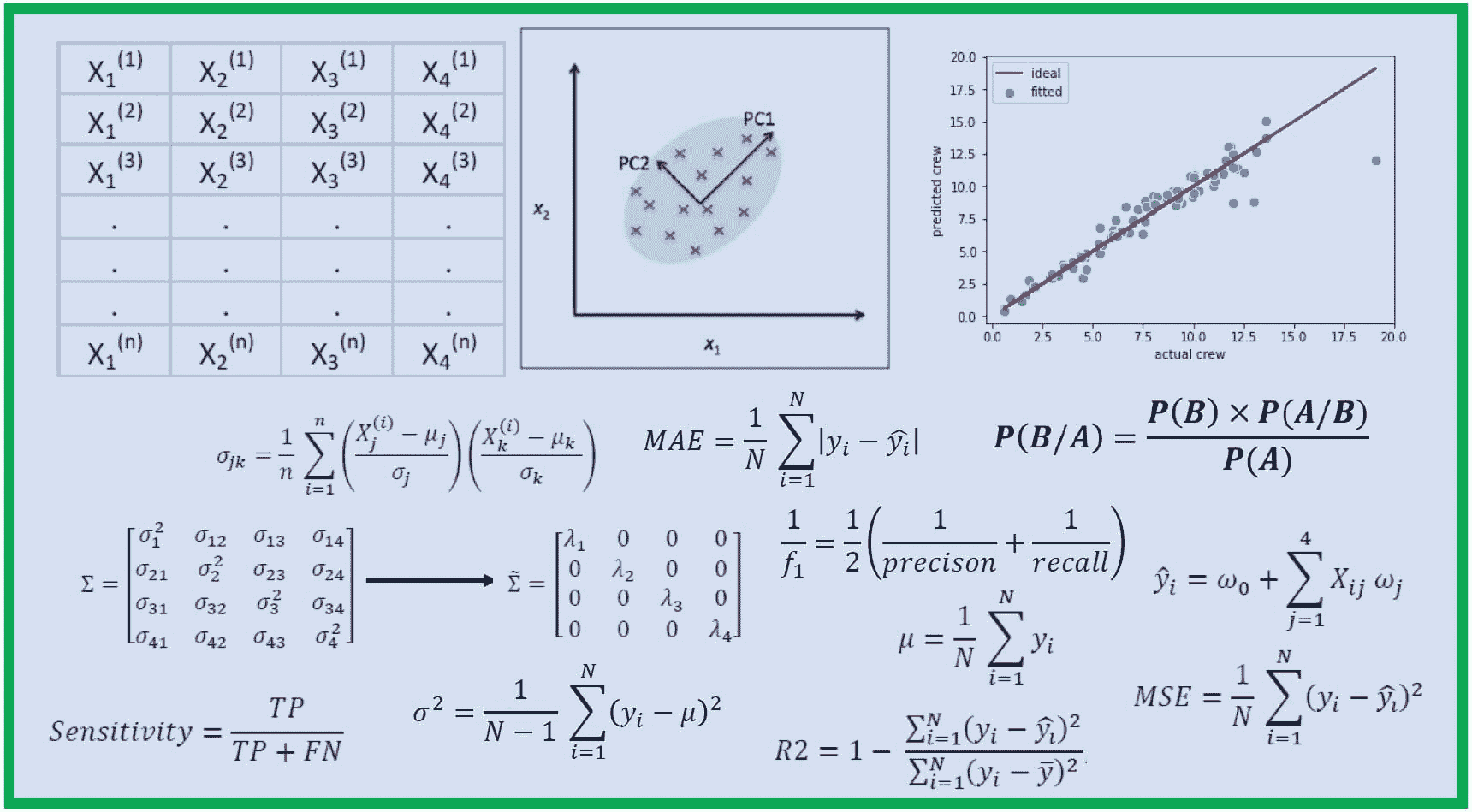

机器学习评估指标:理论与概述

原文:

www.kdnuggets.com/machine-learning-evaluation-metrics-theory-and-overview

作者插图

构建一个在新数据上表现良好的机器学习模型是非常具有挑战性的。需要对其进行评估,以了解模型是否足够好,或者是否需要一些修改来提高性能。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT 需求

如果模型没有从训练集中学习到足够的模式,它将在训练集和测试集上表现不佳。这就是所谓的欠拟合问题。

对训练数据的模式,包括噪声,过度学习会导致模型在训练集上表现非常好,但在测试集上表现不佳。这种情况称为过拟合。如果训练集和测试集上的表现相似,可以获得模型的泛化能力。

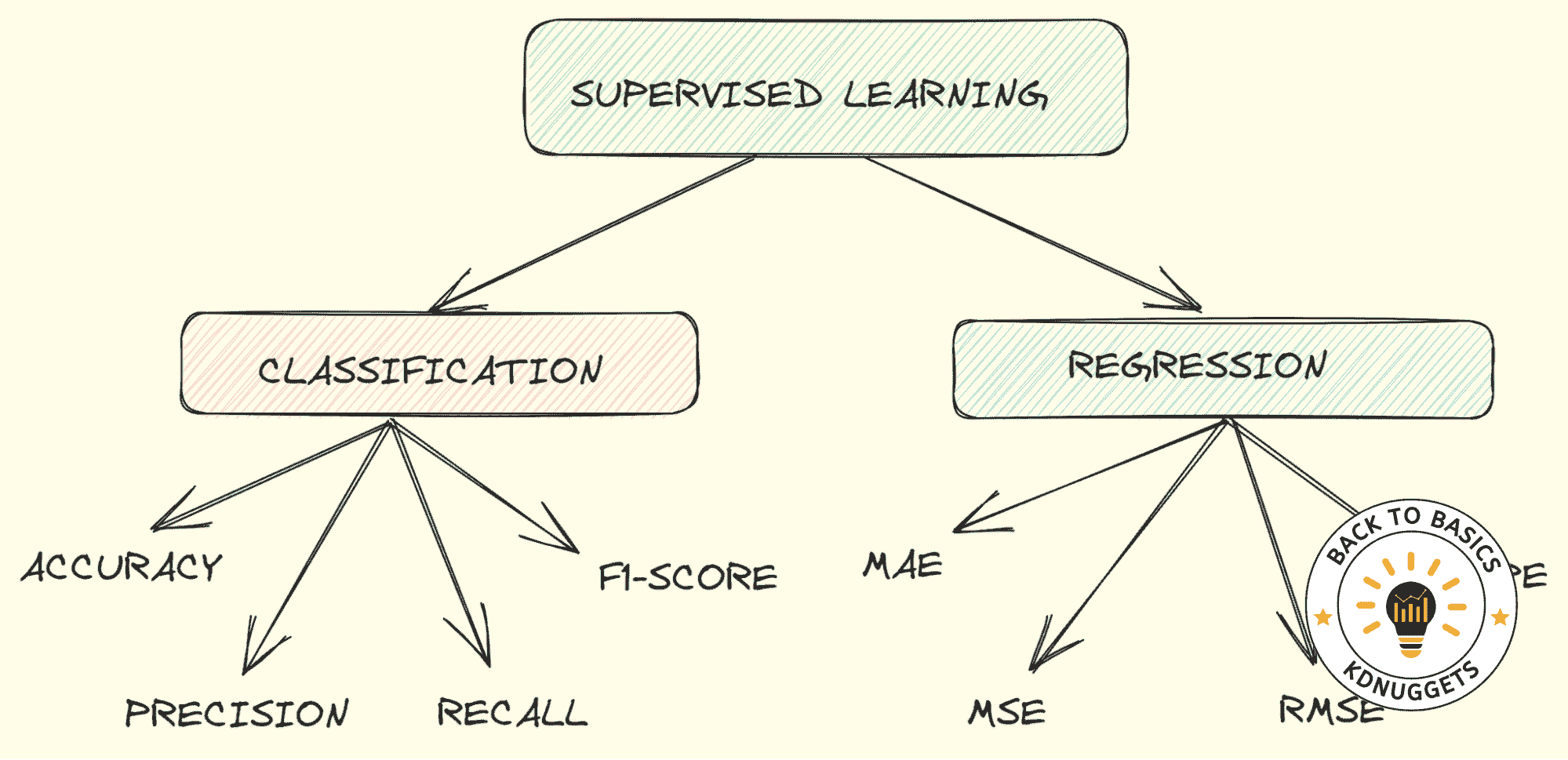

在本文中,我们将探讨分类和回归问题中最重要的评估指标,这些指标将帮助验证模型是否能够很好地捕捉训练样本中的模式,并在未知数据上表现良好。让我们开始吧!

分类

当我们的目标是分类时,我们就面对一个分类问题。最合适的指标选择取决于不同的方面,比如数据集的特征、是否不平衡以及分析的目标。

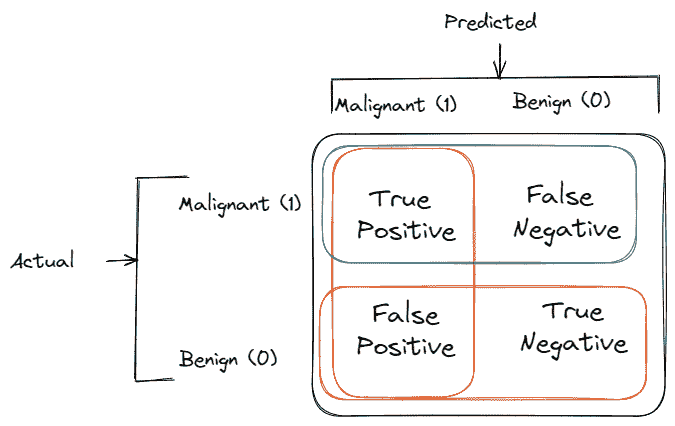

在展示评估指标之前,有一个重要的表格需要解释,叫做混淆矩阵,它很好地总结了分类模型的表现。

假设我们想训练一个模型来从超声图像中检测乳腺癌。我们只有两类:恶性和良性。

-

真正例:预测为恶性癌症的终末期病人数量

-

真负例:预测为良性癌症的健康人数量

-

假正例:预测为恶性癌症的健康人数量

-

假负例:预测为良性癌症的终末期病人数量

混淆矩阵示例。作者插图。

准确度

准确度是评估分类模型最著名和最受欢迎的指标之一。它是正确预测的分数除以样本数量。

当我们知道数据集是平衡的时,使用准确度。因此,输出变量的每个类别有相同数量的观察值。

使用准确度,我们可以回答问题:“模型是否正确预测了所有类别?”因此,我们有正类(恶性癌症)和负类(良性癌症)的正确预测。

精确度

与准确度不同,精确度是用于类别不平衡时的分类评估指标。

精确度回答以下问题:“恶性癌症识别的比例实际上是正确的吗?”它是通过真正阳性和正预测之间的比率计算的。

如果我们担心假阳性并希望将其最小化,我们会使用精确度。最好避免因恶性癌症的虚假信息而影响健康人的生活。

假阳性数量越少,精确度越高。

召回率

召回率与精确度一起,是应用于输出变量类别观察数量不同的另一种指标。召回率回答以下问题:“我能识别出多少比例的恶性癌症患者?”。

如果我们的关注点集中在假阴性上,我们就关心召回率。假阴性指的是患者实际患有恶性癌症,但我们未能识别出来。然后,应该监控召回率和精确度,以在未知数据上获得理想的表现。

F1-分数

同时监控精确度和召回率可能会很麻烦,因此最好有一个可以总结这两个指标的度量。这可以通过 F1-分数来实现,F1-分数定义为精确度和召回率的调和平均数。

高 F1-分数是因为精确度和召回率都具有高值。如果召回率或精确度值较低,F1-分数将受到惩罚,结果也会较低。

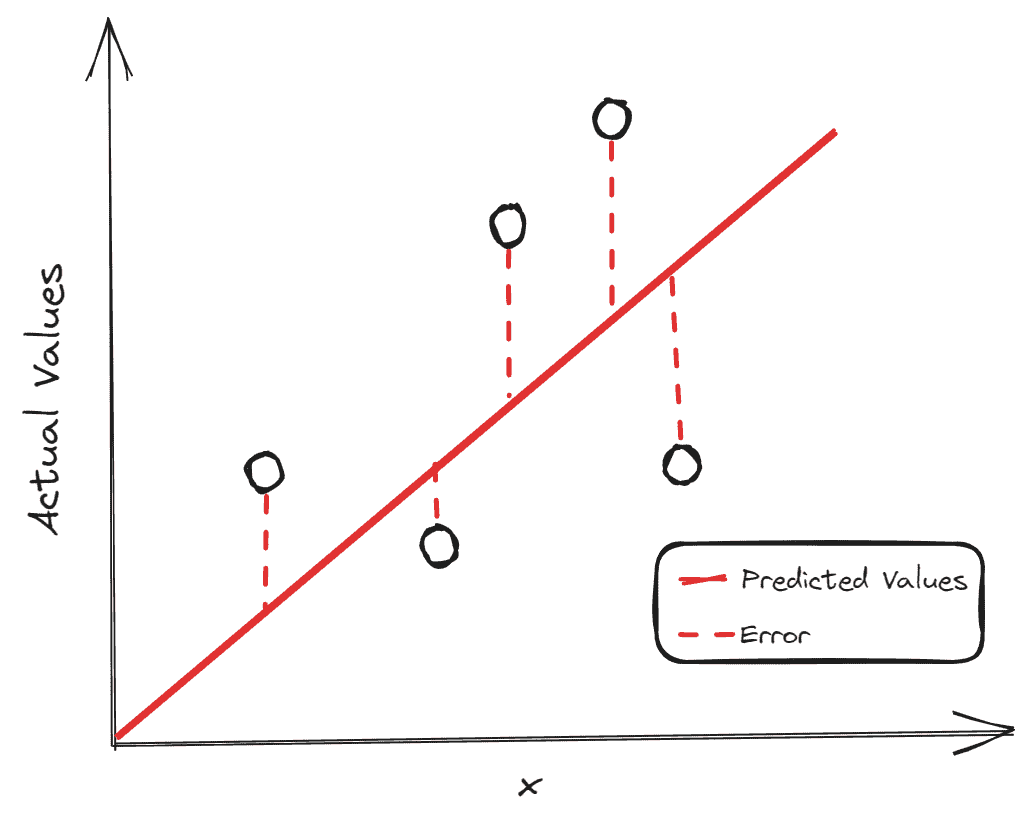

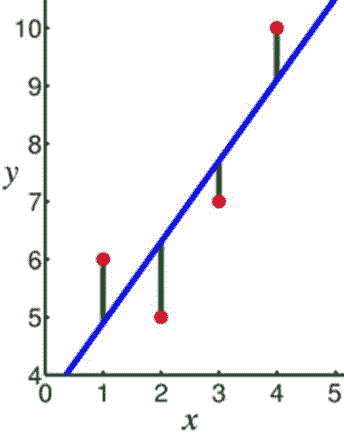

回归

作者插图

当输出变量是数值时,我们处理的是回归问题。与分类问题一样,根据分析的目的选择评估回归模型的指标至关重要。

回归问题最常见的例子是房价预测。我们是否关注准确预测房价?还是只关心最小化总体误差?

在所有这些指标中,构建块是残差,即预测值与实际值之间的差异。

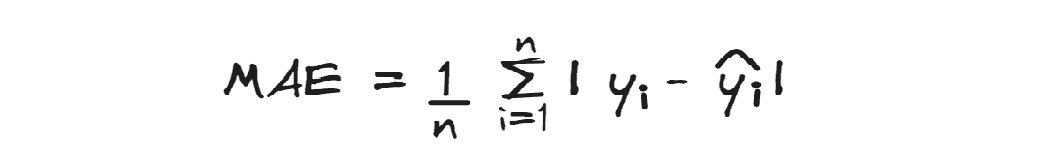

MAE

均绝对误差计算的是平均绝对残差。

它没有像其他评估指标那样对高误差进行惩罚。每个误差都被同等对待,即使是异常值的误差,所以这个指标对异常值具有鲁棒性。此外,差异的绝对值忽略了误差的方向。

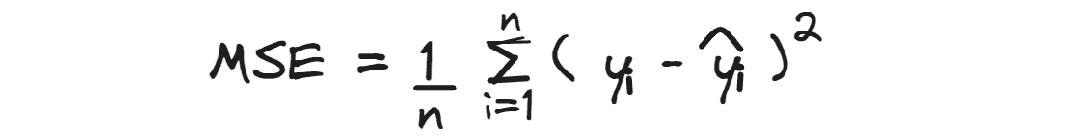

MSE

均方误差计算的是平均平方残差。

由于预测值与实际值之间的差异被平方,它对较大的误差赋予了更多的权重,

因此,当大的误差不可接受时,它可能比最小化总体误差更有用。

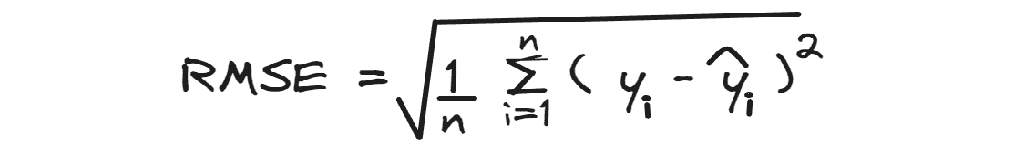

RMSE

均方根误差计算的是 平方根 的平均平方残差。

当你理解了 MSE 后,稍作停留即可掌握均方根误差,它只是 MSE 的平方根。

RMSE 的优点在于它更容易解释,因为该指标的尺度与目标变量的尺度一致。除了形状外,它与 MSE 非常相似:它总是对较大的差异赋予更多的权重。

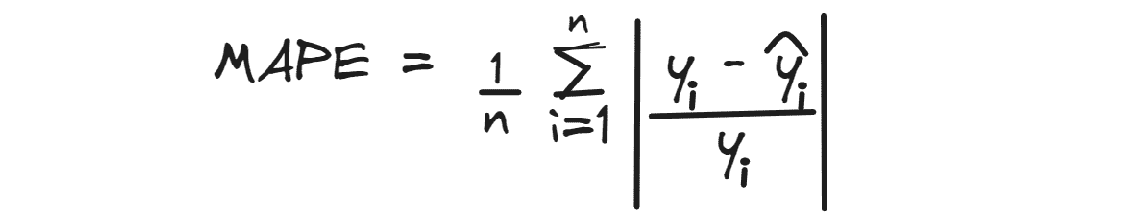

MAPE

均绝对百分比误差计算的是预测值与实际值之间的平均绝对百分比差异。

像 MAE 一样,它忽略了误差的方向,理想的最佳值是 0。

例如,如果我们在预测房价时得到一个 MAPE 值为 0.3,这意味着平均而言,预测值低于实际值 30%。

结束语

我希望你喜欢这次评估指标的概述。我只涵盖了评估分类和回归模型性能的最重要的度量标准。如果你发现了其他对解决问题非常有帮助但没有在此提及的关键指标,请在评论中告诉我。

尤金尼亚·安内洛 目前是意大利帕多瓦大学信息工程系的研究员。她的研究项目集中在持续学习与异常检测的结合上。

更多相关主题

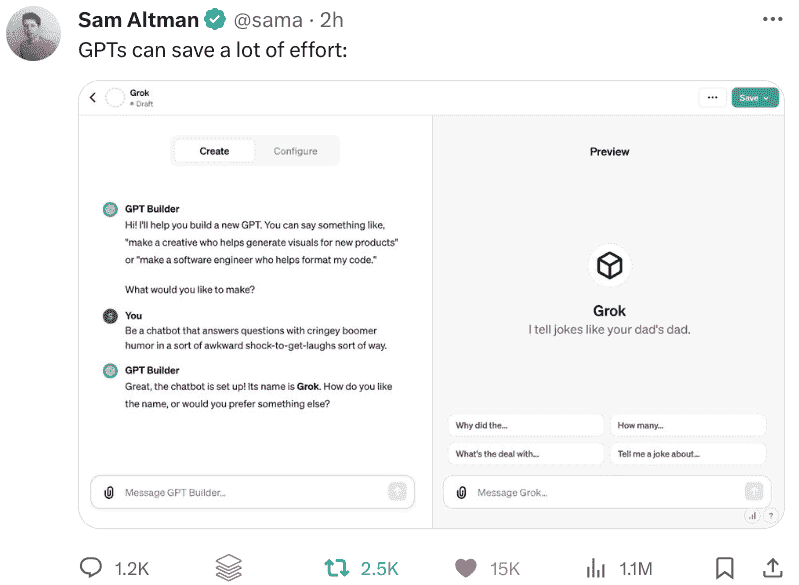

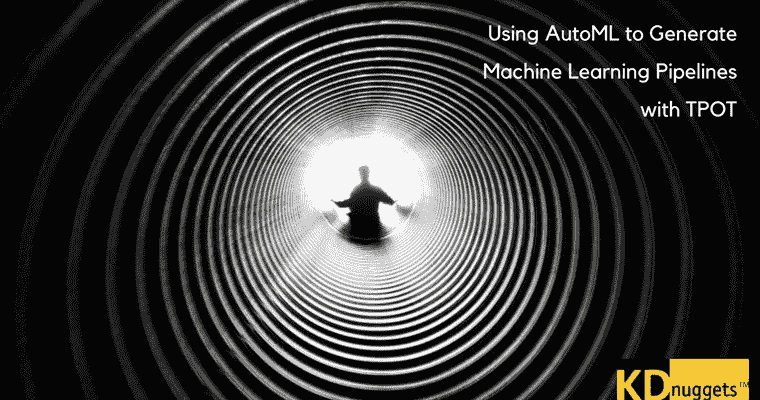

机器学习适合每个人!

原文:

www.kdnuggets.com/2022/10/machine-learning-everybody.html

机器学习适合每个人的截屏

现在是 2022 年。机器学习适合谁呢?

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的信息技术

3. Google IT 支持专业证书 - 支持你的组织的信息技术

机器学习适合每个人!

或者,至少,这就是feeCodeCamp 的新视频课程的名称,由讲师凯莉·英编排。该课程旨在向完全的初学者介绍机器学习的基础知识。

来自课程视频的 YouTube 页面:

以一种对绝对初学者友好的方式学习机器学习。你将学习机器学习的基本知识,并了解如何使用 TensorFlow 实现许多不同的概念。

该课程不仅向新手介绍概念,还让你立即用代码实现这些概念。因此,虽然这是针对机器学习初学者的课程,但并不适合编程初学者。

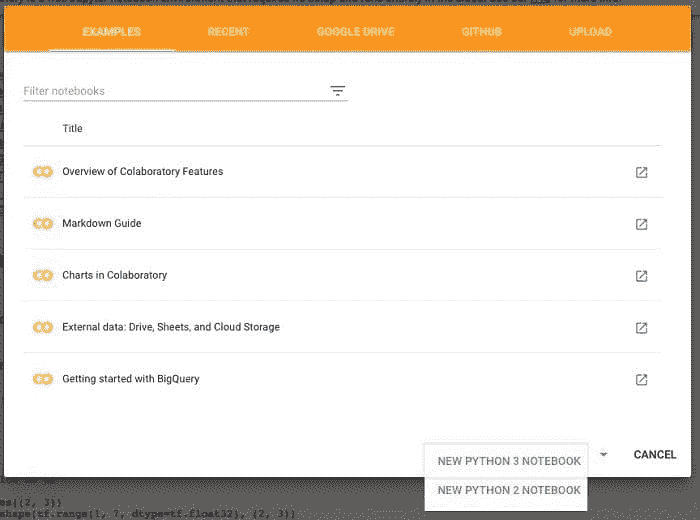

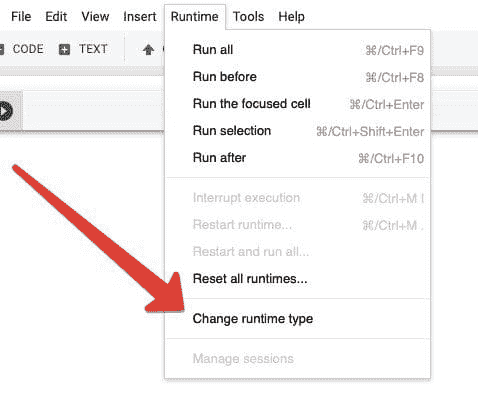

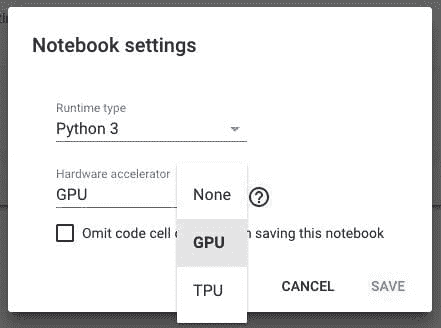

首先,这门课程从最基础的内容开始,比如入门级的 Google Colab、机器学习的基本概念、特征是什么、分类和回归是什么、数据准备和模型训练的意义等。接着,你将深入机器学习领域,学习如 K-近邻、朴素贝叶斯、逻辑回归和支持向量机等算法的理论和实现。

课程的其余部分将关注神经网络和 TensorFlow。你将学习如何在 TensorFlow 中实现分类器,了解带有神经元的线性回归,使用 TensorFlow 实现回归神经网络,以及 K-均值聚类。课程最后将介绍主成分分析及 K-均值和 PCA 的实现。

你可以在这里找到这门课程,也可以在下面找到。

凯莉做得很好,确保机器学习适合每个人。你的任务是享受将其变得适合你的过程。

马修·梅约 (@mattmayo13) 是一名数据科学家,并且是 KDnuggets 的主编,这是一个开创性的在线数据科学和机器学习资源。他的兴趣包括自然语言处理、算法设计与优化、无监督学习、神经网络和自动化机器学习方法。马修拥有计算机科学硕士学位和数据挖掘研究生文凭。你可以通过 editor1 at kdnuggets[dot]com 联系他。

更多相关话题

《Python 中的机器学习练习:入门教程系列》

原文:

www.kdnuggets.com/2017/07/machine-learning-exercises-python-introductory-tutorial-series.html

作者:John Wittenauer,数据科学家。

编辑说明: 本教程系列于 2014 年 9 月开始,8 期教程在 2 年内发布。我提及这一点是为了将约翰的第一段话置于背景中,并向读者保证,这个包括所有代码的系列教程在今天仍然与写作时一样相关和最新。这些资料非常棒,无论是对于参加 Andrew Ng 的 MOOC 课程的人,还是作为独立资源。

今年我职业发展中的一个关键时刻是发现了 Coursera。我听说过“MOOC”现象,但一直没时间深入学习课程。今年早些时候,我终于下定决心报名参加 Andrew Ng 的机器学习课程。我完成了整个课程,包括所有编程练习。这段经历让我认识到了这种教育平台的力量,从此我就迷上了它。

本博客文章将是系列中的第一篇,涵盖 Andrew 课程中的编程练习。我不太喜欢课程中使用 Octave 做作业的一个方面。虽然 Octave/Matlab 是一个很好的平台,但大多数现实世界的“数据科学”都是用 R 或 Python 完成的(当然还有其他语言和工具在使用,但这两种毫无疑问位列前茅)。由于我正在努力提高我的 Python 技能,所以我决定从头开始用 Python 做这些练习。完整的源代码可以在我的 IPython Github 仓库找到。如果你感兴趣,你还会在根目录的子文件夹中找到这些练习所用的数据和原始练习 PDF。

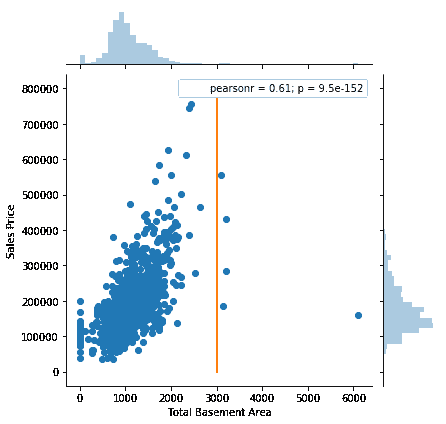

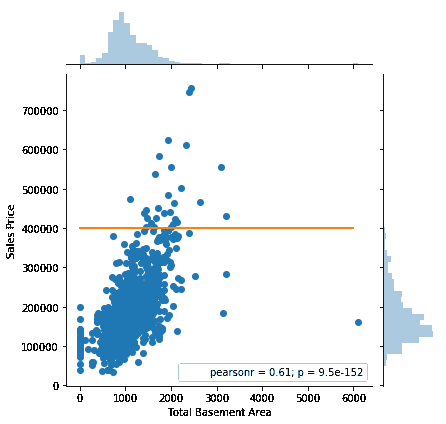

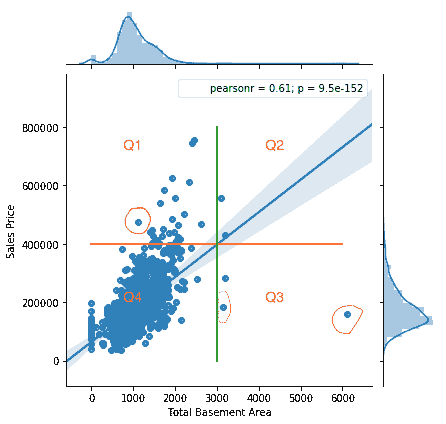

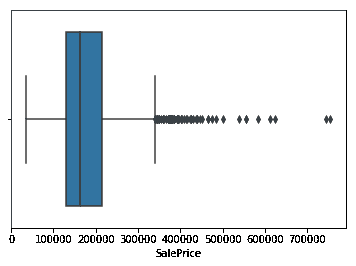

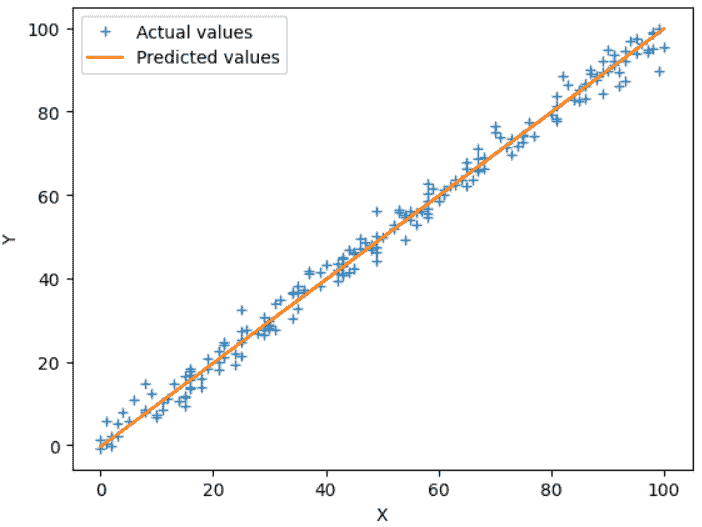

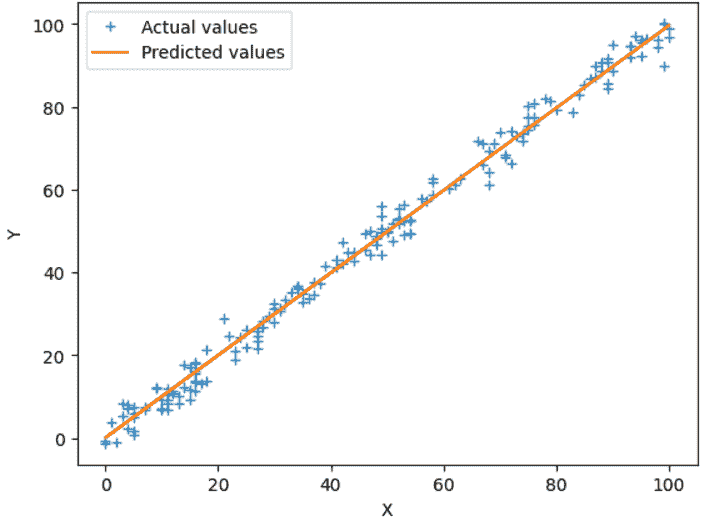

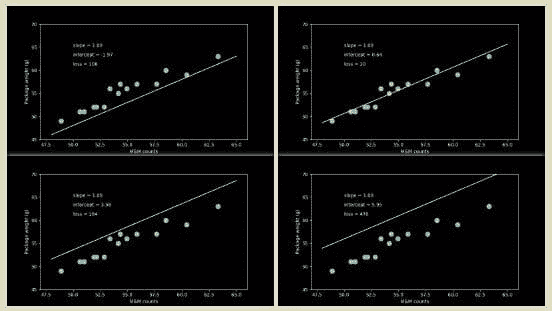

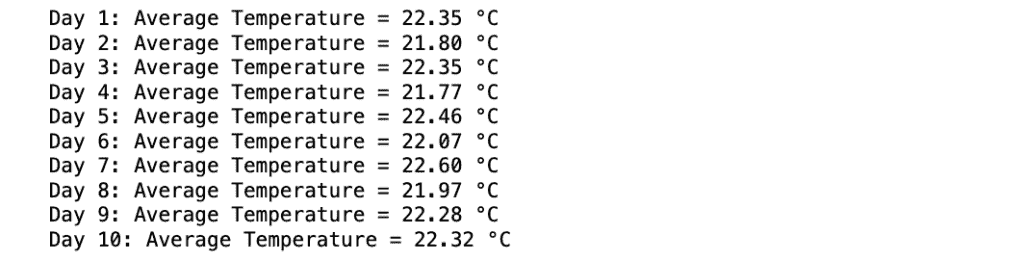

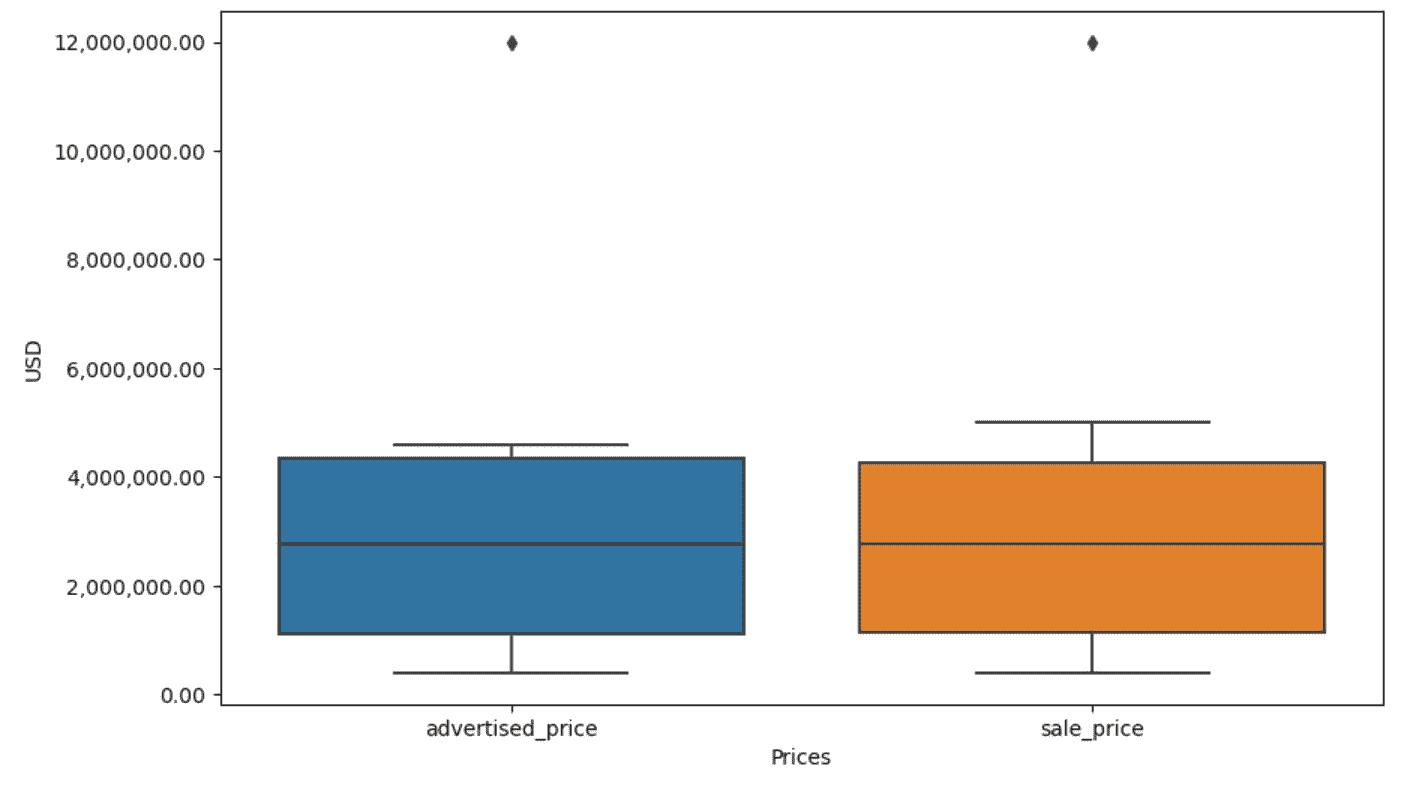

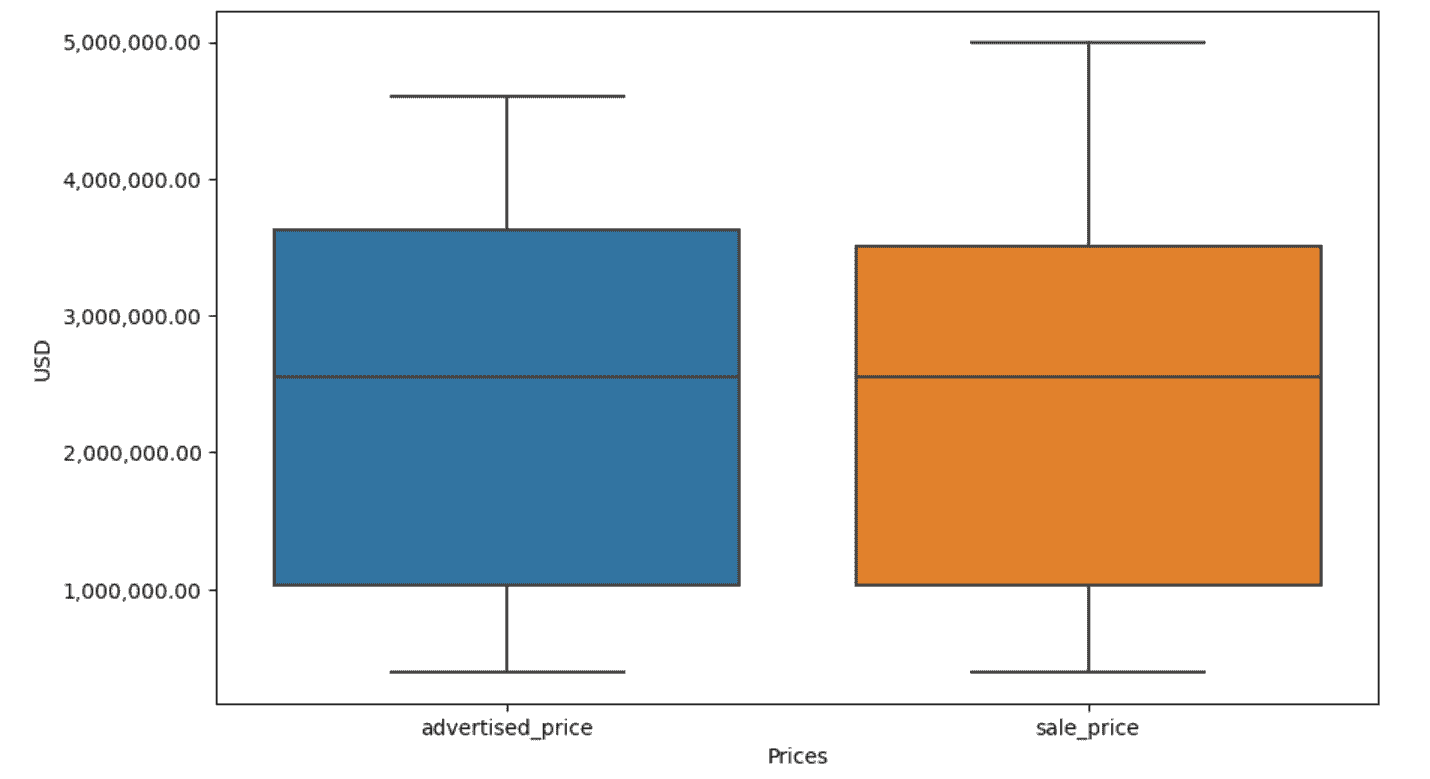

在我关于 Python 机器学习系列的第一部分中,我们介绍了安德鲁·恩的机器学习课程第一部分的内容。在这篇文章中,我们将通过完成第二部分的练习来总结第一部分。如果你还记得,在第一部分中,我们实现了线性回归来预测新食品卡车的利润,这些卡车将被放置在某个城市中。第二部分的任务是预测房屋的销售价格。这次的不同之处在于我们有多个因变量。我们得到的输入包括房屋的平方英尺数以及卧室的数量。我们能否轻松扩展之前的代码来处理多元线性回归?让我们来看看吧!

在系列的第二部分中,我们总结了使用梯度下降法实现多元线性回归,并将其应用于一个简单的房价数据集。在这篇文章中,我们将目标从预测一个连续值(回归)转变为将结果分类为两个或更多离散类别(分类),并将其应用于学生录取问题。假设你是一个大学部门的管理员,你想根据申请人在两个考试中的成绩来确定每个申请人的录取机会。你有来自先前申请人的历史数据,可以用作训练集。对于每个训练样本,你都有申请人在两个考试中的得分以及录取决策。为此,我们将构建一个分类模型,该模型使用一种名为逻辑回归的稍微让人困惑的技术,根据考试成绩估计录取概率。

在本系列的第三部分中,我们实现了简单和正则化逻辑回归,完成了安德鲁·恩机器学习课程第二个练习的 Python 实现。然而,我们的解决方案有一个限制——它仅适用于二分类问题。在这篇文章中,我们将扩展之前练习的解决方案,以处理多类分类问题。在此过程中,我们将涵盖第三部分的前半部分,并为下一个重要话题——神经网络做好准备。

在第四部分中,我们通过扩展解决方案来处理多类分类,并在手写数字数据集上进行测试,从而完成了逻辑回归的实现。仅使用逻辑回归,我们就能够达到约 97.5% 的分类准确率,这相当不错,但几乎达到了线性模型的极限。在这篇博客文章中,我们将再次处理手写数字数据集,但这次使用带有反向传播的前馈神经网络。我们将实现未正则化和正则化的神经网络成本函数版本,并通过反向传播算法计算梯度。最后,我们将通过优化器运行算法,并评估网络在手写数字数据集上的表现。

我们现在正接近课程内容和这系列博客文章的最后阶段。在这个练习中,我们将使用支持向量机(SVM)来构建一个垃圾邮件分类器。我们将从一些简单的二维数据集开始使用 SVM 以了解其工作原理。然后我们将查看一组电子邮件数据,并利用 SVM 在处理过的邮件上构建分类器,以确定它们是否是垃圾邮件。

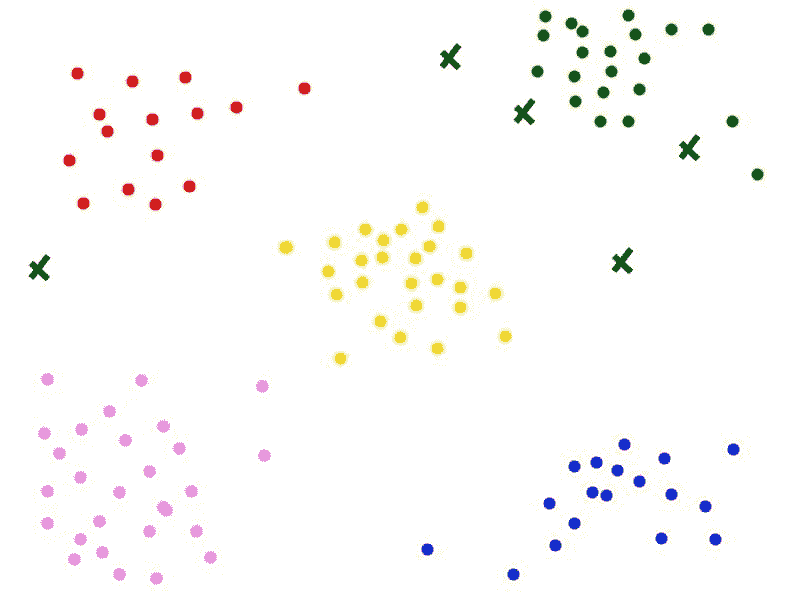

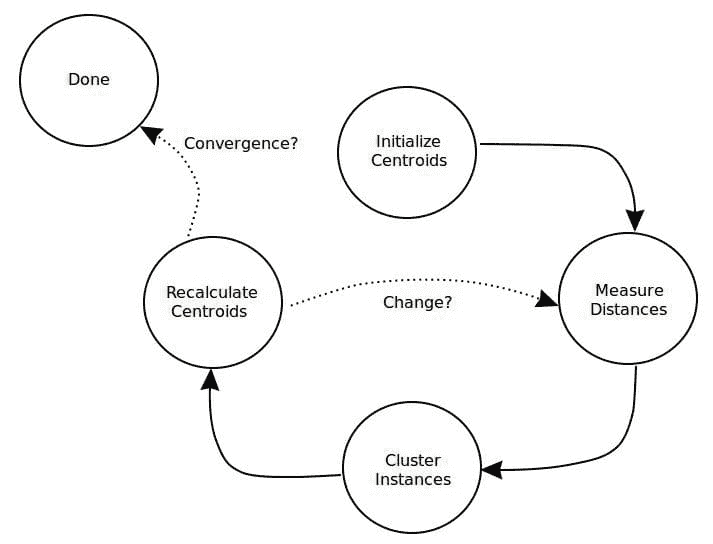

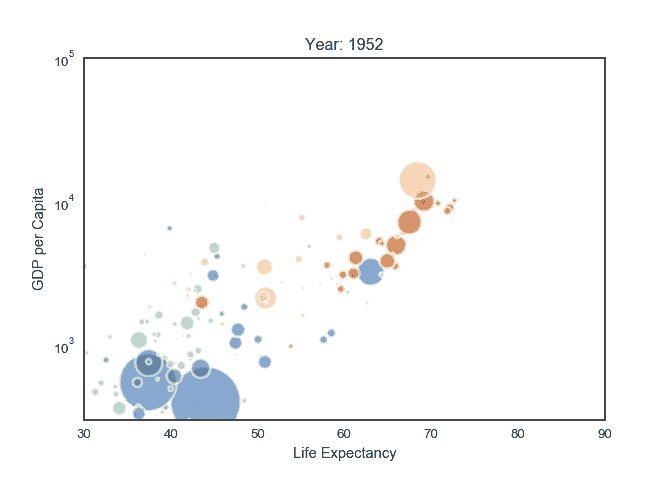

我们现在只剩下这系列中的最后两篇文章了!在这一部分中,我们将讨论两个引人入胜的主题:K 均值聚类和主成分分析(PCA)。K 均值和 PCA 都是无监督学习技术的例子。无监督学习问题没有任何标签或目标供我们学习以进行预测,因此无监督算法试图从数据本身中学习一些有趣的结构。我们将首先实现 K 均值,并看看它如何用于压缩图像。我们还将实验 PCA,以找到人脸图像的低维表示。

我们现在已经到达这一系列的最后一篇文章!这是一次有趣的旅程。安德鲁的课程做得非常出色,将其全部翻译成 Python 是一次有趣的经历。在这最后一部分中,我们将覆盖课程中的最后两个主题——异常检测和推荐系统。我们将使用高斯模型实现异常检测算法,并将其应用于检测网络上的故障服务器。我们还将看到如何使用协同过滤构建推荐系统,并将其应用于电影推荐数据集。

简介: 约翰·维滕瑙尔 (@jdwittenauer) 是一名数据科学家、工程师、企业家和技术爱好者。

相关内容:

-

掌握 Python 机器学习的 7 个步骤

-

数据科学新手: 软件工程师入门教程系列

-

机器学习: 完整详细概述

我们的前 3 名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

更多相关主题

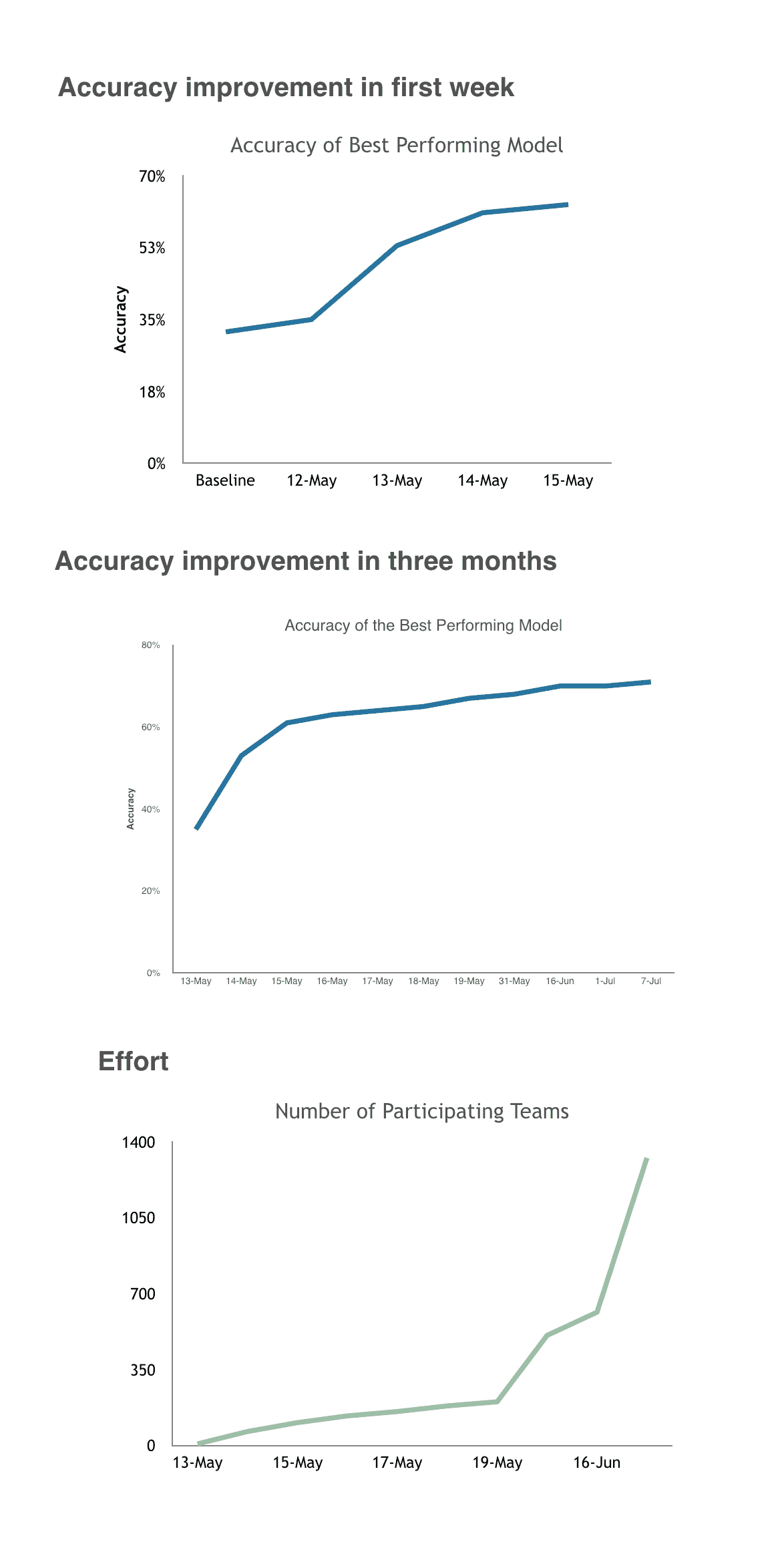

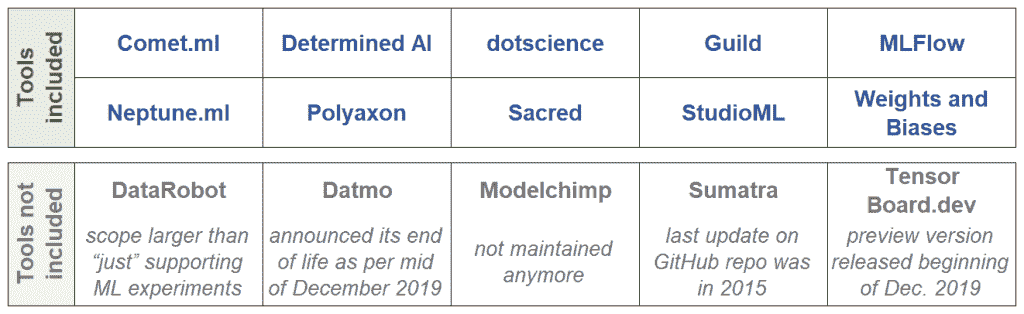

机器学习实验跟踪

原文:

www.kdnuggets.com/2020/06/machine-learning-experiment-tracking.html

评论

由 Lukas Biewald,Weights and Biases 的创始人/首席执行官。

初看,构建和部署机器学习模型看起来很像编写代码。但有一些关键的区别使得机器学习更具挑战性:

-

机器学习项目有比典型软件项目更多的分支和实验。

-

机器学习代码通常不会抛出错误,只会表现不佳,使得调试变得格外困难和耗时。

-

训练数据、训练代码或超参数中的一个小变化可能会极大地改变模型的性能,因此重现早期工作通常需要完全匹配之前的设置。

-

运行机器学习实验可能非常耗时,仅计算成本也可能变得昂贵。

以有组织的方式跟踪实验有助于解决这些核心问题。Weights and Biases(wandb)是一个简单的工具,帮助个人跟踪他们的实验——我与几位不同规模团队的机器学习领导者讨论了他们如何使用 wandb 来跟踪实验。

开始使用 wandb 进行实验跟踪

查看 实时仪表板

在 ML 项目中,进展的基本单元是实验,因此大多数人会以某种方式跟踪他们的工作——通常我看到从业者开始使用电子表格或文本文件来记录他们的工作。

电子表格和文档非常灵活——这种方法有什么问题?

这是我几年前用于一个项目的 Google 文档:

我确定这些笔记在当时很重要,但现在我不知道这些笔记的含义。

Weights and Biases 使得自动记录所有超参数(输入)和指标(输出)变得非常简单。

在 wandb 中的一个典型项目。

这就是你如何在 pytorch 中设置 wandb(你可以在 文档 中找到其他常见的 ML 框架)。

**import wandb****wandb.init(config=args)** # track hyperparameters

**wandb.watch(model)** # track model metricsmodel.train()

for batch_idx, (data, target) in enumerate(train_loader):

output = model(data)

loss = F.nll_loss(output, target)

loss.backward()

optimizer.step() **wandb.log({“loss”: loss})** # track a specific metric

一旦设置完成,Weights and Biases 默认会监控很多内容。任何命令行参数都会变成保存的超参数。任何由 pytorch 提供的值都会成为一个指标。实验可以自动链接到最新的 git 提交或训练代码的确切状态。被动收集信息真的很重要,因为几乎不可能始终如一地记录你可能关心的所有事项。

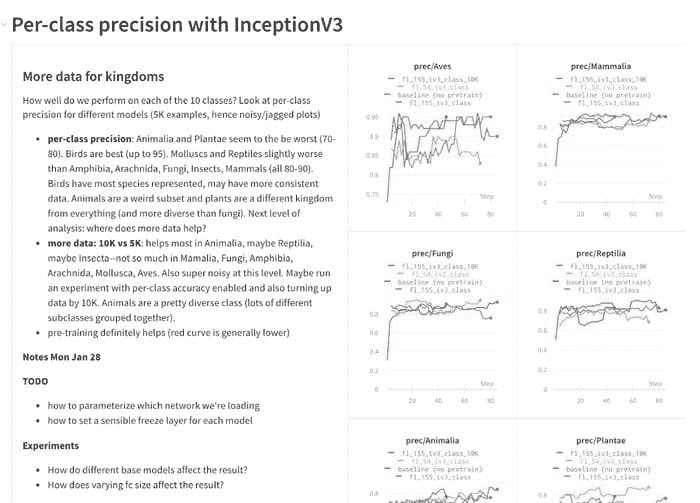

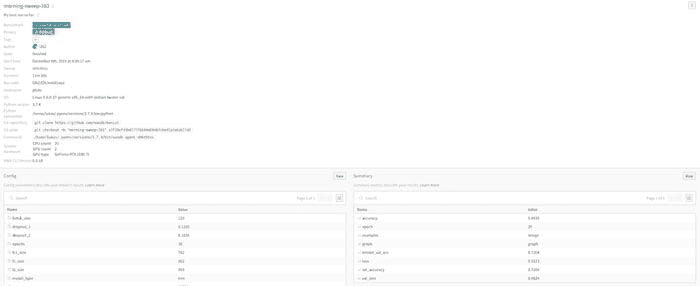

实验概述 在 Weights & Biases 中

记录关于你构建的模型的定性笔记也极为重要,以便以后参考。在 Weights and Biases 中,你可以创建报告来跟踪笔记和模型指标,并与团队分享你的发现和进展。

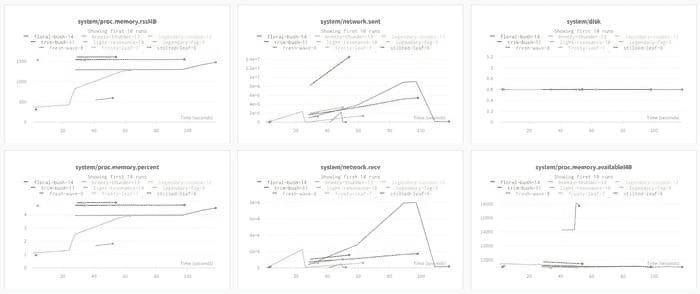

在后台收集系统指标是一个很好的例子。Wandb 在后台收集系统使用指标——例如 GPU 内存分配、网络流量和磁盘使用情况。大多数时候你不需要查看所有这些信息,但当你不再使用大部分 GPU 内存并且很难追踪到这个变化时,情况会变得复杂。如果你 用 wandb 监控你的训练代码 一次,你将能够回顾所有实验并查看使用情况的变化。

在 实时仪表盘查看

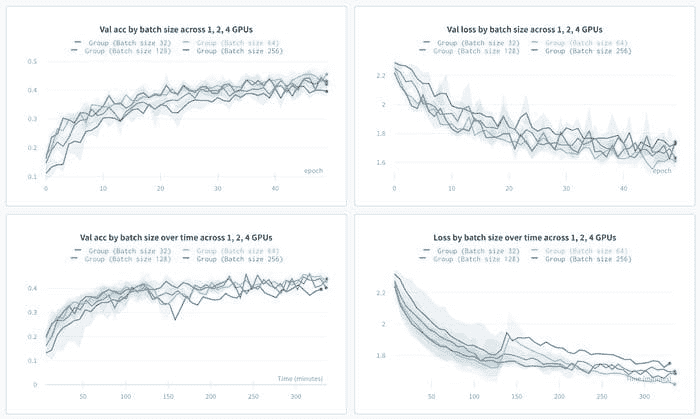

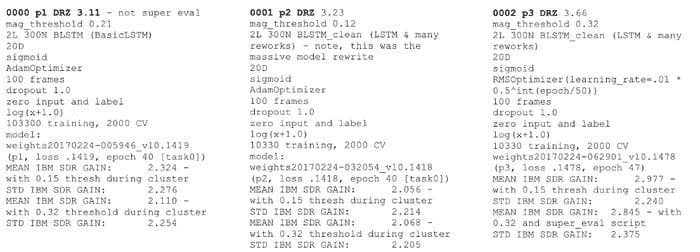

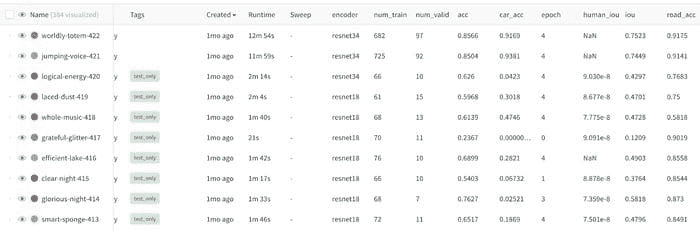

使用实验跟踪来比较实验结果

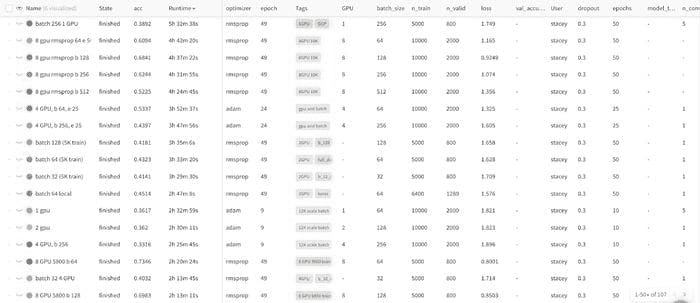

典型的机器学习工作流程涉及运行大量实验。我们发现,将结果 放在其他结果的背景下查看,比单独查看某个实验要有意义得多。

同时查看大量实验会迅速变得混乱。有很多输入变化和不同的可能输出。一些运行不可避免地会提前失败。

不同的实验风格会导致不同的工作流程,但我们发现,记录你可能关注的每一个指标,并用几个对你有意义的标签标记实验,可以使后续工作更加有序。

在 实时仪表盘查看。

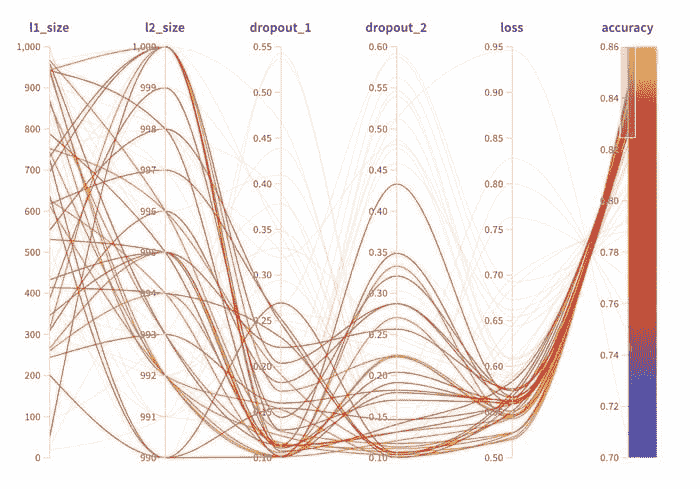

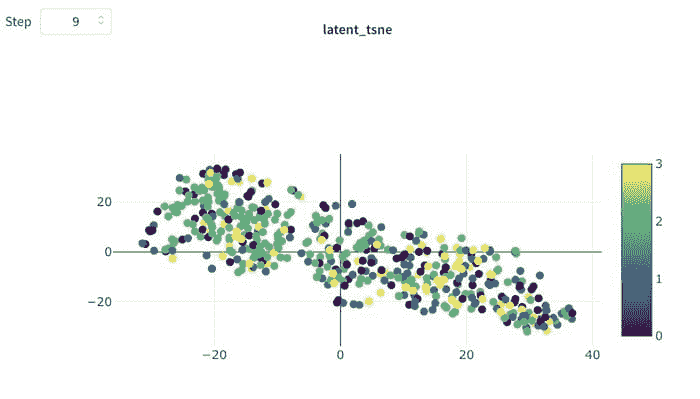

一旦你记录了大量模型,你就有了更多的维度可以检查,而这些维度无法一眼看完。我们发现的一个强大的可视化工具是平行坐标图。

在 实时仪表盘查看

在这里,每一行是一个独立的实验,每一列是一个输入超参数或输出指标。我已经突出了准确率最高的运行,结果很清楚地显示,在我选择的所有实验中,高准确率来自低 dropout 值。

跨实验查看如此重要,以至于 wandb 允许你构建工作区,你可以选择图形分组进行可视化,如散点图,然后立即查看所选运行的比较。

查看具体示例

聚合指标很重要,但查看具体的示例也至关重要。函数 wandb.log() 可以处理各种数据类型并自动可视化它们。

查看 实时报告

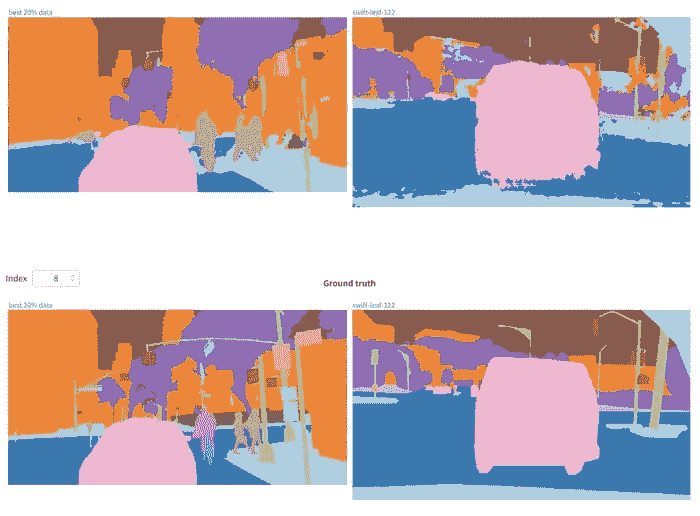

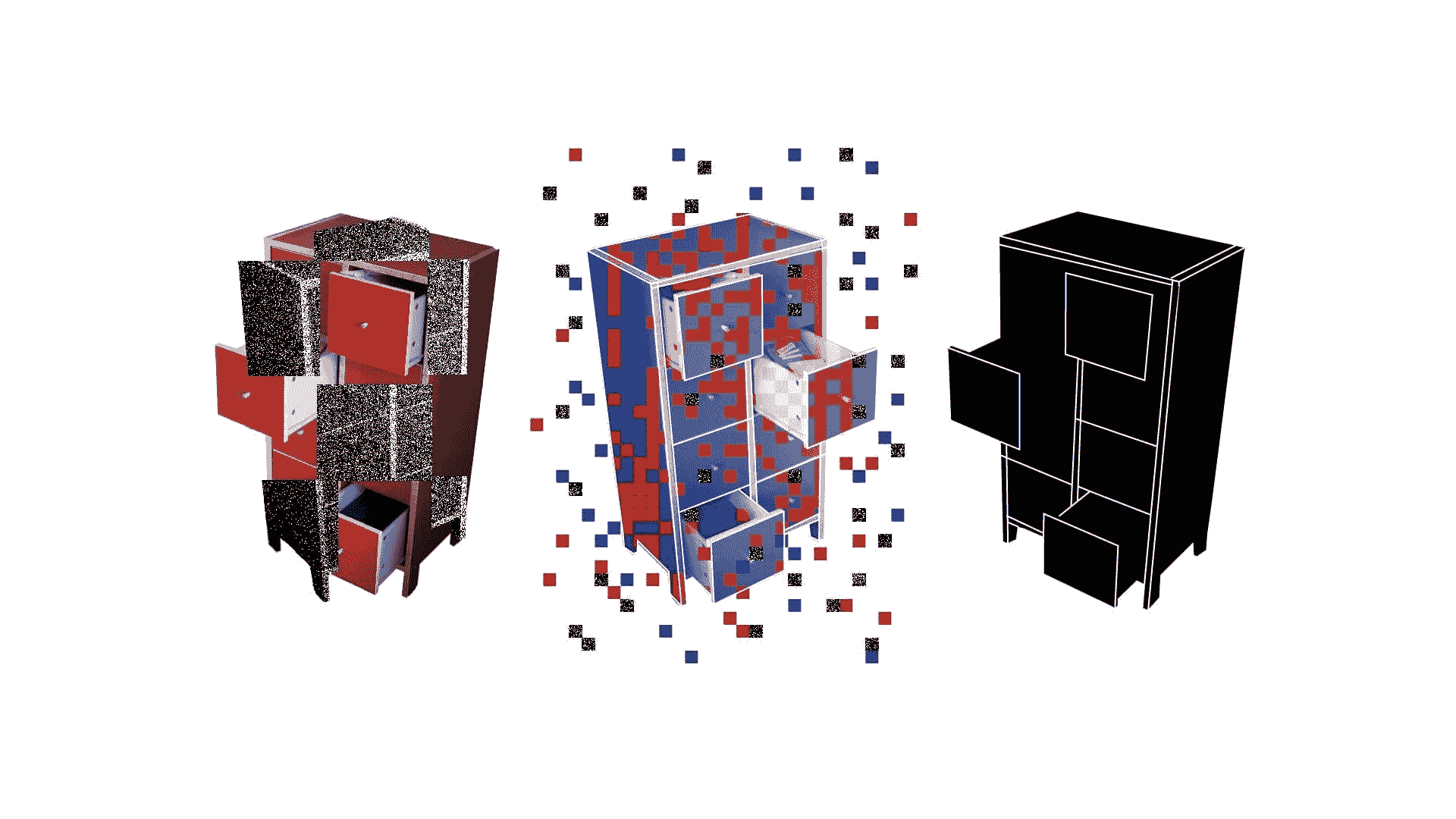

记录图像

记录图像 对于许多应用非常重要,并且可以跨多个运行查看图像。这些是构建 GAN 的不同方法及其在各种尺度和时间步长下的结果。

记录 Matplotlib 图表

通常代码已经在 matplotlib 中跟踪了内容——如果你 记录图表,它将被永久保存,并且容易检索。实际上,你可以为训练代码的每个步骤记录一个独特的图表。

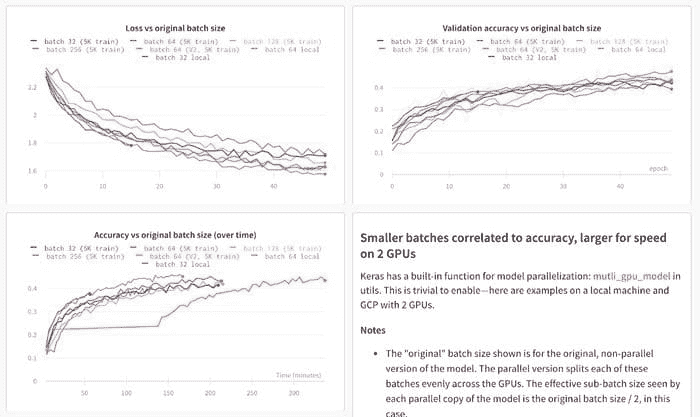

使用实验跟踪来管理分布式训练

在进行 分布式训练 时,甚至只是可视化结果也变得更加困难。

在多台机器上的分布式运行中,每个实例都可以调用 wandb init 并像这样设置 group 和 job_type:

wandb.init(group=”first-run”, job_type=”train”)

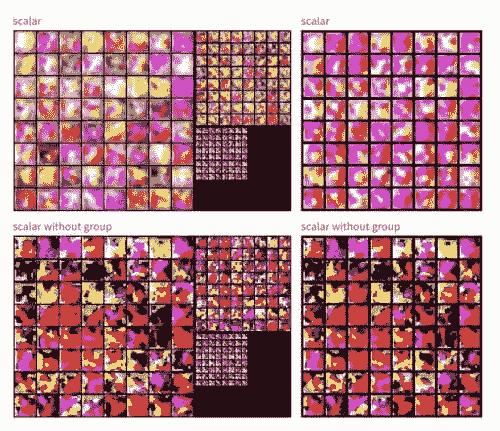

查看 实时仪表盘

Wandb 会显示组内所有运行的指标汇总,但也可以进入并查看单个过程,了解它们的表现如何。

使用实验跟踪报告来管理团队协作

随着团队的发展,跟踪一切变得越来越重要。Wandb 允许你构建 静态报告,准确展示你运行的实验、汇总统计数据以及深入挖掘的能力。

在 OpenAI 机器人团队中,wandb 报告是机器学习从业人员记录他们所做工作的地方,并与同事分享。这对于可视化何时更改可能会无意中阻碍进展至关重要。

在 Latent Space,每个团队项目会议都以审查最新的 wandb 实验报告开始,并讨论当前方法的有效性以及下一步应尝试的实验。

查看 实时报告

使用实验跟踪作为模型的记录系统

随着团队的扩展和模型的投入生产,记录发生的一切变得越来越重要。在丰田研究所,wandb 实验链接被用作每个构建的机器学习模型的官方记录。如果模型构建后发生了问题,他们可以追溯到 wandb 训练运行。通过一组实验生成报告意味着有一个永久记录工作的文档,团队可以轻松地回顾发生了什么。

简介:Lukas Biewald 是 Weights & Biases 的创始人,之前是 Figure Eight(前身为 CrowdFlower)的创始人。

原文。经许可转载。

相关内容:

-

为什么机器学习项目如此难以管理?

-

互动式机器学习实验

-

机器学习中的模型评估指标

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯

1. Google 网络安全证书 - 快速进入网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织中的 IT 事务

3. Google IT 支持专业证书 - 支持你的组织中的 IT 事务

更多相关话题

机器学习可解释性与可理解性:两个概念可能有助于恢复对 AI 的信任

原文:

www.kdnuggets.com/2018/12/machine-learning-explainability-interpretability-ai.html

评论

由 Richard Gall,Packt

不需要数据科学家来发现,内置于自动化和人工智能系统中的机器和深度学习算法缺乏透明性。也不需要太多侦探工作就能看到,这些系统中包含了开发这些系统的工程师无意识偏见的印记。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

可以说,在《经济学人》所称的技术反弹的背景下,这种不透明性(具有讽刺意味地)变得更加明显。尽管许多导致技术反弹的事件既是公司自身利益与令人担忧的治理和问责缺失的混合问题,但不可否认的是,数据科学和机器学习工程的实践自然地与今年最大的一些商业和政治故事紧密相关。

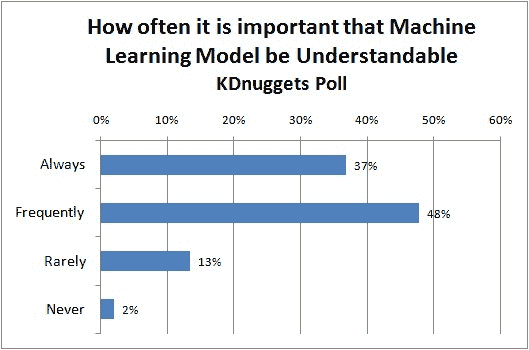

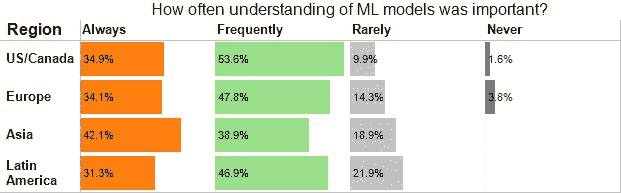

在这种背景下,可解释性和可理解性的概念变得更加紧迫。由于对人工智能伦理的讨论持续进行,它们在 2019 年可能会变得更加重要。

但是,什么是可解释性和可理解性?它们对我们这些从事数据挖掘、分析、科学的人在 2019 年究竟意味着什么?

机器学习可解释性与可理解性之间的区别

在机器学习和人工智能的背景下,可解释性和可理解性通常被交替使用。虽然它们非常密切相关,但值得探讨它们之间的区别,至少可以看到深入了解机器学习系统后事情可能会变得多么复杂。

可解释性是指在系统中观察因果关系的程度。换句话说,就是在输入或算法参数发生变化时,你能够预测会发生什么的程度。它就是能够看着一个算法,嗯,我可以看到这里发生了什么。

同时,可解释性是指机器或深度学习系统的内部机制可以用人类术语解释的程度。理解这个细微的差别可能很困难,但可以这样考虑:可解释性是能够辨别机制而不一定知道原因。可解释性则是能够字面上解释发生了什么。

可以这样理解:假设你在学校做科学实验。实验可能在你看到自己在做什么时是可以解释的,但只有当你深入了解你所看到的化学反应时,它才真正具备可解释性。

这可能有点粗略,但它仍然是思考这两个概念之间关系的一个很好的起点。

为什么在人工智能和机器学习中,可解释性和可理解性如此重要?

如果 2018 年的技术反弹教会了我们什么,那就是尽管技术确实可以被用于可疑的用途,但它也有很多方式可能产生不良 - 歧视性 - 结果,而这些结果并非有意造成伤害。

随着医疗保健等领域希望部署人工智能和深度学习系统,其中问责制和透明度的问题尤其重要,如果我们无法在算法中妥善提升可解释性,最终实现可解释性,我们将严重限制人工智能的潜在影响。这将是非常可惜的。

除了需要考虑的法律和专业问题外,还有一个论点认为,在更平凡的商业场景中,提高可解释性和可理解性同样重要。了解算法的实际工作方式可以帮助更好地将数据科学家和分析师的活动与他们组织的关键问题和需求对齐。

提高机器学习可解释性的方法和技巧

尽管透明性和伦理的问题对实际工作中的数据科学家来说可能显得抽象,但实际上有许多实用的方法可以用来提高算法的可解释性和可理解性。

算法的泛化

第一点是提高泛化能力。这听起来简单,但实际上并不容易。当你认为大多数机器学习工程是在以非常具体的方式应用算法以揭示某个期望结果时,模型本身可能会显得是一个次要元素——它只是实现目标的手段。然而,通过转变这种态度,考虑算法的整体健康状况及其运行的数据,你可以开始为改善可解释性奠定坚实的基础。

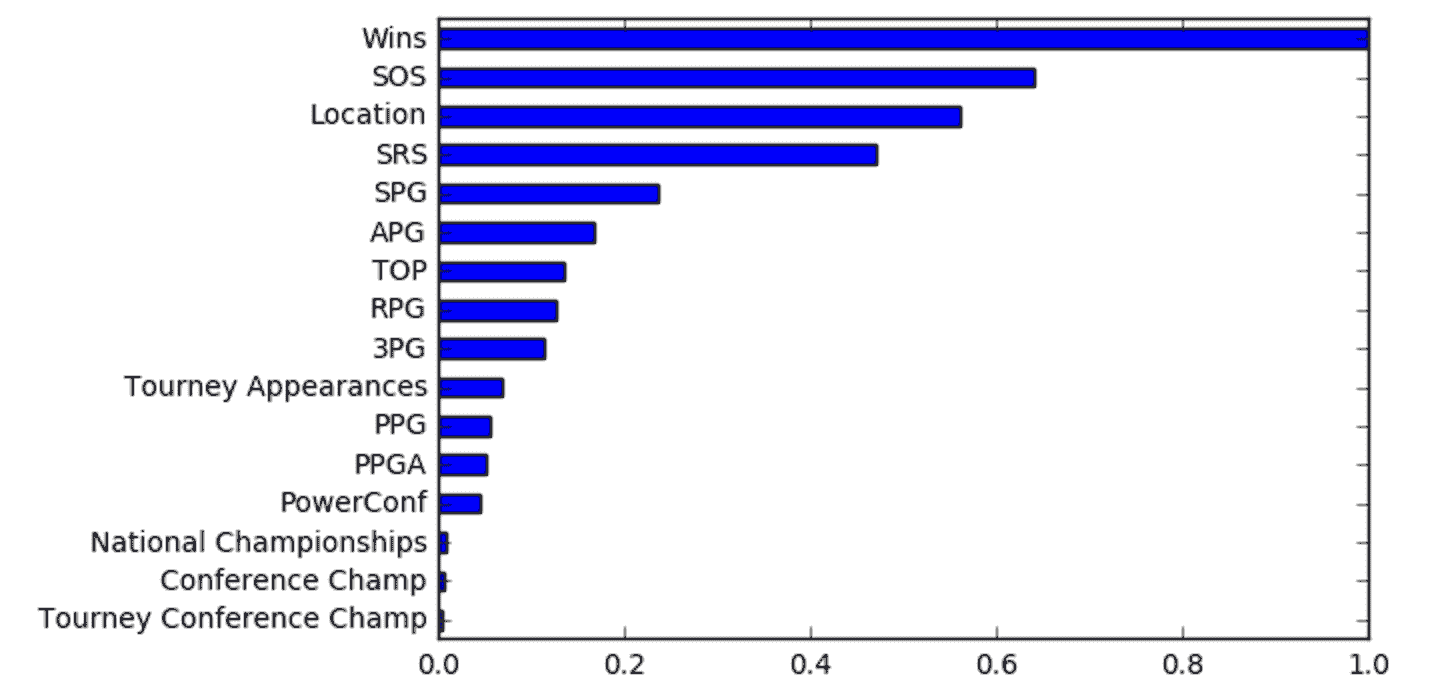

注意特征的重要性

这应该是显而易见的,但很容易被忽视。仔细查看算法中各种特征的设置方式,是实际解决从业务对齐到伦理等各种问题的有效方法。对每个特征如何设置进行辩论和讨论可能会有些耗时,但尽管如此,意识到不同特征以某种方式被设置仍然是朝着可解释性和透明性迈出的重要一步。

LIME:局部可解释模型无关解释

虽然上述技术提供了数据科学家可以采取的实际步骤,但 LIME 是由研究人员开发的一种实际方法,用于获得对算法内部发生的事情的更大透明度。研究人员解释说,LIME 可以以“可解释且忠实的方式解释任何分类器的预测,通过在预测周围局部学习一个可解释的模型”。

实际上,这意味着 LIME 模型通过测试来开发模型的近似值,以查看当模型中的某些方面发生变化时会发生什么。本质上,这就是通过实验过程尝试从相同的输入重现输出。

DeepLIFT(深度学习重要特征)

DeepLIFT 是一个在深度学习领域特别棘手的情况中非常有用的模型。它通过一种反向传播形式工作:它获取输出,然后尝试通过“读取”形成该原始输出的各种神经元来分解它。

实质上,这是一种深入挖掘算法内部特征选择的方法(正如名称所示)。

层级相关传播

层级相关传播类似于 DeepLIFT,它从输出向后工作,识别神经网络中的最相关神经元,直到你回到输入(例如,一张图片)。如果你想了解更多关于这一概念背后的数学知识,Dan Shiebler 的这篇文章是一个很好的起点。

增加复杂性以应对复杂性:这能提高透明度吗?

可解释性和透明性的核心问题在于,你在开发过程中增加了一个额外的步骤。实际上,你可能还添加了多个步骤。从某种角度看,这就像是试图用更大的复杂性来应对复杂性。

在某种程度上,这确实是对的。实际上,这意味着如果我们要真正认真对待解释性和可解释性,就需要在数据科学和工程的方式,以及人们相信它应该如何进行的文化上,进行更广泛的变革。

这或许才是最具挑战性的部分。

个人简介: 理查德·加尔 是 Packt 的编辑内容产品经理。通过优质的信息传递,专注于 Packt 帮助的社区和客户的需求,理查德致力于推动直接和入站收入的增长,并提高 Packt 品牌在当今技术领域的影响力和相关性。

资源:

相关:

更多相关话题

机器学习以 88%的准确率发现“虚假新闻”

原文:

www.kdnuggets.com/2017/04/machine-learning-fake-news-accuracy.html

乔治·麦金泰尔,贡献数据科学撰稿人,ODSC

“谎言在真相来得及穿上裤子之前,就已经传遍了半个世界。”

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT

– 温斯顿·丘吉尔

自 2016 年总统选举以来,一个主导政治讨论的话题是“虚假新闻”问题。许多政治评论员声称,显著偏见和/或虚假的新闻影响了选举,尽管斯坦福大学和纽约大学的研究得出了不同的结论。尽管如此,虚假新闻帖子已经利用 Facebook 用户的信息流在互联网中传播。

“什么是虚假新闻?”

显然,一个故意误导的故事就是“虚假新闻”,但最近喧闹的社交媒体讨论正在改变它的定义。一些人现在使用这个术语来拒绝与他们偏好的观点相悖的事实,最突出的例子是特朗普总统。这样的模糊定义的术语很容易被玩弄。

数据科学社区已经做出回应,采取行动来解决这个问题。有一个类似 Kaggle 的比赛,称为“虚假新闻挑战”,而Facebook 正在使用 AI来过滤用户信息流中的虚假新闻。打击虚假新闻是一个经典的文本分类项目,提出了一个直接的问题:你能建立一个区分“真实”新闻和“虚假”新闻的模型吗?

这正是我为这个项目所尝试做的。我组建了一个包含虚假新闻和真实新闻的数据集,并使用了一个朴素贝叶斯分类器,以便创建一个模型,根据文章中的词汇和短语将其分类为虚假或真实。

数据收集/整理

数据获取过程分为两个部分:获取“假新闻”和获取真实新闻。第一部分很快,Kaggle 发布了一个fake news dataset,包含了在 2016 年选举周期内发布的 13,000 篇文章。

第二部分要困难得多。为了获取数据集中真实新闻的部分,我转向了All Sides,这是一个致力于汇集政治光谱各方新闻和观点文章的网站。该网站上的文章按主题(环境、经济、堕胎等)和政治倾向(左派、中立、右派)进行分类。我使用 All Sides,因为这是从众多媒体渠道中抓取成千上万篇文章的最佳方式。此外,它还允许我下载文章的完整文本,这一点是《纽约时报》和 NPR API 所不具备的。经过漫长而艰辛的过程,我最终抓取了5279 篇文章。我的真实新闻数据集中的文章来自于《纽约时报》、华尔街日报、彭博社、NPR 和《卫报》,并且这些文章发表于 2015 年或 2016 年。

我决定将我的完整数据集构建为假新闻和真实新闻各占一半,从而使模型的空白准确率为 50%。我随机选择了 5279 篇假新闻文章用于我的完整数据集,其余的文章则留作测试集,以便在我的模型完成时使用。

我最终的数据集包含了 10558 篇文章,包括它们的标题、完整正文和标签(真实与假)。数据存放在这个github repo中。

目的与期望

当我刚开始这个项目时,我承认这不会是一个完美的项目。这个项目的目的是看看我能在创建假新闻分类器上走多远,并从中获得什么见解,然后用于改进模型。我的计划是将这个项目视为一个常规的垃圾邮件检测项目。

基于计数向量化器(使用词频统计)或 tfidf 矩阵(词频相对于它们在数据集中其他文章中的使用频率)来构建模型只能取得一定的效果。这些方法没有考虑重要的特质,比如词序和上下文。两个在词频上类似的文章,其含义可能完全不同。我并没有期望我的模型能够熟练处理那些词语和短语重叠的假新闻和真实新闻。然而,我期待这个项目能够提供一些有价值的见解。

建模

由于这是一个文本分类项目,我只使用了朴素贝叶斯分类器,这是文本数据科学项目中的标准做法。

制定模型的真正工作是文本转换(计数向量器与tfidf 向量器)和选择使用哪种类型的文本(标题与全文)。这给了我四对重新配置的数据集来进行操作。

下一步是确定计数向量器或tfidf 向量器的最优参数。对于那些不熟悉文本机器学习的人来说,这意味着使用 n 个最常见的词,使用词和/或短语,是否小写,去除停用词(如 the、when 和 there)以及仅使用在文本语料库中出现至少指定次数的词(文本数据集或文本集合的术语)。

为了测试多个参数及其众多组合的性能,我利用了 Sci-kit Learn 的 GridSearch 功能来高效地执行此任务。要了解如何优化算法参数,请查看这个教程。

在网格搜索交叉验证过程之后,我发现我的模型在使用计数向量器而不是tfidf时效果最佳,并且在用文章的全文训练时比训练在标题上产生了更高的分数。计数向量器的最佳参数是不进行小写转换、使用两词短语而非单个词,并且仅使用在语料库中出现至少三次的词。

鉴于我在帖子中之前概述的期望,我对模型产生的高分感到惊讶甚至有些困惑。我的模型的交叉验证准确率为 91.7%,召回率(真正率)为 92.6%,AUC 分数为 95%。

这是我模型的 ROC 曲线。

如果我基于此图决定模型的阈值,我会选择一个在 0.08 左右产生假阳性率(FPR)和在 0.90 左右产生真正率(TPR)的阈值,因为在图中此点假阳性与真正率之间的权衡是平衡的。

结果与结论

我的模型质量的真正考验是看它能多准确地分类测试集中(未用于模型创建的假新闻文章)假新闻文章。

在 5234 篇其他假新闻数据集中,我的模型能够正确识别 88.2%的假新闻。 这比我的交叉验证准确率低了 3.5 个百分点,但在我看来,这是对我的模型的相当不错的评估。

事实证明,我预测模型在分类新闻文章时会遇到困难的假设是相当错误的。我原本认为 60 多或 70 多的准确率是优秀的,但我设法显著超越了这个预期。

尽管我创建了一个看似相当不错的模型,但考虑到任务的复杂性,我并不完全相信它的表现如同表面上看起来的那样,这就是原因所在。

为了更好地理解为什么会发生这种情况,我们来看看数据中的“最虚假”和“最真实”词汇——我会解释我的意思。

使用我从数据学校的 Kevin Markham 那里借用的技术,这里是我如何得出语料库中“最虚假”和“最真实”词汇的方法。我首先使用了一个宽两列、长 10558 行的表格(这就是语料库中的词汇数量)。第一列表示一个词在被分类为“虚假”的文章中出现的次数,第二列表示一个词在“真实”文章中出现的次数。然后,我将虚假列的数值除以我模型分类的虚假文章总数,真实列也做了同样的处理。接着,我在数据的每个值上加了一,因为我创建了一个新的“虚假:真实”比率列,不想因为除以零而产生错误。这个“虚假:真实”是衡量某个词汇“虚假”或“真实”的一个相当不错但并不完美的指标。逻辑很简单,如果一个词在“虚假”文章中频繁出现而在“真实”文章中很少出现,那么它的虚假与真实比率分数将会很高。

这里是我数据集中前 20 个“最虚假”和“最真实”的词汇。

这两个图表展示了一些令人困惑的结果。“虚假”图表中的词汇种类繁杂,包括一些典型的互联网术语,如 PLEASE、Share、Posted、html 和 Widget,以及一些甚至不是真正的词汇,如 tzrwu。然而,看到 infowars 被提及以及“羊群”和“UFO”等词汇进入前 20 个“最虚假”词汇并不令人惊讶。Infowars 是由 Alex Jones 领导的一个右翼阴谋论媒体,推广关于化学轨迹和 9/11 的阴谋理论。

“真实”的图表主要由名字、政治家以及在政治文章中经常使用的词汇构成,占据了图表中 60%的条形图。二十个词汇中有七个,包括前六名中的四个,是政治家名字。这引发了一个问题,即关于政治家的文章是否更有可能是真实的?当然不是,如果有什么的话,你会预期有大量的虚假新闻传播关于政治家的虚假信息。如果我得出提到政治家的文章更有可能真实的结论,那将是一个巨大的错误。

这个项目的一个重要假设是,各类文章所涵盖的主题有相当大的重叠。正如我们上面所见,仅仅因为某个词在“真实”新闻中出现得比在“虚假”新闻中多,并不意味着包含这些词的文章一定是“真实”的,而只是这些词可能在真实新闻数据集中更常见,而虚假新闻数据集中则反之。

我和另一方对塑造这个数据集有相当大的影响。我决定了哪些文章用于“真实”数据集。“虚假”数据集中的文章是由一个名为“BS Detector”的 Chrome 扩展程序确定的,该程序由 Daniel Sieradski 制作。确定什么是“虚假新闻”、什么不是“虚假新闻”时存在显著的主观性。政治人物的名字被高评级为“真实”的原因,很可能是因为这部分语料库不成比例地来自政治新闻。此外,我确实发现了一些我认为来自可靠新闻来源的文章。其中一篇文章来自 The Intercept,一个具有高新闻标准的新闻组织。是的,我的模型确实将这篇所谓的“虚假新闻”文章标记为真实。

使事情变得更加复杂的是,我们必须决定如何为我们的模型设置阈值概率。如果我是一名在 Facebook 的数据科学家,负责实现一个筛选用户动态中真实与虚假新闻的模型,我将面临选择一个屏蔽所有或大部分虚假新闻和一些真实新闻的模型,还是一个允许所有或大部分真实新闻和一些虚假新闻的模型的困境。但在做出决定之前,我需要弄清楚未能阻止虚假新闻与阻挡真实新闻的成本是什么?如何尝试回答这样一个抽象的问题?除非我们能训练一个 100%真阳性率和 0%假阳性率的模型,否则我们将被困在这个困境中。

总之,虽然我认为标准的朴素贝叶斯文本分类模型可以提供一些解决这个问题的见解,但在专业环境中,应使用更强大的深度学习工具来对抗虚假新闻。

对“虚假新闻”的分类为数据科学界提供了一个新挑战。在许多机器学习项目中,你想要预测的不同类别之间的区别是明确的,而在这种情况下则要模糊得多。这个项目验证了数据科学中的一种观点,即对数据的直觉和熟悉程度与任何模型或工具一样重要,甚至更为重要。

简介:乔治·麦金泰尔 是一位转行的数据科学家/记者混合型人才。寻找数据科学和/或新闻学方面的机会。对新事物充满好奇和热情。在完成 Metis 数据科学训练营之前,他曾在旧金山为 Vice、Salon、SF Weekly、San Francisco Magazine 等媒体担任自由记者。

原文。已获授权转载。

相关内容:

-

这里越来越热:数据科学与假新闻

-

昨晚瑞典发生了什么:数据科学与假新闻

-

警惕两种数据混淆策略

更多相关内容

亚马逊免费入门机器学习课程

原文:

www.kdnuggets.com/2020/10/machine-learning-free-course-amazon.html

评论

我们最近分享了亚马逊新推出的机器学习大学计划的入门课程,这些课程集中在计算机视觉(CV)和自然语言处理(NLP)上。这些课程假设你对这些主题没有任何先验知识,并基于短视频讲座和相应的 Python 笔记本。

但如果你对计算机视觉(CV)或自然语言处理(NLP)的专业路径不感兴趣呢?如果你希望了解将机器学习应用于更传统的数据集怎么办?如果这些描述符合你,加速表格数据 可能是一个不错的起点。

这门课程由亚马逊的技术培训专家Paula Grajdeanu教授,涵盖以下材料:

课程讲座可以在课程的YouTube 播放列表中找到,而附带材料——包括幻灯片、笔记本和数据集——可以在课程的GitHub 仓库中找到。最终项目与课程的实际技能目标一致,基于奥斯汀动物中心的宠物领养数据。

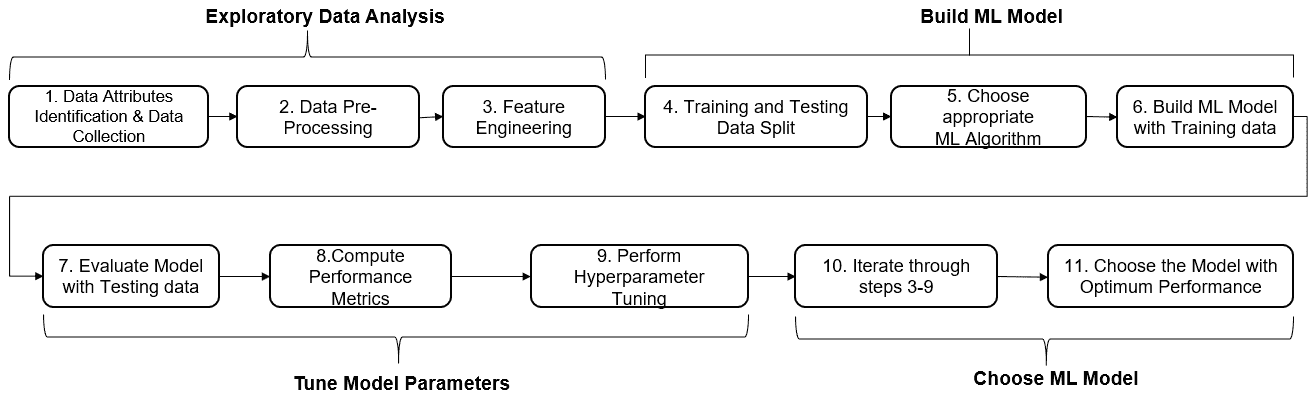

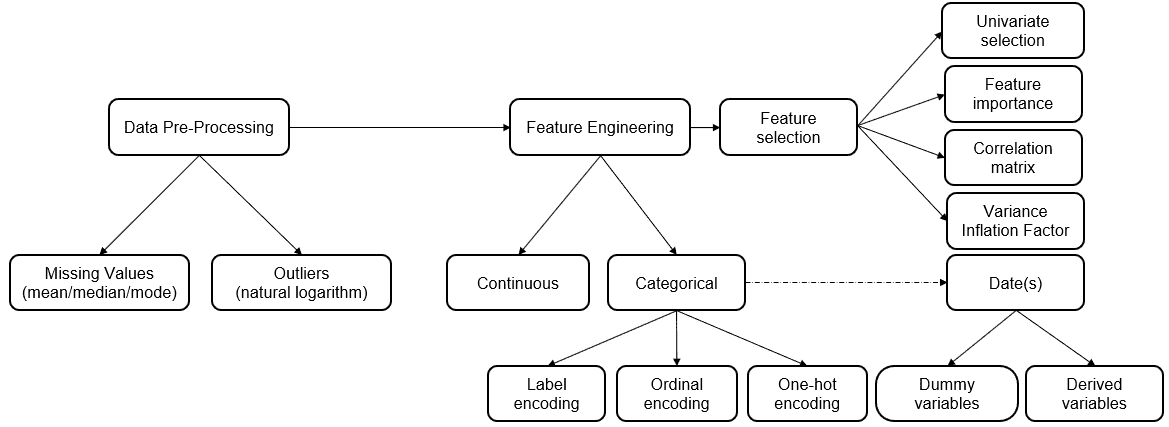

为什么提到“表格数据”?这是因为这门课程并不旨在教授最新深度学习的理论,而是加速表格数据将介绍使用各种技术在表格数据上实现机器学习解决方案——即以行和列存储的字母数字数据,其中行代表观察值,列代表这些观察值的特征。这与其他类型数据的技术形成对比,即计算机视觉和自然语言处理,亚马逊 MLU 的补充课程可以在这些技术的学习上提供支持。

这门课程并不是旨在详尽无遗,而是为了激发你对实际机器学习的兴趣。请查看课程主题,并将其视为对现有内容的一个样本,以及你之后可能选择专注的内容。

通过这门入门课程,你不会立即工程化生产就绪的机器学习系统,但它应当为你提供关于机器学习在实际中可以实现什么的概述,给你必要的工具来完成一些这些任务,并帮助你在课程结束后指引到更深入的学习方向。总体来看,这门课程是一个值得考虑开始机器学习之路的好地方。

相关:

-

加速计算机视觉:亚马逊的免费课程

-

加速自然语言处理:亚马逊的免费课程

-

超越肤浅:具有实质内容的数据科学 MOOC

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速入门网络安全职业

1. 谷歌网络安全证书 - 快速入门网络安全职业

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

更多此主题

《从头开始的机器学习:免费在线教材》

原文:

www.kdnuggets.com/2020/09/machine-learning-from-scratch-free-online-textbook.html

评论

由丹尼尔·弗里德曼编写,他是哈佛大学统计学的高级学生。

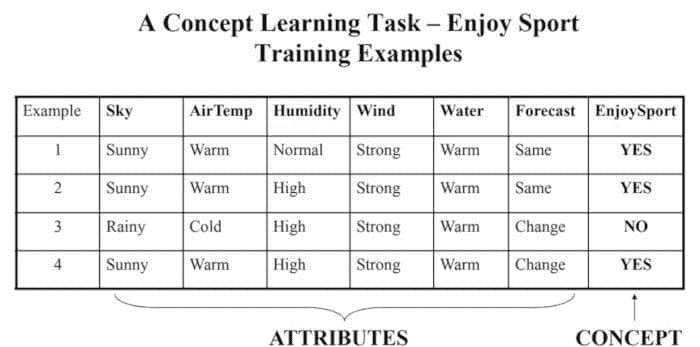

本书涵盖的内容

本书涵盖了机器学习中最常见方法的基础知识。这套方法就像是机器学习工程师的工具箱。那些进入机器学习领域的人应该对这个工具箱感到熟悉,这样他们才能在各种任务中使用合适的工具。本书的每一章都对应一个单独的机器学习方法或方法组。换句话说,每一章都集中于 ML 工具箱中的一个单独工具。

根据我的经验,熟悉这些方法的最佳方式是从头开始理解它们,无论是理论上还是代码实现上。本书的目的是提供这些推导。每章分为三个部分。概念 部分从概念上介绍这些方法,并在数学上推导其结果。构建 部分展示了如何使用 Python 从头构建这些方法。实现 部分演示了如何使用 Python 中的包,如 scikit-learn、statsmodels 和 tensorflow 来应用这些方法。

为什么选择这本书

许多关于机器学习的优秀书籍由更有经验的作者编写,涵盖了更广泛的主题。特别是,我建议阅读统计学习导论、统计学习的元素和模式识别与机器学习,这些书籍都可以在网上免费获取。

虽然这些书籍提供了机器学习的概念概述及其方法背后的理论,但本书专注于机器学习算法的基本内容。其主要目的是使读者能够独立构建这些算法。继续使用工具箱的比喻,本书旨在作为用户指南:它并不旨在教用户广泛的领域实践,而是如何在微观层面上使用每个工具。

本书适合谁

本书适合那些希望学习新的机器学习算法或深入理解算法的读者。特别是,它旨在帮助读者看到从头到尾推导出的机器学习算法。这些推导可能帮助之前不熟悉常见算法的读者直观地理解它们的工作原理。或者,这些推导可能帮助有建模经验的读者理解不同算法如何创建它们的模型以及每种算法的优缺点。

本书对那些有基本建模实践的读者最为有用。它不回顾最佳实践——如特征工程或响应变量平衡——也不深入讨论在何种情况下某些模型比其他模型更合适。相反,它关注这些模型的要素。

读者应了解的内容

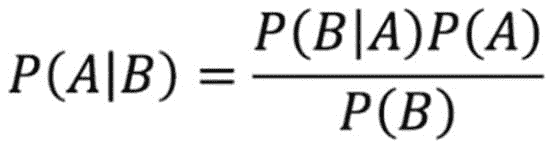

本书的概念章节主要需要微积分知识。然而,有些章节需要理解概率(例如最大似然估计和贝叶斯规则)以及基础线性代数(例如矩阵运算和点积)。附录回顾了理解本书所需的数学和概率。概念章节还参考了一些常见的机器学习方法,这些方法在附录中也有介绍。概念章节不需要编程知识。

本书的构造和代码章节使用了一些基本的 Python。构造章节需要理解相关内容章节,并且熟悉 Python 中的函数和类的创建。代码章节则不需要这些知识。

提问或反馈的方式

你可以通过提出问题或发送电子邮件至 dafrdman@gmail.com 来联系我。你也可以通过Twitter或LinkedIn与我联系。

目录

1. 普通线性回归

**2. 线性回归扩展

**3. 判别式分类器(逻辑回归)

**4. 生成式分类器(朴素贝叶斯)

**5. 决策树

**6. 树集成方法

**7. 神经网络

**附录

**开放教材

相关内容:

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析能力。

2. Google 数据分析专业证书 - 提升你的数据分析能力。

3. Google IT 支持专业证书 - 为你的组织提供 IT 支持。

3. Google IT 支持专业证书 - 为你的组织提供 IT 支持。

更多相关内容

-

学习数据科学统计的顶级资源****************

机器学习在网络安全中是否有未来角色?

原文:

www.kdnuggets.com/2017/06/machine-learning-future-role-cyber-security.html

评论

评论

作者:保罗·奥尼尔,数据分析师,来自Black Duck Software。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速入门网络安全职业。

1. 谷歌网络安全证书 - 快速入门网络安全职业。

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT 工作

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT 工作

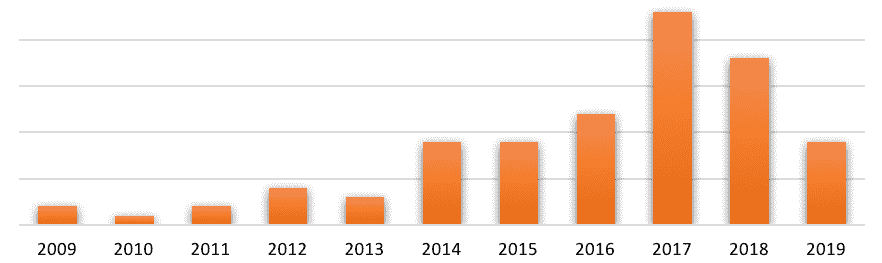

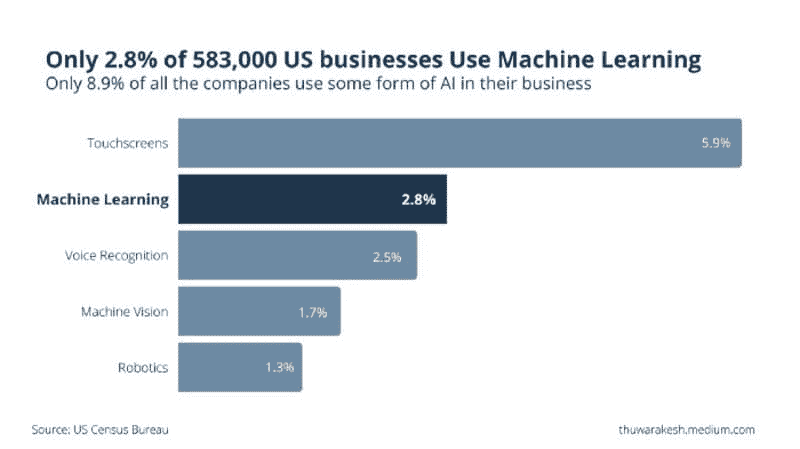

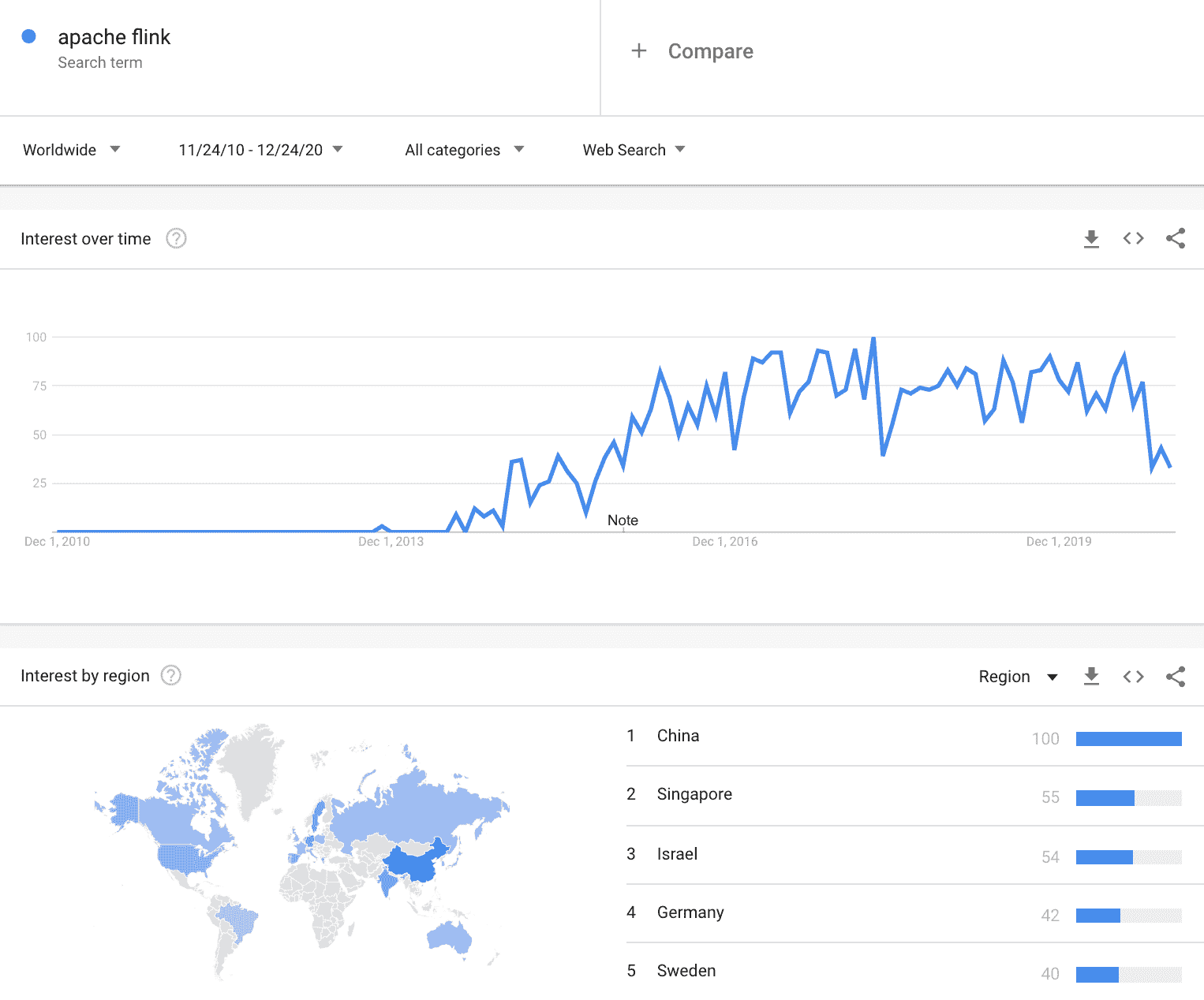

根据谷歌趋势,机器学习自 2015 年以来的兴趣稳步增长(几乎增长了三倍)。Coursera 和 Udacity 的机器学习课程都位列前十相关主题。看来许多人希望了解更多关于它的信息。

如果你曾经使用过谷歌、Netflix、亚马逊、Gmail,那么你已经与机器学习(ML)互动过了。它已成为在线零售、推荐系统、欺诈检测等领域的重要组成部分。开源的机器学习和数据科学工具,如Python 的 Scikit-learn 包,是免费的,非常强大,常用于构建这些工具。

机器学习的早期尝试

过去,机器学习在网络安全领域的成功不如在其他领域。许多早期尝试面临生成过多假阳性的难题,导致对其态度不一。例如,Bromium 的首席技术官 Simon Crosby 认为,尽管机器学习在发现相似性方面表现很好,但在发现异常方面却不如人意,因此不适用于网络安全。前 Symantec 首席技术官 Amit Mital 声称,网络安全“基本上破碎”,而机器学习是为数不多的‘希望之光’之一。我不同意第一个观点,它在事实上的确不正确。无监督机器学习能够区分异常值和正常活动。

演算法应用

机器学习算法有很多种,通常分为有监督学习和无监督学习。有监督学习需要标记的训练数据集,对于网络安全来说不太适用。无监督学习不需要标记的训练数据,更适合发现可疑活动,包括检测以前从未见过的攻击的能力。

Amit Mital的观点更为有趣。网络安全是否已经崩溃?我不是安全专家,所以无法对安全的技术方面发表评论,但我可以查看事实。每天,大型公司和组织都遭受攻击,其中一些攻击是成功的。网络安全是一个‘零容忍领域’,我的意思是,任何成功的攻击都是安全失败。对我来说,如果机器学习有任何帮助的可能性,我们应该加以调查。

大数据能力

最近几个月,一些主要公司已经获得了机器学习能力。例如,Sophos 收购了 Invincia,Radware 购买了 Seculert,而惠普则收购了 Niara。这可能是一个迹象,表明至少一些大型组织将机器学习和大数据能力视为未来的重要资产。

机器学习可能很快在网络安全中将不再是可选的。物联网将严峻地挑战现有的网络安全方法。一旦那些潜在不安全的‘智能’马桶、电烤箱等开始联网,它将显著增加产生和分发的数据量。这可能会显著增加可被利用的弱点数量,这是一种挑战,机器学习或许可以帮助解决。

机器学习提供 24/7 的监控,并处理比人类能够处理的更大的数据负荷。它仍然需要人工干预。机器学习并不是真正的‘即插即用’技术;它需要调优,以帮助筛选真正的攻击与看似可疑但实际上是良性活动的区别,而这种调优需要人类专家。我认为即使是最支持机器学习的人也不会声称它可以替代防火墙、杀毒软件或人工安全专家,但它将补充这些更传统的防御措施,创造出更为多层次的防御体系。

最近的进展

近年来,网络安全机器学习的一些重要进展和改进包括麻省理工学院计算机科学与人工智能实验室(CSAIL)与一家名为 PatternEx 的机器学习初创公司之间的合作。这项合作的成果是 AI2,一个提供 85%检测率的系统,并且减少了五倍的误报率。

深度学习也是未来值得关注的领域。这种形式的人工智能不同于机器学习,因为它基于模仿大脑中神经元行为的算法。深度学习的目标与无监督学习的目标类似:能够识别已知和未知的攻击类型。然而,深度学习可能更好地处理不完整、混乱和复杂的数据——这正是我们在现实世界中看到的数据。

简介: 保罗·奥尼尔 (LinkedIn) 拥有物理学,特别是天体物理学的背景。现在他是一名数据分析师。不仅仅是他的职位,保罗对数据充满了热情。他的兴趣包括数据可视化、自然语言处理、机器学习以及与数据相关的技术方面。但保罗最感兴趣的是数据革命对人类的影响。

原文. 经许可转载。

相关:

-

机器学习与网络安全资源

-

人工“人工智能”泡沫与网络安全的未来

-

使用机器学习检测恶意网址

更多相关话题

机器学习与深度链接图分析:强大的组合

原文:

www.kdnuggets.com/2019/04/machine-learning-graph-analytics.html

评论

评论

作者:Yu Xu(TigerGraph 创始人兼 CEO)和 Gaurav Deshpande(TigerGraph 市场副总裁)

机器学习(ML)——人工智能(AI)的一个方面,使软件能够准确识别模式和预测结果——已经成为一个热门的行业话题。近年来,随着数据分析、存储和计算能力的不断进步,机器学习在企业应用中,如防欺诈、个性化推荐、预测分析等,扮演着越来越重要的角色。

将图形数据库功能应用于机器学习和人工智能应用相对较新。然而,这一点令人惊讶,因为 Google 的知识图谱首次普及了在数据中寻找关系以获得更相关、更精确的信息的概念,早在 2012 年就已出现。此外,这种应用自然契合:图形非常适合存储、连接和从复杂数据中进行推理。

图形在机器学习中未能发挥重要作用的主要原因是,传统的图形数据库无法提供机器学习真正需要的深度链接图分析,用于大数据集。

让我们深入探讨图形如何帮助机器学习以及它们如何与大数据的深度链接图分析相关。

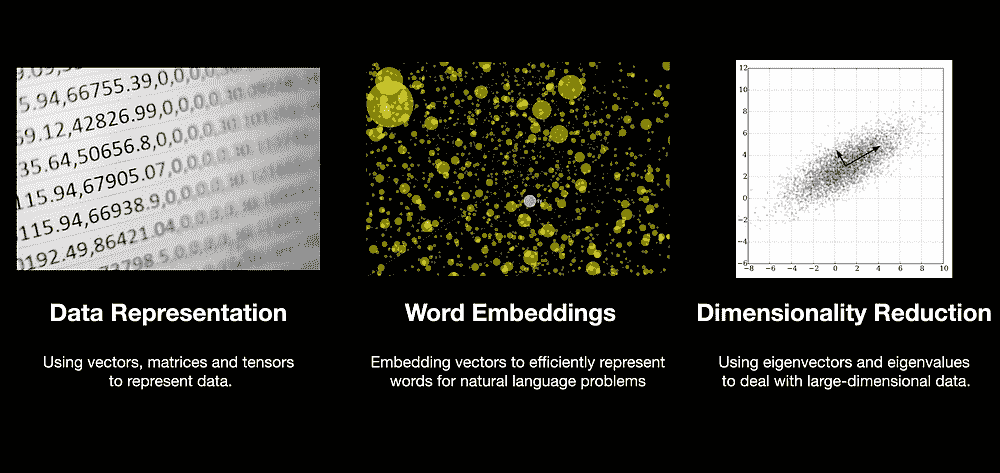

无监督的原生图形基础机器学习算法

首先,图形分析直接提供了一组独特的无监督机器学习方法。许多图算法——社区检测、PageRank、标签传播、介数中心性、接近中心性和邻域相似度——识别出具有广泛应用的有意义的图形导向模式。这些应用包括识别欺诈模式、寻找用户群体、计算影响力用户或社区,并报告操作或供应链中的薄弱环节或瓶颈。

这些原生图算法共有的一个特点是它们都需要进行深度链接图分析——在图中遍历多个连接层级以收集数据并进行分析。这种遍历,尤其是像社区检测这样的全图分析,要求强大的图计算能力。只有原生并行图数据库才能提供这种能力。

用于训练监督式机器学习算法的图形特征

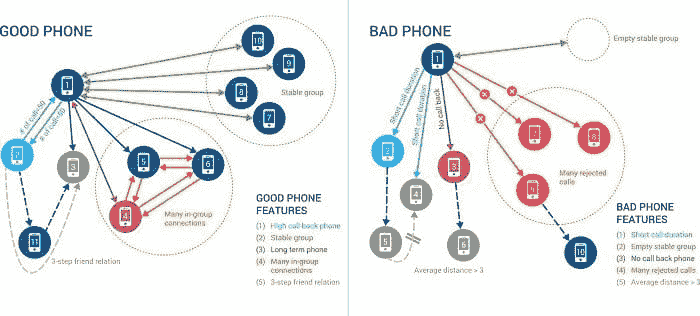

深度链接图分析帮助机器学习的第二种方式是通过丰富用于监督机器学习的数据特征集。考虑中国移动的例子,它是全球最大的移动服务提供商,拥有超过 9 亿用户。中国移动的网络每周有超过 20 亿次语音通话,他们的主要挑战是找到使用预付费 SIM 卡的电话诈骗者,这些 SIM 卡几乎没有用户详细信息。因此,很难将属于正常用户的好电话与属于诈骗者的差电话区分开来。像通话时长或拒接电话百分比这样的简单特征会导致很多误报。

中国移动利用基于图的机器学习特征,如稳定的群体和内部连接,提高了欺诈检测的机器学习准确性。一个好电话还会定期拨打一组其他电话——例如,每周或每月——而且这组电话在一段时间内相当稳定(“稳定群体”)。

另一个表明好电话行为的特征是当一个电话拨打了一个已经在网络中存在了多个月或多年的电话,并且收到回电时。我们还看到在好电话、长期电话联系人和网络中的其他电话之间有大量的通话,这些电话频繁地拨打这两个号码。这表明好电话有很多“内部连接”。中国移动通过为每个电话生成 118 个基于图的特征,将数十亿的新训练数据记录输入到其机器学习解决方案中,从而改进了其欺诈检测过程。

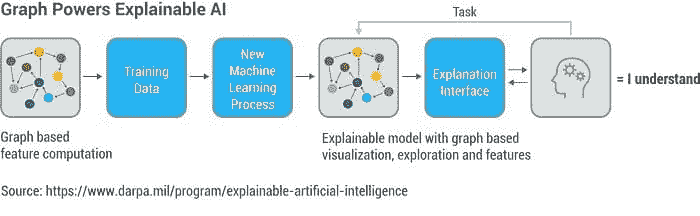

可解释的机器学习/人工智能模型

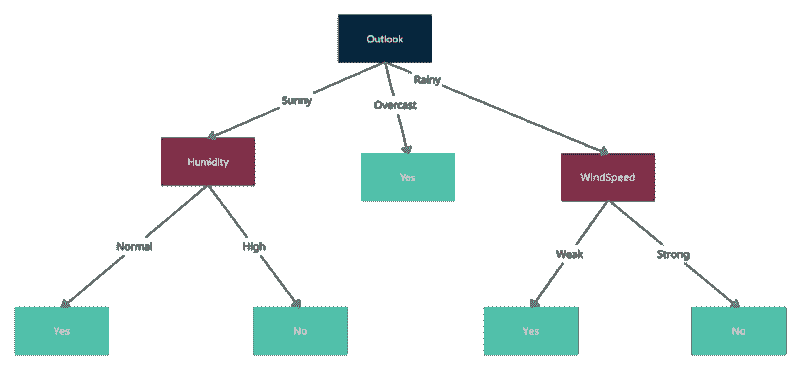

可解释的模型在机器学习应用日益增长的背景下成为了一个广泛讨论的话题。像神经网络及其衍生物深度学习网络等方法常被批评,因为它们生成的预测模型通常无法提供任何因果因素的洞见。它们无法给出为什么会预测结果的简单答案。另一方面,可解释模型往往会突出导致决策的关键变量。一个传统的例子是决策树。考虑一个用于评估你癌症风险的决策树:你是否定期吸烟?如果是,你的风险高于平均水平。如果不是,就问下一个问题……请注意,决策树是一种专门的图。

类似地,当图算法或图特征作为 AI 模型的一部分使用时,图关系的自然语义,例如“客户 --(购买)--> 产品”,容易被解读。

可解释的人工智能模型有很多好处。例如,消费者已经习惯了个性化推荐。如果推荐附带一些解释或证据,用户更有可能采取行动。图形分析非常适合计算并展示这些个性化推荐背后的证据,并根据需要通过图形可视化进行解释。例如,图形分析可能会显示你两到三度关系中的一部分朋友喜欢这个产品或服务,或者与你兴趣相似的其他用户喜欢它,或者该产品类似于你之前的购买。

基于图的机器学习和分析不仅对消费者有帮助,也对企业用户有用。以欺诈检测为例。许多企业雇佣大量训练有素的调查员来判断交易是否可能是欺诈性的。图形擅长将多个数据源结合起来,连接点,允许调查员直观且互动地看到该交易如何与之前标记为欺诈的交易相关联。这比仅仅收到一些机器学习模型给出的模糊 0.7 欺诈评分要有帮助。

另一个例子:实时电话诈骗防护。每天,数以亿计的电话被拨打,但其中只有极小的一部分是恶意诈骗。图形技术可以快速探索拨打者、电话号码和接收者之间的关系,并结合机器学习开发训练模型,以检测哪些是虚假的。

此外,当涉及到监管机构或其他审计方时,可解释的机器学习成为一种必要条件。银行被要求拥有高质量的方法来检测可能的洗钱行为。越来越多的银行使用机器学习来提高检测准确性,但同时,他们必须能够向审计员展示他们的系统如何以及为何有效。使用基于图的特征的机器学习模型提供了所需的透明度。

本地并行图数据库

机器学习一直计算需求很高,基于图的机器学习也不例外。每一次跳跃或连接数据的级别,搜索的数据量呈指数级扩展,要求进行大规模的并行计算来遍历数据。这对需要过多单独查找的键值数据库或在处理过多慢速连接时困难的关系数据库管理系统来说计算开销太大。即使是标准的图数据库也可能无法处理大型图上的深度链接分析。需要一个具有大规模并行和分布式处理能力的本地图数据库。

为了计算和解释个性化推荐和欺诈检测背后的原因,图形数据库需要一个强大的查询语言,它不仅能够遍历图中的连接,还能支持诸如过滤和聚合的计算以及复杂的数据结构来记住证据。

深层图形分析推动了机器学习的下一次进步,通过无监督学习图形模式、为监督学习提供特征增强,并提供可解释的模型和结果。结合 AI 和 ML,这是一种强大的组合,将在未来几年内为企业提供良好的服务。

BioYu Xu 是 Tigergraph 的创始人兼首席执行官,专长包括并行计算、数据库管理、Hadoop、MapReduce、大规模数据分析、数据仓库、半结构化数据的信息检索、XML 文档中的关键词搜索、空间数据库、可扩展的网络系统开发、搜索引擎优化、XML 语言和查询引擎、PigLatin、Cassadra、HBase 和 HIVE。

Gaurav Deshpande 是一位经验丰富的技术高管,专注于组建获胜团队,创造新产品和行业解决方案,建立新市场并主导市场。

资源:

相关:

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

更多相关话题

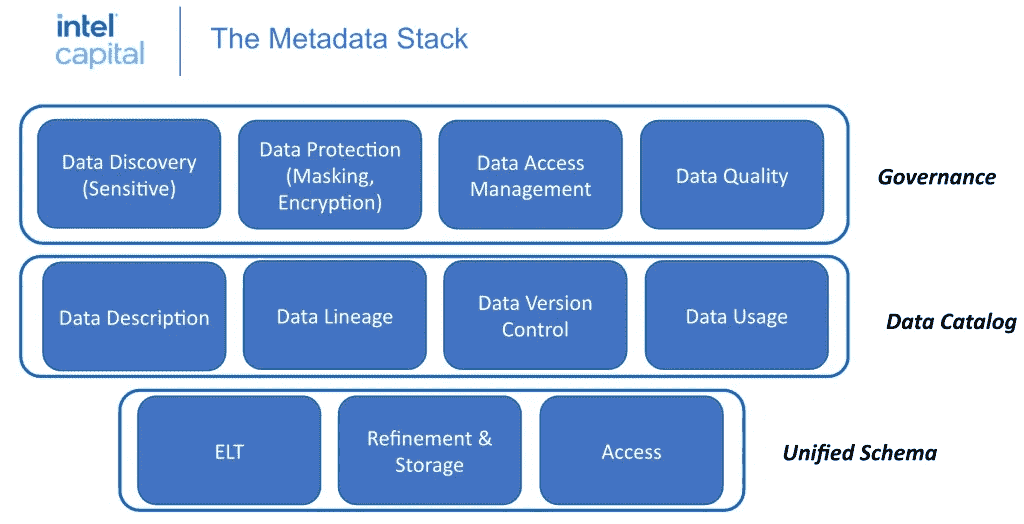

机器学习正在发生:组织采纳、实施和投资的调查

评论

评论

由 Asir Disbudak,企业家兼营销顾问

编辑注:这是完整报告的摘录。你可以在这里阅读完整的调查报告。

执行摘要。

-

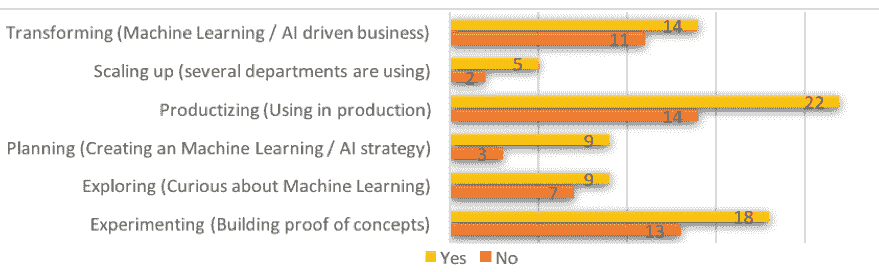

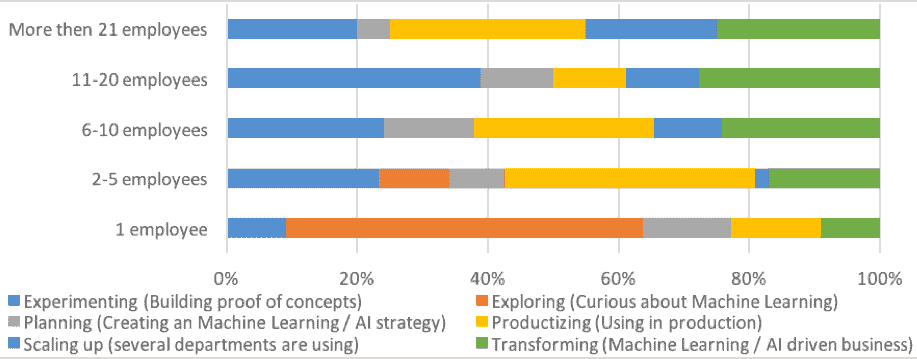

机器学习(ML)正在发生。 大多数受访者(54%)已经实施了机器学习策略,近 28%的人认为自己处于扩展/转型阶段。

-

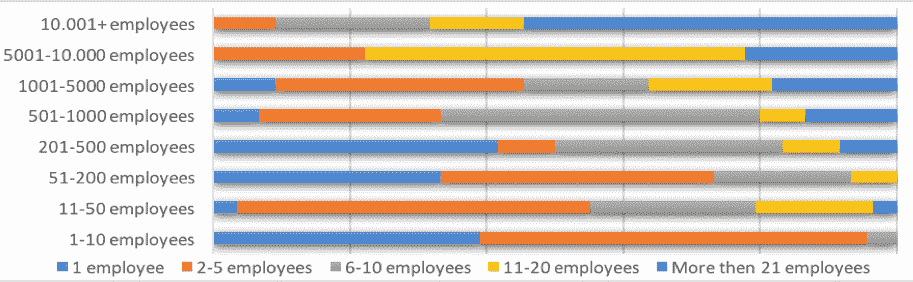

组织正在投资于机器学习。 在现有的机器学习实施者中,我们看到当公司在人工智能成熟度曲线上提升时,数据科学家的数量大幅增加。

-

机器学习提供了更快的行动和决策。 根据受访者的反馈,机器学习的一个主要好处是能够做出更快的有依据的决策,50% 的现有机器学习实施者认为他们已经实现了这一目标。算法和机器学习技术可以提供有价值的管理指导和支持。

-

大多数机器学习实施者和规划者希望通过扩展数据分析工作和增加数据洞察来获益。 约 35%的早期和成熟阶段的用户表示,他们的机器学习工作已导致更好的客户支持,从而在营销和销售方面带来了可观的投资回报。

-

机器学习实施者正在追求广泛的项目。 当前机器学习实施者中最常见的项目包括信息处理(26%);自然语言处理(19%),规划与探索(17%),机器视觉(16%)以及处理与控制(11%)。

-

初创公司正在意识到机器学习的最大潜在好处。

调查于 2019 年 4 月在 LinkedIn 上进行,作为 A.Disbudak 准备的大学论文的一部分。该调查旨在评估机器学习在当今操作中的相关性,评估机器学习采纳的当前状态,并识别用于机器学习的工具。140 位合格的受访者代表了从非常小型(一人初创公司)到非常大型(员工超过 10,000 人的跨国公司)的各种公司规模。

引言:机器学习正在发生。

数据革命的下一个阶段已经到来。计算机科学的一个分支——机器学习,是推动商业世界的下一个重大进展(Raconteur, 2015)。各类企业正在制定技术采纳战略,并已经实现了真正的投资回报(ROI)(Insights, 2017)。

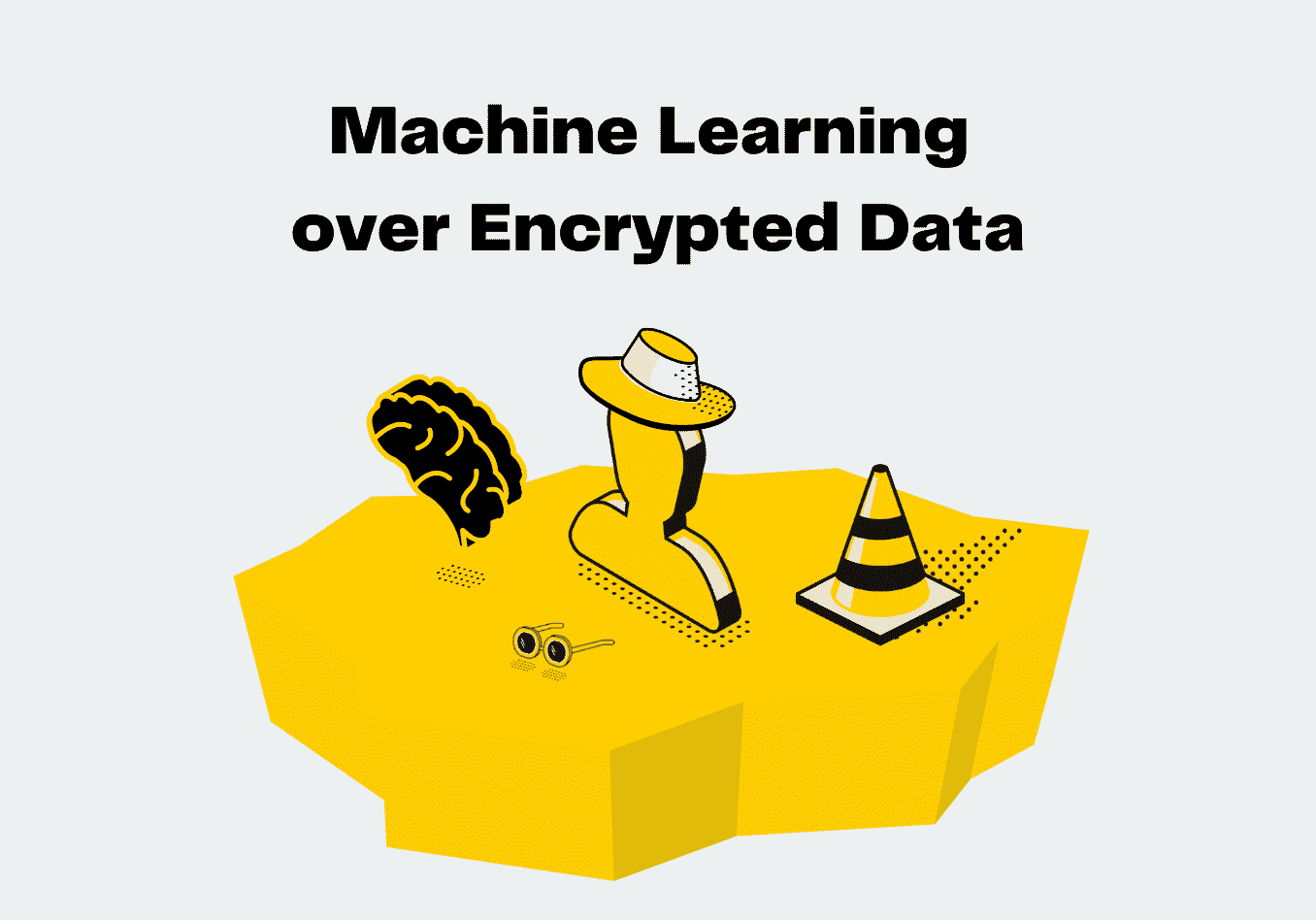

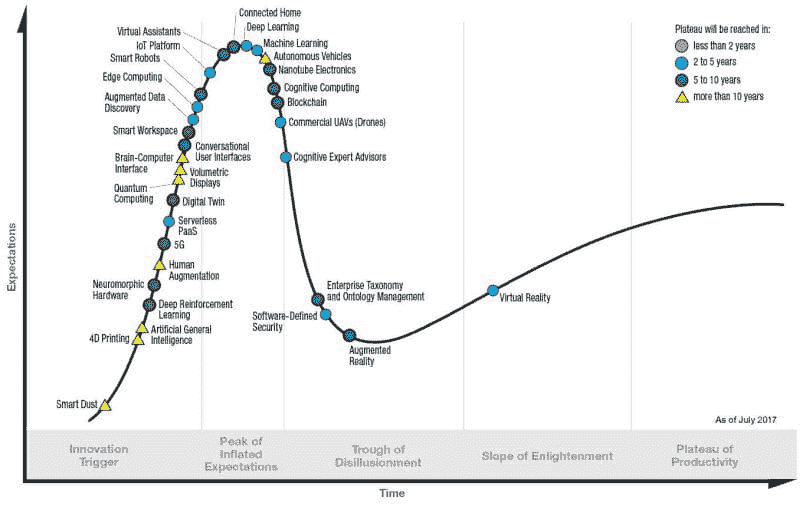

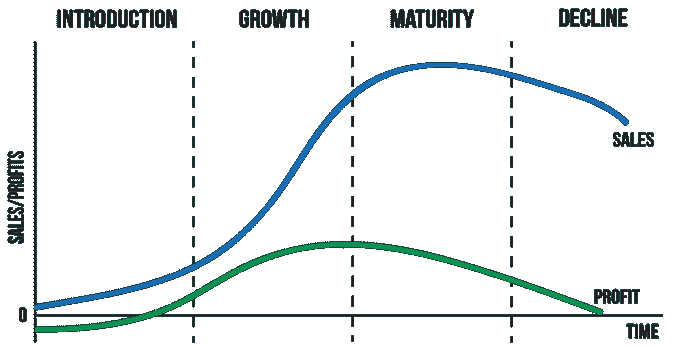

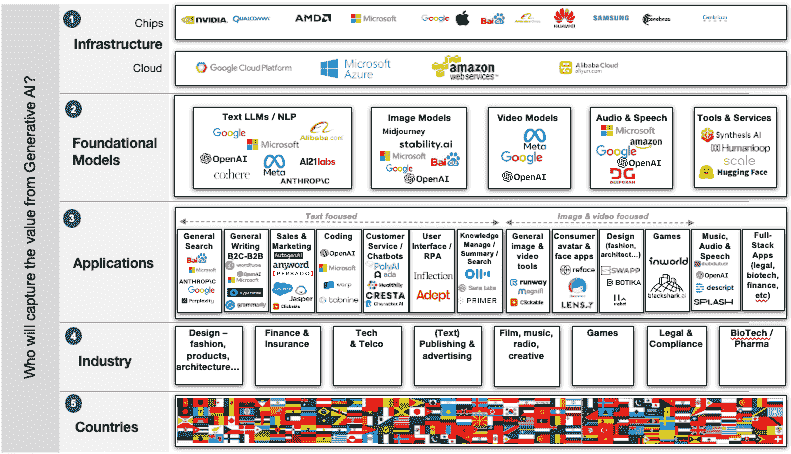

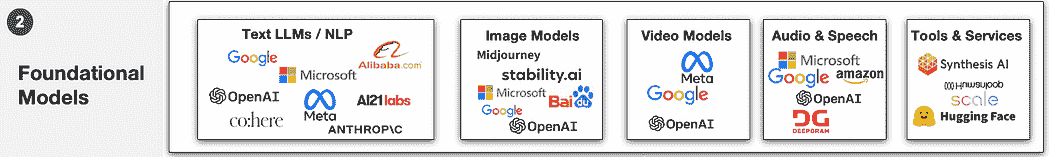

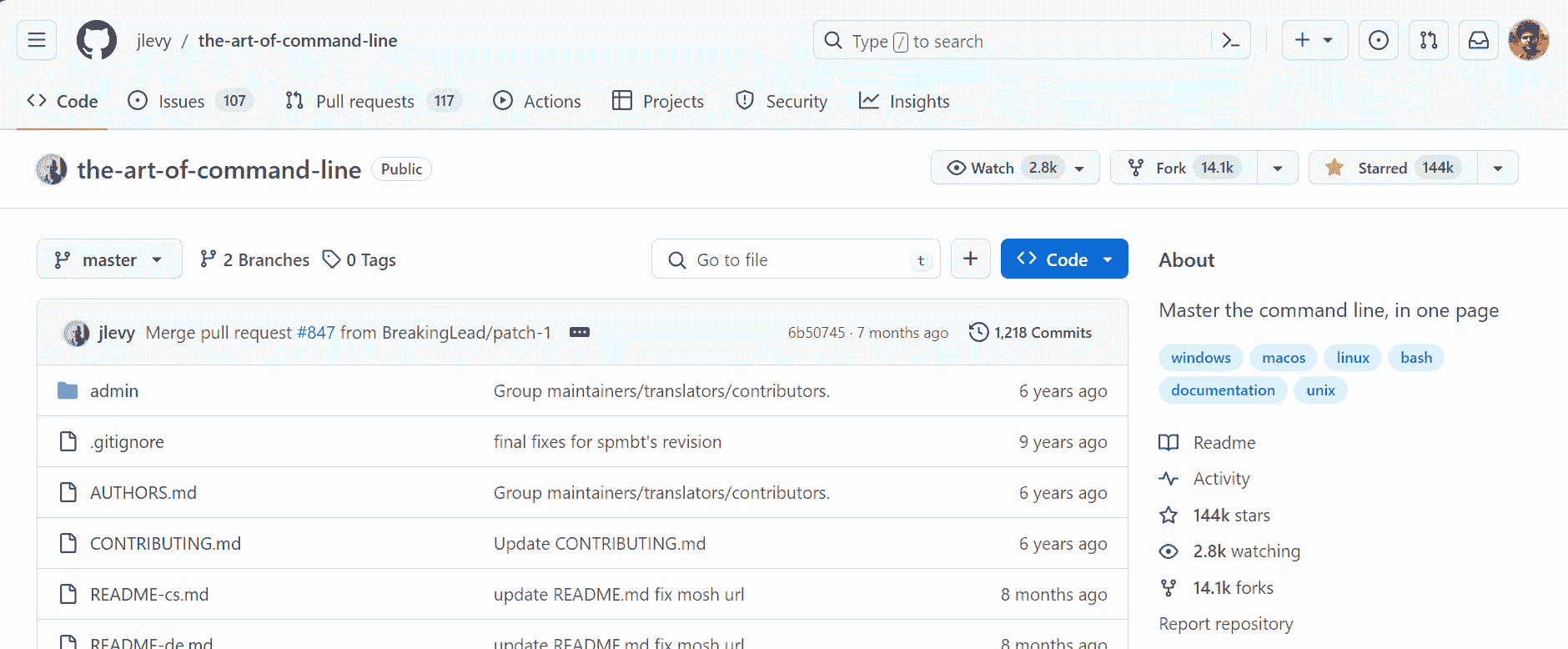

图 1. Gartner 新兴技术的炒作周期,2017

来源:Gartner,Gartner-新兴技术炒作周期,2017。

国际企业对机器学习(ML)的关注可能看起来像是突如其来的发展,但对这一技术的热议自 2005 年大数据兴起以来一直在稳步增长。ML 系统用于帮助计算机从大数据集中识别模式,使其能够执行任务,如预测消费者行为和预测人们对不同营销策略的反应(Raconteur, 2015)。这项技术是解锁大数据价值的关键。创新思维的商业领袖们将 ML 视为“下一个大事物”,并已经制定了 ML 战略和计划,这些计划承诺带来实际收益和投资回报率(Pettey & Meulen, 2018)。

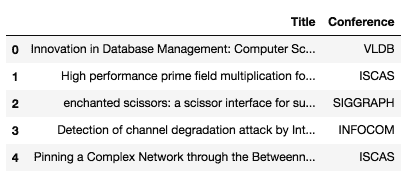

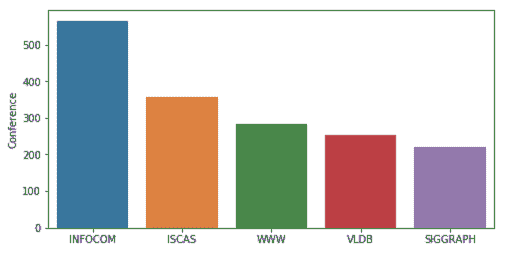

图 2. 机器学习采纳

来源:A.Disbudak 进行的学生调查(机器学习调查,2019 年 4 月)。

机器学习在今天运营中的相关性。

美国科技和互联网巨头,即所谓的 GAFA 公司(Google、Apple、Facebook、Amazon)通过获得大量关于客户及其在线行为的数据来建立他们的业务(Raconteur, 2015)。此外,NATU 公司(Netflix、Airbnb、Tesla、Uber)或 BATX 公司(百度、阿里巴巴、腾讯、小米)也都开发了强大的机器学习能力,通过内部平台和模型来实现。他们获取的数据越多,机器学习的效果就越好。然而,这些机器学习能力并不容易被大多数公司获取。他们需要获得不同的方法来访问机器学习能力,以便将自己独特而有价值的数据资产发挥作用。新一代机器学习平台的出现将使各种规模和行业的企业能够更容易地使用机器学习。

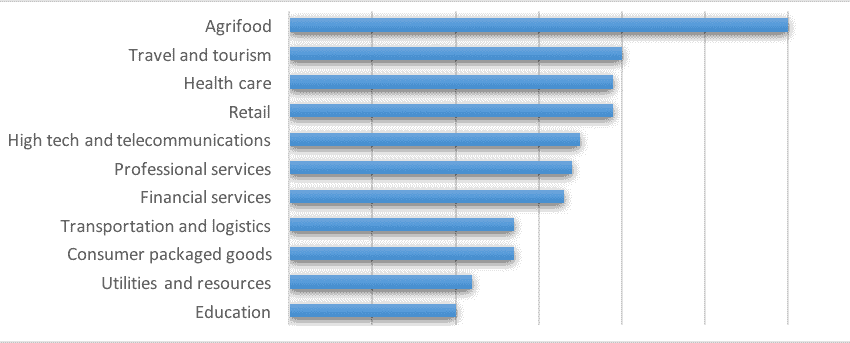

图 3. 机器学习成熟度与行业

来源:A.Disbudak 进行的学生调查(机器学习调查,2019 年 4 月)。

计算能力的进步和大数据现象将 AI、机器学习和深度学习技术推向了一个新领域。Forrester 预测,2017 年 AI 将吸引三倍于以往的企业投资(Press, 2016)。同时,较小的公司声称由于从一开始就将 AI 作为业务核心,其 AI 发展更为先进。

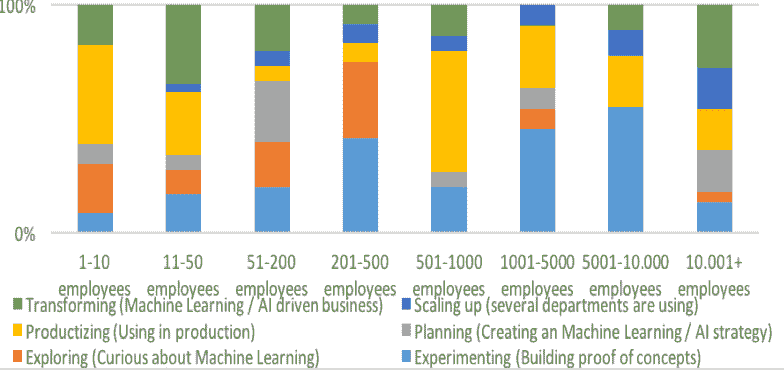

图 4. 组织规模与机器学习成熟度

来源:A.Disbudak 进行的学生调查(机器学习调查,2019 年 4 月)。

机器学习正在帮助公司优化各种业务流程,以实现其战略数字化转型目标。如果组织继续犹豫,它将错失机器学习技术为企业今天提供的宝贵机会。根据埃森哲的报告,管理者如果理解智能系统的工作原理,更愿意信任它(埃森哲,《人工智能的承诺》报告,2016 年)。

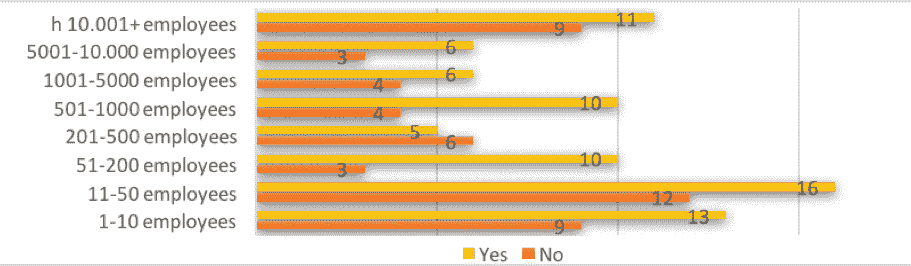

图 5. 机器学习成熟度对培训的需求

来源:A.Disbudak 进行的学生调查(机器学习调查,2019 年 4 月)。

2019 年,公司被认为处于机器学习的“增长”阶段。这意味着最佳实践仍在建立中。机器学习主要被视为研发工作,生产化模型所需的基础设施尚不可用。由于数据访问、研发预算和机器学习案例的多样性,大公司相比于小公司具有优势。谷歌是首个向市场提供大量数据清理和模型训练解决方案的公司,称为 Hadoop。

图 6. 产品生命周期

我们预计在 2020 年机器学习生产化将取得重大突破。数据科学家正在获得更多用于 AI 实验的工具,使他们能够更轻松地管理和部署模型。

图 7. 机器学习成熟度与数据科学部门规模

来源:A.Disbudak 进行的学生调查(机器学习调查,2019 年 4 月)。

商业竞争不仅仅由产品质量或交付物流定义,还由独特的数据资产及其利用能力定义。因此,随着公司在 AI 战略和执行上投入巨资,数据科学家面临着巨大的需求(AI 战略,《福布斯》,2019 年)。

图 8. 公司规模与数据科学家数量

来源:A.Disbudak 进行的学生调查(机器学习调查,2019 年 4 月)。

关于业务相关性的数据显示并转化为需要内部销售的产品和服务创新。将业务需求与机器学习任务连接起来成为数据科学家的核心技能,并为所有参与者带来价值。

图 9. 组织规模对培训的需求

来源:A.Disbudak 进行的学生调查(机器学习调查,2019 年 4 月)。

简介:Asir Disbudak 是一位企业家和营销顾问。他是阿姆斯特丹国际商学院的国际商务学生,充满激情和激励。在这段学习期间,他发展了作为企业家的远见。

相关:

-

Python 引领 11 大数据科学、机器学习平台:趋势与分析

-

打开黑箱:如何利用可解释的机器学习

-

你需要了解的:现代开源数据科学/机器学习生态系统

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析水平

2. Google 数据分析专业证书 - 提升你的数据分析水平

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

更多相关话题

做到不可能的事?少于一个示例的机器学习

原文:

www.kdnuggets.com/2020/11/machine-learning-less-than-one-example.html

评论

“少于一个示例学习”使机器学习算法能够用少于 N 个训练示例来分类 N 个标签。

如果我让你想象一种介于马和鸟之间的生物——比如一匹会飞的马——你是否需要看到一个具体的例子?这样的生物并不存在,但这并不妨碍我们用想象力创造一个:飞马。

人类的思维具备各种机制,可以通过结合其对现实世界的抽象和具体知识来创造新概念。我们可以想象出我们可能从未见过的现有事物(如长脖子的马——长颈鹿),以及在现实生活中不存在的事物(如喷火的有翅蛇——龙)。这种认知灵活性使我们能够用很少甚至没有新的示例来学习新事物。

相比之下,机器学习和深度学习,作为当前人工智能领域的领先技术,通常需要许多示例才能学习新任务,即使这些任务与它们已经知道的内容相关。

克服这一挑战促成了大量的研究工作和机器学习领域的创新。尽管我们仍然远未创造出能够复制大脑理解能力的人工智能,但这一领域的进展是显著的。

例如,迁移学习是一种技术,它使开发人员能够对人工神经网络进行微调,以适应新任务,而不需要大量的训练示例。少样本学习和单样本学习使得一个在某一任务上训练的机器学习模型可以通过一个或很少的新示例来执行相关任务。例如,如果你有一个图像分类器已经训练来检测排球和足球,你可以使用单样本学习将篮球加入它可以检测的类别中。

一种名为“少于一个示例学习”(或 LO-shot 学习)的新技术,最近由滑铁卢大学的 AI 科学家开发,将单次学习提升到了一个新水平。LO-shot 学习的理念是,要训练一个机器学习模型以检测 M 个类别,你需要每个类别少于一个样本。这项技术在 arXiv 预印本 中介绍,由 Ilia Sucholutsky 和 Matthias Schonlau 提供,仍处于早期阶段,但显示出潜力,可以在数据不足或类别过多的各种场景中发挥作用。

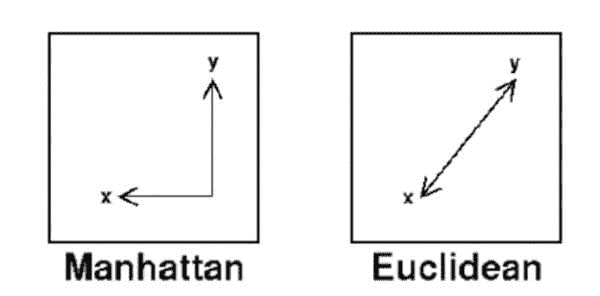

k-NN 分类器

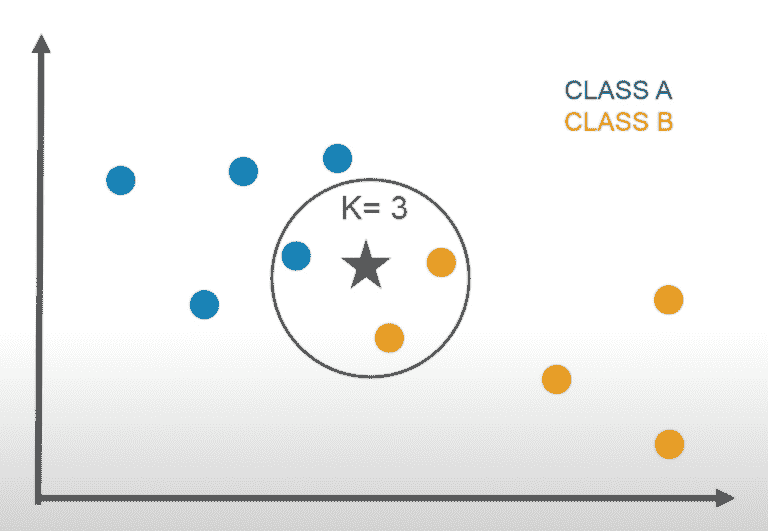

k-NN 机器学习算法通过寻找最接近的实例来对数据进行分类。

研究人员提出的 LO-shot 学习技术适用于“k-最近邻”机器学习算法。k-NN 可用于分类(确定输入的类别)或回归(预测输入的结果)任务。但为了讨论的方便,我们将重点讨论分类。

正如名字所示,k-NN 通过将输入数据与其 k 个最近邻进行比较来进行分类(k 是一个可调整的参数)。假设你想创建一个 k-NN 机器学习模型来分类手写数字。首先,你需要提供一组标记的数字图像。然后,当你给模型提供一张新的、未标记的图像时,它将通过查看其最近邻来确定其类别。

例如,如果你将 k 设置为 5,机器学习模型将为每个新输入找到五张最相似的数字照片。如果说,其中三张属于类别“7”,那么它将把图像分类为数字七。

k-NN 是一种“基于实例”的机器学习算法。当你提供更多每个类别的标记样本时,它的准确性会提高,但其性能会下降,因为每个新样本都会增加新的比较操作。

在他们的 LO-shot 学习论文中,研究人员展示了你可以在提供比类别少的示例时使用 k-NN 实现准确的结果。“我们提出了‘少于一个’-shot 学习(LO-shot 学习),这是一个模型必须在只有 M < N 个示例的情况下学习 N 个新类别的设置,”AI 研究人员写道。“乍一看,这似乎是不可能的任务,但我们从理论和实证上都展示了其可行性。”

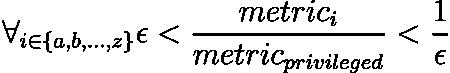

每个类别少于一个示例的机器学习

经典的 k-NN 算法提供“硬标签”,这意味着对于每个输入,它提供了一个确切的类别。另一方面,软标签则提供输入属于每个输出类别的概率(例如,有 20% 的概率是“2”,70% 的概率是“5”,以及 10% 的概率是“3”)。

在他们的工作中,滑铁卢大学的 AI 研究人员探索了是否可以使用软标签来概括 k-NN 算法的能力。LO-shot 学习的提议是,软标签原型应该允许机器学习模型使用少于 N 个标记实例来分类 N 个类别。

该技术建立在研究人员之前关于软标签和数据蒸馏的工作基础上。论文的共同作者 Ilia Sucholutsky 告诉TechTalks:“数据集蒸馏是生成小型合成数据集的过程,这些数据集可以训练模型达到与使用完整训练集相同的准确度。在软标签之前,数据集蒸馏能够使用每个类别仅一个示例来表示像 MNIST 这样的数据集。我意识到,添加软标签意味着我实际上可以使用每个类别少于一个示例来表示 MNIST。”

MNIST 是一个手写数字图像数据库,通常用于训练和测试机器学习模型。Sucholutsky 和他的同事 Matthias Schonlau 仅使用五个合成示例,在卷积神经网络LeNet 上实现了超过 90% 的准确度。

“这个结果真的让我很惊讶,这也是让我更广泛地思考 LO-shot 学习设置的原因,”Sucholutsky 说。

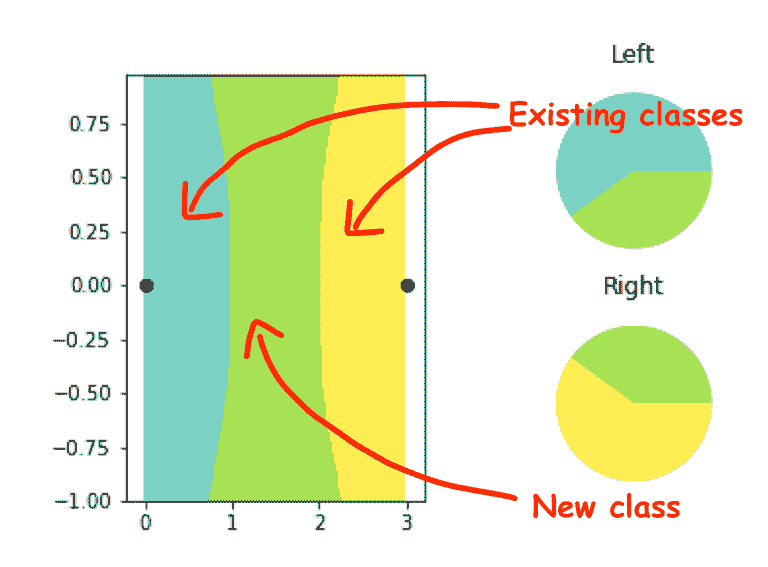

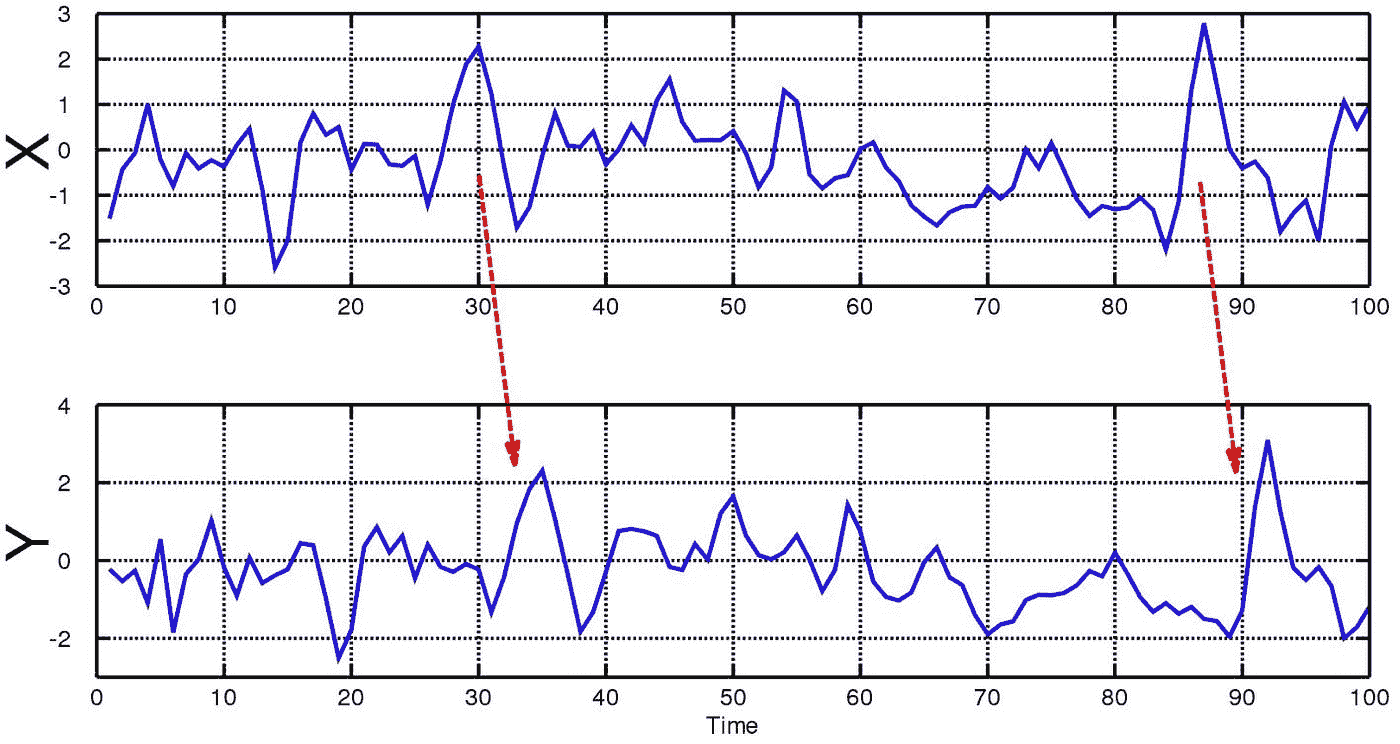

基本上,LO-shot 通过在现有类别之间划分空间来使用软标签创建新类别。

LO-shot 学习使用软标签来划分现有类别之间的空间。

在上面的示例中,有两个实例来调整机器学习模型(用黑点表示)。经典的 k-NN 算法会将两个点之间的空间分割为两个类别之间的空间。但是,被称为 OL-shot 学习模型的“软标签原型 k-NN”(SLaPkNN)算法,在两个类别之间创建了一个新的空间(绿色区域),该区域表示一个新标签(想象一下有翅膀的马)。在这里,我们已经实现了 N 个类别,具有 N-1 个样本。

在论文中,研究人员展示了 LO-shot 学习可以扩展到使用 N 个标签甚至更多的 3N-2 类别。

LO-shot 学习可以扩展以每个实例获得多个类别。左侧:从四个实例获得的 10 个类别。右侧:从五个实例获得的 13 个类别。

在他们的实验中,Sucholutsky 和 Schonlau 发现,通过正确配置软标签,LO-shot 机器学习即使在数据嘈杂的情况下也能提供可靠的结果。

“我认为 LO-shot 学习也可以从其他信息来源中获得成功——类似于许多零-shot 学习方法的做法——但软标签是最直接的方法,”Sucholutsky 说,并补充道,目前已经有几种方法可以为 LO-shot 机器学习找到合适的软标签。

虽然论文展示了 LO-shot 学习在 k-NN 分类器中的威力,但 Sucholutsky 表示,这种技术也适用于其他机器学习算法。“论文中的分析专门集中在 k-NN 上,因为它更容易分析,但它应该适用于任何可以利用软标签的分类模型,”Sucholutsky 说。研究人员很快将发布一篇更全面的论文,展示 LO-shot 学习在深度学习模型中的应用。

机器学习研究的新领域