KDNuggets-博客中文翻译-二十七-

KDNuggets 博客中文翻译(二十七)

原文:KDNuggets

如何优化你的简历以适应数据科学家职业

原文:

www.kdnuggets.com/2020/08/optimize-cv-data-scientist-career.html

评论

由 Dorian Martin,技术作家。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

(图片来源.)

想让你的数据科学家简历更吸引雇主吗?

你来对地方了。

在这篇文章中,你将找到专家的建议、示例和要点,以制作出足够好的简历,帮助你获得真正想要的工作。

数据科学雇主在简历中寻找什么?

让我们暂时成为数据科学招聘人员。

要在众多简历中脱颖而出,吸引雇主的注意,我们需要了解他们在候选人中寻找什么。

根据 成为数据科学家所需的 9 个必备技能*,这些是吸引雇主的最重要技能:

-

教育(至少拥有计算机科学、社会科学或统计学的学士学位)

-

R 编程

-

Python 编码

-

Hadoop 平台

-

SQL 数据库/编码

-

Apache Spark

-

机器学习和人工智能

-

数据可视化

-

非结构化数据。

因此,作为一个有意招聘数据科学家的人,你更可能在简历中寻找这些技能。

这就引出了第一个建议……

1. 将需求技能放在首位

为了省去招聘经理寻找你技能的麻烦,把它们放在简历的最上面。务必将它们列在一个单独的部分,以引起注意。

不要使用单列的项目符号列表来列出技能。这可能会占用大量简历空间,因此尝试其他方式。如果你没有使用设计师已经处理过空间的模板,你可以简单地将技能列在一句话中。

另一种更有创意的方式是像 Upwork 那样通过视觉上区分每项技能,Upwork 在其用户资料中这样做。

你应该按什么顺序列出技能?最佳的做法是首先列出那些需求量大的技能,然后再列出“较不显著”的技能。此外,不要忘记提供对技能水平的评估,例如,“初学者”,“中级”或“专家”。

要点:将你的技能列在前面。这将有助于引起招聘经理的注意,并让他们知道你是否是适合这份工作的候选人。

2. 提供详细且简洁的成就概述

这是另一个关键部分,值得放在简历的前半部分。这是招聘经理想要的“展示,而非告诉”部分。在要求你在面试中披露你的缺陷之前,他们需要被你的优势所吸引。

你的主要目标是找出并列出你的主要专业成就。

正确的做法如下:

-

仅包含相关成就。像“为学生提供专家级论文帮助,以提高他们的学术写作技能”这样的成就听起来很棒,但请坚持数据科学相关的成就。

-

包含数字。量化的成就能更好地展示你的影响力,例如,“通过定制的机器学习算法分析市场营销过程,实现节省$2,000”通过数字显得更具说服力。

-

每项成就只用一句话。你的简历应该控制在一页之内,所以要小心,每项成就限制为一句话。

专业提示:对于每项成就使用“技能 - 活动 - 结果”公式。

这是“通过定制机器学习算法分析市场营销过程,实现节省$2,000”示例中的部分:

-

技能:使用定制机器学习算法

-

活动:市场营销过程分析

-

结果:节省$2,000。

通过这种方式在简历中组织成就,你会使它们简明扼要。

3. 解释,而不是列出你的非技术技能

许多数据科学家犯了一个错误,就是将他们的软技能以项目符号列表的形式呈现。虽然提及这些技能很重要,但不要仅仅以这种方式呈现。

我是说,“口头沟通”这类内容对阅读你简历的人到底说了什么呢?

这需要一些细节来展示你的能力,对吗?

以下是一些示例:

| 非技术技能 | 出色描述 |

|---|---|

| 口头沟通 | 管理每周与客户的会议,以更新项目进展并收集反馈 |

| 书面沟通与团队合作 | 与 10 多个营销团队成员合作,应用数据分析模型来识别客户数据中的模式 |

| 讲故事 | 创建数据可视化演示文稿,并向客户展示以解释数据分析结果 |

| 适应能力 | 同时进行机器学习和数据可视化项目,以帮助识别意外问题并将结果转换为可视化 |

现在,这听起来更有趣了,对吧?

阅读你简历的招聘经理也会同意。

沟通和团队合作是最重要的软技能之一,需要以这种方式呈现。

为什么?因为大多数数据科学专业人士——约 60%——在五人或更多人的团队中工作,正如2019 年数据科学现状报告所说。

来源:数据科学现状 2019

描述这些非技术技能时唯一需要记住的就是每个技能只写一句话(就像成就一样)。

4. 匹配职位描述中的关键词

不秘密的是,招聘经理在职位描述中使用关键词。在数据科学行业,他们包括技能、资格、认证和技术的名称。

让我们看一下这份来自 LinkedIn 的数据科学家职位发布。虽然有点长,但请耐心点,这就是你很快也要做的事情。

职位发布中大多数关键词已为你下划线,以便你快速找到。

你能找到多少个呢?

这份职位发布字面上填满了完美候选人简历上应该有的关键词(如果你申请,这也意味着你需要)。

如果你想申请这样的职位,简历中有以下内容是非常重要的:机器学习、书面和口头沟通技能、软件工程、快速原型制作。

这些是主要的关键词,但你可以用你真正的专业知识涵盖更多的关键词,这样会更好。

重要! 不要让简历充满关键词。这会让招聘人员觉得不自然和可疑。自然地包含这些关键词,以避免显得过于刻意。

此外,关键词堆砌也可能暗示候选人这样做只是为了通过面试,这反过来意味着他们可能不具备资格。

你的下一步

按照你刚刚阅读的提示,制作那份出色的简历,并发送出去!

现在,它应该更加吸引人、详细,并且对潜在雇主更具吸引力。

如果你想了解公司如何聘请数据科学家,可以查看下面的指南(它有一个问题库,包含雇主用来评估数据科学家技能的问题!)

简介: 多里安·马丁拥有七年的技术内容写作经验,并帮助众多技术博客制定内容营销策略。目前,他在Essaysupply.com担任主编,协助制作优质内容。除了写作之外,多里安最大的热情是打排球和观看音乐纪录片。

相关:

更多相关内容

如何优化你的 Jupyter Notebook

评论

由 Pier Paolo Ippolito 提供,南安普顿大学

(来源: gdcoder.com/how-to-create-and-add-a-conda-environment-as-jupyter-kernel/)

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

介绍

Jupyter Notebook 现在可能是解决 Python 中机器学习/数据科学任务最常用的环境。

Jupyter Notebook 是一种客户端-服务器应用程序,用于在浏览器中运行 notebook 文档。Notebook 文档是能够包含代码和丰富文本元素(如段落、方程式等)的文档。

在这篇文章中,我将向你展示一些简单的技巧,帮助你提升 Jupyter Notebook 的使用体验。我们将从有用的快捷键开始,最后加入主题、自动生成的目录等内容。

快捷键

快捷键可以显著加快编写代码的速度。现在,我将向你介绍一些我发现的在 Jupyter 中最有用的快捷键。

与 Jupyter Notebook 互动的方式有两种:命令模式和编辑模式。一些快捷键只在一种模式下有效,而其他快捷键在两种模式下都适用。

一些在两种模式中都适用的快捷键包括:

-

Ctrl + Enter: 运行所有选定的单元格

-

Shift + Enter: 运行当前单元格并移动到下一个单元格

-

Ctrl + s: 保存 notebook

为了进入 Jupyter 命令模式,我们需要按 Esc 然后执行以下任一命令:

-

H: 显示 Jupyter Notebook 中所有可用的快捷键

-

Shift + 上/下箭头: 同时选择多个 notebook 单元格(选择多个单元格后按回车将使所有单元格运行!)

-

A: 在上方插入一个新单元格

-

B: 在下方插入一个新单元格

-

X: 剪切选定的单元格

-

Z: 撤销单元格的删除

-

Y: 将单元格类型更改为代码

-

M: 将单元格类型更改为 Markdown

-

Space: 向下滚动 notebook

-

Shift + 空格: 向上滚动 notebook

为了进入 Jupyter 编辑模式,我们需要按 Enter,然后依次执行以下任一命令:

-

Tab:代码竞赛建议

-

Ctrl + ]:增加代码缩进

-

**Ctrl + **:减少代码缩进

-

Ctrl + z:撤销

-

Ctrl + y:重做

-

Ctrl + a:全选

-

Ctrl + Home:将光标移动到单元格开头

-

Ctrl + End:将光标移动到单元格的末尾

-

Ctrl + Left:将光标向左移动一个单词

-

Ctrl + Right:将光标向右移动一个单词

Shell 命令和包安装

很少有用户知道这一点,但实际上可以通过在单元格开头添加感叹号来在 Jupyter notebook 单元格中运行 shell 命令。例如,运行一个包含 !ls 的单元格将返回当前工作目录中的所有项目。运行一个包含 !pwd 的单元格则会打印出当前目录的文件路径。

相同的技巧也可以用于在 Jupyter notebook 中安装 Python 包。

!pip install numpy

Jupyter 主题

如果你对改变 Jupyter notebook 的外观感兴趣,可以安装一个包含不同主题的包。默认的 Jupyter 主题如图 1 所示。在图 2 中你将看到我们如何能够个性化它的外观。

图 2:Solarized1 notebook 主题

如果你想随时恢复到原始的 Jupyter notebook 主题,只需运行以下命令并刷新页面即可。

!jt -r

Jupyter Notebook 扩展

Notebook 扩展可以用来增强用户体验,并提供各种个性化技巧。

在这个例子中,我将使用 nbextensions 库来安装所有必要的控件(这次我建议你先通过终端安装包,然后再打开 Jupyter notebook)。这个库利用不同的 Javascript 模型来丰富 notebook 的前端。

! pip install jupyter_contrib_nbextensions

! jupyter contrib nbextension install --system

一旦 nbextensions 被安装,你会注意到在 Jupyter notebook 主页上多了一个额外的标签(图 3)。

图 3:将 nbextensions 添加到 Jupyter notebook

通过点击 Nbextensions 标签,我们将看到可用的控件列表。在我的案例中,我决定启用图 4 中显示的控件。

图 4:nbextensions 控件选项

我的一些最喜欢的扩展是:

1. 目录

自动从 markdown 标题生成目录(图 5)。

图 5:目录

2. 代码片段

加载常用库和创建样本图的代码示例,你可以将其作为数据分析的起点(图 6)。

图 6:代码片段

3. Hinterland

Jupyter 笔记本的代码自动补全(图 7)。

图 7:代码自动补全

nbextensions 库提供了许多其他扩展,因此我鼓励你尝试和测试其他对你可能感兴趣的扩展!

Markdown 选项

默认情况下,Jupyter 笔记本单元格中的最后输出是唯一打印的内容。如果我们想要自动打印所有命令而不使用 print(),可以在笔记本开始时添加以下代码行。

from IPython.core.interactiveshell import InteractiveShell

InteractiveShell.ast_node_interactivity = "all"

此外,可以通过将文本包围在美元符号($)之间来在 Markdown 单元格中编写 LaTex。

笔记本幻灯片

通过进入 视图 -> 单元格工具栏 -> 幻灯片 并选择笔记本中每个单元格的幻灯片配置,可以创建 Jupyter 笔记本的幻灯片演示。

最后,通过进入终端并输入以下命令,将创建幻灯片放映。

pip install jupyter_contrib_nbextensions

# and successively:

jupyter nbconvert my_notebook_name.ipynb --to slides --post serve

魔法命令

魔法命令是可以用来执行特定操作的指令。举例来说:内联绘图、打印单元格的执行时间、打印运行单元格的内存消耗等。

以单个 % 开头的魔法命令只应用于单元格中的一行(命令所在的行)。而以两个 %% 开头的魔法命令则应用于整个单元格。

可以使用以下命令打印出所有可用的魔法命令:

%lsmagic

联系信息

如果你想保持对我最新文章和项目的更新, 关注我 并订阅我的 邮件列表。以下是我的一些联系方式:

简介:Pier Paolo Ippolito 是南安普顿大学人工智能硕士课程的最后一年学生。他是一名 AI 爱好者、数据科学家和 RPA 开发者。

原文。经授权转载。

相关内容:

-

笔记本反模式

-

GPU 加速的数据分析与机器学习

-

利用机器学习理解癌症

了解更多此主题

优化生产环境中机器学习 API 的响应时间

原文:

www.kdnuggets.com/2020/05/optimize-response-time-machine-learning-api-production.html

评论

由 Yannick Wolf,Sicara 领先数据科学家

本文展示了如何通过构建更智能的 API 服务深度学习模型来最小化响应时间。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

你的团队努力为特定任务(比如:通过计算机视觉检测商店中的购买产品)构建了一个深度学习模型。很好。

然后你开发并部署了一个集成此模型的 API(让我们继续这个例子:自助结账机会调用这个 API)。太棒了!

新产品运行良好,你感觉所有工作都已完成。

但由于经理决定安装更多自助结账机(我真的很喜欢这个例子),用户开始抱怨每次扫描商品时都会出现巨大的延迟。

你可以做什么?购买速度快十倍且昂贵十倍的 GPU?让数据科学家尝试在不降低准确性的情况下减少模型的深度?

更便宜、更简单的解决方案存在,如本文所示。

一个基础的 API 和一个大型虚拟模型

首先,我们需要一个具有长推理时间的模型。以下是我如何使用 TensorFlow 2's Keras API 来实现这一点(如果你不熟悉这个深度学习框架,可以跳过这段代码):

在我的 GeForce RTX 2080 GPU 上测试模型时,我测得推理时间为 303 毫秒。这就是我们可以称之为大模型的情况。

现在,我们需要一个非常简单的 API 来服务我们的模型,仅一个路由来请求预测。Python 中一个非常标准的 API 框架是 Flask。这是我选择的框架,还有一个叫做 Gunicorn 的 WSGI HTTP 服务器。

我们独特的路径解析请求中的输入,调用实例化的模型,并将输出发送回用户。

我们可以使用以下命令运行我们的深度学习 API:

gunicorn wsgi:app

好的,现在我可以向我的 API 发送一些随机数字,它会用其他随机数字回应我。问题是:有多快?

让我们对我们的 API 进行负载测试

我们确实想了解我们的 API 响应有多快,特别是当每秒请求数量增加时。这样的负载测试可以使用 Locust Python 库进行。

这个库与一个 locustfile.py 一起工作,指示要模拟的行为:

Locust 模拟多个用户同时执行不同的任务。在我们的案例中,我们只想定义一个任务,即使用随机输入调用 /predict 路由。

我们还可以参数化wait_time,这是一个模拟用户在接收到 API 响应后等待的时间,然后再发送下一个请求。为了模拟自助结账的用例,我将这个时间设置为 1 到 3 秒之间的随机值。

用户数量通过 Locust 的仪表盘选择,所有统计数据都会实时显示。可以通过调用以下命令来运行此仪表盘:

locust --host=[`localhost:8000`](http://localhost:8000/) # host of the API you want to load test

Locust 仪表盘

那么,当我们增加用户数量时,我们天真的 API 会有什么反应呢?正如我们所预期的,反应非常糟糕:

-

使用 1 个用户时,我测量的平均响应时间是 332 ms(略高于之前测量的孤立推理时间,没什么惊讶的)

-

使用 5 个用户时,这个平均时间稍微增加了一点:431 ms

-

使用 20 个用户时,它达到了 4.1 秒(比 1 个用户时多了 12 倍以上)

当我们考虑到 API 是如何处理请求的,这些结果并不那么令人惊讶。默认情况下,Gunicorn 启动 2 个进程:一个主进程监听传入的请求,将它们存储在一个 FIFO 队列中,并将它们依次发送到一个工作进程,每次工作进程可用时。后者会运行您的代码来计算每个请求的响应。

由于工作进程是单线程的,请求是逐一处理的。如果 5 个请求同时到达,第 5 个请求将在 5 x 300 ms = 1500 ms 后收到响应,这解释了 20 个用户时高的平均响应时间。

越多越快

幸运的是,Gunicorn 提供了两种通过增加以下内容来扩展 API 的方法:

-

处理请求的线程数量

-

工作进程的数量

多线程选项可能不是对我们帮助最大的一种,因为 TensorFlow 不允许一个线程访问在另一个线程中初始化的会话图。

另一方面,设置大于 1 的工作进程数量将创建多个进程,每个工作进程都初始化整个 Flask 应用程序。每个进程都会实例化自己的 TensorFlow 会话和模型。

让我们通过运行以下命令来尝试这种方法:

gunicorn wsgi:app --workers=5

这是我们在多工人 API 中获得的新性能:

你可以看到,使用 5 个工人而不是 1 个工人对响应时间的影响是巨大的:20 个用户的 4.1 秒平均时间几乎减少了一半。减少了两倍,而不是预期的五倍,因为请求之间的等待时间——如果模拟用户在收到响应后立即重新请求 API,响应时间将减少五倍。

你可能会想知道为什么我止步于 5 个工人:为什么不设置 20 个工人,以便能够处理 20 个用户在同一时间请求 API 的情况?原因是每个工人是一个独立的进程,在 GPU 内存中实例化其自己的模型版本。

因此,20 名工人仅仅在初始化权重时就会消耗 20 倍模型的大小,推理计算则需要更多的内存。对于一个 2GiB 的模型和一个 8GiB 的 GPU 来说,我们的资源有些有限。

每个工人消耗 2349MiB 的 GPU 内存

通过调整分配给每个工人的内存,可以最大化运行工人的数量,使用 TensorFlow 参数(TensorFlow 1.x 中的 per_process_gpu_memory_fraction 和 TensorFlow 2.x 中的 memory_limit——我只测试过第一个),将其设置为不会因内存不足错误而导致预测失败的最小值。

正如库所警告的那样,减少可用内存可能会通过禁用优化理论上增加推理时间。然而,我个人并没有注意到任何显著变化。

无论如何,这样做并不能让我们运行 20 个工人,即使使用我们的 2 个 GPU。那么,买 2 个更多的 GPU?别慌,你还有其他的解决方案。

欲速则不达

现在让我们回到单工人的情况。如果你考虑到当两个或更多请求几乎同时到达此 API 时发生的情况,会发现有一些优化不到位的地方:

3 个请求间隔 100 毫秒到达,平均响应时间为 1433 毫秒

API 将 3 个输入逐个通过模型。然而,由于深度学习模型的数学运算特性,大多数模型可以同时处理多个输入而不会增加推理时间——这就是我们所说的批处理,也就是我们在训练阶段通常做的。

那么,为什么不将这 3 个输入批量处理呢?这将意味着在接收到第一个请求后,API 会稍等片刻,以接收接下来的 2 个请求,然后一次性处理所有请求。这会增加第一个请求的响应时间,但在平均上会减少。

如果 API 在处理批量请求之前等待 300 毫秒,我们得到的平均响应时间是 600 毫秒

在实践中,我们不知道未来请求何时到达,而且决定等待潜在下一个请求的时间有点复杂。一条相当合理的规则是触发处理排队请求的时间是:

- 如果排队请求的数量达到最大值,通常对应于 GPU 内存限制或最大用户数(如果已知)

或者

- 如果队列中最旧的请求比超时时间值还要久。这一值需要通过经验调优以最小化平均响应时间。

这里有一种实现这种行为的方法,仍然使用 Gunicorn - Flask - TensorFlow 堆栈,使用 Python 队列和专门处理批量请求的线程。

这个新 API 必须以与我们希望能够处理的批处理请求最大数量相同的线程数运行:

gunicorn wsgi:app --threads=20

以下是我在对超时时间值进行快速微调后的非常满意的结果:

如你所见,当仅模拟 1 个用户时,这个新 API 设置的超时时间为 500 毫秒,会使响应时间增加 500 毫秒(超时时间值),当然是无用的。但对于 20 个用户,平均响应时间减少了 6 倍。

注意,为了获得更好的结果,这种批处理技术可以与上述的多工人技术并行使用。

难道我们没有重新发明轮子吗?

作为开发人员,从头开始编写一些可能已经由现有工具实现的东西是一种隐秘的快乐,这也是我们在这篇文章中一直做的事情。

确实存在一个用于在 API 中服务 TensorFlow 模型的工具。它由 TensorFlow 开发,名为... TensorFlow Serving。

它不仅允许为模型启动一个预测 API,而无需编写模型以外的任何其他代码,而且还提供了几种你可能会觉得有趣的优化,例如并行处理和请求批处理!

要使用 TF Serving 服务一个模型,你需要做的第一件事是将其导出到磁盘(使用 TensorFlow 格式,而不是 Keras 格式),可以使用以下代码实现:

然后,启动一个服务 API 的最简单方法之一是使用 TF Serving docker 镜像。

下面的命令将启动一个预测 API,你可以通过请求此端点来测试:localhost:8501/v1/models/my_model:predict

docker run -p 8501:8501 \

--mount type=bind,source=/path/to/my_model/,target=/models/my_model \

-e MODEL_NAME=my_model -it tensorflow/serving

注意,它默认不使用 GPU。你可以在 此文档 中找到如何使其工作。

关于批处理呢?你需要编写这样的批处理配置文件:

max_batch_size { value: 20 }

batch_timeout_micros { value: 500000 }

max_enqueued_batches { value: 100 }

num_batch_threads { value: 8 }

特别包括了我们自定义实现中使用的 2 个参数:max_batch_size 和 batch_timeout_micros 参数。后者是我们称之为超时的参数,必须以微秒为单位给出。

最后,运行启用了批处理的 TF Serving 的命令是:

docker run -p 8501:8501 \

--mount type=bind,source=/path/to/my_model/,target=/models/my_model \

--mount type=bind,source=/path/to/batching.cfg,target=/batching.cfg \

-e MODEL_NAME=my_model -it tensorflow/serving \

--enable_batching --batching_parameters_file=/batching.cfg

我进行了测试,感谢一些黑魔法,我得到了比自定义批处理 API 更好的结果:

我希望你能利用本文中提出的不同技巧来提升你自己的机器学习 API。我没有探索的很多领域,尤其是模型本身的优化(而不是 API),如模型剪枝或后训练量化。

简历:Yannick Wolf 是 Sicara 的首席数据科学家。

原文。经许可转载。

相关:

-

机器学习部署的软件接口

-

TensorFlow 2.0 教程:优化训练时间性能

-

如何在 3 个简单步骤中对任何 Python 脚本进行超参数调优

更多相关主题

如何优化 SQL 查询以加快数据检索速度

原文:

www.kdnuggets.com/2023/06/optimize-sql-queries-faster-data-retrieval.html

图片作者

SQL(结构化查询语言),如你所知,帮助你从数据库中收集数据。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能。

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT。

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT。

它是专门为此设计的。换句话说,它处理行和列,使你能够使用 SQL 查询操作数据库中的数据。

什么是 SQL 查询?

SQL 查询是一组你给数据库的指令,用以收集信息。

你可以通过使用这些查询来收集和操作数据库中的数据。

通过使用它们,你可以创建报告、进行数据分析等。

由于这些查询的形式和长度,执行时间可能会很长,特别是当你处理更大的数据表时。

为什么我们需要 SQL 查询优化?

SQL 查询优化的目的是确保你有效地使用资源。简单来说,它可以减少执行时间,节省成本,并提高性能。这是开发人员和数据分析师的重要技能。不仅仅是从数据库中返回正确的数据同样重要,你还需要知道你是多么高效地做到这一点。

你应该总是问自己:“有没有更好的方式来编写我的查询?”

让我们更深入地探讨一下原因。

资源效率: 未优化的 SQL 查询会消耗过多的系统资源,如 CPU 和内存。这可能导致整体系统性能降低。优化 SQL 查询可以确保这些资源的高效使用,从而带来更好的性能和可扩展性。

减少执行时间: 如果查询运行缓慢,这会对用户体验产生负面影响。或者如果你有一个运行中的应用程序,这也会影响应用程序性能。优化查询可以帮助减少执行时间,提供更快的响应时间和更好的用户体验。

成本节约: 优化的查询可以减少支持数据库系统所需的硬件和基础设施。这可以导致硬件、能源和维护成本的节省。

查看 “编写 SQL 查询的最佳实践” 以了解如何改善你的代码结构,即使它是正确的。

SQL 查询优化技术

这是我们将在本文中涵盖的 SQL 查询优化技术概述。

作者提供的图片

这是一个显示优化 SQL 查询时建议遵循的步骤的流程图。我们将在示例中采用相同的方法。值得注意的是,优化工具也可以帮助提高查询性能。因此,让我们从著名的 SQL 命令 SELECT 开始探索这些技术。

作者提供的图片

使用指定字段的 SELECT 代替 SELECT *

当你使用 SELECT * 时,它将返回表中的所有行和所有列。你需要问自己是否真的需要这样做。

使用特定字段替代扫描整个数据库。

在这个示例中,我们将用具体的列名替换 SELECT *。如你所见,这将减少检索的数据量。

结果是,查询运行得更快,因为数据库只需获取和提供请求的列,而不是表的所有列。

这可以最小化数据库的 I/O 负担,尤其是在表包含大量列或大量数据行时特别有用。

以下是优化前的代码。

SELECT * FROM customer;

这是输出。

总查询运行时间为 260 毫秒。这是可以改进的。

为了展示这一点,我将仅选择 3 个不同的列,而不是选择所有列。

你可以根据项目需求选择所需的列。

这是代码。

SELECT customer_id,

age,

country

FROM customer;

这是输出。

正如你所见,通过定义我们要选择的字段,我们不会强迫数据库扫描所有数据,因此运行时间从 260 毫秒减少到 79 毫秒。

想象一下,如果有数百万或数十亿行,或者数百列会是什么情况。

避免使用 SELECT DISTINCT

SELECT DISTINCT 用于返回指定列中的唯一值。为此,数据库引擎必须扫描整个表并删除重复值。在许多情况下,使用诸如 GROUP BY 之类的替代方法可以通过减少处理的数据量来提高性能。

这是代码。

SELECT DISTINCT segment

FROM customer;

这是输出。

我们的代码?? 从客户表中检索 segment 列中的唯一值。数据库引擎必须处理表中的所有记录,识别重复值,并仅返回唯一值。这可能在时间和资源上是昂贵的,特别是对于大型表。

在替代版本中,以下查询通过使用 GROUP BY 子句来检索 segment 列中的唯一值。GROUP BY 子句根据指定的列对记录进行分组,并为每个组返回一条记录。

这是代码。

SELECT segment

FROM customer

GROUP BY segment;

这是输出结果。

在这种情况下,GROUP BY 子句有效地根据 segment 列对记录进行分组,结果与 SELECT DISTINCT 查询相同。

通过避免使用 SELECT DISTINCT,而改用 GROUP BY,你可以优化 SQL 查询,将总查询时间从 198 毫秒减少到 62 毫秒,速度提高了三倍多。

避免使用循环

循环可能会导致查询变慢,因为它们强迫数据库逐条记录进行处理。

在可能的情况下,使用内置操作和 SQL 函数,这可以利用数据库引擎的优化并更高效地处理数据。

让我们定义一个带有循环的自定义函数。

CREATE OR REPLACE FUNCTION sum_ages_with_loop() RETURNS TABLE (country_name TEXT, sum_age INTEGER) AS $$

DECLARE

country_record RECORD;

age_sum INTEGER;

BEGIN

FOR country_record IN SELECT DISTINCT country FROM customer WHERE segment = 'Corporate'

LOOP

SELECT SUM(age) INTO age_sum FROM customer WHERE country = country_record.country AND segment = 'Corporate';

country_name := country_record.country;

sum_age := age_sum;

RETURN NEXT;

END LOOP;

END;

$$ LANGUAGE plpgsql;

上面的代码使用基于循环的方法来计算每个国家中客户 segment 为 'Corporate' 的年龄总和。

它首先检索一个唯一国家的列表,然后使用循环遍历每个国家,计算该国客户的年龄总和。这种方法可能会很慢且效率低,因为它逐行处理数据。

现在让我们运行这个函数。

SELECT *

FROM sum_ages_with_loop()

这是输出结果。

使用这种方法的运行时间为 198 毫秒。

让我们看看我们优化后的 SQL 代码。

SELECT country,

SUM(age) AS sum_age

FROM customer

WHERE segment = 'Corporate'

GROUP BY country;

这是它的输出结果。

一般来说,使用单个 SQL 查询的优化版本会表现得更好,因为它可以利用数据库引擎的优化能力。

为了在我们第一个代码中获得相同的结果,我们在 PL/pgSQL 函数中使用了循环,这通常比使用单个 SQL 查询更慢且效果较差。并且它强迫你编写更多的代码行!

正确使用通配符

适当地使用通配符对优化 SQL 查询至关重要,特别是在匹配字符串和模式时。

通配符是 SQL 查询中用于查找特定模式的特殊字符。

SQL 中最常用的通配符是“%”和“”,其中“%”代表任意字符序列,“”代表单个字符。

明智地使用通配符很重要,因为不当使用可能会导致性能问题,尤其是在大型数据库中。

然而,效率地使用它们可以大大提高字符串匹配和模式匹配查询的性能。

现在让我们查看我们的例子。

这个查询使用 RIGHT() 函数提取 customer_name 列的最后三个字符,然后检查它是否等于 'son'。

SELECT customer_name

FROM customer

WHERE RIGHT(customer_name, 3) = 'son';

这是输出结果。

尽管这个查询达到了预期的结果,但效率不是很高,因为 RIGHT() 函数必须应用到表中的每一行。

让我们通过使用通配符来优化我们的代码。

SELECT customer_name

FROM customer

WHERE customer_name LIKE '%son';

这是输出结果。

这个优化后的 SQL 查询使用 LIKE 运算符和通配符 “%” 来查找 customer_name 列以 'son' 结尾的记录。

这种方法更高效,因为它利用了数据库引擎的模式匹配能力,如果有索引的话,它能更好地利用索引。

如我们所见,总查询时间从 436 毫秒减少到 62 毫秒,几乎快了 7 倍。

使用 TOP 或 LIMIT 来限制样本结果的数量

使用 TOP 或 LIMIT 来限制样本结果对于优化 SQL 查询至关重要,尤其是处理大型表时。

这些子句允许你从表中检索指定数量的记录,而不是所有记录,这对性能是有益的。

现在,让我们从客户表中检索所有信息。

SELECT *

FROM customer

这是输出结果。

在处理大型表时,这个操作可能增加 I/O 和网络延迟,从而降低 SQL 查询性能。

现在让我们通过限制输出为 10 条来优化代码。

SELECT *

FROM customer

LIMIT 10;

这是输出结果。

通过限制输出,你将减少网络延迟和内存使用,改善响应时间,特别是在处理大型表时。在我们的例子中,SQL 查询优化后,总查询运行时间从 260 毫秒减少到 89 毫秒。

所以我们的查询速度变快了近 3 倍。

使用索引

这次,我们将识别并创建适当的索引,用于 WHERE、JOIN 和 ORDER BY 子句中的列,以提高查询性能。

通过对频繁访问的列建立索引,数据库可以更快地检索数据。

现在,让我们首先运行以下查询。

SELECT customer_id,

customer_name

FROM customer

WHERE segment = 'Corporate';

这是输出结果。

我们的查询运行时间为 259 毫秒。

让我们尝试通过创建索引来进一步改进。

CREATE INDEX idx_segment ON customer (segment);

很好,现在我们再次运行代码。

SELECT customer_id,

customer_name

FROM customer WITH (INDEX(idx_segment))

WHERE segment = 'Corporate';

这是输出结果。

通过在 INDEX() 中使用 idx_segment,数据库引擎能够基于 segment 列高效搜索客户表,使查询速度更快——将总查询时间从 259 毫秒减少到 75 毫秒。

奖励部分:使用 SQL 查询优化工具

由于长代码和高度复杂查询的复杂性,你可能考虑使用查询优化工具。

这些工具可以分析你的查询执行计划,识别缺失的索引,并建议替代查询结构,以帮助优化查询。一些流行的查询优化工具包括:

- SolarWinds 数据库性能分析器:该工具帮助你监控和提升数据库性能。它展示了查询中的问题及其运行方式。它兼容多种数据库系统,如 SQL Server、Oracle 和 MySQL。

你可以在这里找到它。

-

SQL Query Tuner for SQL Diagnostic Manager:该工具具有先进的功能来提升查询效果,如性能提示、索引检查以及展示查询的运行方式。它帮助你通过发现和修复问题来改进 SQL 查询。

-

SQL Server Management Studio (SSMS):SSMS 具有内置工具来检查性能和优化查询,如活动监视器、执行计划分析和索引调整向导。

-

EverSQL:EverSQL 是一个在线工具,通过查看数据库结构和查询运行方式自动优化你的查询。它提供建议并重写你的 SQL 查询以提高速度。

使用 SQL 查询优化工具和资源对于改进查询至关重要。通过这些工具,你可以了解查询的工作原理,发现问题,并采用最佳实践来加快数据获取速度,提升应用程序性能。

如果你想简化复杂的 SQL 查询,可以查看 “如何简化复杂 SQL 查询”。

最后的说明

通过优化 SQL 查询所做的更改可能由于其规模(毫秒)看起来微不足道。但随着你处理的数据量增长,这些毫秒将变为秒、分钟,甚至小时。到那时,你会意识到这些 SQL 查询优化技术是非常重要的。

如果你想了解更多,这里有30 个顶级 SQL 查询面试问题,这将帮助那些在学习时也想为面试做准备的人。

感谢阅读!

Nate Rosidi 是一名数据科学家及产品战略专家。他还是一名兼职教授,教授分析课程,并且是StrataScratch的创始人,这个平台帮助数据科学家通过顶级公司的真实面试问题准备面试。可以在Twitter: StrataScratch或LinkedIn上与他联系。

更多相关内容

优化数据分析:在 Databricks 中集成 GitHub Copilot

原文:

www.kdnuggets.com/optimizing-data-analytics-integrating-github-copilot-in-databricks

介绍

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

GitHub Copilot 是 GitHub 和 OpenAI 合作开发的人工智能驱动的代码补全助手,利用 ChatGPT 模型。它旨在帮助开发者加速编码过程,同时减少错误。该模型在 GitHub 自有代码库和公开可用代码的混合数据上进行训练,赋予其广泛的编程范式理解。

另一方面,Databricks 是一个由 Apache Spark 原始创建者创建的开源分析和云平台,帮助组织无缝构建数据分析和机器学习管道,从而加速创新。此外,它促进了用户之间的协作。

将 GitHub Copilot 与 Databricks 集成,使数据分析和机器学习工程师能够高效且及时地部署解决方案。此集成促进了更顺畅的代码开发,提高了代码质量和标准化,提升了跨语言效率,加快了原型开发,并有助于文档编写,从而提高了工程师的生产力和效率。

GitHub Copilot 和 Databricks 集成的前提条件:

Databricks 账户 设置。

设置 GitHub Copilot。

下载并安装 Visual Studio Code。

集成步骤

在 Visual Studio Code 市场中安装 Databricks 插件。

在 Visual Studio Code 中配置 Databricks 插件。如果你之前使用过 Databricks CLI,那么它已经在 databrickscfg 文件中为你本地配置好。如果没有,请在 ~/.databrickscfg 文件中创建以下内容。

[DEFAULT]

host = https://xxx

token = <token>

jobs-api-version = 2.0

点击“配置 Databricks”选项,然后从下拉菜单中选择第一个选项,该选项显示在上述步骤中配置的主机名,并继续使用“DEFAULT”配置文件。

配置完成后,Databricks 连接会与 Visual Studio Code 建立。点击 Databricks 插件时,可以查看工作区和集群配置详细信息。

用户完成 GitHub Copilot 账户设置后,确保您可以访问 GitHub Copilot。通过 Marketplace 在 VSCode 中安装 GitHub Copilot 和 GitHub Copilot Chat 插件。

一旦用户安装了 GitHub Copilot 和 Copilot Chat 插件,将提示通过 Visual Studio IDE 登录 GitHub Copilot。如果没有提示进行授权,请点击 Visual Studio 代码 IDE 底部面板中的铃铛图标。

现在,是时候使用 GitHub Copilot 开发了

开发数据工程管道

数据工程师可以利用 GitHub Copilot 快速编写数据工程管道,包括文档,几乎无需时间。以下是使用提示技术创建简单数据工程管道的步骤。

使用 Python 和 Spark 框架从 S3 存储桶中读取文件。

使用 Python 和 Spark 框架将数据框写入 S3 存储桶

通过主方法执行函数:在提示中表示相同,并通过代码执行步骤得到结果

在 Databricks 中使用 GitHub Copilot 进行数据工程和机器学习的好处

-

优秀的 AI 配对编程工具,可快速提供合理建议并生成模板代码。

-

顶级建议,以优化代码和运行时间。

-

更好的文档和逻辑步骤的 ASCII 表示。

-

更快的数据管道实现,错误最小。

-

详细解释现有的简单/复杂功能,并建议智能代码重构技术。

备忘单

-

打开一个 Co-pilot 文本/搜索栏,您可以在其中输入您的提示。

![优化数据分析:在 Databricks 中集成 GitHub Copilot]()

Windows: [Cltr] + [I]

Mac: Command + [I]

-

在右侧打开一个单独的窗口,显示前 10 个代码建议。

Windows: [Cltr] + [Enter]

Mac: [control] + [return]

-

在左侧打开一个单独的 Copilot 聊天窗口。

Windows: [Cltr] + [Alt] + [I]

Mac: [Control] + [Command] + [I]

-

驳回内联建议。

Windows/Mac: Esc

-

接受建议。

Windows/Mac: Tab

-

参考以前的建议。

Windows: [Alt] + [

Mac: [option] + [

-

检查下一个建议

Windows: [Alt] + ]

Mac: [option] + ]

结论

人工智能配对编程工具与集成开发环境的集成,帮助开发人员通过实时代码建议加速开发,减少查阅文档以获取模板代码和语法的时间,并使开发人员能够专注于创新和业务问题解决方案。

进一步资源

Naresh Vurukonda** 是一位首席架构师,在医疗保健、生命科学和媒体网络组织中拥有超过 10 年的数据工程和机器学习项目经验。

更多相关主题

优化数据存储:探索 SQL 中的数据类型和规范化

原文:

www.kdnuggets.com/optimizing-data-storage-exploring-data-types-and-normalization-in-sql

图片由作者提供

在当今世纪,数据是新的石油。优化数据存储对获取良好的性能始终至关重要。选择合适的数据类型并应用正确的规范化过程对于决定其性能至关重要。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路

1. 谷歌网络安全证书 - 快速进入网络安全职业道路

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 工作

本文将研究最重要且常用的数据类型,并了解规范化过程。

SQL 中的数据类型

SQL 中主要有两种数据类型:字符串和数值。除此之外,还有布尔型、日期和时间、数组、区间、XML 等额外的数据类型。

字符串数据类型

这些数据类型用于存储字符字符串。字符串通常作为数组数据类型实现,包含一个元素序列,通常是字符。

- CHAR(n):

这是一个固定长度的字符串,可以包含字符、数字和特殊字符。n表示它可以容纳的字符串的最大长度。

它的最大范围是从 0 到 255 个字符,问题在于这种数据类型会占用指定的全部空间,即使字符串的实际长度少于指定长度。额外的字符串长度会用额外的内存空间填充。

- VARCHAR(n):

Varchar 类似于 Char,但可以支持可变大小的字符串,没有填充。该数据类型的存储大小等于字符串的实际长度。

它最多可以存储 65535 个字符。由于其可变长度特性,其性能不如 CHAR 数据类型。

- BINARY(n):

它类似于 CHAR 数据类型,但只接受二进制字符串或二进制数据。它可以用于存储图像、文件或任何序列化对象。还有一种数据类型VARBINARY(n),类似于 VARCHAR 数据类型,但也只接受二进制字符串或二进制数据。

- TEXT(n):

这种数据类型也用于存储字符串,但其最大尺寸为 65535 字节。

- BLOB(n): 代表二进制大型对象,存储数据最多可达 65535 字节。

除这些之外,还有其他数据类型,如 LONGTEXT 和 LONGBLOB,它们可以存储更多的字符。

数值数据类型

- INT():

它可以存储一个 4 字节(32 位)的数字整数。这里的 n 表示显示宽度,最大可以达到 255。它指定用于显示整数值的最小字符数。

范围:

-

a) -2147483648 <= 有符号 INT <= 2147483647

-

b) 0 <= 无符号 INT <= 4294967295

-

BIGINT():

它可以存储最大为 64 位的大整数。

范围:

-

a) -9223372036854775808 <= 有符号 BIGINT <= 9223372036854775807

-

b) 0 <= 无符号 BIGINT <= 18446744073709551615

-

FLOAT():

它可以存储带有小数位的浮点数,精度有一定的近似。它存在一些小的舍入误差,因此在需要精确度的情况下不适合使用。

- DOUBLE():

此数据类型表示双精度浮点数。与 FLOAT 数据类型相比,它可以存储更高精度的十进制值。

- DECIMAL(n, d):

此数据类型表示具有固定精度的确切十进制数字,精度由 d 表示。参数 d 指定小数点后的位数,参数 n 表示数字的大小。d 的最大值为 30,默认值为 0。

其他数据类型

- BOOLEAN:

该数据类型仅存储两个状态:真或假。它用于执行逻辑操作。

- ENUM:

它代表枚举类型。它允许你从预定义选项列表中选择一个值。它还确保存储的值仅来自指定的选项。

例如,考虑一个属性 color,它只能是 'Red'、'Green' 或 'Blue'。当我们将这些值放入 ENUM 时,color 的值只能是这些指定的颜色。

- XML:

XML 代表可扩展标记语言。此数据类型用于存储用于结构化数据表示的 XML 数据。

- 自动编号:

它是一个整数,每当添加记录时,值会自动递增。它用于生成唯一或顺序的数字。

- 超链接:

它可以存储文件和网页的超链接。

这完成了我们关于 SQL 数据类型的讨论。还有许多其他数据类型,但我们讨论的数据类型是最常用的。

SQL 中的归一化

归一化是从数据库中去除冗余、不一致和异常的过程。冗余指的是相同数据的重复值存在,而数据库中的不一致性指的是相同的数据在多个表中以不同格式存在。

数据库异常可以定义为数据库中任何突然出现或不应存在的变化或差异。这些变化可能由于各种原因,如数据损坏、硬件故障、软件漏洞等。异常可能导致严重后果,如数据丢失或不一致,因此尽快检测和修复异常至关重要。主要有三种类型的异常。我们将简要讨论每一种,但如果你想了解更多,请参考这篇文章。

- 插入异常:

当新插入的行在表中创建不一致时,会导致插入异常。例如,我们想将一个员工添加到组织中,但他的部门尚未分配给他。那么我们无法将该员工添加到表中,这就产生了插入异常。

- 删除异常:

删除异常发生在我们想从表中删除某些行时,需要从数据库中删除其他数据。

- 更新异常:

当我们想更新某些行时,会发生这种异常,这会导致数据库中的不一致。

规范化过程包含一系列准则,使数据库设计高效、优化且不含冗余和异常。存在多种类型的范式,如 1NF、2NF、3NF、BCNF 等。

1. 第一范式(1NF)

第一范式确保表中不包含复合属性或多值属性。这意味着单一属性中只能存在一个值。如果每个属性都是单值的,则关系处于第一范式。

例如

图片由GeeksForGeeks提供

在表 1 中,属性STUD_PHONE包含多个电话号码。但是在表 2 中,该属性被分解为第一范式。

2. 第二范式

表必须处于第一范式,并且关系中不得存在任何部分依赖。部分依赖意味着非主属性(即不属于候选键的属性)部分依赖于候选键的任何适当子集。为了使关系处于第二范式,非主属性必须完全依赖于整个候选键。

例如,考虑一个名为Employees的表,具有以下属性。

EmployeeID (Primary Key)

ProjectID (Primary Key)

EmployeeName

ProjectName

HoursWorked

在这里,EmployeeID 和 ProjectID 一起构成主键。然而,你可以注意到 EmployeeName 和 EmployeeID 之间存在部分依赖。这意味着 EmployeeName 仅依赖于主键的一部分(即 EmployeeID)。为了完全依赖,EmployeeName 必须依赖于 EmployeeID 和 ProjectID。因此,这违反了第二范式的原则。

要使该关系处于第二范式,我们必须将表拆分为两个独立的表。第一个表包含所有员工详细信息,第二个表包含所有项目详细信息。

因此,Employee 表具有以下属性,

EmployeeID (Primary Key)

EmployeeName

并且 Project 表具有以下属性,

Project ID (Primary Key)

Project Name

Hours Worked

现在你可以看到,通过创建两个独立的表,部分依赖关系被消除了。而两个表中的非主属性依赖于主键的完整集合。

3. 第三范式

在第二范式之后,关系仍可能存在更新异常。如果我们仅更新一个元组而不更新另一个,则可能导致数据库中的不一致。

第三范式的条件是表应处于第二范式(2NF),并且非主属性之间没有传递依赖关系。传递依赖关系发生在非主属性依赖于另一个非主属性时,而不是直接依赖于主属性。主属性是候选键的一部分。

考虑一个关系 R(A, B, C),其中 A 是主键,B 和 C 是非主属性。假设 A→B 和 B→C 是两个函数依赖,则 A→C 将是传递依赖关系。这意味着属性 C 并不是由 A 直接决定的。B 在它们之间充当中介。

如果一个表包含传递依赖关系,我们可以通过将表拆分成独立的关系来将其转换为第三范式(3NF)。

4. 博伊斯-科得范式

尽管第二范式(2NF)和第三范式(3NF)消除了大部分冗余,但冗余仍未完全消除。如果函数依赖关系的左侧不是候选键或超键,则可能会发生冗余。候选键 由主属性形成,而 超键 是候选键的超集。为了解决这个问题,还有另一种函数依赖关系类型,称为博伊斯-科得范式(BCNF)。

要使表处于 BCNF,函数依赖关系的左侧必须是候选键或超键。例如,对于函数依赖 X→Y,X 必须是候选键或超键。

考虑一个包含以下属性的员工表。

-

员工 ID(主键)

-

员工姓名

-

部门

-

部门主管

员工 ID 是唯一标识每一行的主键。部门属性表示特定员工的部门,部门主管属性表示该特定部门的主管员工的员工 ID。

现在我们将检查此表是否符合 BCNF。条件是函数依赖关系的左侧必须是超键。以下是该表的两个函数依赖关系。

函数依赖 1: 员工 ID → 员工姓名、部门、部门主管

函数依赖 2: 部门 → 部门主管

对于 FD1,EmployeeID 是主键,也是超键。但对于 FD2,Department 不是超键,因为多个员工可以在同一个部门。

因此,这个表违反了 BCNF 的条件。为了满足 BCNF 的属性,我们需要将该表拆分为两个独立的表:Employees 和 Departments。Employees 表包含 EmployeeID、EmployeeName 和 Department,而 Department 表将包含 Department 和 Department Head。

现在我们可以看到在两个表中,所有的功能依赖都依赖于主键,即没有非平凡的依赖。

我们已经涵盖了所有著名的标准化技术,但除此之外,还有两种标准范式,即 4NF 和 5NF。如果你想了解更多,可以参考这篇 文章。

总结

我们已经讨论了 SQL 中最常用的数据类型以及数据库管理系统中重要的标准化技术。在设计数据库系统时,我们的目标是使其可扩展,最小化冗余并确保数据完整性。

通过选择合适的数据类型,我们可以在存储、精度和内存消耗之间创建一个微妙的平衡。此外,标准化过程有助于消除数据异常,使模式更加有序。

今天就到这里。直到下次,继续阅读和学习吧。

Aryan Garg 是一名电气工程专业的 B.Tech. 学生,目前在本科最后一年。他的兴趣在于网页开发和机器学习,他已经追求了这一兴趣,并渴望在这些方向上进一步工作。

更多相关内容

使用遗传算法优化基因

原文:

www.kdnuggets.com/2022/04/optimizing-genes-genetic-algorithm.html

介绍

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

2. 谷歌数据分析专业证书 - 提升您的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT 部门

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT 部门

遗传算法可以是解决优化问题的好方法,因为它们可以可靠地找到一个好的解决方案,即使在具有许多局部最优解的复杂适应度景观中。我正在使用这种技术来优化 DNA 序列,以准确生产大量有用的蛋白质。在这里,我们将查看实现遗传算法的关键步骤,而不是深入探讨其背后的理论,但在其他地方有许多更详细的描述,例如 这里 和 这里。

简单来说,遗传算法模拟一个种群,其中每个个体都是一个可能的“解决方案”,并让适者生存发挥作用。困难的部分,就像数据科学和机器学习中的许多问题一样,是如何为计算机构建问题。我们将看到如何通过更好地构建问题来改善您的解决方案。

所有代码均可在 github.com/DAWells/codon_path 获取

问题

DNA 代码用于氨基酸,蛋白质的构建块。三个位于一起的 DNA 字母(A、T、G 或 C)编码一个氨基酸,称为密码子。几个不同的密码子可以编码相同的氨基酸。例如,CAA 和 CAG 都编码氨基酸谷氨酰胺。给定一个已知的蛋白质,我们想要编码的序列应该是简单的。实际上,当蛋白质合成时,前一个密码子可能会影响添加下一个氨基酸的时间,可能需要更长时间或出现错误。尽管几个密码子可以完成相同的工作,但并非所有的配对都能很好地配合在一起。我的目标是优先使用这些配对良好的密码子。

那么,为什么这很重要?通过这种方式优化基因可以让你获得更多你想要的蛋白质。你可能需要一种蛋白质来催化化学反应,或者生产治疗药物。为什么这很困难?每个密码子是两个对中的一部分,这意味着你不能单独选择最佳对。相反,你必须同时考虑所有对。在下面的例子中,每个位置有两个密码子的选择,邻近密码子的配合效果由连接它们的颜色(绿色>黄色>红色)表示。一个好的密码子对可能会让你陷入下一个坏对,如下所示。

解决方案

遗传算法所需的第一件事是一个评分函数,一种衡量可能解决方案适应性的方式。这用于决定哪些解决方案可以“繁殖”。决定如何计算这个数字是任何优化问题的关键步骤,因为它必须在这个值中捕捉问题的所有复杂性。幸运的是,Coleman 等人(2008)为所有 3,721 对可能的密码子对计算了一个评分,我们使用这个评分作为在蛋白质合成过程中对一对密码子效果的衡量。因此,对于任何 DNA 序列,我可以将序列中每对连续密码子的值加起来,并计算一个分数;分数越高,解决方案对我的问题越好。

接下来,我们需要为遗传算法框定问题,即在算法优化过程中,每个可能的解决方案将采取何种形式?最明显的密码子表示方式是一个向量,其中每个元素是一个密码子,用 1-61 的数字表示(对应 61 个密码子中的每一个)。但这对于我们的算法来说自由度过大,因为它可以替换成产生错误氨基酸的密码子。

更好的表述是每个元素表示一个编码正确氨基酸的密码子。确定什么是“正确氨基酸”可以抽象到评分函数中,这意味着我们的遗传算法不会破坏任何东西。任何单一氨基酸可以由多达 6 种不同的密码子编码,因此我们的解决方案向量包含范围为 0-5 的整数值,编码 6 种密码子,并且长度与我们优化的氨基酸序列相同(或 DNA 基因长度的三分之一)。

另一个关键好处是将我们的解决方案向量从 1-6 而非 1-61,这大大减少了问题空间。如果 L 是我们向量的长度,那么要探索的可能解决方案数量是 6L 而非 61L。较小的问题空间意味着更快的答案,这在遗传算法中尤为重要。尽管它们能找到好的解决方案,但速度较慢。如果我没有重新格式化为较小的问题空间,我就没有时间优化基因。

使用 0-5 表示密码子存在一个问题,并不是所有氨基酸都有 6 个密码子,例如赖氨酸只有 2 个。遗传算法可能会使用第 5 个赖氨酸密码子(实际上不存在);那怎么办?你可以让评分函数在每次使用无效密码子时扣分,并希望这能促使你找到好的有效解决方案,但这并没有高效利用我们的问题空间。任何包含无效密码子的解决方案都绝对不是最佳解决方案。这意味着我们在 6L 空间中尝试的许多解决方案(尽管仍然很多)都是浪费的努力。

与其使用惩罚,更好的解决方案是使用模除余数。每当遗传算法请求一个不在真实密码子列表中的密码子时,我将其循环回列表的开头。因此,如果它请求第 5 个密码子而列表中只有 3 个,它将回到开始处并计算剩余的 2 个。这意味着遗传算法探索的任何解决方案都有可能是最佳解决方案。因此,我们应该能更快地得到更好的答案。在下面的图中,我们可以看到惩罚算法总是落后于模除算法,并且需要 30 代才能达到相同的起点。

幸运的是,这使我得到了一个非常好的解决方案,比自然发生的基因要好得多。下面我绘制了自然基因和优化基因在长度上的累积适应度;好的密码子对增加适应度,差的对减少适应度。自然基因的累积得分通常是增加的,因为好的密码子对通常是优选的,但差别不大。而在我们优化的基因中,斜率要陡得多且始终为正,表明密码子对的利用要好得多。总体而言,我们优化的基因比自然基因好 6 倍。

结论

为了最大限度地发挥你的遗传算法的效果,你需要将问题框架设计得尽可能小且高效地探索问题空间。你还需要一个准确捕捉你试图实现目标本质的适应度函数。数据科学中很大一部分就是将现实世界问题转化为数字,以便计算机可以帮助你。通过实践,你可以用多种方式来框定同一个问题。希望这篇文章展示了如何通过恰当框定同一问题来获得更好的答案。

参考文献

Coleman, J. R., Papamichail, D., Skiena, S., Futcher, B., Wimmer, E., & Mueller, S. (2008). 通过基因组规模的密码子对偏好变化进行病毒减毒。科学,320(5884),1784–1787。https://doi.org/10.1126/science.1155761

David Wells 是一位生物信息学家,他将机器学习应用于基因组学以开发疫苗。

更多关于此主题

优化 Python 代码性能:深入了解 Python 性能分析工具

原文:

www.kdnuggets.com/2023/02/optimizing-python-code-performance-deep-dive-python-profilers.html

图片由作者提供

介绍

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT 需求

3. Google IT 支持专业证书 - 支持你的组织 IT 需求

尽管 Python 是最广泛使用的编程语言之一,但在处理大数据集时,它往往会遭遇较差的执行时间。性能分析是动态监控代码性能并识别缺陷的方法之一。这些缺陷可能表示存在错误或编写不当的代码,这些代码消耗了大量的系统资源。使用性能分析工具可以提供程序的详细统计信息,你可以利用这些信息来优化代码以提高性能。让我们来看看一些 Python 性能分析工具及其示例。

1. cProfile

cProfile 是 Python 内置的性能分析工具,它跟踪程序中的每个函数调用。它提供了有关函数被调用频率及其平均执行时间的详细信息。由于它是标准 Python 库的一部分,因此我们不需要显式安装。然而,它不适合用于实时数据分析,因为它会捕捉每一个函数调用,并默认生成大量统计信息。

示例

import cProfile

def sum_():

total_sum = 0

# sum of numbers till 10000

for i in range(0,10001):

total_sum += i

return total_sum

cProfile.run('sum_()')

输出

4 function calls in 0.002 seconds

Ordered by: standard name

| ncalls | tottime | percall | cumtime | percall | percall 文件名:行号(函数) |

|---|---|---|---|---|---|

| 1 | 0.000 | 0.000 | 0.002 | 0.002 | |

| 1 | 0.002 | 0.002 | 0.002 | 0.002 | cprofile.py:3(sum_) |

| 1 | 0.000 | 0.000 | 0.002 | 0.002 | |

| 1 | 0.000 | 0.000 | 0.000 | 0.000 |

从输出中可以看出,cProfile 模块提供了大量关于函数性能的信息。

-

ncalls = 函数被调用的次数

-

tottime = 函数中花费的总时间

-

percall = 每次调用中花费的总时间

-

cumtime = 在此函数及所有子函数中花费的累计时间

-

percall = 每次调用中花费的累计时间。

2. 行分析器

Line Profiler 是一个强大的 Python 模块,可逐行分析代码性能。有时,代码中的热点可能只是单行,直接从源代码中定位并不容易。Line Profiler 对于识别每行执行所花费的时间以及需要特别关注的优化区域非常有价值。然而,它不包含在标准 Python 库中,需要使用以下命令进行安装:

pip install line_profiler

示例

from line_profiler import LineProfiler

def sum_arrays():

# creating large arrays

arr1 = [3] * (5 ** 10)

arr2 = [4] * (3 ** 11)

return arr1 + arr2

lp = LineProfiler()

lp.add_function(sum_arrays)

lp.run('sum_arrays()')

lp.print_stats()

输出

Timer unit: 1e-07 s

Total time: 0.0562143 s

File: e:\KDnuggets\Python_Profilers\lineprofiler.py

Function: sum_arrays at line 2

| 行号 | 点击次数 | 时间 | 每次点击 | % 时间 | 行内容 |

|---|---|---|---|---|---|

| 2 | def sum_arrays(): | ||||

| 3 | # 创建大型数组 | ||||

| 4 | 1 | 168563.0 | 168563.0 | 30.0 | arr1 = [1] * (10 ** 6) |

| 5 | 1 | 3583.0 | 3583.0 | 0.6 | arr2 = [2] * (2 * 10 ** 7) |

| 6 | 1 | 389997.0 | 389997.0 | 69.4 | return arr1 + arr2 |

-

行号 = 代码文件中的行号

-

点击次数 = 执行的次数

-

时间 = 执行该行所花费的总时间

-

每次点击 = 每次点击的平均时间

-

% 时间 = 相对于函数总时间的每行时间占比

-

行内容 = 实际源代码

3. 内存分析器

内存分析器是一个 Python 分析器,跟踪代码的内存分配。它还可以生成火焰图,以帮助分析内存使用情况并识别代码中的内存泄漏。它还可以帮助识别导致大量分配的热点区域,因为 Python 应用程序通常容易出现内存管理问题。内存分析器逐行分析内存消耗的统计信息,需要使用以下命令进行安装:

pip install memory_profiler

示例

import memory_profiler

import random

def avg_marks():

# Genrating Random marks for 50 students for each section

sec_a = random.sample(range(0, 100), 50)

sec_b = random.sample(range(0, 100), 50)

# combined average marks of two sections

avg_a = sum(sec_a) / len(sec_a)

avg_b = sum(sec_b) / len(sec_b)

combined_avg = (avg_a + avg_b)/2

return combined_avg

memory_profiler.profile(avg_marks)()

输出

Filename: e:\KDnuggets\Python_Profilers\memoryprofiler.py

| 行号 | 内存使用 | 增量 | 出现次数 | 行内容 |

|---|---|---|---|---|

| 4 | 21.7 MiB | 21.7 MiB | 1 | def avg_marks(): |

| 5 | # 为每个部分生成 50 个随机分数 | |||

| 6 | 21.8 MiB | 0.0 MiB | 1 | sec_a = random.sample(range(0, 100), 50) |

| 7 | 21.8 MiB | 0.0 MiB | 1 | sec_b = random.sample(range(0, 100), 50) |

| 8 | ||||

| 9 | # 两个部分的综合平均分 | |||

| 10 | 21.8 MiB | 0.0 MiB | 1 | avg_a = sum(sec_a) / len(sec_a) |

| 11 | 21.8 MiB | 0.0 MiB | 1 | avg_b = sum(sec_b) / len(sec_b) |

| 12 | 21.8 MiB | 0.0 MiB | 1 | combined_avg = (avg_a + avg_b)/2 |

| 13 | 21.8 MiB | 0.0 MiB | 1 | return combined_avg |

-

行号 = 代码文件中的行号

-

内存使用 = Python 解释器的内存使用情况

-

增量 = 当前行与上一行的内存消耗差

-

出现次数 = 代码行执行的次数

-

行内容 = 实际源代码

4. Timeit

Timeit 是一个内置的 Python 库,专门用于评估小代码片段的性能。它是一个强大的工具,可以帮助你识别和优化代码中的性能瓶颈,使你的代码更快、更高效。虽然可以使用 timeit 模块比较算法的不同实现,但缺点是只能分析代码块的单独行。

示例

import timeit

code_to_test = """

# creating large arrays

arr1 = [3] * (5 ** 10)

arr2 = [4] * (3 ** 11)

arr1 + arr2

"""

elapsed_time = timeit.timeit(code_to_test, number=10)

print(f'Elapsed time: {elapsed_time}')

输出

Elapsed time: 1.3809973997995257

它的使用限制在于只评估较小的代码片段。需要注意的是,它每次运行代码片段时显示的时间不同。这是因为你的计算机上可能运行着其他进程,资源分配可能在不同的运行中有所变化,使得控制所有变量并实现相同的处理时间变得困难。

5. Yappi

Yappi 是一个 Python 性能分析器,允许你轻松识别性能瓶颈。它用 C 语言编写,是最有效的分析器之一。它拥有一个可定制的 API,允许你仅分析代码中需要关注的特定部分,从而对分析过程有更多控制。它能够分析并发协程,提供对代码运行情况的深入理解。

示例

import yappi

def sum_arrays():

# creating large arrays

arr1 = [3] * (5 ** 10)

arr2 = [4] * (3 ** 11)

return arr1 + arr2

with yappi.run(builtins=True):

final_arr = sum_arrays()

print("\n--------- Function Stats -----------")

yappi.get_func_stats().print_all()

print("\n--------- Thread Stats -----------")

yappi.get_thread_stats().print_all()

print("\nYappi Backend Types: ",yappi.BACKEND_TYPES)

print("Yappi Clock Types: ", yappi.CLOCK_TYPES)

注意: 使用以下命令安装 yappi:

pip install yappi

输出

--------- Function Stats -----------

Clock type: CPU

Ordered by: totaltime, desc

| name | ncall | tsub | ttot | tavg |

|---|---|---|---|---|

| ..lers\yappiProfiler.py:4 sum_arrays | 1 | 0.109375 | 0.109375 | 0.109375 |

| builtins. next | 1 | 0.000000 | 0.000000 | 0.000000 |

| .. _GeneratorContextManager.exit | 1 | 0.000000 | 0.000000 | 0.000000 |

--------- 线程统计 ---------

| name | id | tid | ttot | scnt |

|---|---|---|---|---|

| _MainThread | 0 | 15148 | 0.187500 | 1 |

Yappi Backend Types: {'NATIVE_THREAD': 0, 'GREENLET': 1}

Yappi Clock Types: {'WALL': 0, 'CPU': 1}

记得为内置模块起不同的名称。否则,导入将导入你的模块(即你的 Python 文件),而不是实际的内置模块。

结论

通过使用这些分析工具,开发者可以识别代码中的瓶颈,并决定哪种实现方式最佳。使用合适的工具和一点技巧,任何人都能将他们的 Python 代码性能提升到新的高度。所以,准备好优化你的 Python 性能,看看它如何腾飞到新高度吧!

我很高兴你决定阅读这篇文章,希望它对你是一次有价值的体验。

Kanwal Mehreen 是一位有志的软件开发者,对数据科学和人工智能在医学中的应用充满兴趣。Kanwal 被选为 2022 年亚太地区的 Google Generation Scholar。Kanwal 喜欢通过撰写关于热门话题的文章来分享技术知识,并热衷于改善女性在科技行业中的代表性。

更多相关内容

优化你的 LLM 以提高性能和可扩展性

原文:

www.kdnuggets.com/optimizing-your-llm-for-performance-and-scalability

图片来源:作者

大型语言模型或 LLM 已成为自然语言处理的推动力。它们的使用场景从聊天机器人和虚拟助手到内容生成和翻译服务。然而,它们已经成为科技界增长最快的领域之一——我们可以在各种场景中见到它们。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

随着对更强大语言模型需求的增长,对有效优化技术的需求也在增加。

然而,许多自然的问题出现了:

如何提升它们的知识?

如何提升它们的整体性能?

如何扩展这些模型?

OpenAI DevDay 上由 John Allard 和 Colin Jarvis 主讲的题为“最大化 LLM 性能的技术调查”的深刻演讲试图回答这些问题。如果你错过了这一活动,可以在YouTube上观看这场讲座。

这场演讲提供了各种技术和最佳实践的精彩概述,以提升 LLM 应用的性能。本文旨在总结改善我们 AI 驱动的解决方案性能和可扩展性的最佳技术。

理解基础知识

LLM 是精密的算法,旨在理解、分析和生成连贯且符合上下文的文本。它们通过对大量语言数据进行广泛训练,涵盖各种主题、方言和风格,从而实现这一目标。因此,它们能够理解人类语言的运作方式。

然而,在将这些模型集成到复杂应用中时,需要考虑一些关键挑战:

优化 LLM 面临的主要挑战

-

LLM 的准确性:确保 LLM 输出准确且可靠的信息,没有幻觉。

-

资源消耗:LLM 需要大量的计算资源,包括 GPU 能力、内存和大型基础设施。

-

延迟:实时应用要求低延迟,这可能由于 LLM 的规模和复杂性而具有挑战性。

-

可扩展性:随着用户需求的增长,确保模型能够处理增加的负载而不降低性能至关重要。

提升表现的策略

第一个问题是关于“如何提升其知识?”

创建一个部分功能的 LLM 演示相对简单,但将其完善以投入生产需要迭代改进。LLM 可能在需要深厚专业知识、系统和流程理解或精准行为的任务中遇到困难。

团队使用提示工程、检索增强和微调来应对这一问题。一个常见的错误是认为这个过程是线性的,应按特定顺序进行。相反,根据问题的性质,从两个轴来处理更为有效:

-

上下文优化:问题是否由于模型缺乏获取正确信息或知识?

-

LLM 优化:模型是否未能生成正确的输出,例如不准确或不符合期望的风格或格式?

作者提供的图像

为应对这些挑战,可以使用三种主要工具,每种工具在优化过程中都扮演着独特的角色:

提示工程

定制提示以引导模型的响应。例如,改进客服机器人提示,以确保其始终提供有用且礼貌的回答。

检索增强生成(RAG)

通过外部数据提升模型的上下文理解。例如,将医疗聊天机器人与最新研究论文数据库集成,以提供准确且最新的医疗建议。

微调

修改基础模型以更好地适应特定任务。就像使用法律文本数据集对法律文档分析工具进行微调,以提高其总结法律文档的准确性。

该过程高度迭代,并非所有技术都会对你的具体问题有效。然而,许多技术是可以叠加的。当你找到有效的解决方案时,可以将其与其他性能改进结合,以实现最佳结果。

优化性能的策略

第二个问题是关于“如何提升其整体性能?”

在拥有准确的模型后,第二个令人关切的问题是推理时间。推理是一个训练好的语言模型,如 GPT-3,在现实应用中生成对提示或问题的响应的过程(例如聊天机器人)。

这是一个关键阶段,在实际场景中对模型进行测试,生成预测和响应。对于像 GPT-3 这样的巨大 LLM,计算需求是巨大的,因此在推理期间进行优化至关重要。

考虑像 GPT-3 这样的模型,它有 1750 亿个参数,相当于 700GB 的 float32 数据。这个规模,加上激活需求,要求显著的 RAM。这就是为什么在没有优化的情况下运行 GPT-3 需要一个庞大的设置。

一些技术可以用来减少执行这些应用所需的资源量:

模型剪枝

这涉及修剪非关键参数,确保只有对性能至关重要的参数保留。这可以大幅减少模型的大小,而不会显著影响其准确性。

这意味着计算负载显著减少,同时保持相同的准确性。你可以在以下 GitHub 中找到易于实现的修剪代码。

量化

这是一种模型压缩技术,将 LLM 的权重从高精度变量转换为低精度变量。这意味着我们可以将 32 位浮点数减少到 16 位或 8 位等更节省内存的格式,这可以大幅减少内存占用并提高推理速度。

LLMs 可以通过 HuggingFace 和 bitsandbytes 以量化方式轻松加载。这使我们能够在低功耗资源上执行和微调 LLMs。

from transformers import AutoModelForSequenceClassification, AutoTokenizer

import bitsandbytes as bnb

# Quantize the model using bitsandbytes

quantized_model = bnb.nn.quantization.Quantize(

model,

quantization_dtype=bnb.nn.quantization.quantization_dtype.int8

)

蒸馏

这是训练一个较小模型(学生)以模拟较大模型(也称为教师)性能的过程。这个过程涉及训练学生模型以模拟教师的预测,使用教师的输出 logits 和真实标签的组合。通过这样做,我们可以在资源需求的很小一部分中实现类似的性能。

这个想法是将较大模型的知识转移到具有更简单架构的较小模型上。最著名的例子之一是 Distilbert。

这个模型是模拟 Bert 性能的结果。它是 BERT 的一个较小版本,保留了 97%的语言理解能力,同时速度快 60%,体积小 40%。

可扩展性技术

第三个问题是关于“如何扩展这些模型?”

这一步通常至关重要。当一个系统被少量用户使用时,它的行为可能与在扩展以应对密集使用时大相径庭。以下是一些应对这一挑战的技术:

负载均衡

这种方法有效分配传入请求,确保计算资源的最佳利用和对需求波动的动态响应。例如,为了在不同国家提供像 ChatGPT 这样的广泛使用服务,最好部署多个相同模型的实例。

有效的负载均衡技术包括:

横向扩展:添加更多模型实例以应对增加的负载。使用像 Kubernetes 这样的容器编排平台来管理不同节点上的这些实例。

垂直扩展:升级现有机器资源,例如 CPU 和内存。

分片

模型分片将模型的片段分布在多个设备或节点上,实现并行处理并显著减少延迟。完全分片数据并行(FSDP)提供了利用各种硬件的关键优势,如 GPU、TPU 和其他在多个集群中的专用设备。

这种灵活性允许组织和个人根据他们的具体需求和预算来优化硬件资源。

缓存

实现缓存机制可以通过存储频繁访问的结果来减少对 LLM 的负载,这对于有重复查询的应用程序尤其有利。缓存这些频繁的查询可以通过消除重复处理相同请求的需要,从而显著节省计算资源。

此外,批处理可以通过将类似任务分组来优化资源使用。

结论

对于那些依赖 LLM 的应用程序来说,这里讨论的技术对于最大化这种变革性技术的潜力至关重要。掌握并有效应用策略以获得更准确的模型输出、优化其性能以及实现扩展,是从一个有前景的原型发展为一个强大的、生产就绪的模型的重要步骤。

要充分理解这些技术,我强烈推荐深入了解并开始在你的 LLM 应用程序中实验这些技术,以获得最佳结果。

Josep Ferrer**** 是一位来自巴塞罗那的分析工程师。他毕业于物理工程专业,目前在应用于人类流动的数据科学领域工作。他是一个兼职内容创作者,专注于数据科学和技术。Josep 撰写关于人工智能的文章,涵盖了该领域的持续爆炸性发展。

更多相关内容

从 Oracle 到 AI 数据库:数据存储的演变

原文:

www.kdnuggets.com/2022/02/oracle-databases-ai-evolution-data-storage.html

技术矢量图由 fullvector 创作 - www.freepik.com

尽管机器学习已经变得商品化,但它仍然是西部荒野。各个行业的 ML 团队正在开发自己的数据处理、模型训练和生产使用的技术。这显然不是一个可持续的机器学习方法。随着时间的推移,这些多样化的方法将会标准化。为了加快这一过程,行业需要专门为 AI 设计的开发者工具。在本文中,你将看到传统的数据存储解决方案与专为解决 AI 用例而构建的数据库之间的区别。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

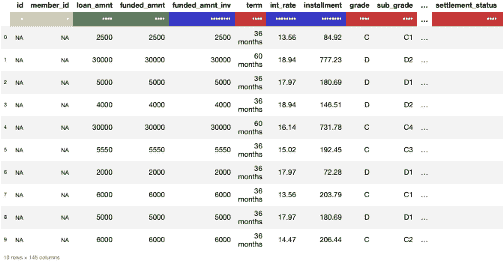

任何与企业打过交道的人都见过一个具有行和列的界面,在那里你认真地添加与工作相关的信息。

Oracle 数据库在 40 多年前作为这种数据输入的目标被引入。尽管许多企业将其作为默认数据库使用,但它对于普通用户来说相当复杂。它也是专有的,因此对开发者不可访问。Oracle 甚至启动了 DeWitt 条款,禁止发布未经数据库创建者授权的数据库基准测试。

快进 15 年,我们见证了像 MySQL 和 PostgreSQL 这样的新一代数据库的出现。与 Oracle 的产品相比,主要的区别在于可访问性——这些新型数据库是开源产品,可以在本地计算机上运行,这使得开发者更容易进行设置和使用。它们在互联网泡沫期间得到了广泛采用也就不足为奇了。

Web 2.0 和开源数据库的崛起

随着时间的推移,我们见证了 2000 年代初“Web 2.0”的兴起。Google 的 Jeff Dean 和 Sanjay Ghemawat 提出了 MapReduce,一种根本性的新数据处理方法。该方法的逻辑是对数据集执行映射和归约操作。映射操作包括对数据行和列的过滤和排序。归约操作涉及对表格数据的汇总和聚合。该基础设施被设计为并行运行。这种 MapReduce 方法是 Hadoop 的核心,Hadoop 是 2000 年代最成功的开源项目之一。

2007-2012 年间,世界迎来了各种开源 NoSQL 数据库。最受欢迎的有:Apache Cassandra、Google 的 BigTable、MongoDB、Redis 和 Amazon 的 DynamoDB。

这些数据库的关键区分点在于它们水平扩展良好。许多机器可以并行启动并协作服务一个能够容纳真正大规模数据集的数据库。NoSQL 数据库不使用关系型的方法将数据建模为行和列,且可以轻松接受非结构化数据,而不需要复杂的数据模型。

还需要提到的是,有两种类型的数据库:事务型和分析型。事务型数据库是操作性的,存储关键数据,如用户日志、活动、IP 地址、采购订单等。它们被设计为能够快速接受新数据,并以最小的延迟响应数据请求。分析型数据库工作速度较慢,可以托管在更便宜的存储上,并允许对数据进行比在事务型数据库中更深入的分析。

大数据:分析与人工智能炒作周期的开端

“大数据”这一术语最初在 2005 年引入,但在应用程序变得更加复杂后才被广泛接受。当时,适当的分析涉及从不同地方提取大量数据。为了应对不断上升的挑战,市场上出现了新产品——Amazon RedShift、Snowflake、Google BigQuery、Clickhouse。这些数据仓库已经成为现代企业的主流。

2020 年引入了一种新的数据协调解决方案——‘湖屋’。湖屋帮助用户以低成本查询历史数据,但在分析和机器学习工作负载方面几乎没有性能下降。这转变成了Snowflake 和 Databricks 之间的一场军备竞赛。虽然它们在表格数据的世界中继续争斗,但一些重大变化正在深处酝酿。

在 2021 年,深度学习(DL)已经成为主流。这是非结构化数据的时代。与以行和列表示的表格数据不同,非结构化数据包括图像、视频流、音频和文本。这些数据无法以电子表格形式表示。

由于去年的封锁,Netflix、TikTok 以及其他社交媒体的消费量飙升至前所未有的水平。这些产品都处理和生成大量的非结构化数据。公司应该如何管理这些数据,尤其是当他们希望通过 AI 来挖掘深层次的见解时?AI 团队在处理这些数据时是否可以使用数据库解决方案?

你可能会感到惊讶,但我们讨论的技术没有一个能完全满足深度学习从业者的需求。像特斯拉这样的公司,处理大量非结构化数据,承认他们不得不构建自己的基础设施。

很少有企业拥有足够的内部带宽从头开始构建数据基础设施。AI 行业需要一个坚实的数据基础和专门为 AI 设计的数据库。

AI 数据库是深度学习创新的支柱

长期以来,行业一直需要一个简单的 API 来创建、存储和协作处理任何大小的 AI 数据集。更重要的是,这个工具应该专门为深度学习相关任务创建。

传统数据库将数据存储在内存中以快速执行查询,但内存存储对 ML 数据集而言极其昂贵,因为它们非常大。即便是使用像 AWS EBS 这样的附加磁盘也非常昂贵。最具成本效益的存储层是对象存储,例如 S3、Google Cloud Storage 和 MinIO,但这些工具在快速查询或计算方面较慢。

专门为深度学习构建的数据库应该支持在这些云存储系统上托管数据并以深度学习模型原生格式存储数据。这种功能将允许更快的计算,并且更具成本效益,因为从这种框架中访问数据不应产生任何额外的预处理成本。这样的框架将帮助现代的 AI 驱动企业节省多达 30%的基础设施成本。

该框架应优化数据从云存储传输到机器学习模型的过程,以尽量减少延迟。这将允许 AI 即时探索和可视化无法存放在其他地方的大规模数据集。

更重要的是,现代 AI 数据库应该非常易于使用,只需几行代码即可实现。根据 Kaggle 最近的调查,超过 20%的数据科学家在行业经验上少于 3 年,另有 14%的人经验不足一年。机器学习仍然是一个年轻的领域,简单性至关重要。

我们已经开始看到专门为 AI 使用案例构建的数据库的出现。在未来五年,我们将见证对 机器学习基础设施堆栈的标准化。更快采用 AI 数据库的组织将站在机器学习革命的前沿。

Davit Buniatyan (@DBuniatyan) 在 20 岁时开始了普林斯顿大学的博士学位。他的研究涉及在 Sebastian Seung 的指导下重建小鼠大脑的连接组。为了克服在神经科学实验室分析大型数据集时遇到的困难,David 成为 Activeloop 的创始首席执行官,该公司是 Y-Combinator 的毕业生初创企业。他还是戈登·吴奖学金和 AWS 机器学习研究奖的获得者。Davit 是 Activeloop 的创始人,这是一个为 AI 设计的数据库。

更多相关话题

Orca LLM: 模拟 ChatGPT 的推理过程

原文:

www.kdnuggets.com/2023/06/orca-llm-reasoning-processes-chatgpt.html

介绍

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的捷径。

1. Google 网络安全证书 - 快速进入网络安全职业的捷径。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT 管理

3. Google IT 支持专业证书 - 支持你的组织进行 IT 管理

在大型语言模型(LLM)领域,始终在追求在不影响效率的情况下提升小型模型的能力。传统的方法是使用模仿学习,小型模型从大型基础模型(LFM)生成的输出中学习。然而,这种方法面临几个挑战,包括来自浅层 LFM 输出的有限模仿信号、小规模的同质训练数据以及缺乏严格评估。这常常导致小型模型模仿风格但无法模仿 LFM 的推理过程。

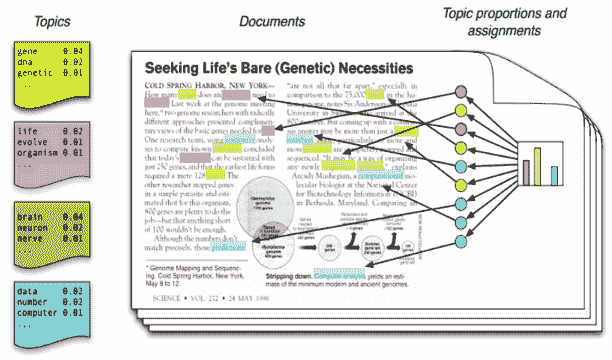

论文Orca: 从 GPT-4 的复杂解释踪迹中渐进学习介绍了 Orca,一个设计用来模仿大型基础模型(LFM)如 GPT-4 的推理过程的 13 亿参数模型。与传统的大型语言模型(LLM)不同,Orca 采用了一种独特的训练方法,将渐进学习和教师辅助相结合,以克服小型学生模型与其大型对应模型之间的能力差距。

训练方法

Orca 的训练过程包括两个阶段。

在第一阶段,Orca 在 FLAN-5M 上进行训练,该训练包括 ChatGPT 的增强技术。这一中级教师助手有助于弥合 Orca 与 GPT-4 之间的能力差距,后者具有显著更大的参数规模。通过利用 ChatGPT 的能力,Orca 受益于改进的模仿学习表现。

在第二阶段,Orca 接受 FLAN-1M 的训练,该训练融合了 GPT-4 的增强技术。这种渐进的学习方法遵循课程学习范式,其中学生模型从简单的例子学习,然后再处理更具挑战性的例子。通过逐步将 Orca 暴露于越来越复杂的推理和逐步解释中,该模型提升了其推理能力和模仿技能。

优势和贡献

Orca 的训练方法相比传统 LLM 具有多个优势。

首先,它通过利用中间教师模型解决了能力差距问题,使 Orca 能够从更有能力的来源学习。这种方法已被证明能够提高较小学生模型的模仿学习性能。

其次,Orca 训练的渐进学习方面使模型能够逐步积累知识。通过从简单的示例开始,逐渐引入更复杂的示例,Orca 为推理和生成解释打下了更坚实的基础。

此外,Orca 模仿像 GPT-4 这样的 LFMs 的推理过程的能力,为各种任务的增强性能打开了可能性。通过利用 GPT-4 的解释痕迹和逐步思维过程提供的丰富信号,Orca 获得了宝贵的见解,并提升了自身能力。

性能基准

Orca 在复杂的零-shot 推理基准测试中表现出色。在 Big-Bench Hard (BBH)等基准测试中,比传统的最先进的指令调整模型 Vicuna-13B 高出 100%以上,在 AGIEval 中高出 42%以上。此外,Orca 在 BBH 基准测试中取得了与 ChatGPT 相同的分数,并在 SAT、LSAT、GRE 和 GMAT 等专业和学术考试中表现具有竞争力。考虑到这些都是零-shot 设置且没有链式思维,Orca 仍表现出竞争力,但与 GPT-4 相比略逊一筹,这一点尤其令人印象深刻。

含义与未来方向

Orca 的发展代表了 LLMs 领域的重大进步。通过学习丰富的信号并模仿 LFMs 的推理过程,Orca 能够以高度准确性执行复杂的推理任务。这具有广泛的影响,尤其是在需要复杂推理和问题解决的领域。

此外,这项研究表明,从逐步 AI 模型解释中学习是一种有前景的方向,有助于提升模型能力。这为 LLMs 领域的研究和开发开辟了新的途径。

结论

Orca 提出了一种新的大规模语言模型训练方法,将渐进学习和教师辅助结合在一起,以增强模仿学习。通过利用中间教师模型,并逐渐将学生模型暴露于更复杂的示例中,Orca 克服了能力差距,提升了推理和生成解释的能力。该论文的发现有助于模仿学习技术的进步,并对未来语言模型的发展产生了影响。

有关 Orca 及其研究的更多细节,请参阅微软的介绍文章和相关研究论文。

更多相关话题

使用 Prefect 在 Python 中协调数据科学项目

原文:

www.kdnuggets.com/2022/02/orchestrate-data-science-project-python-prefect.html

动机

作为数据科学家,为什么你应该关心优化你的数据科学工作流程?让我们以一个基本的数据科学项目为例来开始。

想象一下你在处理一个 Iris 数据集。你开始编写函数来处理你的数据。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速入门网络安全职业生涯。

1. Google 网络安全证书 - 快速入门网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析水平

2. Google 数据分析专业证书 - 提升你的数据分析水平

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

3. Google IT 支持专业证书 - 支持你的组织的 IT 工作

定义了函数后,你需要执行它们。

你的代码运行正常,你没有看到输出中的任何问题,所以你认为工作流程已经足够好了。然而,像上述这样的线性工作流程可能存在许多缺点。

作者提供的图片

缺点包括:

- 如果函数

get_classes出现错误,由函数encode_categorical_columns生成的输出将会丢失,工作流程将需要从头开始。这可能会很令人沮丧,特别是如果执行函数encode_categorical_columns需要很长时间的话。

作者提供的图片

- 由于函数

encode_categorical_columns和get_classes之间没有相互依赖,因此可以同时执行它们以节省时间:

作者提供的图片

以这种方式运行函数还可以防止在不工作的函数上浪费不必要的时间。如果函数get_classes出现错误,工作流程将立即重新启动,而无需等待函数encode_categorical_columns完成。

作者提供的图片

现在,你可能会同意我所说的,优化不同功能的工作流程是重要的。然而,手动管理工作流程可能需要大量的工作。

是否有一种方法可以通过仅添加几行代码来自动优化工作流程?这就是 Prefect 发挥作用的地方。

什么是 Prefect?

Prefect是一个开源框架,用于在 Python 中构建工作流。Prefect 使得构建、运行和监控大规模数据管道变得容易。

要安装 Prefect,请输入:

pip install prefect

使用 Prefect 构建你的工作流

要了解 Prefect 的工作原理,让我们用 Prefect 封装本文开头的工作流。

第一步 — 创建任务

一个Task是在 Prefect 流中的一个离散操作。首先,使用装饰器prefect.task将上述定义的函数转换为任务:

第二步 — 创建一个流

一个Flow表示通过管理任务之间的依赖关系来管理整个工作流。要创建一个流,只需将代码插入到with Flow(...)上下文管理器中运行你的函数即可。

请注意,上述代码运行时,这些任务都不会执行。Prefect 允许你立即运行流或安排以后执行。

让我们尝试立即使用flow.run()执行流:

运行上述代码将得到类似于以下内容的输出:

为了理解 Prefect 创建的工作流,让我们可视化整个工作流。

首先安装prefect[viz]:

pip install "prefect[viz]"

然后将visualize方法添加到代码中:

你应该能看到如下所示的data-engineer工作流的可视化效果!

作者提供的图像

请注意,Prefect 自动管理任务之间的执行顺序,以优化工作流。这对于增加几行代码来说相当酷!

第三步 — 添加参数

如果你发现自己经常尝试不同的变量值,最好将该变量转换为Parameter。

你可以将Parameter视为Task,只是它可以在每次运行流时接收用户输入。要将变量转换为参数,只需使用task.Parameter。

Parameter的第一个参数指定了参数的名称。default是一个可选参数,用于指定参数的默认值。

再次运行flow.visualize将得到如下输出:

作者提供的图像

你可以通过以下方式覆盖每次运行的默认参数:

-

将参数

parameters添加到flow.run()中: -

或使用 Prefect CLI:

-

或使用 JSON 文件:

你的 JSON 文件应类似于此:

你还可以使用 Prefect Cloud 更改每次运行的参数,下一节将介绍此功能。

监控你的工作流

概述

Prefect 还允许你在 Prefect Cloud 中监控工作流。请按照此说明安装 Prefect Cloud 所需的相关依赖项。

安装和设置所有依赖项后,首先通过运行以下命令创建 Prefect 项目:

$ prefect create project "Iris Project"

接下来,启动本地代理,将我们的流本地部署到单台计算机上:

$ prefect agent local start

然后添加:

...在文件的末尾。

运行文件后,您应该会看到类似以下的内容:

点击输出中的 URL,您将被重定向到概述页面。概述页面显示了您的流的版本、创建时间、流的运行历史和运行摘要。

作者提供的图片

您还可以查看其他运行的摘要、执行时间和配置。

作者提供的图片

这些重要信息能够自动跟踪,真是太酷了!

使用默认参数运行工作流

请注意,工作流已注册到 Prefect Cloud,但尚未执行。要使用默认参数执行工作流,请点击右上角的“快速运行”。

作者提供的图片

点击创建的运行。现在您将能够实时查看新流运行的活动!

作者提供的图片

使用自定义参数运行工作流

要使用自定义参数运行工作流,请点击“运行”标签,然后更改“输入”下的参数。

作者提供的图片

当您对参数满意时,只需点击“运行”按钮即可开始运行。

查看工作流图表

点击“示意图”将显示整个工作流的图表。

作者提供的图片

其他功能

除了上述提到的一些基本功能外,Prefect 还提供了一些其他酷炫的功能,这些功能将显著提高您的工作流效率。

输入缓存

记得我们在文章开头提到的问题吗?通常,如果函数 get_classes 失败,则函数 encode_categorical_columns 创建的数据将被丢弃,整个工作流需要从头开始。

然而,使用 Prefect 时,encode_categorical_columns 的输出会被存储。下次重新运行工作流时,encode_categorical_columns 的输出将被下一个任务无需重新运行 encode_categorical_columns 使用。

作者提供的图片

这可能会大幅减少运行工作流所需的时间。

持久化输出

有时,您可能希望将任务的数据导出到外部位置。这可以通过在任务函数中插入保存数据的代码来实现。

但是,这样做会使得测试函数变得困难。

Prefect 通过以下方式简化了每次运行任务的输出保存:

- 将检查点设置为

True

$ export PREFECT__FLOWS__CHECKPOINTING=true

- 并将

result = LocalResult(dir=...))添加到装饰器@task中。

现在任务 split_data 的输出将被保存到目录 data/processed 中!名称会类似于这样:

prefect-result-2021-11-06t15-37-29-605869-00-00

如果你想自定义文件名称,可以在 @task 中添加 target 参数:

Prefect 还提供了其他 Result 类,比如 GCSResult 和 S3Result。你可以在这里查看 API 文档。

在当前流中使用另一个流的输出

如果你正在处理多个流,例如 data-engineer 流和 data-science 流,你可能希望将 data-engineer 流的输出用于 data-science 流。

作者提供的图片

在将 data-engineer 流的输出保存为文件后,你可以使用 read 方法读取该文件:

连接相关流

想象这种情况:你创建了两个互相依赖的流。流 data-engineer 需要在流 data-science 之前执行。

有人查看了你的工作流但没有理解这两个流之间的关系。结果,他们同时执行了流 data-science 和流 data-engineer,并遇到了错误!

作者提供的图片

为了防止这种情况发生,我们应该指定流之间的关系。幸运的是,Prefect 使这变得更简单。

首先使用 StartFlowRun 获取两个不同的流。将 wait=True 添加到参数中,以确保下游流仅在上游流执行完毕后才执行。

接下来,在 with Flow(...) 上下文管理器下调用 data_science_flow。使用 upstream_tasks 指定将在 data-science 流执行前执行的任务/流。

现在两个流连接如下:

作者提供的图片

相当酷!

调度你的流

Prefect 也使得在特定时间或特定间隔执行流变得无缝。

例如,要每分钟运行一次流,你可以初始化 IntervalSchedule 类,并将 schedule 添加到 with Flow(...) 上下文管理器中:

现在你的流将每分钟重新运行一次!

了解更多关于调度流的不同方式,请访问这里。

日志记录

你可以通过简单地将 log_stdout=True 添加到 @task 中来记录任务中的打印语句:

执行任务时,你应该会看到如下输出:

[2021-11-06 11:41:16-0500] INFO - prefect.TaskRunner | Model accuracy on test set: 93.33

结论

恭喜!你刚刚了解了如何用几行 Python 代码优化你的数据科学工作流程。代码中的小优化在长远中可能会带来巨大的效率提升。

随意玩耍并 在这里 fork 这篇文章的源代码。

我喜欢写关于基本数据科学概念的文章,并玩各种数据科学工具。你可以在 LinkedIn 和 Twitter 上与我联系。

如果你想查看我撰写的所有文章的代码,请给this repo打星。关注我的 Medium,获取最新的数据科学文章:

Khuyen Tran 是一位多产的数据科学作家,她撰写了 一系列令人印象深刻的有用数据科学话题,包括代码和文章。她在 Data Science Simplified 分享了超过 400 个关于数据科学和 Python 的技巧。订阅她的新闻通讯,接收她的每日提示。

原文。转载已获许可。

更多相关话题

用 Rmd 文件在 Python 和 R 中编排动态报告

原文:

www.kdnuggets.com/2019/11/orchestrating-dynamic-reports-python-r-rmd-files.html

评论

由 Marija Ilic,数据分析师/科学家

Python 和 R 互相嵌套

几个用 Python 和 R 编写的支持包允许分析师将 Python 和 R 结合在一个 Python 或 R 脚本中。熟悉 R 的人可以使用 reticulate 包在 R 中调用 Python 代码。然后,一个 R 脚本可以在 Python 和 R 之间互操作(Python 对象被转换为 R 对象,反之亦然)。然而,如果你使用 Python 但希望使用 R 的一些功能,考虑使用用 Python 编写的 rpy2 包来启用嵌入的 R 代码。

R markdown,一个将代码和结果合并到一个输出中的流行框架,提供了优雅的 Python 和 R 集成。我们将创建一个动态报告,将两种语言结合在一个 Rmd 脚本中。我们将使用 外汇交易数据 来捕捉 15 分钟间隔的价格变动,然后绘制交易分析师在定价模型中使用的烛台图(OHLC 图表)。

在 R Markdown 文档中运行 R 和 Python 代码

R markdown,或 Rmd,是一个包含文本或评论(结合文本格式)和由 ```py. From a file, inside R or R Studio, you can create and render useful reports in output formats like HTML, pdf, or word. However, the primary benefit is that source code, outputs, and comments are contained in one file, facilitating easy collaboration among your team.

Even R lovers may not know that Rmd files can contain Python chunks. More conveniently, objects are shared between the environments, allowing programmers to call objects in Python and R in the opposing language.

R Markdown with Python

Let’s examine how to use Python in Rmd. First, ensure Python is installed on your computer and all Python libraries or modules you’re planning to use in Rmd are installed (pip works and virtual environments can be utilized, if preferable).

In Rmd files, Python code chunks are similar to R chunks: Python code is placed inside marks: {python} 和 py.

Here’s a simple R markdown with embedded Python code:

In the example above the csv is loaded with the help of the pandas library, a column is renamed, and the first rows are printed. In the file heading, the report is defined with ### and a single author comment is printed. Here’s the result when we run the Rmd:

Beside the code and output, the heading and author comment prints. Now that the data has been loaded using Python, it can be used inside R:

The R code starts with {r} 包围的 R 代码块的文本文件,文件以 结束。代码后面跟着一个 Python 代码块和在 R 代码中引用的对象。在我们的示例中,R 对象在 reticulate 包的帮助下从 Python 对象转换过来。命令 py$data 检索在 Python 中创建的对象并将其转换为 R 数据框。现在,当创建了 R 数据框后,它可以在 R 代码中进一步使用。

输出效果如下:

现在我们将继续使用 R 并创建一个交易者常用的可视化:烛台图。以下是使用 plotly 库编写的 Candlestick 图表的 R 代码:

这应该显示如下内容:

这个简单的例子演示了如何将 Python 和 R 用于报告创建。流行的 Python pandas 库用于加载和数据准备。然后,R 被用于可视化。

可以创建一个 R 数据对象,然后在 Python 环境中引用。以下是一个示例,其中使用 Python mpl_finance 模块创建了一个可视化:

就这些了!现在你可以选择使用哪种语言,或者让你的团队使用他们偏好的语言进行协作。

开始使用 Rmd

R 和 Python 课程在多个流行平台上均可用(例如:Coursera、Udemy、Vertabelo Academy、Data Camp)。许多课程也涵盖了数据可视化概念。R 和 Python 都是数据科学的优秀工具,可以同时使用。如果你有兴趣开始学习,可以考虑这些:

-

在 Coursera 上,有一个很棒的关于可重复研究和 R markdown 基础的课程:

www.coursera.org/lecture/reproducible-research/r-markdown-5NzHN -

如果你对 R 不太熟悉,Data Camp 提供了一个很好的入门课程:

-

作为 Vertabelo Academy 的作者,我个人推荐我们的 Python 和 R 课程。它们特别适合那些来自商业背景的人士:

-

Edx 提供了许多 Python 和 R 课程,包括来自哈佛、IBM、微软的课程。对于 Python 初学者,可以尝试这个 IBM 课程:

www.edx.org/course/python-basics-for-data-science-2

总结

Python 和 R 是当前最热门的数据科学语言。熟悉这两种语言是很有好处的,因为项目可能需要每种语言的不同方面。有许多包可以帮助将两者集成到使用场景中。一个是 R markdown,一种用于在 R 中创建动态文档的文件格式。Rmd 文件无缝集成了可执行代码和评论。在 reticulate 包的帮助下,可以轻松地在 Python 中访问 R 对象,反之亦然。分析师现在无需在 Python 和 R 之间做出选择——可以在一个文件中集成两者。

简介: Marija Ilic 是一名数据分析师/科学家。她喜欢分析大量数据。Marija 在银行业的 DWH/ETL 开发方面有着丰富的背景。

相关:

-

应用于 Pandas DataFrames 的集合操作

-

你可能不知道的 R 中的十个随机有用的东西

-

R 用户的客户细分

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全领域。

1. Google 网络安全证书 - 快速进入网络安全领域。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

主题拓展

为什么组织需要数据仓库

原文:

www.kdnuggets.com/2022/09/organizations-need-data-warehouses.html

Fabio 通过 Unsplash

无论你尝试构建什么,你都需要合适的工具。你可以在没有螺丝刀或电钻的情况下安装衣柜,对吧?你不能没有化妆刷来化妆,对吧?处理数据也是如此。数据被认为是新的石油 - 所以你可以想象你需要什么样的工具来处理这样高价值的东西。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 领域

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 领域

许多公司多年来认识到数据的价值,并决定开始构建机器学习模型,运用分析技能等,以帮助我们对这些数据进行更深入的洞察。但许多人忽视了存储和利用数据是策略中的一个重要方面。

那么你可以在哪里存储、利用和收集数据中的发现 - 在一个地方?这个正确的工具是什么?数据仓库

什么是数据仓库?

数据仓库,也可以称为企业数据仓库,是一个集中存储数据、信息等的仓库,这些数据可以被分析以做出更明智的决策。

它被认为是商业智能的核心组成部分,以及当今任何组织成功的关键。

团队中的业务和数据分析师可以通过以下方式利用数据仓库:

-

绩效测量 - 使用数据查看不同活动的表现,例如某个特定的销售工具。

-

获取验证 - 当使用不同的工具和方法时,你会想要更好地了解这些工具/方法如何改进你的组织目标。

存储的数据可以来自公司的操作数据库或外部来源。

数据仓库与操作数据库的不同之处

操作数据库是一个用于实时管理和存储数据的数据库 - 意味着它只处理当前数据。

然而,数据仓库的工作包括维护历史数据,并帮助知识工作者和组织内的其他方进一步分析,以帮助决策过程。

决策者、分析师和数据专家需要快速访问数据仓库,以帮助他们履行职责。

数据仓库的组成部分是什么?

为了理解数据仓库对业务的好处,我们需要了解数据仓库的实际运作方式。

存储在数据仓库中的数据需要包括报告、仪表板、分析应用程序和临时查询。

数据仓库由原始的原始数据或源数据组成,这些数据可以:

-

不仅处理实时数据,还可以利用更多数据

-

从多个来源收集数据,从而最大化数据质量

-

通过编码和描述不断提高数据的质量

-

能够纠正数据中的错误,如重复数据

-

格式化数据,以便它可以轻松使用并提高查询性能

-

拥有一致的数据历史记录,可以轻松维护

-

改善业务的其他领域,如客户关系管理、销售等

-

向决策者和利益相关者提供集中查看收集的不同类型数据及其关联的视图

为什么需要数据仓库?

组织到达一个点时,他们会意识到所有数据都分散在不同的地方,他们无法看到数据之间的关联,这使得分析师和其他人需要花费时间来找出这些关联,以便向决策者和利益相关者展示。

你希望将所有数据集中在一个地方,以便它可以:

作为单一真实来源

当你的所有数据都存储在一个集中式的存储库中,并且经过正确的维护和管理时,它可以消除数据质量问题、不一致的数据、不准确的数据报告和低查询性能。

一致性

当数据以统一的格式编排时,不仅在整个系统中保持一致,而且使决策者能够基于共享的数据洞察做出准确的决策。一旦数据格式标准化,无论其来源如何,都可以大幅减少风险并提高整体准确性。

更快做出更好的决策!

当你的所有数据、报告和分析都集中在一个地方时,你可以轻松地对大量数据集进行分析。数据仓库不仅提高了数据集访问的效率,还使团队成员能够基于得到的洞察做出更快的决策。

随着公司增长,复杂性也增长

对于任何变得更加创新和成功的公司来说,这都是自然的。这样会导致查询复杂性的增加,分析师、决策者和其他用户将需要更快的查询处理速度。

结论

数据仓库是组织需要的工具,以便拥有可靠和准确的存储数据。它不仅改善了跨组织的数据访问,还使组织能够监控其绩效、改善决策过程——这一切都因为他们知道自己的数据是可信的。

尼莎·阿里亚 是一位数据科学家和自由职业技术写作员。她特别关注提供数据科学职业建议或教程以及围绕数据科学的理论知识。她还希望探索人工智能如何/能够促进人类寿命的延续。作为一名热心学习者,她寻求拓宽自己的技术知识和写作技能,同时帮助指导他人。

更多相关内容

使用 Python 的 Pathlib 组织、搜索和备份文件

原文:

www.kdnuggets.com/organize-search-and-back-up-files-with-pythons-pathlib

图片由作者提供

Python 内置的 pathlib 模块 使得处理文件系统路径变得非常简单。在 如何使用 Python 的 Pathlib 导航文件系统 中,我们了解了处理路径对象和导航文件系统的基础知识。现在是时候深入了解了。

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你在 IT 领域的组织

3. 谷歌 IT 支持专业证书 - 支持你在 IT 领域的组织

在本教程中,我们将使用 pathlib 模块的功能来处理三项具体的文件管理任务:

-

按扩展名组织文件

-

搜索特定文件

-

备份重要文件

在本教程结束时,你将学会如何使用 pathlib 进行文件管理任务。让我们开始吧!

1. 按扩展名组织文件

当你在为一个项目进行研究和工作时,你通常会创建临时文件并下载相关文档到工作目录中,直到它变得杂乱,你需要整理它。

让我们来看一个简单的例子,其中项目目录包含 requirements.txt、配置文件和 Python 脚本。我们希望将文件按扩展名分类到子目录中——每个扩展名对应一个子目录。为了方便起见,我们选择将扩展名作为子目录的名称。

按扩展名组织文件 | 图片由作者提供

这是一个 Python 脚本,它扫描一个目录,按文件扩展名识别文件,并将它们移动到相应的子目录中:

# organize.py

from pathlib import Path

def organize_files_by_extension(path_to_dir):

path = Path(path_to_dir).expanduser().resolve()

print(f"Resolved path: {path}")

if path.exists() and path.is_dir():

print(f"The directory {path} exists. Proceeding with file organization...")

for item in path.iterdir():

print(f"Found item: {item}")

if item.is_file():

extension = item.suffix.lower()

target_dir = path / extension[1:] # Remove the leading dot

# Ensure the target directory exists

target_dir.mkdir(exist_ok=True)

new_path = target_dir / item.name

# Move the file

item.rename(new_path)

# Check if the file has been moved

if new_path.exists():

print(f"Successfully moved {item} to {new_path}")

else:

print(f"Failed to move {item} to {new_path}")

else:

print(f"Error: {path} does not exist or is not a directory.")

organize_files_by_extension('new_project')

organize_files_by_extension() 函数接受一个目录路径作为输入,将其解析为绝对路径,并按文件扩展名在该目录内组织文件。它首先确保指定的路径存在且为目录。

然后,它遍历目录中的所有项目。对于每个文件,它获取文件扩展名,创建一个以扩展名命名的新目录(如果该目录尚不存在),并将文件移动到这个新目录中。

在移动每个文件后,它会通过检查文件在新位置的存在来确认操作是否成功。如果指定路径不存在或不是目录,它会打印错误信息。

下面是示例函数调用的输出(在 new_project 目录中整理文件):

现在在你的工作环境中的项目目录上尝试这个。我使用了 if-else 来处理错误。但你也可以使用 try-except 块来改进这个版本。

2. 查找特定文件

有时你可能不希望像前面的示例那样按扩展名将文件组织到不同的子目录中。但你可能只想找到所有具有特定扩展名的文件(如所有图像文件),为此你可以使用 globbing。

假设我们想找到 requirements.txt 文件来查看项目的依赖项。让我们使用相同的示例,但在按扩展名将文件分组到子目录之后。

如果你使用如上所示的 glob() 方法在路径对象上查找所有文本文件(由模式 '*.txt' 定义),你会发现它没有找到文本文件:

# search.py

from pathlib import Path

def search_and_process_text_files(directory):

path = Path(directory)

path = path.resolve()

for text_file in path.glob('*.txt'):

# process text files as needed

print(f'Processing {text_file}...')

print(text_file.read_text())

search_and_process_text_files('new_project')

这是因为 glob() 只搜索当前目录,而该目录不包含 requirements.txt 文件。requirements.txt 文件位于 txt 子目录中。因此,你必须使用 递归 globbing 和 rglob() 方法。

所以这里是找到文本文件并打印其内容的代码:

from pathlib import Path

def search_and_process_text_files(directory):

path = Path(directory)

path = path.resolve()

for text_file in path.rglob('*.txt'):

# process text files as needed

print(f'Processing {text_file}...')

print(text_file.read_text())

search_and_process_text_files('new_project')

search_and_process_text_files 函数接收一个目录路径作为输入,将其解析为绝对路径,并使用 rglob() 方法在该目录 及 其子目录中查找所有 .txt 文件。

对于找到的每个文本文件,它打印文件的路径,然后读取并打印出文件的内容。此函数对于递归地定位和处理指定目录中的所有文本文件非常有用。

由于 requirements.txt 是我们示例中唯一的文本文件,我们得到了以下输出:

Output >>>

Processing /home/balapriya/new_project/txt/requirements.txt...

psycopg2==2.9.0

scikit-learn==1.5.0

现在你知道如何使用 globbing 和递归 globbing,尝试重新做第一个任务——按扩展名整理文件——使用 globbing 查找并分组文件,然后将它们移动到目标子目录。

3. 备份重要文件

迄今为止我们看到的示例是按扩展名整理文件和查找特定文件。但如何备份某些重要文件呢?为什么不呢?

在这里,我们希望将文件从项目目录复制到备份目录,而不是将文件移动到另一个位置。除了 pathlib,我们还将使用 shutil 模块的 copy 函数。

让我们创建一个函数,将所有具有特定扩展名(所有 .py 文件)的文件复制到备份目录:

#back_up.py

import shutil

from pathlib import Path

def back_up_files(directory, backup_directory):

path = Path(directory)

backup_path = Path(backup_directory)

backup_path.mkdir(parents=True, exist_ok=True)

for important_file in path.rglob('*.py'):

shutil.copy(important_file, backup_path / important_file.name)

print(f'Backed up {important_file} to {backup_path}')

back_up_files('new_project', 'backup')

back_up_files() 函数接收一个现有的目录路径和一个备份目录路径函数,并将指定目录及其子目录中的所有 Python 文件备份到指定的备份目录。

它为源目录和备份目录创建路径对象,并通过创建备份目录及其任何必要的父目录(如果尚不存在)来确保备份目录的存在。

然后,函数使用 rglob() 方法迭代源目录中的所有 .py 文件。对于每个找到的 Python 文件,它将文件复制到备份目录,同时保留原始文件名。本质上,这个函数帮助在项目目录内创建所有 Python 文件的备份。

运行脚本并验证输出后,你可以随时检查备份目录的内容:

对于你的示例目录,你可以使用 back_up_files('/path/to/directory', '/path/to/backup/directory') 来备份感兴趣的文件。

总结

在本教程中,我们探讨了使用 Python 的 pathlib 模块来按扩展名组织文件、搜索特定文件和备份重要文件的实际示例。你可以在 GitHub 上找到本教程中使用的所有代码。

正如你所见,pathlib 模块使得处理文件路径和文件管理任务变得更加轻松和高效。现在,继续在你的项目中应用这些概念,以更好地处理文件管理任务。祝编程愉快!

Bala Priya C**** 是来自印度的开发者和技术作家。她喜欢在数学、编程、数据科学和内容创作的交汇处工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编码和喝咖啡!目前,她正在通过编写教程、操作指南、意见文章等方式学习并与开发者社区分享她的知识。Bala 还创建了有趣的资源概述和编码教程。

相关主题

疫情分析:应对新问题的数据科学策略

原文:

www.kdnuggets.com/2020/04/outbreak-analytics-data-science-novel-problem.html

评论

由 Susan Sivek 提供,Alteryx。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

你走在超市的一条过道上,去拿你最喜欢的麦片。在乳制品过道上,有人因 COVID-19 咳嗽。

你在拿牛奶之前先拿麦片的决定是否可能让你保持健康?

在全球疫情期间,我们在做简单的日常决定时都会问这样的问题。但现在设想一下,你的工作是创建一个 COVID-19 传播模型,这个模型需要考虑人类不可预测的、近乎随机的选择。你的模型还可能包括政府的社交距离规定、医院护理的可用性、人口中的既有疾病等。

听起来复杂吗?确实如此,但来自各种领域的研究人员正在努力创建尽可能准确、有用的模型,以预测和解释 COVID-19 的传播。我不是流行病学家,但如果你也对迄今为止公布的数据可视化和建模感到印象深刻和好奇,这篇文章就是为你准备的。

我查阅了一些最近的研究,以了解这些研究人员如何进行所谓的 疫情分析。这里是对这一独特分析过程几个组成部分的初步介绍。我们也会发现一些其他分析应用的经验教训。

估算病毒传播

“一旦我们知道 R[0],我们就能够掌握疫情的规模。” - 电影《传染病》

再生数,或 R[0](读作“R 零”),指的是一个生病的人可能感染的人的数量。由于人口统计、气候、社会结构和社交距离措施等因素,R[0] 在疾病发生的每个时间和地点都会发生变化。研究人员通过确定第一次感染和第二次感染之间的时间(生成时间,当这种时间对许多对病人已知时,可以绘制为生成时间分布)来计算 R[0]。估计 R[0] 对于预测疾病传播至关重要。对于引起 COVID-19 的 SARS-CoV-2,目前R[0] 被认为在不同地方的范围为 1.5 到 3.5。

一个名为 R0 的 R 包(可以在这里获取)能够利用疫情数据计算当前的 R[0]。该包提供了五种不同的计算方法,还具有一个灵敏度分析选项,显示了哪种时间窗口或生成时间的选择最适合数据。

还有一个类似的 R 包,EpiEstim,由不同的研究小组开发,具有Excel 选项。EpiEstim 基于分支过程模型,并根据简单的时间序列数据估计 R[0]。该模型试图捕捉每个感染者将感染的人的数量,但带有随机性(或随机性)元素——就像在商店里与感染者随机相遇一样。下图(更大图的一部分)显示了该模型为过去五次疫情生成的 R[0] 估计。

病原体基因组测序

“它展示了新奇的特征……它是哥斯拉、金刚和弗兰肯斯坦的结合体。”

- Contagion

对来自不同地点和时间的病人的 SARS-CoV-2 样本进行基因分析可以帮助研究人员追踪病毒的传播和突变。这项分析还可以帮助快速识别可能的治疗方法。研究人员最近展示了一种新的机器学习方法,通过基因组识别未知病毒的类型及其不同的变种(即确定其分类,如“冠状病毒”的广泛类别)。

这种方法将 SARS-CoV-2 基因组序列转换为数值表示(详见 完整研究论文)。几乎 15,000 种其他病毒的序列也被用于训练数据中。研究人员训练了六种不同的机器学习模型(线性判别分析、线性支持向量机、二次支持向量机、细化的 KNN、子空间判别分析和子空间 KNN)。训练后的模型对 COVID-19 病毒株基因组的最高分类等级进行标签预测。研究人员随后将模型转向下一个更具体的分类等级,并重复这一过程。

下图展示了研究人员在最后两次测试中的结果,这些测试将 153 个病毒序列分类为四个亚属和 COVID-19,然后将 76 个病毒序列分类为其他 Sarbecovirus 类型或 COVID-19。

这一策略不仅帮助确认了 SARS-CoV-2 应正确归类于其他冠状病毒科和 β 冠状病毒病原体,而且还发现它与在蝙蝠中发现的其他病毒有重要的相似之处。研究人员认为,他们的方法更快(包括 10 倍交叉验证在内的 10 分钟内),且能够比较更多、更具多样性的样本,相比于以前的分析过程。虽然对当前疫情可能会有一些见解,但这种方法对未来的疫情爆发也可能有所帮助。

尽管存在不确定性,预测疾病传播

“基于我们的模型,根据 R[0] 为 3.2 … 这是我们预计在 48 小时后达到的情况。”

- 传染*

一种流行病学建模方法是创建一个“SIR 模型”,该模型将整体人群划分为“易感”、“感染”和“移除”(即从疾病中康复并被赋予一定程度免疫,或因死亡不再在人群中)这三个“隔间”。

然而,生成这样的模型从来都不容易。由于多种原因,包括制度性障碍、缺乏检测、未知或无症状病例等,疫情数据可能难以准确收集。而且,正如我们所见,各国政府在不同时间实施了不同的社交距离和隔离措施,这可能对“易感”隔间中的人数产生不可预测的影响。

为了处理所有不确定性来源,一组研究人员开发了他们所谓的“eSIR”模型——一个扩展模型,包括“一个时间变化的概率,表示易感者遇到感染者的概率或反之亦然”,以及一个新的区隔来包括选择自我隔离的易感者。这两个因素在特定地区会根据实施隔离协议的时间而有所变化。

为了进一步将不确定性纳入模型,研究人员使用了马尔可夫链蒙特卡罗(MCMC)算法。(这里有两个对 MCMC 的解释:一个较简单的,一个较复杂的)。MCMC 方法允许对那些不能直接知道的分布(如 SARS-CoV-2 感染的真实数量)或过于昂贵以至于难以计算的分布进行近似。eSIR 模型的预测旨在揭示疫情中的“转折点”。转折点包括每日新增病例停止增长的时候,以及感染病例达到最高点的时候。该模型还可以提供 R[0]的估计值。

研究人员正在发布一个名为 eSIR 的 R 包,该包生成模型、ggplot2 对象和总结统计数据。这种方法的有用之处在于,它可以帮助确定哪些隔离策略可能最有效以及何时实施。正如研究人员所说,“……过于严格的隔离可能会适得其反;人们可能会失去对隔离系统的信任和耐心,因此可能会尝试减少遵守或甚至避免隔离。”必须权衡实施严格隔离系统的风险与疾病预防的收益。该模型提供了一种重要计算的途径。

对所有建模的启示

从这些尚处于初步阶段的模型中,我们可以学到哪些超越疫情的教训?有几个关键点。

首先,这些模型展示了在应对极其复杂情况时的快速创新。(上述基因组和“eSIR”研究仍为“预印本”,即尚未经过同行评审,并已尽可能快速发布,以贡献于科学界应对疫情的努力。)尽管面临巨大的压力,看到研究人员如此迅速地将创造力应用于这场危机,实在令人印象深刻,也激励了我们在寻求应对众多新挑战的解决方案。

其次,另一个可能对数据人员来说熟悉的挑战是:让决策者采取行动 基于数据洞察。伟大的“扁平化曲线”可视化和相关的预测似乎对政策制定者和公众产生了强烈的影响。同样,数据专家需要能够清晰地沟通他们的分析和模型——例如,通过 有效的数据可视化——组织也应在各个领域建立数据素养。

最后,我审查的研究经常提到获取优质 COVID-19 数据以建立良好模型的挑战。即使在正常时期,获取我们需要的数据种类和质量也可能很困难。关于大流行的模型——或者任何其他现象——只有建立在高质量数据之上才有价值。数据无处不在,但并非所有数据都值得信赖、可用或相关。每个组织都需要建立稳固的数据收集、管理和分析结构(正如 这些流行病学家建议的用于爆发)。有了这些准备,如果出现任何危机,你的响应可以基于准确、相关、最新的数据。

原文。经许可转载。

个人简介: 苏珊·库里·西维克,博士,是一位作家和数据爱好者,喜欢以日常语言解释复杂的想法,有时以有趣的方式进行。她喜欢美食、科幻小说和狗。

相关内容:

更多相关话题

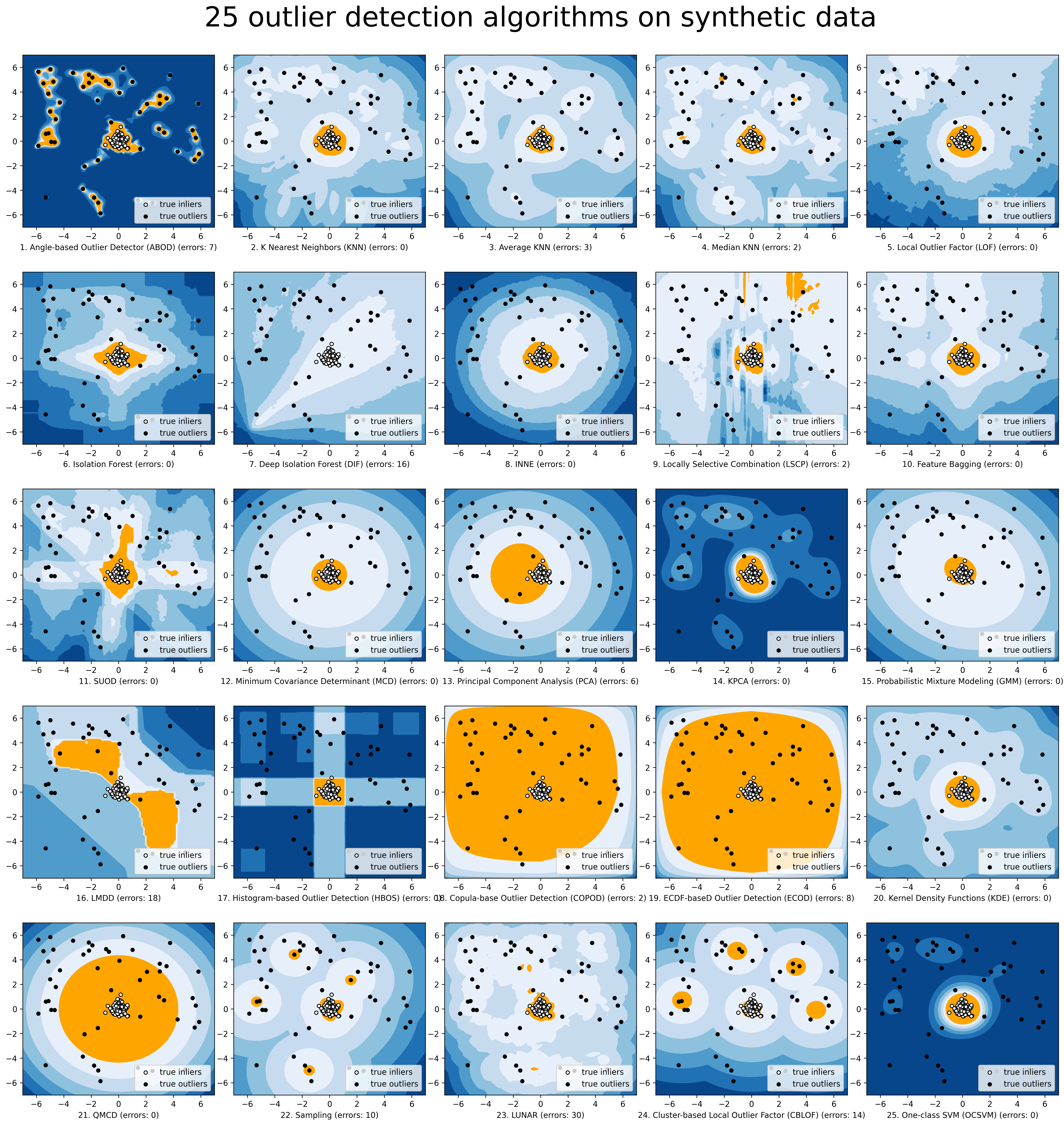

异常值检测方法的直观可视化

原文:

www.kdnuggets.com/2019/02/outlier-detection-methods-cheat-sheet.html

评论

评论

异常值是指那些似乎无法很好适应剩余数据或模型的数据实例。虽然许多机器学习算法故意不考虑异常值,或者可以修改为明确地丢弃它们,但有时异常值本身可能就是关键。

在欺诈检测中,这种情况尤为明显,欺诈检测利用异常值来识别欺诈活动。如果你经常在纽约及其周边以及在线使用信用卡,主要用于一些微不足道的消费?今天早上在 Soho 的咖啡店用过,晚上在 Upper West Side 吃过晚饭,但在这期间在巴黎“亲自”花费几千美元购买电子设备?这就是你的异常值,这些会被用各种机器学习技术进行不懈追踪。

这个简单的例子实际上让这看起来过于简单了。实际上,没有普遍适用的异常值定义;你能想象试图定义一个具体规则来界定地理上“过远”而不适用的情况,并且这个规则适用于所有类似上述情况的欺诈检测场景吗?即使我们能达成共识什么是异常值,根据应用的不同,我们可能不希望去除它,只是对其存在保持警觉。

即使我们说我们希望在检测到异常值时收到通知,仍然有各种方法可以实现这一点。想要使用简单的描述性统计方法,比如识别在正态分布中偏离均值特定倍数的低维数据点?很好,如果这对你有效。但也有许多其他方法。

查看这个用于异常值检测方法的可视化,它来自于Python 异常值检测(PyOD)的创建者——我鼓励你点击查看以享受高清分辨率的效果:

点击放大

至少有 12 种异常值检测方法以非常直观的方式进行了可视化。他们在这方面做得非常出色。

当然,虽然这作为了解不同异常值检测方法如何工作的极好备忘单,但实际上这是来自于之前提到的 Python 项目:

PyOD 是一个全面且可扩展的 Python 工具包,用于检测多变量数据中的异常对象。这个既令人兴奋又具有挑战性的领域通常被称为异常值检测或异常检测。自 2017 年以来,PyOD 已成功应用于各种学术研究和商业产品中。

如果你正在学习异常值检测,PyOD 是一个简单的工具包,具有 Scikit-learn 风格的 API,包括许多检测算法的实现(它的 GitHub 仓库链接到算法的原始论文),且足够直观,可以几乎立即上手,只要你对当代 Python 机器学习生态系统的各个组件有一定了解。你可以在这里找到项目文档。

相关:

-

如何使你的机器学习模型对异常值具有鲁棒性

-

异常值检测的四种技术

-

数据科学基础:从数据中可以挖掘出哪些模式?

更多相关话题

使用 Great Expectations 解决您的数据质量问题

原文:

www.kdnuggets.com/2023/01/overcome-data-quality-issues-great-expectations.html

Gartner, Inc. 估计,不良数据的成本 每年给组织带来的平均损失为 1290 万美元。

我们每天处理 PB 级的数据,大规模的数据量中常常会出现数据质量问题。不良数据会给组织带来金钱、声誉和时间上的损失。因此,持续监控和验证数据质量非常重要。

我们的三大课程推荐

1. Google 网络安全证书 - 加速您的网络安全职业生涯。

1. Google 网络安全证书 - 加速您的网络安全职业生涯。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您组织的 IT

3. Google IT 支持专业证书 - 支持您组织的 IT

什么是不良数据?

不良数据包括不准确的信息、缺失的数据、错误的信息、不符合规范的数据和重复的数据。不良数据会导致错误的数据分析,从而导致不良决策和无效的策略。

Experian 数据质量发现,平均公司因数据不足而损失了 12%的收入。除了金钱,公司还会遭受浪费时间的损失。

在处理数据之前识别异常将帮助组织更好地洞察客户行为并减少成本。

Great Expectations 库帮助组织通过 200 多种现成规则来验证和确认数据中的异常。

什么是 Great Expectations(GE)?

Great Expectations 是一个开源的 Python 库,帮助我们验证数据。Great expectations 提供了一组方法或函数来帮助数据工程师 快速验证给定的数据集。

在这篇文章中,我们将探讨如何通过 Great Expectations 库进行数据验证的步骤。

Great Expectations 如何工作

GE 就像是数据的单元测试。GE 提供了称为 Expectations 的断言,用来对测试数据应用一些规则。例如,保险单文件中的政策 ID/号码不应该为空。要设置和执行 GE,必须按照以下步骤进行。尽管有多种方法可以使用 GE(例如通过其 CLI),我将在本文中解释编程方式的设置。本文解释的所有源代码均可在这个 GitHub 仓库 中找到。

第一步:设置数据配置

GE 有一个存储的概念。存储就是它可以在磁盘上存储期望(规则/断言)、运行详情、检查点详情、验证结果和数据文档(验证结果的静态 HTML 版本)的物理位置。点击这里 了解更多关于存储的信息。

GE 支持多种存储后端。本文中,我们使用文件存储后端和默认设置。GE 还支持其他存储后端,如 AWS(亚马逊 Web 服务)S3、Azure Blob、PostgreSQL 等。请参阅 了解更多关于后端的信息。下面的代码片段展示了一个非常简单的数据配置:

STORE_FOLDER = "/Users/saisyam/work/github/great-expectations-sample/ge_data"

#Setup data config

data_context_config = DataContextConfig(

datasources = {},

store_backend_defaults = FilesystemStoreBackendDefaults(root_directory=STORE_FOLDER)

)

context = BaseDataContext(project_config = data_context_config)

上述配置使用了默认的文件存储后端。GE 将自动创建运行期望所需的文件夹。我们将在下一步中添加数据源。

第二步:设置数据源配置

GE 支持三种类型的数据源:

-

Pandas

-

Spark

-

SQLAlchemy

数据源配置告诉 GE 使用特定的执行引擎来处理提供的数据集。例如,如果你将数据源配置为使用 Pandas 执行引擎,你需要提供一个 Pandas 数据框给 GE 以运行期望。下面是一个使用 Pandas 作为数据源的示例:

datasource_config = {

"name": "sales_datasource",

"class_name": "Datasource",

"module_name": "great_expectations.datasource",

"execution_engine": {

"module_name": "great_expectations.execution_engine",

"class_name": "PandasExecutionEngine",

},

"data_connectors": {

"default_runtime_data_connector_name": {

"class_name": "RuntimeDataConnector",

"module_name": "great_expectations.datasource.data_connector",

"batch_identifiers": ["default_identifier_name"],

},

},

}

context.add_datasource(**datasource_config)

请参阅 这份文档 以获取有关数据源的更多信息。

第三步:创建期望套件并添加期望

这一步是关键部分。在这一步中,我们将创建一个套件并向套件中添加期望。你可以将套件视为一组将作为批次运行的期望。在这里创建的期望是为了验证一个示例销售报告。你可以下载 sales.csv 文件。

下面的代码片段展示了如何创建一个套件并添加期望。我们将向套件中添加两个期望。

# Create expectations suite and add expectations

suite = context.create_expectation_suite(expectation_suite_name="sales_suite", overwrite_existing=True)

expectation_config_1 = ExpectationConfiguration(

expectation_type="expect_column_values_to_be_in_set",

kwargs={

"column": "product_group",

"value_set": ["PG1", "PG2", "PG3", "PG4", "PG5", "PG6"]

}

)

suite.add_expectation(expectation_configuration=expectation_config_1)

expectation_config_2 = ExpectationConfiguration(

expectation_type="expect_column_values_to_be_unique",

kwargs={

"column": "id"

}

)

suite.add_expectation(expectation_configuration=expectation_config_2)

context.save_expectation_suite(suite, "sales_suite")

第一个期望 “expect_column_values_to_be_in_set” 检查列(product_group)值是否等于给定 value_set 中的任何值。第二个期望检查 “id” 列的值是否唯一。

一旦期望被添加并保存后,我们现在可以在数据集上运行这些期望,这将在第四步中进行。

第四步:加载并验证数据

在这一步骤中,我们将 CSV 文件加载到 pandas.DataFrame 中,并创建一个检查点以运行我们之前创建的期望。

# load and validate data

df = pd.read_csv("./sales.csv")

batch_request = RuntimeBatchRequest(

datasource_name="sales_datasource",

data_connector_name="default_runtime_data_connector_name",

data_asset_name="product_sales",

runtime_parameters={"batch_data":df},

batch_identifiers={"default_identifier_name":"default_identifier"}

)

checkpoint_config = {

"name": "product_sales_checkpoint",

"config_version": 1,

"class_name":"SimpleCheckpoint",

"expectation_suite_name": "sales_suite"

}

context.add_checkpoint(**checkpoint_config)

results = context.run_checkpoint(

checkpoint_name="product_sales_checkpoint",

validations=[

{"batch_request": batch_request}

]

)

我们为数据创建了一个批量请求,提供数据源名称,这将告诉 GE 使用特定的执行引擎,在我们的例子中是 Pandas。我们创建一个检查点配置,然后将批量请求与检查点进行验证。如果期望适用于单个检查点中的批量数据,您可以添加多个批量请求。run_checkpoint方法以 JSON 格式返回结果,可以用于进一步处理或分析。

结果

一旦我们在数据集上运行了期望,GE 会创建一个静态 HTML 仪表板,显示检查点的结果。结果包括评估期望的数量、成功的期望、不成功的期望和成功百分比。任何与给定期望不匹配的记录将在页面上突出显示。以下是成功执行的示例:

来源:伟大期望

以下是一个失败期望的示例:

来源:伟大期望

结论

我们已通过四个步骤设置了 GE,并成功在给定数据集上运行了期望。GE 具有更高级的功能,如编写自定义期望,我们将在未来的文章中介绍。许多组织广泛使用 GE 来定制客户需求并编写自定义期望。

Saisyam Dampuri 拥有超过 18 年的软件开发经验,热衷于探索新技术和工具。他目前在美国德克萨斯州 Anblicks 担任高级云架构师。在不编程的时候,他会忙于摄影、烹饪和旅行。

更多相关内容

如何克服对数学的恐惧,并学习数据科学所需的数学

原文:

www.kdnuggets.com/2021/03/overcome-fear-learn-math-data-science.html

编辑器提供的图像

有一件事你需要首先关注:数据科学所需的数学量。使用这些文章作为参考,了解你需要学习什么:

-

一篇很好的博客文章来自 Sharp Sight Labs 的Josh Ebner。他解释了初级数据科学家与高级数据科学家之间的区别,数据科学基础技能所需的数学,数据科学理论与实践之间的区别等。

-

一篇博客文章来自Tim Hopper。他曾是数学专业学生,并在成为数据科学家之前是数学博士生一年。这里是他关于数据科学所需数学量的 YouTube 演讲。

-

Rebecca Vickery有一个数据科学所需学习的数学主题列表。这是我用作参考的内容。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

根据上述内容,这里是我学习数学的方式:

第一步:一种新的学习方法

学习统计学非常令人困惑。我无法将不同部分的主题联系起来。我参加了宾州州立大学的 STAT100 在线课程(一周),但仍然记不住任何东西。

然后是概率。我花了数天数夜和周末试图掌握贝叶斯定理,但它就像一个我永远无法解开的谜。我问自己:

在我个人生活中,我在过去几个月是如何娱乐自己的?我从哪里找到了快乐?

我喜欢观看 纸牌屋、金装律师、攻壳机动队、亿万 和 星球大战。我曾 沉迷观看 了这些剧集的许多季节/卷。我决定在一整周内沉迷于概率学习:从周一到周日。我制定了一个新计划:

我不会阅读数学教科书。我也不会参加任何 MOOC。原因是:这两者都源于为研究生学习(3+ 年)设计的学术标准。学术界的人已经是这些学科的专家,他们已经教授了这些内容多年,因此,关于这些内容的 MOOC/书籍至少是一个或两个学期的长度。那么,对于一个对这些学科一无所知且没有一两个学期时间学习的人来说呢?

我如何学习

-

如果我在一个地方没有理解某个内容,我就会离开,转到另一个地方。与其在同一篇文章、博客或视频上花费几个小时,不如专注于当前主题的学习,这样我能更灵活。我使用了一个又一个资源,直到我理解了概念。

-

我练习了问题。我们不能通过阅读和理解来学习数学。我们需要将其应用到问题中。mathsisfun.com 提供了带有答案的问题列表。

第 2 步:沉迷于*

我最终沉迷于学习、阅读和练习了许多概念:

-

Eddie Woo 的离散随机变量。总共 3 个视频(包括期望值)

-

来自 Eddie Woo 的排列与组合

-

来自 Mario’s Math Tutoring 的排列与组合

-

来自 Math is fun 的贝叶斯定理

-

来自 Investopedia 的条件概率、贝叶斯定理等内容

-

来自 zedstatistics 的概率分布(以梯度形式解释)

-

来自 Explained by Michael 的概率密度函数(以代数和图形形式解释)

-

来自 Explained by Michael 的累积分布函数

-

来自 Jason Gibson 和 mathtutordvd.com 的离散概率分布(这是关于离散概率分布的最佳视频)

-

一篇优秀的 StackExchange 文章 关于 PDF 与 PMF

-

来自我上面提到的 StackExchange 帖子的数学洞察链接关于 PDF 的想法

-

MIT OCW 的PDF 讲座(它在 StackExchange 帖子中提到)

现在我可以用费曼技巧解释关于 PDF 的一切 😃

我不是唯一一个理解这个学习原则的人。Ken Jee在他的 YouTube 视频中提出了一个类似的计划。

Ken Jee 在YouTube上的内容。

第 3 步:统计学和线性回归

最后,我狂看了统计学基础,由 StatQuest 的Josh Starmer主讲。

他现在正在观看的线性回归和线性模型播放列表。这位讲解者非常擅长解释内容。他不浪费时间,直奔主题,确保在继续之前进行复习,而且几乎没有代码。他追求清晰和基础,这才是学习任何东西的核心。Josh 的对数和线性回归介绍是我迄今为止见过的最佳。而且你一定会喜欢他的 BAMs、tiny bam 和 triple BAMs 😃

第 4 步:线性代数

我推荐你从这些地方学习线性代数,而不是使用传统的学习方法(拿起一本书,花几个月时间)。你可以在一周内完成。他们有你进行数据科学所需的所有线性代数:

-

来自Ritchie Ng的线性代数

-

来自Dive Into Deep Learning的线性代数

-

来自Pablo Caceres的线性代数(最全面。我做了 70%的内容,因为我想学习某些主题。它包含了很多理论,我认为它包含了足够的内容,即使是深度学习也需要了解)

-

来自Deep Learning Book的线性代数

第 5 步:克服对数学的恐惧

许多学习者对数学感到恐惧。这种数学恐惧让我们无法理解和掌握我们需要学习的任何主题。我们认为自己没有数学头脑。像乔治·坎托尔那样成为天才,创造数学实体,并能够理解和使用数学作为解决问题的工具或模型,这两者是截然不同的。前者是宇宙(或上帝)赐予的礼物,而后者是一种技能。此外,我们既不是天才,也不是哈佛或牛津的优秀毕业生。我们无法改变这一限制,但我们可以改变态度和能力,将数学作为技能来掌握。查看这些视频来改变你对数学的信念:

列表 A:

你喜欢的任何来自数学巫师的视频(我已经看了 30 多个)。从这些视频开始:

-

6 个鲜为人知的理由为什么自学是数学成功的关键

列表 B:

-

学习数学需要什么?生活需要什么? | Miroslav Lovric

-

任何人都可以成为数学达人一旦他们知道最佳学习技巧 | Po-Shen Loh

-

如何成为数学高手,以及学习的其他惊人事实 | Jo Boaler

-

我们教育系统的有趣故事 | Adhitya Iyer

最后一部视频是关于印度教育系统如何运作的。我在这里学习过,所以我有点偏见把它包括在内。顺便说一句,这是一个有趣的视频。

列表 C:

选择一个你一直想学的数学主题,去数学很有趣阅读并完成所有练习。通过这样做,你会立刻减少一半的恐惧。解释已经简单到让你看穿数学,无论你的年龄或背景如何。

第 6 步:如何不忘记你所学的内容

当你通过阅读、观看和解决问题来学习上述内容时,你很快会在一周左右的时间内忘记 80-90%的内容。让学习持久的唯一方法是:在你的工作中每天使用它。

成为数据科学家的自学诅咒是你不能使用你所学到的一切。因此,这里有一种不同的方法:

-

一旦你学会了一个主题,接下来使用费曼技巧

-

将主题的标题放在一个列表上

-

在一周结束时,检查你的列表,并使用费曼技巧来解释列表上的所有主题

这种方法的好处

这种Binge-* + 费曼技巧的方法有几个好处:

-

你节省了很多时间,因为你不需要阅读整本书或进行大规模在线课程,这些都需要几个月的时间。

-

你只学习你需要的内容。数据科学不是数学。不要忘记业务价值、作品集准备、利益相关者和使用数据讲故事。这些比“全面学习数学”更重要。

-

你的重点仍然放在实际工作上。

-

你学习如何解释。这是在工作场所中能够有效表达观点的一个非常有用的技能,同时尊重周围的每个人。它在面试中也很有帮助。

-

既然你已经掌握了某些数学主题的基本思想,你可以在就业后深入探索和学习。

Arnuld 是一位具有 5 年经验的工业软件开发人员,擅长 C、C++、Linux 和 UNIX。在转型进入数据科学并作为数据科学内容撰稿人工作了一年后,他目前担任自由职业数据科学家。

更多相关主题

克服多语言语音技术中的障碍:前 5 大挑战及创新解决方案

介绍

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力。

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求。

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求。

你多久会在用西班牙语(你的首选语言)向语音助手提问后不得不暂停一下,然后重新用语音助手能理解的语言(可能是英语)重复你的请求,因为语音助手没有理解你的西班牙语请求?或者你多久会在要求语音助手播放你最喜欢的艺术家 A. R. Rahman 的音乐时故意发错音,因为你知道如果你正确地说出他们的名字,语音助手根本听不懂,但如果你说 A. R. Ramen,语音助手就能明白?此外,你多久会在语音助手用它那安抚的、全知的声音把你最喜欢的音乐剧《悲惨世界》叫成“Les Miz-er-ables”时感到尴尬?

尽管语音助手在大约十年前已经成为主流,但它们在多语言环境中的用户请求理解方面仍然显得很简单。在多语言家庭日益增多、现有和潜在用户群体变得越来越全球化和多样化的世界中,语音助手在理解用户请求时必须做到无缝对接,无论是语言、方言、口音、语调、调制还是其他语音特征。然而,语音助手在与用户进行流畅对话方面依然大大滞后于人类之间的自然交流。本文将探讨使语音助手能够进行多语言操作的主要挑战,并讨论一些可能的解决策略。我们将在整篇文章中使用假设的语音助手Nova作为示例。

语音助手的工作原理

在深入探讨使语音助手用户体验多语言化的挑战和机遇之前,让我们先了解一下语音助手是如何工作的。以 Nova 为假设的语音助手,我们看看请求音乐曲目的端到端流程是什么样的(参考)。

图 1. 假设语音助手 Nova 的端到端概览

如图 1 所示,当用户请求 Nova 播放流行乐队 Coldplay 的原声音乐时,用户的声音信号首先被转换为一串文本令牌,这一步是人类与语音助手互动的第一步。这一阶段称为自动语音识别(ASR)或语音转文本(STT)。一旦文本令牌串生成,它将被传递到自然语言理解步骤,在这里语音助手尝试理解用户意图的语义和句法含义。在这种情况下,语音助手的 NLU 解释用户在寻找由乐队 Coldplay 演唱的歌曲(即解释 Coldplay 是一个乐队),这些歌曲的性质是原声的(即在该乐队的专辑中查找歌曲的元数据,只选择版本为原声的歌曲)。然后,这种用户意图理解被用来查询后端以找到用户所寻找的内容。最后,实际的用户查询内容以及任何其他需要呈现给用户的附加信息被转移到下一步骤。在这一步中,响应和任何其他可用信息被用来装饰用户体验,并令人满意地响应用户查询。在这种情况下,输出将是一个文本到语音(TTS)输出(“这是一些 Coldplay 的原声音乐”),接着播放为此用户查询所选择的实际歌曲。

构建多语言语音助手的挑战

多语言语音助手(VAs)意味着能够理解和回应多种语言的语音助手,无论这些语言是否由同一个人或不同的人说,或者如果它们在同一句话中混合着另一种语言(例如“Nova, arrêt! Play something else”)。以下是语音助手在多模态环境中无缝操作时面临的主要挑战。

语言资源的数量和质量不足

为了使语音助手能够很好地解析和理解查询,它需要在该语言的大量训练数据上进行训练。这些数据包括人类的语音数据、地面真实情况的注释、大量的文本语料库、用于改进 TTS(例如发音词典)的资源和语言模型。虽然这些资源在英语、西班牙语和德语等热门语言中很容易获得,但对于斯瓦希里语、普什图语或捷克语等语言,它们的可用性有限甚至不存在。尽管这些语言有足够多的使用者,但仍没有结构化的资源。为多种语言创建这些资源可能成本高昂、复杂且劳动密集,从而成为进步的障碍。

语言变化

语言有不同的方言、口音、变体和地区适应。处理这些变体对语音助手来说是一个挑战。除非语音助手适应这些语言细微差别,否则很难正确理解用户请求或以相同的语言语调作出回应,以提供自然且更像人类的体验。例如,仅英国就有超过 40 种英语口音。另一个例子是墨西哥讲的西班牙语与西班牙讲的西班牙语的区别。

语言识别和适应

多语言用户在与其他人互动时通常会切换语言,他们可能希望与语音助手的互动也能自然地进行。例如,“Hinglish”是一个常用术语,用于描述一个人在讲话时使用印地语和英语的单词。能够识别用户与语音助手互动时使用的语言并相应调整回应是一个困难的挑战,目前没有主流的语音助手能够做到这一点。

语言翻译