InstructGPT 论文略读:三步走,让大模型真正听懂人话

posted @ 2025-10-06 09:47 GlenTt 阅读(253) 评论(0) 推荐(0)

2025年10月6日 #

posted @ 2025-10-06 09:47 GlenTt 阅读(253) 评论(0) 推荐(0)

2025年10月4日 #

posted @ 2025-10-04 14:26 GlenTt 阅读(425) 评论(0) 推荐(0)

2025年10月3日 #

posted @ 2025-10-03 13:43 GlenTt 阅读(467) 评论(0) 推荐(0)

2025年9月29日 #

posted @ 2025-09-29 10:25 GlenTt 阅读(271) 评论(0) 推荐(0)

2025年9月25日 #

posted @ 2025-09-25 10:52 GlenTt 阅读(330) 评论(0) 推荐(0)

2025年9月24日 #

posted @ 2025-09-24 17:57 GlenTt 阅读(253) 评论(0) 推荐(0)

2025年9月19日 #

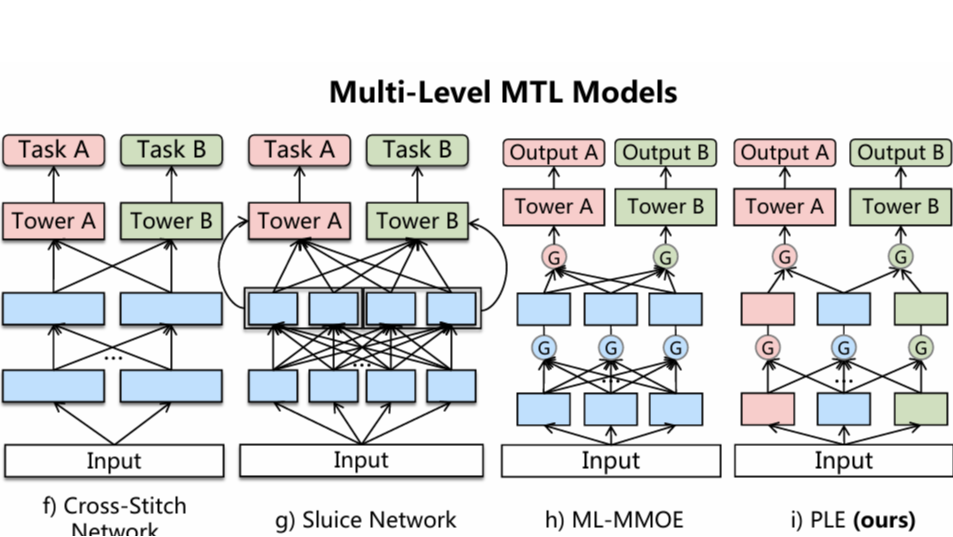

从MMoE到PLE:读懂多任务学习架构的渐进式演化 引言 在多任务学习(MTL)领域,MMoE(Multi-gate Mixture-of-Experts)无疑是一个里程碑式的模型,它通过巧妙的软参数共享机制,极大地提升了工业界推荐、广告等系统的多目标优化能力。然而,在面对任务间关系愈发复杂、甚至相 阅读全文

从MMoE到PLE:读懂多任务学习架构的渐进式演化 引言 在多任务学习(MTL)领域,MMoE(Multi-gate Mixture-of-Experts)无疑是一个里程碑式的模型,它通过巧妙的软参数共享机制,极大地提升了工业界推荐、广告等系统的多目标优化能力。然而,在面对任务间关系愈发复杂、甚至相 阅读全文

posted @ 2025-09-19 10:24 GlenTt 阅读(464) 评论(0) 推荐(0)

2025年9月18日 #

posted @ 2025-09-18 09:30 GlenTt 阅读(437) 评论(0) 推荐(0)

2025年9月17日 #

posted @ 2025-09-17 16:08 GlenTt 阅读(246) 评论(0) 推荐(0)

2025年9月16日 #

posted @ 2025-09-16 16:10 GlenTt 阅读(4288) 评论(2) 推荐(2)