目录

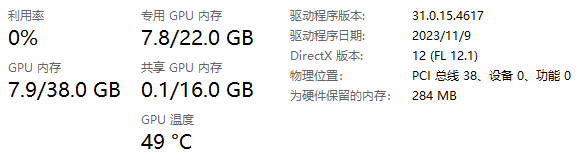

加载fp16模型到显存的消耗

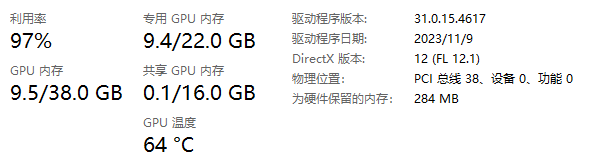

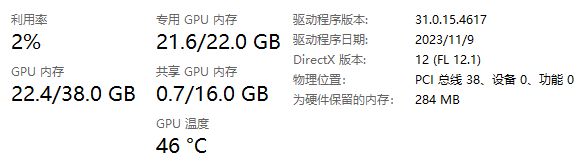

单图运算时的消耗

unet阶段

attention_probs = self.get_attention_scores

attention_probs消耗最高达640MB

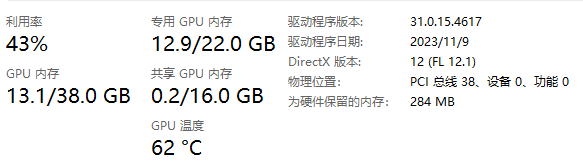

vae阶段

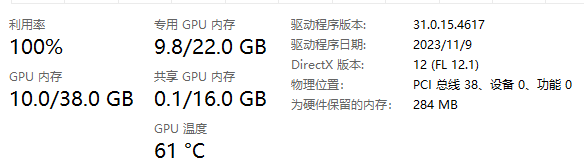

双图运算时的消耗

unet阶段

vae阶段

单图controller = AttentionStore()时的消耗

size of attention_store: 2580.46875

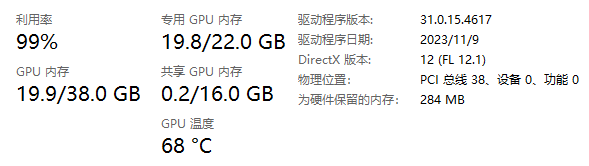

单图controller = AttentionStore()优化后的消耗

attn_copy=attn.clone().detach()

unet阶段:

生图用时:27.75s

浙公网安备 33010602011771号

浙公网安备 33010602011771号