3D人体姿态重构

1. 论文简要

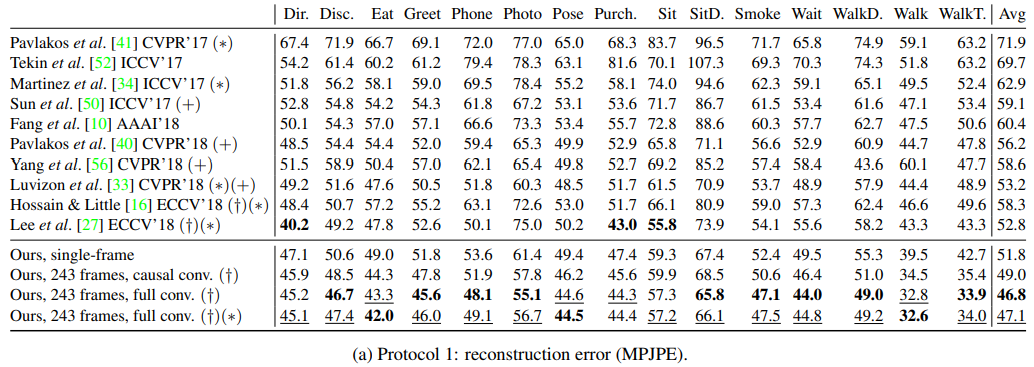

在这项工作中,视频中的3D姿态可以通过全卷积模型来估计,具体是在二维关键点上通过空洞时间卷积的模型得到3D姿态。我们还介绍了一种不带标签(反向投影)的半监督式训练方法。我们先从未标注视频中得到2D姿态,然后估计3D姿态和最后反向投影到输入的2D关键点。在实验中,全卷积模型相比之前state-of-arts,在Human3.6 M上平均每个关节位置误差小6mm,对应误差降低11%,模型在HumanEva-I中也有显著改进。

代码和模型的下载地址:https://github.com/facebookresearch/VideoPose3D

2. 背景介绍

我们的工作重点是视频中的三维人体姿态估计。我们以最先进的方法为基础,然后将问题描述为2D关键点检测三维姿态估计,这种方法可能导致不同的3D姿态对应相同的2D关键点。早期为解决这一问题主要通过RNN构建时序信息,但是由于RNN的串行结构无法多帧并行处理,因此本文提出一个完整的卷积架构,在二维关键点上执行时序卷积用于视频中准确的三维姿态预测,该方法兼容任何二维关键点检测器,并能通过空洞卷积有效地处理较大的上下文信息。与依赖RNNs的方法相比,它在计算复杂度和参数数量方面都提供了更高的精度、简单性和效率。

在构建一个高度精确和高效的架构之后,接下来需要关注训练数据,本文引入了半监督训练的方案,因为3D姿态的监督学习需要大量的带标签的训练数据,收集3D人体姿态标签需要昂贵的动作捕捉设备和长时间录制。本文的方法的灵感来自于无监督机器翻译中的循环一致性,即翻译到中间语言和翻译回原始语言的往返应该接近恒等函数。具体地说,使用现有的2D关键点检测器为未标记的视频预测2D关键点,然后预测3D姿态,最后将它们映射回2D空间中。

本文创新点有两个:(1)在网络结构方面,基于空洞时序卷积将2D关键点轨迹推理出3D人体姿态,在计算量和模型参数量上远小于基于RNN的模型;(2)在训练数据方面,采用半监督学习解决数据量不足的问题,相比于其他方法,该方法仅仅需要相机内部参数(数据增强的过程中需要相机参数对ground-truth姿态进行几何变换),不需要2D标签或带有外部摄像机参数的多视图图像。

3. 相关工作

在深度学习成功之前,大部分的三维姿态估计方法都是基于特征工程和骨骼和关节灵活性的假设。目前大多数的姿态估计方法是在二维姿态估计器的基础上,建立了一种新的三维姿态估计器,然后

被提升到3D空间中。

视频姿态估计,大多数以前的工作都是在单帧的背景下进行的,但最近几年利用视频的时间信息来产生更可靠的预测,并降低对噪音的敏感性。最近,有人提出了LSTM序列到序列学习模型,该模型将视频中的二维姿态序列编码为固定大小的向量,然后解码为三维姿态序列。然而,输入和输出序列具有相同的长度,2D姿态的确定性转换是更自然的选择。用seq2seq模型进行的实验表明,输出姿势在较长的序列上容易产生漂移。

半监督学习训练,

4. 本文方法

4.1 时序空洞卷积模型

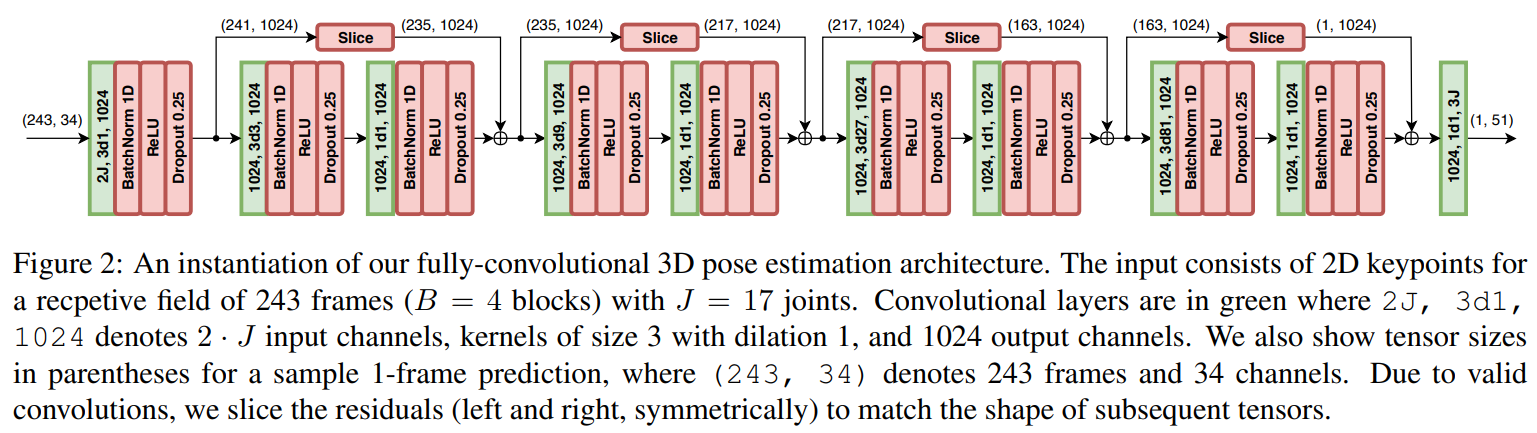

我们的模型是一个具有残差结构的完全卷积的架构,它将一个2D姿态序列作为输入,并通过时间卷积对其进行转换。卷积模型允许在批处理维度和时间维度上并行化,而RNNs不能在时间维度上并行化。在卷积模型中,无论序列长度如何,输出和输入之间的梯度路径都是固定长度的,这可以缓解影响RNN的消失和爆炸梯度。卷积架构也提供了对时间感受域的精确控制,这有利于建立三维姿态估计任务的时间依赖模型。此外,使用空洞卷积能够对长期依赖关系进行建模,同时也保持较高计算效率。(上图表示带有2D关键点的243帧图像,经过网络推理得到3D关节点)

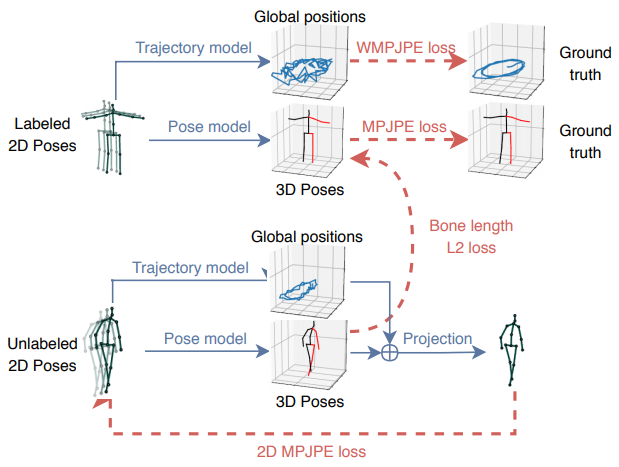

4.2 半监督训练方法

本文引入了一种半监督训练方法,以提高真实的标记数据不足的情况下的模型的准确性。我们利用未标记的视频,然后结合一个现成的2D关键点检测器,来扩展监督损失函数一个反向投影损失项。解决了未标记数据的自动编码问题:编码器(位姿估计器)根据二维关节坐标进行三维位姿估计,解码器(投影层)将三维位姿投影回二维关节坐标。当来自解码器的二维关节坐标远离原始输入时,训练就会受到惩罚。

上图将监督组件与充当正则化器的非监督组件组合在一起。这两个目标是共同优化的,标记数据占据Batch的前半部分,未标记数据占据Batch的后半部分一半。对于标记数据,我们使用真实三维姿态作为目标,训练一个监督损失。未标记的数据用于实现自动编码器损失,其中预测的3D姿态被投影回2D,然后检查与输入的一致性。

轨迹模型,由于透视投影,屏幕上的2D姿态都取决于轨迹(人体根节点整体位置,可以理解成人体中心点)和3D姿态(所有关节点相对于根关节的位置)。目标函数为每个关节的加权平均轨迹的位置误差(WMPJPE)。

骨骼长度损失,添加一个软约束来近似匹配未标记batch的受试者与已标记batch的受试者的平均骨长度。

5. 实验论证

5.1 数据集与评价标准

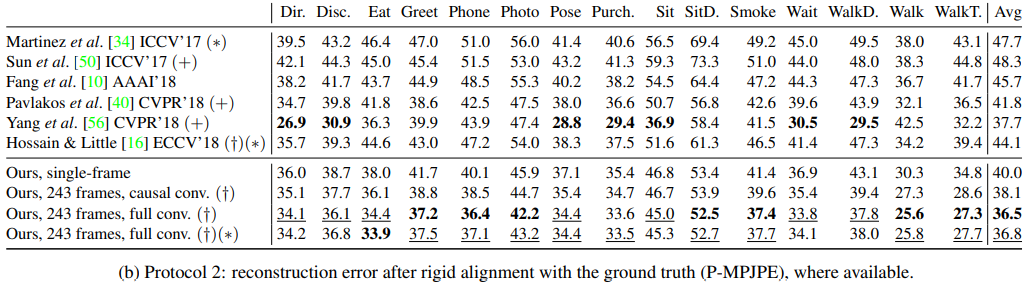

数据集有两个分别是Human3.6M,HumanEva-I,评价标准是Protocol 1: MPJPE(每个关节点的平均误差), Protocol 2:P-MPJPE(与标签数据对准后的平移、旋转、缩放误差),Protocol 3:N-MPJPE(只在比例上与真实标签相匹配)

5.2 2D姿态估计

2D姿态估计网络模型:stacked hourglass detector, Mask R-CNN with ResNet-101-FPN,CPN

5.3 3D姿态估计

6. 总结

介绍了一个简单的完全卷积模型用于视频中三维人体姿态估计。网络结构利用时间信息在2D关键点轨迹上进行空洞卷积。这项工作的第二个贡献是反向投影,这是一种半监督训练方法,在标记数据稀缺的情况下提高性能。该方法适用于未标记的视频,只需要内在的摄像机参数,使其在运动捕捉具有挑战性的场景中切实可行。

7. 论文复现

浙公网安备 33010602011771号

浙公网安备 33010602011771号