论文解读-《Uncertainty-Aware Graph Structure Learning》

1. 论文介绍

论文题目:Uncertainty-Aware Graph Structure Learning

论文领域:图神经网络,图结构学习

论文地址:https://arxiv.org/abs/2502.12618

论文代码:https://github.com/UnHans/UnGSL

论文背景:

2. 论文摘要

图神经网络(GNN)已成为从图结构化数据中学习的一种重要方法。然而,当图结构不够优时,其有效性可能会受到显著影响。为解决这一问题,图结构学习(GSL)作为一种有前景的技术出现,能够自适应地优化节点连接。尽管如此,我们指出现有 GSL 方法的两个关键局限性:1)大多数方法主要关注节点相似性以构建关系,忽视节点信息的质量。盲目连接低质量节点并汇总其模糊信息会降低其他节点的性能。2)构造图结构通常被限制为对称,这可能限制模型的灵活性和有效性。为克服这些局限,我们提出了一种不确定性感知图结构学习(UnGSL)策略。UnGSL 估计节点信息的不确定性,并利用它调整方向连接强度,从而自适应地减少高不确定性节点的影响。重要的是,UnGSL 作为一个插件模块,可以无缝集成到现有 GSL 方法中,且额外计算成本极低。在我们的实验中,我们将 UnGSL 应用于六种代表性的 GSL 方法,展示了持续的性能提升。

3. 相关介绍

3.1 当前GSL算法存在的问题

(1)当前的算法主要依靠嵌入相似度来构造图,而忽略了节点信息的质量。

聚集来自邻居节点的不清楚或不确定的信息会破坏目标节点的embedding信息。

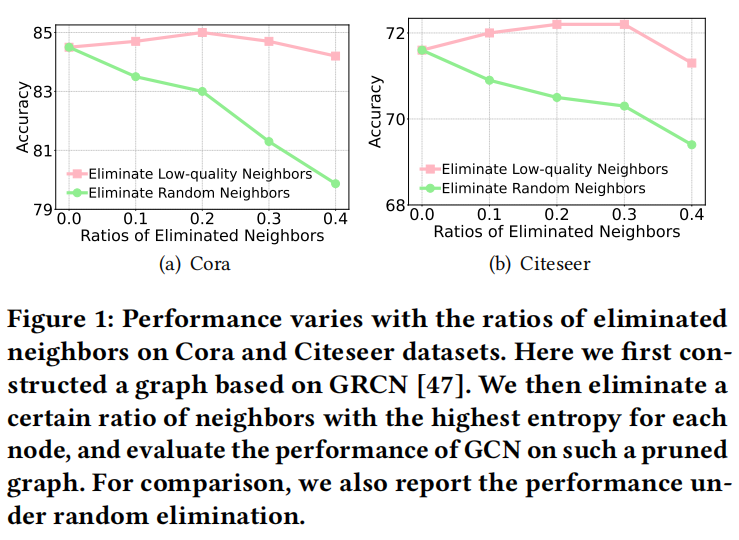

如图,随机消除节点会导致准确率的下降,消除低质量的节点邻居有效保持总体的准确率。(这里的质量低是熵最大的邻居)

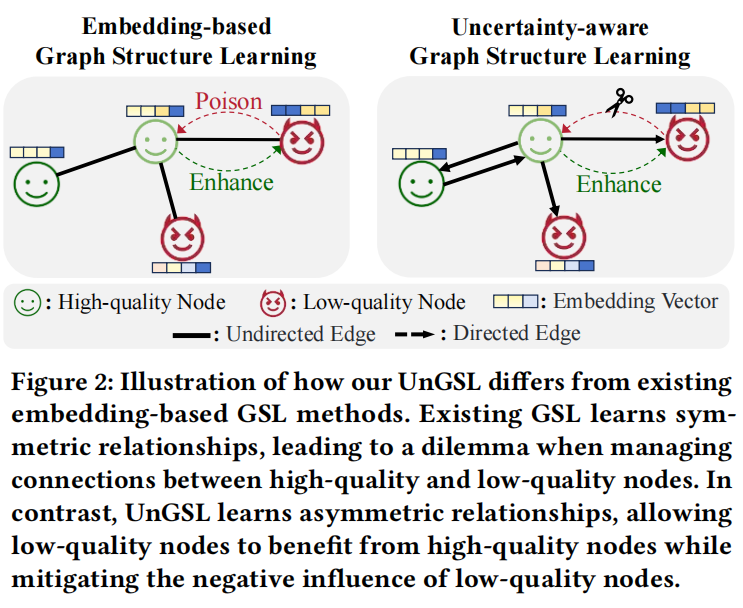

(2)基于嵌入特征的方法倾向于构造节点之间的对称关系。

意味着在GNN学习中两个节点都会产生相等的双向影响,这种对称性可以约束模型的灵活性和容量。(对于高质量节点和低质量连接的场景,则无法实现。高质量传递信息给低质量节点是有利的,但低质量节点传递信息给高质量节点是有害的)

3.2 对边的处理

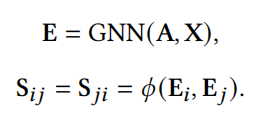

传统的GSL方法对每个边 $S_{i,j}$ 都作为一个可学习的参数,缺点是计算开销大,训练效率高。

其中E是提取到特征矩阵。

该结构模型范式的局限性:

- 依赖于嵌入特征的相似度但忽略了 节点信息的质量

- 该结构限制图倾向于对称。

3.3 熵和不确定性衡量

熵是在一个概率分布中衡量了信息的不确定度量。一个高熵的节点表示了这个节点特征包含的信息的不确定程度,使用该类节点的信息会导致分类器的污染。

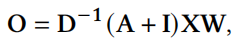

K类分类问题的分类逻辑器可以表示为

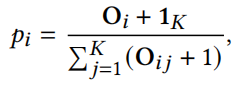

对于每一个节点 $v_i$ 来说,其概率可以表示为

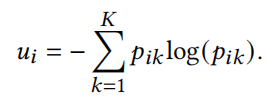

那么一个节点的熵可以表示为

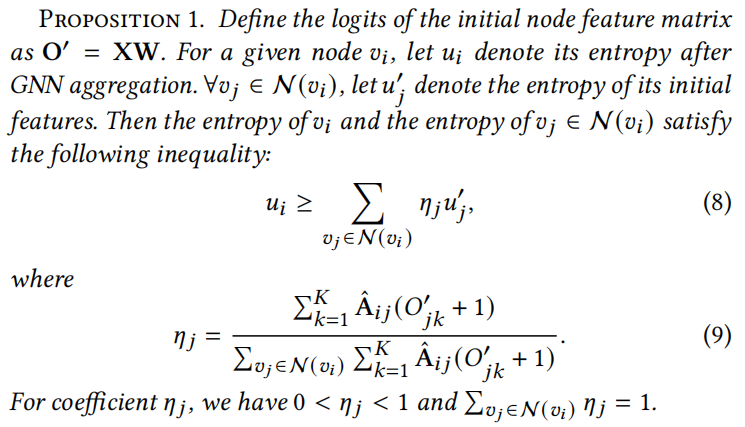

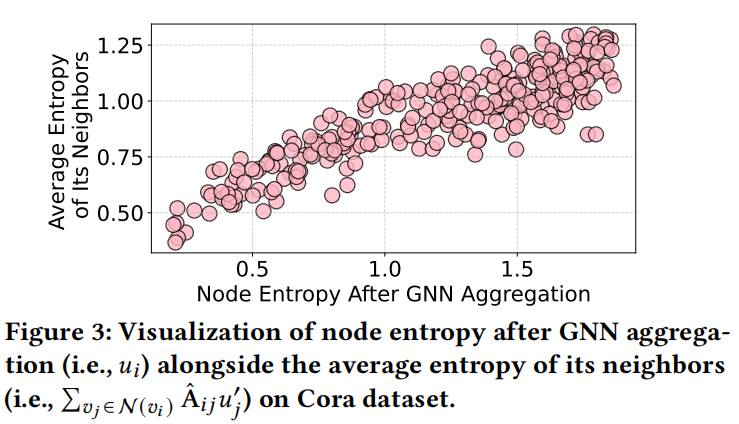

以下的定理说明了目标节点在GNN聚合后的不确定性和其邻居在聚合前的不确定性的边界关系。

使用Cora数据集的实验证明了这一个现象

说明了,对高不确定性的节点信息进行聚合,会拉高目标节点的不确定性下限。移除这些高不确定性的节点的影响,可以显著降低目标节点的不确定性,从而提高性能。

4. 核心算法

UnGSL,直接使用节点的不确定性来表示该节点的信息的质量。(算法用香农熵来表示)

基于不确定性,UnGSL利用可学习的节点的阈值来区分低质量和高质量的邻居,并自适应地减少这些低质量邻居的方向边权重。

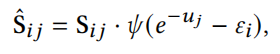

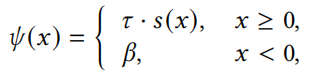

目前的GSL方法的邻接矩阵的产生可以定义为

其中 u_j 是节点vj的熵,ei是可学习的节点级别的阈值,Y是激活函数,S是由GSL产生的邻接矩阵。

节点不确定性归一化为区间[0,1] 的范围。利用可学习的阈值来区分低置信度和高置信度,使用以下激活函数来自适应的细化相应的边缘。

算法通用性:因为UnGSL是替换掉高不确定性的节点信息,整个算法可以无缝切换到任意的GSL框架中。

UnGSL算法更适用于在非对称图上的学习,源自其针对不同节点有着不同确定性的衡量。

5. 实验设置

数据集

七个数据集,4个同质引用数据集(Cora, Citeseer, Pubmed and Ogbn-arxiv),3个异质数据集(Blogcatalog, Roman-Empire and Flickr )

基线模型

选择6个SOTE算法,监督模型(GRCN,PROGNN,IDGL,PROSE,SLAPS)和自监督模型(SUBLIME)

GRCN: 使用GCN提取拓扑特征并计算节点之间的相似度作为学习图的边权重

ProGNN:将图视为可学习的邻接矩阵,并优化图结构的稀疏性、低秩和特征平滑度。

PROSE:使用PageRank scores 识别有影响的节点,并通过连接这些影响节点重建图结构。

IDGL:迭代学习图结构和节点嵌入,并引入节点锚消息传递范例将IDGL扩展为大型图。

SLAPS:提出学习去噪自动编码器来过滤图结构中的噪声边。

CUR:是一个模型不可知的结构学习模块,提出通过CUR分解构造从未标记节点到标记节点的单向边,以便于监督信号向未标记节点的传播。

SUBLIME:是一种无监督GSL模型,它在学习图和扩充图之间使用对比学习来增强图结构的鲁棒性。

给出五个问题,并一一进行回答。

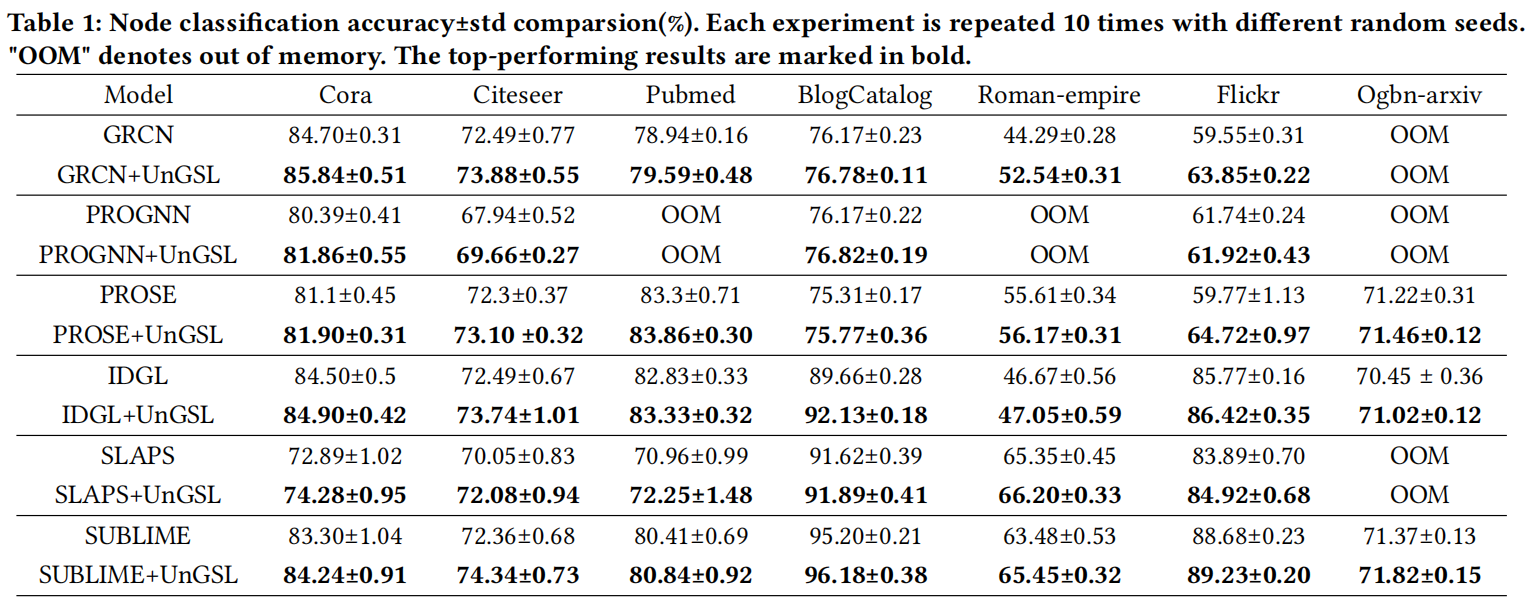

(1)UnGSL整合进入已经存在的GSL方法,可以显著提高表现效果吗

相比已经存在GSL算法,UnGSL可以显著提高表现效果

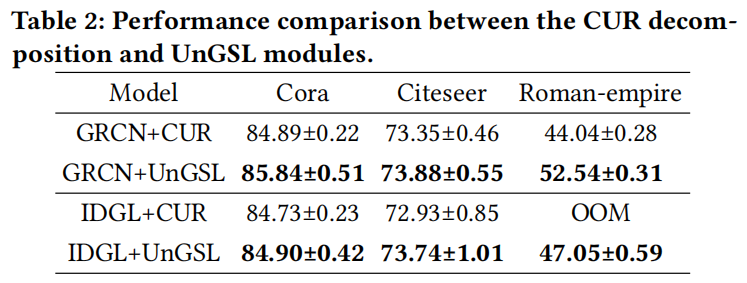

在标签的GSL算法的比较中,UnGSL和CUR的比较

(2)UnGSL的关键配置是什么? 就是超参数配置的讨论

(3)UnGSL可以在结构噪声、特征噪声和标签噪声中增强GNN的鲁棒性表现吗?

(4)UnGSL可以在不同的GNN下通用吗

(5)UnGSL会带来额外的大型计算消耗吗

UnGSL仅包含𝑛 可学习的参数,并在不生成新边的情况下细化给定图的现有边。UnGSL引入的附加操作的复杂性为𝑂(𝑛 + 𝑚),其中𝑛 和 𝑚 表示图中节点和边的数量。

6. 总结

以节点和节点之间的学习得到的阈值来区分节点的不确定度量,以此来重构邻接矩阵以改善图结构学习。

7. 个人感悟

核心点是两个节点的相互影响,本文使用的是可学习得到的熵,那替换为其他类似的指标如互信息,如节点相似度等,不知道能否有GSL上的新意。

浙公网安备 33010602011771号

浙公网安备 33010602011771号