论文解读-《Hierarchical Graph Pooling with Structure Learning》

1. 论文介绍

论文题目:Hierarchical Graph Pooling with Structure Learning

论文领域:图神经网络,图结构学习

论文发表:AAAI 2020(疑似退稿)

论文地址:https://arxiv.org/abs/1911.05954

论文代码:https://github.com/cszhangzhen/HGP-SL

论文背景:

2. 论文摘要

图神经网络(GNN)将深度神经网络推广到图结构数据,引起了相当大的关注,并在众多图相关任务中取得了最先进的性能。然而,现有的 GNN 模型主要集中在设计图卷积作上。图池化(或下采样)作在学习分层表示中起着重要作用,但通常被忽视。在本文中,我们提出了一种新颖的图池化算子,称为结构学习的层次图池化(HGP-SL),它可以集成到各种图神经网络架构中。HGP-SL 将图池化和结构学习整合到一个统一的模块中,以生成图的分层表示。更具体地说,图池化作自适应地选择节点子集,为后续层形成诱导子图。为了保持图拓扑信息的完整性,我们进一步引入了一种结构学习机制,为每层的池化图学习精细化的图结构。通过将 HGP-SL 算子与图神经网络相结合,我们以图分类任务为重点,进行图级表示学习。在六个广泛使用的基准测试上的实验结果证明了我们所提出的模型的有效性。

3. 相关介绍

3.1 本文贡献

1,提出了一种新的图结构池化算子 HGP-SL,一个独立模块,可以集成到各种GNN架构中,非参数的,没有超参数需要调节。

2,HGP-SL为首个为池化图设计结构学习机制的,优点是学习精细的图结构以保留图的关键子结构

3,在数据集上进行广泛实验证明了算法的有效性

3.2 图池化操作

GNN 中的池化作可以缩小输入的大小并扩大感受野,从而产生更好的泛化和性能。

常见的池化算法有DiffPool,gPool,SAGPool,EdgePool和iPool算法。

全局池化操作,有Set2Set,DGCNN和Graclus算法

4. 核心算法HGP-SL

HGP-SL主要有两个组件:

1,图池化:保留信息节点的子集并形成一个较小的诱导子图;

2,结构学习:为池化子图学习一个细化的图结构

提出的结构学习的优势在于它能够保留基本的图结构信息,这将促进消息传递过程。

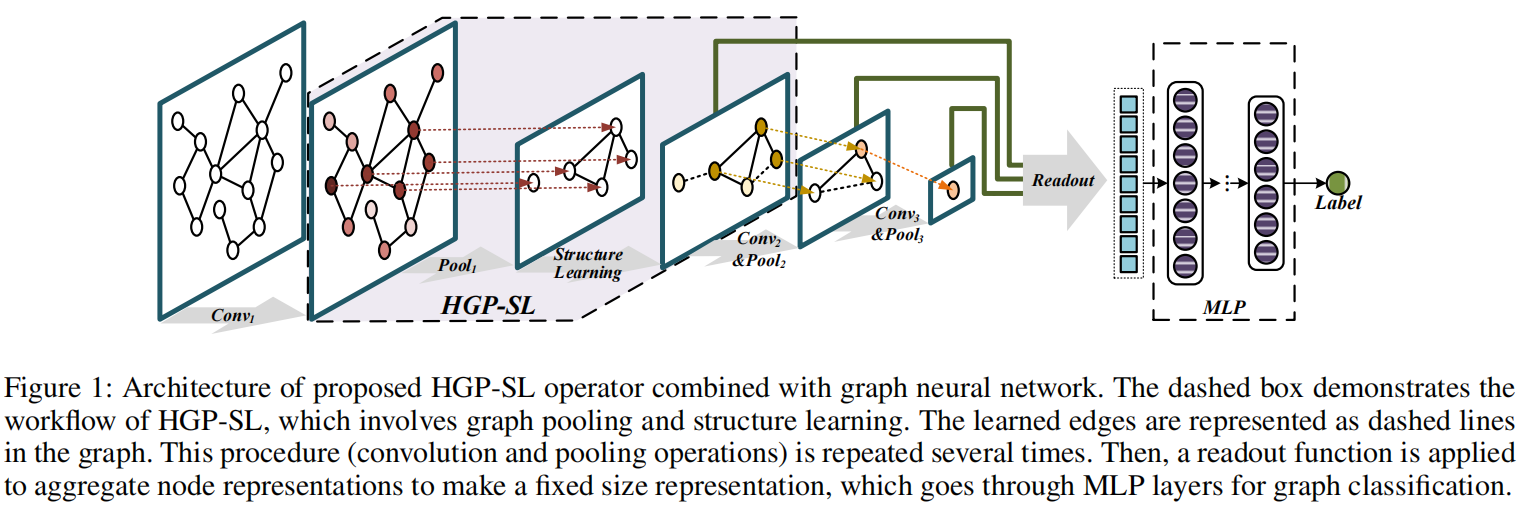

整个架构是卷积和池化作的堆叠,从而使得以分层方式学习图表示成为可能。然后,利用读出函数来汇总每个级别的节点表示,最终的图级表示是不同级别的汇总的相加。

HGP-SL算法的架构图:

4.1 图池化

为了设计了一个非参数池化作,它可以充分利用节点特征和图结构信息。

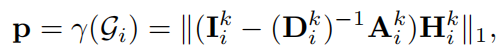

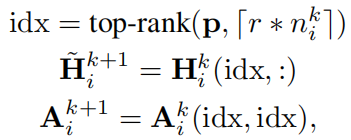

图池化的关键是定义一个指导节点选择过程的标准。为了执行节点采样,首先引入一个名为节点信息分数的标准来评估每个节点在给定其邻域的情况下包含的信息。对图的每个节点的信息分数的编码为P向量。

节点信息得分相对较大的节点将在池化图的构建中保留,因为它们可以提供更多信息。

4.2 结构学习机制

存在的问题:

池化作可能导致诱导子图中高度相关的节点断开连接,从而失去图结构信息的完整性,并进一步阻碍消息传递过程。

已有的方案有:

(1)使用近似距离度量学习算法自适应估计图拉普拉斯,这可能会产生局部最优解。

(2)引入是为了学习节点标签估计的构造图结构,但它生成密集的连通图,不适用于我们的分层图级表示学习场景。

本文的一个新的结构学习层,通过稀疏注意力机制来学习稀疏图结构。

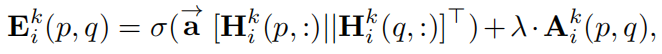

$\vec{a}$ 是一个由权重向量参数化的单层神经网络。 λ 是权衡参数

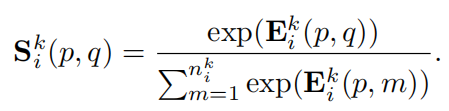

为了让相似性分数在不同节点之间易于比较,可以使用softmax函数在节点之间进行归一化处理。

但,softmax 变换始终具有非零值,因此会导致密集的全连通图,这可能会在学习的结构中引入大量噪声。

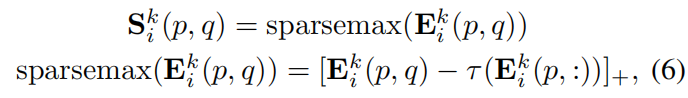

最终使用sparsemax 函数。它保留了 softmax 函数的大多数重要属性,并且还具有产生稀疏分布的能力。该 sparsemax函数旨在将输入的欧几里得投影返回到概率单纯形上。

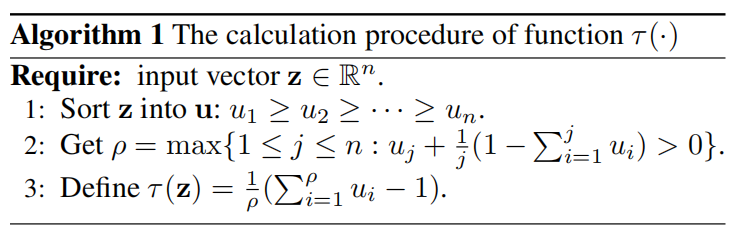

其中上面的 $\tau$ 计算方式为

4.3 GCN的图池化的融合

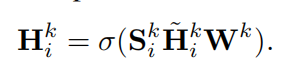

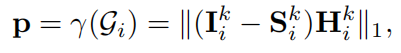

得到细化后的图结构S后,可以基于H和S进行图卷积和池化操作的简化为:

相应的节点的信息得分可以写为

5. 实验设置

5.1 基线实验

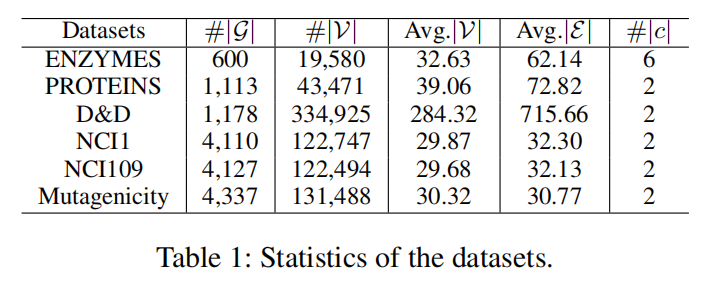

使用6个公共基准的数据集

对比的基线算法

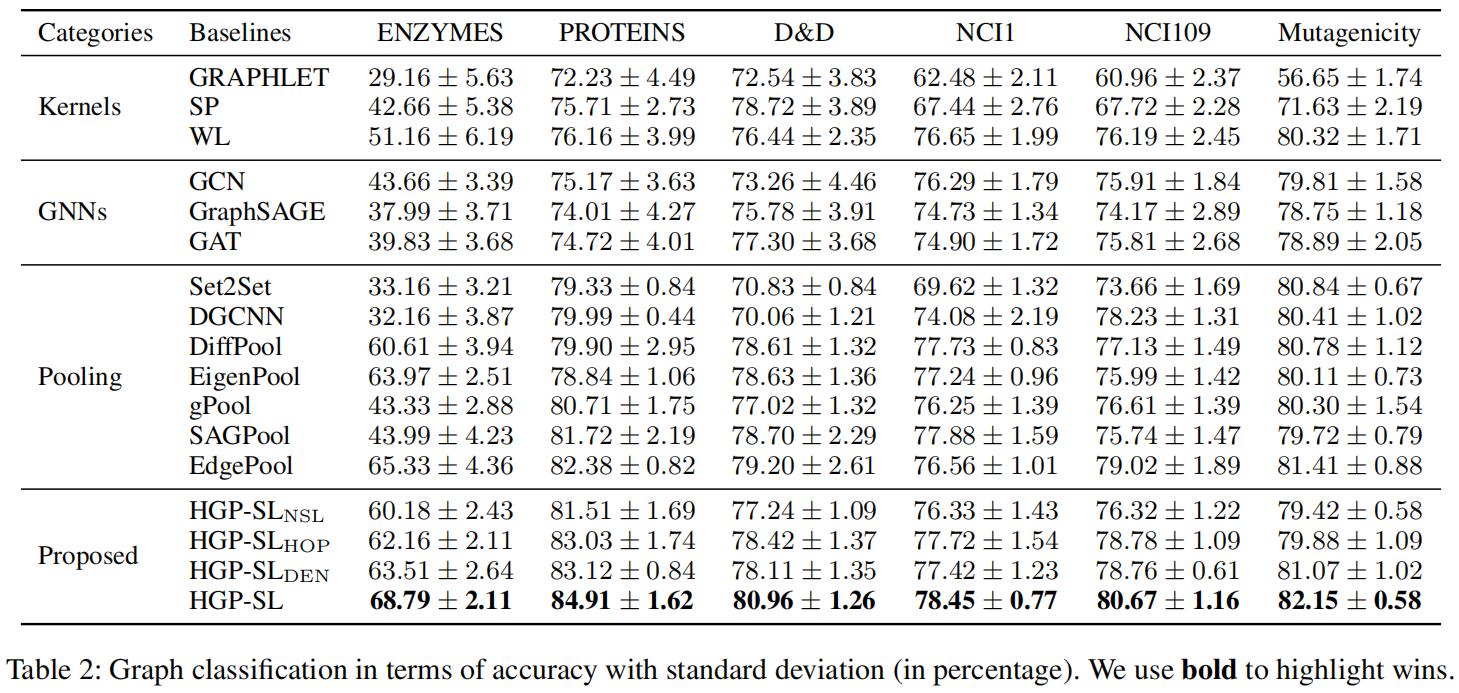

执行图分类的核算法有GRAPHLET,SP(最短路径内核算法),WL三种经典的算法。

GNN架构有:GCN,GraphSAGE,GAT。

与GNN结合的池化操作的算法有:Set2Set,DGCNN,DiffPool,EigenPool,gPool,SAGPool,EdgePool。

同时HGP-SL算法内部还有四种变体,也可以理解为传统意义上的消融实验的对比。

$SL_{NSL}$ 丢弃了结构学习层来验证我们提出的结构学习模块的有效性;

$SL_{HOP}$ 删除了结构学习层并连接了其 h 跃点内的节点;

$SL_{DEN}$ 使用结构学习层学习具有softmax 函数的密集图结构;

5.2 消融实验

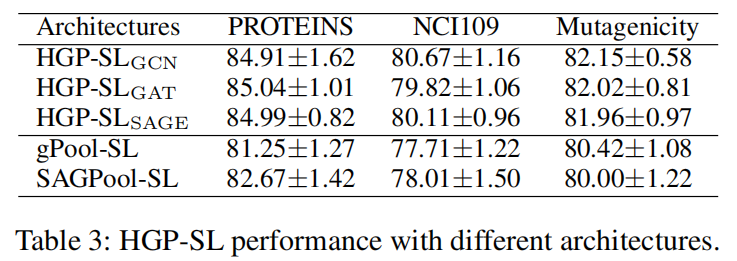

观察到 gPool-SL 和 SAGPool-SL 通过结合结构学习机制优于 gPool 和 SAGPool,这验证了我们提出的结构学习的有效性。

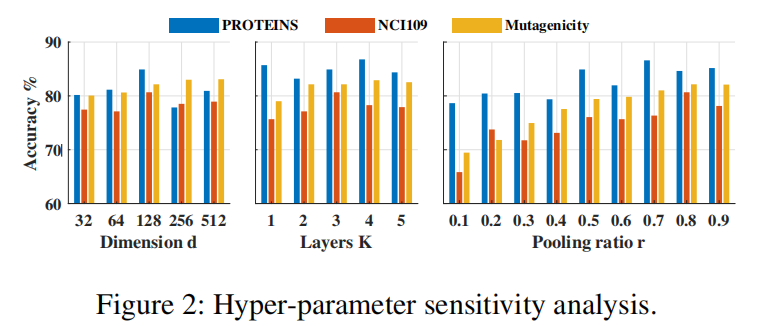

HGP-SL 在分别设置 K=3 和 d=128 r=0.8 时几乎在不同数据集中取得了最佳性能。

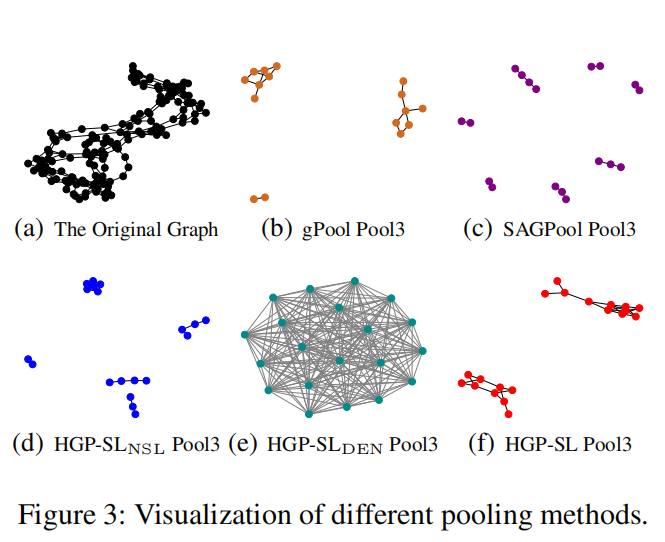

5.3 可视化

HGP-SL 在池化后能够保留原始蛋白质图的相对合理的拓扑结构

6. 总结

在池化作上堆叠一个结构学习层,旨在学习一个能够最好地保留基本拓扑信息的精细图结构。本文的核心亮点。

7. 个人感悟

显而易见的图池化的缺点是池化后对原始拓扑结构的破坏,如何把原始拓扑结构的核心保留下来。这里给出的是结构化学习,面对最终的学习效果。还有没其他手段如社区结构,谱间隙值等。

浙公网安备 33010602011771号

浙公网安备 33010602011771号