论文解读-《Expander Graph Propagation》

1. 论文介绍

论文题目:Expander Graph Propagation

论文领域:图神经网络

论文发表:Best Paper Award at the NeurIPS 2022

论文背景:

2. 论文摘要

在整个图分类或回归任务中部署图神经网络(GNNs)是一个具有挑战性的问题:它通常需要计算节点特征,同时考虑其邻域中的局部交互和图结构的全局上下文。导航此空间的GNN架构需要避免病态行为,例如瓶颈和过压缩,同时理想情况下具有线性时间和空间复杂性要求。在这项工作中,我们提出了一个优雅的方法基于传播信息的扩张图。我们利用一种有效的方法来构造给定大小的扩展图,并利用这种方法提出了EGP模型。我们证明了EGP能够解决上述所有问题,同时只需要很少的设置工作,并在开放图基准中的相关图分类数据集和基线上提供了经验效用的证据。重要的是,使用扩展图作为消息传递的模板必然会产生负曲率。虽然这似乎是违反直觉的,鉴于最近的相关工作对过拟,我们从理论上证明,负曲线边缘可能需要获得可扩展的消息传递没有瓶颈。据我们所知,这是以前在图表示学习环境中未研究过的结果,我们相信我们的分析为一类新的可扩展方法铺平了道路,以对抗GNN中的过拟合。

3. 相关介绍

3.1 背景介绍

当前很多的图分类任务可能最迫切需要突破当前局限,要为图结构赋予标签,仅仅将图视为”节点集合“是远远不够的。新的GNN的设计需要兼顾图全局特征的方式来更新节点特征,仅仅通过堆叠更多消息传递层是不够的。

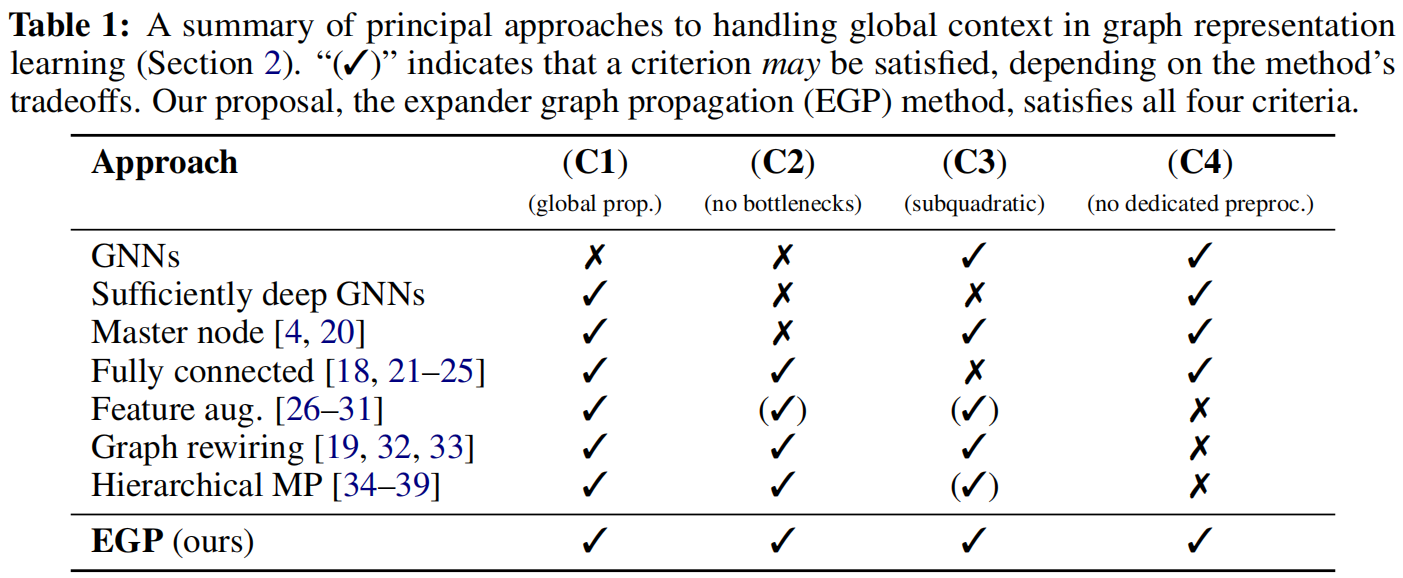

3.2 新的标准

在GNN研究范畴内,提出一种满足四项理想标准的方法:

(C1)能够实现图中信息的全局传播;

(C2)具备抗过度压缩效应的能力且不引入瓶颈;

(C3)其时间与空间复杂度保持次二次方(对于稀疏图而言,严格优于O(|V|²));

(C4)无需对输入数据进行专门预处理。

根据这项标准,在图特征学习相关的方法上的比较

3.3 多层网络叠加

实现全局信息传播的一种途径是构建更深的图神经网络。这种方法能够满足条件(C1)和(C4)——无需专门的预处理步骤。然而根据图的直径特性,我们可能需要多达O(|V|)层网络才能覆盖整个图结构,这不仅会导致二次方复杂度(违反条件(C3)),还会引入对瓶颈效应的敏感性(条件(C2))

3.4 引入主节点

引入全局语境的一个吸引人方法是在图中添加主节点,并将其与图中所有节点相连。这种操作既可通过显式方式实现,也能通过存储"全局"向量的隐式方法完成。该方案直接将图直径缩减至2,仅需新增O(1)数量级的节点和O(|V|)数量级的边,且无需专门预处理,因此满足条件(C1、C3、C4)。然而这些优势的代价是主节点成为瓶颈:它面临着持续整合超大邻域信息并保持有效性的艰巨任务(当图规模扩大时尤为困难),因此无法满足条件(C2)。

3.5 图全连接层

相反的解决方案是将每个节点都设为主节点:这种情况下,我们让所有节点对通过边连接——这一最初由提出的强力方法能有效缓解过度挤压问题。该策略在图变换器近期爆发式发展中广受欢迎,并普遍应用于物理模拟或推理任务的图神经网络中。图的直径被缩减至1,不再存在瓶颈,且该方法无需任何专门预处理。因此条件(C1、C2、C4)被轻松满足。但该方法主要缺陷在于引入了O(|V|²)量级的边数,这意味着条件(C3)永远无法满足——即便对于中等规模的图,这种方法也会因计算量过大而难以实施。

3.6 特征增广

另一种方法是为图神经网络提供额外的特征,这些特征能直接识别每个节点在图中所扮演的结构性角色。若处理得当(即所计算的特征与目标相关),这种方法可显著提升表达能力。因此理论上,在满足条件(C1)的同时不违反条件(C2, C3)是可行的。然而,要计算合适的特征,要么需要特定领域的知识,要么需要进行适当的预训练以获得此类嵌入表示。因此所有这些优势都以无法满足条件(C4)为代价。

3.7 图重连技术

另一项前景广阔的研究方向涉及通过修改原始图的边结构来缓解瓶颈效应。该方法的典型应用包括:使用扩散技术——通过个性化PageRank等核函数扩散额外边;以及随机离散里奇流——通过精准修改少量边来缓解具有负里奇曲率节点上的过度挤压效应。近期并行研究还采用扩展图启发的构造方法,对输入图进行随机局部重布线。若实施得当,这类方法既能保证与原始图的偏离可控,又可被证明能缓解过度挤压现象,从而可能满足条件(C1、C2、C3)。但代价是需要检测输入图结构,且这些方法的计算复杂度未必随节点数量线性增长,因此需要专门预处理,无法满足条件(C4)。

3.8 分层消息传递。

还可以在图中引入额外的节点——每个节点负责图1中的特定子结构。若处理得当,这种方法能在不引入瓶颈节点的情况下(从而满足条件C1、C2)显著缩短图的直径。然而在现有研究中,这通常需要付出预处理成本的代价。此前提出的可扩展分层图神经网络方案都需要专门的预处理步骤,有时还需结合领域知识——因此无法满足条件C4。此外,该类方法需要添加数量庞大的子结构或进行昂贵的预计算(例如计算图拉普拉斯特征向量),这可能导致连(C3)条件都难以满足。

3.9 改进和应用

已有方法,ExpanderGNN通过在神经网络权重上应用扩展图来稀疏化GNN的更新步骤,这直接沿用了深度扩展网络的技术方案——后者曾在卷积神经网络(CNN)中研究过此类结构。就我们的创新贡献而言,这些研究既未讨论GNN计算图中扩展图的应用场景,也未尝试在此类结构上进行信息传播。更重要的是,它们均未能满足我们提出的全部四项核心标准(C1-C4)。

一个关键贡献在于通过曲率分析拓展了现有技术关于过压缩现象的启示。根据之前的研究,负曲率边是导致过压缩效应的根源——然而反直觉的是,我们所构建的扩展图边始终呈现负曲率特性!但我们证明,这些扩展图的负曲率程度永远不足以触发之前研究的结论适用的必要条件,并表明负曲率边的存在实际上可能是实现无瓶颈稀疏通信的必要条件。

4. 理论基础

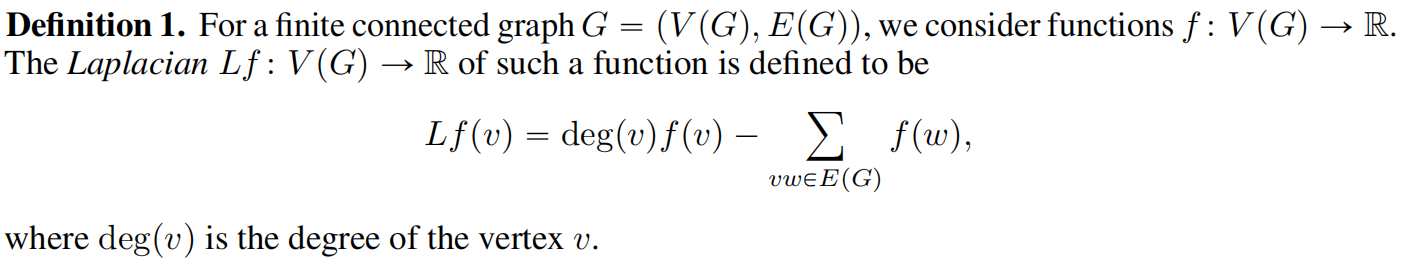

首先定义映射L和拉普拉斯矩阵

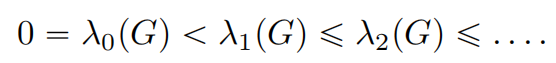

可以知道L是对称且半正定,其特征值都是非负的

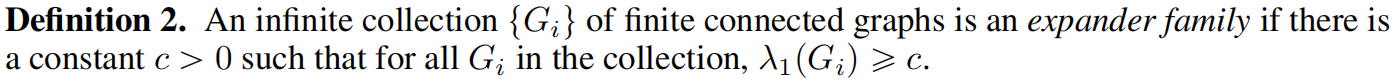

最小特征值为0,其对应的特征空间由常数函数构成(假设图G是连通的)。而最小的正特征值λ1(G)对于扩展图的定义至关重要,如下一定义所示。

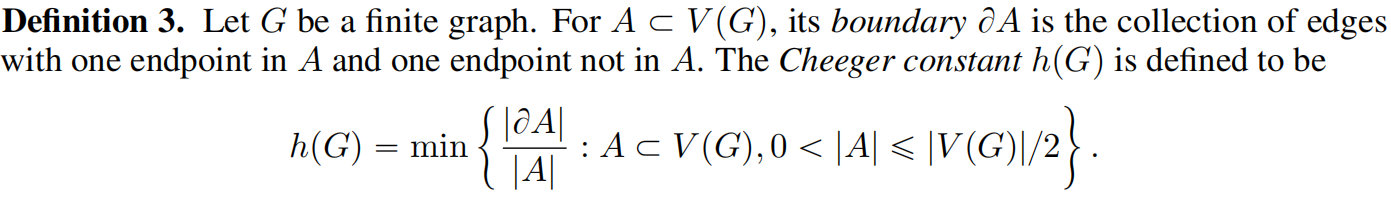

定义Cheeger常量

如果出现一个小的Cheeger常量那意味着图有一个瓶颈。在这个意义上,存在一组边,当这些边被移除时,会将顶点分割成两个集合(A及其补集,$V(G)\big/A$),其特性是A及其补集的大小显著大于该组边的大小。

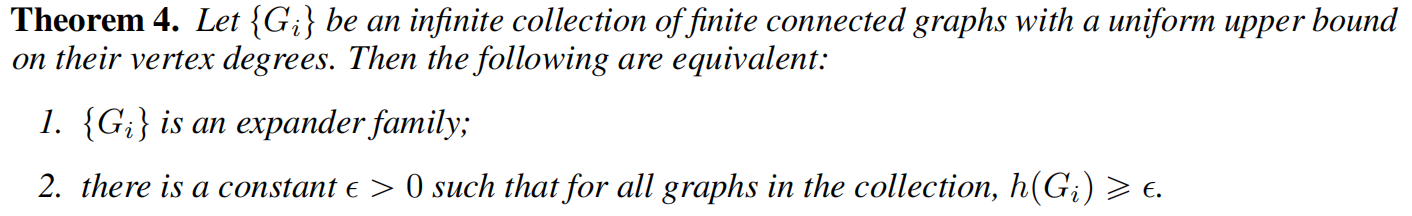

扩展器族可以被Cheeger常量重新解释。

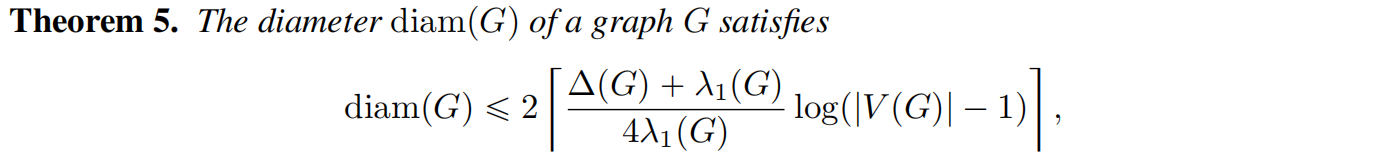

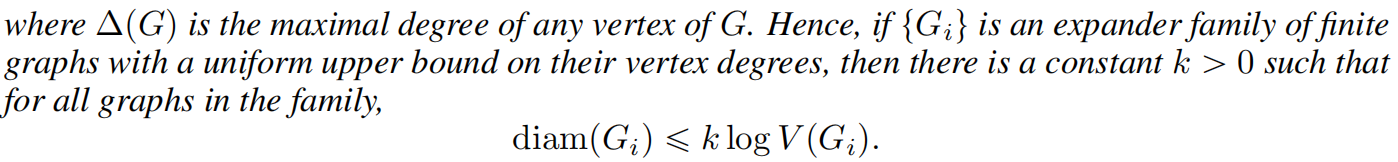

因此,扩展图的切格常数更高,从而由瓶颈边引发的问题严重程度较低。下述结论是扩展图族众多实用特性之一,涉及它们的直径特性。

图的直径属性有

从上面的不等式可以看出,如果需要在有|V|个节点的扩展图上传递消息,只需要O(log|V|)的时间复杂度。

研究表明,扩展器网络因瓶颈边引发的问题严重程度较低,具有优越的传播特性。那目前需要一种有效快速的手段来建立有|V|个节点的扩展图,为了实现这个方法,从群论中找答案。

因此,群自然成为研究使对象保持不变的变换的推理工具。此外,我们定义了群生成集的相关概念:

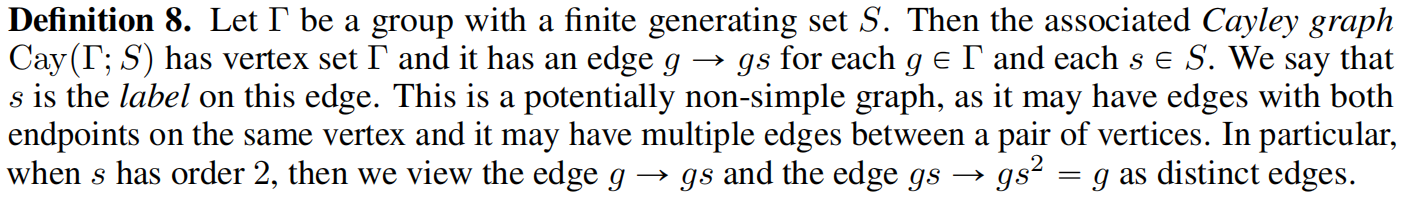

现在可以一个群生成集的Cayley图定义为

每一个Cayley图$Cay(\tau; S)$的每个节点的度为2|S|,因为每一个节点g都被gs 和 gs-1的边进行连接,边属于S。

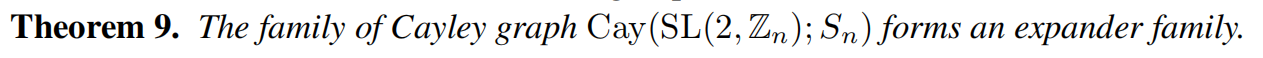

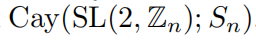

双曲曲面的拉普拉斯算子的最小正特征值至少为3/16。这一结果可用于推导凯莱图Cay(SL(2,Z); Sⁿ)上拉普拉斯算子第一特征值的下界。

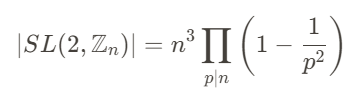

所以,Cayley图的节点数量为

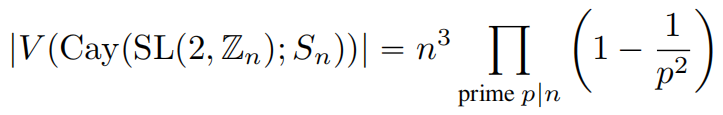

对于图G的一条边e,令N2(e)表示由距离e至少一个端点最多两跳的顶点构成的诱导子图。那么边e的曲率仅取决于N2(e)的同构类型。

我们认为,用于图神经网络的图最好具有较高的Cheeger常数(即在全局意义上不存在瓶颈)。同时,限定顶点度数也很有必要,因为这能保证图的稀疏性,且随着图规模扩大,节点在进行消息传递时无需处理不断增长的邻域范围。

5. EGP算法

本文基于扩展器图来作为研究对象,因为扩展器图的结构有本质稀疏性(边数|E|与顶点数|V|呈线性关系),保持较低的直径(意味着两两节点间跳数少);提出了本文核心算法,扩展器图传播(EGP),一种高效构建扩展图族的方法(利用特殊线性群SLp2在Znq上的已知理论成果)。一旦构建出合适规模的扩展图,我们就能在其结构上执行一定次数的图神经网络传播步骤,实现节点特征的全局分布。

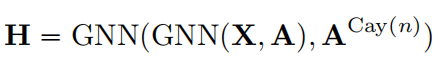

让A^{Cay(n)} 是一个邻接矩阵,由Cayley图生成得到

所以有

整个算法是一个迭代算法,在输入图的每一层之后立即应用扩展图。我们发现,若矩阵A提供的输入图存在瓶颈,仅在末端对 $A^{Cay(n)}$应用图神经网络,可能导致在扩展图传播发生前就出现过度挤压现象。

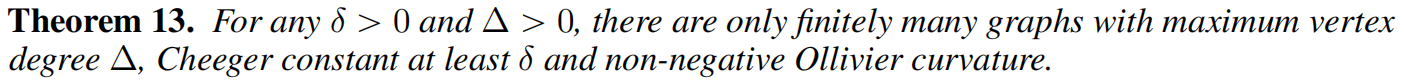

在实验中,采用BFS的方式来构建Cayley图,与全连接图类似,主要是把Cayley图当作是全局信息传播的模板,旨在通过可扩展的方式来缓解瓶颈问题。

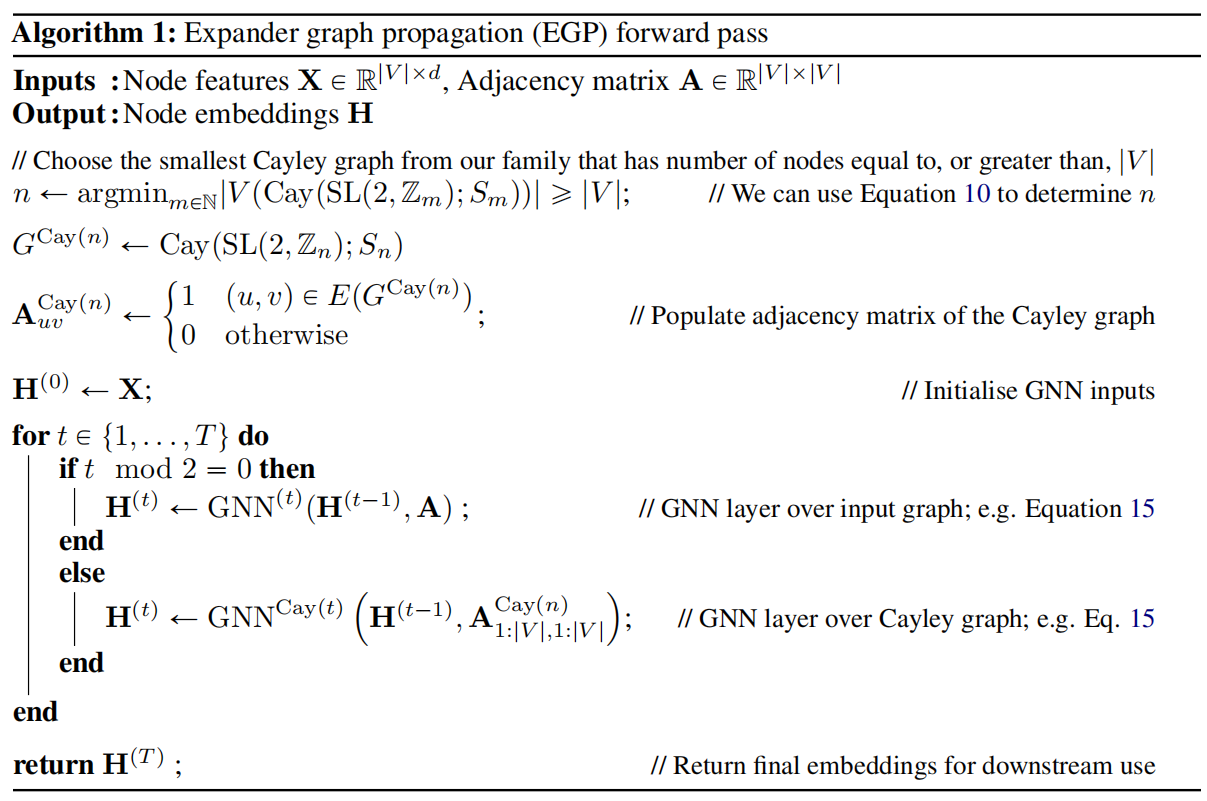

EGP算法的伪代码

算法1总结了我们提出的EGP模型的步骤。作为我们已证明或展示结果的直接推论,我们注意到EGP满足所有四项理想标准:(C1)由定理5保证(只要应用对数级数量的层),(C2)由定理4保证(高Cheeger常数意味着无瓶颈),(C3)基于我们的Cayley图是4-正则的因而具有稀疏性,(C4)则体现在无需详细分析输入即可生成合适尺寸的Cayley图——我们可以预先计算不同尺寸的Cayley图"库"以便临时调用。

扩展器图的解决方案

该方案利用了群论和谱图论的数学概念,其核心思想是在精心构建的扩展器图上的额外传播步骤来增强标准GNN的消息传递。

扩展器图是稀疏图,但保持着出色的连通性。尽管边相对较少,它们能确保信息在图中任意两个节点之间高效流动。论文采用了特殊的线性群SL(2, Zn)的Cayley图,

Cay(SL(2, Zn); Sn)

其中Sn是一个固定的生成集,这些图具有以下的特性

- 4-正则,每个节点恰好有4个邻居节点,确保稀疏性

- 低直径,任意两个节点之间的距离仅仅随着图大小呈对数增长

- 高扩展性,不存在对造成瓶颈的小割

局部与全局传播的交错

扩展器图传播(EGP)算法通过交替两种类型的消息传递步骤来操作

- 1,偶数步骤:标准GNN层在原始输入图结构上操作

- 2,奇数步骤:GNN层在构建的Cayley扩展器图上操作

对于一个包含了|V|个节点的输入图,算法首先确定最小整数n,使得相应的Cayley图至少有|V|个节点,然后利用群结构构建此Cayley图的邻接矩阵

![EGP20]()

这种交错方法确保节点从输入图中学习局部模式,同时通过扩展器图的高效连接接收全局上下文信息。

6. 实验设置

6.1 Tree-NeighborsMatch

Tree-NeighborsMatch(树邻匹配)是一项专门用于测试图神经网络抵抗过度挤压能力的合成基准测试,因此它能让我们通过实验验证EGP确实可以缓解过度挤压现象。在GIN实现方案中加入了EGP层结构,发现该改进方案能以100%准确率完成深度=5的任务测试,证明其有效缓解了过度挤压问题。作为对比,基准版GIN在相同任务中仅能达到29%准确率,而未采用EGP的最佳性能图神经网络(即仅对输入树结构进行传播的方案)最高准确率也无法突破60%。

6.2 OGB数据集

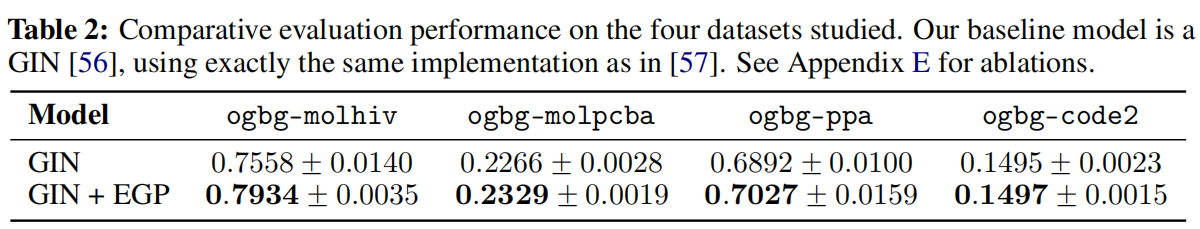

在所有图分类数据集上提供结果:ogbg-molhiv、ogbg-molpcba、ogbg-ppa以及ogbg-code2。前两者是MoleculeNet基准测试中规模最大的分子属性预测数据集。第三个数据集涉及根据输入的蛋白质-蛋白质关联网络将物种分类至其分类单元。第四个数据集为代码摘要任务:要求在给定Python方法实现代码的抽象语法树(AST)前提下,预测该方法名称中的标记符。

6.3 模型选择

在这四个数据集中,我们想要直接评估引入EGP层带来的实证收益,并完全排除参数量或类似架构决策所产生的任何影响。所以基线模型选择GIN。

从数据结果可以观察到,在所有四种情况下,通过Cayley图传播信息都带来了平均性能的提升——这些提升在ogbg-molhiv数据集上最为明显,但在ogbg-molpcba和ogbg-ppa数据集中也有所体现。我们认为这些结果为以下观点提供了令人鼓舞的实证依据:通过Cayley图传播信息是缓解瓶颈效应的巧妙思路。

7. 总结和个人感悟

图神经网络的较大难点是全局和局部,全局需要考虑稀疏性,局部需要克服瓶颈,通过生成基于扩展器图的Cayley来作为新的传播图,在逐层使用原始矩阵和Cayley矩阵来交替使用,同时关注局部性和全局性。

挺好的谱域的论文,值得一读。

浙公网安备 33010602011771号

浙公网安备 33010602011771号