论文解读-《Order Learning and Its Application to Age Estimation》

1. 论文介绍

论文题目:Order Learning and Its Application to Age Estimation

论文代码:https://github.com/changsukim-ku/order-learning

论文发布: ICLR 2020

论文官方: https://iclr.cc/virtual_2020/poster_HygsuaNFwr.html

2. 论文摘要

我们提出了顺序学习来确定类的顺序图,表示等级或优先级,并将对象实例分类为其中一个类。为此,我们设计了一个成对比较器,将两个实例之间的关系分为三种情况之一:一个实例 '大于'、'相似' 或 '小于' 另一个实例。然后,通过将输入实例与参考实例进行比较并最大限度地提高比较结果之间的一致性,可以可靠地估计输入的类。我们应用顺序学习来开发面部年龄估计器,它提供最先进的性能。此外,当使用性别和种族群体信息将顺序图划分为不相交的链时,甚至以无监督的方式划分时,性能会进一步提高。

3. 相关工作

成对比较:通常,直接评估确定的质量是很难的,但是两两之间的粗略比较是非常容易得到的。

序数回归:直接评估x在其类中的排序。

评估学习:度量学习是找到X是与另一个样本Y是相似还是不相似,而次序学习是找到X和Y之间的比较问题。

年龄估计:目前的方法多用的是回归的方式

4. 次序学习

次序学习order learning,是决定类的图顺序,代表着该类的优先级和排序。

次序学习是学习排序,如学习一个检索中在两个文档之间哪个更为相关。次序学习也跟评估学习有关,评估学习研究的是一个对象与另外一个对象是相似还是不相似。

对于一个集合

$$ \Theta = { \theta_1, \theta_2, ..., \theta_n } $$

次序学习会符合下面三个特性:自反律,反对称率,传递律

如果一个集合内所有元素都可以两两比较,那么这个是线性有序集合。

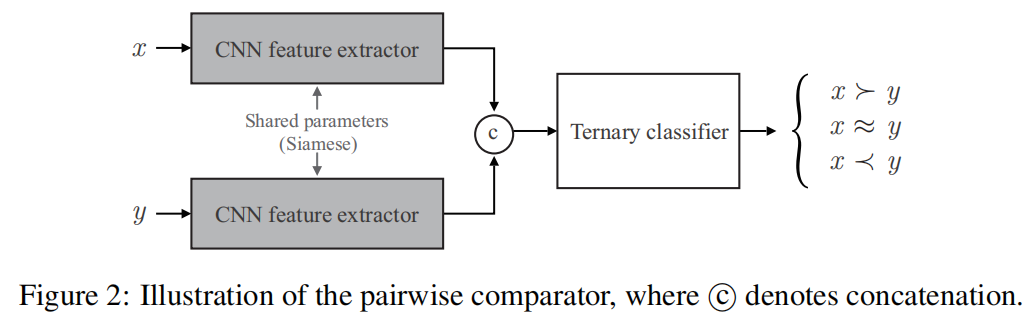

本文设计了一个对比较器,将两个实例之间的关系分为三个情况,大于,类似和小于。通过比较输入实例和引用实例,并最大化比较结果之间的一致性,可以可靠地估计输入的类别。

下图是将一个连接网络和一个三类分类器组成,共同组成来完成训练。

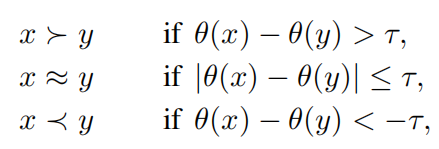

对于样本X和Y,θ(·) 表示样本的类别,那么有

其中 τ 是一个阈值。

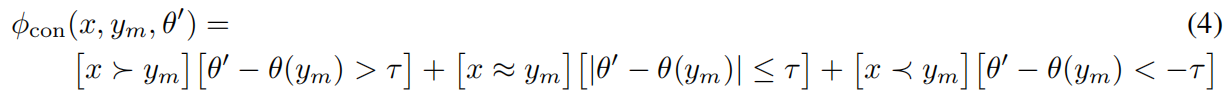

比较结果和估计值之间的一致性函数为

函数在不一致的时候返回0在一致情况下返回1

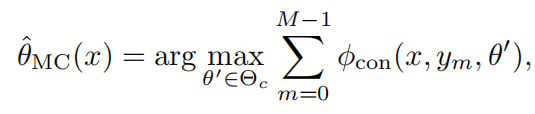

那么对于所有的x来说有,称为最大一致性法则。

上面的大于, 约等于,小于号,并不是数学意义上的符合。只是表征一个近似的表示。

5. 次序学习-有监督链

5.1 有监督链-单链假设

假设q是一个独热编码(one-hot vector)

$$ q^xy = (q_0{xy},q_1,q_2^{xy} ) $$

p是相关比较器的softmax概率向量

$$ P^{xy} = (p_0{xy},p_2,p_2^{xy}) $$

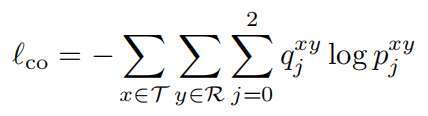

可以得到我们训练比较器最终的损失函数为

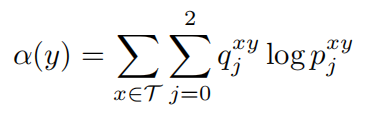

那么对于样本x标签y的可信分为

5.2 有监督链-K链假设

样本根据不同的初始分类划分为多个类别,如年龄估计任务,会先把图片按照性别划分两个链,或根据肤色划分为三个链,或者根据性别+肤色划分为6个链。

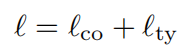

样本在进入比较器之前会经过分类器,分为特定的类,再进入特定的链去进行比较。那么总的损失函数可以由比较损失和分类损失共同组成。

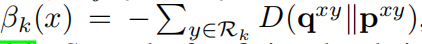

非监督链算法

这部分介绍如何把划分算法引入到非监督学习中

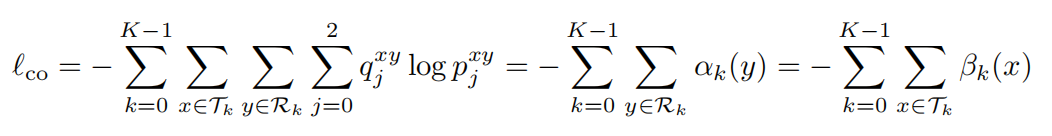

第一步,随机把训练集划分为K个不相交的子集。那么针对这K个集合,有比较器的损失函数为

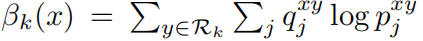

其中有:

上面的D为Kullback-Leibler距离

第二步,根据上面固定下来的子集,根据最大化可信值得到代表性样本Rk,

第三布,得到K个中心代表样本R后,根据K个子集来训练K个链,最大化β。

如此反复迭代,两个步骤会减少总的loss。

算法伪代码为:

6. 实验设置

本文的主要聚焦在图片的年龄识别上。

特征提取器使用的是去掉了全连接层的VGG16,比较器和分类器都是基于此。

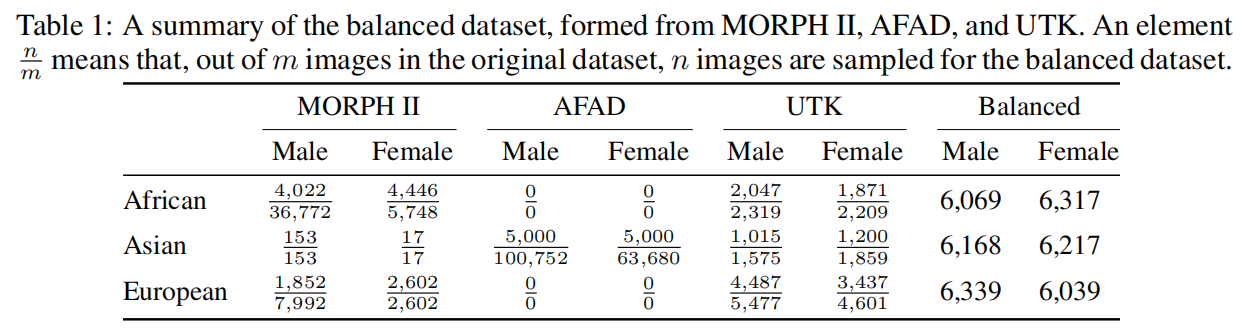

使用的数据集:经过平衡化的数据集

使用的衡量指标是MAE均值绝对误差(mean absolute error)和CS累积得分(cumulative score)

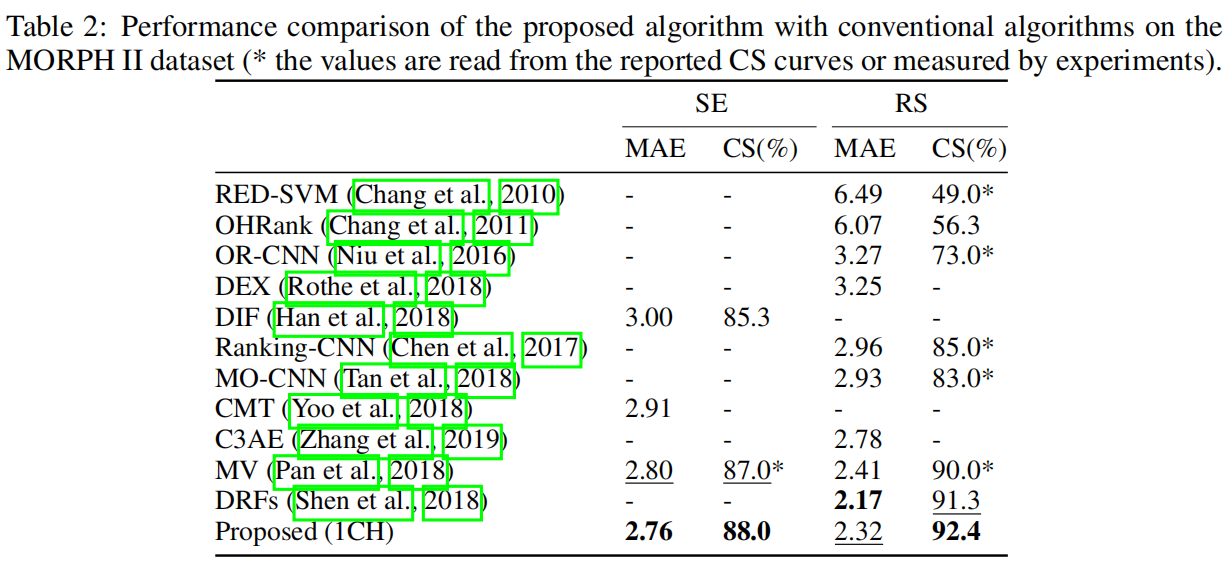

跟各个算法的比较中,论文的算法都取得了好效果

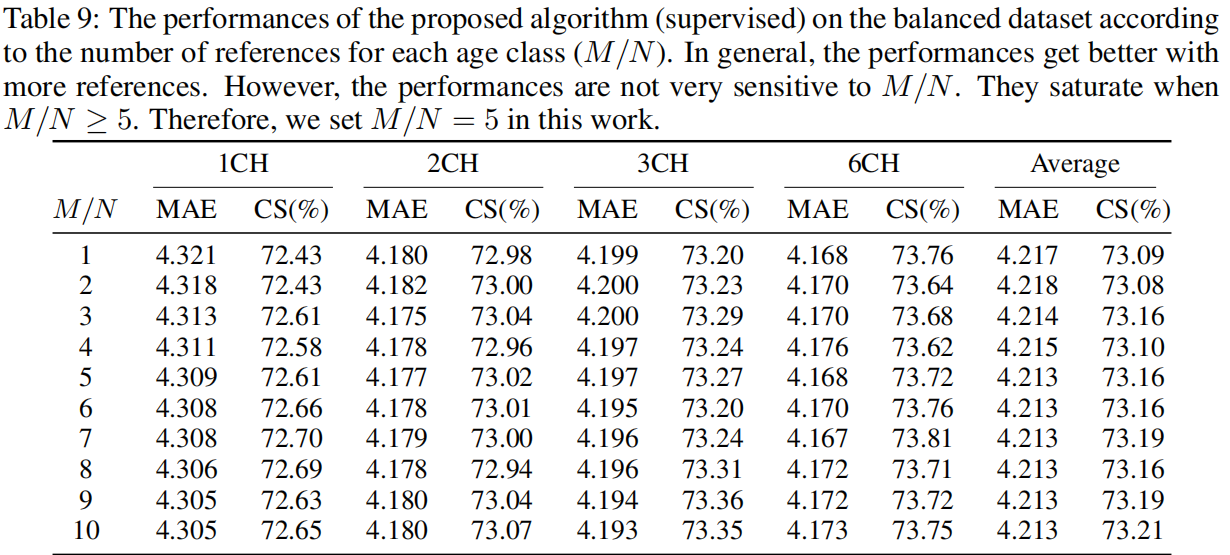

使用不同的链数下的数据效果

7. 总结

论文从一个新的方向来解决,利用半监督学习的比较函数来入手。

浙公网安备 33010602011771号

浙公网安备 33010602011771号