论文解读-《Can Classic GNNs Be Strong Baselines for Graph-level Tasks》

1. 论文介绍

论文题目:Can Classic GNNs Be Strong Baselines for Graph-level Tasks? Simple Architectures Meet Excellence

论文发表:ICML 2025

论文领域: 图神经网络

论文背景:

2. 背景介绍

传统的消息传递性GNN因为其有限的表达能力如过度平滑,过度挤压和获取长距离特征依赖。一般都认为graph transformer因为全局注意力机制可以取得更好的效果。这篇论文提出了一个基于GNN的增强的框架,只引入了6种常用的技术:边特征整合,归一化,dropout算子,残差连接,前馈网络,和位置编码。整合进入了经典的GNN框架,取得了超越GTs等算法的效果。

意义是否定了学术界广泛认为的:复杂全局模型在图级任务的天然优势。

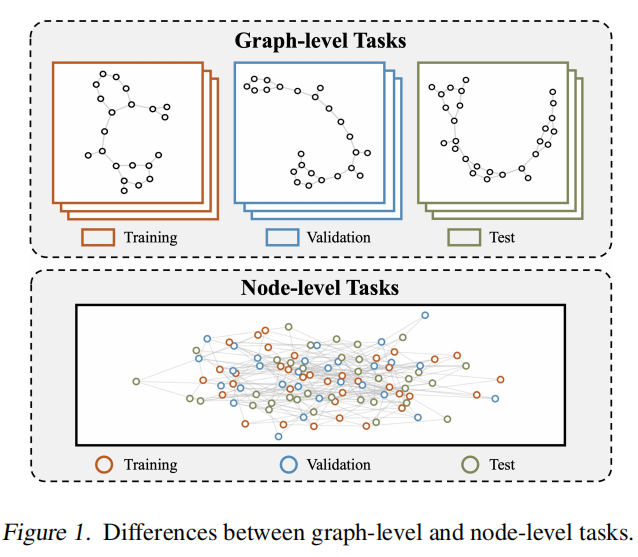

首先对于图任务来说,节点分类和图级别分类,因为其基础数据的构造不同,在方法设计,训练策略,和应用领域上是两种不同的基础形态。

虽然GTs的全局注意力让每一个节点和所有其他节点建立联系,在常见的图级任务上表现最好。但是因为全局注意力机制的二次复杂度,限制了GTs在实际应用中的可扩展性。

在传统的图级任务的分类

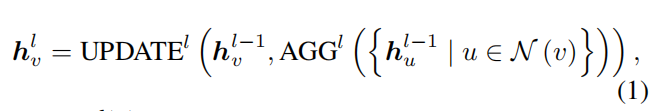

Message-passing GNN 的定义是

3. 本文内容

3.1 超参数技术

首先是常用的网络超参数技术

边特征整合:(在分子研究和超分辨率图像上有重要作用,会编码重要的特定域的信息)

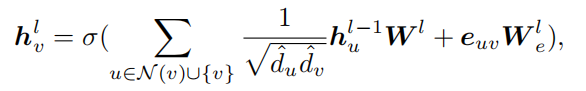

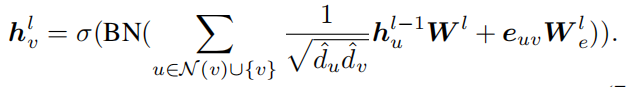

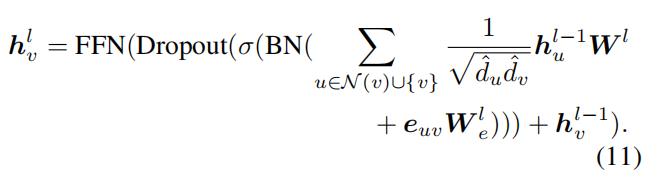

边缘特征通过消息传递过程整合,定义如下

归一化:(随着数据集增大而更重要)

对GNN的训练有关键作用,减轻训练过程中节点在嵌入分布空间的跨层变化的偏差漂移的影响,能够支持更高的学习率和更快的收敛速度。定义如下:

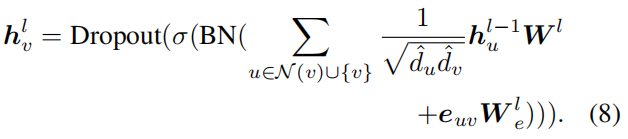

dropout:(适用于大部分图级数据集,一个良好的dropout率是关键)

dropout通过减少隐藏神经元的相互适应的方式来避免过拟合问题。一般是将dropout嵌入在激活函数之后。

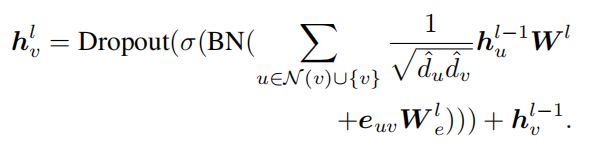

残差连接:(很基础的重要,除了应用在小型图的浅层GNN)

残差连接通过直连层的输入和输出,减缓深度网络的梯度弥散的问题。

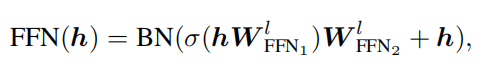

前馈网络:对图级任务的简单模型很重要

FFN增强了模型进行复杂特征转换的能力,引入了非线性能力,提高了整个网络的表达能力。

FNN的定义为:

那么,FFN嵌入网络层的使用为

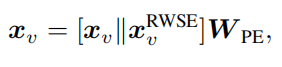

位置编码:(在小型数据集上更为重要)

在Transformer模型中引入位置编码是用于表示语言建模序列中标记的位置。在GTs中,位置编码用于合并图形位置或结构信息。编码通常在输入GTs之前添加或连接到输入节点特征。

使用RWSE(Random Walk Structural Encoding)来作为位置编码

3.2 经典GNN网络

常用的经典的GNN这里用到GCN,GIN,GatedGCN。只用到这三个,大概可以估计为其他的经典图网络模型,和其他超参数技术的不兼容,这三个能够专业地去提取图结构的特征。

GCN图卷积网络,定义为

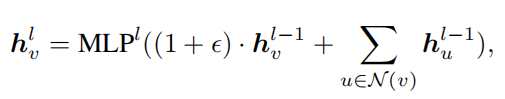

GIN图同构网络,定义为:

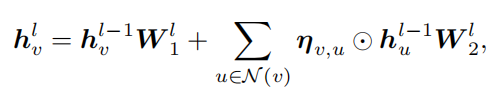

GatedGCN 残差门图卷积网络,定义为

3.3 GNN-Plus介绍

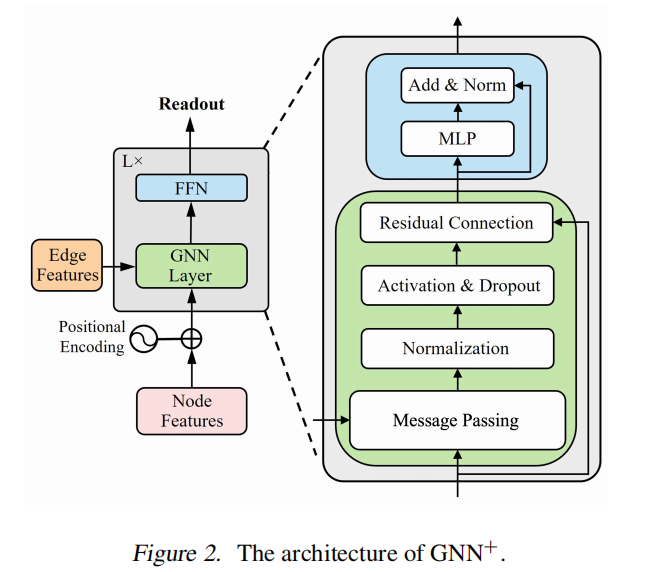

本文提出的GNN-Plus,算法架构为:

4. 实验设置

在来自三个任务的其中14个著名的图级别数据集上

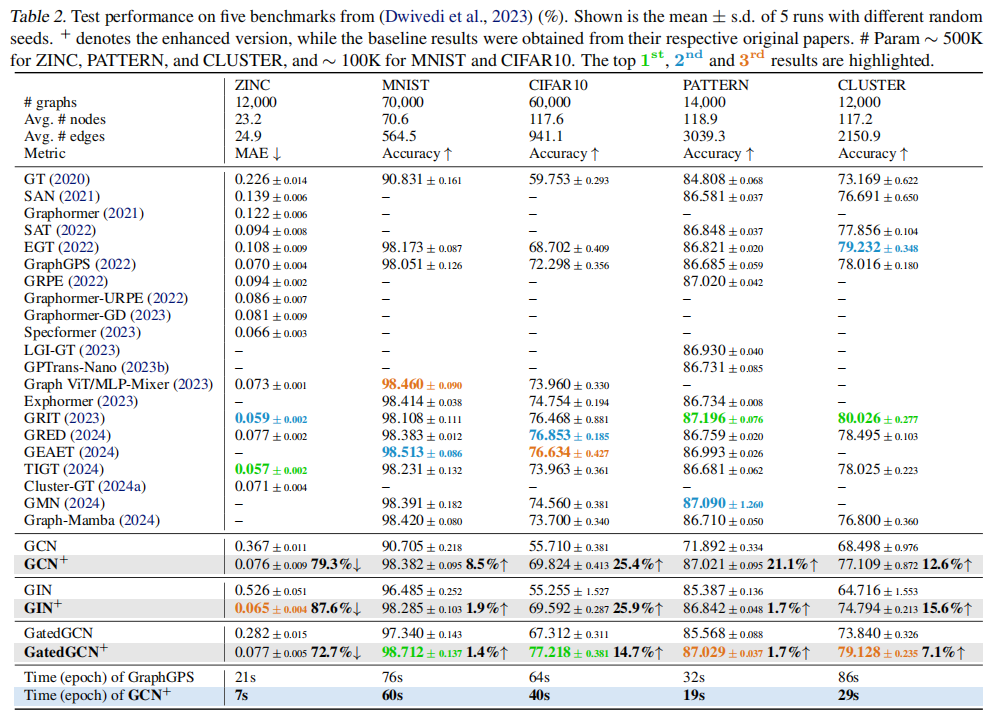

GNN benchmark的数据集:ZINC,MNIST,CIFAR10,PATTERN,CLUSTER

LRGB(Long-Range Graph Benchmark)的数据集:Peptides-func,Peptides-struct,PascalVOC-SP,COCO-SP,MalNet-Tiny

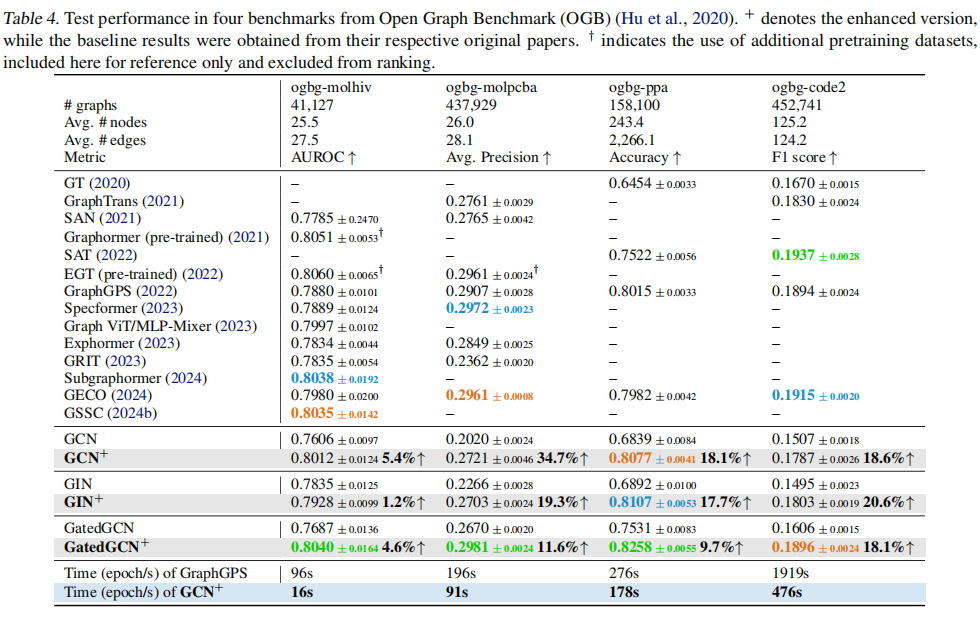

OGB(Open Graph Benchmark)的数据集:ogbg-molhiv,ogbg-molpcba,ogbg-ppa,ogbg-code2

在GNN benchmark上的数据

在LRGB上的实验数据

在OGB上的实验数据

GNN-plus在14个数据集的占据所有的top-3。在8个数据集中表现最佳,同时展示出更高的效率。

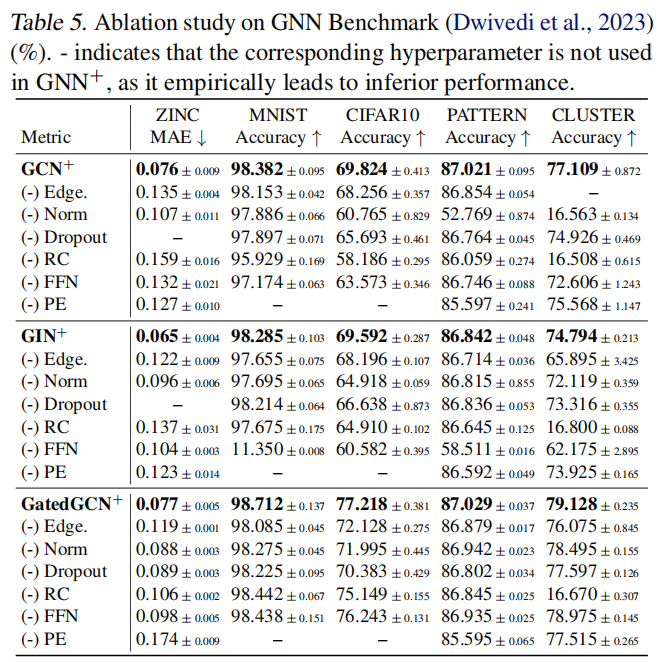

5. 消融实验

为了验证单个超参数技术在GNN-plus中的作用,本文做了选择性移除后的实验测试

在14个数据集上分别进行消融实验,根据实验结果统计,得到实验观察。

观察1:边缘特征的集成在分子和图像超像素数据集中特别有效,这些特征携带关键信息。

观察2:归一化倾向于对较大规模的数据集产生较大的影响,而对较小的数据集影响较小。

观察3:dropout对大多数数据集有利。一个很低的dropout率就很优了,且有效率

观察4:残差连接是很通用且基础的,除了在小图上的浅层GNN。

观察5:FNN对GIN和GCN非常重要,极大提高了性能

观察6:位置编码对小型数据集非常有效,但在大型数据集上的作用很小可忽略。

6. 总结

作者通过对图级任务的细分研究中,结合超参数技术的经典GNN,会表现的比复杂全局模型GNN更好。

论文的亮点在于以多层的超参数技术结合GCN,GIN,GatedGCN经典模型,弥补其在特征提取,模型训练,参数优化上的短板,做到了超越复杂全局模型的效果。

7. 阅读感悟

算法比较,不仅要看各个算法的优劣,还是研究数据。

浙公网安备 33010602011771号

浙公网安备 33010602011771号