论文解读-FedAvg

1,论文背景

论文题目:Communication-Efficient Learning of Deep Networks from Decentralized Data

论文领域:联邦学习

论文发表:The 20th International Conference on Artificial Intelligence and Statistics(AISTATS)

论文时间:2016 arxiv

FedAvg框架,联邦学习中的经典开山论文和经典对比baseline

2,文章的贡献

1,指出了在非中心化数据集上如在移动设备的数据上,进行训练,是一个重要的研究方向

2,针对非中心化数据集提出了一种简单直接的方法

3,针对提出方法进行的广泛的实验验证

3,关键点:

联邦学习:可以解决的问题有现实世界数据的巨大优势,数据隐私和数据规模问题,用户和设备的标签数据。

隐私学习:client和server传递的是更新信息而非原始数据,而且更新信息为临时,训练完丢弃。

联邦学习要解决的问题,(差别于典型的分布式优化问题)

1,Non-IID问题,client上的数据分布各异

2,不平衡问题,client上不同则产生的数据量不一致

3,大规模的分布,client的数量庞大,比单个client上的样本更多

4,通信限制,移动设备需要考虑断网和通信效率问题

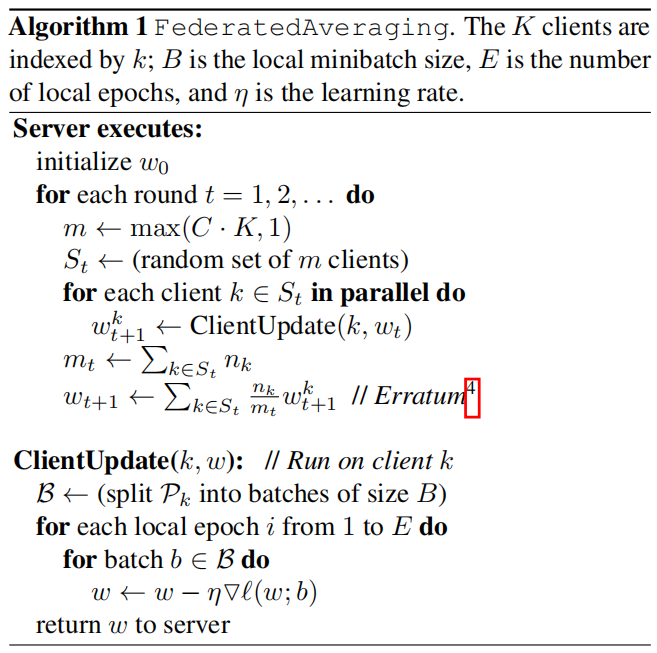

4,fedavg算法架构

算法的计算量体现在三点:

C,每一轮参与计算的client的数量

E,每一轮单个client在其数据集上训练的pass次数

B,本地的最小批次的client更新

5,实验设置

初始的在MNIST数据集上的实验,对应的模型为多层感知机

划分数据的方法有两种:随机划分(为IID数据),排序后根据类别来划分(Non-IID数据)

在自然语言上使用基于莎士比亚的自建数据,模型用的是LSTM模型

实验分别针对C E B这三个变量来验证FedAvg算法在不同参数下的情况,从client的并行数量和每个client的计算量两个角度。

6,总结

联邦学习的开山论文,给出了这个领域需要克服的问题。实验部分以超参数的设置来讨论整个模型框架的特性。

浙公网安备 33010602011771号

浙公网安备 33010602011771号