【转载】深度学习中Xavier初始化

原文地址:

https://www.cnblogs.com/hejunlin1992/p/8723816.html

“Xavier”初始化方法是一种很有效的神经网络初始化方法,方法来源于2010年的一篇论文《Understanding the difficulty of training deep feedforward neural networks》。

文章主要的目标就是使得每一层输出的方差应该尽量相等。下面进行推导:每一层的权重应该满足哪种条件才能实现这个目标。

我们将用到以下和方差相关的定理:

假设有随机变量x和w,它们都服从均值为0,方差为σ的分布,且独立同分布,那么:

• \(w*x\)就会服从均值为0,方差为\(σ*σ\)的分布

• \(w*x+w*x\)就会服从均值为0,方差为\(2*σ*σ\)的分布

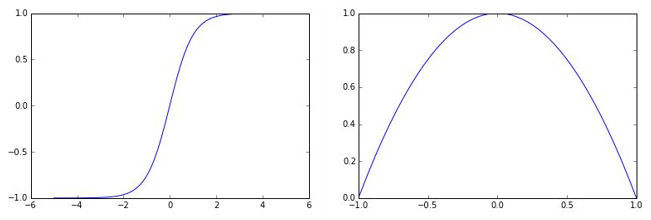

文章实验用的激活函数是tanh激活函数,函数形状如下左图,右图是其导数的函数形状。

具体内容下略,具体参照原文:

https://www.cnblogs.com/hejunlin1992/p/8723816.html

本博客是博主个人学习时的一些记录,不保证是为原创,个别文章加入了转载的源地址,还有个别文章是汇总网上多份资料所成,在这之中也必有疏漏未加标注处,如有侵权请与博主联系。

如果未特殊标注则为原创,遵循 CC 4.0 BY-SA 版权协议。

posted on 2026-01-03 10:01 Angry_Panda 阅读(6) 评论(0) 收藏 举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号