【转载】 梯度的直观理解_谈谈优化算法之一(动量法、Nesterov法、自然梯度法)

原文地址:

https://blog.csdn.net/weixin_34613462/article/details/112333623

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

本文链接:https://blog.csdn.net/weixin_34613462/article/details/112333623

————————————————

========================================

-------------------------------------------------------------------

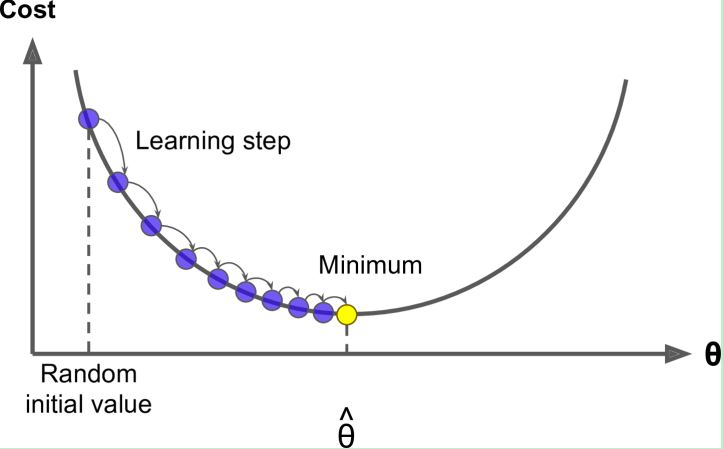

是时候谈谈优化算法了。不管是求解优化目标还是为了调参,只要问题从理论层面上升到实际操作层面,就离不开优化算法。本节讲主要围绕梯度下降(Gradient Descent)算法展开。

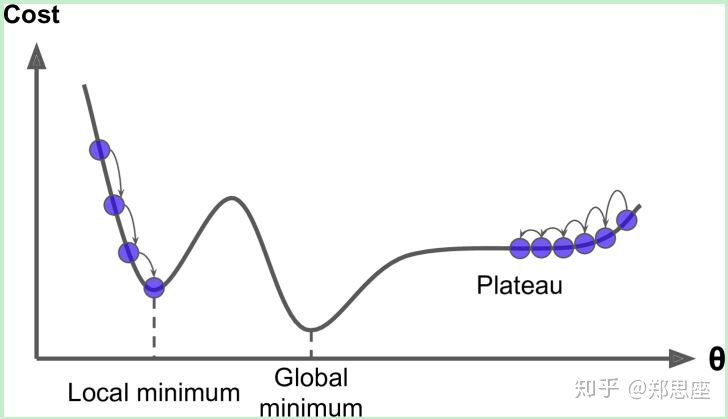

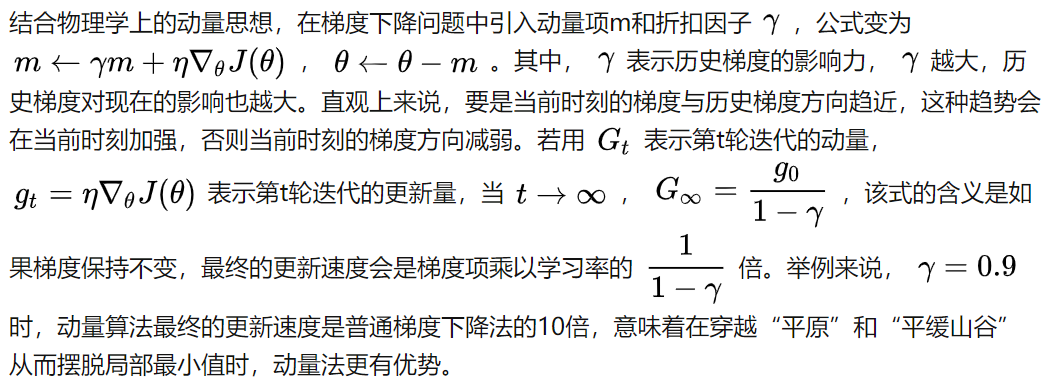

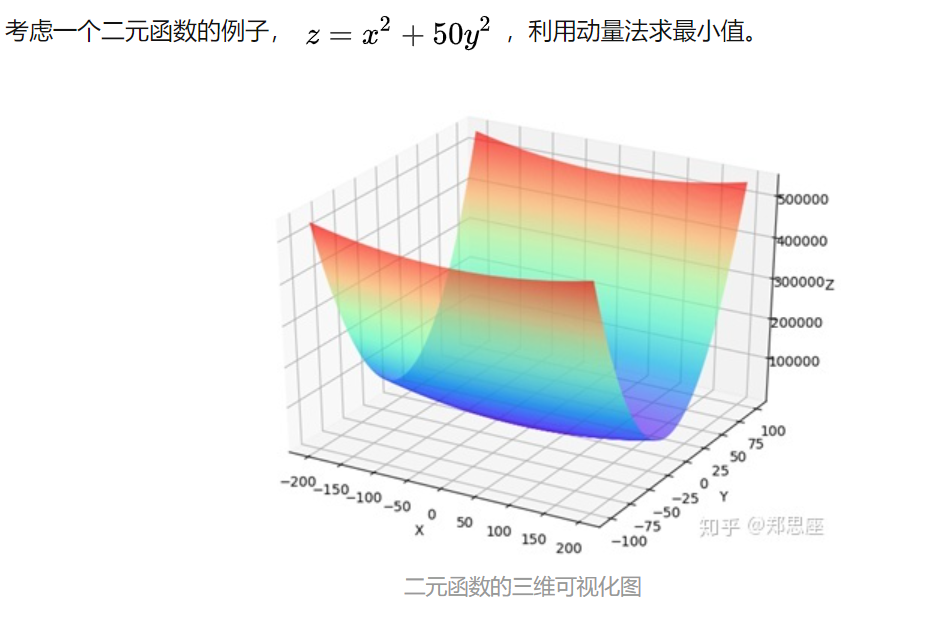

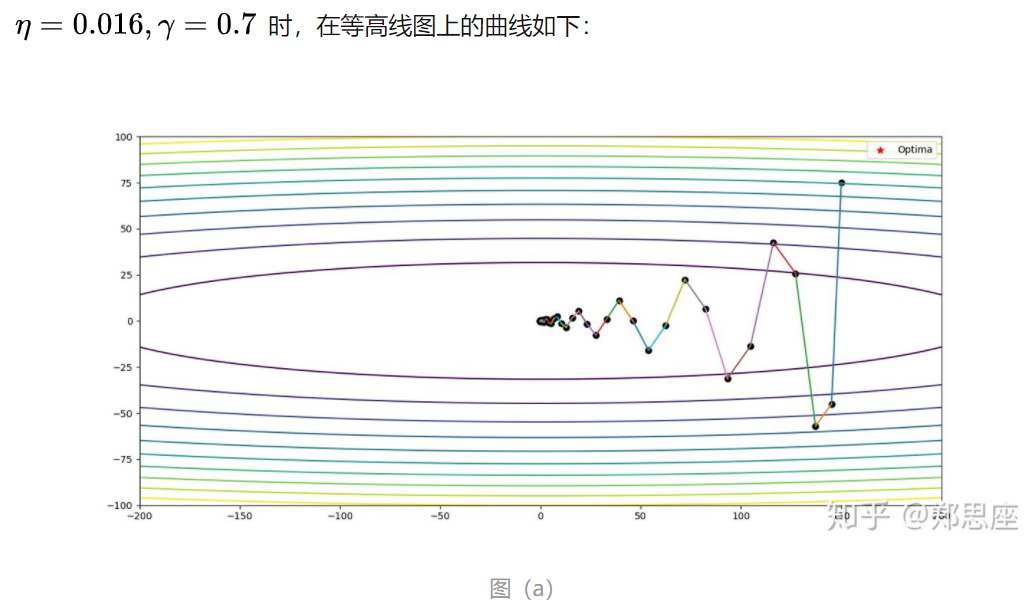

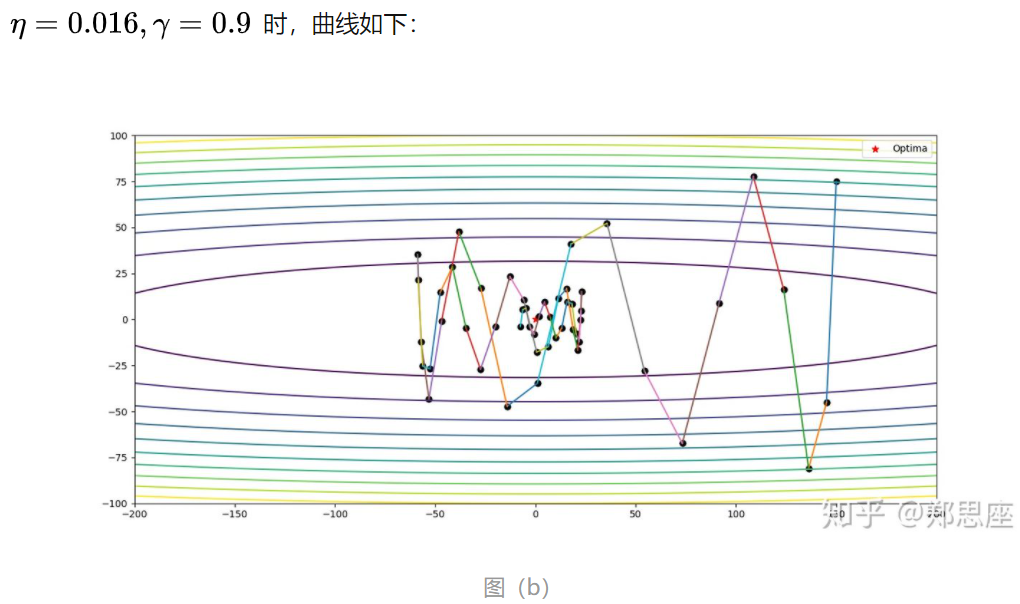

动量法(Momentum)

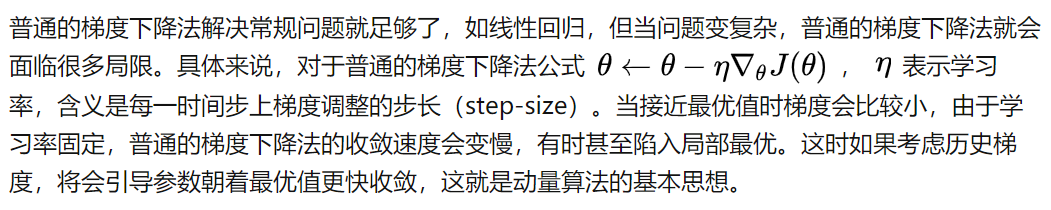

陷入局部最优或在平原部分缓步前行

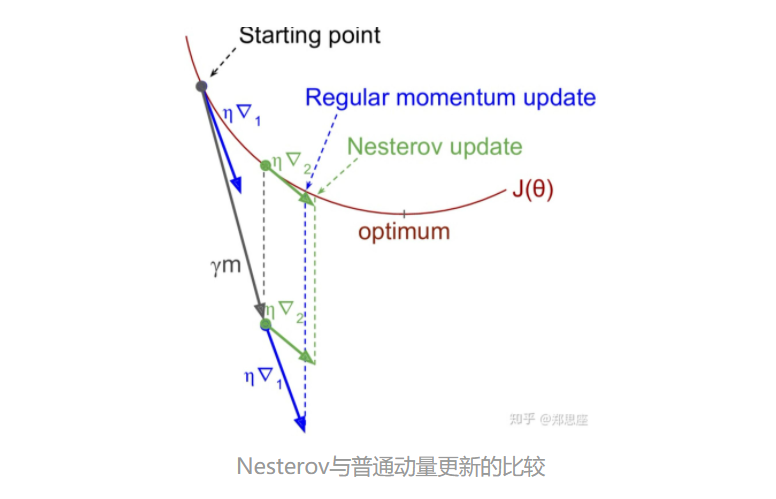

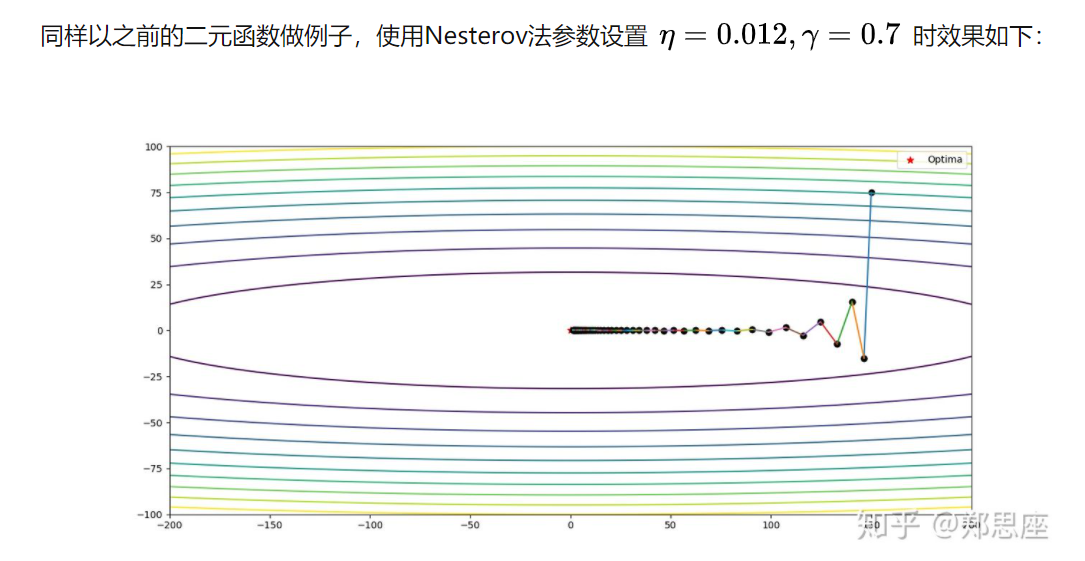

牛顿动量(Nesterov)算法

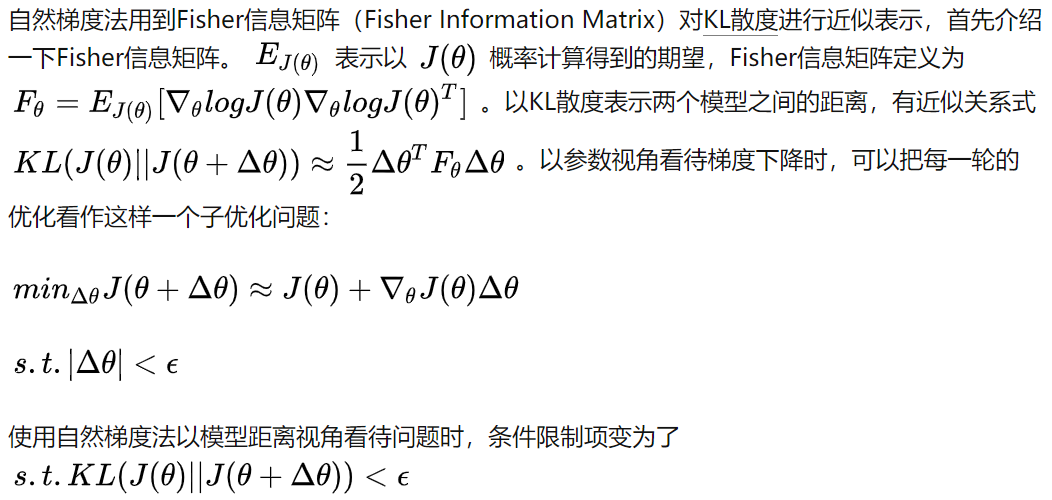

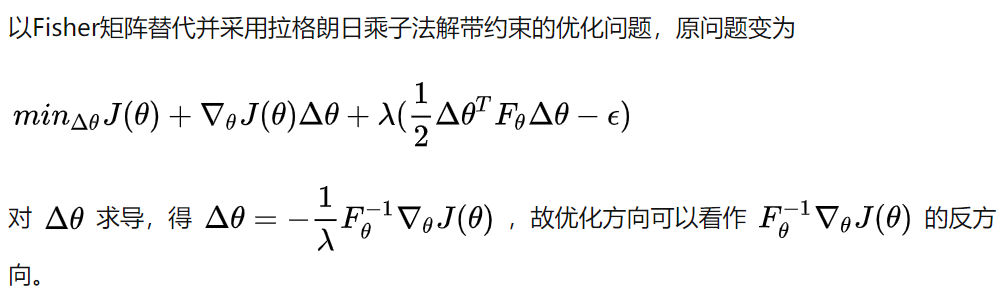

自然梯度法(Natural Gradient Descent)

当优化问题的两个坐标轴尺度差异较大时,动量法在更新过程中会出现震荡问题,Nesterov算法给出了初步解决,但这两种方法有一个共性,就是都是从参数的角度去优化模型的,那有没有可能从模型本身角度来考虑呢?——这就是自然梯度法。在强化学习的Natural Actor-Critic算法和TRPO算法中,自然梯度法是强有力的优化工具。

========================================

posted on 2021-03-26 09:36 Angry_Panda 阅读(365) 评论(0) 收藏 举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号