GAN Lecture 1 (2018)_Introduction

课程主页:提供作业相关

PS: 这里只是课程相关笔记

1. Basic Idea of GAN

GAN 全称是 Generative Adversarial Network !

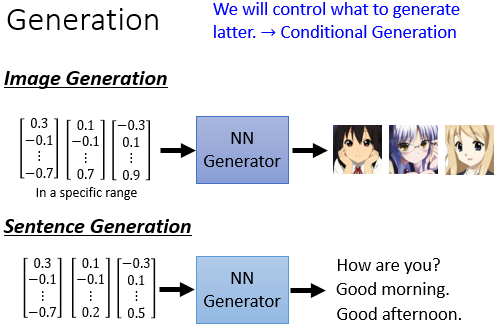

所谓的 Generation 简单来说就是给一个 random vector, 经过 Generator 网络后可以输出一幅画或是一段文字。

GAN 由 Generator 和 Discriminator 两个网络组成。

Generator 输入一个 Vector, 经过 Generator 网络后输出一个 high dimensional vector. 直观上来看,输入 Vector 里每个 scale 都可能代表某个特定的语义特征。

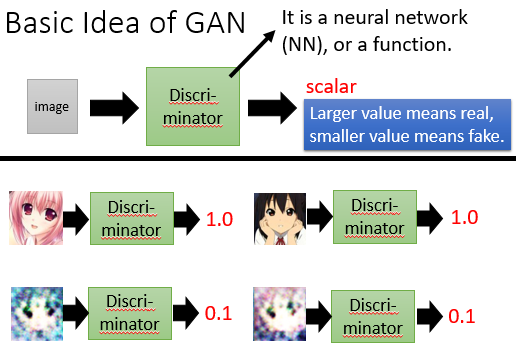

Discriminator 则相反,输入一个 high dimensional vector, 输出一个 scale, 来判断输入时真是假。

| Generator | Discriminator |

|

|

GAN 通过 Generator 和 Discriminator 不断的相互作用(博弈),以期不断提升 Generator 的生成能力和 Discriminator 的判别能力。

2. Alogrithm

2.1 Train pipeline

|

|

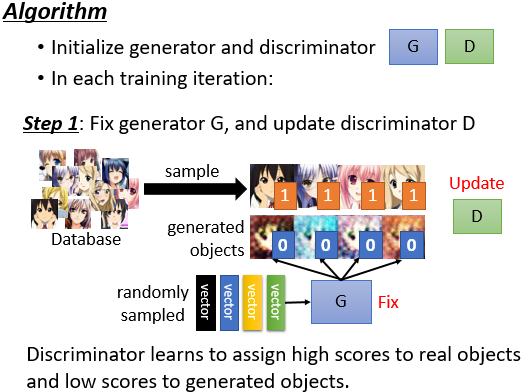

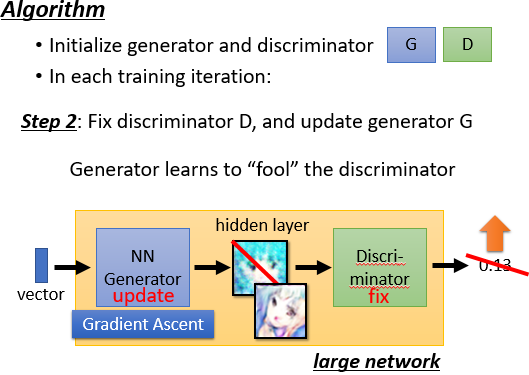

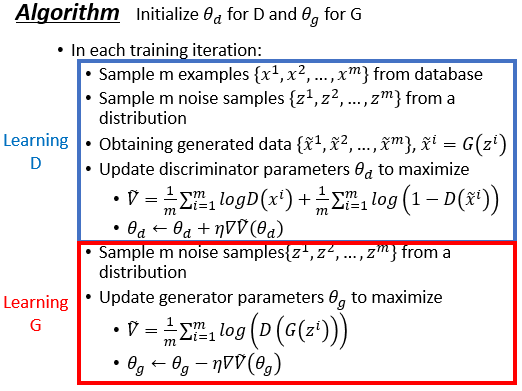

流程上:首先要随机初始化 generator 和 discriminator 两个网络,接下来我们需要迭代的训练这两个网络。每次迭代时,我们首先将 generator 网络参数固定住,只训练 discriminator, 目的是让 discriminator 能够区分真实样本和生成的样本;随后我们将 discriminator 网络的参数固定住,只训练 generator, 目的是让 generator 输出的东西能够骗过 discriminator.

2.2 Alogrithm

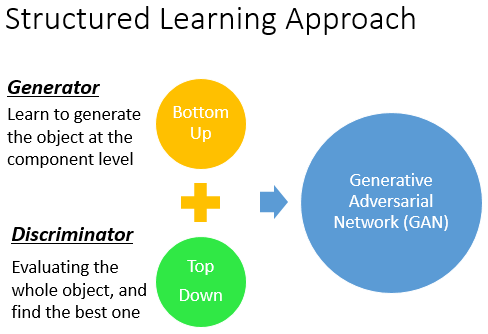

3. GAN as structured learning

GAN 是一种 structured learning,即输出是一个矩阵,而非简单的分类回归任务输出一个向量。

而如果把 Generator 的每个输出看成是一类,那么 GAN 可以理解为是一种极端的 One-shot / Zero-shot Learning,这就要求 Generator 更富有创造性!

Structured Learning 还有一个特点是,评价一个 Structured Learning 的好坏要从输出整体来看,即要考虑输出元素之间的关系。

Structured Learning 可以大体分为两类:自底向上和自上往下。

4. Can Generator learn by itself?

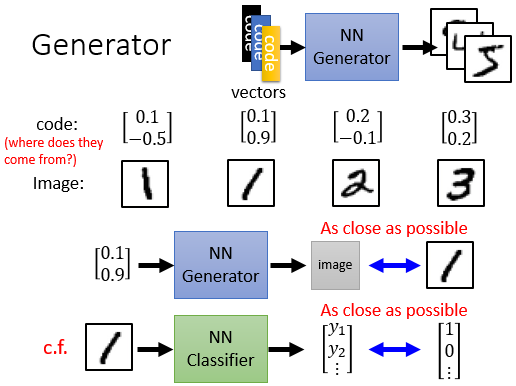

这里我们可能会想,为什么 Generator 不可以独立做到这些任务呢?

实际上 Generator 是可以自己做到的,输入一个向量,我们可以通过有监督的方式让输出和真实图片尽可能的接近。这个过程和一般的分类任务过程相反。

唯一的问题是我们怎样产生这些向量输入并和某个真实图片关联起来,你可能会说随机输入就好了,但如果真是随机输入,那么你可能很难 train 出来这样的模型。

实际上我们希望的是,如果今天有两张图片有非常相近的特征,那么它们对应到的向量输入就应该有某些相似之处。

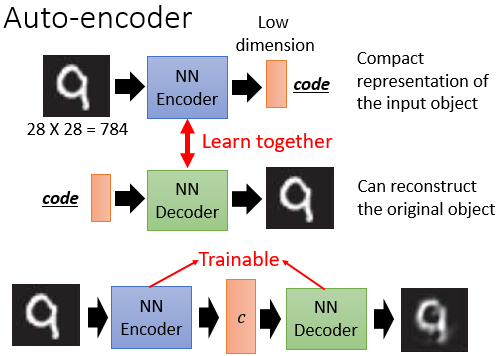

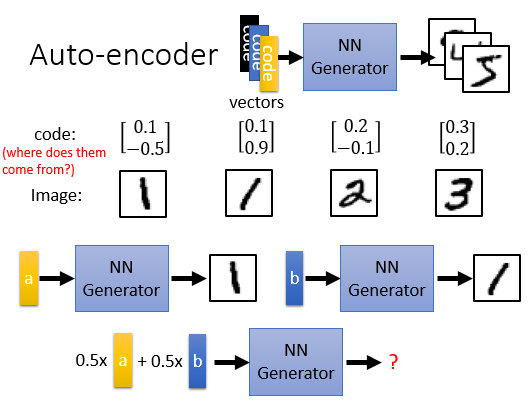

这其实可以通过一个 Auto-encoder 来做到,其中 Decoder 部分就可以看出是 Generator.

但由于 Generator 是非线性的,因此下图最终可能会产生一个噪声!

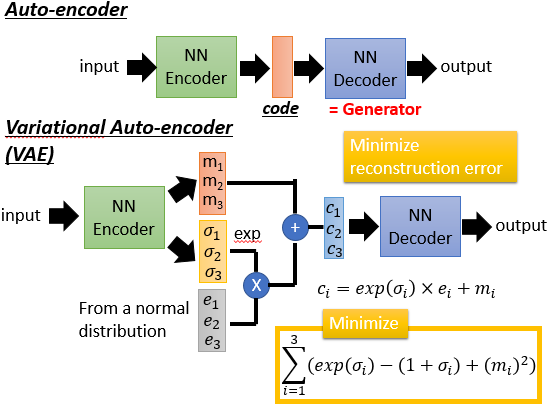

解决这种现象的方法是 Variational Auto-encoder(VAE)

VAE 中,Encoder 不仅会输出一个 Vector, 还会输出一个 Variance,将随机 Noise 乘到 exp(Variance) 上后加到 Vector 上,最后才作为 Decoder 的输入。

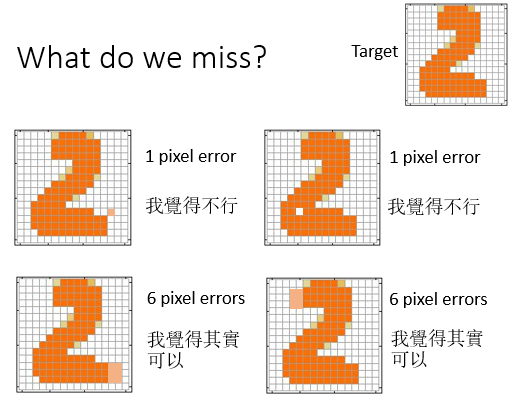

但是这缺少灵魂,它只是像素级的接近 GT, 但缺乏对大局观的把握(一般来说 VAE 产生的图片会比 GAN 产生的图片要糊点):

5. Can Discriminator generate?

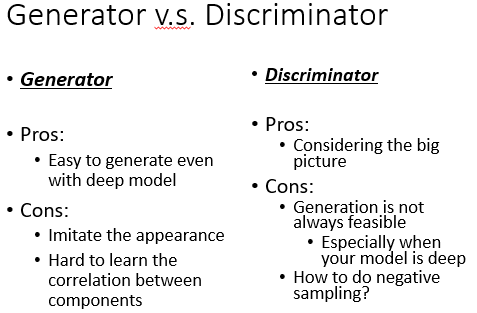

Discriminator 的优点在于可以考虑 components 之间的关系。由于 Discriminator 只会判断不会创造,因此用 Discriminator 来生成的一个可能方法就是穷举。。。这里面还有一个问题就是 hard negative examples 的搜集来训练一个好的 Discriminator(Generator 可以解决这个问题)。

6. Summary

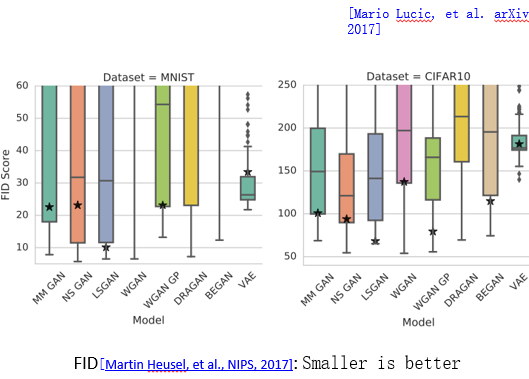

下面这篇论文表达的意思是,不同的 GAN 之间差别不是很大,GAN 生成的质量较 VAE 不稳定:

浙公网安备 33010602011771号

浙公网安备 33010602011771号