0910 每日文献阅读 打卡

|

Read Data:0910 |

Publication: CVPR 2021 |

||

|

Title: VirTex: Learning Visual Representations from Textual Annotations |

|||

|

Aim: 从少量图像学习到高质量的视觉表达。 |

Research Question: 在ImageNet上用卷积网络进行图像分类预先训练,然后将学习到的特征转移到下游任务。由于预训练步骤依赖于人工标注的图像,因此这种方法的扩展成本很高。 |

||

|

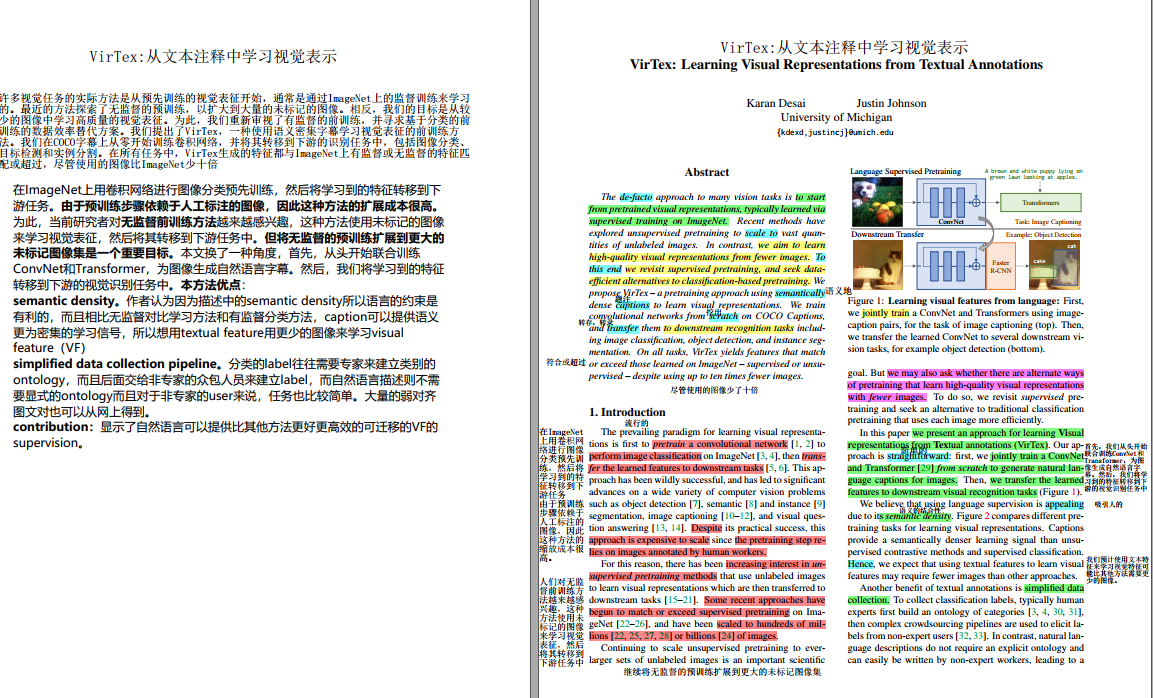

Method: 首先,我们从头开始联合训练ConvNet和Transformer,为图像生成自然语言字幕。然后,我们将学习到的特征转移到下游的视觉识别任务中 |

|||

|

Results: 在VOC07上,VirTex-100%优于IN-sup-100% (mAP 88.7 vs 87.6),尽管使用的图像少10张(118K vs 1.28M)。当使用相似数量的图像时,VirTex的性能始终优于INsup(蓝色、橙色vs绿色),这表明VirTex的数据效率更高。我们还观察到,给定相同数量的标题用于训练,最好将它们分散在更多的图像上,VirTex-50%(1个标题)显著优于VirTex-10%(5个标题)(mAP 79.4 vs 69.3)。 |

Discussion: |

||

|

Conclusion: 我们开始训练COCO,并将预训练模型迁移到包括分类,检测,分割等下游识别任务,在所有任务上virtex,在使用图像比imagenet少十倍的条件下,生成的特征可以匹配甚至超过,无论有监督无监督的imagenet上学习的特征。 证明使用文本注释学习视觉表示可以与基于监督分类和ImageNet上的自监督学习方法相比。但是,我们只关注视觉任务。最后,使用字幕打开了一个清晰的途径,可以将我们的方法扩展到互联网图像-文本对,它们的数量级更大,尽管比COCO题注更嘈杂。 |

Further: 未来的工作可以探索其他任务,转移视觉中枢和文本头部。 |

||

|

Ref: 详细阅读该论文。复现。 |

|||

浙公网安备 33010602011771号

浙公网安备 33010602011771号