0908 每日文献阅读 打卡

|

Read Data:0908 |

Publication: ICML 2021 |

||

|

Title: Interpreting and Disentangling Feature Components of Various Complexity from DNNs |

|||

|

Aim: 从一个新的角度分析深度神经网络的特征表示能力。 |

Research Question: 将该特征的实际复杂性定义为计算该特征所需的非线性变换的最小数目,但非线性转换的量化对最先进的算法提出了重大挑战。 |

||

|

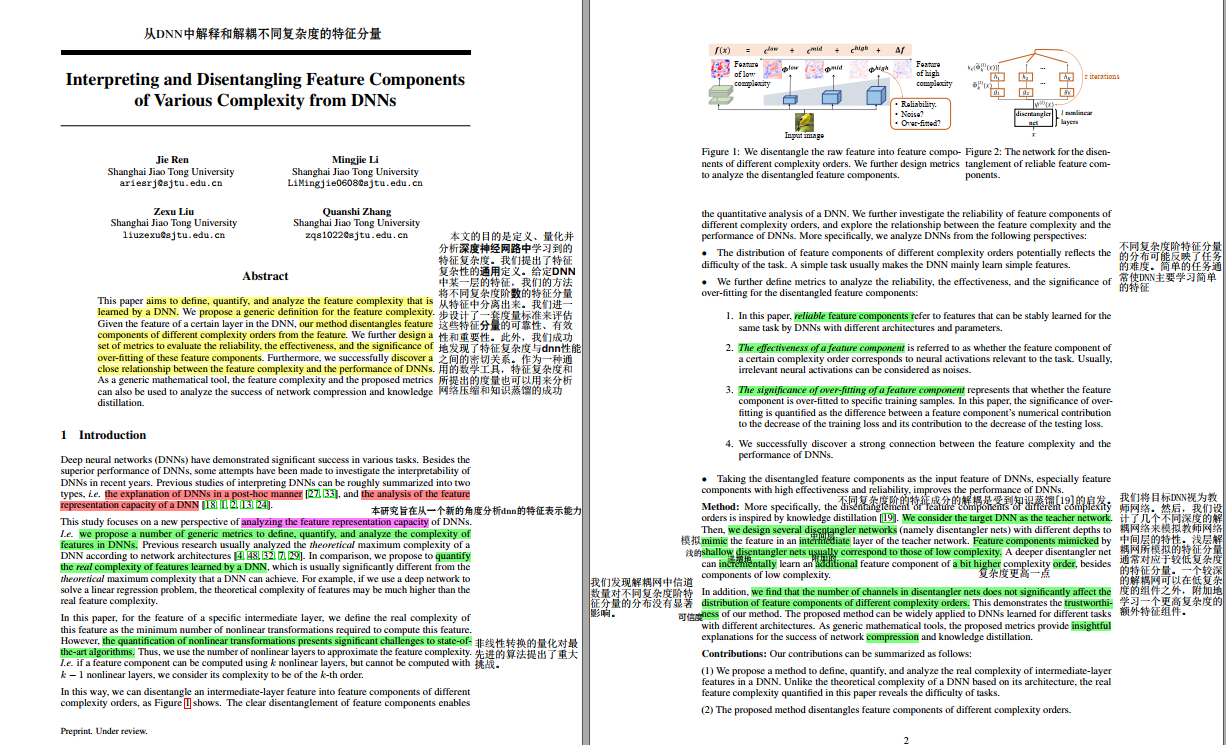

Method: 我们提出了特征复杂性的通用定义。给定DNN中某一层的特征,我们的方法将不同复杂度阶数的特征分量从特征中分离出来。首先,将目标DNN视为教师网络。然后,我们设计了几个不同深度的解耦网络来模拟教师网络中间层的特性。浅层解耦网所模拟的特征分量通常对应于较低复杂度的特征分量。较深的解耦网可以在低复杂度的组件之外,附加地学习一个更高复杂度的额外特征组件。我们进一步设计了一套度量标准来评估这些特征分量的可靠性、有效性和重要性。 |

|||

|

Results: 我们成功地发现了特征复杂度与dnn性能之间的密切关系;发现解耦网中信道数量对不同复杂度的特征分量分布没有显著影响。 |

Discussion: |

||

|

Conclusion: 在本文中,我们提出了DNN特征复杂度的一般定义。我们设计了一种对不同复杂度的特征分量进行分解和量化的方法,并从三个角度对分解后的特征分量进行分析。然后,发现了特征复杂度与DNN性能之间的密切关系。此外,解耦特征分量可以提高DNN的分类精度。 |

Further: 该方法可广泛应用于不同结构、不同任务的DNN学习。作为通用的数学工具,所提出的度量标准为网络压缩和知识蒸馏的成功提供了深刻的解释。 |

||

|

Ref: 贡献:(1)我们提出了一种定义、量化和分析DNN中中间层特征真实复杂性的方法。本文量化的真实特征复杂性揭示了任务的难度。(2)对不同复杂度的特征分量进行解耦。(3)我们提出了新的指标来分析这些特征成分的可靠性,有效性,过拟合的重要性,以及DNN的性能。该分析为理解网络压缩和知识蒸馏提供了一个新的视角。(4)解耦的特征分量提高了DNN的性能。 |

|||

浙公网安备 33010602011771号

浙公网安备 33010602011771号