0616 每日文献阅读 打卡

|

Read Data: 0616 |

Publication: CVPR 2020 |

||

|

Title: ECA-Net: Efficient Channel Attention for Deep Convolutional Neural Networks Participants: Qilong Wang,Banggu Wu,Pengfei Zhu,Peihua Li,Wangmeng Zuo,Qinghua Hu |

|||

|

Aim: 大多数现有的方法都致力于开发更复杂的注意力模块以获得更好的性能,这不可避免地增加了模型的复杂性。本文就是为了克服性能与复杂性权衡的矛盾。 |

Research Question: 当前研究方法往往带来更高的模型复杂度和更大的计算量。与前面提到的以更高模型复杂度为代价获得更好性能的方法不同,本文关注的是一个问题:一个人能否以更有效的方式学习有效的通道注意力? |

||

|

Method: 本文提出了一种有效渠道关注(ECA)模块,该模块只涉及少量参数,却能带来明显的绩效收益。通过对SENet中的通道注意模块的分析,我们发现避免降维对学习通道注意很重要,适当的跨通道交互可以在显著降低模型复杂度的同时保持性能。因此,我们提出了一种无需降维的局部跨通道交互策略,该策略可以通过一维卷积有效地实现。此外,我们发展了一种方法自适应选择核大小的一维卷积,确定局部跨信道交互的覆盖范围。 |

|||

|

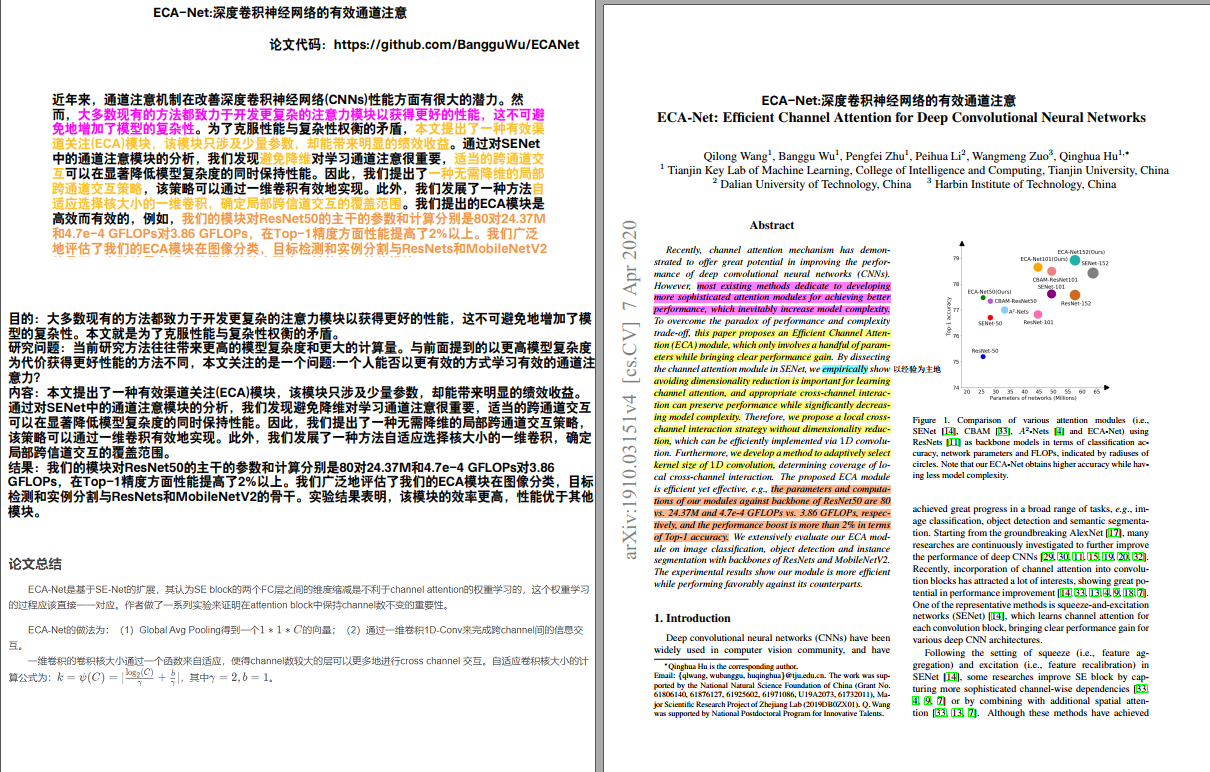

Results: 我们的模块对ResNet50的主干的参数和计算分别是80对24.37M和4.7e-4 GFLOPs对3.86 GFLOPs,在Top-1精度方面性能提高了2%以上。我们广泛地评估了我们的ECA模块在图像分类,目标检测和实例分割与ResNets和MobileNetV2的骨干。实验结果表明,该模块的效率更高,性能优于其他模块。 |

Discussion:

|

||

|

Conclusion: 在本文中,我们重点学习了低模型复杂度的深度神经网络的有效通道注意。为此,我们提出了一种高效的通道注意模块(ECA),该模块通过快速一维卷积产生通道注意,其核大小可以通过通道维数的非线性映射自适应地确定。实验结果表明,我们的ECA是一个非常轻量级的即插即用块,可以改善各种深度CNN架构的性能,包括广泛使用的ResNets和轻量级的MobileNetV2。此外,我们的ECA-Net在目标检测和实例分割任务中表现出良好的泛化能力。

|

Further: 在未来,我们将把ECA模块应用到更多的CNN架构中(如ResNeXt和Inception),并进一步研究ECA与空间注意模块的结合。 |

||

|

Ref: 论文总结 ECA-Net是基于SE-Net的扩展,其认为SE block的两个FC层之间的维度缩减是不利于channel attention的权重学习的,这个权重学习的过程应该直接一一对应。作者做了一系列实验来证明在attention block中保持channel数不变的重要性。 |

|||

浙公网安备 33010602011771号

浙公网安备 33010602011771号