0615 每日文献阅读 打卡

|

Read Data: 0615 |

Publication: ICLR 2021 |

||

|

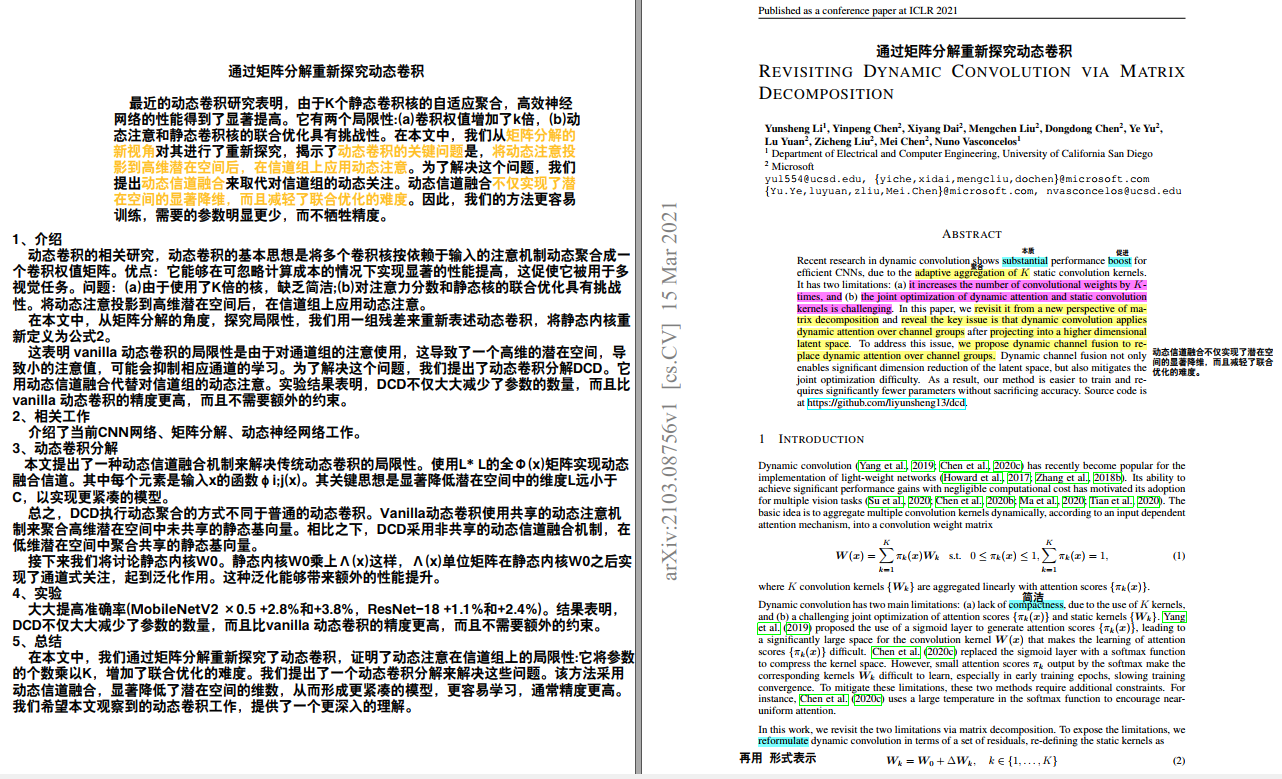

Title: Revisiting Dynamic Convolution via Matrix Decomposition Participants: Yunsheng Li, Yinpeng Chen, Xiyang Dai, Mengchen Liu, Dongdong Chen, Ye Yu, Lu Yuan, Zicheng Liu, Mei Chen, Nuno Vasconcelos |

|||

|

Aim: 动态卷积的基本思想是将多个卷积核按依赖于输入的注意机制动态聚合成一个卷积权值矩阵。解决动态卷积的关键问提:将动态注意投影到高维潜在空间后,在信道组上应用动态注意。 |

Research Question: 问题:(a)由于使用了K倍的核,缺乏简洁;(b)对注意力分数和静态核的联合优化具有挑战性。 在本文中,从矩阵分解的角度,探究局限性,我们用一组残差来重新表述动态卷积,将静态内核重新定义。 |

||

|

Method: 本文提出了一种动态信道融合机制来解决传统动态卷积的局限性。使用L*L的全Φ(x)矩阵实现动态融合信道。其中每个元素是输入x的函数φi;j(x)。其关键思想是显著降低潜在空间中的维度L远小于C,以实现更紧凑的模型。 总之,DCD执行动态聚合的方式不同于普通的动态卷积。Vanilla动态卷积使用共享的动态注意机制来聚合高维潜在空间中未共享的静态基向量。相比之下,DCD采用非共享的动态信道融合机制,在低维潜在空间中聚合共享的静态基向量。 接下来我们将讨论静态内核W0。静态内核W0乘上Λ(x)这样,Λ(x)单位矩阵在静态内核W0之后实现了通道式关注,起到泛化作用。这种泛化能够带来额外的性能提升。

|

|||

|

Results: 大大提高准确率(MobileNetV2 ×0.5 +2.8%和+3.8%,ResNet-18 +1.1%和+2.4%)。 实验结果表明,DCD不仅大大减少了参数的数量,而且比vanilla 动态卷积的精度更高,而且不需要额外的约束。 |

Discussion:

|

||

|

Conclusion: 在本文中,我们通过矩阵分解重新探究了动态卷积,证明了动态注意在信道组上的局限性:它将参数的个数乘以K,增加了联合优化的难度。我们提出了一个动态卷积分解来解决这些问题。该方法采用动态信道融合,显著降低了潜在空间的维数,从而形成更紧凑的模型,更容易学习,通常精度更高。 |

Further: 我们希望我们的工作提供了对动态卷积的一个更深入的理解。 |

||

|

Ref: 类似于之前阅读的有关卷积算子相关论文以及之前汇报笔记。

|

|||

浙公网安备 33010602011771号

浙公网安备 33010602011771号