0609 每日文献阅读 打卡

|

Read Data:0609 |

Publication: CVPR 2021 |

||

|

Title: EfficientNetV2: Smaller Models and Faster Training Participants: Mingxing Tan , Quoc V. Le |

|||

|

Aim: 在保持参数效率的同时提高训练速度。 |

Research Question: EfficientNet存在以下问题: (1)使用非常大的图像尺寸进行训练是缓慢的;(2)卷积深度在早期层是慢的。(3)同等地扩大每个阶段是次优的。 |

||

|

Method: 设计了一个添加Fused-MBConv的搜索空间,并应用NAS和缩放来联合优化模型精度、训练速度和参数大小。训练可以通过在训练过程中逐步增加图像大小来进一步加速。 对于第一个问题:一个简单的改进就是应用. FixRes (Touvron et al., 2019),通过使用较小的图像大小进行训练,而不是用于推理。如表2所示,图像尺寸越小,计算量越少,批量越大,训练速度提高2.2倍。 对于第二个问题,在1-3阶段早期应用fuse- mbconv可以提高训练速度,在参数和FLOPs上的开销较小,但如果我们将所有块替换为fuse- mbconv(阶段1-7),则会显著增加参数和FLOPs,同时也会减慢训练速度。找到MBConv和fuse -MBConv这两个构建块的正确组合并非易事,这促使我们利用神经结构搜索来自动搜索最佳组合。 对于第三个问题,稍微修改了缩放规则,并将最大图像大小限制为一个较小的值。 |

|||

|

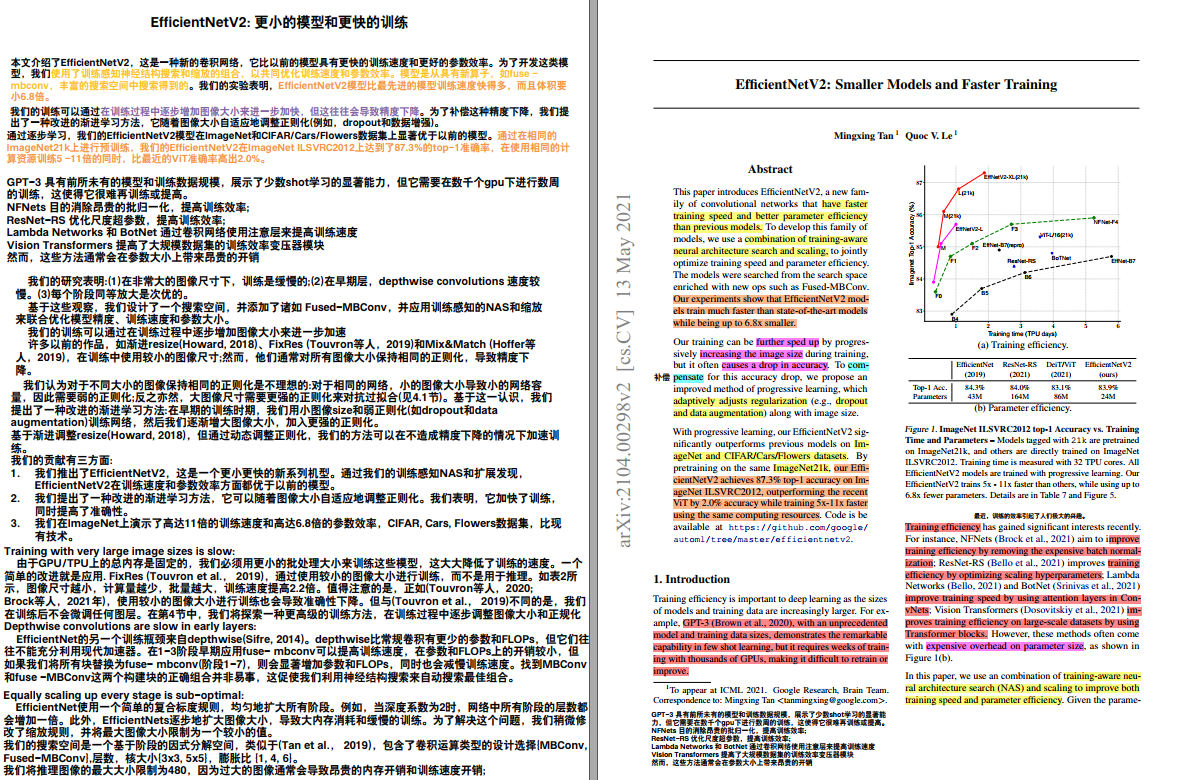

Results: 通过在相同的ImageNet21k上进行预训练,我们的EfficientNetV2在ImageNet ILSVRC2012上达到了87.3%的top-1准确率,在使用相同的计算资源训练5 -11倍的同时,比最近的ViT准确率高出2.0%,而体积小了6.8倍。 |

Discussion:

|

||

|

Conclusion: 本文提出了高效网络v2,一个新的家族更小和更快的图像识别神经网络。我们的EfficientNetV2通过训练感知NAS和模型缩放进行了优化,显著优于以前的模型,同时在参数方面速度更快、效率更高。为了进一步加快训练速度,我们提出了一种改进的渐进学习方法,在训练过程中共同增加图像大小和正则化。 |

Further:

|

||

|

Ref: 贡献:

|

|||

浙公网安备 33010602011771号

浙公网安备 33010602011771号