0608 每日文献阅读 打卡

|

Read Data:0608 |

Publication: CVPR 2020 |

||

|

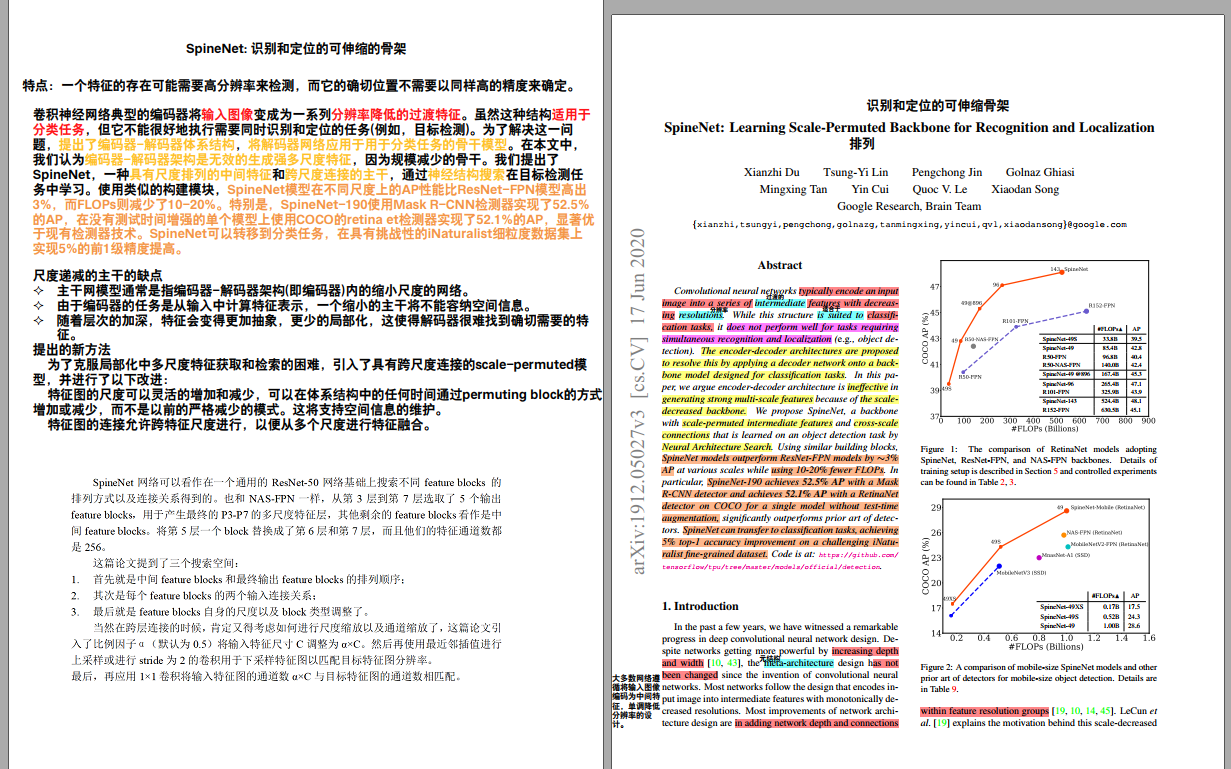

Title: SpineNet: Learning Scale-Permuted Backbone for Recognition and Localization Participants: Xianzhi Du, Tsung-Yi Lin, Pengchong Jin, Golnaz Ghiasi, Mingxing Tan, Yin Cui, Quoc V. Le, Xiaodan Song |

|||

|

Aim: 回答:缩尺模型是同时识别和定位的良好主干架构设计?直观上来说,一个缩减规模的骨干通过下采样扔掉空间信息,使解码网络的恢复具有挑战性。 |

Research Question: 卷积神经网络典型的编码器将输入图像变成为一系列分辨率降低的过渡特征。虽然这种结构适用于分类任务,但它不能很好地执行需要同时识别和定位的任务(例如,目标检测)。 |

||

|

Method: SpineNet网络可以看作在一个通用的ResNet-50网络基础上搜索不同feature blocks的排列方式以及连接关系得到的。也和NAS-FPN一样,从第3层到第7层选取了5个输出feature blocks,用于产生最终的P3-P7的多尺度特征层,其他剩余的feature blocks看作是中间feature blocks。将第5层一个block替换成了第6层和第7层,而且他们的特征通道数都是256。 这篇论文提到了三个搜索空间:

当然在跨层连接的时候,肯定又得考虑如何进行尺度缩放以及通道缩放了,这篇论文引入了比例因子α(默认为0.5)将输入特征尺寸C调整为α×C。然后再使用最近邻插值进行上采样或进行stride为2的卷积用于下采样特征图以匹配目标特征图分辨率。 最后,再应用1×1卷积将输入特征图的通道数α×C与目标特征图的通道数相匹配。 |

|||

|

Results: SpineNet模型在不同尺度上的AP性能比ResNet-FPN模型高出3%,而FLOPs则减少了10-20%。特别是,SpineNet-190使用Mask R-CNN检测实现了52.5%的AP,在没有测试时间增强的单个模型上使用COCO的retinanet检测实现了52.1%的AP,显著优于现有检测器技术。SpineNet可以转移到分类任务,在具有挑战性的iNaturalist细粒度数据集上实现5%的前1级精度提高。 |

Discussion:

|

||

|

Conclusion: 在本研究中,我们发现传统的缩小比例模型,即使有译码网络,也不能有效地同时识别和定位。为了解决这个问题,我们提出了一个新的元架构——可伸缩的模型。为了提高可伸缩模型的效率,通过神经结构搜索学习了SpineNet在目标检测中的应用,并证明了它可以直接用于图像分类。通过在COCO测试开发上实现52.1%的AP, SpineNet显著优于现有检测器技术。同样的SpineNet架构在ImageNet上实现了可与之媲美的前1级精度,在具有挑战性的iNaturalist数据集上实现了5%的前1级精度提升。 |

Further: 在未来,我们希望这个可伸缩的模型将成为超越检测和分类的许多可视化任务的主干的元架构设计。 |

||

|

Ref: 在检测方面影响重大,是个人认为是第一篇将NAS运用在检测上。 这篇论文的特点是受“一个特征的存在可能需要高分辨率来检测,而它的确切位置不需要以同样高的精度来确定”启发的。 |

|||

浙公网安备 33010602011771号

浙公网安备 33010602011771号