对于机器学习初学者来说,“神经网络”“TensorFlow”“Keras” 这些词可能既陌生又神秘。别担心,这篇文章会把每个概念拆成 “大白话 + 实操”,让你从底层逻辑到实战落地,彻底搞懂神经网络和工具链!

一、神经网络:模仿人脑的 “数学结构”

简单来说,神经网络是由大量 “模拟神经元” 组成的分层结构,它通过 “学习数据中的模式” 来完成预测、分类等任务。我们可以把它类比成 “工厂流水线”:

- 输入层:接收 “原材料”(比如图片像素、文本编码);

- 隐藏层:多道 “加工工序”(对数据做层层变换,是模型 “智能” 的核心);

- 输出层:产出 “成品”(比如判断 “这是猫”“那是狗”,或预测 “明天股价涨 3%”)。

1. 神经元:神经网络的 “最小单元”

一个神经元的计算逻辑是:**加权求和 + 激活函数。

- 「加权求和」:把输入数据按 “重要性”(权重w)相加,再加上一个 “偏差b”,公式是 z = w₁x₁ + w₂x₂ + ... + wₙxₙ + b;

- 「激活函数」:给结果加一层 “非线性变换”,让神经元能学习复杂模式,公式是 a = f(z)。

举个例子:判断 “是不是猫” 时,“有胡须”“耳朵尖” 这些特征是输入x,模型会给这些特征分配权重w(比如 “胡须” 的权重很高),加权求和后通过激活函数输出 “是猫的概率”。

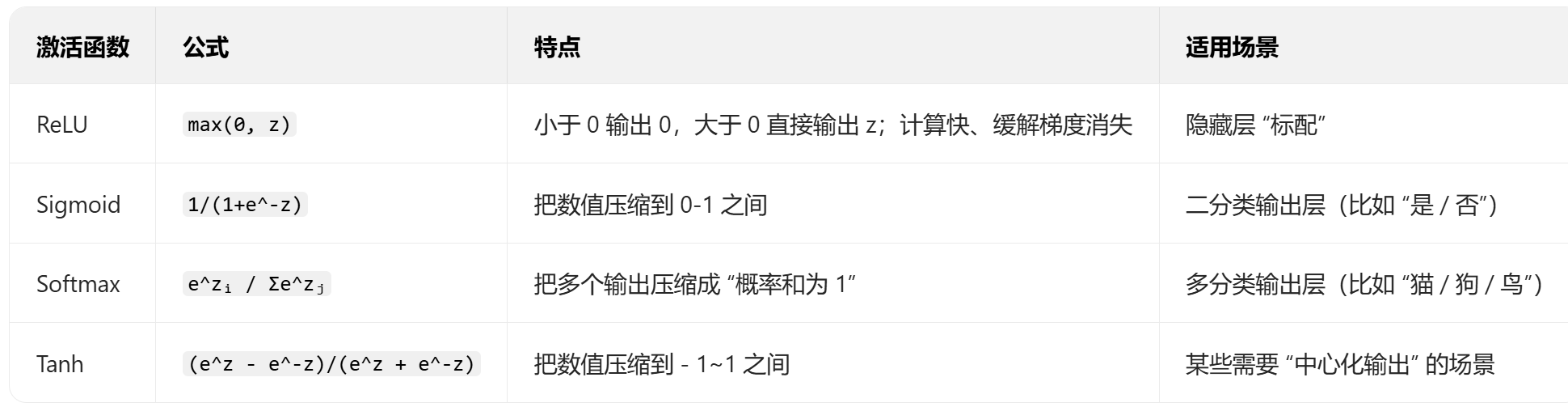

2. 激活函数:让神经元 “会思考” 的关键

如果没有激活函数,多层神经网络会退化成 “单层线性模型”,根本学不会复杂规律。常见激活函数及作用:

3. 层:神经元的 “组织形式”

神经网络的层是 “神经元的集合”,常见层类型:

- 全连接层(Dense):层内每个神经元都和上一层所有神经元连接(最基础的层,用于 “综合所有特征”);

- 卷积层(Conv):专门处理图像,擅长 “提取空间特征”(比如识别 “边缘”“纹理”);

- 循环层(LSTM/GRU):专门处理序列数据(比如文本、时间序列,擅长 “记忆上下文”)。

二、TensorFlow 与 Keras:神经网络的 “施工工具”

- TensorFlow:底层 “钢筋水泥”,负责处理 “张量计算、数据流图、自动微分” 这些核心逻辑;

- Keras****:上层 “预制板”,把 TensorFlow 的复杂逻辑封装成简单 API,让你几行代码就能搭神经网络。

1. 张量(Tensor):神经网络的 “数据载体”

张量就是 “多维数组”,是神经网络中数据的存在形式:

- 0 维张量:标量(比如 “1”“3.14”);

- 1 维张量:向量(比如[1,2,3],可以表示 “一个样本的多个特征”);

- 2 维张量:矩阵(比如[[1,2],[3,4]],可以表示 “多个样本的多个特征”);

- 3 维张量:序列(比如[[[1],[2]],[[3],[4]]],可以表示 “文本的词嵌入序列”);

- 4 维张量:图像(比如[batch, height, width, channel],batch是批量大小,channel是通道数,RGB 图是 3)。

2. 数据流图(Data Flow Graph):神经网络的 “施工蓝图”

TensorFlow 把计算过程拆成 **“节点(操作)” 和 “边(张量)”:

- 节点:代表一个计算(比如 “矩阵乘法”“激活函数”);

- 边:代表张量,数据沿着边在节点之间流动,最终完成整个神经网络的计算。

可以想象成 “工厂流水线”:每个工位(节点)处理原料(张量),产出半成品再传给下一个工位,直到产出最终模型。

3. 自动微分(Automatic Differentiation):神经网络的 “学习引擎”

训练神经网络时,需要不断调整 “权重w和偏差b” 来降低 “预测错误”。这一步需要计算 “损失函数对参数的导数(梯度)”,而自动微分就是让 TensorFlow“自动帮你算导数”,不用手动推导复杂的数学公式。

比如,模型预测 “这是猫” 但实际是 “狗”,自动微分能算出 “每个权重改多少,能让预测更准确”,然后通过 “优化器” 更新权重 —— 这个过程就是 “学习”。

三、Keras 的两种模型:Sequential 与 Model 类

Keras 提供了两种搭建神经网络的方式,覆盖从 “简单到复杂” 的所有场景。

1. Sequential 模型:“线性堆叠” 的新手友好型

适合 “层与层之间无分支、无多输入多输出” 的简单场景,像 “搭积木” 一样一层一层往上堆。

实战:用 Sequential 做 “波士顿房价预测”(回归任务)

import tensorflow as tf

from tensorflow.keras import datasets, layers, models

# 1. 加载数据集(波士顿房价是经典回归数据集)

boston_housing = datasets.boston_housing.load_data()

(train_features, train_labels), (test_features, test_labels) = boston_housing

# 2. 数据预处理:归一化(让不同特征的数值范围一致,模型训练更稳定)

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

train_features = scaler.fit_transform(train_features)

test_features = scaler.transform(test_features)

# 3. 搭建Sequential模型

model = models.Sequential([

layers.Dense(64, activation='relu', input_shape=(train_features.shape[1],)), # 输入层+隐藏层1

layers.Dense(32, activation='relu'), # 隐藏层2

layers.Dense(1) # 输出层(回归任务,无激活函数,直接输出预测房价)

])

# 4. 编译模型:指定优化器、损失函数、评估指标

model.compile(

optimizer='adam', # 常用优化器,兼顾收敛速度和稳定性

loss='mse', # 回归任务用“均方误差”衡量预测值和真实值的差距

metrics=['mae'] # 平均绝对误差,直观看预测和真实值的平均差距

)

# 5. 训练模型:epochs是“把训练集完整过几遍”,batch_size是“每次训多少样本”

history = model.fit(

train_features, train_labels,

epochs=100,

batch_size=32,

validation_split=0.2, # 从训练集中拆20%当验证集,看模型是否过拟合

verbose=1 # 打印训练过程

)

# 6. 评估模型

test_loss, test_mae = model.evaluate(test_features, test_labels)

print(f"测试集上的平均绝对误差:{test_mae:.2f}(单位:千美元)")

# 7. 预测示例

sample = test_features[0:1] # 取一个测试样本

predicted_price = model.predict(sample)

print(f"模型预测房价:{predicted_price[0][0]:.2f} 千美元")

print(f"真实房价:{test_labels[0]:.2f} 千美元")

2. Model 类模型(函数式 API):“自由拼接” 的高手进阶型

适合 “多输入、多输出、层之间有分支” 的复杂场景(比如残差网络、多模态融合)。

实战:用 Model 类做 “多输入文本分类”(模拟场景:结合 “标题 + 正文” 判断新闻类别)

from tensorflow.keras import Input, layers, Model

import numpy as np

# 模拟数据:标题(短文本,用100维向量表示)、正文(长文本,用300维向量表示)、类别(0-4共5类)

n_samples = 1000

title = np.random.rand(n_samples, 100)

content = np.random.rand(n_samples, 300)

labels = np.random.randint(0, 5, n_samples)

# 1. 定义两个输入层

title_input = Input(shape=(100,), name='title_input') # 标题输入,命名方便后续识别

content_input = Input(shape=(300,), name='content_input') # 正文输入

# 2. 分别处理两个输入

title_emb = layers.Dense(64, activation='relu')(title_input)

content_emb = layers.Dense(128, activation='relu')(content_input)

# 3. 融合两个输入的特征

merged = layers.Concatenate()([title_emb, content_emb]) # 拼接特征

merged = layers.Dense(64, activation='relu')(merged)

# 4. 输出层

output = layers.Dense(5, activation='softmax', name='category_output')(merged)

# 5. 组装成Model类模型

model = Model(

inputs=[title_input, content_input],

outputs=output

)

# 6. 编译模型

model.compile(

optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy']

)

# 7. 训练模型

model.fit(

[title, content], # 传入两个输入

labels,

epochs=10,

batch_size=32,

validation_split=0.2

)

# 8. 预测示例

sample_title = title[0:1]

sample_content = content[0:1]

pred = model.predict([sample_title, sample_content])

print(f"类别预测概率:{pred[0]}")

print(f"预测类别:{np.argmax(pred[0])}")

print(f"真实类别:{labels[0]}")

四、神经网络训练的 “核心逻辑”:损失、优化与迭代

很多初学者会卡在 “模型为什么能‘学习’” 这个点上,我们用 “房价预测” 的例子拆解一遍:

- 损失函数(Loss Function):衡量 “模型预测值和真实值的差距”。比如回归任务用 MSE(均方误差),分类任务用交叉熵。损失越大,模型越差。

- 优化器(Optimizer):根据 “损失函数的梯度” 调整模型的 “权重w和偏差b”,目标是 “最小化损失”。常用的优化器是 Adam(结合了动量和自适应学习率,收敛快且稳定)。

3.** 迭代训练(Epoch & Batch)**:

- Epoch:把整个训练集完整训练一遍;

- Batch:把训练集拆成 “小批量”,每次只训一个 Batch(这样更高效,也能模拟 “在线学习” 的场景)。

五、初学者避坑指南

- 数据预处理是 “重中之重”:

- 数值特征要归一化 / 标准化(比如房价、收入这些差距大的特征);

- 分类特征要做独热编码(比如 “男 / 女” 转成[1,0]或[0,1]);

- 缺失值要合理填充(比如用均值、中位数,或专门的缺失值模型)。

- 警惕 “过拟合”:

- 过拟合表现:训练集准确率 99%,测试集准确率 50%;

- 解决方法:加 dropout 层(随机让部分神经元不工作,增强泛化能力)、增大数据量、减少模型复杂度。

- 耐心调参,但别 “盲目调”:

- 先固定模型结构,调学习率(太大不收敛,太小训练慢);

- 再调batch_size(太大内存不够,太小训练波动大);

- 最后调隐藏层数量、神经元数量(从简单到复杂逐步尝试)。

总结

神经网络的本质是 “分层的神经元结构”,TensorFlow 和 Keras 是帮你快速实现它的工具。从 Sequential 的 “线性堆叠” 到 Model 类的 “自由拼接”,从回归到分类再到多输入任务,你可以从简单案例开始,逐步挑战复杂场景。

记住:机器学习是 “实践出真知” 的领域,把上面的代码跑通、改改参数、换个数据集,你就能在实战中不断加深理解。现在就动手试试吧,就会发现神经网络其实没那么难!

浙公网安备 33010602011771号

浙公网安备 33010602011771号