hadoop集群搭建

为什么要安装hadoop

hadoop是一个大数据处理的生态,主要包括存储(HDFS)、计算(MapReduce)、资源调度(Yarn)三个部分,在spark中需要用到HDFS和YARN,以保证spark在分布式文件存储和资源调度方面更好地协调。

hadoop集群的安装

1、下载spark对应的hadoop版本的安装包

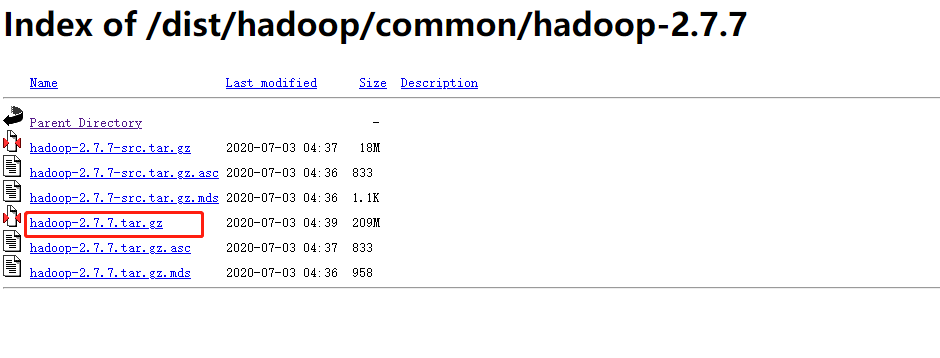

因为我spark版本为spark-3.1.1-bin-hadoop2.7.7-tgz,这里可以看到匹配的hadoop版本为2.7.7所以直接官网下载。

2、解压安装到master主机上

当然如果没有JDK环境的可以参考spark安装中的JDK环境搭建,安装好之后就可以直接用Xftp工具发送到master主机上

用上面语句解压到当前路径

浙公网安备 33010602011771号

浙公网安备 33010602011771号