一.战略挑战:当前数据工作流程的瓶颈与高昂成本

数据是驱动现代企业分析、决策与创新的核心引擎,而数据管道正是确保数据在企业内部高效、可靠流动的关键基础设施。然而,我们当前依赖手动配置和维护的数据工作流程,正面临着日益严峻的效率瓶颈和成本压力,这已成为制约我们业务敏捷性和增长潜力的战略性障碍。

基于对行业实践的深入研究,当前数据管道的开发与维护流程中存在以下几个核心痛点,其影响已被精确量化:

• 极高的人力资源消耗: 研究表明,数据工程师将超过60%3到5小时的高度集中的手动工作。这意味着我们宝贵的工程技术人才,大部分时间被消耗在重复性、低附加值的任务中,而非战略性的数据创新。

• 流程的内在复杂性: 数据工程师必须对源数据的模式(schema)有深刻的理解,才能编写出满足业务需求的复杂数据转换查询。这一过程不仅耗时,且高度依赖个人经验,难以规模化复制,并带来了潜在的错误风险。

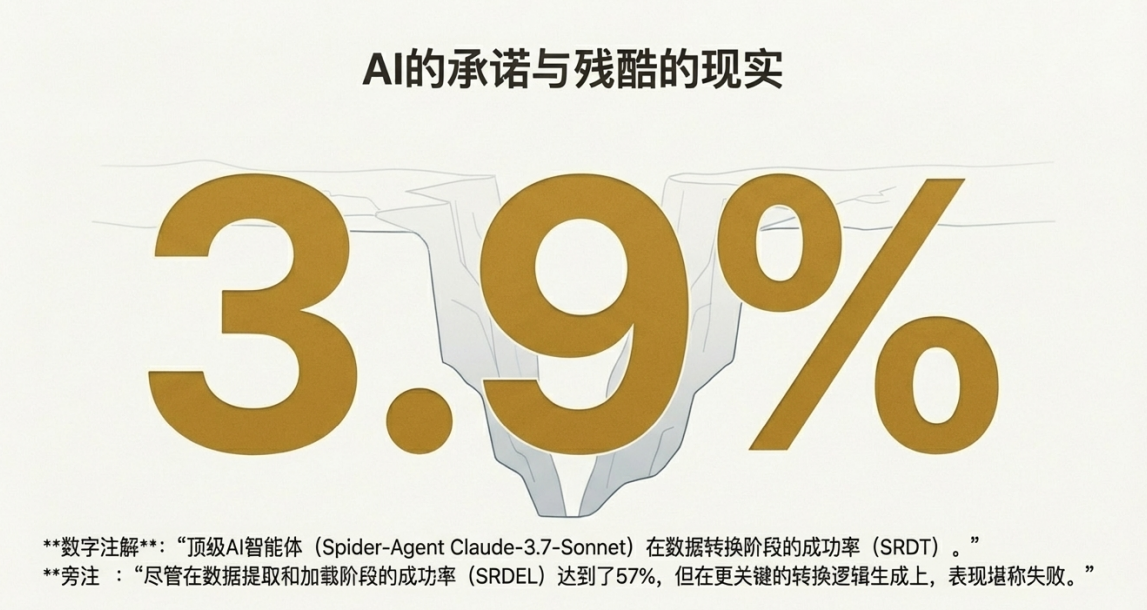

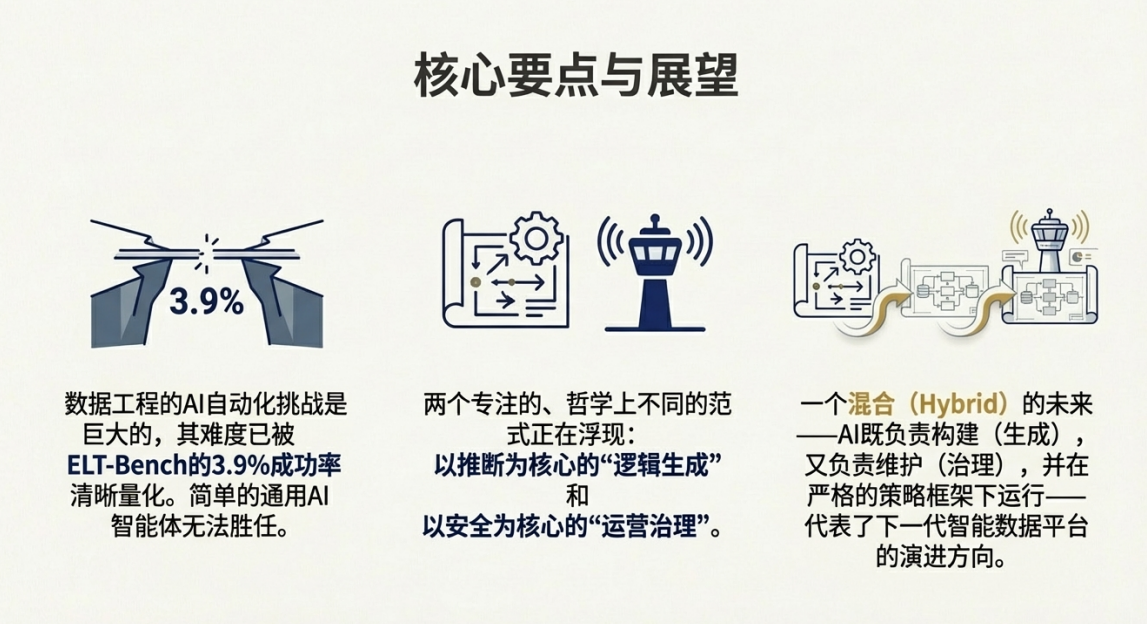

• 现有AI自动化的显著局限性: 尽管人工智能(AI)在许多领域取得了进展,但在核心的数据工程任务上仍力不从心。ELT-Bench的一项基准测试显示,即便是当前表现最佳的AI智能体(Spider-Agent Claude-3.7-Sonnet),在最关键的数据转换阶段,成功率也仅为3.9%。更值得注意的是,为了达成这极低的成功率,AI智能体完成每个管道的平均成本为$4.30美元,并需执行多达89.3个步骤。这一数据清晰地表明,现有的通用AI工具远未成熟到可以有效解决核心挑战的程度。

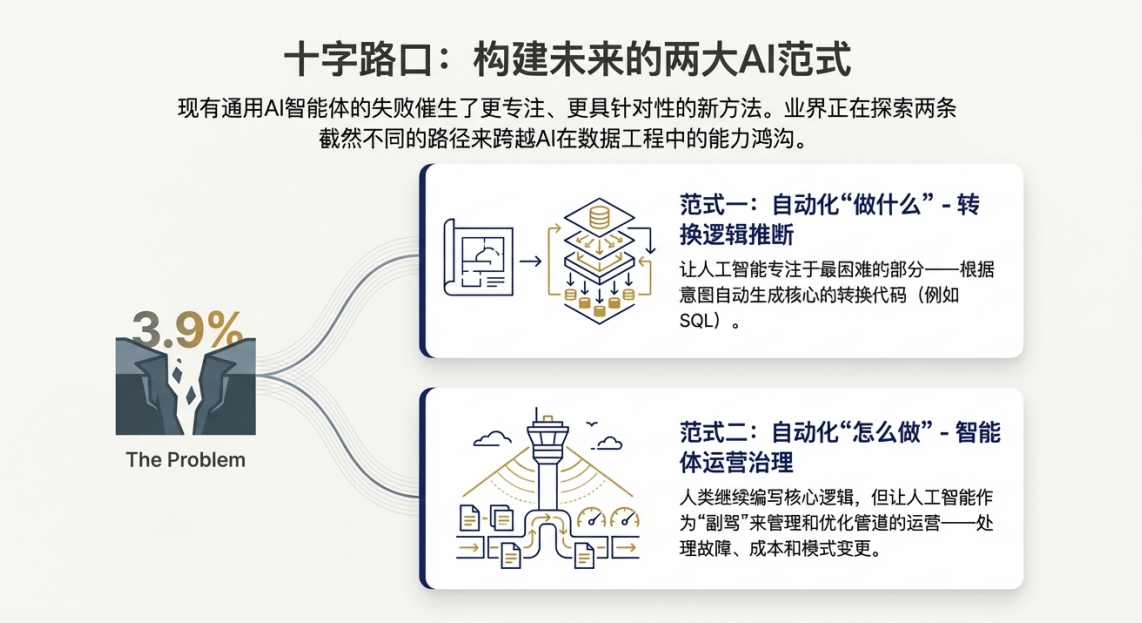

这些效率低下问题不仅是技术挑战,它们直接转化为高昂的运营成本、迟缓的业务响应速度和被抑制的创新能力。现有通用AI智能体的灾难性表现证明,我们需要的不是一个简单的AI助手,而是一个从根本上重新设计的、由策略驱动并内置专业能力的自动化系统,以突破当前的战略困局。

二.技术新范式:策略驱动的控制平面与自主化转换引擎的整合

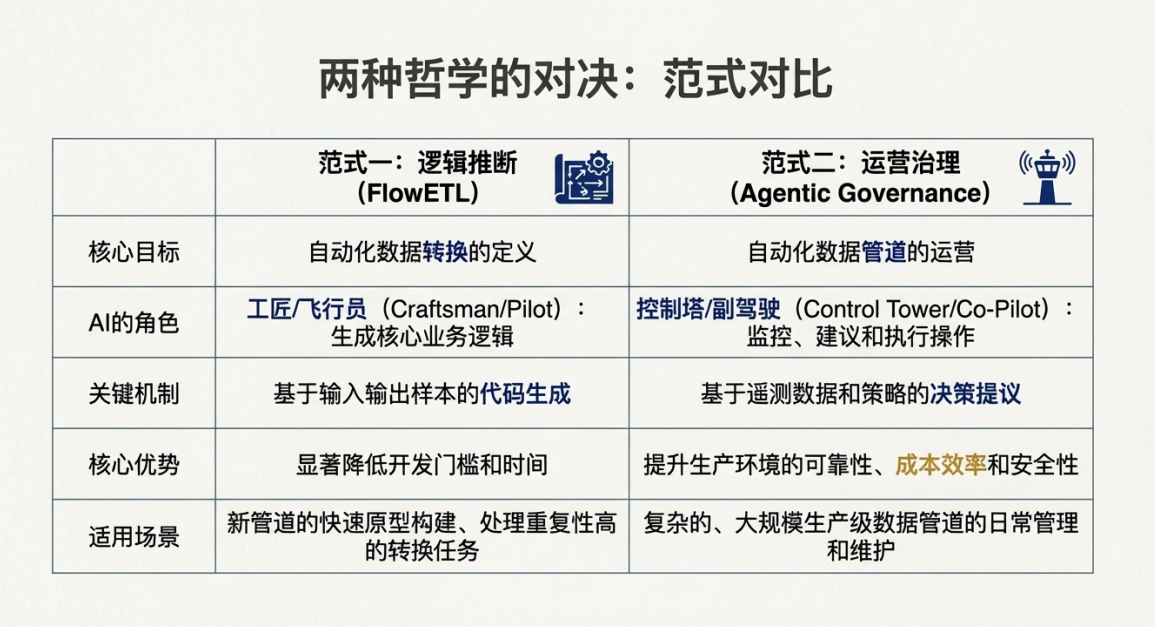

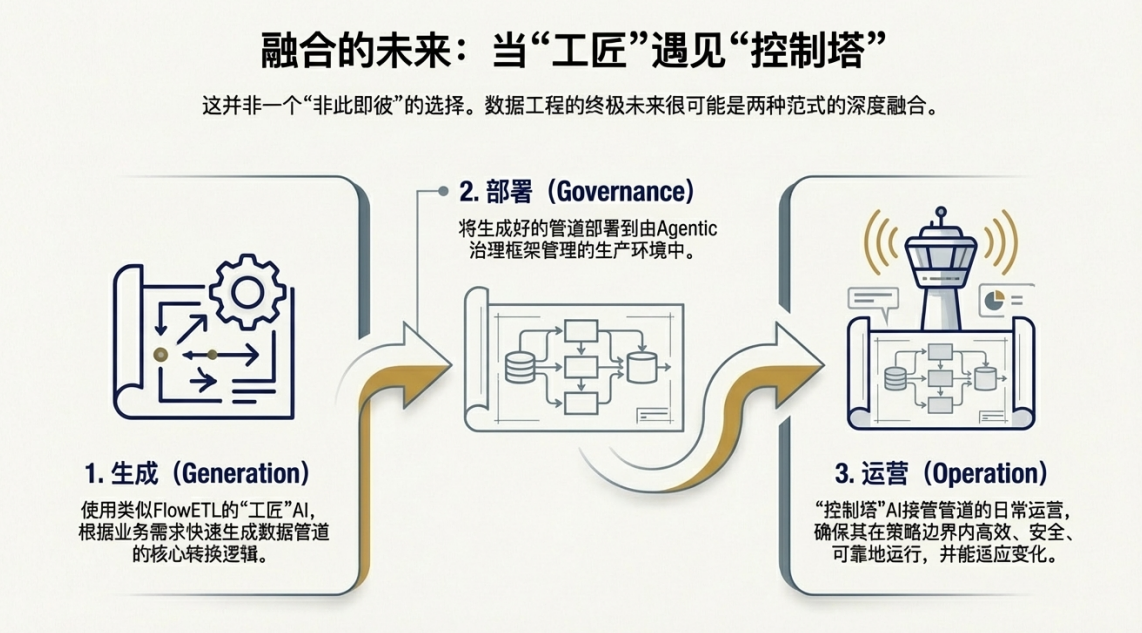

为应对上述根本性挑战,我们需要构建一个集智能治理与高效执行于一体的整体解决方案。这一全新范式包含两个核心组件:一个策略感知的智能“控制平面”,用于管理整个数据管道的生命周期;以及一个强大的自主“转换引擎”,用于处理复杂的数据转换任务。二者结合,将实现从被动的手动管理到主动的、由策略引导的自动化治理的战略转变。

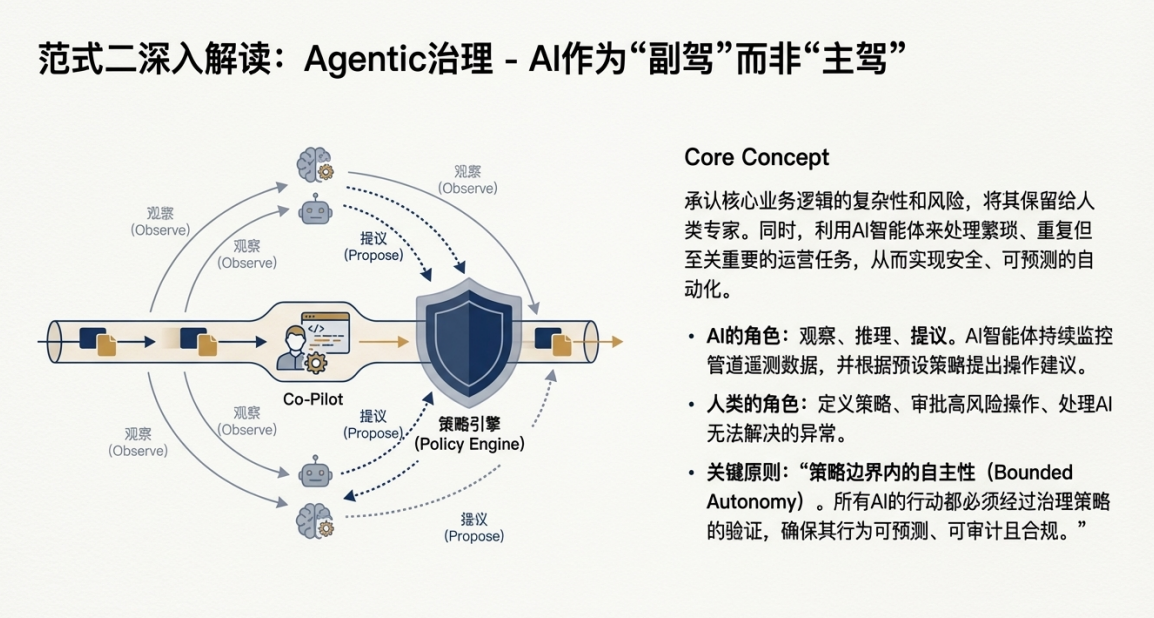

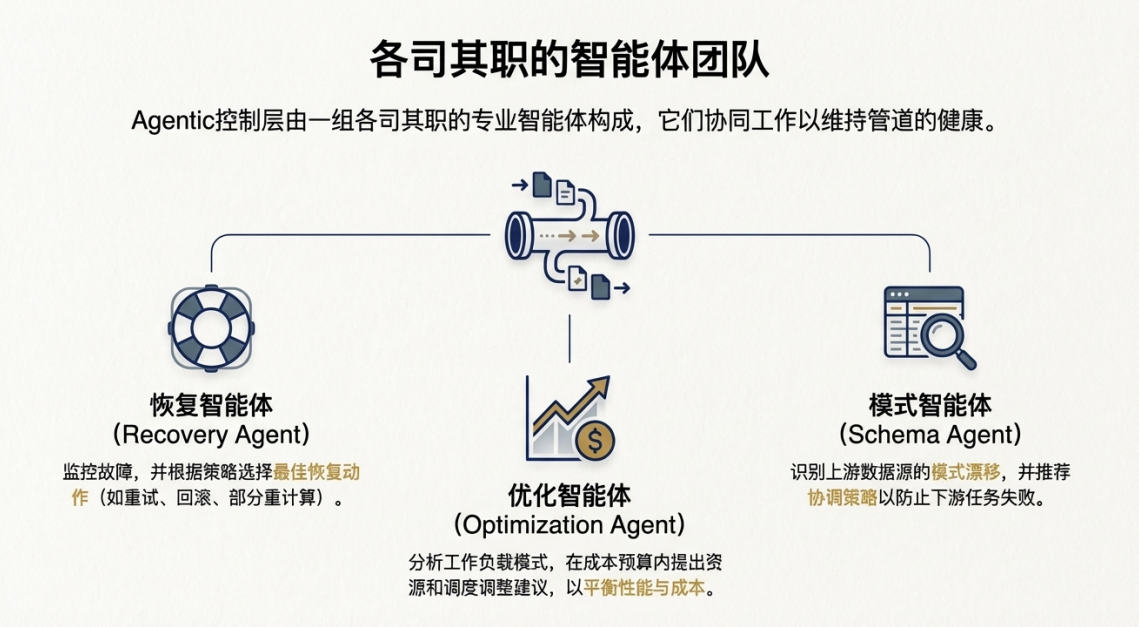

• 策略感知的智能代理控制 (Agentic Cloud Data Engineering) 这是一种顶层的治理与控制框架。它通过一系列专门的AI代理(如恢复代理、优化代理、模式代理)构成一个智能“控制平面”,主动监控数据管道的运行状态。这些代理能够基于实时遥测数据进行推理,并提出具体的操作建议,例如资源调整、故障恢复或模式变更。其核心优势在于,所有代理提出的行动方案都必须经过预设的治理策略验证,确保其行为不仅智能,而且完全可预测、可审计且符合合规要求。这从架构层面解决了通用AI工具在企业环境中不可控、不安全的根本性风险,确保了自动化行为的可靠性。

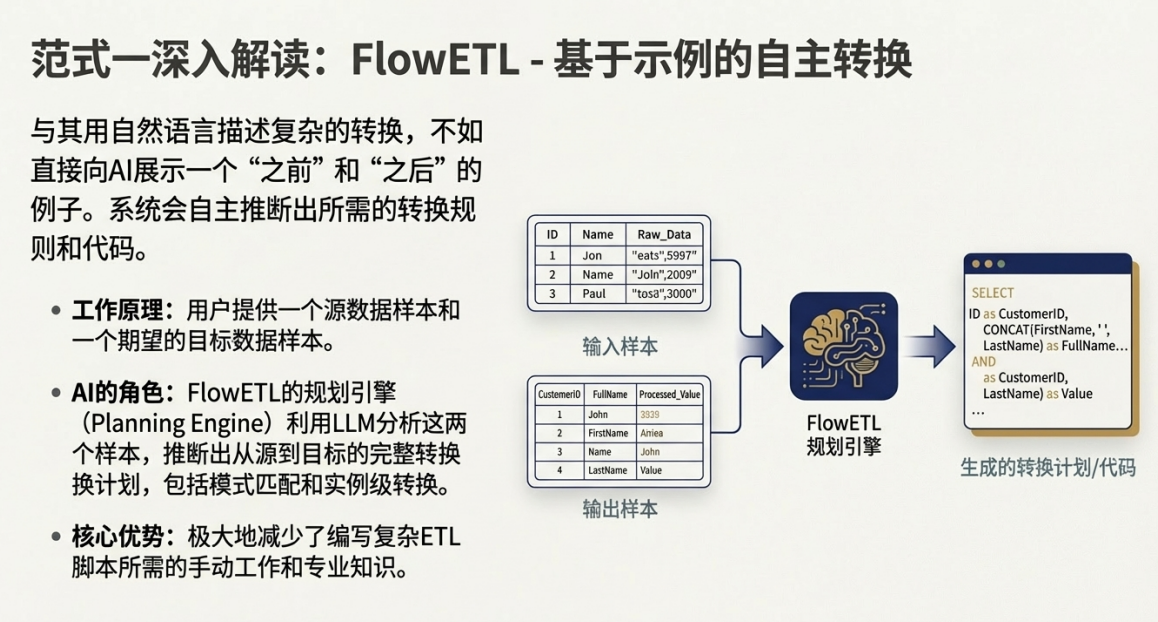

• 自主化、范例驱动的ETL (FlowETL) 这是在智能控制平面内部运行的高效转换引擎。FlowETL架构提出了一种革命性的工作方式:开发人员不再需要手动编写复杂的转换逻辑,只需提供一个简洁的“输入-输出”范例,系统便能自主推断并执行所需的数据转换。这种“范例驱动”的核心理念旨在最大限度地减少开发人员的直接干预,同时能够自动处理常见的缺失值、数值异常值、数据规范化和去重等数据质量问题,从而在提升效率的同时,确保了产出数据的清洁与可靠。

通过将FlowETL这类高效的自主转换引擎置于智能代理平台的治理框架之下,我们构建了一个既自动化又可控的端到端解决方案。这标志着数据管理正经历一场深刻的变革——从以“执行”为中心,向以“智能治理和自主优化”为中心的战略转变,为解锁前所未有的业务价值奠定了坚实的技术基础。

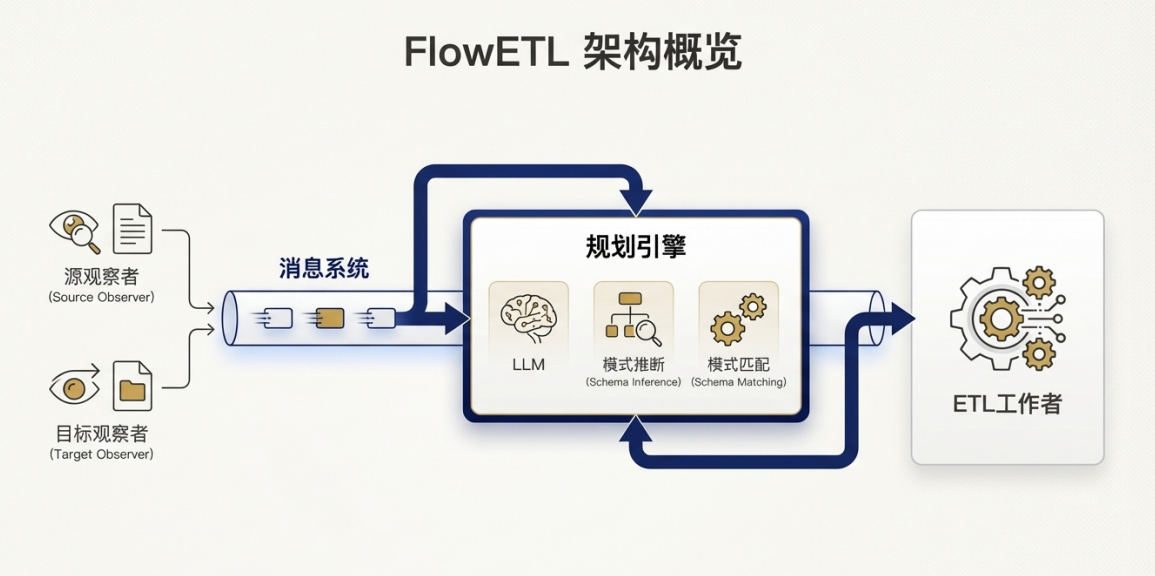

FlowETL:基于微服务和消息驱动的解耦架构

FlowETL采用了一种组件化、松散耦合的微服务架构,旨在实现高可扩展性和异步处理能力。其核心组件通过一个消息系统(如Apache Kafka)进行通信,实现了清晰的责任分离:

• Observers (数据观察者):监控指定位置,当检测到新的源文件和目标样本文件时,将它们的信息发布到消息系统。

• Planning Engine (规划引擎):订阅消息,消费源和目标样本。它是系统的“大脑”,负责推断转换逻辑并生成一个详细的执行计划。

• ETL Worker (执行单元):获取规划引擎生成的计划,并将其应用于完整的源数据集,执行实际的数据转换操作,最终将结果加载到目标位置。

• Messaging System (消息系统):作为各组件之间的通信总线,确保了系统的解耦和异步处理能力。

FlowETL的一个核心抽象是内部表示(Internal Representation - IR),这是一种受数据帧(Dataframe)启发的表格格式。无论输入数据是CSV还是嵌套的JSON文件,都会被统一转换为这种内部结构。对于JSON,系统会创建所有对象中键的并集来构成表头。该设计极大地简化了系统,使后续组件能够处理标准化的数据对象。这种解耦的、消息驱动的架构是生产级解决方案的物理体现。通过将职责分离到“规划引擎”和“ETL Worker”等专用组件中,FlowETL构建了一个可扩展、可维护、高韧性的“自动化工厂”,其设计目标是运营效率,而非AI代理测试。

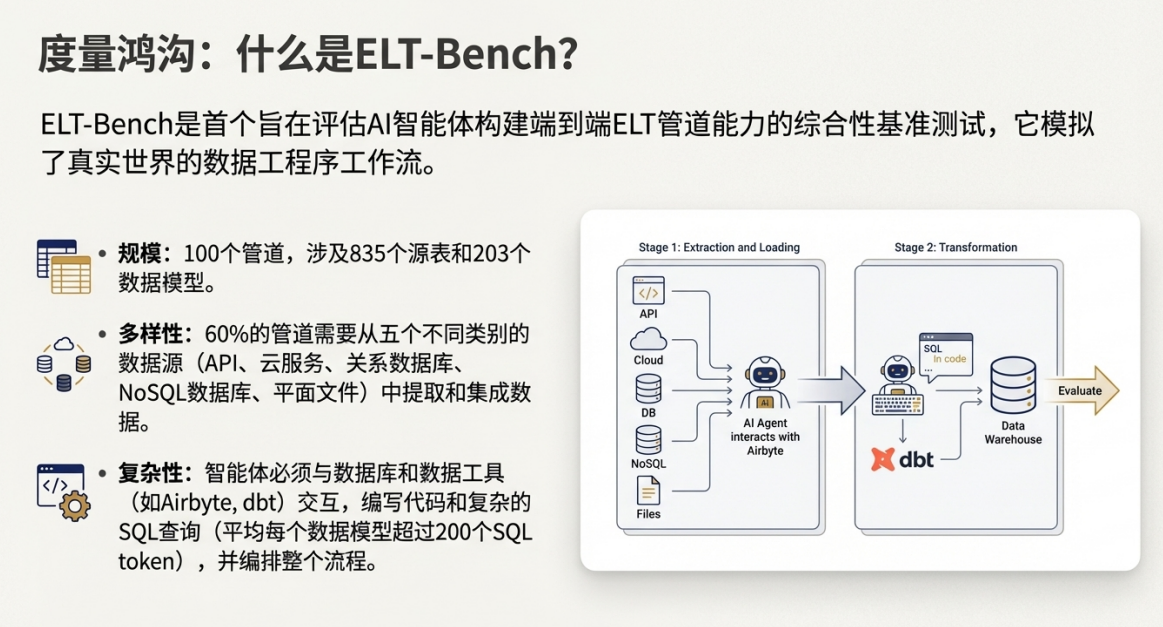

ELT-Bench:AI智能体的推理与行动循环

ELT-Bench所评估的AI智能体,其自动化机制遵循一种通用的“推理-行动”(Reason-Act)循环模式。在这种模式下,代理被赋予一个高级目标,然后需要自主地将目标分解为一系列具体步骤,并通过与环境交互来逐步完成。

在一个典型的ELT-Bench任务中,代理需要执行以下复杂序列:

1. 理解上下文:首先,代理必须仔细阅读并理解项目基础文件,如config.yaml(包含数据库连接信息)和data_model.yaml(定义了最终目标表的结构和逻辑)。

2. 工具配置:接着,代理需要查阅提供的文档,学习如何使用Terraform来配置Airbyte,正确设置多个异构数据源(如PostgreSQL、MongoDB、API等)的连接。

3. 逻辑实现:然后,也是最具挑战性的一步,代理需要根据data_model.yaml中的自然语言描述,编写出复杂的SQL查询。这些查询通常涉及多表连接、聚合、以及诸如RANK()这样的排名函数,其中73个管道的每个数据模型平均需要超过200个SQL token才能实现。

4. 执行与调试:最后,代理执行它生成的代码和命令,并根据命令行返回的输出(无论是成功信息还是错误堆栈)进行调试和修正,直到任务完成。

这种机制的挑战性在于,它极度依赖AI代理的代码生成、工具使用、长期规划和记忆能力。它并非针对ELT任务的特化设计,而是一种通用的、端到端的问题解决范式,试图让一个“黑盒”智能体学会成为一名数据工程师。

三.可量化的业务价值与战略优势

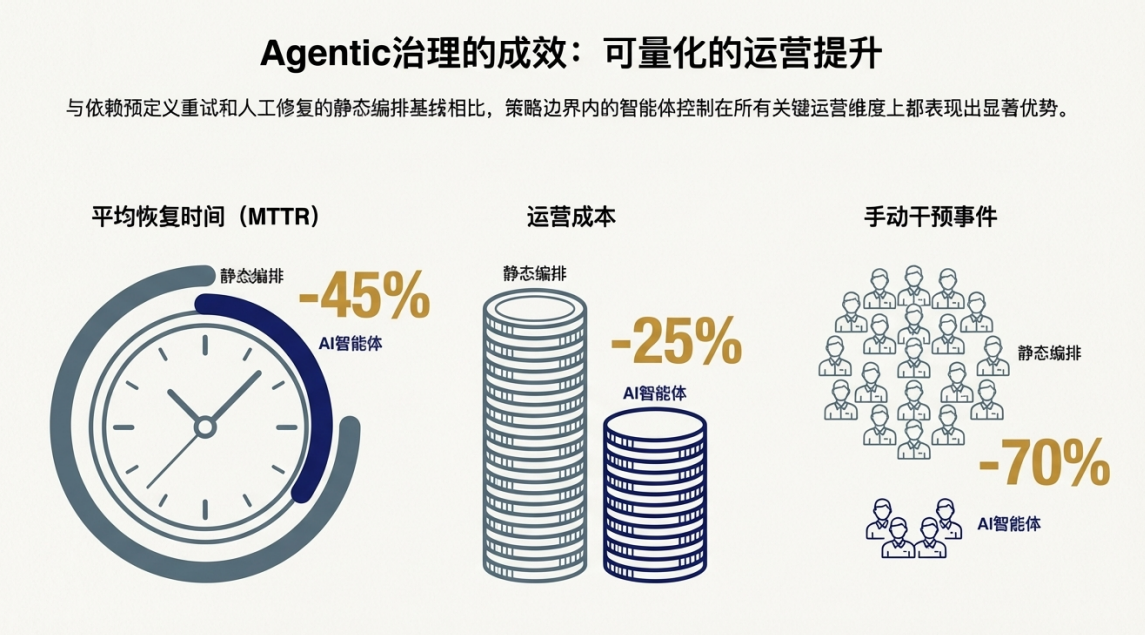

采用这一集成技术范式并非单纯的技术升级,而是一项能够带来明确、可衡量投资回报(ROI)的战略决策。其业务价值体现在运营效率、成本节约、系统可靠性和决策质量等多个维度。基于智能代理数据工程平台在企业级工作负载下的实验结果,其商业影响力已得到清晰的验证。

战略优势领域 | 量化提升成果 |

运营效率与人才优化 | 手动干预事件减少70%以上,将高价值工程师从故障修复中解放出来。 |

显著的成本节约 | 整体运营成本降低约25%,实现直接的财务回报。 |

可靠性与业务连续性 | 平均故障恢复时间(MTTR)缩短高达45%,保障数据服务的稳定性。 |

数据质量与决策敏捷性 | 数据新鲜度显著提升,保障高质量、高时效的数据供给。 |

这些数据点对业务的实际影响深远:

• 运营效率与人才优化: 手动干预需求降低超过70%,意味着我们的工程师团队可以彻底摆脱被动的“救火”模式,专注于数据架构优化、新数据产品开发等更高价值的创新活动。这不仅提升了团队士气,也最大化了我们的人才投资回报。

• 显著的成本节约: 25%的成本降低并非一次性节省,它代表了向更高效运营模式的根本性转变,能够释放可观的运营支出(OPEX),用于再投资于其他战略性数据项目和业务创新。这主要源于智能代理能够根据实时工作负载动态优化云资源,实现了成本与性能的最佳平衡。

• 可靠性与业务连续性: 平均故障恢复时间(MTTR)缩短45%,极大地降低了因数据服务中断而导致的业务风险。更快的故障恢复意味着更短的业务停顿和更高的数据可用性,从而显著增强下游业务部门对核心数据基础设施的信任。

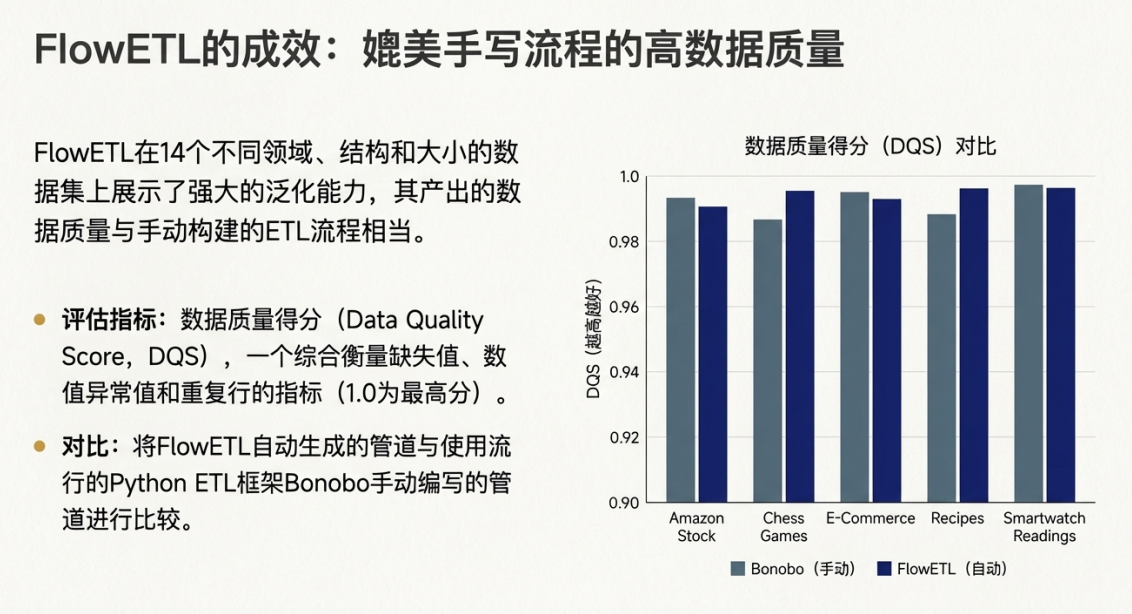

• 数据质量与决策敏捷性: 我们的策略治理框架通过改善数据新鲜度,确保了数据的时效性。同时,通过集成如FlowETL这类强大的转换引擎——其已被证实能够实现0.96至1.0之间的数据质量得分(DQS)——我们能确保交付的数据兼具高质量与高时效性。在瞬息万变的市场环境中,这正是实现敏捷决策、抢占市场先机的关键。

综上所述,这些优势共同构成了一个强有力的商业论证,证明投资于自动化与智能代理数据技术是推动公司数据能力现代化、构筑核心竞争力的必然选择。

四.战略建议与后续步骤

我们正面临一个关键的战略抉择:是继续承受当前数据流程所带来的高昂成本、低效率和创新迟滞,还是主动拥抱自动化与智能化技术,以此获得决定性的竞争优势。为了抓住这一机遇,我提议采取以下具体行动:

1. 批准战略投资: 恳请管理层批准对自动化与智能代理数据管道技术的战略性投资,将其作为公司数据基础设施现代化的核心优先事项。

2. 启动试点项目(Proof-of-Concept): 建议立即组建一个跨职能团队,选取一个具有代表性的业务场景,启动一个为期90天的试点项目。该项目旨在提供经验性的内部验证,证明该技术能直接解决我们在第一部分中识别的核心瓶颈。项目的成功将以实现我们预期的关键指标为衡量标准:手动干预减少70%、运营成本节约25%45%,从而为全面推广建立强有力的商业案例。

3. 评估与全面推广: 在试点项目结束后,我们将基于其量化成果、业务部门的反馈以及团队的学习经验进行全面评估。若成果符合预期,我们将制定一份详细的技术推广路线图,分阶段、分步骤地将该技术整合到公司的核心数据基础设施中,并最终实现规模化应用。

通过这项战略投资,我们将能够构建一个更具弹性、更高效、更智能的数据基础,它不仅是支撑当前业务的坚实后盾,更是驱动未来创新和增长的强大引擎。这将确保我们在新一轮的数字化竞争中,始终保持领先地位。

浙公网安备 33010602011771号

浙公网安备 33010602011771号