导言

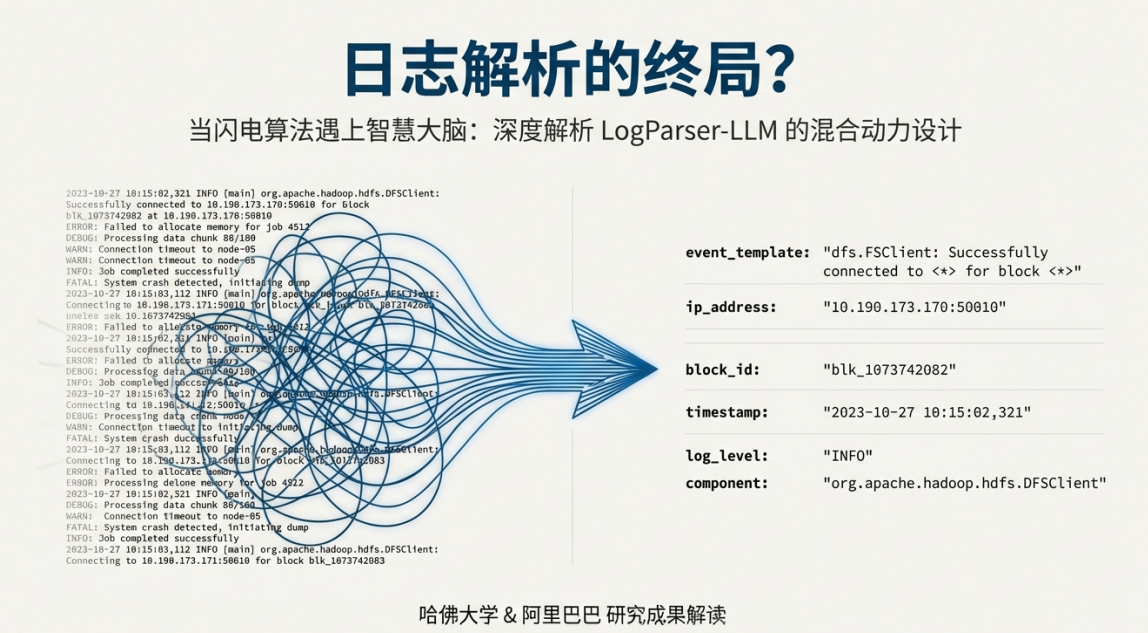

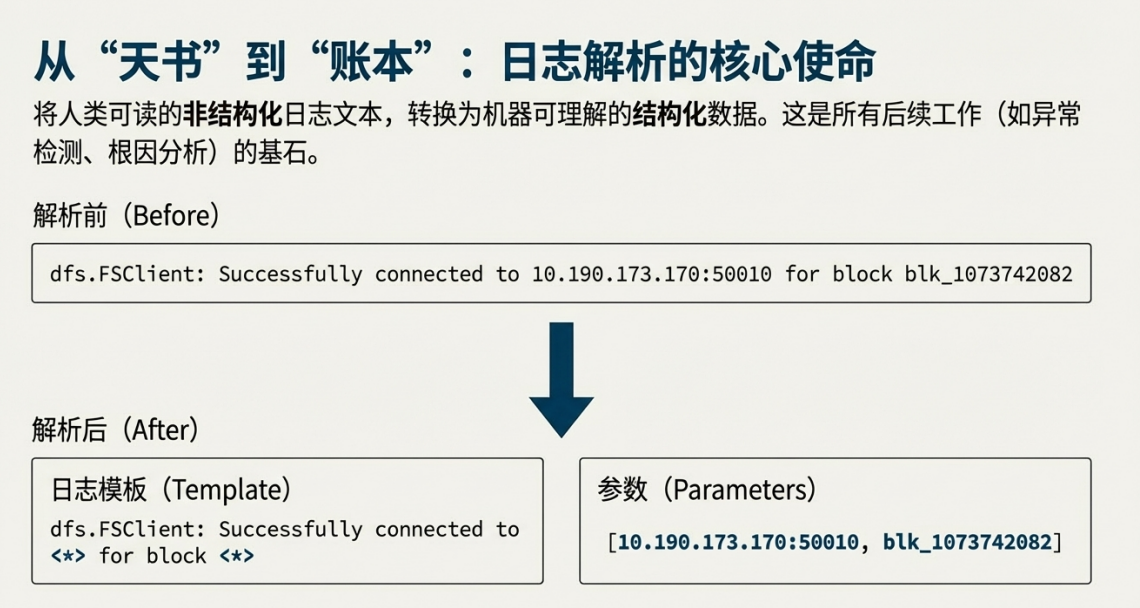

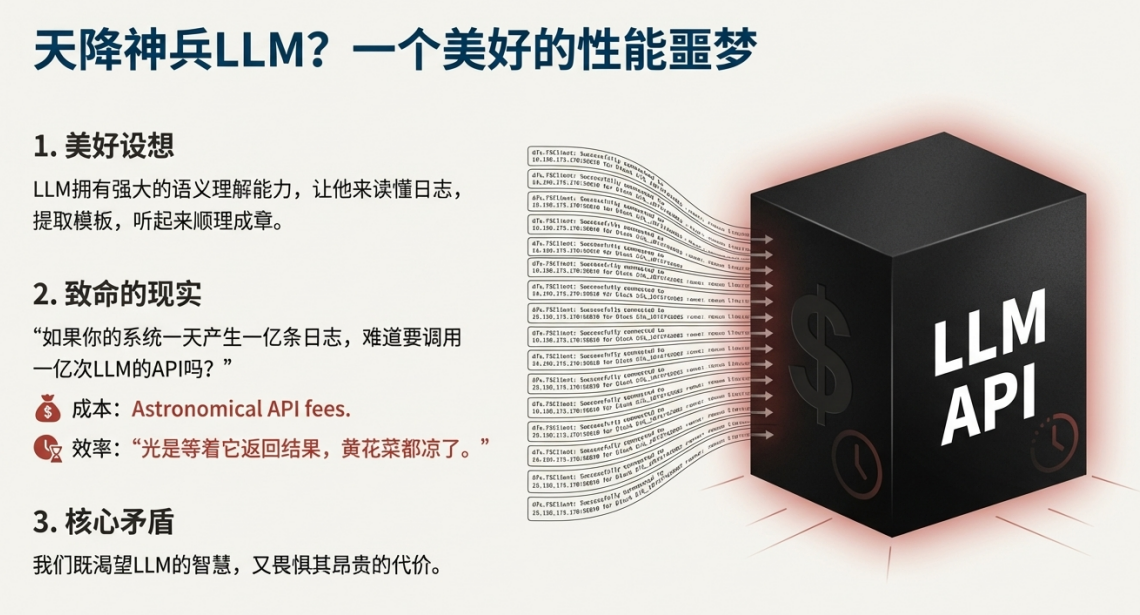

在当今的工程领域,我们普遍面临一个核心挑战:如何从海量的、非结构化的数据(如日志、配置文件、告警信息)中高效提取价值。这些数据是诊断系统故障、洞察系统行为的“救命稻草”,但其杂乱无章的格式对机器而言形同“天书”。大语言模型(LLM)的出现,以其前所未有的语义理解能力,为破解这一难题带来了希望。然而,希望的背后隐藏着一个致命的矛盾:若将每日亿级的日志逐条交由LLM处理,其巨大的成本与时间延迟是任何生产系统都无法承受的。本文旨在为您揭示一种新型的解决方案——混合智能模式,它巧妙地化解了这一矛盾,为在工程领域务实地利用LLM铺平了道路。

一.工程领域的困境:传统方法的局限与LLM的“昂贵智慧”

在评估任何新技术之前,我们必须首先清晰地认识到现有问题的根源和当前技术路线的瓶颈。只有深刻理解了“我们现在为何受困”,才能真正领会新范式的突破性价值所在。

1.1. 传统解析技术的“天花板”

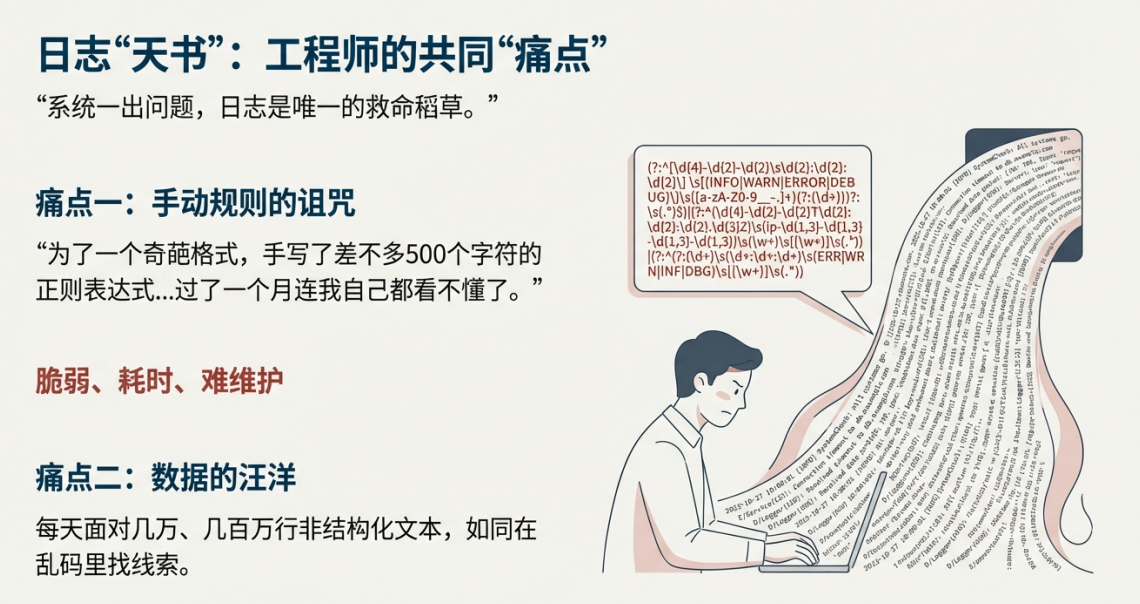

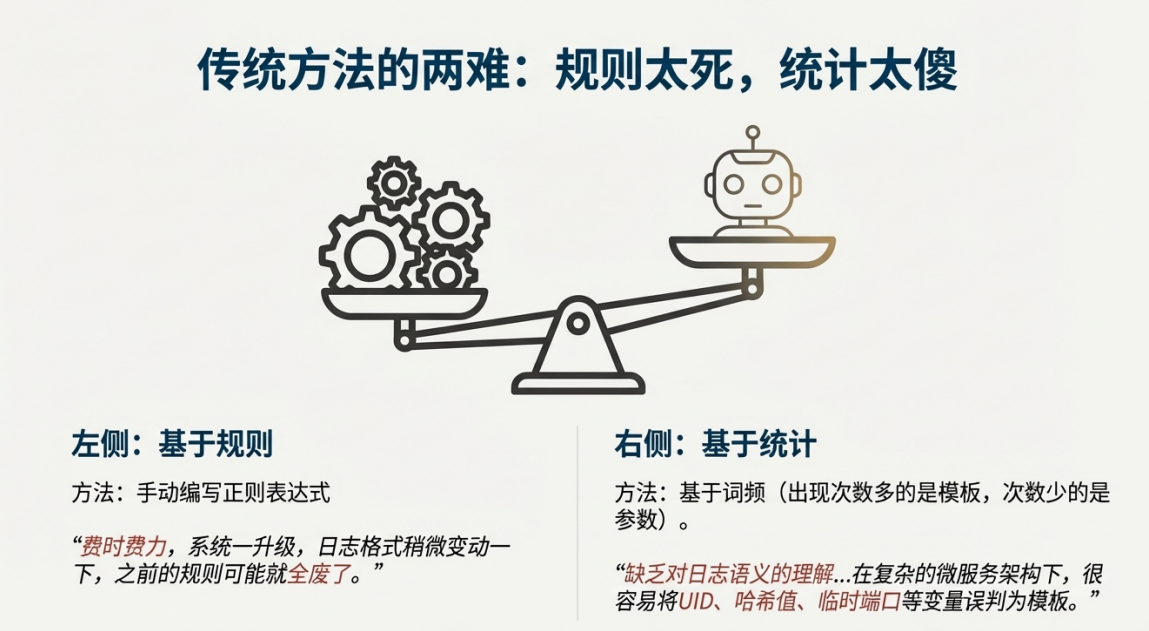

长期以来,工程师们依赖两类传统方法处理日志等非结构化数据,但它们都已触及其能力上限:

• 基于规则的方法(如正则表达式): 这种方法虽然直接,但极其脆弱和耗时。工程师需要为每一种日志格式手动编写复杂的规则。正如一位工程师在回忆如何处理一个奇葩的Java堆栈跟踪日志时所言,一个正则表达式可能“写了差不多500个字符”,但“过了一个月连我自己都看不懂了”。更糟糕的是,一旦系统升级导致日志格式微调,所有规则都可能失效,维护成本极高。

• 基于统计的方法(如词频统计): 这类方法通过统计词语出现的频率来区分“模板”(高频词)和“参数”(低频词)。在简单的系统中尚可一用,但面对充满UUID、哈希值、临时端口的现代微服务架构时,它们因缺乏对文本真正的“语义理解”而频繁出错,无法准确识别模式。

1.2. LLM的承诺与现实:能力与成本的冲突

大语言模型(LLM)的强大语义理解能力,恰好是解决上述传统方法缺陷的理想武器。它能像人类一样“读懂”日志,准确提取模式。然而,理想丰满,现实骨感。LLM在工程应用中面临着一个核心矛盾:

一方面,我们渴望其智慧;另一方面,我们畏惧其昂贵的代价。设想一个每天产生一亿条日志的系统,若要逐条调用LLM API进行解析,其成本将是天文数字,而处理时间(延迟)更是以天为单位计算,这在需要实时响应的生产环境中是完全不可行的。

正是为了解决这一“既要又要”的核心矛盾,一种全新的、更具智慧的设计思路——LogParser-LLM方案——应运而生。

二.混合模式范例:LogParser-LLM的核心设计思想

LogParser-LLM方案的价值不在于它“使用了LLM”,而在于它揭示了“如何巧妙地、有选择性地使用LLM”。本节将深入剖析其架构,为您展示一幅平衡强大能力与经济成本的实用工程蓝图。

2.1. 核心哲学:“尽力不用LLM”

该方案最核心的设计哲学可以总结为一句话:想尽一切办法,避免调用LLM。它并非将LLM视为解决所有问题的万能工具,而是将其定位为轻易不能动用的“专家王牌”。整个系统的设计精髓,在于用最高效、最低成本的常规手段处理99%的常规问题。

2.2. “高速分拣 + 专家诊断”的混合架构

该方案的架构由两个核心组件协同工作构成:

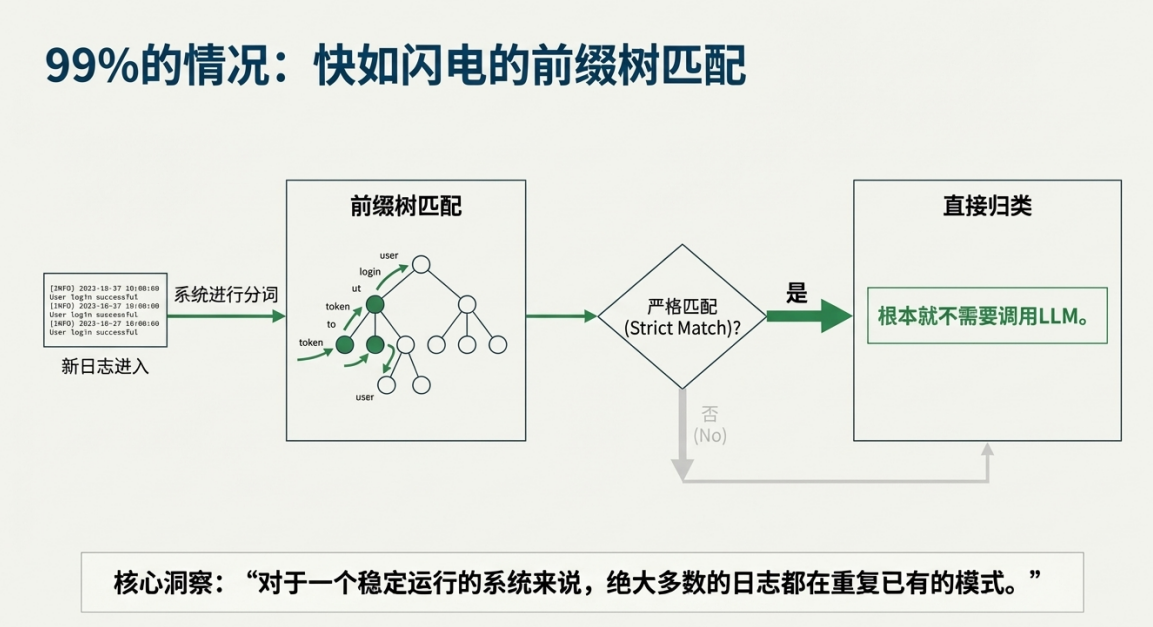

高速分拣系统(前端)

基于一种名为“前缀树”的数据结构,构建了一个高效的初筛系统。该系统存储了所有已知的日志模式。当一条新日志进入时,系统通过极快的内存查找操作,在“前缀树”中进行匹配。如果找到完全匹配的已知模式,日志就会被快速归类,整个过程高效且低成本。

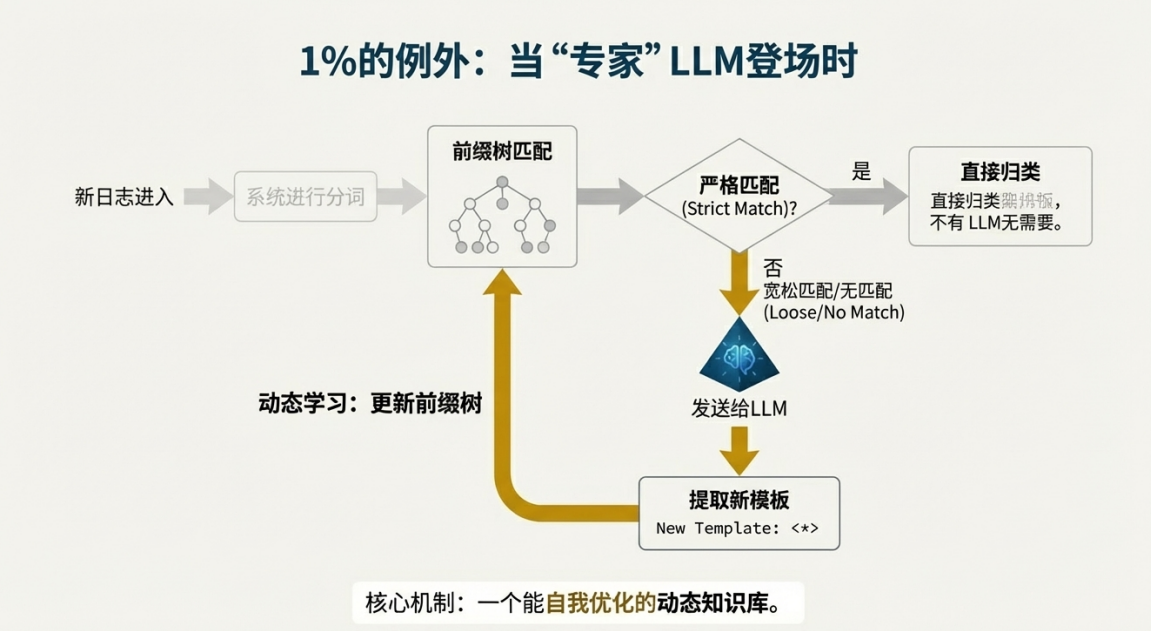

LLM专家组件(后端)

LLM的角色是一位“专家顾问”,仅在系统遇到前所未见的、未知的新日志模式时才被激活。此时,系统会将这条“疑难杂症”日志提交给LLM,利用其强大的语义理解能力生成一个新的、通用的日志模板。它的作用是高智能地解决关键难题。

2.3. 自我优化的动态知识库

这套混合架构形成了一个能够自我学习和优化的闭环流程:

1. 快速匹配: 一条新日志进入,首先由“前缀树”进行高效匹配。对于一个稳定运行的系统,绝大多数日志都属于重复出现的已知模式。

2. 专家介入: 只有当匹配失败(即遇到未知模式)时,这条日志才会被提交给LLM。

3. 知识更新: LLM分析并生成新的日志模板后,这个新模板会被添加回“前缀树”中,成为系统知识库的一部分。

这个流程使得系统能够动态学习,越用越聪明。LLM的调用次数不再与“日志总行数”相关,而是锐减至约等于“日志模板总数”的量级,从根本上解决了效率和成本问题。

2.4. 惊人的性能跃升:从“不可用”到“生产级”

数据最能说明问题。在一项针对360万条真实日志的测试中,不同策略的性能差异是颠覆性的:

策略 | 模型 | 处理360万条日志耗时 | 调用LLM次数 | 可行性评估 |

朴素策略 | GPT-3.5 | 约 22天 | 3,600,000 | 完全不可行 |

LogParser-LLM | GPT-4 | 约 26分钟 | 平均 272.5 | 生产级可用 |

这些数据背后的意义是决定性的:22天意味着方案在真实生产环境中毫无可行性;而26分钟则意味着它今天就可以被部署到预处理流程中,明天就能产生价值。这不仅仅是量级的差异,而是决定一个技术方案“能否在真实生产环境落地”的根本区别。

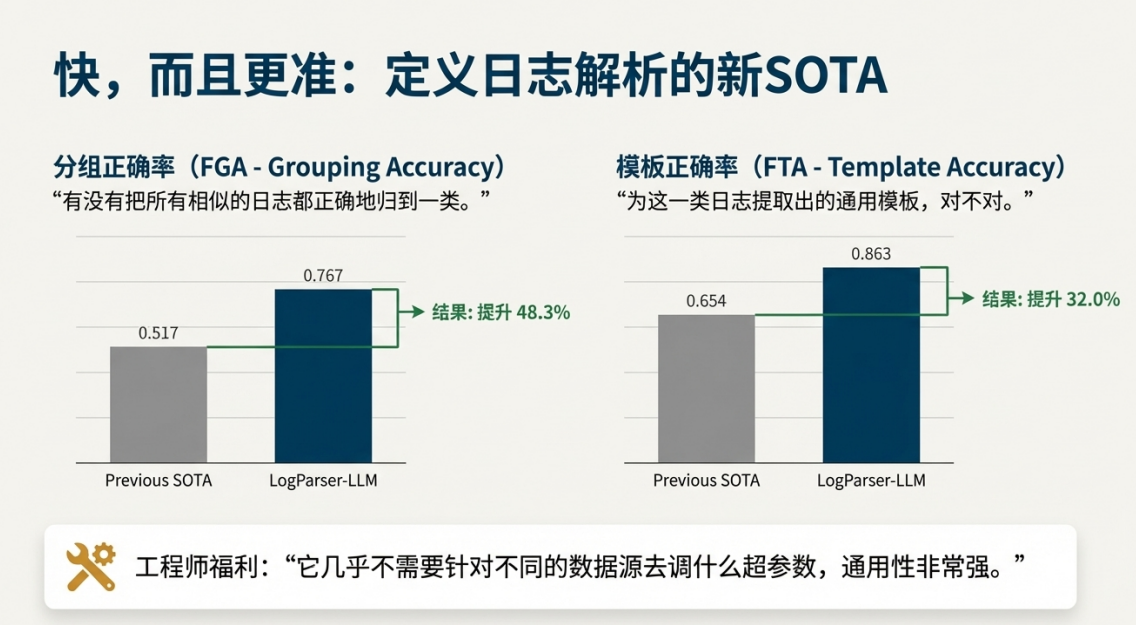

除了惊人的速度,该方案在准确性上也实现了巨大飞跃。在两个关键指标上,其表现远超以往的最佳方法:一是分组正确率(FGA),即是否能将相似的日志正确归为一类,该指标提升了48.3%;二是模板正确率(FTA),即为每类日志提炼出的通用模板是否准确,该指标提升了32.0%。这证明了方案不仅跑得快,而且分得准、总结得好。

更重要的是,该方案具有极强的通用性,几乎无需为不同的日志源进行繁琐的超参数调优,极大地降低了维护成本。

在解决了效率问题后,我们还需要关注另一个更深层次的问题——准确性。特别是,我们该如何定义和评估解析的“准确性”?

三. 超越对错:重新定义语义解析的准确性

在智能化时代,评估系统性能的标准也需要升级。传统评估指标无法覆盖一个微妙但至关重要的问题——“解析粒度”。LogParser-LLM的研究不仅解决了技术问题,更在评估理念上提供了深刻洞见。

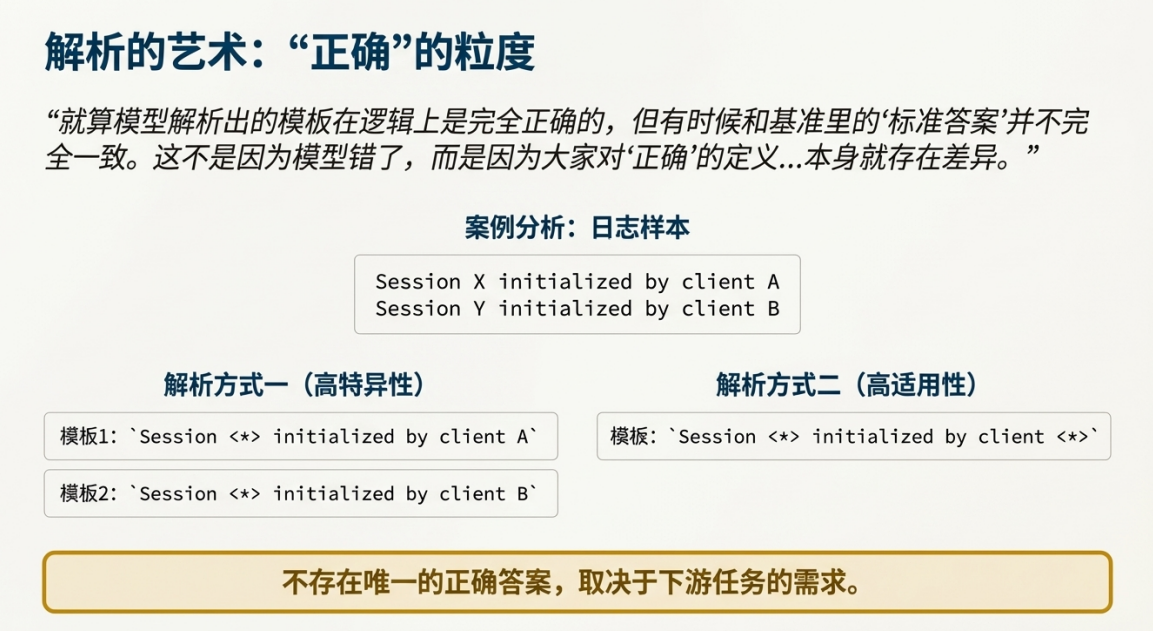

3.1. “解析粒度”的挑战:没有唯一的正确答案

以一组日志为例:session X initialized by client A 和 session Y initialized by client B。对于这组日志,存在至少两种在逻辑上都“正确”的解析方式:

• 方式一(高特异性/低适用性): 生成两个模板:session <*> initialized by client A 和 session <*> initialized by client B。这种方式保留了客户端信息,模板非常具体,但适用范围窄。

• 方式二(低特异性/高适用性): 生成一个模板:session <*> initialized by client <*>。这种方式将客户端也视为变量,模板更通用,但丢失了客户端的具体信息。

哪一种才是对的?答案取决于下游的业务需求。如果后续分析需要区分不同客户端的行为,方式一更优;如果只是统计初始化总次数,方式二更简洁。因此,不存在唯一的“正确”答案,这使得传统的、基于字符串完全匹配的评估方法彻底失效。

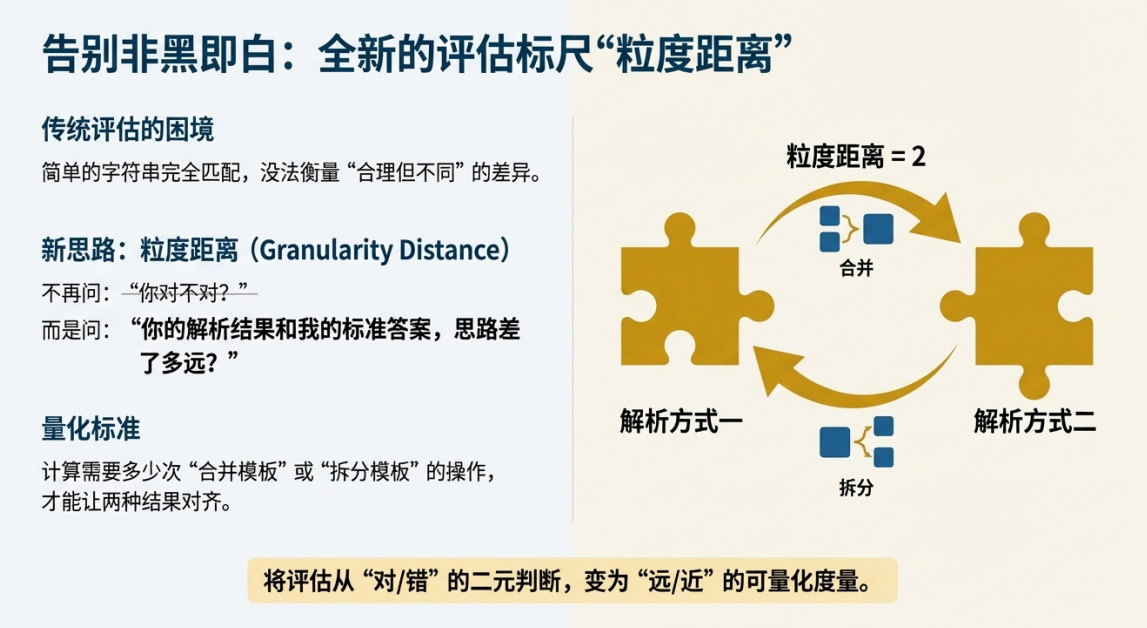

3.2. 创新的度量衡:“粒度距离”

为了解决这个评估难题,研究团队提出了一个创新的评估指标——“粒度距离”(Granularity Distance)。

其核心思想发生了转变:不再问“你的结果是否与标准答案完全一致”,而是问“你的解析思路与标准答案的思路相差多远”。它通过计算需要多少次“合并模板”或“拆分模板”的操作才能使两种结果对齐,从而将对解析粒度的评估从“对/错”的二元判断,转变为“远/近”的可量化度量,为工程实践提供了更有意义的参考。

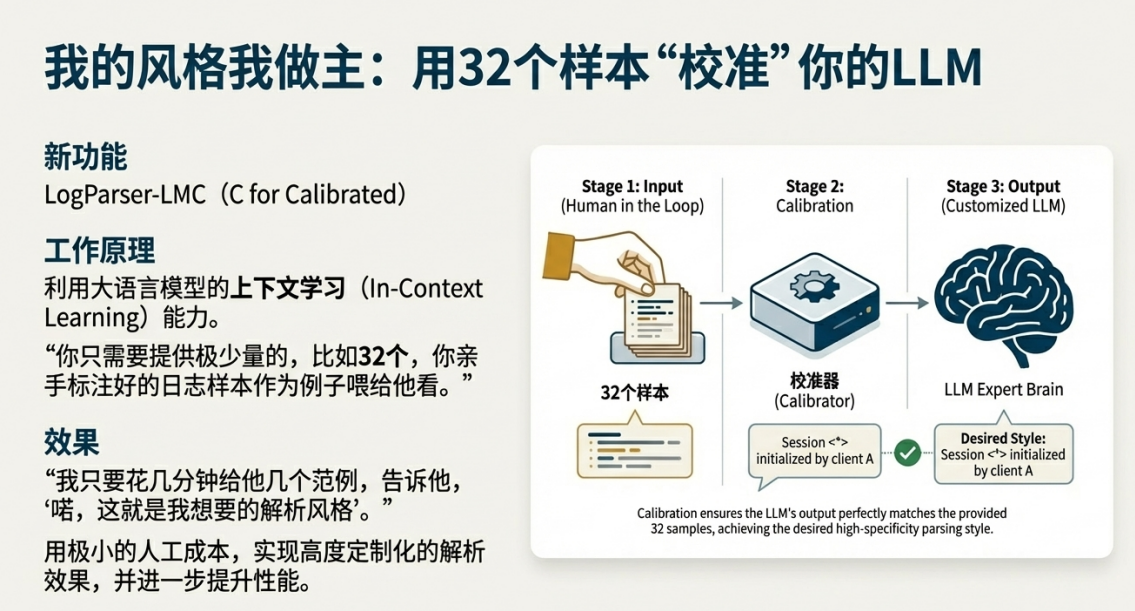

3.3. 人机协同:用极低成本实现定制化校准

更进一步,该方案还提供了一个校准版(LogParser-LLMC),允许用户根据自己的特定需求调整解析粒度。

它巧妙利用了LLM强大的上下文学习(In-context Learning)能力。工程师只需提供极少量(例如32个)高质量的人工标注范例,向模型展示自己期望的“解析风格”。模型便能“心领神会”,在后续的处理中遵循这一特定粒度。这种“人机回环”(Human-in-the-loop)模式的价值在于,工程师可以用极小的代价,实现高度定制化和精准的解析效果。

LogParser-LLM不仅在性能上取得了突破,更在理念上提供了深刻洞见。其核心的混合模式可以被抽象出来,应用到更广泛的工程领域。

四. 通用范式提炼:将“高效算法 + LLM专家”模式推广应用

本简报的最终目的不是仅仅介绍一个日志解析工具,而是提炼其背后的通用设计哲学。我们希望为技术领导者和产品经理提供一个可复用的创新框架,用以解决各类复杂的工程问题。

4.1. 模式解构:99%的常规处理与1%的关键智能

我们可以将“高效传统算法 + LLM专家组件”的混合模式抽象为一个通用框架,它由两部分构成:

• 第一部分(护城河): 使用成熟、高效、确定性强的传统算法构建核心处理引擎。这个引擎负责覆盖绝大多数(99%)的常规、高频场景,以此保证整个系统的低成本、高吞吐和高稳定性。

• 第二部分(攻坚矛): 将昂贵但智能的LLM作为“专家系统”或“智能外援”。它仅在传统算法遇到无法处理的、需要深度语义理解或复杂判断的疑难场景(1%)时被调用,用以解决最关键的难题。

4.2. 启发与应用:在您的业务中寻找应用场景

现在,请思考一个问题:“在您的业务流程中,哪些任务目前依赖于繁琐的硬编码规则,却又在关键环节需要人类的‘智能判断’?”

这些场景正是应用此混合模式的绝佳机会。以下是几个潜在的应用方向,希望能启发您的思路:

• 复杂配置校验: 用传统解析器处理99%的标准化配置项。当遇到自定义脚本或复杂的逻辑依赖关系时,调用LLM进行语义层面的合理性校验,判断配置是否存在潜在风险。

• 智能化代码审查(Code Review): 用静态分析工具(Linter)自动发现常规的语法和风格问题。当需要判断代码是否遵循了某种复杂的设计模式,或识别潜在的逻辑缺陷时,让LLM介入进行深度分析。

• 告警收敛与根因分析: 用高效算法对海量告警进行快速的去重和基础分组。当需要理解不同系统来源、描述各异的告警是否指向同一个根本原因时,利用LLM进行语义聚类,智能地发现事件关联。

总之,这一混合模式是在当前阶段,在工程领域务实且高效地落地LLM价值的关键路径。它不仅解决了眼前的技术难题,更为我们未来的技术创新提供了一张清晰的路线图。

浙公网安备 33010602011771号

浙公网安备 33010602011771号