DeepSeek-V3.2 Speciale介绍

1. 引言

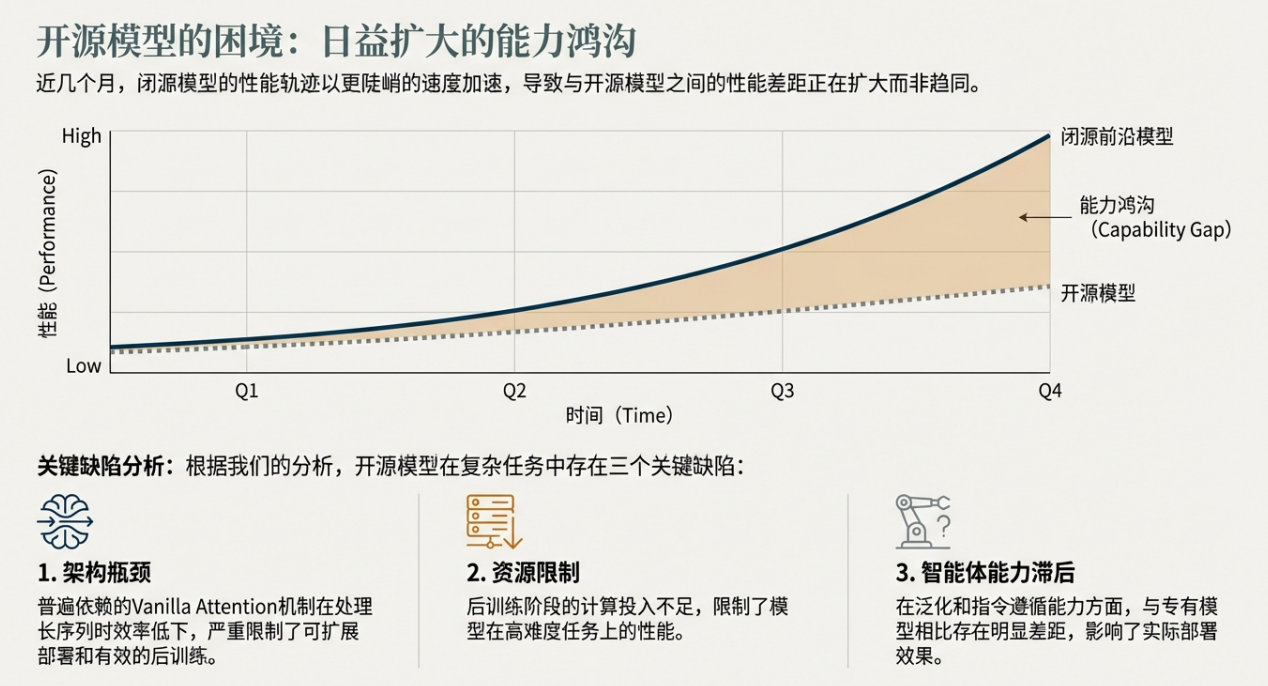

当前,大语言模型(LLM)领域正经历一个显著的分化阶段。一方面,以 OpenAI、DeepMind 等为代表的闭源专有模型性能持续加速迭代;另一方面,尽管开源社区不断进步,但两者间的性能差距却日益扩大。行业分析普遍将此归因于开源模型面临的三大核心瓶颈:一是传统注意力架构在处理长序列时效率低下;二是后训练(post-training)阶段的计算资源投入严重不足;三是智能体(Agent)在复杂任务上的泛化与指令遵循能力相对滞后。

在此背景下,DeepSeek-V3.2 应运而生。它是一款定位明确的开源大语言模型,旨在正面应对上述挑战,通过一系列技术创新,在保证高计算效率的同时,实现与业界顶级模型相媲美的推理与智能体能力。DeepSeek-V3.2 不仅仅是一次常规的模型升级,更是开源社区为弥合与闭源模型性能鸿沟所迈出的关键一步。

本报告旨在系统性地剖析 DeepSeek-V3.2 的核心技术架构、多维度性能表现及其成本效益,并将其与 GPT-5、Gemini-3.0-Pro 等前沿闭源模型进行深入的横向比较。通过本次分析,我们将揭示 DeepSeek-V3.2 的市场定位、相对优势与潜在局限性。接下来,让我们首先深入其技术内核,探究支撑其卓越性能的三大创新支柱。

2. 核心技术创新与差异化分析

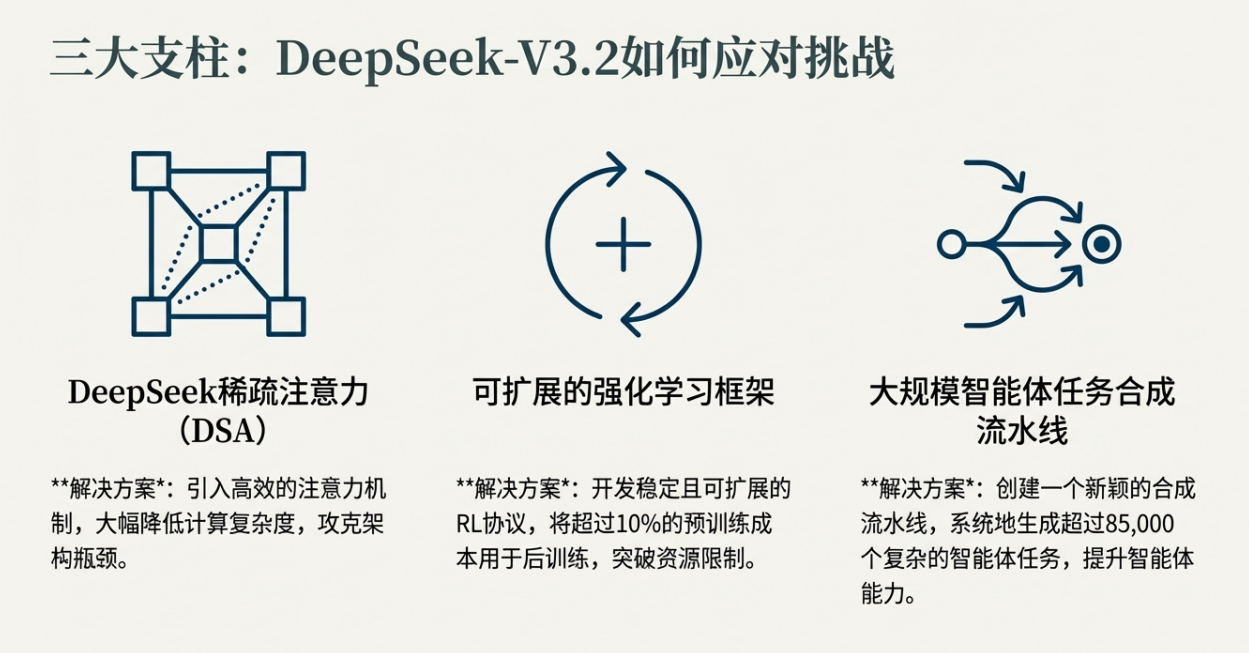

模型架构与后训练(post-training)策略是决定大语言模型性能上限与效率的核心。DeepSeek-V3.2 的突破性表现并非偶然,而是建立在对现有技术瓶颈的深刻洞察和精准攻克之上。本章节将深入剖析支撑其实现性能飞跃的三大核心技术支柱,正是这些创新使其在众多模型中脱颖而出。

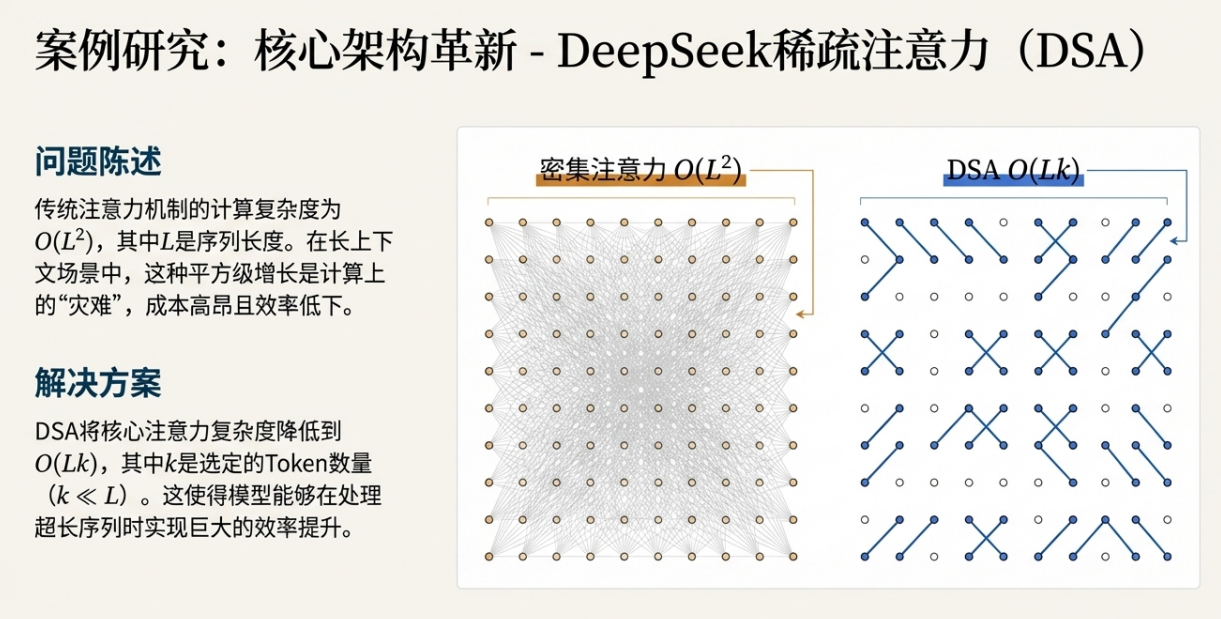

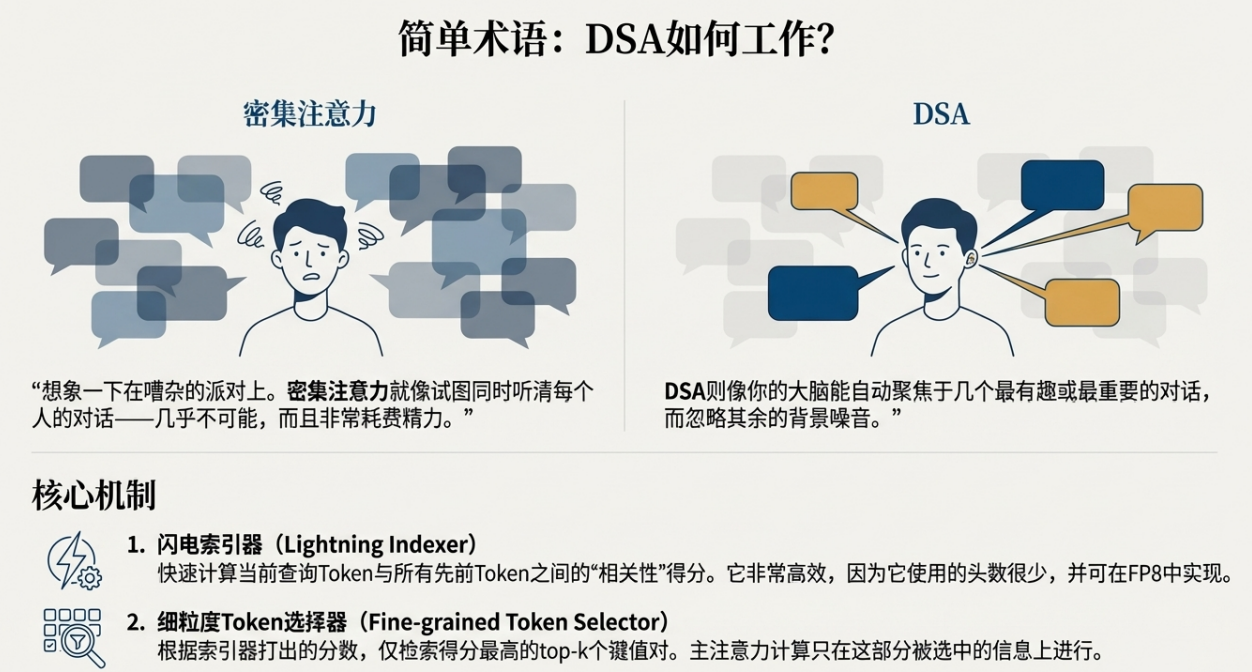

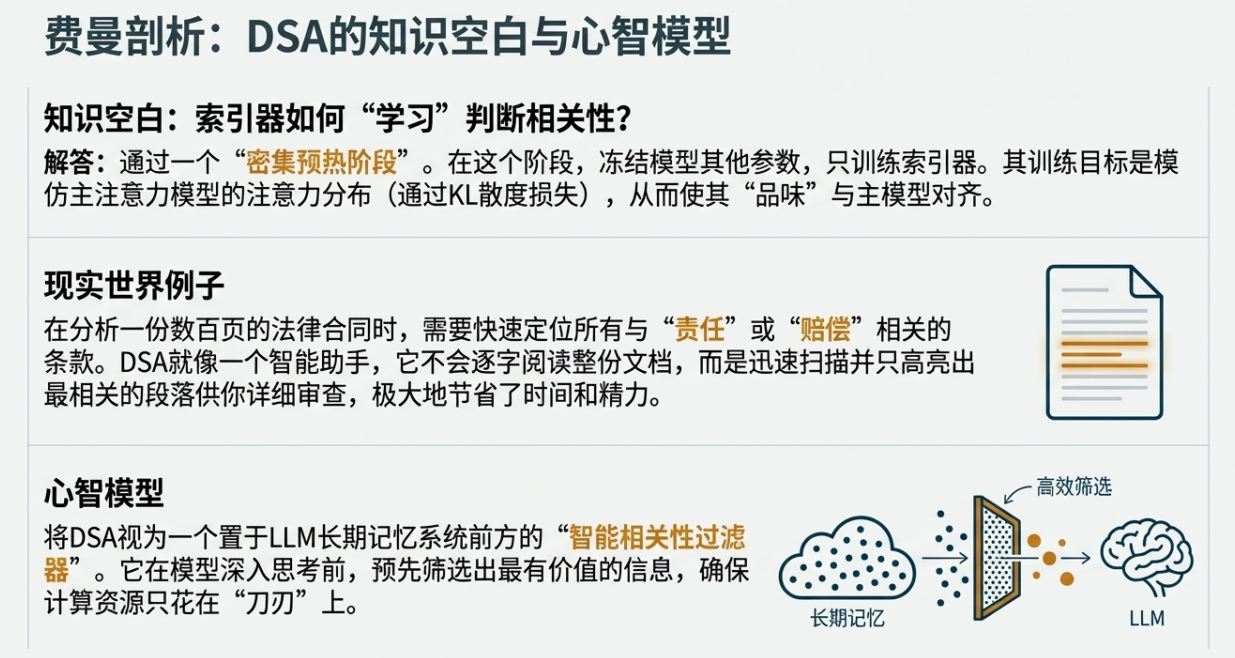

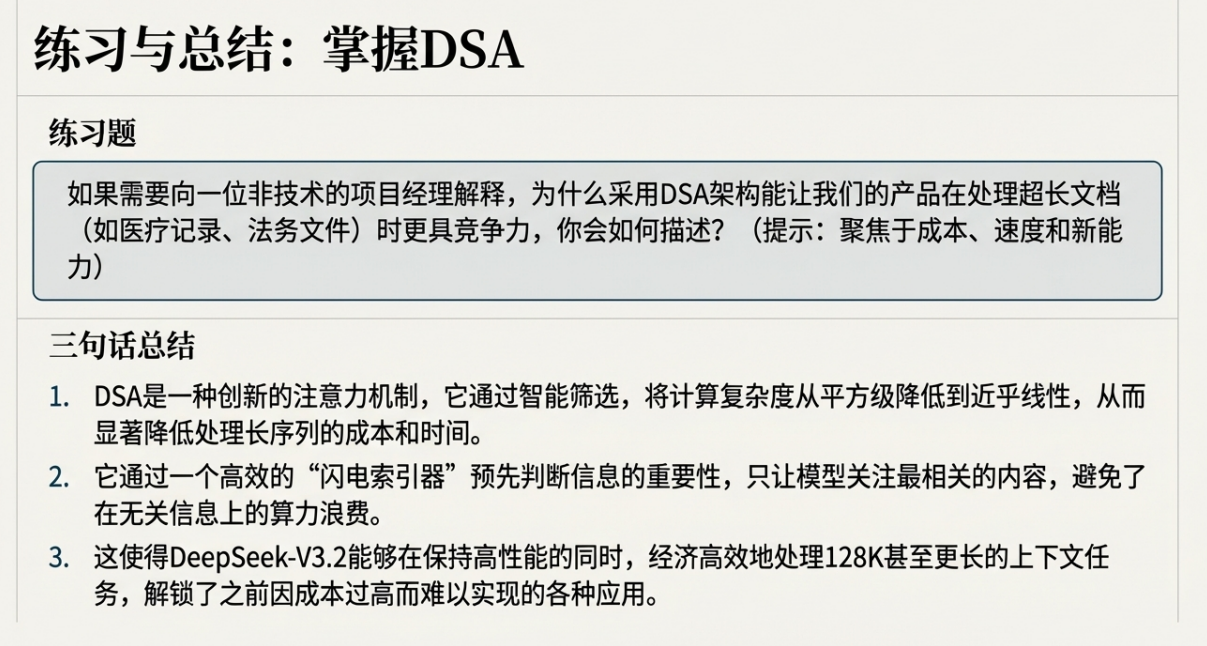

1. DeepSeek稀疏注意力机制 (DSA)

◦ 技术解析: DSA 是一种创新的高效注意力机制。其核心原理在于,通过引入一个轻量级的“闪电索引器”(Lightning Indexer)和细粒度的令牌选择机制,将传统注意力机制中随序列长度(L)二次方增长的计算复杂度 O(L²) 成功降低至 O(Lk),其中 k(被选中的令牌数,本文设为2048)远小于 L。

◦ 战略价值分析: 这一创新直接解决了大模型在处理长序列文本时面临的效率瓶颈。它使得 DeepSeek-V3.2 能够在不牺牲长上下文处理性能的前提下,显著降低推理阶段的计算资源消耗。这种架构层面的优化,为其在需要处理海量上下文的智能体应用场景中,奠定了决定性的成本优势。

2. 可扩展的强化学习 (RL) 框架

◦ 技术解析: DeepSeek-V3.2 团队开发并实施了一套稳定且可扩展的强化学习协议——分组相对策略优化(GRPO)。尤为关键的是,团队在后训练阶段投入了巨大的计算资源,其成本甚至超过了预训练成本的10%。

◦ 战略意义评估: 在开源领域,后训练阶段的计算投入往往相对不足,这限制了模型在复杂任务上的表现。DeepSeek-V3.2 通过前所未有的大规模后训练投入,成功解锁了模型在数学、编程和通用逻辑推理等高级任务上的深层潜力,使其性能得以与投入巨大的顶级闭源模型正面抗衡。这种稳定性是通过无偏KL散度估计 (Unbiased KL Estimate)、离策略序列掩码 (Off-Policy Sequence Masking) 以及针对MoE模型的路由保持 (Keep Routing) 等关键技术实现的,展现了其在规模化RL工程上的深厚积累。

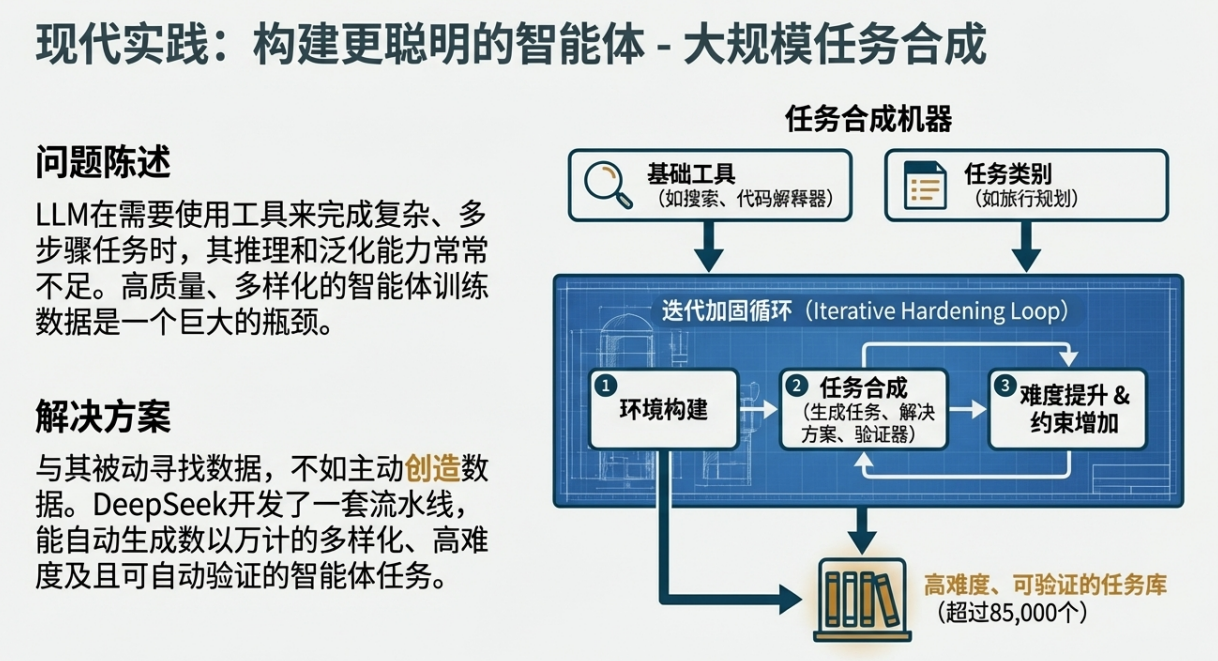

3. 大规模智能体任务合成管线

◦ 技术解析: 为提升模型在复杂交互环境中的工具使用(tool-use)能力,团队构建了一套新颖的合成数据管线。该管线能够系统性地生成超过1800个不同的虚拟环境和85,000个复杂任务提示,为智能体的强化学习过程提供了丰富且高质量的训练数据。

◦ 重要性剖析: 这种方法不仅解决了真实世界智能体任务数据稀缺的难题,更重要的是,它极大地增强了模型在未见过的环境和工具面前的泛化能力与指令遵循的稳健性。这使得 DeepSeek-V3.2 训练出的智能体不只是“死记硬背”,而是真正学会了在动态环境中推理和使用工具的通用策略。

综上所述,这三大技术创新共同构成了 DeepSeek-V3.2 的核心竞争力,使其在性能和效率上达到了新的高度。接下来,我们将通过一系列客观的基准测试来量化验证这些技术创新所带来的实际效果。

3. 关键能力多维度基准评测

本章节将依据一系列行业公认的标准基准测试,从综合推理、代码数学、智能体能力等多个核心维度,对 DeepSeek-V3.2 的性能进行客观、量化的评估,并与 GPT-5 High、Gemini-3.0 Pro 等主要闭源竞品进行直接比较。

3.1. 综合推理与知识能力

在衡量模型综合推理与知识广度的基准测试中,DeepSeek-V3.2 展现了与顶级闭源模型相当的实力。

基准测试 | DeepSeek-V3.2 | GPT-5 High | Gemini-3.0 Pro |

English MMLU-Pro (EM) | 85.0 | 87.5 | 90.1 |

GPQA Diamond (Pass@1) | 82.4 | 85.7 | 91.9 |

HLE (Pass@1) | 25.1 | 26.3 | 37.7 |

分析: 从上表数据可以看出,DeepSeek-V3.2 在 MMLU-Pro、GPQA Diamond 等高难度推理任务上的表现与 GPT-5 High 基本持平,显示出其强大的基础推理能力。尽管与当前性能最强的 Gemini-3.0 Pro 相比仍有一定差距,但已成功跻身业界第一梯队。

3.2. 代码与数学能力

代码与数学能力是衡量模型逻辑推理严谨性的黄金标准。在这些专业领域,DeepSeek-V3.2 同样表现出色。

基准测试 | DeepSeek-V3.2 | GPT-5 High | Gemini-3.0 Pro |

LiveCodeBench (Pass@1-COT) | 83.3 | 84.5 | 90.7 |

Codeforces (Rating) | 2386 | 2537 | 2708 |

AIME 2025 (Pass@1) | 93.1 | 94.6 | 95.0 |

HMMT Feb 2025 (Pass@1) | 92.5 | 88.3 | 97.5 |

分析: DeepSeek-V3.2 在编程竞赛(Codeforces)和高难度数学竞赛(AIME, HMMT)等基准测试中展现出极强的竞争力。其性能不仅大幅领先于其他开源模型,其性能在部分指标上与顶级闭源模型形成有力竞争,证明了其在高度依赖逻辑推理的专业领域中的强大实力。

3.3. 智能体与工具使用能力

智能体与工具使用是衡量模型将推理能力应用于实际交互场景的关键。DeepSeek-V3.2 在这一新兴领域取得了显著进展。

基准测试 | DeepSeek-V3.2 | GPT-5 High | Gemini-3.0 Pro |

Terminal Bench 2.0 (Acc) | 46.4 | 35.2 | 54.2 |

SWE Verified (Resolved) | 73.1 | 74.9 | 76.2 |

BrowseComp (Pass@1) | 67.6* | 54.9 | - |

τ2-Bench (Pass@1) | 80.3 | 80.2 | 85.4 |

Tool-Decathlon (Pass@1) | 35.2 | 29.0 | 36.4 |

注:BrowseComp 的 67.6 分数是在采用上下文管理技术后取得,未使用该技术时的分数为 51.4。 |

分析: 评测结果明确显示,DeepSeek-V3.2 在智能体和工具使用能力上,极大地缩小了与顶级闭源模型的性能差距,同时大幅领先于其他开源模型。尤其值得注意的是,这些测试中包含了模型在训练期间未曾接触过的环境和工具集,其优异表现充分证明了其强大的泛化能力。然而,源文件也揭示了一个关键局限:在如 MCP-Mark 等复杂基准测试中,模型常会进行“冗余的自我验证”,生成过长的思考轨迹,导致超出上下文窗口。这种倾向性揭示了其智能体行为在周密性与Token效率之间存在的权衡。

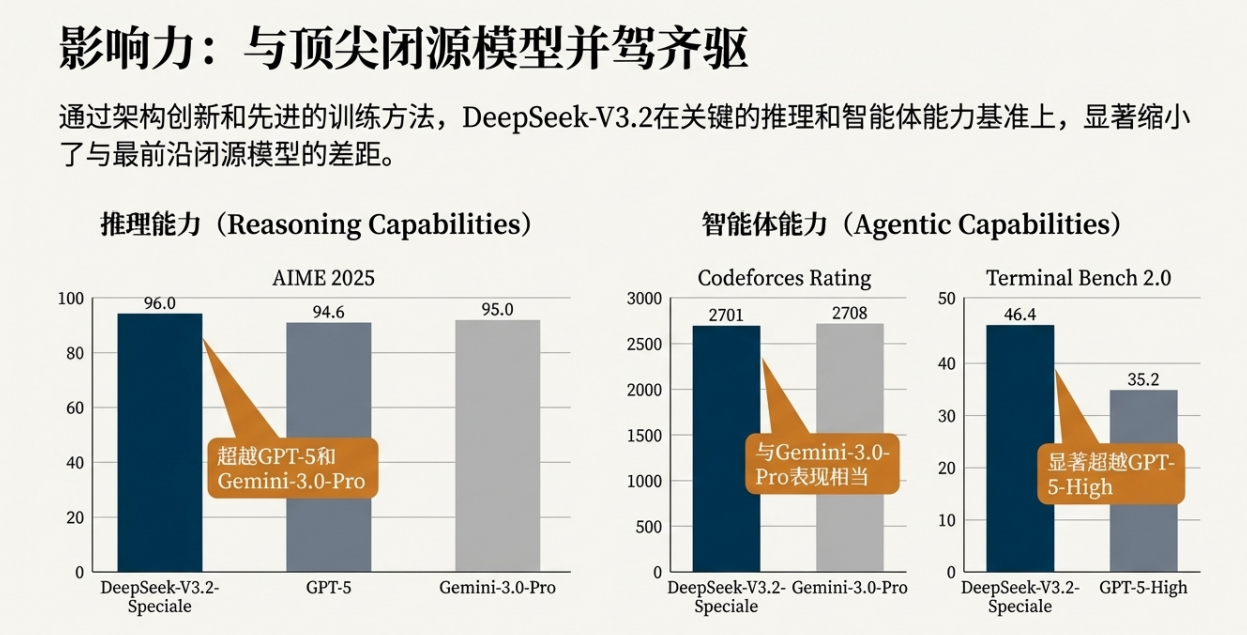

3.4. 性能上限探索:DeepSeek-V3.2-Speciale 版本分析

为了探索其基础架构的性能极限,DeepSeek 团队还开发了一款实验性的高算力版本——DeepSeek-V3.2-Speciale。该版本通过放宽对生成长度的限制,旨在追求极致的推理性能。

基准测试 | Gemini-3.0 Pro | DeepSeek-V3.2-Speciale |

AIME 2025 (Pass@1) | 95.0 (15k) | 96.0 (23k) |

HMMT Feb 2025 (Pass@1) | 97.5 (16k) | 99.2 (27k) |

IMOAnswerBench (Pass@1) | 83.3 (18k) | 84.5 (45k) |

CodeForces (Rating) | 2708 (22k) | 2701 (77k) |

GPQA Diamond (Pass@1) | 91.9 (8k) | 85.7 (16k) |

HLE (Pass@1) | 37.7 (15k) | 30.6 (35k) |

注:单元格内显示 准确率 (输出Token数/千) |

此外,DeepSeek-V3.2-Speciale 在 2025 年国际数学奥林匹克(IMO)、国际信息学奥林匹克(IOI)、国际大学生程序设计竞赛全球总决赛(ICPC World Final)以及中国数学奥林匹克(CMO)等世界顶级竞赛中均取得了金牌级别的成绩,这充分证明了其架构具备冲击业界最前沿性能的巨大潜力。

关键权衡分析: 这揭示了一个关键的性能-效率边界:尽管其底层架构具备达到业界顶尖性能的潜力,但要实现这一目标,目前需要付出计算步骤(即Token生成量)不成比例增加的代价。这正是标准版 DeepSeek-V3.2 模型通过调优着力缓解的一个核心挑战。

这些全面的性能数据揭示了 DeepSeek-V3.2 的强大实力,但对于实际应用而言,性能必须与成本相结合进行考量。

4. 成本效益分析

对于任何希望规模化部署大语言模型的组织而言,推理成本是与模型性能同等重要的核心考量因素。DeepSeek-V3.2 凭借其创新的 DSA 架构,在成本效益方面展现出巨大的竞争优势。

源于 Figure 3 的基准测试数据显示,在基于 H800 GPU 的实际服务部署估算中,DeepSeek-V3.2 的推理成本实现了显著优化。具体而言,无论是在预填充(Prefilling)还是解码(Decoding)阶段,其每百万Token的成本曲线都展现出与前代模型截然不同的形态:

• 解码(Decoding)阶段: DeepSeek-V3.2 的成本几乎保持为一条平坦的直线,不受上下文长度增加的影响;相比之下,前代 V3.1 模型的成本则呈现出明显的线性增长。

• 预填充(Prefilling)阶段: 尽管成本随序列增加而上升,但 DeepSeek-V3.2 的成本曲线斜率远比 V3.1 平缓,显示出在处理长序列时日益扩大的成本优势。

总结分析: 这种成本曲线形态的根本性改变,直观地展示了 DSA 架构的实际经济影响。DeepSeek-V3.2 将自身定位为一个极具成本效益的选项,尤其是在需要处理长上下文的智能体应用等新兴场景中,其卓越的“性价比”展现出巨大的商业潜力,为企业在不牺牲性能的前提下,大规模应用高级 AI 能力提供了经济可行的路径。

在全面了解其性能和成本之后,我们接下来将对其进行一个综合性的评估。

5. 综合评估:相对优势与局限性

本节将整合前述所有分析,以客观、平衡的视角,提炼出 DeepSeek-V3.2 在当前市场格局中的核心竞争优势与尚待完善的局限性,从而形成一个全面的战略评估。

核心优势 (Strengths) | 主要局限性 (Limitations) |

- 性能逼近顶尖水平: 在关键的推理和智能体任务上,性能与GPT-5等顶级模型相当,显著缩小了开源与闭源模型的性能差距。 | - 世界知识广度不足: 由于总训练算力(FLOPs)少于头部专有模型,其在世界知识的广度方面仍有差距。 |

- 卓越的成本效益: 创新的DSA架构大幅降低了长上下文推理成本,为模型的规模化应用提供了坚实的经济可行性。 | - Token效率有待提升: 与Gemini-3.0-Pro等模型相比,通常需要生成更长的内容(消耗更多Token)才能达到同等的输出质量。 |

- 已验证的SOTA潜力: Speciale版本在顶级数理竞赛中夺金,证明了其基础架构具备冲击业界最前沿性能的潜力。 | - 复杂任务处理能力仍有差距: 在解决最顶尖、最复杂的任务时,整体表现相较于最前沿的闭源模型仍显逊色。 |

- 强大的泛化能力: 在工具使用和智能体任务上表现出强大的泛化能力,能够很好地适应训练期间未曾接触过的新环境和新工具。 |

通过这份优劣势分析,我们可以清晰地看到 DeepSeek-V3.2 的市场定位和发展方向。这自然地引出了我们对该模型的最终结论与未来展望。

6. 结论与战略展望

DeepSeek-V3.2 的发布是开源大语言模型发展进程中的一个重要里程碑。它的核心成就,在于成功地在高计算效率和高级推理能力之间架起了一座坚实的桥梁,为整个开源社区树立了全新的技术标杆。通过在架构、后训练和数据工程上的系统性创新,它不仅在性能上追赶上了业界顶级的闭源模型,更在长上下文处理的成本效益上开辟了新的可能性。

作为一款开源模型,DeepSeek-V3.2 的重要意义在于,它向业界证明了,通过精准的技术路线和充足的资源投入,开源社区完全有能力挑战并缩小与闭源巨头的性能差距,从而推动整个 AI 生态向着更加开放、多元和普惠的方向发展。

展望未来,DeepSeek 团队已为其后续演进规划了清晰的战略路径,主要聚焦于以下三个方向:

1. 扩展预训练规模: 团队计划通过增加预训练阶段的计算投入,直接弥补模型在世界知识广度上与顶级闭源模型的差距,进一步夯实其知识基础。

2. 提升智能密度: 未来的工作将重点优化模型的推理链,以提高 Token 效率。目标是让模型能够用更精炼、更高效的思考过程产出高质量的答案,降低实际应用中的延迟与成本。

3. 持续优化迭代: 团队将致力于进一步完善基础模型和后训练方案,不断提升其解决最顶尖复杂任务的能力,向着真正的通用人工智能前沿持续迈进。

浙公网安备 33010602011771号

浙公网安备 33010602011771号