并行思维实现推理加速

和parallel-r1的本质区别:下面这三篇的故事在于推理加速;而parallel-r1的故事在于模型行为

数据构建的两种方法:

https://arxiv.org/abs/2508.08895 :

腾讯:主要的贡献:在多种数据集上测试,加入注意力机制

这篇文档讲的是一种能让大语言模型(比如 ChatGPT、Vicuna 这类)“又快又好” 生成答案的新方法,叫自适应串并行解码(ASPD)。核心思路是:打破大模型 “逐字逐句生成” 的固有模式,利用答案里隐藏的 “可并行结构”,同时生成多个部分,从而大幅提速,还不丢回答质量。

ASPD:基于内在并行性的自适应串并行解码(SFT+注意力机制,实现推理加速)

1. 论文核心概念🔍

这篇论文的核心发现是:尽管大型语言模型(LLMs)通常采用自回归解码方式(即逐个令牌顺序生成),导致推理延迟高,但模型输出中实际上存在大量的内在并行结构(例如列表、项目符号或独立语义段)。这些结构可以被并行解码,从而显著加速推理过程。论文提出了一种名为自适应串并行解码(ASPD)的新框架,通过以下思路解决问题:

- 问题:自回归解码的序列性限制了LLM的推理速度,尤其在实时应用中。

- 解决思路:利用LLM输出中的内在并行性,设计一种自适应机制,在保持生成质量的同时,动态切换串行和并行解码模式。具体包括:

- 自动从模型响应中提取并行化数据。

- 修改模型架构以支持无损的并行解码。

- 实现高效的混合解码引擎,减少开销。

2. 论文方法🔬

2.1 过去方法的问题

过去的方法试图通过并行化加速LLM推理,但存在以下局限性,这引出了ASPD的动机:

- SoT(Skeleton-of-Thought):采用两阶段方法(先生成大纲,再并行填充),但阶段切换时需要重新初始化KV缓存,导致额外延迟和内存开销。此外,提示模板限制了响应质量。

- APAR(Auto-Parallel Auto-Regressive):使用规则提取并行分支,但在最终生成时丢弃并行分支的KV缓存,损害了输出连贯性;且无法处理数学或代码等内容。

- PASTA(Learned Asynchronous Decoding):预分配位置编码范围,但当实际生成长度与预测不符时,会出现位置不匹配问题,影响后续序列质量。

- 共同问题:这些方法未能充分挖掘模型的内在并行性,且在处理分支独立性和位置编码时存在缺陷。ASPD的动机是解决这些挑战,实现高效、无损的并行解码。

2.2 整体框架

ASPD框架包含三个核心组件:非侵入式并行数据转换管道、内部并行化模块和混合解码引擎。整体流程如图3所示:

2.2.1 非侵入式并行数据转换管道

这个管道自动从自回归模型响应中提取并行结构,生成训练数据,而不改变响应概率分布。过程如图4所示:

- 步骤1:并行重写:对每个输入生成多个响应样本,识别可并行化的组(如列表项)。如果样本没有并行组,则归类为串行数据。

- 步骤2:独立性验证:检查每个并行组内的分支是否语义独立。如果验证失败,并行组退化为串行形式;如果所有组都失败,整个样本变为串行数据。为了减少偏差,使用多数投票法(采样三个输出路径,一致同意才通过验证)。

- 步骤3:完整性和答案验证:确保并行组结构完整,并进行答案一致性检查。

- 步骤4:基于偏好的选择:根据并行度(DP)和平均分支数(ABN)排名,保留最高质量的样本。

这个管道确保了并行数据的语义独立性和结构完整性,为训练提供高质量语料。

2.2.2 内部并行化模块

在获得并行数据后,修改模型架构以支持串并行解码。关键设计包括分支不可见掩码和共享位置编码,确保并行解码行为与原生自回归解码一致。架构细节如图5所示:

- 基本概念:引入掩码注意力机制

2.2.3 混合解码引擎

这个引擎支持自适应迭代串并行切换,减少模式转换的开销。实现细节包括:

-

特殊令牌:扩展词汇表,添加6个特殊令牌:

, ,, ,, 。 -

推理流程:

-

当模型判断响应可并行化时,生成多个并行标题(用

和 包裹)。 -

输出

令牌,切换到并行解码模式。 -

对每个分支i,设置前缀"

Ti:"(Ti为标题),分支生成直至 令牌。 -

所有分支完成后,输出,切换回串行解码。

-

-

关键技术:引擎应用分支不可见掩码和同步位置ID机制(如公式2-4),确保并行阶段每个分支仅关注主分支和自身分支的令牌,位置ID顺序递增。完成后,串行解码恢复,位置ID反映完整序列。

-

优势:支持多轮串并行切换,无需批处理或线程开销,KV缓存可重用。

3. 实验结果与分析📊

3.1 实验结果

论文在多个基准测试上评估ASPD,比较了不同基线方法,并使用多种数据集和评估指标。

-

Baseline方法:

- Ori:原始自回归模型(如Vicuna-1.3-7B或Qwen2.5-7B-Instruct)。

- Seq:序列微调模型(在相同数据上训练,但移除并行令牌)。

- SoT:使用官方代码的Skeleton-of-Thought方法。(阶段一:生成骨架:模型首先根据输入提示生成一个响应大纲,例如以项目符号或标题形式列出关键点。这个骨架通常是简洁的,只包含响应的主要结构。阶段二:并行填充:基于生成的骨架,每个关键点被作为一个独立任务,通过批处理解码或外部 API 调用并行生成详细内容。例如,如果骨架有 3 个要点,模型会同时处理这 3 个分支的生成。)

- APAR:使用开源参数的APAR方法。(APAR:在整合阶段丢弃了并行分支的KV缓存,仅将并行分支生成的文本作为提示喂给模型进行后续生成。这导致了信息损失和上下文不连贯,因为模型失去了并行生成过程中的深层表示。)

- APAR*:用Qwen3-235B-A22B增强训练数据后的APAR变体。

- ASPD:本文提出的方法。

-

数据集(一句话介绍):

- Vicuna Bench:通用对话任务基准,评估模型在多轮对话中的表现。

- MT Bench:多任务基准,涵盖编码、提取、人文、数学、推理、角色扮演、STEM和写作等任务。

- RAG Bench:检索增强生成基准,基于rag-dataset-12000,测试模型在外部知识检索下的性能。

- 内部基准:包括机器阅读理解(MRC)、逻辑推理(LR)和AI搜索,用于跨域验证。

- 数学推理基准:如MATH500(数学问题求解)、AMC23、AIME2024等,测试复杂推理能力。

-

评估指标:

- 有效性指标:使用LLM-as-judge框架(如Qwen3-235B-A22B)评分,衡量响应质量。

- 效率指标:

- TPS(Tokens-Per-Second):每秒生成令牌数,衡量整体速度。

- P-TPS(Parallel-TPS):并行阶段的TPS。

- DP(Degree of Parallelism):并行令牌占总令牌的比例。

- ABN(Average Branch Number):平均并行分支数。

- PPD(Proportion of Parallel Data):基准中可并行样本的比例。

实验结果如表1、图7和图8所示,显示ASPD在速度和质量上优于基线。例如,在Vicuna Bench上,ASPD达到平均1.82倍加速,响应质量与序列模型相差不到1%。跨模型评估(如Qwen2.5-7B)也验证了泛化能力。

此外,消融实验(如表6-8)验证了数据管道、掩码可见性和位置编码策略的重要性。

例如,Same-Sequential位置编码策略(ASPD采用)在质量和效率上最优。

APR:学习与语言模型的自适应并行推理(SFT+RL,多线程并行,实现推理加速)

https://arxiv.org/abs/2504.15466 :COLM25

1. 传统推理的 “坑”

之前语言模型推理主要有两种方式,都有明显短板:

- 串行思考(比如 “思维链”):像写作文一样从头想到尾,一步步推导。但复杂问题需要想很多步,不仅慢( latency 高),还容易把 “脑子”(上下文窗口)塞满,没等想出答案就 “记不住” 了。

- 简单并行(比如 “自一致性”):让模型同时跑多个独立的推理线程,最后选多数答案。但这些线程各干各的,没有配合,经常做重复工作,资源浪费还没多大效果;还有些结构化并行方法(比如 “思维树”),需要人工设计推理框架,不灵活。

2. APR 的核心思路:让模型自己 “调度” 思考方式

APR 就像给模型加了个 “任务调度员”,让它自己决定什么时候该一步步串行想,什么时候该分几个 “小助手”(子线程)并行想,最后汇总结果。关键是两个操作:

- spawn(分身):模型在推理中遇到复杂子问题时,自动 “分身” 出多个子线程,每个子线程专注解决一个小问题,而且子线程之间可以并行计算(同时干活)。

- join(汇合):子线程解决完问题后,只把关键结果返回给 “主线程”,不用带一堆中间步骤,大大节省 “脑子” 空间。

而且这一切不用人工设计规则,模型通过训练自己学会怎么调度 —— 先靠监督学习打基础(模仿符号求解器的推理过程),再靠强化学习优化(奖励能成功解决问题的调度方式)。

![[Pasted image 20251224141131.png]]

- 监督学习初始化:首先,使用符号求解器生成包含spawn()和join()操作的演示数据,训练模型模仿这些轨迹。数据生成采用混合搜索策略(结合BFS和DFS),以多样化搜索行为。具体地,论文实现了两种符号求解器:

- SoS+:生成序列化混合搜索路径,无并行操作。

- **目的**:生成序列化混合搜索路径,即结合广度优先搜索(BFS)和深度优先搜索(DFS)的线性轨迹,无并行操作。

- **伪代码逻辑**:

- 输入:起始状态(start_state)和目标状态(goal_state)。

- 步骤:

1. 初始化一个队列(state_deque),包含从起始状态扩展的初始状态。

2. 循环处理队列中的每个状态:

- 如果当前状态等于目标状态,返回“Goal reached”(成功)。

- 否则,使用启发式函数is_promising判断当前状态是否有前景:

- 如果有前景,则递归调用SoS+进行深度优先搜索(DFS)。

- 如果没有前景,则扩展当前状态的所有可能子状态(通过SE函数),并将它们加入队列进行广度优先搜索(BFS)。

3. 如果队列耗尽仍未找到解,返回“No result”。

- **关键点**:这是一个纯串行过程,所有搜索步骤被序列化为一个字符串轨迹。is_promising函数简单设置为10%概率返回true,以随机混合BFS和DFS,增加多样性。伪代码展示了如何线性化搜索,但受限于上下文窗口。

- APR符号求解器:在特定节点选择并行探索,生成父线程和子线程的演示。

APR符号求解器的伪代码如下:

- 输入:起始状态、目标状态,以及一个布尔标志main(表示是否为父线程)。

- 步骤:

1. 初始化队列(state_deque)包含初始状态。

2. 循环处理队列中的每个状态:

- 如果当前状态等于目标状态,返回“Goal reached”。

- 否则,扩展当前状态的所有可能子状态(通过SE函数)。

- 如果当前是父线程(main为true)且状态有前景(is_promising返回true),则进行并行探索:

- 为每个子状态生成一个子线程,每个子线程递归调用APR函数(main设置为false),并行执行。

- 等待所有子线程返回结果(parallel_results),如果任一子线程成功,则返回成功。

- 否则(非前景状态或子线程),将子状态加入队列继续串行搜索。

3. 如果队列耗尽,返回“No result”。

-

训练时,模型学习预测下一个token,包括spawn和join操作。损失函数是标准语言建模损失(交叉熵)。这一步建立了模型对并行执行的基本理解。

-

强化学习端到端优化:监督学习后,使用强化学习(RL)微调模型,以优化任务成功率。RL过程包括:

- 策略:当前语言模型参数化策略,生成推理轨迹(包括spawn/join调用)。

- 奖励函数:基于任务成功(如Countdown中找到正确解)分配二元奖励(1表示成功,0表示失败)。

3. 实验效果:三个维度都赢了

- SoS+:序列化搜索流方法,作为主要串行基线。它通过监督训练生成混合搜索路径。

- 自一致性(cons@n):并行基线,从SoS+独立采样n个推理迹,投票选择最常见解。

- pass@n:上限基线,表示至少一个解正确的概率(通过n次采样计算)。

论文在 “倒计时算术题”(给几个数字,用加减乘除凑目标数)上做了测试,APR 表现很亮眼:

- 同样 “脑子” 大小(4k 上下文窗口):APR 正确率 83.4%,传统串行只有 60%;

- 给更多计算资源(20k 总 tokens):APR 正确率 80.1%,传统并行只有 66.6%;

- 同样耗时(约 5000 毫秒):APR 正确率 75.2%,传统串行只有 57.3%。

简单说,APR 让模型 “思考得又快又准”—— 并行计算减少了等待时间,子线程只返回复核结果避免了 “脑子” 不够用,强化学习让模型越调越聪明,不用人管就能找到最优的思考方式。

![[Pasted image 20251224141414.png]]

关键结果如下:

- 性能对比:APR在相同上下文窗口下准确率更高(4k窗口下83.4% vs. SoS+ 60.0%)。随着计算预算增加(总token数),APR缩放更好(20k token时80.1% vs. SoS+ cons@7 66.6%)。在相同延迟下(约5000ms),APR准确率75.2% vs. SoS+ 57.3%。

- 消融实验:强化学习(RL)显著提升APR性能(从75.5%到83.4%),主要归因于模型学会增加子线程数量(测试时缩放),而非固定预算下决策质量提升。RL对SoS+提升较小(2.7%),表明APR能更好利用并行化。

- 效率分析:APR的顺序token数远低于SoS+(很少超过2500 token),表明并行化减少了串行瓶颈。实际延迟也更低,得益于硬件并行优化。

Multiverse:基于MapReduce的并行语言生成模型

1. 论文核心概念🔍

这篇论文的核心发现是:当前的自回归大语言模型(AR-LLMs)在顺序生成文本时,其实隐含了大量的并行性,但模型本身无法主动利用这种并行性。具体来说,论文通过分析长链思维(Chain-of-Thought, CoT)轨迹发现,超过98%的示例中存在可并行化的分支(例如,同时处理多个子任务或探索不同路径),但这些分支在AR-LLMs中只能顺序执行,导致生成效率低下。

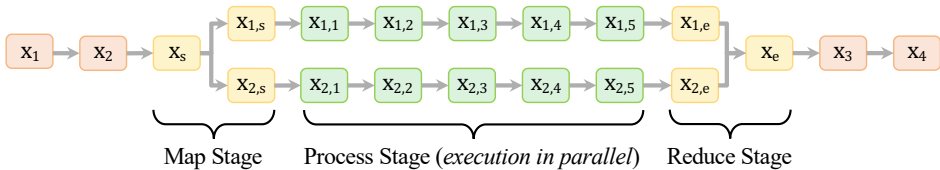

为了解决这个问题,论文提出了Multiverse,一种新的生成模型框架。其核心思路是让语言模型内部化MapReduce范式(一种经典的并行计算模式),从而支持自适应的并行生成。Multiverse将生成过程分为三个阶段:

- Map阶段:顺序生成任务分解计划,将任务拆分为多个子任务。

- Process阶段:并行执行这些子任务,每个子任务独立生成内容。

- Reduce阶段:顺序合并所有子任务的结果,生成最终输出。

这种方法允许模型在生成过程中动态决定何时并行化、如何并行化,并且无损地保留中间状态(如推理步骤),从而在保持模型性能的同时显著提升生成效率。论文通过数据、算法和系统的协同设计,实现了从现有AR-LLMs到Multiverse模型的快速迁移。

2. 论文方法🔬

2.1 过去方法的问题

过去的方法主要分为两类,但都存在局限性:

-

自回归模型(AR-LLMs):这类模型(如GPT系列)通过从左到右顺序生成令牌(token)来输出文本。每个令牌的生成依赖于前面所有令牌,导致生成过程本质上是顺序的。虽然AR-LLMs在推理任务上表现优秀,但顺序生成限制了硬件(如GPU)的并行能力,生成长文本时延迟很高。论文发现,AR-LLMs的推理轨迹中隐含并行性(如同时分析多个案例),但模型无法主动识别或利用这种并行性(通过提示测试和探测测试验证)。

-

非自回归模型:如扩散模型或一致性模型,它们支持并行生成多个令牌,但忽略了令牌间的逻辑依赖关系(例如,在数学推理中,后续步骤可能依赖于前一步的结果)。这种“蛮力并行”会导致计算浪费和错误。此外,这些模型缺乏真实世界的训练数据来指导何时并行生成。

-

外部工具辅助方法:一些研究使用外部工具(如蒙特卡洛树搜索)来启发式地并行化任务,但这种方法在模型与外部模块通信时会丢失内部状态(如中间推理步骤),导致信息不完整。

这些局限性激发了论文的动机:设计一个既能自适应并行化、又能无损保留内部状态的生成框架,适用于多种并行模式(如连续或递归并行)。

2.2 整体框架

Multiverse框架的核心是让语言模型内部化MapReduce范式,通过三个阶段实现自适应并行生成。整个方法包括数据生成(Multiverse Curator)、算法设计(Multiverse Attention)和系统实现(Multiverse Engine)的协同设计。下图展示了Multiverse与自回归模型和扩散模型的对比:

2.2.1 Multiverse建模基础

-

语言建模目标:给定一个令牌序列 x1:L=(x1,x2,…,xL),模型需要学习联合概率分布 P(x1,x2,…,xL)。

-

自回归建模:AR模型将序列概率分解为条件概率的乘积:

P(x1:L∣θAR)=t=1∏LP(xt∣x1,…,xt−1;θAR)

其中 θAR是模型参数。这种分解导致生成必须是顺序的。

-

Multiverse建模:Multiverse通过MapReduce结构消除不必要的顺序依赖。其概率建模涉及三个阶段:

-

Map阶段:模型首先生成一个任务分解计划 xs,然后将每个子任务映射到独立的前缀序列,例如 P(x1,s∣xs)和 P(x2,s∣xs)。

-

Process阶段:每个分支独立并行生成内容,条件于自身的前缀,例如 P(x1,1:6∣x[1:3,s],x1,s)和 P(x2,1:6∣x2,s,x[1:3,s])。

-

Reduce阶段:所有分支完成后,模型切换回顺序生成,合并分支结果,例如 P(xe,[3:4]∣x1,[s,1:6,e],x2,[s,1:6,e],x[1:3,s])。

-

下图直观展示了Multiverse的三阶段流程:

2.2.2 结构化生成流

为了控制生成流程,Multiverse使用一组专用控制标签来定义MapReduce块的结构。这些标签包括:

-

<Parallel>和</Parallel>:标记并行块的开始和结束。 -

<Goal>和</Goal>:在Map阶段定义总体目标,并使用嵌套的<Outline>标签分解子任务。 -

<Path>和</Path>:在Process阶段标记每个并行执行的子任务路径。 -

<Conclusion>和</Conclusion>:在Reduce阶段触发结果合成。

生成示例如下:

<Parallel>

<Goal>

<Outline>1: 计算素数2在20!中的指数</Outline>

<Outline>2: 计算素数3在20!中的指数</Outline>

</Goal>

<Path>1: floor(20/2) + floor(20/4) + ... = 18</Path>

<Path>2: floor(20/3) + floor(20/9) + ... = 8</Path>

<Conclusion>素数2和3的指数分别为18和8。</Conclusion>

</Parallel>

下图展示了一个具体的MapReduce结构示例:

2.2.3 数据生成:Multiverse Curator

由于真实数据缺乏显式并行结构,论文开发了Multiverse Curator,一个LLM辅助的自动化管道,将顺序推理链转换为并行MapReduce结构。管道包括五个步骤:

-

生成摘要树:使用Gemini 2.5 Pro模型将原始推理链分解为树状摘要(先提取主要步骤,再分解子步骤)。

-

识别并行组:分析步骤间的逻辑依赖关系,识别可并行执行的步骤或步骤组。

-

重构为并行结构:使用控制标签(如

<Parallel>)标记并行块。 -

填充原始细节:将原始推理内容填充到并行结构中,保持结构不变。

-

添加MapReduce结构并重写路径:为每个并行块生成Map和Reduce阶段,并重写路径内容以确保独立性(避免引用其他路径)。

整个流程还包含质量检查:内容检查(编辑距离比率超过0.2则重新生成)和语法检查(确保结构有效性)。应用该管道到s1K-1.1数据集后,生成了Multiverse-1K数据集(包含1000个高质量并行推理样本)。

2.2.4 算法设计:Multiverse Attention

为了支持并行生成,论文设计了Multiverse Attention来替代Transformer中的因果注意力(causal attention)。因果注意力的计算为:

aij=Softmax((qi⊤⊙P(i))⋅(kj⊙P(j))+Mij)

其中 Mij=−∞如果 j>i(确保只能关注前面令牌),P(i)是位置嵌入。

Multiverse Attention的修改包括:

-

注意力掩码:在Process阶段,每个路径的注意力计算独立进行,路径间不相互关注。这通过修改掩码 Mij实现,使同一并行块内的路径仅关注自身前缀。

-

位置嵌入:每个路径从相同的位置开始执行,避免路径间的相对位置依赖。在Reduce阶段,所有路径收敛到同一位置(设置为任何路径的最大位置)。

-

优势:这种设计与因果注意力相似,支持硬件高效的并行训练,且只需少量样本即可从AR模型微调而来。

2.2.5 系统实现:Multiverse Engine

为了实际部署并行生成,论文基于SGLang推理引擎实现了Multiverse Engine,关键特性包括:

-

动态切换:通过解释器解析控制标签(如

<Parallel>),动态在顺序和并行生成间切换。 -

Map阶段:当生成

<Parallel>标签时,解释器计数<Outline>数量,创建多个路径(作为同一批次中的不同样本),共享前缀KV缓存。 -

Process阶段:路径并行解码,每个路径以

<Path>i开头;路径完成后进入“僵尸”状态,等待其他路径。 -

Reduce阶段:所有路径完成后,引擎合并所有路径的KV状态和前缀,形成新序列,无需填充或内存复制开销。

下图展示了Multiverse Engine的组件集成:

2.2.6 训练细节

论文通过监督微调(SFT)将Qwen2.5-32B-Instruct模型转换为Multiverse-32B:

-

数据混合:使用Multiverse-1K(带“并行思考”提示)和原始顺序数据(带“逐步思考”提示),动态混合比例从0:1(仅顺序数据)逐渐变为1:0(仅并行数据)。

-

硬件:在8个NVIDIA B200 GPU上使用PyTorch FSDP训练3小时。

-

兼容性:由于Multiverse Attention与因果注意力相似,微调快速且数据高效。

3. 实验结果与分析📊

3.1 实验结果

论文在多个推理任务上评估Multiverse-32B,并与基线模型比较。以下是关键信息:

-

Baseline模型:

-

Qwen2.5-32B-Instruct:原始AR模型作为起点。

-

Autoregressive-32B:使用相同数据训练但无控制标签的AR模型。

-

s1-32B和s1.1-32B:基于顺序CoT数据训练的参考模型(来自s1K-1.1数据集)。

-

-

数据集(每个数据集用一句话介绍):

-

AIME24:美国数学邀请赛2024年试题,包含高难度数学问题,用于评估复杂推理能力。

-

AIME25:美国数学邀请赛2025年试题,类似AIME24但更新,测试模型泛化性。

-

MATH500:包含500个数学单词问题的基准,覆盖代数、几何等领域,衡量基本数学推理。

-

GPQA Diamond:研究生级问答基准,问题需要深度领域知识,用于评估高级推理。

-

-

评估指标:

- pass@1:生成答案的正确率(主要指标)。

- parallel:并行度,计算为总生成令牌数与实际生成长度之比(衡量并行效率)。

实验结果如下表所示(平均超过8个随机种子):

| 模型/指标 | AIME24 pass@1 | AIME24 #parallel | AIME25 pass@1 | AIME25 #parallel | MATH500 pass@1 | MATH500 #parallel | GPQA-Diamond pass@1 | GPQA-Diamond #parallel |

|---|---|---|---|---|---|---|---|---|

| s1-32B | 35.4 | 1.00 | 25.8 | 1.00 | 88.6 | 1.00 | 48.0 | 1.00 |

| s1.1-32B | 52.9 | 1.00 | 41.7 | 1.00 | 93.4 | 1.00 | 62.6 | 1.00 |

| Qwen2.5-32B-Instruct | 15.8 | 1.00 | 10.4 | 1.00 | 80.4 | 1.00 | 47.0 | 1.00 |

| Autoregressive-32B | 54.6 | 1.00 | 45.0 | 1.00 | 92.8 | 1.00 | 61.6 | 1.00 |

| Multiverse-32B-zero | 52.1 | 1.04 | 44.2 | 1.05 | 92.4 | 1.12 | 63.6 | 1.17 |

| Multiverse-32B | 53.8 | 1.18 | 45.8 | 1.15 | 91.8 | 1.15 | 60.7 | 1.17 |

关键发现:

- Multiverse-32B在AIME24和AIME25上分别达到53.8%和45.8%的pass@1,与AR模型(如Autoregressive-32B)性能相当,表明并行生成未牺牲准确性。

- 并行度(#parallel)大于1,证明模型成功实现了并行生成(例如,在GPQA-Diamond上达1.17倍)。

- 缩放实验显示,在固定上下文长度(即相同生成时间)下,Multiverse-32B生成更多令牌,性能提升1.87% on average。

- 效率分析表明,并行度提升可带来延迟降低,最高实现2倍加速(见下图)。

总之,Multiverse通过MapReduce范式实现了高效的并行生成,在保持推理性能的同时显著提升速度,为替代自回归生成提供了新路径。

浙公网安备 33010602011771号

浙公网安备 33010602011771号