2.线程同步

主要根据这篇文章进行总结学习https://subingwen.cn/linux/thread-sync/

1.线程同步概念

假设有4个线程A、B、C、D,当前一个线程A对内存中的共享资源进行访问的时候,其他线程B, C, D都不可以对这块内存进行操作,直到线程A对这块内存访问完毕为止,B,C,D中的一个才能访问这块内存,剩余的两个需要继续阻塞等待,以此类推,直至所有的线程都对这块内存操作完毕。线程对内存的这种访问方式就称之为线程同步,通过对概念的介绍,我们可以了解到所谓的同步并不是多个线程同时对内存进行访问,而是按照先后顺序依次进行的。

1.1 为什么要同步

点击查看代码

#include <stdio.h>

#include <unistd.h>

#include <stdlib.h>

#include <sys/types.h>

#include <sys/stat.h>

#include <string.h>

#include <pthread.h>

#define MAX 50

// 全局变量

int number;

// 线程处理函数

void* funcA_num(void* arg)

{

for(int i=0; i<MAX; ++i)

{

int cur = number;

cur++;

usleep(10);

number = cur;

printf("Thread A, id = %lu, number = %d\n", pthread_self(), number);

}

return NULL;

}

void* funcB_num(void* arg)

{

for(int i=0; i<MAX; ++i)

{

int cur = number;

cur++;

number = cur;

printf("Thread B, id = %lu, number = %d\n", pthread_self(), number);

usleep(5);

}

return NULL;

}

int main(int argc, const char* argv[])

{

pthread_t p1, p2;

// 创建两个子线程

pthread_create(&p1, NULL, funcA_num, NULL);

pthread_create(&p2, NULL, funcB_num, NULL);

// 阻塞,资源回收

pthread_join(p1, NULL);

pthread_join(p2, NULL);

return 0;

}

编译并执行上面的测试程序,得到如下结果:

点击查看代码

$ ./a.out

Thread B, id = 140504473724672, number = 1

Thread B, id = 140504473724672, number = 2

Thread A, id = 140504482117376, number = 2

Thread B, id = 140504473724672, number = 3

Thread A, id = 140504482117376, number = 4

Thread B, id = 140504473724672, number = 5

Thread A, id = 140504482117376, number = 6

Thread B, id = 140504473724672, number = 7

Thread B, id = 140504473724672, number = 8

Thread A, id = 140504482117376, number = 7

Thread B, id = 140504473724672, number = 8

Thread B, id = 140504473724672, number = 9

Thread A, id = 140504482117376, number = 8

Thread B, id = 140504473724672, number = 9

Thread A, id = 140504482117376, number = 9

Thread B, id = 140504473724672, number = 10

Thread B, id = 140504473724672, number = 11

Thread A, id = 140504482117376, number = 10

Thread B, id = 140504473724672, number = 11

Thread A, id = 140504482117376, number = 11

Thread B, id = 140504473724672, number = 12

Thread A, id = 140504482117376, number = 13

Thread B, id = 140504473724672, number = 14

Thread A, id = 140504482117376, number = 15

Thread B, id = 140504473724672, number = 16

Thread B, id = 140504473724672, number = 17

Thread B, id = 140504473724672, number = 18

Thread B, id = 140504473724672, number = 19

Thread A, id = 140504482117376, number = 17

Thread B, id = 140504473724672, number = 18

Thread B, id = 140504473724672, number = 19

Thread A, id = 140504482117376, number = 19

Thread B, id = 140504473724672, number = 20

Thread A, id = 140504482117376, number = 20

Thread B, id = 140504473724672, number = 21

Thread A, id = 140504482117376, number = 21

Thread B, id = 140504473724672, number = 22

Thread A, id = 140504482117376, number = 22

Thread B, id = 140504473724672, number = 23

Thread A, id = 140504482117376, number = 23

Thread B, id = 140504473724672, number = 24

Thread A, id = 140504482117376, number = 24

Thread B, id = 140504473724672, number = 25

Thread A, id = 140504482117376, number = 25

Thread B, id = 140504473724672, number = 26

Thread A, id = 140504482117376, number = 26

Thread B, id = 140504473724672, number = 27

Thread A, id = 140504482117376, number = 27

Thread B, id = 140504473724672, number = 28

Thread A, id = 140504482117376, number = 28

Thread B, id = 140504473724672, number = 29

Thread A, id = 140504482117376, number = 29

Thread B, id = 140504473724672, number = 30

Thread A, id = 140504482117376, number = 30

Thread B, id = 140504473724672, number = 31

Thread A, id = 140504482117376, number = 31

Thread B, id = 140504473724672, number = 32

Thread A, id = 140504482117376, number = 32

Thread B, id = 140504473724672, number = 33

Thread A, id = 140504482117376, number = 33

Thread B, id = 140504473724672, number = 34

Thread A, id = 140504482117376, number = 34

Thread B, id = 140504473724672, number = 35

Thread A, id = 140504482117376, number = 35

Thread B, id = 140504473724672, number = 36

Thread A, id = 140504482117376, number = 36

Thread B, id = 140504473724672, number = 37

Thread A, id = 140504482117376, number = 37

Thread B, id = 140504473724672, number = 38

Thread A, id = 140504482117376, number = 38

Thread B, id = 140504473724672, number = 39

Thread A, id = 140504482117376, number = 39

Thread A, id = 140504482117376, number = 40

Thread B, id = 140504473724672, number = 41

Thread B, id = 140504473724672, number = 42

Thread A, id = 140504482117376, number = 42

Thread A, id = 140504482117376, number = 43

Thread B, id = 140504473724672, number = 44

Thread B, id = 140504473724672, number = 45

Thread A, id = 140504482117376, number = 45

Thread B, id = 140504473724672, number = 46

Thread A, id = 140504482117376, number = 46

Thread B, id = 140504473724672, number = 47

Thread A, id = 140504482117376, number = 47

Thread B, id = 140504473724672, number = 48

Thread A, id = 140504482117376, number = 48

Thread B, id = 140504473724672, number = 49

Thread A, id = 140504482117376, number = 50

Thread B, id = 140504473724672, number = 51

Thread A, id = 140504482117376, number = 51

Thread B, id = 140504473724672, number = 52

Thread A, id = 140504482117376, number = 53

Thread A, id = 140504482117376, number = 54

Thread A, id = 140504482117376, number = 55

Thread A, id = 140504482117376, number = 56

Thread A, id = 140504482117376, number = 57

Thread A, id = 140504482117376, number = 58

Thread A, id = 140504482117376, number = 59

Thread A, id = 140504482117376, number = 60

Thread A, id = 140504482117376, number = 61

通过对上面例子的测试,可以看出虽然每个线程内部循环了50次每次数一个数,但是最终没有数到100,通过输出的结果可以看到,有些数字被重复数了多次,其原因就是没有对线程进行同步处理,造成了数据的混乱。

两个线程在数数的时候需要分时复用CPU时间片,并且测试程序中调用了sleep()导致线程的CPU时间片没用完就被迫挂起了,这样就能让CPU的上下文切换(保存当前状态, 下一次继续运行的时候需要加载保存的状态)更加频繁,更容易再现数据混乱的这个现象。

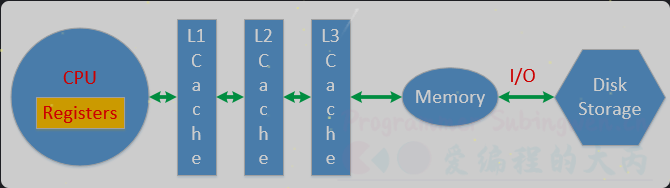

CPU对应寄存器、一级缓存、二级缓存、三级缓存是独占的,用于存储处理的数据和线程的状态信息,数据被CPU处理完成需要再次被写入到物理内存中,物理内存数据也可以通过文件IO操作写入到磁盘中。

在测试程序中两个线程共用全局变量number当线程变成运行态之后开始数数,从物理内存加载数据,然后将数据放到CPU进行运算,最后将结果更新到物理内存中。如果数数的两个线程都可以顺利完成这个流程,那么得到的结果肯定是正确的。

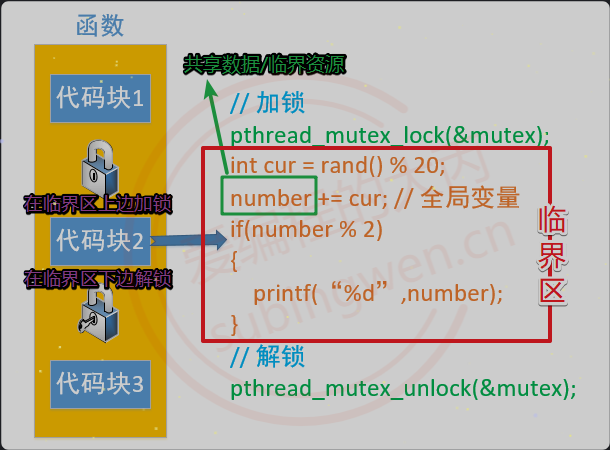

1.2同步方式

对于多个线程访问共享资源出现数据混乱的问题,需要进行线程同步。常用的线程同步方式有四种:互斥锁、读写锁、条件变量、信号量。所谓的共享资源就是多个线程共同访问的变量,这些变量通常为全局数据区变量或者堆区变量,这些变量对应的共享资源也被称之为临界资源。

找到临界资源之后,再找和临界资源相关的上下文代码,这样就得到了一个代码块,这个代码块可以称之为临界区。确定好临界区(临界区越小越好)之后,就可以进行线程同步了,线程同步的大致处理思路是这样的:

就像厕所的坑一样

- 在临界区代码的上边,添加加锁函数,对临界区加锁。

-

- 哪个线程调用这句代码,就会把这把锁锁上,其他线程就只能阻塞在锁上了。

- 在临界区代码的下边,添加解锁函数,对临界区解锁。

-

- 出临界区的线程会将锁定的那把锁打开,其他抢到锁的线程就可以进入到临界区了。

- 通过锁机制能保证临界区代码最多只能同时有一个线程访问,这样并行访问就变为串行访问了。

2.互斥锁

只能被一个线程所拥有

两种状态:锁定,打开

被谁锁

2.1互斥锁函数

在Linux中互斥锁的类型为pthread_mutex_t,创建一个这种类型的变量就得到了一把互斥锁:

pthread_mutex_t mutex;

// 初始化互斥锁

// restrict: 是一个关键字, 用来修饰指针, **只有这个关键字修饰的指针可以访问指向的内存地址**, 其他指针是不行的,比如a=restrict mutex也不行

int pthread_mutex_init(pthread_mutex_t *restrict mutex,

const pthread_mutexattr_t *restrict attr);

// 释放互斥锁资源

int pthread_mutex_destroy(pthread_mutex_t *mutex);

参数:

mutex: 互斥锁变量的地址

attr: 互斥锁的属性, 一般使用默认属性即可, 这个参数指定为NULL

// 修改互斥锁的状态, **将其设定为锁定状态**, 这个状态被写入到参数mutex中

int pthread_mutex_lock(pthread_mutex_t *mutex);

这个函数被调用, 首先会判断参数 mutex 互斥锁中的状态是不是锁定状态:

- 没有被锁定, 是打开的, 这个线程可以加锁成功, 这个这个锁中会记录是哪个线程加锁成功了

- 如果被锁定了, 其他线程加锁就失败了, 这些线程都会阻塞在这把锁上

- 当这把锁被解开之后, 这些阻塞在锁上的线程就解除阻塞了,并且这些线程是通过竞争的方式对这把锁加锁,没抢到锁的线程继续阻塞

// 尝试加锁

int pthread_mutex_trylock(pthread_mutex_t *mutex);

调用这个函数对互斥锁变量加锁还是有两种情况:

- 如果这把锁没有被锁定是打开的,线程加锁成功

- 如果锁变量被锁住了,调用这个函数加锁的线程,不会被阻塞,加锁失败直接返回错误号

// 对互斥锁解锁

int pthread_mutex_unlock(pthread_mutex_t *mutex);

不是所有的线程都可以对互斥锁解锁,哪个线程加的锁, 哪个线程才能解锁成功。

3.死锁

死锁造成的后果是:所有的线程都被阻塞,并且线程的阻塞是无法解开的(因为可以解锁的线程也被阻塞了)。

造成死锁的场景有如下几种:

- 加锁之后忘记解锁

- 重复加锁, 造成死锁

- 在程序中有多个共享资源, 因此有很多把锁,随意加锁,导致相互被阻塞

场景描述:

- 有两个共享资源:X, Y,X对应锁A, Y对应锁B

- 线程A访问资源X, 加锁A

- 线程B访问资源Y, 加锁B

- 线程A要访问资源Y, 线程B要访问资源X,因为资源X和Y已经被对应的锁锁住了,因此这个两个线程被阻塞

- 线程A被锁B阻塞了, 无法打开A锁

- 线程B被锁A阻塞了, 无法打开B锁

4.读写锁

一把锁,但是能做两件事

4.1读写锁函数

pthread_rwlock_t rwlock;//锁的类型为pthread_rwlock_t

之所以称其为读写锁,是因为这把锁既可以锁定读操作,也可以锁定写操作。

锁的状态: 锁定/打开

锁定的是什么操作: 读操作/写操作,使用读写锁锁定了读操作,需要先解锁才能去锁定写操作,反之亦然。

哪个线程将这把锁锁上了

使用读写锁的读锁锁定了临界区,线程对临界区的访问是并行的,读锁是共享的。

使用读写锁的写锁锁定了临界区,线程对临界区的访问是串行的,写锁是独占的。

使用读写锁分别对两个临界区加了读锁和写锁,两个线程要同时访问者两个临界区,访问写锁临界区的线程继续运行,访问读锁临界区的线程阻塞,因为写锁比读锁的优先级高。

#include <pthread.h>

pthread_rwlock_t rwlock;

// 初始化读写锁

int pthread_rwlock_init(pthread_rwlock_t *restrict rwlock,

const pthread_rwlockattr_t *restrict attr);

// 释放读写锁占用的系统资源

int pthread_rwlock_destroy(pthread_rwlock_t *rwlock);

参数:

rwlock: 读写锁的地址,传出参数

attr: 读写锁属性,一般使用默认属性,指定为NULL

// 在程序中对读写锁加读锁, 锁定的是读操作

int pthread_rwlock_rdlock(pthread_rwlock_t *rwlock);

调用这个函数,如果读写锁是打开的,那么加锁成功;如果读写锁已经锁定了读操作,调用这个函数依然可以加锁成功,因为读锁是共享的;如果读写锁已经锁定了写操作,调用这个函数的线程会被阻塞。

// 这个函数可以有效的避免死锁

// 如果加读锁失败, 不会阻塞当前线程, 直接返回错误号

int pthread_rwlock_tryrdlock(pthread_rwlock_t *rwlock);

// 在程序中对读写锁加写锁, 锁定的是写操作

int pthread_rwlock_wrlock(pthread_rwlock_t *rwlock);

调用这个函数,如果读写锁是打开的,那么加锁成功;如果读写锁已经锁定了读操作或者锁定了写操作,调用这个函数的线程会被阻塞。

// 这个函数可以有效的避免死锁

// 如果加写锁失败, 不会阻塞当前线程, 直接返回错误号

int pthread_rwlock_trywrlock(pthread_rwlock_t *rwlock);

// 解锁, 不管锁定了读还是写都可用解锁

int pthread_rwlock_unlock(pthread_rwlock_t *rwlock);

5.条件变量

5.1条件变量函数

条件变量只有在满足指定条件下才会阻塞线程

pthread_cond_t cond;//条件变量类型对应的类型为pthread_cond_t

被条件变量阻塞的线程的线程信息会被记录到这个变量中,以便在解除阻塞的时候使用。

条件变量操作函数函数原型如下:

#include <pthread.h>

pthread_cond_t cond;

// 初始化

int pthread_cond_init(pthread_cond_t *restrict cond,

const pthread_condattr_t *restrict attr);

// 销毁释放资源

int pthread_cond_destroy(pthread_cond_t *cond);

参数:

cond: 条件变量的地址

attr: 条件变量属性, 一般使用默认属性, 指定为NULL

// 线程阻塞函数, 哪个线程调用这个函数, 哪个线程就会被阻塞

int pthread_cond_wait(pthread_cond_t *restrict cond, pthread_mutex_t *restrict mutex);//阻塞时,在函数内部会把互斥锁打开

通过函数原型可以看出,该函数在阻塞线程的时候,需要一个互斥锁参数,这个互斥锁主要功能是进行线程同步,让线程顺序进入临界区,避免出现数共享资源的数据混乱。该函数会对这个互斥锁做以下几件事情:

在阻塞线程时候,如果线程已经对互斥锁mutex上锁,那么会将这把锁打开,这样做是为了避免死锁

当线程解除阻塞的时候,函数内部会帮助这个线程再次将这个mutex互斥锁锁上,继续向下访问临界区

// 表示的时间是从1971.1.1到某个时间点的时间, 总长度使用秒/纳秒表示

struct timespec {

time_t tv_sec; /* Seconds */

long tv_nsec; /* Nanoseconds [0 .. 999999999] */

};

// 将线程阻塞一定的时间长度, 时间到达之后, 线程就解除阻塞了

int pthread_cond_timedwait(pthread_cond_t *restrict cond,

pthread_mutex_t *restrict mutex, const struct timespec *restrict abstime);

这个函数的前两个参数和pthread_cond_wait函数是一样的,第三个参数表示线程阻塞的时长。

// 唤醒阻塞在条件变量上的线程, 至少有一个被解除阻塞

int pthread_cond_signal(pthread_cond_t *cond);

// 唤醒阻塞在条件变量上的线程, 被阻塞的线程全部解除阻塞

int pthread_cond_broadcast(pthread_cond_t *cond);

5.2生产者和消费者

生产者和消费者模型的组成:

- 生产者线程 -> 若干个

-

- 生产商品或者任务放入到任务队列中

-

- 任务队列满了就阻塞, 不满的时候就工作

-

- 通过一个生产者的条件变量控制生产者线程阻塞和非阻塞

- 消费者线程 -> 若干个

-

- 读任务队列, 将任务或者数据取出

-

- 任务队列中有数据就消费,没有数据就阻塞

-

- 通过一个消费者的条件变量控制消费者线程阻塞和非阻塞

- 队列 -> 存储任务/数据,对应一块内存,为了读写访问可以通过一个数据结构维护这块内存

-

- 可以是数组、链表,也可以使用stl容器:queue / stack / list / vector

6.信号量

信号量(信号灯)与互斥锁和条件变量的主要不同在于”灯”的概念,灯亮则意味着资源可用,灯灭则意味着不可用。信号量主要阻塞线程, 不能完全保证线程安全,如果要保证线程安全, 需要信号量和互斥锁一起使用。

6.1信号量函数

#include <semaphore.h>

sem_t sem;//信号的类型为sem_t

#include <semaphore.h>

// 初始化信号量/信号灯

int sem_init(sem_t *sem, int pshared, unsigned int value);

// 资源释放, 线程销毁之后调用这个函数即可

// 参数 sem 就是 sem_init() 的第一个参数

int sem_destroy(sem_t *sem);

参数:

sem:信号量变量地址

pshared:

- 0:线程同步

- 非0:进程同步

value:初始化当前信号量拥有的资源数(>=0),如果资源数为0,线程就会被阻塞了。

// 参数 sem 就是 sem_init() 的第一个参数

// 函数被调用,sem中的资源就会被消耗1个, 资源数-1

int sem_wait(sem_t *sem);

当线程调用这个函数,并且sem中的资源数>0,线程不会阻塞,线程会占用sem中的一个资源,因此资源数-1,直到sem中的资源数减为0时,资源被耗尽,因此线程也就被阻塞了。

// 参数 sem 就是 sem_init() 的第一个参数

// 函数被调用sem中的资源就会被消耗1个, 资源数-1

int sem_trywait(sem_t *sem);

当线程调用这个函数,如果资源被耗尽,线程不会被阻塞,直接返回错误号

// 表示的时间是从1971.1.1到某个时间点的时间, 总长度使用秒/纳秒表示

struct timespec {

time_t tv_sec; /* Seconds */

long tv_nsec; /* Nanoseconds [0 .. 999999999] */

};

// 调用该函数线程获取sem中的一个资源,当资源数为0时,线程阻塞,在阻塞abs_timeout对应的时长之后,解除阻塞。

// abs_timeout: 阻塞的时间长度, 单位是s, 是从1970.1.1开始计算的

int sem_timedwait(sem_t *sem, const struct timespec *abs_timeout);

当线程调用这个函数,如果资源被耗尽,线程被阻塞,当阻塞指定的时长之后,线程解除阻塞。

// 调用该函数给sem中的资源数+1

int sem_post(sem_t *sem);

// 查看信号量 sem 中的整形数的当前值, 这个值会被写入到sval指针对应的内存中

// sval是一个传出参数

int sem_getvalue(sem_t *sem, int *sval);

6.2生产者和消费者

初始化信号量的时候没有消费者分配资源,消费者线程启动之后由于没有资源自然就被阻塞了,等生产者生产出产品之后,再给消费者分配资源,这样二者就可以配合着完成生产和消费流程了。

6.3信号量使用

6.3.1总资源数为1

如果生产者和消费者使用的信号量总资源数为1,那么不会出现生产者线程和消费者线程同时访问共享资源的情况,不管生产者和消费者线程有多少个,它们都是顺序执行的。

6.3.2总资源数大于1

如果生产者和消费者线程使用的信号量对应的总资源数为大于1,这种场景下出现的情况就比较多了:

- 多个生产者线程同时生产

- 多个消费者同时消费

- 生产者线程和消费者线程同时生产和消费

以上不管哪一种情况都可能会出现多个线程访问共享资源的情况,如果想防止共享资源出现数据混乱,那么就需要使用互斥锁进行线程同步

浙公网安备 33010602011771号

浙公网安备 33010602011771号