2026 年最全 Ollama 下载安装教程(Windows 版本详解)

前言

随着 LLM(大型语言模型)生态的不断完善,越来越多开发者希望在本地部署模型以便定制化使用。可是传统方案中,环境配置往往是最大障碍:CUDA 驱动冲突、Python 依赖混乱、模型权重动辄几十 GB,这些问题足以让人望而却步。本篇 Ollama下载安装教程 将完整讲解如何在 Windows 平台上快速安装、配置并运行 Ollama,大幅降低本地部署 LLM 的门槛。

可以通过以下链接下载(经过毒霸安全认证):

https://dubapkg.cmcmcdn.com/cs/257def/ollama.exe

一、为什么值得使用 Ollama

如果你接触过 HuggingFace 或者 LangChain,一定体会过环境兼容和依赖管理的痛苦。Ollama 的出现,为本地化运行大语言模型提供了一个更加轻量的解决路线。

其最大特点,是将模型权重、推理引擎与运行配置整体封装为一个 Modelfile,运行方式类似于 Docker 镜像。你无需再手写 Python 脚本,仅一条命令:

ollama run llama3

即可在本地完成模型启动。它在 CPU 与 GPU 之间实现混合推理,在显存有限的电脑上也能顺利执行 8B 或 70B 模型,特别适合想在个人环境中尝试大模型的开发者。

二、Ollama 下载安装教程(Windows 版)

多数开发者在部署初期会遇到“下载缓慢”或“连接中断”的情况,这主要是因为镜像源位于海外。以下步骤可帮助你快速完成 Ollama 的下载与安装。

1. 获取安装包

访问提供的加速源,下载最新版 Windows 64 位安装文件(.exe)。建议保存至非系统盘根目录,以便后续快速更新。

或者可以通过以下链接下载(经过毒霸安全认证):

https://dubapkg.cmcmcdn.com/cs/257def/ollama.exe

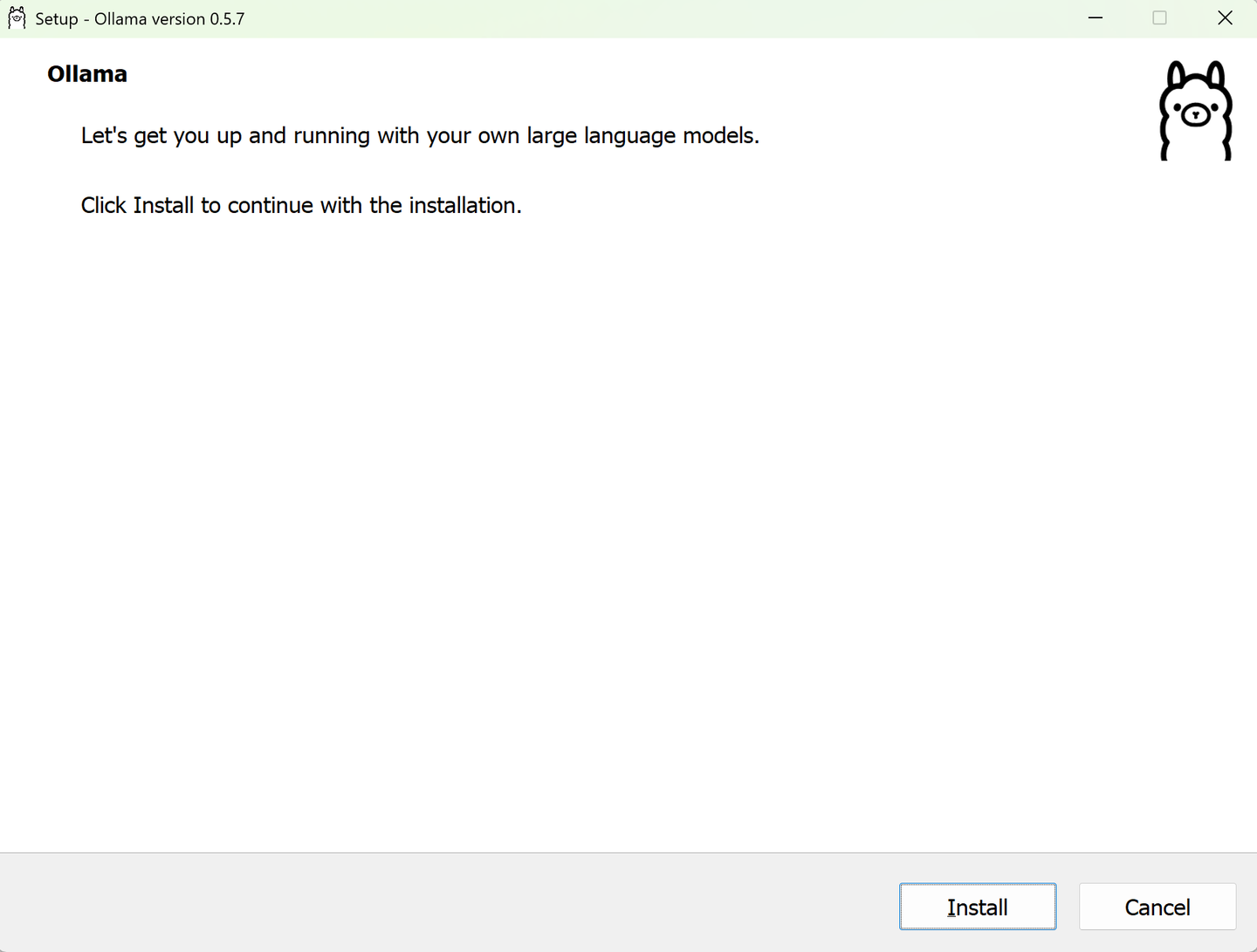

2. 安装步骤

Windows 环境下的安装几乎零门槛:

- 双击运行下载好的 ollama.exe。

- 点击 “Install”。默认路径:

- C:\Users\你的用户名\AppData\Local\Programs\Ollama

- 安装完成后,Ollama 会在后台启动,并在任务栏出现羊驼图标。

当前版本暂不支持在安装界面自定义路径,但这对后续使用无影响。模型数据体积较大,路径可以通过环境变量调整,具体方法见后文。

3. 验证是否安装成功

打开 PowerShell 或 CMD,输入以下命令验证版本信息:

ollama --version

若命令输出类似:

ollama version 0.5.x

则说明安装成功且环境变量已自动配置完毕。

三、运行首个模型:Llama3 与 Qwen 实测

Ollama 的核心价值在于“一条命令即可运行模型”。安装完成后,我们可以立即拉取并测试模型。

1. 拉取并运行模型

在终端中执行:

运行 Llama3(8B 模型):

ollama run llama3

运行 Qwen 2.5(中文优化较好):

ollama run qwen2.5

首次执行命令时,系统会自动下载模型文件。文件体积较大(数 GB 级别),下载速度取决于带宽。下载完成后系统将自动进入交互界面。输入 /bye 可退出。

2. 常用命令速查表

| 命令 | 功能说明 | 示例 |

|---|---|---|

| ollama pull [模型名] | 下载模型但不运行 | ollama pull llama3 |

| ollama list | 查看本地已下载模型列表 | ollama list |

| ollama rm [模型名] | 删除指定模型 | ollama rm llama3 |

| ollama serve | 启动本地 API 服务(端口 11434) | ollama serve |

四、进阶配置:修改模型存储路径

默认情况下,Ollama 会将下载的模型存储在:

C:\Users\你的用户名.ollama\models

考虑到模型体积动辄几十 GB,该路径可能迅速占满系统盘。通过设置系统环境变量,可轻松修改模型存储位置。

操作步骤

- 关闭 Ollama 服务:

- 在任务栏右下角点击羊驼图标,选择 “Quit Ollama”。

- 进入系统环境变量设置:

- “此电脑”右键 → 属性 → 高级系统设置 → 环境变量。

- 新增系统变量:

- 变量名:OLLAMA_MODELS

- 变量值:如 D:\AI_Models

- 重启 Ollama 程序。

修改成功后,新下载的模型文件将自动存储到指定路径,从而彻底避免 C 盘空间不足问题。

五、开发者接口与二次集成

Ollama 不仅可以直接作为交互式命令行工具使用,也支持 API 接口集成,适合用于内网推理、知识问答系统或应用自动化。

1. 启动本地服务

Ollama 安装完成后,会默认在 localhost:11434 启动 API 端口。用户可以通过简单的 HTTP 请求调用模型。

2. Python 接口调用示例

import requests

import json

url = "http://localhost:11434/api/generate"

data = {

"model": "llama3",

"prompt": "用Python实现一个冒泡排序",

"stream": False

}

response = requests.post(url, json=data)

print(response.json()['response'])

通过这种方式,可轻松将本地 LLM 功能接入到自定义应用中,例如 Web 后端、自动化脚本或企业知识库。

3. 可视化界面方案

对于偏好图形化界面的用户,可以选择 Open WebUI 或 Chatbox。后者的使用方式更为轻量,只需将接口地址设置为:

http://localhost:11434

即可实现类似聊天机器人的交互体验。

六、常见问题与解决方案

Q1:模型下载速度很慢或中断?

网络延迟是主要原因。可尝试配置代理,或使用稳定的加速镜像源获取安装包。确保网络连接稳定后再运行命令。

Q2:显存不足导致运行卡顿?

Ollama 默认执行 FP16 精度推理。若显存紧张,可尝试量化模型版本,例如:

ollama run llama3:8b-instruct-q4_0

Q4 量化能显著降低资源占用,8GB 显存环境亦可流畅运行。

Q3:如何让其他设备访问我的 Ollama 服务?

默认绑定地址为 127.0.0.1,仅本机可访问。若希望局域网访问,可设置系统变量:

OLLAMA_HOST=0.0.0.0

重启后即可从局域网中其他终端访问。

七、总结与经验建议

通过本篇 Ollama下载安装教程(Windows 版),我们完成了以下关键步骤:

- 了解了 Ollama 的封装机制与轻量化特性

- 成功在 Windows 上完成安装配置

- 掌握了模型拉取、运行及路径迁移方法

- 掌握 API 调用及本地化集成用法

在本地部署 LLM 的领域中,Ollama 提供了更接近生产环境的体验 —— 它不依赖复杂框架、不要求手动搭建推理后端,极大地缩短了从试验到上线的周期。

对于个人开发者而言,Ollama 既能充当快速原型验证工具,也可作为企业内部私有化推理的中间层。未来的 LLM 应用生态正在向本地化与模块化演进,而 Ollama 已在这条路上确立了清晰的方向。

最后附上下载链接(经过毒霸安全认证):

https://dubapkg.cmcmcdn.com/cs/257def/ollama.exe

浙公网安备 33010602011771号

浙公网安备 33010602011771号