【2025最新】Ollama 下载安装教程(超详细图文步骤 + 本地大模型离线运行指南)

一、Ollama 是什么?为什么越来越多人在用?

如果你正在寻找一个简单、安全、免费的方式在 本地运行各种大模型(如 Llama、Qwen、Mixtral、Gemma),那么 Ollama 就是目前最轻松的方案之一。

它的优势非常明显:

- 支持本地推理,数据不上云,隐私安全

- 一键拉取 & 一条命令运行大模型

- 无需复杂配置、无需 CUDA,也能运行 CPU 版本

- 提供 REST API,可直接接入本地应用、网页、脚本

- 模型生态丰富:Llama、Qwen、Mistral、Phi、Gemma 都能跑

无论你是开发者、AI 爱好者,还是想在本地体验大模型的普通用户,阅读本篇 Ollama 下载安装教程 就足够你完成入门。

二、Ollama官方下载与安装包地址(安全可用)

为方便国内用户下载,你可以使用以下经过毒霸安全认证的安装包:

👉 Ollama Windows 安装包(直链下载):

https://dubapkg.cmcmcdn.com/cs/257def/ollama.exe

该安装包为 Windows 系统专用,下载完成后双击即可安装。

⚠️ 提醒:Ollama 官方支持 Windows 10/11(64 位)。

三、Ollama 安装步骤(新手也能看懂)

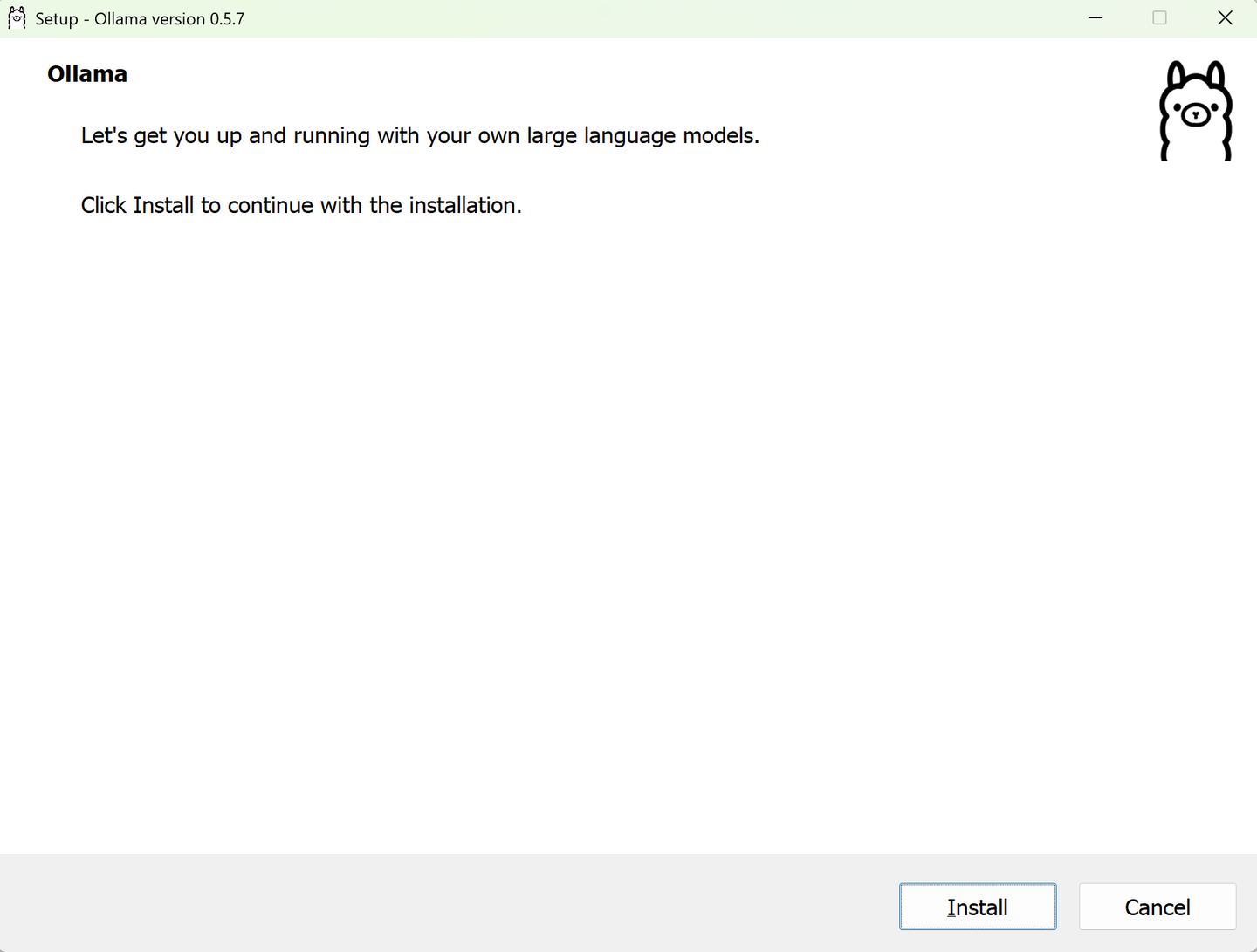

步骤 1:运行安装程序

下载完成后,双击 ollama.exe。

系统会弹出 UAC 询问是否允许安装,点击 “是”。

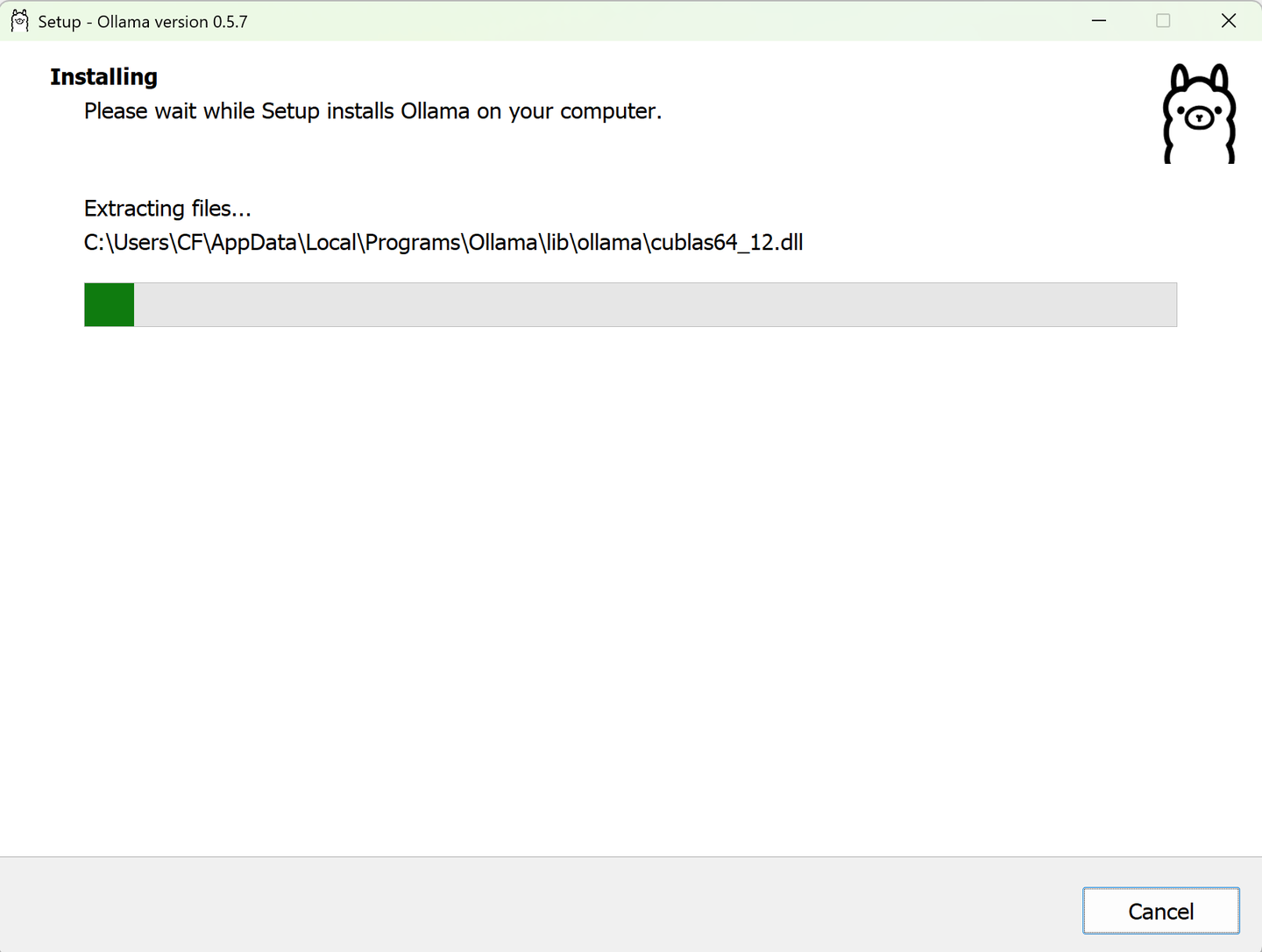

步骤 2:静默安装过程

Ollama 的安装过程实际上很简单,不需要手动操作:

- 自动复制文件

- 自动注册系统服务

- 自动配置本地端口(默认 11434)

安装通常只需要 10 秒左右。

步骤 3:安装完成后自动启动

安装完成后,Ollama 会自动启动一个本地服务,你无需额外设置,就能开始使用模型了。

你可以打开 PowerShell / CMD 或 Windows Terminal,输入:

正常情况下你会看到可用命令提示。

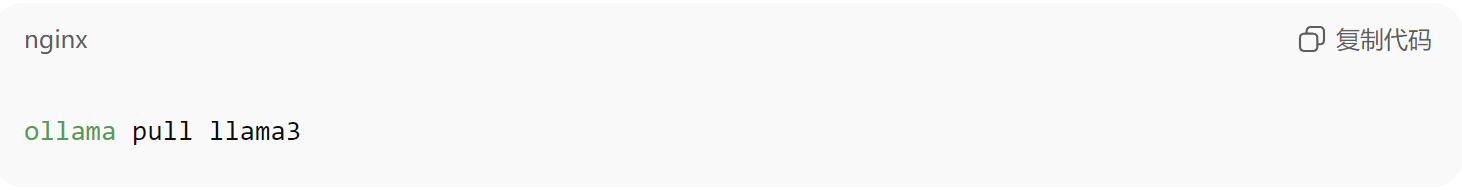

四、首次使用:下载 & 运行你的第一个大模型

Ollama 的核心体验就是“拉取模型”。

例如,拉取(下载)Llama3 8B 模型:

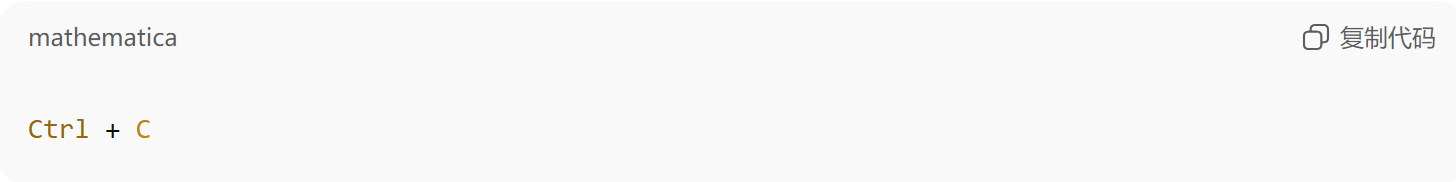

完成后,运行模型:

出现提示符后,你就可以像聊天一样与模型互动。

如果你想退出,按:

五、常用模型推荐(可直接复制)

| 模型名称 | 推荐用途 | 拉取命令 |

|---|---|---|

| llama3:8b | 通用任务、日常对话 | ollama pull llama3 |

| qwen2:7b | 中文能力强、代码不错 | ollama pull qwen2 |

| gemma:7b | 谷歌轻量模型 | ollama pull gemma |

| phi3:mini | 超轻量、适合低配电脑 | ollama pull phi3 |

| mistral:7b | 英文代码能力优秀 | ollama pull mistral |

提示:如果你只想轻量体验,推荐从 phi3:mini 或 llama3:instruct 开始。

六、Ollama 常见问题解决(强烈建议收藏)

1. 提示 “无法连接到服务器”

打开浏览器访问:http://localhost:11434

- 能打开:说明服务正常

- 打不开:请尝试重启 Ollama 服务

![image]()

2. 下载模型速度慢

解决方法:

- 使用代理

- 切换网络

- 换运行时间(晚间更快)

Ollama 模型的体积普遍较大(3GB~10GB),速度慢属于正常现象。

3. GPU 没生效?仍然在用 CPU 推理?

检查显卡:

若 GPU 显示 “0”,请检查是否:

- 显卡驱动太旧

- 没安装 NVIDIA CUDA(仅 NVIDIA 显卡可用)

- 使用 AMD / Intel 显卡暂时只支持部分模型

七、如何在应用中调用 Ollama(开发者必看)

Ollama 默认开启 REST API,地址为:

http://localhost:11434/api/generate

最简单的调用方式:

你可以在:

- Python 脚本

- 网页前端

- Node.js 项目

- 本地软件

中完全无缝调用,开发体验非常友好。

八、Ollama 卸载方法

如需卸载:

- 打开 “设置 → 应用 → 已安装应用”

- 搜索“Ollama”

- 点击卸载即可

不会残留服务、不会占用后台。

九、总结:本地大模型最佳方案,入门首选 Ollama

通过本文的 Ollama 下载安装教程,你已经掌握:

- Windows 快速下载 & 安装方法

- 常见模型下载命令

- 如何启动、运行、调用模型

- GPU/速度常见问题处理

Ollama 的优势让它正在成为国内外开发者的本地推理首选平台。如果你想在自己的电脑上安全、私密、快速地运行大模型,从 Ollama 入门完全足够。

浙公网安备 33010602011771号

浙公网安备 33010602011771号