基于LSTM深度学习网络的视频类型分类算法matlab仿真

1.前言

视频类型分类是计算机视觉与多媒体分析领域的核心任务,旨在通过算法自动识别视频的语义类别(如动作片、喜剧、纪录片、动画片等)。该任务的核心挑战在于:视频是时空混合的动态序列数据,既包含单帧内的空间视觉信息(如场景、人物、物体),又包含帧间的时序依赖关系(如动作变化、情节推进)。例如,动作片的帧间运动剧烈且时序变化快,纪录片的场景切换平缓,喜剧片则可能存在重复的幽默场景模式。 传统方法(如基于手工特征的 SVM 分类、基于帧统计特征的机器学习方法)难以捕捉复杂的时序依赖,而深度学习中的循环神经网络(RNN)虽能处理序列数据,但存在 “长程依赖遗忘” 问题 —— 当序列过长时,早期信息会逐渐丢失,无法学习视频中跨长时间跨度的关联。 长短期记忆网络(Long Short-Term Memory, LSTM)作为RNN的改进模型,通过特殊的 “门控机制” 解决了长程依赖问题,能够自适应地保留或遗忘时序信息,因此成为视频类型分类的理想选择。

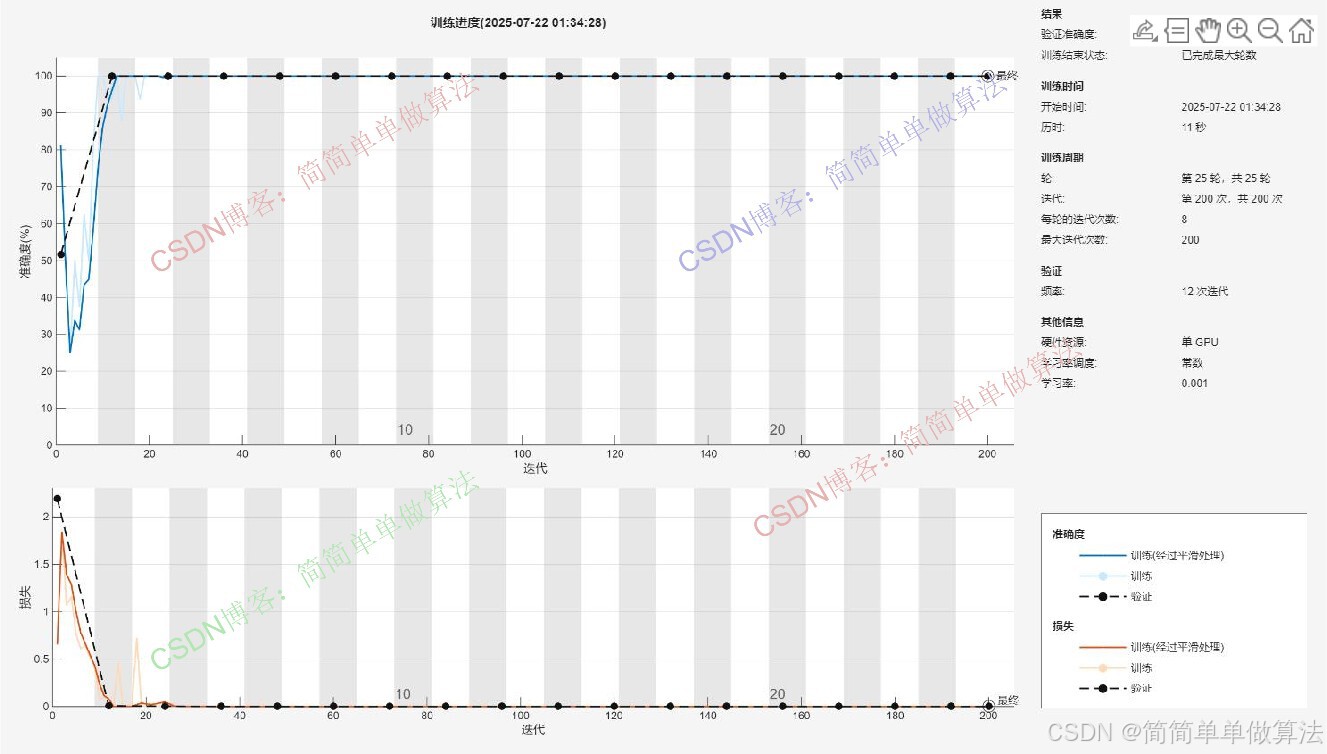

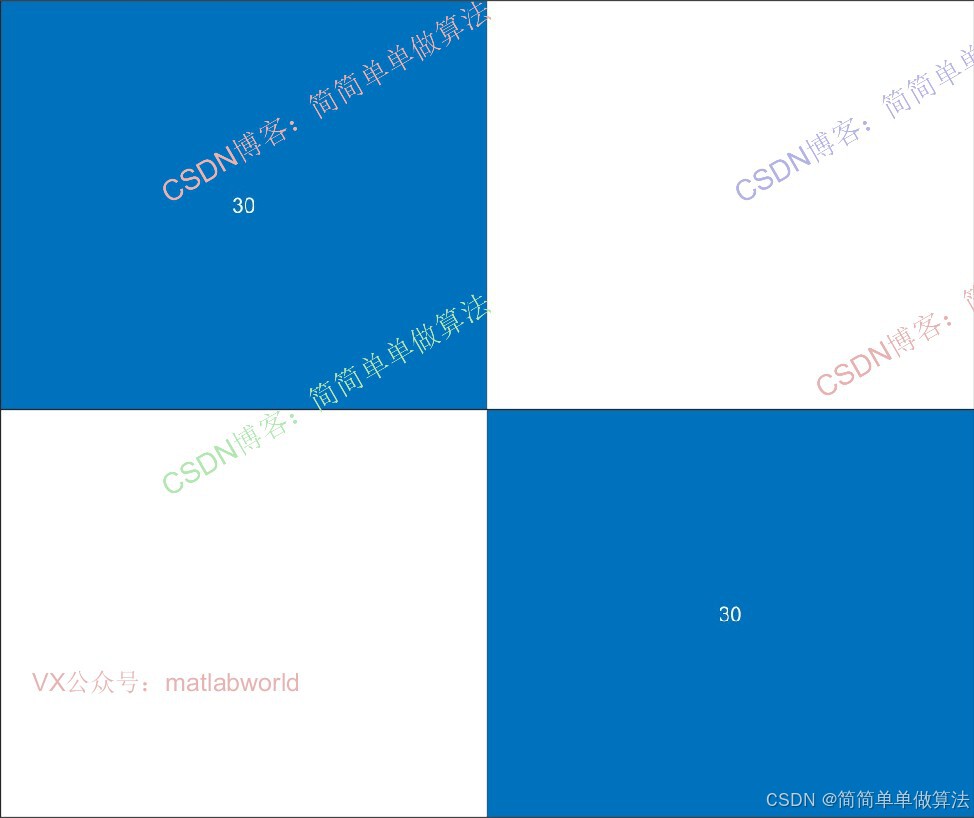

2.算法运行效果图预览

3.算法运行软件版本

Matlab2024b(推荐)或者matlab2022a

4.部分核心程序

Nframe = 1.5/(1/Vcat.FrameRate); % "5"是要显示的视频时长(秒),计算对应帧数 RFrames=zeros(224,224,3,Vcat.NumFrames,'uint8'); WFrames=zeros(224,224,3,Vman.NumFrames,'uint8'); for i=1:Vcat.NumFrames % 循环读取cat视频的所有帧 i % 读取一帧并调整尺寸为224x224(ResNet-18要求的输入尺寸) RFrames(:,:,:,i)=imresize(readFrame(Vcat),[224 224]); end for i=1:Vman.NumFrames % 循环读取man视频的所有帧 i % 读取一帧并调整尺寸为224x224 WFrames(:,:,:,i)=imresize(readFrame(Vman),[224 224]); end % 使用ResNet-18的'pool5'层提取特征,输出为列向量,数据类型为single R=single(activations(netCNN,RFrames,'pool5','OutputAs','columns')); W=single(activations(netCNN,WFrames,'pool5','OutputAs','columns')); 224

5.算法理论概述

LSTM的核心优势在于其设计的 “细胞状态”(Cell State)和 “门控单元”(Gates),能够在处理长序列时选择性保留关键信息、过滤冗余信息。LSTM通过这4个步骤实现时序信息的迭代更新,其核心是细胞状态Ct的 “平滑流动”:相比RNN的隐藏状态直接覆盖,LSTM的细胞状态通过 “遗忘 - 更新 - 输出” 的门控机制实现渐进式调整,从而有效保留长程依赖。

例如,在处理视频时,LSTM能通过遗忘门保留 “解说词出现时的场景特征”,通过输入门更新 “新场景的画面信息”,最终通过隐藏状态ht捕捉 “解说-场景” 的周期性关联。

视频类型分类的前提是将原始视频转化为LSTM可处理的时序特征序列。由于视频包含 “空间信息”(单帧内的视觉内容)和 “时序信息”(帧间的动态变化),需通过 **“空间特征提取→时序序列构建”** 的两步预处理流程,将视频转化为LSTM的输入x1,x2,...,xT(T为序列长度)。

浙公网安备 33010602011771号

浙公网安备 33010602011771号