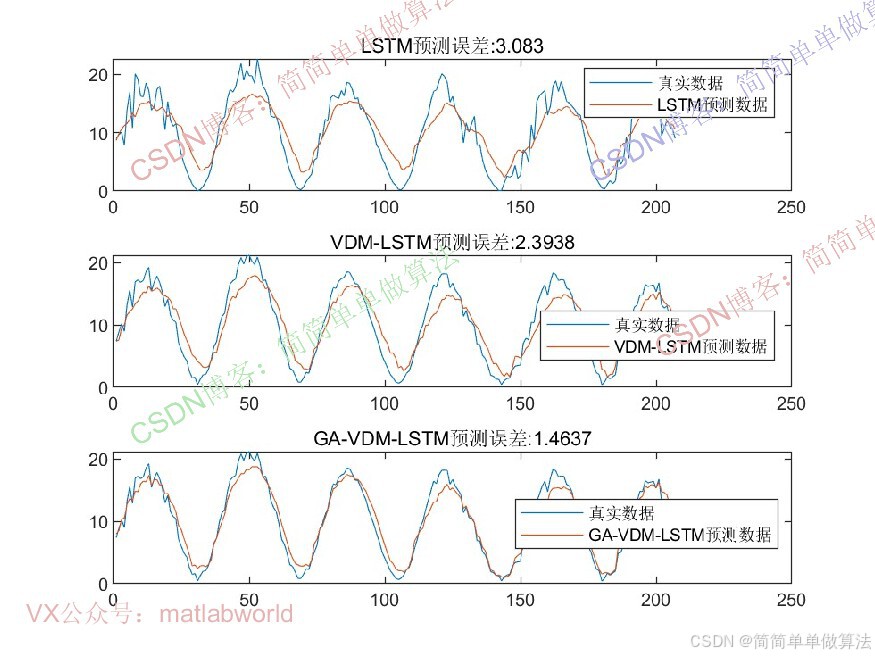

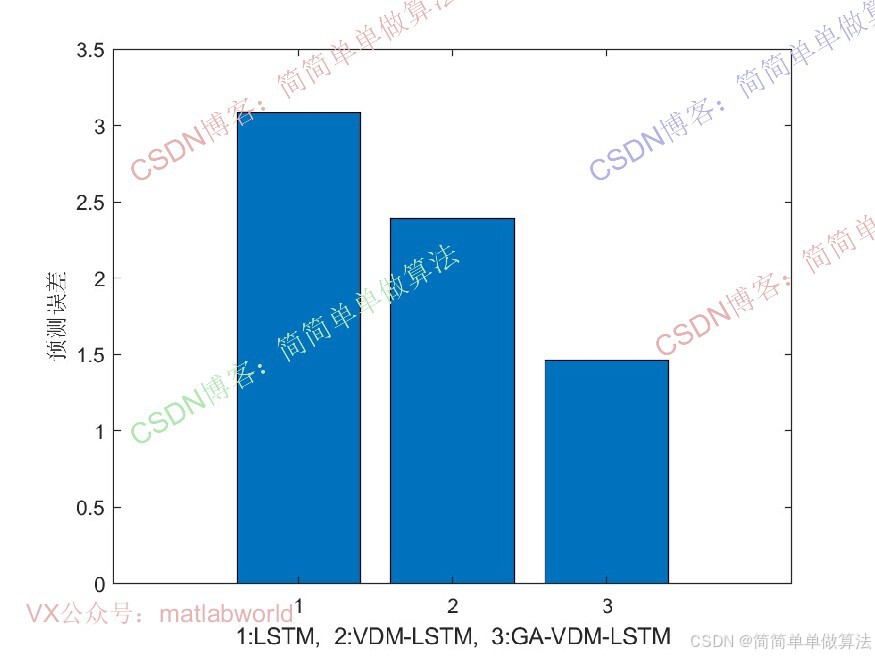

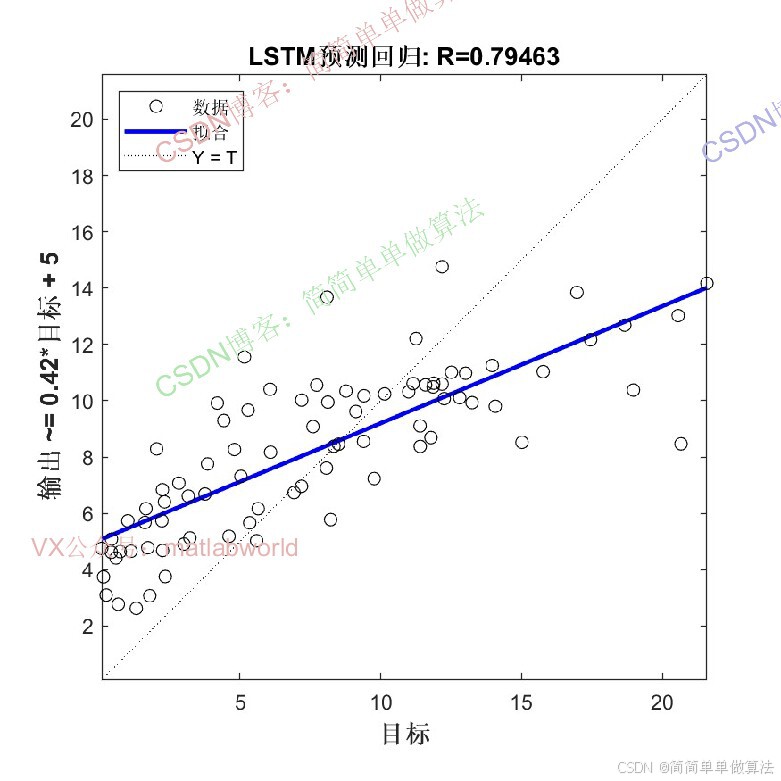

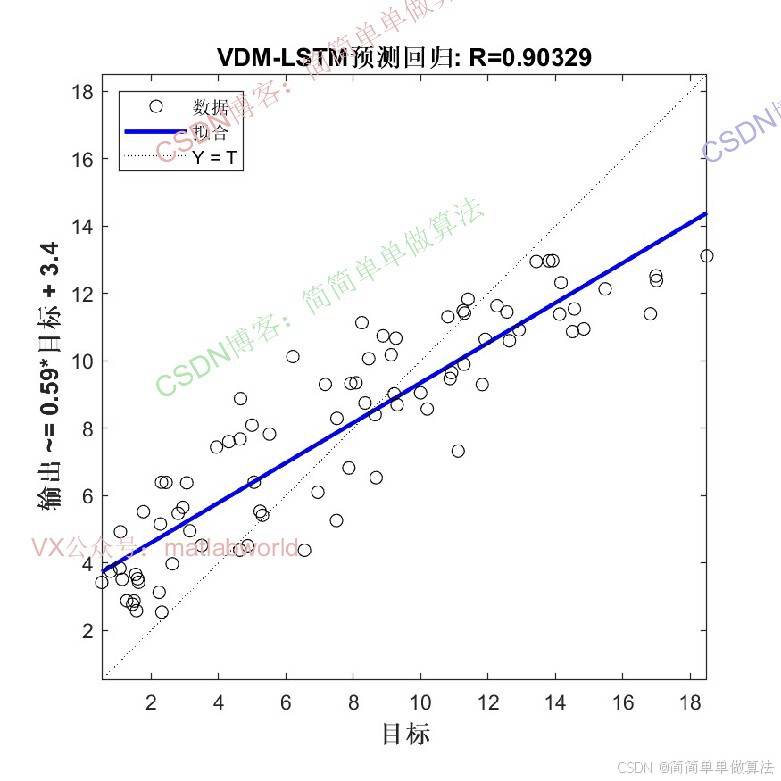

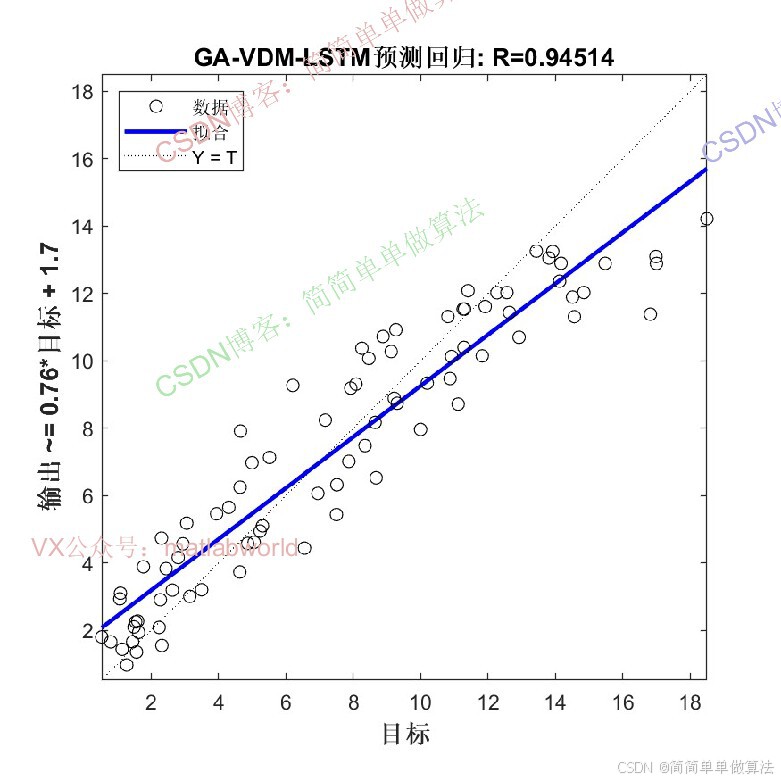

基于GA遗传优化的VMD-LSTM时间序列预测算法matlab仿真

1.前言

时间序列预测在能源、气象等领域具有重要应用价值。传统方法如ARIMA、SVM等在处理非线性、非平稳序列时存在局限性,而深度学习模型(如LSTM)虽能捕捉时序特征,但对初始参数敏感,且复杂序列需预处理以提升预测精度。变分模态分解(VMD)可将复杂时序分解为多个平稳模态分量,LSTM可有效建模序列长期依赖关系,GA遗传优化则用于优化LSTM的关键参数,形成 “分解-优化-预测” 的完整框架。该算法通过多技术协同,提升时序预测的准确性和鲁棒性。

2.算法运行效果图预览

(完整程序运行后无水印)

3.算法运行软件版本

Matlab2024b(推荐)或者matlab2022a

4.部分核心程序

................................................................... layers = [ ... sequenceInputLayer(indim) lstmLayer(Nlayer) fullyConnectedLayer(outdim) regressionLayer]; %训练 [net,INFO] = trainNetwork(Pxtrain, Txtrain, layers, options); Rerr = INFO.TrainingRMSE; Rlos = INFO.TrainingLoss; %预测 Tpre1 = predict(net, Pxtrain); Tpre2 = predict(net, Pxtest); %反归一化 TNpre1 = mapminmax('reverse', Tpre1, Norm_O); TNpre2 = mapminmax('reverse', Tpre2, Norm_O); %数据格式转换 TNpre1s(d,:) = cell2mat(TNpre1); TNpre2s(d,:) = cell2mat(TNpre2); T_trains(d,:) = T_train; T_tests(d,:) = T_test; Rerrs(d,:)=Rerr; Rloss(d,:)=Rlos; end 223

5.算法理论概述

VMD是一种自适应信号分解方法,通过构建变分模型将原始序列分解为若干模态分量(IMF),每个分量对应特定频率尺度,且带宽之和最小化。该过程通过交替迭代更新各模态的频率和幅值实现,无需预设分解层数(实际应用中需结合数据特性确定或优化)。LSTM是一种特殊的循环神经网络,它通过引入门控机制来控制信息的流动,从而能够有效捕捉时间序列中的长距离依赖关系 。LSTM的核心是记忆单元,它可以存储和更新时间序列中的信息。

浙公网安备 33010602011771号

浙公网安备 33010602011771号