LLaVA-Grounding: Grounded Visual Chat with Large Multimodal Models

郑重声明:原文参见标题,如有侵权,请联系作者,将会撤销发布!

Abstract

随着大型多模态模型(LMM)的最新重大进展,它们在视觉聊天中的定位(Grounding)能力的重要性越来越得到认可。尽管最近努力使LMM支持定位,但它们的定位和聊天能力通常是分开的,当被要求定位时,它们的聊天性能会急剧下降。问题是缺乏一个用于定位视觉聊天(GVC)的数据集。现有的定位数据集只包含简短的说明文字。为了解决这个问题,我们创建了GVC数据,允许将定位功能和聊天功能相结合。为了更好地评估GVC的能力,我们引入了一个名为Grounding-Bench的基准。此外,我们还提出了一种模型设计,通过将分割模型与语言模型连接起来,可以支持GVC和各种类型的视觉提示词。实验结果表明,我们的模型在Grounding-Bench上的性能优于其他LMM。此外,我们的模型在RefCOCO/+/g和Flickr30K Entities等经典定位基准上实现了具有竞争力的性能。

1. Introduction

随着GPT4 [25]等大语言模型和开源替代品LLaMA [31]的成功,研究人员渴望在视觉领域利用其强大的语言能力。这种热情导致了大型多模态模型(LLM)的开发激增。以前的LMM,如LLaVA [18]和miniGPT-4 [49],通过基于图像和用户指令生成合理的响应,已经证明了非凡的视觉聊天能力。然而,他们在提供对图像表现出细粒度理解的响应方面经常遇到挑战,包括特定区域和与相关图像区域的对齐——这通常被称为视觉定位。

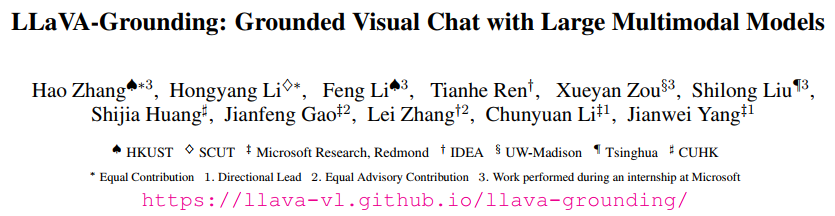

认识到视觉定位对LMM的重要性,最近的研究工作集中在开发LMM的定位和引用能力[2, 3, 10, 33, 40]。虽然这些模型在RefCOCO [8]和Flickr30K [29]等经典定位基准上实现了与专业模型[19, 21]相当的性能,但它们通常将定位视为一项独特的任务,需要自定义提示词才能启动。因此,当被赋予定位任务时,他们的文本响应会发生重大变化。大多数模型,如MiniGPT-v2 [2]和CogVLM-Grounding [33],在执行定位时只能生成短说明文字,因为它们主要基于Flickr30K等定位说明文字数据进行训练。如图1所示,这些早期的模型很难同时在聊天和定位任务中表现出色。BuboGPT [47]通过利用外部定位模型进行定位来保持聊天功能,但这种方法可能会受到定位模型中语言编码器性能的限制。Shikra [3]参与引用对话,其中包括定位聊天,但由于可用数据的稀缺,其性能受到限制。所有现有的LMM [2, 3, 33, 40]都只支持将坐标输出为文本,这限制了定位性能,并且不支持逐像素的定位和引用。总之,由于缺乏定位的视觉聊天数据和次优的模型设计,以前的LMM很难有效地执行定位的可视化聊天。此外,它们缺乏像素定位和引用的能力。

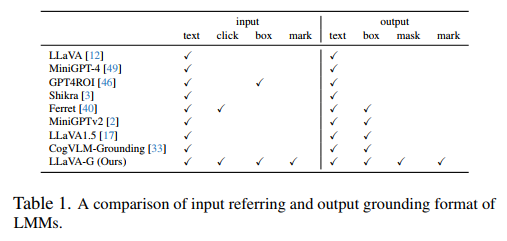

为了应对这些挑战,我们在三个关键领域为定位视觉聊天做出了贡献:数据创建、网络架构和基准测试。在注释定位数据时,以前的方法,如Kosmos-2 [28]和GPT4ROI [46],依赖于预先训练的定位模型或检测模型来基于现有说明文字预测边界框。相比之下,我们使用人类标记的目标检测数据标记定位视觉聊天数据[15]。

我们的数据创建过程从利用GPT4 [25]开始,遵循LLaVA [18]中使用的数据创建方法。我们向GPT-4提供聊天数据和定位事实实例,指示它将实例与聊天数据中的名词短语进行匹配。这种方法得益于GPT-4生成的高质量人工标记实例和聊天数据,确保数据标注流水线中的噪声最小。我们总共标注了150K个定位视觉聊天数据。

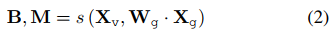

在网络架构方面,我们提出将LLM的输出特征与定位模型连接起来,以处理定位任务,从而减轻语言模型的视觉定位任务的负担。为此,我们使用开集分割和检测模型OpenSeeD [44]作为定位模型,同时实现框级和像素级的定位。

为了评估定位视觉聊天的能力,我们引入了Grounding-Bench,这是一个同时评估定位和聊天性能的基准。我们的基准测试建立在LLaVA-Bench的基础上,在三个上下文中评估聊天和短语定位:对话、详细描述和复杂推理。此外,认识到定位的详细描述是定位视觉聊天最具挑战性的方面,我们提出了定位召回和精度指标。定位召回衡量正确提及和定位的基本事实实例的比例,而定位精度衡量定位或预测框的准确性。我们还计算了F1分数,这是精度和召回率的结合。为了评估语义匹配的正确性(因为模型生成自由形式的短语),我们依赖GPT-4。

总之,我们的贡献如下:

- 我们引入了一个数据标注流水线来标记高质量的定位视觉聊天数据。利用人类标记的目标检测数据[15]和GPT-4 [27]的强大匹配能力,我们已经使用LLaVA指令调整数据集成功标记了150K个GVC实例。

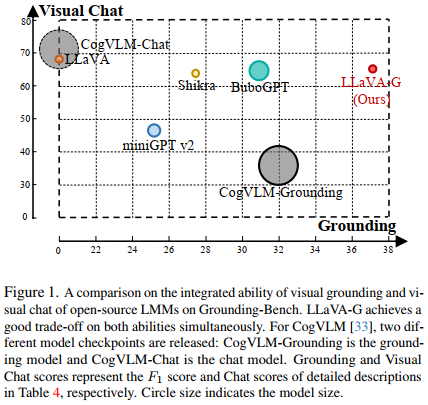

- 我们提出了一个端到端模型,简称LLaVA-Grounding(简称LLaVA-G),它将LMM与定位模型连接起来,以促进定位视觉聊天。我们的模型支持目标级和像素级定位,可以适应各种视觉提示词,如标记、点击、框和涂鸦。表1指出,与其他LMM相比,我们的模型提供了更广泛的输入和输出提示词类型。

- 我们建立了用于评估定位视觉聊天的Grounding-Bench,并提出了一个由GPT-4辅助的自动评估流水线。该基准测试评估定位视觉聊天功能,并为其他最先进的方法提供了性能指标。

- 通过广泛的实验,我们证明了我们的模型在Grounding-Bench上的性能优于其他定位LMM,同时在RefCOCO/+/g和Flickr30K等经典定位基准上也取得了有竞争力的结果。

2. Method

2.1. Overview

为了推进LMM的定位视觉聊天的开发,我们引入了一个用于标记定位视觉聊天数据的综合流水线,一种为定位视觉聊天任务设计的定制建模方法,以及一个评估定位视觉聊天性能的基准,如图2所示。我们将在以下小节中提供有关这三个组成部分的更多详细信息。

2.2. Grounded Visual Chat Data Creation

为了有效地进行定位视觉聊天,拥有高质量的数据至关重要,这些数据包括有意义的对话和准确的定位。我们基于LLaVA指令调优数据构建了我们的数据集,主要有两个原因。首先,该数据集中的对话是由GPT-4生成的,GPT-4以其高语言质量而闻名。其次,所使用的图像来源于COCO,其中包含人工标注的定位框实例。

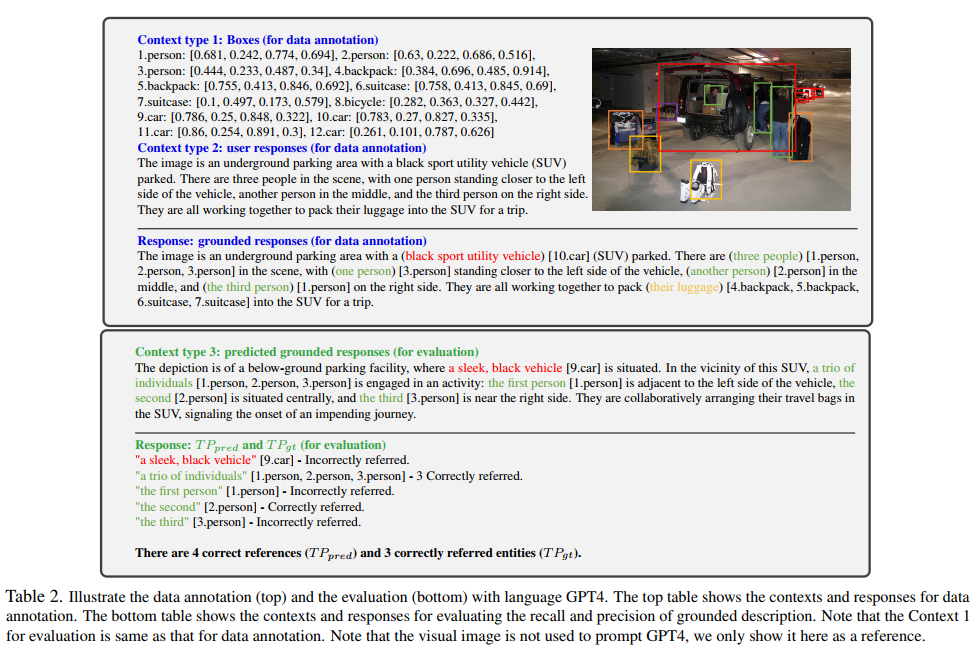

我们的数据标注过程旨在将对话中的短语与特定实例相关联。为了实现这一点,我们利用了GPT-4的功能。如表2所示,我们为GPT-4提供了包含类标签和对话中的一句话的基本事实(GT)框。我们让GPT-4从句子中匹配名词短语到GT实例。一旦名词短语被GPT-4成功地定位,我们就用特殊的开始token ⟨gs⟩和⟨ge⟩来标记它们,后面跟着一个token ⟨seg⟩,它对应于定位模型用于分割定位区域的输出特征。数据集中的问题及其答案示例如下:

Q: What is the man doing? A: ⟨gs⟩ The man ⟨ge⟩ ⟨seg⟩ is using ⟨gs⟩ a clothing iron ⟨ge⟩ ⟨seg⟩ on the back of ⟨gs⟩ a yellow taxi ⟨ge⟩ ⟨seg⟩.

对于每个⟨seg⟩,我们都有相应的分割掩码。这些标注数据构成了我们的定位视觉聊天数据集的基础。可选地,为了支持用户说明中的视觉提示词,我们将类似的标注过程应用于问题本身的实例。结果数据显示如下:

Q: What is the object ⟨obj⟩ doing? A: ⟨gs⟩ The man ⟨ge⟩ ⟨seg⟩ is using ⟨gs⟩ a clothing iron ⟨ge⟩ ⟨seg⟩ on the back of ⟨gs⟩ a yellow taxi ⟨ge⟩ ⟨seg⟩.

需要注意的是,在模型可能忽略视觉提示词的情况下,我们会将"the man"修改为"the object"。对于问题中的每个⟨obj⟩,我们提供相应的分割掩码。该数据集被称为GVC-R (Grounded Visual Chat with Referencing)。

2.3. Network Architectures

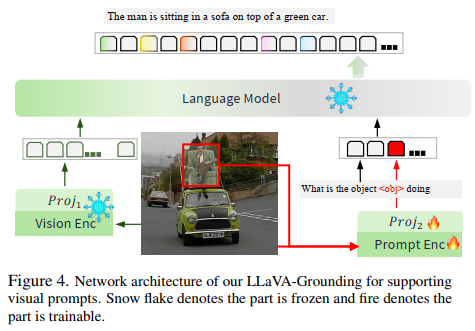

由于我们的网络架构与LLaVA几乎相同,除了额外的提示词编码器和定位模型外,我们将在本节中仅介绍这两个部分。有关我们架构的其他组件,请参阅LLaVA [18]。

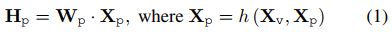

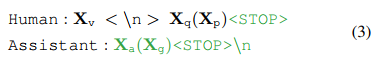

提示词编码器。对于输入图像Xv和视觉提示词Xp,我们使用预训练的Semantic-SAM作为提示词编码器。该编码器基于输入图像和视觉提示词提取视觉特征,表示为Xp = h(Xv, Xp)。为了将这些提示词特征转换为与语言模型中的单词嵌入空间具有相同维度的语言嵌入token Hp,我们使用具有可训练投影矩阵Wp的简单线性层:

这导致了一系列视觉token Hp。值得注意的是,Xq中存在以单词嵌入为占位符的特殊标记⟨obj⟩,Hp中的视觉token取代了Hq中⟨obj⟩的单词嵌入。

定位模型。除了语言响应Xa,我们的模型还产生了用于定位的特征Xg。这些特征对应于与⟨seg⟩ token对齐的语言模型的最后一层隐藏特征。我们最初使用可训练投影矩阵Wg将这些特征映射到定位空间。随后,我们使用预训练的OpenSeeD模型作为定位模型来生成边界框B和掩码M。这个过程可以定义如下:

这里,s(·,·)表示定位模型,该模型以图像Xv和定位特征为输入。

2.4. Training

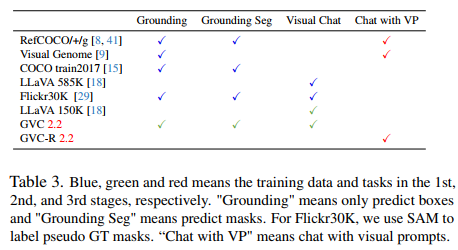

我们提出了一个三阶段的训练策略,如表3所示。这些阶段是对齐预训练、定位视觉聊天的指令调整以及视觉提示词的扩展。我们的指令遵循数据的统一表征如下:

在此表征中,Xp和Xg被括在括号中,表示它们是可选的。在训练过程中,对模型进行训练,以预测助手的答案,包括定位实例和停止位置。因此,仅使用绿色序列/token来计算自回归模型中的损失。

阶段1:对齐预训练。阶段1侧重于视觉编码器的特征对齐和定位模型的粒度对齐。

视觉编码器的特征对齐。如表3所示,我们利用RefCOCO/+/g、COCO 2017train、Visual Genome、LLaVA 585K图片说明和Flickr30K Entities数据集进行阶段1。LLaVA 585K和Flickr30K Entities数据集都由图像说明文字对组成,并用于训练投影层W用于视觉编码器中的特征对齐。对话构建方法与LLaVA的方法一致,其中从表17中随机选择一个问题作为Xq,并使用原始说明文字作为Xa。该部分的可学习参数表示为θ={W}。

定位模型的特征和粒度对齐。为了便于定位,我们需要将语言模型输出的特征Xg与定位模型的词汇空间对齐。为此,我们在RefCOCO/+/g、COCO 2017train、Visual Genome和Flickr30K Entities数据集上进行训练。构造指令遵循数据的方法如下:

- 对于RefCOCO/+/g和Visual Genome,用户指令Xq是从表16中随机选择的,Xa仅由特殊token ⟨seg⟩组成。COCO 2017train遵循与RefCOCO/+/g相同的方法,但有一个区别:实例的类名用作其引用文本。

- 相比之下,Flickr30K Entities数据集与前面提到的图像说明文字数据不同。这里,用户指令后面跟着一个从表18中随机选择的后缀。该后缀向模型发出信号,以产生定位格式的响应,如第2.2节所述。然后,通过在Xa中插入特殊token ⟨gs⟩、⟨ge⟩和⟨seg⟩来标记名词短语,将响应Xa转换为定位格式。

给定指令遵循数据,通过将语言模型的最后一层隐藏特征(对应于⟨seg⟩ token Xg)乘以Wg映射到定位词汇空间。此外,由于我们的定位模型是在COCO和Object365上预训练的,与Visual Genome和Flickr30K定位数据相比,它们具有不同的粒度,因此我们还训练定位模型来对齐这些粒度。

总之,阶段1的可学习参数表示为θ={W, Wg, Φg}。

阶段2:定位视觉聊天的指令调整。在第二个训练阶段,我们利用定位视觉聊天数据(不包括视觉提示词)进行指令调整。为了在不定位的情况下支持聊天,我们引入了LLaVA 158K指令遵循数据。在此阶段,我们冻结CLIP视觉编码器,并专注于微调模型的其他组件。该阶段的可学习参数表示为θ={W, Wg, Φ, Φg}。

数据格式由指令数据组成,其中包含答案中的⟨seg⟩ token,并附有几个定位注释。定位注释的数量对应于存在的⟨seg⟩ token的数量。在这个阶段,我们计算语言损失和定位损失。语言损失的计算方式与LLaVA中回答token和"STOP" token的计算方式相同。定位损失包括框、掩码和匹配损失。框和掩码损失仅用于训练定位模型,而匹配损失则传播到语言模型。

阶段3:视觉提示词的拓展。在第三个阶段,我们引入了对视觉提示词的支持,作为一个额外的组成部分,通过仅训练hΦ和投影层Wp。如表3所示,训练数据包括RefCOCO/+/g、Visual Genome和GVC-R。与阶段1相比,对于RefCOCO/+/g和Visual Genome,我们为基本事实实例提供视觉提示词,并指示模型预测说明文字。文本指令Xp是从表19中随机选择的,其中⟨obj⟩ token用作占位符,它们的输入嵌入将被提示词特征取代。文本答案Xa包括原始引用表达式。

在这个阶段,可学习参数表示为θ={Φp, Wp},其中Φp被训练为输出与视觉提示词相对应的框和掩码,而Wp被训练成将视觉提示词特征与语言嵌入空间对齐。

标记集(SoM)提示词。(可选) 除了可以通过提示词编码器处理的视觉提示词(如点击和框)外,我们的模型还支持标记作为视觉提示词,类似于[35]中提出的方法。这些标记由直接覆盖在图像上的字母数字和掩码组成。为了进行说明,请考虑第2.2节中的数据样本。假设我们在输入图像中的"man"、"iron"和"taxi"上叠加标记为⟨1⟩、⟨2⟩、⟨3⟩。这导致定位和引用视觉聊天(GRVC)数据采用以下形式:

Q: What is the object ⟨1⟩ doing? A: The man ⟨1⟩ is using a clothing iron ⟨2⟩ on the back of a yellow taxi ⟨3⟩.

需要注意的是,问题和答案都只包含文本。因此,为了支持标记作为视觉提示词,我们专门对模型的语言部分进行了微调。

2.5. Grounding-Bench

基准创建。我们引入了一个名为Grounding-Bench的基准来评估模型的定位视觉聊天能力。为了同时评估定位和聊天能力,我们在LLaVA-Bench (COCO)的基础上构建了这个基准,该基准包括GPT4生成的聊天数据和MSCOCO的实例注释。为了增强Grounding-Bench的稳健性,我们扩展了我们的测试数据集,将1000张图像和7000个实体包括在内,这些图像都来自MSCOCO 2014val分割。使用我们的数据创建流水线,这些图像被转换为定位视觉聊天数据,形成我们测试数据集的基础。

任务定义。定位视觉聊天任务包括将图像XV和用户指令 I 作为输入,并生成伴随着边界框b的说明文字T,其中每个边界框对应于特定短语。

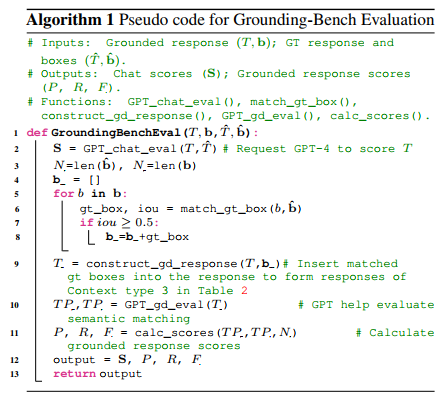

评估聊天分数。我们的基准评估包括两个主要方面:聊天分数和定位响应分数。我们概述了算法1中Grounding-Bench的评估过程。聊天分数与LLaVA-Bench中使用的分数相似。然而,相反,我们指示模型产生定位响应。随后,我们处理输出以删除特殊的token和框,从而生成纯文本响应以进行评估。

评估定位响应分数。对于定位响应,我们专门评估定位详细描述任务。我们的评估包括完整性的召回率(R)、幻觉的准确率(P)和结合这两个方面的F1分数(F1)等指标。R衡量描述中正确提及和定位的实体比例,而P评估正确预测依据的比例。只有当框与IoU大于0.5的基本事实框匹配,并且它们的语义准确匹配时,定位才被认为是正确的。为了确定GPT4的TPpred和TPgt,我们提供了上下文类型1和3,如表2中的底部块所示。例如,在所提供的示例中,Npred=7并且Ngt=12。基于GPT4的响应,我们计算出TPpred = 4和TPgt = 3。因此,我们得到P = 0.57,R = 0.25,F1 = 0.35。

3. Experiments

在本节中,我们将首先介绍我们的实验设置。然后,我们将把我们的模型与其他最先进的模型进行比较。接下来,我们将针对RefCOCO、RefCOCO+和RefCOCOg上具有挑战性的引用表达理解(REC)和引用表达分割(RES)任务,将我们的模型与其他定位模型进行比较。结果将表明,我们的模型在REC和RES任务上都优于具有相同参数数量的其他定位LLM,并且我们的模型是唯一能够有效处理REC和RES的模型。之后,我们将对各种类型的视觉提示词的支持进行评估。最后,我们将对我们的建模和数据创建过程进行消融研究,以验证我们的方法。

3.1. Experimental Settings

为了便于结果复现,我们提供了详细的设置。我们的语言模型是从预训练的Vicuna-7b v1.3初始化的,定位模型是从在COCO和Object365上预训练的OpenSeeD Tiny模型的视觉部分初始化的,交互式编码器是从在具有三个粒度的COCO上预训练的Semantic-SAM Tiny模型初始化的。

在第一个训练阶段,我们冻结语言模型,并以1×10−4的学习率训练定位模型、提示词编码器和投影层。对于第二个阶段,我们以2×10−5的学习率来训练语言模型和投影层,同时以1×10−4的学习率训练定位模型,同时冻结CLIP视觉编码器和提示词编码器。

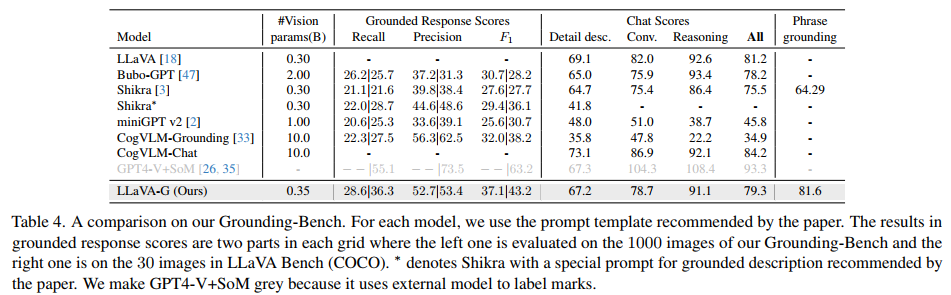

3.2. Grounding-Bench

为了证明我们的方法在定位视觉聊天中的有效性,我们将我们的方法与其他在基准上支持视觉定位的强LMM进行了比较。如表4所示,每个网格的定位响应分数结果分为两部分。左一部分在Grounding-Bench的1000张图像上进行评估,右一部分在LLaVA-Bench (COCO)的30张图像上评估。所有定位LMM的数字都使用定位的官方提示模板进行评估,以确保最佳性能。结果表明,除了CogVLM-Chat和LLaVA这两个聊天模型外,我们的方法在定位响应分数和定位响应的聊天分数方面都优于所有开源方法。GPT4V在SoM的帮助下实现了定位详细描述的最佳性能,但它是两种模型的组合。在开源方法中,CogVLM在定位详细描述的F1分数方面仅次于我们,但它的GPT评估分数最低。Shikra的聊天分数仅次于我们的模型。我们还在LLaVA-Bench (COCO)中注释了30张图像作为定位详细描述,并报告了我们的模型和Shikra的短语定位性能,以供参考。

3.3. Traditional Grounding Benchmarks

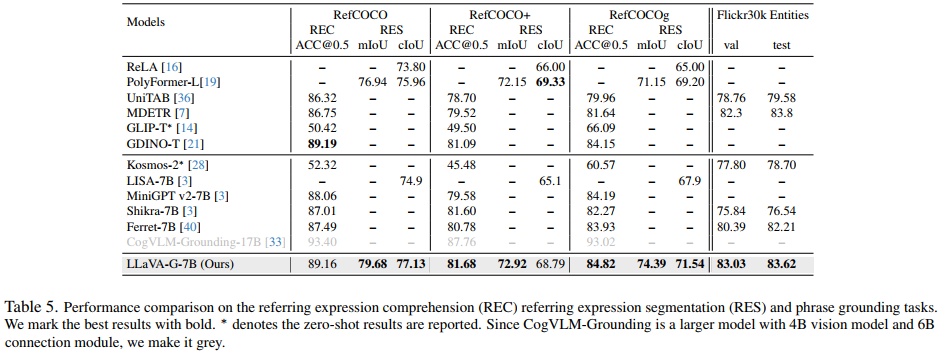

我们还根据经典的定位基准来评估我们的模型,包括用于引用表达理解(REC)和引用表达分割(RES)的RefCOCO/+/g,以及用于短语定位的Flickr30K Entities。对于这个实验,我们使用7B语言模型和使用Swin-Tiny主干的定位模型。我们的模型在第一个阶段使用RefCOCO/+/g、Visual Genome和Flickr30K Entities进行训练。我们的模型是唯一一个在REC和RES任务中都表现出色的LMM。在REC任务中,我们的模型优于所有LMM,除了CogVLM-Grounding,它使用了4B视觉模型和6B连接模块。在RES和短语定位任务方面,我们的模型超越了所有LMM。我们的模型的一个优势是它能够在框和掩码数据上进行训练,使我们能够利用Visual Genome来提高我们的RES性能。

3.4. Visual Prompts

我们展示了对各种类型的视觉提示词的支持,包括标记、单击和框。

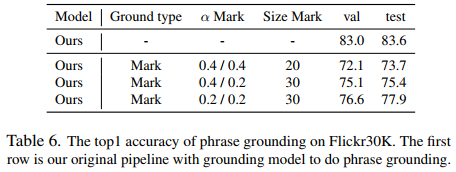

支持标记作为视觉提示词。在表6中,我们展示了当使用标记作为视觉提示词时,我们在Flikr30K上的短语定位性能。值得注意的是,在这个实验中,我们将GT掩码和标记叠加到输入图像上,将标记定位在掩码的中心。该表显示了不同掩码的α值和标记大小的结果。我们还将Shikra-7B和Ours-7B的性能与定位模型进行了比较。结果清楚地表明,我们的模型有效地支持使用标记进行定位。

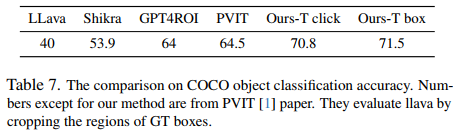

支持点击和框作为视觉提示词。为了进一步证明我们对视觉提示词的支持,我们在表7中比较了COCO val2017的目标分类准确性。我们使用点击和框作为视觉提示词来报告我们的表现。此外,我们还包括PVIT文件中的数字供参考。结果表明,我们的引用准确度超过了以前的作品,框比点击产生更好的准确度。

3.5. Visualizations

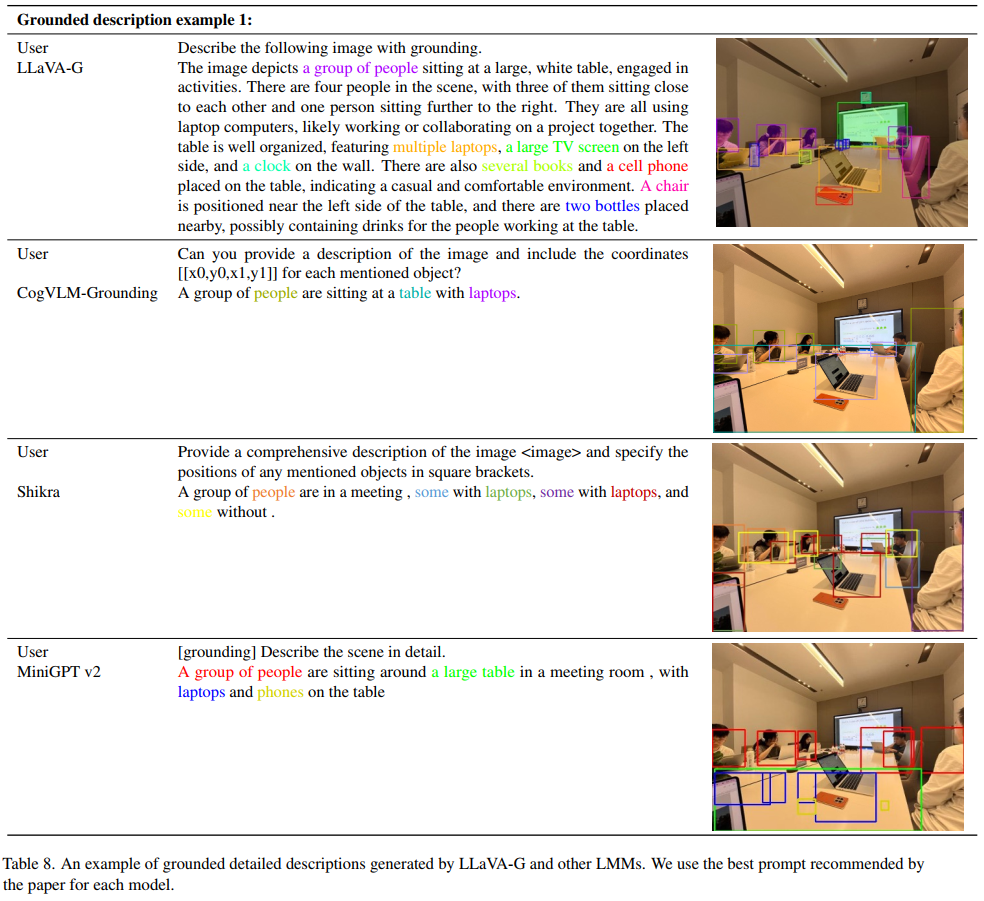

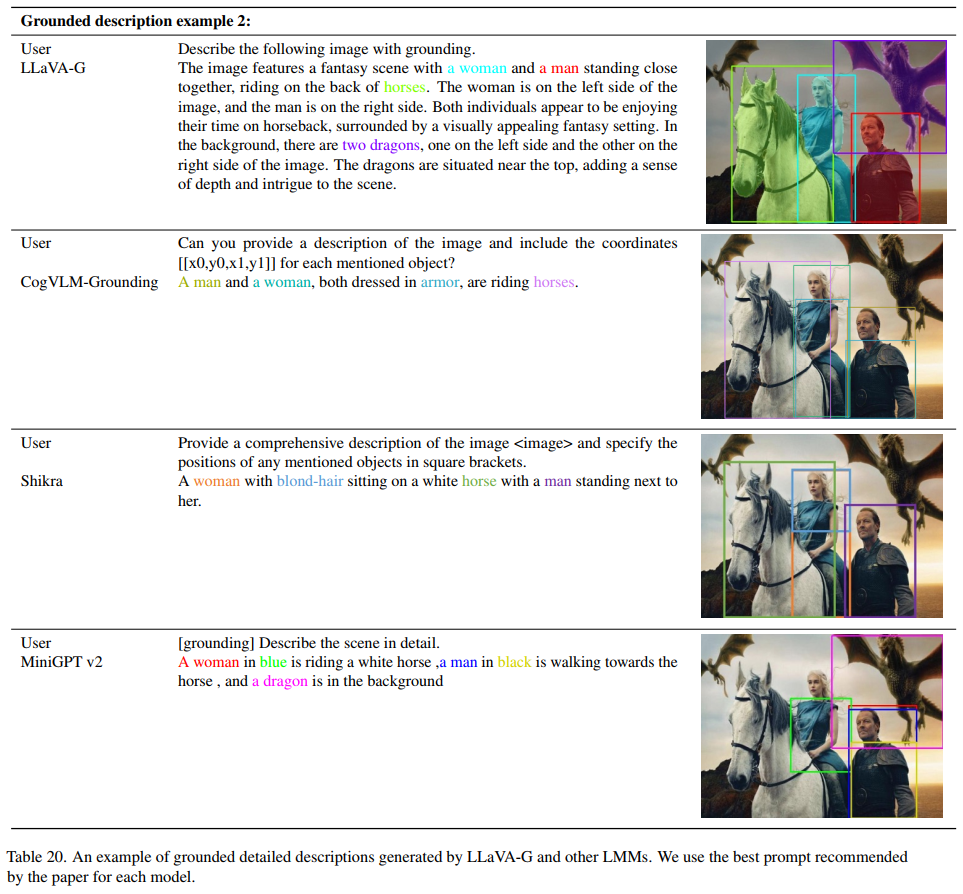

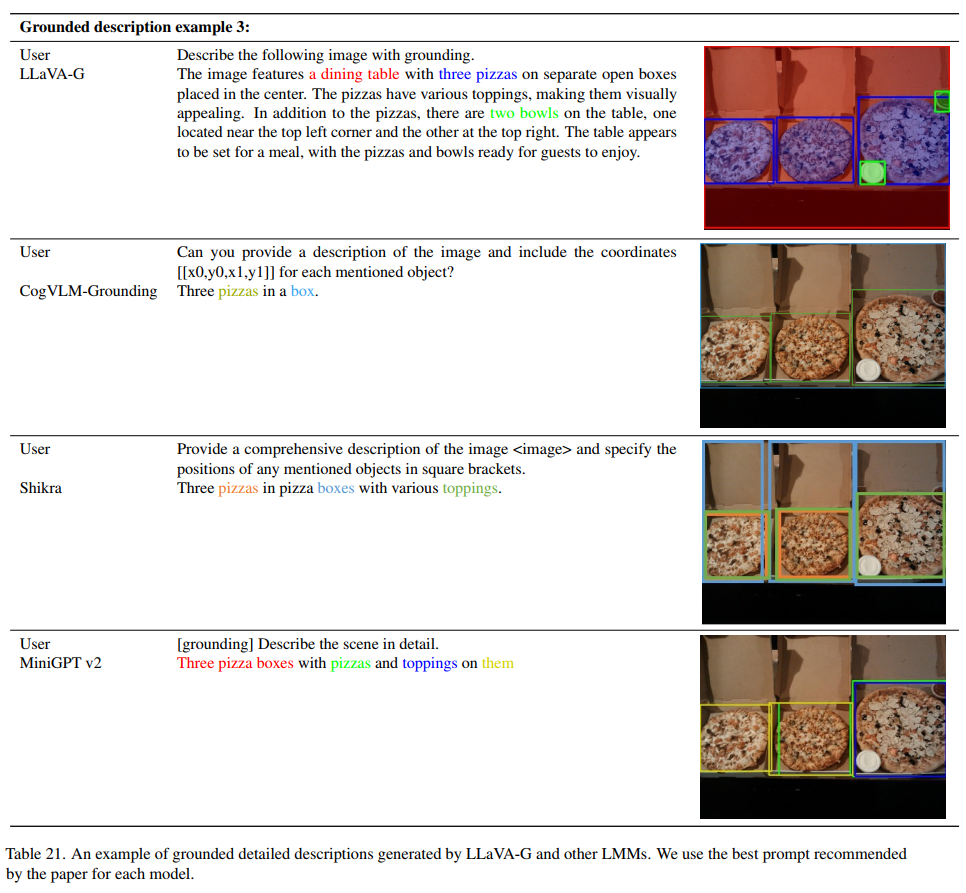

与其他模型进行比较。我们在表8、20和21中提供了我们的模型与其他定位LMM之间的视觉比较,包括CogVLM-Grounding、Shikra和MiniGPTv2。这些可视化突出表明,我们的模型生成更长的描述,检测更多的目标,并保持高精度。此外,我们的模型展示了建立开放集概念的能力,例如"dragons",而这些概念在我们的定位视觉聊天数据中并不存在。这些视觉比较强调了我们的模型在定位视觉聊天环境中的优势和能力。

其他功能:

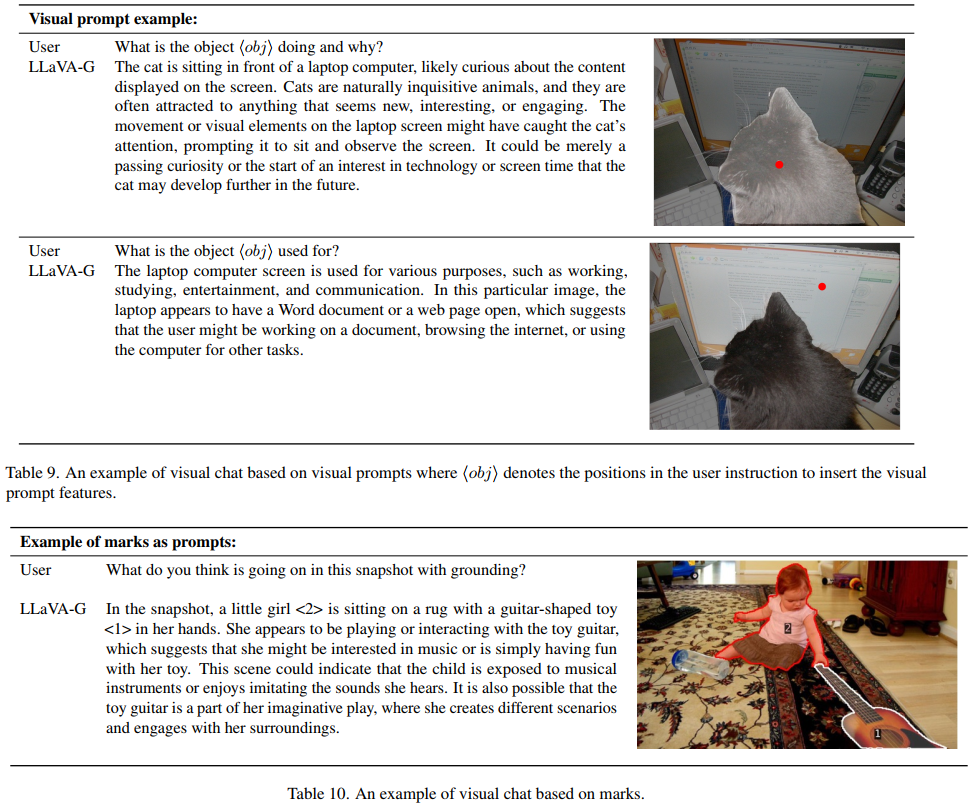

- 带有视觉提示词的视觉聊天(表9):我们的模型展示了它使用框或点击等视觉提示词进行视觉聊天的能力。

- 支持标记作为视觉提示词(表10):在对标记数据进行微调后,我们的模型有效地支持标记作为可视化提示词。

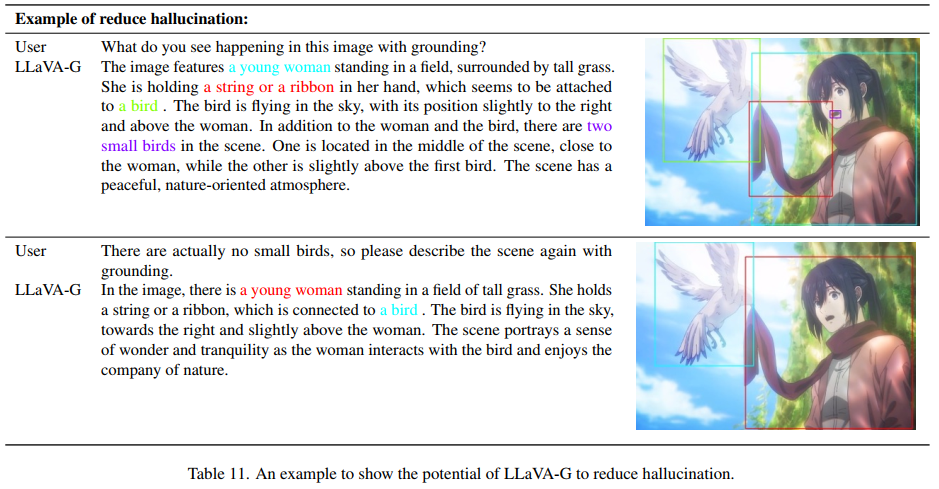

- 调试和消除幻觉(表11):我们的模型显示出通过允许用户识别和更正错误来帮助调试的潜力。在这个例子中,初始输出包含幻觉("two small birds"定位在女人的嘴上),用户通过定位来检测,然后指示模型进行纠正。

3.6. Ablation Studies

在本节中,我们将通过各种消融研究深入了解我们的视觉聊天能力和定位模型的设计。

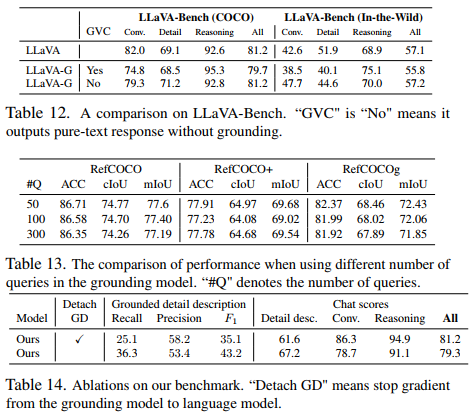

保持可视聊天功能。通过与LLaVA-Bench上的LLaVA进行比较,我们证明了我们的模型保留了强大的视觉聊天功能(表12)。结果表明,无论是否定位,我们的模型的视觉聊天性能都与LLaVA相当。

定位模型中的查询数。表13显示了我们的模型在具有不同查询数量的引用表达理解(REC)和引用表达分割(RES)任务上的性能。结果表明,使用50个查询对于这两个任务都是足够的,并实现了最佳性能。这一发现突显了我们处理这些任务的方法的效率。

分离定位模型。我们研究了分离定位模型对聊天和定位性能的影响。分离定位模型意味着阻止梯度从定位模型传播到LLM。表14将分离模型的性能与原始模型进行了比较。结果表明,分离定位模型会略微提高聊天性能,但会显著降低定位性能。这表明了定位模型在保持具有定位能力的高质量视觉聊天方面的重要性。

4. Related Work

4.1. Large Multi-modal Models

随着最近LLM的激增,研究人员一直在积极探索将这些模型的功能扩展到文本之外以涵盖其他模态的方法,从而开发出了几种LMM。值得注意的是,LLaVA [12]和MiniGPT-4 [49]等项目已经承担了将视觉指令调整数据的任务集成到LMM中。他们通过利用GPT-4或采用手工设计的提示词来实现这一点,从而增强LMM有效遵循指令的能力。

除此之外,该领域还有其他值得注意的工作,包括mPLUG-DocOwl [39]、Otter [11]、LLaMa-Adaptor [45]和InternGPT [22]。这些项目还结合了各种技术和方法,为LMM的发展做出了重大贡献。

此外,研究人员已经深入研究了对LMM的精细理解领域,例如VisionLLM [32]、GPT4RoI [46]和PVIT [1]等工作。例如,VisionLLM使用语言引导的tokenizer来提取特定粒度的视觉特征,而GPT4RoI和PVIT则使用边界框来获得相关的视觉特征。

4.2. Visual Grounding Models

视觉定位任务[4, 7, 19, 23, 24, 34, 48]旨在基于文本输入精确定位图像中目标的位置。这一挑战是多模态感知的基础,具有很好的应用前景。它需要对图像和文本进行深入的理解,同时建立图像区域和文本描述之间的对应关系。

GLIP模型[13]通过集成各种数据格式,包括检测和引用数据,朝着这个方向迈出了重要一步。结果表明,定位预训练有效地提高了定位模型的定位能力。在GLIP的基础上,GLIPv2 [43]通过统一定位和视觉-语言(VL)理解任务,迈出了进一步的步伐。利用定位预训练和DINO [42]检测器的Grounding-DINO [21]在该领域以其卓越的性能而脱颖而出。

近年来,视觉-语言模型在与视觉识别和感知相关的任务中越来越受到关注。像CLIP [30]和ALIGN [6]这样的模型,通过在图像级别的大规模图像-文本对数据集上的对比学习,在图像分类中实现了通用和稳健的能力。同时,在更细粒度的识别任务中,如视觉定位[4, 5, 7, 19, 23, 24, 34, 48],旨在根据文本输入定位特定区域,研究人员正在探索在区域层面进行图像和文本对比学习的潜力。

MDETR [7]、DetCLIP [37]、DetCLIPv2 [38]、GLIP [13]、GLIPv2 [43]和Grounding-DINO [21]等方法致力于通过使用大规模区域文本数据进行训练来检测任意类别。例如,MDETR [7]是在现有的多模态数据集上进行训练的,使用端到端的框架,在文本短语和图像目标之间进行显式对齐。

GLIP [13]通过将目标检测重新定义为定位任务,并结合额外的定位数据来执行定位预训练,增强短语和区域之间的语义对齐,从而推进了这种方法。GLIPv2进一步展示了定位预训练如何提高VL理解,从而为定位和VL理解建立统一的模型。

此外,通过将定位预训练与DINO [42]检测器相结合,Grounding-DINO [21]在该领域表现出色。视觉-语言模型的这些进步,特别是通过对大规模文本区域数据的对比学习,代表了细粒度识别任务的重大进展,从而产生了更精确和上下文感知的视觉理解。

4.3. Grounding Large Multi-modal Models

根据其结构特征和功能,定位LMM可分为三类。

第一类涉及以文本格式预测框坐标的模型。这一类别中值得注意的模型包括Kosmos-2 [28]、Shikra [3]、MiniGPT v2 [49]、Ferret [40]和CogVLM [33]。例如,Kosmos-2引入了一个全面的定位说明文字数据集,并训练了一个具有强大定位能力的模型,在各种定位基准上展示了令人印象深刻的零样本性能。另一方面,Shikra专注于构建推荐对话框数据,并训练他们的模型,以支持将框作为输入和输出的推荐对话框。MiniGPT v2使用任务token来激活不同的任务特定功能,包括支持带框的固定输出。同时,CogVLM利用一个100亿参数的视觉模型,在各种视觉-语言任务中实现了最先进的性能,包括定位。值得注意的是,尽管在视觉定位方面取得了重大进展,但其中许多方法都是在低质量的定位说明文字数据上训练的。例如,Shikra的参考对话框数据虽然很有价值,但相对较小,仅由5000个图像组成。

第二类涉及使用独立定位模型进行定位聊天的模型,例如BuboGPT [47]和LLaVA-PLUS [20]。然而,这些模型在定位模型的语言编码器处经常面临性能限制。

第三类采用一种方法,将语言模型的输出输入到定位模型中,以解码掩码和框。LISA [10]是这一类别中的一个代表性模型,主要关注各种细分任务,而不是聊天交互。

在之前的许多工作中,在定位能力和聊天能力之间进行了权衡,数据和评估指标通常强调其中一个方面。相比之下,我们的数据集和基准测试优先评估定位和聊天互动的组成能力,为该领域提供了独特的视角。

5. Conclusion

本文介绍了LLaVA-Grounding,一种结合了视觉聊天和定位功能的人工智能助手。我们首先使用一个新颖的数据创建流水线创建了一个定位视觉聊天数据集。随后,我们提出了一种端到端的模型架构,该架构将定位模型与语言模型集成在一起,以实现有效的定位。此外,我们还引入了Grounding-Bench,作为评估定位视觉聊天性能的综合基准,涵盖聊天和定位两个方面。我们的实验表明,LLaVA-Grounding在聊天和定位任务中始终优于其他开源LM模型,显示了其有效性。此外,LLaVA-Grounding在传统定位基准中表现出色,突出了其多功能性。然而,我们承认LLaVA-Grounding在语义范围方面有局限性,未来的工作可以探索将数据集和数据标记方法扩展到开放词汇设置。

Supplementary Material

A. More details about visual prompt

我们只训练视觉提示词编码器将提示词特征与语言空间对齐,从而以较低的训练成本支持点击、框和涂鸦等视觉提示词。

训练。我们将视觉提示词的支持无缝添加到经过训练的定位视觉聊天模型中。我们使用预训练的Semantic-SAM模型作为提示词编码器。如图4所示,视觉提示词将被提示词编码器编码为提示词特征,并通过投影层映射到语言空间。文本指令中有一个特殊标记⟨obj⟩,其输入嵌入将被视觉提示词特征取代。为了避免对现有模型产生任何影响,我们提出固定模型的其他部分,只调整提示词编码器和提示词编码器的投影层。

数据。如第2.2节所示,我们使用GPT4创建了150K的定位视觉聊天数据,以将答案中的none短语与GT实例相匹配。视觉提示词的数据以与定位视觉聊天数据相同的方式进行注释。如表2的前几个块所示,我们只需将上下文2中的句子更改为问题,GPT4可以帮助将问题中的实体与GT实例进行匹配。然后,我们可以基于GT实例对各种类型的视觉提示词进行采样。示例数据如下。假设输入图像如图4所示,最初的问题是Q:What is the man doing?。在GPT4的帮助下,"the man"与图像中的红框匹配。然后我们将文本提示词更改为Q:What is the object ⟨obj⟩ doing?。⟨obj⟩是占位符。它的输入嵌入将被"the man"的提示词嵌入所取代。我们将150K LLaVA指令调整数据的一部分标记为视觉提示词数据。该数据由GPT4生成,因此具有高质量的视觉聊天。

然而,它不善于区分图像中的不同实例,因为它通常会为每个图像谈论几个主要目标。对于许多图像,数据仅包含关于一个实例的讨论。这不利于模型区分不同的实例。因此,我们包括RefCOCO来训练用于区分实例的视觉提示词编码器。RefCOCO有几个实例,每个图像的文本对表示为(I, T)。我们使用以下模板将它们转换为视觉聊天数据:Q:Please describe the object ⟨obj⟩ briefly。A:T,其中T是引用文本。

B. Implementation details

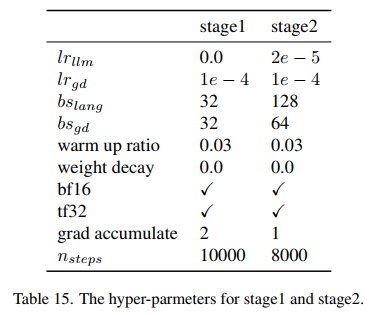

我们提供了我们的实验配置的更多细节,以复现我们的方法。我们在表15中提供了阶段1和阶段2的超参数。

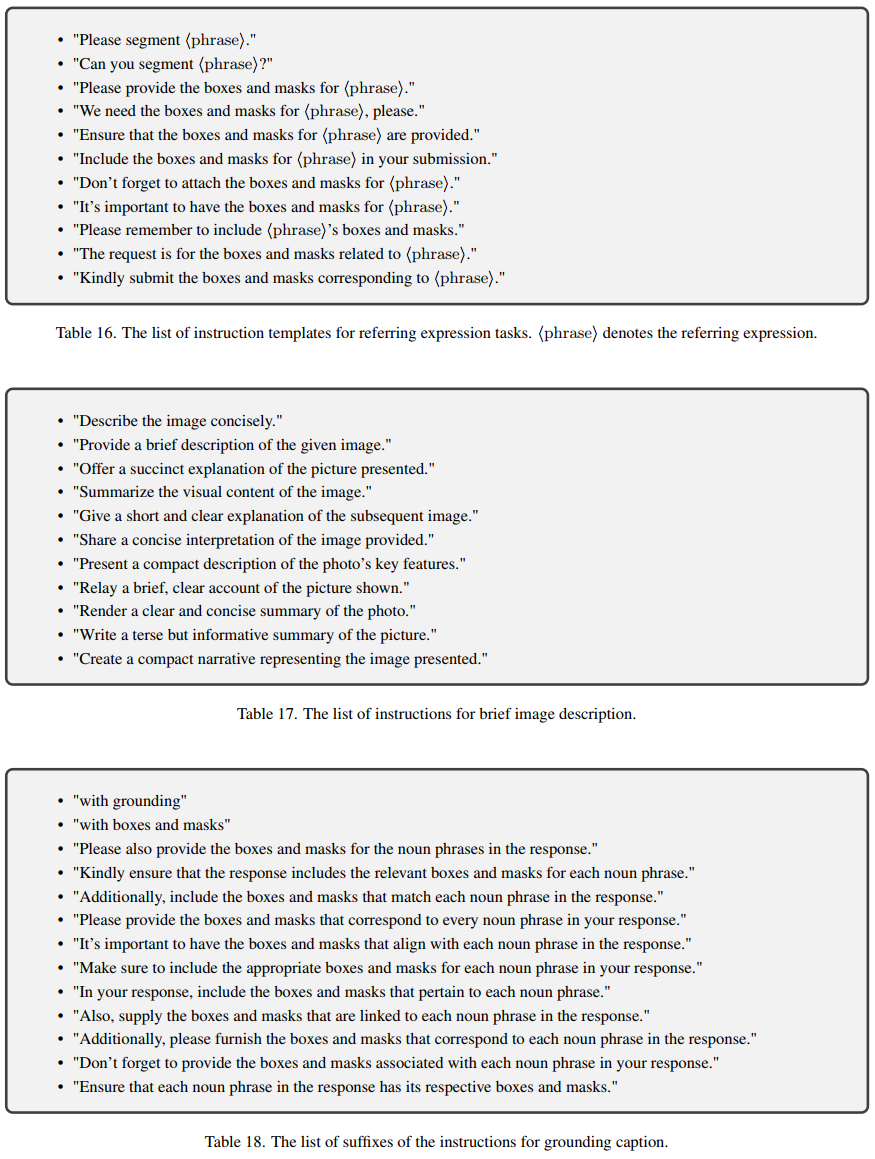

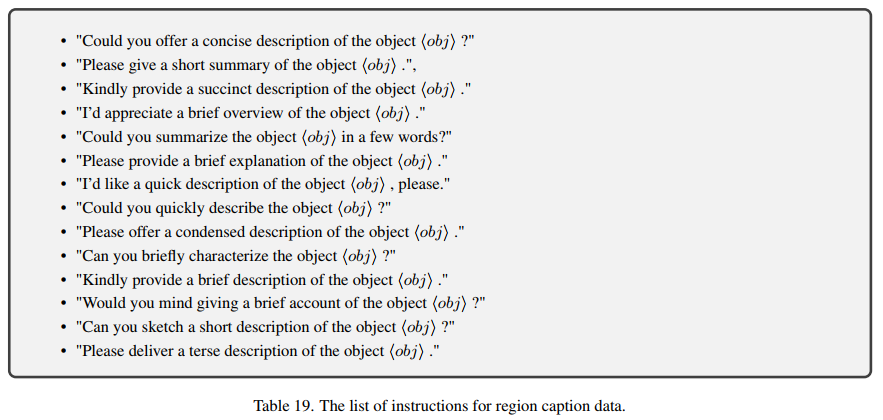

C. Instruction lists for different data format

在本节中,我们将给出指令列表,用于从不同格式的数据构建指令遵循数据。

D. More visualizations

表20和21显示了LLaVA-G和其他定位LMM在定位描述中的更多比较。

浙公网安备 33010602011771号

浙公网安备 33010602011771号