线性回归分析中的假设检验

讨论最简单的线性回归, 假设有两个变量Y和X,对他们的做二元的线性回归

$\hat{y} = \hat{\beta}_{0}+\hat{\beta}_{1}x$

对于每个x,能计算出预测值y,预测值与实际值的残差为$e_{i} = {y}_{i} - \hat{y}_{i}$

RSS为样本残差的平方和 $\sum_{i=1}^{n}{e_{i}^2}$

可以计算得出$\beta_{0}$和$\beta_{1}$使得RSS最小。

那么接下来的问题是,任何数据我们都可以用线性回归去做拟合,1)比如本身这些数据其实并不明显的线性关系 2)即使本身这些数据是来自一个线性关系,但是他们的采样会导致偏差。我们需要了解我们求得的模型的可靠性是多大?

假设Y和X服从的关系是 $y = \beta_{0}+\beta_{1}x + \epsilon$,其中$\epsilon$是噪音均值为0,且与x独立不相关,

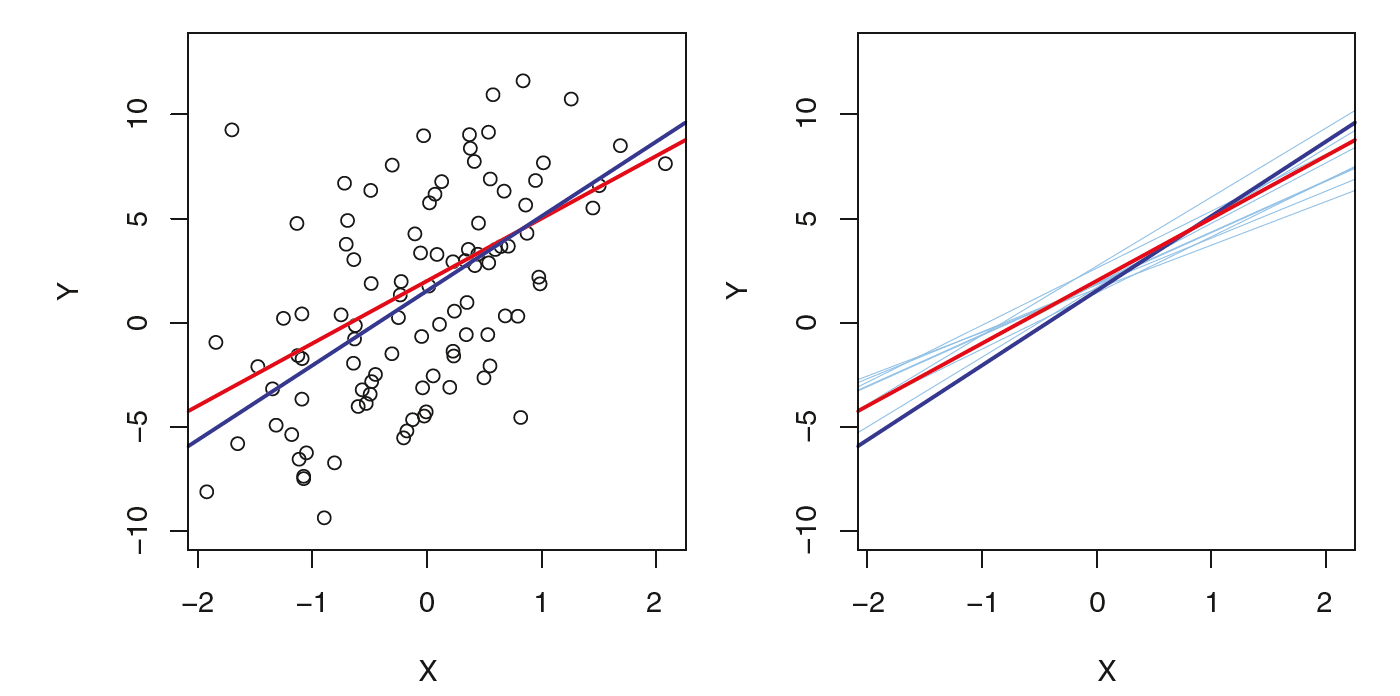

如图上红色的线是没有噪音的Y和X的关系,它是不可观测的,而蓝色的线是在有噪音的情况下根据图中实际样本通过线性回归计算出来的。那我们如何认为我们得到的蓝线是对红线的准确估计呢?这就类似于我们用一个随机变量的有限数量的样本的平均值去估计这个随机变量的均值,我们怎么知道到底有多准确呢?

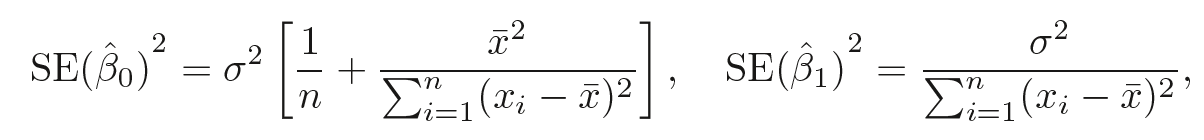

那么95%的置信度认为, $\hat{\beta}_{1}$在下面范围内,$\hat{\beta}_{0}$也有类似的结论。

![]()

知道了一个统计量的值以及他的样本方差,便可以对进行t检验,比如我们检验:假设$\hat{\beta}_{1}$的均值为0, t值如下,通过t分布,可以查出某一个t值对应的p值,如果p值<0.05, 那么我可以拒绝该假设。

接下来我们观察模型的准确度,有三个统计量,分别是RSE,R方,F值。

其中RSE是残值的标准差,越小越好,可以用RSE与y的比值,作为一个准确性度量

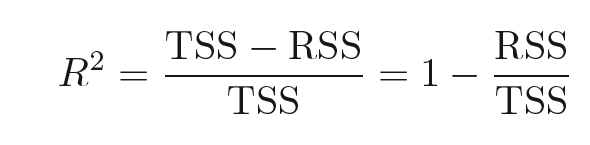

R方的取值范围是0到1,所以它给出的信息是一个相对的RSE值,计算方式如下。如果R方越接近于1,越是说明RSS足够小。

其中TSS是Y值的方差 $\sum_{i=1}^{n}{(y_{i} - \bar{y})^{2}}$

F值的计算如下

浙公网安备 33010602011771号

浙公网安备 33010602011771号