大二下 AI知识通识拓展笔记(非南大课程)20250223

内容如下:

01 从函数到神经网络

其中,人类其实是能够找到一个函数准确的穿过所有在坐标轴上的点的,可是这种情况属于过拟合,过拟合并不能使函数更加合理的反应坐标轴上的点的分布趋势,所以人类更倾向于有意将函数进行简化。因为模型的目的不是要拟合过去的全部训练数据,而是为了更好地做预测,使得没看过的样本也可以得到好效果。不追求绝对拟合是考虑到原有数据可能并非完全准确。比如说12345这一组数,可以很简单用y=x表达,但如果因为一些失误,原始数据成了13345,那么 完全拟合 的表达函数和y=x就不一样了,如果我需要对x=100的情况进行预测,两种方式计算出的结果可能相差极大。所以一般会舍弃部分值、放弃现有数据下得到的“绝对精准”,以追求在更多环境中可能更加适用的“相对精准”。(就是数据总会有“误差”,“ 离群点 ”,如果真用绝对精确的函数去拟合,就会受这些异常情况很大影响。所以科学家们选择忽视极个别离群数据,能符合绝大部分数据就行了。)

02 如何计算神经网络的参数

内容来自于:https://www.bilibili.com/video/BV1CVAUeuECE/?spm_id_from=333.788.videopod.sections&vd_source=594a6e571127875bac2b018206a99fd4

均方误差就是用来表示损失函数的一种.

03调教神经网络之难

内容来自于:https://www.bilibili.com/video/BV1RqXRYDEe2/?spm_id_from=333.1007.tianma.20-3-61.click&vd_source=594a6e571127875bac2b018206a99fd4

我们知道,神经网络的本质就是线性变换套上激活函数不断组合而成的一个非常复杂的非线性函数,并且能够通过巧妙的梯度下降一点一点地计算出神经网络中的一组合适的参数。

在训练过的数据上表现得很完美,在没见过的数据上表现得很糟糕的情况,我们称之为过拟合。

模型在没见过的数据上的表现能力,我们称之为泛化能力。

过拟合的原因是:训练数据的规律本身很简单,但是模型过于复杂,把噪声和随机波动也学会了。所以有必要简化模型的复杂度。

上面情况下,用一个非常复杂的神经网络模型来训练,效果甚至不如一个简单的线性模型好。所以神经网络不是越大越好。

简化模型复杂度有效果,与之相对的就是增加训练数据的量。数据量比较充足,原本复杂的模型也变得相对简单了。

或者我们可以进行数据增强:对原有数据进行加噪声,裁剪等操作来创造新的数据。如下:

这样,我们在增加数据量的同时,顺带还让让模型不因数据一点点小的变化进而产生很大的波动,我们增强了模型的鲁棒性。

我们也可以在训练过程中抑制参数的野蛮增长(往过拟合的方向发展),来阻止过拟合的发生。

方法1:提前终止训练过程,差不多就行了,不要追求完美(粗糙方法)。

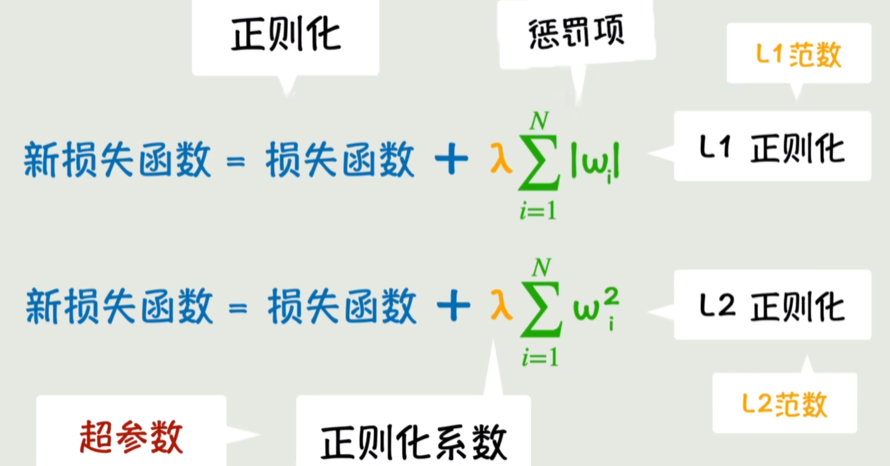

方法2:(目的也是为了抑制参数野蛮增长)在损失函数中把参数本身的绝对值加上去,这样在参数往大的调整的时候,如果原本的损失函数那部分小的没有那么多,参数变大的那部分更多,这样整个新的损失函数反而是变大的,则此时的调整不合适,这样就抑制了参数的野蛮增长。

我们可用参数的绝对值之和,参数的平方和(这样参数大的时候抑制的效果更强)。

控制参数的参数,我们称之为超参数。

为什么叫L1正则化,L2正则化:因为绝对值之和叫做L1范数,而平方和的平方根叫做L2范数。(向量空间中范数的概念)

方法3(Drop out):本方法简单,但效果好。我们的目的是防止让模型过于依赖某几个参数,所以我们可以在训练过程中,每次都随机丢弃一部分参数,这样模型就必须学会依赖更多的普通参数而非那一两个非常有用的关键参数。这样避免了在某些关键参数上过度依赖的风险。

总结:对抗过拟合的办法有增加数据量、减少模型复杂度、提前终止训练、L1正则化、L2正则化、Dropout等等。

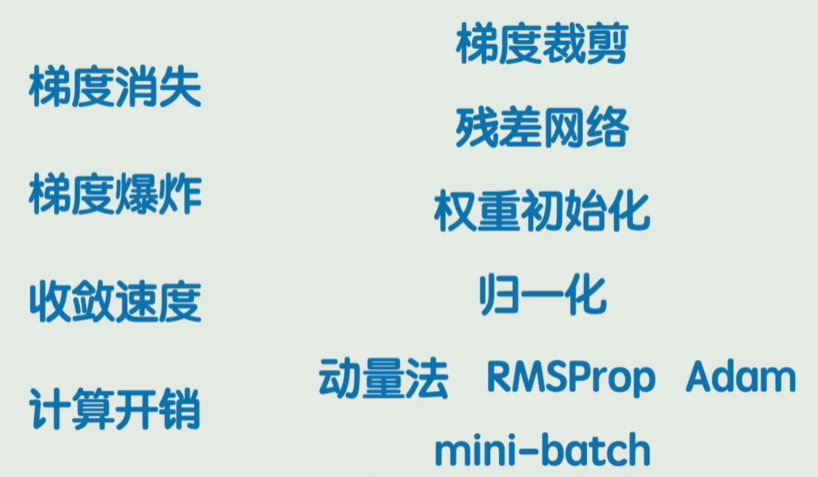

为了让训练过程更好,同样会遇见很多问题(下图左列),为了解决他们,我们采取下图右列的各种策略。

总之,不是神经网络足够大就能包打天下。有各种各样的策略在里面。

浙公网安备 33010602011771号

浙公网安备 33010602011771号